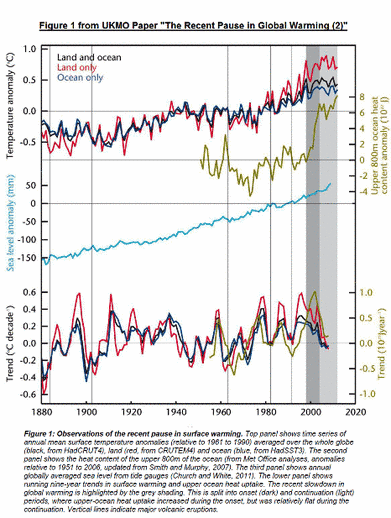

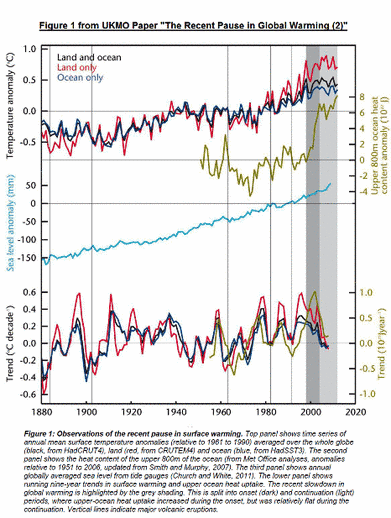

Beginnen möchte ich mit ihrer ersten Abbildung im 2. Teil:

[Die Übersetzung der Bildunterschrift lautet:

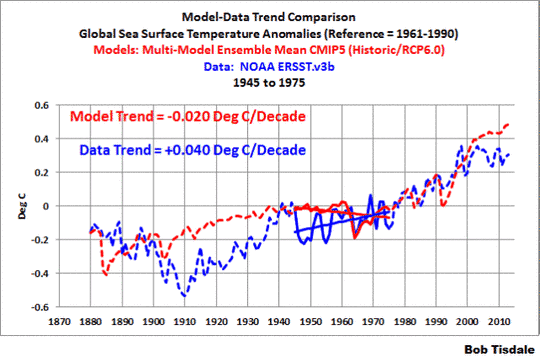

Abbildung 1: Beobachtungen des gegenwärtigen Stillstands der Erwärmung. Die oberste Graphik zeigt Zeitreihen mittlerer jährlicher Temperaturanomalien (relativ zur Periode 1961 bis 1990) gemittelt über den ganzen Globus von HadCRUT4 (schwarz), Festland von CRUTEM4 (rot) und Ozeane von HadSST3 (blau). Die zweite Graphik zeigt den Wärmegehalt der obersten 800 Meter der Ozeane (aus Analysen des Met. Office, Anomalien relativ zur Periode 1951 bis 2006, aktualisiert von Smith und Murphy 2007). Die dritte Graphik zeigt den mittleren jährlichen Meeresspiegel, ermittelt aus Pegelmessungen (Church und White 2011). Die unterste Graphik zeigt gleitende neun-Jahres-Trends der Erwärmung und der Wärmeaufnahme der oberen Ozeanschichten. Dies ist aufgeteilt in einsetzende (dunkel) und andauernde Perioden (hell) […split into onset (dark) and continuation (light) periods]. Dabei nahm die Wärmeaufnahme der oberen Schichten während der Onset-Perioden zu, verlief dagegen relatriv flach in continuation-Perioden. Vertikale Linien zeigen große Vulkanausbrüche an.]

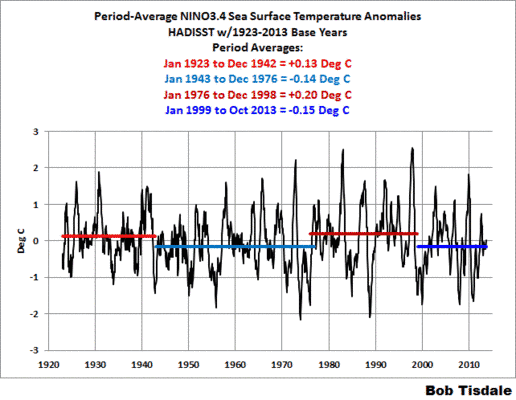

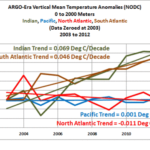

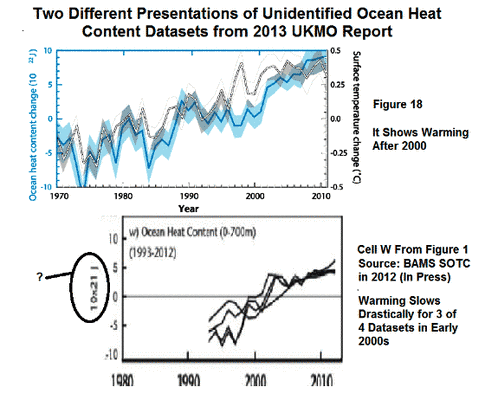

Meine Abbildung 1 ist auch Abbildung 1 im 2. Teil des UKMO-Berichtes zum gegenwärtigen Stillstand der globalen Erwärmung. Aus einer ganzen Reihe von Gründen ist sie kurios. Erstens hat das UKMO einen weiteren Datensatz des ozeanischen Wärmegehaltes präsentiert. Im 1. Teil des Berichtes hat UKMO den ozeanischen Wärmegehalt von 0 bis 700 m Tiefe in zwei Abbildungen dargestellt: In Kasten W der Abbildung 1 und in ihrer Abbildung 18. Der Vergleich der beiden Graphiken aus dem ersten Teil steht hier. In diesem 2. Teil ihres Berichtes hat UKMO jetzt den Wärmegehalt von 0 bis 800 m Tiefe gezeigt. Auch dieser Datensatz zeigt nach dem Jahr 2000 einen flachen Verlauf, enthält aber auch einen merkwürdigen Knick nach oben im Jahr 2012. Das UKMO beruft sich auf Smith und Murphy (2007) als Quelle der Daten zum ozeanischen Wärmegehalt in der jüngsten Graphik, aber jene Studie trägt den Titel „An objective ocean temperature and salinity analysis using covariances from a global climate model” (paywalled). [Etwa: Eine objektive Temperatur- und Salzgehalts-Analyse mit Hilfe von Kovarianzen aus einem globalen Klimamodell]. Auf ihrer EN-3 Ocean Heat Content data webpage beruft sich das UKMO nicht auf Smith und Murphy (2007). Also scheint es so, als seien die „Daten“ des ozeanischen Wärmegehaltes, die UKMO in Abbildung 1 des zweiten Teiles präsentiert, lediglich eine Reanalyse und nicht Daten. Wie auch immer, es scheint, als ob UKMO Datensätze des ozeanischen Wärmegehaltes gezielt danach aussucht, um einen bestimmten Standpunkt zu stützen, den sie versuchen geltend zu machen.

Zweitens, der Meeresspiegel: Der dritte Plot in Abbildung 1 von UKMO zeigt einen mit einer fast monotonen Rate steigenden Meeresspiegel. Der offensichtliche Grund dafür, den Meeresspiegel in Abbildung 1 mit zu zeigen, besteht wohl darin zu belegen, dass der Meeresspiegel weiterhin steigt, obwohl der Temperaturverlauf seit dem Jahr 1997 flach verlaufen war (es war das Jahr, dass UKMO als Anfang der Abflachung festgelegt hat). Tatsächlich stellt das UKMO weiter unten in der Studie fest:

Wie Abbildung 1 zeigt und wie besprochen im 1. Teil dieser Reihe ist der Meeresspiegel während des gesamten derzeitigen Stillstands weiterhin gestiegen.

Was sie nicht erwähnen ist die Tatsache, dass der Meeresspiegel eine lausige Proxy für die globalen Temperaturen ist. Aus den Plots der globalen Temperatur im oberen Teil ihrer Abbildung 1 geht hervor, dass sich die globale Temperatur von 1880 bis etwa 1917 abgekühlt hat, gefolgt von einer Erwärmung von 1917 bis 1944. Als ob sich dieser Zyklus wiederholt hätte, hat sich die globale Temperatur danach von 1944 bis 1976 abgekühlt und von 1976 bis 1998/2000 wieder erwärmt. Der Anstieg des Meeresspiegels jedoch hat sich während der zwei Abkühlungsperioden nicht verlangsamt.

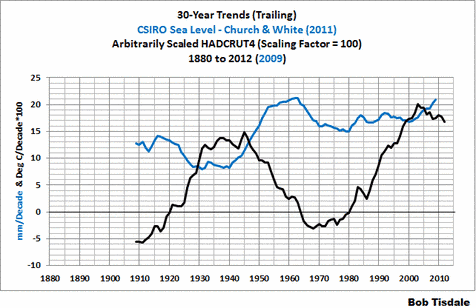

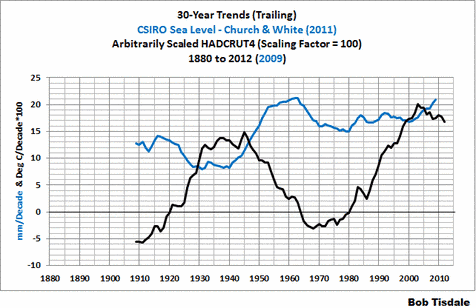

Meine Abbildung 2 zeigt die 30-jährigen linearen Trends der Temperatur und des Meeresspiegels von 1880 bis 2012. Jeder Datenpunkt in der Graphik repräsentiert die 30-Jahres-Trends in mm pro Jahrzehnt für den Meeresspiegel und Grad Celsius pro Dekade für die Temperatur, und zwar für den in jenem Jahr endenden Zeitraum. Die Temperaturdaten stammen aus den jährlichen UKMO HADCRUT4-Daten, die hier verfügbar sind. Man beachte, dass die Temperaturdaten willkürlich skaliert worden sind, indem man sie mit einem Faktor 100 multipliziert hat. Und der rekonstruierte globale Meeresspiegel von 1880 bis 2009, wie er durch Church und White (2011) beschrieben worden ist, stammt von der Website vom CSIRO hier. (CSIRO ist die australische nationale Wissenschaftsagentur). So erhalten wir die Daten der globalen Temperatur und des Meeresspiegels, wie sie vom UKMO präsentiert werden. Wie Abbildung 2 zeigt, gibt es in den 30-jährigen linearen Trends keine Übereinstimmung. Die 30-Jahres-Trends des globalen Meeresspiegels haben während der 1940 zu Ende gegangenen 30-Jahres-Perioden zugenommen, der 30-Jahres-Trend der globalen Temperatur hat jedoch von 1945 bis 1960 abgenommen.

Kurz gesagt, auf Basis der 30-Jahres-Trends gibt es keine Übereinstimmung zwischen den Raten der Erwärmung/Abkühlung hinsichtlich der Temperatur und der Raten des globalen Anstiegs des Meeresspiegels. Also gibt es auf Grundlage der Abkühlungstrends seit 1880 keinen Grund für die Annahme, dass sich der Anstieg des Meeresspiegels während eines Stillstands der globalen Temperatur verlangsamen würde. Dies könnte dazu führen, jemanden glauben zu machen, dass UKMO die Graphik des Meeresspiegels nur als Ablenkung in die Abbildung eingefügt hatte. Der globale Meeresspiegel ist seit dem Ende der letzten Eiszeit gestiegen, und aufgrund der von UKMO präsentierten Daten gibt es keinen Zusammenhang zwischen den Raten des mittels Instrumenten gemessenen Anstieg des Meeresspiegels und der Rate, mit der sich die globale Temperatur erwärmt oder abkühlt.

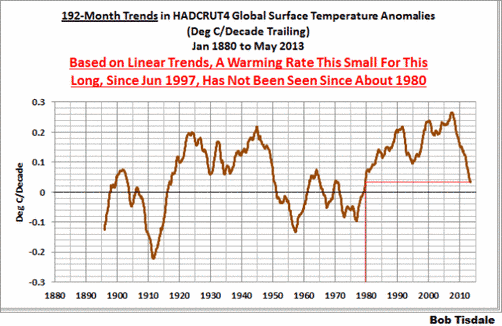

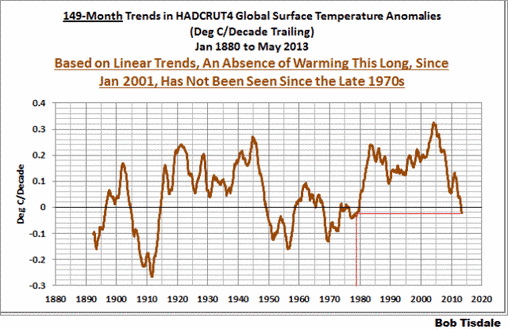

Der dritte Punkt hinsichtlich der Abbildung 1 im 2. Teil des UKMO-Berichtes bzgl. des Stillstands bei der globalen Erwärmung: In der untersten Darstellung zeigen sie 9-Jahres-Trends innerhalb der 3 Datensätze der globalen Temperatur und des ozeanischen Wärmegehaltes (Reanalyse?) Woher kommen diese 9 Jahre? Das UKMO ist sehr genau hinsichtlich der Diskussion über den Startzeitpunkt des Stillstands. Sie schreiben:

Es ist schwierig, den Beginn des gegenwärtigen Stillstands genau zu terminieren. Zwar wird oftmals das Jahr 1998 als Beginn genannt, doch war dies ein außerordentlich warmes Jahr wegen des stärksten El Niño seit Beginn instrumenteller Messungen. Diesem folgte ein starkes La Niña-Ereignis und ein Rückgang der globalen Temperatur um etwa 0,2°C (Abbildung 1). Das ist hinsichtlich der Größenordnung äquivalent zum mittleren dekadischen Erwärmungstrend der letzten Jahrzehnte. Tatsächlich ist der Anstieg der globalen Temperatur erst im Jahr 2000 zum Stillstand gekommen.

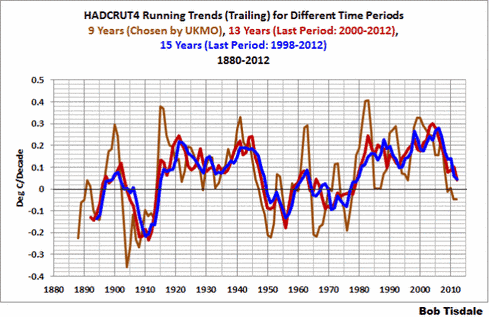

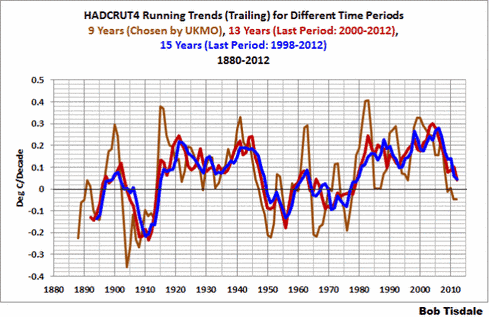

Die jährlichen Daten von 2000 bis 2012 überdecken einen Zeitraum von 13 Jahren, nicht 9 Jahre. Und die Jahre von 1998 bis 2012 überdecken 15 und nicht 9 Jahre. Es scheint, dass das UKMO 9 Jahre gewählt hat, um die Behauptung zu stützen, dass es hinsichtlich eines 9-jährigen Stillstands der globalen Erwärmung nichts Ungewöhnliches gibt. Aber um die 9 Jahre geht es ja gar nicht. Es geht um 13 Jahre und 15 Jahre. Es ist nur zu offensichtlich, warum das UKMO 9 anstatt 13 oder 15 Jahre gewählt hat. Man betrachte meine Abbildung 3. Hätte man beim UKMO 13 oder 15 Jahre als Periode gewählt, würde der gegenwärtige Stillstand ungewöhnlich aussehen; das heißt, seit Ende der siebziger Jahre haben wir keinen so geringen Erwärmungstrend mehr erlebt.

Es sieht ganz danach aus, als ob die meisten Inhalte der Abbildung 1 bei UKMO die Öffentlichkeit in die Irre führen sollten; sie von der Tatsache abzulenken, dass der jüngste Stillstand der globalen Erwärmung in seiner langen Dauer ungewöhnlich ist, wenn Klimamodelle Erwärmung nur simulieren können, wenn sie mit vom Menschen stammenden Treibhausgasen gefüttert werden.

Das UKMO widerspricht sich selbst

Die Atlantische multidekadische Oszillation (AMO) ist Gegenstand des nächsten Abschnitts. Für weitere Informationen bzgl. dieses Phänomens siehe hier, hier und hier.

In ihrer Besprechung ihrer Abbildung 1 bezieht sich das UKMO auf multidekadische Änderungen der globalen Temperatur. Es schreibt (Fettdruck von mir):

Eindeutig gab es auch schon zu anderen Zeiten Perioden mit einer geringen oder mit gar keiner Erwärmung in der relativ kurzfristigen Vergangenheit. Ein gutes Beispiel hierfür ist der Zeitraum zwischen den vierziger und den siebziger Jahren des vorigen Jahrhunderts (Abbildung 1). Der Erwärmungstrend während dieser Zeit ist gut verstanden und hängt zusammen mit einer substantiellen Zunahme von Aerosolen in der Atmosphäre.

Das UKMO erweckt hier die Aerosol-Vermutung erneut zum Leben und behauptet, dass diese „gut verstanden“ ist. Allerdings widersprechen sie sich weiter unten in dem Bericht selbst. Unter der Überschrift „2.2 Redistribution of energy within the climate system – Storing the heat below the surface” und als ein Vorwort zu ihrer Besprechung der Auswirkungen der AMO auf die globalen Temperaturen schreibt das UKMO:

Es ist immer noch unklar, wie diese multidekadischen Variationen der Temperaturen im Nordatlantik angetrieben werden, und es ist eine Debatte im Gange über die Rolle anthropogener Aerosole als Antrieb der AMO (Booth et al 2012, Zhang et al. 2013).

Wenn das UKMO feststellt, dass eine Debatte im Gange ist über die Auswirkungen anthropogener Aerosole auf die AMO und dass diese der dominante Faktor bzgl. der multidekadischen Variationen der Temperaturen sind, wie kann das UKMO dann von „gut verstanden“ reden und davon, dass der Stillstand der Erwärmung von den vierziger bis zu den siebziger Jahren „mit einer substantiellen Zunahme der Aerosol-Menge in der Atmosphäre verbunden ist“?

Booth et al. (2012) und Zhang et al. (2013) habe ich in meinem Blogbeitrag vom März 2013 besprochen. Er trägt den Titel Blog Memo to Lead Authors of NCADAC Climate Assessment Report. Darin habe ich geschrieben:

Booth et al (2012) – eine Studie auf Basis von Klimamodellen – behaupten im Abstract, dass ein „Zustand-der-Erde-Klimamodell…“ verwendet worden ist, „…um zu zeigen, dass Emissionen von Aerosolen und Perioden vulkanischer Aktivität 76 Prozent der simulierten multidekadischen Varianz der trendbereinigten Temperaturen im Nordatlantik von 1860 bis 2005 erklären können“. Andererseits haben Zhang et al (2013) die begrenzte Datenmenge genutzt, um diese Behauptungen in Frage zu stellen. Offensichtlich ist ein „Zustand-der-Erde-Klimamodell“ immer noch ungeeignet für Studien dieser Art der Zuordnung. Wissen wir auf Basis von Computermodellen und sehr begrenzter Daten, was die multidekadischen Variationen der Wassertemperatur im Nordatlantik auslöst? Die realistische Antwort lautet nein.

Dann gibt es da die kürzlich erschienene Studie, in der die vielen Fehler der Klimamodell-Simulationen bzgl. der AMO behandelt werden. Die Studie stammt von Ruiz-Barradas et al. (2013) und trägt den Titel The Atlantic Multidecadal Oscillation in twentieth century climate simulations: uneven progress from CMIP3 to CMIP5. Die gesamte Studie steht hier. In den „abschließenden Bemerkungen” findet sich zu Beginn eine Erklärung, warum es für die Klimamodelle so wichtig ist, in der Lage zu sein, die AMO angemessen zu simulieren. Sie schreiben (Fettdruck von mir):

Die dekadische Variabilität im Klimasystem durch die AMO ist eine der wichtigsten Quellen der Variabilität in diesem temporären Rahmen, und die Klimamodelle müssen zum Ziel haben, dies angemessen zu dokumentieren, und zwar wegen des Einflusses dieses Phänomens auf das Klima der angrenzenden Kontinente. Diese Angelegenheit hat besondere Bedeutung für die gegenwärtigen Bemühungen hinsichtlich dekadischer Klimavorhersage-Experimente, die in Vorbereitung des fünften IPCC-Zustandsberichtes analysiert worden sind. Die gegenwärtige Analyse beabsichtigt nicht, die Mechanismen hinter der Abbildung der AMO in Modellsimulationen zu untersuchen, sondern Beweise für Verbesserungen der Modellrechnungen zu liefern oder das Fehlen derselben. Falls die Klimamodelle die mit der Erzeugung der AMO (oder andere Quellen dekadischer Variabilität wie die PDO) verbundenen Mechanismen nicht angemessen spiegeln und stattdessen die Variabilität mit anderen Häufigkeiten zeigen oder verstärken, dann ist die Fähigkeit der Modelle, im Zeitrahmen von Jahrzehnten zu simulieren und vorherzusagen in Frage gestellt und damit auch die Art und Weise, mit der sie diese Variabilität des Klimas und deren Auswirkungen auf menschliche Gesellschaften übertragen.

Die einzige Möglichkeit, wie sich Ruiz-Barradas et al. noch klarer hätten ausdrücken können wäre es, wenn sie klar sagen, dass Klimamodelle nur dann einen Sinn haben, falls und wenn sie jemals die dekadischen und multidekadischen Charakteristika natürlicher ozeanischer Prozesse simulieren können. Die Autoren beschreiben dann die vielen Probleme im Zusammenhang mit den Klimamodell-Simulationen hinsichtlich der AMO. Die Studie endet mit den Worten (Fettdruck von mir):

Die hier vorliegende Analyse präsentiert keine Beweise, warum die Modelle so agieren, wie sie agieren, sondern zeigt, dass die ungerechtfertigte Zunahme der hohen 10 bis 20-jährigen Variabilität von den Modellen CMIP3 zu CMIP5 hinter dem unbefriedigenden Fortschritt stehen könnte, die räumlich-zeitlichen Erscheinungen der AMO darzustellen. Dieses Problem gekoppelt mit der Unfähigkeit der Modelle, die regionale Low-Level-Zirkulation einzubeziehen, den Treiber der Feuchtigkeits-Flüsse, scheint im Mittelpunkt der ärmlichen Repräsentation der hydroklimatischen Einflüsse der AMO zu stehen.

Falls die Klimamodelle die AMO nicht angemessen simulieren können, dann ist es sehr offensichtlich, dass der Stillstand der globalen Temperaturen von den vierziger bis zu den siebziger Jahren eben nicht „gut verstanden“ ist, wie das UKMO behauptet.

ANMERKUNG: Die Abbildungen 2 und 3 oben zeigten Variationen der Trends. Im Folgenden zeigen die Abbildungen 4 bis 7 Variationen von Temperaturanomalien.

Das UKMO zeigt dann den falschen Datensatz für eine Diskussion multidekadischer Temperaturvariationen

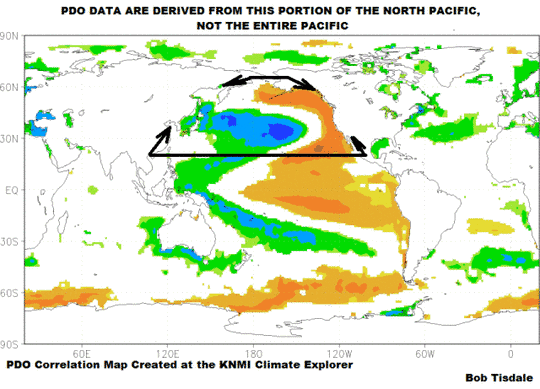

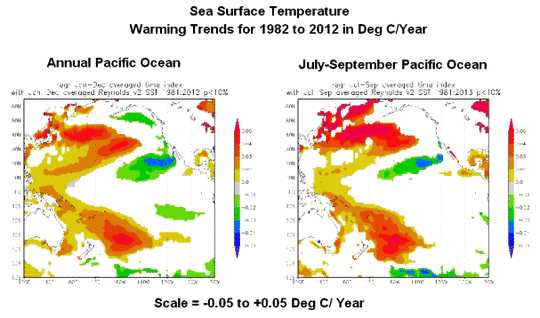

Weiter zur Pazifischen Dekadischen Oszillation PDO: Das UKMO stellt zu Beginn richtig fest, dass es hinsichtlich der Wassertemperaturen im Nordpazifik multidekadische Variationen gibt. Aber dann weicht es tangential von der Linie ab, wenn es die PDO und andere abstrakte Erscheinungen hinsichtlich der Wassertemperatur des Pazifiks behandelt, als ob diese abstrakten Erscheinungen die multidekadischen Variationen der Wassertemperatur im Pazifik nördlich von 20°N oder im Pazifischen Ozean repräsentieren:

Der Pazifische Ozean zeigt auch längerfristige Variationen (Abbildung 5), die verschiedentlich als die Pazifische Dekadische Oszillation PDO bezeichnet werden (Mantua et al. (1997)) oder als Pazifische Dekadische Variabilität PDV (Deser et al. (2012)) oder als Interdekadische Pazifische Oszillation IPO (Power et al. (1999)).

Dann macht das UKMO ein ziemlich überraschendes Zugeständnis (Fettdruck von mir):

Die Charakteristika und die Mechanismen der PDO sind viel weniger gut verstanden als bei der AMO, und es gibt einige Diskussionen darüber, ob die PDO lediglich das niederfrequente Verhalten der ENSO und deren Einfluss auf atmosphärische Zirkulationen der mittleren Breiten und Oberflächen-Flüsse zeigt (Deser et al. 2012), oder ob die Dynamik der Ozeane ebenfalls eine Rolle spielt.

Hier wollen wir einen Moment innehalten. Die gegenwärtige Generation der Klimamodelle kann die AMO nicht simulieren, außerdem gibt es eine Debatte darüber, ob menschliche Aerosole in der AMO eine Rolle spielen oder nicht. Und jetzt stellt das UKMO fest, dass die multidekadischen Variationen im Nordpazifik (und dem Pazifik als Ganzem) sogar noch weniger verstanden sind! Und das UKMO möchte uns glauben machen, dass „der Erwärmungstrend während jener Periode gut verstanden ist und mit einer substantiellen Zunahme von Aerosolen in der Atmosphäre zusammenhängt“.

Das ist wirklich lächerlich. (Und ich lache nicht mit ihnen, sondern über sie). Was für eine Frechheit!

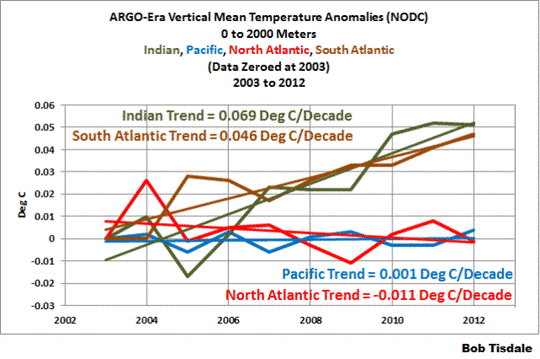

Zurück zur PDO: Das UKMO macht dann weiter mit der Besprechung des PDO-Index‘ und illustriert dies mit seiner Abbildung 4. Aber sie ignorieren (absichtlich? unwissend?) die Tatsache, dass der PDO-Index nicht die Wassertemperaturen des Nordpazifik repräsentiert – dass der PDO-Index eine abstrakte Form der Wassertemperatur des Nordpazifiks repräsentiert.

Kurze Beschreibung des PDO-Index’: El Niño- und La Niña-Ereignisse erzeugen eine spezifische räumliche Verteilung der Wassertemperatur im Nordpazifik nördlich von 20°N. Zum Beispiel sind die Wassertemperaturen während eines starken El Niño im Ostteil des Nordpazifik warm und in den westlichen und zentralen Teilen kalt. Der PDO-Index zeigt im Wesentlichen, wie eng die räumliche Verteilung im Nordpazifik und deren Intensität zur räumlichen Verteilung von El Niño und La Niña-Ereignissen passt. Der PDO-Index bezieht sich nicht auf die Wassertemperatur im Nordpazifik, 1), weil die räumliche Verteilung bei jedweder Wassertemperatur existieren könnte und 2), weil der Bodenluftdruck und damit zusammenhängende Windverhältnisse) ebenfalls die räumliche Verteilung und damit wiederum den PDO-Index beeinflussen.

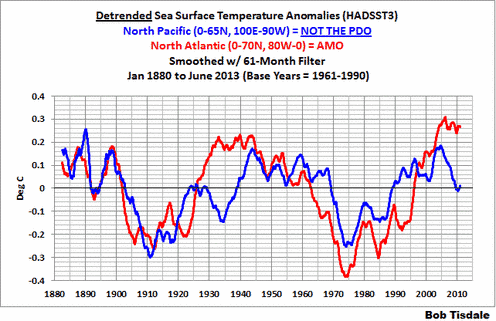

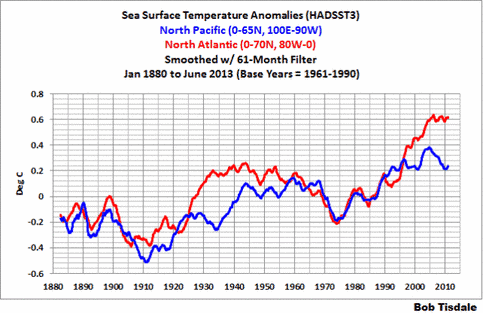

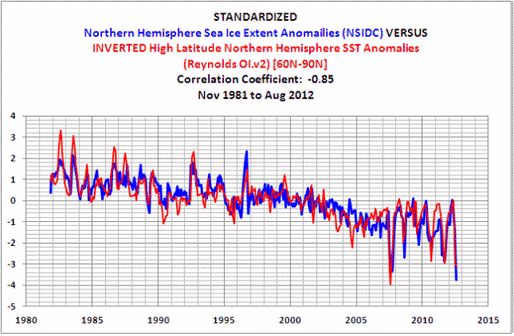

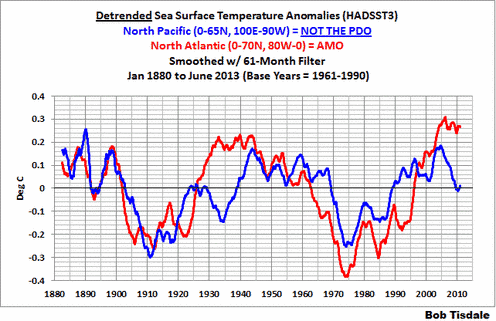

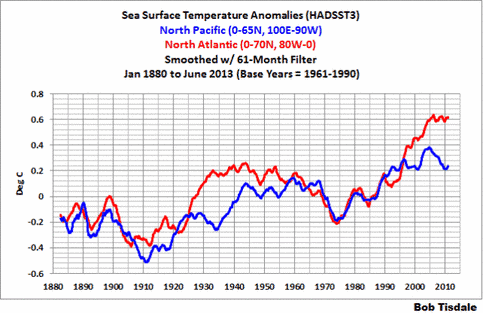

Und das UKMO ignoriert die Tatsache, dass die Wassertemperaturen des Nordpazifiks multidekadische Variationen aufweisen, die vergleichbar sind mit jenen im Nordatlantik. Das kann man leicht erkennen, wenn man die Anomalien der Wassertemperatur im Nordpazifik nördlich von 20°N trendbereinigt, und zwar auf die gleiche Weise, wie es NOAA ESRL mit dem Atlantic Multidecadal Oscillation Index macht. Meine Abbildung 4 vergleicht trendbereinigte Anomalien der Wassertemperatur im Nordatlantik (0° bis 70°N, 80°W bis 0) und im Nordpazifik (0 bis 65°N, 100°E bis 90°W). In dieser Graphik wird der UKMO HADSST3-Datensatz verwendet. Beide Unter-Datensätze wurden auch mit 61-Monate-Filtern geglättet, um monatliche und jährliche Fluktuationen zu reduzieren. (Anmerkung: Normalerweise präsentiere ich die trendbereinigten Anomalien der Wassertemperatur im außertropischen Nordpazifik {20N-65N, 100E-100W} in diesen Vergleichen, weil die PDO daraus abgeleitet ist, aber in diesem Falle habe ich den gesamten Nordpazifik {0-65N, 100E-90W} betrachtet).

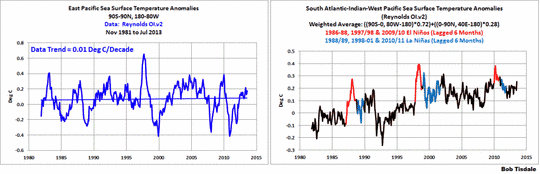

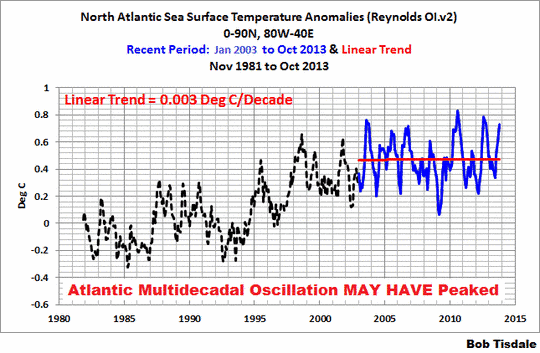

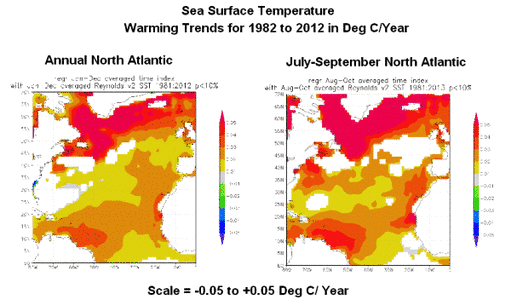

Es ist wirklich schwierig, die multidekadischen Variationen der Wassertemperatur im Nordpazifik zu übersehen. Sie können synchron oder asynchron mit dem Nordatlantik variieren. Aber wir wollen einmal auf die Anomalien der Wassertemperatur im Nordatlantik und Nordpazifik ohne die Trendbereinigung schauen, Abbildung 5. Die Wassertemperaturen im Nordatlantik mögen einen Spitzenwert erreicht haben, aber das Plateau ist sehr kurz. Andererseits hat sich der Nordpazifik seit dem Jahr 2003 ziemlich drastisch abgekühlt.

Von den beiden Ozeanbecken trägt der Nordpazifik am meisten zum Stillstand der Erwärmung bei, aber dem UKMO zufolge sind die Variationen der Oberflächentemperaturen dort sogar noch weniger verstanden als im Nordatlantik, die auch nicht verstanden sind. Aber Moment, da ist noch mehr.

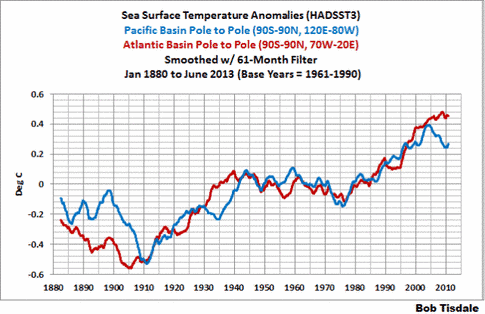

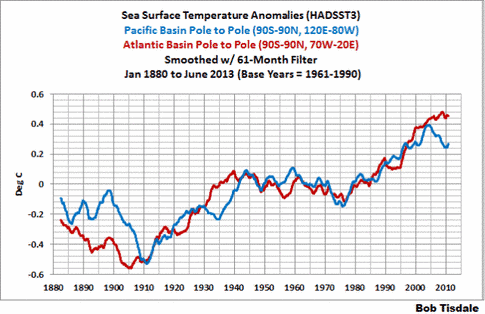

Die Abkühlung im Nordpazifik erstreckt sich auf das gesamte pazifische Becken, aber die Abflachung der Wassertemperatur-Anomalien im Nordatlantik erstreckt sich nicht auf den gesamten Atlantischen Ozean. Man betrachte Abbildung 6, welche die Wassertemperatur-Anomalien im Pazifik von Pol zu Pol (90S-90N, 120E-80W) und im Atlantik von Pol zu Pol (90S-90N, 70W-20E) repräsentiert.

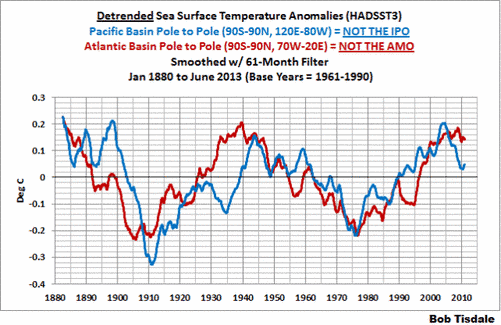

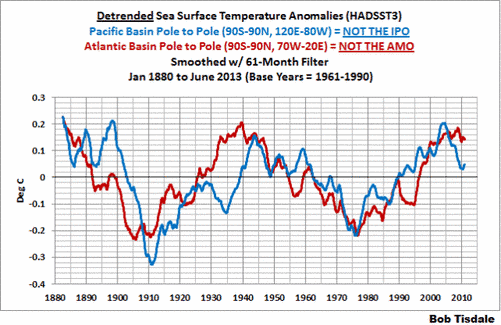

Diese beiden beckenweiten Datensätze wurden in Abbildung 7 trendbereinigt, um zu zeigen, dass die multidekadische Variabilität in beiden Fällen auf das gesamte Becken übergreift.

Auf Grundlage der Statements vom UKMO selbst verstehen sie und die klimawissenschaftliche Gemeinschaft allgemein nicht die Gründe der multidekadischen Variationen der Wassertemperatur im Atlantischen und Pazifischen Ozean. Dies zeigt, dass sie auch nicht verstehen, was die globale Erwärmung von Mitte der siebziger Jahre bis zum Jahr 2000 ausgelöst hat. Wenn sie den Stillstand nicht erklären können, dann können sie mit Sicherheit auch nicht die Erwärmung erklären.

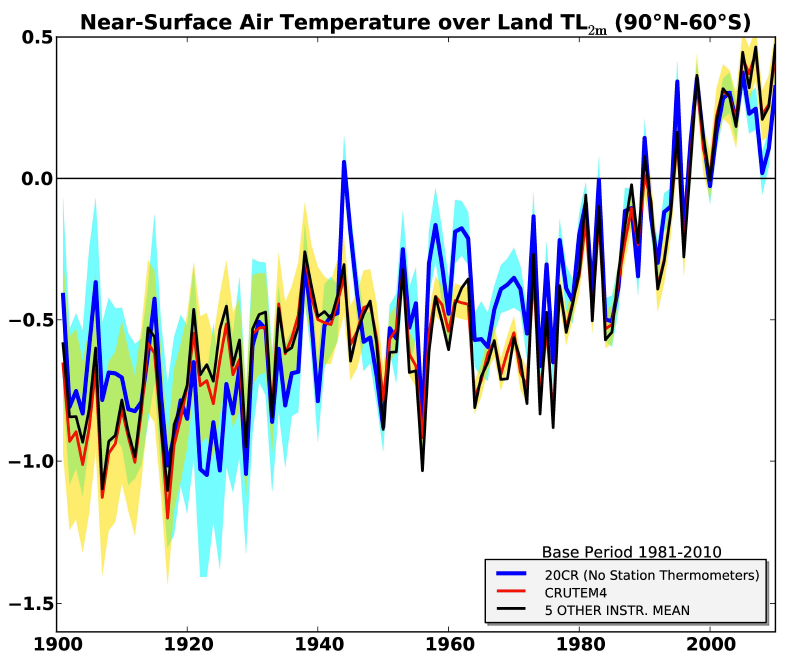

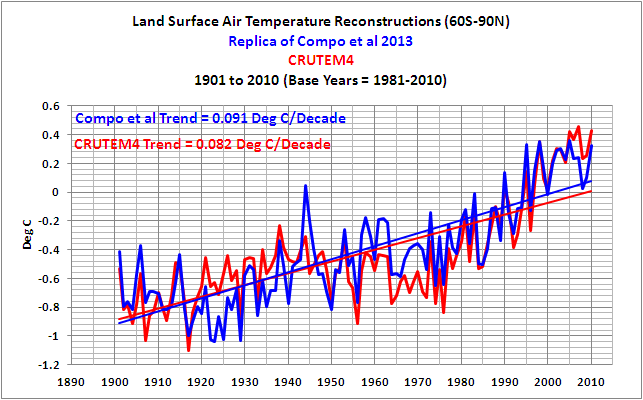

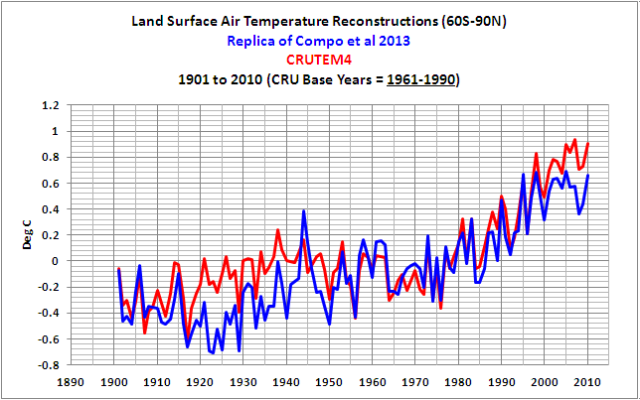

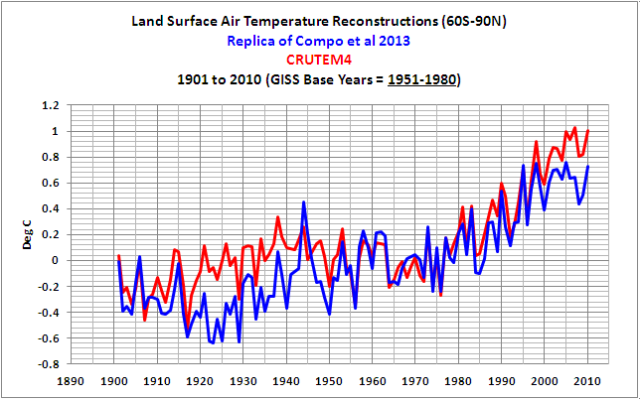

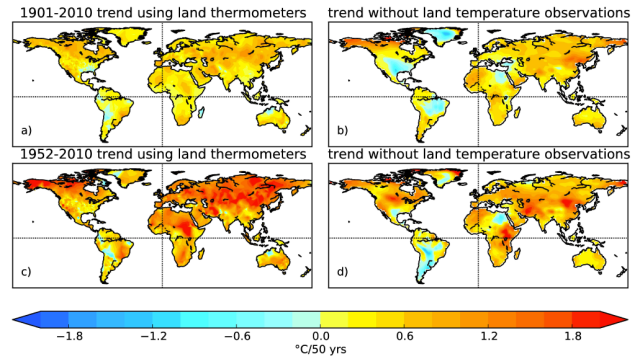

Es ist für die Gemeinschaft der Klimawissenschaftler sehr wichtig, die natürlichen Prozesse modellieren zu können, die zur Erwärmung und zur Abkühlung der globalen Ozeane beitragen. Die Temperaturen auf dem Festland folgen den jährlichen, dekadischen und multidekadischen Variationen der Wassertemperatur mit größerer Amplitude. Dies wurde von Compo und Sardesmukh (2009) in ihrer Studie Oceanic influences on recent continental warming gezeigt. Das Abstract beginnt mit den Worten:

Beweise werden präsentiert, dass die jüngste weltweite Erwärmung auf dem Festland zum großen Teil auf eine weltweite Erwärmung der Ozeane zurückzuführen ist und nicht eine direkte Reaktion auf zunehmende Treibhausgase an Land.

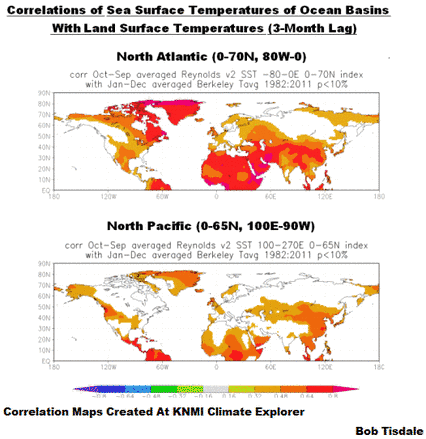

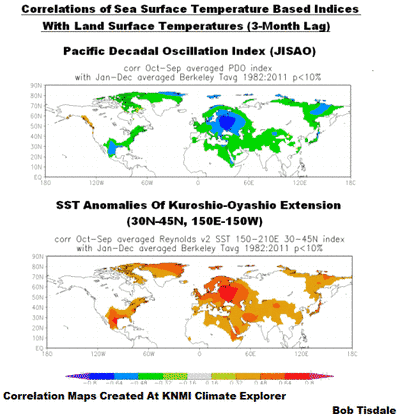

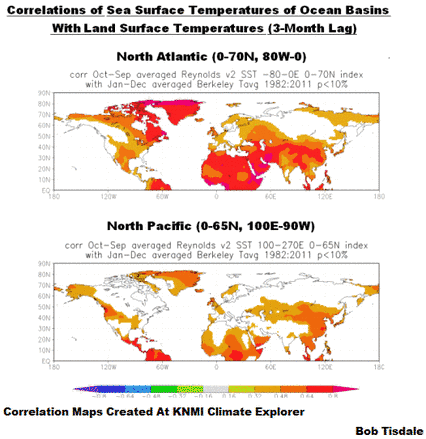

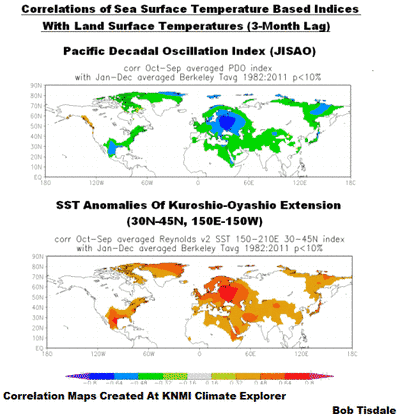

Wir können auch Karten der Korrelation benutzen, um den Einfluss der Wassertemperatur in Nordatlantik und Nordpazifik auf die Festlands-Temperaturen in der Nordhemisphäre zu illustrieren. Ich habe die Berkeley Earth Surface Temperature (BEST)-Daten in Abbildung 8 verwendet, weil CRUTEM4 räumlich nicht vollständig ist, und ich habe die Reynolds OI.v2-Daten anstatt der HADSST3-Daten aus dem gleichen Grund verwendet. Die Daten erstrecken sich von 1982 (dem Beginn der auf Satellitenmessungen basierenden Reynolds OI.v2-Daten) bis 2011 (dem letzten Jahr mit vollständigen BEST-Daten). Die obere Karte zeigt die Korrelationen der Festlands-Temperaturanomalien mit denen der Wassertemperatur im Nordatlantik, und die untere Karte das Gleiche mit dem Nordpazifik. Man kann leicht erkennen, warum Forscher glauben, dass der Nordatlantik einen starken Einfluss auf die Temperaturen in der Nordhemisphäre hat. Aber man kann den Pazifik nicht ignorieren, weil er ebenfalls Auswirkungen zeitigt.

Das UKMO ist kurz auf die möglichen Gründe für multidekadische Variationen der Wassertemperatur der Kuroshio Extension eingegangen, bekannt auch unter der Bezeichnung Kuroshio-Oyashio Extension oder KOE:

Es gibt einige Beweise, dass Änderungen der Wärmetransporte in den Ozeanen in Zusammenhang mit dem Gebiet der Kuroshio Extension (einer ostwärts gerichteten Meeresströmung im Nordpazifik) und die Erzeugung interner Ozean-Zirkulationen durch oberflächennahe Winde, Rossby-Wellen genannt, beitragende Faktoren sein können (z. B. Alexander 2010).

Wir haben die Prozesse besprochen, durch die das durch starke El Niño-Ereignisse zurück gebliebene Restwarmwasser in die Kuroshio-Oyashio Extension gelangt während nachfolgender La Niñas, und dass diese einem starken El Niño folgenden Erwärmungen die Auswirkungen der nachfolgenden La Niña-Ereignisse auf die Luft- und Wassertemperaturen kompensieren. Siehe diesen Beitrag hier.

Wie schon zuvor erwähnt repräsentiert der PDO-Index nicht die Wassertemperaturen des Nordpazifiks. Wir haben dies in zahlreichen Beiträgen während der letzten Jahre behandelt; siehe hier, hier und hier. Wie in jenen Beiträgen dargestellt, ist der PDO-Index umgekehrt verbunden mit den Wassertemperaturen im Nordpazifik. Und wie in Abbildung 9 dargestellt ist der PDO-Index auch mit Variationen der Temperaturen an Land in vielen Gebieten der Nordhemisphäre anti-korreliert. Das heißt, wenn der PDO-Index steigt, kühlen sich die Temperaturen an Land in vielen Gebieten des Globus‘ ab – und umgekehrt, wenn der PDO-Index sinkt. Andererseits sind die Anomalien der Wassertemperatur der Kuroshio-Oyashio Extension ein Maß für die Wassertemperatur, und sie sind positiv korreliert mit den Temperaturen an Land in ähnlichen Gebieten der Nordhemisphäre.

Zusammenfassend zu diesem Abschnitt: die PDO ist eine abstrakte Repräsentation der Wassertemperatur im Nordpazifik und als solche der falsche Datensatz zur Verwendung in den Diskussionen zur globalen Erwärmung – oder zu dem Fehlen derselben.

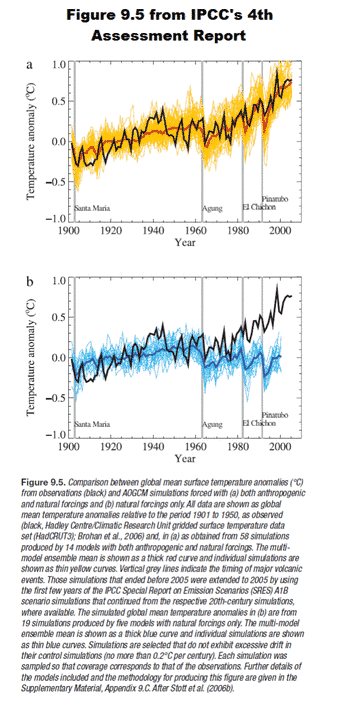

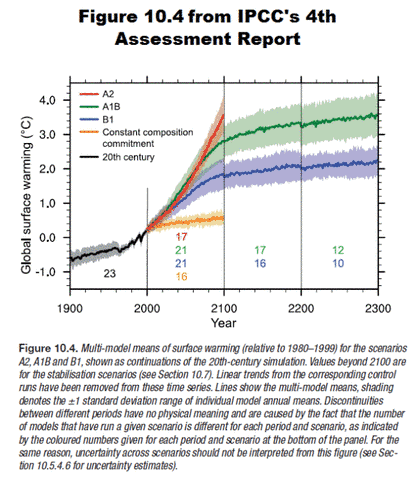

Repräsentationen der dekadischen Variabilität in Klimamodellen

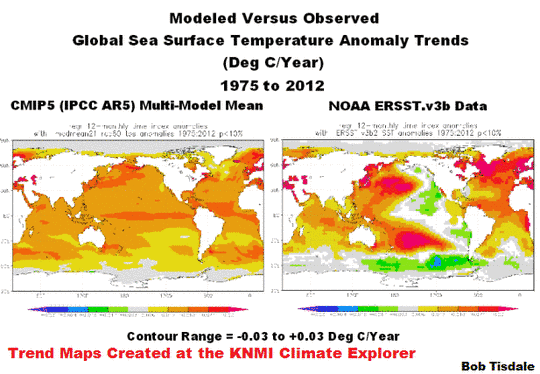

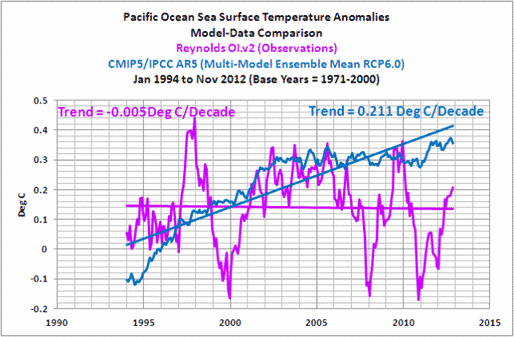

Danach folgt beim UKMO eine Besprechung ihrer Simulationen der Wassertemperaturen des Pazifischen Ozeans mit verschiedenen Versionen ihrer Klimamodelle, und sie zeigten ein paar Karten der Simulationen, um das Übergewicht einer La Niña-Verteilung während der modellierten, ein Jahrzehnt langen Stillstandsperioden zu belegen:

Die Bedeutung der dekadischen Variabilität im Pazifischen Ozean als Antrieb für verlängerte Perioden der Abkühlung wurde auch in Multi-Jahrhundert-Simulationen mit festgesetzten Strahlungsantrieben identifiziert. Abbildung 6 zeigt die räumliche Verteilung des Temperaturtrends, gemittelt über Perioden mit extremer Abkühlung aus einer Reihe von Klimamodellen des Met. Office Hadley Centre, einschließlich des jüngsten Modells (HadGEM2), das auch Eingang in den 5. IPCC-Zustandsbericht gefunden hat. Sie sehen alle in bemerkenswerter Weise aus wie die beobachtete Verteilung während der letzten Dekade (Abbildung 6, Graphik rechts unten) und stellen einen ziemlich robusten Beweis dar für die Bedeutung des Verständnisses der Rolle des Pazifischen Ozeans hinsichtlich der gegenwärtigen Pause der mittleren globalen Erwärmung.

„Festgesetzte Strahlungsantriebe” bedeutet, dass infrarote Strahlung durch vom Menschen emittierte Treibhausgase in den Modellen nicht zunimmt, es gibt keine vorübergehenden Abnahmen des Sonnenlichts durch vulkanische Eruptionen, es gibt keine Variationen der Strahlung von der Sonne usw. Mit anderen Worten, das ist nicht die reale Welt. Es ist irrelevant.

Ich bin immer wieder erstaunt darüber, dass Gruppen von Modellierern die Fehlschläge ihrer Modelle herausstellen. Die UKMO-Präsentation von Modellergebnissen mit „festgesetzten Strahlungsantrieben“ zeigt nachhaltig, dass die Klimamodelle vom UKMO den Stillstand nicht simulieren können, falls die Modelle mit Bedingungen der realen Welt gefüttert werden. Oder vielleicht besteht die einzige Möglichkeit für die UKMO-Klimamodelle, die Jahrzehnte lange Pause der Wassertemperatur-[Änderungen] zu simulieren darin, die Auswirkungen der Treibhausgase zu entfernen. Man denke darüber mal eine Weile nach.

Das UKMO bezieht sich dann auf eine Studie von Meehl et al. 2011 mit dem Titel „Model-based evidence of deep-ocean heat uptake during surface-temperature hiatus periods“. Diese Studie basiert auf dem NCAR CCSM4 Klimamodell. Meehl et al. haben im Wesentlichen die Zukunfts-Projektionen des CCSM4-Modells hinsichtlich Jahrzehnte langer Stillstands-Perioden untersucht. Während dieser Zeiten haben die Modelle La Niña-artige Bedingungen simuliert. Aber wir wissen, dass Klimamodelle die El Niño und La Niña-Ereignisse nicht angemessen abbilden. Ich habe Guilyardi et al (2009) als Referenz für dieses Scheitern in früheren Beiträgen benutzt. Die folgende Studie ist eine jüngere Bestätigung, wie schlecht die Klimamodelle die ENSO simulieren. Die Studie: Bellenger et al. 2013: ENSO representation in climate models: from CMIP3 to CMIP5. Ein Vorabdruck findet sich hier. Der Abschnitt mit der Überschrift „Discussions and Perspectives“ beginnt mit den Worten:

Die Modellierer müssen noch viel Arbeit aufwenden, um die ENSO korrekt zu repräsentieren, seine grundlegenden Charakteristika (Amplitude, Entwicklung, Zeiträume, jahreszeitliche Abläufe…) und fundamentale Prozesse wie die Bjerkness-Rückkopplungen und andere.

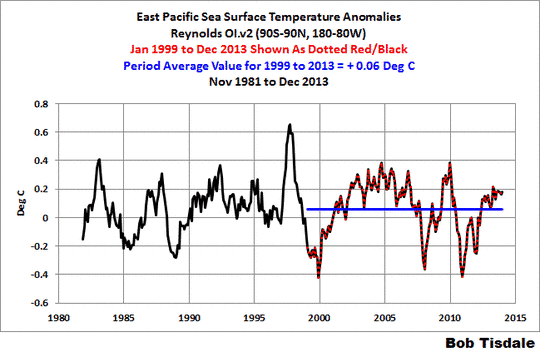

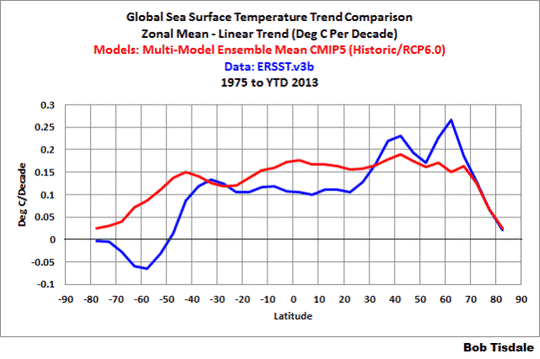

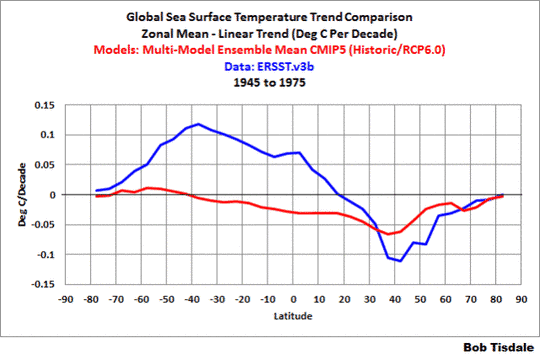

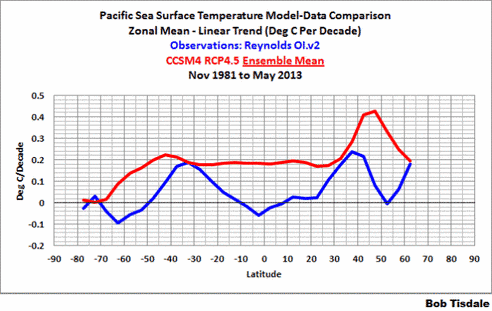

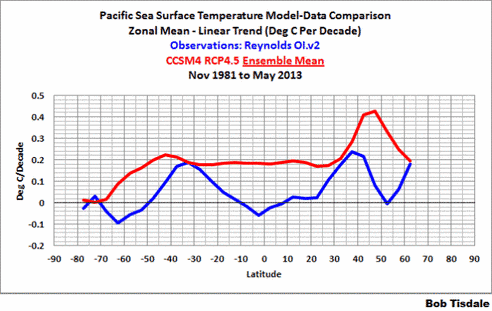

Außerdem zeigen und diskutieren wir in diesem Beitrag, wie das NCAR CCSM4-Klimamodell nicht in der Lage war, die beobachtete Erwärmung im Pazifischen Ozean während der letzten 31 Jahre zu simulieren. Siehe Abbildung 10, in der modellierte und beobachtete Trends der Wassertemperatur im Pazifischen Ozean seit November 1981 dargestellt sind, und zwar auf einer breitenabhängigen Basis (zonale Mittel). Die Tatsache, dass jene Modelle gelegentlich Jahre lange Stillstandsperioden simulieren können, ist daher unerheblich.

Änderungen im Wärmehaushalt der Ozeane

In ihrer Besprechung der Abbildung 1 schreibt das UKMO (Fettdruck von mir):

Außerdem hat der ozeanische Wärmegehalt in den oberen Schichten noch ein paar Jahre nach 1998 weiter zugenommen (Abbildung 1). Nichtsdestotrotz ist aber klar, dass die Erwärmungsrate sowohl an der Oberfläche als auch in den oberen Ozeanschichten in jüngster Zeit abgenommen hat (Abbildung 1, untere Darstellung). Und dies trotz eines fortgesetzten Anstiegs der atmosphärischen Kohlendioxid-Konzentrationen, die innerhalb des Systems Erde als Fallen für Strahlung agieren.

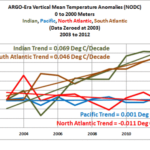

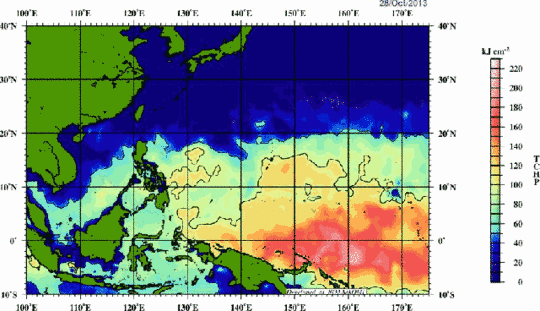

Die Daten (vielleicht eine Reanalyse?) für den oberen Ozean in ihrer Abbildung 1 gelten für die oberen 800 m. Das UKMO fährt dann fort, über die Daten des ozeanischen Wärmegehaltes zu sprechen unter der Überschrift „2.3 What do we know about changes in the ocean heat budget?” Sie schreiben (Fettdruck von mir):

Falls die Ozeane wirklich Wärme unter ihrer Oberfläche verborgen hätten, muss man sich fragen, ob Änderungen des Wärmegehaltes vor allem im tieferen Ozean überhaupt entdeckt werden können. Es gab bedeutende Fortschritte hinsichtlich der Abschätzung des ozeanischen Wärmespeichers während des vergangenen Jahrzehnts, und zwar wegen der Korrektur von Verzerrungen bei konventionellen Erkundungen und der Entwicklung der ARGO-Bojen.

Das ist ein gewaltiges FALLS, mit dem dieser Absatz beginnt, vor allem wenn sie einräumen, dass die Daten modifiziert werden müssen, und zwar natürlich auf eine Art und Weise, dass die Daten eine Erwärmung zeigen. Sie fahren fort (Fettdruck von mir):

Die ARGO-Messungen zeigen eine rapide Zunahme des Wärmegehaltes bis zu einer Tiefe von 700 m, und zwar von 1999 bis 2004 (Guemas et al. 2013). Das zeigt auch Abbildung 1, aber die Rate der Zunahme ist danach geringer. Diese Periode fällt jedoch zeitlich zusammen mit substantiellen Änderungen im Beobachtungssystem infolge der raschen Einführung der ARGO-Bojen. Obwohl ARGO-Bojen zunehmend robuste globale Messungen der oberen Ozeanschichten zur Verfügung stellen, müssen Schlussfolgerungen aus Perioden mit großen Änderungen in einem Beobachtungssystem mit großer Vorsicht behandelt werden.

Man sollte dem UKMO gratulieren für die Anmerkung, dass „…Schlussfolgerungen aus Perioden mit großen Änderungen in einem Beobachtungssystem mit großer Vorsicht behandelt werden müssen“. Aber dabei war es um den oberen Ozean gegangen. Weiter heißt es dort (Fettdruck von mir):

Messungen des Wärmegehaltes in tieferen Ozeanschichten sind viel weiter gestreut und daher weniger gewiss. Mittels einer Kombination von Satelliten- und Ozeanmessungen bis zu einer Tiefe von 1800 m schätzen Loeb et al. 2012, dass das System Erde von 2001 bis 2010 Energie mit einer Rate von 0,5±0,4W/m² akkumuliert hat, ähnlich den 0,4 W/m² von 2005 bis 2010 bis zu einer Tiefe von 1500 m durch ARGO-Bojen allein (von Schuckman und Le Traon 2011). Reanalysen3 der Ozeandaten zeigen im Zeitraum von 2000 bis 2010 eine mittlere Erwärmungsrate um 0,9 W/m² gemittelt über den Globus, wobei 30% der Zunahme unter 700 m stattfand (Balmaseda et al. 2013). Wir folgern daraus, dass das System Erde weiterhin eine substantielle Menge an Wärme während der letzten 15 Jahre angesammelt hat, trotz des Stillstands der Erwärmung.

Die Fehler bei Balmaseda et al. 2013 haben wir bereits in zahlreichen Beiträgen während der letzten Monate angesprochen. Siehe hier, hier, hier, hier und zuletzt hier unter der Überschrift Balmaseda et al. 2013.

Fußnote 3 beim UKMO lautet:

Ozeananalysen verwenden ein globales Ozeanmodell angetrieben durch historische Schätzungen der Winde, Wärme und Frischwasser-Flüsse, um historische Beobachtungen des Ozeans zu synthetisieren mit einer ganzen Reihe von Methoden wie Datenassimilationen, um historische Änderungen des Zustands der Ozeane zu rekonstruieren.

Und die von Balmaseda et al. 2013 verwendete Reanalyse war das ORAS4 durch das Europäische Zentrum für Mittelfristige Wettervorhersage ECMWF. Auf der Website des ECMWF gibt es zu ORAS4 mehr Informationen. Es enthält die folgende Gegenerklärung (Fettdruck von mir):

Es gibt große Unsicherheiten in den Produkten ozeanischer Reanalysen (vor allem bei den Transporten), die schwierig zu quantifizieren sind. Zielgruppe dieser Websites ist die Forschungsgemeinschaft. Jedes außergewöhnliche Klimaereignis sollte weiter gehend untersucht (sic) und nicht als Wahrheit angesehen werden.

Diese einfache Tatsache findet in der UKMO-Studie keinerlei Beachtung, als ob Balmaseda et al. 2013 lediglich ein Evangelium verkünden.

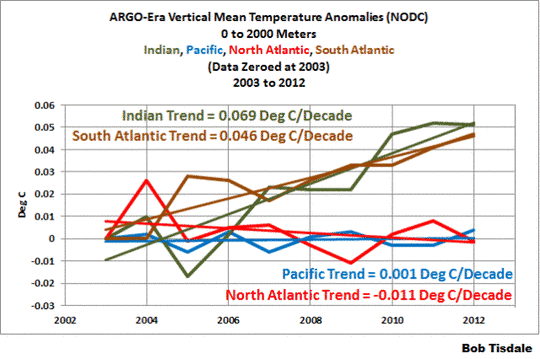

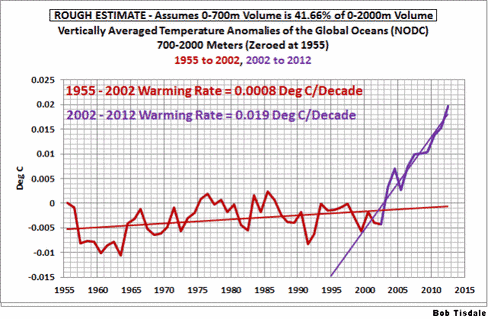

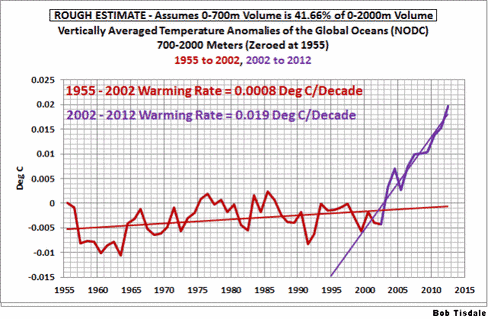

Oben habe ich dem UKMO zum Einräumen von Problemen gratuliert, die bei großen Änderungen des Beobachtungssystems auftreten, als der ozeanische Wärmegehalt für die oberen Schichten der Ozeane besprochen worden ist. Jetzt scheint es so, als hätten sie das vergessen, wenn sie die Daten bis zu einer Tiefe von 2000 Metern übernehmen. In diesem Beitrag haben wir vor Kurzem gezeigt, wie die Temperaturen unterhalb der Oberfläche in Tiefen zwischen 700 und 2000 Metern kaum einen langzeitlichen Trend von 1955 bis 2002 zeigen. Siehe Abbildung 11. Dann, kaum waren die ARGO-Bojen installiert, sind die Temperaturen dort in die Höhe geschossen. Man erinnere sich auch daran, dass die ARGO-Daten adjustiert werden mussten, um Erwärmung zu zeigen.

Die Änderung im Beobachtungssystem scheint einen sehr starken Einfluss auf die Messungen der Temperaturen in Tiefen zwischen 700 und 2000 m gehabt zu haben, aber es scheint, dass das UKMO diesen Einfluss übersehen will, weil die Daten ihre Mutmaßungen stützen.

Dann stellt das UKMO das Ungleichgewicht von Strahlung zur Diskussion:

Der Meeresspiegel kann ebenfalls benutzt werden, um den ozeanischen Wärmegehalt zu belegen. Wie früher schon besprochen erfordert der Stillstand der mittleren globalen Erwärmung entweder eine Reduktion des Energie-Inputs auf den Planeten um etwa 0,6 W/m² oder die Speicherung dieser Energiemenge innerhalb des Ozeans. Falls eine zusätzliche Erwärmung von 0,6 W/m² tatsächlich im Ozean gespeichert wird, würde dies thermosterisch (thermische Ausdehnung) den Meeresspiegel um 1,2 mm/Jahr steigen lassen unter der Voraussetzung, dass sich die gesamte Wärmemenge in den oberen 700 m sammelt. Diese Zahl wäre kleiner, falls ein Teil dieser Wärme in Tiefen unter 700 m herunter gemischt wird, wo der Ausdehnungskoeffizient kleiner ist.

Das vermutete Strahlungs-Ungleichgewicht an der Oberfläche war jüngst auch Gegenstand einer Studie von Stephens et al. 2013 mit dem Titel An update on Earth’s energy balance in light of the latest global observations. Siehe ihre Abbildung 1. Sie illustrieren ein Ungleichgewicht von 0,6 W/m² an der Oberfläche mit einer geschätzten Fehlerbreite von ± 17 W/m². Hier wird klar, warum das UKMO diese Unsicherheit nicht angesprochen hat.

Das UKMO kommt dann zu einer erstaunlichen Schlussfolgerung aus diesem Abschnitt. Mit unglaublicher Selbstsicherheit stellen sie fest:

Zusammengefasst zeigen Beobachtungen des ozeanischen Wärmegehaltes und des Anstiegs des Meeresspiegels, dass die Erde weiterhin Wärmenergie während der letzten 15 Jahre absorbiert hat und dass diese zusätzliche Wärme in den Ozeanen absorbiert worden ist.

Sie haben jedoch nichts präsentiert, was ihre Sicherheit stützen würde.

UKMO hält den Mythos am Leben

Alles in allem pflegt das UKMO weiter den Mythos, dass nur ein vermutetes Energie-Ungleichgewicht, verursacht durch anthropogene Treibhausgase, die Erwärmung der globalen Ozeane erklären kann, während die Daten aufgeteilt in logische Untergruppen darauf hindeuten, dass menschliche Treibhausgase keine sichtlichen Auswirkungen auf die Erwärmung der globalen Ozeane hatten. Wenn das für Sie neu ist, schauen Sie hier: „The Manmade Global Warming Challenge” (42MB).

Schlussbemerkungen

Allgemein gesagt hat das UKMO zahlreiche Datensätze gezeigt in dem Bemühen zu belegen, dass die globale Erwärmung theoretisch weitergeht, selbst wenn sich die Temperaturen nicht mehr erwärmen. Kümmert sich die allgemeine Öffentlichkeit um die Temperatur in den globalen Ozeanen unter 2000 m? Nein. Kümmert sie sich um Strahlungs-Ungleichgewichte? Nein. Die Leute kümmern sich um die Temperaturen und den Niederschlag in ihren Wohngebieten. Und wenn diese Leute an den Küsten leben, kümmern sie sich um den Meeresspiegel. Und der ist vielleicht die größte Sorge. Aber der Meeresspiegel wird weiterhin steigen, egal was wir hinsichtlich von Treibhausgasen unternehmen. Spricht das UKMO dies an? Nein. Dann haben sie die Leute um die Steuergelder betrogen, die sie zur Durchführung dieser Forschungen erhalten haben.

Im letzten Absatz im 2. Teil des UKMO-Berichtes zum Stillstand der Erwärmung heißt es (Fettdruck von mir):

Die wissenschaftlichen Frage, die durch den gegenwärtigen Stillstand der globalen Erwärmung aufgeworfen werden, verlangen von uns, die Energieflüsse zur Erde und von der Erde weg sowie um die Erde herum viel besser zu verstehen. Gegenwärtige Beobachtungen sind nicht detailliert oder lang genug, um definitive Antworten hinsichtlich der Gründe des jüngsten Stillstands zu liefern. Darum können wir den Energiehaushalt der Erde nicht schließen. Es gibt wesentliche wissenschaftliche Herausforderungen, die die Forschungsgemeinschaft derzeit verfolgt. Dabei wird mittels einer Kombination von Theorie, Modellen und Beobachtungen erkundet und experimentiert.

Mit anderen Worten, auf der Basis der begrenzt verfügbaren Daten versteht das UKMO nicht den Grund (oder die Gründe) für den Stillstand der globalen Erwärmung, und das zeigt sehr deutlich, dass sie den Grund der Erwärmung von Mitte der siebziger Jahre bis zum Jahr 2000 nicht verstehen – während einer Zeit also, als die Datenlage noch unsicherer war.

Link: http://wattsupwiththat.com/2013/07/30/part-2-comments-on-the-ukmo-report-the-recent-pause-in-global-warming/

Übersetzt von Chris Frey EIKE