IPCC ertappt: der neue AR 5 enthält einen alten, bekannten und nicht korrigierten Fehler

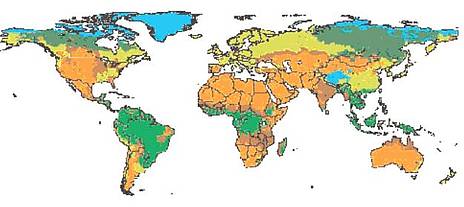

Unter der Voraussetzung einer CO2-Verdoppelung erwarten sie, dass sich der tropische Waldgürtel ostwärts bewegen soll nach Minnesota, Wisconsin, Iowa und Illinois und sich sogar noch weiter östlich bis Ohio, Michigan und Pennsylvania erstrecken soll.

Schaue ich auf meinen eigenen Teil der Welt, sehe ich, dass das IPCC Papua-Neu-Guinea, Indonesien und die Philippinen gegenwärtig als mit Savannen, Trockenwäldern und Forsten bedeckt listet. Aber mit einer globalen CO2-Verdoppelung werden sich die Prärien Südostasiens nordwärts nach Malaysia, Vietnam, Laos, Myanmar und selbst Südchina ausweiten.

In Indien sind der folgenden Karte zufolge 70% seines Gebietes mit Tropenwäldern bedeckt. Aus irgendwelchen Gründen bewegt sich der Tropenwaldgürtel des IPCC von Nordaustralien (die meisten Australier glauben, dass es sich dabei um Gummibaum-Landschaften handelt) um etwa 1000 km nach Süden, so dass Touristenorte wie Cairns und Townsville plötzlich von Gummibaum-Vegetation à la Kongo umgeben und damit geeignet sind für den Import von Bonobos und vielleicht Okapis.

Betrachtet man Südamerika, dann wird der Amazonas-Regenwald schon jetzt auf mysteriöse Weise vom IPCC in Savannen verwandelt, die sich bei einer CO2-Verdoppelung über die gesamte obere Hälfte von Südamerika ausbreiten sollen. http://www.quadrant.org.au/blogs/thomas/2013/08/spot-the-error-the-ipcc-can-t – _edn2

Es ist eine merkwürdige alte IPCC-Welt. Ein Fehler vielleicht? Mitnichten! All diese Angaben finden sich bereits im hoch wichtigen Synthese-Bericht aus dem Jahr 1995, wo sich das IPCC zum ersten Mal für eine „wahrnehmbare“, vom Menschen verursachte globale Erwärmung entschieden hatte.

Das IPCC listet Tropenwälder auch in Nord- und Süd-Dakota sowie Teilen des Mississippi-Tales.

Auf die Waldverrücktheit des IPCC wurden die IPCC-Experten zumindest während der letzten sechs Jahre immer wieder hingewiesen. Der erste Vorsitzende des IPCC war Bert Bolin (von 1988 bis 1997). Im Jahre 2007 schrieb er in einer Fußnote seines Buches A History of the Science and Politics of Climate Change: The Role of the IPCC (S. 253):

„Als Kuriosität ist es vielleicht interessant, dass in Abbildung 2 der ‚Zusammenfassung für Politiker’ der Arbeitsgruppe 11 (1995) ein wesentlicher Fehler steckt, nämlich eine Verwechslung der Öko-Systeme ‚Savanne’, ‚Trockenwälder’, ‚Forsten’ und Tropenwälder’. Aber ich habe bisher nicht gesehen, dass dieser Fehler irgendwo in den IPCC-Veröffentlichungen korrigiert worden wäre“.

Ich bin Anfang des vorigen Jahres über diese Fußnote gestolpert, als ich einen Beitrag über die Ursprünge des IPCC für meinen Blog Quadrant geschrieben habe. Ich schaute in die Karten des IPCC, und siehe da, auch fünf Jahre nach Bolins Aufforderung zur Korrektur waren sie nicht verändert worden.

Also schrieb ich im Februar 2012 an Renate Christ, die IPCC-Sekretärin in der Schweiz, wobei ich sorgfältig dem Reglement für eine Beschwerde folgte, die in einem IPCC-Prozedere zur Fehlerkorrektur im Jahre 2011 umrissen worden war.

Ein Fehler in einem ‚Synthese-Bericht’ muss spezielle Alarmglocken beim IPCC zum Klingen bringen. Die Verantwortung verbleibt dem Protokoll zufolge beim IPCC-Vorsitzenden (Dr. Pachauri) höchstpersönlich. Sowohl er als auch die Vize-Vorsitzenden der relevanten Arbeitsgruppe zur Zeit der Zustandsbeschreibung „müssen angemessen über die Entwicklung und die Teilnahme auf dem Laufenden gehalten werden“.

Die Details des Protokolls sind sogar noch strikter: Alle Vorsitzenden der Arbeitsgruppen und das Exekutiv-Komitee müssen involviert werden. Diese wiederum könnten genötigt sein, ihre Vorgänger dazu zu befragen.

Ich war hoch erfreut, innerhalb von 48 Stunden später via E-Mail eine Antwort von Jonathan Lynn erhalten zu haben, dem Vertreter der abwesenden Dr. Christ.

„Vielen Dank, dass Sie uns daran erinnern, dass wir uns damit befassen müssen.

Auf den ersten Blick sieht es ziemlich geradlinig aus, aber es ist ein wenig schwierig für unsere internen Prozesse, weil ein alter Bericht involviert ist, deren Arbeitsgruppen schon lange aufgelöst worden sind.

Dennoch habe ich Ihren Einwand an unser Exekutiv-Komitee weitergeleitet (in dem auch Dr. Pachauri sitzt), und ich versichere Ihnen, dass daran gearbeitet wird.

Freundliche Grüße, Jonathan Lynn“

Wunderbar! Außer dass ich mir eineinhalb Jahre später, am 18. August 2013, die Karten erneut angeschaut habe, und erneut hatte sich nichts geändert, trotz selbst Dr. Pachauris und seines Exekutiv-Komitees besonderer Aufmerksamkeit bzgl. dieser Angelegenheit. Vielleicht wird es nicht als prioritär angesehen, einen Fehler zu korrigieren, den der Ex-Vorsitzende des IPCC Bert Bolin als einen „wesentlichen“ Fehler beschrieben hat?

Ich fürchte, dass dies ein weiterer Fall dessen ist, was die kanadische Journalistin Donna Laframboise in ihrem Buch Delinquent Teenager über das IPCC beschrieben hat: Das IPCC sagt etwas und macht das Gegenteil. http://www.quadrant.org.au/blogs/thomas/2013/08/spot-the-error-the-ipcc-can-t – _edn3[3] Nur mal als Beispiel: Das IPCC verlangt von seinen Autoren, dass alle nicht begutachteten Referenzen für den Bericht 2007 als solche gekennzeichnet werden müssen. Als der Bericht dann erschienen war, hat Laframboise nachgezählt. Von den 5587 nicht begutachteten Referenzen waren gerade mal insgesamt sechs oder 0,1% davon als solche gekennzeichnet.

Das Fehlerprotokoll des Jahres 2011 erwuchs aus der aggressiv falschen Reaktion von Dr. Pachauri auf den IPCC-Fauxpas der schmelzenden Himalaya-Gletscher im Jahr 2007. Diese Gletscher sollten der Vorhersage zufolge bis zum Jahr 2035 abgeschmolzen sein und eine halbe Milliarde durstiger Asiaten hinterlassen.

Pachauri (der von sich sagt, dass er zwei PhD habe, obwohl es in Wirklichkeit nur einer ist) hat im Jahre 2009 ursprünglich den Beschwerdeführer hinsichtlich der Himalaya-Gletscher diffamiert [4]. Diese Person war Vijay Raina, ein bedeutender indischer Glaziologe. Pachauri hat Raina vorgeworfen, ‚Voodoo-Wissenschaft’ und ‚Zauberei’ auszuüben und weitere unhaltbare Vorwürfe. Er fügte hinzu, dass es dem Glaziologen nicht zukomme, eine solche Frage so einer bedeutsamen Institution wie dem IPCC vorzulegen [5].

Pachauri hat offensichtlich die kurze entsprechende Passage gar nicht gelesen, obwohl die schlechte Arithmetik und zweifelhafte Herkunft (Gerüchte, die von der Aktivistengruppe Worldwide Fund for Natur recycelt worden waren) für sich selbst sprachen. Tatsächlich mussten auf der einen Seite mit den Himalaya-Gletschern im Bericht 2007, die aus 497 Wörtern bestand, neun unterschiedliche Fehler korrigiert werden [6].

Pachauris Gehässigkeit war zu viel für die ehrenwerte wissenschaftliche Gemeinschaft, und innerhalb weniger Monate wurde er dazu gezwungen, dem Inter Academy Council IAC, einer internationalen Spitzen-Wissenschaftsagentur, hinsichtlich prozessualer Reformen im IPCC Rede und Antwort zu stehen, um weitere Fehler und damit den Verlust an Glaubwürdigkeit zu vermeiden.

Der IAC berichtete im August 2010, dass als Folge des Himalaya-Unsinns und Klimagate 1 „das öffentliche Vertrauen in die Klimawissenschaft abgenommen hat“ [7]. Aber, fügte er hastig hinzu, weder der Himalaya-Fauxpas noch Klimagate 1 unterminierten die wesentlichen Ergebnisse über die globale Erwärmung, verursacht vom Menschen. (Seine Quelle für diese Schlussfolgerung war niemand anders als der Integritäts-Spezialist Peter Gleick, der später, Anfang 2012, zugegeben hat, auf betrügerische Weise an interne Dokumente einer konservativen US-Denkfabrik gekommen zu sein, nämlich dem Heartland Institute) [8].

Zur Korrektur von Fehlern sagte der IAC: „Die Herausforderung bzgl. Kommunikation hat neue Dringlichkeit erhalten in der Folge jüngster Kritiken an den langsamen und unangemessenen Antworten des IPCC auf berichtete Fehler im 4. Zustandsbericht 2007. Diese Kritik unterstreicht die Notwendigkeit von Beziehungen zu Medien, um es dem IPCC zu ermöglichen, rasch und in angemessener Weise auf Kritik und Sorgen zu antworten, die in einem solchen umstrittenen Bereich zwangsläufig auftauchen“ [9].

Als Folge dieser Kritik des IAC hat die maßgebliche IPCC-Abteilung auf ihrer Sitzung im Mai 2011 in Abu Dhabi ein detailliertes und großartiges 12-seitiges Protokoll und Flussdiagramme zur Fehlerkorrektur herausgegeben [10]. Darin findet sich u. A.:

„Wenn der Fehler in einem Synthese-Bericht auftaucht, liegt die Verantwortung beim augenblicklichen IPCC-Vorsitzenden.

Zu Beginn des Prozesses wird der Beschwerdeführer vom IPCC-Sekretariat über die nächsten Schritte informiert … Der Beschwerdeführer wird nochmals über die Ergebnisse dieses Prozesses informiert.

Errata werden auf den Websites des IPCC, der Arbeitsgruppen oder der Task Force nach dem Ende des Prozesses aufgelistet. Eine kurze Erklärung über den Fehler kann ebenfalls gepostet werden“.

Nun, als gutgläubige IPCC-Fehler-Spürnase wurde ich vor 18 Monaten wirklich über die ‚nächsten Schritte’ informiert. Aber der Prozess, die grünen und braunen Kästen auszutauschen ist bislang nicht durchgeführt worden.

Vielleicht haben die IPCC-Experten einen hinterhältigen Sinn für Humor, und ihre Berichte sind ein raffinierter praktischer Witz. In diesem Falle hätte ich Tomaten vor den Augen; ich bin so verdammt vertrauensselig.

###

References:

[1] http://www.trust.org/item/20130816133815-ao2wt/?source=hptop

[2] http://www.ipcc.ch/pdf/climate-changes-1995/ipcc-2nd-assessment/2nd-assessment-en.pdf p31, maps

[3] http://www.amazon.com/Delinquent-Teenager-Mistaken-Climate-ebook/dp/B005UEVB8Q

[4] http://www.quadrant.org.au/magazine/issue/2012/3/the-fictive-world-of-rajendra-pachauri

[5] http://www.youtube.com/watch?v=bnYmQjFoNCs

[6] ibid

[7] http://www.interacademycouncil.net/File.aspx?id=27672 p2

[8] http://science.time.com/2012/02/20/climate-expert-peter-gleick-admits-deception-in-obtaining-heartland-institute-papers/

[9] http://www.interacademycouncil.net/24026/26050/27665.aspx p2

[10] https://www.ipcc.ch/pdf/ipcc-principles/ipcc_error_protocol.pdf

=================================================================== Aktualisierung: Das IPCC antwortet

Ich schreibe in Bezug auf Ihren Beitrag vom 19. August, der von Tony Thomas übermittelten Story, in der Sie ansprechen, dass das IPCC laut Hinweis von Tony Thomas noch nicht einen Fehler korrigiert hat.

Das ist falsch, und ich möchte gerne die Fakten für Ihre Leser nennen:

Als wir den Brief von Tony Thomas am 8. Februar 2012 erhalten haben, wurde erkannt, dass es einen typographischen Fehler in der Summary for Policymakers der Arbeitsgruppe II im zweiten Zustandsbericht 1995 gibt. Eine Korrektur mit Datum vom 9. März 2012 wurde ausgegeben und kann hier gefunden werden:

http://www.ipcc.ch/ipccreports/sar/sar_syr_errata.pdf (…)

Wir haben Tony Thomas am 20. September 2012 geschrieben und ihn hierüber informiert. Eine Kopie dieser E-Mail folgt hier:

Jonathan Lynn, Head of Communications, IPCC

Sehr geehrter Herr Tony Thomas,

mit Bezug auf Ihre E-Mail vom 9. Februar 2012 informieren wir Sie, dass wir den gemäß der IPCC-Richtlinien zum Umgang mit möglichen Fehlern in den IPCC-Zustandsberichten, Synthese-Berichten, Sonderberichten oder methodischen Berichten den Prozess in Gang gesetzt haben. Wir möchten Ihnen mitteilen, dass die Arbeitsgruppe II des IPCC die Analyse der in Ihrer E-Mail vom 8. Februar 2012 angesprochenen Punkte abgeschlossen hat. Am 8. März 2012 hat das Büro der Arbeitsgruppe II festgelegt, dass man tätig werden müsse und dass der Fehler als ein typographischer Fehler betrachtet werden müsse wie in Abschnitt 2, Schritt 4A in den Richtlinien bestimmt. Vielen Dank, dass Sie uns darauf aufmerksam gemacht haben.

…

Mit freundlichen Grüßen, IPCC-Sekretariat

2. Aktualisierung:

Ich habe mit folgender E-Mail darauf geantwortet. Dafür erhielt ich ein Standard-Dankeschön, aber keine Antwort auf meine Frage. – Anthony

Sehr geehrter Mr. Lynn,

ich habe ihre Korrektur am Ende des Beitrags angefügt, vielen Dank dafür. Es scheint wie ein möglicher Fall der nicht perfekten Natur des Internets, was ab und zu dazu führt, dass Sendungen verloren gehen oder im Spam-Filter landen.

In dieser Hinsicht: Haben wir die Entschuldigung von Dr. Pachauri an die Klimaskeptiker in der ganzen Welt für seine „Voodoo-Wissenschaft“ hinsichtlich der Behauptung des Abschmelzens der Himalaya-Gletscher bis zum Jahr 2035 verpasst? Siehe hier: http://wattsupwiththat.com/2012/02/09/ipccs-pachauris-voodo-science-claim-comes-full-circle/

Vielen Dank für Ihr Interesse.

Anthony Watts, WUWT

3. Aktualisierung: Antwort von Tony Thomas:

Wie es manchmal so geht, habe ich meine E-Mail-Adresse von einem australischen Provider am 18. September 2012 zu gmail gewechselt. Jonathan Lynn vom IPCC hat mir am 20. September 2012 geantwortet, zweifellos an meine ehemalige E-Mail-Adresse. Ich habe keinen Beleg für ihren Empfang. In der Rückschau war mein Beitrag ein wenig zu harsch in Bezug auf das IPCC. Mein Check bestand aus der Untersuchung der IPCC-Karten aus dem Jahr 1995 und dem Synthese-Bericht, um zu sehen, ob es Beweise für eine Korrektur gebe. Es gab keine.

Der ehemalige IPCC-Vorsitzende Bert Bolin beschrieb die Karten als einen ‚wesentlichen Fehler’ und nicht als einen typographischen Fehler. Darum habe ich angenommen, dass es irgendeine Änderung oder Aufmerksamkeit geben würde.

Ich bin auch verwirrt, dass trotz der Klagen des IAC über die Verzögerungen bei Antworten des IPCC auf Fehlerhinweise dieser IPCC-Prozess immer noch sehr langsam zu sein scheint. Ich habe mich darüber am 9. Februar 2012 beklagt. Die Arbeitsgruppe II des IPCC wurde am 8. März 2012 aktiv. Und doch dauerte es bis zum 20. September, also ein halbes Jahr, bis ich darüber in einer E-Mail informiert worden bin.

Also ist das Ganze ein schlimmer gewordenes kleines Durcheinander. [So the story is really one of compounding small snafus.]

1. Die Beschriftung der Karte wird 1995 umgekehrt.

2. Bert Bolin beklagt sich im Jahre 2007 über einen nicht korrigierten „wesentlichen Fehler“.

3. Ich habe mich auch über diesen Fehler beschwert, und zwar Anfang 2012.

4. Irgendeine Panne in den Büros des IPCC führt zu einer Verzögerung von sechs Monaten, bis man mir antwortet. Die Antwort verschwindet dann im E-Mail-Äther.

5. Die Karten wurden nicht geändert.

6. Ich habe dem IPCC im August 2013 eine harte Mail geschickt.

7. Verletzte Gefühle allerorten.

Link: http://wattsupwiththat.com/2013/08/19/ipcc-caught-with-an-old-uncorrected-error-in-new-ar5-report/

Übersetzt von Chris Frey EIKE