In einem Tweet im Namen von Präsident Obama war unterstellt worden, dass die frühere betrügerische Studie von Cook und anderen eine Bestätigung von 97% für die Gefährlichkeit des Klimawandels gefunden habe:

„97% Prozent der Wissenschaftler stimmen zu: die Klimaänderung ist real, vom Menschen verursacht und gefährlich“ (Hervorhebung hinzugefügt)

Die neue Studie durch den führenden Klimatologen Dr. David Legates und seine Kollegen wurde in dem angesehenen Journal Science and Education veröffentlicht und enthüllt, dass Cook nicht in Betracht gezogen hat, ob die Wissenschaftler in ihren veröffentlichten Studien gesagt haben, die Klimaänderung sei „gefährlich“.

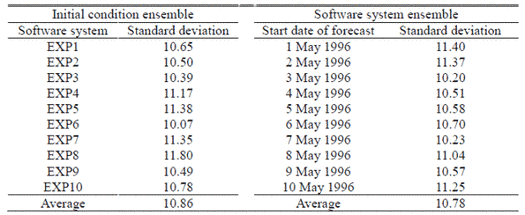

Der von Cook angeführte Konsens bestand aus der Standard-Definition: dass der Mensch das meiste der Erwärmung nach 1950 verursacht hat. Selbst unter dieser schwächeren Definition unter den veröffentlichten wissenschaftlichen Studien betrug der Konsens nicht 97,1%, wie Cook behauptet hat, sondern nur 0,3%.

Nur in 41 der 11944 veröffentlichten Klimastudien, die Cook explizit untersucht hat, wurde behauptet, dass der Mensch den größten Teil der Erwärmung seit 1950 verursacht hat. Cook selbst hat 64 Studien angeführt, die diesen Konsens explizit stützen, obwohl 23 dieser 64 Studien das gerade nicht getan hatten.

Dieses Schock-Ergebnis kommt knapp vor der Herausgabe des 5. IPCC-Zustandsberichtes, in dem ein „Vertrauen von 95%“ in den vorgestellten Konsens behauptet wird. Der neuen Studie zufolge ist dies imaginär.*

[*Der Absatz enthält ein unübersetzbares Wortspiel und folgt daher hier im Original: This shock result comes scant weeks before the United Nations’ climate panel, the IPCC, issues its fifth five-yearly climate assessment, claiming “95% confidence” in the imagined – and, as the new paper shows, imaginary – consensus.]

Die neue Studie mit dem [etwas sperrigen] Titel ‚Climate Consensus and ‘Misinformation’: a Rejoinder to ‘Agnotology, Scientific Consensus, and the Teaching and Learning of Climate Change’ weist entschieden Ergebnisse von Cook und anderen zurück, dass diejenigen, die sagen, dass nur wenige Wissenschaftler explizit den fast einstimmigen Klimakonsens stützen, die Öffentlichkeit falsch informieren und in die Irre führen.

Dr. Legates: „Es ist erstaunlich, dass irgendein Journal eine Studie veröffentlichen konnte, in der ein Konsens von 97% behauptet wird, wenn der eigenen Analyse des Autors zufolge der wirkliche Konsens weniger als 1% betragen hat. Es ist noch erstaunlicher, dass das IPCC eine Sicherheit von 95% hinsichtlich des Klimakonsens’ behaupten kann, wenn nur ein so kleiner Teil der veröffentlichten Studien diesen Konsens, wie ihn das IPCC definiert, untermauert“.

Dr. Willie Soon, ein angesehener Solarphysiker, zitierte den Wissenschaftsautor Michael Crichton mit den Worten: „Wenn es Wissenschaft ist, gibt es keinen Konsens. Wenn es Konsens ist, ist es keine Wissenschaft“. Soon fügte hinzu: „Seit nunmehr fast 17 Jahren gab es keine globale Erwärmung mehr. Keines der ‚Konsens’-Computermodelle hat das vorhergesagt“.

Dr. William Briggs, „Statistician to the Stars” [?], sagte: „in jeder Erhebung nach Art von Cook ist es ganz wichtig, die Fragen sehr klar zu formulieren. Und doch hat Cook drei separate Definitionen des Klimakonsens’ wirr durcheinander verwendet. Auch schloss er 8000 der 12000 betrachteten Studien willkürlich aus, und zwar mit der inakzeptablen Begründung, dass sie hinsichtlich des Klimakonsens’ keine Meinung äußern. Diese Kunstgriffe ließen ihn zu der ungerechtfertigten Schlussfolgerung kommen, dass es einen Konsens von 97,1% gegeben hat, obwohl das gar nicht stimmt.

Tatsächlich bietet Cooks Studie den klarsten verfügbaren statistischen Beweis, dass es kaum irgendeine explizite Unterstützung unter den Wissenschaftlern für den Konsens gibt, den das IPCC, Politiker, Bürokraten, Akademiker und die Medien so lange und so falsch proklamiert haben. Das war nicht das Ergebnis, das sich Cook erhofft hatte, und es entsprach nicht dem Ergebnis, dass er in seiner Studie behauptet hat, aber es entsprach dem Ergebnis, das er wirklich herausbekommen hatte“.

Christopher Monckton of Brenchley, Experten-Begutachter für den 5. Zustandsbericht, der die Fehler in Cooks Daten entdeckt hatte, sagte: „Es kann sein, dass mehr als 0,3% der Wissenschaftler glauben, dass der Mensch für mindestens die Hälfte der Erwärmung seit 1950 verantwortlich ist. Aber nur in 0,3% der 12000 Studien kommt das auch explizit zum Ausdruck. Cook hat nicht berücksichtigt, wie viele Studien das auch nur implizieren. Zweifellos halten viele Wissenschaftler das für möglich, so wie wir es tun, dass der Mensch für etwas, aber nicht den größten Teil der Erwärmung verantwortlich ist.

Es ist unwissenschaftlich anzunehmen, dass die meisten Wissenschaftler das glauben, was sie weder gesagt noch geschrieben haben“.

###

Die Studie: Climate Consensus and ‘Misinformation’: A Rejoinder to Agnotology, Scientific Consensus, and the Teaching and Learning of Climate Change

David R. Legates, Willie Soon, William M. Briggs, Christopher Monckton of Brenchley

http://link.springer.com/article/10.1007/s11191-013-9647-9

Abstract

Nichtwahrnehmung [Agnotology] ist das Studium des Aufkommens von Ignoranz mittels der Verbreitung von Fehlinformation, die darauf abzielen, in die Irre zu führen. Legates et al. (Sci Educ 22:2007–2017, 2013) haben die Anwendbarkeit von Agnotology in politisch gefärbten Diskussionen in Frage gestellt. In ihrer Antwort haben Bedford und Cook (Sci Educ 22:2019–2030, 2013) danach getrachtet, Agnotology in der Klimawissenschaft anzuwenden, indem sie versichern, dass Interessen fossiler Treibstoffe Zweifel geweckt haben hinsichtlich eines Klimakonsens’. Ihre Definition von Klima-‚Fehlinformation’ war vielleicht angebracht für die postmodernen Hypothesen, dass wissenschaftliche Wahrheit mit der Messung eines Konsens’ unter den Experten feststellbar ist und dass ein fast einstimmiger Konsens existiert. Allerdings hat die Untersuchung einer Behauptung von Cook et al. (Environ Res Lett 8:024024, 2013) über einen Konsens von 97,1%, die sich stark auf Bedford und Cook stützt, nur eine Unterstützung von 0,3% für die Standarddefinition eines Konsens’ergeben: dass nämlich die meiste Erwärmung seit 1950 anthropogener Natur ist.

Agnotology ist also ein zweischneidiges Schwert, da jede Seite in der Diskussion behaupten kann, dass generelle Ignoranz aus Fehlinformationen stammt, die vermeintlich von der anderen Seite lanciert worden waren. Wichtige Fragen über anthropogene Einflüsse bleiben aber bestehen. Daher haben Legates et al. in geeigneter Weise vermutet, dass parteiische Präsentationen von Kontroversen die Diskussion abwürgen und in der Bildung keinen Platz haben.

================================================================

Aktualisierung: Studie von Cook und Nuccitelli abgelehnt:

Bishop Hill schreibt:

Die Benestad-Studie (Cook, Nuccitelli) über „Agnotology“, eine bizarre Erfindung, die zum Ziel hat, praktisch jede jemals geschriebene skeptische Studie zu widerlegen, ist von Earth System Dynamics (ESD) abgelehnt worden:

„Basierend auf Begutachtungen und meiner eigenen Lesart der Original- und der überarbeiteten Studie lehne ich die Studie in ihrer jetzigen Form ab. Die Einreichung ist löblich hinsichtlich der Ziele und der Verfügbarkeit des R source code [?], aber davon abgesehen gibt es kaum etwas, das als wissenschaftlicher Beitrag bei ESD fungieren könnte. Während ich glaube, das eine ESD-Veröffentlichung zumindest eine Diskussion der R-Routines [?] hätte auslösen und die Aufmerksamkeit vieler interessierter Gemeinden hätte gewinnen können, ist das Manuskript selbst unpassend für dieses Journal und bräuchte wesentliche weitere Überarbeitungen, bevor es für dieses Journal in Betracht kommt (wenn überhaupt).

Link: http://wattsupwiththat.com/2013/09/03/cooks-97-consensus-disproven-by-a-new-paper-showing-major-math-errors/

Erster Kommentar unter dem Original: Die Aussage ‚wenn es Konsens ist, ist es keine Wissenschaft’ sagt alles!

Übersetzt von Chris Frey EIKE