Spätestens in 2030 gehen in Deutschland die Lichter aus, da die sichere Stromerzeugungkapazität zum Ausgleich der Schwankungen über die Stromerzeugung über Wind und Sonne nur in Ansätzen ausreicht, es sei denn, es werden Stromspeicher mit einer täglichen Kapazität von 22 Gigawatt (GW) als Jahresmittelwert zur Verfügung gestellt (entsprechend etwa 79 Pumpspeicherwerke der Goldisthalgröße).

Ebenso bleibt die Wunschvorstellung der „Dekarbonisierung“ in 2050 eine Fata Morgana ohne eine tägliche erforderliche Stromspeicherkapazität von 31 GW als Jahresmittelwert (bei diesem täglichen Speicherbedarf erübrigt sich eine Betrachtung zum Speicherbedarf bei einer z.B. 14-tägigen Windflaute im Winter).

Der CO2-Gehalt in der Atmosphäre liegt z.Z. bei 400 ppm bzw. 0,0400%.

Durch die Energiewende in Deutschland könnte – wenn sie denn funktioniert – theoretisch der CO2-Gehalt der Atmosphäre um 0,13 ppm abgebaut werden bei natürlichen jährlichen Schwankungsbreiten der gemessenen CO2-Gehalte durch die Photosynthese zwischen 3 (Äquator-fern) und 20 ppm (Äquator).

Der kostenmäßige Aufwand für die Absenkung des CO2-Gehaltes im Rahmen der Energiewende von 0,13 ppm (0,000 013%) liegt bis 2025 bei 520 Mrd.€.

„Postfaktisch“ ist das Wort des Jahres 2016. Für die CO2-Hysterie seit den 1980er Jahren sowie die daraus resultierende Energiewende in 2000 kommt das Wort zu spät. Beides ist seit Anbeginn ein „Postfaktisches“ Desaster.

……………………………………………………………………………………………………………………

Basierend auf der Angst vor einem Weltuntergang durch einen hohen CO2-Austoß hat es in Deutschland zu diversen „Energiewenden“ geführt, nicht zuletzt auch, weil Deutschland ein Vorbild in der Weltgemeinschaft darstellen möchte (Ausrufung der „Dekarbonisierung“ durch Frau Merkel auf dem G7-Gipfel in Elmau in 2015).

Nun hat die Bundesregierung unter dem Begriff „Klimaschutzplan 2050“ für die Weltklimakonferenz in Marrakesch eine neue Energiewende kreiert, wobei wie bei allen bisherigen Energiewenden die Frage von Machbarkeit und Bezahlbarkeit auch nicht im Ansatz geprüft wurde, was erstaunlicherweise in unserer Gesellschaft nicht wahrgenommen wird, ein Aufschrei der Wissenschaft findet nur vereinzelt statt.

Vielmehr wird das Thema beherrscht von staatlich dotierten Klimawissenschaftlern, Politikern, Soziologen etc.

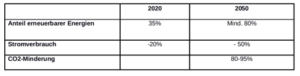

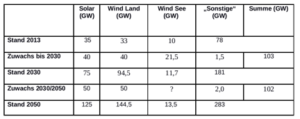

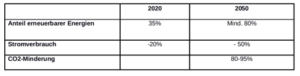

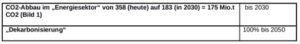

Im Folgenden sollen nun zunächst noch einmal rückblickend die letzten Energiewenden für den Bereich „Energiesektor“ mit ihren Zielen aufgeführt werden, um dann schließlich den „Klimaschutzplan 2050“ näher zu diskutieren:

a) „Energiewende 2010/2011“

b) „Energiewende 2014“

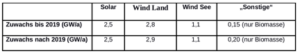

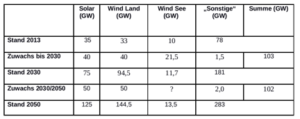

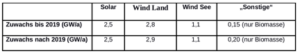

Stromerzeugungskapazitäten

(keine Angaben zu Wind See in 2030-2050)

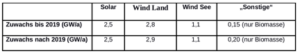

c) „Eckpunkte für die geplante Novelle des EEG“ (Beschluß am 08.06.2016) (1)

(Wind See 15 GW bis 2030)

(keine Begrenzung mehr für Solar mit 52 GW)

d) „Klimaschutzplan 2050“ (2)

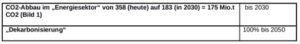

Bild 1 zeigt in einer Graphik die Zielsetzungen des „Klimaschutzplanes 2050“ für die einzelnen Bereiche in CO2-Äquivalenten.

Die Entwicklung der Abnahme der CO2-Äquivalente seit 1990 in Deutschland ist in Bild 2 dargestellt.

Nach Frau Hendricks ist dies das erste Regierungsdokument, das den Weg in ein weitgehend treibhausneutrales Deutschland in 2050 aufzeigt.

Auf die CO2-Einsparungen in anderen Wirtschaftszweigen soll hier nicht näher eingegangen werden.

Die o.g. Absenkung des CO2-Ausstoßes für den Energiesektor kann naturgemäß nur über eine Stilllegung von Kohlekraftwerken führen (worüber es noch Einwendungen in der Bundesregierung gibt), wofür dann ein Leistungs-entsprechender Ausbau der Stromerzeugung über Wind und Sonne erfolgen muß, da ein Zuwachs der Stromerzeugung über Biomasse etc. vernachlässigbar gering ist. (1)

Berechnung der still zu legenden Stromerzeugung über Kohlekraftwerke, um bis 2030 175 Mio. t CO2/a einzusparen

Der Abbau von 175 Mio.t CO2, der bis 2030 erfolgen soll, ist ein Mindestwert.

Bei Kenntnis des CO2-Ausstoßes von Kohlekraftwerken je erzeugter kWh kann nun die mit dem CO2-Abbau verknüpfte Stromerzeugung über Braunkohle- und Steinkohlekraftwerke errechnet werden:

Der CO2-Ausstoß schwankt je nach Wirkungsgrad der Kraftwerke zwischen

Braunkohlekraftwerke (BKK) 850-1200 g CO2/kWh Mittelwert: 1,1 kg/kWh

Steinkohlekraftwerke (SKK) 750-1100 g CO2/kWh Mittelwert: 0,9 kg/kWh

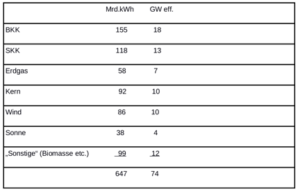

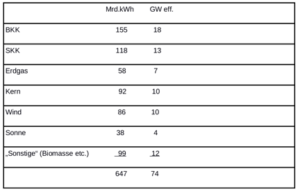

Nach dem BDEW lag die Bruttostromerzeugung in 2015 wie folgt:

Die Stromerzeugung über BKK +SKK liegt somit bei 273 Mrd.kWh/a.

Aus diesen Angaben errechnet sich dann ein CO2-Ausstoß von

BKK 155 x 1,1 = 171 Mio.t CO2

SKK 118 x 0,9 = 106 Mio.t CO2

277 Mio.t CO2

Um nun bis 2030 175 Mio.t CO2 einzusparen, liegt der erlaubte CO2-Ausstoß über Kohlekraftwerke in 2030 bei

277 – 175 – = 102 Mio. t.CO2

entsprechend einer Stromerzeugung über Kohlekraftwerke von

273 x 102/ 277 = 101 Mrd.kWh/a bzw. 101 000 GWh/a ,

d.h. es müssen

273 – 101 = 172 Mrd.kWh/a

über alternative Energien erzeugt werden.

Berechnung der zu installierenden Stromerzeugungskapazitäten über Wind und Sonne, um 172 Mrd. kWh/a in 2030 darstellen zu können

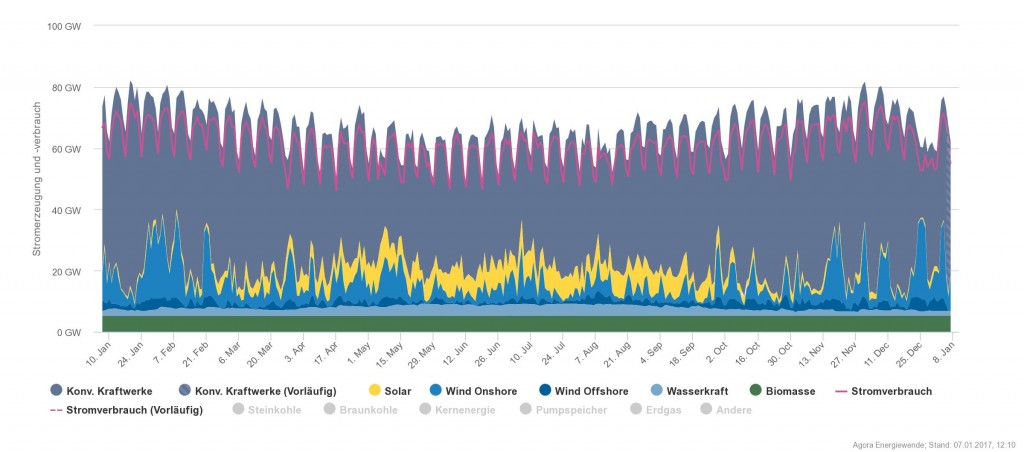

Bekanntlich schwanken die Stromleistungen über Wind und Sonne in weiten Grenzen praktisch zwischen null und ihren Nennleistungen. (3)

So überrascht es nicht, dass in den Jahren 2010-Juli 2016 die kleinsten Jahresleistungen für Wind zwischen 0,07 und 0,43 % bezogen auf die jeweilige Nennleistung (Viertelstundenwerte) schwanken. (4) Die höchsten Einspeisungen liegen bei etwa 80 % der Nennleistung (Bild 3).

Erschreckend niedrig ist auch der mittlere Beitrag der Windanlagen von lediglich 15,2 – 21,3 % (Mittelwert 17,7 %) im gleichen Zeitraum bezogen auf ihre Nennleistung. (4)

Die Schwankungen der mittleren Jahresleistungen über die Sonne liegen in den Jahren 2011-November 2016 zwischen 9,9 und 11% bezogen auf die jährlichen Nennleistungen mit einem Mittelwert von 10,4%, die Maximalwerte zwischen 65 und 77% (Bild 4). (5

Damit kann eine definierte mittlere Erzeugung von Strom über Wind und Sonne nur erzielt werden, wenn der über der mittleren nutzbaren Leistung anfallende Strom gespeichert werden kann, um ihn bei Werten unterhalb der mittleren nutzbaren Leistung wieder einspeisen zu können. (6,7) (vgl. auch Bild 5; hier wurden die unterhalb der mittleren nutzbaren Leistung anfallenden Werte in Ermangelung von Stromspeichern über Erdgas ausgeglichen). (8)

Mit diesen fluktuierenden Stromerzeugungsanlagen Wind und Solar müssen nun

172 Mrd. kWh/a oder 172 000 GWh/a erzeugt werden.

Im Klimaschutzplan 2050 sind keine Angaben zum Zuwachs an Biomasse etc. gemacht worden, der Zuwachs ist aber nach früheren Angaben gering. (1)

Um den zu erzeugenden Strom über Wind und Sonne abzuschätzen, wird von den Angaben nach (1) ausgegangen: 58 % Wind, 42 % Solar.

Somit müssen von 172 000 GWh/a

99 760 GWh/a über Wind,

72 240 GWh/a über Sonne

erzeugt werden, um den CO2-Ausstoß über Kohlekraftwerke um 175 Mio. t CO2/a bis 2030 abzubauen bzw. eine entsprechende Kapazität an Kohlekraftwerken stillzusetzen (31 GW eff.).

Die über Wind und Sonne herzustellenden Kapazitäten können nun bei mittleren Nutzungsgraden von Wind (17,7%) und Sonne (10,4%) wie folgt abgeschätzt werden:

Wind 64 GW inst.,

Solar 79 GW inst.

143 GW inst.

Das entspräche einem jährlichen Zuwachs bis 2030 von

Wind 4,6 GW/a

Solar 5,6 GW/a.

Daraus errechnet sich für 2030 ein Gesamtbestand von

Wind 47 (z.Z.) + 64 = 111 GW inst.

Solar 40 (z.Z.) + 79 = 119 GW inst.

230 GW inst.

Die mittlere nutzbare Kapazität für Wind+Solar errechnet sich dann zu 43,7 GW eff.

Derzeit sind etwa 26 800 Windanlagen mit einer Leistung von etwa 47 GW installiert, für eine Kapazität von 111 GW ergeben sich dann 63 290 Windanlagen.

In Bild 6 sind nun zunächst die für das Jahr 2015 bekannten Stromleistungen über „Sonstige“ (Biomasse etc.) von etwa 12 GW, die sicheren Stromerzeuger Erdgas, Kern und Kohle mit 48 GW sowie die Installation der fluktuierenden Stromerzeuger Wind und Solar mit einer Schwankungsbreite von 87 GW (9) mit dem mittleren nutzbaren Wert von 12 GW aufgetragen.

Der Strombedarf schwankt zwischen etwa 35 und 73 GW. Die Netzkapazität liegt z.Z. bei 80 GW.

Mit den Kapazitäten der „Sonstigen“ (12 GW), der Kohle-, Kern- und Erdgaskraftwerken (48 GW) sowie der mittleren Nutzung von Wind und Solar (12 GW) kann der höchste Strombedarf von 73 GW gerade abgedeckt werden.

Geht jedoch die Wind-+Solarkapazität gegen null (nachts bei Windstille oder an windstillen Tagen im Winter), reichen die Kapazitäten mit 60 GW nicht mehr aus, um die Strombedarfsspitzen abzudecken, d.h. es muß kräftig Strom importiert werden (nach dem „Statistischen Bundesamt“ mußten in 2015 37 Mrd.kWh (5,7 %) importiert werden, alleine über Frankreich 10,7 Mrd.kWh). (10)

Andererseits wurden 85 Mrd.kWh (13 %) in 2015 exportiert, da die Stromerzeugung über erneuerbare Energien am Bedarf vorbei ging oder die Netzkapazität nicht ausreichte, was in den letzten Jahren mit dem immer weiter steigenden Anteil des Stroms über alternative Energien weiter zunahm mit weiter steigenden „Negativen Strompreisen“. (3)

Hinzu kommt, dass von den 6100 Kilometern Leitungen, die sich aus dem Bundesbedarfsplan ergeben, gerade 350 km genehmigt und 69 km gebaut wurden. Von den geplanten Pilotstrecken für Erdkabel ist noch keine in Betrieb.(11)

Geradezu explodiert ist in 2015 die „Ausfallarbeit“, d.h. der Strom, der wegen Netzüberlastung nicht eingespeist werden konnte. Diese Menge hat sich in 2015 verdreifacht. Erstmals mußten Windkraftanlagen auf hoher See abgeregelt werden, um das Netz zu schonen.(11)

Nach Aussage der Netzbetreiber müssen seit dem 10.10.2016 fast jeden zweiten Tag Notfallkraftwerke zugeschaltet werden. Die Netzbetreiber haben auf Anweisung der Netzagentur als „Winterreserve“ die Kapazität der Notfallkraftwerke von 6,6 in 2016 auf 8,3 GW erhöht. (12)

Vor diesem Hintergrund soll nun der „Klimaschutzplan 2050“ gestartet werden, mit einem ersten Schritt bis 2030, nämlich dem Abbau von 175 Mio. t CO2/a.

Nach der Stilllegung der Kohlekraftwerke mit einer Kapazität von 172 Mrd.kWh und nach der Schließung des letzten Atommeilers in 2022,ergibt sich dann folgendes Bild:

Die Kapazität der „Sonstigen“ ist auf 13 GW leicht gestiegen (Bild 6), die der Kohlekraftwerke auf 11 GW abgeschmolzen (die Kapazität der Gaskraftwerke ist wie 2015 angesetzt worden (7 GW)), so dass in Summe nur etwa 18 GW (Kohle+Gas) verbleiben, um Schwankungen in der Stromerzeugung von Wind und Solar auszugleichen. Dazu gekommen ist eine Kapazität über den Zubau von Wind- und Solaranlagen von 143 GW, so dass in Summe eine Kapazität von 230 GW vorhanden ist mit einem mittleren Nutzungsgrad von rd. 44 GW eff. (Mittlere Nutzung Wind+Sonne; Bild 6)

Die mittlere Nutzung Wind+Sonne stellt gleichzeitig die Summe der Kapazitäten von „Sonstigen“, Kohle und Gas einschließlich der mittleren Nutzung von Wind + Sonne (der letzte Atommeiler soll 2022 geschlossen werden) dar und deckt sich praktisch mit dem oberen Strombedarf in 2030 (Bild 6).

Um das Auffangen derartiger Spannbreiten in der Erzeugung zu ermöglichen, ist naturgemäß zunächst eine kräftige Erweiterung der Netzkapazität von z.Z. 80 GW erforderlich.

Im Übrigen wird in 2030 von einer gleichen Verteilung des Strombedarfes wie in den Jahre 2011-2015 ausgegangen.

Nachts bei Windstille oder bei windlosen Tagen im Winter reicht die Summe der „Sonstigen“ mit 13 GW einschließlich der verbleibenden Kohle- und Gaskraftwerken mit 18 GW nicht einmal aus, den Mindeststrombedarf von 35 GW zu decken.

Um den höchsten Strombedarf (73 GW) bedienen zu können, müßten die Kapazitäten der Gaswerke von 7 GW um

73-13 („Sonstige“) – 11 (Kohle) = 49 GW auf 56 GW aufgestockt werden.

Herr Putin wird sich freuen, außerdem wird das Ziel des Abbaues von 175 Mio. t.CO2 wegen des CO2-Anfalles beim Verbrennen von Erdgas verfehlt.

Um die instabile Stromerzeugung über Wind- und Solaranlagen auszugleichen, müßten bis 2030 Stromspeicher in der Größenordnung von

44/2=22 GW

geschaffen werden, da nur durch das Auffangen der über dem nutzbaren Mittelwert liegenden Kapazitäten von Wind und Sonne und ihre Einspeisung bei Ergebnissen unterhalb des Mittelwertes der Mittelwert gehalten werden kann (vgl. Bild 5) .

Die zu speichernden Strommengen lägen dann von 22 GW und einer jährlichen Bruttostromerzeugung von 647 Mrd.kWh in 2015 ausgehend bei

192 720 GWh/a oder 528 GWh/Tag.

Das größte deutsche Pumpspeicherwerk Goldisthal hat eine Leistung von 1,05 GW und kann diese Leistung jeweils 8 Stunden halten entsprechend 8,4 GWh (Kosten 600 Mio.€).

Für eine tägliche Stromspeicherung wären dann bei einem Wirkungsgrad der Speicher von 80%

528/ 8,4 x o,8 = 79 Speicher

als Jahresmittelwert erforderlich, ohne eine Gesamtbetrachtung der zu bauenden Speicher zum Beispiel bei einem 14-tägigen Zeitraum ohne Wind im Winter anstellen zu wollen.

Die Topographie Deutschlands ließe eine solche Anzahl ohnehin nicht zu, andere Speicher wie „Power To-Gas“ oder Batterien sind für solche Strommengen weder geeignet noch bezahlbar.

Kann eine ausreichende Zahl an Speichern nicht zur Verfügung gestellt werden- wovon auszugehen ist- gehen in Deutschland in 2030 die Lichter aus.

Die Stromversorgung kann dann in 2030 nur aufrecht erhalten werden, wenn die fehlende Speicherkapazität von 22 GW über Kohle- und Gaskraftwerke ausgeglichen wird.

Das würde bedeuten, dass im Sinne von Bild 5 die unter dem Mittelwert liegenden Werte (im Bild über Gas ersetzt) über leicht steuerbare Kohle- und Gaskraftwerke ständig angepaßt werden müßten.

Das heißt, der Strombetrieb kann in 2030 nur funktionieren über eine Kohle-+ Gaskapazität von

18 GW (Kohle+Gas – wie bereits erwähnt)

+ 22 GW (Kohle+Gas als Ersatz für fehlende Speicher)

= 40 GW

Gleichzeitig müßte die Stromkapazität über der mittleren Nutzung von Wind+Sonne auch im Sinne einer gezielten Kapazitätseinstellung still gesetzt werden, d.h. hälftig, nämlich 22 GW. (vgl. Bild 6)

Das bedeutet, dass neben der Kapazität über Kohle und Gas von 40 GW, „Sonstige“ von 13 GW für Wind+Sonne nur noch 20 GW oder einschließlich der „Sonstigen“ ein Anteil über alternative Energien von 33 GW bzw. 45% verbleibt (vgl. (6,7))

Eine für ein Industrieland wie Deutschland beschämende Vorstellung eines Planes zur „Dekarbonisierung“, genannt „Klimaschutzplan 2050“.

Die Wunschvorstellung der Vollendung der „Dekarbonisierung“ im Jahre 2050

Wenn nun bis 2050 dieses Drama weiter gehen soll, müßten die 18 GW, die in 2030 noch über Kohle- und Gaskraftwerke abgedeckt werden, stillgesetzt und über eine entsprechende Kapazität über Wind+Sonne ersetzt werden.

Geschieht dies unter den o.g. Randbedingungen, so gilt:

18/ 0,19 ( %uale Nutzung von Wind (17,7%) und Sonne (10,4%) bezogen auf die

Nennleistung) = 95 GW inst.

Damit lägen dann die zu installierenden Kapazitäten über Wind+Sonne in 2050 insgesamt bei:

230 GW (bis 2030)

95 GW (2030-2050)

= 325 GW

mit einer mittleren Nutzung von 44+18=62 GW.

Hinzu käme noch die nur leicht gestiegenen Kapazität über die „Sonstigen“ von etwa 17 GW (Bild 6) . (1)

Entsprechend den bereits oben gemachten Ausführungen müßte bis 2050 eine tägliche mittlere Speicherkapazität von 62/2 = 31 GW aufgebaut werden, um die Kapazität von 62 GW nutzen zu können (s.oben).

Da eine derartige Speicherkapazität auch bis 2050 nicht aufgebaut werden kann, bleibt der „Klimaschutzplan 2050“ eine Fata Morgana.

Denn es müßten nämlich dann analog zu 2030 nun 31 GW durch die fehlenden Speicher über Kohle- und Gaskraftwerke im Sinne von Bild 5 ausgeglichen werden, gleichzeitig dürften die Wind-+Solaranlagen keinen Strom mehr über der mittleren Nutzung erzeugen, d.h. die Anlagen müssen hälftig stillgesetzt werden, nämlich 31 GW.

Hier verbleiben dann neben der Stromkapazität über Kohle und Gas von 31 GW, den „Sonstigen“ von 17 GW nur noch 31 GW für Wind+Sonne.

Das bedeutet, dass zur Aufrechterhaltung der Stromerzeugung in 2050 die Stromkapazität über die alternativen Energien Wind+Sonne (31 GW) einschließlich der „Sonstigen“ (17 GW) nur noch bei 48 GW oder 61% liegen kann – anstelle der Wunschvorstellung von 100% (vgl. auch (6,7)).

Wenn dann das Programm der Grünen vorsieht, nach 2030 keine Verbrennungsmotoren mehr zuzulassen mit dem Ziel einer kompletten Umstellung aller PKW, LKW und Bussen auf Elektroantrieb, so zeugt dies von einer tief verwurzelter Abkehr von einem technischen Verständnis und eher von einer Hinwendung zu einem religiösen Sendungsbewußsein.

Der Strombedarf würde dann nämlich bis 2050 um etwa 200 Mrd. kWh/a höher liegen als heute (13), abgesehen von einer zusätzlichen kompletten Umstellung der Strominfrastruktur (Kraftwerke, Netzausbau etc.).

„Postfaktisch“ ist das Wort des Jahres 2016. Im Rahmen der Energiewende wird das „Postfaktische“ jedoch seit ihrer Gründung im Jahre 2000 praktiziert. Mit einer Kugel Eis fing es an. (Trittin)

Wen wundert es da noch, wenn die größten CO2-Emittenten wie China, Indien, Rußland und Amerika die deutsche Klimapolitik über alle Maßen loben- aber vor ihrer Nachahmung warnen. (14)

Die postfaktische Energiewende, verborgen hinter einer vordergründigen Weltrettung über einen CO2-Abbau

Der in den Jahren 1977 bis 1998 gefundene Gleichlauf von CO2-Gehalten in der Atmosphäre und der globalen Temperatur wird 1986 von der Deutschen Physikalischen Gesellschaft (DPG) aufgegriffen und zur „Klimakatastrophe“ stilisiert.

Im Jahre 1988 wurde dann von den Vereinten Nationen die Unternehmung „Intergovernmental Panel on Climate Change“ (IPCC) als eine politische Institution gegründet, die die Aussagen der DPG gerne aufgriff.

Weltweit wurden in der Folgezeit im Auftrage des IPCC Klimainstitute gegründet und finanziell unterstützt mit dem Ziel, ausschließlich das Ausmaß von CO2 auf die Erderwärmung zu untersuchen, insbesondere den aus anthropogenen Quellen stammende CO2-Anteil.

Die staatlich dotierten Wissenschaftler folgten diesem einseitig definierten Auftrag, zahlreiche Klimamodelle zum Einfluß von CO2 auf das Klima wurden erstellt, obwohl vor 1977 und nach 1998 ein Zusammenhang zwischen dem CO2-Gehalt und der globalen Temperatur nicht existiert (Bild 7,8).) (15)

Wen wundert bei diesen staatlichen Eingriffen die Aussage einschlägiger Vertreter des Klimaalarmismus, wenn sie von einer Übereinstimmung aller Wissenschaftler hinsichtlich einer Klimaänderung durch CO2 von 97% sprechen.

Zwangsläufig scheiterten die Klimamodelle auch aus thermodynamischen Gründen mit ihren bedrohlichen Aussagen zum Temperaturanstieg an der Wirklichkeit (16), aber die Angst der Menschen vor dem Weltuntergang durch überhöhte Temperaturen (Kirche: Höllenfeuer) war im kollektiven Gedächnis der Menschen verankert, besonders in Deutschland („German Angst“).

Daß CO2 das Klima nicht beeinflussen kann, zeigt auch die Klimageschichte der Erde nach der letzten Eiszeit (Bild 9). Von den sechs wärmeren Phasen nach der letzten Eiszeit waren alle wärmer als die Jetzige, auch ohne den Einfluß von anthropogenem CO2.

Damit war auch die Klimawissenschaft flächendeckend politisiert, alle Medien und Nichtregierungsorganisationen griffen in dem 1980er Jahren dieses Angst-einflößende Thema zur Anhebung ihrer Auflagen/Einschaltquoten/Spenden dankbar auf, abenteuerliche Meeresspiegelanstiege wurden auch noch vorausgesagt und damit weitere Urängste geweckt, was für viele nach der Abwendung vom Christentum zu einer neuen Heilsbotschaft wurde.

Zudem gab es in der Klimageschichte der Erde Zeiträume, in denen der CO2-Gehalt in der Atmosphäre um mehr als eine Zehnerpotenz höher lag als heute, ohne dass die Temperatur in dieser Zeit höher lag.

Ein zufälliger nicht kausaler Zusammenhang zwischen CO2-Gehalt in der Atmosphäre und globaler Temperatur von etwa 21 Jahren (1977 bis 1998) wird von den politisierten Wissenschaftlern zu einem Dogma stilisiert, das die Welt- vor allem Deutschland- massiv verändern wird, wenn nicht Einhalt geboten wird.

Weiterhin kommt hinzu, dass das CO2 aus verschiedenen Quellen stammt: Ausgasung Meere, Atmung Pflanzen, Zersetzung Bodenorganismen, Entwaldung, Atmung Lebewesen etc., in Summe etwa 800 Gt C/a, wovon nur etwa 3% aus der Verbrennung fossiler Stoffe stammt.

Bei einem CO2-Gehalt in der Atmosphäre von 400 ppm oder 0,0400% errechnet sich dann ein Anteil über Verbrennung von 12 ppm oder 0,0012%.

Der Anteil von Deutschland liegt bei 2,7%, bezogen auf den insgesamt von Menschen verursachten CO2-Anteil, also 0,32 ppm bzw. 0,000 032%.

Der theoretisch abbaubare CO2-Anteil über die Energiewende läge bei einem CO2-Ausstoß von 42% über den Energiesektor (Bild 1) bei 0,13 ppm oder 0,000 013%.

Damit liegt der theoretisch mögliche CO2-Abbau durch die Energiewende – so sie denn gelingt -mit 0,13 ppm weit unterhalb der natürlichen jährlichen Schwankungsbreite durch die Photosynthese von 20 ppm (Äquator) und 3 ppm (Äquator-nah). (17)

Die mögliche Absenkung des CO2-Gehaltes über die Energiewende kostet Deutschland bis 2025

520 Mrd.€ (18)

Der weltweite geringe anthropogene CO2-Anteil von 12 ppm oder 0,0012% soll nun in der Lage sein, gegen thermodynamische Gesetzmäßigkeiten eine Wärmemenge von 324 W/m2 (IPCC) im Sinne eines Treibhauseffektes aus der Atmosphäre zurück zur Erde zu bewegen – das wäre dann ein Perpetuum Mobile ungeahnten Ausmaßes!

Dennoch hat das IPCC bereits 1992 die Forderung erhoben, durch Begrenzung des anthropogenen CO2-Ausstoßes den Anstieg der globalen Temperatur auf 2° Celsius zu begrenzen.

Deutschland zahlt neben den genannten 520 Mrd.€ für die Energiewende (bis 2025) auch noch in 2016 2,7 Mrd.€ für den internationalen Klimaschutz. (19) Die Entwicklungsländer mit ihren korrupten Regierungen werden sich freuen.

Wo bleibt der Aufschrei der nicht staatlich dotierten Wissenschaftler, der Gesellschaft? Ein Aufschrei der Medien ist nicht zu erwarten, zu tief ist die Verflechtung in einer „mediatisierten“ Gesellschaft und Politik.

Medien bevorzugen außerdem zur Anhebung ihrer Auflagen/Einschaltquoten eine dramatisierende, skandalisierende und emotionalisierende Berichterstattung nach dem Motto „Only bad news are good news“, wo dann leicht der Respekt vor der Wahrheit verloren geht.

War vor einigen Jahren die Angsteinflößung durch einen Anstieg der globalen Temperatur noch das Monopol der Grünen, so haben nun fast alle Parteien dieses Machtinstrument entdeckt.

Irgendwann wird diese CO2-Hysterie auf dem Müllhaufen der Wissenschaftsgeschichte landen, wie z.B. das Waldsterben etc.- Verantwortliche wird es nicht geben.

Quellen

1.FAZ, 09.06.2016

2.Klimaschutzplan 2050: Beschluß Bundeskabinett im Umlaufverfahren vom 14.11.2016

3.Beppler, E.: „Der unaufhaltsame, gestufte Fall der „Deutschen Energiewende“, ein quantitatives Desaster“, EIKE,11.07.2016

4.Schuster, R.: Mitteilung Juli 2016

5.Schuster, R.: Mitteilung 03.12.2016

6.Beppler, E.: „Energiewende – Zweite industrielle Revolution oder Fiasko“, 2013, ISBN 978- 3-7322-0034-4

7.Beppler, E.: „Energiewende 2014 – ein Debakel“, 2015, ISBN 978-3-7386-9418-5

8.Öllerer, K.: Windenergie in der Grund-, Mittel- und Spitzenlast: www.oellerer.net

9.Schuster, R.: Mitteilung Februar 2016

10.“Der Spiegel“ 41/2016

11.FAZ, 26.11.2016

12.FAZ, 08.12.2016

13.Mueller, F. F.: „Wenn der Wirt die Ökorechnung selbst nachprüft. Der neue Tesla, eine Dreckschleuder.

14.FAZ,28.11.2016

15.Puls,K.-E.: „CO2 am Pranger“, EIKE, Vortrag 2016

16.Spencer,R.: www.drroyspencer.com

17.Wikipedia: „CO2 in der Erdatmosphäre“

18.Limburg, M.: Mitteilung EIKE vom 10.10.2016 (Untersuchung des Düsseldorfer Instituts für Wettbewerbsökonomik)

19.FAZ, 11.11.2016

Bildunterschriften

Bild 1: CO2-Einsparungen in einzelnen Bereichen nach dem Klimaschutzplan 2050

Bild 2: Gasemissionen in Deutschland nach 1990 in CO2-Äquivalenten

Bild 3: Kleinste, mittlere und größte Jahreseinspeisungen Wind 2010 bis 2016

Bild 4: Kleinste, mittlere und größte Jahreseinspeisungen Sonne 2011 bis 2016

Bild 5: Gesamtwindleistung von März 2011 hochgerechnet auf eine Stromleistung von 40 GW

Bild 6: Stromerzeugungskapazität „Sonstige“, Kohle, Kern, Gas und Wind+Solar von 2015 über 2030 bis 2050

Bild 7: Temperaturverlauf 1850 bis 2015

Bild 8: Temperaturverlauf 1997 bis 2015

Bild 9: Temperaturverlauf nach der letzten Eiszeit