Was ist von Horrorzahl-Studien zu halten?

Eines der schlagkräftigsten Argumente für die Gegner des Verbrennungsmotors sind zahlreiche Studien, in denen angeblich nachgewiesen wurde, dass Abgase und Feinstaub jährlich zigtausende Tote verursachen würden. Schaut man sich diese Untersuchungen jedoch genauer an, so fällt auf, dass es sich oft um sogenannte Kohortenstudien handelt. Dabei werden nicht etwa eindeutige Ursache-Wirkungsbeziehungen auf experimenteller Basis untersucht, sondern beispielsweise die Entfernung des Wohnorts von stark befahrenen Straßen.

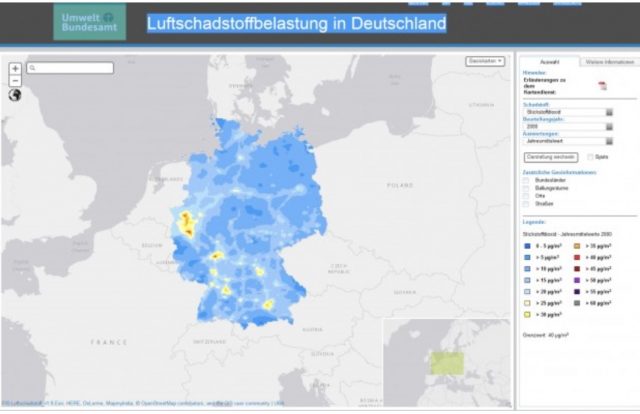

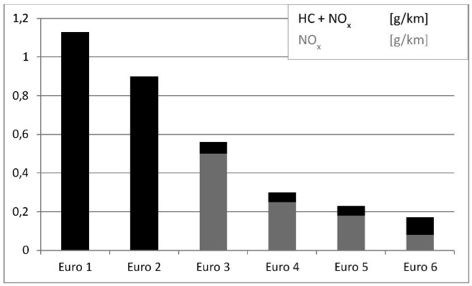

Die schrittweise Einengung der zulässigen Gehalte von Kohlenwasserstoffen (HC) und Stickoxiden in den Abgasen von Diesel-PKW im Verlauf der verschiedenen Stufen der Euronorm (Quelle: [KIT])

Bei diesen Kohortenstudien kommt es jedoch häufig zu offensichtlich gravierenden Falschinterpretationen. In manchen Fällen scheint eine gleichzeitige Betrachtung anderer Risikofaktoren wie Rauchen, Alkoholkonsum, sozialer Status oder Ernährungsgewohnheiten nicht einbezogen zu werden. Anwohner stark befahrener Straßen leben in der Regel in einem anderen sozialen Umfeld als Eigenheimbesitzer in verkehrsfernen Wohnvierteln. Die Relevanz von Studien, die dies nicht ausreichend berücksichtigen, ist daher anzweifelbar.

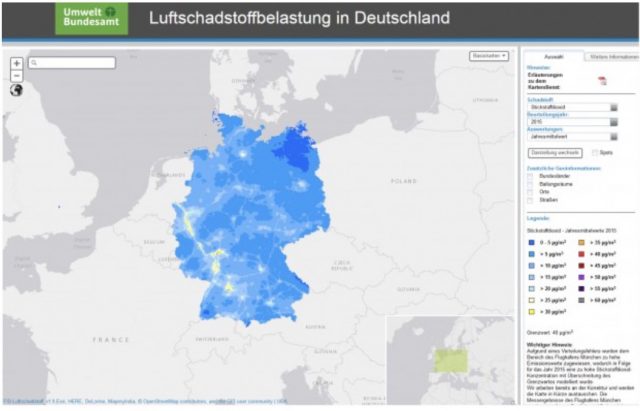

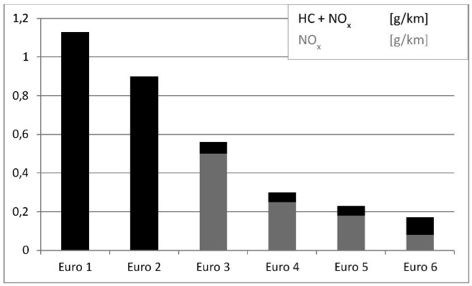

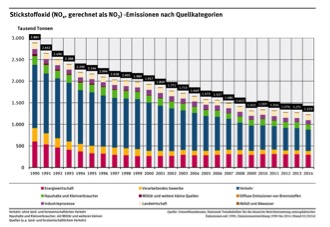

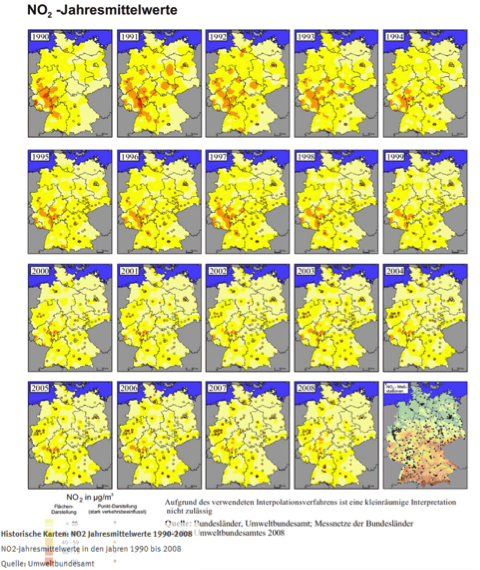

In anderen Fällen wird beispielsweise häufig ein Zusammenhang zwischen NOx und Krebs behauptet, was ganz offensichtlich im Widerspruch zum klassisch experimentell ermittelten Stand des Wissens steht. Solche Studien sind daher zur Beurteilung der Risiken der Abgase moderner Dieselfahrzeuge ungeeignet. Weitergehende Vorwürfe, die sich auch auf Feinstaub beziehen, wirken so alarmistisch, dass ihre Glaubwürdigkeit dadurch stark in Frage gestellt wird. So finden sich Aussagen wie die, dass Nanopartikel das Gehirn schädigten. Sie seien möglicherweise sogar Ursache für bestimmte Alzheimer-Erkrankungen, Kinder entwickelten systematische Entzündungen des Gehirns sowie frühe Anzeichen der Alzheimer-Erkrankung und es komme zu einem reduzierten Intelligenzquotienten [HEIS]. In anderen Studien werden sogar Risiken bezüglich Herz-Kreislauferkrankungen sowie Diabetes erwähnt [CIRC]. Besonders alarmistisch bezüglich selbst geringer Werte von NOx in der Atemluft ist beispielsweise eine Metastudie der italienischen Epidemiologin Annunziata Faustini im European Respiratory Journal. Sie hat die wichtigsten Studien zum Thema analysiert und errechnet, dass die Zahl der jährlichen Todesfälle in der Bevölkerung um jeweils vier Prozent zunehme, wenn die jährliche Durchschnittsbelastung weitere zehn Mikrogramm NO₂ pro Kubikmeter ansteigt. Nun beträgt die jährliche Stickstoffkonzentration in städtischen Wohngebieten im Mittel zwanzig bis dreißig Mikrogramm. An vielbefahrenen Straßen sind Anwohner jedoch nach Messungen des Umweltbundesamts manchmal Konzentrationen ausgesetzt, die bis zu vierzig oder sogar sechzig Mikrogramm pro Kubikmeter darüberliegen. Mit jeden weiteren zehn Mikrogramm NO2 soll die Zahl der tödlichen Herzattacken und -infarkte um dreizehn Prozent ansteigen [FAZ]. Dies müsste eigentlich zu einer signifikant sinkenden Lebenserwartung der Bevölkerung großer Städte führen. Da das Gegenteil der Fall ist, kann man solcherlei Studien als widerlegt abhaken.

Anzahl der Stunden, in denen die Grenzwerte für NO2 an verschiedenen Messstellen überschritten wurden (Quelle: [LUST])

Eine Schlüsselrolle bei solchen Untersuchungen kommt auch den beiden Instituten für Epidemiologie (EPI I/II) am Helmholtz Zentrum München unter der Leitung von Prof. Dr. Annette Peters zu. Sie ist hochdekorierte Beraterin in wissenschaftlichen und beratenden Gremien auf nationaler wie auch auf internationaler Ebene und hat großen Einfluss auf Politik und Presse bis hin zur World Health Organisation (WHO) der UNO. Dort vertritt sie Ansichten wie die, dass die aktuell geltenden Grenzwerte für NOx aus gesundheitlicher Sicht deutlich zu hoch seien. Die Weltgesundheitsorganisation WHO (in der sie ebenfalls Einfluss hat) überarbeite gerade ihre Empfehlungen, weil neuere Daten zeigten, dass die Sterblichkeit bereits weit unterhalb dieses Wertes ansteige. Aus gesundheitlicher Sicht sei der in Europa erlaubte Jahresmittelwert für Stickstoffdioxid von 0,04 mg/m3 zu hoch. Wahrscheinlich gebe es für Stickoxide überhaupt keinen „sicheren“ Schwellenwert [PETE]. Dies steht in diametralem Widerspruch zu den Erkenntnissen z.B. der Arbeitsmedizin. Wer wissen will, woher ein nicht unerheblicher Teil der durch öffentliche Gelder geförderten Meinungsmache gegen unsere technische Zivilisation stammt, dem sei empfohlen, sich die beeindruckende Liste der Institutionen und politischen Gremien anzusehen, in denen Fr. Prof. Dr. Peters in führender Position vertreten war oder ist [PETE2].

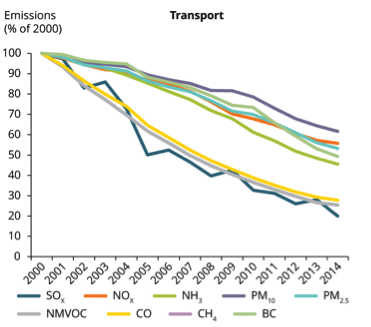

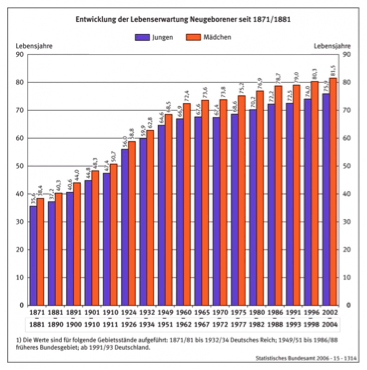

Bei all diesen Schreckensmeldungen fragt man sich, wie die Menschheit in früheren Jahrzehnten und Jahrhunderten überhaupt überleben konnte, denn die Luft des Mittelalters war in den Stuben und Werkstätten sicherlich um ganze Größenordnungen stärker mit Schadstoffen z.B. aus der Holzverbrennung belastet als heute. Bei vielen dieser Untersuchungen hat man den Eindruck, dass die Verfasser vor allem darauf aus sind, das Auto als Wurzel jedes nur denkbaren Übels darzustellen. Statt sich von dem hochwissenschaftlichen Wortgeklingel dieser Studien einschüchtern zu lassen, sollte man lieber auf den eigenen gesunden Menschenverstand vertrauen. Tut man dies, so erkennt man schnell, dass diese Art von epidemiologischen Studien in deutlichem Widerspruch zur Erhöhung des Lebensalters in Deutschland generell und speziell in den großen Städten steht. Die Menschen in den höher mit Abgasen belasteten großen deutschen Städten leben länger als der Durchschnitt der deutschen Bevölkerung, und ihr Lebensalter steigt immer weiter an [MUEL]. Demnach ist den Aussagen solcher Kohortenstudien gegenüber eine gehörige Portion Misstrauen angebracht. Der führende Toxikologe Professor Helmut Greim von der TU München, von 1992 bis 2007 Vorsitzender der MAK-Kommission, hält die heute geltenden Grenzwerte für Stadtluft und insbesondere Forderungen nach ihrer weiteren Absenkung für übertrieben [GREI]. Auch Prof. Matthias Klingner, Leiter des Fraunhofer-Instituts für Verkehrs- und Infrastruktursysteme IVI in Dresden, sagte in einem Interview mit den Dresdner Neueste Nachrichten: „In der Feinstaub-Debatte, wo von 80.000 Toten im Jahr die Rede war, hatten wir ausgerechnet, dass der Grenzwert von 50 Mikrogramm Feinstaub am Tag, der nur 35 mal im Jahr überschritten werden darf, den eingeatmeten Partikeln einer halben nikotinfreien Zigarette entspricht. Nun kann man natürlich sagen, man soll überhaupt nicht rauchen, aber an der großen Gruppe der Raucher statistisch nachgewiesen sind gesundheitliche Folgen erst nach einem sehr, sehr viel höherem Zigarettenkonsum“ [KLIN].

Entwicklung der Lebenserwartung von Einwohnern verschiedener deutscher Großstädte sowie für Deutschland insgesamt für die Geburtsjahrgänge 1995 und 2010 (Daten: [LEBE], Statista)

Abgas-Beurteilung: Eine zweigeteilte Welt

Bezüglich der Beurteilung der Gefährlichkeit von Abgasen ist die Fachwelt offensichtlich zweigeteilt. Da gibt es auf der einen Seite Fachgremien, deren Zusammensetzung zumindest früher hauptsächlich nach ärztlicher bzw. arbeitsmedizinischer Qualifikation erfolgte. In der Schweiz ist dies die SUVA (Schweizer Unfall Versicherung), die in der Schweiz Aufgaben wahrnimmt, die denjenigen der Berufsgenossenschaften in Deutschland entsprechen. In Deutschland ist hierfür die Ständige Senatskommission zur Prüfung gesundheitsschädlicher Arbeitsstoffe (MAK-Kommission) der Deutschen Forschungsgemeinschaft [DFG] verantwortlich, der aktuell 36 hochrangige Fachleute angehören. Wer sich einen Eindruck davon verschaffen will, wie sorgfältig und verantwortungsbewusst diese Gremien an ihre Aufgaben herangehen, dem sei ein Blick in das Factsheet: Schweizer Grenzwerte am Arbeitsplatz [MAKW] empfohlen.

In Deutschland erscheint jedes Jahr eine neue Ausgabe der MAK-Liste mit den erfolgten Änderungen. Dabei finden sich interessante und teils dramatische Verschiebungen. Noch 1994 findet sich in der MAK-Liste zu NO2 die ein Grenzwert von 9 mg/m³, heute sind es nur noch 0,95mg/m³. Die Bestimmung erfolgt folgendermassen: Zunächst wird der Stand der Erkenntnisse aus der Literatur gesammelt und ausgewertet. Dazu zählen sowohl Tier- als auch Menschenversuche sowie Studien z.B. an Mitarbeitern, die entsprechenden Auswirkungen ausgesetzt sind oder waren. So wird ermittelt, wo die Dosisgrenze für NO2 in der Atemluft ist, bei der mit Sicherheit keine Wirkung auf den Organismus erfolgt. Dieses nennt man den NOAEL-Wert (no observed adverse effect level). Oft wird dieser Wert als MAK-Wert festgelegt. Da der Mensch sich nicht Rund-um-die-Uhr am Arbeitsplatz befindet, bedeutet die Festlegung vom NOAEL-Wert als MAK-Wert eine zusätzliche Sicherheit. Oft wird noch ein zusätzlicher Sicherheitsfaktor (häufig zwischen 0,1 bis 0,25) eingeführt. Letzteres könnte auch zur Herabsetzung des deutschen MAK-Wertes für NO2 von 9 mg/m3 auf nur noch 0,95 mg/m3 geführt haben [NIEM].

Der Erfolg der ergriffenen Maßnahmen zur Reinhaltung der Luft zeigt sich besonders deutlich an der Entwicklung der Werte für Schwefeldioxid vor allem im Bereich der neuen Bundesländer (Grafik: [UBA])

Auf der anderen Seite gibt es die „Fachwelt“ der grünlinken Aktivisten, die heute nicht nur in Parteien, NGO’s, zahllosen finanzstarken Stiftungen und den Medien, sondern auch in den meisten staatlichen und halbstaatlichen Gremien einschliesslich der Forschung eine dominante Rolle spielen. Diese Kräfte verfügen nicht nur über Milliardensummen aus Steuergeldern, sie üben auch dank ihrer Dominanz in Gremien, die über die Vergabe von Forschungsbudgets entscheiden, einen unglaublichen starken und zugleich negativen Einfluss auf alle Bereiche der Wissenschaft aus. Wer nicht mit ihrer Ideologie konform geht, geht bei der Beantragung von Geldern für Forschungsprojekte solange leer aus, bis er seine Lekion gelernt hat. Hier bestimmen längst nicht mehr Fachleute, sondern politisch gestützte Ideologen den Gang der Dinge, hier werden Gefälligkeitsgutachten initiiert, die dann in geeigneten politischen Gremien – gern auch auf EU- oder UNO-Ebene – ohne Rücksicht auf toxikologische Erkenntnisse und unter souveräner Missachtung jeglicher ökonomischen Vernunft durchgepeitscht werden. Von diesen Kräften, die oft auf gesicherten und hoch dotierten Beamtenpöstchen sitzen, wird die Festlegung rein „politisch-ideologischer“ Grenzwerte für Autos und die Luft in Städten gesteuert, die bei weniger als einem Zweihundertstel dessen liegen, was noch vor etwas mehr als zwei Jahrzehnten als unbedenklich für ständige jahrelange Exposition am Arbeitsplatz galt. Hier liegen die Ursprünge der nicht nur gegen das Automobil, sondern im Prinzip gegen unsere ganze technische Zivilisation gerichteten Kampagnen, die derzeit vor allem das Automobil im Visier haben. Wenn es nicht gelingt, diesen Kräften die Deutungshoheit über die von ihnen okkupierten Bereiche im Gesundheits-, Arbeits- und Umweltschutz wieder zu entreißen, wird unsere Bevölkerung für deren Eskapaden noch einen sehr hohen Preis zu zahlen haben.

Todesurteile auf dem Umweg über die EU

Bei vielen der alarmistischen Studien über die angeblich zu hohen Risiken von Abgasen für die Bevölkerung finden sich auffallend häufig Formulierungen wie „werden diskutiert“, „nähere Angaben zu obiger Quelle sind nicht verfügbar“, „möglicherweise“, „Hinweise“ oder „kann“. Ein weites Feld für politisch dominierte Verbotsgremien, in denen Ideologen die Fachleute jederzeit mühelos überstimmen können. Diese Entwicklung kann man seit Jahren sowohl auf nationaler Ebene als auch auf internationaler Ebene beobachten. Insbesondere in EU-Gremien kommen zu den „grünen“ Motiven noch die üblichen Grabenkämpfe der EU-Staaten untereinander. Hier kann man den ungeliebten deutschen Klassenprimussen, deren Industrie stark automobillastig ist, mal so richtig vor das Schienbein treten. Die aktuelle Dauerkanzlerin hat schon öfters bewiesen, dass sie es meisterhaft versteht, solche Gremien mit den „richtigen“ Leuten zu besetzen. Diese helfen bei der Durchsetzung ihrer eigentlichen Ziele, ohne dass sie sich im eigenen Land zu sehr in die Nesseln setzen müsste. Wenn dann die eigene Industrie mit Grenzwerten auf EU-Ebene konfrontiert ist, gegen die man selbst als deutsche Regierung nichts mehr ausrichten kann, kann man sich immer noch dadurch profilieren, dass man gegenüber der „übermächtigen“ EU ein bisschen auf Widerstand mimt und nach „hartem Verhandeln“ ein paar Brosamen mitbringt, während die beschlossenen Grenzwerte längerfristig von vornherein das Todesurteil für die Automobilindustrie bedeuten. Das funktionierte vor allem deshalb besonders gut, weil die Regierung und damit die Vertreter unseres Landes insgeheim sowieso der Meinung waren, der Verbrenner sei nicht mehr zeitgemäß und in einigen Jahrzehnten werde es nur noch selbstfahrende Autos geben. Allen voran unsere Klimakanzlerin, die überraschend kurz vor der aktuellen Bundestagswahl ihre Linie des Versteckens und des Agierens über das Ziehen von Strippen im Hintergrund aufgegeben hat. So hat sie sich in einem Interview mit der „Super-Illu“ klar auf die völlige Abkehr vom Verbrennungsmotor festgelegt [MERK] und in einer weiteren Stellungnahme auch für das Ende des Individualverkehrs ausgesprochen, da sie überzeugt sei, dass man „in 20 Jahren nur noch mit Sondererlaubnis selbstständig Auto fahren“ dürfe [SELB]. Das Lenken wird aus ihrer Sicht dann der Staat übernehmen. Halt so, wie sie es von Kindesbeinen an gewohnt war. Und wen kümmern schon die paar Rentner, die durch diese Manöver enteignet werden, weil sie ihren alten Wagen nicht mehr benutzen dürfen, ihnen aber das Geld für die Beschaffung der teuren neuen Modelle mit ihrem ganzen nur bedingt erforderlichen Schnickschnack fehlt.

Die etwas überraschende Selbstdemaskierung der Bunddeskanzlerin lässt darauf schließen, dass sie glaubt, die „Festung Automobil“ sei dank der pausenlosen Attacken einer breiten Front von Gegnern – von der US-Regierung über die EU und die grünlinken Kräfte in Politik und Medien bis zur öffentlichen Meinung – inzwischen so diskreditiert und sturmreif geschossen, dass man mit ihr dasselbe veranstalten könne wie mit der Kernkraft im Jahre 2011. Es würde nicht verwundern, wenn sie unmittelbar nach ihrem alternativlosen Wahlsieg wieder so ein Gremium wie die damalige „Ethikkommission“ ins Leben rufen würde, um der wichtigsten deutschen Exportindustrie und zugleich dem Individualverkehr beschleunigt den Garaus zu machen.

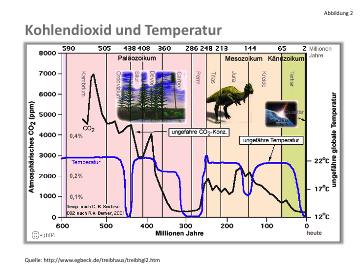

Die CO2-Würgeschlinge

Dass die Weichen längst gestellt wurden, kann man auch an einem weiteren Punkt erkennen: Den CO2-Grenzwerten. Zwar ziert sich die Kanzlerin bei der Festlegung von Endterminen, aber das ist nur Show. Nach dem großen Getue um die angebliche „Vergasung der Bevölkerung“ [DOE] durch „kriminelle, von Gier getriebene Manager der Automobilbranche“ haben sich die etablierten politischen Parteien von grün über rot bis schwarz beim „Dieselgipfel“ auf eine vorübergehende Entschärfung der aufgeheizten Stimmungslage verständigt. Den Politikern ist klar, dass dieses Thema so kurz vor den Wahlen nicht weiter hochkochen sollte, weil dann die Gefahr bestünde, dass die betrogene Bevölkerung ihnen die ersehnten Stimmen verweigern könnte. Denn das Manöver, das langfristig durchgezogen wird, erfordert langsames, schrittweises Vorgehen, damit die Opfer nicht unruhig werden.

Das Ziel bleibt natürlich unverändert: Während man derzeit im Rahmen einer Scheibchenstrategie nur auf den Diesel einprügelt, wird es ab 2020 alle Verbrenner treffen. Das ist bereits jetzt festgeschrieben, und zwar durch die Vorgaben für den CO2-Ausstoss des sogenannten Flottenverbrauchs, der auf EU-Ebene von den derzeit noch rund 130 g CO2/100 km schon ab 2020 auf 95 g CO2/ 100 km gesenkt werden soll. So gilt derzeit ein Limit von 130 g CO2/km, was beim Diesel-Pkw 4,9 l/100 km und beim Benziner 5,5 l/100 km entspricht. Es wird von der aktuellen deutschen Neuwagenflotte knapp eingehalten. Mit dem neuen Grenzwert 95 g CO2/100 km darf ein Diesel nur noch 3,6 l/100 km verbrauchen, ein Benziner nur noch 4,0 l/100 km [NIEM]. Bei den für 2025 avisierten Werten von 68 oder 78 g CO2/100km [CO2V] wären beim Diesel nur noch 2,6 bzw. 3,0 l/100 km zulässig, beim Benziner entspräche dies 2,86 bzw. 3,3 l/100 km. Dass schon die Werte für 2020 und erst recht die Vorgaben für 2025 nicht einzuhalten sein werden, ist selbst für Laien leicht einzusehen. Diese Grenzen können nur als Ausdruck des festen Willens der EU interpretiert werden, den PKW mit Verbrennungsmotor zum Tode zu verurteilen. Das ganze Gehampel mit den Grenzwerten und die Dieseldiskussion bzw. die „Dieselgipfel“ sollen davon nur ablenken, um den Widerstand durch die übliche Salamitaktik aufzusplittern. Und diese bereits vor vielen Jahren getroffenen Entscheidungen hätten niemals gegen den entschlossenen Widerstand Deutschlands gefällt werden können.

Auch beim Feinstaub PM10 zeigt die Langzeitauswertung, dass die Luftqualität immer besser geworden ist. Umso misstrauischer sollte man gegenüber der aktuellen Panikmache sein (Grafik: [UBA])

LKW verursachen den Löwenanteil der Dieselabgase

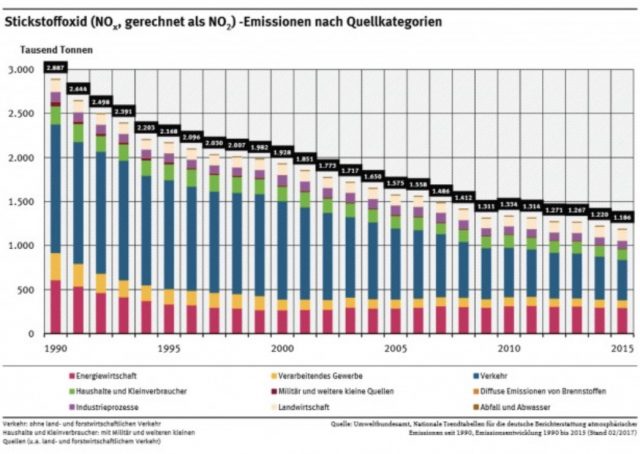

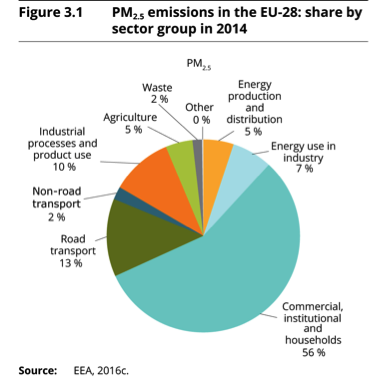

Ein besonders wichtige Quelle von NOx-Emissionen im Straßenverkehr sind die Diesel-LKW sowie Autobusse. Alleine LKW emittieren in einer Stadt wie Ulm dreimal soviele Abgase wie die Diesel-PKW. Kaum etwas dokumentiert die Verlogenheit der aktuellen Kampagne gegen Diesel-PKW sowie der angekündigten Fahrverbote ausgerechnet gegen Diesel-PKW deutlicher als solche Tatsachen. Besonders klar erkennbar sind die Falschbehauptungen zu Abgasen neuer Dieselautos ab Euro 5 auch am Vorwurf der angeblich von ihnen ausgehenden „Krebsgefahr“ festzumachen: Diese besteht definitiv weder bei NO noch bei NOx, und Feinstaub ist seit Einführung des Dieselpartikelfilters kein spezifisches Problem des Diesel-Pkw, sondern entsteht aus einer Vielzahl von Quellen, wozu insbesondere auch die Benziner gehören. Gegenteilige Behauptungen in sogenannten epidemiologischen Studien sind lediglich der Beweis, dass die Verfasser Probleme damit hatten, bei ihrer Analyse die Einflüsse multipler Quellen bzw. Ursachen sauber zu trennen. Auch am Gesamtaufkommen des Feinstaubs haben Diesel-PKW nur einen untergeordneten Anteil. Verkehrswissenschaftler wie Prof. Klingner weisen darauf hin, dass dem Verkehr keinesfalls die behauptete dominierende Rolle bei den Feinstaubemissionen zukommt [KLIN].

Unerwartete Auswirkungen „stickoxid-gereinigter“ Dieselabgase

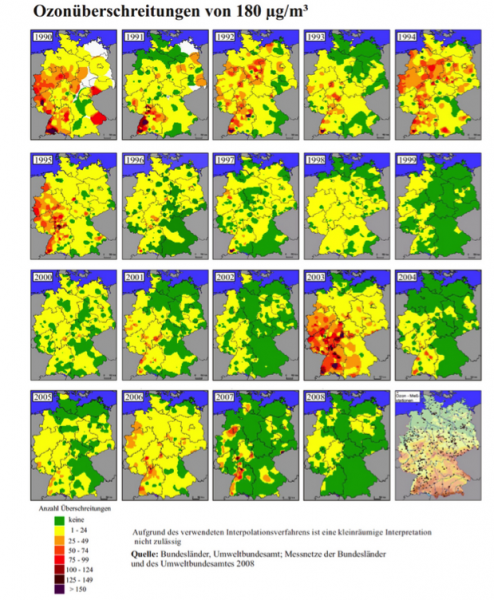

Auf eine ebenso interessante wie ungewollte Nebenwirkung der Verringerung des Stickoxid-Ausstoßes moderner Dieselfahrzeuge der Euro 5 und Euro 6- Kategorie verweist eine Meldung der Neuen Osnabrücker Zeitung vom 23.10.2015 [NOZ]. Zwar bildet das indirekt von Autos stammende NO2 , das sich aus dem zunächst ausgestoßenen NO bildet, bei Sonnenlicht zusammen mit organischen Substanzen und Sauerstoff Ozon, das in entsprechender Konzentration Schleimhäute, Augen und Lungen reizt und zu Atemwegsbeschwerden führen kann. Da das von Autos primär emittierte NO nachts jedoch Ozon abbaut, haben zwar mit der Abgasverbesserung die Ozon-Spitzenwerte abgenommen, dafür ist wegen des verringerten nächtlichen Ozonabbaus jedoch die durchschnittliche Belastung angestiegen. Somit führt ausgerechnet die Verringerung des NO-Ausstosses moderner Dieselfahrzeuge zur erhöhten Bildung eines anderen Luftschadstoffs.

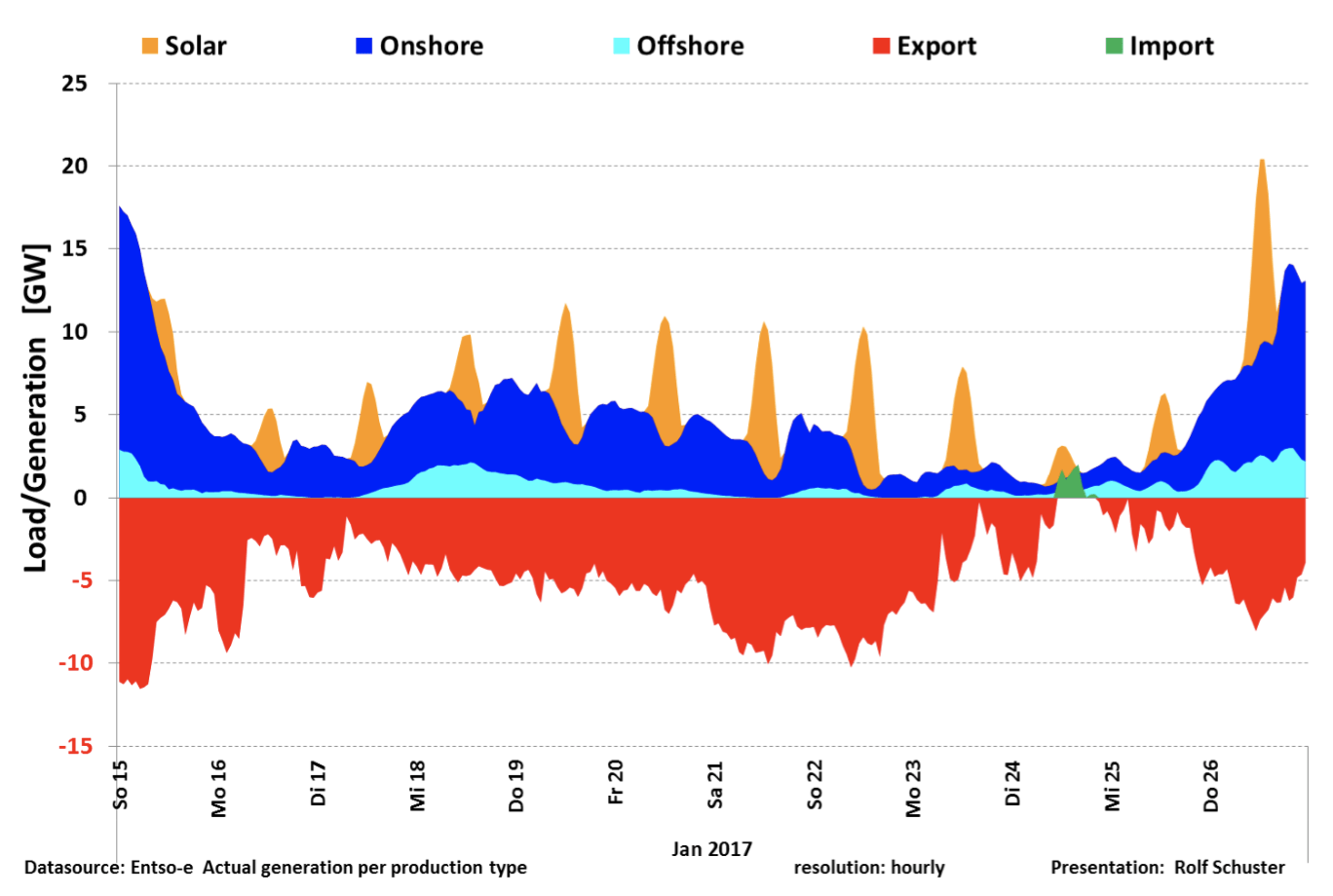

In seiner hervorragenden Analyse hat R. Leistenschneider (Teil 1 hier und Teil 2 hier) nachgewiesen, dass der Anteil der Diesel-PKW an den realen NO2-Emissionen sehr viel geringer ist als von der Politik behauptet (Grafik: [LEIS2])

Natürlicher NOx-Kreislauf

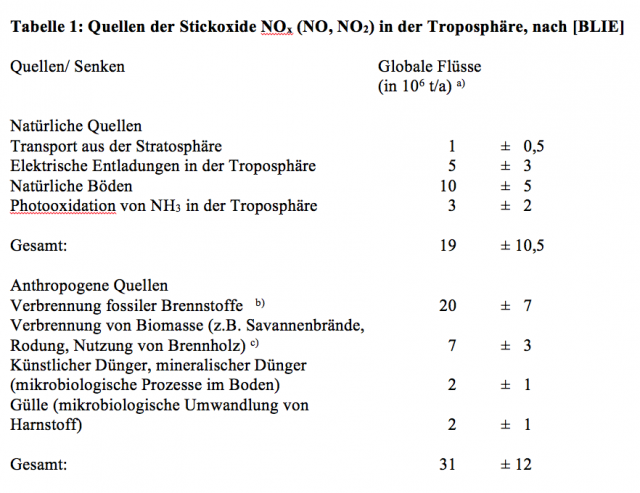

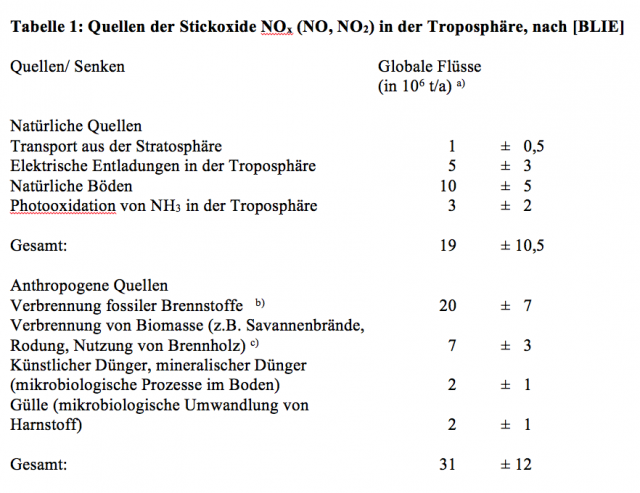

Angesichts der lauten und völlig überzogenen Diskussion über die vom Menschen und insbesondere vom Auto erzeugten NOx-Abgase ist den meisten Menschen gar nicht bewusst, dass diese Teil natürlicher Kreisläufe sind, deren wahre Dimensionen bisher kaum beachtet wurden. In der Atmosphäre hat das NOx nur eine kurze Verweildauer von typischerweise 2-5 Tagen. Zum Aufkommen aus natürlichen Quellen gab es bereits im Jahre 1994 detaillierte Erkenntnisse:

- Angegeben in N;

- 55 % Energiegewinnung, 45 % Transport (Autos, Flugzeuge)

- Von diesen Bränden sind 4 % natürlichen und 96 % anthropogenen Ursprungs

Demnach entsprangen damals rund 40 % des in der Atmosphäre vorhandenen NOx natürlichen Quellen, wobei dies sowohl regional als auch zeitlich starken Schwankungen unterworfen ist. Zudem kommt nur ein Bruchteil der aus anthropogenen Quellen stammenden Mengen tatsächlich von modernen Diesel-PKW, siehe auch bei [LEIS, LEIS2].

Stickstoff ist essentiell für alles Leben und ist wesentlicher Bestandteil z.B. von Eiweißen. Daher muß unsere Nahrung Stickstoff enthalten. Mit der Ernte wird dem Boden Stickstoff entzogen, das sind in Deutschland etwa 1,5 bis 2 Mill. t Stickstoff pro Jahr. Der Stickstoffaustrag durch die Ernte muß dem Boden durch Düngung wieder zugeführt werden. Die Pflanzen können den Stickstoff jedoch nicht direkt aus den Stickstoffmolekülen der Luft aufnehmen, sondern erst aus NO2, das aus der Luft z.B. durch Regen in den Boden gewaschen wird. Deshalb nehmen auch die in Kraftwerken und im Verkehr erzeugten Stickoxide am Stickstoffkreislauf der Natur teil, so daß schließlich ein Teil dieses aus dem Auspuff stammenden Stickstoffs auch auf unserem Teller landet [NIEM].

Auch ein Skript der TU Darmstadt unterstreicht die grosse Bedeutung natürlicher Quellen für den Stickstoffkreislauf zwischen Atmosphäre, Boden und Gewässern (Grafik: [TUDA])

Eine weitere, neuere Untersuchung belegt, dass die aus natürlichen Quellen stammenden Stickoxidmengen diejenigen aus modernen Diesel-PKW um ein Vielfaches übertreffen [LEIS]. Behauptungen mancher Epidemiologen, dass es für Stickoxide wahrscheinlich überhaupt keinen „sicheren“ Schwellenwert gebe, sollte man angesichts dieser „unbequemen Wahrheit“ skeptisch begegnen.

Die Qual der Wahl

Deutschland und mit ihm Europa haben ein Problem. Wir haben ein Staatsoberhaupt, das schon in einer anderen Republik im goldenen Käfig lebte. Das ist auch heute noch so, wozu braucht man ÖPNV oder Fahrrad, wenn man Fahrer und Regierungsjet hat. Dieses Staatsoberhaupt huldigt Visionen, die den Realitäten der Naturgesetze sowie der Ökonomie zuwiderlaufen, und ihm ist in seinem Lauf zu dieser visionären heilen Welt das Schicksal des eigenen Volks ganz eindeutig ziemlich egal. Unglücklicherweise verfügt ebendieses Staatsoberhaupt trotz nahezu flächendeckender Lern- und Faktenresistenz über großmeisterliche Fähigkeiten im Bereich der politischen Manipulation und hat es geschafft, nicht nur die eigene Partei, sondern auch alle sogenannten etablierten anderen Parteien in ihr Macht- und Ideologiegespinst einzubinden. So, wie es halt auch in der ehemaligen „Demokratischen Republik“ mit ihren Schein-„Oppositionsparteien“ war, die im Volk ironisch als „Blockflöten“ bezeichnet wurden. Die aktuell an der Regierung beteiligte zweite angebliche deutsche „Volkspartei“ hat sich von den Zeiten ihrer ehemals bodenständigen Anführer wie Helmut Schmidt inzwischen weit entfernt. Während die alte Garde sich damals noch Gedanken über die Daseinsvorsorge der eigenen Bevölkerung machte, kommen von den heutigen Anführern nur noch reflexhaft hohle Phrasen über die angebliche „Gier der Manager“ und deren „hochnäsige“ Weigerung, sich planwirtschaftlichen Diktaten unfähiger politischer Spinner nach nicht verkaufsfähigen E-Autos widerspruchslos zu beugen. Leute wie Schulz, Hendricks oder Dobrindt werden nie bereit sein anzuerkennen, dass unhaltbare politische Vorgaben die Ursache des Problems sind. Lieber erheben sie Forderungen, die darauf hinauslaufen, das Ende der Autoindustrie schon in den nächsten ein bis zwei Jahren herbeizuführen. Dem Verfasser ist heute noch erinnerlich, wie Mitarbeiter eines Industrieunternehmens in einer Diskussion mit kommunistischen Aktivisten der damaligen Studentenbewegung auf den Firmenparkplatz wiesen und sagten: „Da seht ihr den Unterschied zwischen unserer Situation hier und derjenigen in der DDR“. Die SPD hat heute keinen Helmut Schmidt mehr, der lapidar feststellte: „Wer Visionen hat, soll zum Arzt gehen“. Die Gesamtheit der heutigen etablierten Parteien gehört mit ins Wartezimmer. Mit Blick auf die kommende Wahl ist das passendste Zitat vermutlich das von Heine: „Denk ich an Deutschland in der Nacht, so bin ich um den Schlaf gebracht“. Man sollte wirklich genau überlegen, wohin man sein Kreuzchen auf dem Wahlzettel setzt.

Fred F. Mueller

Hier finden Sie den vollständigen Bericht als pdf zum herunterladenEnergiewendeAutoMord

Quellen

[BLIE] Umweltchemie. Von C. Bliefert. VCH Verlagsgesellschaft, Weinheim, 1994. 453 S., Broschur 68.00 DM. – ISBN 3-527-28692-6

[CIRC] https://doi.org/10.1161/CIRCULATIONAHA.116.026796 Circulation. 2017;136:618-627

[CO2V] http://www.spiegel.de/auto/aktuell/co2-grenzwerte-flottenverbrauch-steigt-erstmals-wieder-an-a-1162063.html

[DOE] https://eike.institute/2017/08/01/moralischer-bankrott-ard-energieexperte-juergen-doeschner-luegt-hemmungslos-die-vergasung-von-10-000-unschuldigen-herbei/

[FAZ] http://www.faz.net/aktuell/wissen/leben-gene/studie-was-zu-viel-feinstaub-mit-unserem-koerper-macht-15151548.html

[GREI] http://www.focus.de/finanzen/karriere/berufsleben/politik-ignoriert-zweifel-am-grenzwert-40-mikrogramm-dieselpanik-wegen-grenzwertluege-in-ihrem-buero-ist-20-mal-so-viel-stickstoff-erlaubt_id_7378545.html

[HEIS] https://www.heise.de/forum/heise-online/News-Kommentare/2018-koennen-Elektroautos-fuer-Endkunden-guenstiger-sein-als-Verbrenner/Re-430-000-Europaeer-sterben-jaehrlich-an-Feinstaub/posting-14242020/show/

[KIT] http://www.ifkm.kit.edu/Abgasmessung-Fragen-und-Antworten.php

[LEIS] https://eike.institute/2017/08/20/das-kartell-der-dummheit-irrenhaus-deutschland-wie-wir-mit-dem-diesel-unsere-grundfesten-demontieren-teil-1-stickoxide-der-grosse-anteil-natuerlichen-ursprungs/

[LEIS2] https://eike.institute/2017/08/21/das-kartell-der-dummheit-irrenhaus-deutschland-wie-wir-mit-dem-diesel-unsere-grundfesten-demontieren-teil-2-stickoxide-die-fehler-des-umweltbundesamtes-der-t/

[LUST] https://www.stadtklima-stuttgart.de/index.php?luft_luftinstuttgart

[MAKW] https://safety.physik.unibas.ch/Downloads/Factsheet–grenzwerte.pdf

[MCDO] https://www.ncbi.nlm.nih.gov/pubmed/25842615

[MERK] http://www.spiegel.de/auto/aktuell/merkel-haelt-ende-von-verbrennungsmotoren-fuer-richtigen-ansatz-a-1162820.html

[MUEL] https://eike.institute/2016/07/22/einsatz-der-oeko-garotte-gegen-das-auto-dieselverbote-der-vernichtungsfeldzug-gegen-eine-deutsche-top-industrie/

[NIEM] https://eike.institute/2016/01/21/dieselgate-was-sagen-uns-die-zahlen/#comment-184943

[NOAEL] Empfehlungen des Wissenschaftlichen Komitees der EU für Grenzen beruflicher Exposition gegenüber NO2 SCOEL/SUM/53 vom Juni 2013 (Ref. Ares(2013)2611731 – 09/07/2013, GSW 1421 82-48

[NOZ] https://www.noz.de/deutschland-welt/vermischtes/artikel/629895/gefahrliche-stoffe-kommen-aus-dem-auspuff

[NO2GE] http://gestis.itrust.de/nxt/gateway.dll/gestis_de/001090.xml?f=templates$fn=default.htm$3.0

[NOMA] https://de.wikipedia.org/wiki/Stickstoffmonoxid

[NO2MA] https://de.wikipedia.org/wiki/Stickstoffdioxid

[PETE] http://www.stern.de/gesundheit/diesel-abgase–grenzwerte-fuer-stickoxide-und-feinstaub-zu-hoch-7569076.html

[PETE2] https://www.helmholtz-muenchen.de/epi2/the-institute/staff/staff/ma/362/Prof.%20Dr.-Peters/index.html

[SELB] http://derstandard.at/2000059138106/Merkel-Selbstfahrende-Autos-in-zwanzig-Jahren-Pflicht

[SPIE] Kommentator #7 HansGustor in http://www.spiegel.de/spiegel/stuttgart-eine-autostadt-auf-der-suche-nach-einer-neuen-mobilen-zukunft-a-1161847.html#js-article-comments-box-pager

[SUED] http://www.sueddeutsche.de/auto/internationale-automobil-ausstellung-merkels-motorvisionen-1.29734

[THAL] European Environment Agency EEA Report No28/2016 Air Quality in Europe – 2016 report https://www.eea.europa.eu/publications/air-quality-in-europe–2016

[TUDA] http://indigo.meteor.tu-darmstadt.de/umet/script/Kapitel1/kap01.html#%C3%BCber1-6-3

[UBA] UBA Bericht Entwicklung der Luftqualität in Deutschland UBABerichtLuftqualität3760-6 (2009)