Nun also ist die Stunde der Wahrheit gekommen, und man muss erklären, endlich, das Klimaziel 2020 muss aufgegeben werden. Na, das wird 2028, wenn 2030 vor der Tür steht, auch nicht anders sein.

Schon die Definition von „Zielen“ ist ein übler Spuk, eigentlich brauchen wir nicht Ziele, sondern Konzepte, die klar durchgerechnet und von Jahr zu Jahr kontrolliert werden können, aber dazu kann sich das politische System nicht durchringen, das wäre ja auch zu ehrlich. Von einer Regierung, die Verantwortung wirklich ernst nimmt, muss man verlangen, dass klar definiert wird, was will man erreichen, wie kommt man dahin, und was kostet das. Für das einfache Volk jedoch müssen nebulöse Wunschvorstellungen reichen, so eine Art moderner Fatah morgana. Und, brauchen wir überhaupt ein Klimaziel ? Dazu gibt es ganz aktuell auch eine Veröffentlichung (hier):.

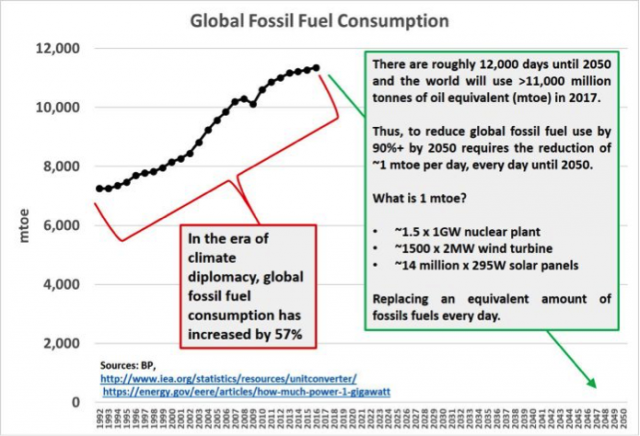

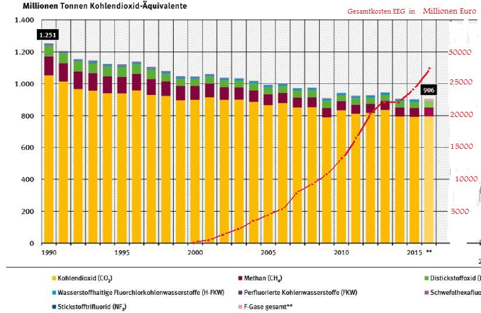

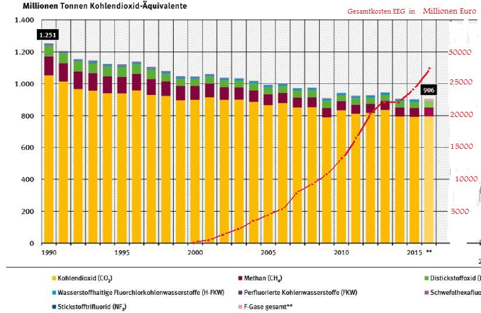

Wo wir heute wirklich stehen, zeigt die nachfolgende Grafik:

Dieses Diagramm stammt aus dem „Masterplan Weserbergland“, ist also eine offizielle Statistik, und ich habe in dieses Diagramm nun die (jährlichen) Aufwendungen für die „Erneuerbaren“ eingetragen, es sind erhebliche Beträge mit zur Zeit ca. 28 Milliarden Euro pro Jahr.

Man vergleicht mit 1990, und damit lügt man sich schon mal ordentlich in die Tasche, hier hat der CO2-Ausstoß zwar tatsächlich abgenommen, aber das hat mit Klimaschutz nichts zu tun (ist kein Erfolg irgendeiner Energiepolitik), sondern es ist die Folge der Wiedervereinigung, verbunden mit der Abwicklung der total veralteten sozialistischen Wirtschaft in der DDR und den angrenzenden Ostblockländern (weiter östlich, in Russland, findet eine Modernisierung der Technik auch heute nahezu nicht statt). Dass man veraltete Technik durch modernere ersetzt ist vernünftig, das hätte man auch ohne einen Hinweis auf Klimaschutz gemacht, und ist im Westen schon in den 50-er Jahren geschehen.

Die Investition in die Erneuerbaren (über das EEG) beginnt in 2000. Einen kurzen Rückgang der CO2-Emissionen hat es zuletzt noch in 2009 gegeben, das war eine Folge der Finanzkrise, seitdem haben wir Jahr für Jahr weiter steigende Subventionen für die Erneuerbaren aufbringen müssen, jedoch ist noch nicht mal eine Tendenz erkennbar, dass sich das in Reduzierung von CO2 auswirkt oder jemals auswirken wird. Die Gründe dafür sind gut bekannt, denn da die Speichermedien fehlen, braucht jede EE-Einheit ein Backup-Kraftwerk gleicher Größe, um das Netz stabil aufrechtzuerhalten, und man gewinnt nichts. Im Netz muss der tatsächliche Bedarf an elektrischer Energie sekundengenau ausgeglichen werden, sonst gerät man in die Gefahr eines „Blackouts“, also eines Zusammenbruchs der Energieversorgung für Stunden oder Tage. Das heute über die technische Entwicklung von über 100 Jahren entstandene Netz ist sogar noch anspruchsvoller, auch die Frequenz hat nur eine zulässige Toleranz von ca. 0,1 Hz, für die Versorgung einer solchen Technik ist die durch Wind und Wetter stark schwankende Leistung der Erneuerbaren natürlich nicht geeignet. Man kann die Charakteristik der Erneuerbaren in einem einfachen Dreisatz darstellen:

1.) Nachts ist es dunkel. Das kann man politisch nicht ändern.

2.) Der Wind weht, wenn er will, und nicht, wenn er soll.

3.) Die Speicher fehlen, sie sind technisch und ökonomisch nicht darstellbar.

Das sagt eigentlich alles, man kann die Erneuerbaren einpacken. Das geschieht übrigens auch, klamm-heimlich natürlich, denn niemand möchte eingestehen, dass man in gigantischer Weise Fehler gemacht hat, Beispiele dazu später.

Aus dem oben dargestellten Diagramm ist ersichtlich, dass mit den Erneuerbaren für den Klimaschutz eigentlich nichts erreicht werden kann. Dazu muss man dann drei Forderungen aufstellen:

1.) Wir müssen den Bürgern die Wahrheit sagen. Die Erneuerbaren, so, wie wir sie heute haben, sind für den Klimaschutz nutzlos.

2.) Ein weiter so darf es nicht geben. Zumindest muss die Subventionierung dieser offensichtlich nutzlosen Technik beendet werden.

3.) Die Politiker, die diesen Schaden zu verantworten haben (es ist ein Schaden in finanzieller Hinsicht, in Umweltzerstörung und Ressourcenverschwendung) müssen zur Verantwortung gezogen werden.

Die naturwissenschaftlichen und technologischen Gegebenheiten sind so, dass zu erkennen ist, dass sich an dieser Situation in absehbarer Zeit nichts ändert. Wenn wir also für den Klimaschutz nichts erreichen, stellt sich doch die Frage, kann man die Erneuerbaren denn wenigstens auch sonst noch irgendwie brauchbar einsetzen.

Abgesehen von der Volatilität, die nicht beherrschbar ist, kommt ein weiterer Nachteil hinzu, die erneuerbare Energie kommt zunächst kostenlos auf uns zu (der Wind weht und die Sonne scheint, ohne dass wir dafür etwas bezahlen müssen), aber diese Energie ist „dünn“, das heißt, sie ist über eine große Fläche verteilt, der Flächenbedarf ist riesig, und wenn man diese „dünne“ Energie einsammeln will, muss man große Flächen mit Technik zubauen, man muss diese Flächen der Natur entziehen und in eine Industrielandschaft verwandeln, das ist vom Umweltschutz her gesehen natürlich extrem nachteilig.

Ein einfaches Nachrechnen mit dem Taschenrechner zeigt, dass der gesamte Bedarf an Primärenergie (der Bedarf ist rund fünf mal so groß wie der elektrische allein) für Deutschland, selbst wenn man alle Wälder, Natur- und Landschaftsschutzgebiete auch noch einsetzt, nicht gedeckt werden kann, es bleibt eine erhebliche Lücke. Die Ideologen, die die Propaganda der Energiewende betreiben, haben dazu noch andere Vorstellungen entwickelt, man müsste den Energiebedarf eben deutlich reduzieren, durch Steigerung von Effizienz und Suffizienz. Die Steigerung der Effizienz, also das Bemühen mit weniger Energie-Aufwand dasselbe Ziel zu erreichen, ist praktisch zum Stillstand gekommen, die Potentiale sind hier längst ausgeschöpft, da sind nur noch Reste von wenigen Prozent erreichbar. Der oben erwähnte „Masterplan Weserbergland“ fordert eine Reduzierung des Verbrauchs um 50 Prozent (sonst kann man die Welt nicht retten).

Dann bleibt Suffizienz, was wird hinter diesem Fremdwort versteckt ? Nun, es ist die Vorstellung, unser Lebenswandel ist sündig, wir verbrauchen eigentlich mehr als uns zusteht, es wird also eine beträchtliche Einschränkung an Verbrauch und damit auch eine Minderung des Lebensstandards gefordert. Wir führen also die Technik des Mittelalters ein (also die Windmühlen), und dazu passend reduzieren wir auch den Lebensstandard auf die Zeit vor Erfindung der Dampfmaschine Diese Vorstellungen gibt es tatsächlich (z.B. „klimaneutrales Berlin“.), in der praktischen Konsequenz das durchzusetzen, das laut zu sagen wagt dann doch niemand.

Wenn also klar ist, dass die „Energiewende“, also der Ersatz des gesamten Energieverbrauchs durch Erneuerbare weit jenseits jeder Realität liegt, kann man nicht wenigstens Teile des Energieverbrauchs (oder wenigstens des elektrischen Verbrauchs) durch Erneuerbare gestalten ?

Voraussetzung für die praktische Verwendung der Erneuerbaren ist die Bereitstellung der Speichereinheiten, denn dann könnte man den volatilen Strom soweit glätten, dass er nach dem jeweiligen Bedarf in Netz eingespeist werden kann, und soweit das gelingt kann man dann auch die Bereitschaft (und den zugehörigen Leerbetrieb) der konventionellen Anlagen einschränken, und dann ergäbe sich zum ersten Mal tatsächlich so etwas wie Klimaschutz, also eine tatsächliche Reduzierung von CO2-Ausstoß.

Was brauchen wir denn nun tatsächlich ? Das hängt von der Energiequelle ab, wir gehen die Beispiele mal durch.

- A) Wasserkraft.

Hier brauchen wir kaum Speichereinheiten, der Speicher ist der Obersee mit seinem Energievorrat, der ist natürlich vorhanden, abgesehen in einem strengen Winter, wenn Vereisung den Betrieb beschränkt, was aber kaum vorkommt. Aber, Wasserkraft ist nicht weiter ausbaubar und hat nur einen sehr kleinen Anteil (ca. 1 Prozent) am Energieaufkommen.

- B) Erdwärme, Geothermie

In bescheidenem Maß für die Beheizung von Wohnraum einsetzbar, der Investitionsbedarf ist sehr hoch, in städtischen Bereichen ist das nicht realisierbar. Es gibt eine kleine Versuchsanlage in der Größenordnung von etwa 70 kW. Größere Versuche scheiterten, weil es dann zu seismischen Erscheinungen kam und die Sicherheit von Gebäuden gefährdet war. Für die elektrische Verwendung eigentlich unbrauchbar, da die Temperaturdifferenz sehr klein ist und der thermische Wirkungsgrad (Carnot) dann sehr bescheiden ist.

- C) Bio-Energie, Biogas usw.

Der Vorteil: Bio-Energie ist grundlastfähig, man braucht keine Speicher. Die Nachteile aber sind gewaltig. Am Anfang der Bio-Energie steht die Photo-Synthese, und die hat einen Wirkungsgrad von nur 0,7 Prozent, damit hat man wieder einen riesigen Flächenbedarf. Wie er hier wirklich aussieht, sagt die bekannte Leopoldina-Studie, ich zitiere wörtlich: „Der Input an fossiler Energie in Landwirtschaft und Verarbeitung von Biomasse zu Biobrennstoffen übersteigt häufig den Bioenergie-Output.“ Was „häufig“ an Zahlenwerten wirklich bedeutet, das herauszufinden ist mir bisher nicht gelungen, es gibt aber Studien, die zeigen, dass man für einen Liter Bio-Diesel gut 2 Liter fossilen Diesel braucht, also ein wirtschaftlich unsinniges Verfahren. Damit hängt es auch zusammen, dass Bio-Energie massiv subventioniert wird und sich nur so halten kann. Ein weiterer gravierender Gesichtspunkt ist auch, dass die Bio-Energie in direkter Konkurrenz zur Nahrungsmittelerzeugung steht, und da Deutschland ein Netto-Importeur an Nahrungsmitteln ist bedeutet jeder Quadratmeter Boden, der hoch-subventioniert für die Bio-Energie zur Verfügung gestellt wird, in Wahrheit Export von Hunger in die Welt.

In bescheidenen Grenzen kann man an die Verwertung von Abfällen denken, das geschieht auch (z.B. Müll-Verbrennung). Aber, in einer biologisch geführten Landwirtschaft gibt es gar keine Abfälle. Abfälle kann man aus der Massen-Tierhaltung verwenden, die aber natürlich auch unter ethischer Kritik steht, da allein für die Futterversorgung der Tiere Nahrungsmittel aus der dritten Welt importiert werden, die dort für die Versorgung von Menschen fehlen. Kleinere Mengen von biologischen Abfällen werden gesammelt und verwertet, in ländlichen Gegenden lohnt sich das aber auch nicht, die „Bio-Tonne“ gibt es dort nicht, weil allein das Einsammeln mehr Energie verbraucht als man am Ende gewinnt.

Fazit also: Bio-Energie ist also, abgesehen von geringen Beständen an Abfallverwertung, für die Energieversorgung insgesamt ungeeignet.

-

D) Photovoltaik, PV

Die Sonne soll es bringen, das klingt doch so schön. Aber, wie oben schon erwähnt, nachts ist es dunkel. Also brauchen wir hier die Speicher, sonst geht gar nichts. Dass es nachts dunkel ist, ist noch das kleinere Problem, denn dann bräuchte man ja nur einen Speicher für einige Stunden. Von daher könnte PV eine gewisse Möglichkeit für Länder in der Nähe des Äquators sein. Für die europäischen Länder aber stellt sich die Problematik der Jahreszeiten, denn gerade in der Winterzeit, wenn der Energiebedarf im größten ist, liefert PV wenig oder fast nichts. Das bedeutet konkret, man braucht einen Speicher, der die im Sommer eingesammelte Energie aufnimmt und für den Winter bereit stellt. Das ist nicht zu realisieren, und damit ist die Photovoltaik für unsere Breitengrade für die Energieversorgung nicht geeignet.

Nun könnte man denken, es wäre doch immerhin noch nützlich, wenn man die Nachtstunden durch Speicher überwindet und dann wenigstens in den Sommermonaten eine brauchbare Energietechnik hat. Das ist aber zu kurz gedacht, denn die konventionellen Anlagen muss man wenigstens für die Winterzeit vorhalten, und was macht man dann im Sommer, dann stellt sich die soziale Frage, schickt man die Arbeiter nach Hause und bezahlt dann „Sonnengeld“? Das wäre volkswirtschaftlich unsinnig, und auch die kleine PV-Hausanlage müsste man stark besteuern, weil diese ja die übrige Versorgung in ungünstige Betriebsbereiche treibt (diese ist also in Wahrheit sozial-schädlich).

Fazit: die notwendigen Speichereinheiten sind nicht realisierbar. PV-Anlagen auf Feldern müssten abgebaut werden, und die Felder werden der Natur (und der Versorgung mit Nahrungsmitteln) wieder zurückgegeben. PV-Anlagen auf Dächern können bleiben, die stören ja zunächst einmal nicht (sieht ja auch ganz hübsch aus) , aber man muss doch kontrollieren, dass sozial-schädlicher Betrieb unterbleibt oder wenigstens durch Besteuerung ausgeglichen wird.

-

E) Windenergie

Hier hat man nun gleich beide Probleme, der Flächenbedarf ist riesig, also man muss weite Flächen der Natur entnehmen und in Industrielandschaften umwandeln, und dann kommt die Volatilität hinzu, die Versorgung ist unzuverlässig und schwankt unplanbar zwischen Höchstwerten und Werten bei null. Letzteres ist der Grund, warum man diese Technik, die ja so preiswert ist, Wind kostet ja nichts, in der Vergangenheit aufgegeben hat. Unsere Windmühlen wurden etwa 1860 auf Dampf umgestellt, man bezahlt lieber Kohle und hat eine stete und planbare Versorgung. Die letzten Segelschiffe für den Frachtverkehr wurden um 1930 aufgegeben, auch da war dann das Faktum, der Wind ist zwar umsonst, aber so unzuverlässig, dass er mit den Dampfern nicht mithalten konnte. Wie heißt es im „Fliegenden Holländer“ so schön: „Wer auf den Wind baut, baut auf des Satans Erbarmen“. Das ist eine alte Menschheitserfahrung.

Energiewende (also nicht nur elektrischer Strom ) ist also schon vom Flächenbedarf her nicht zu realisieren. Frage also, geht es denn wenigstens mit der Stromwende, oder einen beträchtlichen Anteil davon ?

Für eine zuverlässige Versorgung stellt sich sofort die Frage der Speicherung. Alle Versuche dazu sind bisher krachend fehlgeschlagen (dazu weiter unten mehr), es gibt einfach kein tragfähiges und einigermaßen durchgerechnetes Konzept. Da man hier kein Konzept hat und sich das auch nicht eingestehen will, stürzt man sich in Aktionismus und plant und baut die Leitungssysteme, die man zwar auch braucht, die aber ohne Speicherung keinen Sinn machen, was nützt eine Leitung, durch die tagelang kein Strom fließt ?

Welche Speicher braucht man denn wirklich ? Ausführlich beschäftigt sich damit Prof. Sinn in seinen Vorträgen, jetzt ganz neu: (https://www.youtube.com/watch?v=xzXAZad3TcE) Allein um den jetzt schon vorhandenen Ausbau an Wind (und Sonne) mit Speichern zu versorgen kommt man nach seinen Berechnungen auf eine Anforderung von 3000 bis 6000 Pumpspeicherwerken, Deutschland hat 35 davon, dabei auch kleinere, die an diese Anforderungen nicht herankommen, das ist also vollkommen illusorisch.

Die andere Möglichkeit ist noch die Speicherung über chemische Energie, also Akkumulatoren. Da hat Enercon etwas vorgestellt, wörtlich: „Es ist der bislang größte Batteriespeicher in Deutschland“, das Pilotprojekt RRKW bei Feldheim (Windblatt 03-2015). Von der äußeren Größe wohl beeindruckend, etwa ein halbes Fußballfeld, und was es kostet, wird nicht verraten. Allerdings für die Stromwende bräuchte man dann 2 Millionen Stück davon, für die Energiewende dann doch 10 Millionen Stück, also für je 8 Bundesbürger eines, und die müssten das bezahlen, warten und in Betrieb halten. Da wird dann sofort klar, das ist weit jenseits jeder Realität.

Weitere Beispiele irrsinniger Ideen will ich hier ersparen.

Die gegenwärtige Realität.

Man hat wohl unter der Hand eingesehen, dass es praktische Möglichkeiten für eine Speicherung nicht gibt, jedenfalls wird dazu konkret nichts angefangen. Daher müssen nun die konventionellen Anlagen einspringen und die fehlenden Speicherungen ersetzen, und für eine solche Betriebsweise sind diese aber nicht konzipiert. Kohlekraftwerke und Kernkraftwerke laufen in der Grundlast, ein Kohlekraftwerk braucht zum Anheizen 8 Stunden oder mehr (Kernkraftwerke sind spürbar schneller, aber die will man ja vernichten), und es muss ständig in Betrieb gehalten werden, da es ja den Totalausfall der Erneuerbaren (die sog. „Dunkelflaute“) sofort ausgleichen können muss. Das Kohlekraftwerk ist so konzipiert, dass es rund um die Uhr im Dauerbetrieb läuft, nur dann hat es den besten Wirkungsgrad. Wenn man nun herunterregeln soll (weil gerade Wind kommt, der gesetzlich „Vorrangeinspeisung“ hat, ohne diesen Zwang würde das niemand abnehmen), dann gerät die Anlage in ungünstige Betriebszustände (und erhöhten Reparaturbedarf) und verbraucht ungünstig viel Kraftstoff. Wenn das schnell gehen soll, dann hilft man sich anders, man verschiebt die Phase (um 180 Grad) und packt die überschüssige Energie, die man anders nicht los wird, in die Überlandleitungen, die allerdings auch nur bis zu etwa 80 Grad Celsius aufgeheizt werden dürfen. Also, um die Erde zu kühlen heizen wir kräftig die Leitungen. Wenn das auch nicht reicht, dann geht das in den „Export“ (man nennt das „Export“), allerdings, der ist ziemlich teuer, für die Nachbarländer ist unser „grüner“ Strom eigentlich nur Sondermüll, der stört dort die Netze, und das lässt man sich bezahlen (sog. „negative Preise“), und auch das geht in die EEG-Umlage Auf einen Export-Überschuss, den man teuer bezahlen muss, sollte man eigentlich besser verzichten, aber die Volatilität der Erneuerbaren, die man sonst nicht beherrschen kann, erzwingt dies. Die Folgen dieser Konzeption haben wir oben im Diagramm gesehen, der CO2-Ausstoß geht nicht zurück, und es ist auch nicht erkennbar, wie das anders werden wird. Man bezahlt also zwei Systeme, die konventionellen Anlagen kommen sogar in ökonomische Schwierigkeiten, da sie bei halber Last oder weniger dann nicht mehr genug verdienen, um ihre Arbeiter zu bezahlen. Das einzige, was wirklich gut läuft, sind die Profite der Anlagenbetreiber, nur das allein ist dem System wichtig, eine extrem unsoziale Umverteilung von unten nach oben.

Wie geht es nun weiter ?

Man macht unverdrossen weiter, obwohl alle Voraussetzungen für eine solide Entwicklung fehlen, die Propaganda läuft und verkündet stolz neue Erfolgszahlen und gaukelt Klimaschutz vor, aber das sind Schein-Erfolge, eben nur Durchschnittswerte an elektrischer Leistung, die die Taschen der Anlagenbetreiber füllen. Zu einem brauchbaren System kommt man nicht, denn die Konventionellen müssen trotzdem in voller Kapazität in Bereitschaft gehalten werden, man kommt vermehrt in Phasen, in denen zu viel produziert wird (und zu anderen Zeiten nichts, nach wie vor), und das ist auch nur schädlich, da man den dann notwendigen Export zusätzlich bezahlen muss, oder, wenn das nicht geht, müssen erneuerbare Anlagen zurückgeregelt werden, aber dafür, dass sie weniger liefern, bekommen sie trotzdem noch den vollen Preis, und es wird nur zusätzlich teurer, und das alles ohne einen wirklichen Nutzen. Das ist die Situation, solange das EEG, wenn auch leicht „gedeckelt“ in Kraft bleibt, was am Ende eine rein politische Frage ist. In der Politik wird von einigen Seiten versprochen, dass „die Kohle“ nun zurückgefahren werden soll, selbst Ausstiegstermine werden phantasiert, aber wie das konkret gehen soll, das weiß kein Mensch. Wenn praktische Konzepte fehlen, dann müssen eben Sprüche reichen. Dann gibt es auch Vorgänge, dass man mit Gewalttätigkeiten gegen Anlagen des Bergbaus vorgeht, aber damit kann man natürlich nicht naturwissenschaftliche Gegebenheiten und technologische Zwänge aufheben, eine Mischung von Brutalisierung und Hilflosigkeit zugleich.

Für die ältesten Anlagen ist die Stunde der Wahrheit schon gekommen, Panorama 3 berichtete darüber in einer aktuellen Sendung

https://www.ndr.de/nachrichten/schleswig-holstein/Rueckbau-bei-Windraedern-oft-mangelhaft,windkraft920.html

Schon der Abbau der Fundamente bringt erhebliche Probleme, und man versucht, die gesetzlichen Vorschriften zu umgehen. Und warum wird denn da abgebaut ? Im Nebensatz kommt verschämt die Erläuterung, wörtlich: „sei es dass die Nutzungszeit der Anlagen abgelaufen ist und damit dann der Rückbau fällig wird“ . Mit „Nutzungszeit“ ist hier offensichtlich die Zeit der Subventionierung gemeint, und es wird deutlich, ohne Subventionierung geht bei den Erneuerbaren nichts. In einem Zeitraum von sage und schreibe 20 Jahren wurden in diese Anlagen erhebliche Mittel gesteckt, geliefert wurde ein weitgehend wertloses Produkt, eben „Flatterstrom“, den man im Netz eigentlich nicht gebrauchen kann, und in der Propaganda wurde uns immer erzählt, das sei ja eine „Anschubfinanzierung“, mit der die Marktreife erreicht werden soll. Diese Marktreife ist offensichtlich nicht erreicht worden, denn ohne „Vorrangeinspeisung“ ist niemand bereit, dieses Produkt abzunehmen, im Gegenteil, beim Abschub in das Ausland gibt es „negative Preise“, und damit kann man allein den Erhalt der Anlagen nicht bezahlen.

Aus alledem ist festzuhalten: die Anlagen an Erneuerbaren, die wir heute noch bauen, sind für den Klimaschutz nutzlos (da die Speichereinheiten fehlen und weiter fehlen werden), sie sollen für 20 Jahre erhebliche Subventionen erhalten, und nach dieser „Nutzungszeit“ müssen sie abgebaut werden, da die Marktreife nicht erreicht werden kann. Einzige Schlussfolgerung: dieser Irrsinn ist umgehend zu beenden (also EEG abschaffen), ohne Subventionierung wird niemand solche Anlagen bauen, das hat sich dann von allein erledigt, und Natur und Umwelt können aufatmen. Mit den dann eingesparten Beträgen, ca. 30 Milliarden pro Jahr, könnte man an die wirklich dringenden Aufgaben herangehen, also z.B. Sanierung der Schulgebäude oder der übrigen Infrastruktur.

Einen sehr lesenswerten Beitrag zu dieser Problematik gibt es auch hier:

https://docs.google.com/viewerng/viewer?url=http://www.vernunftkraft.de/de/wp-content/uploads/2017/12/171225-Kompendium.pdf&hl=de

Die Flops

Es ist immer dasselbe, von Zeit zu Zeit wird eine neue Sau durchs Dorf getrieben, also ein neues, vielversprechendes Projekt wird angekündigt. Da gibt es eine feierliche Eröffnung, mit Reden des Ministerpräsidenten, die schöne und heile Welt der erneuerbaren Energie wird verkündet. Bald danach stellt man fest, die Sache läuft total aus dem Ruder, zumindest finanziell, keiner möchte lange mehr zuzahlen für eine Sache, die doch nichts wird, also, es wird dann doch wieder alles abgebaut, das dann ohne feierliche Reden, klammheimlich eben. Und um das zu vertuschen erklärt man uns, man hätte ja ernsthaft so etwas wie Energiewende gar nicht vorgehabt, man hat nur soeben mal ein bisschen rumexperimentiert, ohne konkretes Ziel, das muss man sich schon mal ein paar Milliönchen kosten lassen.

Die Liste dieser Flops will ich in einem späteren Beitrag zusammenstellen.