Zur Anhörung LT Brandenburg am 18.4.8

von Michael Limburg VP EIKE

Im Antrag wird die Frage gestellt: „Wie könnte die Akzeptanz der Windenergie erhöht werden?“.. das bedeutet ganz klar- auch die fast hilflos zu nennenden Vorschläge meiner Vorredner, lassen diese Deutung zu, dass

..die Akzeptanz der Windenergie in Brandenburg offensichtlich an ihrem Ende angekommen ist.

Denn anders lässt sich dieser Antrag der Grünen nicht erklären.

Die Gründe dafür liegen auf der Hand. Sie sind jedoch keinesfalls darin zu suchen, dass die betroffenen Bürger nicht ausreichend informiert wurden, oder dass bei den vorausgehenden Planungen zu wenig „Transparenz“ herrschte,

..oder dass die Bürger nicht darüber Bescheid wüssten, wer die Profiteure –Sie nennen Sie „Akteure“- sein werden, und wie sie ggf. selber in den Genuss solcher Profite kommen können.

…Oder, dass zu wenig Werbung für die Windkraft gemacht wurde.

Die hier geladenen Experten der Windkraftindustrie belegen just das Gegenteil, denn sie tun – Tag für Tag für Tag– nichts anderes als das.

Nein! Die Gründe liegen allein darin,

- ..dass die Nutzung der Windenergie unermesslichen Schaden über die betroffenen Bürger gebracht hat.

- …Schaden, der sich in großflächiger Landschaftszerstörung äußert,

- ..Schaden am Eigentum der Bürger, deren Immobilien in der Nähe solcher Anlagen dramatisch an Wert verloren haben,

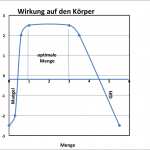

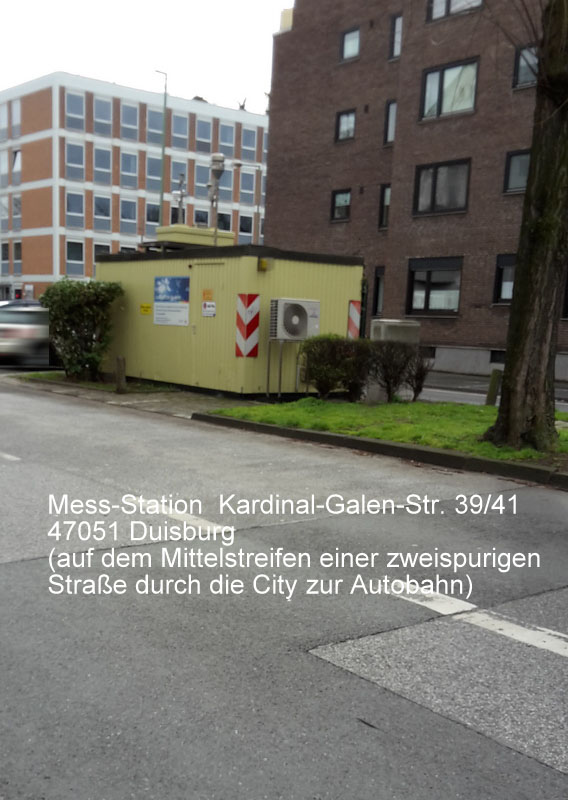

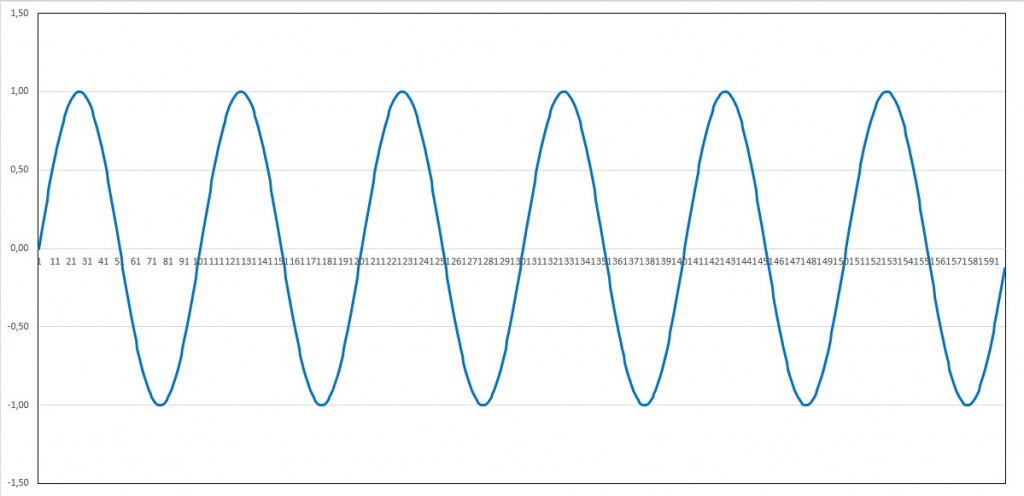

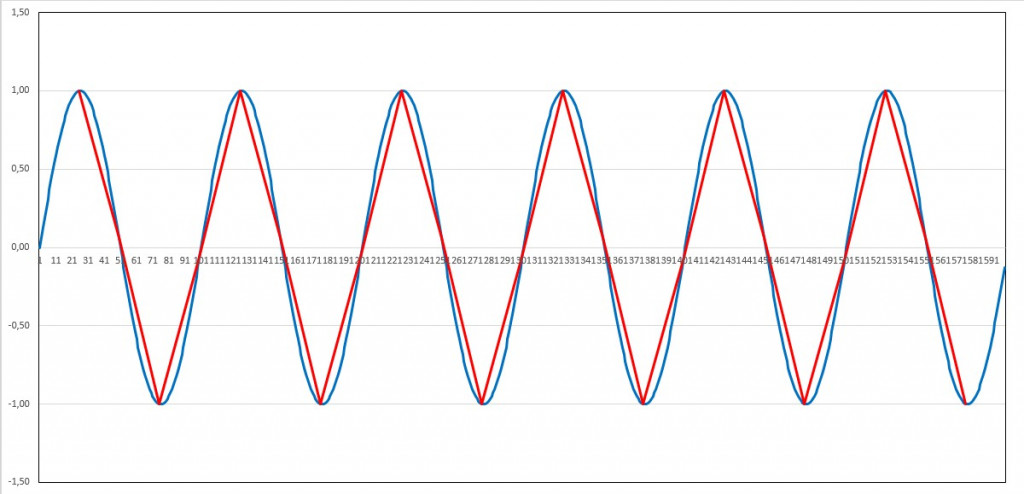

- ..Schaden an der Gesundheit der betroffenen Bürger, die durch den ständigen Infraschall, erzeugt durch diese Industriegiganten, oft dauerhaft beeinträchtigt wird. Und letztendlich direkter..(hinzugefügt: Details dazu hier ; mit Dank an Infraschallexperten Sven Johannsen von GusZ)

- ..Schaden am Geldbeutel aller Bürger, der durch die extrem hohen Stromkosten – Deutschland hat inzwischen die höchsten in Europa und Brandenburg steht ganz vorne auf der Liste- per Zwangsumlagen und Steuern verursacht wird.

Das sind die wahren Gründe für die mangelnde Akzeptanz.

Und alle die hier sitzen wissen das, oder müssten es wissen.

Insofern ist der Antrag der Grünen eigentlich an Zynismus nicht zu überbieten. Da sollen mit unwahren Behauptungen -ich werde im zweiten Teil meiner Rede darauf ausführlicher eingehen- mit Steuergeldern alimentierte Planstellen geschaffen werden, deren einzige Aufgabe darin besteht, die gebeutelten Bürger zu spalten

- zu spalten in

- Profiteure

- und Opfer-

- um dann über die Profiteure noch mehr von diesen, in jeder Hinsicht, unsinnigen unnützen und teuren, Anlagen aufzustellen.

- und die Opfer dieser Politik sollen das auch noch von ihren Steuergeldern bezahlen.

Ein wahrhaft zynischer Plan!

Lassen Sie mich nun zu Begründung des Antrages der Grünen vom 5.12.17 kommen, dazu muss ich etwas grundsätzlicher werden…

Darin heißt es dazu ganz am Anfang:

Der weitere Ausbau der Windenergie auf 2 % der Landesfläche in Brandenburg ist zur Umsetzungder Pariser Klimaschutzzielenotwendig.

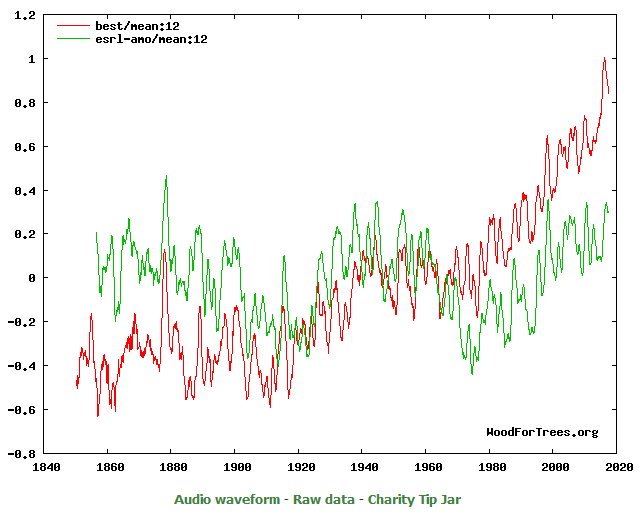

Diese Begründung könnte falscher nicht sein. Zunächst einmal deswegen, weil es bisher – trotz vieler milliardenschwerer Forschung – koordiniert durch den sog. Weltklimarat IPCC – keinerlei Hinweise, schon gar keine Beweise, dafür gibt, dass das menschgemachte CO2, auf irgendeine mysteriöse Weise die Temperatur der Atmosphäre dieses Planeten erwärmt. Es gibt nur Klimamodelle, die weder die Klimavergangenheit, noch die bereits vergangene Klimazukunft korrekt berechnen können.

Auch wenn viele -als Beweisersatz- behaupten, – dass 97 % aller Wissenschaftler der Überzeugung wären, dass der moderne Mensch mit seinen CO2 Emissionen daran schuld sei, ändert das nichts an den genannten Fakten.

Denn erstens ist dem nicht so:

Es gibt unzählige Studien, die zu genau gegenteiligen Erkenntnissen kommen und

zweitens

zählen demokratische Mehrheiten in der Wissenschaft nicht die Bohne.

Weder dreht sich die Sonne um die Erde, trotzdem die Mehrheit der Wissenschaftler über tausende von Jahren dieser Ansicht waren,

..noch sind beispielsweise die Kontinente fest auf der Oberfläche des Globus verankert. Auch das war mal eine Mehrheitsmeinung der Wissenschaftler! Sogar von hundert Prozent von ihnen.

Im Gegenteil…sie driften. Wenn auch sehr langsam.

Erst Alfred Wegener klärte Anfang des 20. Jahrhunderts diesen fundamentalen Irrtum auf und wurde dafür ausgelacht.

Und diese Aufzählung ließe sich beliebig verlängern.

Aber auch dann, wenn man an die Irrlehre vom menschgemachten Klimawandel glaubt, und die Delegierten in Paris taten so, als ob sie es glaubten,

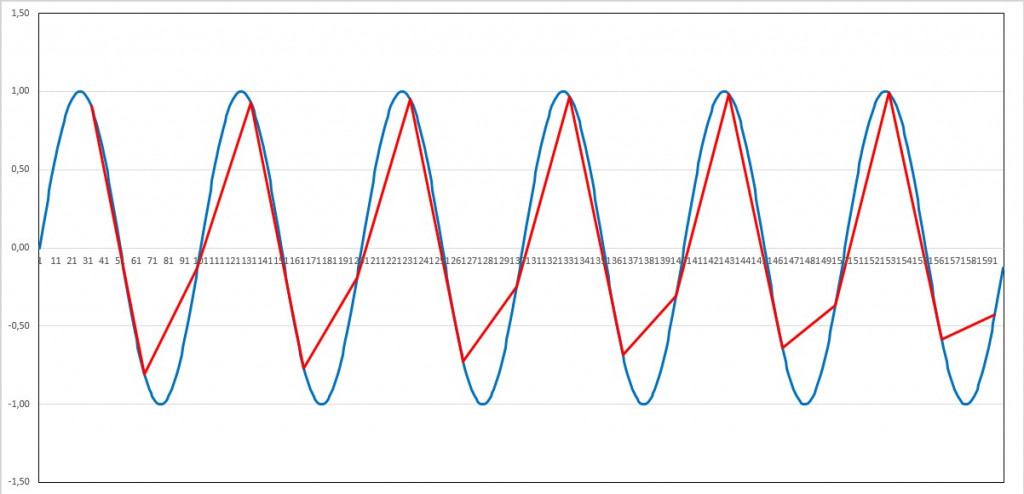

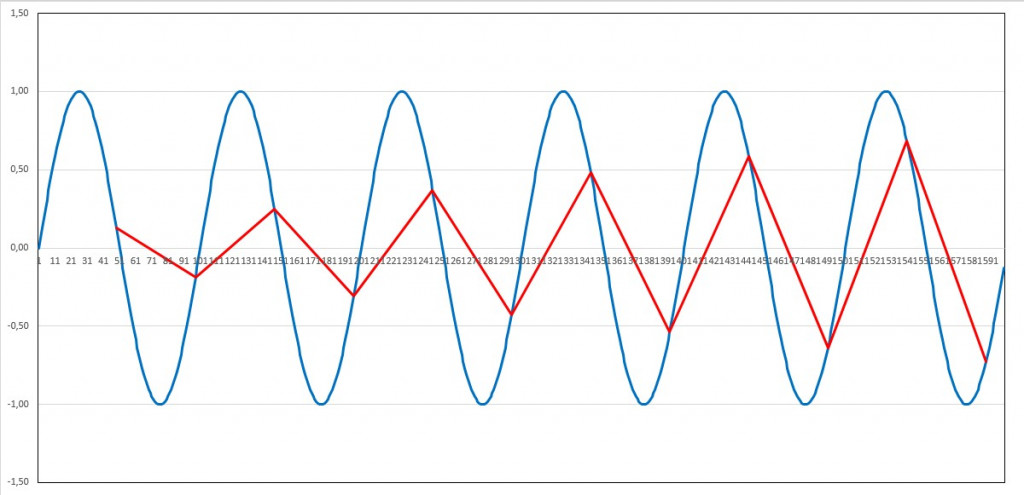

….objektiv sind Windkraftanlagen weder für den „Klimaschutz“

…noch für die Einsparung von „Ressourcen“,

….noch für Versorgung eines Industrielandes mit elektrischer Energie tauglich.

Das ist naturgesetzlich bedingt und könnte nur umgangen werden, – bei weiterer riesengroßer Kostenerhöhung-

…wenn es ausreichend Speicher für die so erzeugte Elektroenergie im großtechnischen Maßstab gäbe.

Die gibt es aber nicht und sie sind auch nirgendwo, auch nur ansatzweise, in Sicht.

Deshalb kann die geforderte Erhöhung der „Akzeptanz“ also nur dem Zweck dienen, die Bürger über die wahren Sachverhalte und unter Einsatz von Steuermitteln weiter grob zu täuschen.

Aber es gibt noch andere, schwerwiegende Gründe, die dagegen sprechen:

Zu ihnen gehört, dass es keinen Mangel an billigen, konventionellen Energieträgern gibt! Im Gegenteil, sie sind im Überfluss vorhanden.

Gerade wieder meldet Bahrein[1], die Entdeckung eines der größten Öl- und Gasfeldes der Welt. Es enthält eine Menge an fossilen Energieträgern (> 80 Mrd. Barrel) die gleich groß ist, wie die Vorräte der gesamtem russischen Föderation.

Selbst Deutschland könnte seine, im Vergleich zu anderen Ländern, knappen fossilen Energieträger u.a. mittels Fracking und dem Weiterlaufen, voll betriebsfähiger – mit Abstand sichersten- Kernkraftwerke der Welt- nutzen, um das Land voll mit sicherer, billiger, stets verfügbarer elektrischer Energie zu versorgen.

Aber damit nicht genug. Auch die zusätzliche Installation eines zweiten, – aus unserer Sicht- völlig überflüssigen, aber sehr teuren Stromerzeugungssystem aus „Erneuerbaren“ ist in jeder Hinsicht inakzeptabel. Denn der Markt wird dadurch ja nicht größer!

Nur das Angebot wird es.

Allein deswegen muss ja der so erzeugte Strom per Zwang über die Vorrangeinspeisung in die vorhandenen Leitung gepresst werden.

Und deshalb ist es nutzlos, viel zu teuer, gefährlich für die Bürger, mit allen negativen Folgen und zerstörerisch für unsere Landschaft und deren Flora und Fauna.

Eine Akzeptanzerhöhung wäre daher nur kontraproduktiv.

Auch die Antrags-Begründung gemäß dem Pariser Abkommen ist falsch: Richtig falsch! Warum?

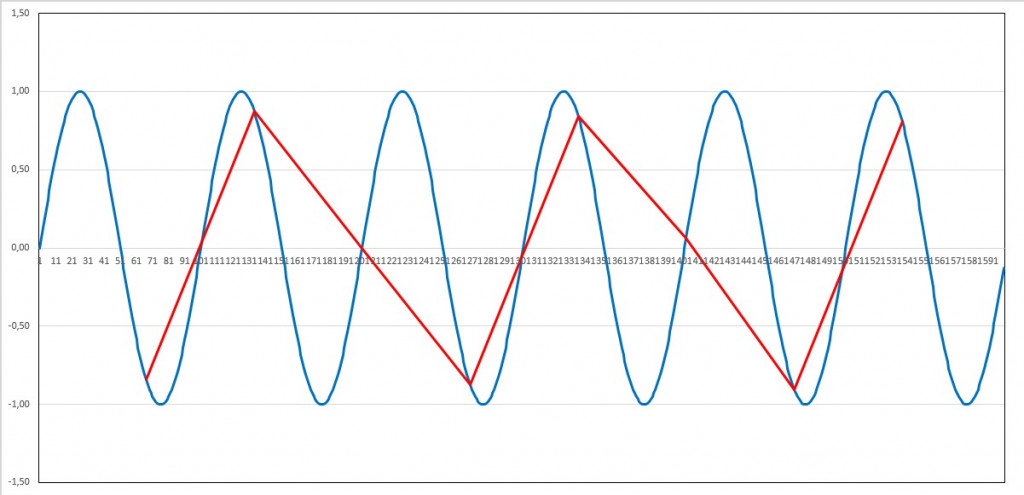

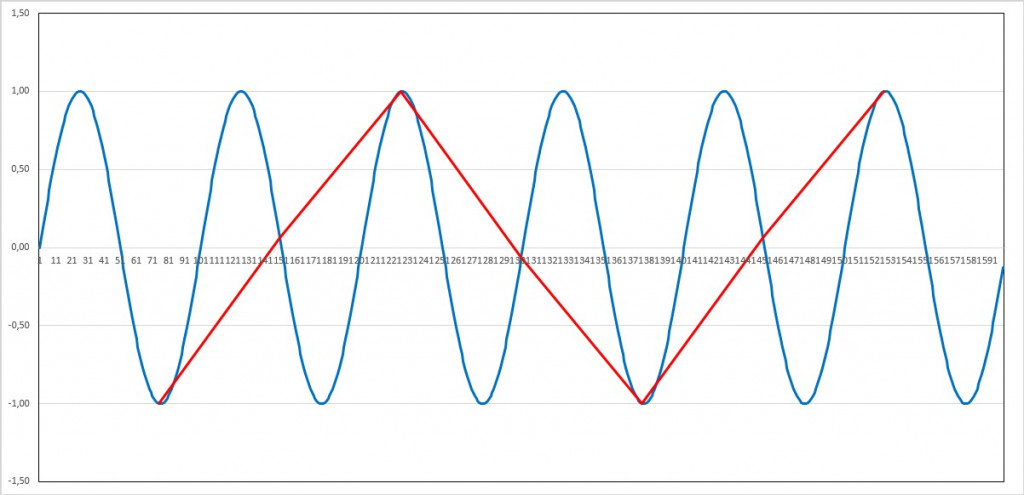

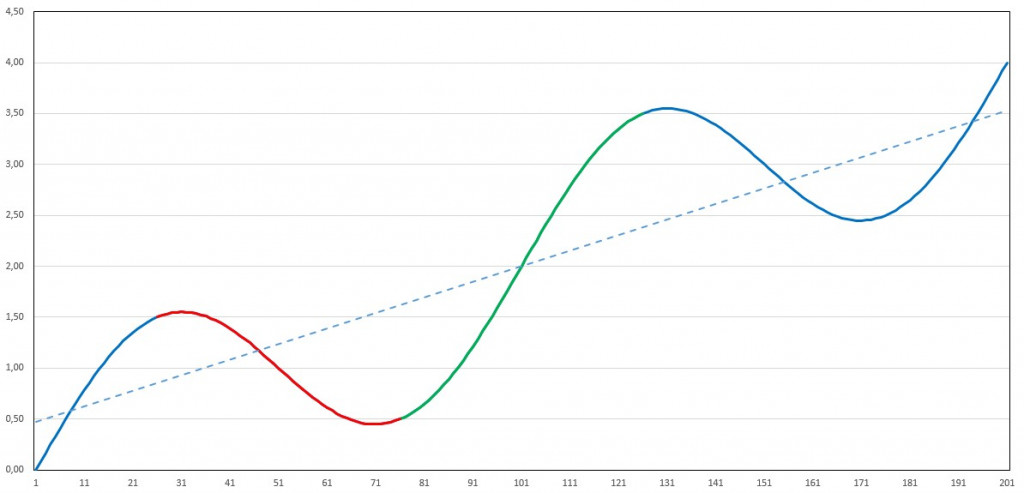

Brandenburgs CO2Emissionen betrugen 2017 rd. 59 Mio t CO2p.a.[2]. 2006 – also 11 Jahre zuvor- waren es 60,2 Mio t. Sie bleiben also defacto unverändert. In dieser Zeit hat sich aber installierte Leistung der WKA von 3.128 MW auf 6.776 MWmehr als verdoppelt [3].

Eine Wirkung auf die CO2Emissionen ist demnach nicht eingetreten. Die blieben praktisch konstant. Damit gab und gibt es auch keinen Beitrag zur Erreichung der Pariser Klimaziele. Dafür sind die Kosten explodiert.

Im Bund sieht es nicht anders aus. Die Emissionen blieben ebenso stabil wie 10 Jahre zuvor. Also hat Brandenburg auch nicht anteilig geholfen die Bundesemissionen zu senken. Nichts, nada, niente, zero, null!

Trotzdem zahlten die Verbraucher in 2017 rd. 30 Mrd. € über die Netzbeitreiber an die Erzeuger dieses Stroms

Und wg. der hohen Netzkosten werden die Verbraucher Brandenburgs noch mal zusätzlich zur Kasse gebeten. Denn der Wind wird ja nicht dort erzeugt, wo er gebraucht wird, sondern ganz woanders.

Und es gibt noch einen Grund, den niemand wegdiskutieren kann. Brandenburgs Anteil am Weltklimageschehen ist kleiner als mikroskopisch. Denn selbst dann, wenn man die CO2Emissionen hierzulande auf nahe oder ganz Null senken könnte, und, das wäre die einzige Folge – bei Inkaufnahme der völligen Verarmung der Bevölkerung- würde der Anteil Brandenburgs an der durchschnittlichen Temperaturabsenkung des „Weltklimas“ lediglich [4]0,000042 K betragen.

Das sind vier Nullen nach dem Komma und dann erst die Zahl!

Nochmals winzige:

4, 2 hunderttausendstel ° C (K)!!.

Daher mein Fazit: Die Grünen wollen mit ihrem Antrag die Profite der Windkraft Profiteure erhöhen und das zu Lasten der Bevölkerung. Und diese auch noch über ihre Steuern (per Landesmittel) zur Kasse bitten. Das ist nutzlos aber teuer und nur als zynisch und unlauter zu bewerten und daher abzulehnen.

[1]Quelle Shale Revolution 3.0: Bahrain Hits (Black) Gold With Biggest Shale Discovery In World

The Times, 5 April 2018

[2]Quelle http://www.lfu.brandenburg.de/cms/detail.php/bb1.c.296595.de

[3]Quelle: https://www.foederal-erneuerbar.de/landesinfo/bundesland/BB/kategorie/wind/auswahl/180-installierte_leistun/versatz/0/#goto_180)

[4]nach der Formel 3,0 x ln(Calt/Cneu)/ln2 = Dabei ist der Faktor 3,0, der sog. ECS Wert, Caltdie CO2 Konzentration vor der Absenkung, Cneudie CO2 Konzentration nach der Absenkung. Von dieser Menge verbleibt max. die Hälfte in der Atmosphäre. Und ln das Kurzzeichen für den natürlichen Logarithmus. Die Formel unterstellt eine Erhöhung von 3 K bei Verdopplung. (ECS Wert). Die Forschung geht inzwischen aber von 0,3 bis 1,1 K aus. CO2in der Atmosphäre (Calt) rd. 3000 Gt, das sind 3.000.000 Mio. t, Brandenburg emittiert 2017 59 Mio. t. Davon verbleibt max. die Hälfte in der Atmosphäre. D.h. nach Absenkung enthält die Atmosphäre rd. 3.000.000 Mio. t minus 29,5 Mio. t = 2.999.970,5 Mio t.

Diese Rede kann auch hier unter Anhörung LT Brandenburg Wirkung V4-5 und hier Anhörung 18.4.18 EE Einspeisung & CO2 V1 heruntergeladen werden. Ein link zu den Vorträgen der andern Experten wird – unmittelbar nach Vorlage- nachgereicht.