Ja, in Italien haben vor kurzem über 90 Wissenschaftler eine Petition unterzeichnet mit dem Titel: “Klima, eine Gegenstrom-Petition“:

————

An den Präsidenten der Republik

An den Präsidenten des Senats

An den Präsidenten der Abgeordnetenkammer

An den Präsidenten des Rats

19.6.2019

PETITION ZUR GLOBALEN ANTHROPOGENEN ERWÄRMUNG

Die Unterzeichnenden, Bürger und Wissenschaftler, schicken eine warme Einladung an die politischen Führungskräfte, eine Umweltschutzpolitik einzuführen, welche im Einklang mit den wissenschaftlichen Erkenntnissen steht.

Insbesondere ist es dringend, die Verschmutzung dort zu bekämpfen, wo sie auftritt, gemäß den Befunden der modernsten Wissenschaft. Diesbezüglich ist die Verzögerung beklagenswert, mit welcher der Wissensreichtum, der von der Welt der Forschung zur Verfügung gestellt wird, benutzt wird, um die anthropogenen Schadstoffemissionen zu reduzieren, welche sowohl in den kontinentalen als auch Meeresumweltsystemen weit verbreitet vorhanden sind.

Aber uns muss bewusst sein, dass KOHLENDIOXID SELBST KEIN SCHADSTOFF IST. Im Gegenteil. Es ist für das Leben auf unserem Planeten unentbehrlich.

In den letzten Jahrzehnten hat sich eine These verbreitet, dass die Erwärmung der Erdoberfläche um rund 0,9°C, welche ab 1850 beobachtet worden ist, anomal wäre und ausschließlich von menschlichen Aktivitäten verursacht werden würde, insbesondere durch den Ausstoß von CO2 in die Atmosphäre beim Gebrauch fossiler Brennstoffe.

Dies ist die These der anthropogenen globalen Erwärmung, welche von dem Weltklimarat (IPCC) der Vereinten Nationen gefördert wird, deren Konsequenzen Umweltveränderungen sein würden, die so ernst wären, dass man enormen Schaden in der unmittelbaren Zukunft fürchten muss, außer wenn drastische und kostenintensive Abschwächungsmaßnahmen unverzüglich ergriffen werden.

Diesbezüglich sind viele Nationen in der Welt Programmen beigetreten, um Kohlendioxidemissionen zu reduzieren, und werden unter Druck gesetzt, auch durch eine nicht nachlassende Propaganda, zunehmend fordernde Programme anzunehmen, deren Umsetzung, welche mit hohen Belastungen auf die Wirtschaften der einzelnen Mitgliedsstaaten verbunden ist, von Klimakontrolle abhängig wäre und daher die „Rettung“ des Planeten.

Jedoch ist der anthropogene Ursprung der globalen Erwärmung EINE UNBEWIESENE HYPOTHESE, nur abgeleitet von einigen Klimamodellen, d.h. komplexen Computerprogrammen, genannt ‚General Circulation Models‘.

Hingegen hat die wissenschaftliche Literatur zunehmend die Existenz einer natürlichen Klimaschwankung betont, welche die Modelle nicht reproduzieren können.

Diese natürliche Schwankung erklärt einen beachtlichen Teil der globalen Erwärmung, welche seit 1850 beobachtet worden ist. Die anthropogene Verantwortung für die Klimaveränderung, welche in dem letzten Jahrhundert beobachtet worden ist, wird daher UNGERECHTFERTIGT ÜBERTRIEBEN und Katastrophenvorhersagen SIND NICHT REALISTISCH.

Das Klima ist das komplexeste System auf unseren Planeten, daher muss man sich damit mit Methoden befassen, welche adäquat sind und mit seinem Niveau der Komplexität übereinstimmen.

Klimasimulationsmodelle reproduzieren nicht die beobachtete natürliche Schwankung des Klimas und rekonstruieren insbesondere nicht die warmen Perioden der letzten 10.000 Jahre. Diese haben sich ungefähr alle tausend Jahre wiederholt und schließen die gut bekannte mittelalterliche Warmzeit ein, die heiße römische Periode, und generell die Warmzeiten während des „Holozänen Optimums“.

Die PERIODEN DER VERGANGENHEIT SIND AUCH WÄRMER GEWESEN ALS DIE GEGENWÄRTIGE ZEIT, obwohl die CO2 Konzentration niedriger war als die gegenwärtige, dieweil sie mit den tausendjährigen Zyklen der Sonnenaktivität verbunden sind. Die Auswirkungen werden von den Modellen nicht reproduziert.

Es sollte daran gedacht werden, dass die Erwärmung, welche seit 1900 beobachtet worden ist, tatsächlich in den 1700en begann, d.h. am Tiefpunkt der Kleinen Eiszeit, der kältesten Periode der letzten 10.000 Jahre (übereinstimmend mit dem tausendjährigen Tiefpunkt der Sonnenaktivität, welche Astrophysiker Maunder Minimum nennen). Seitdem ist die Sonnenaktivität, ihrem tausendjährigen Zyklus folgend, angestiegen, wobei sie die Erdoberfläche erwärmt.

Des Weiteren versagen die Modelle dabei, die bekannten Klimaschwankungen von ungefähr 60 Jahren zu reproduzieren.

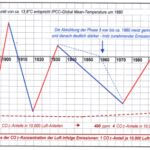

Diese waren zum Beispiel verantwortlich für eine Warmzeit (1850-1880) gefolgt von einer kühleren Periode (1880-1910), eine Erwärmung (1910-40), eine Abkühlung (1940-70) und einer neuen wärmeren Periode (1970-2000) ähnlich der, welche 60 Jahre früher beobachtet wurde.

Die folgenden Jahre (2000-2019) sahen einen Anstieg, der nicht von den Modellen vorhergesagt wurde, von ungefähr 0,2°C pro Jahrzehnt, und eine beachtliche Klimastabilität, welche sporadisch von den schnellen natürlichen Schwankungen des äquatorialen Pazifischen Ozeans unterbrochen wurde, bekannt als die El Nino Southern Oscillations, wie diejenige, welche zu der temporären Erwärmung zwischen 2015 und 2016 führte.

Die Medien behaupten auch, dass extreme Ereignisse, wie z.B. Hurrikans und Zyklone, alarmierend angestiegen sind. Umgekehrt sind diese Ereignisse, wie viele Klimasysteme, seit dem zuvor erwähnten 60-Jahre-Zyklus moduliert worden.

Zum Beispiel, wenn wir die offiziellen Daten von 1880 über tropische Atlantikzyklone betrachten, welche Nordamerika getroffen haben, scheinen sie eine starke 60-Jahre Schwankung zu haben, entsprechend der thermischen Schwankung des Atlantiks, genannt Atlantic Multidecadal Oscillation (=atlantische mehrdekadische Schwankung).

Die Spitzen, welche pro Jahrzehnt beobachtet wurden, sind in den Jahren 1880-90, 1940-50 und 1995-2005 miteinander kompatibel. Von 2005 bis 2015 nahm die Anzahl der Zyklone ab, wobei dies präzise dem zuvor erwähnten Zyklus folgte. Somit gibt es in der Zeitspanne von 1880-2015 zwischen der Anzahl der Zyklone (welche schwanken) und dem CO2 (welches monoton ansteigt) keine Korrelation.

Das Klimasystem wird noch nicht ausreichend verstanden. Obwohl es wahr ist, dass CO2 ein Treibhausgas ist, ist laut dem IPCC die Klimasensitivität auf dessen Anstieg in der Atmosphäre immer noch extrem unsicher.

Es wird geschätzt, dass eine Verdoppelung der Konzentration des atmosphärischen CO2 von ungefähr 300ppm vorindustriell auf 600ppm die Durchschnittstemperatur des Planeten von einem Minimum von 1°C bis zu einem Maximum von 5°C erhöhen kann.

Diese Unsicherheit ist enorm.

Jedenfalls schätzen viele neue Studien, die auf experimentellen Daten basieren, dass die Klimasensitivität auf CO2 BEDEUTEND NIEDRIGER ist als jene, die von den IPCC Modellen geschätzt wird.

Dann ist es wissenschaftlich unrealistisch, die Verantwortung für die Erwärmung, welche vom vergangenen Jahrhundert bis heute beobachtet wurde, den Menschen zuzuschreiben. Die voreilenden Vorhersagen der Panikmacher sind daher nicht glaubwürdig, da sie auf Modellen basieren, deren Ergebnisse den experimentellen Daten wiedersprechen.

Alle Beweise legen nahe, dass diese MODELLE den anthropogenen Beitrag ÜBERSCHÄTZEN und die natürliche Klimaschwankung unterschätzen, besonders jene, die von der Sonne, dem Mond und den Meeresschwankungen verursacht wird.

Schließlich veröffentlichen die Medien die Nachricht, laut dessen es in Bezug auf die menschliche Ursache der gegenwärtigen Klimaänderung einen fast einstimmigen Konsens unter den Wissenschaftlern gibt, dass die wissenschaftliche Debatte abgeschlossen werden würde.

Jedoch müssen wir uns zuerst einmal bewusst werden, dass die wissenschaftliche Methode bestimmt, dass die Fakten und nicht die Anzahl der Anhänger eine Mutmaßung zu einer gemeinsamen wissenschaftlichen Theorie machen.

Wie dem auch sei, der gleiche angebliche Konsens EXISTIERT NICHT. Es gibt tatsächlich eine bemerkenswerte Variabilität an Meinungen unter den Spezialisten – Klimatologen, Meteorologen, Geologen, Geophysiker, Astrophysiker – von denen viele einen wichtigen natürlichen Beitrag zur globalen Erwärmung anerkennen, welche von der vorindustriellen Zeit und sogar von der Vorkriegszeit bis heute beobachtet worden ist.

Es hat auch Petitionen gegeben, welche von tausenden von Wissenschaftlern unterschrieben worden sind, die eine abweichende Meinung zur Mutmaßung der anthropogenen globalen Erwärmung ausgedrückt haben.

Diese umfassen diejenige, welche 2007 von dem Physiker F. Seitz gefördert wurde, ehemaliger Präsident der American National Academy of Science, und diejenige, welche von dem nichtstaatlichen Weltklimarat (NIPCC) gefördert wurde, deren Bericht von 2009 zu dem Schluss kommt, dass „die Natur, und nicht die Aktivität des Menschen, regiert das Klima“.

Zum Schluss, angesichts der ENTSCHEIDENDEN WICHTIGKEIT, WELCHE FOSSILE TREIBSTOFFE für die Energieversorgung der Menschheit haben, schlagen wir vor, dass sie nicht der Politik von kritikloser Reduzierung der Emission von Kohlendioxid in die Atmosphäre unterworfen werden sollten mit DEM ILLUSORISCHEN ANSCHEIN DES BEHERRSCHENS DES KLIMAS.

FÖRDERKOMITEE :

1. Uberto Crescenti, Emeritus Professor of Applied Geology, University G. D’Annunzio, Chieti-Pescara, formerly Rector and President of the Italian Geological Society.

2. Giuliano Panza, Professor of Seismology, University of Trieste, Academician of the Lincei and of the National Academy of Sciences, called of the XL, 2018 International Award of the American Geophysical Union.

3. Alberto Prestininzi, Professor of Applied Geology, La Sapienza University, Rome, formerly Scientific Editor in Chief of the magazine International IJEGE and Director of the Geological Risk Forecasting and Control Research Center.

4. Franco Prodi, Professor of Atmospheric Physics, University of Ferrara.

5. Franco Battaglia, Professor of Physical Chemistry, University of Modena; Galileo Movement 2001.

6. Mario Giaccio, Professor of Technology and Economics of Energy Sources, University G. D’Annunzio, Chieti-Pescara, former Dean of the Faculty of Economics.

7. Enrico Miccadei, Professor of Physical Geography and Geomorphology, University G. D’Annunzio, Chieti-Pescara.

8. Nicola Scafetta, Professor of Atmospheric Physics and Oceanography, Federico II University, Naples.

UNTERZEICHNENDE

1. Antonino Zichichi, Emeritus Professor of Physics, University of Bologna, Founder and President of the Ettore Center for Scientific Culture Majorana di Erice.

2. Renato Angelo Ricci, Professor Emeritus of Physics, University of Padua, former President of the Italian Society of Physics and Society European Physics; Galileo Movement 2001.

3. Aurelio Misiti, Professor of Health-Environmental Engineering, University of Sapienza, Rome.

4. Antonio Brambati, Professor of Sedimentology, University of Trieste, Project Manager Paleoclima-mare of PNRA, already President of the National Oceanography Commission.

5. Cesare Barbieri, Professor Emeritus of Astronomy, University of Padua.

6. Sergio Bartalucci, Physicist, President of the Association of Scientists and Tecnolgi for Italian Research.

7. Antonio Bianchini, Professor of Astronomy, University of Padua.

8. Paolo Bonifazi, former Director of the Institute of Interplanetary Space Physics, National Astrophysical Institute.

9. Francesca Bozzano, Professor of Applied Geology, Sapienza University of Rome, Director of the CERI Research Center.

10. Marcello Buccolini, Professor of Geomorphology, University University G. D’Annunzio, Chieti-Pescara.

11. Paolo Budetta, Professor of Applied Geology, University of Naples.

12. Monia Calista, Researcher in Applied Geology, University G. D’Annunzio, Chieti-Pescara.

13. Giovanni Carboni, Professor of Physics, Tor Vergata University, Rome; Galileo Movement 2001.

14. Franco Casali, Professor of Physics, University of Bologna and Bologna Academy of Sciences.

15. Giuliano Ceradelli, Engineer and climatologist, ALDAI.

16. Domenico Corradini, Professor of Historical Geology, University of Modena.

17. Fulvio Crisciani, Professor of Geophysical Fluid Dynamics, University of Trieste and Marine Sciences Institute, Cnr, Trieste.

18. Carlo Esposito, Professor of Remote Sensing, La Sapienza University, Rome.

19. Mario Floris, Professor of Remote Sensing, University of Padua.

20. Gianni Fochi, Chemist, Scuola Normale Superiore of Pisa; scientific journalist.

21. Mario Gaeta, Professor of Volcanology, La Sapienza University, Rome.

22. Giuseppe Gambolati, Fellow of the American Geophysica Union, Professor of Numerical Methods, University of Padua.

23. Rinaldo Genevois, Professor of Applied Geology, University of Padua.

24. Carlo Lombardi, Professor of Nuclear Plants, Milan Polytechnic.

25. Luigi Marino, Geologist, Geological Risk Forecasting and Control Research Center, La Sapienza University, Rome.

26. Salvatore Martino, Professor of Seismic Microzonation, La Sapienza University, Rome.

27. Paolo Mazzanti, Professor of Satellite Interferometry, La Sapienza University, Rome.

28. Adriano Mazzarella, Professor of Meteorology and Climatology, University of Naples.

29. Carlo Merli, Professor of Environmental Technologies, La Sapienza University, Rome.

30. Alberto Mirandola, Professor of Applied Energetics and President of the Research Doctorate in Energy, University of Padua.

31. Renzo Mosetti, Professor of Oceanography, University of Trieste, former Director of the Department of Oceanography, Istituto OGS, Trieste.

32. Daniela Novembre, Researcher in Mining Geological Resources and Mineralogical Applications, University G. D’Annunzio, Chieti Pescara.

33. Sergio Ortolani, Professor of Astronomy and Astrophysics, University of Padua.

34. Antonio Pasculli, Researcher of Applied Geology, University G. D’Annunzio, Chieti-Pescara.

35. Ernesto Pedrocchi, Professor Emeritus of Energetics, Polytechnic of Milan.

36. Tommaso Piacentini, Professor of Physical Geography and Geomorphology, University G. D’Annunzio, Chieti-Pescara.

37. Guido Possa, nuclear engineer, formerly Deputy Minister Miur.

38. Mario Luigi Rainone, Professor of Applied Geology, University of Chieti-Pescara.

39. Francesca Quercia, Geologist, Research Director, Ispra.

40. Giancarlo Ruocco, Professor of Structure of Matter, La Sapienza University, Rome.

41. Sergio Rusi, Professor of Hydrogeology, University G. D’Annunzio, Chieti-Pescara.

42. Massimo Salleolini, Professor of Applied Hydrogeology and Environmental Hydrology, University of Siena.

43. Emanuele Scalcione, Head of Regional Agrometeorological Service Alsia, Basilicata.

44. Nicola Sciarra, Professor of Applied Geology, University G. D’Annunzio, Chieti-Pescara.

45. Leonello Serva, Geologist, Director of Geological Services of Italy; Galileo Movement 2001.

46. Luigi Stedile, Geologist, Geological Risk Review and Control Research Center, La Sapienza University, Rome.

47. Giorgio Trenta, Physicist and Physician, President Emeritus of the Italian Association of Medical Radiation Protection; Galileo Movement 2001.

48. Gianluca Valenzise, Director of Research, National Institute of Geophysics and Volcanology, Rome.

49. Corrado Venturini, Professor of Structural Geology, University of Bologna.

50. Franco Zavatti, Astronomy Researcher, University of Bologna.

51. Achille Balduzzi, Geologist, Agip-Eni.

52. Claudio Borri, Professor of Construction Sciences, University of Florence, Coordinator of the International Doctorate in Engineering Civil.

53. Pino Cippitelli, Agip-Eni Geologist.

54. Franco Di Cesare, Executive, Agip-Eni.

55. Serena Doria, Researcher of Probability and Mathematical Statistics, University G. D’Annunzio, Chieti-Pescara.

56. Enzo Siviero, Professor of Ponti, University of Venice, Rector of the e-Campus University.

57. Pietro Agostini, Engineer, Association of Scientists and Tecnolgi for Italian Research.

58. Donato Barone, Engineer.

59. Roberto Bonucchi, Teacher.

60. Gianfranco Brignoli, Geologist.

61. Alessandro Chiaudani, Ph.D. agronomist, University G. D’Annunzio, Chieti-Pescara.

62. Antonio Clemente, Researcher in Urban Planning, University G. D’Annunzio, Chieti-Pescara.

63. Luigi Fressoia, urban architect, Perugia.

64. Sabino Gallo, nuclear engineer.

65. Daniela Giannessi, First Researcher, Ipcf-Cnr, Pisa.

66. Roberto Grassi, Engineer, Director of G&G, Rome.

67. Alberto Lagi, Engineer, President of Restoration of Complex Damaged Plants.

68. Luciano Lepori, Ipcf-Cnr Researcher, Pisa.

69. Roberto Madrigali, Metereologo.

70. Ludovica Manusardi, Nuclear physicist and scientific journalist, Ugis.

71. Maria Massullo, Technologist, Enea-Casaccia, Rome.

72. Enrico Matteoli, First Researcher, Ipcf-Cnr, Pisa.

73. Gabriella Mincione, Professor of Sciences and Techniques of Laboratory Medicine, University G. D’Annunzio, Chieti-Pescara.

74. Massimo Pallotta, First Technologist, National Institute for Nuclear Physics.

75. Enzo Pennetta, Professor of Natural Sciences and scientific divulger.

76. Nunzia Radatti, Chemist, Sogin.

77. Vincenzo Romanello, Nuclear Engineer, Research Center, Rez, Czech Republic.

78. Alberto Rota, Engineer, Researcher at Cise and Enel.

79. Massimo Sepielli, Director of Research, Enea, Rome.

80. Ugo Spezia, Engineer, Industrial Safety Manager, Sogin; Galileo Movement 2001.

81. Emilio Stefani, Professor of Plant Pathology, University of Modena.

82. Umberto Tirelli, Visiting Senior Scientist, Istituto Tumori d’Aviano; Galileo Movement 2001.

83. Roberto Vacca, Engineer and scientific writer.

—————-

Italienisches Original hier

Englische Übersetzung hier

Der Beitrag erschien zuerst bei „Die kalte Sonne“

Die Information, dass sie eigentlich „seit Beginn der Wetteraufzeichnungen“ meinte, versteckte das Münchner Blatt deutlich weiter unten im Text.

Die Information, dass sie eigentlich „seit Beginn der Wetteraufzeichnungen“ meinte, versteckte das Münchner Blatt deutlich weiter unten im Text.