Es geht ein Klagen durch das Land, allenthalben wird Kompetenzverlust und Stümperei bejammert. In der Tat sind andere Nationen, vor allem in Asien, dabei, uns auf vielen Feldern technisch und wissenschaftlich davon zu laufen. Dennoch ist Deutschland nach wie vor ein Cluster an hervorragendem Know-how und ein guter Wissenschaftsstandort, der auf vielen Gebieten zu Spitzenleistungen fähig ist. Das ist zunächst einmal eine gute Botschaft, noch besser wäre sie, wenn die entsprechenden Fähigkeiten auch entsprechend anerkannt, gefördert und vor allem genutzt werden würden. Besonders natürlich in einer Krise, die das Wohlergehen des ganzen Landes betrifft. So wie Corona.

Für die Einschätzung der Situation und den richtigen Weg zur Bewältigung braucht man ja nicht nur Mediziner, Virologen, Epidemiologen, Immunologen und dergleichen. Man braucht genauso Ökonomen und Mathematiker, Ingenieure und Praktiker, Sozialwissenschaftler und Kommunikations-Experten und vieles mehr. Eine Seuche und ihre Bewältigung ist ein komplexes System mit vielfachen Wechselwirkungen. Man kann das mit einer vollen Spagettischüssel vergleichen: Zupfst Du an einer Nudel, weißt du nie, wo sich dann an anderer Stelle etwas bewegt. „Ein komplexes System mit dem die meisten von uns schon einmal zu tun hatten, ist ein Kind, besonders ein Teenager“, formuliert der amerikanische Schriftsteller Michael Chrichton eine anschauliche Parallele. Man weiß eigentlich nie, welches Ereignis welche Reaktionen wann hervorruft. Ein Anstoß, der gestern ein bestimmtes Resultat erzielte, kann morgen zu einem vollkommen anderen Ergebnis führen.

Es liegt also nahe, wirklich alle Disziplinen zu mobilisieren und für eine Abschätzung der Wirkungen zu nutzen und auch offen gegenüber scheinbaren Außenseitern und ihren Ideen zu sein. Leider ist all dies in der Corona-Krise nicht geschehen. Die Bundesregierung verließ sich weitgehend auf die Empfehlungen einer einzigen Behörde, des Robert-Koch-Instituts (RKI), und weniger Wissenschaftler (an führender Stelle der Virologe Christian Drosten), die offenbar eifersüchtig ihre Pfründe bewachten und sorgfältig darauf achteten, dass abweichende Meinungen und Expertisen nicht oder kaum Gehör fanden.

Das wissenschaftliche Potenzial Deutschlands blieb ungenutzt

Daraus resultiert die wohl größte Tragik der Corona-Krise: Das wissenschaftliche Potenzial Deutschlands blieb ungenutzt. Es wurde nie eine der komplexen Situation angemessene interdisziplinäre Risikoabschätzung vorgenommen. Entsprechend eindimensional und mitunter möglicherweise kontraproduktiv waren die Maßnahmen – mit negativen Auswirkungen sowohl auf die Bekämpfung des Virus selbst als auch auf die Wirtschaftslage in Folge. Ich möchte diesen Aspekt hier einmal pars pro toto an einem konkreten Beispiel durchdeklinieren.

Wie so oft, stehen alle Informationen dazu in der Zeitung, es hat sie nur niemand richtig bemerkt oder bemerken wollen. Da Achgut.com während der Corona-Krise zu einer wichtigen Lektüre vieler Fachleute und Experten auf diesem Gebiet geworden ist, kommen von dieser Seite viele Hinweise an die Redaktion. So machte uns eine ganze Reihe von Lesern auf die Veröffentlichungen eines Spezialisten für Künstliche Intelligenz aufmerksam, der an der Technischen Hochschule in Ulm (THU) lehrt.

Professor Dr. Ralf Otte arbeitet dort im Fachgebiet Künstliche Intelligenz (KI) und ist Spezialist für sogenanntes „Data Mining“ und „Data Science“. Das ist eigentlich eine Ingenieurswissenschaft, die aber bei näherem Hinsehen auch gut geeignet ist, Prognosen abzuliefern. Etwa die Vorhersage von Emissionswerten in der Chemieindustrie, Prognosen von Betrugsversuchen bei Abrechnungen an Krankenkassen, Prognosen von Crashs bei Industrieprojekten und vieles mehr. Das ist seit Jahren sogar eine sehr gefragte Disziplin in der Industrie, weil Fehlerraten bei Datenauswertungen niedrig sein müssen, was unmittelbar einleuchtet, wenn man etwa an die Flugzeugindustrie denkt.

Und was hat so jemand mit Corona zu tun? Auf den ersten Blick nicht viel, der Mann ist schließlich kein Virologe oder Epidemiologe. Doch die Notwendigkeit, angesichts der dünnen Datenlage in Sachen Corona halbwegs verlässliche Vorhersagen zu machen, weckte schon im Februar seine berufliche Neugier, sagt Otte in mehreren Zeitungsbeiträgen. In einem Essay vom 15. Juni in den Diesbach-Medien schreibt er: „Ich muss zugeben, dass mich das SARS-CoV-2-Virus sehr erschreckt hat, für Mai hatte ich eine Reise an die HUAT University in Hubei geplant, doch die Gastvorlesungen konnte ich ganz sicher vergessen“.

Einige seiner Studenten kommen aus der Hubei-Provinz, das Virus begann ihn zu interessieren: „Das Problem bei SARS-CoV-2 war, dass es Mitte März nur sehr wenige Daten gab. Wir nennen das in der Fachwelt ein Small Data Problem. Damit umzugehen, ist viel schwieriger als mit Big Data-Themen, denn viele Data Mining Verfahren versagen beim Small Data, aber natürlich nicht alle.“ Und genau mit denen wollte Otte der Einschätzung der Pandemie auf den Grund gehen: „Das Robert-Koch-Institut (RKI) publizierte ab 4. März in seinen täglichen Lageberichten sogenannte Fallzahlen, und man nannte diese in den Medien sogar Infizierte. Das kam uns nicht schlüssig vor“.

Ausbreitung bereits für Dezember 2019/Anfang 2020 vermutet

Otte stellt in seinem Essay gleich zu Beginn klar, dass er eine exponentielle Corona-Ausbreitung bereits für Dezember 2019 bzw. Anfang 2020 vermutet. Dass dies nicht bemerkt wurde, kann aus seiner Sicht nun daran liegen, dass das Virus bei Millionen unentdeckt Infizierten entweder relativ harmlos ist oder dass es in der Bevölkerung bereits eine hohe Grundimmunität gegen diese neue Spielart des Coronavirus gab, was die Verbreitung verlangsamen würde. Otte nimmt in seinem Beitrag sogar beides an, insbesondere „weil die Durchseuchungsraten so schnell gefallen sind“, wie er zum Schluss des Essays ausführt.

Die veröffentlichten Zahlen des Robert-Koch-Instituts (RKI) und der Johns-Hopkins-Universität waren dennoch eine solide Basis, so Otte, um mit den Methoden der Künstlichen Intelligenz ein empirisches Modell zur Simulation der Fallzahlen, der Durchseuchungsrate und der Todesfälle zu entwickeln.

Das Ergebnis formulierte er in den oben erwähnten Diesbach-Medien (Weinheimer Nachrichten, Odenwälder Zeitung) so: „Ab dem 22. März zeichnete sich bereits ab, dass sich die Zahlen für Deutschland deutlich anders entwickeln werden als zum Beispiel in Italien. Ab dem 29. März waren wir auf Grundlage unserer Daten bereits ziemlich sicher, dass es den befürchteten Sturm nicht geben wird.“ Man habe bei den Auswertungen jedoch schnell festgestellt, dass die Fallzahlen des RKI wissenschaftlich nutzlos waren, weil die Anzahl der dafür durchgeführten Tests nicht dokumentiert sei. Weiter führt er aus: „Ich begann am 22. und 23. März dem RKI zu schreiben, teilte unsere Überlegungen mit, dass wir aktuell eventuell schon Millionen Infizierte hätten, bot unsere Hilfe an und bat um Informationen zu den Tests. Man bedankte sich höflich und behielt sich eine Prüfung der Briefe und Mails vor.“

Und spätestens ab hier beginnt eine Geschichte der Inkompetenz oder des Nicht-wissen-wollens seitens des RKI. „Bereits am 29. März konnten wir an den Zeitreihen der Todesfallzahlen erkennen, dass es bei uns nicht wie in Italien oder Spanien werden würde, ich schrieb dem RKI erneut und bot nochmals Unterstützung an. Aber man brauchte keine Hilfe“, sagt Otte in dem Essay. Auch der Weg über die Medien veränderte das Beharrungsvermögen der staatlichen Virusbekämpfer nicht. „Anfang April war uns klar, dass es in Deutschland nicht zu einem Ansturm auf unser Gesundheitswesen kommen würde.“ Otte gab im April in der Lokalzeitung seines Wohnortes Weinheim ein ausführliches Interview mit dem Titel: „Den befürchteten Sturm wird es nicht geben“ (Weinheimer Nachrichten, 7. April) . Heute wissen wir: Es gab ihn auch nicht. Otte lag mit seiner Prognose zum Verlauf der Epidemie systematisch richtig, damals und auch in der Folgezeit bis heute.

Der „Supergau“ der Krise

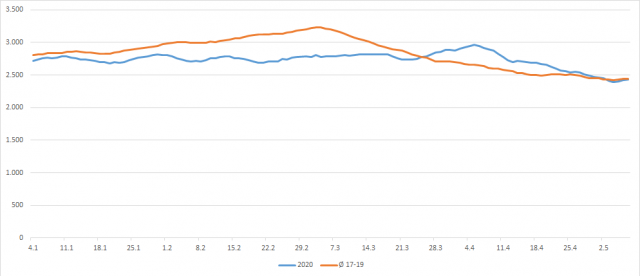

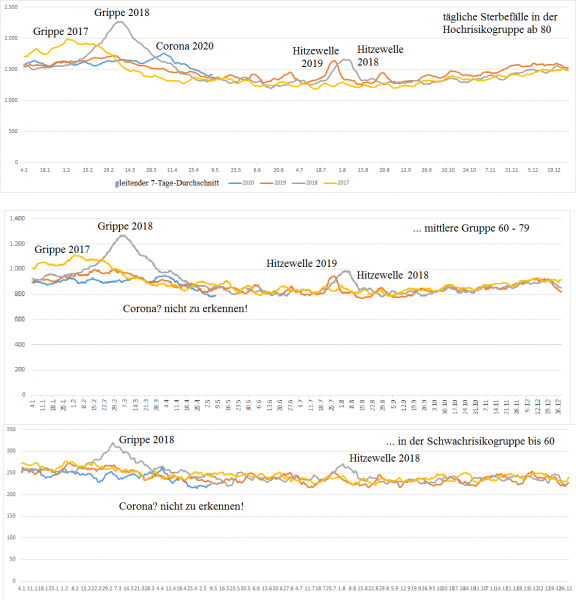

In einem neuen Beitrag mit dem Titel „Die Epidemie ist in Deutschland vorbei“ wurde Otte am 13. Juni erneut in seiner Regionalzeitung publiziert, und es wurde auf den längeren Essay von ihm verwiesen, welcher am 15. Juni erscheinen würde und aus dem oben bereits zitiert wurde. Im Essay führt Otte für die Öffentlichkeit dann aus: „Virologen, Mediziner und Politiker sprachen im März, sogar noch im April und Mai davon, dass wir am Anfang der Pandemie stehen würden. Aber stimmte das? Nein… In der Woche vor dem Lockdown (16.3. bis 22.3.) gab es zwar immer noch eine starke exponentielle Verbreitung des Virus, aber ab dem 23. März war die Verbreitung am Abschwächen und eine Woche später (ab dem 5. April) war die epidemiologische Welle sogar vorbei. Wir hatten also Glück in Deutschland! Es war Ostern und es war geschafft!“

Otte mag im Nachhinein weder den Lockdown noch die Politik verurteilen, allerdings dürfe man für eine ganzheitliche Bewertung der Lockdown-Maßnahmen die „schweren Nebenwirkungen“ nicht ausblenden.

Wirklich problematisch bewertet der KI-Spezialist im Essay, aber auch in seinem Beitrag in der Thüringer Landeszeitung vom 15. Juni (“ Warum die Pandemie vorbei ist und Thüringen recht hat“) die Vorgehensweise des Robert-Koch-Instituts. Hier liegen wohl handwerkliche Fehler vor, die solchen Institutionen und Verantwortlichen einfach nicht passieren dürfen. Er schreibt zum Beispiel: „Es ist natürlich klar, dass dann, wenn man die Anzahl der Tests um den Faktor 2,7 erhöht, auch viel mehr Fallzahlen generiert werden, was eine sehr schnelle Ausbreitung der Infektion suggeriert. So gelangten sehr störanfällige R-Werte in die Medien, doch sie bildeten das Geschehen nicht robust ab“, so der Tenor in all seinen Veröffentlichungen. Die täglich produzierten Fallzahlen des RKI zeigen ja nicht an, wie viele Infizierte es in Deutschland gibt, sondern nur, wie viele von den Infizierten mit dem Test pro Tag entdeckt werden. Um das Problem der Fallzahlabhängigkeit zu lösen, entwickelte Otte sogar einen eigenen, Robusten R-Wert und zeigt in seinem Essay, welche Auswirkungen das hat.

Der „Supergau“ der Krise sei für Otte jedoch die anfängliche Verwechslung von Fallsterblichkeit und Infektionssterblichkeit gewesen. Er schreibt im o.g. Essay: „Unsere Politiker und Virologen sprachen im Februar und noch März davon, dass es alleine in Deutschland bis zu 250.000 Tote geben könnte, oder gar Millionen! Doch auf Basis welcher Zahlen? Verwechselten Virologen und Mediziner oder nur die Medien etwa Fallsterblichkeit mit Infektionssterblichkeit? Wie auch immer, es war medial gesehen der Supergau der Krise.“ Otte schätzt bereits in den Weinheimer Nachrichten vom 7. April, „dass weniger als einer von tausend Infizierten an Covid-19 versterben würde.“ Die Verwechselung von Fallsterblichkeit mit Infektionssterblichkeit hatte das politische Geschehen jedoch bereits überrollt, bedauert er.

„Das ist keine Epidemie mehr“.

Die Fallsterblichkeit bezieht sich auf Menschen, die an oder mit Corona verstorben sind in Bezug auf jene, bei denen Corona amtlich festgestellt wurde (Fallzahlen). Die Infektionssterblichkeit bezieht sich jedoch auf die Gesamtheit der Infizierten in der Bevölkerung, und diese Anzahl kann, wie gesagt, in die Millionen gehen. Infizierte also, die teilweise überhaupt nicht gemerkt haben, dass sie das Corona-Virus in sich tragen. Nimmt man diese viel höhere Zahl zur Basis und setzt die Verstorbenen mit dieser Zahl ins Verhältnis, so kommt eine um Größenordnung geringere Gefahr heraus.

Und diese liegt – wie Otte bereits im April prognostiziert (und daran ändern auch einzelne Infektionscluster wie beim Fleischhersteller Tönnies nichts) – eben nur bei 0,1 Prozent. Auch bei Tönnies muss man zwischen Infizierten und ernsthaft Erkrankten unterscheiden (siehe zum Fall Tönnies auch Achgut.com: Bericht zur Coronalage 23.06.2020: Rinderwahn). Bei Tönnies wird es hoffentlich keinen einzigen Toten geben, aber ein riesiger Testapparat wurde in Bewegung gesetzt. Und es wird das passieren, was bei vergleichbarem Testaufwand woanders in ähnlicher Form passieren würde: Die Zahl der nachweislich Infizierten steigt erheblich. Das Virus ist und bleibt ja da und wer es sucht, der findet es. Und er findet in Deutschland auch eine nicht-alarmistische Perspektive: Denn trotz der hohen Zahlen von Infizierten stellt das Virus nur für sehr wenige, meist vorbelastete Menschen eine ernsthafte Gefahr dar, die natürliche Abwehr des Menschen funktioniert auch bei Corona.

Und was sagt Otte zur ominösen Dunkelziffer und der Durchseuchung der Bevölkerung? Derzeit, so Otte in den Weinheimer Nachrichten vom 13.6., der Thüringer Landeszeitung vom 15.6. und im Essay der Diesbach-Medien vom 15.6., sind in Deutschland höchstes 2 von 10.000 Menschen noch ansteckend infiziert. „Rechnen Sie das auf Ihre Heimatstadt hoch, das ist keine Epidemie mehr“.

Falsche Einschätzungen zur Gefahrenlage

Die wichtigsten Kritikpunkte von Seiten des KI-Professors gegenüber dem RKI möchte ich daher kurz so zusammenfassen:

– Das RKI gab mehrmals falsche Einschätzungen zur Gefahrenlage ab.

– Das RKI berechnet falsche oder zumindest störanfällige R-Werte. Otte führt in seinen Interviews und Gastbeiträgen (wie oben gesagt) einen eignen, Robusten R-Wert ein, der das Geschehen wohl fallzahlunabhängig beschreiben könne.

– Das RKI erstellt zahlreiche Analysen auf Basis von Fallzahlen, ein wissenschaftliches Unding.

– Das RKI vermutet einen festen Faktor (11 bis 20) zwischen positiv Gemeldeten (Fallzahlen) und der sogenannten Dunkelziffer. Otte führt immer wieder aus, das dies irreführend sei, da Fallzahlen nicht testzahlunabhängig sind.

– Das RKI verwechselte zu Beginn seiner Analysen Fallsterblichkeit mit Infektionssterblichkeit. Otte nennt das den „Supergau der Krise“.

– Das RKI widerspricht daher falschen Sterblichkeitszahlen der Medien und führenden Virologen nicht (bis zu 250.000 mögliche Tote sagte Christian Drosten im Februar bzw. März voraus).

– Das RKI hat den wahrscheinlichen Anfang der Epidemie nicht richtig datiert. Otte schätzt erste (unentdeckte) Corona-Fälle in Deutschland bereits auf Dezember 2019 oder Anfang 2020 und nicht erst auf den 27.1. bei Webasto. Bei einer Exponential-Funktion für die Hochrechnung bedeuten diese Zeitdifferenzen „Welten“, die für die Bewertung der Krise alles entscheiden könnten.

– Das RKI bewertete die Gefahr wegen der Auslastung der Intensivbetten lange Zeit falsch oder kommunizierte zumindest falsch. Laut Otte gab es in Deutschland zu keinem einzigen Zeitpunkt die ernsthafte Gefahr, dass die Intensivbetten nicht ausreichen würden. Einschub der Redaktion: Aktuell sind weniger als 350 Menschen wegen Covid-19 in intensivmedizinischer Behandlung (Lagebericht RKI vom 23.6.), und es stehen aktuell tausende freie Intensivbetten zur Verfügung.

– Das RKI kann bis heute die Falsch-Positiv-Rate seiner Tests nicht beziffern. Entsprechende Anfragen von interessierten Fachleuten bleiben meist unbeantwortet. Otte berichtet in seinem Essay jedoch von einer persönlichen Mitteilung vom Präsidenten des RKI, Prof. Wieler, dass der Falsch-Positiv-Wert tatsächlich nicht bezifferbar sei.

– Otte warnt in seinen letzten Debattenbeiträgen aber ausführlich vor den Falsch-Positiven, weil die Messfehlerrate des RT-PCR-Tests in die Nähe der Durchseuchungsrate gelangt sei. Bei täglich 50.000 Messungen werden nach Ottes Schätzung jeden Tag ca. 250 Menschen als infiziert deklariert, die das nicht sind. Diese Menschen müssen in Quarantäne, obwohl sie nicht infiziert sind. Und das RKI meldete vor den Ausbrüchen in den Hotspot ca. täglich nur 200 bis 300 neue Fälle. Das RKI jedoch warnt (Stand 2.6.) auf seinen Seiten bei der „Messung von asymptomatischen Personen“ überraschenderweise vor den Falsch-Negativen (das sind die, die infiziert sind, aber diese Infektion bei ihnen nicht erkannt wurde), das ist nach dem Lesen von Ottes Beitrag nicht mehr verständlich. Gerade die Falsch-Positiven, die bei der geringen Durchseuchung nun ein Problem darstellen, werden für die Bevölkerung unzureichend thematisiert. Warum eigentlich?

Eine wohlmeinende Empfehlung für die Bundesregierung

Ottes Anliegen ist es, der Bevölkerung ihre panische Angst zu nehmen. Er ist Ingenieur, er begibt sich daher zumindest indirekt auf ein für ihn fachfremdes Feld, auch er mag in dem einen oder anderen Aspekt irren. Das ist der Lauf der wissenschaftlichen Erkenntnis. Anscheinend hat aber bislang noch niemand der Betroffenen mit einer substanziellen wissenschaftlichen Kritik geantwortet, auch das wäre Wissenschaft. Eine These ist so lange gut, bis sie widerlegt ist. Es sieht aber überhaupt nicht danach aus, dass dies für Ottes Arbeit erfolgt.

Es zeigt sich, dass Ottes öffentliche Prognosen vom 7. April bis dato auf frappierende Weise korrekt sind, und dies völlig diametral zur öffentlichen Meinung. Bei aller Vorsicht lässt sich daraus eine wohlmeinende Empfehlung für die Bundesregierung ableiten:

Sie sollte sich bei der Begründung ihrer Maßnahmen zum Umgang mit der Corona-Krise nicht ernsthaft weiter auf das Robert-Koch-Institut und die einschlägigen Berater berufen. Die Zahl der Versäumnisse, Fehler und wissenschaftlichen Peinlichkeiten ist einfach zu groß. Sie sind gut belegt und dokumentiert. Auch hinsichtlich möglicher Schadensersatz-Forderungen dürfte der Kronzeuge RKI eher ein Risiko als eine Absicherung darstellen.

Das Auftauchen einer großen Zahl von Infizierten beim Fleischproduzenten Tönnies wird in den Medien als Hiobsbotschaft überbracht. Wer die Lehren aus Ottes Beiträgen zieht, kommt zu dem Schluss, dass die gemeldeten Infektionsfälle in Deutschland vielleicht nie wieder aufhören werden, dass aber für die Gesamtbevölkerung trotzdem keine Gefahr mehr besteht, da man in Hotspots die Infektionsketten gut nachverfolgen kann und die Infektionssterblichkeit von Covid-19 für die Gesamtbevölkerung viel, viel geringer ist, als von den Behörden (zu Beginn) angenommen oder medial verbreitet.

Dies sind nun ziemlich gute Nachrichten für die Allgemeinheit, wir sollten uns darüber freuen. Wenn Ottes Einschätzung stimmt, – und sie stimmt in der Grundaussage ja durchaus mit anderen kritischen Stimmen überein – (siehe hier Achgut.com „Bericht zur Coronalage „Die Infektionswelle ist vorbei“ und Corona-Aufarbeitung: „Warum alle falsch lagen„), dann wäre die Epidemie in Deutschland tatsächlich vorbei, trotz aller Hotspots.

Doch solange die RT-PCR-Tests durchgeführt und sogar medial überhöht werden, wird ohne Not in den Köpfen der Bevölkerung eine Epidemie kreiert. Der Grund, warum Medien das immer noch mitmachen, erschließt sich mir nicht. Mit aufopferungsvoller Fürsorge für die Covid-19 Gefährdeten ist das nur noch schwerlich zu begründen. Ob die Leitmedien aus eigener Kraft noch umsteuern können oder ob die Judikative die Reißleine in Deutschland wird ziehen müssen, ist schwer vorherzusagen.

Und damit wären wir wieder am Anfang dieses Beitrages: Es gibt in Deutschland noch das großartige Know-how und die exzellente Wissenschaft. Man muss sie nur nutzen.

Fazit: Von dem Ulmer KI-Experten Ralf Otte wurde mit ingenieurmäßiger Präzision die „Akte Corona“ zerlegt. Man darf gespannt sein, wie lange es der offiziellen Linie gelingt, diese und andere Beiträge einfach zu ignorieren oder ob es endlich zu den dringend notwendigen Streitgesprächen unter den Experten verschiedener Fachdisziplinen kommen wird.

Quelle und Lektüre zum Thema:

Prof. Dr. Ralf Otte hat seine Kritik in einem ausführlichen Essay für die Weinheimer Nachrichten ausgearbeitet, es steht für 99 Cent hinter der Bezahlschranke, ist aber Gold wert.

Der Beitrag erschien zuerst bei ACHGUT hier