Hauptperson unserer Geschichte ist der Jungwissenschaftler Shaun Marcott. Fast auf den Tag genau vor zwei Jahren, im April 2011, reichte Marcott bei der Geologischen Fakultät der Oregon State University eine Doktorarbeit ein, in der er sich mit den Gletschern und der klimatischen Entwicklung der Erde während der späten Eiszeit sowie der letzten 10.000 Jahre beschäftigte. Der Arbeit voran stellt Marcott ein Zitat von Richard P. Feynman:

„Wissenschaft ist der Glaube an die Ignoranz der Experten“

Ach, hätte sich der junge Marcott doch dieses Motto vollständig zu Eigen gemacht, dann wäre ihm sicher einiges erspart geblieben. Aber davon ahnte er damals vielleicht noch nichts. Letztendlich waren es nämlich genau diese ignoranten Experten, die den Doktoranden zu Fall brachten.

Das Papier

Zwei Jahre später. Als Produkt der Dissertation erschien am 8. März 2013 in der Zeitschrift Science von Marcott eine Arbeit mit einer globalen Temperaturrekonstruktion der letzten 11.300 Jahre, also für die Zeit seit Ende der letzten Eiszeit. Der Publikationszeitpunkt war günstig, denn so konnte die Studie noch gerade so in den momentan entstehenden 5. Klimazustandsbericht des Weltklimarats IPCC eingearbeitet werden. Entsprechend viel Mühe machten sich die US-amerikanischen National Science Foundation und die Universität, die beide am Tag vor Veröffentlichung des Papiers kräftig Werbung betrieben und aufsehenerregende Pressemitteilungen herausgaben. So titelte die Science Foundation sensationsheischend:

Die Erde ist heute wärmer als während 70-80% der letzten 11.300 Jahre.

Auch die Universität Oregon wollte ihren Anteil an den Presselorbeeren und spielt daher in ihrem Titel auf die angeblich besondere Bedeutung der Erwärmung der letzten Jahrzehnte an:

Rekonstruktion der Temperaturgeschichte unterstreicht Bedeutung der kürzlichen Erwärmung

Noch am Erscheinungsdatum des Artikels war die Nachricht über den Atlantik geschwappt, wo die deutsche Presse die bedrohliche Nachricht ihren Lesern lustvoll und ungeprüft kredenzte. So berichtete der Berliner Tagesspiegel:

In den vergangenen Jahrzehnten sind die Temperaturen im globalen Durchschnitt gestiegen. Das zeigen zahlreiche Studien. Wie die Entwicklung über einen längeren Zeitraum aussieht, ist schon schwieriger festzustellen, da brauchbare Daten über das Weltklima nur für die letzten 1500 Jahre vorlagen. Shaun Marcott von der Oregon State University und Kollegen haben diese Spanne nun beträchtlich erweitert auf 11 300 Jahre. Ihre Daten zeigen, dass es derzeit wärmer ist als in drei Vierteln der gesamten Beobachtungszeit. Und dass es sehr wahrscheinlich ist, dass die Erde bald einen neuen Temperaturrekord erleben wird.

Auch die klimaaktivistische Webplattform klimaretter.de freute sich sehr über die neue Studie und schrieb:

Die globalen Temperaturen steigen derzeit schneller als jemals zuvor seit dem Ende der letzten Eiszeit. Das ist das Ergebnis einer Studie, bei der ein Team von Wissenschaftlern um den Geologen Shaun Marcott von der Oregon State University in Corvallis die Temperaturen der vergangenen 11.300 Jahre rekonstruiert hat. “Wir wussten bereits, dass die Erde heute wärmer ist als während der vergangenen 2.000 Jahre”, sagt Marcott. “Jetzt wissen wir, dass sie heute wärmer ist als während – fast – der gesamten letzten 11.300 Jahre”. Steigt die Erwärmung im bisherigen Tempo, dann, so Jeremy Shakun von der Havard University, einer der Co-Autoren der Studie, “sind wir auf dem Weg zu einem Planeten, der ganz anders ist als das, was wir bis jetzt gewohnt sind”.

Shaun Marcott selbst macht es in einem Beitrag im National Journal ganz deutlich:

„Wir fanden, dass die Temperaturen in den letzten hundert Jahren im gleichen Maße angestiegen sind, wie sie im Laufe der letzten 6000 Jahre gefallen sind. In anderen Worten: Die Änderungsrate [der Erwärmung] ist sehr viel größer als irgendwann im gesamten Holozän“ [welches die letzten 11.500 Jahre nach Ende der Eiszeit abdeckt].

Shaun Marcott war über Nacht berühmt geworden, wie sein großes Vorbild Michael Mann. Die Presse riss sich um den Jungforscher. Die ganze Welt interessierte sich plötzlich für seine Meinung, wollte zitierfähige Sätze aus dem Mund des Shooting Stars hören, welche sogleich digital um die ganze Welt gefunkt wurden. Vertreter des IPCC beglückwünschten den jungen Mann zu seiner ausgezeichneten Arbeit. Der Weg zu einer goldenen Karriere stand offen. Wie bereits bei Michael Mann geschehen, konnte Marcott nun auf schnelle Beförderung, zügige Professur und verantwortungsvolle IPCC-Posten hoffen. Nach 15 enttäuschenden Jahren des Erwärmungsstopps gab es nun endlich wieder Hoffnung auf neue Temperaturrekorde. Endlich schien hier die neue Arbeit zu sein, die den Schlüssel zum ganz großen Neustart der Klimakatastrophe darstellte. Hier war er, der Beweis, dass alleinig der Mensch an der Klimaerwärmung Schuld war.

Man kann sich vorstellen, dass der Vater des ursprünglichen Hockey Sticks ganz aus dem Häuschen war. Michael Mann twitterte vergnügt, dieses Paper wäre der langersehnte ‚Dolch im Herzen‘ der Klimaleugner. Und Marcott hielt sich ganz eng an sein großes Vorbild, lobt diesen für seine Pionierarbeit und seine Ausdauer im Kampf gegen die Feinde der Wissenschaft. Im Wetterzentrale Forum jubilierte ein K.a.r.S.t.e.N, dies wäre doch eine geradezu bahnbrechende Arbeit, ein absoluter Meilenstein.

Wiederauferstehung einer Kurve: Kann man ihr wirklich vertrauen?

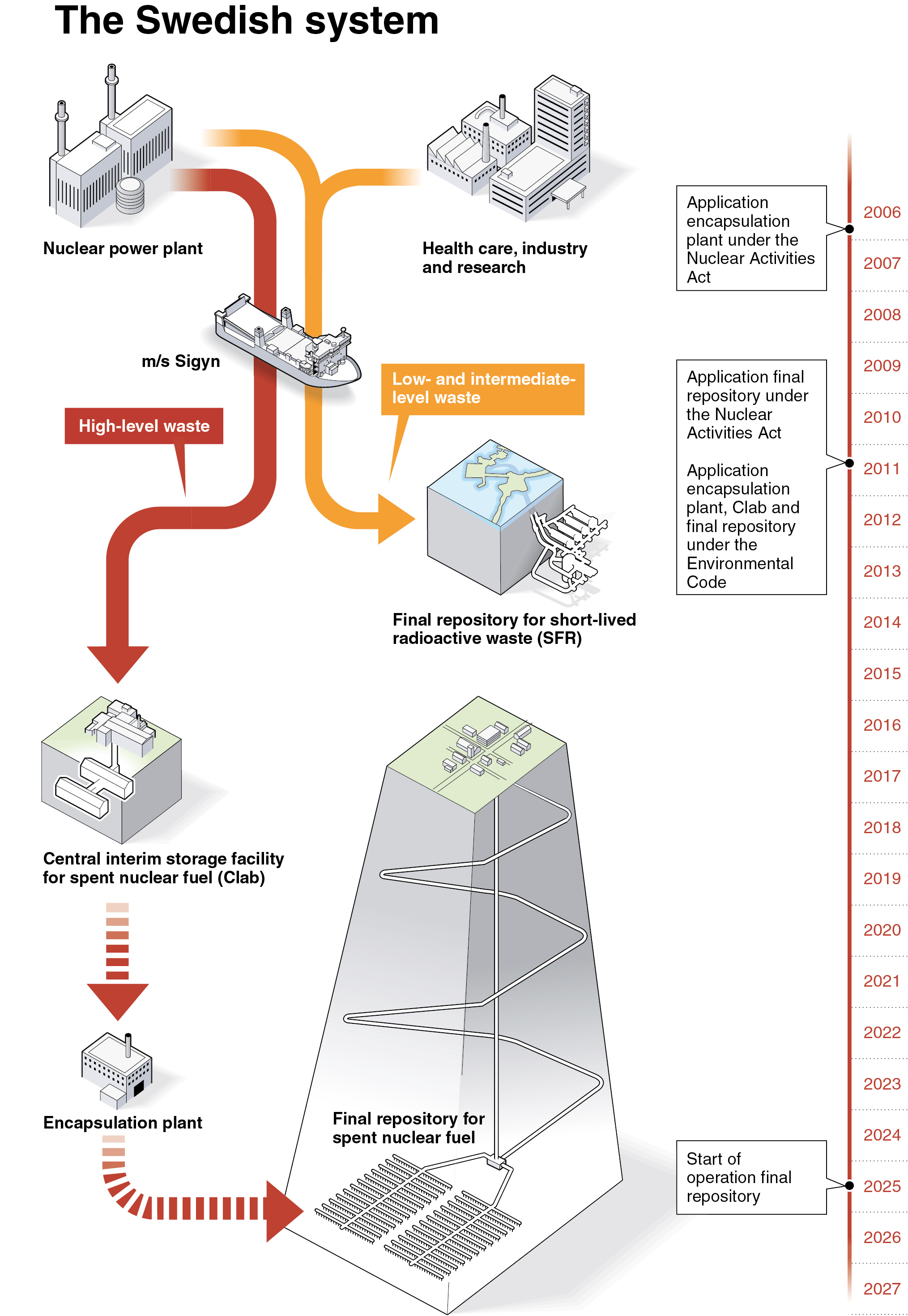

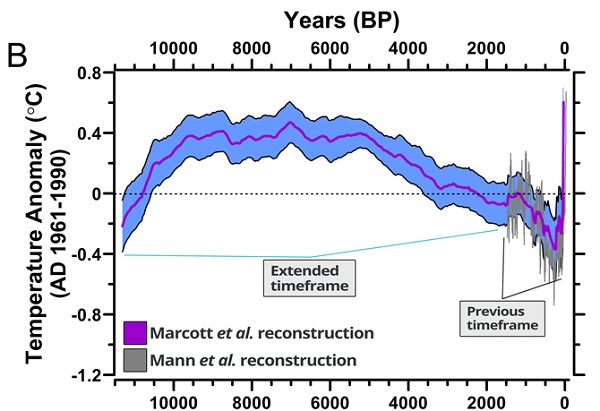

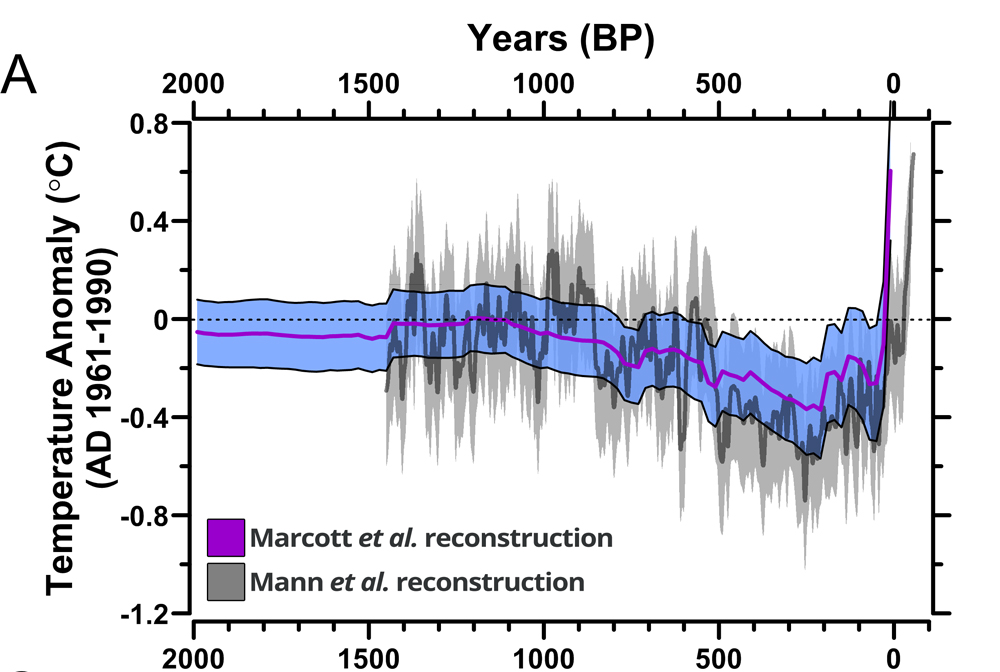

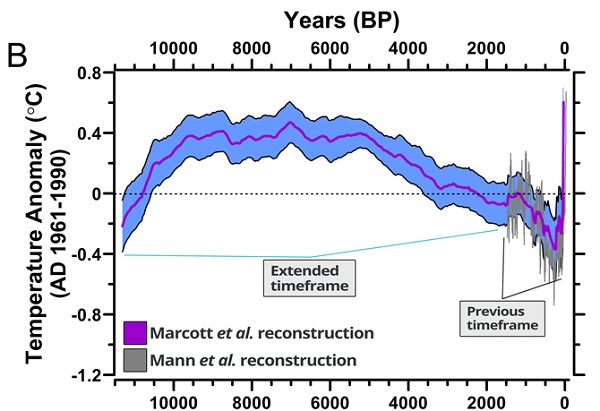

Klingt alles ziemlich gut. Trotzdem wollen wir uns die eigentlich unnötige Mühe machen und schauen kurz auf die in den Pressemitteilungen und Zeitungsartikeln gelobte neue Temperaturkurve:

Abbildung 1: Globale Temperaturrekonstruktion für die letzten 11.300 Jahre. Aus Marcott et al. (2013).

In der Tat ragt in der Heutezeit eine raketenhaft nach oben schießende Temperaturspitze aus der Kurve heraus. Allerdings erreicht sie gerade so etwa das Temperaturniveau, das bereits 4000 Jahre lang zu Beginn der Nacheiszeit geherrscht hat. Wäre dies nicht auch eine Schlagzeile wert gewesen? Zum Beispiel: „Neue Studie zeigt: Es war bereits tausende von Jahren mindestens so war wie heute.“

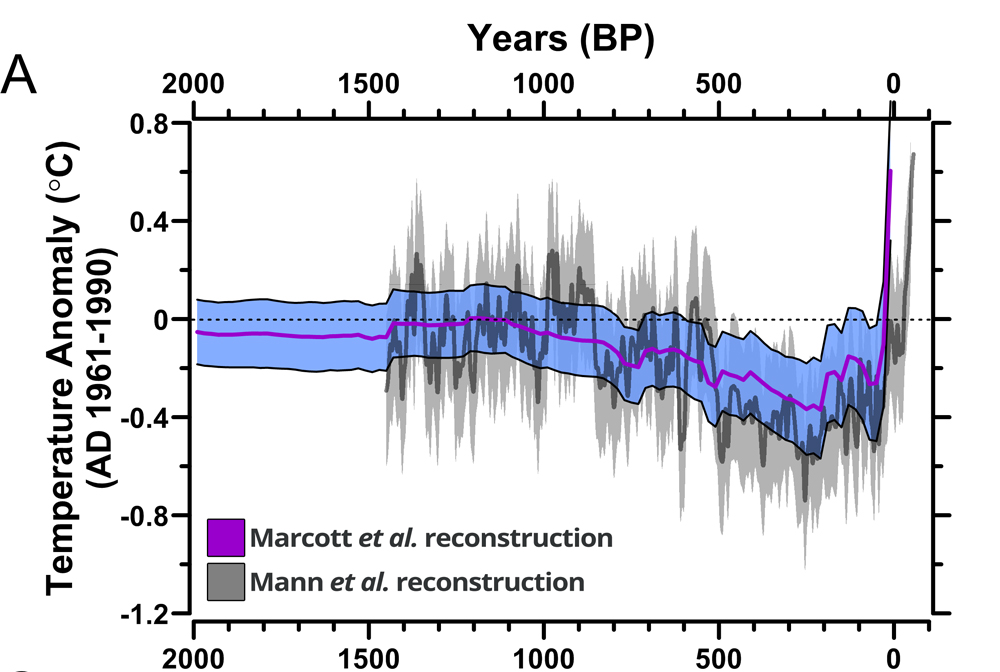

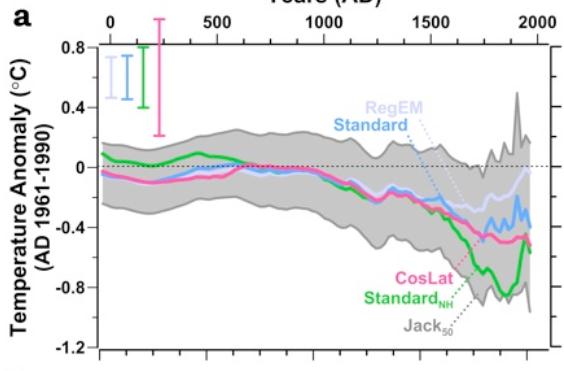

Dankenswerterweise haben die Autoren der Studie auch einen vergrößerten Ausschnitt ihrer Temperaturrekonstruktion für die letzten 2000 Jahre dazu gegeben:

Abbildung 2: Globale Temperaturrekonstruktion für die letzten 2,000 Jahre. Aus Marcott et al. (2013).

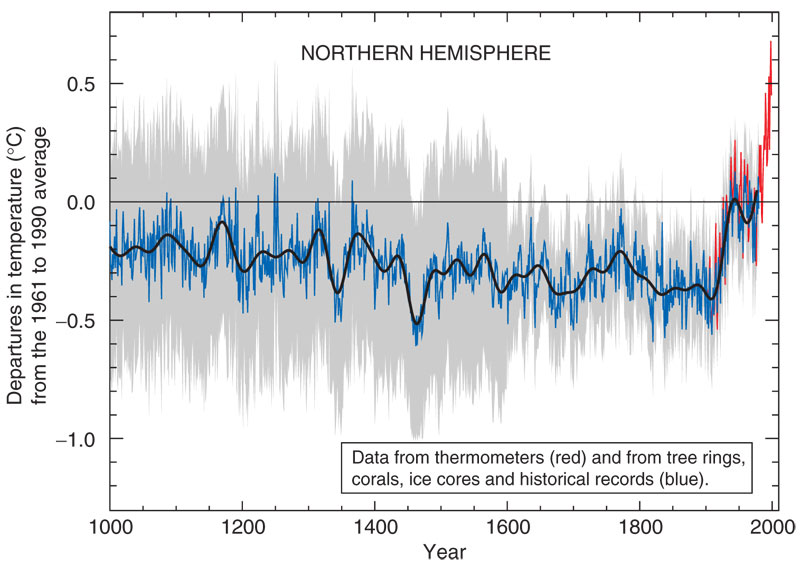

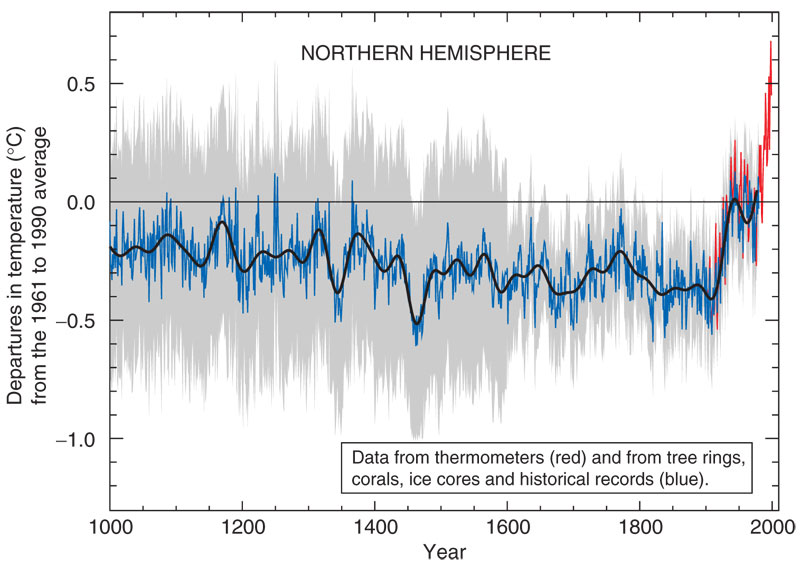

Fällt Ihnen etwas auf? Genau, das sieht doch fast genauso wie die berühmt berüchtigte Hockey Stick Kurve von Michael Mann aus. Weil jene so wunderschön ist, wollen wir sie hier nochmal zeigen:

Abbildung 3: Temperaturrekonstruktion der nördlichen Hemisphäre für die letzten 2,000 Jahre nach Michael Mann und Kollegen. Aus dem 3. IPCC-Bericht (Fig. 2.20).

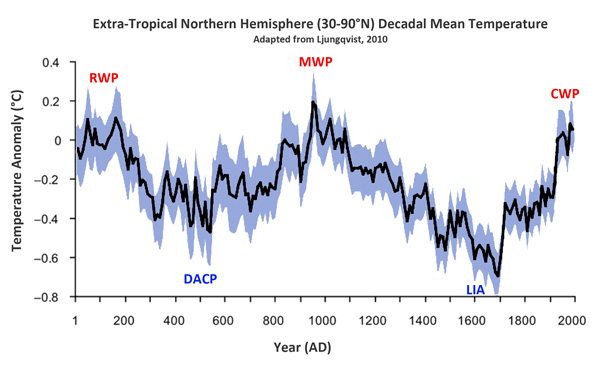

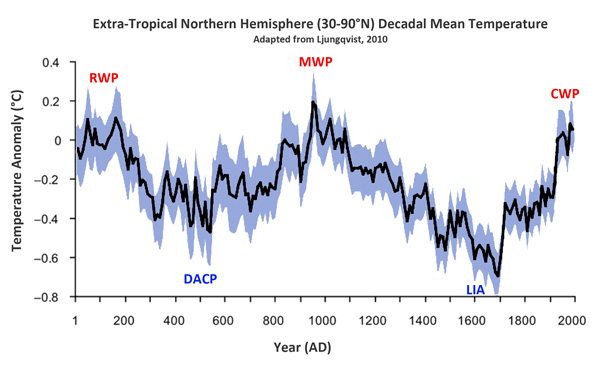

Da war er also wieder, der gute alte Hockey Stick. Auferstanden von den Toten. Aber wie konnte dies sein? Neuere Untersuchungen hatten doch zwischenzeitlich eindeutig nachgewiesen, dass es vor 1000 Jahren eine Mittelalterliche Wärmeperiode gegeben haben muss, die in etwa das heutige Temperaturniveau hatte. Zu nennen sind hier beispielsweise die Arbeiten des Schweden Fredrik Ljungqvist (Abbildung 4). Selbst der ursprüngliche Hockey Stick Erfinder Michel Mann musste seine Kurve in den letzten Jahren signifikant verändern und die Mittelalterliche Wärmeperiode wieder integrieren.

Abbildung 4: Temperaturrekonstruktion der außertropischen nördlichen Hemisphäre für die letzten 3,000 Jahre. Nach Ljungqvist 2010.

Auf Basis dieser allbekannten Vorgeschichte hätten sich die wissenschaftlichen Gutachter von Science sowie die internationale Fachpresse eigentlich besondere Mühe geben müssen, die Studie des Jungforschers Marcott auf Herz und Nieren zu prüfen. Ganz so viele Jahre Erfahrung hat er ja noch nicht vorzuweisen, da kann ein bisschen gesundes Misstrauen wohl nicht schaden. Dabei stehen zwei Fragen im Vordergrund:

1) Wo ist die Mittelalterliche Wärmeperiode plötzlich geblieben?

2) Durch welche Daten ist die raketenhafte Erwärmung der letzten Jahrzehnte belegt, die laut der Marcott-Studie zuletzt vor 6000 Jahren erreicht worden sei?

Nur wenige Pressevertreter hatten die Problematik bereits früh erkannt. Dazu gehörte auch Axel Bojanowski von Spiegel Online, der sich bezüglich der Studie von Experten aus Deutschland (Jan Esper, Universität Mainz) und der Schweiz (Ulf Büntgen, Eidgenössische Forschungsanstalt für Wald, Schnee und Landschaft) beraten ließ. Und diese Exerten mahnten zur Vorsicht. Bojanowski schrieb:

Gleichwohl falle auf, dass es den Daten zufolge in den vergangenen 11.300 Jahren nie einen so starken Wärmesprung gegeben habe wie im vergangenen Jahrhundert, seit der Mensch das Klima erwärme, sagt Studienautor Marcott. Ob es jedoch tatsächlich der einzige derartige Temperatursprung gewesen sei, ist Büntgen und Esper zufolge unklar: Die zeitliche Genauigkeit der Kurve liege bei durchschnittlich 120 Jahren, gibt Büntgen zu bedenken. Nur in den vergangenen Jahrzehnten gibt es auf den Tag genaue Aufzeichnungen. “Da kann die jüngste Erwärmung im Vergleich dann dramatischer erscheinen”, sagt Esper. Die meisten Daten stammen vom Meeresgrund. Doch Klimadaten aus dem Ozean zeigen üblicherweise geringere Ausschläge nach warm und kalt als Daten vom Land, erläutert der Forscher. Die Temperatur könnte in Wirklichkeit also mehr Sprünge gemacht haben. Mögliche Auswirkungen solcher Klimaschocks auf historische Ereignisse sollen künftige Studien klären.

Kollegen-Check: Mit wem arbeitet Marcott eigentlich?

Bevor wir uns gleich der Analyse von Marcotts Klimakurve widmen, wollen wir kurz überprüfen, um wen es sich eigentlich bei den drei Co-Autoren des jungen Geologen handelt. Zunächst wäre da Alan Mix. Mix ist Professor an der Oregon State University. Er betreibt das hiesige Isotopenlabor, dessen Messungen für derlei Studien unverzichtbar sind. Interessanter sind jedoch die anderen beiden Mitautoren. Peter U. Clark ist ebenfalls Professor an der Fakultät und fungierte als Doktorvater von Marcott. Aber was noch viel wichtiger ist: Clark ist ‚Koordinierender Leitautor“ für Kapitel 13 (Meeresspiegel) des gerade entstehenden IPCC-Klimaberichts. Dies könnte vielleicht den klimaalarmistischen Ton der Arbeit erklären. Eine böse Vorahnung beschleicht uns: Werden hier möglicherweise noch letzte aufrüttelnde Mosaiksteinchen für den 5. Klimazustandsbericht fabriziert, sozusagen als Auftragsarbeiten für IPCC-Kollegen?

Dieser Verdacht erhärtet sich, wenn wir uns den letzten Co-Autor näher anschauen, Jeremy Shakun. Auch Shakun war bis vor kurzem noch Clarks Doktorand. Bereits vor einem Jahr fiel Shakun mit einem fragwürdigen Paper auf, in dem eines der größten Probleme des IPCC „gelöst“ wurde, nämlich das zeitliche Hinterherhinken des CO2-Verlaufs gegenüber der Temperatur in den letzten 600.000 Jahren. Wie kann das CO2 in einem solchen Fall Wärmetreiber sein? Jeremy Shakun stellte damals neue Altersdatierungen vor, und schwupps sah plötzlich alles viel besser aus (siehe unseren Blogbeitrag „Statistik-Trick befördert CO2 vom Beifahrer zum Chauffeur: Fragwürdiger neuer Shakun-Artikel in Nature“). Co-Autoren der umstrittenen Studie? Peter U. Clark und Shaun Marcott ! Man wird das Gefühl nicht los, dass hier ein Doktorvater seine Schützlinge für fragwürdige IPCC-Zwecke verheizt. Ohne zuviel vorweg nehmen zu wollen: Alterdatierungen spielen auch in unserer aktuellen Geschichte wieder eine wichtige Rolle.

Die Analyse

Schreiten wir nun zur Analyse des wissenschaftlichen Gehalts des Marcott-Artikels. Wir stützen uns dabei auf die wertvolle Arbeit etlicher fleißiger Faktenchecker wie etwa Steve McIntyre, Rud Istvan und Don Easterbrook, die in ihrer Freizeit die Arbeit verrichten, die eigentlich von den bezahlten Vollzeit-Forschern hätte selbst erbracht werden sollen. Die Links zu diesen Analysen sind jeweils in den Text eingearbeitet.

Kümmern wir uns zunächst um den großen, zentralen Temperaturberg in der Kurve, der etliche Jahrtausende des Untersuchungszeitraums dominiert hat. Hier scheint prinzipiell alles in Ordnung zu sein. Es handelt sich nämlich um das wohlbekannte ‚mittelholozäne Klimaoptimum‘ während dessen es auf der Erde um mindestens ein Grad wärmer war als heute. Grund hierfür war die Bahnkonstellation der Sonne um die Erde, so dass während der Nordsommer durch geometrische Effekte mehr Sonneneinstrahlung auf die landreiche Nordhalbkugel geriet (siehe S. 128 in „Die kalte Sonne“).

Kommen wir zur nächsten Frage: Warum sieht der Kurvenverlauf eigentlich so glatt aus? Aus geologischen Untersuchungen wissen wir doch eigentlich, dass der Temperaturverlauf viel hochfrequenter war und sich enorme Änderungen im Jahrhundert bis Jahrtausend-Maßstab ereigneten. Das Rätsel lässt sich zum Glück relativ leicht auflösen. Marcott und Co-Autoren selbst wiesen in der Einleitung ihres Papers hin, dass die verwendeten Datensätze eine mittlere zeitliche Auflösung von nur 120 Jahren haben, einige sogar nur von 500 Jahren. Das heißt, dass das Geschehen von bis zu 500 Jahren auf einen einzigen Punkt verschmilzt. Die Mittelalterliche Wärmephase wurde mit dieser Methode einfach weggeglättet. Zur Analyse der genauen Temperaturgeschichte sind Marcotts Kurven daher überhaupt nicht geeignet. Vielmehr geht es in der Arbeit um den groben, langfristigen Klimaverlauf, der durch das mittelholozäne Klimaoptimum und die darauf folgende Abkühlung im Prinzip auch gut abgebildet ist.

Die wirklich brennende Frage ist jedoch eher methodischer Natur: Wie kann in einer Arbeit, die nur eine zeitliche Auflösung von Jahrhunderten besitzt, eigentlich plötzlich eine Temperaturspitze in der Heutezeit nach oben schießen, die nur wenige Jahrzehnte umfasst? Ein Ding der Unmöglichkeit. Warum sind die Gutachter von Science nicht auf diesen Widerspruch gestoßen? Waren die Gutachter möglicherweise gar nicht daran interessiert, etwaige Schwächen aufzudecken? Zwischenzeitlich kursieren Gerüchte, dass einer der Gutachter Michael Mann gewesen sein soll, was einiges erklären würde. Und noch etwas fällt auf: In Marcotts Doktorarbeit ist das entsprechende Manuskript auf Seite 41 noch als Einreichung bei der Zeitschrift Nature gekennzeichnet. Hatten die Gutachter von Nature den Braten frühzeitig gerochen und das Manuskript kurzerhand abgelehnt?

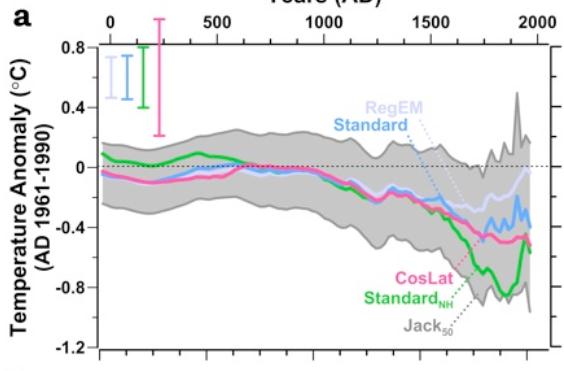

Bohren wir noch etwas genauer nach und versuchen zu verstehen, wie die moderne Temperaturspitze in Marcotts Kurve zustande kam. Dazu schauen wir zunächst in Marcotts Doktorarbeit nach. Dort ist bekanntlich viel mehr Platz um Dinge zu erklären als in einem vierseitigen Science-Artikel. Aber was für eine Überraschung ! In Marcotts Doktorarbeit taucht die moderne Wärmespitze gar nicht auf ! Falls Sie es nicht glauben, laden Sie sich doch einfach mal das pdf der Arbeit herunter und schauen auf Seite 48 nach. Dort findet sich nämlich die folgende Kurve (Abbildung 4). Das Resultat: Keine moderne Wärmespitze !

Abbildung 5: Globale Temperaturentwicklung der letzten 2000 Jahre laut Marcotts Doktorarbeit 2011. Es fehlt die ominöse moderne Wärmespitze, das Herzstück des späteren Science Artikels.

Shaun Marcott selbst scheint sich also der Problematik durchaus bewusst gewesen zu sein, dass man in einem zeitlich schlecht aufgelösten und stark geglätteten Datensatz nicht plötzlich nach Belieben kurzfristige Zacken einbauen kann. Nun wissen wir alle, dass man in Doktorarbeiten auf keinen Fall Schummeln darf, um schlimme Spätfolgen zu vermeiden, wie einige deutsche Politiker am eigenen Leibe erfahren mussten. In wissenschaftlichen Papers hingegen kann man schreiben was man will. Wenn es von den Gutachtern durchgelassen wird, gilt es als akzeptiert. War die Temperaturspitze im Science-Artikel daher möglicherweise nur eine Art böses Spiel, mal sehen, ob die Gutachter es finden, und wenn nicht, dann umso besser? Wer könnte hinter diesen Bestrebungen stecken? Doktorvater Peter U. Clark, der sich als koordinierender IPCC-Leitautor in unwissenschaftlicher Weise dem klimaalarmistischen Gedankengut verschrieben haben könnte?

Es kommt noch besser. Die Grundlage für Marcotts Temperaturkurve bildeten 73 einzelne Temperaturkurven, die von anderen Forschern in verschiedenen Teilen der Erde erstellt und größtenteils bereits publiziert worden waren. Marcotts Arbeit bestand lediglich darin, die Daten statistisch zu bearbeiten und eine Gesamtkurve daraus zu formen. Und von den 73 verwendeten Temperaturkurven decken lediglich 9 die Zeit ab 1950 ab. In diesen 9 Kurven muss also irgendwie die moderne Wärmespitze der letzten Jahrzehnte stecken, die die Autoren in ihrem Science Paper und den Pressemitteilungen stolz präsentieren und hervorheben.

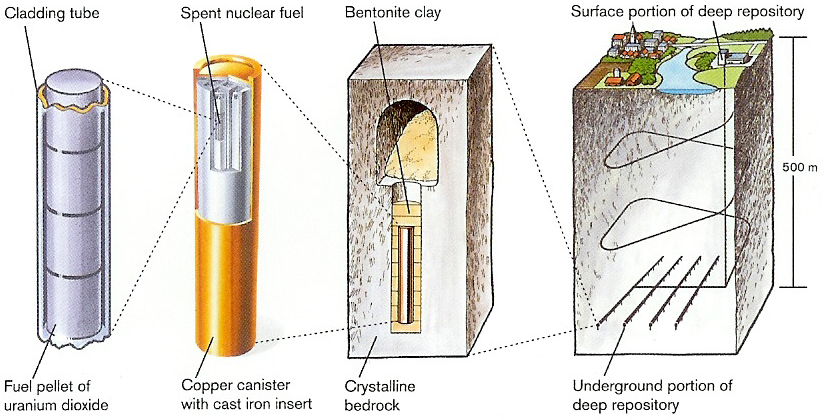

The Inconvenient Skeptic hat die Originaldaten dieser 9 Kurven einmal aufgetragen:

Abbildung 6: Darstellung der 9 Temperaturkurven, die in Marcotts Studie die Zeit nach 1950 abdecken und aus denen durch geeignete statistische Verfahren eine enorme Wärmespitze generiert wurde. Quelle: The Inconvenient Skeptic.

Sehen Sie es auch? Keine einzige der 9 Kurven besitzt eine ausgeprägte Wärmespitze in den letzten Jahrzehnten. Die Spitze im Science Paper ist ein übles, statistisches Artefakt. Was für eine Riesenpleite. Das Science Magazin sollte sich schleunigst neue Gutachter suchen.

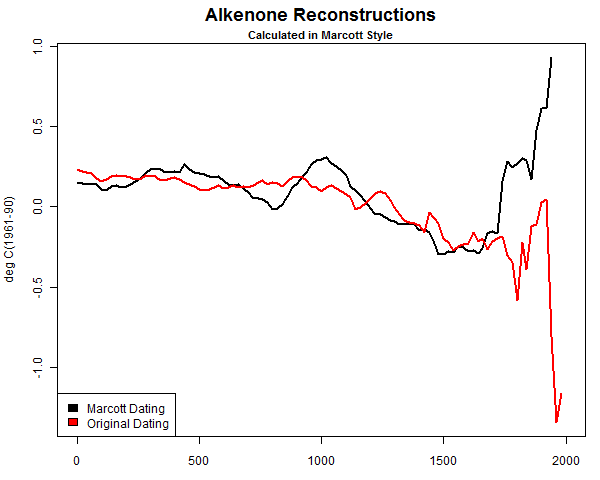

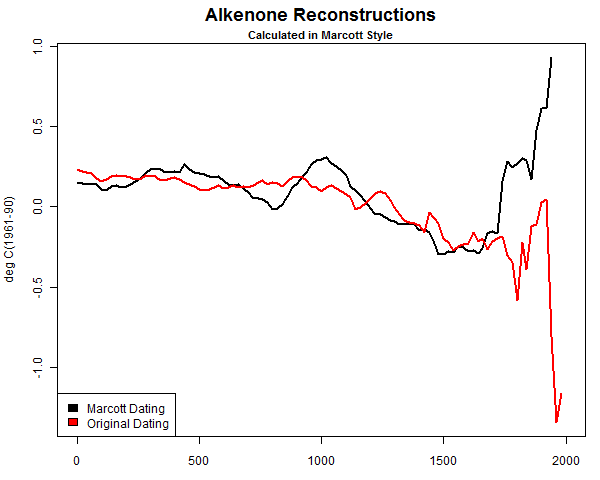

Offensichtlich hat die Marcott-Truppe aber auch an den Originaldaten herumgedoktort, um die Wärmespitze herbeizuzaubern. Spürnasen wieSteve McIntyre fanden schließlich, was passiert war. Marcott nahm sich die „künstlerische Freiheit“ die Altersdatierungen unliebsamer Datenpunkte zu modifizieren, um die gewünschte Hockey Stick-Geometrie zu erhalten. Schauen Sie sich das mal an:

Abbildung 7: Originaltemperaturdaten (rot) und was daraus nach phantasievoller Modifikation durch Marcott et al. wurde. Quelle: Climate Audit.

Das Eingeständnis

Drei Wochen nach dem Erscheinen des Papers, musste die Marcott-Truppe schließlich ihre Flunkerei hinsichtlich der modernen Wärmespitze einräumen. In aller Stille, am Ostersonntag, dem 31. März 2013 erschien auf der klimaalarmistischen Webplattform realclimate.org eine langatmige Erklärung der Autoren, in der sorgfältig in den Buchstabensalat versteckt das überfällige Eingeständnis zu finden war: Ja, die Temperaturen des 20. Jahrhunderts in der publizierten Kurve sind statistisch nicht robust, und die Temperaturspitze daher auch nicht. Lesen Sie die Einlassung im englischen Original:

Question: What do paleotemperature reconstructions show about the temperature of the last 100 years?

Answer: Our global paleotemperature reconstruction includes a so-called “uptick” in temperatures during the 20th-century. However, in the paper we make the point that this particular feature is of shorter duration than the inherent smoothing in our statistical averaging procedure, and that it is based on only a few available paleo-reconstructions of the type we used. Thus, the 20th century portion of our paleotemperature stack is not statistically robust, cannot be considered representative of global temperature changes, and therefore is not the basis of any of our conclusions.

Im Prinzip stand dies sogar bereits auf der ersten Seite im Science Artikel, nur etwas verklausulierter (Fettsetzung ergänzt):

Without filling data gaps, our Standard5×5 reconstruction (Fig. 1A) exhibits 0.6°C greater warming over the past ~60 yrB.P. (1890 to 1950 CE) than our equivalent infilled 5° × 5° area-weighted mean stack (Fig. 1, C and D). However, considering the temporal resolution of our data set and the small number of records that cover this interval (Fig. 1G), this difference is probably not robust.

Da wundert es umso mehr, dass Marcott zum Zeitpunkt des Erscheinens des Artikels in den zahlreichen Medieninterviews stets die angeblich einzigartige Erwärmungsrate der letzten Jahrzehnte hervorhob, obwohl diese Erwärmungsrate nach eigenen Angaben im Paper sowie dem späteren Eingeständnis in keiner Weise belastbar war. Was ging bloß im Kopf des jungen Mannes vor? Wurde ihm zu diesem Vorgehen geraten oder war es seine eigene Idee, die Welt so zu täuschen?

Ein Skandal und keine Folgen?

Der Skandal ist aufgeflogen und trotzdem scheint es keinen der ehemaligen Berichterstatter der Studie zu interessieren. Tagesspiegel,Stuttgarter Zeitung und Klimaretter haben noch immer ihren Originalartikel im Netz, ohne Hinweis oder Addendum auf den sinnentstellenden Fehler. Die klimaalarmistische Gemeinde verstummte plötzlich und ging auf Tauchstation. Klimarealisten wie Ross McKittrick mussten die Lücke füllen und die Öffentlichkeit über die veränderte Sachlage in der Presse informieren.

In einer sorgfältigen Analyse diskutiert Roger Pielke Jr., Professor für Umweltstudien an der University of Colorado at Boulder, ob das Verhalten der vier Autoren der Temperaturstudie möglicherweise sogar den Tatbestand des wissenschaftlichen Fehlverhaltens erfüllt. Pielke kann dabei zeigen, dass die Gruppe um Shaun Marcott die Ergebnisse ihrer Studie in den beiden Pressemitteilungen fehlerhaft dargestellt haben, die dann von einer Vielzahl von Medien im guten Glauben übernommen wurden. Pielke fordert in seinem Artikel die Zeitschrift Science auf, die fehlerhaften Abbildungen im Fachartikel gegen korrekte Versionen auszutauschen und den Text entsprechend zu korrigieren. Weiterhin fordert Pielke die National Science Foundation auf, Korrekturen an ihrer irreführenden Pressemitteilung vorzunehmen. Bislang hat keine der beiden Parteien auf diese berechtigten Forderungen reagiert.

Angesichts der schweren wissenschaftlichen Verfehlungen wäre es vermutlich das Beste, wenn die Autoren das Paper zurückziehen würden. Einen solchen Schritt ist Mitte 2012 bereits eine australische Forschergruppe gegangen, die ebenfalls einen vergeblichen Wiederbelebungsversuch des Hockey Sticks gestartet hatten (siehe unseren Blogbeitrag „Kontroverse um neuen australischen „Hockey Stick“: Autoren ziehen Paper zurück“). Es lohnt sich also durchaus, in den kommenden Wochen öfter einmal auf der Webseite von Retraction Watchvorbeizuschauen. Schließlich wäre dem IPCC und der Oregon State University angeraten, die Aktivitäten des koordinierenden IPCC-Leitautors Peter U. Clark näher unter die Lupe zu nehmen. Die Verkettung seltsamer Vorkommnisse in seiner Forschungsgruppe sollte Anlass genug sein, die dort angewandten Methoden sowie die eigentlich notwendige wissenschaftliche Unparteilichkeit zu prüfen.

Dr. Sebastian Lüning

übernommen von „Die kalte Sonne“

Related Files