Die Energiewende

Im November 2010 wurde unter großem medialen Getöse von der schwarz-gelben Regierung Merkel die „Energiewende“ als nationales Ziel bis 2050 ausgerufen. Alle Parteien im Deutschen Bundestag stimmten, bis auf wenige (7!) Abweichler in der Koalition und die Fraktion der Linkspartei (obwohl übereinstimmend mit dem Ziel, wollte sie es noch radikaler angehen) begeistert dafür. Die veröffentlichte Meinung in gut wie allen Medien hatten schon Monate zuvor für die Akzeptanz dieser „Energiewende“ auf allen Kanälen und ohne Unterlass getrommelt.

Sie fußte auf dem „Energiekonzept“, das wenige Monate zuvor unter der Regie des damaligen Umweltministers Norbert Röttgen, die vielen Einzel-Elemente der gesetzgeberischen Aktivitäten zum „Klimaschutz“ zusammenfasste, unter Einfügung neuer Elemente ergänzte und deutlich erweiterte. Nicht nur der „Klimaschutz“ wurde nunmehr als Begründung für die Notwendigkeit der „Energiewende“ angeführt, sondern auch die verkündete baldige Endlichkeit der fossilen Ressourcen.

Die Tsunami-Katastrophe in Japan vom März 2011, die mehr als 18.000 Todesopfer und unzählige Verletzte forderte und zusätzlich dann zur Havarie des Kernkraftwerkes in Fukushima führte, wurde zum Anlass genommen, den „Atomausstieg“ zu beschließen und spontan 8 Kernkraftwerke dauerhaft abzuschalten, und die restlichen 17 bis zum Jahre 2022 stillzulegen. Und dies, obwohl bei der Havarie in Fukushima kein einziger Mensch durch Strahlung ums Leben gekommen war, wohl aber rd. 1000 Menschen durch den Stress der panikartig durchgeführten Evakuierung weiter Landstriche.

Mit diesen einfach gestrickten Begründungen, die weiten Teilen der Wählerschaft auch unmittelbar einleuchteten, wurde die größte gesellschaftliche Transformation in Gang gesetzt, die ein Industrieland jemals außerhalb von Kriegen zu bewältigen hatte. Und mit vergleichbaren Kosten und identischen Folgen. Denn am Ende wird zwangsläufig ein völlig verarmtes, weil deindustrialisiertes, Deutschland stehen, dass nur noch bitterste Not und Zerstörung kennt, obwohl die Befürworter der „Energiewende“ das genaue Gegenteil versprechen. Nur, auch dem fähigsten Ideologen, Politiker, Wirtschaftsboss, Gewerkschaftler, Kirchenoberen, Erfinder oder sonst wem, wird es nicht gelingen geltende Naturgesetze außer Kraft zu setzen, und wenn man sie umgehen will, sorgen ebenso starke ökonomische Gesetze dafür, dass die Kosten für eventuelle Ersatzmöglichkeiten explodieren.

Doch genau das – nämlich das Umgehen geltender Naturgesetze- ist mit der Energiewende beabsichtigt! Um zu verstehen, warum das so ist, müssen wir uns ein wenig mit den physikalischen Eigenschaften von Energie im Allgemeinen und von elektrischer Energie im Besonderen beschäftigen. Denn das „Erneuerbare Energien Gesetz“, das die Erzeugung elektrischer Energie (vulgo: Strom) aus alternativen Energiequellen regelt bzw. erzwingen soll, ist das Kernstück der Energiewende.

Was ist Energie?

Energie, ist im wesentlichen die universale Fähigkeit im physikalischen Sinne Arbeit zu leisten. Sie ist weder erzeugbar noch vernichtbar. Das fundamentale Naturgesetz dazu heißt Energieerhaltungssatz. Sie kann aber von einer Form in eine andere umgewandelt werden. Doch jede Umwandlung ist zwangsläufig (Naturgesetz) mit Verlusten verbunden, die als Wärme, als der niedrigsten Stufe der Energie, entsteht. Deshalb ist der Begriff „Erneuerbare Energien Gesetz“ bereits eine bewusste Irreführung der Wähler, denn Energie kann selbstverständlich auch nicht „erneuert“ werden, auch dann nicht, wenn nachwachsende Rohstoffe zu ihrer Gewinnung eingesetzt werden. Energie kann eben nur unter unvermeidlichen Verlusten gewandelt werden! Das gilt selbstverständlich auch für die Stromgewinnung aus fossilen oder Kernbrennstoffen.

Sonderfall elektrische Energie

Elektrische Energie, wird allgemein als die höchst veredelte Form von Energie angesehen. Wärme dagegen, als die niedrigste. Letztendlich wird daher unvermeidlich – ein weiteres Naturgesetz von der stetig zunehmenden Entropie- die gesamte Energie unseres Universums in Wärme gewandelt sein. Aber bis dahin ist noch viel, sehr sehr viel Zeit. Und in dieser Zeit können wir das Gut „elektrische Energie“, also Strom, aus diversen Quellen durch Umwandlung erzeugen. Und der hat gegenüber den anderen Energieformen viele starke Vorteile. Aber auch einige Nachteile. Die Vorteile sind schnell aufgezählt: Schnellste und verlustarme Übertragungsmöglichkeit über weite Strecken, punktgenauer Einsatz auch in großen Mengen, zu jedem beliebigen Zeitpunkt, gut einsetzbar in Antriebe, Speicher und Heizungen in Investitions- und Konsumgütern, bei Beachtung gewisser Regeln sicher und sauber verfüg- und handhabbar, und sehr billig in der Erzeugung (Wandlung von thermischer Energie in elektrische Energie).

Die Nachteile reduzieren sich in diesem Zusammenhang auf eines, es lautet: Strom ist nicht – von Minimengen abgesehen- direkt speicherbar. Und, als Folge daraus: Strom muss immer dann auf Bruchteile von Sekunden verfügbar sein, wann immer er gebraucht wird. Manche Stromanbieterfirmen u.a. von Greenpeace, propagieren den Begriff des „Stromsees“, der durch das Netz geschaffen würde, aber das ist nichts weiter als irreführender Unsinn. Ins Verteilnetz muss zu jeder Zeit sekundengenau so viel Strom eingespeist werden, wie irgendwo entnommen wird. Einen Stromsee gibt es nicht.

Eine weitere Folge daraus ist, dass Speicher nur gewandelte elektrische Energie speichern können. Entweder in Form von Bewegungsenergie (Pumpspeicherwerke, Schwungradspeicher, Druckluftspeicher), chemischer Energie (Batterien, Akkus) oder thermischer Energie (durch Elektrolyse erzeugter Wasserstoff, der mit CO2 zu Methan umgewandelt wird).

Strom aus „Erneuerbaren“

Allein dieser naturgesetzlich bedingte Nachteil reicht aus, um die Erzeugung von Strom aus Windkraft und Sonneneinstrahlung gegenüber den bisherigen Methoden als völlig unzureichend auszusondern. Sie sind einfach qualitativ schlechter und als Folge daraus viel teurer. Denn keine dieser Quellen kann diesen schweren Nachteil von sich aus ausgleichen. Deswegen ist es korrekter diese Quellen nicht als „Erneuerbare“ zu bezeichnen, sondern als „Neue Instabile Energien“ (NIE). Nicht umsonst haben unsere Vorfahren vor über hundert Jahren die Nutzung der Windenergie mit Freuden verlassen und sich auf Energie aus fossilen Quellen gestürzt. Der Aufstieg der Nationen zu beispiellosem Wohlstand war die Folge. Denn sie vermeidet von Anfang an die oben genannten Nachteile, weil die notwendige Speicherung bereits von Mutter Natur in den fossilen oder Kernbrennstoffen vorgenommen wurde. Und damit kommen wir zu einer besonderen Eigenschaft, die die NIE´s insbesondere benachteiligen. Es ist deren Energiedichte!

Die Energiedichte natürlicher Speicher

Aufbereitetes Uran enthält pro kg ca. 350.000 kWh[1], Gas ca. 12 kWh/kg, Diesel/Öl ca. 11 kWh/kg, Steinkohle ca. 8 kWh/kg. Im Vergleich dazu sollte man die Energiedichte von chemischen Batterien/Akkumulatoren kennen. Sie liegt bei Bleiakkus, wie wir sie im Auto haben, bei 0,033 kWh/kg, bzw. bei den sehr teuren Lithium Akkus bei 0,166 kWh/kg. Also 333 bis 66 x schlechter. Die letzten beiden Zahlenwerte zeigen auch auf, warum die „Elektromobilität“ unter normalen kaufmännischen aber auch Umwelt-Gesichtspunkten, an echten Märkten keine Chance hätte.

Nun kann man schlecht den Energieinhalt von bewegter Luft (Wind) oder Sonnenstrahlen in kWh/kg ausdrücken, nur Schildbürger könnten das. Aber man kann den Flächenbedarf vergleichen, den Anlagen zur Erzeugung gleicher Energiemenge auf konventionelle Art bzw. alternative Art beanspruchen.

Sicher ist Ihnen lieber Leser/Leserin auch schon aufgefallen, das Wind- und Solarkraftwerke immer in Rudeln, beschönigend „Parks“ genannt, auftreten. Der Grund dafür ist die mangelhafte aber naturgegebene sehr geringe Energiedichte. Deswegen müssen Riesenflächen mit diesen Anlagen vollgestellt werden, die bei der Windenergie auch noch als riesige Türme in den Himmel ragen, um die Energie der Energieträger Wind und Sonne in brauchbaren Mengen „abzuernten“. Wie aberwitzig das ist, zeigt ein Vergleich mit einem konventionellen oder Kernkraftwerk, mit einer Leistung (das ist die „Kraft“ um Arbeit zu „leisten“) von 1 GW. 1 Gigawatt sind 1.000 Megawatt, und das sind 1.000.000 Kilowatt. Die Einheit, die wir bereits kennen gelernt haben. Da die Energiedichte konventioneller Energieträger sehr hoch ist, kann man die Kraftwerke sehr kompakt bauen. Ein derartiges Kraftwerk mit 1 GW Leistung bedeckt incl. Gleisanschluss und Brennstofflager ca. 1,5 bis max. 2 km2. Da es ganzjährig und rund um die Uhr betrieben werden kann, liefert es bei Bedarf eine Energiemenge von ca. 7.900 GWh.

Windkraftanlagen

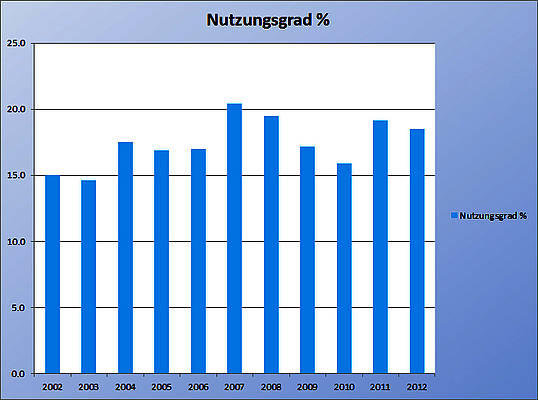

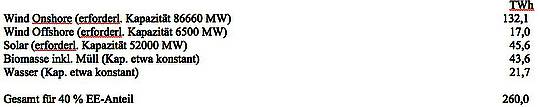

Um – auch nur rechnerisch- dieselbe Menge an Energie mit NIE, z.B mit der neuesten 2,3 MW[2] Anlage von Siemens, aus Wind zu erzeugen, bräuchte man einen „Windpark“ auf dem Lande mit ca. 2.300 Windkraftanlagen dieses Typs. Weil man die nicht dicht an dicht bauen kann, denn der Wind weicht aus, braucht man dafür einen Korridor mit der Länge von 920 km, und einer Breite von ca. 0,25 km. Also insgesamt 230 km2 . Das ist rd. das 130 fache des Flächenbedarfes eine konventionellen Kraftwerkes.

Solaranlagen

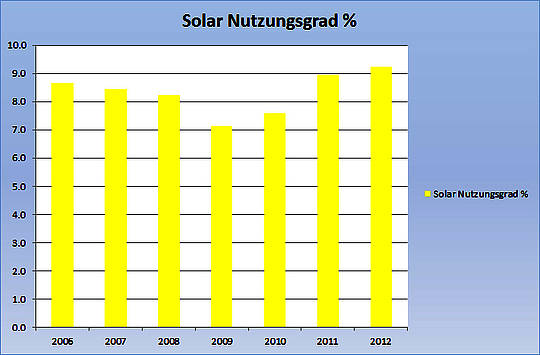

Bei den Solaranlagen ist das Ergebnis ähnlich schockierend. Als Beispiel soll hier der Solarpark bei Finowfurt/Brandenburg dienen, bis vor kurzem der größte „Solarpark“ Europas. Der hat eine Nennleistung von 84 MW. Dank der geringen Sonneneinstrahlung in Brandenburg und der Tatsache, dass die Sonne des Nachts und vor allem in den dunklen Herbst und Wintermonaten nirgendwo so richtig scheint, kann dieser „Solarpark“, solange er neu ist, rd. 59 GWh ins Netz -sofern die Leitungen gebaut wurden- einspeisen. Dann aber mit Vorrang gem. EEG. Seine Fläche wird von den Betreibern mit 1,82 km2 angegeben. Um wiederum nur rechnerisch dieselbe Energiemenge wie das konventionelle Vergleichskraftwerk, wie oben benannt, zu erzeugen, benötigte man rd. 134 „Parks“ dieser Art, die eine Fläche von 244 km2 bedecken müssten.

Biomasse

Den Vogel schießt übrigens die Biomasse ab. Zur Erzeugung von z.B. Mais für entsprechend viel Biogas-Kraftwerken w.o. benötigte man mindestens (ohne Lager, Wege und Fläche für die eigentlichen Kraftwerke) eine Fläche von ca. 1.600 km2. Da ist rund 2 x die Fläche der freien und Hansestadt Hamburg.

Einschub über Leistung und Arbeit (Energie):

An dieser Stelle scheint es angebracht auf den Unterschied zwischen Energie (hier z.B. in Gigawattstunden (GWh) angegeben) und Leistung (hier in z.B. Gigawatt angegeben) einzugehen, der in den Medien und der Politik fast immer durcheinander gebracht, oft auch gleich gesetzt wird. In Deutschland sind inzwischen Ende 2013 ca. 32 GW an Windenergieanlagen installiert. Oft lesen wir, das sei so viel wie die von 32 Kernkraftwerken.

Auch lesen wir fast immer, diese oder jener Park aus „Erneuerbaren“ Quellen könne so und so viele Haushalte mit Strom versorgen. Glauben Sie kein Wort davon. Tatsache ist dass kein Wind- oder Solarpark jemals ein konventionelles Kraftwerk egal ob Kern- Gas oder Kohle betrieben, ersetzen kann, denn wie zuvor schon erwähnt, liefern diese Quellen nicht dann wenn Strom gebraucht wird, sondern nur an den wenigen Stunden im Jahr, wenn die Sonne scheint, oder der Wind weht. Und dazu noch nur vom Willen Götter bestimmt. Man verwechselt also, bewusst oder unbewusst, die Nennleistung, welche die jeweilige Anlage unter Laborbedingungen gemessen, bereitstellen kann, mit der Energie, die ein Kraftwerk gleicher Nenn-Leistung ganzjährig und auf Abruf jederzeit liefert. Ein ganz erheblicher Unterschied! Mit gleicher „Wahrheit“ könnte man behaupten, ein einziger Blitz würde die Leistung sämtlicher deutscher Kraftwerke übertreffen. Man vergisst dabei nur, dass niemand etwas davon hat, weil der Blitz zufällig auftritt und seine Leistung nur wenige Mikro- bis Millisekunden abgeben kann.

Mangelnde Speicher

Diese Zufälligkeit der Energieerzeugung ist ein weiterer nicht behebbarer naturgesetzlicher Mangel der NIE. Es gibt einfach keine Speicher, um die so aufwendig (Die Investition dafür ist jeweils 6 x teurer bei Offshore Wind bis 17 x teurer bei Solar, als konventionell) erzeugte Energie zu speichern und bei Bedarf zur richtigen Zeit am richtigen Ort in der richtigen Menge wieder einzuspeisen. Weder heute noch in Zukunft. Die einzigen Großmengen-Speicher für elektrische Energie sind Pumpspeicherwerke (PSW). Sie werden seit ca. hundert Jahren gebaut, und haben nur einen Wirkungsgradverlust von 20 bis 25 %. Alle anderen Speicherverfahren sind darin wesentlich schlechter und großtechnisch nicht verfügbar. Das Prinzip der PSW ist einfach. Aus einem Untersee wird bei Nacht, wenn der Strom billig ist, viel Wasser in einen manchmal hundert oder mehr Meter höher gelegenen Obersee gepumpt. Zur Mittagszeit, oder bei anderen Lastspitzen, werden die Schleusen des Obersees dann geöffnet, das Wasser rauscht nach unten und treibt Turbinen zur Stromerzeugung an.

Das größte deutsche Pumpspeicherwerk und eines der größten in Europa, ist Goldisthal im schönen Thüringen. Es hat eine Leistung von 1 GW und kann diese Leistung 8 Stunden lang abgeben. Das sind 1 GW x 8 Stunden also 8 GWh. Dann ist es leer und muss wieder gefüllt werden. Das geht nur langsam, und auch nur dann, wenn genügend billiger Strom zur Verfügung steht. Deutschland hat jährlich einen Stromverbrauch von rd. 600 TeraWatt-Stunden. Das sind 600.000 GWh. Pro Stunde sind das im Mittel 68,5 GWh. Goldisthal könnte also den Energiebedarf Deutschlands rechnerisch gerade mal für gut 8,5 Minuten decken. In ganz Deutschland stehen PSW mit insgesamt 7 GW. Sie könnten -aber auch nur theoretisch[3]– für rd. 35 Minuten Deutschlands Energiebedarf decken. Mehr können aus Gründen der Topologie, des Umweltschutzes aber vor allem der riesigen Kosten wegen nicht gebaut werden. Allein Goldisthal benötigte eine Bauzeit von 11 Jahren und kostete 600 Mio €.

Aus diesen Gründen kann der zwingend erforderliche Lastausgleich nur über konventionelle Kraftwerke erfolgen. Man spricht dann von Pufferkraftwerken. Das geht und wird auch so gemacht. Allein diesen -oft übelst beschimpften- Kraftwerken, die „schmutzigen“ Strom erzeugen, und ihren fähigen Betreibern, ist es zu verdanken, dass bisher in Deutschland die Lichter nicht ausgingen. Das Problem aber, was diese nun sehr intermittierende und zeitlich immer geringere Einspeisung aus konventionellen Kraftwerken erzeugt, ist zunächst mal ein ökonomisches. Wegen der geringen abgegebenen Energiemenge und des geringen Börsenpreises, welcher der zuvor hoch subventionierte Überproduktion an NIE Strom zu verdanken ist (Strom lässt sich nicht speichern, zusammen sind jetzt bereits rd 70 GW NIE Kapazität installiert), rechnen sich die konventionellen Kraftwerke häufig nicht mehr. Zudem werden sie durch den ständigen Lastwechsel völlig auf Verschleiß gefahren. Die Kosten steigen rasant. Die Konsequenz ist, dass immer mehr dieser Kraftwerke stillgelegt werden. Ein Umstand, der den Befürworten der NIE überhaupt nicht passt.

Auch deshalb, aber insbesondere durch die ungebremste Vorrang-Einspeisung (so will es das EEG) von zappelndem Solar und Windstrom mehren sich die Störungen, die einen geordnete Stromversorgung bei stabiler Spannung (230 V) und Frequenz (50 Hertz) immer schwieriger machen. Bald werden sie so weit zunehmen, dass Experten der Netzbetreiber, die für diese stabile Stromversorgung sorgen müssen, in Kürze von flächendeckenden und langandauernden Ausfällen (Blackouts) ausgehen. Denn aus Gründen der Betriebssicherheit sind alle Anlagen mit automatischen Überlastabschaltungen ausgerüstet, die in Sekundenbruchteilen gefährdete Anlagen bei gefährlichen Störungen vom Netz nehmen. Lag die Zahl der Störungen vor einigen Jahren noch bei 3 bis 4 pro Jahr, so sind es heute ca. 1.000. Und ein deutschlandweiter nur einstündiger Blackout[4] würde heute mit ca. 600 Mio € an Schaden zu Buche schlagen.

Fazit

Wir können also mit Fug und Recht feststellen, dass die Energiewende von Anfang an gescheitert ist, weil sie scheitern musste. Kein Naturgesetz lässt sich von einem noch so schlauen Politiker brechen oder beugen. Gute Ingenieure können die eine oder andere natürliche Begrenzung umgehen. Doch das kostet! Und wie. Zahlten wir doch bis jetzt schon Ende 2013 seit Bestehen des EEG ca. 120 Mrd € in die Taschen der NIE Erzeuger, ihrer Finanziers und Projektierer ein. Gleichzeitig ist dieser Geldsegen für die kommenden 20 Jahre garantiert . Kein Wunder dass die EEG Gewinnler dieses mit Klauen und Zähnen verteidigen. Denn allein diese Garantie kostet uns Verbraucher in den nächsten Jahren nochmals 330 Mrd €. Und so geht es ungebremst weiter, denn auch im neuen Koalitionsvertrag steht, dass man die „Erneuerbaren“ bis 2035 auf 55 % bis 60 % Anteil hochfahren will.

Wofür zahlen wir das? Für ein Produkt, welches aus Preis und Qualitätsgründen in echten Märkten nicht die Spur einer Chance hätte. Denn es ist in jeder Hinsicht miserabel.

Klima und Ressourcen

Lassen Sie mich zum Schluss liebe Leserin und lieber Leser noch auf die beiden Hauptargumente eingehen, die zur Begründung der Energiewende herhalten müssen. Um es vorweg zu sagen: Sie sind beide falsch.

Klimaschutz

Im neuen Koalitionsvertrag steht unter Punkt 1.4 wirklich, dass die Energiewende Umwelt und Klima schützt, ferner Importe – also fossile Resourcen- mindert. Kein Wort davon ist wahr. Selbst wenn man mit geschlossenen Augen durch diese Welt geht, wie es viele Entscheidungsträger und Mitbürger offensichtlich tun, und ohne Mitdenken oder Reflexion den öffentlichen Verlautbarungen des zum Weltklimarates hochgejubelten staatlichen IPCC (Intergovernmental Panel on Climate Change) über den Einfluss des (insbesondere anthropogen erzeugten) CO2 auf die Weltmitteltemperatur Glauben schenkt, dann muss man zwangsläufig konstatieren, dass sämtliche deutsche Absenkungsbemühungen durch den EU Emissionshandel völlig konterkariert werden. Selbst wenn NIE Anlagen CO2 vermeiden würden, was sie – wenn man ihren gesamten Lebenszyklus betrachtet- nicht tun, dann wird diese Absenkung durch eine automatische Erhöhung des CO2 Ausstoßes der am Emissionshandel beteiligten EU-Länder mehr als ausgeglichen. Das ist so gewollt und geschieht auch so.

Darüber hinaus blasen andere große Länder wie Indien, China oder Brasilien in einer Woche das zusätzlich an CO2 aus, was wir dummen Deutschen in einem Jahr einsparen wollen. Doch nicht nur das. Auf keiner der vielen tausenden von Seiten aller fünf bisherigen IPCC Berichte findet sich auch nur der Hauch eines Hinweises auf Beobachtungen oder andere Belege, die beweisen, dass CO2 die Temperatur steuert, in diesem Falle gefährlich anhebt. Stattdessen ist es bestätigt, dass die Mitteltemperatur der Erdatmosphäre seit nunmehr 17 Jahren nicht mehr angestiegen ist, obwohl es die CO2 Konzentration stetig, auf jetzt knapp 0,04 %, tat. Die Klimamodelle haben schmählich versagt. Sie sind durch die Wirklichkeit eindeutig widerlegt.

Ressourcenknappheit

Auch die vermutete oder erhoffte Ressourcenknappheit gehört ins Reich der Fabel, wie sie besonders der grün-rote Club of Rome zu erzählen beliebt. Derzeit krempeln neuartige Prospektions-, Bohr- und Gewinnungsverfahren, also technologischer Fortschritt (Stichwort „Fracking“), die energetische und damit politische Weltkarte komplett um. Die USA sind bereits jetzt weltgrößter Erdgasproduzent der Welt und werden in Kürze auch zum weltgrößten Exporteur aufsteigen. Deren Gaspreis liegt um 75 bis 80 % unter dem unseren. Dasselbe passiert am Ölmarkt, von der Kernenergie nicht zu reden. Beinah im 2 Monatsrythmus werden riesige Erdgas und Erdölfelder entdeckt, welche die Reichweite dieser Ressourcen um viele hundert bis tausend Jahre in die Zukunft verschieben.

Schlussbemerkung

Ich bin sicher, ich konnte Ihnen verdeutlichen, dass die Energiewende keine der verkündeten Ziele erreichen kann, aber sehr unerwünschte, zwangsläufige Nebenwirkungen hat, die wir bereits heute in großem Umfang spüren. Der Trend wird sich beschleunigen und nicht nur die Energie sehr, sehr teuer machen, sondern auch die Zahl der wertschöpfenden Arbeitsplätze in diesem Lande dramatisch reduzieren. D.h. die Zange kneift von zwei Seiten, wesentlich höhere Kosten für jeden von, bei gleichzeitigem Verlust oder Drohung des Verlustes von Millionen von Arbeitsplätzen.

In der Verwaltungsgesetzgebung gibt es ein Gesetz, was bestimmt, dass Verwaltungsakte, deren Ziele eindeutig nicht erreichbar sind, nichtig sind. Die Energiewende ist so ein Verwaltungsakt. Sie muss ersatzlos um 180 ° gewendet werden, alle Durchführungs-Gesetze sind ersatz-und entschädigungslos zu streichen. Lassen Sie uns gemeinsam dafür kämpfen

Michael Limburg; Dezember 2013

Der Beitrag erschien Ende Dezember im Extrablatt der „Vertraulichen Mitteilungen“ des Verlages für Arbeit und Wirtschaft Büsingen.

Sie können ihn auch als pdf im Anhang herunterladen

[1] Anmerkung: Energie wird heute in Joule oder Watt-Sekunden (Ws) bzw. vielfachem davon gemessen. Hier kWh d.h. Tausend (kilo) Watt in einer Stunde. Nach der Definition von Energie als Arbeit = Leistung x Zeit. Das bedeutet auch, dass 1 Kraftwerk bei einer Leistung von 1 Kilowatt über 1 Stunde 1 kWh abgibt, bzw ein Herd bei einer Leistung von 1 kW eine Stunde lange 1 kWh „verbraucht“ bzw. wieder in Wärme umwandelt.

[2] Gem. Daten von Siemens hier http://www.siemens.com/sustainability/de/umweltportfolio/produkte-loesungen/erneuerbare-energien/wind-onshore.htm

[3] Kein Kraftwerk kann mehr Leistung abgeben, als die wofür es ausgelegt wurde. Im Falle der PSW sind das max. 7 GW. Zudem kann diese Leistung nur über die per Auslegung festgelegte Zeit abgegeben werden. Wegen der Rohrquerschnitte und der Auslegung der Turbinen kann man min. 5 bis 6 h lang diese Energiemenge abrufen. D.h. dass die deutschen PSW nur d. 1/10 der notwendigen deutschen Leistung decken können, dies dann für rd. 5-6 h.

[4] Quelle Die Welt http://www.welt.de/wirtschaft/article121265359/Jede-Stunde-Blackout-kostet-600-Millionen-Euro.html

Related Files