I. AUSGANGSSITUATION

Die Energiewende soll zwei (vermeintliche?) Probleme lösen: Erstens die Abhängigkeit von fossilen Rohstoffen beseitigen, die nach den „Prophezeiungen“ des Club of Rome über die Grenzen des Wachstums aus dem Jahre 1972 „sehr zeitnah“ nicht mehr verfügbar sein werden, sprich die Begrenztheit der Vorräte an Kohle, Öl und Gas wird ins Kalkül gezogen. Dadurch sollen sich auch die anthropogen verursachten Emissionen des Gases CO2 verringern, die vom wissenschaftlichen „Mainstream“ ganz wesentlich für den Klimawandel verantwortlich gemacht werden – Stichwort: Menschengemachter Klimawandel. Zweitens soll das deutsche Energiesystem sukzessive, d.h. in vier Schritten von fossilen auf erneuerbare Energien wie Sonne, Wind, Biomasse und Wasserkraft umgestellt werden. Bis 2020 sollen jeweils mindestens 35%, bis 2030 50%, bis 2040 65% und bis 2050 80% der Stromerzeugung regenerativ erfolgen, die gesamte Energieversorgung zur Jahrhundertmitte zu mindestens 50%.

Parallel zum Umstieg von fossilen Energieträgern auf erneuerbare Energien erfolgt der Ausstieg aus der Kernenergie, der schon in 2022 zu 100% vollzogen sein soll (doppelter Ausstieg aus Kohle und Uran). Dies ist das Ergebnis der im Nachgang zu der Naturkatastrophe vom 11. März 2011 – dem Erdbeben und Tsunami mit anschließender Havarie von drei Reaktoren in Fukushima/Japan – von der Bundesregierung am 6. Juni 2011 getroffenen Entscheidungen (Eckpunkte für eine beschleunigte Energiewende). Kurz zuvor war der Kernkraftnutzung in Deutschland noch eine Funktion als „Brückentechnologie“ zugetraut und zugebilligt worden. D.h. sie sollte einen behutsamen Systemwechsel von Fossil auf Erneuerbar auch wirtschaftlich abfedern und begleiten (zum Status quo der Kernenergie in Deutschland siehe nur www.kernenergie.de).

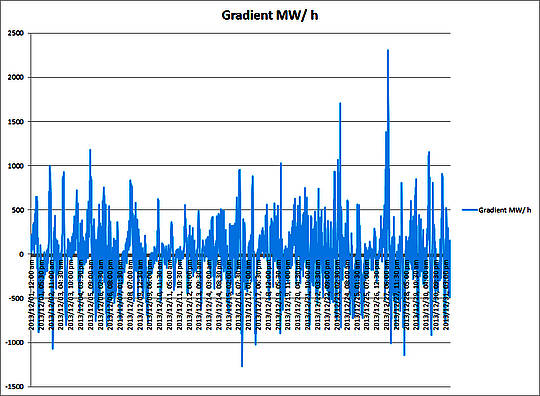

Die Energiewende setzt damit einen gravierenden Umbau des gesamten deutschen Energieversorgungssystems in allen Sektoren (Erzeugung, Transport über Leitungsnetze, Speicher) voraus, einschließlich der Anpassungen in Industrie und Gesellschaft (Effizienzerhöhung, Energieeinsparung, Orientierung am Stromangebot). Zu beachten ist, dass sich Strom in energiewirtschaftlich relevantem Maße bis heute kaum speichern lässt. Hinzu kommt die Notwendigkeit, vermehrt Strom zu importieren. Wirtschaftlich mit vertretbarem Wirkungsgrad sind lediglich Pumpspeicherkraftwerke (PSKW) in der Lage, die Speicherfunktion (über einen Umweg) in einer nennenswerten Größenordnung zu übernehmen. Allein schon aufgrund der Topographie können aber gar nicht so viele PSKW gebaut werden, wie notwendig wären. Alle andern Speichersysteme sind noch „meilenweit“ von der großtechnischen Realisierbarkeit und Wirtschaftlichkeit entfernt.

Das Vehikel zur Umsetzung der Wende bildet das Erneuerbare Energien Gesetz (EEG). Es trat zum 1. April 2000 zu Zeiten einer rot-grünen Bundesregierung in Kraft und löste das Stromeinspeisungsgesetz – mit dem ersten Einspeise- und Vergütungssystem zugunsten regenerativen Stroms – ab, das seit dem 1. Januar 1991 gültig war.

Als Väter dieses ganze fünf Paragraphen starken „Gesetzes über die Einspeisung von Strom aus erneuerbaren Energien in das öffentliche Netz“ werden einzelne Politiker von CSU, Grünen und SPD kolportiert. Sicher ist, dass der entsprechende Gesetzesentwurf von der CDU/CSU-Fraktion eingebracht und u.a. von Helmut Kohl und dem FDP-Politiker Helmut Haussmann (dem damaligen Bundeswirtschaftsminister) unterzeichnet wurde. Also eine schwarz-rot-grüne Erfindung, die knapp 10 Jahre später unter der Mitwirkung von Solarunternehmern am Gesetzesvorhaben richtig „vergoldet“ wurde.

Das Markenzeichen des an die Bedingungen im liberalisierten Strommarkt angepassten und erheblich erweiterten EEG – zuletzt geändert am 20.12.2012, mit zwischenzeitlich 66 Paragraphen und fünf Anhängen – sind der Einspeisevorrang für Erneuerbare, die 20 Jahre lange Garantiezeit sowie die, trotz verschiedener Anpassungen nach unten (sog. Degressionen) immer noch stattlichen Einspeisevergütungen. Mit dieser in Kürze vorletzten Novellierung wurde – zum ersten Mal überhaupt – für die Förderung des weiteren Ausbaus von PV-Anlagen bei 52 Gigawatt eine Deckelung verfügt.

Der Anstieg der Nutzung von erneuerbaren Energien ist wesentlich auf das EEG zurückzuführen. Ihr Anteil an der Bruttostromerzeugung betrug im Jahr 2013 bereits 23,4 Prozent (siehe hierzu die umfangreichen Daten aus dem Bundesministerium für Wirtschaft und Energie – www.bmwi.de).

II. FEHLENDE „SOLLBRUCHSTELLEN“ IM KONZEPT DER ENERGIEWENDE

Zweifelsfrei hat das EEG zur Markteinführung und -durchdringung der Erneuerbaren einen ganz wesentlichen Beitrag geleistet. Nunmehr kommen aber in zunehmendem Maße Probleme zum Tragen, die allein aus dem Konstrukt heraus zu erklären, und somit systemimmanent sind. Ein grundsätzliches Problem ist sicher, dass nicht von Beginn an ein Verfallsdatum festgelegt worden ist und auch die Evaluation nicht mit der notwendigen Akribie erfolgte, vermutlich weil sich die Finanzierung zu großen Teilen außerhalb des Bundeshaushalts bewegt.

Systemdefekt 1: EU-Zertifikate und EEG ein Widerspruch an sich

Bei der Einführung von Emissionszertifikaten auf Ebene der Europäischen Union im Jahre 2005 hätte man das EEG ersatzlos streichen müssen. Denn obwohl beide Systeme eine Verringerung der CO2-Emissionen beabsichtigen, schließen sie sich im Grunde genommen aus. In der Folge kann „ … durch das EEG keine Kohlendioxidminderung erzielt werden, die über das durch den Emissionshandel allein bewirkte Maß hinausgeht.“ (Manuel Frondel u.a.: Solarweltmeister Deutschland? Ein gewaltig teurer Irrtum, in: List Forum, Bd. 39 (2013), S. 99-122, hier S. 111). Denn die geringeren CO2-Emissionen in Deutschland lassen den Preis der an der Börse gehandelten Zertifikate/Verschmutzungsrechte sinken. Dadurch wird es günstiger Zertifikate zu kaufen, anstatt CO2-Vermeidungsmaßnahmen zu finanzieren. Die Einsparungen an der einen Stelle werden also durch höhere Emissionen an anderer Stelle kompensiert, es findet lediglich eine Verlagerung im EU-Raum statt (vgl. ebenda; interessant auch die FAZ vom 7. März 2014 (www.faz.net) mit dem Blick auf die vor 10 Jahren gelaufene Auseinandersetzung zwischen den Ministern Clement (Wirtschaft) und Trittin (Umwelt), wobei letzterer und damit die Unvernunft die Oberhand behielt). Damit degeneriert das EEG zum reinen Umverteilungsmechanismus, der zudem Innovationen verhindert, wie die von der Bundesregierung eingesetzte Expertenkommission Forschung und Innovation (EFI) zu Beginn des Jahres schlussfolgert (siehe www.e-fi.de auf den Seiten 51-52).

Systemdefekt 2: planwirtschaftlicher Fremdkörper mit eingebauter Ausbreitungstendenz

Das EEG widerspricht im Grunde genommen der Sozialen Marktwirtschaft und dem liberalisierten Strommarkt. Während die Liberalisierung auf einen wettbewerblich organisierten Strommarkt setzt, hebelt das EEG mit seiner stark planwirtschaftlichen Ausrichtung (Bevorzugung einzelner Energieerzeugungsarten, feste Einspeisevergütungen) diesen aus. Fatal wirkt sich die Interventions- (Ludwig von Mises) oder Subventionsspirale aus, die zur Eindämmung unbeabsichtigter Nebenwirkungen immer weitere Korrekturen notwendig macht. Peter Heller umschreibt dies mit dem Dominoeffekt von EEG-Subventionen, der eine Überproduktion von Strom, ebenso wie Industrierabatte, eventuell sogar Kapazitätsmärkte, auf jeden Fall aber Investitionen in den Netzausbau und schließlich auch die finanzielle Entlastung von Haushalten zwangsläufig nach sich zieht und damit massiv weitere Kostentreiber bedingt (beim 16. Albstädter Wirtschaftsforum – www.zak.de).

Systemdefekt 3: in Kauf genommene Ressourcenvernichtung hinterlässt Scherbenhaufen

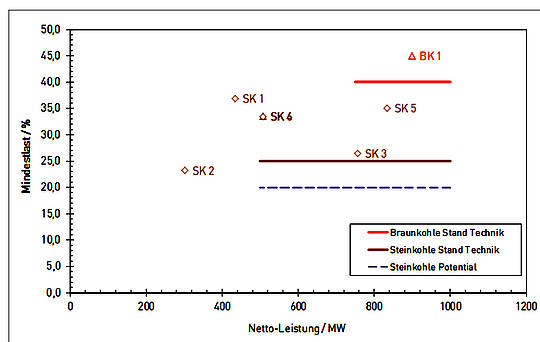

Der im EEG verfügte Einspeisevorrang für Erneuerbare setzt einen simplen Prozess in Gang: Die verringerte Nachfrage nach konventionellem Strom verdrängt entsprechend der Merit-Order (Einsatzreihenfolge von Kraftwerken nach deren kurzfristigen Grenzkosten) Kraftwerke mit höheren variablen Kosten (gleich Grenzkosten) und sorgt dafür, dass Kraftwerke mit vergleichsweise niedrigeren variablen Kosten preissetzend werden. Dies sind zum gegenwärtigen Zeitpunkt vor allem ältere, bereits abgeschriebene Kohlekraftwerke, die zusätzlich von fallenden Rohstoffpreisen profitieren. Dies führt wiederum zunehmend zur vorläufigen oder dauerhaften Stilllegung und sogar zur Nichtinbetriebnahme von hochmodernen Gas- und Dampfturbinen-Kraftwerken, die aber als Produzenten von Regelenergie zur Stabilisierung des Stromnetzes – hier hat die Physik das letzte Wort – dringend gebraucht werden.

Die von der Bundesnetzagentur geführte Liste wird länger und länger. Ihr sind aufgrund einer Ende 2012 beschlossenen Neuregelung Stilllegungen mindestens 12 Monate im Voraus anzukündigen, auch vorläufige Abschaltungen müssen angezeigt werden (aktueller Stand: www.bundesnetzagentur.de). Entsprechende Ankündigungen liegen gegenwärtig von drei der vier großen Energieversorger, ebenso von Stadtwerken vor. Ist ein Kraftwerk „systemrelevant“ kann die Bundesnetzagentur anordnen, dass es zwei Jahre lang weiterbetrieben werden muss. Im Januar hat die EnBW beim Oberlandesgericht Düsseldorf eine Beschwerde eingereicht, mit der sie sich dagegen wehrt, vier Kraftwerksblöcke in Marbach und Walheim nicht abschalten zu dürfen.

Hohe Abschreibungen, Gewinneinbrüche, notwendige Finanzspritzen für Stadtwerke, gravierender Kursverfall bei den vier großen Energieversorgungsunternehmen – RWE, Eon, EnBW und Vattenfall –, Arbeitsplatzverluste inklusive, sind an der Tagesordnung. Auch den so hoffnungsvoll gestarteten Solar- und Windkraftanlagenbauern geht reihenweise die Luft aus. „Die Energiewende wird zum eiskalten Kapitalvernichter“ ist unter Bezugnahme auf eine Liste der Deutschen Schutzvereinigung für Wertpapierbesitz in der Welt vom 6. März d.J. zu lesen. An den 50 größten Börsendebakeln der letzten Jahre in Deutschland partizipiert die Energie-Branche mit rund einem Viertel, obenauf Solar- und Windkraftfirmen (www.welt.de). Hinzu kommt ein schleichender Prozess der De-Industrialisierung, der insbesondere in energieintensiven Branchen bereits empirisch nachweisbar ist, und sich aufgrund der für die deutsche Volkswirtschaft typischen integrierten industriellen Wertschöpfungskette auch belastend auf die restlichen Glieder der Kette auswirkt (siehe hierzu die umfassende Analyse der Deutschen Bank vom 18. Dezember 2013 – www.dbresearch.de, hier S. 11-12). Dort wird auch sehr zu recht darauf hingewiesen, dass für eine Beurteilung der Energiewende die Netto-Effekte entscheidend sind. „Schließlich sind die häufig angeführten positiven Beschäftigungseffekte aufgrund von Investitionen in die Energiewende dadurch zu relativieren, dass sie zu nennenswerten Teilen auf … Subventionen zurückzuführen sind. Man muss sich also stets fragen, welche Beschäftigungseffekte man anderer Stelle mit den eingesetzten Mitteln hätte erzielen können. Da bei den Arbeitsplatzeffekten zudem häufig die Brutto-Effekte ausgewiesen werden, müsste zudem berücksichtigt werden, in welcher Höhe Beschäftigung in anderen Branchen verlorengegangen ist.“ (S. 7).

Nordrhein-Westfalen führt die Riege der stark Gebeutelten an, denn dort laufen die Problemlagen von Energieversorgern und klammen Kommunen unweigerlich zusammen. Die Städte sind in der Regel auch Anteilseigner an z.B. der RWE und/oder haben eigene Stadtwerke, die wiederum Beteiligungen halten. Hinzu kommt, dass NRW am wenigsten von den EEG-induzierten Zahlungsströmen profitiert, da die Fotovoltaik- bzw. Windkraftanlagen relativ stärker im Süden bzw. Norden der Republik massiert sind und der Stromverbrauch im bevölkerungsreichsten Bundesland mit der größten Dichte an Industriebetrieben am höchsten ist. Keinem anderen Bundesland kommt deshalb die Energiewende so „teuer“: 4,5 Mrd. € wurden 2013 in den EEG-Topf gelegt und nur 1,6 Mrd. € wieder „abgegriffen“ (siehe hierzu die ausführliche Analyse des BDEW vom Februar d.J. zur regionalen Verteilung auf den S. 82-92 – www.bdew.de). Nachvollziehbar, aber auch typisch und ganz konform mit der beschriebenen Interventionsspirale ist, dass der NRW-Wirtschaftsminister noch bevor die Bundesregierung die EEG-Novelle unter Dach und Fach hat, weitere Hilfen des Bundes anmahnt (siehe Handelsblatt vom 20.3.2014 www.handelsblatt.com).

Aber selbst im ansonsten gesunden Südwesten brennt es, so musste die Stadt Ulm für eine Kapitalerhöhung der Stadtwerke Ulm/Neu-Ulm, die Beteiligungen an Kohle-, Gas- und Offshore-Windkraftwerken halten, in zwei Schritten 30 Millionen € nachschießen und wird künftig auch Arbeitsplätze abbauen müssen (www.swp.de). Und die Anteilseigner der EnBW – grob je zur Hälfte das Land Baden-Württemberg und die neun Landkreise mit einer Beteiligung an den Oberschwäbischen Elektrizitätswerken (OEW) – müssen sich aufgrund einer Halbierung der EnBW-Ausschüttungen auf magere Jahre einstellen. Ob durch verminderte Ausschüttungen oder Verluste bei den Stadtwerken, alles kommt beim Bürger in Form von Leistungseinschränkungen an, denn im sogenannten Querverbund sorgten Gewinne aus dem Strom schon immer für kommunale Bäder, Verkehrsbetriebe und die Finanzierung weiterer Infrastrukturen. Die nächsten Hilferufe an Land und Bund sind hier schon vorprogrammiert.

Systemdefekt 4: unzureichende internationale Einbindung zwingt Deutschland auf Sonderweg

Sollbruchstellen schützen Systeme vor Überforderung – zumindest in technischen Anwendungen. Die Politik ist im Falle der Energiewende offenbar total überfordert, um von sich aus die richtigen Schlüsse und Konsequenzen zu ziehen. Zu den drei beschriebenen Defekten gesellt sich mit der mangelnden internationalen Einbindung die wohl offensichtlichste Schwachstelle.

Zwar haben 17 von 28 EU-Mitgliedstaaten unserem EEG vergleichbare Anreizsysteme, aber diese sind in ihrer Ausgestaltung und Zeitschiene wesentlich moderater. Österreich beispielsweise deckelt die Subvention auf maximal 27 Mio. € im Jahr, gibt „nur“ eine 13jährige Garantiezeit und wird in 2015 vom Einspeise- auf ein Quotenmodell umstellen. Italien, Spanien, Bulgarien, Griechenland und Tschechien haben schon längst die weit weniger opulente Förderung zurückgeschnitten.

Die Europäische Kommission unternimmt größte Anstrengungen, um zu einem gemeinsamen Energiebinnenmarkt zu kommen. Sie dringt unter anderem darauf, dass Förderregelungen bei sinkenden Technologiekosten schnell angepasst und die Erneuerbaren in den Energiemarkt integriert werden (z. B. durch den Wechsel von Einspeisevergütungen zu -prämien oder -quoten und durch Ausschreibungen) sowie die grenzüberschreitende Zusammenarbeit ausgebaut wird (siehe hierzu den Fortschrittsbericht „Erneuerbare Energien“ 2013, S. 14-15: www.bmwi.de).

Die Effizienzvorteile eines Energiebinnenmarktes zeigt Veit Böckers (Wettbewerbsökonomische Vorteile eines Europäischen Binnenmarktes für Stromerzeugung, in: DICE Policy Brief, September 2013, S. 6-7, hier S. 6) mit einer einfachen Überschlagskalkulation auf: „Würde die heute in Deutschland installierte Solaranlagenkapazität, die im Jahr 2011 18.500 GWh Solarstrom erzeugt hat, stattdessen in Spanien stehen, hätten damit 37.000 GWh Strom produziert werden können. So hätte sich bei einem durchschnittlichen Strompreis von 40 Euro/MWh zusätzlicher Strom im Wert von 740 Millionen Euro erzeugen lassen.“

Als Antwort auf die immer noch stark zersplitterte Förderlandschaft hat die Europäische Kommission Leitlinien entwickelt, denen zufolge die Förderung auf das notwendige Minimum und die Einführungsphase von Technologien beschränkt und letztendlich eingestellt werden soll. Auch soll der in den anderen Mitgliedstaaten erzeugte Strom aus Erneuerbaren Zugang zu nationalen Fördersystemen erhalten (siehe hierzu Moritz Bonn u.a.: „Brüsseler Spitzen“: Europäische Impulse für eine EEG-Reform, in: et Energiewirtschaftliche Tagesfragen, 30. März 2014, S. 1-2 – www.et-energie-online.de).

Gerade die zuletzt genannte Bedingung stellt einen richtigen „Sprengsatz“ dar, der schon im August dieses Jahres detonieren könnte. Beim Europäischen Gerichtshof (EuGH) ist die Klage eines finnischen Windkraftbetreibers anhängig, der Strom nach Schweden liefert, aber dort keine Ökostrom-Förderung bekommt. Generalanwalt Yves Bot fordert in seinem Schlussantrag, solche Ungleichbehandlungen innerhalb von zwei Jahren zu beseitigen. Laut FOCUS und FAZ – aber auch EU-Energiekommissar Günther Oettinger und andere Brüssel-Insider sehen das so – könne das die EEG-Umlage sprengen (www.faz.net). Locker könnte man formulieren, „bis dass der EuGH euch scheidet!“ Ein vergleichbares Verfahren mit Tschechien befindet sich übrigens im Anfangsstadium und hat noch nicht die Gerichtsebene erklommen.

Hinzu kommt das laufende Beihilfeverfahren wegen der sogenannten „Besonderen Ausgleichsregelung“ – so wird der Ausnahmetatbestand für befreite Unternehmen genannt: siehe hierzu Anhang 1 – mit weiteren ungeklärten juristischen Fragen, die allerdings nicht ganz die Brisanz des oben genannten Falles haben.

Offensichtlich ist, dass selbst in der Europäischen Union ein gemeinsamer Energiebinnenmarkt mit Nutzung sämtlicher Effizienzvorteile (d.h. auch des Einsatzes von Fotovoltaik- und Windkraftanlagen an den dafür optimalen Standorten) noch in den Sternen steht und die Unterschiede zwischen den 28 Mitgliedsstaaten so riesig sind, dass der notwendige Anpassungsprozess Jahre in Anspruch nehmen wird, von der technischen Seite mit den erforderlichen Übertragungsnetzen ganz zu schweigen. Und auch der beschlossene Ausstieg aus der Kernenergie wird immer mehr zum nationalen Alleingang. „Der deutsche Weg ist einer von vielen“ titelt die Stuttgarter Zeitung im Bericht über den Weltenergiekongress im südkoreanischen Daegu im Oktober letzten Jahres (www.stuttgarter-zeitung.de). Deutschland gesellt sich 2022 zu den 14 Ländern in Europa, die schon bisher ohne Atomkraft waren, während die Zahl derer weltweit wächst, die neue Kernkraftwerke planen und bauen. Laut der auch insgesamt sehr lesenswerten Energiestudie 2013 der Bundesanstalt für Geowissenschaften und Rohstoffe (BGR) in Hannover waren Ende 2012 68 Kernkraftanlagen in 14 Ländern in Bau und weitere 110 in der Planungs- oder Genehmigungsphase (www.bgr.bund.de. Siehe noch Anhang 2 zum häufig angestellten Vergleich der Kosten von Kernkraft und regenerativer Energie).

Bundeskanzlerin Angela Merkel weiß das: In ihrer Regierungserklärung vom 29. Januar 2014 (S. 4-5) spricht sie von einer Herkulesaufgabe und dass kein vergleichbares Land auf der Welt seine Energiewende so radikal anpacke wie Deutschland. Es lohnt, sich die folgende Textpassage genauer anzuschauen: „Die Welt schaut mit einer Mischung aus Unverständnis und Neugier darauf, ob und wie uns diese Energiewende gelingen wird. Wenn sie uns gelingt, dann wird sie – davon bin ich überzeugt – zu einem weiteren deutschen Exportschlager. Und auch davon bin ich überzeugt: Wenn diese Energiewende einem Land gelingen kann, dann ist das Deutschland.“ So die Kanzlerin. Sie ist also nicht überzeugt, dass uns die Energiewende gelingt und sie sieht realistischer Weise, dass alle anderen noch größere Schwierigkeiten in der Umsetzung haben. Und sie thematisiert nicht den Fall des Misslingens, des Scheiterns: dann sitzen wir Deutsche, neben reichlich Häme und Schadenfreude, auch auf einem wirtschaftlichen Scherbenhaufen. Und danach sieht es aus.

III. VERTEILUNGSEFFEKTE

Durch die Finanzierung über den Strompreis entstehen gravierende Umverteilungseffekte (un)sozialer (von unten nach oben) und regionaler Art, die an anderer Stelle (z.B. in der zitierten BDEW-Studie) ausführlich beschrieben wurden. Es gibt Gewinner und Verlierer, die regelrechten Verteilungskämpfe auf Ebene der Bundesländer und der Interessengruppen (ersichtlich an den Stellungnahmen zur EEG-Novelle, siehe unter VI.) geben ein klares Spiegelbild ab. So unkoordiniert das Vorgehen auf Länderebene in der Umsetzung der Energiewende bislang war, so einig ist man sich bei der Gesprächsrunde im Bundeskanzleramt am 2. April 2014 zum EEG, deren Ergebnis die FAZ tags darauf sauber zusammenfasst: „Verbraucher zahlen für Energie-Kompromiss. Der Bund gibt nach. Die Ökostromhilfen werden nicht so stark gedeckelt. Teurer wird es für Stromkunden und Bahnfahrer.“ Es ging (mit Ausnahme von NRW) nur um reine Besitzstandswahrung, bei der die Ministerpräsidentinnen und -präsidenten das große Ganze aus dem Blick verloren haben. Dabei sind die Größenordnungen um die es geht, auch im Vergleich zu anderen Ausgabeblöcken beachtlich: Das Volumen der EEG-Umlage mit 24 Mrd. € in diesem Jahr ist rund dreimal so groß wie der viel gescholtene Länderfinanzausgleich (8,5 Mrd. € in 2013) oder die Rundfunkgebühr (7,5 Mrd. € in 2012), auch der Solidaritätszuschlag liegt mit 15 Mrd. € immer noch kräftig darunter.

Nicht zu unterschätzen auch die Interessenlage des Bundesfinanzministers am EEG. Solange er die Energiewende nicht über den Bundeshaushalt finanzieren muss, verdient er daran mit. Da die Mehrwertsteuer auch auf die EEG-Umlagen erhoben wird, stecken rd. 4 Mrd. € im gesamten Umsatzsteueraufkommen in Höhe von 204 Mrd. € drin (die Energiesteuer mit 39 Mrd., Stromsteuer mit 7 Mrd. und Kernbrennstoffsteuer mit 1,3 Mrd. € werden davon unabhängig erhoben – Schätzungen für 2014 –www.bundesfinanzministerium.de). Müsste er umgekehrt die 24 Mrd. € selbst finanzieren, dann wäre das nach den Bundesministerien für Arbeit und Soziales mit 122 Mrd. und für Verteidigung mit 33 Mrd. sowie der Bundesschuld mit 30 Mrd. € der viertgrößte Haushaltsposten und würde etwa acht Prozent seines gegenwärtigen Gesamthaushalts in Höhe von 299 Mrd. € ausmachen (www.bundesfinanzministerium.de). Sicherlich gäbe es dabei im Parlament lange und harte Diskussionen, da bei anderen Budgets eingespart werden müsste.

IV. INTENTION VERSUS WIRKUNG: CO2-VERMEIDUNG FEHLANZEIGE

Ein Ziel der Energiewende ist, wie erwähnt, die anthropogen verursachten Emissionen des Gases CO2 zu verringern. Aus der Parallelität von Emissionshandel und EEG – Systemdefekt 1 – war aber eine Verminderung nicht zu erwarten. Dass nun darüber hinaus ein Anstieg von CO2 zu beobachten ist, resultiert aus dem beim Systemdefekt 3 beschriebenen Wirkungszusammenhang (siehe hierzu wiederum dbresearch, S. 11, auch zu Überlegungen, inwieweit ggf. die CO2-Emissionen bei einem Rückgang der Energiekosten infolge einer geringeren inländischen Wertschöpfung sinken könnten).

V. (ZWISCHEN)FAZIT

Welche Auswirkungen hat die gegenwärtige Energiewende auf unsere Volkswirtschaft: Schafft oder sichert sie Arbeitsplätze, regt sie zu Innovationen an, verbessert sie unsere Wettbewerbsfähigkeit? Ist der über das EEG in Gang gesetzte Umbau unseres gewachsenen Energieversorgungssystems überhaupt mit den physikalischen Gesetzmäßigkeiten (fehlende Speicherfähigkeit von Strom; Notwendigkeit konstanter Frequenz im Netz) in Einklang zu bringen? Sind die sich daraus ergebenden finanziellen Lasten und Belohnungen, sprich Kosten und Gewinne ausgewogen verteilt? Ist die deutsche Energiewende in Bezug auf die gewünschte Verringerung der CO2-Emissionen zielführend und besitzt sie eine solch überzeugende „Ausstrahlung“, dass mehr und mehr andere Länder nachfolgen?

Zusammenfassend betrachtet sind alle aufgeworfenen Fragen mit einem klaren Nein zu beantworten. Nach diesem eindeutigen, ernüchterndem Diktum kann man zu guter Letzt auch noch die eigentliche Sinnfrage stellen und diskutieren: ob der Klimawandel menschengemacht und überhaupt beeinflussbar ist? Die Antwort bleibt in dem einen wie anderen Falle spekulativ.

Marco Wehr hat sich (im FAZ-Feuilleton vom 7. Januar d.J. unter dem Titel “Kompetenzillusion” – www.faz.net) mit der Prognosefähigkeit und Güte wissenschaftlicher Berater, insbesondere auch von Klimatologen, auseinandergesetzt und es als reines “Orakelgekrakel” qualifiziert, das “… man guten Gewissens als unseriös bezeichnen …” kann. Dies bestätigen wunderbar die hilflosen Erklärungsversuche für die Stagnation der Erwärmung, die David Whitehouse aktuell zusammengetragen hat (Warming interruptus – Causes für the pause – www.thegwpf.org). Dem kann sich auch der am 31. März vorgestellte neueste Bericht des Weltklimarates (IPCC) nicht gänzlich entziehen. Von der Signalwirkung her nicht zu unterschätzen ist die unter Protest erfolgte Niederlegung des Mandats ausgerechnet durch einen Niederländer, Richard Tol, der nach eigenem Bekunden genug hat von Schwarzmalerei und übertrieben alarmistischen Szenarien. Tol – führender Klimaökonom und koordinierender Leitautor für das Kapitel über die wirtschaftlichen Auswirkungen – „ … vertritt die Position, dass die ökonomischen Auswirkungen des Klimawandels eher gering sind. Außerdem sei es weniger teuer, eine Strategie der Anpassung an den Klimawandel zu wählen, statt ihn durch drastische CO2-Reduktion verhindern zu wollen.“ (www.faz.net). Der jährliche Bericht der Weltorganisation für Meteorologie (WMO) – einer anderen UN-Organisation – hingegen widersteht (noch) nicht der alarmistischen Versuchung und kaschiert den Umstand, „ … dass es seit über 15 Jahren nicht mehr wärmer wird … “ auch indem die entsprechende Presseerklärung den „ … Begriff Stillstand (Hiatus) nicht einmal erwähnt.“ (Rudolf Kipp in www.science-skeptical.de).

VI. KURIEREN AN SYMPTOMEN UNTER ZEITDRUCK – DIE GABRIELSCHE EEG-NOVELLE

An dem Entwurf zur Novellierung des EEG wird mit Hochdruck gefeilt. Er „besticht“ durch zunächst 90 Paragraphen und, nachdem das Ergebnis der Verhandlungen mit EU-Wettbewerbskommissar Almunia zur „Besonderen Ausgleichsregelung“ (den Industrieausnahmen) eingearbeitet ist, im zweiten Entwurf vom 31. März 2014 mit 99 Paragraphen und vier Anhängen. Der Vorläufer war zur Regelung der Materie noch mit 66 Paragraphen, bei allerdings fünf Anhängen ausgekommen. Ein nie dagewesener Zeitdruck begleitet das Machwerk und ebenfalls einzigartig ist, dass ein Grüner als beamteter Staatssekretär in einer schwarz-roten Bundesregierung die Feder führen darf. Rainer Baake kennt zumindest die Materie, hat er doch selbst als Staatssekretär unter Bundesumweltminister Trittin im Jahre 2000 das EEG mit entwickelt. Im Handelsblatt vom 13. März d.J. wird er unter der Überschrift „Gabriels Problem-Grüner“ als einer der Väter des Atomausstieg und eben des EEG eingeordnet. Nicht nur das Gesetz selbst, auch die Stellungnahmen der Verbände sind mit heißer Nadel gestrickt. Bis zum Abgabetermin für den ersten Entwurf am 12. März sind 152 Stellungsnahmen und bis zum Abgabetermin für den überarbeiteten Entwurf am 2. April, 17.00 Uhr, nochmals weitere 97 eingegangen, die wiederum bis zur Kabinettssitzung nächste Woche (am 8., so das Ministerium, oder 9. April, so die Kanzlerin in ihrer Regierungserklärung) eingearbeitet sein müssen. Pauschalierend lässt sich sagen, dass die Stellungnahmen umso länger sind, als es Positionen oder Pfründe zur verteidigen galt, und dass es zwischenzeitlich eine sehr vielfältige Lobbyarbeit und aktive Lobbyisten-Szene im Bereich der erneuerbaren Energien gibt (Link zu den Entwürfen und Stellungnahmen zur EEG-Reform – www.bmwi.de).

Interessanterweise wird im Vorblatt zum Gesetzesentwurf bei der kategorischen Abfrage zu den Alternativen vermerkt, dass es keine gebe. Auch bezüglich der Frage nach dem Erfüllungsaufwand für Bürger, Wirtschaft und Verwaltung wird tiefgestapelt bzw. darauf verwiesen, dass dieser noch zu berechnen sei und im Laufe des Gesetzgebungsverfahrens nachgeliefert werde. Hier darf man gespannt sein, was vom Nationalen Normenkontrollrat – dem Wächter über eine bessere Rechtsetzung und angemessenen Erfüllungsaufwand – noch verlautbart werden wird (www.normenkontrollrat.bund.de).

Eine abschließende inhaltliche Beurteilung ist angesichts der kurzen Fristen und der Fortschreibung des Gesetzesentwurfs enorm schwer bis fast unmöglich. Auffällig ist, dass es auch von der Zeitschiene her eher zaghafte Ansätze sind, die Erneuerbaren im Zubau zu begrenzen und an den Markt heranzuführen. Dies trifft auch für die Direktvermarkungspflicht für die Betreiber größerer Anlagen zu, eine zunächst vorgesehene Beteiligung der Eigenstromerzeuger scheint hingegen wieder vom Tisch zu sein. Überlegungen in Richtung Kapazitätsmärkte waren von vorneherein nicht im Entwurf enthalten. Viel Raum im Rahmen der zweiten Anhörungsrunde nimmt das Pro und Kontra bei der „Besonderen Ausgleichsregelung“ ein. Während beispielsweise die IG Metall für die weitest gehende Beibehaltung der Industrieausnahmen im Rahmen einer europarechtskonformen Ausgestaltung plädiert, setzt sich Greenpeace für eine deutlich kürze Liste der zu befreienden Unternehmen ein. Die neuerliche, vier Seiten lange Stellungnahme von Greenpeace enthält auch eine Rüge für die eingeräumte Bearbeitungszeit von lediglich 34 Stunden sowie ein schon der ersten Stellungnahme beigefügtes, nun aktualisiertes „Kurzgutachten“ einer Hamburger Anwaltskanzlei mit ganzen 24 Seiten.

VII. AUSSTIEGSGEDANKEN

Es ist höchste Zeit, sich intensiver mit den Möglichkeiten eines verträglichen Ausstiegs aus der EEG-Geschichte zu befassen. Umso mehr als mit an Sicherheit grenzender Wahrscheinlichkeit vorherzusagen ist, dass dieses nun entstehende Gesetz die beschriebenen Systemdefekte nicht abschütteln und auch wegen seiner Komplexität und den sicher enthaltenen handwerklichen Fehlern nie und nimmer funktionieren kann. Hinzu kommt als „Damoklesschwert“ das im August zu erwartende Urteil des EuGH, das allerdings wie berichtet eine zweijährige Übergangsfrist einräumt.

Bislang existieren nur vereinzelte Überlegungen, unter anderem von Klaus Töpfer, der mit einem „Altlasten-Fonds“ die aufgelaufenen finanziellen Verpflichtungen aus dem EEG auffangen möchte (www.zfk.de). Auch Ilse Aigner hat schon einmal den „Versuchsballon“ Steuerfinanzierung aufsteigen lassen, musste allerdings zusehen, wie er ganz schnell zum Platzen gebracht wurde.

Jan Fleischhauer hat in einer Kolumne zum „Wahnwitz mit System“ folgenden Gedanken zu Papier gebracht:

„Wie immer, wenn Politiker merken, dass sie sich verrechnet haben, versuchen sie, die Spuren zu verwischen. Die einfachste Art, sich aus der Verantwortung zu stehlen, ist die Verschleierung der Kosten durch Ausgliederung in einen Schattenhaushalt. Für die Aufnahme von Schulden ist noch nie ein Politiker abgewählt worden. … Wenn der Preis für die Erneuerbaren nicht mehr auf der Stromrechnung auftaucht, vergisst der Bürger vielleicht, welchen Bären man ihm aufgebunden hat, als man ihm Wind und Sonne als preiswerte Alternativen verkaufte. Im normalen Geschäftsleben sind solche Deals aus gutem Grund verboten. Aber dort landet man ja bei vorsätzlicher Täuschung auch vor Gericht.“ (www.spiegel.de).

VIII. GEISTERFAHRT UND WENDEWIRKLICHKEIT – DIE POLITIK MUSS FARBE BEKENNEN!

Die Anekdote vom auf dem Kopf liegenden Streifenwagen umschreibt trefflich die Lage:

„Anfang der achtziger Jahre stellte eine Militärstreife im Bereich des Grazer Korps ihren Streifenwagen wortwörtlich auf den Kopf. Sie waren schlicht und einfach zu schnell gefahren. Um den Vorfall zu verschleiern, meldete der Streifenkommandant über Funk an seine vorgesetzte Dienststelle, er könne seinen Auftrag nicht weiter durchführen, da sein Blaulicht ausgefallen sei. Die Kommandostelle funkte zurück: Glühbirne auswechseln! Jetzt hieß es Farbe bekennen. Kleinlaut kam es aus dem Äther zurück: Wir können die Glühbirne nicht auswechseln. Das Fahrzeug liegt drauf.“

An unsere Bundestagsabgeordneten und diejenigen, die gegenwärtig in den Ministerien an der EEG-Novelle basteln gerichtet: Wer das kennt und weiß, macht sich nach meinem Verständnis der Untreue und des Betrugs durch Unterlassung schuldig: Im juristischen Sinne, aber vor allem auch moralisch im Hinblick auf den Eid, den Abgeordnete wie Beamte auf die Verfassung der Bundesrepublik Deutschland ablegen. Lassen Sie sich nicht weiter hinters Licht führen! Das EEG gehört ganz einfach abgeschafft!

Anhang 1:

Die begünstige Strommenge im Rahmen der “Besonderen Ausgleichsregelung” hat sich in den Jahren 2011 – 2012 – 2013 wie folgt entwickelt: von 85 über 86 auf 96 Terawattstunden, dabei wuchs die Anzahl der befreiten Unternehmen von 603 über 734 auf 1720 (infolge der EEG-Novelle 2012). Bei einem Gesamtvolumen der EEG-Umlage dieser Jahre in Höhe von 13,2 – 17,0 – 20,4 Mrd. € macht die Befreiung 2,2 – 2,5 – 4,0 Mrd. € aus. Interessant ist noch, dass zum Anstieg der EEG-Umlage in 2014 (um 0,96 ct/kWh) auf 6,24 ct/kWh, die Befreiung mit 0,14 ct/kWh beiträgt, das sind 15% (nachzulesen in der Antwort der Bundesregierung vom 27.12.2013 auf die Kleine Anfrage der Abgeordneten Bärbel Höhn und der Fraktion BÜNDNIS 90/DIE GRÜNEN – Drucksache 18/165).

Anhang 2:

In einer Publikation aus dem Jahre 2011 (www.kernenergie.de) ist zum Thema „Kostenvergleich“ auf S. 468 zu lesen:

„Die Kernkraftwerke, die heute Strom erzeugen, haben nie Subventionen erhalten.

Dies haben verschiedene Bundesregierungen, zuletzt die Regierung Schröder/Fischer, unmissverständlich erklärt. Eingesetzte FuE-Mittel der öffentlichen Hand waren als Anschubfinanzierung gedacht und haben dort, wo die einzelnen Technologien sich entfalten konnten, ihren Zweck überzeugend erfüllt. Andere Energieträger, wie beispielsweise regenerative Energien, erhielten und erhalten weiterhin Unterstützungsmittel, allerdings nach einem anderen Förderkonzept. Sie werden überwiegend unmittelbar vom Stromkunden aufgrund gesetzlicher Vorgaben unterstützt, ohne dass das Ziel wirtschaftlicher Stromerzeugung entscheidend näher rückt.“

Und zum Rückbau der Kernkraftwerke ist zu lesen:

„Ebenso falsch ist die Aussage in Politik und Medien, der Rückbau der Kernkraftwerke und ihre Entsorgung würden aus Steuermitteln bezahlt. Richtig ist, dass diese Kosten heute bereits im Strompreis enthalten sind. Der notwendige Aufwand für die Stilllegung der Kernkraftwerke wird in den Bilanzen zurückgestellt. Er wird angespart über 25 Jahre; die Mittel stehen also bereits jetzt nahezu vollständig zur Verfügung. Jährliche Anpassungen tragen Preissteigerungen und neuen regulatorischen Vorgaben Rechnung. Die notwendigen Kosten der Endlagerung, darunter aktuell die Umrüstung des Endlagers Konrad und die Erkundung des Salzstocks Gorleben auf seine Eignung als Endlager, werden im laufenden Jahr vom Bund vorfinanziert und unmittelbar danach den Abfallverursachern aus Industrie und öffentlicher Hand in Rechnung gestellt. Einzelheiten dazu regelt die Endlagervorausleistungs-Verordnung. Die späteren Kosten des Betriebs und der Stilllegung der Endlager sind und werden weiter bedarfsgerecht zurückgestellt. Auch die auf 2,5 Mrd. € begrenzte Deckungsvorsorge für Schäden aus der Kernenergie-Nutzung kann nicht als Subvention gelten. Die Haftungssumme bis 250 Mio. € wird zunächst über den Versicherungsmarkt gedeckt und darüber hinaus bis 2,5 Mrd. € über den, auch im Ausland üblichen Nuklearversicherungspool der betroffenen Unternehmen auf Gegenseitigkeit. Außerdem haften die jeweiligen Unternehmen aber mit ihrem ganzen Vermögen für Schäden, die diese Grenze überschreiten. Würde eine solche Forderung nach einer unbegrenzten Haftung auch an andere risikoträchtige Industrien gerichtet, so wäre deren Wettbewerbsfähigkeit im internationalen Bereich massiv eingeschränkt.“

PS.: Thomas Linnemann, der Mitautor der o.g. Publikation ist nicht identisch mit dem Albstädter Stadtwerkedirektor.

Über den Autor:

Dr. Jürgen Gneveckow ist ein deutscher Politiker der CDU und seit 1999 Oberbürgermeister der Stadt Albstadt. Nach dem Studium der Betriebs- und Volkswirtschaftslehre in Freiburg und Regensburg, Abschluss Diplom-Kaufmann und Diplom-Volkswirt promovierte er in Regensburg, arbeitete bis 1999 im Bundesumweltministerium und war von 1993 bis 1996 als Nationaler Experte zur Generaldirektion „Umwelt“ der Europäischen Kommission in Brüssel abgeordnet

Der Beitrag erschien am 4.April 2014 bei ScienceSceptical hier