In den Teilen 1 + 2 des Faktenchecks habe ich mich ausführlich mit den kontroversen Aussagen der Teilnehmer der ersten 13:46 und dann folgenden 21:27 Minuten beschäftigt. Um jedermann den Vergleich zwischen den gesagten Statements und Bestätigung oder Widerlegung der Behauptungen auf einfachste Weise sowie objektiv und fair zu ermöglichen, hat EIKE sich die Mühe gemacht und den gesamten gesprochenen Text mit Untertiteln samt Zeitmarken zum schnellen Auffinden (und damit zu überprüfen) der in Frage kommenden Stelle zu hinterlegen. Diese Prinzip wird auch hier im dritten Teil fortgesetzt. Der Fairness halber wird allen Teilnehmern dazu noch die Möglichkeit angeboten, ihre Sicht der Dinge hier darzustellen.

Tonmitschnitt ab Minute 13:46 der Podiumsdiskussion am 22.6.15 in den Räumen der Bundeszentrale für politische Bildung. Der Tonmitschnitt kann zum einfacheren Vergleich der unten zitierten Aussagen deutsch untertitelt werden. Hier wird der Teil ab Minute 21:28 behamdelt.

Bisher hat nur der Teilnehmer H.J. Fell indirekt diese Möglichkeit genutzt, indem er mir per Mail vom 12.7.15 mitteilte dass er sich nicht äußern wolle weil ich „… mit Falschinterpretationen, Faktenverdrehungen und Aussagenverdrehungen arbeitet und gar noch den unseriösen Versuch unternimmt, eine Nichtantwort als Akzeptanz zu missinterpretierten.“ Das sei unseriös etc. etc.

In ähnlicher Weise der pauschalen Diffamierung von sachlich neutralen Anfragen vieler Leser an ihn direkt, beantwortete er deren Fragen. Die Leser mögen sich daher selbst ein Urteil bilden, sowohl über die Kompetenz der Herrn Fell als auch seine Art auf höfliche Fragen mit Belegen über seine eindeutige Falschaussagen umzugehen.

Faktencheck Teil 3

Der oben gezeigte Mitschnitt fängt wieder bei 0:00 min, schließt aber nahtlos an das Ende des hier gezeigten Teilmitschnittes an.

Im Folgenden werden ausgewählte– weil kontroverse- Statements ab Minute 21:28 behandelt.

H.J. Fell ab Minute (0:20:27)

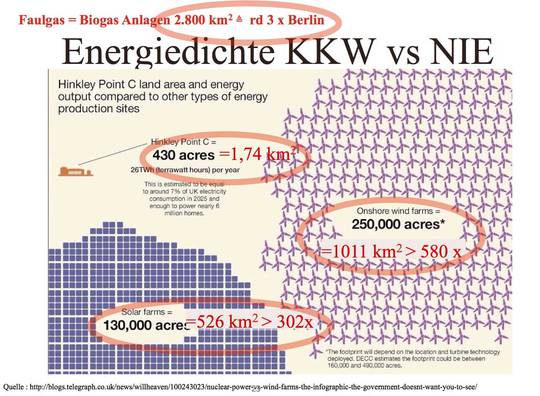

Hier äußert er sich zum Erfolg der „Erneuerbaren“ in China (Meine Stellungnahme dazu ab Minute 0:02:43 hier, das braucht hier nicht wiederholt zu werden) und anderswo, um zu begründen, dass Deutschlands Aufwand zur Förderung der Nachhaltig Instabilen Energien(NIE) weit mehr brächte als die 4/1000 ° C weniger Erwärmung bei Reduktion der CO2 Emissionen um 85 % bis 2050.

(0:21:06) Fell: Deswegen haben sie in die Erneuerbaren investiert und deswegen ist auch der Einfluss einer deutschen Industrie und Entwicklung wesentlich größer als der minimale Einfluss über die eigenen CO2-Emissionen.

Fakt ist,

dass 1. Herr Fell damit bestätigt, dass eigene Klimawirkung des deutschen CO2 Senkungsprogrammes, noch kleiner als mikroskopisch klein ist, und nur über die erhoffte Verstärkung bei der Verwendung „deutscher“ Technologien dieser größer würde.

Fakt ist aber auch, dass auch diese Hoffnung trügt, denn wie z.B. Björn Lomborg, ein ebenso überzeugter Anhänger der Treibhaushypothese, aber auch Kritiker, der aus seiner Sicht völlig verfehlten Klimapolitik, in der FAZ vom 8.Mai 2015 richtig feststellte[1]:

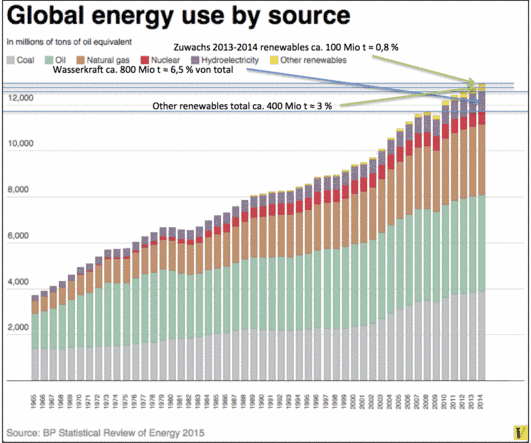

„Im optimistischen, „grünen“ IEA-Szenario werden Solar- und Windenergie in 40 Jahren bloß 2,2 Prozent der weltweiten Energieversorgung ausmachen. Trotz der in unserer Kultur allgegenwärtigen Auffassung, dass Solar- und Windenergie kurz davor seien, den Klimawandel aufzuhalten, wissen sogar Schwarzseher wie der Klimaberater von Al Gore, Jim Hansen, dass dies nicht der Fall ist:

„Wer glaubt, dass wir uns in den Vereinigten Staaten, in China, Indien oder auf der ganzen Welt dank erneuerbarer Energien kurzfristig von fossilen Brennstoffen verabschieden können, der glaubt auch an den Osterhasen und an die Zahnfee.“

..Die einfache unbequeme Wahrheit lautet, dass Solar- und Windenergie noch nicht ausgereift sind: Sie sind zu teuer und benötigen teure Reserven, wenn der Wind nicht bläst oder die Sonne nicht scheint….

…Makroökonomische Modelle weisen zudem darauf hin, dass der wirtschaftliche Verlust durch Erneuerbare wesentlich größer sein könnte als einfach nur deren Mehrkosten, da erhöhte Produktionskosten alle anderen Branchen schwächen und das Wachstum drosseln. Der Durchschnitt aller großen Modelle deutet darauf hin, dass die derzeitige Klimapolitik Deutschland bis 2020 jährlich 43 Milliarden Euro kostet….

… In den vergangenen 30 Jahren hat China durch die Nutzung billiger, wenn auch umweltschädlicher Kohle 680 Millionen Menschen aus der Armut befreit. Von China zu verlangen, diesen Prozess durch unausgereifte teure erneuerbare Energien zu verlangsamen, wird wohl nicht gelingen. Im Hinblick auf 800 Millionen in extremer Armut lebender Menschen in Indien und Afrika ist es Wunschdenken, von diesen Ländern ein Umsteigen auf Erneuerbare zu erwarten.“

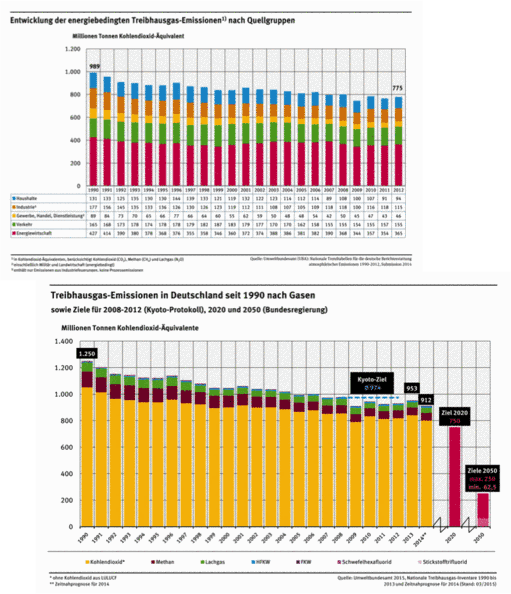

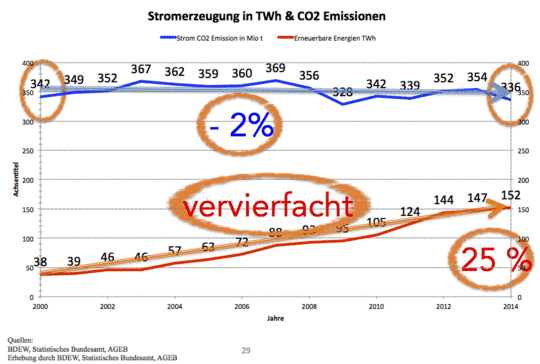

Dem ist eigentlich nichts hinzufügen, abgesehen von der weiteren wesentlichen Einschränkung, dass in den 15 Jahren des Wirkens des Fell´schen EEG´s zwar Unsummen für die Erzeugung dieser NIE ausgegeben wurden, deren Anteil an der Stromproduktion dadurch zwar auf 27 % stieg, aber nicht zu einer Minderung des CO2 Ausstoßes der Kraftwerke bei der Stromproduktion führte. Deren Emissionen lagen per 2014 lediglich um 2 % unter denen des Jahres 2000, und damit für jeden eindeutig erkennbar unterhalb jeder Signifikanzschwelle.

0:21:27 Frau Dr. Zink fragte: Wie hoch liegen denn die Kosten für die Energiewende?

Kommentar:

Eigentlich kann man diese Frage als erledigt abhaken, denn sie wurde schon ausführlich im Teil 2 beantwortet. Doch interessant ist, wie insbesondere Frau Dehmer und Herr Fell, versuchten die offensichtlich extremen Kosten durch „Mathematisieren“ [2] geringer erscheinen zu lassen als sie es in Wirklichkeit sind.

Während der zunächst angesprochene Herr Brabeck mit etwas wirren Äußerungen die Zulässigkeit der Frage bestritt, und behauptete unsere Volkswirtschaft sei ja (bisher) in der Lage diese Kosten zu „stemmen“, dabei aber die bereits bestehende und sich schnell ausbreitende „Energiearmut“ (ca. 1 Mio Haushalte können bereits jetzt ihre Stromrechnung nicht mehr bezahlen) zunächst nicht kannte, aber dann meinte, die solle man möglichst vermeiden, durfte ich im Anschluss auch zu dieser Frage Stellung nehmen.

0:23:56 Frau Dr. Zink fragte: Ja, Herr Limburg: wie beurteilen sie eine Kosten der Energiewende?

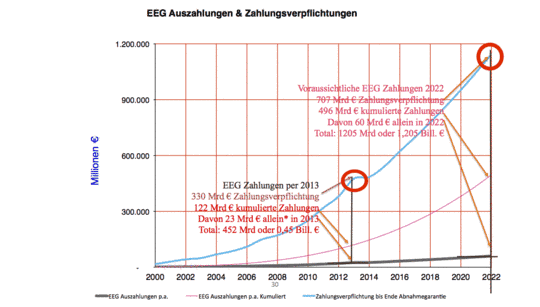

Meine Antwort lautete zusammengefasst, dass wir bis zum Jahre 2013 und nur für das EEG bereits rd. 122 Mrd € bezahlt hätten und noch 330 Mrd € zu zahlen haben. Und wir würden bis 2022 bereits die 1,2 Billionen € Grenze überschreiten und, bis zum Jahre 2050, irgendwo bei 7 bis 9 Billionen € landen. Bei einem Gegenwert der gleich Null ist.

Wie setzen sich die z.B. 7 Billionen € zusammen? Sinngemäß übernommen wird der folgende Text aus diesem Beitrag „Die deutsche Energiewende – das Billionen-Grab“ [3]

Quelle hier

Allein die zusätzlichen Stromkosten, die das Erneuerbare-Energien-Gesetz (EEG) verursacht, lassen sich mit mindestens 2 Billionen € veranschlagen. Die zusätzlichen Kosten für das Stromnetz mit weiteren Trassen müssen auf 1 bis 1,5 Billionen € veranschlagt werden.

Die Energiesparverordnung (EnEV) führt einer Kostenbelastung von rund 3 Billionen €. Hinzukommt: Mit zu hohen Stromkosten verlieren Betriebe an Wettbewerbsfähigkeit. Zwingt das, wie es schon geschieht, zu Schließungen oder zu Verlagerungen ins Ausland, gehen Arbeitsplätze dauerhaft verloren. Die Kosten, die sich daraus ergeben, sind noch nicht bezifferbar, aber es werden, viele weitere Milliarden sein. Hinzukommt auch, dass mit immer mehr Windkraft- und Fotovoltaikanlagen die Gefahr für die Netzstabilität noch größer wird als schon bisher. Denn der Strom mit Wind und Sonne ist höchst unzuverlässig, ist „Flatterstrom“. Netzzusammenbrüche führen zu flächendeckenden Stromausfällen. Auch diese Kosten lassen sich vorher schwer berechnen. In die Milliarden werden auch sie gehen.

Und, da diese 7 Billionen € Mindestschätzungen sind, kann man erwarten, dass auch die 9 Billionen-Grenze erreicht oder sogar überschritten wird.

Auf keinen Fall darf übersehen werden, dass Investitionen in „Erneuerbare“ eine zusätzlich Infrastruktur schaffen, zusätzlich zur bereits bestehenden! Und nur durch deren gesicherte Zwangsabnahme, dank der gesetzlichen Vorrangeinspeisung, haben diese überhaupt Abnehmer, bzw. einen Markt

Und darauf versuchte Frau Dehmer konträr einzugehen, als sie feststellte

(0:27:05) Frau Dehmer

Weil, das sind natürlich völlig alberne Zahlen!

Wenn Sie sich wenn sie sich mal ernsthaft überlegen was eine Billion bedeuten würde oder lassen Sie es 2 Billionen sein, bezogen auf 35 Jahre zum Aufbau einer Infrastruktur, die ohnehin erneuert werden musste, Es ist ja nicht so, dass wir ne Infrastruktur haben die so topfit war und so brandneu, dass man da gar nichts hätte tun müssen. Man hätte in das Energiesystem auf jeden Fall investieren müssen.

Viele haben es ja auch getan. Dann ist das keine wahnsinnig große Zahl mehr, wenn sie das mal runterbrechen auf das was es dann für den Strompreis heißt, das ist mal das eine… dass sie natürlich völlig ignorieren, das wir das Stromsystem davor unter Monopol-Marktbedingungen, als es noch staatliche Unternehmen gab, aufgebaut haben. Auch das war von uns allen jederzeit subventioniert und die Zahl, die ist genauso atemberaubend, wie die, die sie jetzt gerade auf den Tisch gelegt haben.

Hiermit stellte Frau Dehmer vier Behauptungen auf, dass

1. die Energiewende (denn darauf bezog sich die Frage) nur 1 bis 2 Billionen € kosten würde

2. die Infrastruktur der Stromerzeugung ohnehin zu erneuern wäre, weil nicht „topfit“ und „brandneu“ sei, im Grunde also – meine Interpretation- ziemlich „marode“

3. dass die Kosten für die Erneuerung dann .. keine wahnsinnig große Zahl mehr seien, besonders wenn man sie auf den Strompreis herunterbreche..

4. Die bisherige Infrastruktur Investitionen verlangt hätte, mit einer ...Zahl, die ist genauso atemberaubend die, die Sie jetzt gerade auf den Tisch gelegt haben. Oder vielleicht sogar noch atemberaubender

Fakt ist jedoch: Alle diese Behauptungen sind falsch!

Zu 1: Kosten der Energiewende:

Wie oben gezeigt, wenn die Energiewende, die das EEG und seine Folgelasten enthält, aber auch den Netzaufbau, die Energie-Einsparverordnung, und viele andere Lasten zur gewaltsamen Senkung der CO2 Emissionen verlangt, bis zum bitteren Ende durchgeführt wird, dann werden wir ziemlich sicher irgendwo zwischen 7 und 9 Billionen € landen.

Zu 2. Modernität

Deutschland verfügte bis vor kurzem über die modernsten und zuverlässigsten Stromerzeugungs- und Verteilkapazitäten der Welt. Die Ausfallsicherheit von 1/10×10^6 war bisher weltweit Spitze.

Das weltweit modernste Kraftwerk (GuD) mit einem Gesamtwirkungsgrad von > 60 % wurde in 2011 in Irrsching in Betrieb genommen. Inzwischen wurde es mangels Auslastung stillgelegt. Daher kann von einem Nicht-Topfit oder gar „marode“ – bzw. Investitionsstau keine Rede sein.

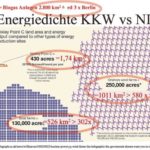

Zu 3 und 4. Erneuerungskosten

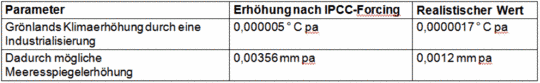

Doch gesetzt den Fall, Frau Dehmer würde richtig damit liegen, dass der gesamte Kraftwerkspark in Deutschland erneuert werden müsste, was würde das zu heutigen Preisen kosten[4]?

Die Kraftwerksplaner rechnen mit rd 1 Mio € pro MW installierter Leistung[5] oder 1 Mrd €/GW. In Deutschland sind aktuell (konventionelle wie Kern-) Kraftwerke mit 97.000 MW oder 97 GW Leistung installiert. Bei den angenommenen Kosten von 1 Mrd €/GW ergibt das ein Investitionsvolumen von 97 Mrd €, oder 0,097 Billionen €.

Das sind noch nicht einmal 10 % der Summe, die Frau Dehmer für den bisherigen Kraftwerkspark angibt.

Rechnet man mit einer Abschreibung von 30 Jahren, dann müssen Jahr für Jahr für neue Kraftwerke für rd. 3,2 Mrd € investiert werden. Und auch das sind nur wenige Prozent der Summen die zusätzlich in „Erneuerbare“ investiert, besser, verbrannt werden. Denn weder Wind noch Sonne liefern dann sicher Strom, wenn er gebraucht wird, also müssen konventionelle Kraftwerke zusätzlich vorgehalten werden, was die Kosten weiter steigert, denn denen steht kein Gewinn gegenüber.

Natürlich ist auch der bisherige Netzausbau zu berücksichtigen. Es handelt sich dabei um einige zehntausend km Hoch- und Höchstspannungsleitungen, viele zehntausend km Mittelspannungsleitungen und wenige Mio km Niederspannungsleitungen. Dazu kommen noch einige hundert Umspannwerke. Diese sind bisher optimal von den wenigen ( < 700) Kraftwerken, die nahe den großen Verbrauchszentren errichtet wurden, zu den Millionen Verbrauchern übers Land gespannt worden.

Sie unterliegen natürlich einem Verschleiß, der, weil es so gut wie kaum bewegte Teile gibt, mit Wartungs- und Erneuerungskosten von unter 1 % der Investitionssumme erledigt werden kann.

Auch dieses ökonomisch optimale Modell kehrt die Energiewende um, indem sie es erzwingt Millionen von Kleinerzeugern (bisher ca. 25.000 WKA und >1,4 Mio PVA Anlagen und x Biomasse KW) mit unterschiedlichsten Leistungsprofilen anzuschließen, ohne das bisherige Netz zu ersetzen zu können. Auch der Aufbau dieser zusätzlichen Leitungen ist ausschließlich den NIE geschuldet, die kein Mensch braucht.

Damit zeigt sich erneut, welche abenteuerliche Vergleiche in der Öffentlichkeit gezogen werden können, ohne das sich auch nur einer unter den anwesenden „Experten“ (weder Herr Brabeck, noch Frau Zink, vom verblendet-gläubigen Herrn Fell gar nicht zu reden) es für angebracht hielt einzugreifen.

Als Paradebeispiel dazu nochmals Frau Zink, die sagte

(0:31:19) Sind es denn überhaupt die erneuerbaren Energien, die bei der Energiewende wirklich so kostenexplosionsartig sind, weil, ich hab da mal Rechnungen mir angeschaut da sind die gar nicht so groß?

Welche Rechnungen sie da angeschaut hatte, sagte sie zwar nicht, aber sie lieferte damit bewusst eine Steilvorlage für Herrn Fell, der den Spieß versuchte umzudrehen, indem er dem alten Sprichwort nacheiferte in dem der Dieb versucht von sich abzulenken indem er „haltet den Dieb“ ruft.

Fell: 0:31:31

Nein, sie sind es nicht!

…Insofern sind die erneuerbaren Energien die Preissenker!

…und verwies dann auf das ominöse Diskussionspapier der FAU in Erlangen, die versuchten mittels abenteuerlicher Annahmen nachzuweisen, dass wir ohne die „Erneuerbaren“ (NIE) 11 Mrd. € jährlich mehr für unsere Stromrechnungen zu bezahlen gehabt hätten. Dazu haben wir hier und auch hier bereits ausführlich Stellung genommen. Hinzufügen wäre nur noch die Feststellung, dass, wie in Abb. 6 Teil 2 der Podiumsdiskussion dargestellt, die CO2 Emissionen fossiler Kraftwerke praktisch ungebremst weiter laufen, von einer Brennstoffeinsparung nichts, aber auch gar nichts zu sehen ist. Es ist also reines Wunschdenken, bei dem die schnöde Realität nur stört.

0:33:02 Fell weiter zum Atom-Endlager

Sie haben völlig zu recht erwähnt (gemeint ist Frau Dr. Zink) , kein Mensch weiß heute, was die Atommüll-Entsorgung kostet. Wir haben hier einen offenen Flug begonnen, ohne Landung zu haben und niemand weiß es! Nur eines ist klar wenn es noch mehr Atommüll gibt, dann wird es mit Sicherheit noch ein paar viele Billionen Euro teurer

Fakt ist.

Was Herr Fell –geübt in jahrzehntelanger Praxis der politischen Diskussion – völlig unterließ zu erwähnen, war, dass es die Grünen mit ihren Hilfstruppen der Kernkraftgegner waren, die im Jahr 2001 durchsetzten, dass die Endlagerforschung für 10 Jahre verboten wurde. „Moratorium“ wurde dieser einmalige Grundgesetzverstoß gegen die Freiheit der Wissenschaft, genannt.

Wohlwissend, dass damit die Wunde „kein Endlager“ immer offen gehalten werden konnte. Das fast vollständig, für rd. 2 Mrd € ausgeforschte, hervorragend geeignete Endlager Gorleben, wird inzwischen aufgegeben und „ergebnisneutral“ neu gesucht. Dabei wird so getan als ob ein neuer Standort gesucht wird. Insofern haben die Grünen danke ihrer Angstkampagnen dafür gesorgt, dass dem höchst erfolgreichen Flug (um bei der Metapher von H.J. Fell zu bleiben) der Kernenergienutzung den Deutschland mit den sichersten KKW der Welt -international führend- begonnen hatte, plötzlich kein Landeplatz mehr zur Verfügung stand. Eine zynischere Verdrehung der Tatsachen bekam man selten zu Gehör.

Anschließend drehte sich die Diskussion um das politische sog. 2 ° Ziel. Da hier auf diesem Blog und auch woanders schon soviel zu diesem Humbug gesagt und geschrieben wurde, will ich nicht ausführlicher darauf eingehen.

Nur eines noch:

Am Minute 0:35:30 führte ich aus, dass die Welternährung heute, dank der erhöhten CO2 Konzentration in der Atmosphäre viel besser sei als früher. Ich erwähnte, dass die Ernten von C3 Gräsern (umfasst häufig genutzte Getreidesorten) um etwa 11 % gestiegen sei. Doch da habe ich mich in der Zahl geirrt.

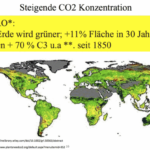

Tatsache ist, dass die Ernten von C3 Gräsern, dank des CO2 um ca. 70 % gestiegen sind. Um 11 % wuchs allein in den letzten 30 Jahren die Fläche auf der Erde die grüner wurde. Siehe Abb 1

Abbildung 1: Bild der ergrünenden Erde mit farbig gekennzeichneten Flächen bei denen eine Vegetationsveränderung über die letzten 30 Jahre stattgefunden hat. Bilanz: Deren Fläche ist heute um 11 % größer als zuvor.

und wieder fühlte sich die Moderatorin aufgerufen für Herrn Fell die Stichwortgeberin zu spielen, indem sie fragte

(0:37:47) Herr Fell Sie haben ja in ihrem Buch „Globale Abkühlung“ gehen sie sogar noch weiter und sagen, dass reicht überhaupt nicht aus, das Zwei Grad-Ziel! Eigentlich muss man ja sagen in der Tendenz, ..aber in der Tendenz ist es ja so; wir müssten eigentlich sowieso Richtung Abkühlung geben,.. Sie sagen jetzt, es ist eigentlich besser, wenn wir von der globalen Abkühlung sprechen und das als Ziel setzen. Können Sie uns das mal erklären bitte!

Herr Fell nahm den Ball gerne wieder auf und äußerte sich umfassend über die „jetzt schon“ spürbaren Auswirkungen der Welt-Erwärmung. Dabei verschwieg er den nunmehr fast zwanzigjährigen Stillstand der Erwärmung, stattdessen vereinnahmte er alle Wetterkatastrophen der jüngeren Vergangenheit mit „Massen Toten… mit Vernichtung von Immobilien“, und führte beispielhafte den Wirbelsturm auf den Philippinen mit rd. 7000 Toten an.

Als Kronzeugen führte er dazu die Münchner Rück an, die „die uns akribisch genau, jedes Jahr vorrechnet, wie hoch die Schadensbilanz infolge der Welterwärmung ist..,“ Und nannte auch „ die Klimaforscher, (die) zu Recht immer gewarnt haben. Diese Wetterextreme werden zunehmen und sie sind da. (assistierender Zwischenruf von Frau Zink:…Stärkere Regenfälle, stärkere Stürme..) stärkere Stürm,e Wüstenausbreitungen, nichts anderes.“ Um dann abzuschließen mit den Worten (0:39:13):

Fakt ist, dass die Schadensbilanz jetzt schon, bei Null Komma 8 Grad Celsius Welt-Erwärmung zu hoch und untragbar für diese Menschheit ist. Und das wir deswegen Wege suchen müssten.. dass wir deswegen Wege suchen müssten die Welterwärmung eben nicht weiter anwachsen zu lassen bis 2 Grad oder, um Himmels Willen noch mehr hinaus, sondern, dass wir Wege finden müssen, sie zu stoppen.

Das stoppen stellte er sich als massenhafte Verbreitung sog. Nullemissionstechnologien vor, weil die 400 ppmv CO2 in der Atmosphäre schon jetzt viel zu viel seien.

Kommentar:

Fell zeigt hier wieder das typische Verhalten von Politikern, die den Wählern schmerzhaften Verzicht schmackhaft machen wollen, indem sie Nichthandeln als eine viel, viel größere Gefahr – und beim Klima geht es immer gleich um die ganze Welt- darstellen. In diesem Fall muss die irreführende ( Anm. des Autors: leider kann ich hier kein weniger kräftiges Wort verwenden, weil die hier gebrachten Behauptungen von Herr Fell wirklich nur irreführend waren) Argumentationsweise des Herrn Fell, über die schrecklichen Wetterextreme herhalten, obwohl jeder der lesen und schreiben und vielleicht noch rechnen gelernt hat, weiß, dass Wetterextreme schon immer auftraten, schon immer als große Unglücke empfunden wurden, gegen deren Wirkung man sich evtl. schützen, deren Entstehen aber nicht verhindert werden kann. Auf jeden Fall aber sind und bleiben es Wetterereignisse

In seinen späteren Ausführungen bot Herr Fell dann an, gern „wissenschaftlich“ (0:41:27) über sein Buch diskutieren zu wollen. Ein Angebot, das er jedoch sobald sich eine ernsthafte Gelegenheit dazu bot, z.B. mit EIKE Lesern, die ihm Emails mit klaren Fragen und Belegen sandten, über ihre und seine Methoden zu diskutieren, entrüstet zurücknahm.

Wissenschaftlich wäre hingegen auch hier gewesen, wenn er nachgewiesen hätte, dass sich die derzeitige Extremwetterentwicklung in irgendeiner Weise signifikant (um mal wieder ein Modewort aus der Statistik zu verwenden) und vor allem negativ von der früheren unterscheidet. Da dem nicht so ist , wie selbst das IPCC zugeben musste und wie sämtliche neutralen Meteorologen unablässig wiederholen, beschränkte sich Herr Fell, und hier muss man wohl leider sagen bewusst, auf die Irreführung des Publikums.

Leider assistiert von der voreingenommenen Moderatorin, die einmal mehr die gebotene Neutralität verletzte und zudem ihre Hausaufgaben nicht gemacht hatte. Sie hätte sonst wissen müssen, dass es weder weltweit noch in Deutschland eine Zunahme vom Extremwetterereignissen gibt.

Fakt ist..

weder das IPCC noch der DWD, noch die beiden zuarbeitenden Klimainstitute – mit einer Ausnahme, dem chronisch alarmistischen PIK- geben an, dass sie eine Zunahme, weder an Zahl noch an Intensität z.B. an Wirbelstürmen, Tornados noch sonst was, gefunden hätten.

Abbildung 2 Zitatesammlung aus dem letzte IPCC Bericht zur Situation der Extremwetterentwicklung. Eine vollständige Quellenangaben dazu finden Sie im Anhang.

Und das weder in der Vergangenheit, noch in den Klimamodellen. Dazu Meteorologe Jochem Marotzke: „In unserem Computermodell brauen sich weder mehr Stürme noch stärkere Stürme über uns zusammen“ (Jochem Marotzke, Direktor MPI HH, in DER SPIEGEL, 7.5.2007, Abschied vom Weltuntergang, S.145)..

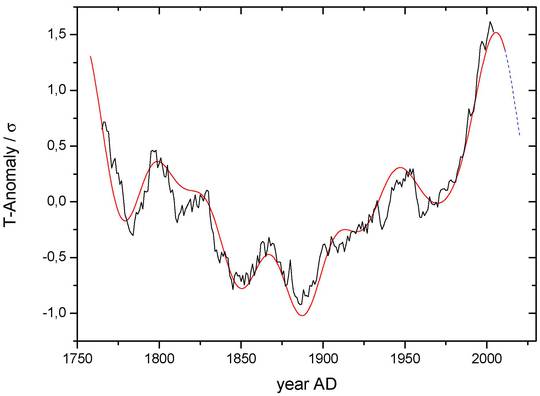

Es mag sein, dass inzwischen die Modelle so getrimmt wurden, dass sie den gewünschten Weltuntergang zeigen, doch wie fast immer bei den Klimamodellen folgt die Wirklichkeit ihnen nicht. S. Abb 2 und Abb3.

Abbildung 3 Diagramm der Extremwetterentwicklung nach Angaben der von Herr Fell zitierten Münchner Rück zu großen Wetterkatastrophenentwicklung. Tendenz rückläufig, sowie Erklärungen der Swiss Re für diese Situation.

Und vom Münchner Rück „Klimapapst“ Prof. Dr. Höppe – dessen Haus von Herrn Fell als akribisch notierende „Kronzeugin“ angeführt wurde- ist zu lesen.

„Dass das Ausmaß der Katastrophen immer drastischer wird, ist eindeutig zu erklären: Die Bevölkerung ist gewachsen, zudem sind die betroffenen Sachwerte höher als früher“ (FTD 20.08.2010, S 13) .. um wenig später hinzuzufügen

„Hauptgrund für die markant steigenden Schadenssummen durch Natirkatastrophen in den sozioökomischen Bedingungen (Wertkonzentration und Besiedlung exponierter Regionen, Bevölkerungszunahme, höhere Schadenanfäligkeit) zu suchen ist“

0:40:11. H.J. Fell behauptet

da ja die Welt-Temperatur – das wissen wir seit langen Zeitrahmen über Millionen von Jahren hinweg dem CO2-Gehalt zeitverzögert folgt, müssen wir auch, müssen wir auch dafür Sorge tragen, dass der Kohlendioxidgehalt in der Atmosphäre reduziert wird.

Kommentar:

Eine derartig absurde Ursache-Wirkungsbeziehung, ist eine reine Erfindung des H.J. Fell. Und wird wissenschaftlich durch nichts und niemanden gestützt. Im Teil 1 bin ich ausführlicher darauf eingegangen. Es sieht eher nach der alt bewährten Methode aus, erstmal das Gegenteil von dem zu behaupten was wahr ist, um die Zuhörer zu verblüffen.

Abbildung 4 : Temperatur- und CO2 Verlauf aus Eisbohrkernmessungen nach petit et al 1999. Zusätzlich eingezeichnet die höher aufgelöste Zeitspanne von vor rd. 20.000 bis 40.000 Jahren. Deutlich ist der Nachlauf der CO2 Konzentration zu erkennen.Grafik J. Herold

Fakt ist:

Niemals in der Vergangenheit hat CO2 die Globaltemperatur gesteuert. Dafür gibt es keinerlei Anhaltspunkte, und auch keine Beobachtungen. Doch das Gegenteil ist richtig. Ändert sich die globale Mitteltemperatur dann ändert sich – mit gehörigem zeitlichen Nachlauf von im Mittel 800 Jahren- auch der CO2 Gehalt der Atmosphäre. Das zeigen die Eisbohrkerndaten ganz deutlich.

Und der Prozess dafür ist auch gut bekannt. Wärmeres Wasser kann weniger Kohlensäure binden, als kaltes Wasser. Wird Wasser wärmer gast CO2 aus, wird es kälter, wirkt es als CO2 Senke und nimmt CO2 auf. Immerhin bedecken die Ozeane rd. 70 % der Erdoberfläche, dies ist ein gewaltiger Speicher in dem etwa 50 bis 70 x mehr CO2 als in der Atmosphäre gebunden ist.

CO2 muss abgesenkt werden

Ab Minute 0:41:37 führt H.J.Fell aus, warum er den CO2 Gehalt der Atmosphäre auf den vorindustriellen Wert von 280 ppm senken will und liefert dafür wieder eine Begründung die dem Faktencheck nicht standhält:

Er sagte:

Aber eines ist klar, dies ist die entscheidende Aufgabe der Menschheit. Zu gucken wie wir wieder auf das CO 2 -Gehalt des vorindustriellen Niveau kommen, denn das war die Grundlage für 20 tausend Jahre ähnlich gleichbleibendes Klima auf der Erde. Wo sich erst… wo sich erst die Hochkulturen der Menschheit entwickeln konnten.

Fakt ist

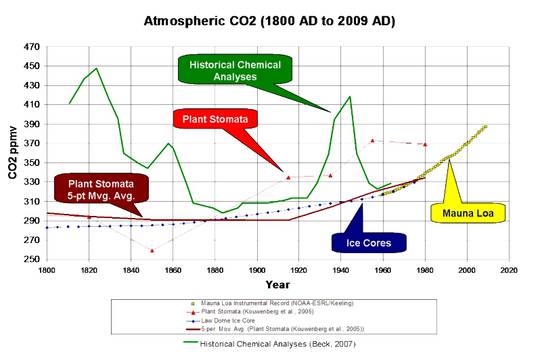

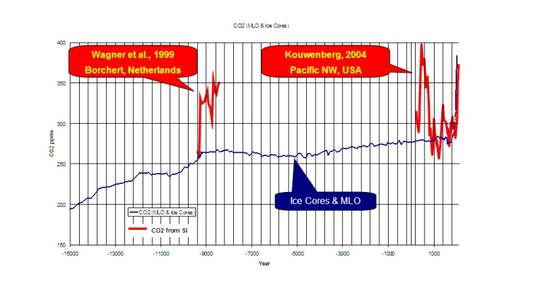

1. dass der CO2 Gehalt der Atmosphäre zumindest wissenschaftlich umstritten ist, wie ich im Teil 2 (Hier) ausführlicher erläuterte.

Und aber viel wichtiger

2. dass sich die Hochkulturen der Menschheit alle bei warmen bis sehr warmen Temperaturen – oft deutlich höher als heute – etablierten.

Abbildung 4 Holozäne Optima und Pessima (nur Temperaturen) im wesentlichen der nördlichen Hemisphäre. Ebenso ist die Zeit der römischen Hochkultur eingezeichnet. Dies trifft ebenfalls für die frühere ägyptische Hochkultur zu. Sie waren ausnahmslos zu Warmzeiten möglich. Literaturangaben zur Abbildung vgl. unter Dansgaard & Johnsen (1969) und Schönwiese (1995). Man beachte dass die Schwankungsbreite rd 3 K betrug. Die Grafik wurde von David Archibald aus den genannten Quellen erstellt. Weitere Infos: „Klima- u. Vegetationsgeschichte SO-Europas sowie des östl. Mittelmeerraums“.

Dann folgten noch Meinungsäußerungen zum möglichen „Erfolg“ der kommenden UNO Klimakonferenz in Paris Anfang Dezember des Jahres. Insbesondere Frau Dehmer begründete umfangreich, sowohl die ihrer Meinung nach bestehende Notwendigkeit, dass die Konferenz zu einem Erfolg würde, als auch die veränderten Rahmenbedinungen, die sich seit der Konferenz von Kopenhagen im Winter 2009 ergeben hätten.

Soweit, so Meinung!

Eine subjektive Schlussbetrachtung

Wie gezeigt werden konnte sind die meisten Behauptungen der anderen Teilnehmer zum Klimawandel, zur Energiewende – insbesondere deren Kosten- falsch oder in Einzelfällen bestenfalls halbwahr (z.B. Chinas CO2 Emissionen und NIE Investitionen). Aber sie klingen für den Laien in fast allen Fällen plausibel. Und werden deshalb gern geglaubt.

Die Frage, die mich daher am meisten beschäftigt ist: Warum sagen diese Leute das? Die einfachste Erklärung wäre: In der Politik muss gelogen werden und wird gelogen. Frei nach Jean-Claude Juncker: „Wenn es ernst wird, dann muss man lügen“. Und ernst ist es mit den gewünschten politischen Folgen dieser Ideologie. Doch das meine Podiumskollegen wissentlich und willentlich gelogen haben, glaube ich nicht.

Ich glaube vielmehr, dass sie der festen Überzeugung waren und sind, wahre, weil oft schlüssige oder wenigstens plausible, Argumente gebracht zu haben. Trotzdem waren viele von ihnen vielleicht schlüssig, aber trotzdem einfach falsch. Eine Erklärung liegt sicherlich in der mangelhaften Kompetenz der Teilnehmer, zu der sich wenigstens Herr Brabeck des öfteren bekannte.

Eine weitere Erklärung – besonders bei Herrn Fell- ist m.M.n. nicht unbedingt eine zu geringe Kompetenz in naturwissenschaftlicher Hinsicht – wenn auch seine herablassenden Äußerungen zu manchen Beiträgen und Überprüfung seiner eigenen deutlich zeigen, dass er sich und sein Wissen deutlich überschätzt, sondern die nach eigenem Bekunden existierende reale Angst, dass die Welt – ohne Gegenmaßnahmen- einem Hitzetod entgegen geht.

Und diese Angst verleitet dazu, alle Pro & Contra-Argumente und Fakten nur sehr selektiv aufzunehmen. Also ist (letztendlich gewollte) Unwissenheit die Quelle der Angst, die wiederum das Motiv für seine Aktionen liefert. Das Angebot von einigen Lesern diese Unwissenheit per wissenschaftlich fairer Diskussion wenigstens eine wenig zu vermindern, wurde von ihm bisher aber nicht angenommen.

Eine weitere Erklärung wäre auch, weil z.B. Frau Dehmer der Konferenz in Paris während der Podiumsdiskussion (0:29:00) und in der anschließenden Diskussion deswegen viel Erfolg wünschte, weil wir (sprich der reiche Westen, von dem sie ein nutznießender Teil ist) den armen Länder etwas weggenommen hätte, was es nun aus Gerechtigkeitsgründen auszugleichen gälte.

Diese tiefsitzende Wut über vermeintlich reale oder eingebildete Ungerechtigkeit auf der Welt, scheint mir der eigentliche Motor, das treibende Motiv vieler Anhänger der Treibhaushypothese zu sein.

Doch letztendlich verbirgt sich dahinter nur die übliche sozialistische Litanei, ja man auch sagen, das sozialistische Glaubensbekenntnis. Weil die Mär von der herannahenden menschgemachten Klimakatastrophe die geeignete Erzählung ist, um endlich das sozialistische Paradies zu schaffen. Es heißt jetzt nur anders.

Viele hochrangige IPCC Vertreter, vom Schmuddelerotiker und Ex Chairman Pachauri angefangen, über die Millionärstochter Christiana Figueres, Vorsitzende des UNFCC oder des IPCC Vizepräsidenten und Ex Jesuiten Otmar Edenhofer, um nur einige zu nennen, wie auch die neue Enzyklika des Papstes – entstanden unter tatkräftiger Mithilfe von PIK Chef Schellnhuber, verfolgen mit Inbrunst dieses Ziel

Das darf niemanden verwundern, weil es oft genug öffentlich festgestellt wurde. Die folgenden Originalzitate belegen dies eindeutig:

Rajendra Pachauri IPCC Chef in Nature vom 19.12.2007:

Wir waren so trunken mit unserem Wunsch, immer mehr und mehr zu produzieren und zu konsumieren, egal welche Auswirkungen auf die Umwelt das hat, dass wir uns auf einem völlig unhaltbaren Weg befinden“, sagt er. „Ich werde mich nicht zurücklehnen, bis ich in jedem möglichen Forum die Notwendigkeit zum Ausdruck gebracht habe, dass wir grundlegende strukturelle Änderungen hinsichtlich des wirtschaftlichen Wachstums und der Entwicklung vornehmen müssen. Das ist es, worum es wirklich geht. Die Klimaänderung ist lediglich ein Teil davon.

Otmar Edenhofer NZZ vom 14.11.2010 erklärt im Interview ganz deutlich was von seiten der UNO und der sie unterstützenden Kreise eigentlich angestrebt wird:

„Zunächst mal haben wir Industrieländer die Atmosphäre der Weltgemeinschaft quasi enteignet. Aber man muss klar sagen: Wir verteilen durch die Klimapolitik de facto das Weltvermögen um. Dass die Besitzer von Kohle und Öl davon nicht begeistert sind, liegt auf der Hand. Man muss sich von der Illusion freimachen, dass internationale Klimapolitik Umweltpolitik ist. Das hat mit Umweltpolitik, mit Problemen wie Waldsterben oder Ozonloch, fast nichts mehr zu tun.“

U.N.FCC Präsidenting Christiana Figueres speaks during an interview at the World Economic Forum in Davos, Switzerland, on Jan. 22, 2014

„This is the first time in the history of mankind that we are setting ourselves the task of intentionally, within a defined period of time, to change the economic development model that has been reigning for at least 150 years, since the Industrial Revolution,“ she said. „This is probably the most difficult task we have ever given ourselves, which is to intentionally transform the economic development model for the first time in human history.“

Damit ist ganz offenkundig, dass über die (bisher erfolgreiche) Panikmache mit der menschgemachten Klimakatastrophe, von den Haupt-Beteiligten eine ganz andere Agenda betrieben wird. Nämlich die, den Sozialismus über einen dritten (Um-)Weg doch noch einzuführen. Aufgeschrieben hat das auch der „Wissenschaftliche Beirat Globale Umwelt (WBGU)“ der Bundesregierung in seiner Broschüre zur großen Transformation: „Die Welt im Wandel“, welches zur besseren Beeinflussung von Kindern und Jugendlichen sogar als Comic vorliegt.

Axel Reichmuth von der Zürcher Weltwoche formulierte diesen Sachverhalt so:

„Hoffen auf die Apokalypse“ :

„Sicher ist, daß diejenigen Kräfte, die politisch mit dem Klimawandel agieren, ihre apokalyptischen Szenarien mit Zähnen und Klauen verteidigen werden … Sie haben sich in eine Zwangssituation hineinmanövriert:

Die Warnungen vor dem Klimawandel sind jetzt ein politisches Erfolgsrezept … Sollte der Klimawandel als Bedrohung wegfallen, fiele das politische Konzept von Links-Grün in sich zusammen wie ein Kartenhaus … Insofern ist der Streit um die Wahrheit beim Klimawandel die Mutter aller Ökoschlachten. Die Klimaschützer kämpfen nicht nur gegen die Erderwärmung, sondern auch um ihre politische Existenz.

[1] WELTWOCHE Zürich, 47/2010, S.54-55, Alex Reichmuth, Die Mutter aller Ökoschlachten

Daher muss und soll unsere Regierung die Frage beantworten, welches Mandat und welches Motiv sie hat, unser Land, unser Europa, diesen Leuten auf dem silbernen Tablett zu servieren. Auf eine Antwort dürfen wir gespannt sein.

[1] Quelle: Frankfurter Allgemeine Zeitung, 8. Mai 2015: Die Ordnung der Wirtschaft; Björn Lomborg „Deutschlands gescheiterte Klimapolitik“

[2] Ein Begriff aus der Psychologie des Verkaufens. In dem man den ursprünglich großen Wert auf kleine und kleinste Bezugsgrößen herunterbricht, erreicht man, das er im Bewusstsein des Gegenübers wesentlich kleiner erscheint als der in der Realität ist.

[3] Die deutsche Energiewende – das Billionen-Grab hier weitere Details dazu hier

[4] Ich habe bei dieser Rechnung zur Vereinfachung bewusst auf Abzinsung und Inflation etc. verzichtet. Vielleicht mag der eine oder andere Leser dies nachtragen

[5] In Wikipedia (hier) findet man für Kohlekraftwerke die Angabe von 798 €/kW, jedoch für 2003. Inzwischen, so steht da, seien diese Kosten wesentlich gestiegen. Am Beispiel Herne, so wird geschrieben, seien diese Kosten auf 2133 €/kW gestiegen. Verschwiegen wird jedoch, dass diese Kostensteigerungen fast ausschließlich dem organisierten Missbrauch der Raumplanungsordnung durch fanatisierte Kohlegegner zu verdanken ist. Die Gerichte folgen diesem Missbrauch häufig. Jedoch nicht immer, denn

Das neueste Braunkohlenkraftwerk von RWE (BoA 2&3), welches 2012 in den Probebetrieb gegangen war und im November 2013 die Sorge dafür getragen hatte, dass das bundesdeutsche Stromnetz nicht abgeschmiert ist, hat eine installierte Brutto-Engpassleistung von 2.200 MW (= 2 Blöcke zu je 1.100 MW). Die Baukosten betrugen knapp 2,6 Milliarden Euro. Das sind knapp 1,2 Mio €/MW. Dasselbe gilt für das KW in Niederaussem mit ca. 1 Milliarde Euro für 1.000 MW.

Related Files