La Niña und das Bundesverfassungsgericht – von Fritz Vahrenholt

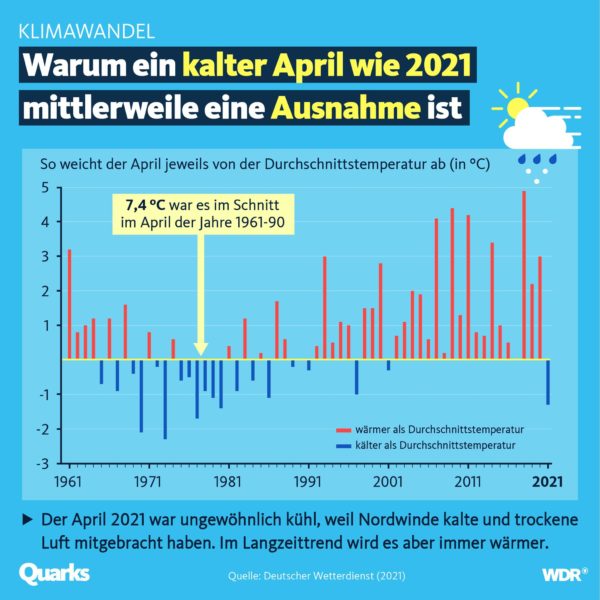

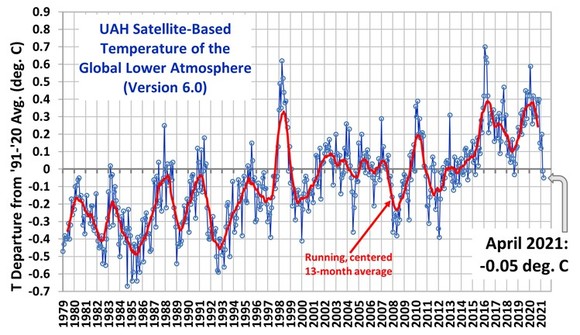

Globale Temperaturkurve im kalten April 2021

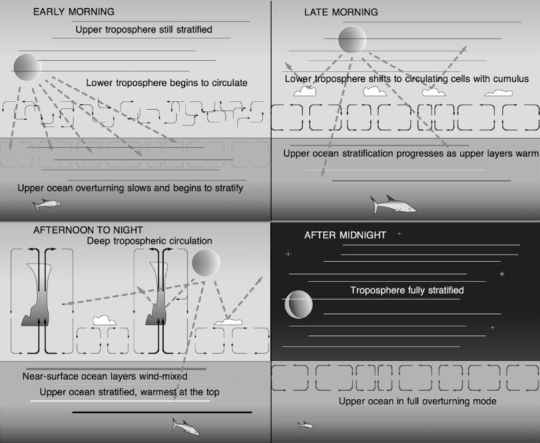

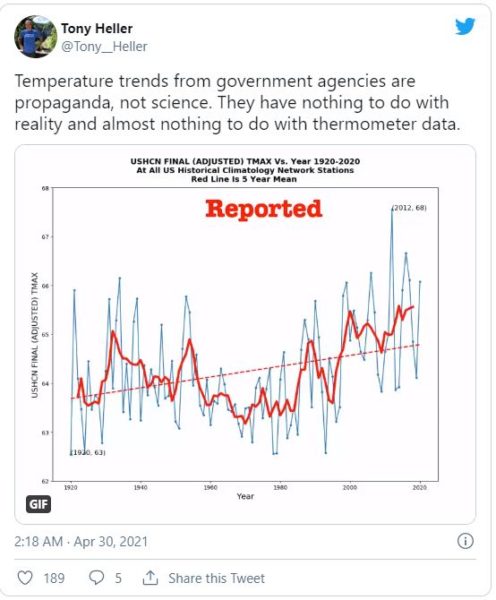

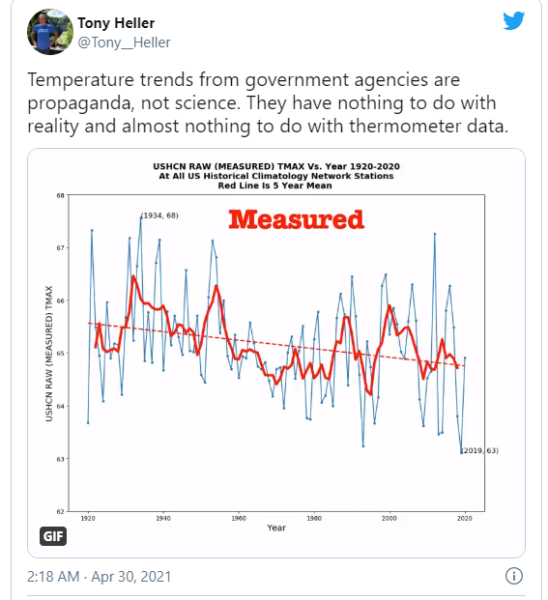

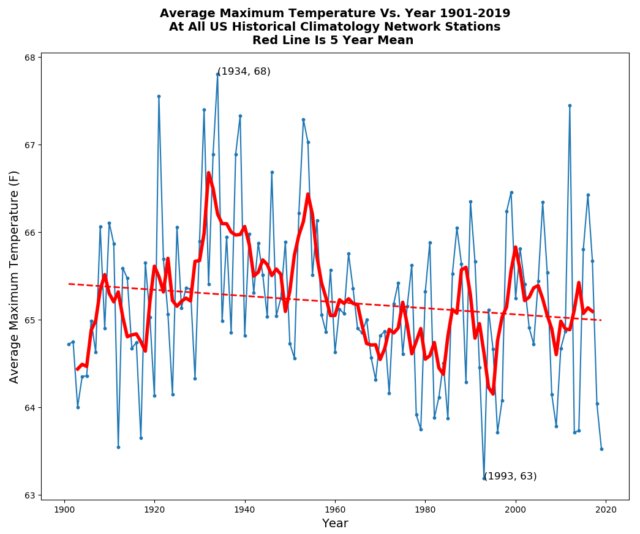

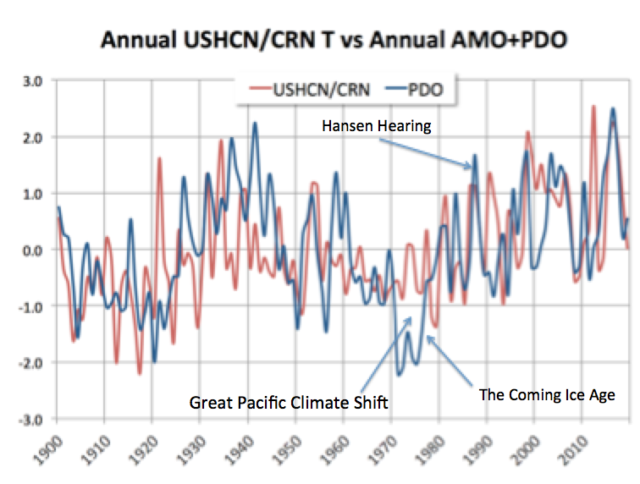

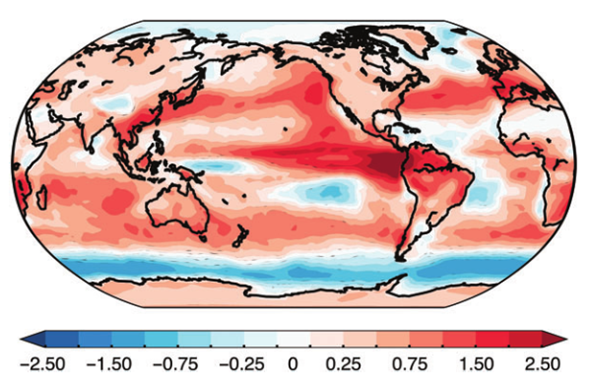

Die Abweichung der globalen Mitteltemperatur der satellitengestützten Messungen vom Durchschnitt der Jahre 1991 – 2020 ging im April 2021 weiter auf – 0,05 Grad Celsius zurück. Noch wirkt sich die kühle La Niña-Situation der letzten Monate aus. Laut der US- amerikanischen Wetter- und Ozeanografiebehörde NOAA wird La Niña mit 80%iger Wahrscheinlichkeit von Mai bis Juli beendet sein. Allerdings erwartet die Behörde im Herbst den Wiederbeginn einer neuen La Niña.

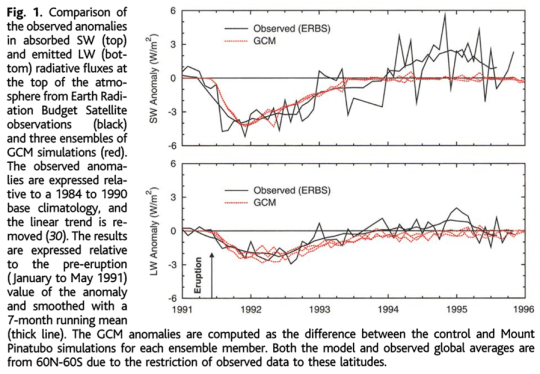

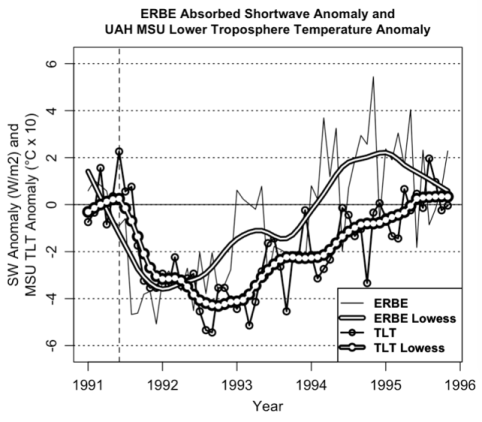

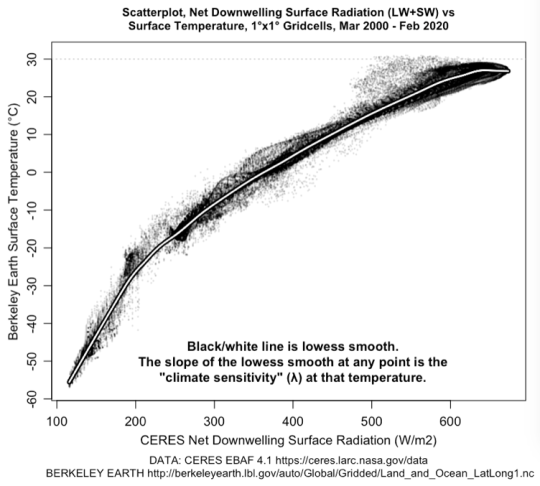

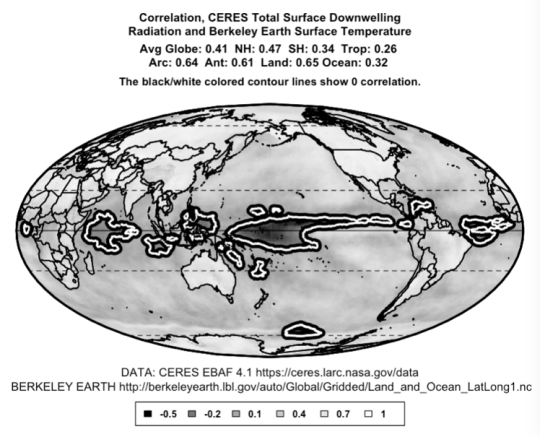

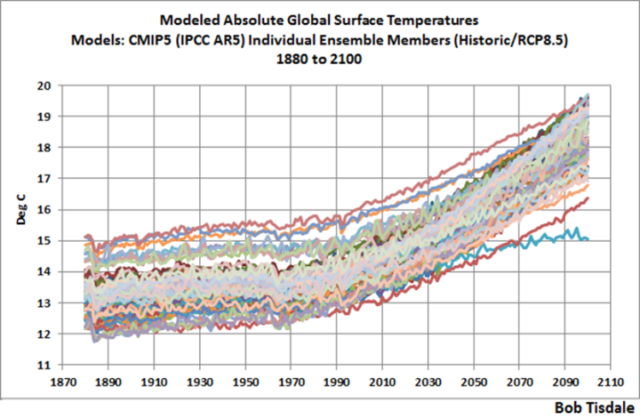

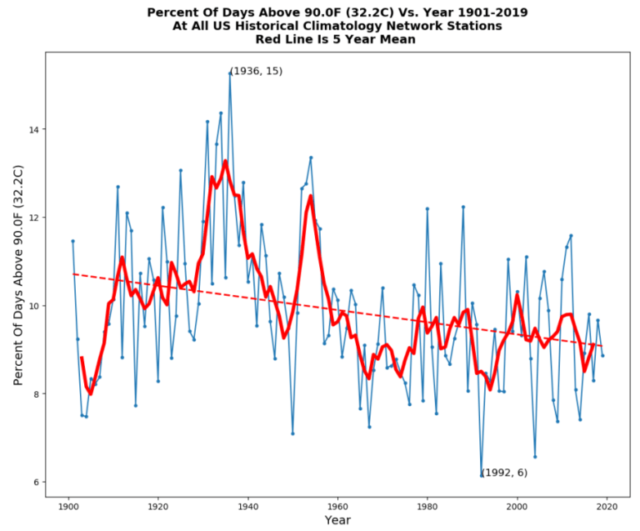

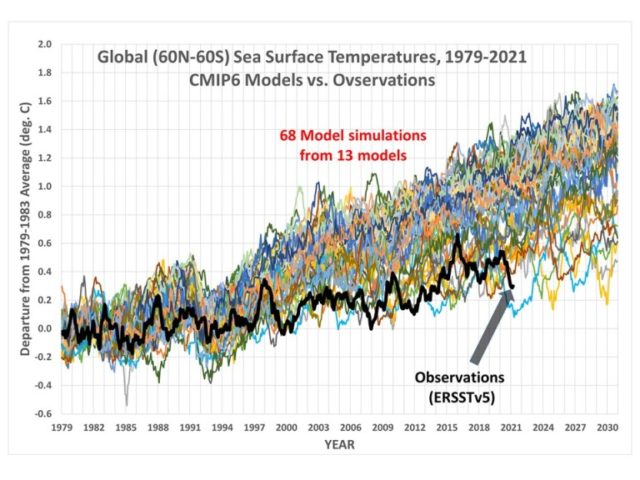

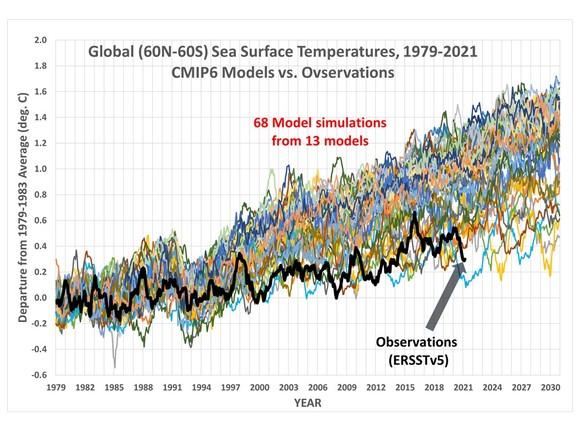

Der Durchschnitt der Temperaturerhöhung beträgt 0,14 Grad Celsius pro Jahrzehnt. Die Modellrechnungen, auf denen die Empfehlungen des IPCC beruhen, kommen auf einen doppelt so hohen Temperaturanstieg für den gleichen Zeitraum. (siehe nächste Grafik, Quelle: R.Spencer 2021). Diese eklatante Abweichung von der realen Temperaturentwicklung ist politisch bedeutsam, weil die Prognosen der Modelle zur Grundlage von weitreichenden Entscheidungen, wie z.B. Verfassungsgerichtsurteilen, gemacht werden.

Ein Verfassungsgerichtsurteil, das sich auf fragwürdige Quellen stützt

Mit Beschluss vom 24.März hat das Bundesverfassungsgericht auf Klage einiger Einzelpersonen wie dem Schauspieler Hannes Jänicke, Luisa Neubauer (Fridays for future), Prof. Volker Quaschning, Josef Göppel (CSU und Energiebeauftragter des Bundesministeriums für wirtschaftliche Zusammenarbeit) entschieden, dass das Klimaschutzgesetz vom 12. Dezember 2019, verfassungswidrig ist, weil „hinreichende Maßgaben für die weitere Emissionsreduktion ab dem Jahre 2031 fehlen“.

Wie kommt das Gericht zu diesem Ergebnis?

In der Beschreibung der „tatsächlichen Grundlagen des Klimawandels“ (Ziff.16-29) und den „tatsächlichen Grundlagen des Klimaschutzes“ (Ziff.31-37) bezieht das Gericht sich im Wesentlichen auf vier Quellen: den IPCC, das Buch Rahmstorf/Schellnhuber „Der Klimawandel“, das Umweltbundesamt und den Sachverständigenrat für Umweltfragen SRU.

Das Gericht stellt zu den Grundlagen des Klimawandels fest:

„zwischen der Gesamtmenge an emittierten klimawirksamen Treibhausgasen und dem Anstieg der mittleren Oberflächentemperatur besteht eine annähernd lineare Beziehung“ (Ziff.19). „Ohne zusätzliche Maßnahmen zur Bekämpfung des Klimawandels gilt derzeit ein globaler Temperaturanstieg um mehr als 3 °C bis zum Jahr 2100 als wahrscheinlich„.

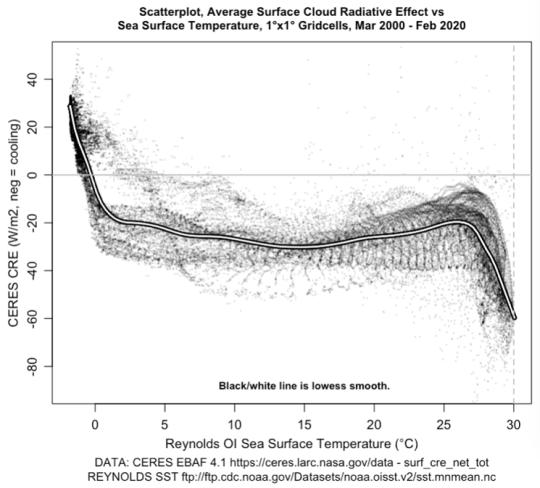

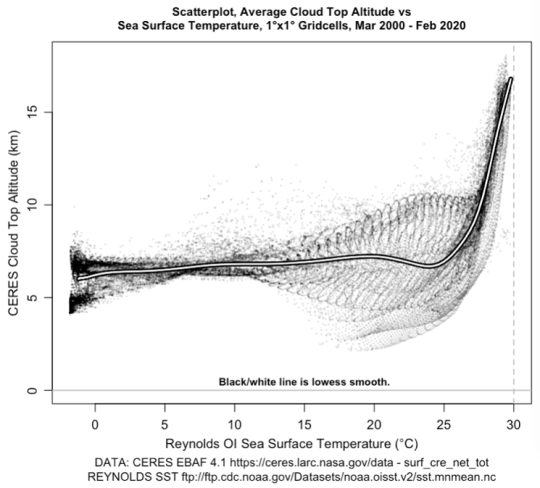

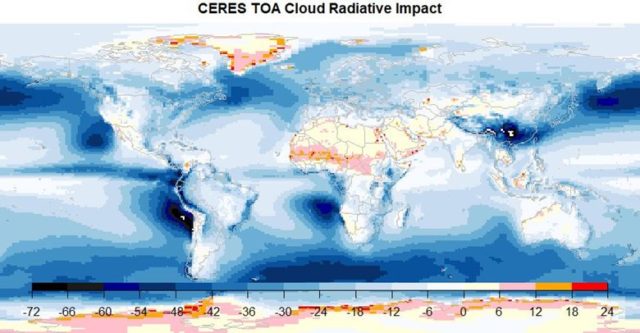

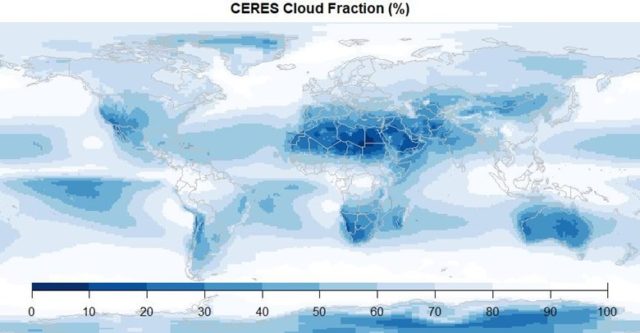

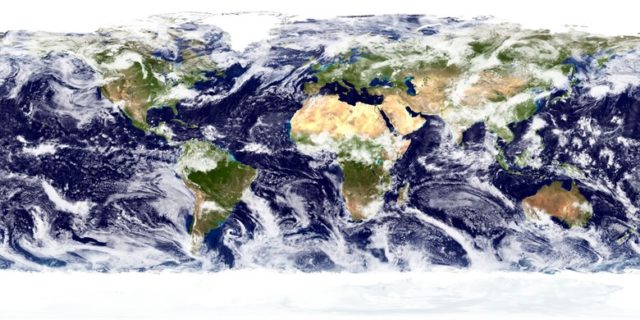

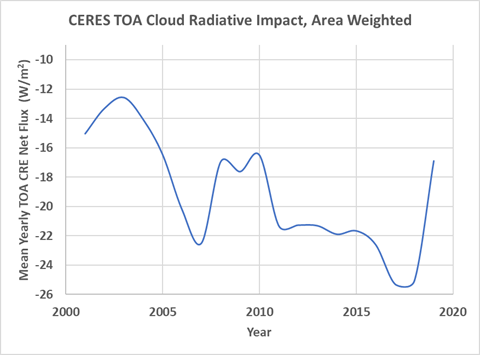

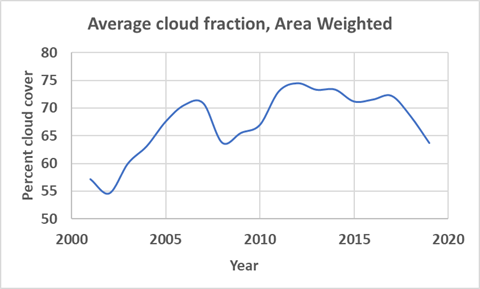

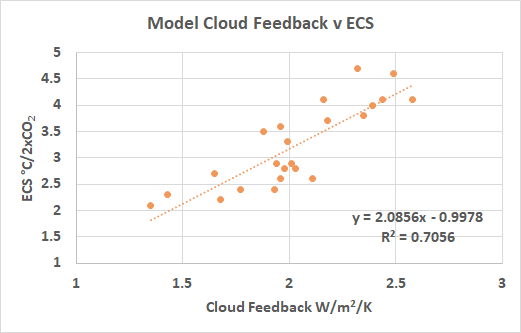

Hier ignoriert das Gericht die erheblichen Unsicherheiten über Rückkopplungseffekte, wie etwa der Wolken, die das IPCC selbst dazu führt, eine Spannbreite von 1,5 bis 4,5 Grad Celsius bei Verdoppelung der CO2-Konzentrationen von 285 ppm (1.860) auf 570 ppm 2.100 anzugeben.

In Ziffer 20 greift das Gericht die unter Klimaforschern umstrittene Annahme Stefan Rahmstorfs auf, wonach es Hinweise gibt,

„daß infolge des Abschmelzens des Grönländischen Eisschildes und anderer Frischwassereinträge in den Nordatlantik die thermohaline Zirkulation des Nordatlantiks (atlantische Umwälzbewegung) an Stärke verliert. Eine starke Abschwächung hätte unter anderem große Auswirkungen auf die Wettersysteme in Europa und Nordamerika. Der Nordatlantikraum würde sich rasch um mehrere Grad abkühlen.“

Hier beruft sich das Gericht auf eine umstrittene Außenseitermeinung. Hätte es auf die Web-Seite des Max-Planck-Instituts für Meteorologie in Hamburg geschaut, hätte es auf die Frage “ kann die globale Erwärmung zum Abriss des Golfstroms führen?“ die Antwort gelesen „Die kurze Antwort ist: Nein.

Auch die Schellnhuberschen Kipppunkte haben es dem Gericht angetan.

„Als eine besondere Gefahr für die ökologische Stabilität werden sogenannte Kipppunktprozesse im Klimasystem angesehen, weil diese weitreichende Umweltauswirkungen haben können. Kippelemente sind Teile des Erdsystems, die eine besondere Bedeutung für das globale Klima haben und die sich bei zunehmender Belastung abrupt und oft irreversibel verändern. Beispiele sind die Permafrostböden in Sibirien und Nordamerika, die Eismassen in den polaren Zonen, der Amazonasregenwald und bedeutende Luft- und Meeresströmungssysteme.„(Ziffer 21)

Wahrscheinlich hatten die Richter das Interview mit Jochem Marotzke, Doyen der deutschen Klimaforscher vom Hamburger Max-Planck-Institut für Meteorologie mit der FAZ nicht gelesen:

FAZ: Welcher Kippunkt macht Ihnen am meisten Sorgen?

Marotzke: Keiner

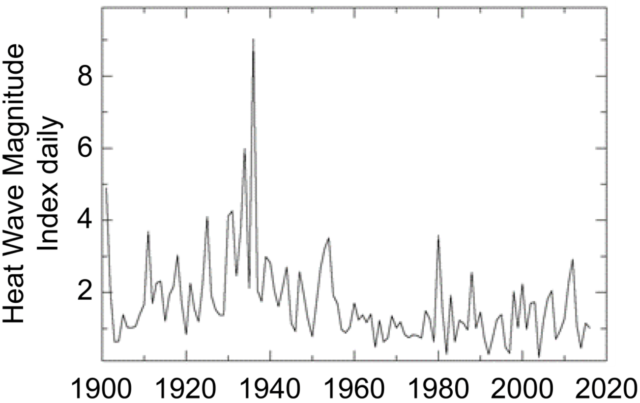

Auch bei den Extremereignissen entspricht das Gericht kaum den aktuellen Erkenntnissen. Selbst der Deutsche Wetterdienst hatte 2018 erklärt – wie der IPCC noch 2013 – dass es schwierig sei, eine Zunahme von Extremwetterereignissen in Deutschland statistisch nachzuweisen. Und dies gilt auch – nach wie vor – weltweit für Dürren, Starkregenereignisse, Hurrikane, Tornados. Im Kapitel IV-Extremwetter unseres Buches „Unerwünschte Wahrheiten“ haben wir 488 Literaturstellen zitiert, die die weitverbreitete Meinung, Extremwetter hätten zugenommen, widerlegen.

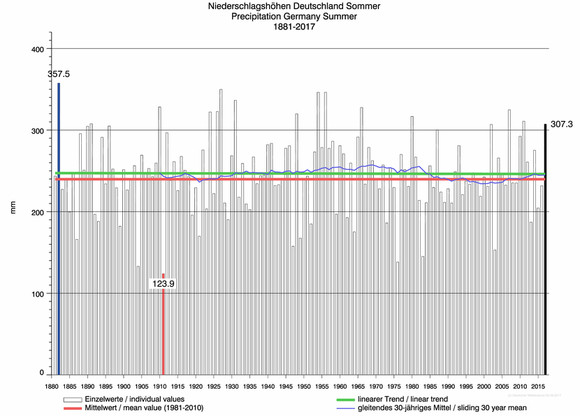

Als Widerlegung der Aussage des Gerichts (Ziffer 27):

„Als eine besondere Herausforderung gilt die in Deutschland beobachtete Zunahme von Trockenheit und Dürre. Die hiermit einhergehende Austrocknung der Böden hat vor allem für die Landwirtschaft Bedeutung“, sei die Grafik der Sommerniederschläge gezeigt:

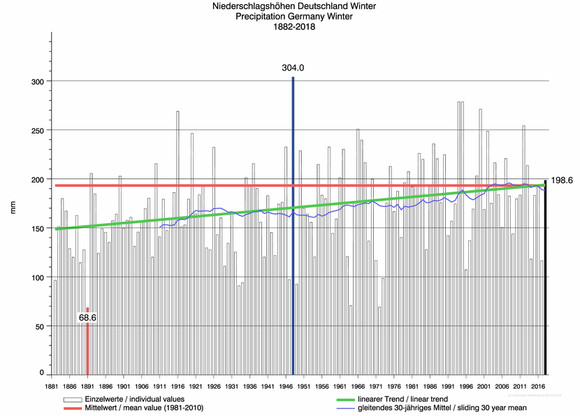

Aber nicht nur die Sommerdaten widerlegen diese Aussage des Gerichts, die Winterdaten ebenso.

Hier gibt es sogar einen Anstieg der Niederschläge. Quelle : hier

Es gibt auch keinen Dürreanstieg europaweit und sogar weltweit („Unerwünschte Wahrheiten“, S. 168). In Ziffer 28 des Beschlusses heißt es :

„Der Klimawandel ist zudem bedeutende Ursache von Flucht und Migration. Menschen verlassen ihre Heimat auch in Folge von Naturkatastrophen und aufgrund langfristiger Umweltveränderungen wie etwa vermehrter Dürren und des Anstiegs des Meeresspiegels.“(Quellenangabe Rahmstorf/Schellnhuber)

Benjamin Schraven vom Deutschen Institut für Entwicklungspolitik schreibt zu diesem Sachverhalt :

„Vieles deutet daraufhin, dass die immer noch weit verbreitete Annahme eines Automatismus zwischen Klimawandel und Migration stark angezweifelt werden muss. Ein solch genereller Ökodeterminismus ist empirisch nicht haltbar.“

Das folgende unzureichende Verständnis von Quellen und Senken des CO2 in Ziffer 32 hat riesige Konsequenzen für den Urteilsspruch:

Das ist nun objektiv falsch. Aber wer hat das dem Gericht aufgeschrieben, denn es geht so weiter?

„Der große Rest anthropogener CO2-Emissionen verbleibt aber langfristig in der Atmosphäre, summiert sich, trägt dort zur Erhöhung der CO2-Konzentration bei und entfaltet so Wirkung auf die Temperatur der Erde. Im Gegensatz zu anderen Treibhausgasen verlässt CO2 die Erdatmosphäre in einem für die Menschheit relevanten Zeitraum nicht mehr auf natürliche Weise. Jede weitere in die Erdatmosphäre gelangende und dieser nicht künstlich wieder entnommene (unten Rn. 33) CO2-Menge erhöht also bleibend die CO2-Konzentration und führt entsprechend zu einem weiteren Temperaturanstieg. Dieser Temperaturanstieg bleibt bestehen, auch wenn sich die Treibhausgaskonzentration nicht weiter erhöht.„(Ziffer 32)

Selbst das IPCC würde dem widersprechen, denn es werden zur Zeit etwa 4,7 ppm jährlich durch anthropogene CO2-Emissionen der Atmosphäre hinzugefügt, aber etwas mehr als die Hälfte des Zuwachses wird durch Ozeane und Pflanzen aufgenommen. (Das Gericht s.o.: „nur kleine Teile“!) Da die Aufnahme von Pflanzen und Ozeanen proportional der CO2-Konzentration in der Atmosphäre erfolgt, hätte eine deutliche Emissionsreduktion – wie etwa eine Halbierung – in der Zukunft sehr wohl eine Konzentrationsminderung in der Atmosphäre zur Folge, denn die durch Pflanzen und Ozeane aufgenommenen etwa 2,6 ppm bleiben vorerst unverändert, auch wenn die CO2– Emission auf 2,35 ppm sinkt.

Aber mit dieser Feststellung hat das Gericht die Voraussetzung für den CO2-Budgetansatz geschaffen:

„Daher lässt sich in Annäherung bestimmen, welche weitere Menge an CO2 noch höchstens dauerhaft in die Erdatmosphäre gelangen darf, damit diese angestrebte Erdtemperatur nicht überschritten wird…Diese Menge wird in der klimapolitischen und klimawissenschaftlichen Diskussion als „CO2-Budget“ bezeichnet„.(Ziffer 36).

Und nun fängt das Gericht an zu rechnen und folgt dem Gutachten des sechsköpfigen Sachverständigenrats für Umweltfragen SRU (stellv. Vorsitzende Prof. Claudia Kemfert). Der SRU hatte in seinem 2020-Gutachten auf Seite 46 das Budget des IPCC von 2018 zur Einhaltung eines Ziels von 1,75 °C mit 800 Gigatonnen CO2 übernommen. Diese Größe teilt der SRU durch die anteilige Bevölkerung und kommt zu 6,7 Gigatonnen CO2, die Deutschland noch ausstoßen darf. Dass die genannten 800 Gigatonnen selbst nach Ansicht des IPCC mit großer Unsicherheit versehen ist, erwähnt das Gericht, rechnet aber weiter mit den 6,7 Gigatonnen. Der Hamburger Klimaforscher Prof. Jochem Marotzke überraschte kurz nach Erscheinen des IPCC-Berichts von 2018 mit der Aussage, dass die zulässige Emission an CO2 sich auf 1.000 Gigatonnen erhöht hätte. Ursache hierfür war die Erkenntnis, dass die Pflanzen der grüner werdenden Erde unvorhergesehenerweise mehr CO2 aufnehmen können als bislang vermutet. Aber das Gericht folgt lieber den Rechnereien des Sachverständigenrats für Umweltfragen.

„Legt man als ab 2020 verbleibendes konkretes nationales CO2-Restbudget 6,7 Gigatonnen zugrunde, wie es der Sachverständigenrat für das Ziel ermittelt hat, den Anstieg der mittleren Erdtemperatur mit einer Wahrscheinlichkeit von 67 % auf 1,75 °C zu begrenzen, würde dieses Restbudget durch die in § 4 Abs. 1 Satz 3 Klimaschutzgesetz in Verbindung mit Anlage 2 zugelassenen CO2-Mengen bis 2030 bereits weitgehend aufgezehrt“. (Ziffer 231).

In der Tat legt das Klimaschutzgesetz eine Minderung der CO2 -Emissionen von 0,813 GT in 2020 auf 0,543 GT in 2030 für alle Sektoren Deutschlands von Energie über Industrie, Gebäude, Verkehr und Landwirtschaft fest. Das Gericht summiert die begrenzten Emissionen und kommt zum Ergebnis:

„Nach 2030 verbliebe danach von dem vom Sachverständigenrat ermittelten CO2-Restbudget von 6,7 Gigatonnen weniger als 1 Gigatonne. (Ziffer 233) Zur Wahrung der Budgetgrenzen müsste demzufolge nach 2030 alsbald Klimaneutralität realisiert werden. …Dass dies gelingen könnte, ist aber nicht wahrscheinlich“. (Ziffer 234)

Und somit kommt das Gericht zum Ergebnis:

„Nach der Berechnung des Sachverständigenrats bleibt bei Verfolgung einer Temperaturschwelle von 1,75 °C bei 67%iger Zielerreichungswahrscheinlichkeit nach 2030 allenfalls noch ein minimaler Rest an Emissionsmöglichkeiten, der angesichts des für 2031 noch zu erwartenden Emissionsniveaus kaum für ein weiteres Jahr genügte (oben Rn. 231 ff.). Zur strikten Wahrung des durch Art. 20a GG vorgegebenen Emissionsrahmens wären danach Reduktionsanstrengungen aus heutiger Sicht unzumutbaren Ausmaßes erforderlich, zumal die allgemeine Lebensweise auch im Jahr 2031 noch von hoher CO2-Intensität geprägt sein dürfte und die jährliche Emissionsmenge im Vergleich zu 1990 erst um 55 % reduziert sein wird (vgl. § 3 Abs 1 Satz 2 KSG). … das verfassungsrechtliche Klimaschutzgebot …(würde) die Hinnahme erheblicher Freiheitseinschränkungen fordern, die aus heutiger Sicht kaum zumutbar wären.“ (Ziffer 246)

Der Schlusssatz des Gerichts lautet :

„Der Gesetzgeber muss daher die Fortschreibung der Minderungsziele für Zeiträume nach 2030 jedoch bis zum 31. Dezember 2022 unter Beachtung der Maßgaben dieses Beschlusses näher regeln.“

Wie die Politik, die nach Ansicht des Gerichts 2030 noch vorhandene 1 Gigatonne CO2 auf alle Sektoren und den Zeitraum 2030 bis 2050 verteilt, ist eine unlösbare Aufgabe. Es sei denn, man macht ab 2035 alles dicht.

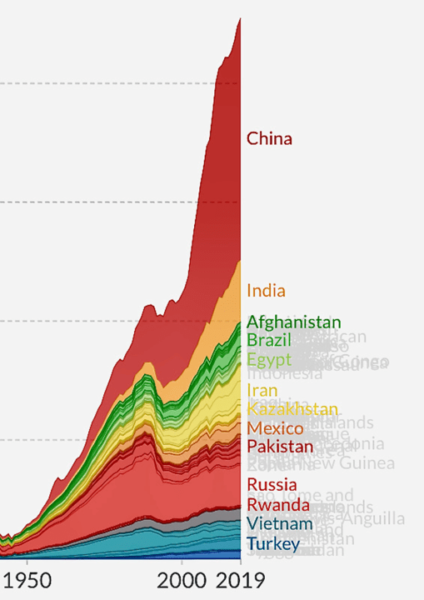

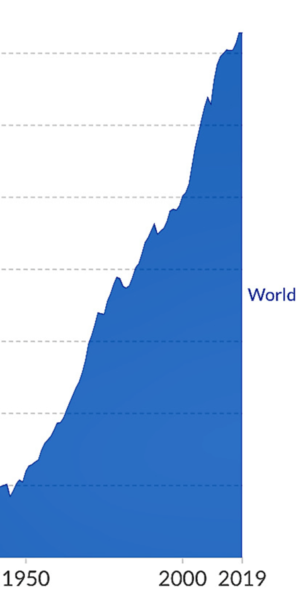

Damit nähert sich das Gericht der Auffassung eines Klägers, Herrn Prof. Quaschning, der eine Null-CO2-Emission für 2035 gefordert hatte. Um den Ausgangspunkt des Gerichts – Restbudget von 6,7 GT bis 2050 für Deutschland in ein Verhältnis zu setzen: das entspricht etwa einem halbem Jahr CO2-Emissionen der VR China in 2030. Bis zu diesem Zeitpunkt beabsichtigt das Land nach seiner freiwilligen Erklärung zum Pariser Abkommen die Emissionen von 9,5 auf 12,5 GT zu steigern- pro Jahr wohlgemerkt. Das Gericht sieht aber für Deutschland für 2030 bis 2050 ein Restbudget von durchschnittlich 0,05 GT pro Jahr vor, soviel wie allein die Baustoffindustrie emittiert, die naturgesetzlich durch die Zementherstellung CO2 (Kalziumkarbonat-Verarbeitung zu Kalziumoxid) ausstößt.

War schon das Klimaschutzgesetz dazu angetan, erhebliche Wohlstands- und Arbeitsplatzverluste bis 2030 zu bewirken, werden die jetzt zu erwartenden Verschärfungen zu tiefsten Verwerfungen führen. Spät, sehr spät wird man erkennen, dass die Elektrifizierung der Sektoren Wärme, Verkehr und Industrie ohne Gas, ohne die in Deutschland verbotene CO2-Abscheidung, ohne die in Deutschland verbotene Kernenergie nicht zu bewerkstelligen ist. Wind und Solar werden die nötige Energie jedenfalls nicht liefern. Denn es geht praktisch um die Stillegung der Gas-und Ölheizungen, das Verbot von Benzin- und Dieselautos, die Stilllegung des LKW-Verkehrs, des Flugverkehrs, der Raffinerien, der Grundstoffindustrie und die Durchleitung des in Nordstream 1 und 2 ankommenden Erdgases (etwa 0,2 GT CO2 pro Jahr) an unsere Nachbarn , die es dann verbrennen dürfen – das volle grüne Programm also. Das wird grandios scheitern.

Das Gericht hat einen momentanen, mit hohen Unsicherheiten behafteten Diskussionsstand der Klimadebatte zum Anlaß genommen, den CO2-Knopf in Deutschland für 2030 bis 2050 auf Null zu stellen.

Wir bräuchten dringend eine Abkühlung. Nicht nur in der CO2-Debatte. Sondern auch des Klimas selbst. Nur wenn die von vielen Wissenschaftlern erwartete Abkühlung in diesem Jahrzehnt eintritt, ist der deutsche soziale Rechtsstaat noch zu retten.

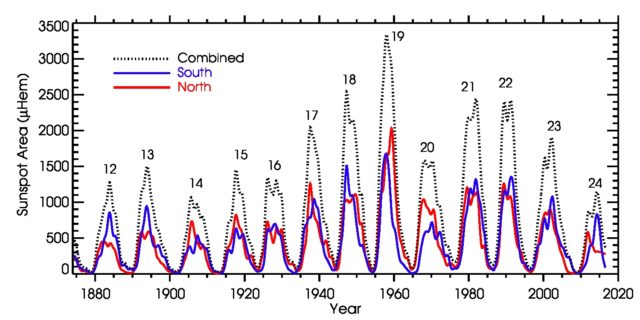

Hinsichtlich dieser Abkühlung gegenüber den Modellprognosen bin ich zuversichtlich.