Beseitigung der AMO

Seine Studie trägt den Titel „Multidecadal climate oscilliations during the past millennium driven by volcanic forcing. Daraus das

Abstract

Frühere Forschungen sprechen für eine interne multidekadische (40- bis 60-jährige) Oszillation, die sich vom Klimarauschen unterscheidet. Neuere Studien haben behauptet, dass diese so genannte Atlantische Multidekadische Oszillation stattdessen eine Manifestation konkurrierender zeitvariabler Effekte von anthropogenen Treibhausgasen und Sulfataerosolen ist. Diese Schlussfolgerung wird durch das Fehlen von robusten multidekadischen Klimaschwingungen in den Kontrollsimulationen der aktuellen Modellgeneration gestützt. Paläoklimadaten zeigen jedoch ein multidekadisches Oszillationsverhalten während der vorindustriellen Ära. Durch den Vergleich von Kontroll- und forcierten „Last Millennium“-Simulationen zeigen wir, dass diese scheinbaren multidekadischen Oszillationen ein Artefakt von Impulsen vulkanischer Aktivität während der vorindustriellen Ära sind, die sich deutlich auf das multidekadische (50- bis 70-jährige) Frequenzband projizieren. Wir kommen zu dem Schluss, dass es keine überzeugenden Beweise für interne multidekadische Oszillationen im Klimasystem gibt.

…

Mann hat einen Blog-Beitrag über das Papier bei RealClimate

Wow! Auf einen Schlag sind die lästigen Probleme des „Grand Hiatus“ Mitte des 20. Jahrhunderts, die Debatten über die Zuordnung der Erwärmung des 20. Jahrhunderts und die Rolle der multidekadischen internen Variabilität sowie die Schwierigkeit, die jüngste Zunahme der atlantischen Hurrikanaktivität dem AGW zuzuschreiben, alle verschwunden. Brillant! Fast so „brillant“ wie der Hockeystick.

Zufälligerweise habe ich den Entwurf eines Kapitels aus einem Bericht, den ich gerade schreibe, in der Tasche. Ich habe den relevanten Text unten auszugsweise wiedergegeben (ich bitte zu entschuldigen, dass ich keine Links zu den Referenzen habe):

9.Multidekadische Variabilität des Atlantiks

Der Atlantische Ozean ist für die globale Ozeanzirkulation besonders wichtig, da sich im nördlichen Nordatlantik das Nordatlantische Tiefenwasser (NADW) bildet, eine wichtige Komponente der Atlantic Meridional Overturning Circulation (AMOC). Die AMOC umfasst die nordwärts gerichtete Strömung des warmen, salzigen Wassers im oberen Atlantik und die südwärts gerichtete Strömung des umgewandelten, kalten, frischen NADW im tiefen Atlantik, die ein wesentlicher Treiber des beträchtlichen nordwärts gerichteten atlantischen Wärmetransports über den Äquator ist.

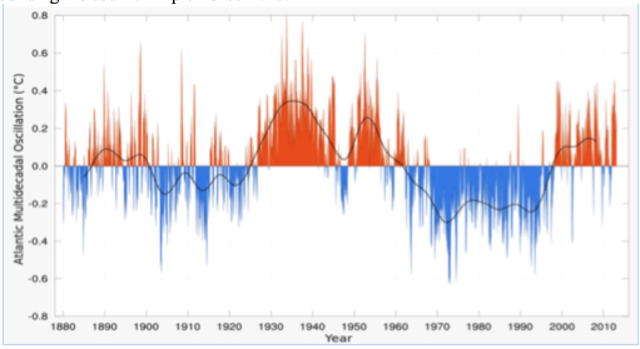

Hinsichtlich der Wassertemperatur im Atlantik (SST) wurden multidekadische Schwankungen in räumlicher Größenordnung der Ozeanbecken beobachtet. Die im Atlantik beobachtete großräumige multidekadische Variabilität wird als Atlantic Multidecadal Oscillation (AMO) bezeichnet. Der multidekadische Charakter der AMO unterscheidet sich von der interannualen Ozeanvariabilität, die durch den führenden Modus der atmosphärischen Zirkulations-Variabilität über dem Nordatlantik, die Nordatlantische Oszillation (NAO), verursacht wird. Der Begriff Atlantische Multidekadische Variabilität (AMV) wird oft verwendet, weil die beobachteten multidekadischen Schwankungen im Atlantik möglicherweise keine Oszillation mit einer einzigen Frequenz sind, sondern aus einem breiteren Band niederfrequenter Signale bestehen.

9.1 Index-Definition und Klimatologie

Die Atlantische Multidekadische Oszillation (AMO) ist mit beckenweiten Schwankungen der SST und des Meeresspiegeldrucks (SLP) verbunden. Für die positive AMO-Phase wird dies manchmal als eine fast gleichmäßige Erwärmung des Nordatlantiks dargestellt. Der traditionelle AMO-Index assoziiert die positive AMO-Phase mit einem Muster hufeisenförmiger SST-Anomalien im Nordatlantik mit ausgeprägter Erwärmung im tropischen und Teilen des östlichen subtropischen Nordatlantiks, einem anomal kühlen Gebiet vor der US-Ostküste und warmen Anomalien um die Südspitze Grönlands.

Die letzten 100 bis 150 Jahre der atlantischen SSTs sind durch einen Jahrhunderte langen Nettoanstieg und Perioden multidekadischer Erwärmung und Abkühlung gekennzeichnet. Die Begründung für die Trennung „Trend+AMO“ wird jedoch durch die fehlende Linearität des globalen Erwärmungstrends konterkariert, so dass die Trendbereinigung den AMO-Index verfremdet. Die Nichtlinearität ist besonders ausgeprägt während des Zeitraums 1945-1975, als die globalen SSTs einen leichten Abkühlungstrend zeigten.

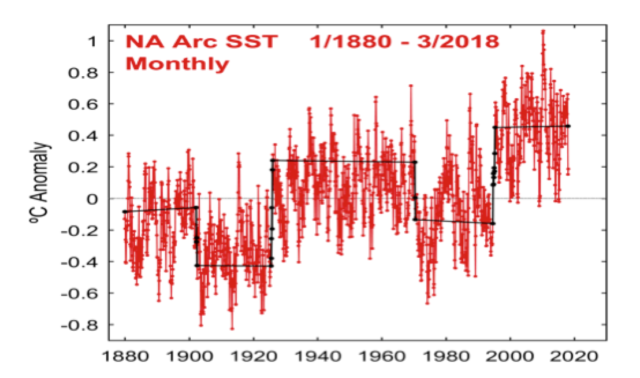

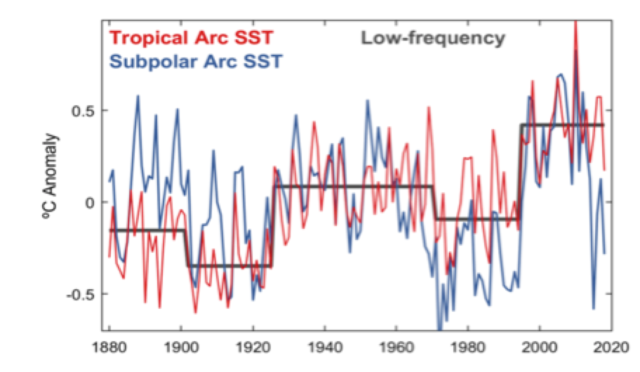

Um die mit der Trendbereinigung verbundenen Unklarheiten bei der Formulierung des AMO-Index zu beseitigen, hat Johnstone (2017) einen atlantischen „Arc“-Index formuliert, der auf der führenden Hauptkomponente der nordatlantischen SST-Variabilität (60°N bis 0°, 70°W-0°W) basiert. Der atlantische „Arc“-SST-Index spiegelt die kohärente Variabilität innerhalb eines bogenförmigen Musters auf Beckenebene wider (manchmal als „Hufeisen“ bezeichnet), eine Signatur der AMO, die den tropischen Nordatlantik, die östliche Grenze der mittleren Breiten und einen Großteil des subpolaren Nordens umfasst (Abb. 9.2).

Das Arc-Muster wird als räumliche Signatur der AMO erkannt, die mit der gekoppelten Ozean-Atmosphären-Variabilität identifiziert wird, und ist eng mit einem „Tripol“-Muster der SST-Reaktion auf die NAO verbunden. Der Arc-Index zeigt eine Nettoerwärmung zusätzlich zu der multidekadischen Periode, die als kühle Phase der AMO anerkannt ist (Abbildung 9.3). Da der Arc-Index sowohl die AMO-Variabilität als auch den allgemeinen Erwärmungstrend kombiniert, ist es sinnvoller, ihn als Definition multidekadischer Regime und Verschiebungen zu interpretieren (siehe Abschnitt 9.4).

Der Arc Index (Abbildung 9.3) zeigt abrupte Verschiebungen in die warme Phase in den Jahren 1926 und 1995, die mit der konventionellen AMO-Analyse in Abbildung 9.1 übereinstimmen. Die Analyse von Johnstone zeigt eine Verschiebung in die kalte Phase im Jahr 1971, was sich von der Analyse in Abbildung 9.1 unterscheidet, die die Verschiebung in die kalte Phase im Jahr 1964 anzeigt. Der AMO-Index von Klotzbach und Gray (2008) zeigt ebenfalls eine Verschiebung in die kalte Phase im Jahr 1970 an.

9.2 Paläoklima-Rekonstruktionen

Die Kürze der verfügbaren instrumentellen Daten begrenzt unser Verständnis der Atlantischen Multidekadischen Variabilität (AMV). Paläoklima-Proxy-Rekonstruktionen von AMV-bezogenen Signalen, die über die instrumentelle Ära hinausreichen, bieten eine wichtige Grundlage für das Verständnis der Natur und der zeitlichen Stationarität der AMV.

Die jüngste AMV-Rekonstruktion von Wang et al. (2017) unter Verwendung von terrestrischen Proxy-Aufzeichnungen (Baumringe, Eisbohrkerne usw.) über die letzten 1.200 Jahre hat sowohl eine breite räumliche Abdeckung als auch eine hohe zeitliche (jährliche) Auflösung. Wang et al. (2017) fanden heraus, dass große Vulkanausbrüche und solare Einstrahlungsminima kühle Phasen der atlantischen multidekadischen Variabilität induzieren und zusammen etwa 30% der Varianz in der Rekonstruktion auf Zeitskalen größer als 30 Jahre erklären. Sie isolierten die intern erzeugte Komponente der atlantischen multidekadischen Variabilität, die sie als AMO definieren. Sie fanden heraus, dass die AMO den größten Beitrag zur atlantischen multidekadischen Variabilität in den letzten 1.200 Jahren leistet.

[Es folgen drei längere Abschnitte der Beschreibung von Rekonstruktionen von anderen Autoren. Auf deren Übersetzung wird hier der Länge wegen verzichtet. Alle Autoren kommen im Prinzip zu ähnlichen Ergebnissen. A. d. Übers.]

…

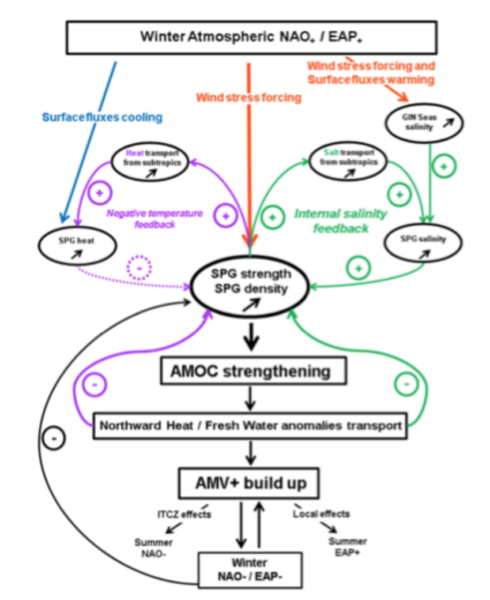

9.3 Klima-Dynamik

Trotz anhaltender Debatten über die Klimadynamik der AMV wird allgemein akzeptiert, dass die AMV eine komplexe Verschmelzung von natürlicher interner Variabilität der atlantischen meridionalen Umwälzzirkulation (AMOC), natürlichem stochastischem Rot-Rauschen des Ozeans durch die Atmosphäre (hauptsächlich die NAO) und externem Antrieb durch vulkanische Ereignisse, Aerosolpartikel und Treibhausgase darstellt.

9.3.1 Die AMO

Die Atlantische Multidekadische Oszillation (AMO) ist der prominenteste Modus der multidekadischen atlantischen Variabilität; die physikalischen Ursprünge der AMO bleiben jedoch ein Thema anhaltender Debatten. Die beobachteten SST-Änderungen der AMO werden seit langem auf langsame Variationen des nordwärts gerichteten Wärmetransports im oberen Ozean durch die AMOC zurückgeführt. Ozeanische Prozesse bieten einen plausiblen Mechanismus für große multidekadische Klimaschwankungen; solche Schlussfolgerungen basieren aufgrund der kurzen Aufzeichnung der AMOC-Zirkulation, die erst 2004 beginnt, weitgehend auf Klimamodell-Simulationen.

Es wurden mehrere zusätzliche Hypothesen für AMV-Prozesse vorgeschlagen. Es wurde angenommen, dass anthropogene Aerosole eine Hauptursache für die beobachtete AMV sind. Das Argument ist, dass ein Anstieg des linear verzögerten AMV-SST-Indexes durch den erhöhten abwärts gerichteten kurzwelligen Strahlungswärmefluss erzwungen wird, der durch die abnehmenden anthropogenen Aerosole durch ihre Wechselwirkung mit Wolken induziert wird. Der beobachtete Rückgang des subpolaren AMV-SST-Signals in der letzten Dekade steht jedoch im Widerspruch zu der kürzlich beobachteten Veränderung (eine leichte Abnahme) der anthropogenen Aerosole über der nordatlantischen Region. Wie von Zhang et al. (2019) zusammengefasst, widerspricht die Hypothese, dass Änderungen des externen Strahlungsantriebs ein Haupttreiber der AMV sind, vielen beobachteten Schlüsselelementen der AMV.

[Diese Problematik wird naturgemäß ebenfalls von mehreren anderen Autoren untersucht. Deren Zusammenfassungen werden hier der Ähnlichkeit der Ergebnisse wegen nicht mit übersetzt. A. d. Übers.]

…

Alles in allem ist die kombinierte Wirkung von NAO und EAP [= East Atlantic Pattern] für einen unregelmäßigen und gedämpften Modus der Variabilität der AMOC/AMV verantwortlich, der etwa 35-40 Jahre zum Aufbau und etwa 15-20 Jahre zum Abbau benötigt. Zusätzlich zur direkten NAO-/EAP-Wirkung wird die Beendigung von AMOC/AMV-Ereignissen auch durch die Advektion von anomalem Süßwasser aus dem subtropischen nordatlantischen Becken entlang der mittleren westlichen Grenzozeanzirkulation und auch aus der Arktis aufgrund des beträchtlichen Eisvolumenverlusts in Verbindung mit den insgesamt wärmeren atmosphärischen Bedingungen bei erhöhter AMOC induziert.

Aktualisierung: Eine ausgezeichnete neue Publikation der American Meteorological Society bestätigt im Wesentlichen meine Ergebnisse.

9.4 Verschiebungen in jüngerer Zeit

Wie von Robson et al. (2012) zusammengefasst, erfuhr der subpolare Wirbel des Nordatlantiks Mitte der 1990er Jahre eine bemerkenswert schnelle Erwärmung, wobei die Wassertemperatur in nur 2 Jahren um etwa 1,8°C gestiegen war. Diese schnelle Erwärmung folgte auf eine lang anhaltende positive Phase der Nordatlantischen Oszillation (NAO), fiel aber auch mit einem ungewöhnlich negativen NAO-Index im Winter 1995/96 zusammen. Durch den Vergleich von Ozeananalysen und sorgfältig entworfenen Modellexperimenten zeigten sie, dass diese schnelle Erwärmung als eine verzögerte Reaktion auf die verlängerte positive Phase der NAO verstanden werden kann und nicht einfach als eine sofortige Reaktion auf den negativen NAO-Index von 1995/96. Außerdem folgerten sie, dass die Erwärmung teilweise durch einen Anstieg und anschließenden Rückgang der meridionalen Umwälzzirkulation und des nordwärts gerichteten Wärmetransports des Atlantiks verursacht wurde.

Robson et al. (2016) zeigten, dass sich seit 2005 ein großes Volumen des subpolaren Nordatlantiks deutlich abgekühlt hat und damit der vorherige Erwärmungstrend umgekehrt wurde. Durch die Analyse von Beobachtungen und einem hochmodernen Klimamodell zeigten sie, dass diese Abkühlung mit einer Abnahme der Stärke der Ozeanzirkulation und des Wärmetransports konsistent ist, die mit rekordverdächtig niedrigen Dichten in der tiefen Labradorsee verbunden ist. Die geringe Dichte in der tiefen Labradorsee ist in erster Linie auf die Erwärmung des tiefen Ozeans seit 1995 zurückzuführen, aber auch eine langfristige Auffrischung spielte eine Rolle. Sie schlossen daraus, dass die beobachtete Abkühlung einer großen Region des oberen Nordatlantiks seit 2005 nicht als direkte Reaktion auf Veränderungen der atmosphärischen Zirkulation im gleichen Zeitraum erklärt werden kann.

Johnstone (2017) beschreibt ein „coupled shift model“ des niederfrequenten nordatlantischen Klimawandels, das auf abrupten Übergängen zwischen quasi-stabilen Wassertemperaturen und gekoppelten atmosphärischen Zirkulationen basiert. Diese Hypothese beschreibt wiederkehrende stufenförmige Änderungen der nordatlantischen SST, wobei SST-Störungen mit großer Amplitude gelegentlich als anomale multidekadische Klimazustände durch positive Atmosphäre-Ozean-Rückkopplungen aufrechterhalten werden. Es wird der statistische Nachweis erbracht, dass niederfrequente SST-Änderungen keine graduellen Prozesse waren, wie sie üblicherweise beschrieben werden, sondern durch eine Reihe von kurzen, diskreten Ereignissen, gekennzeichnet durch abrupte ~1-Jahres-stufenartige Verschiebungen, die längere multidekadische Perioden mit relativ geringen Veränderungen trennen.

Die starke Erwärmung des Atlantiks Mitte der 1990er Jahre (Abbildung 9.1), die von gefilterten AMO-Indizes als ein allmählicher Prozess dargestellt wird, der sich über ein Jahrzehnt oder länger hinzieht, lässt sich auf einen abrupten und bemerkenswert kontinuierlichen Anstieg der SST auf der Beckenskala zurückführen, der im Oktober/November 1994 begann und im Wesentlichen als +0,8°C SST-Änderung über den größten Teil des Nordatlantiks bis Juli 1995 vollzogen wurde (Abbildung 9.3). Die abrupte Erwärmung von 1994-95 wurde in den folgenden Monaten, in den nächsten Jahren und in den darauffolgenden zwei Jahrzehnten bis zur Gegenwart nicht gebremst und führte schnell zu einem neuen wärmeren Klimazustand*. Die beckenweite Ausdehnung der Verschiebung von 1995 ist an der abrupten Verschiebung der monatlichen SST-Anomalien sowohl über dem subpolaren Nordatlantik (50-60oN) als auch über den subtropischen Rändern von NW-Afrika zu erkennen, die sich fast gleichzeitig erwärmten (Arc Index, Abbildung 9.2).

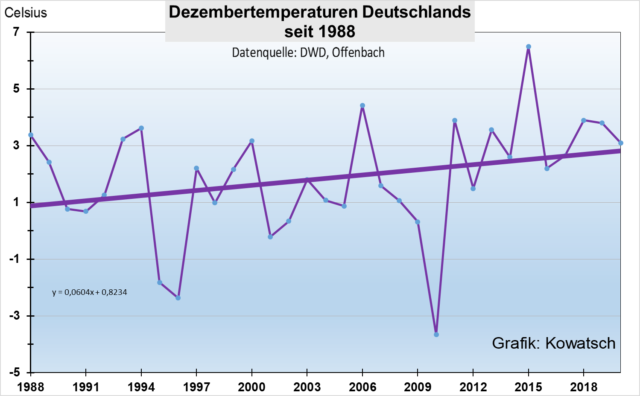

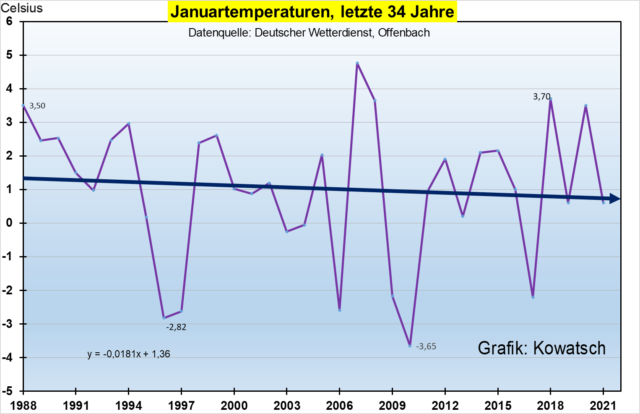

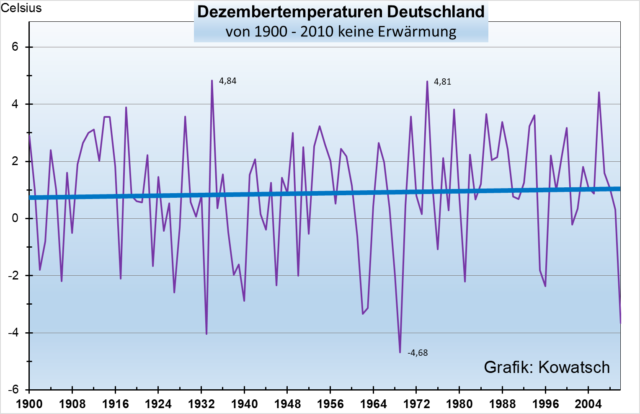

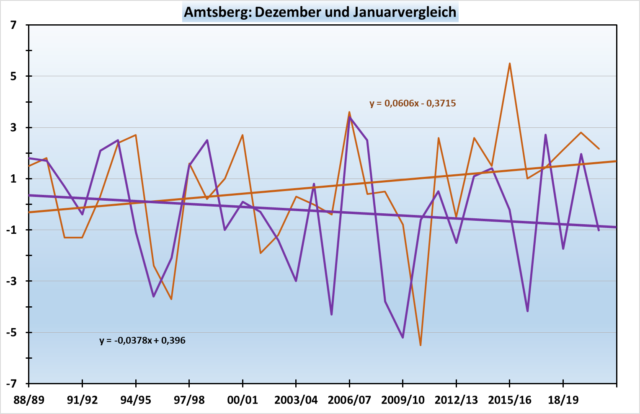

[*Siehe hierzu auch die Arbeiten von Kämpfe & Kowatsch zum „Temperatursprung“ in Mitteleuropa. A. d. Übers.]

Verschiebungen erscheinen in der jährlichen Arc-SST-Aufzeichnung (Abb. 9.3) als ausgeprägte Jahr-zu-Jahr-Sprünge in den Jahren 1925-26 (+0,5°C), 1970-71 (-0,3°) und 1994-95 (+0,6°), denen eine multidekadische Persistenz ähnlicher Anomalien in Bezug auf die Vorjahre folgte (1926-1970: +0,5°C, 1971-1994: -0,2°C und 1995-2014: +0,5°). In jedem dieser Intervalle fehlt ein signifikanter linearer Arc-SST-Trend, was darauf hindeutet, dass auf große vorübergehende Klimaänderungen eine Restabilisierung der Wärmebilanz des Oberozeans und die Persistenz neuer anomaler Bedingungen über Jahre bis zu mehreren Jahrzehnten folgte. Arc-SST-Änderungen 1926, 1971 und 1995 traten mit moderaten gleichgerichteten Anomalien der Winter (Oktober-März) Niño 3.4 SST auf, was auf eine systematische Rolle von ENSO bei der Erzeugung von niederfrequenten Klimaänderungen im Nordatlantik hindeutet.

Ein spezifischerer regionaler Indikator zeigt sich in der Korrespondenz der SST-Verschiebungen des Bogens mit hochamplitudigen SST-Änderungen vor Nordwestafrika, die im September 1925, August 1970 und November 1994 ihren Höhepunkt erreichten. Westafrikanische SSTs sind eine prominente Komponente des Atlantischen Multidekadischen Modus (AMM), der als Brücke über Zeitskalen hinweg dienen kann, indem er SST-Störungen als anhaltende Klimaanomalien aufrechterhält.

Eine physikalische Implikation des Verschiebungsmodells ist, dass niederfrequente Klimaveränderungen durch gelegentliche Impulse der Wärmeaufnahme und -abgabe des oberen Ozeans auftreten, und nicht durch allmähliche oder kumulative Prozesse.

Die Atmosphäre-Ozean-Bedingungen, die zur Erwärmung von 1994-95 führten, weisen bemerkenswerte Ähnlichkeiten mit der Erwärmung von 1925-26 und (entgegengesetzt) mit der Abkühlung von 1970-1971 auf, was auf die Vorhersagbarkeit größerer Klimaverschiebungen im Nordatlantik hindeutet. Allen drei Ereignissen gingen in den vorangegangenen 2-3 Jahren einzigartig starke Anomalien des Meeresspiegeldrucks (SLP) mit entgegengesetztem Vorzeichen um die Norwegische See innerhalb eines breiteren NAO-ähnlichen Musters voraus. In jedem Fall wies der Übergangswinter moderate ENSO-Bedingungen auf, die die sich entwickelnde Temperaturveränderung begünstigten, und jede Verschiebung zeichnete sich durch extreme lokale SST-Veränderungen vor NW-Afrika aus.

Historisch gesehen waren atlantische Verschiebungen durch extreme kurzfristige SST-Änderungen vor NW-Afrika gekennzeichnet: ein Verhalten, das derzeit nicht zu beobachten ist, da die subtropischen und tropischen Gebiete des Bogens in einem warmen Zustand verbleiben, der 1995 begann. Es ist jedoch bemerkenswert, dass die subpolaren SSTs von 50-60N Anzeichen einer abrupten Abkühlung seit 2015 zeigen (Abb. 9.10), ein Verhalten, das auf eine „partielle“ Verschiebung hindeutet, die bald den breiteren Nordatlantik, einschließlich der Tropen, betreffen könnte. Die aktuelle Divergenz zwischen subpolarer und tropischer nordatlantischer SST ist möglicherweise analog zu dem Verhalten, das in den späten 1960er- und frühen 1970er-Jahren zu beobachten war, als die schnelle subpolare Abkühlung 1969-70 dem starken Rückgang der tropischen SST 1971 etwas vorausging. Basierend auf historischen Mustern könnte ein abrupter Wechsel zu kühleren Bedingungen unmittelbar bevorstehen, obwohl die ungewöhnlich lange Zeitspanne von 1926 bis 1970 darauf hindeutet, dass auch eine erhebliche Verzögerung von bis zu 10-20 Jahren plausibel sein könnte.

Inwieweit war die AMO-Verschiebung von 1995 durch Klimamodelle vorhersagbar? Msadek et al. (2014) fassen die dekadischen Vorhersageexperimente zusammen, die mit dem GFDL-Klimamodell durchgeführt wurden. Die Initialisierung des Modells erzeugt eine hohe Kompetenz in der rückwirkenden Vorhersage der Erwärmung Mitte der 1990er Jahre, die von den nicht initialisierten Vorhersagen nicht erfasst wird. Alle Hindcasts, die in den frühen 1990er Jahren initialisiert wurden, zeigen eine Erwärmung des SPG (subpolarer Wirbel); allerdings sind nur die 1995 und 1996 initialisierten Hindcasts im Ensemble-Mittel in der Lage, die beobachtete abrupte Erwärmung und die damit verbundene Abnahme und Kontraktion des SPG zu reproduzieren. Die verbesserte dekadische Vorhersagefähigkeit des Atlantiks wird in erster Linie durch die Initialisierung der AMOC-Anomalien erreicht, anstatt die AMOC-Anomalien in den hohen nördlichen Breiten vorherzusagen.

Bei der Betrachtung einer möglichen zukünftigen Verschiebung in die kalte Phase der AMO ist es lehrreich, die vorherige Verschiebung in die kalte Phase zu betrachten, die in den 1960er und frühen 1970er Jahren stattfand, als sich die Meeresoberflächentemperaturen im Nordatlantik schnell abkühlten. Hodson et al. (2014) wiesen nach, dass die Abkühlung in mehreren unterschiedlichen Phasen verlief:

● 1964-68: Die anfängliche Abkühlung ist größtenteils auf die nordischen Meere und die Golfstromverlängerung beschränkt. In diesem Zeitraum gibt es keine nennenswerten atmosphärischen Zirkulationsanomalien, abgesehen von einer kleinen niedrigen MSLP-Anomalie über der Arktis im Oktober-Juni.

● 1968-72: Mit dem Fortschreiten der Abkühlung dehnen sich kühle Anomalien auf einen Großteil des subpolaren Wirbels (SPG) und der nördlichen mittleren Breiten aus. Es gibt einen Hinweis auf niedrige SLP-Anomalien über Nordafrika, aber der auffälligste Hinweis auf Zirkulationsanomalien ist eine antizyklonale Anomalie im Juli-September, die sich über Nordeuropa und nach Asien erstreckt.

● 1972-76: Die kühlen Anomalien erreichen in dieser Periode ihre maximale Größe und räumliche Ausdehnung. Der westliche Teil des subtropischen Nordatlantiks zeigt keine signifikante Abkühlung, was zu einem Tripol- (oder Hufeisen-) Muster führt. Das Muster der SLP-Anomalien projiziert sich auf die positive Phase der NAO.

9.5 Klimamodell-Simulationen

Viele gekoppelte Klimamodelle simulieren die Atlantische Dekadische Variabilität, die in mancher Hinsicht mit den verfügbaren Beobachtungen übereinstimmt. Die Mechanismen unterscheiden sich jedoch stark von Modell zu Modell, und die unzureichende Beobachtungsdatenbank erlaubt keine Unterscheidung zwischen „realistischen“ und „unrealistischen“ Simulationen (Latif und Keenlyside, 2011). Ruiz-Barradas et al. (2013) untersuchten historische Simulationen der AMO in CMIP3- und CMIP5-Modellen. Die Variabilität der AMO in den Bereichen 10-20/70-80 Jahre wird in den Modellen überschätzt/unterschätzt.

Cheng et al. (2013; 2015) untersuchten die Atlantische Meridionale Umwälzzirkulation (AMOC), die von 10 Modellen aus CMIP5 für das historische und zukünftige Klima simuliert wurde. Das Multimodel-Ensemblemittel der AMOC zeigt eine multidekadische Variabilität mit einer 60-jährigen Periode; alle Einzelmodelle projizieren sich konsistent auf diesen multidekadischen Modus.

Wie die NCA (2017) zusammenfasst, variiert die simulierte AMOC-AMV-Verknüpfung zwischen den gekoppelten globalen Klimamodellen beträchtlich, was wahrscheinlich aus der Streuung der Modellverzerrungen im Mittelwert im Nordatlantik resultiert. Die AMOC-AMV-Verknüpfung hängt von den Amplituden der niederfrequenten AMOC-Variabilität ab, die in Klimamodellen viel schwächer ist als in der realen Welt aufgrund der unterschätzten niederfrequenten AMOC-Variabilität, die die relative Rolle des externen Strahlungsantriebs oder des stochastischen atmosphärischen Antriebs in der AMV verstärkt.

Der Zeitpunkt einer Verschiebung in die AMO-Kaltphase ist nicht vorhersehbar; er hängt bis zu einem gewissen Grad von unvorhersehbaren Wettervariabilitäten ab. Die Analyse historischer und paläoklimatischer Aufzeichnungen legt jedoch nahe, dass ein Übergang in die kalte Phase vor 2050 zu erwarten ist. Enfield und Cid-Serrano (2006) verwendeten paläoklimatische Rekonstruktionen der AMO, um eine probabilistische Projektion der nächsten AMO-Verschiebung zu entwickeln. Die Analyse von Enfield und Cid-Serrano deutet darauf hin, dass eine Verschiebung in die kalte Phase innerhalb der nächsten 13 Jahre stattfinden sollte, mit einer Wahrscheinlichkeit von 50 %, dass die Verschiebung in den nächsten 6 Jahren stattfindet.

Evaluierung der Studie von Mann et al.:

Mit diesem Kontext können Sie sehen, warum ich die Aerosol-Erklärung (Verschmutzung und/oder Vulkane) als Erklärung für die Ursachen der AMO nicht akzeptiere. Es gibt erhebliche Diskussionen und Meinungsverschiedenheiten in der Klimadynamik-Gemeinschaft zu diesem Thema, was angesichts der offensichtlichen komplexen Wechselwirkungen zwischen den Ozeanzirkulationen und der AMOC, dem Wetter und der interannuellen Klimavariabilität sowie dem externen Antrieb durch die Sonne und Vulkane nicht überraschend ist.

Was genau ist also falsch an Manns Analyse? Er verlässt sich auf globale Klimamodelle, die bei der Simulation der AMO unzureichend sind. Dies wurde zuletzt von Kravtsov et al. (2018) hervorgehoben, die zu dem Schluss kamen, dass:

„Während die Klimamodelle verschiedene Niveaus der dekadischen Klimavariabilität und einige regionale Ähnlichkeiten mit den Beobachtungen aufweisen, stimmt keine der betrachteten Modellsimulationen mit dem beobachteten Signal in Bezug auf seine Größe, räumliche Muster und ihre zeitliche Entwicklung überein. Diese Ergebnisse unterstreichen ein erhebliches Maß an Unsicherheit in unserer Interpretation des beobachteten Klimawandels unter Verwendung der aktuellen Generation von Klimamodellen.“

Sich auf globale Klimamodelle zu verlassen, die die multidekadische interne Variabilität nicht adäquat simulieren, um zu „beweisen“, dass eine solche multidekadische interne Variabilität nicht existiert, ist ein Zirkelschluss (bestenfalls). Wie kann so etwas in einer Zeitschrift wie Science veröffentlicht werden? Peer-Review ist sooooo kaputt.

Was Mann in den Klimamodell-Simulationen sieht, ist die kurzperiodische tropische Ausprägung der AMO, die auf den Nordatlantik beschränkt ist – nicht die multidekadische Variabilität, die mit der globalen Oszillation verbunden ist. Diese tropische Ausprägung kann sehr wohl bis zu einem gewissen Grad durch tropische Vulkanausbrüche erzwungen werden, sagt aber wenig über die globale multi-dekadische Variabilität aus, die von größtem Interesse ist.

Die tatsächliche multidekadische Klimavariabilität wird größtenteils intern generiert, obwohl solare Variationen helfen können, das Tempo zu bestimmen, und große Vulkanausbrüche können die Variationen maskieren oder helfen, eine Verschiebung auszulösen.

Warum ist das wichtig? Die verschiedenen Phasen der AMO sind verbunden mit: Die Aktivität der atlantischen Hurrikane, die Massenbilanz Grönlands und Witterung, die Nordamerika und Europa beeinflussen (insbesondere Dürren); ganz zu schweigen von der globalen Temperaturänderung.

Aus der Pressemitteilung der Penn State University geht hervor, dass ein Hauptmotiv für die Annullierung der AMO darin besteht, dass Mann die Zunahme der atlantischen Hurrikan-Aktivität seit 1995 dem AGW zuschreiben kann. Die Annullierung der AMO wird hier nicht viel helfen. Wie in meinem letzten Beitrag über den AIR-Versicherungssektor-Bericht diskutiert, war die Anzahl der großen Hurrikane (Cat 3+) im Atlantik während der 1950er und 1960er Jahre (frühere warme Phase der AMO) mindestens so groß wie in den letzten beiden Jahrzehnten bei deutlich niedrigeren SSTs.

Ein weiteres zentrales Problem mit der AMO ist, dass die gesamte Beschleunigung des Meeresspiegelanstiegs in den letzten Jahrzehnten von der Grönlandschmelze herrührt, die stark von der AMO beeinflusst wird.

Unter der Annahme, dass sich die Natur weiterhin so verhält, wie sie es in den letzten 8 Jahrtausenden getan hat, werden wir irgendwann (möglicherweise im nächsten Jahrzehnt) eine Verschiebung in die kalte Phase der AMO sehen, mit einer Abschwächung der atlantischen Hurrikanaktivität und des grönländischen Massenverlustes.

Abschließend sei gesagt, dass Manns Bestreben, die mittelalterliche Warmzeit und jetzt die AMO zu annullieren, um zu zeigen, dass die jüngste Erwärmung zu 100% anthropogen ist, für Wissenschaftler, die etwas von Klimadynamik und globalen Klimamodellen verstehen, überhaupt nicht überzeugend ist.

Link: https://judithcurry.com/2021/03/06/canceling-the-amo/

Übersetzt von Chris Frey EIKE