BLACKOUT – kleines Handbuch zum Umgang mit einer wachsenden Gefahr – Folge 6

Doch im 19. Jahrhundert trat ein überlegener Beleuchtungskörper seinen Siegeszug in Europa und Amerika an: heller und kostengünstiger als die Kerze, einfach in der Handhabung sowie bei richtiger Einstellung praktisch rußfrei – die Petroleumlampe. Nachdem eine ganze Reihe von Innovationen in ihre Komponenten Brenner, Glaszylinder und Docht geflossen waren und man die Teile aufeinander abgestimmt hatte, erhellten diese Lampen millionenfach die Haushalte in Deutschland. In ihrer manchmal sehr aufwändigen handwerklichen Ausführung wurden sie zu einem Teil der bürgerlichen Wohnkultur. All diese Eigenschaften sprechen dafür, sie als Notbeleuchtung beim Stromausfall in Betracht zu ziehen – vorher können sie als Dekoration in der Wohnung dienen. Man muss solche Lampen nicht beim Antikhandel erwerben, sondern kann sie auch nagelneu kaufen.

Empfehlung: Kaufen Sie sich ein paar neue, schöne Petroleumlampen mitsamt eines Vorrats an Lampenöl.

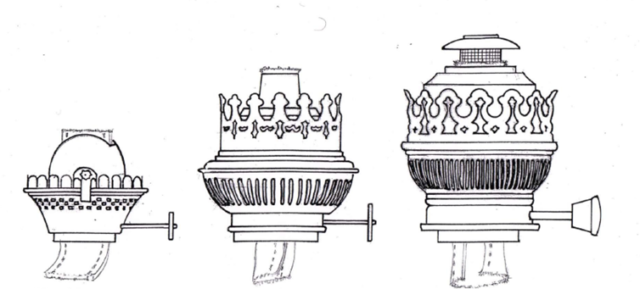

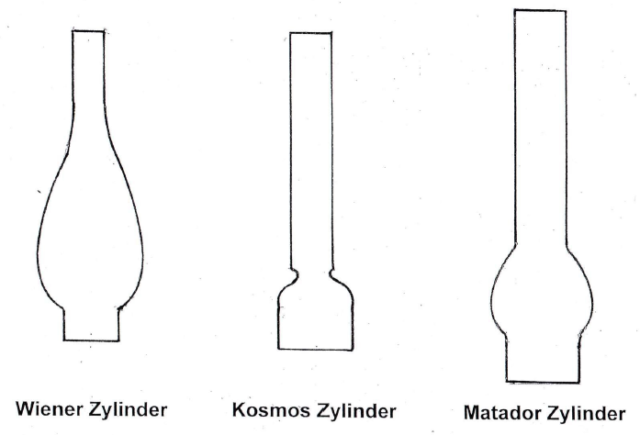

Die einzelnen Typen unterscheiden sich durch die Art des Brenners und des Zylinders. Bei den Brennern gibt es drei Bauformen für unterschiedliche Helligkeiten: Flachbrenner, Runddochtbrenner (Kosmosbrenner) und Flammscheibenbrenner (Idealbrenner, Matadorbrenner). Der Runddochtbrenner ist deutlich heller als der Flachbrenner und verbraucht weniger Petroleum als der noch hellere Flammscheibenbrenner.

Zu jedem Brenner gehört der passende Zylinder, bei denen man Wiener Zylinder (für Flachbrenner), Kosmos Zylinder (für Runddochtbrenner) und Matador Zylinder (für Flammscheibenbrenner) unterscheidet. Die Wahl eines falschen Zylinders kann zur Zerstörung desselben führen.

Es sei noch erwähnt, dass die unterschiedliche Größe der Brenner und Zylinder, wie auch die der Dochte, in der Maßeinheit der „Pariser Linie“ angegeben wird.

Empfehlung: Damit eine Petroleumlampe rußfrei brennt, sollte man nach dem Anzünden fünf Minuten warten, ehe man den Docht auf maximale Lichtstärke einstellt.

6.8 Geld

Bei einem Blackout fallen alle elektronischen Zahlungssysteme aus. Zahlungen mit EC- oder Kreditkarte sind nicht mehr möglich. Den Menschen wird plötzlich bewusst, dass sie nur noch für Bargeld etwas bekommen und versuchen, an den Geldautomaten welches zu ziehen. Doch diese Automaten funktionieren nicht. Ob Bankschalter völlig ohne Strom eine Bargeldauszahlung vornehmen können, ist zu bezweifeln. Und selbst wenn Bankfilialen noch für ein paar Stunden notstromversorgt sein sollten, werden sie dem Ansturm nicht gewachsen sein und die Höhe der Auszahlungen begrenzen. In dieser Situation kann das Anwachsen einer kollektiven Angst der Kunden zu einem Bankenrun führen, der dann das Schließen der letzten arbeitsfähigen Filialen zur Folge hat.

Empfehlung: Halten Sie ständig zu Hause eine Summe Bargeld in kleinen Scheinen vor. Die Höhe dieser Summe hängt natürlich von Ihren finanziellen Möglichkeiten ab.

6.9 Wird die Heizung bei einem Blackout noch warm?

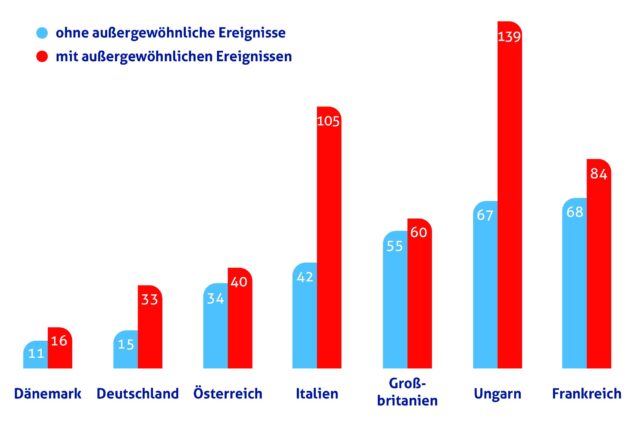

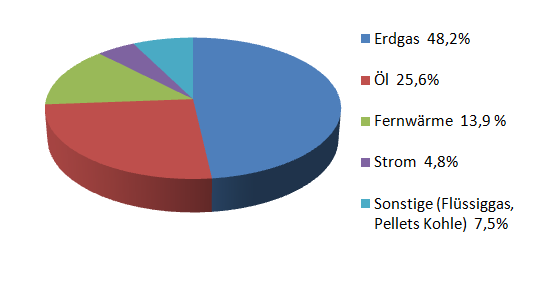

Raumheizungen mit Öfen, welche mit Holz oder Briketts beschickt werden, sind gefeit gegen einen Stromausfall, doch besitzen sie inzwischen Seltenheitswert. Einer BDEW-Studie zum Heizungsmarkt /34/ lassen sich die Angaben für eine Abschätzung jenes Teils der Wohnungen entnehmen, in denen es bei einem Blackout in Deutschland unabänderlich kalt wird (s. Bild 16).

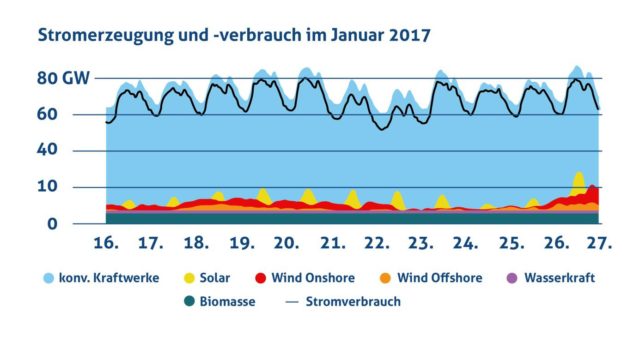

Es steht fest, dass bei einem Stromausfall die drei leitungsgebundenen Heizsysteme mit Strom, Fernwärme und Erdgas ausfallen. Erdgas wird nicht mehr zu den Verbrauchern transportiert, weil die Verdichterstationen in den Leitungen für ihren Betrieb auf elektrischen Strom angewiesen sind. Damit werden bereits rund 67% aller Heizungen kalt.

Die Besitzer von Ölheizungen haben sich ja prinzipiell bevorratet und sind damit erst einmal auf einen Zufluss ihres Energieträgers nicht angewiesen. Ähnlich sieht es bei den „Sonstigen“ aus. Und doch fallen auch bei ihnen die Heizungen aus. Grund dafür ist die Tatsache, dass es sich bei ihnen praktisch immer um Zentralheizungen mit einer elektrischen Steuerung und elektrischen Umwälzpumpen handelt. Aber im Gegensatz zu den ersten 67% aller Heizungsbesitzer können die Besitzer von Heizungen mit Vorratshaltung Vorsorge gegen eine kalte Wohnung treffen – durch Anschaffung eines Notstromaggregats.

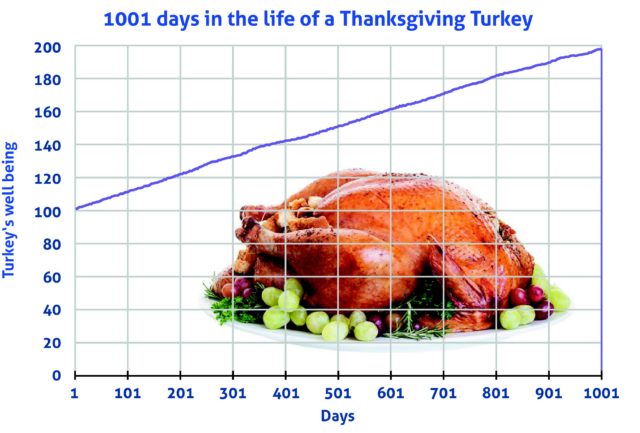

6.10 Notstromversorgung

Der Gedanke liegt nahe: Wenn kein Strom mehr von außen kommt, erzeugt man halt selber welchen; Notstromaggregate gibt es ja in jedem Baumarkt. Doch vor dem Kauf eines solchen Gerätes sind einige Überlegungen anzustellen – die Gefahr, ein ungeeignetes Gerät zu erwerben ist sonst beträchtlich. Die nachstehenden Ausführungen sollen helfen, einen Fehlkauf zu vermeiden.

6.10.1 Welche Leistung wird benötigt?

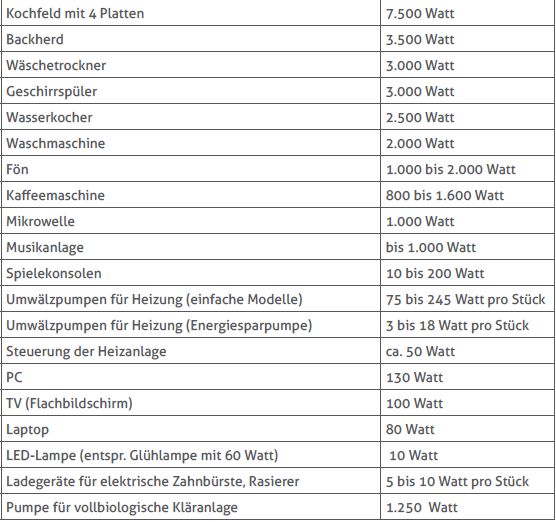

Zunächst sollte man sich eine Übersicht darüber verschaffen, welche elektrische Leistung die in der Wohnung / im Haus vorhandenen Geräte aufnehmen. Dazu gibt die folgende Tabelle eine Hilfestellung:

Für einen langandauernden Stromausfall sollte man keine Notstromversorgung der „Stromfresser“ Kochfeld, Backherd, Wasserkocher, Geschirrspüler, Waschmaschine und Wäschetrockner vorsehen. Der Kraftstoffverbrauch eines Notstromaggregats wäre für ihre Nutzung zu hoch, und es gibt Alternativen (s. Punkt 6.5).

Empfehlung: Überlegen Sie sich, welche Geräte im Falle eines Blackout für Sie unverzichtbar sind, und wie viele davon höchstens gleichzeitig in Betrieb wären.

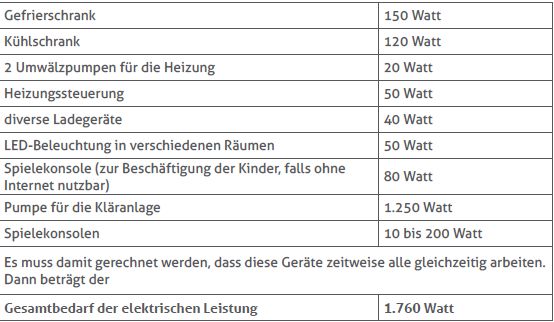

Beispiel: Es soll sich bei dem mit Notstrom zu versorgenden Objekt um ein relativ neues Einfamilienhaus mit voll biologischer Kläranlage und Ölheizung handeln. Die Heizanlage arbeitet mit zwei Strängen. Die Küche ist u. a. mit Kühlschrank und separatem Gefrierschrank ausgestattet.

Annahmen:

– Der Eintritt des Blackouts erfolgt in der kalten Jahreszeit; damit die Ölheizung weiter arbeitet, müssen die Heizungssteuerung und die Umwälzpumpen in den beiden Heizungssträngen mit Strom versorgt werden.

– Propangas und Kocher sind vorhanden.

– Während des Blackout wird verzichtet auf die Nutzung von: Backherd, Mikrowelle, Kaffeemaschine, Wasserkocher, Mikrowelle, Fön, Geschirrspüler, Wäschetrockner, Fernseher (kein Bild), Laptop bzw. PC(kein Internet) und Musikanlage.

Unverzichtbare Geräte:

Über welche Leistung muss ein zu diesem Bedarf passendes Notstromaggregat verfügen? Vom Hersteller wird stets die sogenannte Scheinleistung S als Nennleistung angegeben, die größer ist als die benötigte Wirkleistung P (in unserem Beispiel 1,76 Kilowatt) und mit ihr über den Faktor 0,8 zusammenhängt:

P = 0,8 ∙ S.

Außerdem empfiehlt es sich, zur Bewältigung sogenannter Anlaufströme noch 20% Leistungsreserve zuzugeben. Das Aggregat für unser Beispielobjekt müsste dann eine Nennleistung von S = 1,76 Kilowatt ∙ 1,25 ∙ 1.2 = 2,64 Kilowatt aufweisen. Doch es gibt noch weitere Dinge zu beachten, auf die im folgenden Punkt eingegangen wird.

6.10.2 Lichtstrom oder Drehstrom?

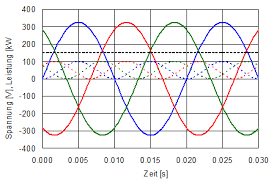

Moderne Häuser und auch Wohnungen sind grundsätzlich mit Dreiphasenstrom (Drehstrom) versorgt. Das bedeutet: Es werden drei spannungsführende Leiter (Phasen genannt) in den Haus- (Wohnungs-) anschluss geführt, deren Wechselspannungen zeitlich gegeneinander versetzt (phasenverschoben) sind, wie Bild 23 zeigt.

Zwischen jeder Phase und dem Nullleiter (Erde) liegt eine Wechselspannung von 220 Volt an; zwischen den Phasen beträgt (wegen der Phasenverschiebung) die Spannung 380 Volt. Die Installation der festverdrahteten Verbraucher und Steckdosen versucht man stets einigermaßen gleichmäßig auf die drei Phasen zu verteilen. Wenn man bei einem Stromausfall die freie Wahl haben möchte, welche Verbraucher vom Notstromaggregat gespeist werden, wird ein Drehstromaggregat benötigt. Ein Drehstromaggregat ist auch erforderlich, wenn nur ein einziger (beim Stromausfall unverzichtbarer) Verbraucher von drei Phasen gespeist wird, wie das häufig bei Pumpen der Fall ist. Die Einspeisung in die drei Phasen von Haus oder Wohnung erfordert eine spezielle Installation.

Empfehlung: Lassen Sie von Ihrem Hauselektriker hinter der Hauseingangs- (Wohnungseingangs-) sicherung einen mit der Hand zu bedienenden Drehstromschalter mit den drei Stellungen „Netz“, „leer“ und „Notstromaggregat“ anbringen.

Empfehlung: Bei Stromausfall schalten Sie dann zunächst alle verzichtbaren Verbraucher aus. Danach starten Sie das Aggregat. Anschließend schalten Sie den Schalter von der Stellung „Netz“ über „leer“ in die Position „Notstromaggregat“.

Eine Automatik für die Einschaltung des Aggregats muss bei der Bundesnetzagentur angemeldet werden.

Nach der vorstehenden Erläuterung der Grundbegriffe des Drehstroms müssen wir noch einmal zu unserem Beispiel zurückkehren, bei dem wir eine Wirkleistung des Notstromaggregats von 1,76 Kilowatt als ausreichend festgestellt hatten. Wenn es sich bei der Kläranlagenpumpe mit einer Leistung von 1,25 Kilowatt nicht um eine Drehstrompumpe, sondern um eine einphasige (Lichtstrom-) Pumpe handelt, ist eine höhere Leistung des Aggregats erforderlich. In jeder Phase des von uns berechneten Aggregats steht nur ein Drittel der Gesamtleistung, also nur 0,59 Kilowatt zur Verfügung, was für den Betrieb der Pumpe nicht ausreicht. In Anbetracht solcher, den Nichtfachmann vermutlich überfordernden Fakten ergeht die

Empfehlung: Lassen Sie sich bei der Auswahl eines Notstromaggregats von der Elektrofachfirma Ihres Vertrauens beraten.

Doch eine Grundsatzentscheidung lässt sich auch ohne Konsultation eines Elektrikers treffen. Wenn Sie während eines Stromausfalls nur wenige Elektrogeräte nutzen wollen, die sämtlich einphasig (mit normaler Netzschnur) zu betreiben sind und von denen keines fest verdrahtet ist, können Sie auch ohne weiteren Aufwand ein Kabel mit mehreren Abgängen von einem einphasigen Notstromaggregat mit ausreichender Leistung zu diesen Verbrauchern führen.

Empfehlung: Wenn elektronische Geräte betrieben werden sollen, bevorzugen Sie ein Gerät mit AVR-Regelung. Dabei wird die Spannung des Generators unabhängig von der Belastung weitgehend konstant gehalten.

Empfehlung: Wenn Sie ein Aggregat mit Batteriestarter erworben haben, sollten Sie ein passendes Ladegerät für die Erhaltungsladung der Batterie installieren, damit das Gerät stets betriebsbereit ist.

Es versteht sich von selbst, dass die Abgase eines Notstromaggregats so ins Freie abzuleiten sind, dass sie weder eine Gefährdung für Menschen, noch eine Brandgefahr darstellen. Ein Beispiel zeigt Bild 24:

Von vielen Herstellern der Notstromaggregate wird ein halbjährlicher Probebetrieb unter Last empfohlen. Weil Notsituationen generell geübt werden sollten, legt dies eine weitere Empfehlung nahe.

Empfehlung: Opfern Sie wenigstens einmal einen Tag für eine komplette Notfallübung. Sie ist zwar unbequem, aber lehrreich. Beginnen Sie die Übung am besten an einem Samstagabend und beenden Sie diese am Nachmittag des folgenden Tages.

<Folge 7 kommt demnächst> Teil 1 steht hier, Teil 2 hier, Teil 3 hier, Teil 4 hier, Teil 5 hier

—————————————-

Hinweis: Das PDF mit dem vollständigen Inhalt ist beigefügt. Es kann aber auch beim Kaleidoscriptum-Verlag berstellt werden (www.kaleidoscriptum-verlag.de)