Aktuelles Grand Solar Minimum wird globale Abkühlung bringen

In diesem Leitartikel werde ich anhand des neu entdeckten Proxy-Magnetfeldes für die Sonnenaktivität zeigen, dass die Sonne in das moderne Grand Solar Minimum (2020-2053) eingetreten ist, das zu einer signifikanten Reduktion des solaren Magnetfeldes und der Aktivität wie während des Maunder-Minimums führen wird, was zu einer spürbaren Abkühlung der Erdtemperatur führt.

Die Sonne ist die Hauptenergiequelle für alle Planeten des Sonnensystems. Diese Energie wird der Erde in Form von Sonnenstrahlung in verschiedenen Wellenlängen zugeführt, die als Total Solar Irradiance (TSI) bezeichnet wird. Die Schwankungen der solaren Bestrahlungsstärke führen zur Erwärmung der oberen Planetenatmosphäre und zu komplexen Prozessen des solaren Energietransports zur Planetenoberfläche.

Die Zeichen der Sonnenaktivität werden aus den zyklischen 11-Jahres-Schwankungen der Anzahl der Sonnenflecken auf der Sonnenoberfläche abgeleitet, wobei die gemittelte monatliche Anzahl der Sonnenflecken als Proxy für die Sonnenaktivität der letzten 150 Jahre verwendet wird. Die Sonnenzyklen wurden durch die Wirkung des solaren Dynamo-Mechanismus im Sonneninneren beschrieben, der magnetische Stränge am Boden der solaren Konvektionszone erzeugt.

Diese magnetischen Stränge wandern durch das Sonneninnere und erscheinen auf der Sonnenoberfläche, oder Photosphäre, als Sonnenflecken, die die Fußpunkte anzeigen, an denen diese magnetischen Stränge in die Photosphäre eingebettet sind.

Das Magnetfeld der Sonnenflecken bildet ein toroidales Feld, während das solare Hintergrundmagnetfeld ein poloidales Feld bildet. Der Solardynamo wandelt zyklisch das poloidale Feld in ein toroidales um und erreicht sein Maximum bei einem Sonnenzyklus-Maximum und dann das toroidale Feld zurück in das poloidale zu einem Sonnen-Minimum. Es ist offensichtlich, dass für die gleiche führende Polarität des Magnetfeldes in Sonnenflecken auf der gleichen Hemisphäre die Länge des Sonnenzyklus auf 22 Jahre verlängert werden sollte.

Trotz des Verständnisses des allgemeinen Bildes eines Sonnenzyklus war es ziemlich schwierig, die beobachteten Sonnenfleckenzahlen mit den modellierten in Einklang zu bringen, es sei denn, der Zyklus ist schon weit fortgeschritten. Diese Schwierigkeit ist ein deutlicher Hinweis auf einige fehlende Punkte in der Definition der Sonnenaktivität durch Sonnenfleckenzahlen, die unsere Aufmerksamkeit auf die Erforschung des solaren (poloidalen) Hintergrundmagnetfeldes (SBMF) lenkte [1].

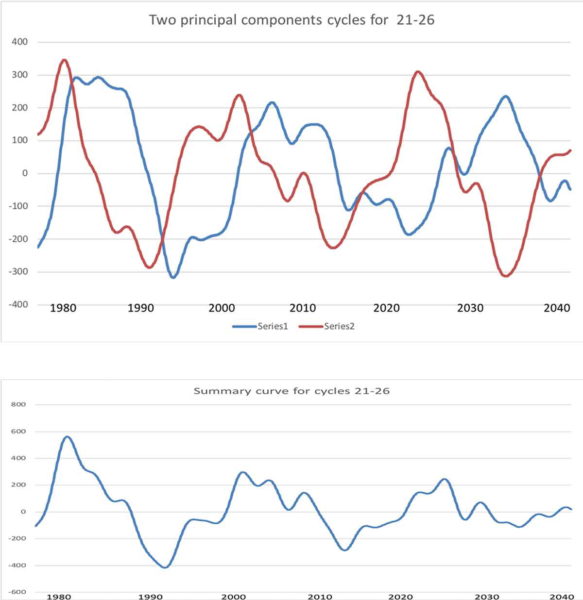

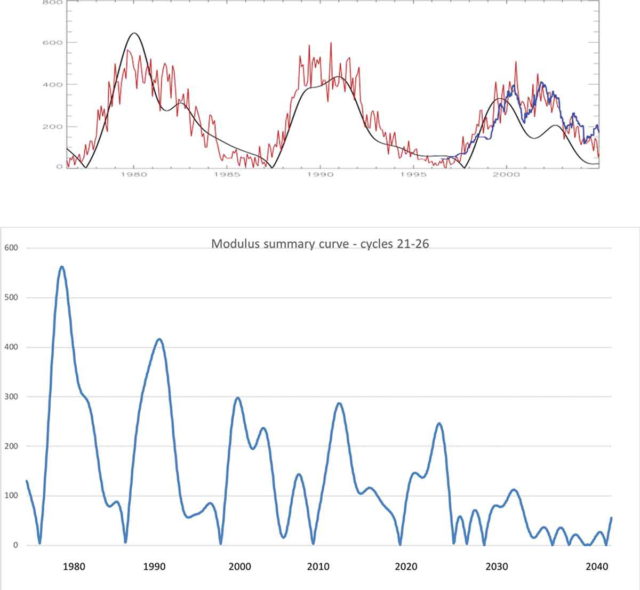

Durch Anwendung der Principal Component Analysis (PCA) auf die niedrig aufgelösten Magnetogramme der gesamten Sonnenscheibe, die in den Zyklen 21-23 vom Wilcox Solar Observatory aufgezeichnet wurden, entdeckten wir nicht eine, sondern zwei Hauptkomponenten dieses solaren Hintergrundmagnetfeldes (siehe Abbildung 1, oberes Diagramm), die mit zwei magnetischen Wellen verbunden sind, die durch rote und blaue Linien markiert sind. Die Autoren leiteten mathematische Formeln für diese beiden Wellen ab, indem sie die Hauptkomponenten aus den Daten der Zyklen 21-23 mit der Reihe der periodischen Funktionen anpassten und diese Formeln zur Vorhersage dieser Wellen für die Zyklen 24-26 verwendeten. Es wurde festgestellt, dass diese beiden Wellen in verschiedenen Schichten des Sonneninneren erzeugt werden und nahe, aber nicht gleiche Frequenzen erreichen [1]. Die Summenkurve dieser beiden magnetischen Wellen (Abbildung 1, unterer Plot) zeigt die Interferenz dieser Wellen, die Maxima und Minima der Sonnenzyklen bilden.

Die Summenkurve zweier magnetischer Wellen erklärt viele Merkmale der 11-Jahres-Zyklen, wie z.B. Doppelmaxima in einigen Zyklen oder Asymmetrie der Sonnenaktivität in den gegenüberliegenden Hemisphären während verschiedener Zyklen. Zharkova et al. [1] verknüpften die Summenkurve des Moduls mit den gemittelten Sonnenfleckenzahlen für die Zyklen 21-23, wie in Abbildung 2 (oberer Plot) gezeigt, und erweiterten diese Kurve auf die Zyklen 24-26, wie in Abbildung 2 (unterer Plot) gezeigt. Es scheint, dass die Amplitude des zusammengefassten solaren Magnetfeldes, die in der Summenkurve dargestellt ist, in Richtung der Zyklen 24-25 abnimmt und im Zyklus 26 fast Null wird.

Zharkova et al. [1] schlugen vor, die Summenkurve als neuen Proxy für die Sonnenaktivität zu verwenden, der nicht nur die Amplitude eines Sonnenzyklus‘, sondern auch dessen führende magnetische Polarität des solaren Magnetfeldes markiert.

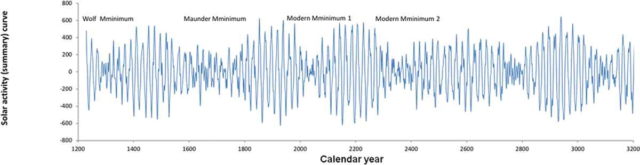

Abbildung 3 zeigt die Summenkurve, die mit den abgeleiteten mathematischen Formeln für die kommenden 1200 Jahre und für die letzten 800 Jahre berechnet wurde. Diese Kurve zeigt das Auftreten von Großen Solarzyklen alle 350-400 Jahre, die durch die Interferenz von zwei magnetischen Wellen verursacht werden. Diese großen Zyklen werden durch die großen solaren Minima, oder Perioden sehr geringer Sonnenaktivität, getrennt [1]. Das vorhergehende große Sonnenminimum war das Maunder-Minimum (1645-1710), und das andere davor hieß Wolf-Minimum (1270-1350). Wie in Abbildung 3 aus der Vorhersage von Zharkova et al. [1] zu sehen ist, nähern sich in den nächsten 500 Jahren zwei moderne große solare Minima der Sonne: das moderne im 21. Jahrhundert (2020-2053) und das zweite im 24 Jahrhundert (2370-2415)

Die beobachteten Eigenschaften der beiden magnetischen Wellen und ihre Summenkurve wurden durch doppelte Dynamowellen, die von dipolaren magnetischen Quellen in zwei Schichten des Sonneninneren erzeugt werden, eng aneinander angepasst: innere und äußere Schichten [1], während andere drei Paare magnetischer Wellen von vierfachen, sechsfachen und achtfachen magnetischen Quellen erzeugt werden können, wobei die dipolare Quelle das sichtbare Erscheinungsbild der Sonnenaktivität an der Oberfläche bestimmt.

Derzeit hat die Sonne den Sonnenzyklus 24 abgeschlossen – den schwächsten Zyklus seit über 100 Jahren – und im Jahr 2020 beginnt der Zyklus 25. Während der Perioden geringer Sonnenaktivität, wie dem derzeitigen großen solaren Minimum, ist die Sonne oft frei von Sonnenflecken. Dies wird nun zu Beginn dieses Minimums beobachtet, denn im Jahr 2020 hat die Sonne bis August 115 fleckenfreie Tage (oder 78 %) gesehen, was bedeutet, dass 2020 auf dem besten Weg ist, den Weltraumrekord von 281 fleckenfreien Tagen (oder 77 %) für das gesamt Jahr zu übertreffen, der im Jahr 2019 beobachtet wurde. Der Start des Zyklus 25 ist jedoch immer noch langsam im Auftreten aktiver Regionen und Flares, so dass mit jedem zusätzlichen Tag/Woche/Monat, der vergeht, die Null in der Sonnenaktivität verlängert wird, was den Beginn des großen solaren Minimums markiert.* Welche Folgen hat dieser Rückgang der Sonnenaktivität für die Erde?

[*Der Beitrag datiert vom August 2020. Die aktuell immer noch fleckenfreie Sonne unterstreicht diese Aussagen. A. d. Übers.]

Die verringerte TSI während des Maunder-Minimums

Betrachten wir jetzt das Verhalten der Sonneneinstrahlung während des letzten großen Sonnenminimums – dem Maunder-Minimum. Während dieses Zeitraums erschienen nur sehr wenige Sonnenflecken auf der Sonnenoberfläche, und die Gesamthelligkeit der Sonne war leicht verringert.

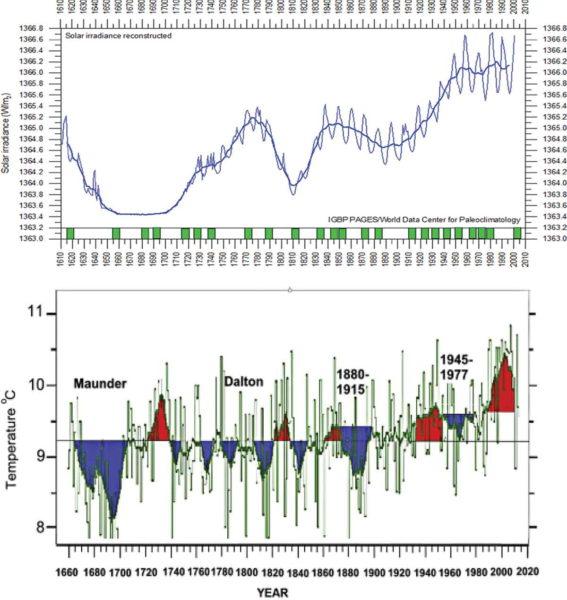

Die Rekonstruktion der zyklusgemittelten solaren TSI zurück bis ins Jahr 1610 (Abbildung 4, oberes Diagramm) deutet auf eine Abnahme der TSI während des Maunder-Minimums um einen Wert von etwa 3 W/m² [2] hin, was etwa 0,22 % der gesamten solaren Bestrahlungsstärke im Jahr 1710 entspricht, nachdem das Maunder-Minimum beendet war.

Temperaturrückgang während des Maunder-Minimums

Von 1645 bis 1710 sanken die Temperaturen in weiten Teilen der nördlichen Hemisphäre der Erde, als die Sonne in eine Ruhephase eintrat, die heute als Maunder-Minimum bezeichnet wird. Dies geschah wahrscheinlich, weil die TSI um 0,22 % reduziert wurde, wie in Abbildung 4 (oberer Plot) [2] dargestellt, was zu einem Rückgang der durchschnittlichen Erdtemperatur, die hauptsächlich auf der Nordhalbkugel in Europa gemessen wurde, um 1,0-1,5 °C führte, wie in Abbildung 4 (unterer Plot) [3] dargestellt. Dieser scheinbar geringe Rückgang der Durchschnittstemperatur in der nördlichen Hemisphäre führte zu zugefrorenen Flüssen, kalten langen Wintern und kühlen Sommern.

Die Oberflächentemperatur der Erde sank überall auf dem Globus (siehe Abbildung 1 in [4]), besonders in den Ländern der nördlichen Hemisphäre. Europa und Nordamerika gerieten in eine Frostperiode: Die Alpengletscher dehnten sich über das Ackerland in den Tälern aus; das Meereis kroch von der Arktis nach Süden; die Flüsse Donau und Themse froren in diesen Jahren regelmäßig zu, ebenso wie die berühmten Kanäle in den Niederlanden.

Shindell et al. [4] konnten nachweisen, dass der Temperaturrückgang mit der Abnahme der Ozonmenge zusammenhängt, die durch das ultraviolette Licht der Sonne in der Stratosphäre gebildet wird, also der Schicht der Atmosphäre zwischen 10 und 50 Kilometern Höhe. Da die Sonne während des Maunder-Minimums insgesamt weniger Strahlung emittierte, einschließlich der starken ultravioletten Emission, wurde weniger Ozon gebildet, was sich auf die planetarischen hemisphärischen Wellen, die riesigen Mäander im Jetstream, auswirkte.

Shindell et al. [4] vermuten auf S. 2150, dass „eine Veränderung der planetarischen Wellen während des Maunder-Minimums die Nordatlantische Oszillation (NAO) – das Gleichgewicht zwischen einem permanenten Tiefdrucksystem in der Nähe von Grönland und einem permanenten Hochdrucksystem in seinem Süden – in eine negative Phase brachte, die dazu führte, dass es in Europa während des MM ungewöhnlich kalt blieb.“

Die Rolle des Magnetfeldes bei der terrestrischen Abkühlung in Grand Solar Minima

Doch nicht nur die Sonnenstrahlung zeigte sich während des Maunder-Minimums verändert. Es gibt noch einen weiteren Beitrag zur Reduzierung der Erdtemperatur während des Maunder-Minimums – das ist das solare Hintergrundmagnetfeld, dessen Rolle bisher übersehen wurde. Nach der Entdeckung [1] einer signifikanten Reduktion des Magnetfeldes im bevorstehenden modernen großen Sonnenminimum und während des Maunder-Minimums wurde erkannt, dass das solare Magnetfeld die Stärke der kosmischen Strahlung steuert, welche die planetaren Atmosphären des Sonnensystems einschließlich der Erde erreicht. Eine signifikante Reduktion des solaren Magnetfeldes während des großen solaren Minimums wird zweifellos zu einer Erhöhung der Intensität der galaktischen und extra-galaktischen kosmischen Strahlung führen, die wiederum zur Bildung von hohen Wolken in den terrestrischen Atmosphären führt und zur Abkühlung der Atmosphäre beiträgt, wie Svensmark et al. gezeigt haben [5].

Im letzten solaren Minimum zwischen den Zyklen 23 und 24 nahm die Intensität der kosmischen Strahlung um 19% zu. Gegenwärtig nimmt das in Abbildung 1 von Zharkova et al. [1] vorhergesagte solare Magnetfeld in der Sonne radikal ab, was wiederum zu einem starken Rückgang des interplanetaren Magnetfeldes der Sonne auf nur noch 4 nanoTesla (nT) von typischen Werten von 6 bis 8 nT führt. Diese Abnahme des interplanetaren Magnetfeldes führt natürlich zu einem signifikanten Anstieg der Intensität der kosmischen Strahlung, die in die Atmosphären der Planeten eindringt, wie von den jüngsten Weltraummissionen berichtet wird [6]. Daher schreitet dieser Prozess der Verringerung des solaren Magnetfeldes voran, wie von Zharkova et al. vorhergesagt [1], und sein Beitrag wird von den planetarischen Atmosphären, einschließlich der Erde, absorbiert werden. Dies kann die terrestrische Temperatur während des modernen großen solaren Minimums, das bereits im Jahr 2020 begonnen hat, verringern.

Der erwartete Rückgang der terrestrischen Temperatur während des derzeitigen Grand Solar Minimums

Diese Summenkurve zeigte auch das bevorstehende moderne große Sonnenminimum 1 in den Zyklen 25-27 (2020-2053) und das moderne große Sonnenminimum 2 (2370-2415) an. Dies wird in der modernen Zeit die einzigartigen niedrigen Aktivitätsbedingungen der Sonne bringen, die während des Maunder-Minimums auftraten. Es wird erwartet, dass während des modernen großen Sonnenminimums die Sonnenaktivität deutlich reduziert sein wird, wie dies während des Maunder-Minimums der Fall war (Abbildung 4, untere Grafik). Ähnlich wie beim Maunder-Minimum wird die Verringerung des solaren Magnetfelds, wie oben beschrieben, eine Abnahme der solaren Bestrahlungsstärke um etwa 0,22 % für die Dauer von drei Sonnenzyklen (25-27) für das erste moderne große Minimum (2020-2053) und vier Sonnenzyklen ab dem zweiten modernen großen Minimum (2370-2415) verursachen.

Dies wiederum kann während der nächsten drei Zyklen (25-27) des großen Minimums 1 zu einem Absinken der terrestrischen Temperatur um bis zu 1,0°C gegenüber der aktuellen Temperatur führen. Die stärksten Abkühlungsphasen werden während der lokalen Minima zwischen den Zyklen 25-26 und den Zyklen 26-27 auftreten, wenn das niedrigste Niveau der Sonnenaktivität erreicht wird, wenn man die Abschätzungen in Abbildung 2 (unterer Plot) und Abbildung 3 verwendet. Daher kann die Durchschnittstemperatur in der nördlichen Hemisphäre um bis zu 1,0°C im Vergleich zur aktuellen Temperatur sinken, die seit dem Maunder-Minimum um 1,4°C gestiegen war. Dies wird dazu führen, dass die Durchschnittstemperatur nur noch 0,4°C über der im Jahr 1710 gemessenen Temperatur liegt. Dann, nachdem das heutige große solare Minimum 1 vorbei ist, wird sich die Sonnenaktivität im Zyklus 28 in dem eher kurzen, aber kräftigen großen Sonnenzyklus zwischen 2053 und 2370 wieder normalisieren, wie in Abbildung 3 dargestellt, bevor es im Jahr 2370 zum nächsten großen solaren Minimum 2 kommt.

Conclusions

In diesem Leitartikel habe ich gezeigt, dass die jüngsten Fortschritte beim Verständnis der Rolle des solaren Hintergrundmagnetfeldes bei der Bestimmung der Sonnenaktivität und bei der Quantifizierung der beobachteten Größen des Magnetfeldes zu verschiedenen Zeiten eine zuverlässige langfristige Vorhersage der Sonnenaktivität auf einer Zeitskala von einem Jahrtausend ermöglichen. Dieser Ansatz zeigte, dass es nicht nur 11-jährige Sonnenzyklen gibt, sondern auch große Sonnenzyklen mit einer Dauer von 350-400 Jahren. Wir konnten zeigen, dass diese großen Zyklen durch die Interferenzen zweier magnetischer Wellen mit nahe beieinander liegenden, aber nicht gleichen Frequenzen gebildet werden, die durch die doppelte solare Dynamowirkung in unterschiedlichen Tiefen des Sonneninneren erzeugt werden. Diese großen Zyklen werden immer durch große solare Minima vom Typ des Maunder-Minimums getrennt, die in der Vergangenheit regelmäßig auftraten und die bekannten Maunder-, Wolf-, Oort-, Homeric- und andere große Minima bildeten.

Während dieser großen solaren Minima kommt es zu einer signifikanten Reduktion des solaren Magnetfeldes und der solaren Bestrahlungsstärke, die die Reduktion der terrestrischen Temperaturen erzwingen, die für diese Zeiträume aus der Analyse der terrestrischen Biomasse während der letzten 12.000 oder mehr Jahre abgeleitet wurden. Das jüngste große solare Minimum trat während des Maunder-Minimums (1645-1710) auf, das zu einer Verringerung der solaren Bestrahlungsstärke um 0,22 % gegenüber der heutigen und zu einer Verringerung der durchschnittlichen terrestrischen Temperatur um 1,0-1,5 °C führte.

Diese Entdeckung der doppelten Dynamowirkung in der Sonne brachte uns eine rechtzeitige Warnung vor dem bevorstehenden großen solaren Minimum 1, wenn das solare Magnetfeld und seine magnetische Aktivität um 70% reduziert sein werden. Diese Periode hat in der Sonne im Jahr 2020 begonnen und wird bis zum Jahr 2053 andauern. Während dieses modernen großen Minimums würde man eine Reduktion der durchschnittlichen terrestrischen Temperatur um bis zu 1,0°C erwarten, insbesondere während der Perioden der solaren Minima zwischen den Zyklen 25-26 und 26-27, z.B. in der Dekade 2031-2043.

Die Verringerung der terrestrischen Temperatur während der nächsten 30 Jahre kann für verschiedene Teile des Planeten wichtige Auswirkungen auf die wachsende Vegetation, die Landwirtschaft, die Nahrungsmittelversorgung und den Heizbedarf sowohl in der nördlichen als auch in der südlichen Hemisphäre haben. Diese globale Abkühlung während des bevorstehenden großen solaren Minimums 1 (2020-2053) kann für drei Jahrzehnte jegliche Anzeichen einer globalen Erwärmung ausgleichen und würde zwischenstaatliche Anstrengungen erfordern, um Probleme mit der Wärme- und Nahrungsmittelversorgung für die gesamte Erdbevölkerung anzugehen.

References

- ZharkovaVV, ShepherdSJ, PopovaE, et al. Heartbeat of the sun from principal component analysis and prediction of solar activity on a millennium timescale. Sci Rep. 2015;5:15689. Available from: https://www.nature.com/articles/srep15689 [Crossref], [PubMed], [Web of Science ®], [Google Scholar]

- LeanJL, BeerJ, BradleyR. Reconstruction of solar irradiance since 1610: implications for climatic change. Geophys Res Lett. 1995;22:3195–3198. [Crossref], [Web of Science ®], [Google Scholar]

- EasterbrookDJ. Cause of global climate changes. In: Evidence-based climate science. 2nd ed. Elsevier Inc.; 2016. p. 245–262. [Crossref], [Google Scholar]

- ShindellDT, SchmidtGA, MannME, et al. Solar forcing of regional climate change during the Maunder minimum. Science. 2001;294:2149. [Crossref], [PubMed], [Web of Science ®], [Google Scholar]

- SvensmarkH, EnghoffMB, ShavivNJ, et al. Increased ionization supports growth of aerosols into cloud condensation nuclei. Nat Comms. 2017;8:2199. [Crossref], [PubMed], [Web of Science ®], [Google Scholar]

- SchwadronNA, RahmanifardF, WilsonJ, et al. Update on the worsening particle radiation environment observed by CRaTER and implications for future human deep-space exploration. Space Weather. 2018;16:289–303. [Crossref], [Web of Science ®], [Google Scholar]

Link: https://www.tandfonline.com/doi/full/10.1080/23328940.2020.1796243

Übersetzt von Chris Frey EIKE

Anmerkung des Übersetzers: Noch einmal: der Beitrag datiert vom August 2020. Die gerade zu Ende gegangene 14-tägige Folge ohne Sonnenflecken unterstreicht die Aussagen der Autorin, auch wenn heute (19.2.) erstmals wieder Sonnenflecken auftauchen.