Energiewende, große Transformation, Green Deal, Klimaschutz: Worum geht es da eigentlich?

Die Deutsche Bank (DB), noch nie mit Empathie für normale Zeitgenossen hervorgetreten, dafür aber stets mit ihren an die Mafia erinnernden Finanzgaukeleien beschäftigt, hat das Thema in einem eigenen Artikel behandelt. Er ist der Bezahlschranke wegen nur teilweise im Global Warming Policy Forum (GWPF) des Anthropologen und Sekretärs der GWPF Benny Peiser (hier) wiedergegeben. Der Artikel hat den Titel „EU Green Deal can only succeed with “a certain degree of eco-dictatorship”, kurz, ohne etwas Diktatur geht es nicht.

Der Artikel-Autor, Eric Heymann, ist leitender Ökonom bei der DB, in Neudeutsch „senior economist beim „Deutsche Bank Research“. Die folgende Beschreibung und der Kommentar des Autors beziehen sich auf die von Benny Peiser gekürzte Version. Der voll umfängliche Originaltext ist trotz angegebenem Link nicht erreichbar.

Ganz allgemein kritisiert Heymann die „unehrliche Debatte“, mit der die EU ihren „Green Deal“ verkaufen will. Er warnt vor dem zu erwartenden massiven Wohlstandsverlust der Bevölkerung infolge des „Green Deal“, vor den sich daraus ergebenden politischen Folgen und fragt „sind wir zu einer ehrlichen Diskussion bereit„? Wer mit „wir“ gemeint ist, wird dabei nicht ganz klar. Auf jeden Fall erscheint dieser Artikel für eine Bank untypisch, sind EU-Banken doch auf das Wohlwollen Brüssels angewiesen. Man fragt sich daher bei der Diskussions-Frage Heymanns: ist er etwa auf dem beruflichen Absprung, oder ist dieser, scharf die EU angehende Artikel tatsächlich mit seinem Arbeitgeber abgesprochen? Wir wissen es nicht.

Im ersten Absatz „A certain degree of eco-dictatorship will be necessary” wird geschildert, was die EU mit dem „Green Deal“ vorhat. Im Klartext: Die nochmalige Verteuerung von CO2-Erzeugung auf allen nur denkbaren Ebenen. Eric Heymann spricht es erstaunlich frei aus: Der von der EU in Gang gesetzte „Green Deal“ kann ohne eine gehörige Portion Diktatur nicht funktionieren. Zwar sei von einer neuen Wachstumsstrategie die Rede, aber diese würde der EU-Bevölkerung sehr viel abverlangen und ihren Lebensstandard erheblich verringern. Heymann hat Recht, Wachstum und gleichzeitig sinkender Lebensstandard, wie das denn? Meine Antwort im Kommentar weiter unten.

Im Absatz „Loss of competitivness or restrictions to free trade” geht Heymann dann ans Eingemachte. Niemand könne sich heraushalten, denn jeder für den “Klimaschutz” ausgegebene Euro sei für Bildung, Forschung, Gesundheit usw. verloren, also für uns alle. Heymann fragt schließlich ein wenig naiv „Sind wir willens, dies alles für Klimaschutz auszugeben“? Die Bevölkerungsmehrheit ist es sicher nicht, zumindest dann nicht, wenn man sie korrekt informieren würde.

In „Massive political resistance ahead“ wird Heymann ebenfalls deutlich und spekuliert über die politischen Folgen des „Green Deal“. Er deutet politischen Widerstand und Umbrüche der Parteienlandschaft an, wie wir sie heute bereits mit dem Erscheinen der AfD in Deutschland und ähnlichen Parteien in anderen Europäischen Ländern kennen. Hoffentlich werden seine Spekulationen wahr, werden sich jetzt manche Leser wünschen. Kann man es ihnen angesichts des „Green Deal“ des Wiedergängers der ehemaligen UdSSR als EUdSSR verdenken?

Der Kommentar des Autors zum Artikel von Eric Heymann:

Das durch den „Green Deal“ beschworene Wachstum wird von gleichzeitig sinkendem Lebensstandard begleitet? Was geht da schief? Ohne jetzt gleich Orwellsche Dialektik zu bemühen – Krieg ist Frieden, Schwäche ist Stärke, gut ist ungut usw., Sie kennen das ja sicher – denkt man eher an das erste physikalische Gesetz von Kirchhoff: Was in ein System hineinfließt, muss irgendwo auch wieder herauskommen – falls nichts im System verlorengeht oder verbleibt natürlich.

Mit Sicht auf dieses physikalische Gesetz entsteht die Frage, wo denn nun die Kohle landet, die der „Green Deal“ jedem von uns abknöpft. Ich ahne es schon, die Klugen unter Ihnen haben es wieder erraten. Natürlich bei den Profiteuren des „Green Deal“. Und zu denen gehört insbesondere der unersättliche sozialistische Staat. Zu dieser Art von sozialistischen Staaten sei es erlaubt, heute auch die EU und Merkel-Deutschland zu zählen.

„Unersättlich“, weil Sozialisten zwar wirtschaftlich komplett unfähig, dafür aber besonders begabt sind, das Geld anderer Leute auszugeben. Die entsprechenden Folgen in von Sozialisten regierten Volkswirtschaften kennt jeder, beste Beispiele bieten Kuba, Nordkorea, die DDR und Venezuela. Und natürlich ist zum „Green Deal“ ein wenig Diktatur unabdingbar, wie soll es denn anders anders gehen? Leider wird es bei „ein bisschen“ wohl nicht bleiben. Hier ist Eric Heymann kein Prophet, sondern nüchterner Beobachter. Nun aber zum Grundproblem. Was ist eigentlich passiert?

Die Großfinanz dieser Welt, aber auch die Wirtschaftspolitik westlicher Staaten sind wieder einmal an einem toten Punkt angekommen. Womit kann man noch Geld ohne große Anstrengung verdienen, und woher sollen gerne wiedergewählte Politiker ihre Wahlgeschenke noch hernehmen? Es geht nur mit steigender Produktivität, wobei die asiatischen Tiger gerade dabei sind den Westen zu überholen.

Gute Ideen sind immer schwerer zu finden. Es gibt diese Ideen zwar noch, sie werden aber immer schräger – wie beispielsweise Beispiel die von Elon Musk mit seinem Tesla. Niemand will zwar E-Autos kaufen, denn diese Dinger sind die technische Inkarnation von Nutzlosigkeit (Reichweite, Tankprobleme, woher soll der Strom kommen) und Umweltschädlichkeit (Batterien, Brandgefahr). Wenn man aber geschickt auf politischen Wellen reitet, kann es klappen. Die Aktien von Tesla haben Musk zum reichsten Bewohner unseres Planeten gemacht. Man muss jetzt nicht gleich an Wirecard denken, aber Tesla-Aktienbesitzer sollten vielleicht doch …, Pardon, als Aktien-Nichtversteher nehme ich das wieder zurück.

Nun zur optimalen Lösung des Produktionsproblems. Sie ist nichts Anderes als genial verpackter Betrug an der Bevölkerung, also Betrug an denen, von denen am meisten zu holen ist. Genauer gesagt, sind das Sie. Man vergrößert nicht mehr die Produktivität, weil man die dazu notwendigen Grundlagen von Ausbildung bis Infrastruktur zugunsten von Wahlgeschenken hat verkommen lassen, sondern man verteilt um und zerstört noch konsequenter als es bisher schon geschah.

Zum Plan der Betrüger: Die Verantwortlichen, im Wesentlichen die Großfinanz und ihr riesiges, nicht sehr sympathisches Gefolge von Politik, Neppern, Schleppern und Bauerfängern haben sich drei einfache geniale Schritte einfallen lassen, die vor aller Augen offen ablaufen:

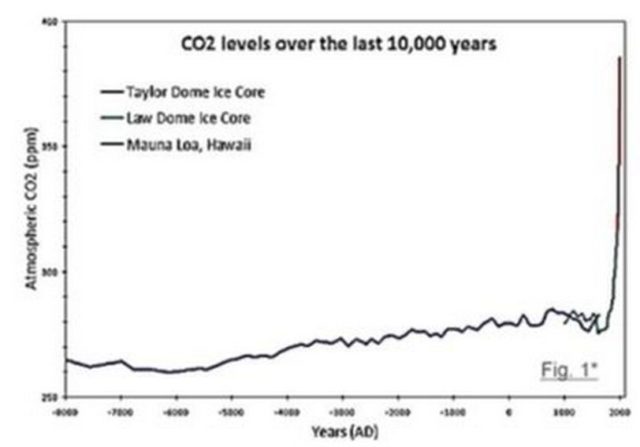

- Man erzeuge ausreichend Angst vor einem nicht existierenden Problem. Dieses ist aktuell der natürliche Klimawandel, den man nach erfolgreichem mittelalterlichen Vorbild (Hexenglaube) der Schuld des Menschen zuschreibt: Inseln versinken, wir werden alle an Überhitzung verbraten, die Meere versauern,… Sie kennen diesen Unsinn ja zur Genüge. Er funktioniert, denn die Natur tobt sich nun einmal oft in für uns Menschen katastrophalen Exzessen aus. Selber kennt die Natur keine Katastrophen. Infolgedessen läßt sich seit Bestehen der Menschheit jeder durch die Natur verursachte Schaden an uns durch unsere eigene Schuld erklären und wird, weil es am einfachsten klingt, gerne geglaubt.

- Man biete Erlösung von dieser Schuld an, die völliger Unsinn sein muss. Aktuell sind es CO2-Einsparungen. Warum Unsinn? Weil reale Lösungen gegen die oft schädlichen Folgen des natürlichen Klimawandels, wie beispielsweise höhere Deiche, auf Wirksamkeit und Kosten überprüft werden können. Reale Lösungen sind für den Betrug ungeeignet. Die Wirkung von CO2-Einsparung und der damit verbundenen geringen Erwärmung kennt dagegen niemand, vermutlich ist sie unbedeutend oder sogar positiv, wenn man das verstärkte Pflanzenwachstum bei mehr CO2 berücksichtigt. Etwas Besseres ist also kaum denkbar.

- Man überzeuge den maßgebenden Teil der Wähler, dass das Scheinproblem nur mit der angebotenen Unsinnslösung „Klimaschutz“, „Energiewende, „Green Deal“ etc. behoben werden kann und erstelle dann nur noch die Pipelines, welche das der Bevölkerung entwendete Geld in eigene Taschen fließen lässt.

Wer nun meint, so etwas sei angesichts des heutigen Bildungsstandes schwierig umzusetzen, wird schnell eines Besseren belehrt. Mit dem Argument „Naturschutz“ erzielt man die besten Erfolge bei dem Teil der Bevölkerung, der bekanntlich weniger mit gesundem Menschenverstand gesegnet ist. Er ist die Mehrheit. Hier muss nun doch an Dialektik erinnert werden, denn die Grünen, ehemalige Naturschützer, sind heute mit ihren Windrädern und Energiemaisfeldern zu den größten Naturzerstörern überhaupt geworden und zu roten Sozialisten zudem, ohne dass ihnen dies im Geringsten die Wählergunst vermasselt. Chapeau, das muss man erst einmal hinbekommen.

Dialektik funktioniert also! Natürlich will jeder Naturschutz, sicher besonders die Gutwilligen und nur schwer Begreifenden, welched den Betrug nicht erkennen. Der erstaunliche Erfolg der so einfachen Strategie ist also nachvollziehbar. Schwer Begreifende kommen mit produktiver Arbeit schlechter zurecht, weil diese Grips, Kenntnisse und jahrelange Anstrengung erfordert. Ideologische Einflüsterungen bieten leichtere Wege an.

Deutschland bildet dieses hier nur knapp umrissene Szenario mustergültig ab. Seit 1968 hat sich durch geschickte Grünpropaganda, durch aktives stetiges Absenken der Allgemeinbildung (Schulen und Medien) und mit dem Marsch durch die Institutionen ein ausreichender grüner Bodensatz für den „Green Deal“ gebildet. Es könnte nur problematisch werden, wenn dieser heute vermutlich meist öffentlich alimentierte Teil der Bevölkerung seine Bezüge durch den „Green Deal“ schwinden sieht.

Schließlich gilt immer noch gemäß dem schon erwähnten Physiker Kirchhoff – was dem Einem zugute kommt, muss dem Anderen weggenommen werden. Produktives Wachstum, wie von grünsozialistischen Phantasten erwartet, kann es mit dem „Green Deal“ nicht geben. Das ist so unmöglich wie den Berg hinauffließendes Wasser. Pure industrielle Zerstörung als Synonym für „Green Deal“ ist nicht mit steigender Produktivität zu verwechseln. Man wird diesen Trick dialektisch versuchen, aber die Folgen und deren Verständnis holen zuletzt auch die Dümmsten ein – nur ist es dann für alle zu spät.

Es kommt noch etwas dazu: Insbesondere den Gutgläubigen kann man mit Hilfe der staatsfügsamen Medien inzwischen alles erzählen. Die Auffassung, es sei richtig, was in den Zeitungen steht und was die Staatsmedien von sich geben, ist bis zur wieder einmal auftretenden Katastrophe unausrottbar. Es ist eine fatale Kette, die offenbar nicht enden will – Kaiserreich, national Sozialismus, DDR-Kommunismus und nun Ökosozialismus. Da inzwischen auch die Mehrheit der Akademiker zu den Zeitgenossen mit wenig selbständigem Denkvermögen gehören, darf nicht verwundern, dass gerade der akademische Bereich der grünen Verführung sperrangelweit offensteht. Diskutieren Sie doch mal mit einer grün gepolten Gymnasiallehrerin über Klimaschutz und Energiewende! Die immer wieder auftauchenden Plagiate, mit welchen sich Politiker beiden Geschlechts den Dr. -Titel betrügerisch aneignen wollten, sind Fußnoten, welche die hier angesprochene akademische Dekadenz bestätigen. Heute gehört Promotionsbetrug fast schon zum guten Ton auf dem politischen Parkett. Politiker, die dabei erwischt werden, denken nicht mehr daran zurückzutreten.

Es ist ein schwerwiegender Irrtum, Akademikern höhere praktische Intelligenz zuzuschreiben als den vorgeblich einfachen Leuten. Das genaue Gegenteil ist der Fall. Wer sein Brot hart verdient und den „Laden am Laufen hält“, dem braucht man nicht mehr mit dem Quatsch „Klimaschutz“ oder „Energiewende“ zu kommen. Falls davon profitiert wird, wie z.B. von Handwerkern, die Solarunsinn auf Dächer schrauben, geht es um schlichten Lebensunterhalt. Das ist in Ordnung. Man schraubt das Ding ordentlich aufs Dach und hält die Klappe, obschon man es meist besser weiß.

Die mit selbständigem Denkvermögen am miserabelsten versehenen Grün-Verführten sind zweifellos rot-grün gepolte Journalisten, die immer noch an die Verheißungen von Marx und an das Grünparadis ohne Gentechnik und Kernenergie glauben. Sie werden von den in den Radio- und TV-Gremien sitzenden Ideologen an die passenden Stellen lanciert und gehätschelt, solange sie pflichtgemäß den Medienkonsumenten täuschen. Schert einer aus, „hat er beruflich fertig“. Daher steht heute in den Medien die richtige Haltung, aber nicht mehr eine neutral-objektive Berichterstattung in Konjunktur.

Und so schließt sich der Kreis. Alle glauben allmählich den gleichen Ökounsinn, denn Wohlfühlkonsens ist eine Humankonstante. Daher ist es nicht mehr schwer, Fachleuten, die lediglich auf solider wissenschaftlicher Basis die Wahrheit berichten (zum Beispiel Thilo Sarrazin über die Folgen ungebremster Migration) auszugrenzen, Parteimitgliedschaften zu entziehen und schlussendlich als Nazis zu diffamieren. Deutschland ist hier freilich nur Nachahmer. In den USA erwischte es jetzt sogar einen US-Präsidenten, der das Spiel der Großfinanz nicht mitmachte (hier), (hier). Sein Nachfolger geht wieder an der Leine mit erster Amtsankündigung über die Wiederbelebung des Klimabetrugs.

Es wird wohl noch eine Weile dauern, bis auch der Letzte begriffen hat, dass das, was alle glauben, in aller Regel falsch ist. So schreibt der Diplomat und Schriftsteller Jean Giraudoux (1882-1944): „Einen Irrtum erkennt man daran, dass alle Welt ihn teilt„. Ähnlich urteilt der Philosoph und Lyriker Paul Valery (1871-1945): „Was von allen akzeptiert wird, ist aller Wahrscheinlichkeit nach falsch„. Aber auch der deutsche Reichskanzler Otto von Bismarck (1815-1898) wusste über diese Zusammenhänge bestens Bescheid: „Es ist nichts schwerer als gegen Lügen vorzugehen, die die Leute glauben wollen„.

Zum Abschluss sei noch angemerkt, dass der „Green Deal“ inzwischen weiter fortgeschritten ist, als es sich viele vorstellen. Durch entsprechenden politischen und EU-gesetzlichen Druck sind heute Banken verpflichtet, Kredite vorrangig nur noch an Firmen zu vergeben, die „grün“ produzieren.

Damit kann jetzt nichts mehr schiefgehen – freuen wir uns also auf die „EU Orwell 2021“ und speziell hierzulande auf die wohl unvermeidbare DDR 2.0.

Die Infection Fatality Rate für SARS-CoV-2 ist gering: Von denen, die sich infizieren, sterben rund 0,23%.

Die Infection Fatality Rate für SARS-CoV-2 ist gering: Von denen, die sich infizieren, sterben rund 0,23%. Lockdowns sind kein Mittel, um Herdenimmunität zu erreichen, denn es würde mehrere Jahre dauern, um dieses Ziel zu erreichen, vorausgesetzt Immunität gegen SARS-CoV-2, die mit Lockdowns kontrolliert erreicht werden soll, hält so lange vor;

Lockdowns sind kein Mittel, um Herdenimmunität zu erreichen, denn es würde mehrere Jahre dauern, um dieses Ziel zu erreichen, vorausgesetzt Immunität gegen SARS-CoV-2, die mit Lockdowns kontrolliert erreicht werden soll, hält so lange vor;