COVID-19: die „zweite Welle“ in Europa

Das hier übersetzte Original mit den Zusatzinformationen nimmt in WORD mehr als 40 Seiten ein. Also habe ich hier einen Auszug der langen Übersetzung auf den Server geladen. Mehr Details finden Sie in dem „hochgeladenen“ und übersetzten PDF. – Einleitung durch den Übersetzer

Die Langversion meiner Übersetzung finden Sie als PDF

Die oben angesprochene Studie finden Sie hier in englischer Sprache

https://www.bsg.ox.ac.uk/sites/default/files/2020-11/BSG-WP-2020-032-v9.pdf.

In der Studie der Hinweis auf aktuelle updates: https://covidtracker.bsg.ox.ac.uk/

…

Original Bericht Neil Lock auf

https://wattsupwiththat.com/2020/12/06/covid-19-the-second-wave-in-europe/

Die von Neil Lock angesprochene Definition der Original Studie, Kap. 4 finden Sie als PDF in Deutsch

Variation in goverment response to covid-16

…

Vor einem Monat habe ich die Geschichte der COVID-19-Epidemie in vierzehn westeuropäischen Ländern verglichen. Zu diesem Zeitpunkt wurde die „zweite Welle“ des Virus, die sich seit drei oder vier Monaten in der gesamten Region gebildet hatte, von den Regierungen als Entschuldigung genommen, wieder mit der Einführung von Sperren zu beginnen. Also dachte ich mir, dass ich die Situation in ungefähr einem Monat überprüfen würde. Dieser Monat ist nun abgelaufen. Hier ist der Rückblick. Vielleicht, nur vielleicht, habe ich jetzt genug Daten, um eine Vorstellung davon zu bekommen, welche Sperrmaßnahmen wirksam waren und welche nicht.

Hier die Liste der betrachteten Länder:

- Österreich

- Belgien

- Dänemark

- Frankreich

- Deutschland

- Irland

- Italien

- Luxemburg

- Niederlande

- Portugal

- Spanien

- Schweden

- Schweiz

- Vereinigtes Königreich

Die Datenquellen sind dieselben wie zuvor: Our World in Data und die Blavatnik School of Government, beide an der Universität Oxford. Die Daten, die ich verwende, wurden am 3. Dezember veröffentlicht und sie enthalten Zahlen bis einschließlich 2. Dezember.

In der letzten Woche hat sich die Sammlung auf „Unsere Welt in Daten“ erheblich geändert. Die meisten Daten vor der dritten Januarwoche wurden gelöscht. Einige Länder – zumindest Frankreich, Deutschland und Schweden – haben die Gelegenheit genutzt, viele ihrer Daten zu löschen und neu zu schreiben, einige davon bis zum Beginn der Epidemie. Und die Daten für britische Abhängigkeiten (Jersey, Guernsey, Isle of Man, Gibraltar) und dänische Abhängigkeiten (Färöer, Grönland) sind vollständig verschwunden. Ich hätte erwartet, dass diese Daten im Mutterland konsolidiert wurden. Aber zumindest für Großbritannien sehe ich keine Beweise dafür.

…

Außerdem haben die Schweden im November ihre Daten zur Stringenz der Sperrung komplett neu geschrieben und nun sieht es so aus, als ob ihr Lockdown seit Monaten nicht annähernd so leicht war, wie wir angenommen hatten. Nach all dem werde ich wiederholen, was ich schon oft gesagt habe: Es sind die besten Daten, die ich habe, also werde ich sie verwenden.

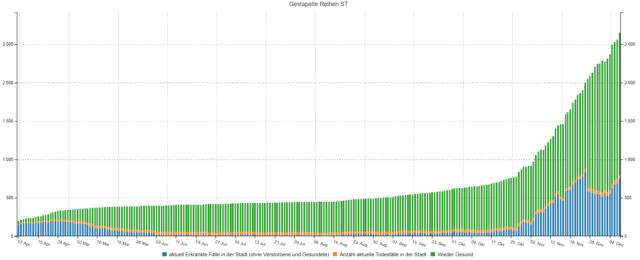

Fälle

…

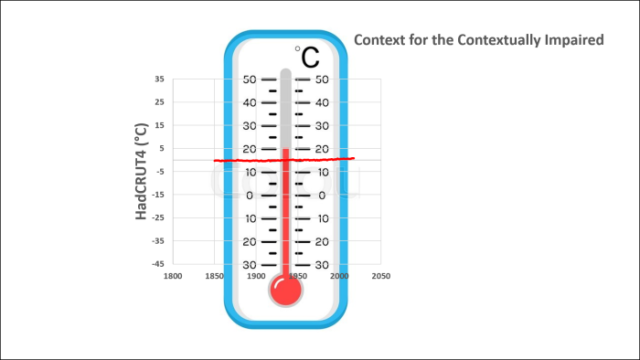

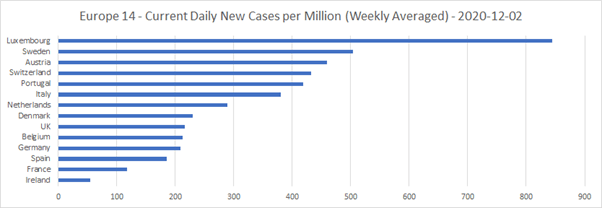

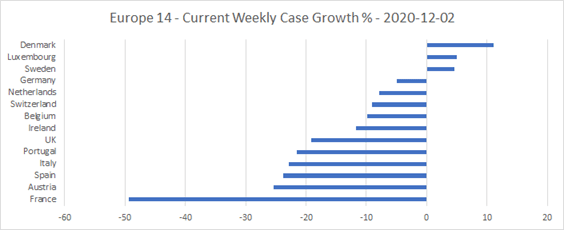

Hier ist die Grafik der täglichen Fälle pro Million zum Monatsende:

Um dies ins rechte Licht zu rücken: Derzeit liegen nur Spanien, Irland und Frankreich unter den 200 neuen Fällen pro Million Einwohner pro Tag, bei denen die WHO das Virus als endemisch ansieht und keine Aufhebung des Lockdown in Betracht gezogen werden sollte. Vier weitere Länder, darunter Großbritannien, liegen jedoch nur geringfügig darüber.

…

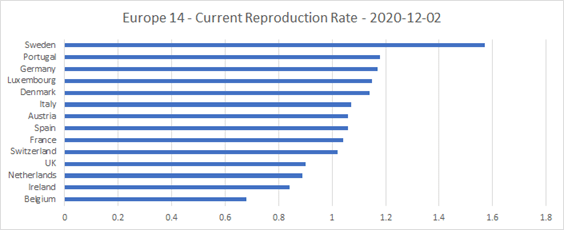

Hier sind die Rt-Werte aufgeführt, die jedes Land im Verlauf der Epidemie geliefert hat. Mit Ausnahme von Schweden sind die Rt-Sätze im November gesunken:

Großbritannien ist eines von nur vier Ländern mit einer RT-Rate unter 1 zum Ende November.

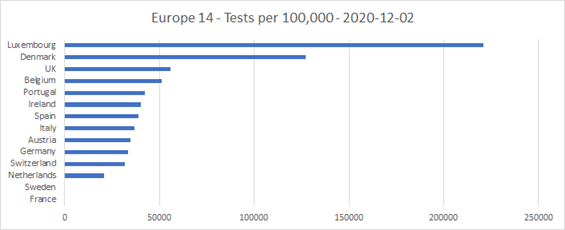

Tests

Die Anzahl der gefundenen [Inzidenz-] Fälle, hängt zumindest teilweise von der verfügbaren Testkapazität ab. Hier sind die kumulativen Tests, die pro 100.000 Einwohner in jedem Land durchgeführt wurden (mit Ausnahme von Schweden und Frankreich, in denen keine kumulativen Testzahlen angegeben sind):

Luxemburg und Dänemark liegen mit der Anzahl der Tests, bezogen auf je 100.000 Einwohner weit vor den anderen. Tatsächlich ist die Anzahl der seit Beginn der Epidemie in Luxemburg durchgeführten Tests mehr als doppelt so hoch wie die Anzahl der Bevölkerung!

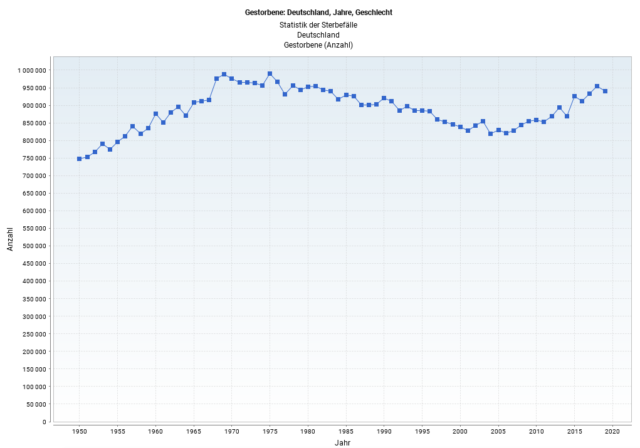

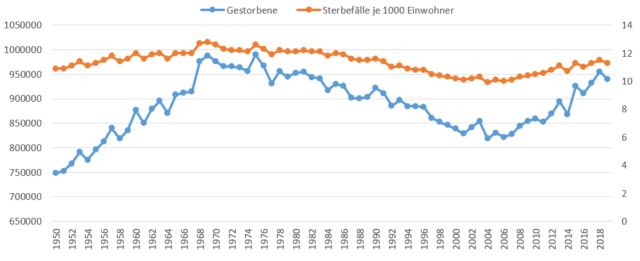

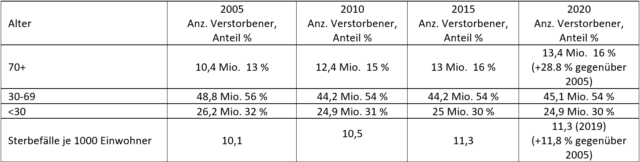

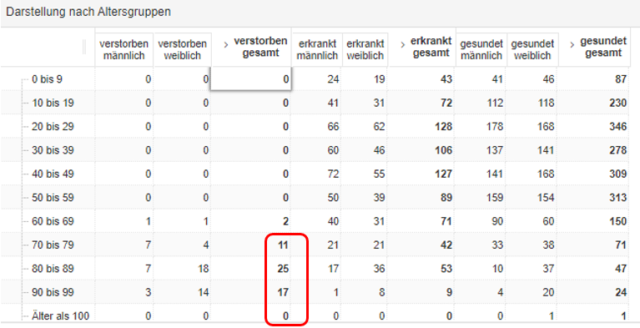

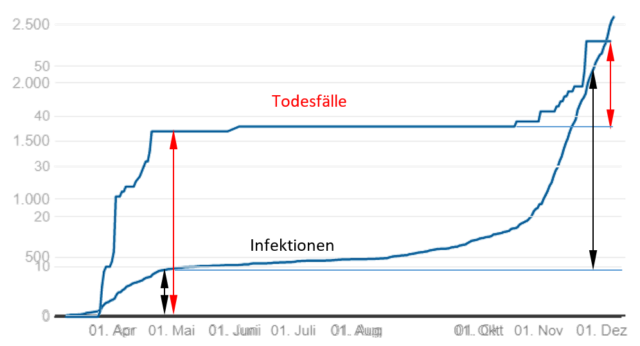

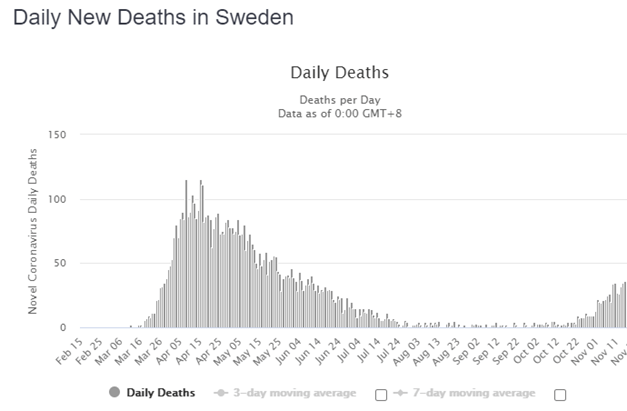

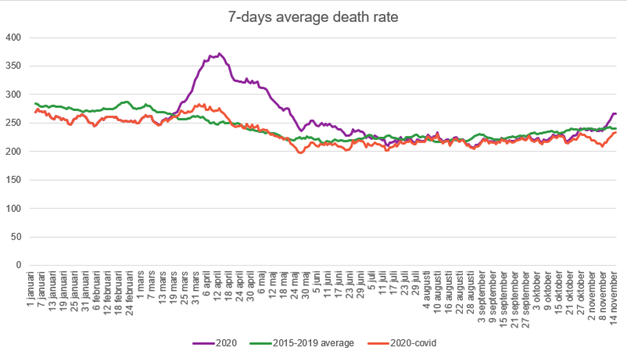

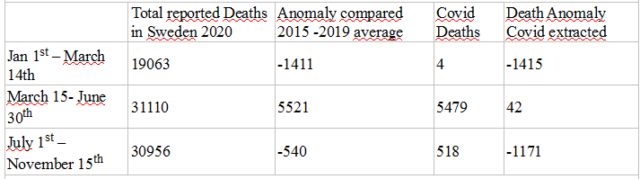

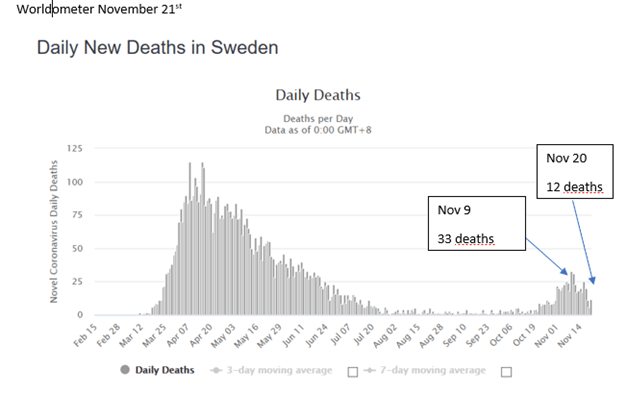

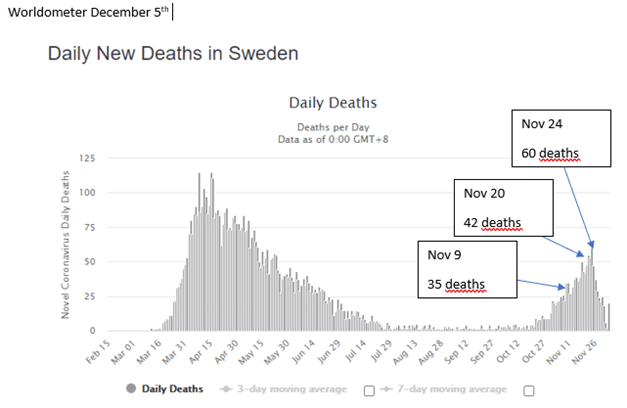

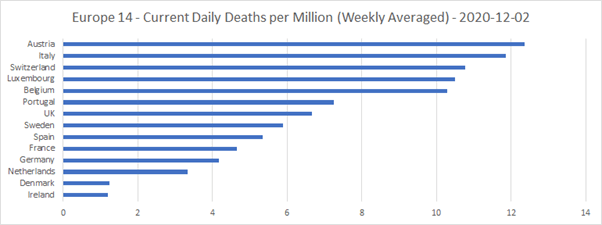

Todesfälle

…

und ich habe ein Histogramm der Todesfälle pro Million angehängt, Daten zum 30. November. Sie können hier sehen, welche Länder begonnen haben, die zweite Welle zu „erobern“, und welche nicht.

….

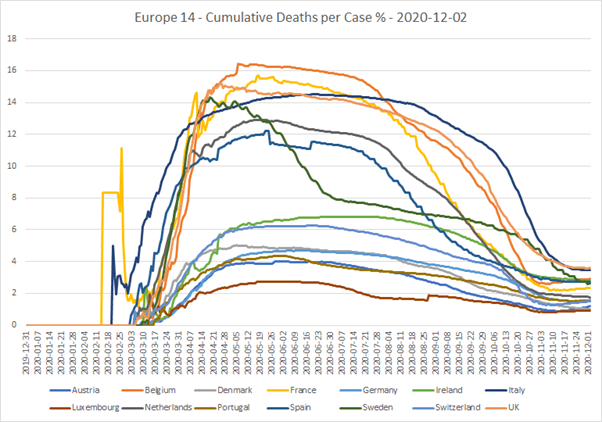

Die vierte und letzte Grafik zeigt die kumulierten Todesfälle pro Fall über den gesamten Verlauf der Epidemie.

Großbritannien (rosa Linie) schneidet bei den Todesfällen je Fall nicht gut ab. Es hat nach Italien das zweitgrößte Anzahl Todesopfer pro Tag. Und Großbritannien steht jetzt mit rund 3,6% an der Spitze der Liste der Todesfälle pro Fall über die gesamte Epidemie gesehen. Todesfälle pro Fall sind meines Erachtens ein fairer Indikator für mangelnde Qualität im Gesundheitssystem eines Landes. Aufgrund mangelnder Testkapazität und einer weniger wirksamen Behandlung derjenigen, die einen Krankenhausaufenthalt benötigen, wird dies tendenziell zu einer Erhöhung beider Dinge führen.

…

Im Original kommen hier Betrachtungen zu den einzelnen Ländern.

…

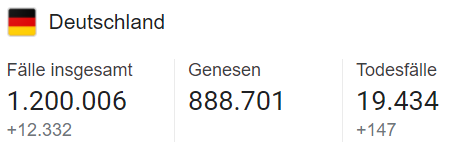

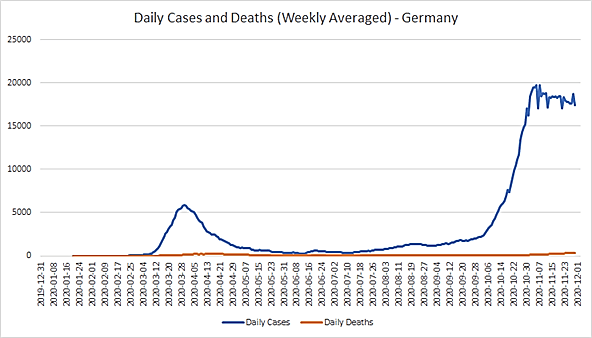

Deutschland

…

Die wahrscheinlichsten Ursachen für diese jüngste Stabilisierung scheint der 15. Oktober zu sein „Bleiben Sie zu Hause: Empfohlen“ und „Travel. Empfohlen nicht zu reisen“ Die Deutschen tun normalerweise das, was ihnen gesagt wird! Der 2. November: Beschränkung Gruppengröße, und die Schließung von einigen Arbeitsplätzen haben Rt reduziert, aber sie scheinen nicht so weit auf das Wachstum der Inzidenz Fälle viel Wirkung gehabt zu haben. Und für einen Großteil des Novembers lag Rt weit über 100%, aber die Anzahl der neuen Fälle wuchs nicht konstant.

…

Einige vorläufige Schlussfolgerungen

In vielen Fällen ist es schwierig, eine starke Korrelation zwischen dem Erfolg gegen das Virus und einer bestimmten Sperrmaßnahme herzustellen. Ein Grund dafür ist, dass Regierungen gerne viele verschiedene Vorschriften erlassen, die alle am selben Datum beginnen. Daher ist es schwierig festzustellen, welche funktionierten und welche nicht. Die folgenden Schlussfolgerungen können daher nur vorläufig sein.

Obwohl Schulen als Brutstätte für das Virus bekannt sind, konnte ich keine Beweise dafür finden, dass Schulschließungen, entweder empfohlen oder vorgeschrieben, allein während der zweiten Welle zu einem signifikanten Rückgang des Fallwachstums geführt haben.

Arbeitsplatzschließungen scheinen in Belgien oder den Niederlanden nicht vorteilhaft gewesen zu sein, und ihre Wirksamkeit in Deutschland ist zweifelhaft. Es gibt jedoch Hinweise darauf, dass sie in Italien einen Unterschied gemacht haben, und vielleicht auch in Portugal und der Schweiz.

In den meisten Ländern wurden (und werden) Großveranstaltungen abgesagt. Wenn ein Land diese Maßnahme gelockert hat, scheint sich eine erneute Einführung häufig positiv auf die Anzahl neuer Fälle ausgewirkt zu haben. Zumindest in Irland, Luxemburg, den Niederlanden und Spanien. Es scheint jedoch keinen klaren Vorteil zu geben, diese Maßnahme in Belgien erneut durchzusetzen.

Die Reduzierung der maximalen Versammlungsgröße auf 10 oder weniger scheint in Österreich, Belgien, Italien, Spanien und Großbritannien wirksam gewesen zu sein. Das einzige Land, in dem es keinen großen Unterschied gemacht zu haben scheint, sind die Niederlande.

Die Einstellung öffentlicher Verkehrsmittel, scheint während der zweiten Epidemiewelle kein wesentlicher Faktor gewesen zu sein.

Die Anforderungen für den Aufenthalt zu Hause scheinen einen signifikanten Effekt gehabt zu haben. Allein die Empfehlung, zu Hause zu bleiben, hat in Österreich, Deutschland und Großbritannien Auswirkungen. In Belgien, Spanien und vielleicht auch in Luxemburg scheint es einen Unterschied gemacht zu haben, zu Hause zu bleiben.

Auch Reisebeschränkungen machen einen Unterschied. Selbst eine Empfehlung, nicht zu reisen, hat sich in Deutschland und den Niederlanden positiv ausgewirkt. Obligatorische Reisebeschränkungen waren in Irland und wohl auch in Spanien wirksam. Und eine Mischung aus beiden hat wahrscheinlich in Großbritannien Wirkung gezeigt.

Die einzigen Länder, die ihre internationalen Reiseregeln im Oktober oder November geändert haben, sind Deutschland, die Schweiz und Italien. Ich würde erwarten, dass die Auswirkungen dieser Änderungen vernachlässigbar waren, da internationale Reiseverbote und Quarantänen in Zeiten, in denen das Virus in einem Land auf einem niedrigen Niveau ist, weitaus größere Auswirkungen haben würden, als wenn es – wie jetzt – höher ist als im Rest der Welt.

Aus Belgien, Frankreich, Spanien und dem Vereinigten Königreich geht hervor, dass Masken für die breite Öffentlichkeit keine positiven Auswirkungen haben. In der Tat ist es angesichts der Daten nicht von der Hand zu weisen, dass das Tragen von Gesichtsbedeckungen in der Öffentlichkeit tatsächlich noch zur Verbreitung des Virus beiträgt.

https://wattsupwiththat.com/2020/12/06/covid-19-the-second-wave-in-europe/

Übersetzt durch Andreas Demmig

Fundstücke zum Thema

Review report Corman-Drosten et al. Eurosurveillance 2020

Die externe Begutachtung des RTPCR-Tests zum Nachweis von SARS-CoV-2 durch Fachkollegen zeigt 10 wichtige wissenschaftliche Mängel auf molekularer und methodischer Ebene: Konsequenzen für falsch positive Ergebnisse.

https://cormandrostenreview.com/report/

….

Das blieb natürlich nicht unwidersprochen, hier auf Focus online

Internationale Forscher stecken hinter Papier

Schmidt-Chanasit zerlegt Anti-Drosten-Gutachten: „Desinformationskampagne“

… Mit der Corona-Pandemie erleben auch Verschwörungstheorien einen Aufschwung. Nun kursiert ein seltsames Papier in den sozialen Medien, in dem behauptet wird, Christian Drostens PCR-Test funktioniere nicht. Was es mit der These auf sich hat, erklärt Virologe Jonas Schmidt-Chanasit in einem aktuellen Interview.

…

Da darf der universelle Unheilsprophet nicht fehlen

Harald Lesch rechnet mit Corona-Egoisten ab: „Zeigt, dass Ethik-Unterricht versagt hat“

Und hier mein derzeitiges liebstes Fundstück:

Botschafter warnen Simbabwe vor Freiheitseinschränkungen wegen Corona

Düsseldorf, 28.08.2020

Wie handelsblatt.com berichtet, haben die Botschafter Deutschlands, Kanadas, Norwegens, der USA, der Niederlande, Polen und Großbritannien, die Regierung von Simbabwe ermahnt, die Rechte der Bürgerinnen und Bürger nicht im Namen der Corona-Krise einzuschränken.