Covid-19 und die Illusion von der Wissensgesellschaft

Yogeshwar wollte damit wohl sagen, dass die Menschen, von wochenlanger Einschränkung ihrer Freiheitsrechte frustriert und ermüdet, es nun wieder vorzogen, sicheres wissenschaftliches Wissen zu verdrängen, um zum gewohnten Trott ihres Alltagslebens zurückkehren zu können und sich dabei wieder von ihrem eigenen Hausverstand leiten zu lassen. Wie Massendemonstrationen gegen die „Hygiene-Diktatur“ in etlichen deutschen Großstädten zeigen, entwickelte sich bei einem Teil der Bevölkerung Widerstandsgeist. Der Wissenschaftsjournalist sieht seine Aufgabe offenbar darin, das lesende und fernsehende Publikum wieder zum rechten Glauben an die Leistungsfähigkeit der wissenschaftlichen Methode zurückzuführen.

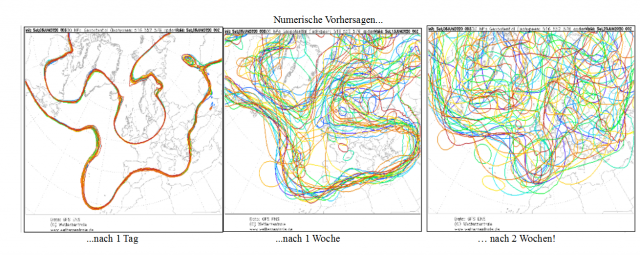

Hinter dieser Einschätzung versteckt sich meines Erachtens aber ein grundsätzlicher Irrtum, der auf der Verwechslung von wissenschaftlichem Wissen und szientistischer Ideologie beruht. Zwar glaubt heute kaum noch jemand, die wissenschaftliche Forschung könne durch zähe Anstrengung irgendwann zum gottgleichen Allwissen beziehungsweise ganzheitlichen Verständnis natürlicher und/oder gesellschaftlicher Prozesse gelangen. Doch vermuten wohl immer noch viel zu viele, man könne sich der Wahrheit zumindest bis auf 90 Prozent annähern. Oft fehlen uns für das umfassende Verständnis komplexer Sachverhalte aber über 90 Prozent der nötigen Informationen. Das gilt nach Aussage der darauf spezialisierten Biologen schon für einzellige Organismen und noch in weit größerem Maße für ganze Ökosysteme und für menschliche Individuen und ganze Gesellschaften. Dennoch trauen gerade Menschen mit formal höherer Bildung den zumeist staatlich besoldeten Wissenschaftlern zu, mithilfe deterministischer Computersimulationsmodelle, d.h. mit dem Durchrechnen von Differential- bzw. Differenzengleichungen die wesentlichen Ursachen der Entwicklung komplexer Systeme ausmachen zu können. Nur wer glaubt, bereits die wesentlichen Faktoren und Zusammenhänge verstanden zu haben, kann von Computersimulationen realistische Prognosen erwarten. Es handelt sich dabei aber, wie leicht gezeigt werden kann, um nichts anderes als um das, was Wirtschafts-Nobelpreisträger Friedrich A. Hayek „Anmaßung von Wissen“ genannt hat.

Ich hatte selbst in Sachen Modellierung ein Schlüsselerlebnis. Als ich vor Jahren beim deutschen Magazin „Bild der Wissenschaft“ einen Übersichtsartikel über das Pro und Contra von Tierversuchen einreichte, wollte der zuständige Redakteur nicht verstehen, warum man Chemikalientests an Tieren nicht vollständig durch Tests an Zellkulturen und durch Computersimulationen ersetzen kann. Er ging offenbar davon aus, dass solche Modelle alle wesentlichen Zusammenhänge abbilden konnten. Um ihn vom Umfang unseres Nichtwissens zu überzeugen, argumentierte ich mit Karl R. Popper und anderen Wissenschaftsphilosophen. Danach können Forscher aufgrund von Beobachtung und Experiment nur zu mehr oder weniger vorläufigen Hypothesen, aber nicht zu definitiven Erklärungen von Naturzusammenhängen gelangen. Aber den Namen Popper hatte der junge Mann noch nie vernommen. Mein Artikel wurde schließlich zwar veröffentlicht, aber vom Cover genommen und ins Innere des Heftes verbannt, obwohl er vom Umfang her der Hauptartikel der Ausgabe war.

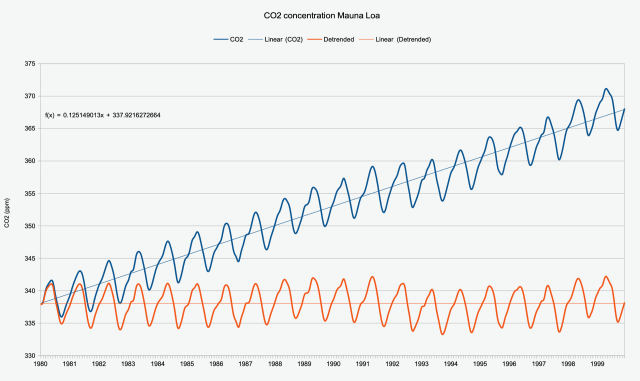

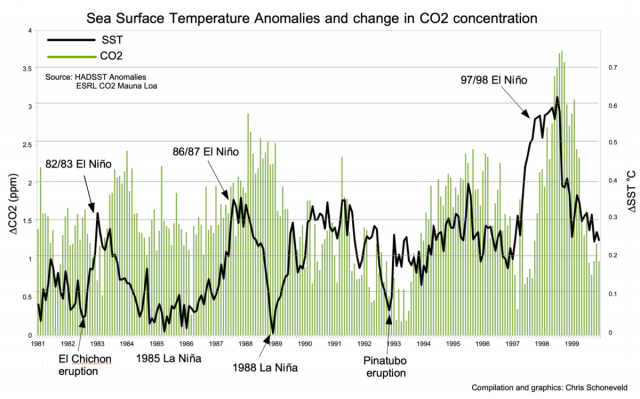

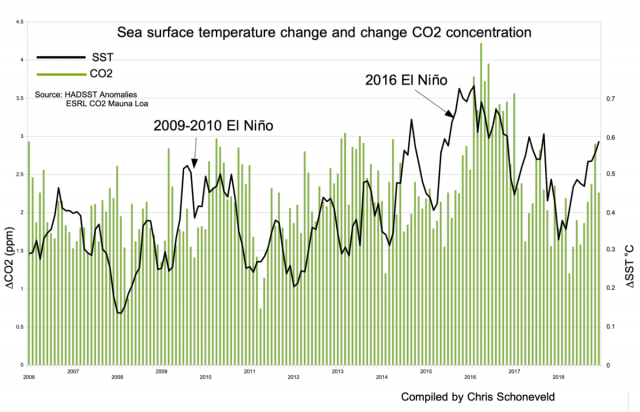

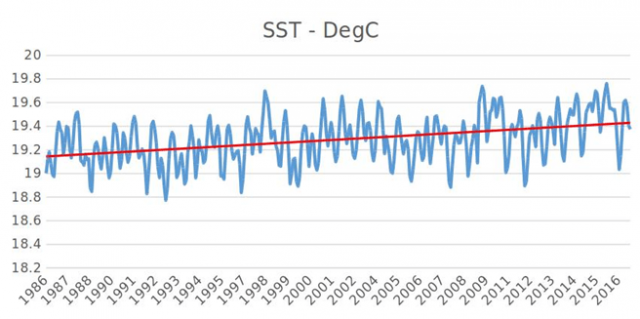

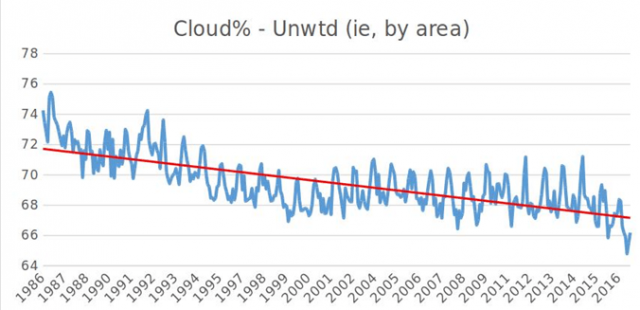

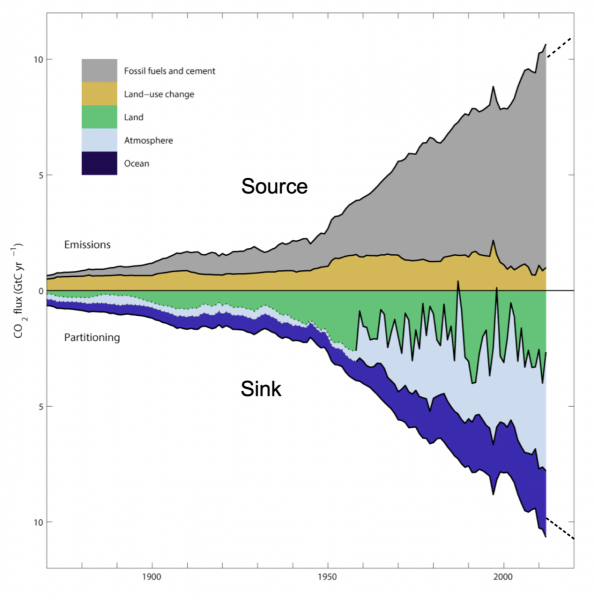

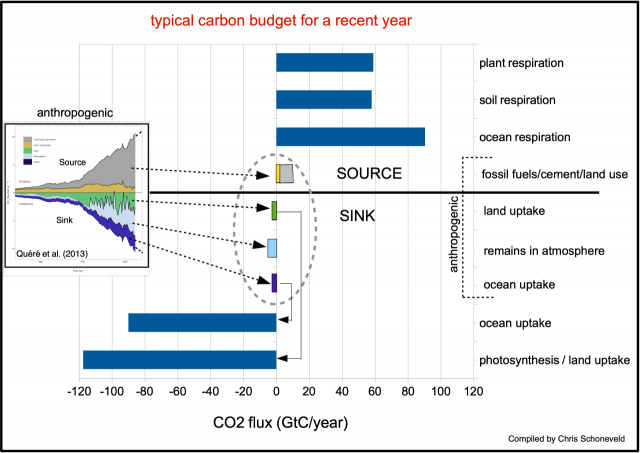

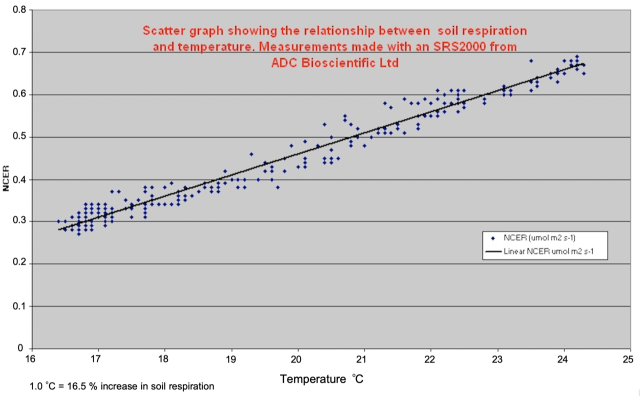

Die Anmaßung von Wissen in Form mathematischer Modelle zeigte sich bislang hauptsächlich in den vergleichsweise primitiven Computersimulationen auf malthusianistischer Grundlage, die der 1972 erschienen Studie „Die Grenzen des Wachstums“ zugrunde liegen, die vom „Club of Rome“ in Auftrag gegeben worden war. Danach sollte die Weltwirtschaft schon um die Jahrtausendwende wegen der Erschöpfung von Ressourcen zusammengebrochen sein. Die aktuelle Ölschwemme auf dem Weltmarkt zeigt, wie weit von der Realität diese Modelle entfernt waren. Weniger augenfällig ist das bei den scheinbar erheblich komplexeren Klimamodellen, mit denen die so genannte Klimapolitik zur Abwendung einer der Menschheit angeblich drohenden „Klimakatastrophe“ begründet wird. Das Vertrauen in diese Modelle ist inzwischen so groß, dass ihnen widersprechende Messdaten und Alltagserfahrungen bei maßgeblichen Massenmedien und den ihnen ausgelieferten Bevölkerungsteilen der selektiven Wahrnehmung zum Opfer fallen. Kaum jemand wagt es noch zu bezweifeln, dass die Freisetzung von Kohlenstoffdioxid durch menschliche Aktivitäten die Hauptursache der Erderwärmung ist. Dabei gibt es für die monokausale Argumentation und daher nur scheinbar komplexe Struktur dieser Modelle keine empirischen Belege. Das unrühmliche Ende des Biosphere-II-Experiments in Arizona (hier) hätte schon in den 1990er Jahren zeigen können, dass die Natur nicht so funktioniert, wie die Grünen sich das vorstellen. Doch wer sich heute die akademische Freiheit nimmt, die Erzählung vom schädlichen Einfluss der industriellen Revolution auf Umwelt und Klima durch Hinweis auf eigene Beobachtungen kritisch zu hinterfragen, der riskiert, wie das Beispiel der Auseinandersetzung des australischen Meeresforschers Peter Ridd zeigt, inzwischen seine berufliche Zukunft.

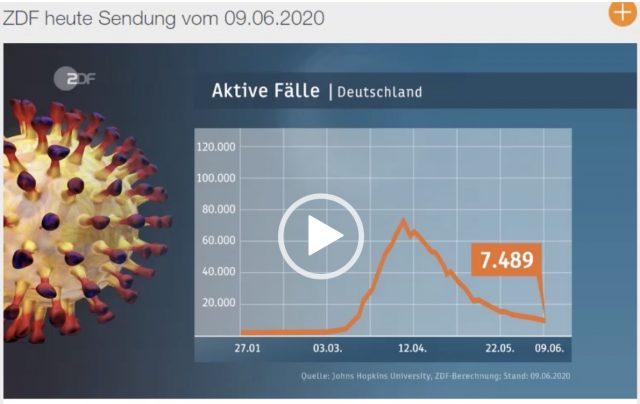

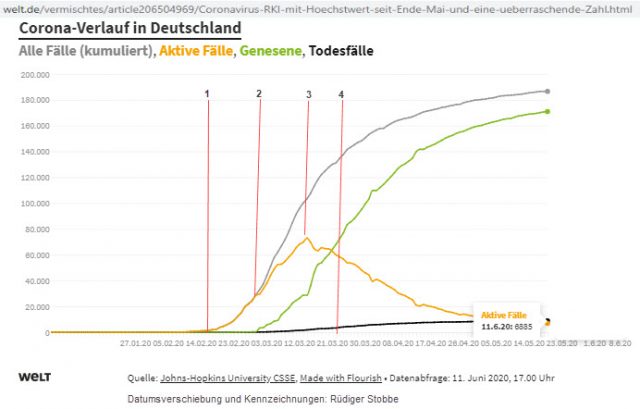

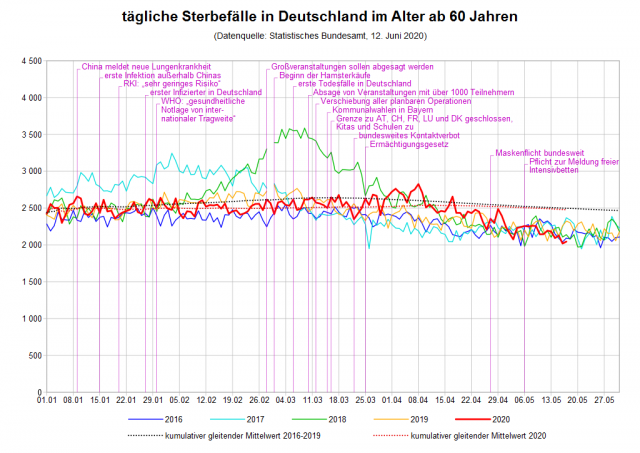

Nur auf dem Hintergrund der verbreiteten Modell-Gläubigkeit bei den Regierenden und den ihnen nahe stehenden Medien wird verständlich, wie es unter Hinweis auf „die“ Wissenschaft zur politischen Entscheidung kam, der Ausbreitung des neuen Virus SARS-CoV-2 mit der dümmsten aller denkbaren Strategien, nämlich dem kompletten Lockdown des Kultur- und Wirtschaftslebens zu begegnen, anstatt lediglich die an Covid-19 Erkrankten zu isolieren und empfindliche Bevölkerungsgruppen besonders zu schützen. Eine zentrale Rolle spielte dabei das epidemiologische Modell des Teams um Neil Ferguson vom renommierten Londoner Imperial College. Dieses prognostizierte im März 2020, die Covid-19-Epidemie würde in Großbritannien höchstwahrscheinlich eine halbe Million und in Amerika über zwei Millionen Todesopfer fordern. Wörtlich schrieb die New York Times: „With ties to the World Health Organization and a team of 50 scientists, led by a prominent epidemiologist, Neil Ferguson, Imperial is treated as a sort of gold standard, its mathematical models feeding directly into government policies.“ Der britische Premierminister Boris Johnson revidierte daraufhin die von ihm ursprünglich favorisierte Option einer kontrollierten Durchseuchung der Bevölkerung zugunsten eines strengen Lockdowns nach chinesischem Vorbild – mit unabsehbaren wirtschaftlichen und sozialen Folgekosten. Die meisten anderen europäischen Regierungen, mit Ausnahme der schwedischen, taten es ihm gleich – soweit sie nicht ohnehin bereits von sich aus dem Beispiel der chinesischen Diktatur gefolgt waren.

Ausschlaggebend für die Angst erzeugenden Projektionen des Ferguson-Modells war die Annahme einer unrealistisch hohen Infektionsrate von 80 Prozent und dessen deterministische Struktur, die keinen Platz ließ für intelligente Anpassungsmaßnahmen der von der Epidemie bedrohten Menschen. Obendrein verwendete das Team von Neil Ferguson ein total veraltetes Computerprogramm.

Das hielt die „New York Times“ nicht davon ab, es zum „gold standard“ der epidemiologischen Modellierung zu erklären. Dabei hatte Ferguson bereits eine lange Liste von haarsträubenden Fehlprognosen auf seinem Register: Im Jahre 2001 wurden auf seinen Rat hin in England vorsorglich sechs Millionen Schafe gekeult, um die Ausbreitung der Maul- und Klauenseuche zu stoppen. Kostenpunkt: Sechs Milliarden Pfund Sterling. Ein Jahr später sagte Ferguson den Tod von 150.000 Personen durch BSE (Creutzfeldt-Jacob-Krankheit) voraus. Es starben aber in GB gerade einmal 177 Menschen daran. Im Jahre 2005 prognostizierte Ferguson sage und schreibe 200 Millionen Todesopfer durch die Vogelgrippe. Es starben aber weltweit nur 282 Personen. Und im Jahre 2009 sagte er den Tod von 65.000 Briten durch die Schweinegrippe voraus. Es starben nur 457 Personen. Am Ende verlor Ferguson seinen Job nicht wegen seiner betrügerischen Fehlprognosen, sondern weil er während der von ihm selbst propagierten Kontaktsperre mit seiner Geliebten, einer verheirateten Frau mit zwei Kindern, erwischt wurde.

Auf die herrschende szientistische Ideologie ist auch der bislang wohl größte Wissenschaftsskandal der herbeigeredeten Coronakrise zurückzuführen. Es handelt sich dabei um die offenbar orchestrierte Lobby-Kampagne großer Pharma-Konzerne gegen den Einsatz des seit über sieben Jahrzehnten bewährten und obendrein sehr preiswerten Anti-Malaria- und Anti-Rheuma-Mittels Chloroquin (CQ) beziehungsweise dessen verträglichere Abkömmlinge Hydroxychloroquin (HCQ) und Chloroquinphosphat in Kombination mit dem ebenfalls zum Klassiker gewordenen Antibiotikum Azithromycin (AZ). In Frankreich verordnete Prof. Didier Raoult seinen positiv auf Covid-19 getesteten Patienten im Marseiller Hospital „La Timone“ in der Anfangsphase der Krankheit diese beiden Medikamente. Er hat nie behauptet, dass diese für ganz andere Anwendungen gedachten Medikamente allein in der Lage sind, die bereits fortgeschrittene Erkrankung zu stoppen. Vielmehr sollten sie einer Verschlimmerung der Virusinfektion vorbeugen, gehören also eher in die Kategorie Prophylaxe. Er berief sich dabei auf die guten Erfahrungen seines chinesischen Kollegen Zhong Nanshan und auf den Hippokratischen Eid, der ihm gebiete, Patienten beim Fehlen einer anerkannten Therapie auch mit unkonventionellen Methoden zu helfen. Raoult konnte sich mit seinem empirischen, vom gesunden Menschenverstand geleiteten Vorgehen auf seine Jahrzehnte lange Erfahrung als Infektiologe und seine weltweite Anerkennung als führender Mikrobiologe (dessen Namen einige bekannte Krankheitserreger tragen) berufen, was sich nicht zuletzt im Science Citations-Index niederschlug. Die zunächst bei über 1.000 und schließlich bei fast 4.000 Patienten erzielten Resultate gaben Didier Raoult am Ende recht. Kaum irgendwo starben so wenige Patienten an Covid-19 wie in Marseille (0,9 Prozent). Nur bei 25 Patienten (0,67 Prozent) wurde die befürchtete Herzrhythmus-Störung (Verlängerung des Q-T-Intervalls) festgestellt. Nur in drei Fällen führte diese zum Abbruch der Behandlung.

Doch damit fand er bei den Mandarinen des staatlichen französischen Gesundheitswesens keine Anerkennung. Im Gegenteil: Sie mokierten sich darüber, dass Raoult in Südfrankreich vom einfachen Volk inzwischen wie ein Messias verehrt wird, und warfen ihm vor, sein Vorgehen entspreche nicht dem „Gold Standard“ klinischer Studien. Als solcher gelten angeblich nur randomisierte Doppel-Blind-Studien, bei denen ein Teil der Probanden ohne ihr Wissen nur mit Placebos behandelt wird. Bei potenziell lebensbedrohenden Erkrankungen wie Covid-19 sei es aber ethisch nicht vertretbar, Patienten mit Placebos abzuspeisen, entgegnete Didier Raoult. Medizin erschöpft sich eben nicht in der Anwendung starrer von „der“ Wissenschaft abgeleiteter Regeln, sondern ist bekanntlich auch eine Kunst, die sich auf jahrzehntelange Erfahrung und Intuition stützt. Sie hat es also weniger mit Gewissheit, sondern mehr mit Wahrscheinlichkeiten zu tun. Didier Raoult kann sich damit immerhin auf Paul Feyerabends Polemik wider den Methodenzwang berufen.

Diese vom gesunden Menschenverstand inspirierte Haltung stieß offenbar in der französischen Gesundheitsbürokratie auf Missfallen. Yves Lévy, der Mann der früheren Gesundheitsministerin Agnès Buzyn, versuchte als Direktor des nationalen medizinischen Forschungs-Netzwerks INSERM Didier Raoult und seinem Institut Hospitalier Universitaire (IHU) Méditerranée das Leben schwer zu machen, indem er es nicht anerkannte. Seine Frau ließ zu Beginn dieses Jahres HCQ als gefährliche Substanz und damit verschreibungspflichtig einstufen, nachdem das Medikament, trotz einiger problematischer Nebenwirkungen bei Herz-Patienten, vor allem in warmen Ländern Jahrzehnte lang ohne Beanstandung in großen Mengen als Malaria-Prophylaktikum eingenommen worden war. Buzyns Amtsnachfolger Olivier Véran versuchte schließlich sogar in mehreren Anläufen, HCQ für die Behandlung von Covid-19-Patienten ganz zu verbieten.

Da kam die Veröffentlichung einer internationalen Metastudie im renommierten Magazin „The Lancet“ unter dem Titel „Hydroxychloroquine or chloroquine with or without a macrolide for treatment of COVID-19: A multinational registry analysis“ am 22. Mai 2020 offenbar wie gerufen. In dieser von Prof. Mandeep Mehra MD, Sapan S. Desai MD, Prof. Frank Ruschitzka MD und Amit N. Patel MD gezeichneten Publikation, die inzwischen zurückgezogen werden musste, geht es um die Analyse von anscheinend überwiegend aus Amerika, aber auch von anderen Kontinenten stammenden Patientendaten aus insgesamt 671 Kliniken, die nach Angaben von Sapan Desai elektronisch an das von ihm geleitete Chicagoer Start-up-Unternehmen Surgisphere übermittelt worden waren. So hätten die Heilungserfolge von fast 15.000 mit CQ oder HCQ behandelten Patienten mit Daten von 81.000 Patienten verglichen werden können, die anders behandelt wurden. Im Ergebnis Im Vergleich zur Kontrollgruppe wurde danach bei den mit HCQ (18 %), HCQ plus Makrolid-Antibiotikum (23,8 %), Chloroquin (16,4 %) und Chloroquin plus Makrolid (22,2 %) im Krankenhaus behandelten Patienten sogar eine erhöhte Mortalitätsrate wegen Herzrhythmusstörungen o.ä. festgestellt. Jedenfalls sei die Anwendung von Chloroquin und HCQ nicht von Vorteil.

Schon am 23. Mai kündigte Olivier Véran daraufhin über Twitter an, das zuständige Beratergremium HCSP werde sich mit der Aufhebung der provisorischen Zulassung von HCQ befassen. Am 27. Mai verbot Olivier Véran den Ärzten schließlich die Verschreibung von HCQ an Covid-19-Patienten. Schon am 25. Mai unterbrach die Weltgesundheitsorganisation WHO unter Hinweis auf die Veröffentlichung in „The Lancet“ teilweise ihre groß angelegte Studie SOLIDARITY . In Deutschland wurde jedoch entschieden, zwei ähnliche Studien mit etwa 3.000 Patienten fortzuführen, wie der Koordinator der beiden Studien, der Tübinger Professor Peter Kremsner gegenüber der „Ärzte-Zeitung“ erklärte. Eine dieser beiden Studien, die COMIHY-Studie konzentriert sich auf ambulant behandelte, also weniger schwer an Covid-19 erkrankte Patienten und hält sich auch mit der Dosierung an die Vorgaben von Prof. Didier Raoult, während die meisten übrigen Therapie-Experimente mit HCQ eine Überzahl schwerkranker Patienten einschlossen und obendrein mit Überdosen von HCQ arbeiteten. Auch Raoult selbst fuhr fort, von seiner autonomen Entscheidungsbefugnis als Arzt Gebrauch zu machen, wies jedoch darauf hin, dass es zu diesem Zeitpunkt zumindest in Marseille kaum noch Covid-19-Patienten gab.

In der Zwischenzeit hatte eine ganze Reihe international renommierter Kliniker und Statistiker , angeführt durch den Statistiker Dr. James Watson (aus Deutschland steht Prof. Dr. Frank Brunkhorst von der Jenaer Uni-Klinik auf der Liste) in einem Brief an die Autoren der Studie und an Richard Horton, den Herausgeber von „The Lancet“ öffentlich bezweifelt, dass bei der Datenauswertung der in „The Lancet“ veröffentlichten Metastudie von Mehra et al. alles mit rechten Dingen zugegangen ist. Unter anderem bemängelten die Wissenschaftler, dass die Herkunft der Daten wegen des Fehlens eines Codes nicht nachvollzogen werden kann. Man wisse also nicht, welche Kliniken Daten übermittelt haben und welche nicht. In Australien wurden für fünf Kliniken mehr Corona-Tote erfasst als im ganzen Land ermittelt worden waren. Als verwunderlich erschien den Kritikern auch die auffällig geringe Varianz des (verborgenen) statistischen Materials. Aus diesen und weiteren Gründen forderten die Experten die Offenlegung der Rohdaten und der Codes, mit deren Hilfe sie verarbeitet wurden. Dieser Bitte konnten Mehra et al. nicht nachkommen.

In Brasilien, dessen Präsident Jair Bolsonaro sich wie US-Präsident Trump nachdrücklich für die Verabreichung von HCQ einsetzte, versammelte der führende Chemiker Marcos Eberlin 300 weitere Top-Wissenschaftler, um den Artikel von Mehra et al. in „The Lancet“ zu zerpflücken und die Ergebnisse der Analyse in einem offenen Brief zu veröffentlichen. Die brasilianischen Kritiker der Veröffentlichung von Mehra et al. wiesen überdies nach, dass schwerkranken Patienten in der so genannten Manaus-Studie (veröffentlicht im JAMA hier) tödliche Dosen von CQ verabreicht worden war, um die Gefährlichkeit dieses Medikaments zu demonstrieren. Am Ende ihres offenen Briefes weisen die brasilianischen Wissenschaftler übrigens ausdrücklich darauf hin, dass sie sich nicht absolut gewiss sind, ob HCQ den Patienten hilft. Nur die Wahrscheinlichkeit spreche dafür. Die Justiz könne bei der Prüfung der Zulassung dieses Medikaments nur nach dem Grundsatz „In dubio pro reo“ verfahren.

(Leider gehen die Wissenschaftler nicht auf die bei Schwarzen, also gerade auch in Brasilien relativ häufige HCQ-Unverträglichkeit bei Glucose-6-Phosphat-Dehydrogenase (G6PD(H)-Mangel https://de.wikipedia.org/wiki/Glucose-6-phosphat-Dehydrogenase-Mangel ein. Durch diese ernsthafte Störung des Zuckerstoffwechsels werden die Zellmembranen, insbesondere die der roten Blutkörperchen, anfällig für oxidativen Stress durch HCQ. Das kann zur hämolytischen Anämie führen.)

Noch strenger ging ein anonymer, aber bekannter Blogger aus der Wissenschaftsszene (Goldstein) mit den Autoren der in „The Lancet“ publizierten Studie ins Gericht. Er wies nach, dass die Studie auf Fake-Daten beruht und dass Surgisphere nichts anderes ist als eine unseriöse Briefkastenfirma, in der eine Porno-Darstellerin als leitende Angestellte untergekommen war. Weitere Statistik-Profis schlossen sich in anonymer Form dieser vernichtenden Kritik an, indem sie nachwiesen, dass Surgisphere zu tragbaren Kosten gar nicht an die in der Studie angeblich verwendeten klinischen Daten gelangt sein konnte. Schlag auf Schlag kamen dann über soziale Netzwerke im Internet weitere kompromittierende Tatsachen über die Chicagoer Firma und über Interessenskonflikte der Autoren ans Licht.

In Frankreich untersuchte der linke Soziologe Laurent Mucchielli mögliche Interessenskonflikte der Autoren des Lancet-Artikels und wies nach, dass Mandeep Mehra verschwiegen hatte, dass das Bostoner Brigham Hospital, an dem er arbeitete, vom Pharma-Konzern Gilead bezahlt wird, um das Virostatikum Remdesivir zu testen. Gilead hatte dieses Medikament entwickelt, um die in Zentralafrika ausgebrochene Ebola-Epidemie gewinnbringend zu bekämpfen. Doch diese Epidemie war von selbst erloschen, bevor das neue Medikament auf den Markt kam. Nun versucht Gilead offenbar, sein teures, aber noch kaum erprobtes Medikament in der Coronakrise loszuwerden, indem er mithilfe willfähriger Wissenschaftler und Medien das preiswerte Konkurrenz-Produkt HCQ mit allen Mitteln schlecht macht. Auch der an der Zürcher Uni-Klinik arbeitende Prof. Dr. Frank Ruschitzka forscht mit Geldern der US-Pharma-Konzerne Gilead und Abbott. Mit dem letztgenannten Konzern arbeitet auch Dr. Mandeep Mehra zusammen. Der an der University of Utah lehrende Mediziner Amit Patel gab zu, die beiden renommierten Professoren Mehra und Ruschitzka mit seinem Schwager Sapan Desai, dem Gründer von Surgisphere, bekanntgemacht und für die Unterzeichnung der gefakten Lancet-Veröffentlichung gewonnen zu haben. Er trennte sich kürzlich „im Einvernehmen“ von seiner Universität.

Anfang Juni 2020 gab es nach alledem kein Halten mehr. „The Lancet“ musste die Veröffentlichung der inkriminierten Studie zurückziehen. So endete (vorläufig) einer der größten Wissenschaftsskandale der letzten Jahrzehnte. In Frankreich spricht man von „Lancet Gate“ . Tausende von Ärzten und Angehörige von Covid-19-Opfern haben in Frankreich juristische Schritte gegen die (un)verantwortlichen Minister eingeleitet oder angekündigt. Aber vermutlich dürfte dieser Skandal noch sehr viel weiter reichende politische Konsequenzen haben.

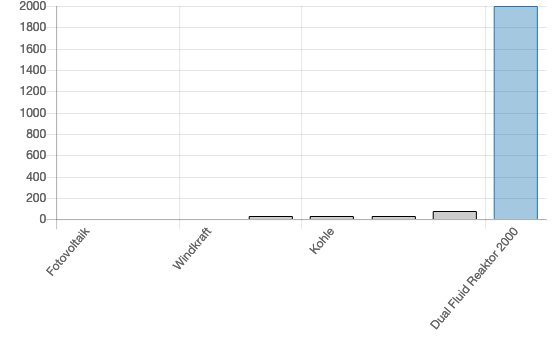

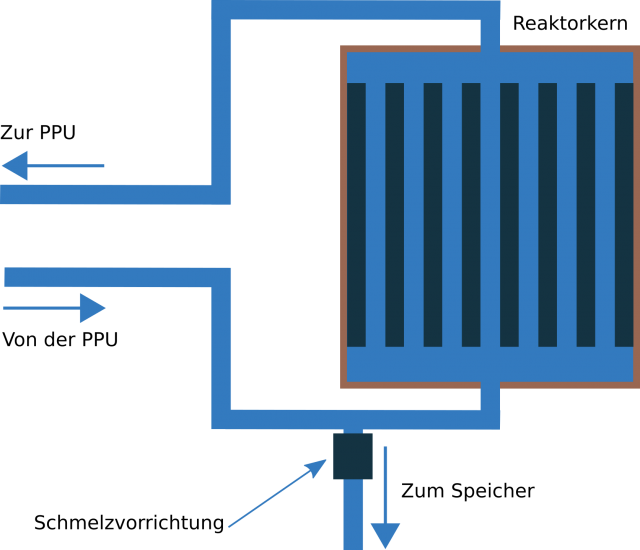

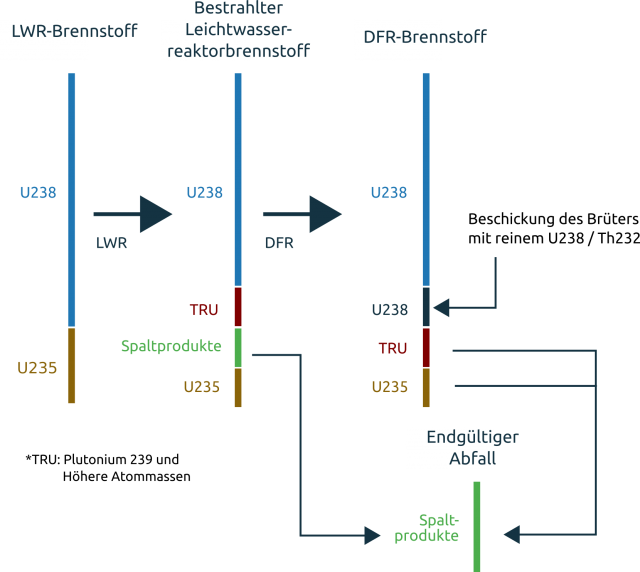

Man erinnert sich daran, dass die Europäische Union im Rahmen des so genannten Lissabon-Prozesses einmal offiziell verkündet hat, innerhalb von einem Jahrzehnt zur dynamischsten Wissensgesellschaft der Welt werden zu wollen. Dahinter steht offenbar der u.a. auf Auguste Comte zurückgehende Anspruch, das angeblich im Mittelalter vorherrschende magische Denken durch eine wissenschaftliche Weltanschauung überwinden zu können. Es lässt sich aber leicht zeigen, dass gerade die durch deterministische Modelle begründete Politik in Verbindung mit postmoderner Werteverkehrung zur Renaissance des magischen Denkens führt. Marxisten bewegen sich ohnehin nur in Modellwelten. Beispiele dafür sind die Klimapolitik, die damit zusammenhängende „Energiewende“, die Öffnung der Grenzen für die unkontrollierte Masseneinwanderung aus nichteuropäischen Ländern und die Euro-Rettungspolitik der EZB. Es bedarf bei all diesen Politiken keiner höheren Mathematik, um zu erkennen, dass diese nicht an ihr Ziel gelangen können. Das gilt vermutlich auch für die szientistisch begründete und bürokratisierte Gesundheitspolitik Frankreichs.

Hinter dem Anspruch, im Namen „der“ Wissenschaft zu sprechen, stehen m.E. letztlich immer totalitäre Bestrebungen. Um Fehlentwicklungen wie „Lancet Gate“ zu vermeiden, gilt es, im Gesundheitswesen dem Pluralismus und vor allem dem gesunden Menschenverstand größere Chancen einzuräumen. Das darf aber nicht mit Zugeständnissen an wissenschaftsfeindliche Ideologien einhergehen. Man braucht mit der Bescheidenheit hinsichtlich der menschlichen Erkenntnisfähigkeit nicht so weit gehen wie Sokrates, dem die Aussage zugeschrieben wird: „Ich weiß, dass ich nichts weiß.“ Denn wir wissen, trotz unserer grundsätzlichen Beschränktheit, schon sehr viel über uns und unsere Umwelt und haben das für eine Vielzahl echter Verbesserungen der menschlichen Lebensqualität genutzt. Aber wir sollten m. E. nie vergessen, dass unser Wissen immer nur eine Insel in einem Ozean von Unwissen sein kann.