Beeinflusst die Sonnenaktivität unsere Witterung – viele Indizien sprechen dafür

Die folgende Arbeit kann nur einen kleinen Beitrag zur Klärung des solaren Einflusses auf unser Klima leisten. Sie zeigt schwerpunktmäßig Zusammenhänge zwischen Sonnenaktivität und den Häufigkeitsverhältnissen bestimmter Großwetterlagen in Mitteleuropa auf. Wo es möglich war, wurden die Bewölkungs-, Niederschlags-, Temperatur- und Sonnenscheinverhältnisse, aerologische Daten sowie die AMO in die Betrachtungen einbezogen.

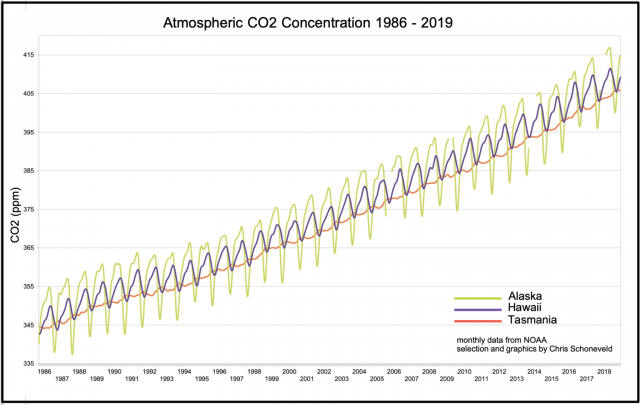

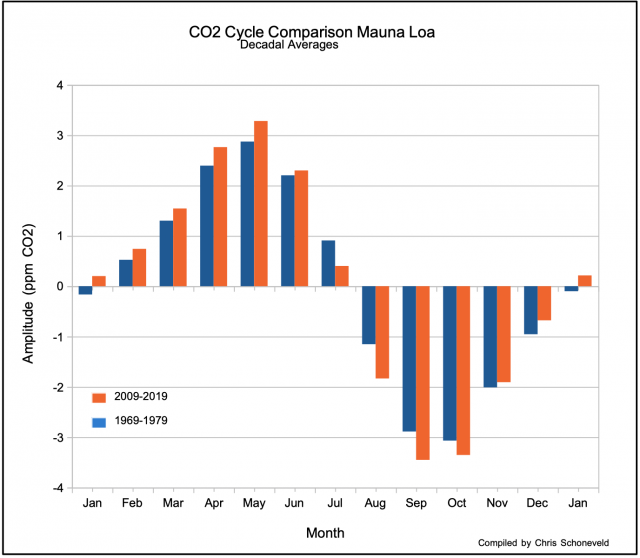

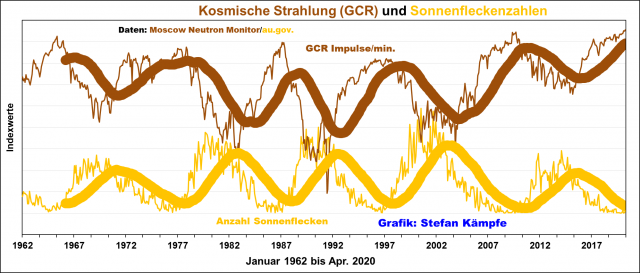

Sonnenaktivität und Kosmische Strahlung

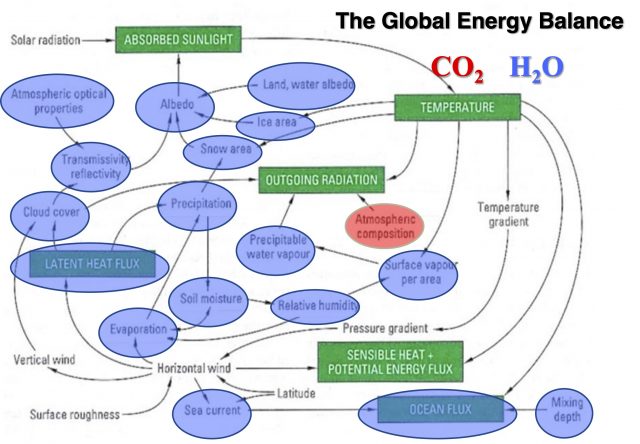

Für langfristige Betrachtungen (die Häufigkeitsverhältnisse der Großwetterlagen, Niederschlags- und Temperaturmittel reichen in Deutschland bis immerhin 1881 zurück) stehen nur die Sonnenfleckenzahlen zur Verfügung; sie bilden leider die solare Aktivität nur sehr grob ab. Ein besserer Indikator ist die leider erst seit etwa 1960 aufgezeichnete Intensität der so genannten Kosmischen Strahlung – keine Strahlung im physikalischen Sinne, sondern ein hochenergetischer Teilchenstrom, der von der Sonne, der Milchstraße und fernen Galaxien kommt. Sie besteht vorwiegend aus Protonen, daneben aus Elektronen und vollständig ionisierten Atomen. Näheres dazu unter anderem beim Stichwort „SVENSMARK-EFFEKT“. Ihre Intensität verhält sich in etwa spiegelbildlich zur Sonnenaktivität; die Sonnenaktivität schirmt entsprechend ihrer wechselnden Stärke den Einfluss der galaktischen Strahlung von der Erde mehr oder weniger ab.

Fast identische Ergebnisse zeigen sich bei der Analyse der GCR-Reihe aus Oulu/Finnland. Weil diese aber nur bis 1964 zurückreicht, wird im Folgenden die Beobachtungsreihe der Kosmischen Strahlung aus Moskau verwendet.

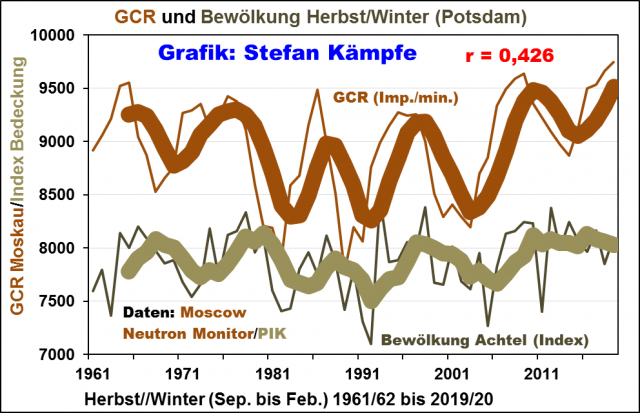

Beeinflusst die Kosmische Strahlung die Bewölkungs- und Niederschlagsverhältnisse?

Grobe Zusammenhänge konnten nur für den Zeitraum Herbst und Winter gefunden werden; wobei die Datenlage hinsichtlich der Bewölkung aber sehr mangelhaft ist, denn ein DWD-Flächenmittel fehlt, und auch für Potsdam liegt nur das Gesamtmittel in Achteln vor; trotzdem zeigt sich ein signifikanter Zusammenhang:

Beim Niederschlag wird im selben Betrachtungszeitraum keine Signifikanz erreicht, doch deuten sich in Phasen erhöhter Kosmischer Strahlung etwas geringere Herbst- und Winterniederschläge über Deutschland an:

Auf den ersten Blick erscheint es merkwürdig – mehr Bewölkung, aber weniger Niederschlag in Phasen mit erhöhter Kosmischer Strahlung? Man kann vermuten, dass bei erhöhter Kosmischer Strahlung besonders mehr tiefe Bewölkung (Hochnebel) entsteht, aus der aber kein oder nur unbedeutender Niederschlag (Sprühregen, Schneegriesel) fällt – entscheidend für das Niederschlagsaufkommen ist aber die Art und Menge der Mittelhohen Bewölkung in etwa 2.000 bis 4.000 Metern Höhe. Und warum fehlen merkliche Zusammenhänge im Frühling und Sommer? Da könnten Austrocknungseffekte durch geänderte Landnutzung und die Luftreinhaltemaßnahmen, welche die Sonnenscheindauer stark erhöhten, mögliche Zusammenhänge verwischt haben. Ohnehin dominieren im Sommerhalbjahr konvektive Prozesse, deren chaotisches Verhalten bei der Wolken- und Niederschlagsentwicklung jedem selbst noch so erfahrenen Wetter-Prognostiker immer wieder ein Schnippchen schlägt – mögliche Zusammenhänge werden da quasi vom Zufall „weggewischt“.

Kosmische Strahlung und Großwetterlagenhäufigkeiten

Wie schon bei der Abbildung 1, werden im Folgenden monatsweise Analysen verendet, weil diese detailliertere Untersuchungen erlauben; außerdem musste dabei stets in Anomalien umgerechnet werden, weil sonst viele Größen, man denke nur an die Lufttemperaturen, sonst nicht vergleichbar sind. In den vergangenen Jahren häuften sich immer wieder so genannte Meridionale Lagen, welche zu Extremwetter neigen, weil bei ihnen, abweichend zur vorherrschenden Westdrift, die Luftmassen entlang der Längenkreise entweder aus nördlichen oder südlichen Regionen oder aus dem kontinental geprägten Osteuropa/Westasien („Ostwetterlagen“) nach Deutschland strömen. Schon ein Blick auf dieses freilich sehr große Wetterlagen-Cluster mit 18 Großwetterlagen zeigt einen groben Zusammenhang zur Kosmischen Strahlung – je höher deren Intensität (wie auch momentan), desto häufiger treten diese Lagen tendenziell auf:

Ein noch deutlicherer, signifikanter Zusammenhang ergibt sich bei Betrachtung nur bestimmter Wetterlagen aus dieser Gruppe, und zwar der Lagen mit Hohem Luftdruck über dem Nordmeer, den beiden Troglagen sowie den zyklonalen Nordost-, Hoch Nordmeer/Fennoskandien- und Südostlagen:

Da es sich bei den beeinflussten Wetterlagen um solche handelt, die in negativen NAO-Phasen auftreten, bietet sich ein Blick auf den Zusammenhang zwischen NAO und Kosmischer Strahlung geradezu an. Er ist nicht signifikant negativ, aber trotzdem erkennbar:

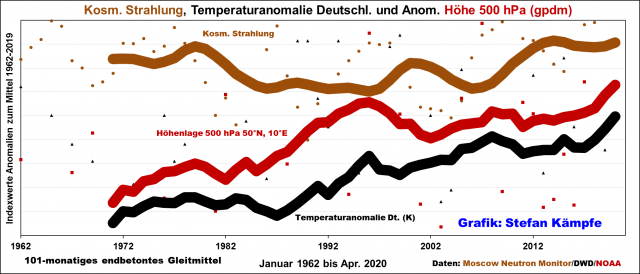

Für die langfristige Temperaturentwicklung in Deutschland ist die Höhenlage der 500-hPa-Fläche von Bedeutung – je höher sie liegt, desto wärmer ist es tendenziell, von wenigen Inversionswetterlagen abgesehen, in bodennahen Luftschichten. Die Höhenlage der 500-hPa-Fläche stieg in den letzten Jahrzehnten stark an, was den Temperaturanstieg in Deutschland erklärt, doch scheint der Anstieg in Phasen mit erhöhter Kosmischer Strahlung gebremst zu werden:

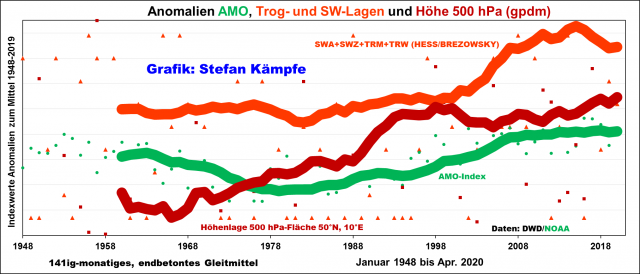

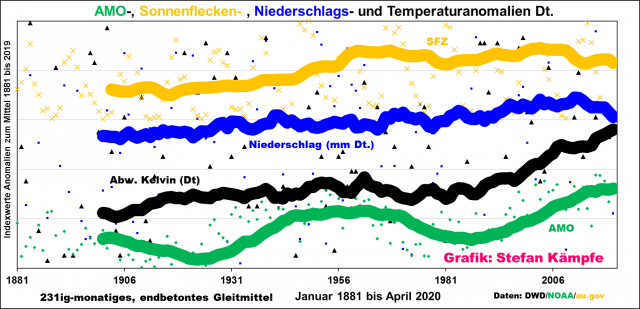

Doch was könnte nun verantwortlich für die massive Anhebung der 500-hPa-Fläche und der damit steigenden Lufttemperaturen in Deutschland sein? Eine mögliche Ursache ist die AMO; sie beeinflusst besonders im April und von Juni bis November die deutschen Temperaturverhältnisse und auch die Häufigkeitsverhältnisse bestimmter Großwetterlagen:

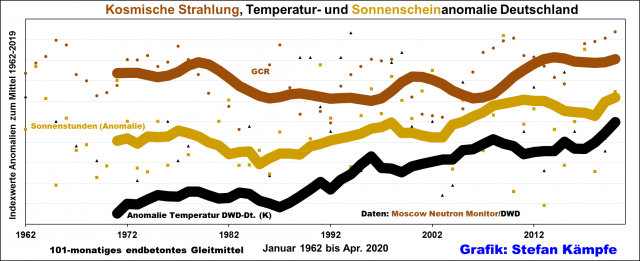

Als weitere Ursache kommt die seit Jahrzehnten steigende Sonnenscheindauer ernsthaft in Betracht – doch auch sie könnte zumindest teilweise von der AMO beeinflusst werden; ein Zusammenhang zur Kosmischen Strahlung ist hingegen nicht eindeutig erkennbar, aber auch nicht auszuschließen:

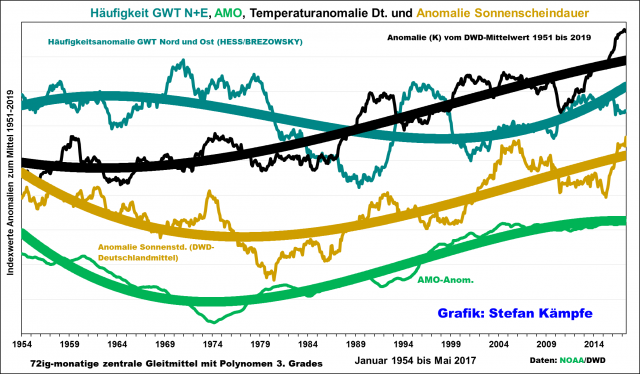

Weil die Daten des DWD-Flächenmittels der Sonnenscheindauer immerhin bis 1951 zurückreichen, bot sich die Errechnung eines zentralen Gleitmittels zusammen mit Temperatur- und AMO-Anomalie und der Häufigkeitsanomalie der insgesamt leicht kühlend wirkenden Nord- und Ostwetterlagen an:

Die Sonnenscheindauer wird auch von anderen Faktoren beeinflusst; ihr Minimum fällt mit dem Höhepunkt der Luftverschmutzung in den späten 1960er bis frühen 1980er Jahren zusammen; weitergehende Informationen zur Sonnenscheindauer hier https://eike.institute/2020/05/02/immer-mehr-aprilsonne-ueber-deutschland-fakten-und-hintergruende/

Langfristige Betrachtungen bis ins 19. Jahrhundert zurück

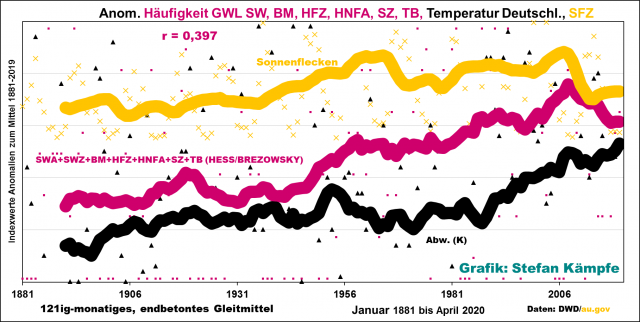

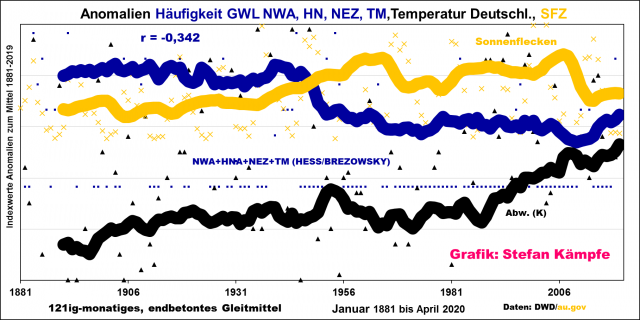

Zwar sind langfristig nur die Sonnenfleckenzahlen verfügbar, doch zeigen sich auch hier merkliche Einflüsse auf die Häufigkeitsverhältnisse bestimmter Großwetterlagen, die teilweise in den Signifikanzbereich reichen. Die zwei auffälligsten seien im Folgenden dargestellt:

Auch ein gewisser Einfluss der Sonnenaktivität auf die Niederschlagsmenge ist grob erkennbar; Zeiten mit inaktiver Sonne fallen tendenziell trockener aus:

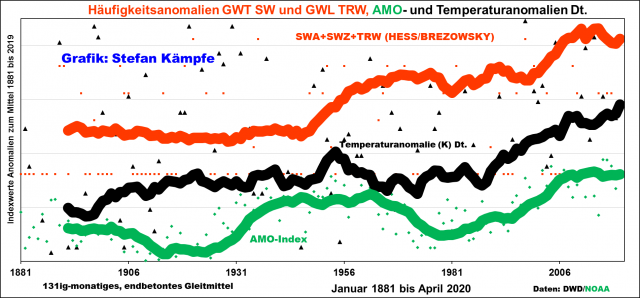

Abschließend werfen wir noch einen Blick auf eine wegen ihrer Häufigkeitsentwicklung und ihrer starken Erwärmungswirkung besonders auffällige Wetterlagengruppe – die Südwestlagen und den Trog über Westeuropa. Diese seit der Mitte des 20. Jahrhunderts massiv häufiger werdenden drei Wetterlagen sind neben einer deutlich zunehmenden Sonnenscheindauer und den wachsenden Wärmeinseleffekten eine wesentliche Ursache der Erwärmung in Deutschland:

Mehr Extremwetter im 21. Jahrhundert?

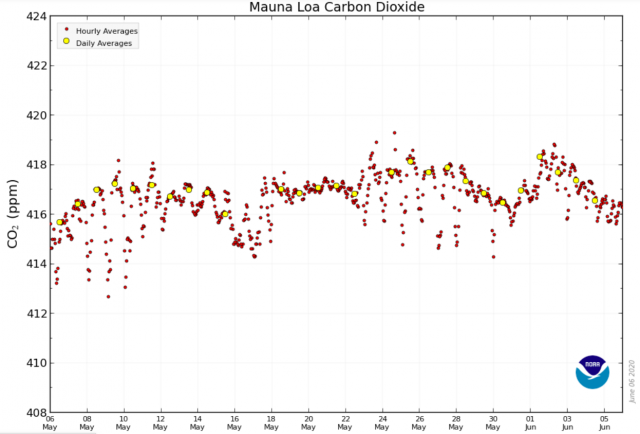

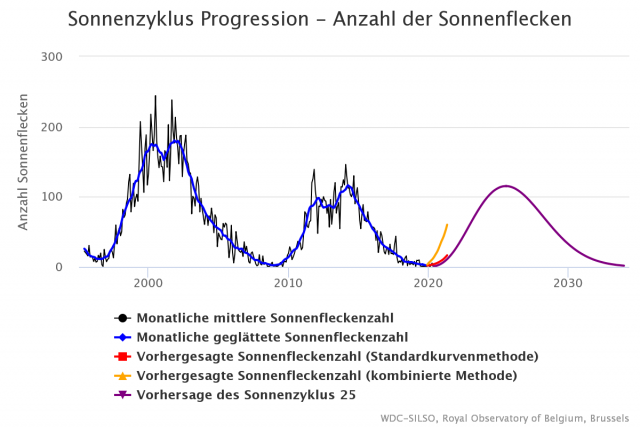

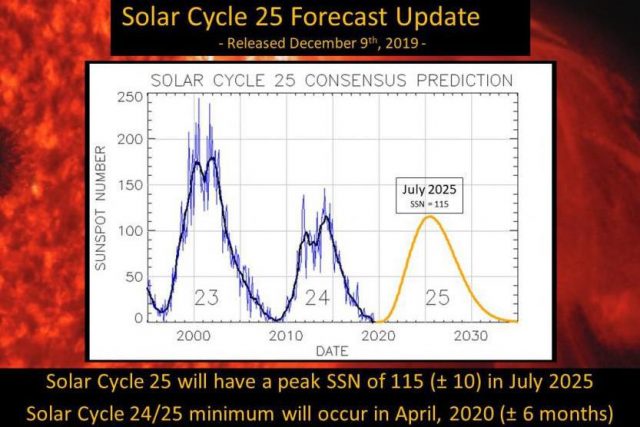

Alle Untersuchungsergebnisse deuten in die gleiche Richtung: In Phasen geringerer Sonnenaktivität häufen sich Extremwetterlagen, Niederschläge fallen unregelmäßiger, es gibt abruptere Schwankungen zwischen sehr warmen und sehr kalten Phasen – alles Phänomene, die wir schon ab den frühen 2000er, besonders aber ab den 2010er Jahren, gehäuft erlebt haben. Entscheidend ist nun die weitere, freilich nur schwer abschätzbare Entwicklung der solaren Aktivität. Die meisten Prognosen gehen von einem ähnlich schwachen oder noch schwächeren 25. Sonnenfleckenzyklus im Vergleich zum aktuell endenden 24. Zyklus aus:

Ähnliches sieht auch der amerikanische Wetterdienst NOAA vorher – kein neues Maunder-Minimum, aber einen relativ schwachen 25. Sonnenfleckenzyklus.

Die gute Nachricht wäre das Ausbleiben eines neuen „Maunder-Minimums“ mit all seinen negativen Konsequenzen. Trotzdem dürften auch die 2020er Jahre eher zu Extremwetter neigen. Welche Rolle dabei Coronale Löcher auf der Sonne spielen, welche (mit hoher Wahrscheinlichkeit) die überlangen Schönwetterperioden der vergangenen Jahre mit verursacht haben, bedarf noch einer Klärung. Und was nach 2030 passiert, steht buchstäblich in den Sternen.