Wo Wissenschaft noch Wissenschaft ist – und wo nicht. Universitäre Klimaforschung

Dieser Wissenschafts-Prozess hakt allerdings in den Geisteswissenschaften, wo 80 Prozent der in Fachjournalen publizierten Arbeiten von der entsprechenden Wissenschaftsgemeinde überhaupt nicht zur Kenntnis genommen werden. Das heißt, dass 80 Prozent aller publizierten geisteswissenschaftlichen Ergüsse nicht ein einziges Mal von einem anderen Forscher zitiert werden. Diese Arbeiten enthalten also ganz offensichtlich weder Erkenntnisse, die geeignet sind zur Begründung weiterführender oder vertiefender Untersuchungen, noch erscheinen sie anderen Wissenschaftlern als so relevant oder interessant, dass sie sich kritisch mit ihnen auseinandersetzen oder sie gar widerlegen wollten.

In den Naturwissenschaften verhält es sich glücklicherweise meist anders. Obwohl es natürlich auch hier Forschung für den Papierkorb gibt, aber eben in deutlich kleinerem Maßstab als in den Geisteswissenschaften. Unter der Überschrift „Wenn Bewährtes scheitert“ hat kürzlich das Deutsche Ärzteblatt auf ein gutes Beispiel für eine funktionierende Wissenschafts-Kultur hingewiesen. Es handelt sich dabei um eine in zweierlei Hinsicht bemerkenswerte Studie aus den USA: Zum einen ist die systematische und anspruchsvolle Fleißarbeit des Autorenteams zu loben, zum anderen der Gegenstand dieser Fleißarbeit, nämlich klinische Studien aus ganz verschiedenen medizinischen Gebieten, in denen zwar gängige, aber nicht gut oder auch gar nicht belegte Therapien einer kritischen Prüfung ihrer Wirksamkeit unterzogen wurden.

Denn nicht selten sind Mediziner mit dem Problem konfrontiert, dass es für den gerade vor ihnen sitzenden oder liegenden Patienten mit seinem gesundheitlichen Problem keine durch methodisch einwandfreie Forschungsergebnisse belegte Therapie gibt. Was macht man in einer solchen Situation? Man entscheidet sich für das, was unter Berücksichtigung des übrigen medizinischen Wissens und der eigenen Erfahrung plausibel erscheint. Das kann durchaus funktionieren – oder eben auch nicht.

Liebgewordene Erkenntnisse über Bord werfen

Die Forschergruppe hat nun für den Zeitraum von 2001 bis 2017 aus den weltweit führenden drei Medizinjournalen mehr als 3.000 randomisierte klinische Studien herausgefiltert und näher analysiert. Dabei ermittelten sie 396 Treffer, also Studien, die gängige Therapien im Vergleich zu anderen Therapien oder Placebo als unwirksam, unnötig oder gar schädlich identifizierten. Bei den untersuchten Therapien geht es vor allem um verschiedene medikamentöse Behandlungen einschließlich der Einnahme von bestimmten Nahrungsergänzungsmitteln, aber auch um invasive Verfahren wie die Anlage eines Stents bei bestimmten Herzerkrankungen. Ein Nebenergebnis dieser Analyse belegt zudem die Notwendigkeit unabhängiger Forschungsförderung: Während der Anteil von industriegesponserten Studien insgesamt gut 40 Prozent betrug, traf das auf nur 9 Prozent der erwähnten 396 Studien zu.

In der klinischen Medizin herrscht also ganz offensichtlich nicht die Meinung, dass es ewige therapeutische Wahrheiten gibt, die sozusagen unantastbar und sakrosant sind. Etwa weil die überwältigende Mehrheit der einschlägigen Fachärzte, Lehrstuhlinhaber oder Fachgesellschaften von der Wirksamkeit dieser Methoden restlos und frei von vernünftigen Zweifeln überzeugt sind. Wissenschaft ohne Offenheit für Neues, ohne Bereitschaft, auch sehr, sehr liebgewordene Erkenntnisse durch bessere, widerspruchsfreiere über Bord zu werfen, würde nicht mehr die Bezeichnung Wissenschaft verdienen und alle Beteiligten schlussendlich ins Abseits führen.

Natürlich gibt es auch in der Medizin, wie in allen Wissenschaften, so etwas wie die Grundlagen oder Basics, die sinnvollerweise nicht mehr zur Diskussion stehen. Aber bereits bei der Frage, wo genau die Grenze zwischen diesen kristallisierten Basics und den beginnend fluiden fachlichen Grundlagen des Faches zu ziehen ist, wird man keine hundertprozentige Übereinstimmung unter Medizinern mehr herstellen können. Ganz zu schweigen von den offen geführten kontroversen Diskussionen, die es zu zahllosen speziellen, aber auch grundlegenden Fragen des Faches gibt.

Manchmal allerdings dauert es in der Medizin lange oder vielleicht auch zu lange, bis ein einmal eingeschlagener Forschungspfad aufgegeben wird. Ein solches Beispiel betrifft die bisher weitestgehend erfolglose Suche nach medikamentösen Therapien für die Alzheimer-Krankheit. Wie mittlerweile klar geworden ist, hatten sich die führenden Forscher nahezu geschlossen, vorschnell und einseitig auf eine bestimmte und durchaus gut untersuchte Theorie – fast schon ein Basic– – zur Krankheitsentstehung festgelegt, die aber ganz offensichtlich nur einen Teilaspekt des Geschehens erklärt. Aber, wie es sich für eine Wissenschaft nun einmal gehört, hat das ständige Scheitern mit verschiedenen – theoretisch immer überzeugenden – Pharmaka im praktischen Versuch an echten, nicht an virtuellen, Patienten schließlich zu einem Umdenken geführt, es geradezu erzwungen.

Wenn Wissenschaft sich der Politik andient

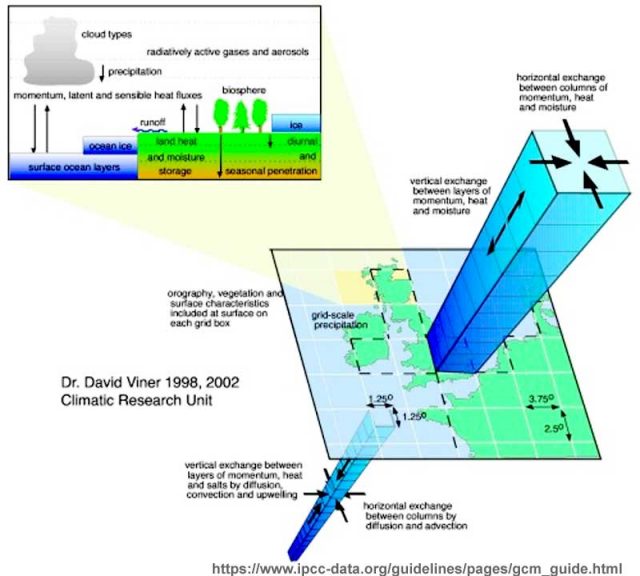

Ungeachtet dieses letzten Beispiels möchte ich trotzdem behaupten, dass die Erkenntnisse der Medizin über ihren Haupt-Forschungsgegenstand – die Krankheiten des Menschen – umfassender, detaillierter und abgesicherter sind, als es beispielsweise in der Klimawissenschaft in Bezug auf den Klimawandel der Fall ist. Das gilt nicht zuletzt deshalb, weil man es in der Medizin im Gegensatz zum Klimawandel nicht „mit einem gekoppelten, nichtlinearen und chaotischen System“ (IPCC) zu tun hat.

Wieso man angesichts dieser Voraussetzungen und einer von steten Klimawandeln geprägten Erdgeschichte den aktuell vor sich gehenden Klimawandel de facto monokausal glaubt erklären zu können, wird zweifellos als großes Rätsel in die Wissenschaftsgeschichte eingehen. Und dass Vertreter einer Wissenschaft und sogenannte Wissenschaftsjournalisten sich trauen zu behaupten, es gäbe unter den Klimaforschern zu einem so komplexen Problem wie den Treibern des gegenwärtigen Klimawandels einen grundlegenden Konsens von 97 Prozent, lässt tief, ja geradezu in Abgründe blicken. Unberücksichtigt bleiben soll ausnahmsweise, dass diese Prozentangabe nicht stimmt, denn das ist hier nicht der entscheidende Punkt.

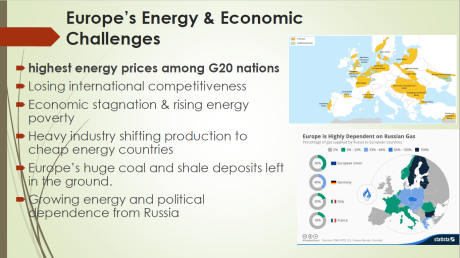

Vielmehr zeigt das Prahlen mit dieser vermeintlich exorbitant hohen Übereinstimmung innerhalb der Wissenschaftsgemeinde zweierlei: wie weit man sich in der Mainstream-Klimawissenschaft bereits von herkömmlichen Wissenschafts-Idealen und -Standards entfernt hat und in welchem Maße das Schicksal des Faches – meist auch des eigenen – mittlerweile verwoben ist mit der Politik. Denn die Politik würde nicht Riesensummen über einen längeren Zeitraum auf der Grundlage von offen als unsicher deklarierten, sehr kontrovers und ergebnisoffen diskutierten Hypothesen für die Forschung und die gesellschaftliche Transformation bereitstellen.

Um so etwas machen zu können, braucht die Politik vielmehr nicht zu komplizierte, sondern auf den ersten Blick plausibel erscheinende und zumindest dem Anschein nach abgesicherte und unstrittige Ergebnisse. Wenn dann die Agenda der Wissenschaftler noch zeitgeistkompatibel ist, vielfältige Möglichkeiten für die Lieblingsbeschäftigung der meisten Politiker – regulieren und neue Steuern erlassen – eröffnet und zudem ein sogar im globalen Maßstab sinnstiftendes Potenzial bietet, steht einer wunderbaren Zusammenarbeit nichts mehr im Wege.

Die durch die mediale, politische und finanzielle Protektion mittlerweile übermächtig und omnipräsent erscheinende Mainstream-Klimawissenschaft hat es jedenfalls geschafft, dieses Anforderungsprofil der Politik zu erfüllen – und es mit Hauen und Stechen zu verteidigen. Die Klimawissenschaft hat seinerzeit die Gunst der Stunde genutzt und sich unter sehr wohlmeinender Beobachtung der Medien der Politik angedient, sich ihr geradezu prostituiert. Allerdings werden die Mainstream-Klimaforscher nun die Geister nicht mehr los, die sie riefen. Sie sind dazu verdammt, Politik und Medien jeden Wunsch zu erfüllen. Also: immer mehr vom Gleichen zu liefern und die sogenannte Klimakrise dabei immer bedrohlicher erscheinen zu lassen. Gibt die Empirie das nicht her, wird bei der Computer-Modellierung eben scaling betrieben, vulgo: nachgebessert.

Mit freundlicher Genehmigung des Autors. Zuerst erschienen auf der Achse des Guten.