Die Kosten radikalen Umweltaktivismus‘ für die Gesellschaft

In der Novelle „1984“ von George Orwell aus dem Jahre 1949 sah der Autor eine Zeit kommen, „in welcher ein großer Teil der Welt das Opfer eines ewigen Krieges ist, Opfer von omnipräsenter Überwachung seitens der Regierung, Opfer historischen Negationismus [?] und Propaganda“ [hier]. Heute scheint es so, als hätte Orwell bemerkenswerte seherische Fähigkeiten gehabt.

Hier folgt das reale „1984“, ein Interview aus jenem Jahr mit dem Ex-KGB-Offizier und Überläufer Yuri Bezmenov [YouTube]. Er beschrieb das langfristig angelegte Programm der Sowjetunion, die westlichen Demokratien ideologisch zu unterminieren. Man springe zu 1:07:30, also zu Bezmenovs Diskussion „ideologischer Subversion“. Es geht darum, die nützlichen Idioten zu manipulieren – also die pro-sowjetischen Linksextremen innerhalb der Demokratien.

Ein Kommentator des Videos schrieb: „Das ist irre! Fast alles, was in dem Video prophezeit wurde, ist bereits im Gange!“ Bernie Sanders [US-Präsidentschafts-Bewerber für die Wahl 2020, AOC und andere Soialisten-Demokraten sagen ganz offen, was Bezmenov schon vor Jahrzehnten prophezeit hatte. Die letzten Demokratien werden durch Linksextremisten angegriffen.

Auf der ganzen Welt sind Länder, die einst eine Zukunft hatten, zu Diktaturen verkommen und in Armut und Elend versunken. Es ist bemerkenswert, dass von allen der rund 167 großen Länder der Welt die meisten totalitäre Staaten sind (hier), und sämtliche Bürger mit Ausnahme der „ausgewählten Wenigen“ leiden unter brutalen Linksdiktaturen.

Radikale Grüne haben Storys über eine runaway-globale Erwärmung und Klimawandel wild übertrieben, um die Leichtgläubigen vor sich her zu treiben, um ihre politischen Ziele zu erreichen. Die Grünen behaupten, pro-Umwelt zu sein, aber deren Politik hat der Umwelt bereits schwerste Schäden zugefügt. Radikale Grüne waren außerdem bzgl. der Menschheit äußerst destruktiv und haben Millionen Todesopfer zu verantworten. Kürzlich schrieb ich dazu:

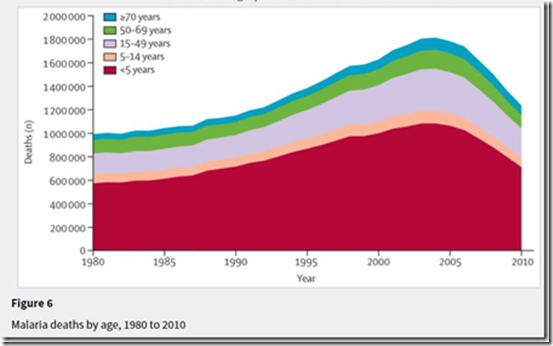

„Die modernen Grünen begannen mit dem effektiven Verbot von DDT 1972 bis 2002. Dies führte global zu Todesfällen durch Malaria, die von etwa 1 Million auf zwei Millionen Menschen pro Jahr zunahmen. Die meisten dieser Todesfälle waren Kinder unter fünf Jahren in Afrika südlich der Sahara…“ (hier).

„…radikale Grüne (wirkliche Linksextremisten) sind die großen Mörder unserer Zeit. Jetzt töten die Grünen Babys oder lassen sie erblinden mittels ihrer Opposition gegen Goldenen Reis…“ (hier)

„Die grüne Bewegung ist in Wirklichkeit ein Deckmantel für die alten Marxisten – und sie sind die Großen Mörder unserer Zeit“ (hier, auf deutsch hier).

2. Radikale Grüne haben Kosten von Billionen Dollar verursacht sowie hunderte Millionen Menschen das Leben gekostet!

Hier folgen einige der Belege dafür:

● Das DDT-Verbot von ~1972 bis 2002. Es verursachte Todesfälle durch Malaria von Zehner-Millionen Kindern und ließ weitere Zehner-Millionen Menschen aller Altersstufen erkranken und sterben.

Referenz: „Silent Spring At 50: The False Crises of Rachel Carson“, 21. September 2012:

Carson machte sich kaum die Mühe, eine ausgeglichene Perspektive zu vermitteln und ignorierte konstant alle Beweise, die ihrer Arbeit widersprachen. Zwar bot das Buch einige bemerkenswerte Gedanken, aber eine Anzahl von Carsons Hauptargumenten basieren auf etwas, das man nur als vorsätzliche Ignoranz beschreiben kann“.

● Die wütende grüne Opposition gegen Goldenen Reis. Sie tötete Millionen weitere Kinder und ließ sie erblinden. Referenzen hier, hier, hier und hier.

● Die Fehlleitung seltener globaler Ressourcen für kostspielige und destruktive Programme bzgl. ,Grüner Energie‘, welche alles andere als grün sind und kaum nützliche Energie erzeugen (hier).

● Wären sie angemessen verteilt worden, hätte ein Bruchteil der für grüne Programme verschwendeten Billionen Dollar ausgereicht, um saubere Trinkwasser- und Sanitär-Systeme in jeder Gemeinde auf der ganzen Welt zu installieren. Dies hätte vielen Zehner-Millionen Kindern und Erwachsenen das Leben gerettet! Mit dem übrigen Geld hätte man Todesfälle durch Malaria und Mangelernährung signifikant reduzieren können.

„Globale Krisen, globale Lösungen“, der 1. Kopenhagen-Konsens, Bjørn Lomborg et al. 2004.

● Die Anzahl der Todesfälle durch extreme Winterkälte in der entwickelten Welt sowie die Anzahl beeinträchtigter Lebensverhältnisse durch ausufernde Energiekosten in den Entwicklungsländern geht möglicherweise noch über die Zehner-Millionen Malaria-Toten durch das DDT-Verbot hinaus. Kältetote (mehr Todesfälle im Winter als in Nicht-Winter-Monaten) machen über zwei Millionen Seelen pro Jahr aus. Dies belegt eindeutig, dass die Erde kälter ist als es für die Menschen optimal wäre (hier).

● Todesfälle in Behausungen durch offene Kochfeuer (hier) tragen zu Krankheiten und frühzeitigem Tod in den Entwicklungsländern bei, besonders bei Frauen und Kindern.

● Zusätzlich zu ausufernden Energiekosten und zunehmenden Kältetoten haben intermittente Wind- und Solarenergie die Netz-Stabilität reduziert (hier) und das Risiko von Stromausfällen drastisch erhöht (hier).

● Riesige Landflächen sind dem Ackerbau entzogen und für die Erzeugung von Biotreibstoffen missbraucht worden. Dies führte zu steigenden Kosten für Nahrungsmittel und Hunger bei den ärmsten Menschen auf der Welt (hier).

3. Es gibt KEINERLEI glaubwürdige Beweise, dass das Klima gegenüber einem steigenden atmosphärischen Kohlendioxidgehalt sehr sensitiv ist – und reichliche Beweise für das Gegenteil. Eine katastrophale, vom Menschen verursachte Erwärmung ist eine falsche Krise.

Kompetenten Wissenschaftlern ist diese Tatsache seit Jahrzehnten bekannt. In einer von APEGA gesponserten, schriftlich niedergelegten Debatte im Jahre 2002 (hier) unter Mitwirkung von Dr. Sallie Baliunas, Dr. Tim Patterson und mir selbst von unserer Seite kamen wir zu dem Ergebnis:

„Die Klimawissenschaft stützt nicht die Theorie einer katastrophalen, vom Menschen verursachten globalen Erwärmung – die vermeintliche Erwärmungs-Krise ist nicht existent.

Die ultimative Agenda von Pro-Kyoto-Befürwortern läuft auf die Eliminierung fossiler Treibstoffe hinaus, aber dies würde zu einem katastrophalen Einbruch der globalen Energieversorgung führen – die verschwenderischen, ineffizienten Lösungen bzgl. Energie aus dem Kyoto-Protokoll können fossile Treibstoffe einfach nicht ersetzen“.

Viele wissenschaftliche Beobachtungen zeigen, dass beide Feststellungen immer noch gültig sind. Der gegenwärtige Gebrauch des Terminus‘ „Klimawandel“ ist vage, und die Definition desselben wird regelmäßig geändert – es handelt sich um eine „nicht falsifizierbare Hypothese“. Sie ist daher unwissenschaftlicher Nonsens.

„Eine Theorie, die nicht widerlegbar ist durch irgendein vorstellbares Ereignis ist unwissenschaftlich!“ – Karl Popper.

Das Klima hat sich immer geändert. Das gegenwärtige Klima ist nicht ungewöhnlich und außerdem vorteilhaft für Mensch und Umwelt. Die Erde befindet sich in einer etwa 10.000-jährigen Warmzeit innerhalb eines Zyklus‘ von 100.000 Jahren mit abwechselnden Kalt- und Warmzeiten. Eine Warmzeit ist KEINE Krise. Eine Vereisungs-Periode (,Eiszeit‘) mit 2 km dicken Eisschilden über dem Festland IST eine Krise.

Der Terminus „katastrophale, vom Menschen verursachte globale Erwärmung“ IST eine falsifizierbare Hypothese und WURDE AUCH SCHON vor Jahrzehnten falsifiziert. Die Verbrennung fossiler Treibstoffe und der atmosphärische CO2-Gehalt haben nach ~1940 drastisch zugenommen, während die globale Temperatur von ~1945 bis ~1977 gesunken ist. Es gibt keine glaubwürdigen Belege, dass das Wetter jetzt chaotischer ist – die Anzahl sowohl von Hurrikanen als auch von Tornados befindet sich seit vielen Jahrzehnten auf einem niedrigen Aktivitätsniveau (hier).

Selbst wenn man die gesamte globale Erwärmung dem gestiegenen atmosphärischen CO2-Gehalt zuordnet, beträgt die berechnete maximale Klimasensitivität bei einer Verdoppelung von CO2 in der Atmosphäre nur etwa ein Grad Celsius, und das reicht nicht zur Auslösung einer katastrophalen Erwärmung. Belege dafür hier und hier.

Der Alarmismus um die globale Erwärmung basiert auf der falschen Vermutung, dass der zunehmende atmosphärische CO2-Gehalt eine katastrophale globale Erwärmung verursacht. Tatsächlich hinken Änderungen des atmosphärischen CO2-Gehaltes den Änderungen der globalen Temperatur in allen Zeitmaßstäben hinterher (hier). Erst ändert sich die Wassertemperatur tropischer Meeres, danach die Feuchtigkeit in den Tropen, dann die Lufttemperaturen und erst dann der CO2-Gehalt – in dieser Reihenfolge.

In Klima-Computermodelle des IPCC und von anderen Klima-Aktivisten gehen viel höhere vermutete Sensitivitäts-Werte ein, welche falschen Alarm erzeugen. Die Fähigkeit zur Prognose ist vielleicht die objektivste Maßgabe wissenschaftlicher Kompetenz. Sämtliche Angst erzeugenden Prophezeiungen der Klima-Alarmisten bzgl. einer gefährlichen globalen Erwärmung oder extremerem Wetter haben sich bis auf den heutigen Tag als falsch erwiesen. Die Alarmisten können einen perfekt negativen prognostischen Werdegang vorweisen, so dass ihnen kein vernünftiger Mensch mehr glauben sollte.

Auf der Grundlage des gegenwärtigen Wissens sind die einzigen bedeutenden Auswirkungen des gestiegenen CO2-Gehaltes der Atmosphäre ein erheblich verbessertes Wachstum von Pflanzen und steigende Ernteerträge.

4. Die Menschheit braucht moderne Energiesysteme, um zu überleben – um unsere Nahrungsmittel anzubauen und zu verteilen, um Schutz, Wärme und überhaupt alles zu bieten, das wir zum Leben brauchen. Wind- und Solarenergie sind viel zu unberechenbar und diffus, um praktikabel oder effektiv zu sein. Grüne Energieprogramme waren kostspielige Fehlschläge.

Fast 85% der globalen Primärenergie stammt von fossilen Treibstoffen – Öl, Kohle und Erdgas (hier). Die verbleibenden 15% gehen fast durchweg auf das Konto von Kern- oder Wasserkraft. Grüne Energie ist von 1% auf weniger als 2% gestiegen – trotz vieler Billionen Dollar an verschwendeten Subventionen. Die Komponente fossiler Treibstoffe von 85% ist über die vergangenen Jahrzehnte praktisch unverändert geblieben und dürfte sich auch in zukünftigen Jahrzehnten kaum ändern.

Das folgenschwere Scheitern der Netzanbindung grüner Energie ist, dass diese weder grün ist noch nutzbare Energie erzeugt, hauptsächlich der Unberechenbarkeit geschuldet – der Wind weht nicht immer und die Sonne scheint nicht 24 Stunden am Tag. Intermittente, in das Netz eingespeiste grüne Energie erfordert fast 100% Backup-Reserve mittels konventioneller Energiequellen. Intermittente Stromerzeugung durch Wind und Solar reduziert nicht einmal signifikant CO2-Emissionen – alles, was sie mit sich bringen, sind steigende Energiekosten und Reduktion der Netz-Stabilität.

(Siehe auch hier bei Jo Nova)

Behauptungen, Energiespeicherung in der Größenordnung des Netzes das Problem der Unberechenbarkeit lösen werden, haben sich bis auf den heutigen Tag als falsch erwiesen (hier). Das einzige hinreichende Speichersystem einer ,Super-Batterie‘ ist Pumpspeicherung, aber geeignete Stellen dafür sind rar. Die Provinz Alberta ist größer als viele Länder, weist aber keine einzige geeignete Lokation für einen solchen Speicher auf.

5. Die Billionen Dollar für seltene globale Ressourcen, welche für die Hysterie um die globale Erwärmung verschwendet worden waren, um Fanatismus bzgl. fossiler Treibstoffe und grüner Energie-Programme, hätten bei ordentlicher Verwendung das Leben vieler Millionen Menschen verbessern und retten können.

Etwa zwei Millionen Kinder unter 5 Jahren sterben jedes Jahr durch verschmutztes Wasser – etwa 70 Millionen tote Kinder seit Aufkommen des Alarmismus‘ um die globale Erwärmung. Bjørn Lomborg schätzt, dass ein Bruchteil dieser vergeudeten Gelder für grüne Energie sauberes Wasser und sanitäre Einrichtungen in jede Gemeinde weltweit hätte bringen können.

Verschwendung von Geld für den Globale-Erwärmung-Alarmismus und den grünen Energie-Unsinn haben die Menschen auf der ganzen Welt geschädigt. In Nordamerika, Europa und Australien sind Billionen Dollar verschwendet worden für grüne Energie-Programme und deren Netzanbindung (hier). Das hat zu steigenden Energiekosten, steigender Winter-Sterblichkeit und reduzierter Stabilität elektrischer Netze geführt.

In den Entwicklungsländern ist die Installation von Stromnetzen Jahrzehnte lang verhindert worden – alles aufgrund des falschen Globale-Erwärmung-Alarmismus‘ (hier).

Im Winter 2017/18 traten in England und Wales über 50.000 zusätzliche Winter-Todesfälle auf (hier). Diese britische Pro-Kopf-Rate war ~drei mal so hoch wie die entsprechende Rate in den USA und Kanada.

Dabei sind die Energiekosten in UK viel höher – dank der radikalen grünen Opposition in UK gegen Fracking von Schiefergas (hier).

Die Anti-Ölpipeline-Kampagne kostete ~120 Milliarden Dollar durch verlorene Einnahmen aus dem Ölverkauf. Sie vernichtete ~200.000 Arbeitsplätze in Alberta und ganz Kanada. Dies stellt für das Land einen enormen Verlust an Geld und Arbeitsplätzen dar. Kanada, größtenteils Alberta, ist der fünftgrößte Ölproduzent der Welt und der größte Energie-Lieferant für die USA. Mehr dazu hier und hier.

Die Verschwendung finanzieller Ressourcen für die jeder Grundlage entbehrende Globale-Erwärmung-Hysterie, der anti-fossile Fanatismus und destruktive grüne Energie-Programme hätten bei ordentlicher Verwendung das Leben vieler Millionen Menschen verbessern und retten können.

6. Das Verhalten der Klima-Alaristen ist destruktiv, heimtückisch und gewalttätig.

Globale-Erwärmung-Alarmisten haben legitime Debatten niedergeschrien sowie heimtückische und gewalttätige Akte begangen, um ihre falsche Causa zu stützen.

Die Klimagate-E-Mails zeigen unwiderlegbar die wissenschaftliche Verdunkelung und das betrügerische Fehlverhalten.

In Kanada sind der skeptische Klimatologe Dr. Tim Ball und Andere Drohungen ausgesetzt, und Gebäude mit Bezug zur Energieindustrie, darunter der Calgary Petroleum Club, waren Gegenstand von Brandanschlägen. In den USA wurden die Wohnungen skeptischer Wissenschaftler überfallen, und viele hoch kompetente skeptische Wissenschaftler wurden geschmäht und aus ihren akademischen Stellungen hinausgedrängt.

7. Radikale Grüne haben der Umwelt gewaltige Schäden zugefügt, darunter:

● Rodung der tropischen Regenwälder, um Zuckerrohr- und Palmöl-Plantagen anzulegen für die Erzeugung von Biotreibstoffen

● Beschleunigte Trockenlegung der vitalen Grundwasser führenden Schicht in den USA für die Äthanol- und Biodiesel-Erzeugung.

● Rodung von Wäldern im Osten der USA, um das Holz an das Drax-Kraftwerk in UK zu liefern.

● Die Errichtung von Vögel und Fledermäuse zerschmetternden Windturbinen.

8.Warum sind die radikalen Grünen so sehr anti-umweltlich?

Dr. Patrick Moore, Mitbegründer und ehemaliger Präsident von Greenpeace, haben schon vor Jahrzehnten darauf Antworten geliefert. Moore erkannte, dass Öko-Extremismus die neue ,falsche Front‘ für ökonomische Marxisten ist, der nach dem Fall der Sowjetunion um das Jahr 1990 so diskreditiert war. Sie übernahmen die Grüne Bewegung, um ihre politischen Ziele zu fördern. Beschrieben hat Moore das in seinem Artikel mit dem Titel „Hard Choices for the Environmental Movement“ aus dem Jahr 1994 – man beachte „The Rise of Eco-Extremism“.

Radikalen Grünen war es nie um die Umwelt gegangen – die Umwelt war nichts als ein Deckmantel für ihre linksextremen totalitären politischen Ziele. Sollten radikale Grüne je an die Macht kommen, wird es „Ein Mann, Eine Stimme, aus!“ sein – das Ende jeder Demokratie.

Um die radikalen grünen Ziele zu verstehen, schaue man hier: http://www.green-agenda.com/. Auszüge daraus:

● Der gemeinsame Feind der Menschheit ist der Mensch. Auf der Suche nach einem neuen feind, der uns einigen kann, kamen wir auf die Idee, dass Verschmutzung, die Drohung einer globalen Erwärmung, Wasserknappheit, Hungersnöte und dergleichen dieses Ziel erreichen können. Alle diese Gefahren sind menschlichen Eingriffen geschuldet, und nur durch verändertes Verhalten kann diesen Dingen begegnet werden. Der wirkliche Feind ist also die Menschheit selbst“. – Club of Rome, primäre Umwelt-Denkfabrik und Berater der UN.

● Wir müssen breit angelegte Unterstützung bekommen, um die Vorstellung in der Bevölkerung zu verankern … also müssen wir ängstigende Szenarien entwerfen, vereinfachte dramatische Erklärungen abgeben sowie kein Aufhebens um irgendwelche Zweifel machen … Jeder von uns muss für sich selbst entscheiden, ob er lieber ehrlich oder lieber effektiv sein will“ – Prof. Stephen Schneider, Professor der Klimatologie bei Stanford und Leitautor vieler IPCC-Berichte.

● Besteht nicht die einzige Hoffnung des Planeten darin, dass die industrialisierten Zivilisationen kollabieren? Liegt es icht in unserer Verantwortung, genau dies auf den Weg zu bringen? – Maurice Strong, Gründer des UN-Umweltprogramms UNEP

● Das Aussterben der menschlichen Spezies mag nicht nur unvermeidlich sein, sondern wäre auch etwas Gutes“ – Christopher Manes, Earth First!

● Eine massive Kampagne zur De-Entwicklung der USA muss angezettelt werden. De-Entwicklung bedeutet, unser ökonomisches System auf eine Linie zu bringen mit den Realitäten der Ökologie und der Lage der Welt-Ressourcen“ – Paul Ehrlich, Professor für Bevölkerungsstudien

● Ein Amerikaner belastet die Erde mehr als zwanzig Bewohner von Bangladesh. Das zu sagen ist schrecklich. Um die Weltbevölkerung zu stabilisieren, müssen wir 350.000 Menschen pro Tag eliminieren! Das zu sagen ist furchtbar, aber genauso furchtbar ist es, das nicht zu sagen. – Jacques Cousteau, UNESCO-Botschafter.

[Hervorhebung vom Übersetzer]

● Es spielt keine Rolle, ob die Wissenschaft der globalen Erwärmung durchweg verlogen ist … der Klimawandel bietet die beste Gelegenheit, Gerechtigkeit und Gleichheit in die Welt zu bringen“. – Christine Stewart, ehemalige kanadische Umweltministerin

● Ich glaube, dass die Ausrottung der Pocken ein Fehler war. Sie spielten eine tragende Rolle bei der Ausbalancierung von Ökosystemen. – John Davis, Herausgeber des Earth First!-Journals.

● Wir müssen auf diesem Thema globale Erwärmung herumreiten. Selbst falls die Theorie zur globalen Erwärmung falsch ist, tun wir das Richtige hinsichtlich Wirtschafts- und Umweltpolitik. – Timothy Wirth, Präsident der UN-Foundation

● Das Aussterben der Menschen würde das Überleben von Millionen, wenn nicht Milliarden Spezies auf der Erde bedeuten. Das Auslöschen der menschlichen Rasse wird jedes Problem auf der Erde lösen – in sozialer und umweltlicher Hinsicht. – Ingrid Newkirk, ehemelaige PETA-Präsidentin

[Hervorhebung vom Übersetzer]

● Das Ziel ist jetzt eine sozialistische Umverteilungs-Gesellschaft, welche der angemessene Bewahrer der Natur und die einzige Hoffnung für die Gesellschaft ist. – David Brower, erster Direktor des Sierra Club und Gründer von Friends of the Earth.

9. Schlussfolgerungen

Radikale grüne Extremisten haben der Gesellschaft Billionen Dollar gestohlen und viele Millionen Menschenleben auf dem Kerbholz. Das Verbot von DDT und die radikale grüne Opposition gegen Goldenen Reis haben Zehnermillionen Kinder erblinden und sterben lassen.

Grüne Energie- sowie CO2-Verbots-Programme, getrieben durch falsche Befürchtungen bzgl. einer katastrophalen globalen Erwärmung haben die Umwelt ernsthaft geschädigt sowie Billionen Dollar verschwendet, welche man viel besser ausgegeben hätte, um den realen und unmittelbaren Bedürfnissen der Menschheit Rechnung zu tragen. Ordentlich verwendet hätte dieses Geld wohl ausgereicht, um Malaria und den Hunger in der Welt auszumerzen.

Die Zahl der zerrütteten Leben aufgrund des radikal-grünen Aktivismus‘ liegt gleichauf mit der Todesrate der großen Killer des 20. Jahrhunderts – Stalin, Hitler und Mao – radikale Grüne befürworten eine ähnliche linksextrem-totalitäre Politik. Sie sind unempfänglich für die daraus resultierenden Umweltschäden und menschliches Leiden … und falls man nicht aufpasst, wird der radikale Umweltaktivismus uns die Freiheit rauben.

Link: https://wattsupwiththat.com/2019/07/04/the-cost-to-society-of-radical-environmentalism/

Übersetzt von Chris Frey EIKE