Millionen von Menschen gehen wegen des Klimawandels auf die Strasse, stellt Professor Reto Knutti freudig fest. In der Wissenschaft herrscht Konsens über Ursachen und Folgen, die Regierungen streben nach den im Pariser Abkommen formulierten Zielen, die Protestierenden fordern Massnahmen gegen den Weltuntergang: «Nur Roger Köppel und seine Verbündeten versuchen auf ihrer Insel der Glückseligen, der Weltwoche, ihr Weltbild zu retten», schreibt ETH-Professor Knutti in seinem Beitrag für die Weltwoche(Nr. 23/19). Auf zwei Seiten – am Schluss dieses Hefts nochmals nachzulesen (Seite 32/33) – legt er dar, warum diese falsch liegen. Zum Beweis rattert er den Katechismus herunter, den die Klimaforscher seit Jahren in der Wissenschaft durchsetzen und in den Medien verbreiten – zumeist ohne Widerspruch, obwohl Kritik die Grundlage der Wissenschaft und die Aufgabe der Journalisten ist.

Dabei gibt es, wie dieses Heft zeigt, in der Klimadebatte viele offene Fragen und wenige klare Antworten. Und jeder der Glaubenssätze von Reto Knutti ruft nach einem kritischen Kommentar:

«Die Fakten sind klar.»

«Die Debatte ist vorbei», dekretierte Barack Obama 2014 in seiner Rede zur Lage der Nation: Der menschengemachte Klimawandel sei ein Fakt. Der US-Präsident schloss sich damit führenden Klimaforschern an, die seit zwanzig Jahren meinen: «The science is settled», die wissenschaftlichen Erkenntnisse stehen fest. Das hindert die Forscher allerdings nicht daran, von den Steuerzahlern immer noch Milliarden zu fordern, damit sie ihre unfehlbaren Studien mit immer gravierenderen Prognosen bestätigen und in immer alarmierenderen Reports des Weltklimarats (IPCC) verdichten können.

Dabei stehen die Erkenntnisse fest, seit die Uno den IPCC vor dreissig Jahren einsetzte: Führende internationale Experten, darunter Berner Forscher um Hans Oeschger und später Thomas Stocker, sollten die wissenschaftlichen Grundlagen für die Umweltkonferenz von Rio 1992 und die Klimakonferenz von Kioto 1997 liefern – es ging also von Anfang an nicht um eine wissenschaftliche Recherche mit offenem Ergebnis, sondern um eine politische Mission mit striktem Auftrag. Schon der erste IPCC-Bericht von 1990 schrieb denn auch fest: Es gibt eine unnatürliche Klimaerwärmung, und die Schuld daran trägt die Menschheit, weil sie immer mehr Treibhausgase, vor allem CO2, ausstösst.

Das heisst: Seit dreissig Jahren bekam nur noch Lehrstühle, Forschungsgelder und Publikationsmöglichkeiten, wer die Thesen des IPCC bestätigte, gerade auch in der Schweiz. Das ist das Gegenteil von Wissenschaft – sie findet nur eine vorläufige Wahrheit, wie der Philosoph Karl Popper lehrte, wenn sich eine Hypothese auf keine Weise falsifizieren, also widerlegen lässt. Deshalb nannte der Soziologe Robert Merton die Wissenschaft «organisierte Skepsis». Für den Fortschritt der Erkenntnis sorgen das Peer-Review, also die kritische Begutachtung von Publikationen durch Kollegen, und die intensive Debatte unter Forschern.

«Klimaskeptiker» aber gilt als Schimpfwort. Die Klimaforscher suchen sich für das Peer-Review Publikationen und Experten mit gleicher Gesinnung aus und drücken bei wichtigen Studien für IPCC-Berichte die Begutachtung im Eilverfahren durch. Sie drängen Nonkonformisten aus der akademischen Debatte, wie in den USA die renommierten Atmosphärenphysiker Richard Lindzen, John Christy und Judith Curry oder in der Schweiz den Berner Professor Christian Schlüchter (Seite 10). Und sie schmähen Skeptiker als «Klimaleugner», sogar den Forscher Roger Pielke Jr, der beim Zusammenhang von Klimaerwärmung und Naturkatastrophen zur selben Erkenntnis kommt wie der IPCC (Seite 28).

Die führenden Schweizer Forscher wie Thomas Stocker oder Reto Knutti stellen sich seit Jahren keinem Streitgespräch mehr und zählen darauf, dass die Journalisten ohne Nachfrage, also unjournalistisch, für sie PR machen. So stört sie niemand mehr, wenn sie selbstzufrieden behaupten, die Debatte sei vorbei.

«Die Erde hat sich über das letzte Jahrhundert um ein Grad Celsius erwärmt.»

«Die ausgeprägteste Kaltperiode seit 1520», wie sie der Berner Professor Christian Pfister nannte, endete um 1860 herum. Der Pionier der Klimageschichte zeigte früher in vielen Studien, wie die Menschen unter der Kleinen Eiszeit litten, die im 16. Jahrhundert hereinbrach und bis ins 19. Jahrhundert anhielt: Das kalte, nasse Wetter führte zu Missernten und Seuchenzügen, und da die geplagten Menschen Sündenböcke suchten, kam es zur Hexenjagd.

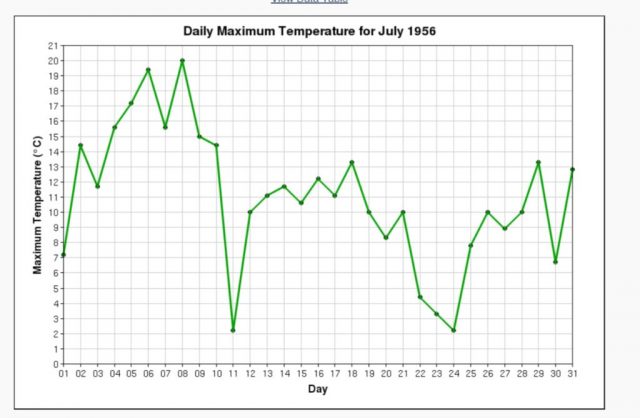

Drei Jahre nach dem Ende der letzten grimmigen Kaltperiode, 1863, baute der Bund sein Netz von Wetterstationen im ganzen Land auf. Sie massen einen schnellen Anstieg der Temperaturen bis zum «Wärmegipfel», den Christian Pfister zwischen 1943 und 1952 ansiedelte. Diese Erwärmung – also die Rückkehr zu den freundlicheren Temperaturen des Mittelalters – galt damals nicht als Gefahr, sondern als Segen: Dank dem weltweit günstigen Klima wuchsen die Ernten stark an. Als die Temperaturen in den sechziger und siebziger Jahren jäh sanken, warnten deshalb führende Klimaforscher vor Hungersnöten und Massensterben in einer neuen Eiszeit.

In den achtziger Jahren stiegen die Temperaturen aber wieder – angeblich so schnell wie nie zuvor, wie auch die Schweizer Meteorologen meinen, seit sie an ihren Daten herumgeschraubt haben (Seite 14). Deshalb setzt der IPCC seit dreissig Jahren das Dogma durch, die unnatürlich schnelle Erwärmung komme vom CO2, sei also menschengemacht.

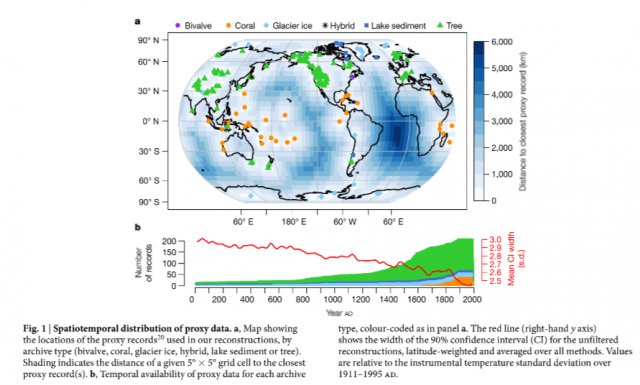

Nur: Als sie noch ohne Scheuklappen forschten, zeigten die Klimahistoriker, gerade auch Christian Pfister (Seite 26), dass heute nichts ist wie noch nie zuvor. Es gab in der Geschichte heftigere Stürme, schlimmere Dürren, schrecklichere Hochwasser, schnellere Gletscherschmelzen und vor allem Zeiten mit einem zumindest gleich warmen Klima, wie in der Römerzeit, im Hochmittelalter oder auch in der Mitte des 20. Jahrhunderts – bei einem weit niedrigeren Anteil an CO2.

Deshalb musste der IPCC die unerklärbaren Warmzeiten zum Verschwinden bringen. Besonders dreist tat es der amerikanische Forscher Michael Mann: Er bearbeitete seine Daten so lang, bis die Temperaturkurve in der Grafik am rechten Rand wie einhockey sticknach oben wies – seit dem Jahr 1000 eine kaum veränderte Temperatur, dann im 20. Jahrhundert einen steilen Anstieg. Die Grafik wurde von Kritikern zerzaust, aber sie fand sich prominent im IPCC-Bericht von 2001 und im Film «An Inconvenient Truth» mit Al Gore. Deshalb prägt sie bis heute, wozu die Klimahistoriker wie Christian Pfister forschen und was das Publikum zur Klimageschichte denkt.

«[…] der Mensch ist mit extrem hoher Wahrscheinlichkeit die dominante Ursache.»

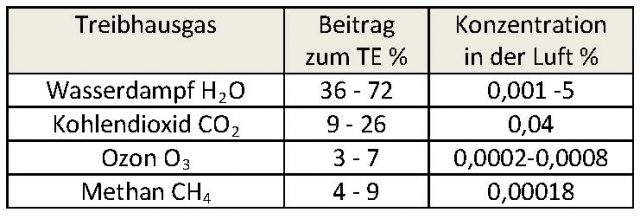

Ohne Treibhausgase gäbe es kaum Leben auf Erden. Denn sie sorgen dafür, dass die Erde weniger Wärme abstrahlt, als sie von der Sonne aufnimmt. Sonst läge die Temperatur 32 Grad tiefer, höhere Lebewesen hätten sich also nicht entwickeln können.

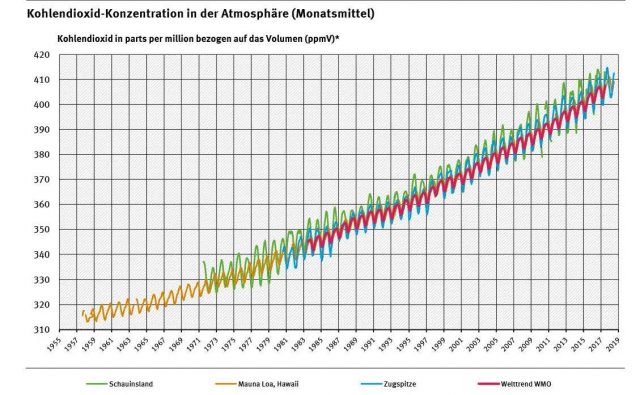

Dieser Effekt wurde schon 1824 vom französischen Physiker Joseph Fourier entdeckt und 1896 vom schwedischen Chemiker Svante Arrhenius quantitativ beschrieben. In der Wissenschaft bestreitet ihn niemand. Und alle anerkennen, dass der Anteil des wichtigsten Treibhausgases, CO2, in der Atmosphäre von 280 ppm (Teile pro Million) in der vorindustriellen Zeit auf gut 400 ppm zugenommen hat, dies vor allem wegen des Verbrennens von Kohle, Öl und Gas – die Menschen haben also den Treibhauseffekt verstärkt.

Wer diesen unstrittigen Aussagen zustimmt, der gehört zu den 97 Prozent, die sich gemäss oft kolportierten Studien im Konsens finden, dass der Klimawandel menschengemacht sei. Die Studien sind nicht nur deshalb unsinnig: Die Wahrheitsfindung geschieht in der Wissenschaft nicht per Mehrheitsentscheid. Als Albert Einstein vom Buch «Hundert Autoren gegen Einstein» hörte, scherzte er: «Warum einhundert? Wenn sie recht hätten, würde ein Einziger genügen!»

In den entscheidenden Fragen gibt es gar keinen Konsens. Alle wissen, dass sich die Atmosphäre wegen des Treibhauseffekts erwärmt – aber niemand weiss, wie stark. Der wichtigste Wert für die Wissenschaft ist die Klimasensitivität: Um wie viel Grad steigt die Temperatur bei einer Verdoppelung des CO2-Anteils? In dieser Frage kommt der IPCC aber seit zwanzig Jahren nicht weiter; ja er weitete die Unsicherheitsspanne im letzten Bericht sogar wieder aus, auf 1,5 bis 4,5 Grad. Und die meisten Studien der letzten Jahre zeigen, dass der Wert wohl im unteren Bereich oder sogar darunter liegt.

Das CO2 allein führt auf jeden Fall nicht zu einer gefährlichen Erwärmung, die Experten des IPCC fürchten solche Entwicklungen nur aufgrund der komplexen Rückkoppelung mit dem Wasserhaushalt der Erde, vor allem mit den Wolken.Der Experte Bjorn Stevens gestand aber kürzlich imSpiegel, die Forscher verstünden zwar die Wechselwirkungen im kleinen Massstab, «auf der grossen Skala des globalen Kontextes aber verstehen wir wenig». Trotzdem glauben Wissenschaftler wie ETH-Professor Reto Knutti, sie könnten auf die Tonne genau berechnen, wie viel CO2 die Menschheit noch ausstossen darf.

«Die Folgen [der Erwärmung] sind […] gut beobachtet, verstanden und in Computermodellen simuliert. Sie werden sich ohne rasches Handeln massiv verstärken.»

Sturmfluten toben, Waldbrände lodern, Dürren herrschen, die Pazifikinseln versinken im Meer, und die Eisbären sterben aus. Täglich schocken die Medien ihr Publikum mit düsteren Prognosen, was der Welt aufgrund der Klimaerwärmung droht. Darum glauben auch viele Menschen in der Schweiz, die nichts fürchten müssen ausser einer Hitzewelle oder einem Frostschaden, dass der Klimanotstand herrscht.

Jede Wissenschaft macht Voraussagen: Forscher stellen Hypothesen auf und testen empirisch, also in der realen Welt, ob sie stimmen. Was die Wissenschaftler des IPCC mit ihren Computermodellen an üblen Folgen für die Menschheit errechnen, lässt sich aber zu unseren Lebzeiten kaum überprüfen. Die Klimaforscher überbieten sich deshalb ohne störende Nachfragen mit ihrem Alarm – und sie verschweigen, dass sie bisher immer falschlagen.

Denn viele Prognosen liessen sich durchaus testen, und zwar mit den historischen Daten. Die Behauptung, die Erwärmung führe zu mehr Naturkatastrophen, ist so nachweisbar falsch. Die Forscher des ETH-Instituts WSL, die dazu eine Datenbank führen, stellten fest: «Da die meisten Wissenschaftler eine Zunahme der Schadenereignisse aufgrund des Klimawandels voraussagen, erscheint das Fehlen eines Trends in unseren Daten erstaunlich.» Die erfreuliche Tatsache, dass es in der Schweiz nicht mehr Unwetterschäden gibt, sei auf die Schutzmassnahmen der letzten Jahre zurückzuführen, behaupten die Alarmisten. Sie unterschlagen: Diese Beobachtung gilt weltweit, bestätigt vom IPCC. Das hinderte einen Mob von Politikern, Journalisten und Aktivisten nicht daran, den amerikanischen Experten Roger Pielke Jr., der diese Frage studierte, aus der Klimaforschung zu vertreiben (Seite 28).

Die Populationen der Eisbären bleiben seit zwanzig Jahren gleich. Die Pazifikinseln wachsen teils sogar. Die Zahl der Opfer von Naturkatastrophen nimmt stark ab. Und die Welt ist bisher nicht untergegangen, obwohl schon 1989 der Direktor des Umweltprogramms der Uno prophezeite, der Menschheit blieben nur zwölf Jahre zur Rettung vor dem Desaster.

Ja, die Klimaforscher verstehen nicht einmal den Zusammenhang zwischen der Zunahme des CO2 und dem Ansteigen der Temperatur, auf dem ihre Modelle beruhen. Sie können nicht erklären, weshalb die globale Temperatur in den nuller Jahren nicht anstieg oder weshalb sich das Klima schon in der ersten Hälfte des 20. Jahrhunderts schnell erwärmte. Und der Berner Professor Thomas Stocker lieferte mit den Studien, die ihn berühmt machten, sogar die Falsifikation der Theorie: Seine Bohrkerne aus dem Antarktis-Eis zeigten, dass der CO2-Anteil nach der Temperatur stieg, also nicht Ursache, sondern Folge war. Statt ihre Modelle zu verwerfen, schrauben die Klimaforscher deshalb an den Daten herum – sie machen passend, was nicht passt.

«Nur eine vollständige Abkehr von Öl, Gas und Kohle in den nächsten paar Jahrzehnten kann die Erwärmung auf deutlich unter zwei Grad begrenzen: das Klimaziel, das sich alle Regierungen 2015 in Paris gesetzt haben.»

Was aber, wenn der IPCC recht hat mit all seinen Erklärungen und Voraussagen? «Ja, der Klimawandel ist ein Problem», sagt Bjørn Lomborg, «aber er ist nicht das Ende der Welt.» Der dänische Ökonom ruft deshalb seit Jahren die Politiker auf, sie sollten mit ihrem Geld für den Kampf gegen den Klimawandel, weltweit 162 Milliarden Dollar im Jahr, nicht unwirksame Solar- und Windanlagen subventionieren, sondern das Energiesystem innovieren (Seite 8).

Bjørn Lomborg zweifelt nicht am Dogma des IPCC, dennoch zieht er den Hass der Alarmisten auf sich. Und die Klimaforscher werfen dem Kritiker aus Kopenhagen vor, er mische sich in ihre Wissenschaft ein, obwohl er keine Publikationen mit Peer-Review vorweisen könne. Sie übersehen: Bjørn Lomborg äussert sich als Ökonom nur zu Fragen, von denen er mehr versteht als die Klimaforscher wie Thomas Stocker und Reto Knutti, die der Welt als ökonomische Laien einen sofortigen Umbau ihres Wirtschaftssystems befehlen. Und vor allem: Er stützt sich auf die führenden Experten – und zumeist auf den IPCC selbst.

Der 8. Oktober 2018 war ein denkwürdiger Tag für die Klimapolitik. Einerseits stellte in Seoul der IPCC einen Sonderbericht vor, der forderte, die Welt müsse den Temperaturanstieg nicht nur auf 2 Grad, sondern zur Sicherheit besser auf 1,5 Grad begrenzen. Anderseits gab in Stockholm die Königlich Schwedische Akademie der Wissenschaften bekannt, der Nobelpreis für Ökonomie gehe an den Amerikaner William Nordhaus, den Erfinder der Klimaökonomie. «Ein Statement für den Klimaschutz!», jubelten die Medien – dabei vertragen sich die Forderungen des IPCC und die Erkenntnisse von Nordhaus nicht.

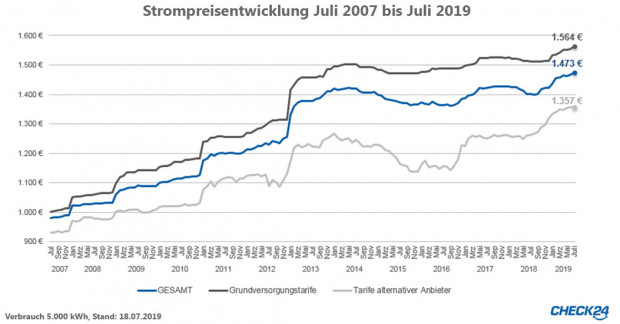

Wenn alle Staaten ihre Pflichten gemäss dem Pariser Abkommen erfüllen, stossen sie bis 2030 insgesamt 60 Milliarden Tonnen CO2 weniger aus. Das ist weniger als ein Prozent dessen, was es brauchen würde, um gemäss den Modellen des IPCC die Erwärmung auf 1,5 Grad zu begrenzen – und dies zu Kosten, die das weltweite Wachstum von zwei Billionen Dollar im Jahr auf eine Billion zurückstutzen würden. Allein die EU-Länder, die ihren Ausstoss bis 2050 um 80 Prozent verringern wollen, müssten dafür jährlich 3,3 Billionen Euro ausgeben, mehr als doppelt so viel wie für Gesundheit, Erziehung, Sicherheit und Verteidigung zusammen.

William Nordhaus bekam den Nobelpreis gerade dafür, dass er die Kosten und den Nutzen der Klimapolitik berechnete. Er empfiehlt eine moderate CO2-Steuer für die Welt und erkennt ein Optimum bei einer Politik, die gemäss IPCC bis Ende des Jahrhunderts zu einer Erwärmung um 3,5 Grad führt. Wenn die Staatengemeinschaft zu exorbitanten Kosten ein strengeres Ziel anstrebe, warnt er, dann mache sie die Welt ärmer, also auch für Katastrophen verletzlicher. Das heisst: Wer das Mantra predigt, wir müssten die Erwärmung auf deutlich unter zwei Grad begrenzen, der leugnet die Wissenschaft.

«Das Klimaproblem ist lösbar, aber unvergleichlich schwieriger, weil es weltweit ist, alle Sektoren betrifft und die grössten Probleme erst in Jahrzehnten sichtbar werden.»

Wenn es nach den Alarmisten ginge, müsste die Welt längst untergegangen sein. Schon 1972 forderte der Club of Rome einen Totalumbau der Wirtschaft, weil sie an die «Grenzen des Wachstums» stosse: Bis zum Jahr 2000 drohten alle wichtigen Rohstoffe wie das Erdöl auszugehen. Als das neue Millennium anbrach, gab es aber von diesen Rohstoffen grössere bekannte Reserven denn je. Die Warner lagen also falsch – so falsch wie der berühmte Untergangsprophet Thomas Robert Malthus: Der englische Pfarrer rechnete 1798 vor, dass die Menschheit verhungern werde, weil die Nahrungsproduktion linear ansteige, die Bevölkerungszahl aber exponentiell.

Die Apokalyptiker machen immer denselben Denkfehler: Sie rechnen Trends bis zum bitteren Ende hoch und zählen nicht auf die Erfindungsgabe der Menschen, die sie seit zwei Millionen Jahren auszeichnet. So brach, als Thomas Robert Malthus die Menschheit vor dem Hungertod warnte, gerade die Agrarrevolution an: Dank besseren Düngern, Züchtungen und Anbaumethoden, später auch dank dem Einsatz von Treibstoffen für Traktoren und Maschinen steigerte die Welt ihre Produktion stetig, so dass sie heute siebenmal so viele Menschen ernähren kann wie zur Zeit von Malthus.

Statt die Apokalypse zu fürchten, sollte sich die Menschheit um die wahren Probleme kümmern, meinen Kritiker wie Bjørn Lomborg. Mit seinem Copenhagen Consensus Center, bei dem weltführende Ökonomen wie der Zürcher Bruno S. Frey mitdenken (Seite 20), stellte er fünfzig führenden Wissenschaftlern die Frage, wie sich mit einem bestimmten Betrag der grösste Nutzen stiften lässt. So empfiehlt er günstige Massnahmen bei Gesundheit oder Ernährung, vor allem aber mehr Freihandel: Alle Menschen werden wohlhabender, also auch weniger verletzlich für Katastrophen, wenn die Welt das Wachstum vorantreibt – und es nicht mit ihrer Klimapolitik abwürgt.

Ja, das Klimaproblem ist lösbar. Aber nicht, wenn wir die Jungen aufschrecken, wie es auch Reto Knutti tut, sondern wenn wir auf die Menschen vertrauen, wie es der englische Wissenschaftsautor Matt Ridley rät (in: WELTWOCHE, Sonderheft „Klimawandel für die Schule“, 11.07.2019 Seite 18) : „Bleiben wir rationale Optimisten“.

=================================================================

Lesen Sie auf Seite 32 (WELTWOCHE, Sonderheft „Klimawandel für die Schule“, 11.07.2019) : Prof. Knuttis bereits erschienener Weltwoche-Aufsatz, auf den sich Markus Schär in seinem Artikel hier bezieht.

Markus Schär hat als Historiker seine Dissertation über die mentalen Folgen der Kleinen Eiszeit in Zürich geschrieben und sich als Bundeshaus-Redaktor derWeltwochebis 2017 vertieft mit der Klimaforschung auseinandergesetzt.

Er führt mit kritischen Kollegen die Website www.cool-down-schweiz.ch

=================================================================

)* Anmerkung der EIKE-Redaktion :

Dieser Artikel ist zuerst erschienen in der WELTWOCHE Zürich : Markus SCHÄR, „Wenn das Klima zur Glaubensfrage wird“ | Sonderheft „Klimawandel für die Schule“, (11.07.2019) ; http://www.weltwoche.ch/

EIKE dankt der Redaktion der WELTWOCHE und dem Autor Markus SCHÄR für die Gestattung der ungekürzten Übernahme des Beitrages.

=================================================================