Vor kurzen lasen Sie auf Eike den Bericht über obige Angelegenheit. Die lokale Zeitung brachte verschiedene Meinungen zum Thema:

Der Pro- Kommentar wurde durch Dr. Sean Connin, den Leiter des Clean Energy Program verfasst. Der Kontra Kommentar wurde durch John Droz jr., Physiker und Umweltanwalt verfasst.

Wie üblich, wichen die Kommentare einiger Leser dann auf die Bedrohung durch Klimawandel (AGW) aus, um ihre Vorliebe für Wind und Solarenergie voranzubringen. Zum Stichwort AGW veröffentlichte die Zeitung dann ein Opposite Editorial eines Paläoklimatologen, Dr. Curt Stager [… was Klimaleugner falsch machen], der sich vor allem an dem als unwissenschaftlich abgelehnten Konsens des Kontra Autoren abarbeitete.

Einleitung durch den Übersetzer

***

John Droz jr.

Ich war aus mehreren Gründen ziemlich überrascht, den Kommentar von Dr. Curt Stager [gemäß angloamerikanischen Gebräuchen im Folgenden nur Curt genannt] im Adirondack Almanac zu sehen. [… was Klimaleugner falsch machen]

Weshalb?

- Ich habe mich in der Vergangenheit mehrfach höflich mit Curt ausgetauscht und er hat nie etwas wie in der Zeitung geschrieben, direkt zu mir gesagt.

- sein Kommentar enthält mehrere Fehlschlüsse und

- weil er die traditionelle Wissenschaft so offen ablehnt.

Der letzte Punkt überrascht und beunruhigt mich am meisten. Überdenken Sie dieses Zitat von Curt vor acht Jahren (ich habe die wichtigsten Teile hervorgehoben):

„Wissenschaftler sind Menschen, die eine Vielfalt von Meinungen und Einstellungen widerspiegeln. Natürlich haben die meisten von uns diese lächerliche Situation satt, daher ist es nicht verwunderlich, dass Sie von so vielen hören, die diese Bedenken äußern. Ich bin es auch satt, aber ich bin auch nicht alleine in meinen Präferenzen, weil ich von „aggressiven Aktivistenhaltungen“ Abstand genommen habe. Ich tue das, weil ich Wissenschaft an sich mehr schätze als jedes einzelne Thema, das damit verbunden wird.

„Ich betrachte Wissenschaft als eine der wertvollsten Erfindungen der menschlichen Zivilisation, und ich erkenne, wie wertvoll und anfällig für Korruption sie für jemanden ist, der an die objektive Realität, die Fehlbarkeit der menschlichen Wahrnehmung und die Notwendigkeit objektiver Methoden zur Suche nach Wahrheit glaubt . Ich erkenne auch an, dass das Vertrauen der Öffentlichkeit in die Wissenschaft selbst stark vom Vertrauen in die Objektivität derer abhängt, die sie verfolgen. Wir müssen eine klare Linie zwischen der Verteidigung der Wahrheit und dem Versuch, sie anderen Menschen aufzuzwingen, gehen und ich persönlich entscheide mich dafür, diese Linie vorsichtiger zu gehen. “

Dies ist eine gut formulierte, wichtige Aussage – und ich würde jedem Wort zustimmen. Seit dieser Zeit ist Curt jedoch radikalisiert worden. Wie sein Adirondack-Almanack-Kommentar zeigt, hat er sein früheres Bekenntnis zu den Grundlagen seines Berufs im Wesentlichen aufgegeben und ist stolz ein politikwissenschaftlicher Aktivist zu sein.

————————

Auf den ganzen Unfug in seinem Kommentar korrekt zu reagieren, würde mehr Zeit und Platz in Anspruch nehmen, als es hier möglich ist. Daher werde ich nur einige Punkte davon ansprechen. Anspruchsvolle Leser können sich den Rest hoffentlich selbst interpretieren…

Beginnen wir mit einer einfachen Definition. Was wir diskutieren, heißt „Anthropogen Globale Erwärmung “(AGW). Grundsätzlich ist dies der Glaube, dass die globale Erwärmung fast ausschließlich durch vom Menschen verursachte Einflüsse (z. B. Verbrennung fossiler Brennstoffe) verursacht wird.

Der Kern des Problems besteht darin, dass Curt sich entschieden hat, sich selbst in ein Dilemma zu bringen. Einerseits möchte er, dass wir glauben, dass seine Ansichten über die AGW auf korrekter Wissenschaft beruhen – aber andererseits möchte er nicht durch die Zwänge belastet werden, wenn man die Verfahren der wirklichen Wissenschaft einhält. Anders ausgedrückt, seine Kommentare zeigen eine klare Unterscheidung zwischen echter Wissenschaft und Politikwissenschaft. Betrachten Sie einige Beispiele:

# 1 – Wenn zwei Wissenschaftler nicht übereinstimmen, legt jeder höflich die besten empirischen (d. h. realen) Beweise vor, von denen sie glauben, dass sie ihren Fall stützen. Zu keinem Zeitpunkt wird die Motivation des anderen, frühere Assoziationen, Überzeugungen, Schwiegermutter usw. verunglimpft, da dies für die vorliegende Diskussion irrelevant ist. Wenn Curt so überzeugt von den wissenschaftlichen Beweisen seiner Behauptungen wäre, warum sollte er dann ein einziges Wort seines limitierten Textfeldes vergeuden, um mich abzulehnen? Dies ist eine politische Taktik außerhalb von Wissenschaft.

# 2 – Curt macht dann fälschlicherweise geltend, dass die einzigen Personen, die zur Beurteilung der Gültigkeit der AGW-Angelegenheit kompetent genug seien, „nur wirklich qualifizierte Klimaforscher“ sein dürften. Ob die AGW-Hypothese korrekt ist oder nicht, beruht allein auf den Behauptungen ihrer Befürworter.

Jeder kompetente Wissenschaftler kann sehen, ob andere Wissenschaftler (auf ihrem Fachgebiet oder auf andere Weise) wissenschaftliche Regeln befolgt haben. Interessanterweise untergräbt Curt seine eigene Behauptung (das AGW der ausschließliche Bereich von Klimawissenschaftlern ist), indem er „Physik“ (d.h. mein Fachgebiet) als Grundlage für einige seiner AGW-Ansprüche zitiert.

# 3 – Curt beschreibt dann unkorrekt, was eine wissenschaftliche „Hypothese“ ist, indem er sie als „bloßes Schätzen“ bezeichnet. Hier ist eine vernünftige Definition:

„Die Formulierung und Prüfung einer Hypothese ist Teil der wissenschaftlichen Methode, mit der Wissenschaftler versuchen, Vorstellungen über Naturphänomene zu verstehen und zu testen. Die Erstellung einer Hypothese wird häufig als kreativer Prozess beschrieben und basiert auf vorhandenem wissenschaftlichem Wissen, Intuition oder Versuch. Die zwei Hauptmerkmale einer wissenschaftlichen Hypothese sind Falsifizierbarkeit und Nachweisbarkeit. “

# 4 – Curt weiß das sehr genau, ist jedoch nicht geneigt zuzugeben, dass die AGW-Angelegenheit eine Hypothese ist – da er die meisten der traditionellen, belastbaren wissenschaftlichen Methoden nicht einhalten möchte. Warum nicht? Aus verschiedenen Gründen wie:

- es ist zu zeitaufwändig,

- AGW ist zu kompliziert, um von der traditionellen Wissenschaft analysiert zu werden,

- AGW ist nicht falsifizierbar (siehe oben), und

- die traditionelle Wissenschaftsmethodik wirft erhebliche Zweifel an der AGW-Hypothese auf. Mit anderen Worten, sagt Curt, lassen Sie uns all das nervige Wissenschafts-Zeug überspringen und zur Sache kommen. Auch dies ist die Perspektive einer politisch argumentierenden Person: Lassen Sie uns die Regeln ändern!

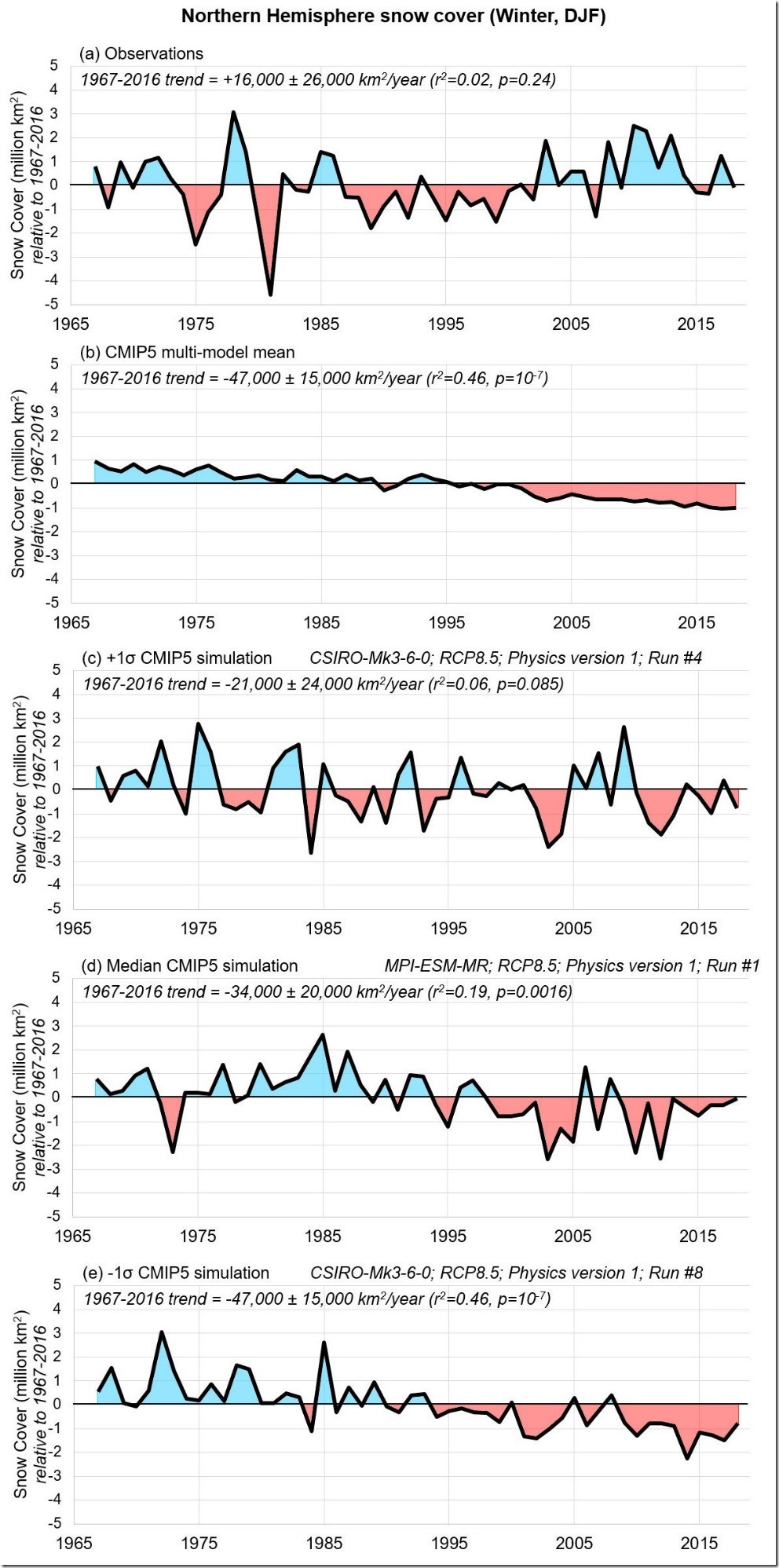

# 5 – Die AGW-Hypothese basiert fast ausschließlich auf Computermodellen. Computermodelle sind jedoch keine Zauberei: Sie sind das Ergebnis von (selbst) ausgedachten Rechenanweisungen für den dummen Computer, um ein bestimmtes Ziel (Ergebnis) zu erreichen und von den Daten, die von den Menschen dafür als wichtig erachtet werden. Aber wenn AGW zu kompliziert ist, um von der traditionellen Wissenschaft analysiert zu werden, wie können dann bestimmte Personen überhaupt entschlüsseln, welche Daten relevant sind und wie sie miteinander in Beziehung stehen? Anders formuliert: Wenn eine genaue Beurteilung der Gültigkeit und der Ergebnisse von AGW für die traditionelle Wissenschaft zu kompliziert ist, ist sie auch für Computermodelle zu kompliziert. Übrigens, Wissenschaftler konzentrieren sich auf empirische Daten. Politikwissenschaftler bevorzugen Computermodelle als Kinderspiel, um sie zu manipulieren (ohne das die Bürger sich dessen bewusst sein sollen), sodass jedes gewünschte Ergebnis erzielt werden kann…

# 6 – Es ist bedauerlich, dass Curt nicht öffentlich eingeräumt hat, dass wir RIESIGE Wissenslücken in unserem Verständnis des Klimas haben. Zum Beispiel scheint die AGW-Angelegenheit auf einer sehr grundlegenden Gleichung zu beruhen: der globale CO2-Anteil. Auf der einen Seite befinden sich „CO2-Quellen“, die entweder natürlicher Natur oder von Menschen gemacht sind. Auf der anderen Seite gibt es „CO2-Senken“, die zumeist natürlich sind. Wenn die Zuflüsse die Abflüsse (Absorptionen) übersteigen, haben wir einen Netto-CO2-Anstieg. Eines von mehreren Problemen ist, dass bis zu 30% der Abfluss-Seite der Gleichung nicht verstanden werden. Wie genau können Computermodelle sein, wenn es so viel Unbekanntes gibt? Traditionelle Wissenschaftler wissen sehr genau, was sie / wir wissen und wissen nicht. Politikwissenschaftler überdecken die unbekannten Zusammenhänge und Daten.

# 7 – In Curts Kommentar gibt es mehrere Verweise auf „Peer-Review“. Zwei Ergänzungen dazu. Erstens ist es rätselhaft, dass Curt die Leser nicht darüber informiert, dass es rund 2000 von Experten begutachtete Artikel gibt, die seine AGW-Position in Frage stellen (hier ein Beispiel). Ein Wissenschaftler stellt beide Seiten eines Streits objektiv vor. (Beachten Sie das Zitat von Curt zu Beginn!) Ein Politikwissenschaftler befürwortet nur seine eigene Agenda und tut so, als gäbe es keine andere vernünftige Schlussfolgerung als die ihre.

# 8 – Zweitens besteht das Ziel dieser Peer-Review-Hinweise darin, den zufälligen Leser davon zu überzeugen, dass die Wissenschaft die Behauptung von Curt‘s AGW-Hypothese unterstützt. Das ist schlicht nicht so. Laien müssen wissen, dass ein Peer-Review-Prozess NICHTS mit der Feststellung der Gültigkeit der Schlussfolgerungen einer Studie zu tun hat. Im Peer-Review-Prozess beispielsweise wiederholt KEIN EINZIGER irgendeins in der Studie angeführte Versuche, um die Ergebnisse zu überprüfen.

Um ein gutes Bild davon zu bekommen, worum es bei Peer-Review geht, lesen Sie die Aussage eines der wichtigsten Akteure des Prozesses, des Herausgebers der weltberühmten medizinischen Zeitschrift Lancet:

„Der Fehler ist natürlich die Ansicht, dass Peer Review mehr als ein grobes Mittel ist, um die Akzeptanz – und nicht die Gültigkeit – eines neuen Befundes zu bestätigen.

Redakteure und Wissenschaftler bestehen gleichermaßen auf der zentralen Bedeutung von Peer Review. Der Öffentlichkeit wird Peer Review als quasi-sakraler Prozess vorgestellt, der dazu beiträgt, die Wissenschaft zu unserem objektivsten Wahrsager zu machen.

Aber wir wissen, dass das Peer-Review-System voreingenommen, ungerecht, nicht nachvollziehbar, unvollständig, leicht voreingenommen, oft beleidigend, in der Regel unwissend, gelegentlich dumm und häufig falsch ist.“

Mit anderen Worten, Verweise auf Peer-Review zur Unterstützung der Behauptungen basieren auf der Prämisse, dass der Leser nicht über Peer-Review-Realitäten informiert ist. Dies ist eine Strategie, die von Politikwissenschaftlern genutzt wird: um einen Vorteil aus dem zu ziehen, was die Bürger nicht verstehen – um ihre eigenen Ziele zu fördern.

[Ein peer-review-prozess zeigt m.e. nur, dass die Gedankengänge des Autors in sich logisch sind (erscheinen). Um eine Aussage zur Gültigkeit (Wahrheit?!) der Schlussfolgerungen zu treffen, müssten die Bewerter selbst alle Versuche und Untersuchungen durchführen, auch müssten alle Daten und Annahmen vorliegen. – der Übersetzer]

# 9 – Auf derselben Linie liegt Curt’s Verweis auf „Konsens“. Oh Mann! Wenn Curt eine unwiderlegbare Wissenschaft zur Unterstützung seiner AGW-Hypothese hat, warum sollte er dann Zeit verlieren, indem er über solche unwissenschaftlichen Themen wie Konsens spricht? Schauen Sie sich die wissenschaftliche Methode genau an. Gehört Konsens dazu? NEIN!

Unstrittig ist auch, dass es in der Vergangenheit zahlreiche Fälle gab, in denen der Konsens dessen, was die Wissenschaftler glaubten, sich als falsch erwies. Echte Wissenschaftler sind sich dieser Realität durchaus bewusst, also würden sie niemals versuchen, ihre Hypothese zu rechtfertigen, indem sie auf die Überzeugungen anderer Wissenschaftler verweisen. Auf der anderen Seite geht es in der Politik (-wissenschaft) um Konsens.

# 10 – Trotz seines Kommentars von 1300 ± Wörtern sprach Curt nicht wirklich die Hauptpunkte an, die ich in meinem Adirondack Explorer-Artikel angesprochen hatte. Stattdessen faselte er beredsam über AGW – das war nicht das Thema, über das ich einen Beitrag schreiben sollte / geschrieben habe. Erneuerbare Energien im Adirondack Park waren meine Aufgabe. Er hat dazu nichts gesagt! Ist Ihnen jemals aufgefallen, dass wenn einem Politiker eine Frage gestellt wird, die ihm nicht gefällt, dass er das Thema reibungslos ändert? Das ist ein weiterer krasser Unterschied zwischen echter Wissenschaft und Politikwissenschaft.

# 11 – Die Bemerkungen von Curt zur Skepsis sind ebenfalls interessant. Er versteht, dass Skepsis das Markenzeichen eines echten Wissenschaftlers ist – er weist Sie also darauf hin, dass er [früher] mal ein AGW-Skeptiker war. Obwohl ich keinerlei skeptischen Berichte / Studien von ihm zur AGW finden konnte, bin ich bereit, sein Wort dafür zu nehmen. Aber jetzt, wo er zufrieden ist, warum sind es nicht auch alle anderen? Tatsächlich, wenn er eine erlernte Position vertreten hätte:

- die den Konventionen der traditionellen Wissenschaft folgen würde,

- die ehrliche Anerkennung, das wir viel über AGW nicht wissen,

- ohne 1. das folgte den Konventionen der traditionellen Wissenschaft,

- dass wir ehrlich anerkannt haben, wie viel wir über AGW nicht wissen,

- ohne ad hominems [Angriff persönlicher Umstände oder Eigenschaften des Streitgegners],

- ohne Hinweise auf solche unwissenschaftlichen Angelegenheiten wie Konsens und

- ohne falsche Implikationen zur Wahrhaftigkeit der Peer-Review zu machen,

– dann könnten wir erkennen, dass er auf der Grundlage wissenschaftlicher Erkenntnisse eine ernstzunehmende Aussage vorbrachte. Stattdessen bekamen wir eine politikwissenschaftliche Antwort, die kein Vertrauen weckt.

# 12 – Aus all dem ist klar, dass es in diesem AGW-Thema nicht wirklich um CO2 geht. Stattdessen ist dies nur ein bequemes Mittel für diejenigen, die unsere amerikanische Lebensweise radikal verändern wollen – um uns buchstäblich in eine agrarisch-marxistische Gesellschaft zu verwandeln. Glauben Sie meinen Worten nicht, sondern prüfen Sie genau die Elemente (und Konsequenzen) des Green New Deal (voller Wortlaut im Original), der nur ein Testballon für das ist, was wirklich die Agenda ist, die hier durchgesetzt werden soll.

Unter dem Strich wollen Curt und andere ähnliche denkende Parteien, dass wir mehr als 100 Billionen US-Dollar investieren:

- um ihre AGW-Hypothese zu akzeptieren, die sich nicht mit traditionellen Wissenschaft Regularien abgibt, und

- um „Lösungen“ zu implementieren (wie die industrielle Windenergie), die keinerlei wissenschaftliche Grundlage haben.

Was ist falsch gelaufen?

John Droz, jr. Physicist Brantingham Lake, NY 3-18-

Die übersetzte Stellungnahme findet sich hier .pdf, etwa Mitte März 2019

Übersetzt durch Andreas Demmig