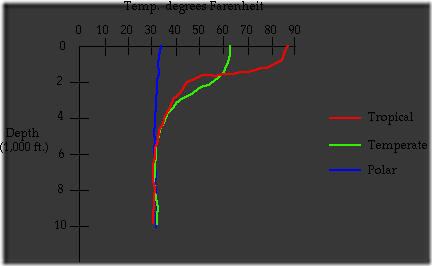

Europa schrammte »knapp an einer Katastrophe« vorbei, zitiert »Der Standard« aus Wien Experten, wie auf dieser Kurve zu sehen ist.

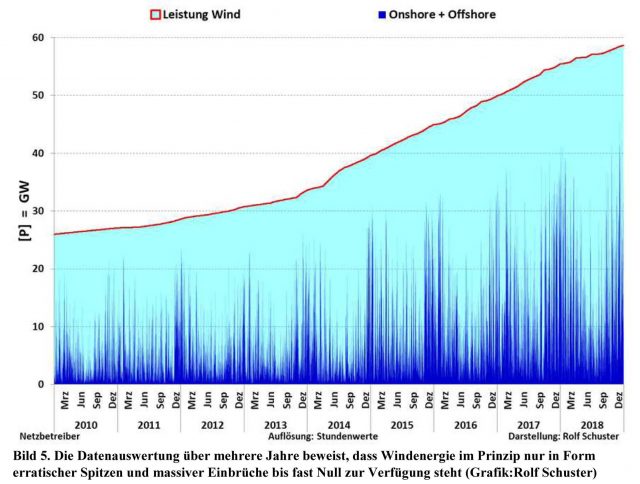

Die Frequenz ist das entscheidende Maß dafür, ob genügend Strom produziert wird. Denn der kann nicht in größeren Mengen gespeichert, sondern muss in genau dem Augenblick erzeugt werden, in dem er gebraucht wird. Angebot und Nachfrage müssen immer im Gleichgewicht stehen. Nicht mehr ganz einfach, denn mehr und mehr Windräder und Photovoltaikanlagen speisen »Wackelstrom« in die Netze. Der muss sogar den Vorrang vor dem gleichmäßigen Strom aus Kraftwerken bekommen.

Sämtliche Stromerzeuger und Verbraucher in Europa takten im Gleichklang von 50 Hertz. Sinkt die Frequenz unter diesen Wert, so herrscht Strommangel und die Netzbetreiber müssen schnellstens weitere Stromquellen dazuschalten – oder eben möglichst schnell Stromverbraucher abschalten.

An jenem Donnerstagabend warfen die Netzbetreiber »Lasten ab« und schalteten Industriebetrieben, die viel Strom verbrauchen, denselben ab. Der französische Netzbetreiber RTW warf mehr als 1,5 GW ab, Strom für hauptsächlich Industriebetriebe. Abwerfen, das heißt in der Sprache der Stromerzeuger: Strom aus. Sofort, meist ohne Vorwarnung.

Das geschieht automatisch in mehreren Stufen, um die Netzfrequenz aufrecht zu erhalten. Sackt die trotzdem noch weiter unter 47,5 Hertz ab, wird das Stromnetz abgeschaltet. Blackout total. Nichts geht mehr.

Sollten irgendwann einmal tatsächlich nur noch Windräder Strom erzeugen, so könnten noch nicht einmal mehr das Stromnetz wieder in Gang gesetzt werden. Nur mit Windrädern allein klappt das aus technischen Gründen nicht. An jenem Donnerstag ging es gerade noch einmal gut. Lasten wurden nur in einer ersten Stufe abgeworfen, das reichte, um das Netz wieder zu stabilisieren.

Wenig später teilte der österreichische Übertragungsnetzbetreibers APG mit, dass »ein Datenfehler an einem Netzregler« im Gebiet der deutschen TenneT, den Störfall auslöste. Die Störung habe jedoch gezeigt, dass das europäische Schutzsystem nach dem Frequenzabfall gegriffen und die Frequenz sofort wieder in den Normalbetrieb zurückgeführt habe.

Ob aber dieser Messfehler die einzige Ursache war, bezweifeln die Experten des Verbandes Europäischer Übertragungsnetzbetreiber ENTSO in Brüssel.

Einen Blackout befürchten manche Energiemanager hierzulande nicht. Sie verweisen darauf, dass im Zweifel Strom aus dem Ausland eingekauft wird. Kosten spielen sowieso keine Rolle mehr im Energiewendenwahnsinn.

Doch was, wenn nicht mehr genügend Erzeugerkapazitäten in Europa bereitstehen? Die französischen Kernkraftwerke schwächeln, im vergangenen Sommer waren die Schweizer Speicherseen ziemlich leer. Häufiger müssen auch Länder wie Frankreich, die Schweiz und Belgien Strom importieren.

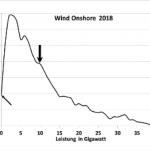

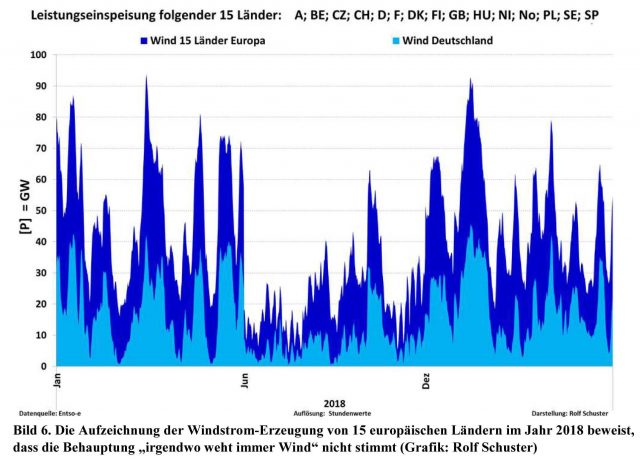

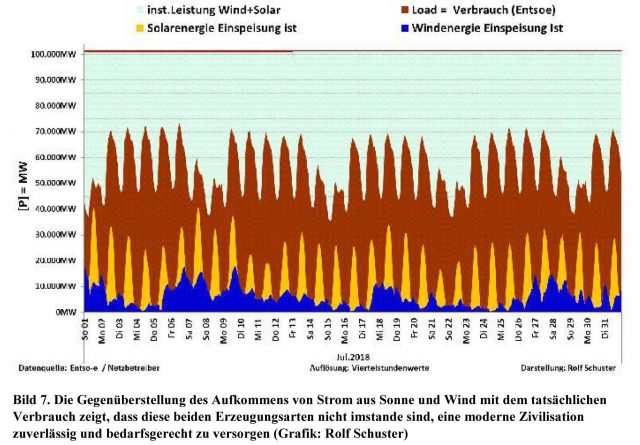

Strom ist nicht gleich Strom. Es hängt davon ab, wann er gebraucht und produziert wird. Wind und Sonne liefern zu ungleichmäßig, können ein Industrieland wie Deutschland nicht mit Energie versorgen. Deutschland exportiert häufig dann Strom, wenn auch im europäischen Netz zu viel vorhanden ist. Dann muss oft genug noch eine gute Stange Geld mitgeliefert werden, damit irgendjemand diesen Strom abnimmt.

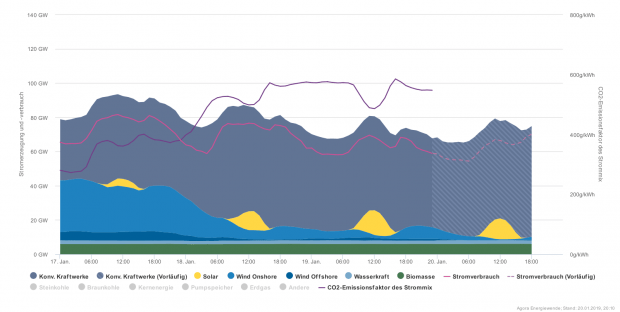

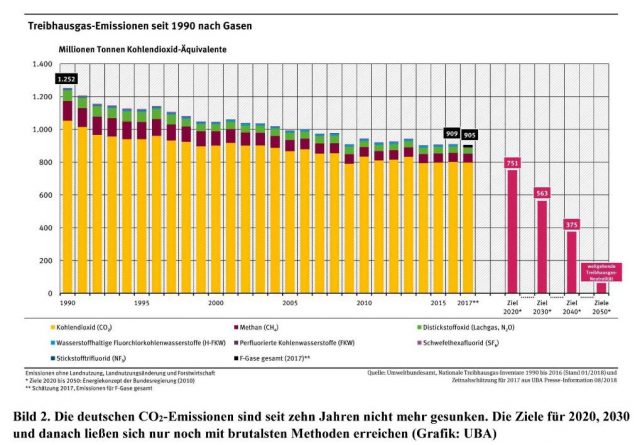

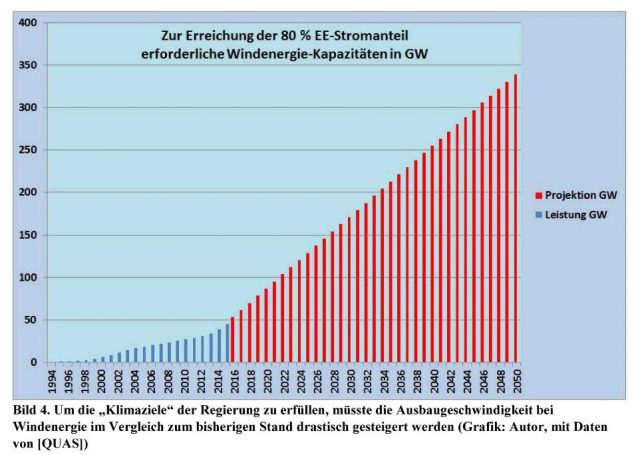

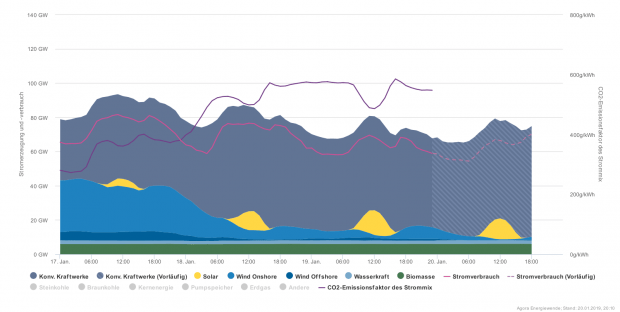

Und ohne Kernenergie, Kohle und Gas hätte Deutschland am vergangenen Wochenende im Dunkeln gesessen. Wind und Sonne lieferten mal wieder nicht. Die beiden unteren kleinen blauen Flächen zeigen, dass kaum Strom kam. Gegen Mittag lieferten die Photovoltaikanlagen kurzzeitig ein wenig Strom. Doch von der Sonne kommt noch nicht so viel Energie wie im Sommer an, sie steht zudem noch sehr schräg am Himmel. Die konventionellen Kraftwerke mussten den Löwenanteil bei der Stromerzeugung abdecken. Noch hat niemand von den Energiewendlern erklärt, woher der Strom kommen soll, wenn die letzten Kohle- und Kernkraftwerke abgeschaltet sein werden. Dann herrscht Nacht über Deutschland.

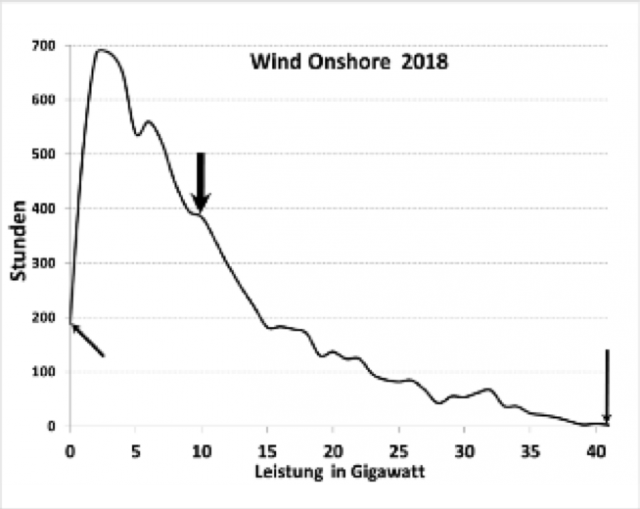

Ein paar Tage vorher um den 17. Januar, weht der Wind wenigstens noch einigermaßen, wie das Schaubild (oben) zeigt.

Unternehmen in Deutschland protestieren mittlerweile heftig gegen immer häufigere Abschaltungen. Sie müssen immer häufiger damit rechnen, dass ihnen kurzfristig der Strom abgeschaltet wird, und sie ihre Produktion stillegen müssen.

»Bisher sind dieses Jahr (gemeint ist das Jahr 2018) 78 Abschaltungen alleine der Aluminiumhütten erfolgt«, zitiert die FAZ einen »Brandbrief« der Hydro Aluminium aus Neuss an den Präsidenten der Bundesnetzagentur. Das sei ein neuer Rekord.

Aluminiumhütten gehören zu den großen Stromverbrauchern. Eine jener waghalsigen Ideen der Energiewende ist, solchen Großverbrauchern den Strom abzuklemmen, wenn Flaute im Netz herrscht und weder Wind noch Sonne genügend Energie liefern. Damit kappen sie zwar die Spitzen im Stromverbrauch, bringen aber gleichzeitig die Unternehmen in erhebliche Schwierigkeiten. Die benötigen den Strom in der Regel nicht aus Freude am Spielen, sondern für ihre Produktion. Sie bekommen zwar ein Entgelt für die Stromabschaltung, die 15 Minuten vorher angekündigt werden muss. Doch das nutzt nicht viel, haben sie doch Lieferverpflichtungen. Bei einem längeren Stromausfall kann in Verhüttungsbetrieben oder in Glaswerken die Schmelze erstarren und die Anlagen zerstören.

Die FAZ beschreibt zum Beispiel den 14. Dezember vergangenen Jahres. Der Tag war eigentlich als ein sonniger Tag eingeplant, bei dem die Photovoltaik-Anlagen viel Energie in die Netze einspeisen sollten. Grundlage war die spezielle Wettervorhersage, die für die Stromversorger produziert wird. Doch das Wetter hält sich nicht immer an die Vorhersage vom Tage zuvor. Es kommt häufig anders.

Der Himmel über Deutschland war an jenem Freitag fast durchgängig bedeckt. Nur an einigen Stellen kam kurz die Sonne durch. Die schwerwiegende Folge: In Deutschland gab es zu wenig Strom. Die Netzbetreiber wollten den Strom bei einer Reihe von Industriebetrieben abschalten, vor allem bei jenen, die viel Strom verbrauchen wie Aluminiumhütten, Walzwerke und Gießereien.

Das ist vereinbart, dafür bekommen sie auch Geld, und das hilft den Netzbetreibern, die Spitzen im Stromverbrauch abzusenken. So können sie das Netz gerade noch stabil halten, Haushalte und Büros verfügen weiterhin über Strom. Gegen 15 Uhr konnten die normalen Energieerzeuger wieder genügend Strom liefern, der Engpass war vorbei.

»Später wird bei Netzbetreibern von einem ›Prognosefehler bei den erneuerbaren Energien aufgrund einer seinerzeit komplexen Wetterlage‹ die Rede sein«, schreibt die FAZ.

Eine Papierfabrik aus dem niedersächsischen Varel hatte früher bereits eine Verfassungsbeschwerde dagegen eingelegt, dass der zuständige Netzbetreiber auf das Kraftwerk des Betriebes zugreifen darf, wenn zu wenig Strom im öffentlichen Netz vorhanden ist. Doch die Bundesverfassungsrichter wiesen diese Beschwerde gegen die Eingriffe in das Eigentumsrecht des energieintensiven Betriebes kurzerhand zurück.

Es sind jedoch nicht nur die großen Stromabschaltungen, die der Industrie zu schaffen machen. Auch die Qualität des Stromes nimmt ab. Kurzfristige Frequenzschwankungen nehmen zu. Die können die empfindlichen Rechnersteuerungen von Produktionsanlagen, Grafikkarten oder Netzteilen in Rechnern zerstören.

Der österreichische Blackout-Experte Herbert Saurugg beobachtet die sich häufenden kritischen Netzsituationen. Für ihn ein Zeichen zunehmender Instabilitäten im europäischen Verbundsystem. Die Netzschwankungen könnten immer schlimmer werden, meint der ehemalige Major des österreichischen Bundesheeres.

Vorräte einkaufen, empfiehlt er. Man könne sich bei der Planung an einem zweiwöchigen Campingurlaub orientieren. Und er hat noch einen Tipp für den Stromausfall.

»Gemeinsam lassen sich derartige Krisen deutlich besser bewältigen. Nutzen wir auch die damit verbundenen Chancen: Kommen Sie mit Ihrer Nachbarschaft ins Gespräch. Der soziale Zusammenhalt ist gerade in einer solchen Situaton überlebenswichtig.«

So haben wir die »Energiewende« noch nicht gesehen: der Blackout als soziales Instrument.

Der Beitrag erschien zuerst bei TICHYS Einblick hier