ANTONIA HOYLE

Oonagh Dalgliesh gibt als erstes zu, dass sie gerne schwanger wäre. Sie ist verzaubert von der Idee, ein Baby aufwachsen zu sehen, dieses erste schiefe Lächeln zu bewundern, diese zaghaften ersten Schritte und die jungen Versuche der Unabhängigkeit, die die Herzen der meisten Mütter zum Schmelzen bringen.

Trotzdem hat sie beschlossen, dass sie nie die Freude erleben will, schwanger zu sein.

Mit 32 ist Oonagh sicher im gebärfähigen Alter. Mit einem gut bezahlten Job als Eventmanagerin ist sie finanziell solvent. Und seit einem Jahr hat sie eine ernsthafte Beziehung zu einem Mann, der sich danach sehnt, Vater zu werden.

Was hat diese wichtige Entscheidung ausgelöst? Einfach ausgedrückt? Ihr Wunsch, den Planeten zu retten.

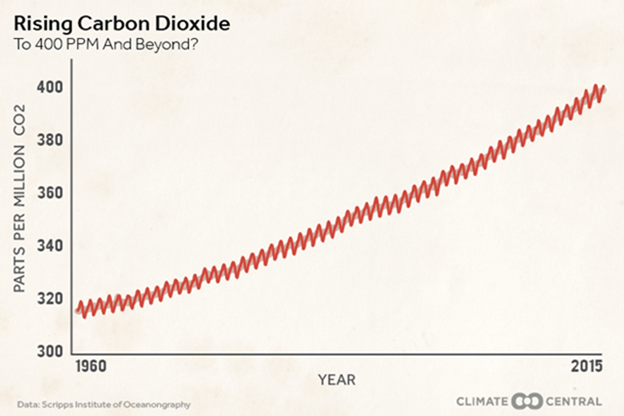

„Der Mensch ist der größte Einzeltreiber für den Klimawandel und die Treibhausgasbeiträge, für die Entwaldung und den Säuregehalt der Ozeane“, erklärt sie ernst. „Das einzige, was diese Probleme beheben wird, ist, dass weniger Menschen auf dem Planeten leben. Ich sehe es als nicht gerechtfertigt an, mehr Menschen heranwachsen zu lassen, als wir bereits haben. Ja, ich habe einen mütterlichen Instinkt, aber ich werde meine Meinung nie ändern.

Drastisch? Vielleicht. Aber so erstaunlich, wie es klingt, ist Oonagh eine von vielen britischen Frauen, die sich dafür entscheiden, kinderfrei zu bleiben, nicht wegen Karrierewünschen oder der Unfähigkeit, einen Partner zu finden, sondern weil sie wegen der lähmenden Auswirkungen der Überbevölkerung auf die Erde besorgt sind.

Verrückt? Sie dagegen fordern Sie auf, die Fakten zu berücksichtigen. Die Weltbevölkerung wächst alle 12 bis 15 Jahre um eine weitere Milliarde.

Bis zum Jahr 2050 soll die Menschheit um weitere 30 Prozent zugenommen haben.

Während ein Großteil der Bevölkerungsexplosion in Entwicklungsländern stattfindet, wo Mangel an Verhütungswissen und Ausbildung bedeutet, dass Frauen mehr Kinder haben, ist das Thema hier in Großbritannien genauso drängend.

Ihr Beweis? Im vergangenen Jahr verzeichnete die Bevölkerung Großbritanniens den stärksten Anstieg seit fast 70 Jahren.

Obwohl das Amt für nationale Statistiken sagte, dass die internationale Nettozuwanderung der Hauptantrieb für das Wachstum war, gab es auch einen Anstieg der Geburten und weniger Todesfälle. Mit unserem starken Verbrauch fossiler Brennstoffe wie Benzin, Kohle und Gas, so argumentieren sie, nutzen wir derzeit fast das Dreifache der erneuerbaren Ressourcen, die unser Land zur Verfügung stellen kann.

Wir sind auch eines der am stärksten naturbelasteten Länder in Europa und verlieren viele Arten von Wildtieren, über dem globalen Durchschnitt.

Außerdem werden wir daran erinnert, dass wir 200.000 neue Häuser pro Jahr brauchen, um die Anforderungen unserer wachsenden Bevölkerung zu erfüllen, und erstaunlicherweise liegt der dicht besiedelte Südosten Englands an 161ter Stelle von 180 Gebieten weltweit in Bezug auf seine Fähigkeit, ausreichend Wasser für seine Bewohner zu liefern.

Die britische Wohltätigkeitsorganisation Population Matters führt die Kampagnen für das heikle Thema der Bevölkerungskontrolle an.

Sie hat derzeit Tausende von Mitgliedern in Großbritannien und auf der ganzen Welt, mit hochkarätigen Schirmherren – darunter Sir David Attenborough, TV-Naturforscher Chris Packham und der kinderlose Autor Lionel Shriver – die das Wort über die Gefahren der Fortpflanzung auf dem Planeten verbreiten.

Natürlich ist die Weltuntergang – Panikmache zum Bevölkerungswachstum nichts Neues.

Thomas Malthus, ein anglikanischer Geistlicher aus dem 18. Jahrhundert, glaubte, dass eine Bevölkerungsexplosion die Welt einer Hungersnot und einem Desaster aussetzen würde. Die Bevölkerung würde sich alle 20 Jahre verdoppeln, bis die Menschen nicht mehr in der Lage wären, Lebensmittel schnell genug zu produzieren, um sich zu ernähren.

Malthus ‚Theorie, die auf der falschen Annahme basiert, dass die Zahlen stetig und gleichmäßig wachsen, wurde seitdem von Ökonomen diskreditiert, die die industrielle Revolution als Rettung vor dem von ihm vorhergesehenen Untergang bezeichneten. Technologische Innovationen ermöglichten es der modernen Gesellschaft, sich mit ausreichenden Ressourcen auszustatten.

Aber das Problem wird nicht verschwinden. Eine Reihe von Websites, die das Problem der Überbevölkerung thematisieren, sind ebenfalls in den letzten Jahren entstanden, wobei Gespräche mit jungen britischen Männern und Frauen geführt wurden, die es ernst meinen mit ihrem Wunsch, durch die Zeugung nicht zur Belastung des Planeten beizutragen.

In diesen Foren bekennen viele, dass ihre Familien, Freunde und oft auch Partner von ihrer Entschlossenheit enttäuscht sind, keine Familie zu haben.

Es ist zweifellos ein emotionales und spaltendes Problem, aber Oonagh ist entschlossen.

Als engagierte Vegetarierin wurde sie von ihrer Mutter, einer Sonderschullehrerin und ihrem Vater, einem Personalsachbearbeiter, „grün“ erzogen.

Sie entschied, dass sie nach dem Studium von Klimawandel und Energiemanagement an der Universität von West England keine Kinder haben wollte.

„Die Wissenschaft, dass Überbevölkerung den Planeten schädigt, war vorhanden und sobald ich es gelernt hatte, konnte ich nichts anderes tun, da ich wusste, dass es richtig war“, sagt Oonagh aus Bristol.

So überzeugt war sie, dass sie mit ihren späten 20ern begann, die Möglichkeiten zu untersuchen, sich sterilisieren zu lassen.

„Der NHS [staatliche Gesundheitskasse] wird für mich nichts tun, weil sie nicht akzeptieren können, dass ich meine Meinung nicht ändern werde“, sagt sie.

„Die Leute sind überrascht, eine junge Frau zu sehen, die sich so sicher ist, dass sie keine Kinder will. Ich habe meine Gründe nicht genannt – ich denke nicht, dass ich es sollte. „

Jetzt in ihren 30ern, ist sie entschlossen, dem Wunsch nach Kindern nicht nachzugeben, trotz der Tatsache, dass alle ihre Freunde Babys haben.

Aber ihr Freund des vergangenen Jahres, ein 33-jähriger Ingenieur – der, wie sie zugibt, „einen noch größeren Kinderwunsch hat“ als sie – teilt ihre Umweltanliegen nicht.

Wie um alles in der Welt, denkt sie daran, diese heikle Frage zu bewältigen?

„Ich bin mir wirklich nicht sicher“, gibt sie zu, obwohl Adoption eine Möglichkeit sein könnte. „Die Betreuung von Kindern liegt in meiner Natur und es gibt Kinder in Großbritannien ohne liebevolle Familie, deren Auswirkungen auf die Umwelt bereits in Stein gemeißelt sind.“

Was denkt sie über Frauen mit großen Familien?

„Vier oder fünf Kinder zu haben, ist unverantwortlich. Warum sollte man sich für das Recycling interessieren, wenn man fünf Kinder im Wert von Abfall aufzieht?

[Ja, so steht es tatsächlich im Original: „‘Why bother recycling if you’re consuming five kids’ worth of waste?“; der Übersetzer]

„Ich würde mir nicht anmaßen, den Leuten zu sagen, wie sie sich fühlen sollen, aber sie sollten mit dem Wissen über Probleme der Überbevölkerung ausgestattet werden. Ich denke, es gibt einen Mangel an Bewusstsein. Die Beziehung zwischen der Anzahl der Kinder und den Auswirkungen auf die Umwelt wurde ihnen nicht dargelegt.“

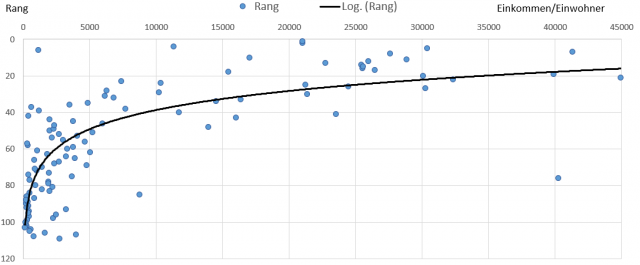

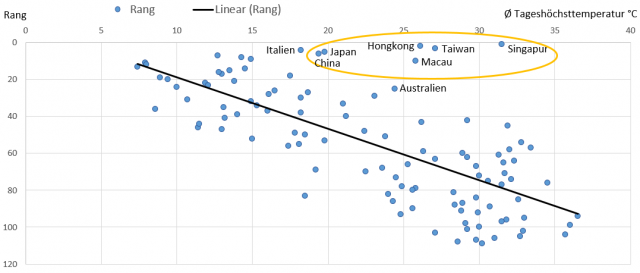

Die Anzahl der von britischen Frauen geborenen Kinder ist in den letzten Jahrzehnten zurückgegangen, von durchschnittlich 2,21 bei Frauen die 1944 geboren wurden, bis zu 1,90 für Kinder, die 1971 geboren wurden.

[Zur Info https://de.wikipedia.org/wiki/Liste_der_Länder_nach_Geburtenrate]

Ein Zustrom von Einwanderern im gebärfähigen Alter, die aus Kulturen stammen, in denen Familien tendenziell größer sind, und die Tatsache, dass wir alle länger leben, dürften unsere Bevölkerung von derzeit 65,6 Millionen auf über 70 Millionen steigern bis 2026.

Natürlich ist es nicht nur kontrovers, sondern nahezu unmöglich, Frauen vorzuschreiben, sich nicht fortzupflanzen.

„Man kann die Menschen nicht zwingen, keine Kinder zu haben und das würden wir auch nie tun“, sagt Population Matters Direktor Robin Maynard. „Es geht um positive Überzeugungsarbeit. Wir finden viel Resonanz bei der umweltbewussten Millennium-Generation, von denen viele sagen, dass sie sicherlich bei zwei Kindern aufhören werden. Das Wirkungsvollste was Sie tun können, um Ihren ökologischen Fußabdruck zu reduzieren, ist, ein Kind weniger zu haben.“

* * *

Aber Experten, die sich gegen Bevölkerungswachstum einsetzen, müssen auch dem Stigma begegnen, dass Frauen, die sich entschließen, keine Kinder zu haben, irgendwie selbstsüchtig sind – ein Stereotyp, den Anna Hughes, 35, zurückweist.

„Man könnte sagen, ich bin selbstlos, wenn ich keine Kinder will, aber ich trage nicht zur Überbevölkerung bei. Das erleichtert es Ihnen und Ihren Kindern, einen Platz in der Kita zu bekommen“,

sagt Anna, eine Ausbilderin fürs Radfahren, wurde mit „Respekt vor der Umwelt“ erzogen und erkannte Anfang 20, dass sie, obwohl sie eine von vier Schwestern mit zwei Nichten und drei Neffen ist, selbst keine Kinder haben will.

„Wir verwenden mehr Ressourcen, als die Erde bereitstellen kann, und wir können nicht exponentiell expandieren – das ist einfache Mathematik“, so Anna, eine Veganerin, die Kleidung aus Wohltätigkeitsgeschäften kauft und in einem Hausboot an einem Kanal in Bath, Somerset, lebt, um ihren eigenen ökologischen Fußabdruck zu begrenzen.

Als sie ihren Freunden zum ersten Mal von ihrer Entscheidung erzählte, gingen sie alle davon aus, dass sie ihre Meinung irgendwann ändern würde – eine Reaktion, die sie bevormundend fand.

„Heute bin ich Mitte 30 und habe meine Meinung immer noch nicht geändert. Die meisten meiner Freunde bewundern mich jetzt, dass ich standhaft geblieben bin. Manche fragen, ob ich ihnen gegenüber kritisch bin, weil sie Kinder haben, aber sie verstehen meine Gründe.“

Es gab nur eine Beziehung, in der Annas Entscheidung, absolut keine Kinder zu bekommen, ein Problem war.

Das war mit einem Mann, mit dem sie zwei Jahre lang mit Mitte 20 zusammen war, und der glaubte, dass sie schließlich zustimmen würde, Nachwuchs zu bekommen. „Nein, wir haben uns getrennt“, sagt sie. Jetzt, als Single, würde sie sich gerne irgendwo niederlassen und hofft, dass ihre Weigerung, Mutter zu werden, ein Bonus ist.

„Heutzutage sind viele Männer, die ich treffe, geschieden und haben oft Kinder. Ich glaube also nicht, dass ich sie nicht nehmen würde. Es wäre schön, Kinder aufzuziehen. Aber sie müssen nicht mein eigenes Fleisch und Blut sein.

Ein Teil ihrer Argumentation dafür, dass sie keine Mutter wird, ist, dass sie fürchtet, welche Zukunft ihre Kinder haben würden, sollten die Auswirkungen der Überbevölkerung anhalten.

„Ich werde nicht mehr sein, bevor das einen wirklichen Einfluss hat, aber ich sorge mich um meine Nichten und Neffen. Wie wird ihre Zukunft sein? Es ist erschreckend.

Sicherlich hat sie Anlass zur Sorge. Aufgrund unserer schnell wachsenden Bevölkerung werden bis 2025 zusätzliche 750.000 Schulplätze in England benötigt.

Und laut den Vereinten Nationen ist England mit 410 Menschen pro Quadratkilometer bereits die am stärksten übervölkerte Nation in der EU.

[Zur Info: https://de.wikipedia.org/wiki/Bevölkerungsdichte]

* * *

Für Helen Campbell, 40, aus Hay-on-Wye, Südwales, ist die Entscheidung, keine Kinder zu haben, mit ihrem Wunsch verbunden, ihren weniger umweltfreundlichen Aktivitäten entgegenzuwirken.

„Mein Mann Kenny und ich lieben Sportwagen, wir fliegen gerne in den Urlaub und leben in einem großen denkmalgeschützten Gebäude, das keine Doppelverglasung erlaubt. Das erhöht unseren Heizungsbedarf“, sagt Helen, die eine Firma besitzt, die Krüge mit lokalen Künstlern herstellt. „Es muss ein Gleichgewicht geben. Wir können nicht alles machen, was wir wollen, und es geht darum, was ich tun kann, um meinen Einfluss zu verringern.

„Menschen sind schlecht für die Umwelt und ich mag die Idee nicht, dafür verantwortlich zu sein, noch einen weiteren auf den Planeten zu bringen.“

Sie sagt, sie habe sich bereits entschieden, als sie Kenny, 50, einen Sportreporterin für die Formel 1, in der Mitte ihrer 30er traf.

„Freunde und Familie dachten, ich würde irgendwann diesen überwältigenden Drang nach Fortpflanzung verspüren, aber das habe ich nie“, sagt sie.

Sie gibt zu, Feindseligkeit über ihre Ansichten zu erleben. „Ich traf eine Frau bei einem Konzert, die sagte, sie sei „so egoistisch“gewesen wie ich, bevor sie ihren Sohn bekam.

„Eine andere Frau, mit der ich einmal gearbeitet habe, brach in Tränen aus, als ich sagte, dass ich nie Kinder bekommen will, weil sie es wollte aber selbst nicht schwanger werden konnte und daher meine Wahl nicht glauben konnte. Aber ich denke nicht, dass das was ich mache, schlecht ist.“

Ihr Mann Kenny, sagt sie, ist ähnlich eingestellt wie sie, zum Kinder bekommen.

„Für mich ist die Umwelt das große Thema, während für ihn seine anspruchsvolle Arbeit die Elternschaft unmöglich machen würde.“

* * *

Joe Gray und seine Frau Romita, beide 36 und Absolventen der Cambridge University, lernten sich 2007 als Studenten kennen und heirateten später, bestehen ebenfalls darauf, dass sie kinderfrei bleiben werden.

Joe, ist ein medizinischer Redakteur in St. Albans, Hertfordshire, sagt, dass der Schaden, den die Menschen den Tierarten antun, der treibende Faktor bei seiner Entscheidung ist.

„Ich möchte der menschlichen Spezies nichts hinzufügen – jedes weitere Kind ist eine weitere Person, die Ressourcen verbraucht und mehr von dem schwindenden Raum für sich nimmt, der für die unberührte Natur übrig bleibt. Ich bin nicht anti-menschlich, aber es ist ethisch falsch, andere Spezies zum Aussterben zu treiben.

Seine Frau Romita, ist Gesundheitsökonomin und Diplom Naturwissenschaftlerin, ist ebenfalls besorgt über die Auswirkungen der Überbevölkerung auf die Menschen. Sie gibt zu, dass ihre Mutter ein wenig enttäuscht war von ihrer Entscheidung, keine Kinder zu haben, und dass sie, als sie 30 wurde, sich fragte, ob sie das noch einmal überdenken sollte.

Aber, nach ein paar Monaten wusste sie, dass sie die richtige Wahl getroffen hatte. „Ich würde mich so schuldig fühlen, ein anderes Kind zur Welt zu bringen, das die begrenzten Ressourcen aufbrauchen würde, es würde sich nicht positiv anfühlen.“

Joe gibt jedoch zu, dass er auf Unverständnis trifft. Wenn Leute mich fragen, warum ich keine Kinder habe, sage ich es ihnen. „Die Leute nehmen das Thema nicht ernst und ich werde angeschaut, als wäre ich eine Art Spinner, der will, dass die Menschen aussterben.“

„Dagegen, die Überbevölkerung ernst zu nehmen, bevor es zu spät ist, bietet den Schlüssel für eine langfristigen Zukunft der Menschheit.“

Und, die Vereinten Nationen argumentieren, wenn jede Familie in der Zukunft durchschnittlich ein halbes Kind weniger hätte, als derzeit prognostiziert, wird es bis zum Jahr 2050 eine Milliarde weniger Menschen geben, und bis zum Ende des Jahrhunderts vier Milliarden weniger.

„Wir müssen über die Auswirkungen nachdenken, die ein zusätzliches Kind auf Freunde, Familie und Nachbarn, auf die weitere Gemeinschaft und auf die Welt bedeutet“, sagt Maynard. „Es wird Zeit brauchen, aber wenn wir die Menschen dazu bringen würden, sich mit ein oder zwei Kindern zu beschränken, könnten wir uns auf eine nachhaltige Bevölkerung zubewegen.“

Gefunden auf The Daily Mail vom 8 Juni 2018

Übersetzt durch Andreas Demmig

http://www.dailymail.co.uk/femail/article-5819361/Women-refuse-babies-save-planet.html

* * *

Und hier als Kontrast für unsere Leser:

http://web.archive.org/web/20100531175731/http://www.pi-news.net/2010/05/elternquote-gefordert/