Warum die Überschwemmungen in Houston kein Zeichen von Klimawandel sind

Roy W. Spencer

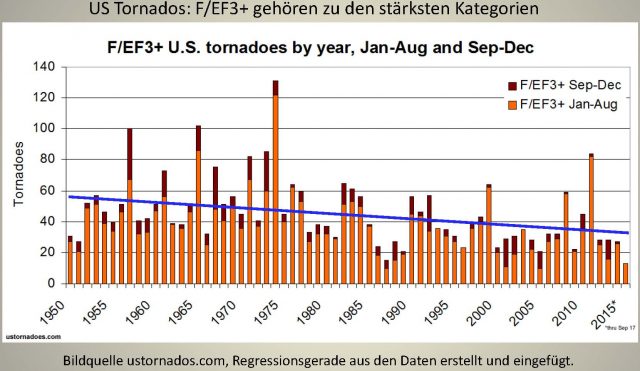

Es gab schon viele Überschwemmungskatastrophen in der Region um Houston, auch schon Mitte des 19. Jahrhunderts, als die Gegend noch sehr dünn besiedelt war. Im Dezember 1935 war es zu einer massiven Überflutung im Bereich des Stadtzentrums gekommen, als der Pegel bei Buffalo Bayou in Houston das Rekordniveau von 54,4 Fuß [ca. 16,5 m] erreichte. Zum Vergleich: um 6.30 Uhr [Ortszeit] am Montag Morgen lag der Pegelstand an der gleichen Stelle bei 38 Fuß [ca. 11,5 m], also immer noch 16 Fuß [fast 5 m] unter dem Niveau von 1935. Ich bin sicher, dass der Pegel noch steigt. Es gibt keinen Aspekt in der Theorie der globalen Erwärmung, dem zufolge sich die Regen bringenden Wettersysteme langsamer verlagern, wie es derzeit in Texas der Fall ist. Das ist einfach eine Zufallsverteilung. – Roy W Spencer 28 August 2017

————————————————

Hurrikan Harvey im Zusammenhang

Judith Curry

Wer auch immer Hurrikan Harvey mit globaler Erwärmung in Zusammenhang bringt, hat keine Grundlage.

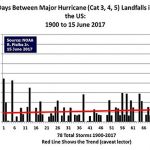

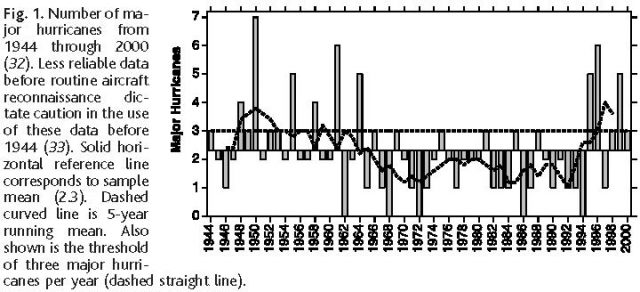

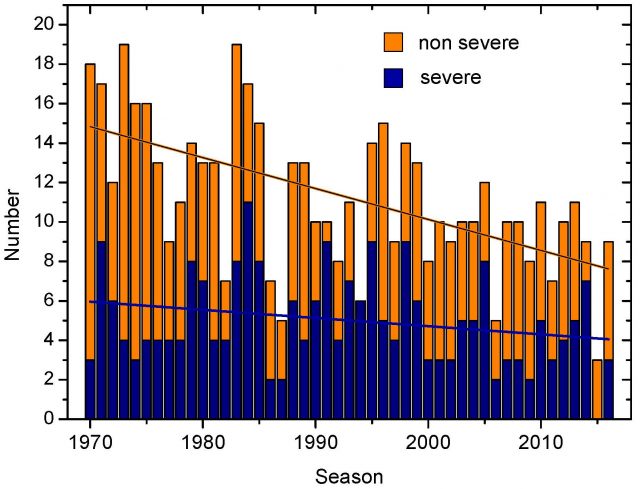

Der Zeitraum von 12 Jahren, ohne dass ein starker Hurrikan auf das US-Festland übergetreten ist, ist beendet, mit katastrophalen Auswirkungen in Texas. Vorhersagen von Hurrikan Harvey illustrieren Erkenntnisse erweiterter und langfristiger Hurrikan-Vorhersagen.

Dieser Beitrag analysiert die Vorhersagen bzgl. Hurrikan Harvey, ausgegeben von meinem Unternehmen Climate Forecast Applications Network (CFAN) und auch diejenigen des National Hurricane Center. (…)

Harvey im Zusammenhang

Ich bin sicher, dass Sie nicht überrascht sind zu hören, dass Mancher Harvey mit globaler Erwärmung in Zusammenhang bringt. Wie ungewöhnlich war Harvey? Nun, mit Sicherheit wird er in die Annalen eingehen als der Hurrikan, welcher die rekordlange Zeit ohne ein solches Ereignis beendet hat.

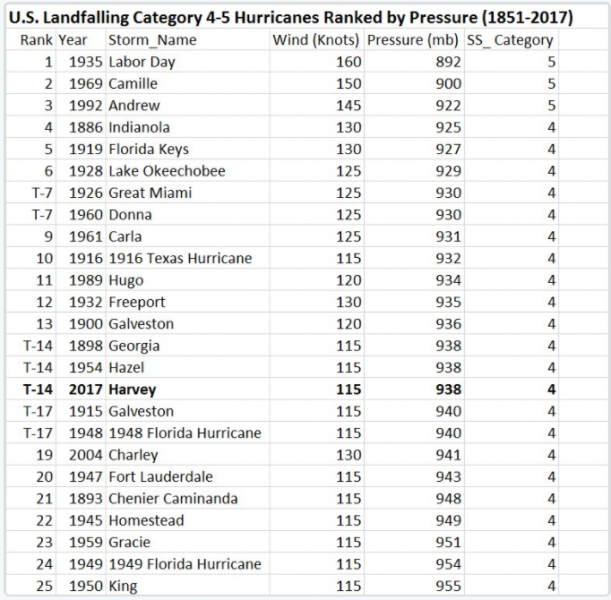

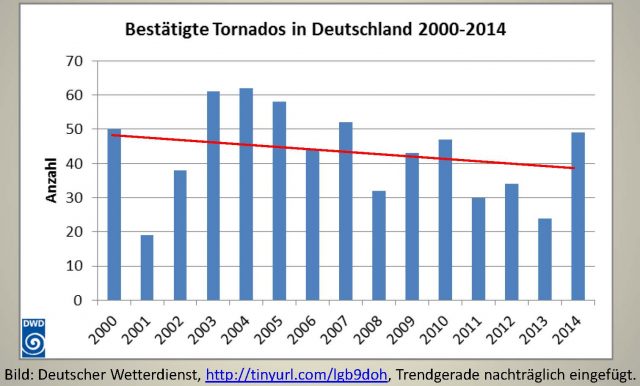

Phil Klotzbach hat eine Liste der Hurrikane Kategorie 4 und 5 zusammengestellt, die auf das US-Festland übergetreten waren:

Diese Liste erinnert uns, wie schlimm es schon einmal war. Abgesehen der furchtbaren Jahre 2004 und 2005 haben wir während der letzten Jahrzehnte ziemliches Glück gehabt.

Die Verbindung von Harvey mit globaler Erwärmung, wer auch immer diesen herzustellen versucht, entbehrt jeder Grundlage.

Harvey wird in die Annalen eingehen für seine fast unglaublich hohen Regenmengen. Die endgültigen Mengen sind noch nicht gefallen, und unglücklicherweise wird es wohl noch einige Tage in Texas regnen, wobei sich die bisher gefallenen Mengen potentiell verdoppeln können. Während riesige Mengen Wasserdampf in Harvey kondensierten, gehen die extrem hohen Regenmengen darauf zurück, dass sich Harvey kaum noch verlagert hat. Dabei liegt er immer noch nahe genug an der Golfküste, um weitere Feuchtigkeit aufzunehmen.

Full post

————————————————

Party in Paris anstatt Vorsorge in Houston

Ron Clutz

Während gewählte Bürokraten über „Null-Kohlenstoff-Fußabdrücke“ schwafeln, wird nichts getan, um sich auf Wetterereignisse vorzubereiten, die es schon immer gegeben hat und zu denen es immer wieder kommen wird. Internationale Abkommen und Konferenzen wie jüngst in Paris leisten nichts, aber auch gar nichts für verwundbare Orte wie Houston.

Man betrachte beispielsweise diesen Beitrag mit dem Titel [übersetzt] „Ein Nachrichtenportal in Texas hat eine Katastrophe vorhergesagt. Jetzt ist sie eingetreten“ (hier). Auszüge daraus:

Die TEXAS TRIBUNE und PROPUBLIKA haben im vorigen Jahr eine mehrteilige Untersuchung veröffentlicht, in der sie unter die Lupe genommen hatten, was passieren würde, falls Houston von einem starken Hurrikan betroffen werden würde.

[Hervorhebung vom Übersetzer]

Die Reporter taten sich mit Wissenschaftlern von verschiedenen Universitäten in Texas zusammen, um Simulationen verschiedener Sturm-Szenarien* durchzuspielen für die viertgrößte Stadt mit seiner rapide wachsenden Bevölkerung, gewaltigen Öl- und Erdgaslagern sowie einer Haupteinrichtung der NASA.

[*Das amerikanische Wort „storm“ lässt sich nicht einfach mit Sturm übersetzen, denn damit sind alle irgendwie extremen Wettervorgänge gemeint. Auch Dauerregen oder im Winter Glatteisregen oder Schnee wird als „storm“ bezeichnet, auch wenn dabei keinerlei Wind aufgetreten war. Der Einfachheit halber bleibe ich aber hier bei der Übersetzung mit „Sturm“. Anm. d. Übers.]

Ergebnis: Die Stadt und ihr Umland sind schrecklich unvorbereitet auf einen starken Hurrikan. Die Infrastruktur für Evakuierungen und Flutkontrolle ist unzureichend. Ein schwerer Sturm würde katastrophale Schäden verursachen und zu einem „ökonomischen und ökologischen Desaster“ führen. Die Serie wurde mit Preisen ausgezeichnet, hat aber keinerlei politische Änderungen oder große neue Investitionen in die Infrastruktur nach sich gezogen.

Houston ist die viertgrößte Stadt des Landes. Der größte Raffinerie- und petrochemische Komplex befindet sich dort, wo Milliarden Gallonen Öl und gefährliche Chemikalien gelagert werden. Und sie ist potentielles Opfer des nächsten großen Hurrikans. Lesen Sie, warum Texas nicht darauf vorbereitet ist. – 3. März 2016

Ein Haus ist in Flammen aufgegangen, nachdem Wasser und Wellen Häuser auf der Galveston-Insel überschwemmt haben. So geschehen durch den Hurrikan Ike am 12. September 2008.

Jetzt starren die gleichen Journalisten nervös auf die Annäherung von Harvey an die texanische Küste. Der Übertritt auf das Festland wird zwischen den Städten Corpus Christy und Houston erwartet [was eingetroffen ist, Anm. d. Übers.], und das Worst-Case-Szenario kann immer noch eintreten.

„Unglücklicherweise könnte es einer Katastrophe bedürfen, bevor Texas aufwacht und erkennt, dass man ein wenig echtes Geld aufbringen muss, um einen der größten Häfen des Landes zu schützen, wo wir das Meiste unseres Öls und unserer Chemikalien lagern“, sagt einer der Autoren, und weiter: „Falls Houston irgendwann von einem Sturm der Stärke von Harvey betroffen wird, könnten die Umweltschäden über diejenigen bei der Havarie der Ölplattform ,Deepwater Horizon‘ hinausgehen“.

Nachdem die Serie erschienen war, traten die Reporter an die gesamte Kongress-Delegation des Staates heran sowie an beide seine US-Senatoren, von denen einer, Ted Cruz, sich als Präsidentschaftskandidat in Stellung brachte. „Keiner dieser Herrschaften kann also von sich behaupten, dass niemand dieses Unheil voraussehen konnte, welches ein großer Sturm für ihre jeweiligen Wahlbezirke heraufbeschwören könnte“, schrieben die Autoren. „Ike sollte eigentlich dieser Weckruf sein, in diesem Zusammenhang endlich tätig zu werden. Alles, was ich mir erhoffe ist, dass hier und jetzt ein neuer Weckruf erschallt und Texas mehr Maßnahmen fordern wird vor dem ,Big One’“.

Full post

————————————————

Warum hat Harvey keine größeren Auswirkungen auf die Energiepreise? Stichwort: Schiefer!

Liam Denning, Bloomberg

Die schockierenden Bilder, wie sich die Hauptstraßen von Houston in Kanäle verwandelt haben im Zuge von Hurrikan Harvey (hier) erinnern an ähnliche Bilder der Fluten der Hurrikane Katrina und Rita vor 12 Jahren an der Golfküste.

Wie alles andere auch ist die Energieindustrie, die sich in diesem Gebiet so konzentriert hat, hart getroffen worden, sowohl damals als auch jetzt. Und dennoch, während das volle Ausmaß der Schäden erst nach diesen Wettervorgängen hervortreten wird, kann es sein, dass die Hurrikan-Saisons 2005 und 2017 zu Marksteinen einer Transformation im US-Energiesektor werden.

Selbst wenn sie es mit noch existenzielleren Problemen zu tun haben, sind Energie-Händler auch mit der Tatsache konfrontiert, dass die Märkte im Großen und Ganzen weitgehend ungestört scheinen.

Die Preise für Benzin und andere Raffinerie-Produkte sind nach oben geschnellt – ein logisches Ereignis angesichts des Umstandes, dass etwa ein Sechstel der US-Raffinierungs-Kapazität zum Stillstand gekommen ist. Und dennoch, die Preise für Öl und Erdgas blieben entweder gleich oder waren bis Montag Morgen sogar gesunken.

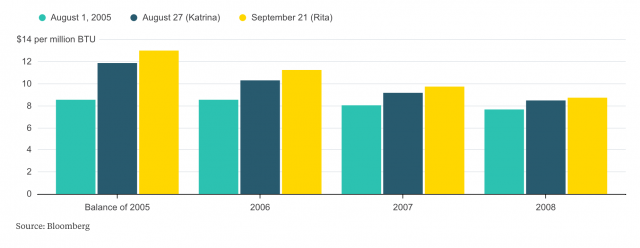

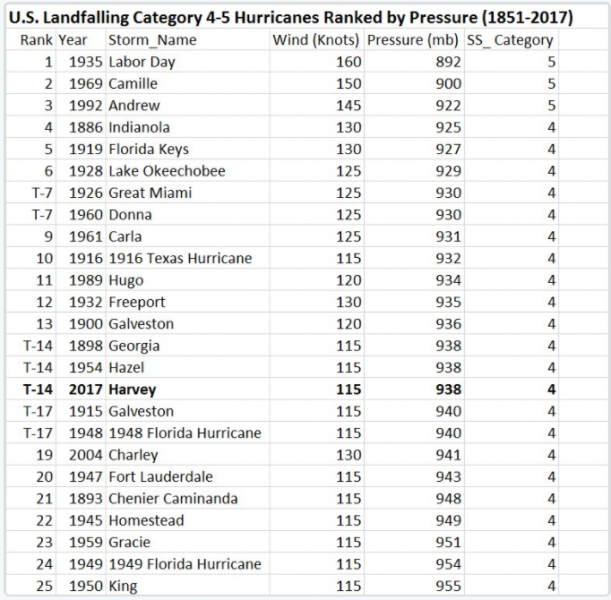

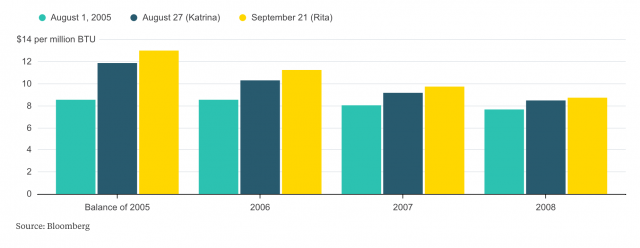

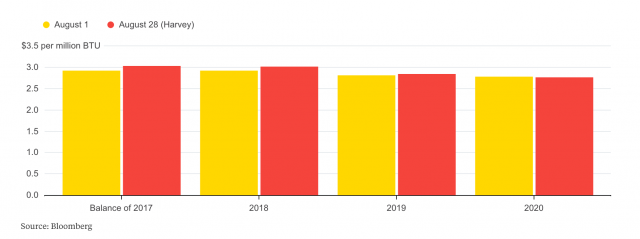

Dies ist ein markanter Gegensatz zur Lage vor 12 Jahren. Erdgas illustriert den Punkt. Als Katrina und Rita die Golfregion heimsuchten, sind die Erdgaspreise sprunghaft auf zweistellige Zahlen gestiegen. Heute dagegen liegt der Preis bei weniger als 3 Dollar pro Million BTU.

Noch erstaunlicher allerdings sind die völlig unterschiedlichen Erwartungen hinsichtlich der Auswirkungen, wenn man die Marktlage damals und heute vergleicht. Im Jahre 2005 geschah Folgendes:

Nach den Hurrikanen des Jahres 2005 wurden in den Himmel schießende Preise für Erdgas erwartet, nicht nur unmittelbar nach dem Ereignis, sondern auf Jahre hinaus.

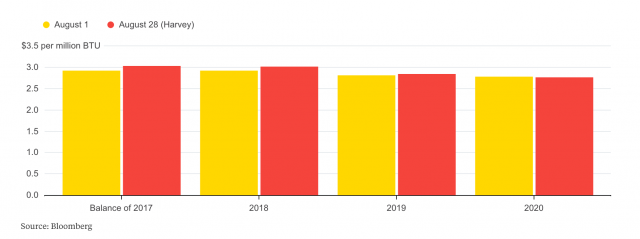

Und hier folgt, wie es sich in diesem Monat entwickelt hat. Man beachte den Unterschied:

Die Auswirkung von Hurrikan Harvey hat sich in den Märkten bzgl. der Zukunft von Benzin kaum bemerkbar gemacht, vor allem im weiteren Verlauf der Kurve:

Indifferent

Indifferent

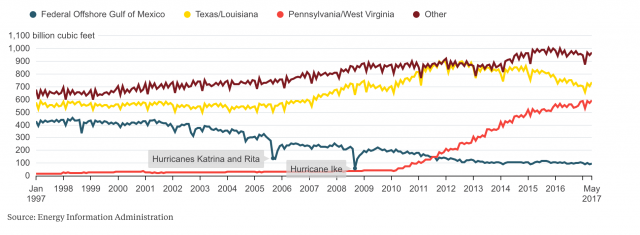

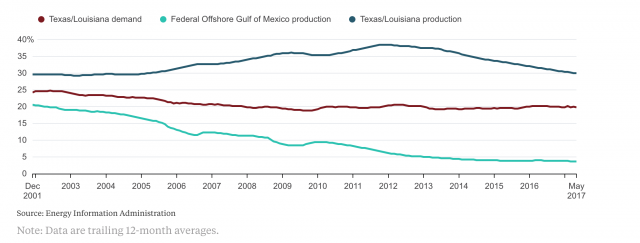

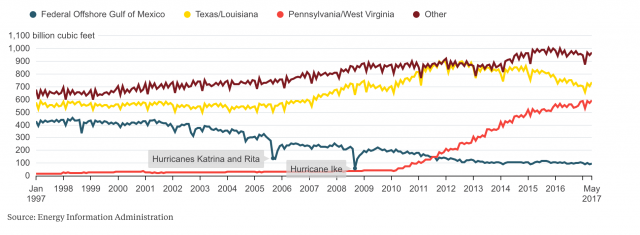

Der Schlüsselfaktor ist der Schiefer-Boom. In der Anfangsphase bekam er Rückenwind durch stark steigende Erdgaspreise, sowohl infolge des Handels-Superzyklus im Jahrzehnt vor 2014 und Preisspitzen in Verbindung mit Katastrophen wie im Sommer und Herbst 2005. Man erkennt dies in den dramatischen Verschiebungen der Ursprünge der heimischen Gasversorgung.

Zurück auf das Land

Der Schiefer-Boom beschleunigte sich in Texas und Louisiana nach dem Jahr 2005, wobei Appalachia nach dem Jahr 2009 den Stab übernahm. Die Offshore-Erzeugung ist inzwischen eingebrochen.

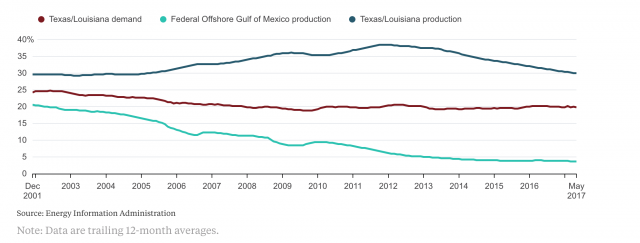

Die Verschiebung weg von den durch Hurrikane bedrohten Gewässern am Golf von Mexiko bedeutet, dass selbst ein katastrophales Ereignis wie Harvey derzeit kaum Auswirkungen auf die Preisentwicklung hat. Tatsächlich hat sogar die Onshore-Erzeugung in Texas und Louisiana während der letzten Jahre an Bedeutung verloren als Anteil an der heimischen Erdgas-Erzeugung in den USA, nachdem die erste Welle des Schiefer-Booms abgeebbt ist und das Wachstum sich anderswohin verlagert hat, besonders nach Appalachia.

Die Verschiebung weg von den durch Hurrikane bedrohten Gewässern am Golf von Mexiko bedeutet, dass selbst ein katastrophales Ereignis wie Harvey derzeit kaum Auswirkungen auf die Preisentwicklung hat. Tatsächlich hat sogar die Onshore-Erzeugung in Texas und Louisiana während der letzten Jahre an Bedeutung verloren als Anteil an der heimischen Erdgas-Erzeugung in den USA, nachdem die erste Welle des Schiefer-Booms abgeebbt ist und das Wachstum sich anderswohin verlagert hat, besonders nach Appalachia.

Falls überhaupt belastet Harvey die Erdgasversorgung vor Ort, welche an Bedeutung im vorigen Jahrzehnt nichts verloren hat:

Nachfrage

Während der Anteil von Texas und Louisiana zusammen mit den Offshore-Aktivitäten im Golf von Mexiko an der US-Erdgaserzeugung abgenommen hat, ist der Anteil der Nachfrage relativ konstant geblieben:

Full story

————————————————

Harveys weit reichende Zerstörung testen US-Schiefer

The Wall Street Journal

Dieser Sturm ist der Stärkste, welcher den Bereich nach Beginn der Schiefer-Bohrungen vor einem Jahrzehnt heimgesucht hat, und es könnte dauern, bis sie sich wieder erholt.

HOUSTON – Der Tropensturm Harvey, der stärkste Sturm in Texas seit Langem, hat einen bedeutenden Anteil der Schiefer-Erzeugung des Staates zum Erliegen gebracht, was die Versorgung der USA um 15% zurückgehen ließ.

Jetzt, angesichts des ersten starken Sturmes, welcher ein Test für US-Schiefer ist, lautet die große Frage, wie schnell der Sektor ein Comeback hinlegen kann.

Vor Übertritt von Harvey auf das Festland haben viele große Schiefergas-Erzeuger in den Schieferformationen bei Corpus Christi in Texas alle ihre Öl- und Gasbohrlöcher geschlossen. Erste Schätzungen der Verluste wegen der zum Erliegen gekommenen Produktion belaufen sich auf 400.000 bis 500.000 Barrel pro Tag.

Nachdem die verbreiteten Schäden klarer hervorgetreten waren, sagen viele Analysten, dass es fast sicher ist, dass ein großer Teil, wenn nicht die gesamte Ausbeutung der 1,4 Millionen Barrel pro Tag in der Region zum Erliegen gekommen ist. Schiefer-Produzenten stützen sich auch auf ein riesiges Netzwerk von Energie-Infrastruktur im Wert von Multimilliarden Dollar – von Häfen über Eisenbahnlinien bis zu Pipelines – welches sich während der letzten Jahre entlang der texanischen Küste entwickelt hat. Viele Teile dieses Netzwerkes scheinen ebenfalls ertränkt worden zu sein.

Der Bedarf jener Infrastruktur könnte die Fähigkeit des Schiefers, sich zu erholen, behindern. In der Vergangenheit haben Hurrikane ein Loch in die Energieindustrie von Texas geschlagen, indem sie Offshore-Plattformen im Golf von Mexiko versenkten; aber in vielen Fällen konnten viele dieser großen Installationen schon bald ihren Betrieb wieder aufnehmen, nachdem der Sturm erst einmal abgezogen war.

„Die Auswirkung auf Schiefer könnte sich hinziehen angesichts des Ausmaßes und der Ausdehnung der Überschwemmungen, welche der Schiefer-Logistik zusetzen“, sagte Benny Wong, ein Analyst bei Morgan Stanley.

Der durch Fracking induzierte Boom in Texas hat die Rolle des Staates in der US-Ökonomie gestärkt, was bedeutet, dass falls die Ölfelder und die umgebende Infrastruktur längere Zeit ausfallen, dies außerordentliche ökonomische Auswirkungen auf den Staat haben kann, sagt Joe Brusuelas, Chefökonom einer Beraterfirma.

Das Schieferfeld Eagle Ford in Texas erzeugt 1,4 Millionen Barrel Öl pro Tag, das ist der zweitgrößte Output des Staates nach dem Permian Basin in West-Texas. Seit Beginn der Schiefer-Bohrungen vor einem Jahrzehnt gab es keinen Sturm dieser Größenordnung.

Unternehmen waren am Montag bereits damit beschäftigt, die Schäden an ihren Einrichtungen im Eagle Ford-Feld zu erfassen, welche direkt von Harvey betroffen worden waren. Aber die Ausdehnung des Sturms, der am Samstag vom Hurrikan-Status herabgestuft worden war, sowie der weiter fallende Regen in einigen Gebieten haben diese Bemühungen behindert.

Full post

Übersetzt von Chris Frey EIKE