Trinkstationen gegen den Klimawandel

Gäbe es nicht die Informationsseite zu Klima und Energie [3] und einen EIKE-Unterstützungsautor, der es sich zur Klimakasteiung ab und zu antut, dort hineinzusehen, hätten viele EIKE-Leser sicher nie etwas über diesen Meilenstein in der Klima-Stadtertüchtigung erfahren:

KLIMARETTER.INFO, 26. September: Trinkstationen gegen den Klimawandel

Das Berliner Projekt Kiezklima hat Bürger befragt, wie sie mit extremer Hitze in der Stadt umgehen. Herausgekommen sind überraschend gute Ideen für die Anpassung von Städten an den Klimawandel

Unsere Städte werden zu lebensgefährlichen Klimafallen …

KLIMARETTER.INFO: [1] Großstädte sind Wärmeinseln – und das kann gefährlich sein. In Berlin zum Beispiel, Deutschlands größter Stadt, sterben pro Jahr 700 bis 800 Menschen zusätzlich während Hitzewellen. Vor allem ältere und kranke Menschen sind gefährdet. Und die Zahlen dürften steigen, denn Klimaforscher erwarten für den Raum Berlin-Brandenburg, dass sich die jährliche Zahl heißer Tage mit über 30 Grad Celsius in diesem Jahrhundert vervierfachen und die der Tropennächte, in denen die Temperatur nicht unter 20 Grad fällt, sogar verfünffachen wird. Nicht nur in Dachgeschoss-Wohnungen könnte es für die Bewohner dann sehr ungemütlich bis lebensgefährlich werden.

… wovon die Natur nur nichts weiß

Wie eigentlich immer, wenn „Klimaforscher“ in den schlimmsten Farben ausmalen, lohnt es sich bei solchen Aussagen, die Messwerte aus der Natur zu „befragen“.

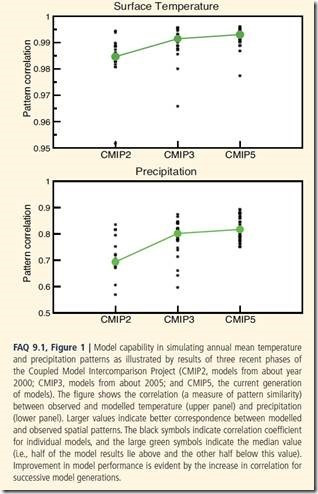

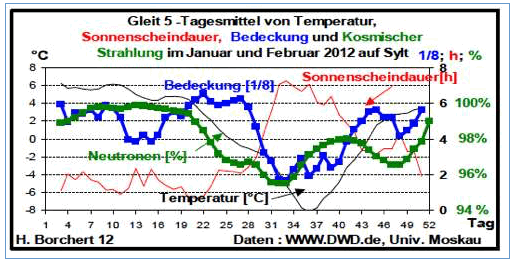

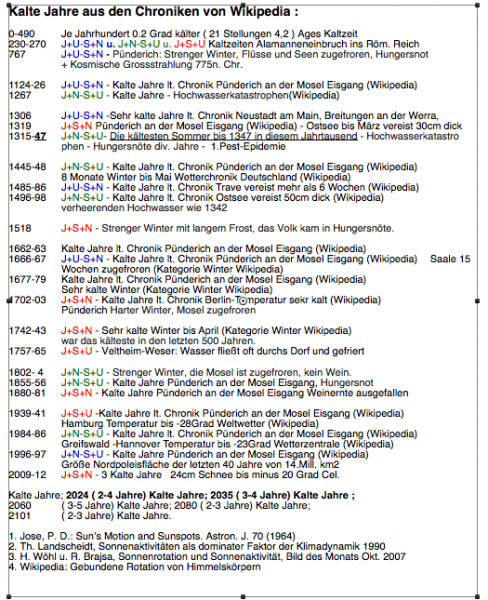

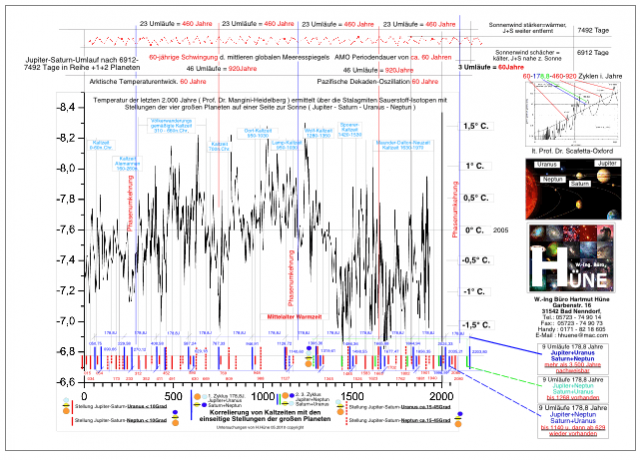

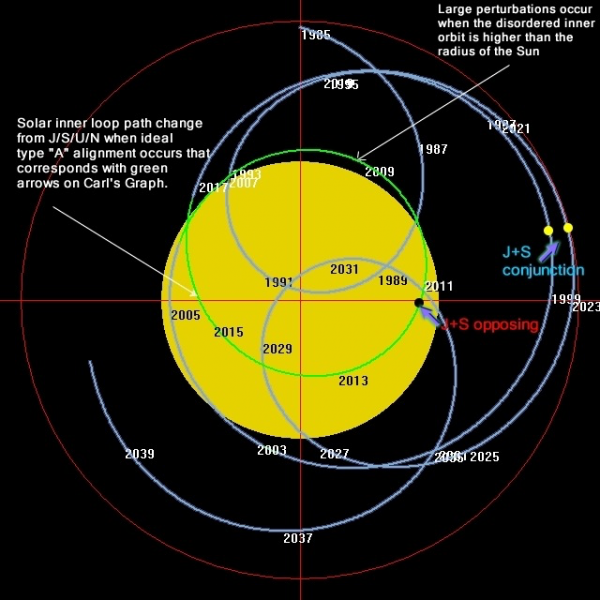

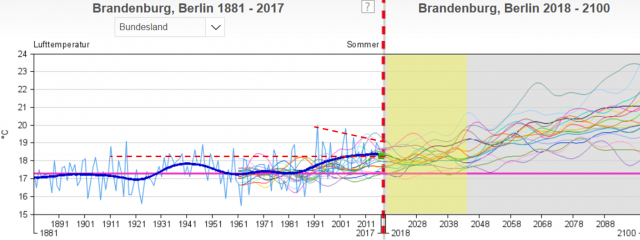

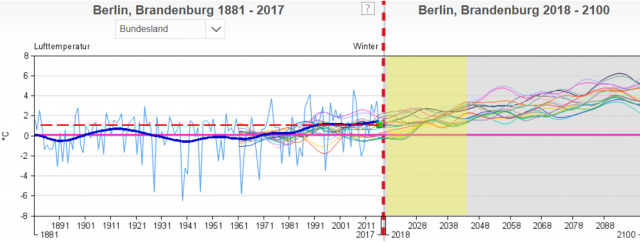

Wie Bild 1 zeigt, wurden die Sommertemperaturen seit dem Hoch kurz nach 1990 wieder niedriger und sind aktuell nicht höher als im Jahr 1911. Kein Wunder, dass die Zukunftsprojektionen schon aktuell meistens danebenliegen und für das Jahr 2100 eine Spanne von 6 Grad „bieten“, aus der sich jeder Klimafachmann das Gewünschte heraussuchen darf.

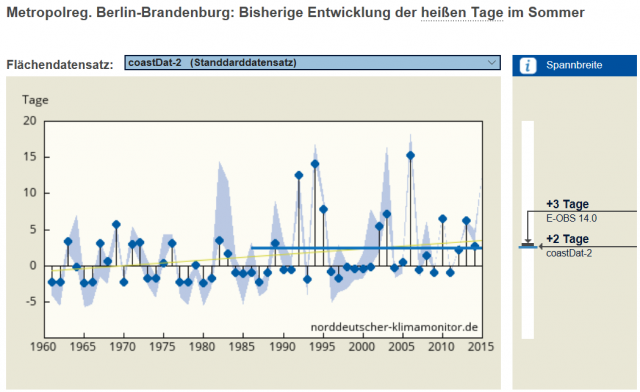

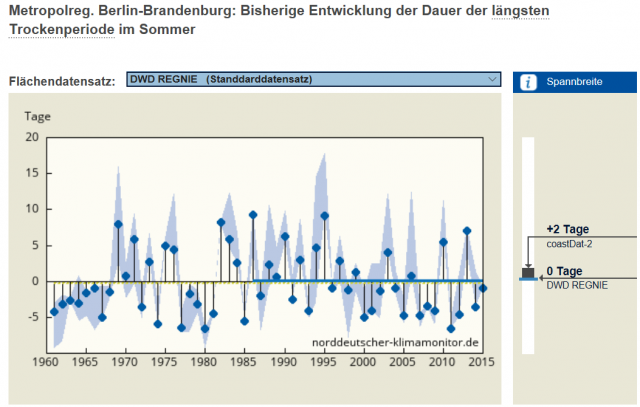

Die „heißen Tage“ nahmen seit 1990 zu- Ein stetiger Trend zu „immer mehr“ ist aber nicht zu sehen.

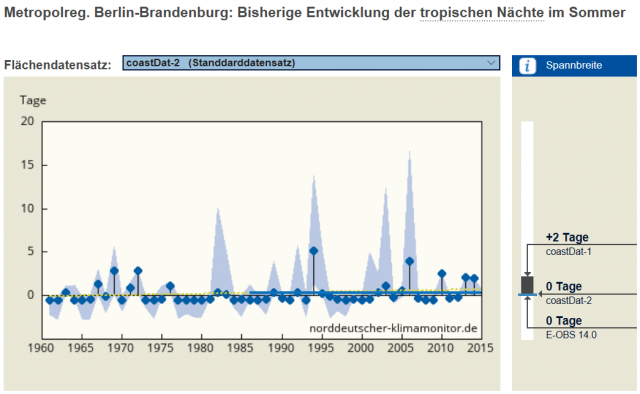

Auch Tropennächte, welche „lebensgefährlich“ werden, zeigen keinen ansteigenden Trend, nur, dass diese Anzahl schon in den 70er Jahren von der heutigen Rentnergeneration „überlebt“ wurde.

In Deutschland ist es vor allem heiß, wenn es nicht regnet. Doch die Länge der Trockenperioden nimmt auch nicht zu.

Nur die Winter werden nicht mehr ganz so kalt. Fast könnte man sagen: Winter, wie bis zum ersten Weltkrieg schon einmal waren und ohne die folgenden, schlimmen Kältewellen bis 1970, als die Klimaforscher entnervt die kommende Eiszeit ausgerufen hatten.

Nachdem die „Alten“ jedoch entgegen den Angaben von Klimaretter weiterhin vorwiegend bei Kälte sterben:

EIKE 21.07.2015: Ruhestand im Süden kann tödlich sein – Wetterdienst glaubt Klimawandel tötet alte Menschen

ist auch das positiv und erspart sicher einigen Senioren, in den warmen Süden ziehen zu wollen, wo sie nach der Klimawandel-Zunft unweigerlich an Hitze noch frühzeitiger zu sterben hätten.

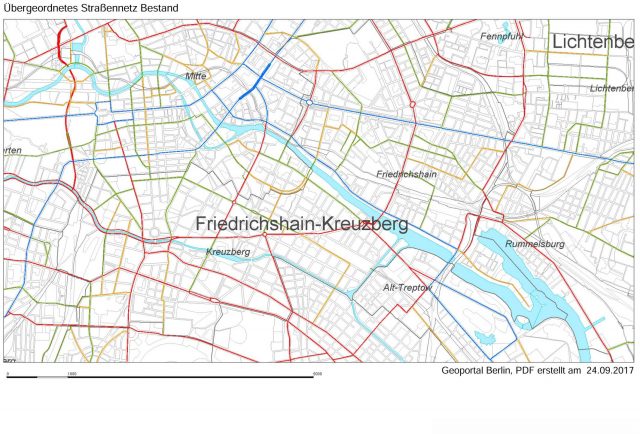

Der Stadtteil erwärmt sich um bis zu 10°C gegenüber dem Umland

Ein Umstand, den alle Großstädte haben und gegen dessen Größe jeglicher, denkbare Einfluss eines sich stetig wandelnden Klimas vollkommen in den Hintergrund tritt.

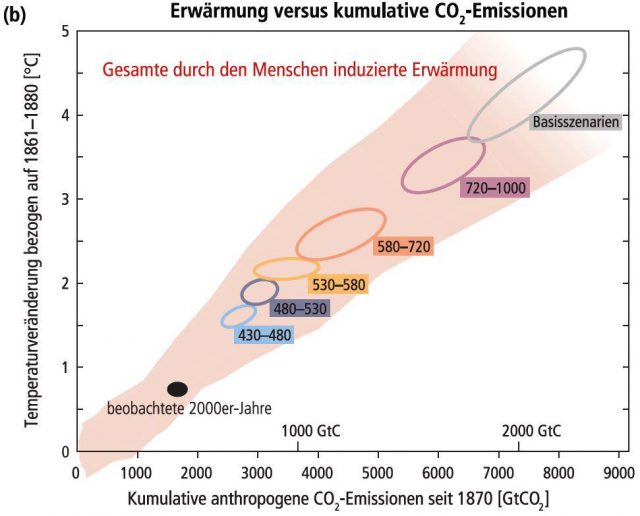

Berlin-Brandenburg hatte seit 1880 ca. +1,5 Grad Temperaturerhöhung. Davon sind angeblich 50 % vom Menschen verursacht, wären demnach CO2-bedingt maximal +0,75 Grad in fast 140 Jahren. Gegen den städtischen Wärmeinseleffekt von +10 Grad ist das nichts.

Für städtische Verwaltungen jedoch kein Grund, den minimalen Effekt nicht durch CO2-Minderung mit Unsummen an Steuergeldern „bekämpfen“ zu wollen:

EIKE 24.09.3017: [4] Ganz(?) München steht Kopf, denn die Stadt verfehlt ihre Ziele beim Kampf gegen den Klimawandel

EIKE 25.04.2017: [5] Wo Klimaschutzprogramme bestimmen, spielen Sinn und Geld überhaupt keine Rolle mehr (Berlin)

und viele, langwierige und teure Studien aufzusetzen:

KLIMARETTER.INFO: [1] … In dem bundesweit einmaligen Forschungsprojekt „Kiezklima“ wurde in den vergangenen drei Jahren untersucht, wie das Leben unter Klimawandel-Bedingungen verbessert werden kann … „Hier im Brunnenviertel wird es im Sommer bis zu zehn Grad heißer als im Berliner Umland„, sagt Eva Wiesemann von der privaten List-Stadtentwicklungsgesellschaft, die das vom Bundesumweltministerium geförderte Projekt zusammen mit sechs weiteren Partnern seit 2014 durchgeführt hat

Die Bewohner selbst spüren zwar nichts vom Klimawandel. Doch wenn man ihnen davon erzählt, erinnern sie sich, dass sie schon mal unkonzentriert waren…

Auch Berlin scheint das Problem zu haben, dass die Bewohner „klimadumm“ sind und erst durch „Fachpersonen“ darauf gestoßen werden müssen. Vergleichbar vielen Südsee-Atollbewohnern, die erst nach den „Einweisungen“ von NGOs und der Kenntnis um Klimaschutzgelder [6] darauf kamen, dass ihre Inseln untergehen.

KLIMARETTER.INFO: [1] … Wiesemann musste viel Aufklärungsarbeit leisten. „Wenn man die Leute fragt, ob sie etwas vom Klimawandel spüren, sagen sie meist: Nein„, erzählt sie. Doch wenn die Fragen konkret wurden, wenn die List-Mitarbeiterin zum Beispiel wissen wollte, wie die Bewohner in den Hitzeperioden zurechtkommen, sei das ganz anders gewesen. Sehr heiß sei es gewesen, hätten sie berichtet, man könne sich nicht gut konzentrieren, und viele Menschen fänden in den heißen Nächten kaum Schlaf.

Die Klima-Vulnerabilitätsforschung zeigt Erfolge und Lösungen, welche bisher niemand kannte

KLIMARETTER.INFO: [1] … Außerdem konnte Wiesemann Geschäfte im Viertel dafür gewinnen, ein Netz von „Trinkstationen“ aufzubauen, an denen man kostenlos ein Glas kaltes Wasser bekommen kann. Und seit Anfang des Sommers gibt es einen öffentlichen Trinkbrunnen auf dem Vinetaplatz mitten im Quartier, ein zweiter steht am Bahnhof Gesundbrunnen.

Ohne umfassendes Klimamanagement ist ein Stadtteil heutzutage praktisch hilflos …

Immer neu bestätigt sich die Überzeugung des Autors, dass „der Klimawandel“ im Wesentlichen eine weltweit angelegte Arbeitsbeschaffungsmaßnahme für die sonst nicht verwendbare Akademikerschwemme ist.

KLIMARETTER.INFO: [1] … Vorbild für Klimaanpassung

„Kiezklima“ arbeitet seit 2014 an einer Beteiligung der Bürger für den Aus- und Umbau des Berliner Brunnenviertels. Das Projekt erhebt Klimadaten, schlägt Anpassungsmaßnahmen etwa für Hitzewellen vor und bezieht die Anwohner in die Planungen ein. Das Viertel im Zentrum der Hauptstadt ist so zu einem „Modellgebiet für Klimaanpassungsmaßnahmen“ geworden. Dazu gehören auch die „Brunnengärten“. Im vergangenen Jahr zeichnete das Umweltbundesamt das Projekt mit dem „Blauen Kompass“ aus. In diesem Jahr ist es für den ZeitzeicheN-Preis für lokale Nachhaltigkeitsinitiativen nominiert

… wer käme sonst auf die Idee, gegen den Klimawandel in Hochbeeten Gemüse- und Gartenkräuter anzubauen

Dazu natürlich auch die wohl in Vergessenheit geratene Kenntnis, dass Beschattung gegen Sonnenstrahlung schützen kann.

KLIMARETTER.INFO: [1] … Wohnhof bekommt Sonnensegel

Eine ganze Reihe Ideen sind in dem Kiezklima-Projekt gesammelt worden. Einige davon wurden schon in die Tat umgesetzt. So wurden in einem der Innenhöfe der Wohnblöcke der kooperierenden Berliner Wohnungsbaugesellschaft Degewo Hochbeete angelegt, in denen Mieter Gemüse und Gartenkräuter anbauen.

Mit Klimawandel hat das alles jedoch nichts zu tun, eher mit dem Unvermögen der bisherigen Verwaltung

Im Gegensatz zur Redaktion von Klimaetter kann der Autor nicht erkennen, dass ein sich stetig veränderndes Klima Anlass für solche Ma0nahmen geben könnte. Zumindest die Klimadaten geben dafür keinerlei Anhaltspunkt.

Sollten sich in diesem Wohnviertel wirklich herausstellen, dass Wohnungen bei bestimmten Wetterlagen „lebensgefährlich“ sind, sollte man vielleicht die Bausubstanzen und Isolierungen überprüfen und den zuständigen Aufsichtsbehörden und Vermietern gehörig „die Ohren langziehen“. Lösungen wie beim Auto, welche es inzwischen mit Klimaanlagen gibt, weil niemand mehr wie früher im Sommer ohne fahren will, wären denkbar. Zumindest käme der Autor ohne eine langwierige und teure Untersuchung darauf.

Nun handelt es sich laut dem Bericht wohl um einen Problemstadtteil [1]: „ …viele Sozialwohnungen, haben zu zwei Dritteln einen Migrationshintergrund …“.

Dies legt die Vermutung nahe, dass man Sanierungsanalysen und Stadtteilarbeit unter dem Deckmantel „Klima“ finanzieren lies, weil für vernünftige Direkt-Maßnahmen keine Fördermittel genehmigt wurden. Den „Ideologieschwund“ und übertriebenen Aufwand, sowie sinnlose Zusatzmaßnahmen nahm man wohl in Kauf.

Ob dieses Vorgehen wirklich so richtungsweisend ist, wie es die Redaktion von Klimaretter darstellt, wagt der Autor zu bezweifeln.

Vielleicht nehmen es aber die Stadtverwaltungen der noch viel „lebensgefährlicheren“ Städte im Rheingraben und schönen Freiburg zum Anlass, die Bewohner vorsorglich bis zur Gefahrenklärung „auszulagern“, wie es bei den wärmegedämmten Hochhäusern schon passiert ist.

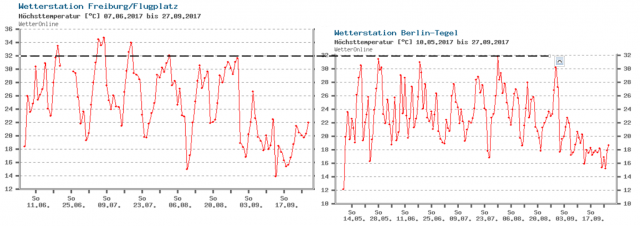

In Freiburg waren es im Sommer immerhin zwei Grad mehr Hitze, während in Berlin-Brandenburg die Sommer-Mitteltemperatur seit 1880 um ca. 1,5 °C gestiegen ist.

Nach der in Freiburg bereits erfolgten „Klimazeitreise“ von über 200 Jahren müsste die schöne und beliebte Stadt eigentlich schon den Klimatod gestorben sein.

Welch ein Glück, dass es ausreicht, erst in der fernen Zukunft mit dem „Klimaschutz“ anzufangen und den „Werkzeugkasten“ zu füllen, der sich anscheinend vorwiegend um Förderprogramme und Finanzierungsfragen kümmert.

Weiterbildung „Kommunales Energie- und Klimaschutzmanagement“

15. Januar 2016 – 16. Juli 2016, berufsbegleitend

FWTM: Durchgeführt von fesa e.V. in Kooperation mit dem Institut für Fortbildung und Projektmanagement ifpro

In 13 kompakten Modulen vom 15. Januar bis zum 16. Juli 2016 füllen die künftigen Klimaschutzmanager und andere regional Klimaschutzaktive ihren Werkzeugkasten mit allem, was es für die Umsetzung der Energiewende vor Ort braucht: Vom Kontext und den Grundlagen kommunalen Klimaschutzes geht es über die rechtlichen Rahmenbedingungen bis zu Förderprogrammen und Finanzierung. Der Kurs beinhaltet ebenso Basiswissen über Erneuerbare Energien, Kraft-Wärme-Kopplung und Wärmenetze wie Informationen zu Energieeffizienz und Energiemanagement in kommunalen Liegenschaften. Weitere Themenfelder sind Öffentlichkeitsarbeit und Bürgerbeteiligung. Abgerundet und auf Praxisnähe zugeschnitten wird die Fortbildung durch eine Einführung in das Projektmanagement, das die Teilnehmerinnen und Teilnehmer dann auch im Rahmen eigener, kursbegleitender Projektarbeiten vertiefen und verfestigen.

Quellen

[1] KLIMARETTER.INFO 26. September 2017: Trinkstationen gegen den Klimawandel

[2] Kiezklima, Homepage

[3] EIKE 25. September 2017 : Das Interview!

[4] EIKE 24.09.3017: Ganz(?) München steht Kopf, denn die Stadt verfehlt ihre Ziele beim Kampf gegen den Klimawandel

[5] EIKE 25.04.2017: Wo Klimaschutzprogramme bestimmen, spielen Sinn und Geld überhaupt keine Rolle mehr

[6] EIKE 14.12.2015 (Tel 2 … 3): Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 3 Die Marshall-Inselgruppe – (kein) Beispiel für einen Untergang