„Es gibt zwei Anlässe im Leben eines Menschen, bei denen er nicht spekulieren sollte: Wenn er es sich nicht leisten kann, und wenn er es sich leisten kann“ – Mark Twain

Mein Thema heute ist die Vorherrschaft von Spekulation in den Medien. Was bedeutet das? Warum ist das so allgegenwärtig? Sollten wir etwas dagegen tun? Falls ja, was – und warum? Sollten wir uns überhaupt darum kümmern? Ist Spekulation überhaupt validierbar? Und so weiter.

Ich möchte diesem Spekulationstrend beitreten und darüber spekulieren, warum es so viel Spekulation gibt. Im Zuge, diesem Trend zu folgen, möchte ich meine Standpunkte ohne jedwede faktische Stützung darlegen, einfach indem ich eine Reihe von schlichten Behauptungen aufstelle.

Bevor wir anfangen, möchte ich eine Definition klären. Mit Medien meine ich Filme, Fernsehen, Internet, Bücher, Zeitungen und Zeitschriften. Um dem allgemeinen Trend der Spekulation zu folgen, wollen wir nicht zu viele Kleinstunterscheidungen treffen.

Anfangen können wir damit, uns zu fragen, bis zu welchem Grad sich die Medien der reinen Spekulation verschrieben haben. Jemand könnte hierzu eine Studie durchführen und Fakten präsentieren, aber bislang hat das niemand getan. Ich würde es mit Sicherheit nicht tun. Es gibt keinen Grund, sich damit zu behelligen. Die Erfordernis, eine Faktenbasis für eine Behauptung zu demonstrieren, ist schon vor langer Zeit entfallen. Sie wurde ausgesondert mit dem universellen Lob für das Buch Backlash von Susan Faludis, welches im Jahre 1991 den National Book Critics Circle Award für Allgemeine Sachbücher verliehen bekam, und welches hunderte Seiten quasi-statistischer Behauptungen auf der Grundlage einer Prämisse enthält, welche niemals belegt wurde und die fast mit Sicherheit falsch war.

Aber das ist ein alter Hut, und ich erwähne es hier nur, um Standards zu setzen.

Heute weiß natürlich jedermann, dass „Hardball“, „Rivera Live“ und ähnliche Shows nichts weiter sind als ein stetiger Strom von Vermutungen über die Zukunft. Die Talkshows am Sonntag Morgen sind reine Spekulation. Jeder weiß, dass es sonntags keine Nachrichten gibt.

Aber Fernsehen ist Unterhaltung. Betrachten wir die so genannten seriösen Medien. Zum Beispiel die New York Times [ein Ober-Alarmisten-Blatt! Anm. d. Übers.] vom 6. März, also von dem Tag, als Dick Farson mir gesagt hat, dass ich diese Gedanken von mir gebe. In der Kolumne an erster Stelle jenes Tages geht es um die Zölle von Bush auf importierten Stahl. Jetzt lesen wir: Die Maßnahme von Mr. Bush „wird wahrscheinlich den Preis von Stahl scharf in die Höhe treiben, vielleicht um bis zu zehn Prozent…“. Amerikanische Verbraucher „werden ultimativ höhere Preise zahlen müssen“. Amerikas Verbündete „würden fast mit Sicherheit die Entscheidung anfechten“. Ihr legales Anliegen „könnte Jahre dauern, um in Genf einen Prozess anzustrengen“ um Dieses und Jenes.

Man beachte auch die vage und versteckte Spekulation. Die Anfechtung seitens der Alliierten würde „die Bühne bereiten für einen großen Handelskrieg mit vielen der gleichen Länder, die Bush zusammenhalten möchte in der zerbrechlichen Koalition gegen den Terror“. Mit anderen Worten, in der Story wird spekuliert, dass Zölle den Kampf gegen den Terrorismus beeinträchtigen können.

Inzwischen bin ich unter dem Faludi-Standard zu dem festen Standpunkt gekommen, dass Medien hoffnungslos von Spekulation durchsetzt sind, und wir können darangehen, die Auswirkungen dieses Umstandes zu betrachten.

Nun könnte man diese Story über Zölle lesen und sich fragen „na und?“. Es ist keine schlechte Geschichte. Ist es nicht vernünftig, über Auswirkungen gegenwärtiger Ereignisse auf diese Weise zu reden? Ich antworte, absolut nicht! Derartige Spekulationen sind komplette Zeitverschwendung.Sie sind sinnlos. Es ist Mist auf der Frontseite der Times.

Der Grund dafür, dass es sinnlos ist, ist natürlich der Umstand, dass niemand weiß, was die Zukunft bereit hält.

Stimmen wir alle darin überein, dass niemand weiß, was die Zukunft bereit hält? Oder muss ich Ihnen das erst beweisen? Ich stelle diese Frage, weil es einige sehr gut untersuchte Auswirkungen der medialen Berichterstattung gibt, was passiert, wenn man das Fernsehgerät verkehrt herum aufstellt: die Kinder werden sagen, dass das Popcorn aus der Tüte herausfällt. Dieses Ergebnis wäre erheiternd, falls es auf Kinder beschränkt bleibt. Aber die Studien zeigen, dass niemand davon ausgenommen ist. Alle Menschen unterliegen diesem medialen Effekt, einschließlich all jener unter uns, die glauben, dass wir ich-bewusst und hip und gut unterrichtet sind.

Medien bringen eine Glaubwürdigkeit mit, die total unverdient ist. Wir alle haben schon das erlebt, was ich den Murray Gell-Mann Amnesie-Effekt nenne. (Ich beziehe mich auf diesen Namen, weil ich über dieses Thema einmal mit Murray Gell-Mann diskutiert habe, und mit der Einführung eines berühmten Namens impliziere ich größere Bedeutung für mich selbst und den Effekt, welche er anderenfalls nicht hätte).

Kurz beschrieben lautet der Gell-Mann-Amnäsie-Effekt so: Man schlägt die Zeitung auf und stößt auf einen Artikel über etwas, über das man gut Bescheid weiß. In Murrays Fall war das Physik. In meinem Fall war es Show-Business. Man liest den Artikel und stellt fest, dass der Journalist absolut keine Ahnung hat, weder hinsichtlich der Fakten noch der Thematik. Oftmals ist der Artikel so falsch, dass er tatsächlich die Story von hinten aufzäumt – indem Ursache und Wirkung vertauscht werden. Ich nenne dies die „wet streets cause rain“-Storys [was man etwa übersetzen könnte mit „weil die Straßen nass sind, regnet es“]. Zeitungen sind voll davon.

In jedem Falle liest man mit Verbitterung oder auch amüsiert die multiplen Fehler in einer Story und blättert dann um zur Seite mit den nationalen oder internationalen Angelegenheiten. Diese liest man dann so, als ob sie irgendwie genauer sind über Palästina als der Unsinn, den man eben gelesen hat. Man blättert um und vergisst, was man weiß.

Das ist der Gell-Mann-Amnäsie-Effekt. Ich möchte betonen, dass er in anderen Arenen des Lebens nicht aktiv ist. Im normalen Leben ist es so: falls jemand einen permanent anlügt, wird man bald alles, was jener sagt, verwerfen. Vor Gericht gibt es eine gesetzliche Doktrin von falsus in uno, falsus in omnibus, was bedeutet Unwahrheit in einem Teil – Unwahrheit in Allem. Aber wenn es um Medien geht, glauben wir gegen alle Beweise, dass es uns unsere Zeit wahrscheinlich wert ist, andere Teile der Zeitung zu lesen. Und das, wenn das fast mit Sicherheit nicht der Fall ist. Die einzig mögliche Erklärung für unser Verhalten ist Amnäsie.

[Und ich dachte, nur die Deutschen wären so zeitungsgläubig, wie sie nun mal sind! Anm. d. Übers.]

Ein Problem mit der Spekulation besteht also darin, dass man den Gell-Mann-Effekt unberechtigter Glaubwürdigkeit huckepack mit sich herumträgt, was die Spekulation als brauchbarer aussehen lässt als sie ist.

Ein weiteres Thema ist die schiere Masse von Spekulation. Die schiere Masse impliziert einen Wert, der fadenscheinig ist. Ich nenne dies den There-Must-Be-A-Pony-Effekt, abgeleitet aus dem alten Witz, dass ein Kind am Weihnachtsmorgen die Treppe herabkommt, den Raum voller Pferdemist vorfindet und vor Freude in die Hände klatscht. Seine erstaunten Eltern fragen: Warum bist du so glücklich? Es antwortet, bei so viel Pferdemist muss ein Pony da gewesen sein.

Weil wir in jeder Hinsicht mit Spekulation konfrontiert werden, in gedruckter Form, in Videos, im Internet, bei der Konversation können wir möglicherweise zu dem Schluss kommen, dass sie von Wert sein muss. Das ist sie aber nicht. Und zwar weil – egal wie viele Menschen spekulieren, egal wie bekannt deren Gesichter, wie gut ihr Makeup ist und wie gut sie daherkommen; egal wie lange sie vor uns persönlich oder in Kolumnen in Erscheinung treten – es wahr bleibt, dass keines dieser Individuen weiß, was die Zukunft bringt.

Einige Menschen glauben insgeheim, dass die Zukunft bekannt gemacht werden kann. Sie stellen sich zwei Gruppen vor, die über die Zukunft Bescheid wissen und auf die man deswegen hören sollte. Die erste Gruppe sind die Experten [pundits]. Da sie sich die ganze Zeit über die Zukunft auslassen, müssen sie doch wissen, wovon sie reden. Ist das so? „Brill’s Content“ [hier steht, was damit gemeint ist; Anm. d. Übers.] geht üblicherweise den Vermutungen der Experten nach, und während der eine oder andere auch mal einen Treffer erzielt, sind diese Vermutungen über die Zeit nicht besser als Zufall. Dies würde man auch erwarten. Weil niemand die Zukunft kennt.

Ich möchte im Vorübergehen noch erwähnen, dass Expertentum mit den Jahren eine subtile Veränderung durchlaufen hat. In den alten Zeiten haben Kommentatoren wie Eric Sevareid die meiste Zeit damit zugebracht, Ereignisse in einen Zusammenhang zu stellen und einen Standpunkt zu beschrieben über das, was bereits geschehen ist. Darüber sprechen, was sie dachten, war wichtig oder irrelevant hinsichtlich der Ereignisse, die bereits stattgefunden hatten. Dies ist natürlich eine legitime Funktion der Expertise in jedem Bereich menschlichen Wissens.

Aber mit den Jahren hat sich das vertrauen in Expertentum von der Diskussion über Geschehenes weg verschoben hin zu Diskussionen über das, was geschehen könnte. Und hier haben die Experten keinerlei Vorteil aus ihrer Expertise. Schlimmer noch, sie könnten versuchen, wie die Sonntagspolitiker die eine oder andere Agenda durchzupauken mittels der Prophezeiung von deren unmittelbar bevorstehenden Kommen oder Niedergang. Das ist politischer Aktionismus, keine Prophezeiung*.

[*Unübersetzbares Wortspiel: ,This is politicking, not predicting‚].

Die zweite Gruppe, von denen manche Menschen die Vorstellung haben, dass sie über die Zukunft Bescheid wissen, sind Spezialisten unterschiedlicher Art. Die wissen das aber auch nicht. Als Grenzfall möchte ich daran erinnern, dass es einen neuen Bereich gibt, der Spezialisten gebiert – ich weigere mich, es eine Disziplin oder einen Studienbereich zu nennen – Futurismus genannt. Das Narrativ hier lautet, dass einen Weg gibt, Trends zu studieren und zu wissen, was die Zukunft bringt. Das wäre tatsächlich wertvoll, falls es möglich wäre. Aber es ist nicht möglich. Futuristen wissen nicht mehr über die Zukunft als Sie und ich. Man lese deren Zeitschriften von vor ein paar Jahren, und man wird eine endlose Kette der Irrtümer finden.

Expertise ist kein Schutzschild gegen grandiose Fehleinschätzungen. Darum war es Thomas Watson, der Chef von IBM, der prophezeite, dass die Welt höchstens 4 oder 5 Computer brauchen würde. Das ist so falsch wie etwas nur sein kann – prophezeit von einem Mann, der in jeder Hinsicht informiert war darüber, wovon er sprach.

Nicht nur, dass er einen Trend falsch bewertete oder eine Technologie, sondern auch, dass er die Myriaden Verwendungszwecke nicht verstand, für die man eine Maschine allgemein rüsten kann. Genauso lag auch Paul Ehrlich, ein brillanter Akademiker, der sein gesamtes Leben ökologischen Themen widmete, mit fast allen seinen großen Prophezeiungen falsch.

Er lag falsch hinsichtlich schwindender Ressourcen, hinsichtlich der Bevölkerungsexplosion, und er lag falsch mit seiner Prophezeiung, dass bis zum Jahr 2000 50% aller Spezies ausgestorben sein würden. Er widmete sein Leben intensiv empfundenen Bereichen – und lag doch spektakulär falsch.

Nun gut, könnte man sagen, wir akzeptieren, dass man die Zukunft nicht kennen kann in der Art und Weise, wie ich es hier beschreibe. Aber was ist mit dringlicheren Dingen wie etwa die Auswirkungen unerledigter Gesetzgebung? Sicher ist es wichtig, darüber zu reden, was passieren kann, falls bestimmte Gesetze eingeführt werden. Nun – nein, ist es nicht. Niemand weiß, was passieren wird, wenn das Gesetz eingeführt wird. Hierfür möchte ich zwei Beispiele nennen, eines von den Linken und eines von den Rechten.

Das erste Beispiel ist die Clinton’sche Wohlstandsreform, welche hart kritisiert wurde seitens seines eigenen linken Flügels, weil er Anleihen in einer Agenda der Republikaner machte [Clinton war natürlich von den Demokraten. Anm. d. Übers.]. Den Prophezeiungen der Linken zufolge sollten sich daraus menschliches Leiden, bittere Kälte, Kindesmissbrauch, und schreckliche Folgen ergeben. Und was geschah? Nichts dergleichen! Kindesmissbrauch nahm ab. Tatsächlich war die Reform, wie es bei Reformen der Regierung manchmal ist, ein Erfolg; aber Mother Jones [eine Zeitschrift; mehr hier bei Wikipedia] prophezeit immer noch düsterste Effekte, die unmittelbar bevorstehen.

Dieses Scheitern bei der Prophezeiung von Auswirkungen eines Programms spiegelte sich in hysterischem Geschrei von den Rechten bei den Republikanern über steigenden Mindestlohn. Chaos und düstere Zeiten würden sicher folgen, wenn Firmen ihre Türen schließen und das Land in eine überflüssige Rezession gestürzt würde. Aber was waren die wirkliche Auswirkungen? Im Grunde gar keine. Wer diskutiert jetzt noch darüber? Niemand! Was wird geschehen, falls es einen neuen Versuch geben würde, den Mindestlohn anzuheben? Die gleichen düsteren Prophezeiungen noch einmal. Haben wir irgendetwas gelernt? Nein!

Aber mein Punkt ist – bei bevorstehender Gesetzgebung ebenso wie mit allem Anderen – niemand kennt die Zukunft.

Gleiches ist auch wahr hinsichtlich der Auswirkungen von Wahlen und Verabredungen. Welche Auswirkungen hat die Wahl eines bestimmten Präsidenten oder eines Obersten Gerichtshofes? Niemand weiß es. Einige von Ihnen sind alt genug, sich an die berühmte Kolumne von Art Buchwald während der Tage der Johnson-Regierung zu erinnern. Buchwald schrieb einen Beitrag mit dem Titel „Thank God we don’t have Barry Goldwater“ [seinerzeit der Gegenkandidat zu Johnson. Anm. d. Übers.]. Darin erinnerte er daran, wie jedermann befürchtete, dass Goldwater uns in einen großen Krieg ziehen würde. Also wählten wir Johnson, der nichts Eiligeres zu tun hatte als 200.000 Soldaten nach Vietnam zu schicken. Das ist es, was passiert, wenn man einen sich friedlich gerierenden Kandidaten wählt [a dove-ish candidate]. Man bekommt einen Krieg. Oder man wählt den intellektuell brillanten Jimmy Carter, und wird Zeuge, wie er persönlich damit endet zu bestimmen, wer auf den Tennisplätzen des Weißen Hauses spielen darf. Oder man wählt Richard Nixon, der den Stecker aus der Vietnam-Sache herausziehen kann und der dann den Kampf noch Jahre fortsetzt. Und dann China öffnet*.

[*Damit ist hier natürlich nicht China gemeint, sondern das ,China Syndrome‘. Mancher wird mit dem Begriff noch etwas anfangen können. Wer nicht – hier bei Wikipedia steht mehr. Anm. d. Übers.]

Genauso ist die Historie von Entscheidungen des Obersten Gerichtshofes eine endlose Folge von Fehlern hinsichtlich Prophezeiungen von Rechtsprechung, wenn man erst einmal vor Gericht landet. Nicht alle sind überraschend, aber sehr viele schon.

Können wir also hinsichtlich unmittelbar bevorstehender Ereignisse überhaupt irgendetwas vorhersagen? Nein! Dazu reicht es schon sich anzuschauen, was vor dem Fall der Mauer in Berlin gesagt worden ist. Schon dabei sieht man, dass niemand auch nur ein paar Stunden im Voraus etwas prophezeien kann. Menschen sagten alle Arten von Dummheiten bzgl. des Kommunistischen Weltreiches – nur Stunden vor dessen Zusammenbruch. Ich kann hier keine Beispiele zitieren, weil ich dazu erst Faktensuche betreiben müsste, was ich versprochen habe, nicht zu tun. Aber glauben Sie mir, man findet idiotische Statements noch von 24 Stunden zuvor.

Niemand kennt die Zukunft!

Nun ist das keine neue Information.Es war Mark Twain, der gesagt hat: „Ich habe einen Haufen Schwierigkeiten in meinem Leben vorhergesehen, und die meisten davon sind niemals passiert“.

Und Vieles von dem, was die Politiker sagen, ist nicht so sehr eine Prophezeiung, sondern ein Versuch, es wahr werden zu lassen. Es ist Argumentation maskiert als Analyse. Aber es überredet nicht wirklich irgendjemanden. Weil die meisten Menschen es durchschauen.

Falls Spekulation also nutzlos ist, warum gibt es dann so viel davon? Liegt es daran, dass die Menschen sie haben wollen? Das glaube ich nicht. Ich selbst spekuliere, dass sich die Medien der Spekulation zugewandt haben aus den Medien eigenen Gründen. Schauen wir also mal auf die Vorteile der Spekulation von einem Standpunkt der Medien aus:

1. Sie ist unglaublich billig. Schwatzen ist billig. Und Spekulations-Shows sind das Billigste, was man im Fernsehen bieten kann. Sie sind fast genauso billig wie das Senden eines Testbildes. Spekulation erfordert keine Forschung, keinen großen Stab an Mitarbeitern. Minimalen Aufwand. Lediglich den Moderator, Buchung der Teilnehmer – an denen es keinen Mangel gibt – und fertig! Einfach Show! Keine Reporter in verschiedenen Städten auf der ganzen Welt, keine Film-Crew am Drehort. Keine Ultimaten, kein Filmmaterial, welches bearbeitet werden müsste, keine Editoren … nichts! Einfach nur Gerede. Billig.

2. Man kann nicht verlieren. Obwohl die Spekulation nur zufällig auch mal stimmt, was bedeutet, dass man in jedem Falle zu 50% falsch liegt, erinnert sich niemand daran, weshalb sich auch niemand darum schert. Man ist niemals haftbar. Die Zuhörerschaft erinnert sich nicht an gestern, geschweige denn an die vorige Woche oder den vorigen Monat. Medien existieren nur im ewigen Jetzt, in dieser Minute, in dieser Krise, bei diesem Fernsehansager, in dieser Kolumne, bei dieser Spekulation.

Einer der klarsten Beweise hierfür ist die Kontroverse um die Currents of Death [= elektromagnetische Strahlung unter Strom-Überlandleitungen. Anm. d. Übers.]. Sie hatte ihren Ursprung im Journal The New Yorker, welches seit fünfzig Jahren eine sprudelnde Quelle falscher wissenschaftlicher Spekulation ist. Aber mein Punkt ist Folgender: Viele der Menschen, die vor zehn Jahren wild darauf waren, in ihren Häusern gefährliche elektromagnetische Strahlung zu messen, geben jetzt Tausende Dollar aus für den Kauf von Magneten, die sie um ihre Arme und Fersen wickeln wegen der vermeintlich die Gesundheit fördernden Effekte von Magnetfeldern. Diese Menschen erinnern sich nicht daran, dass es sich dabei um genau die gleichen magnetischen Felder handelt, die sie früher zu vermeiden trachteten. Und weil sie sich nicht erinnern, kann das Journal genau wie der Medien-Spekulant nicht verlieren.

Diesen Gedanken, dass man dabei nicht verlieren kann, möchte ich noch etwas weiter ausführen. Das ist nicht auf die Medien beschränkt. In den meisten Bereichen des intellektuellen Lebens hat man die Werte der Spekulation entdeckt und wild für sich vereinnahmt. In der Akademia wird Spekulation normalerweise als Theorie gewürdigt. Es ist faszinierend: sogar obwohl die intellektuelle Haltung der postmodernen deconstructionist era gegen die Theorie ist, besonders gegen allumfassende Theorien, ist das was jeder Akademiker zum Ausdruck bringen möchte, eine Theorie.

Dies ist teilweise übergeschnappte Wissenschaft, aber es ist auch ein Flucht-Türchen. Eine genaue Lektüre der Texte von Jane Austen kann man gut als falsch empfinden, und ein kenntnisreicherer Antagonist kann auch zeigen, dass sie falsch sind. Aber die Theorie der radikalen Feminisierung und autoritären Revolte in den Arbeiten von Jane Austen sind auch unberührbar. Unsere Standpunkte hinsichtlich der Ursprünge der Ersten Weltkrieges können durch andere Institutionen wesentlich genauer erklärt werden als von uns. Aber ein Beitrag eines New Historicist, in welchem durchaus unsere eigene Phantasie enthalten sein kann, welche das sein könnten, würden so sein wie als ob man während des ersten Krieges Soldat war … nun, das ist nicht debattierbar.

Ein hervorragender Bereich für spekulative akademische Arbeiten ist das Unbekannte. Dieser Tage sind religiöse Gegenstände in Ungnade, aber es gibt immer noch viele gute Themenbereiche. Die Natur des Gewissens, die Arbeit des Gehirns, der Ursprung von Aggression, der Ursprung der Sprache, der Ursprung des Lebens auf der Erde, SETI und Leben auf anderen Welten … all das ist großartiges Zeug. Wunderbares Zeug. Man kann endlos darüber debattieren. Aber dem kann nicht widersprochen werden, weil niemand die Antwort auf irgendeines dieser Themen kennt – was wahrscheinlich auch niemals der Fall sein wird.

Aber das ist nicht die einzige Strategie, die man heranziehen kann. Weil die medien-indoktrinierte Öffentlichkeit Behauptungen aus der Vergangenheit ignoriert und vergisst, kommen heutzutage selbst Autoren ungeschoren davon, wenn sie harte Daten präsentieren, die sich dann erwiesenermaßen als falsch herausstellen.

[Woher ,wusste‘ Crichton im Jahre 2002, als er dies schrieb, von den jetzt offenbar gewordenen Manipulationen der NOAA? Anm. d. Übers.]

Eine der am konsistentesten falsch liegenden Denker der letzten Jahre, Carol Gilligan von Harvard, einst ,Wissenschaftlerin des Jahres‘ des MS-Magazins, musste vieles von dem, was sie je geschrieben hatte, zurückziehen oder modifizieren. Und doch hat ihr Ruf als profunde Denkerin und bedeutende Untersucherin keinerlei Schaden genommen. Man muss nicht recht haben, nicht mehr. Niemand erinnert sich.

[Gibt’s da nicht auch einen Mojib Latif von gleichem Kaliber? Anm. d. Übers.]

Dann gibt es da die spekulativen Arbeiten von Anthropologen wie Helen Fisher, die behaupten, uns etwas über die Ursprünge der Liebe oder der Untreue mittels Verweisen auf andere Gesellschaften, auf das Verhalten von Tieren und fossilen Aufzeichnungen zu vermitteln. Wie kann sie falsch liegen? Es ist unüberprüfbar, unbeweisbar, einfach so Stories.

Und damit nicht jemand sich vorstellt, dass Dinge in der Hard Science anders sind, denke man an die String-Theorie, seit fast zwanzig Jahren die dominante physikalische Theorie. Mehr als eine Generation von Physikern hat an der String-Theorie gearbeitet. Aber – falls ich sie richtig verstehe, was vielleicht nicht der Fall ist – die String-Theorie kann nicht getestet oder bewiesen oder widerlegt werden. Obwohl einige Physiker bei dem Argument, dass eine unüberprüfbare Theorie nichtsdestotrotz wissenschaftlich ist, die Augen verdrehen, wer leistet wirklich Widerstand? Man erkenne: Eine unüberprüfbare Theorie ist ideal! Die Karriere ist gesichert!

Kurz gesagt, so lange man spekuliert, kann man nicht verlieren. Diese Erkenntnis ist weit verbreitet. Und sie ist perfekt für das Informations-Zeitalter, welches ein Füllhorn von Wissen verspricht, aber nur ein Füllhorn voll Quacksalberprodukten liefert.

Und nirgendwo steht geschrieben, dass die Medien akkurat oder nützlich sein müssen. Das waren sie nicht während der allermeisten Zeit der Historie. Also spekulieren sie jetzt … na und? Was ist daran falsch?

1. Die Tendenz zum Exzess. Die Tatsache, dass es sich nur um Gerede handelt, macht Dramatik und Spektakel unwahrscheinlich – es sei denn, das Gerede wird hitzig und exzessiv. Also wird es exzessiv. Nicht in jeder Show tritt der Kampf um Stoff nach Art eines Kreuzverhörs zutage, aber es ist eine Tendenz in allen Shows.

2. Die „Verkritisierung“ von allem und jedem ist möglich. Die meiste Spekulation ist nicht fesselnd, weil die meisten Ereignisse nicht fesselnd sind – Mensch, ich frage mich was mit der Deutschen Mark passieren wird! Werden sie ihre Arbeits-Probleme unter Kontrolle bekommen? Dies dient dem wohlbekannten Bedarf der Medien nach einer Krise. Krise bei der Deutschen Mark! Oh je! Passt auf! Krisen einigen das Land, ziehen Zuschauer in großer Zahl an und liefern etwas, über das sich treffend spekulieren lässt. Ohne Krise wird das Gerede bald zu einer Debatte darüber degenerieren, ob die Schiedsrichter eines Footballspiels das letzte Footballspiel hätten noch einmal begutachten sollen. Es gibt also eine Tendenz zu Dringlichkeit und Bedeutung zu hypen und ein Geh-Hin-Gefühl zu vermitteln, wenn das nicht wirklich angemessen ist. Man betrachte die ellenlange Schriftrolle unten im Bildschirm bei der Beerdigung der Königin-Mutter. Wie auch immer die Story um die Königin-Mutter geartet ist, es ist keine Krise. Ich habe sogar ein paar Tage lang die Berichterstattung über meine eigene Scheidung auf CNN verfolgt. Es ist irgendwie schmeichelhaft, obwohl die Darstellung falsch war. Aber meine Scheidung ist mit Sicherheit keine ultimative Brandnachricht.

3. Oberflächlichkeit als Norm. Es muss schnell gehen. Man muss sofort zu den Höhepunkten kommen. Spekulation ist der Oberflächlichkeit förderlich. Das ist es, oder?

4. Endlose Präsentation von Unsicherheit und Konflikten kann Lösungen von Dingen in die Quere kommen. Es gibt einige Beweise, dass die Verteilungskämpfe im Fernsehen nicht nur nicht die Meinungen der meisten Menschen repräsentieren – die nicht so polarisiert sind – sondern dass sie dazu tendieren, die Lösungen aktueller Streitfälle in der realen Welt schwieriger zu machen. Zu allermindest verschleiern diese Verteilungskämpfe die Erkenntnis, dass Streitfälle jeden Tag gelöst werden. Kompromisse bei relativ zentralen Positionen sind viel einfacher als bei extremen oder feindlichen Positionen, die miteinander im Konflikt stehen: Greenpeace gegen die Holzindustrie.

5. Die unendliche Kette von Spekulationen pflastert den Weg zum Streit über Brustimplantate, Hysterie über das Jahr-2000-Problem oder globale Erwärmung, Artikel im The New Yorker über Todesströmungen [currents of death] und eine Vielzahl anderer Resultate, deren Eintreffen keine guten Dinge wären. Es kommt irgendwann zu der Vorstellung – was für die Medien sehr bequem ist – dass am Ende nichts sicher ist. Wenn das tatsächlich nicht wahr ist.

Ich möchte auf eine vorzeigbare schlimme Auswirkung der Hypothese hinweisen, dass nichts wirklich erfahrbar ist. Das Whole Word Reading [ein neues System zum Erlernen von Wörtern in der Grundschule, Anm. d. Übers.] wurde eingeführt durch die Bildungsschulen im ganzen Land, meines Wissens ohne irgendein Test der Effizienz der neuen Methode. Sie war auf einmal da. Generationen von Lehrern wurden mit diesen Methoden indoktriniert. Als Folge davon weisen die USA eine der höchsten Analphabetenrate in der industrialisierten Welt auf. Die Hypothese, dass man nichts mit Sicherheit weiß, hat schreckliche Konsequenzen.

GK Chesterton sagte (in einem anderen Zusammenhang): „Falls man an nichts glaubt, glaubt man an alles“. Genau das erleben wir heute. Die Menschen glauben alles.

Aber einfach ausgedrückt als allgemeine emotionale Haltung des Lebens glaube ich oft, dass Menschen nervös und überspannt sind in diesem medialen Klima von Was ist, wenn… vielleicht…, könnte sein, dass… obwohl es einfach keinen Grund gibt, nervös zu sein. Genau wie ein bärtiger Kuttenträger auf einem Bürgersteig, der unentwegt das kurz bevorstehende Ende der Welt verkündet, machen die Medien genau das, was sich gut anfühlt, und berichten nicht über harte Fakten. Wir müssen anfangen, die Medien als den bärtigen Ultra auf dem Bürgersteig zu sehen, der falsche Befürchtungen hinaus brüllt. Es ist nicht vernünftig, darauf zu hören.

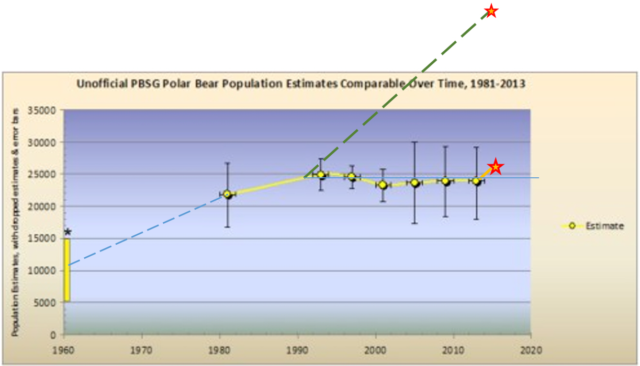

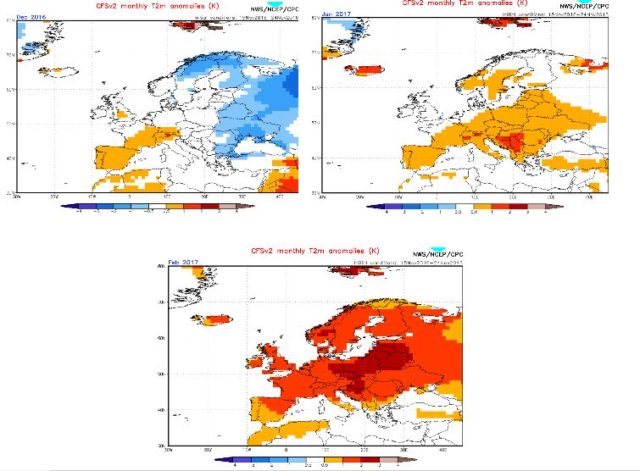

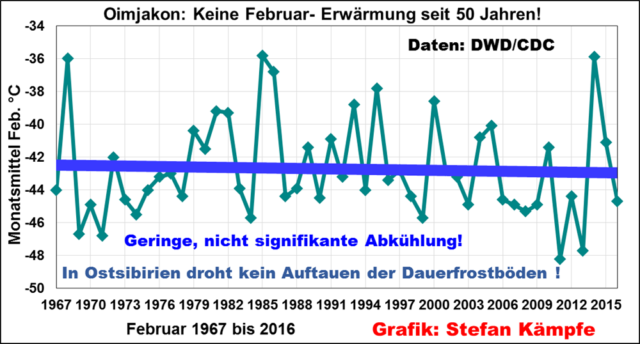

Wir müssen anfangen, uns daran zu erinnern, dass jeder, der seinerzeit sagte, das Jahr-2000-Problem sei kein wirkliches Problem, entweder niedergebrüllt oder von der Öffentlichkeit fern gehalten worden ist. Gleiches gilt für Bereiche wie das Aussterben von Spezies und globale Erwärmung. Man hört niemals jemanden, der sagt, das ist keine Krise. Das möchte ich nicht weiter vertiefen, weil es uns zur Heranziehung von Fakten bringen könnte, aber ich möchte zwei Berichte erwähnen, von denen ich spekuliere, dass Sie von diesen noch nie gehört haben. Der erste Bericht findet sich im Magazin Science vom 18. Januar 2001 (Oha! Eine Tatsache!), dass im Gegensatz zu früheren Studien die Antarktische Eismasse zu- und nicht abnimmt, und dass diese Zunahme bedeutet, dass wir endlich ein Ende des Schrumpfens der Eismasse sehen, welche bereits seit Tausenden von Jahren im Gange ist, seit Beginn des Holozäns. Ich weiß nicht, was überraschender ist – das Statement, dass das Eis zunimmt, oder das Statement, dass die Schrumpfung Tausende Jahre der globalen Erwärmung vorausgegangen ist.

Die zweite Studie ist ein Bericht der National Academy of Sciences über die ökonomischen Auswirkungen des jüngsten El Nino-Ereignisses von 1997 [zur Erinnerung, dieser Beitrag stammt aus dem Jahr 2002, Anm. d. Übers.]. Jene Erwärmung erbrachte einen Gesamt-Profit von 15 Milliarden Dollar für die Wirtschaft. Darin enthalten sind die Verluste von 1,5 Milliarden in Kalifornien durch Regen, welche jedoch ausgeglichen wurden durch billigere Treibstoffrechnungen infolge eines milderen Winters und einer längeren Wachstumssaison. Gesamtergebnis 15 Milliarden an gestiegener Produktivität.

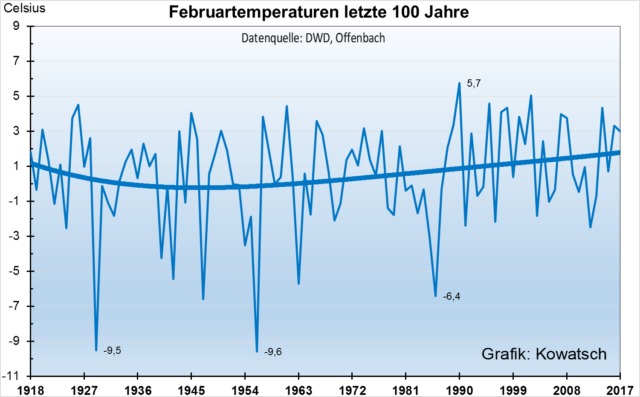

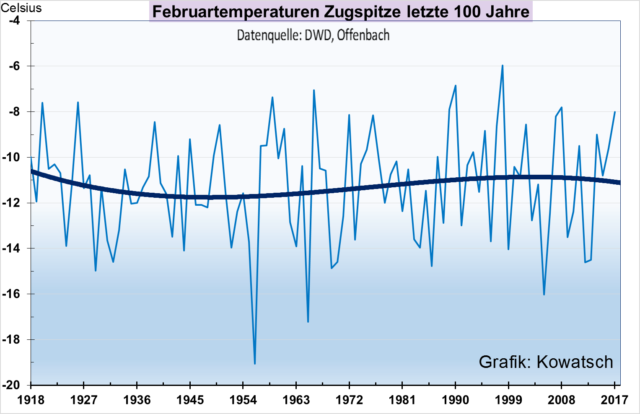

Das Andere, was ich erwähnen möchte ist, dass während der letzten 100 Jahre, während die mittlere Temperatur um lediglich 0,3°C gestiegen ist, das Magnetfeld der Erde um 10% abgenommen hat. Dies hat viel stärkere Auswirkungen als globale Erwärmung und ist potentiell für das Leben auf diesem Planeten weitaus ernster.

Unser Magnetfeld ist das, was die Atmosphäre bereit hält. Sie schirmt uns ab vor tödlicher Strahlung aus dem Weltall. Eine Abnahme des Erdmagnetfeldes um 10% ist extrem besorglich. Aber wer ist besorgt? Niemand! Wer ruft nach Gegenmaßnahmen? Niemand! Warum nicht? Weil man nichts dagegen tun kann. Wie das in Relation zur globalen Erwärmung zu setzen ist, möchte ich Ihrer eigenen Spekulation überlassen.

Persönlich denke ich, dass wir uns von den Medien abwenden sollten, und die Daten zeigen, dass wir das bereits tun, zumindest was die Fernsehnachrichten betrifft. Ich finde, dass wann immer es mir fehlt, den Medien ausgesetzt zu sein, ich viel glücklicher bin, und mein Leben fühlt sich besser an.

Abschließend möchte ich daran erinnern: Während es so Manches gibt, das wir nicht sicher wissen können, gibt es viele Dinge, die herausgefunden werden können und tatsächlich auch herausgefunden werden. Jedoch nicht durch Spekulation. Sondern durch sorgfältige Untersuchung und rigorose statistische Analyse. Da wir in diesem vorübergehenden Ozean von Spekulation schwimmen, vergessen wir, dass man Dinge mit Sicherheit wissen kann, und dass wir nicht in einer angstvollen Welt unendlicher, nicht gestützter Meinungen leben. Aber der Graben, der harte Fakten von Spekulation trennt, ist inzwischen so unbekannt, dass die meisten Menschen ihn nicht fassen können. Vielleicht kann ich ihn mit folgender Geschichte verdeutlichen:

Auf einem Flug nach Europa platzierte man mich neben einem Mann, der sehr unglücklich ist. Es stellt sich heraus, dass er ein Arzt ist, den man für eine zweijährige Doppelblind-Studie für die FDA [= die amerikanische Gesundheitsbehörde, Anm. d. Übers.] engagiert hatte bzgl. der Wirksamkeit von Medikamenten, und es könnte zum Fenster hinaus geworfen sein. Nun bedeutet eine Doppelblind-Studie, dass es vier separate Forscherteams gibt, die untereinander keinen Kontakt haben – vorzugsweise arbeiten sie an unterschiedlichen Universitäten in verschiedenen Teilen des Landes. Das erste Team definiert die Studie und legt die Behandlungsweisen fest, die wirklichen Arzneien und die Kontrollen. Das zweite Team erklärt die Einnahme den Patienten. Das dritte Team sammelt die Daten und schätzt unabhängig die Wirkung der Arznei auf jeden Patienten. Das vierte Team sammelt die Daten und führt eine statistische Analyse durch. Die Kosten dieser Art von Studien betragen, wie man sich vorstellen kann, Millionen Dollar. Und die Teams dürfen sich niemals treffen.

Mein Nachbar ist unglücklich, weil Monate nach Ende der Studie er in einem Wartesaal am Flughafen Frankfurt ins Gespräch mit einem anderen Mann dort gekommen war, und sie entdecken – zu ihrem Schrecken – dass sie beide in der Studie involviert waren. Mein Nachbar war in dem Team, welches die Arzneien verabreichte. Der andere Mann war in dem Team mit den Statistiken. Es gibt keinen Grund, warum einer den anderen zu diesem späten Zeitpunkt beeinflussen sollte, aber nichtsdestotrotz verlangt das Protokoll, dass sich die Teammitglieder niemals treffen. Und so wartet mein Nachbar jetzt darauf, von der FDA zu hören, ob diese die Studie insgesamt einstampfen wollte wegen dieses zufälligen Zusammentreffens in Frankfurt.

Das sind jene Strapazen, durch die man hindurch muss, falls man sicher sein will, dass seine Information korrekt ist. Aber wenn ich den Menschen diese Story erzähle, starren sie mich nur verständnislos an. Sie finden das absurd. Sie glauben nicht, dass es notwendig ist, all das zu tun. Sie glauben, es ist Overkill. Sie leben in der Welt von MSNBC und der New York Times. Und sie haben vergessen, was reale, zuverlässige Informationen sind sowie die Mühen, diese zu erhalten. Das ist so viel schwerer als einfach nur zu spekulieren.

Herzlichen Dank!

– International Leadership Forum, La Jolla (26 April 2002)

Quelle: http://larvatus.com/michael-crichton-why-speculate/

Übersetzt von Chris Frey EIKE