DDR 2.0 – oder wie ich lernte die Energiewende als Erfolgsgeschichte zu sehen!

„Den Sozialismus in seinem Lauf, halten weder Ochs noch Esel auf“ (hier ein hübsches Video davon, dass sich aber leider nicht einbetten lässt ) hat der späte Honecker noch 1989 frohlockend seinen Bürgern verkündet, als das Ende der DDR schon fest besiegelt war. Was haben wir uns über diesen Naivling gefreut. War er auch Staatschef eines, wie man heute sagen würde, „failed state“, hatte dies aber weder begriffen noch akzeptiert, so hatte er seine Zuversicht, dass der Sozialismus eines Tages siegen würde, doch nie verloren.

Und wir Deppen haben geglaubt, der Mann wüsste nicht wovon er redet. Heute erkennen wir, reichlich spät, eventuell zu spät , dass wir es waren, die nicht wussten, wovon er redet. Honecker meinte nicht unbedingt die DDR, wenn er vom unaufhaltsamen Siegeszug des Sozialismus redete, er meinte den Sozialismus in seiner Reinform, freiwillig praktiziert von einem Staat, dem sich die DDR Bürger kurz nach seiner Rede mit Inbrunst anschlossen. Der Bundesrepublik Deutschland.

Denn wie anders ist zu erklären, dass seinerzeit Kohl´s Mädchen – die ehemalige FDJ Sekretärin für Agitprop und Propaganda [1], dann Umweltministerin, welche der Rio Nachhaltigkeitserklärung zustimmte und heutige Bundeskanzlerin Dr. Angela Merkel – schon 1992 das Stromeinspeisegesetz einführte, mit dem die „Energiewende“ als sozialistisches Element der Planwirtschaft begann. Anschließend wurde sie von der SPD und den Grünen im Jahre 2000 mit dem „Erneuerbare Energiengesetz“ (EEG) drastisch beschleunigt und erweitert, und dann wieder unter Merkels Regie mächtig ausgeweitet, und auf alle Bereiche der Energiewirtschaft ausgedehnt. Und, unter dem Deckmantel des Klimaschutzes, über viele weitere Gesetze und Verordnungen immer weiter ausgeweitet, um schlussendlich die „Dekarbonisierung“ zu erzwingen. Die damit durch die Hintertür eingeführte sozialistische Planwirtschaft erstreckt sich heute auf so gut wie alle Bereiche des täglichen Lebens. Und kaum jemand merkt etwas und nur sehr, sehr wenige tun etwas.

„Wenn der Faschismus wieder kommt, wird er nicht sagen: ich bin der Faschismus, er wird sagen ich bin der Antifaschismus“. In Abwandlung dieses zutreffenden Zitates des italienischen Schriftstellers Ignazio Silone, kann man heute feststellen: „Wenn der Sozialismus wieder kommt, wird er nicht sagen: ich bin der Sozialismus, er wird sagen ich bin der Klimaschutz“.

Womit wir wieder bei Erich Honecker und seiner aus heutiger Sicht bemerkenswerten Weitsicht wären und der großen Transformation, die der Sozialismus, jedoch nur vordergründig, durchlaufen hat.

Halten wir also fest. Der heutige Klimaschützer – besser die heutigen KlimaschützerInnen- sind die SozialistInnen von gestern.

Beispiel gefällig?

Die vierfarbige zwanzigseitige Beilage großer Tageszeitungen, mit dem Titel „Die Energiewende unsere Erfolgsgeschichte“ flatterte unlängst in Millionen Haushalte. Eine Veröffentlichung der Bundesministerin für Wirtschaft und Energie, wie man ganz oben rechts am Rand erkennen kann. Verantwortlich zeichnet Frau Brigitte Zypries, zu der Zeit gerade mal wenige Tage als Ministerin im Amt.

Nun weiß jeder, der mit auch nur einem Funken Sachverstand gesegnet ist, dass die Energiewende gescheitert ist. Gescheitert deswegen, weil man auch als begnadeter Politiker, egal welcher Couleur, selbst als Sozialist, nicht gegen die Naturgesetze gewinnen kann. Sie können weder gebogen noch gebrochen werden. Sie können aber unter sehr hohen Kosten umgangen werde.

Ihr Vorgänger im Amt, das politische Multitalent Siegmar Gabriel[2] hatte dies vor einiger Zeit in einem kurzen Anfall von Wahrheitsliebe auch zugegeben_

-

„Die Wahrheit ist, dass die Energiewende kurz vor dem Scheitern steht.“

-

„Die Wahrheit ist, dass wir auf allen Feldern die Komplexität der Energiewende unterschätzt haben.“

-

„Für die meisten anderen Länder in Europa sind wir sowieso Bekloppte.“

Dem ist eigentlich nichts hinzuzufügen, außer vielleicht die Aufforderung:

„Nun handelt endlich und schafft dieses Monstrum wieder ab.“ !

Das wäre Realpolitik. Die ist aber bei Politikern generell und den Sozialisten insbesondere, äußerst unbeliebt. Ihr Motto heißt daher: Wenn die bisherigen Politik nichts gebracht hat, dann muss es eben mehr davon sein. Und wenn die Realität nicht mitspielt, umso schlechter für die Realität. Und dafür legt die millionenfach verteilte Broschüre „Die Energiewende unsere Erfolgsgeschichte“ beredt Zeugnis ab. Die Wirklichkeit wird geleugnet, dass die Schwarte kracht.

Frei nach dem alten DDR Spruch:„Von der Sowjetunion lernen heißt siegen lernen“

Diese schöne Losung aus der DDR 1.0 ist mir immer noch in Erinnerung.

Von ähnlicher Aussagekraft und Wahrheitsgehalt sind die folgenden Sprüche (Kapitelüberschriften) in der DDR 2.0 Broschüre der Bundeswirschaftsministerin:

Nachhaltig und sicher,

Bezahlbar und planbar

Verlässlich und intelligent

Wettbewerbsfähig

Weltweit wegweisend

Als Krönung lesen wir auch darin:

„Die Broschüre bilanziert die bisherigen Erfolge der Energiewende und gibt einen Ausblick auf die bevorstehenden Schritte.“

Also unterziehen wir einige der genannten Losungen einer kurzen Überprüfung

Nachhaltig und sicher

Mit „nachhaltig“ – dem Modewort seit der Rio-Nachhaltigkeitskonferenz 1992- ist gemeint, dass die „Erneuerbaren“ keine (fossilen) Brennstoffe verbrauchen und als gewünschtem Haupteffekt zum Klimaschutz beitragen (sollen). Das trifft zwar in Bezug auf den Verbrauch von Brennstoffen für die Stromerzeugung zu, jedoch werden für Bau, Betrieb, Unterhalt und Rückbau erhebliche Mengen an hoch veredelten Ressourcen benötigt, die, Dank der sehr geringen Energiedichte der Energielieferanten, wie auch der geringen Lebensdauer dieser Anlagen, fallen diese erheblich größer aus, als für die konventionelle Energieerzeugung. Statt Kohle, Öl, Gas und Kernbrennstoff verbrauchen die „Erneuerbaren“an hochveredelten Rohstoffen jeglicher Art daher ein Mehrfaches pro MW installierter Leistung .

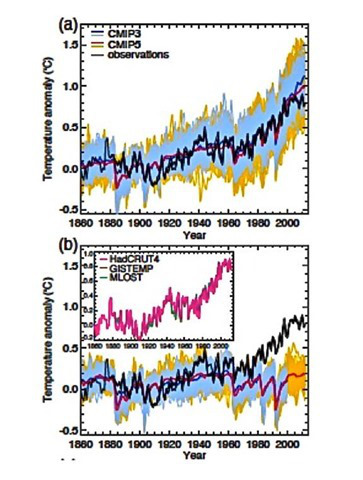

Auch die Hoffnung auf Klimaschutz erfüllt sich nicht,

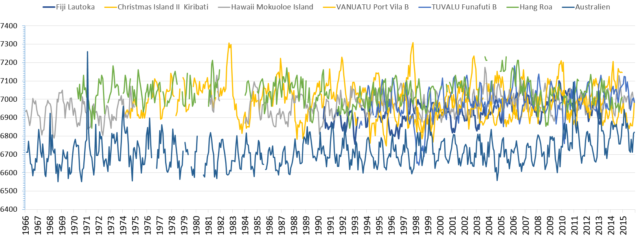

- weil das Klima sich nicht um den CO2 Ausstoß schert

und

- weil trotz eines Anteils der „Erneuerbaren“ von rd. 32 % an der Bruttostromerzeugung, die CO2 Emissionen für den Stromsektor nahezu unverändert blieben, während sie insgesamt sogar wieder steigen. Doch für den Fall, dass sie doch sinken würden, die Nachbarstaaten dank des Emissionshandels diese Mengen gern zusätzlich in die Luft blasen würden.

Fazit: Diese Behauptung ist eine Nullnummer für Dummies.

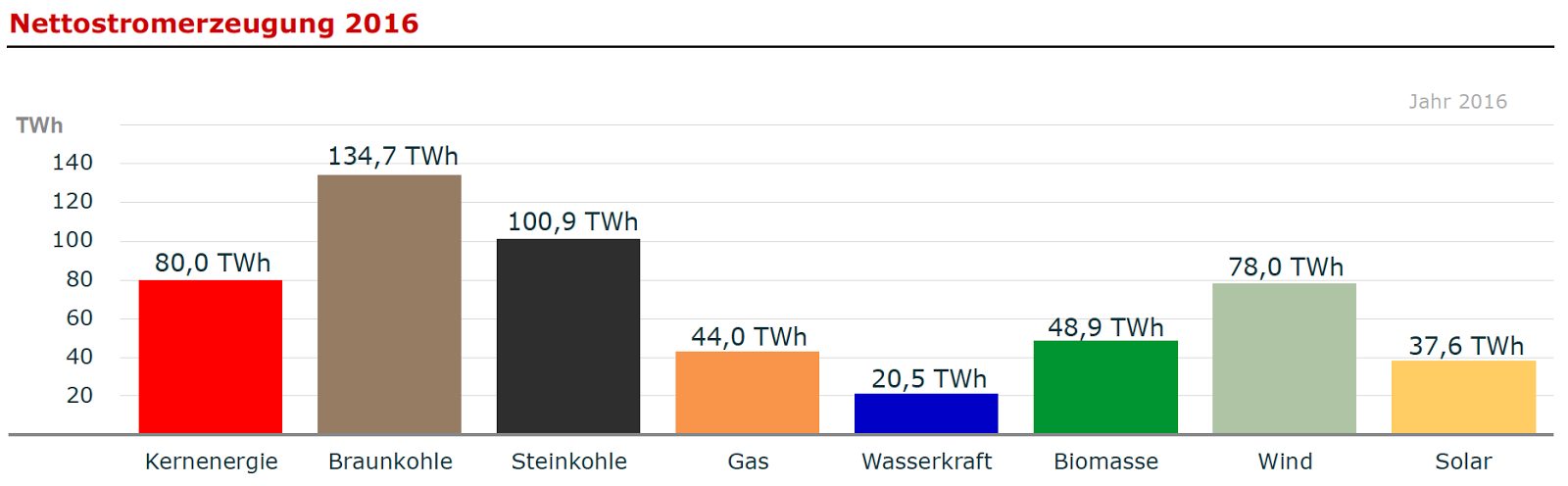

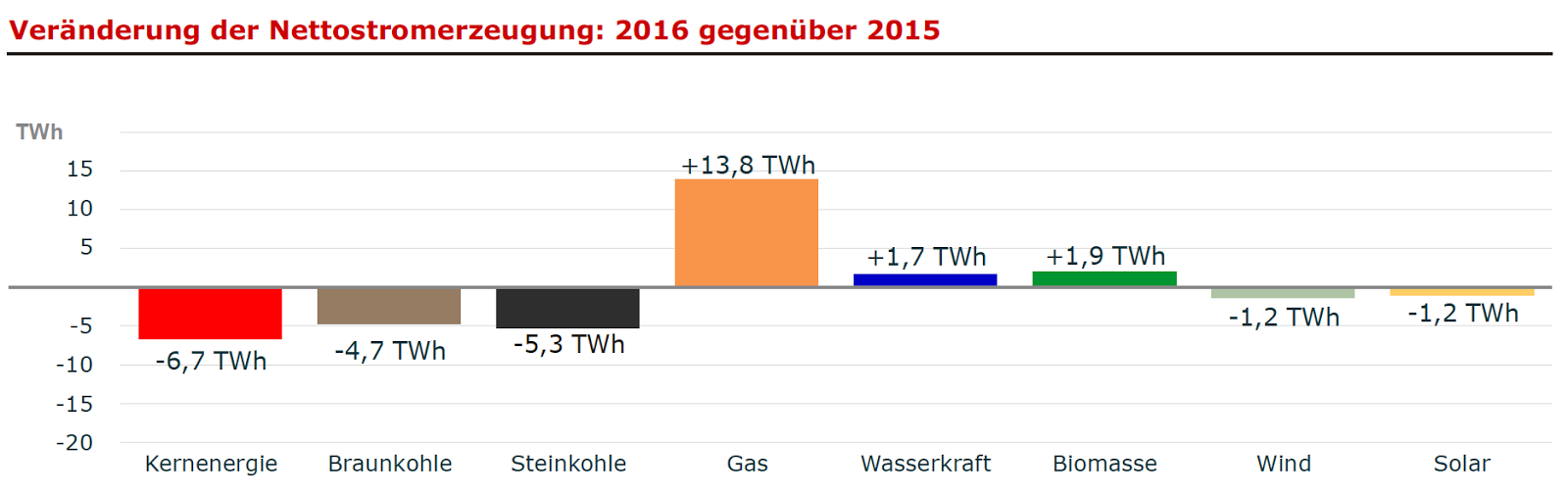

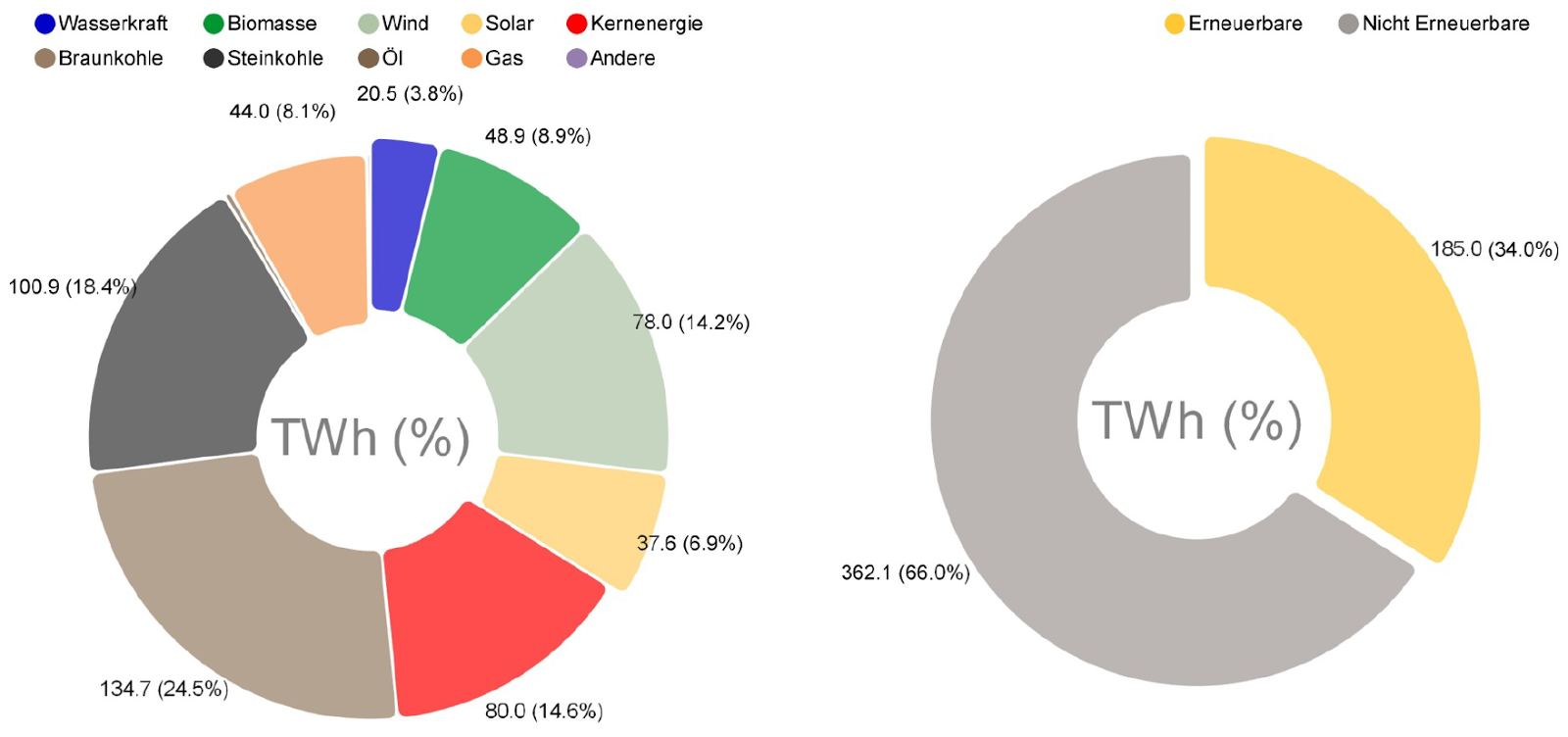

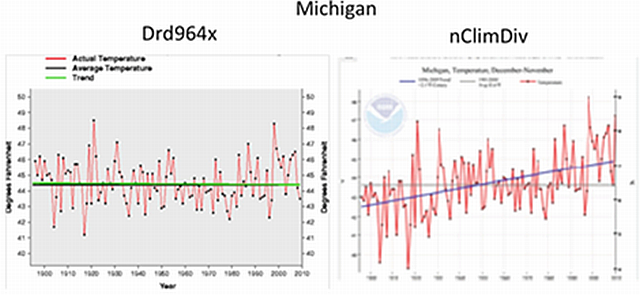

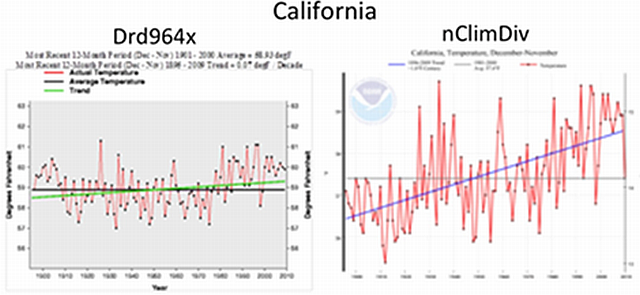

Abbildung 1 Trotz eines Anteils 2016 von rd. 32 % der „Erneuerbaren“ an der Bruttostromerzeugung liegt der Anteil von Wind & Sonne bei läppischen 3,1 % des Primärenergieverbrauches. Bei geplantem 100 % „EE“-Anteil müssten die Wind – und Solaranlagen um den Faktor 28 gesteigert werden. Wasserkraft, Biomasse und Geothermie sind ausgereizt. Wollte man das mit Windrädern allein stemmen und legt man die derzeitige installierte Zahl zugrunde, dann kämen wir überschlägig auf gut 700.000 dieser „Kathedralen der Grünen (Bärbel Höhn). Dann kämen auf jeden bundesdeutschen Quadratkilometer 2 Windkraftanlagen.

„sicher“

Was mit „sicher“ gemeint ist, kann dem Kapitel nicht entnommen werden. Eventuell meint die Überschrift:

Das Ende als Wirtschaftsstandort ist sicher !

Denn es wird darin ein Loblied auf die Pariser Klimabeschlüsse und deren erfolgreiche Umsetzung mittels Dekarbonisierung durch die Berliner Regierung gesungen. Und an deren Ende, wenn wir das zulassen, steht mit Sicherheit das Ende des Industriestandortes Deutschland.

Bezahlbar und planbar

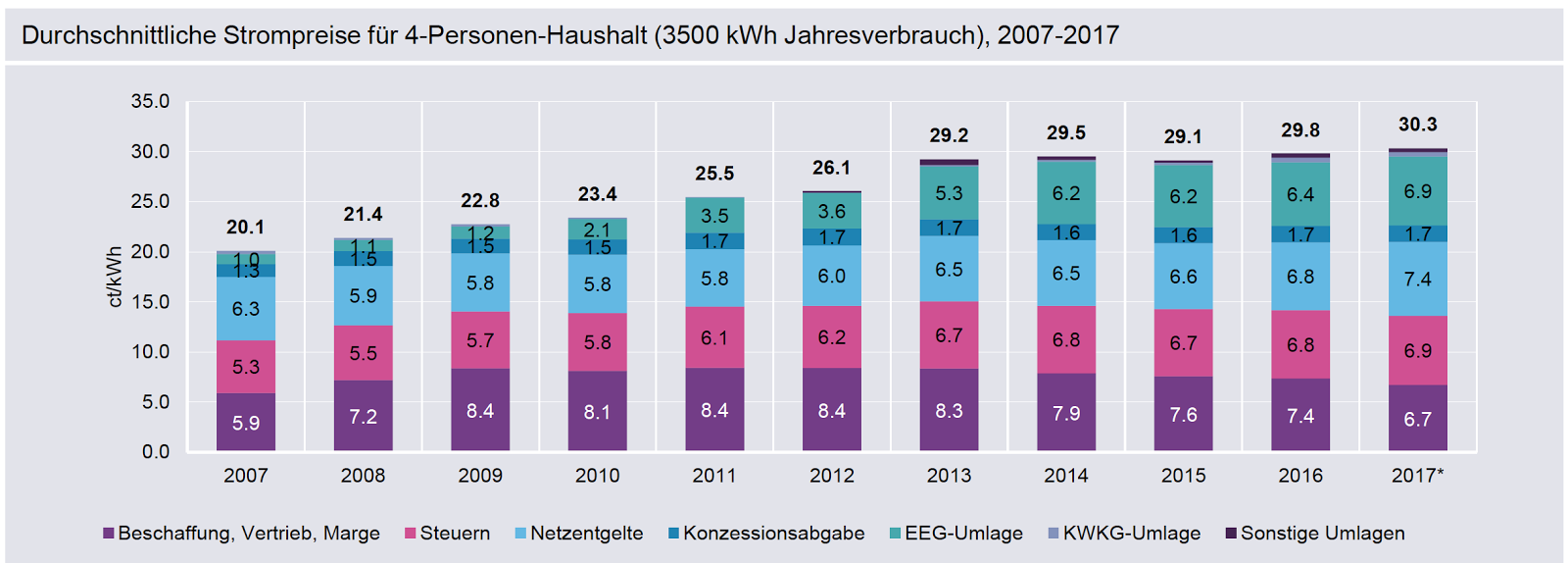

Bezahlbar

Unter „bezahlbar“ versteht Frau Zypries, dass die Verbraucher durch das EEG gezwungen werden, die EE kWh mit z.Zt 6.88 ct/kWh + 19 % Mwst = 8,19 ct/kWh über die EEEG Umlage zu finanzieren. Das ist der rd 3 fache Preis eine kWh ab Braunkohle E-Werk und der rd 4 fache Preis dessen, was der EE Strom derzeit an der Börse wert ist. Hinzu kommen noch rd. 1 ct/kWh für den Netzausbau und die rapide ansteigenden Kosten der Stabilisierungsmaßnahmen, die unter dem Begriff Netzentgelt versteckt werden.

„Infolge der Energiewende müssen die Netze massiv aus- und umgebaut werden – allein im Verteilnetz müssen bis zu 50 Milliarden Euro bis 2032 investiert werden. Hinzu kommt: Steuern, Abgaben und Umlagen auf den Strompreis sind drastisch gestiegen“,

erklärt Stefan Kapferer[3], ein Grüner und Vorsitzender des Energieverbands BDEW.

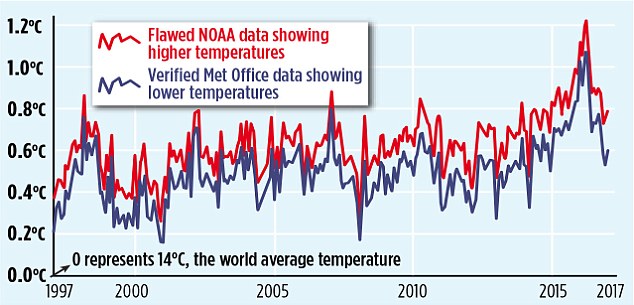

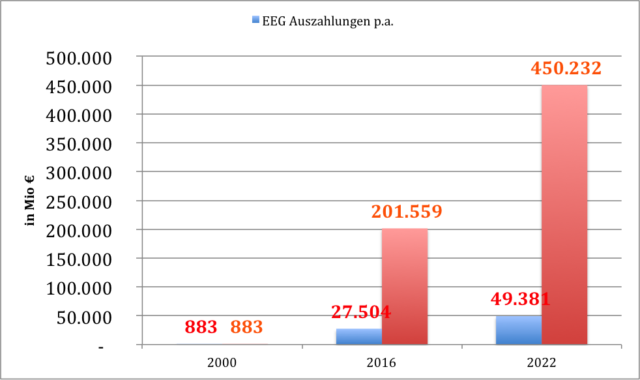

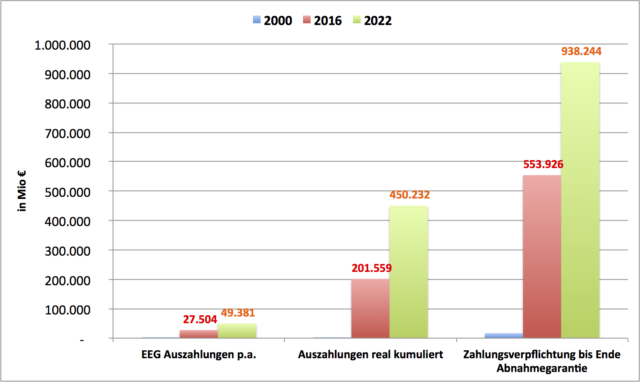

Summa summarum haben daher die Verbraucher über die Netzbetreiber allein im letzten Jahr rd. 27,5 Mrd € an EEG Umlage, EE Stromwert an die Besitzer von EE Anlagen bezahlt. Insgesamt seit Beginn des EEG sind 201 Mrd € aufgelaufen (Abb. 2a). Und noch schlimmer, auf Grund der 20 jährigen im EEG festgeschriebenen Abnahmegarantie, werden sie für die nächsten 20 Jahre nochmals rd 553 Mrd € (siehe Abb. 2b) aufbringen müssen. Aber nur dann, wenn ab sofort jeglicher Zubau gestoppt würde, sonst wird es jedes Jahr exponentiell mehr.

Abbildung 2a EEG Auszahlungen an „EE“-Besitzer durch die Netzbetreiber blau jährliche Auszahlung. Rot kumuliert, das was wir bisher schon gezahlt haben. Quelle. BMWi Erneuerbare Energien und eigene Berechnungen für die Jahre nach 2016. Das Düsseldorfer Institut für Wettbewerbsökonomik (was es nicht alles gibt!) berechnet die Gesamtkosten bis 2025 mit 520 Mrd €.

Abbildung 2b: EEG jährliche Auszahlungen, kumulierte Auszahlungen und zukünftige Auszahlungsverpflichtungen der Netzbetreiber an „EE“-Besitzer durch die Netzbetreiber in den Jahren 2000, 2016 und 2022. In Summe hätten wir dann 2022 rd. 0,45 Billionen € an die „EE“ Besitzer gezahlt und noch immer eine knappe Billion zu zahlen. Diese gewaltige Zwangshypothek auf die Zukunft, die jeder von uns zu schultern gezwungen wird, „vergessen“ die meisten Studien in ihre Berechnungen einzubeziehen. Quelle. BMWi Erneuerbare Energien

Einen Ausbaustopp will die Regierung aber nicht. Sie will das Gegenteil. Ist es doch feste Absicht der Regierung und u.a. im Klimaschutzplan 2050 fest geschrieben, den Ausbau sogar noch drastisch zu steigern. Bleibt es dabei, dann müssen wir Verbraucher im Jahr 2022 bereits knapp 50 Mrd € für den EE Strom zahlen, hätten bereits für den Stotterstrom 450 Mrd aufgebracht und haben zusätzlich eine Hypothek Laufzeit 20 Jahre von 940 Mrd € aufgebrummt bekommen.

Das also versteht eine linke Ministerin unter „bezahlbar“.

Der Begriff ist so schön schwammig irreführend, dass man verstehen kann, warum er der Lieblingsbegriff vieler Politiker ist.

Doch merke: Auch ein Ferrari ist bezahlbar, wenn man das nötige Kleingeld dafür hat.

Um aber die Volksverdummung auf die Spitze zu treiben, brüstet sich die Ministerin im Text damit, dass die Einspeisevergütung für „große Photovoltaikanlagen“ im Laufe der Jahre abgesenkt wurde. Ein Aha Erlebnis für alle diejenigen, die des einfachen Dreisatzes nicht kundig sind.

FakeNews der gröberen Art.

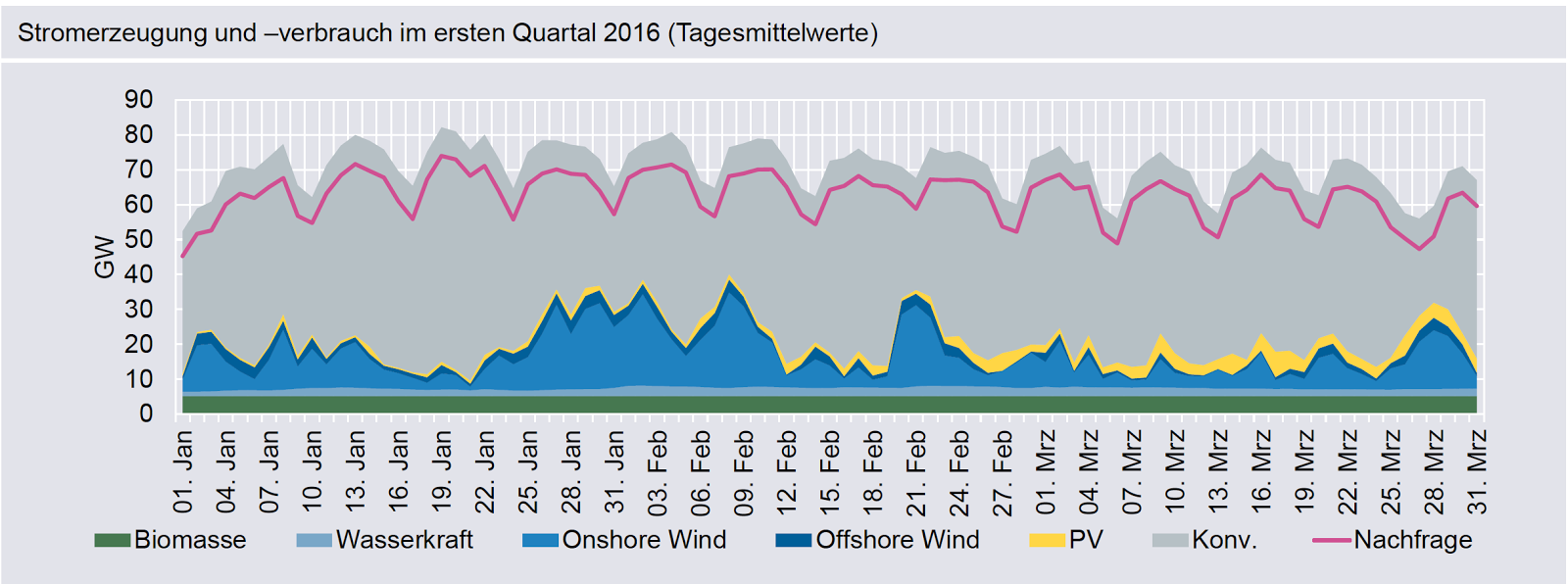

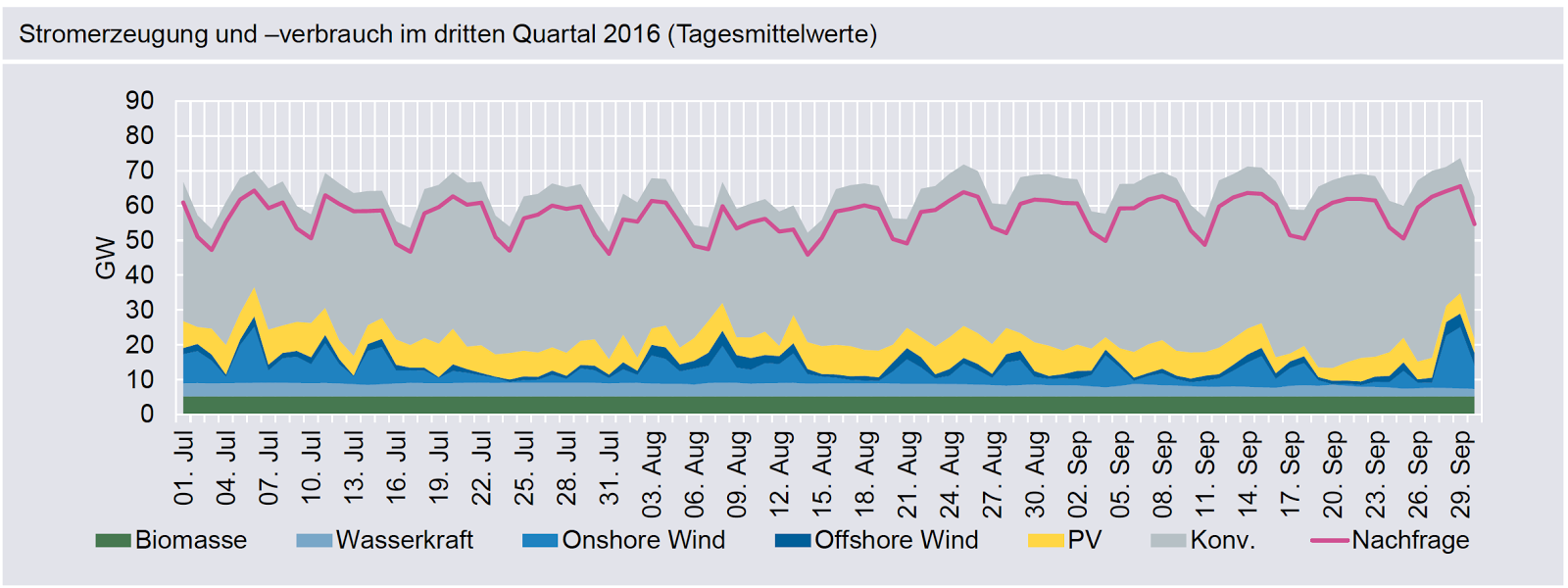

Planbar

Unter planbar versteht Frau Zypris nicht etwa die Planbarkeit der Stromeinspeisung. bei der in jeder Sekunde Angebot und Nachfrage ausgeglichen sein müssen, zumindest in dieser Hinsicht macht sie uns nichts vor, sondern allein die Planbarkeit der Einnahmen, wie sie in Abbildung 2 so klar dargestellt sind. Da werden sämtliche EEG Gewinnler vor Freude juchzen, gibt es doch kein besseres Instrument das Geld auch der ärmsten Verbraucher in die Taschen der EEG Gewinnler umzuverteilen. Und die Mehrheit im Lande findet das auch noch gut! Frau Zypris, der Regierung Merkel und allen Parteien die derzeit im Bundestag sitzen sei Dank.

Verlässlich und intelligent

Verlässlich

Schon am Anfang gesteht die Ministerin ein, dass Wind und Sonne den Strom nicht verlässlich erzeugen können. Und weil das auch nicht zu ändern ist, münzt sie die bisherige, noch immer hohe Zuverlässigkeit des Stromsystems, die unsere Energiewirtschaft in guten Jahren und in typisch deutschem Überengineering (so gut wie möglich, statt so gut wie nötig) aufgebaut hatte als ihren Verdienst um. Dabei verschweigt sie die bereits jetzt in schwindelnde Höhen angestiegenen Stabilisierungskosten, welche die Maßnahmen der Netzbetreiber bereits heute erzwingen.

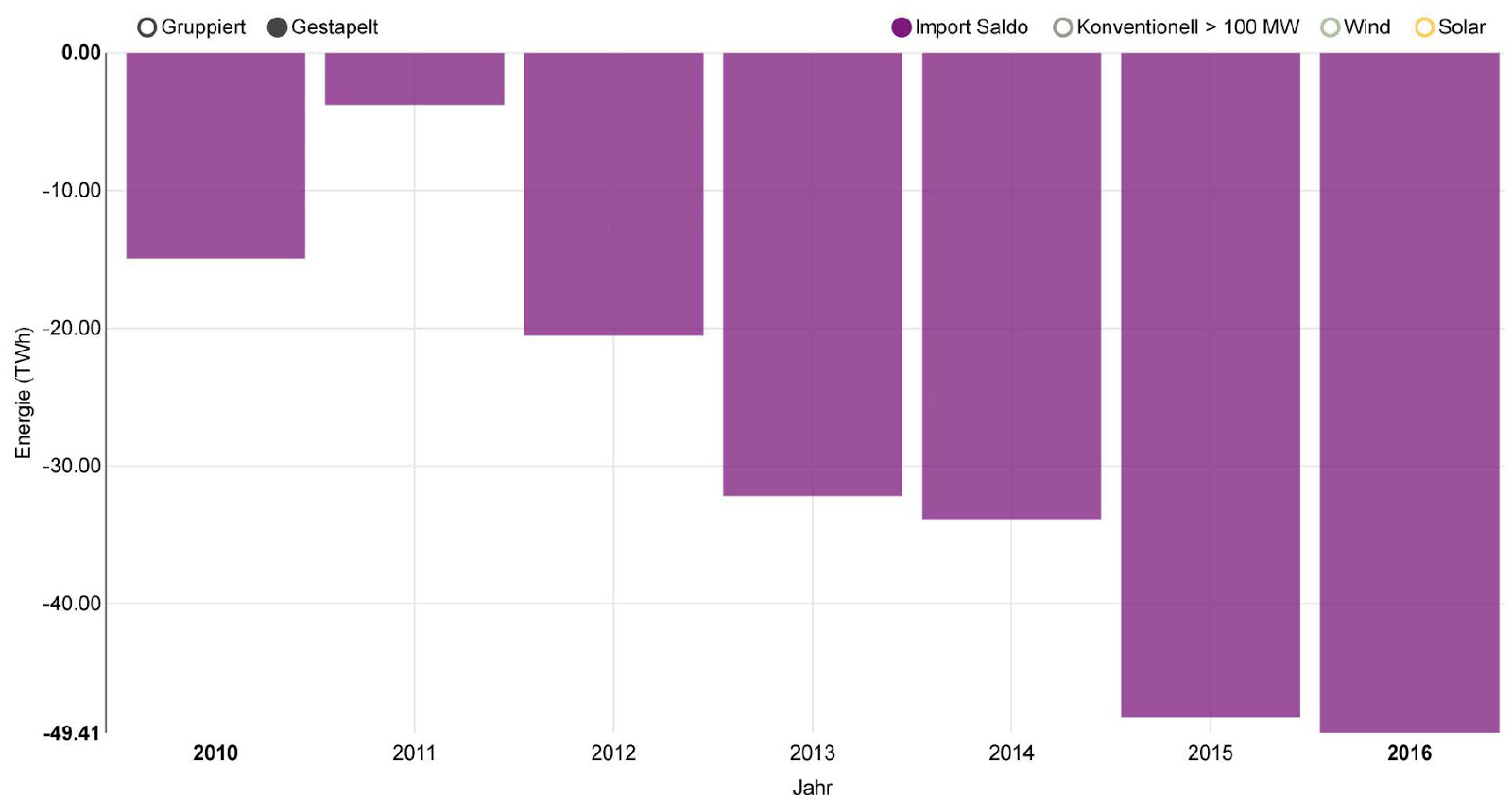

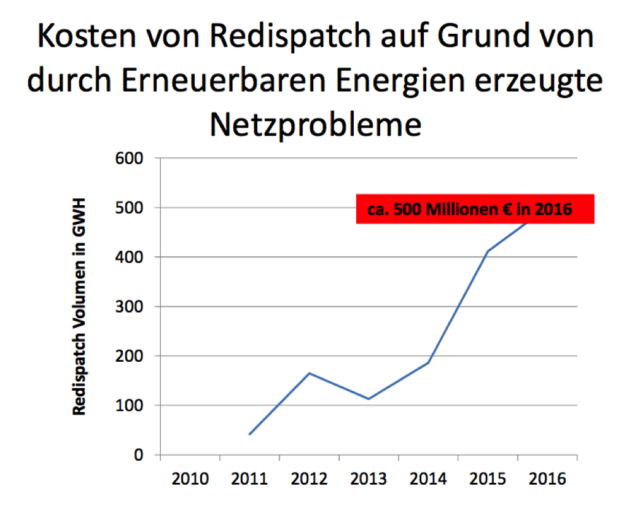

„Im Jahr 2011, vor dem Atomausstieg und dem Boom der erneuerbaren Energien, mussten die Netzbetreiber einmal pro Tag eingreifen. Bis 2016 stiegen die Eingriffe auf 17-mal am Tag an; 6000 Interventionen pro Jahr, mit Kosten von rund 500 Millionen“ [4]

Abbildung 3 Redispatchkosten p.a..Quelle Vortrag Prof. Dr. F. Vahrenholt House of Commons am 17. Januar 2017

Dass diese Redispatchmaßnahmen nicht ewig einen großen Blackout vermeiden können, ist jedem, der sich ein wenig damit beschäftigt, völlig klar. Es geht nicht mehr um das Ob, sondern allein um das Wann! Und wenn er kommt, dann sind seine Folgen gravierend. Auf 600 Mio € pro Stunde werden die Kosten eines bundesweiten Blackouts von Fachleuten geschätzt. Von den zahllosen Tragödien durch Verkehrsunfälle wg. blinder Ampeln oder Signale, oder der Nichtversorgung allein von 60.000 Dialyse Patienten mal ganz abgesehen. Wer sich ein Bild davon machen möchte, dem sei die Lektüre des Thrillers von Marc Elsberg „Blackout“ anempfohlen. Nichts für schwache Nerven, weil streng an den Ergebnissen einer zeitgleich erstellten Studie im Auftrag des Deutschen Bundestages orientiert. Die Story ist erfunden, die sich entwickelnden Zustände auf Grund der Faktenlage jedoch nicht

Intelligent

Stattdessen verlagert die Ministerin das Problem der unvermeidlich zunehmenden Instabilität auf den Verbraucher und schwärmt ihm von „intelligenten“ Stromzählern vor. Die bleiben zwar nach gängiger Intelligenzdefinition dumm wie Brot, auch wenn ein eingebauter Chip es gestattet, den vom Zähler überwachten Stromkreis vom Netz zu trennen oder zuzuschalten.

Über „steuerbare Verbrauchseinrichtungen“ wie es euphemistisch im Text weiter heißt.

D.h im Klartext, dass jede „steuerbare Verbrauchseinrichtung“ und die nötigen Gesetze dafür werden bald folgen, also auch ein ganzer Haushalt, eine Fabrik, eine Geflügelzucht oder ein Altenheim eine „steuerbare Verbrauchseinrichtung“ ist, die je nach anfallender Strommenge zu- oder abgeschaltet werden können.

Unter anderen bereiten die Stadtwerke Bielefeld ihre Kunden gerade auf diese Situation vor. Wie man sehr schön beim wdr nachlesen kann.

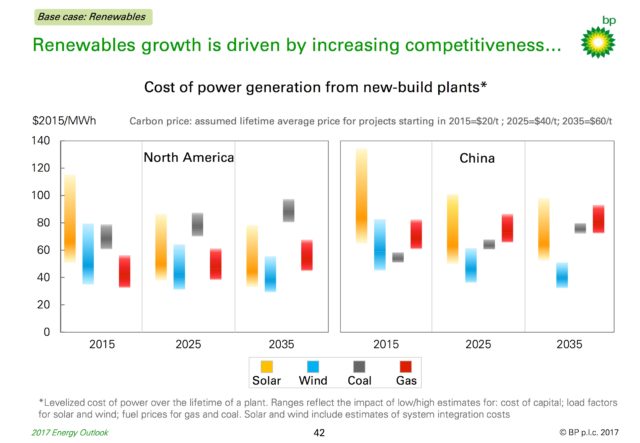

Wettbewerbsfähig; Weltweit wegweisend

Wettbewerbsfähig

Man muss schon völlig blind, dazu noch dumm oder gar böswillig sein – oder alles zusammen- um den noch immer nicht ganz abgeschlossenen rapiden Niedergang der hochsubventionierten Solarindustrie nicht nur nicht zu sehen, sondern auch noch für die hochsubventionierten „EE“- Industrien den Begriff „wettbewerbsfähig“ zu verwenden.

Jede Subvention lässt sich allerdings von einer noch größeren übertrumpfen. Deswegen gilt, solange die Subventionen weiter auf so hohem Niveau bleiben und sie nicht durch ein anderes Land z.B. China, wie bei der Solarindustrie exemplarisch gezeigt, übertrumpft werden, können diese Industrien hierzulande bestehen.

Aber nicht vergessen: Allein durch die EEG Umlage werden diese Arbeitsplätze mit rd. 100.000 € pro Jahr subventioniert. Jedenfalls dann, wenn man die in der offiziellen Statistikreichlich reichlich enthaltenen Schattenarbeitsplätze hinzuzählt. Nach unseren Erhebungen sind es deutlich weniger Jobs, nämlich max. 80.000! Und dann erhöht sich deren EEG Umlagen-Subvention auf rd. 250.000 €/Job und Jahr.

Weltweit wegweisend

Den Schlusspunkt bildet die Behauptung: Die Energiewende sei weltweit wegweisend.

Sie könnte ebenso gut aus dem Zentralorgan der SED dem Neuen Deutschland unseliger DDR Zeiten stammen, verdreht sie doch die Fakten solange, bis sie passen. Festgemacht wird diese Behauptung an einer Statistik der Internationalen Energie Agentur (hier hinter Zahlschranke) in der behauptet wird, dass die Investitionen in Erneuerbare mehr als doppelt so hoch waren wie in fossile Energieträger. Nämlich 288 Mrd $US zu 111 Mrd $ US.

Nun, traue keiner Statistik, die Du nicht selbst gefälscht hast.

Zunächst fällt auf, dass die Investitionen in Kernenergie bei dieser Darstellung außen vor geblieben sind. Mit Kosten von rd. 3500 $US/MW (in China) und 60 KKW in Planung oder Bau mit einer Leistung von ca. 60-70 GW dürfte deren Anteil etwa bei 10 bis 20 % der Gesamtkosten von rd. 227 Mrd $US also ca. 22,7 bis 45,2 Mrd $US liegen. Dies sind den konventionellen Kraftwerksinvestitionen hinzuzuzählen. Damit wären wir bei ca. 140 Mrd. $US

Doch auch bei den Investitionen in Wasserkraft wurde getrickst, denn es wurden nur Kleinanlagen bis max. 50 MW berücksichtigt. Nimmt man diese Kleinanlagen heraus (denn Wasserkraft ist in Deutschland gesättigt, eine Steigerung nicht mehr möglich) bleiben für EE Investitionen rd. 210 Mrd $US übrig.

Insgesamt wurden aber weltweit über 33 GW [5]aus neuen Wasserkraftwerken in 33 Ländern installiert, gegenüber rd. 110 GW in Wind + Solar. Die erscheinen in dieser Statistik aber nicht.

Doch die sind nicht 1:1 mit den kontinuierlich bedarfsgesteuerten konventionellen oder Wasserkraft-Anlagen vergleichbar.

Rechnet man nämlich deren geringen Nutzungsgrad ein, bei Wind ca. 20 %, bei Solar bestenfalls 10-15 %, dann bleiben von den in 2015 hinzugekommenen 110 GW gerade mal 20 GWeff. übrig. (Bei 63 GW Wind und 50 GW PV) [6]. Für stolze 210 Mrd $US.

Der Hauptgrund dafür, dass sich die Investitionen in „Erneuerbare“ trotzdem rechnen ist, dass von 160 Ländern, die diese Stromerzeugung mit Höchstsummen fördern allein 108[7] diesem Strom Vorrang einräumen. Die Renditen der Investoren also staatlich garantiert sind.

Fazit:

Es wird sich lohnen diesen Bericht, in bester planwirtschaftlicher Übererfüllungseuphorie geschrieben, die kommenden Jahre aufzuheben. Es ist ein Zeitzeugnis der Verdummung, der Verblendung und der Hybris, wie man es sonst nur gelegentlich in der Hinterlassenschaft von größenwahnsinnigen Ideologen findet.

Dass er aber gleichzeitig den Gemütszustand einer ganzen Regierung, und ganzer Parlamente, auf regionaler wie Bundesebene zeigt, ist die eigentliche Schreckensbotschaft. Hoffentlich dient er dereinst mal – in einem parlamentarischen Untersuchungsausschuss- als Beleg für kriminelles Regierungshandeln.

Wenn also die Energiewende überhaupt eine Weg weist, dann den in den ökonomischen wie politischen Abgrund.

Und das Ausland sieht es genauso. Nicht ein einziges Land auf der Welt folgt in seiner Konsequenz Deutschland auf seinem Irrweg.

Hatte doch Genossin Zypries ehemaliger Chef, der damalige Wirtschaftsminister Gabriel kurz und bündig aber korrekt festgestellt_

„Für die meisten anderen Länder in Europa sind wir sowieso Bekloppte.“

[1] http://www.n-tv.de/politik/Nichts-verheimlicht-nicht-alles-erzaehlt-article10631536.html

[2] Siegmar Gabriel in Kassel am 17. 4. 2014 vor Vertretern aus Nordhessen (SMA- Managern, SPD- Spitzen uva…

[3] http://www.focus.de/immobilien/energiesparen/strom-ratgeber/netzentgelte-und-oekoumlage-strompreise-steigen-zum-jahreswechsel_id_6037816.html

[4] Zitat aus dem Vortrag Deutschlands Energiewende – ein sich anbahnendes Desaster von Prof. Dr. Fritz Vahrenholt Dieser Vortrag wurde am 17. Januar 2017 im House of Commons, London, gehalten.

[5] chrome-extension://oemmndcbldboiebfnladdacbdfmadadm/https://www.hydropower.org/sites/default/files/publications-docs/2016%20Hydropower%20Status%20Report_1.pdf

[6] Quelle RENEWABLE ENERGY INDICATORS 2015 Seite 19, http://www.ren21.net/wp-content/uploads/2016/06/GSR_2016_Full_Report.pdf

[7] Quelle: Quelle http://www.ren21.net/wp-content/uploads/2015/06/GSR2015_KeyFindings_lowres.pdf S. 7 und 9