Hier der Link: WUWT; Andy May, Oil – will we run out?

In den vergangenen sechs Jahren hatte ich dank Anthony Watts das Glück, Beiträge für Watts Up With That zu schreiben. Viele meiner Beiträge behandelten Fragen im Zusammenhang mit der Ölproduktion und jeder dieser Beiträge triggert in der Regel Kommentare von Befürworter der abiotischen Erdöl Entstehung. In diesem Beitrag will ich erklären, warum die Hypothese der abiotischen Erdöl Entstehung nicht weithin akzeptiert ist, und warum die meisten denken, dass die ursprüngliche Quelle von Rohöl organische Substanz ist.

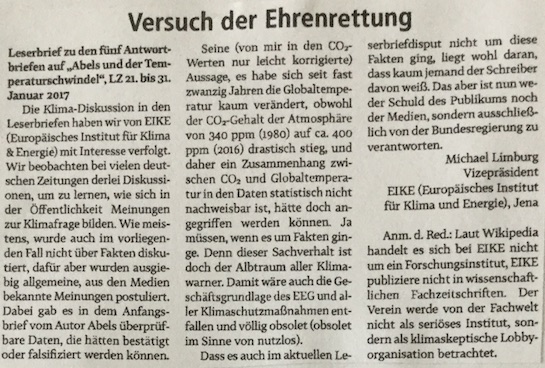

Es ist möglich, dass sich Öl die ganze Zeit im Erdmantel [neu] bildet. Die chemischen Gleichungen können ausgeglichen werden. Ich werde also den Anhängern der abiotischen Erdöl Entstehung eindeutig sagen, dass ihre bevorzugte Hypothese nicht unmöglich ist.

Biogenetisch vs abiogenetisch ist ein wirklich schlechter Weg, um das Problem zu charakterisieren. Es bedeutet, dass die Bildung von Rohöl entweder ein biologischer oder nicht-biologischer Prozess ist. Der Prozess ist thermogen. Das ursprüngliche Ausgangsmaterial gilt als organischen Ursprungs, weil alle Beweise dies unterstützen.

Allgemein akzeptierte Theorie für die Bildung von Kohlenwasserstoffen

Ich werde nicht ins Detail gehen. OffshoreEngineering.com beschreibt die Grundlagen sehr gut.

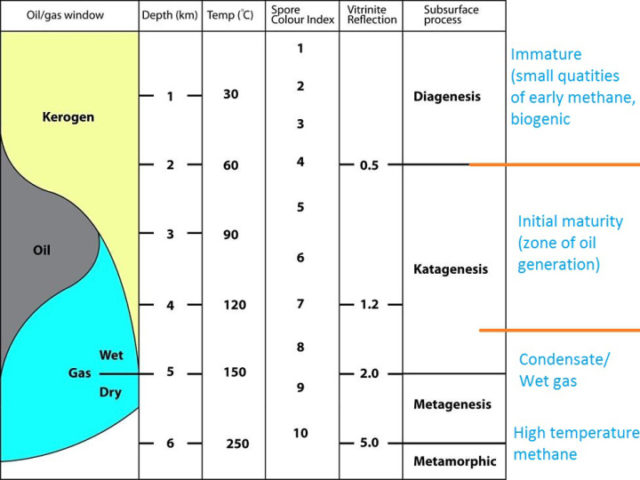

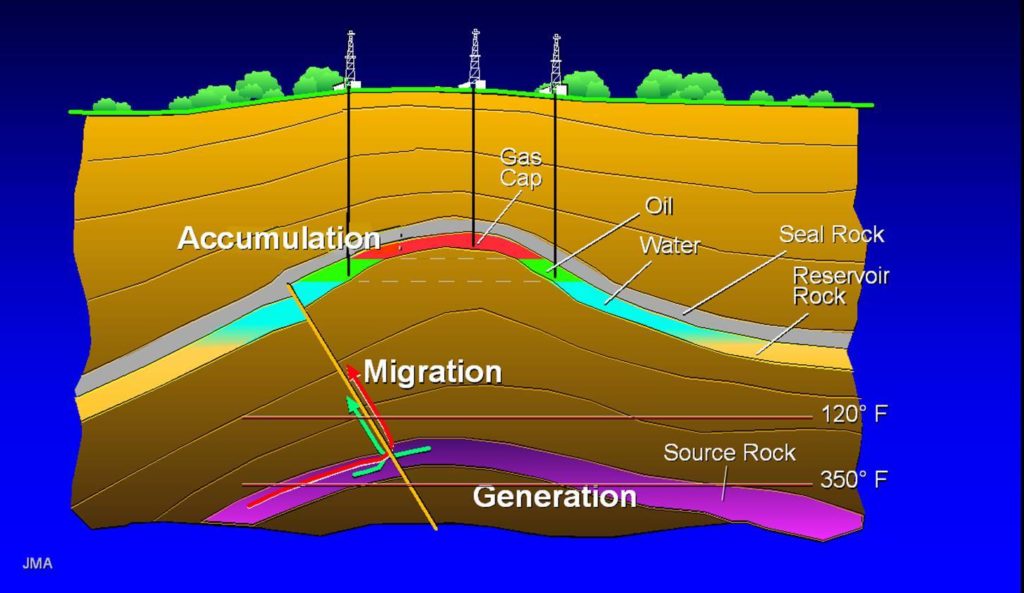

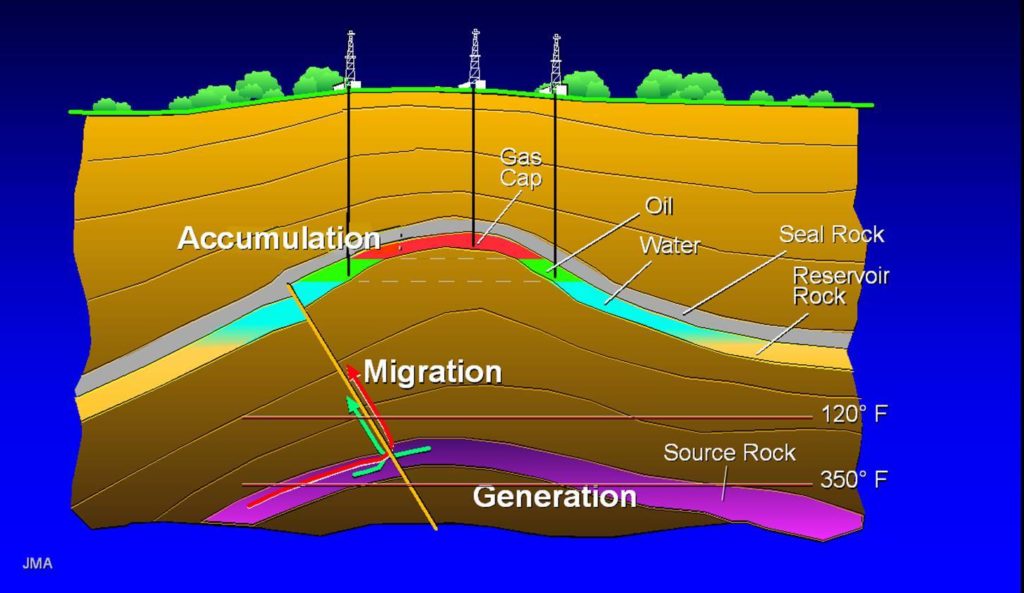

Die grundlegenden Schritte sind:

- Algen, Plankton und andere Meeres- und See-Photosynthese nutzenden Lebewesen sterben und sinken bis zum Grund des Ozeans. [… and lacustrine photosynthesizers die …; ich bin mir nicht ganz sicher mit der Übersetzung]

- Sie werden im Schlamm unter anoxischen [sauerstofffreien] Bedingungen begraben.

- Weitere Sediment Ablagerung begräbt sie immer tiefer.

- Der geothermische Gradient erhöht allmählich die Temperatur der begrabenen Lebewesen.

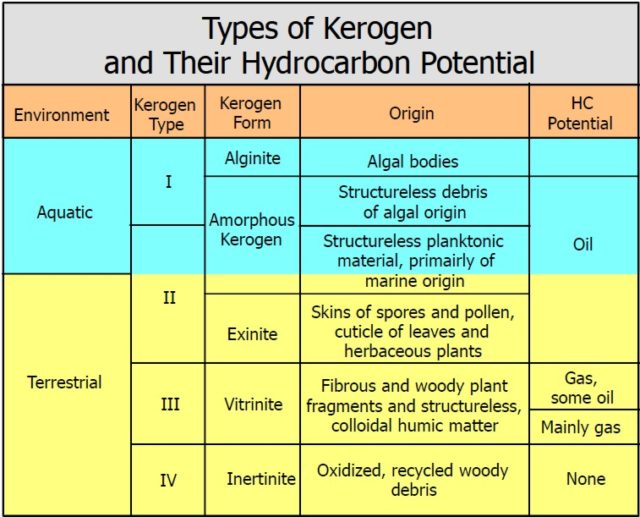

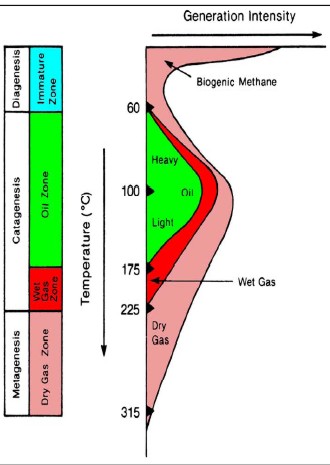

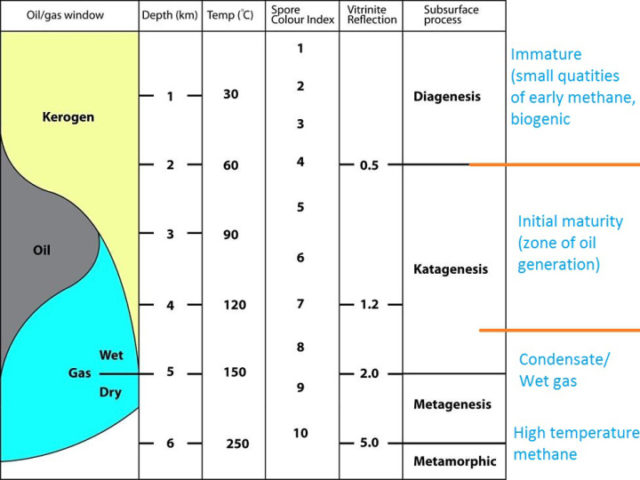

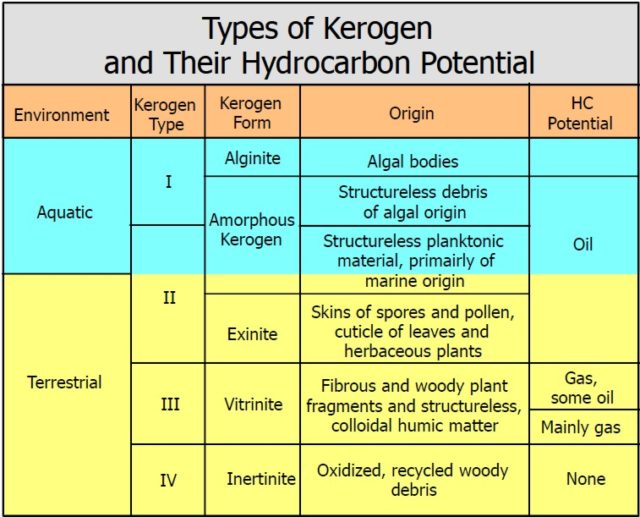

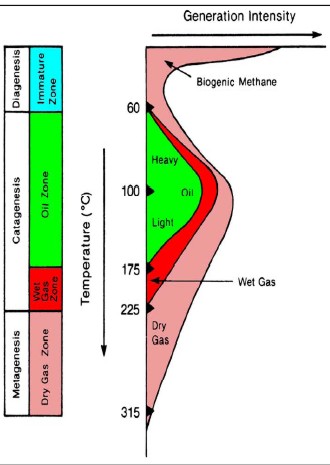

- Diagenese und Katagenese führen zur Bildung von Kerogen, dann Öl, dann Wet Gas [„feuchtes“ Gas mit einem geringen Fluidanteil].

- Metagenese führt zur Bildung von trockenem Gas und dann Hochtemperatur-Methan.

1-Die Tiefenskala ist verallgemeinert. Es kann sehr variieren, je nach Art der Überlagerung.

http://www.offshoreengineering.com/oil-and-gas/petroleum-geology/1-hydrocarbon-formation

Jede Phase kann in der Natur beobachtet werden und kann unter Laborbedingungen wiederholt werden.

Öl kommt nicht von Dinosauriern oder toter Vegetation

Unabhängig von Sinclairs Öl Logo…

2- Quelle : https://upload.wikimedia.org/wikipedia/en/thumb/a/a7/Sinclair_Oil_logo.svg/1280px-Sinclair_Oil_logo.svg.png

Oder der alte Conoco-Werbespot, der eine Vibroseis-Crew [Mannschaft mit Spezialfahrzeugen, die mit Rüttelplatten den Boden erschüttern für seismologische Untersuchungen] auf der Suche nach einem vergrabenen Dinosaurier zeigte, entsprach noch nie der Theorie der Kohlenwasserstoffbildung.

Methan und andere einfache Kohlenwasserstoffe vs Rohöl

Was ist Kohlenwasserstoff?

Kohlenwasserstoff

- n. [Geologie]

Eine natürlich vorkommende organische Verbindung, die Wasserstoff und Kohlenstoff enthält. Kohlenwasserstoffe können so einfach wie Methan sein [CH4], aber viele sind hochkomplexe Moleküle und können als Gase, Flüssigkeiten oder Feststoffe auftreten. Die Moleküle können die Form von Ketten, Verzweigungsketten, Ringen oder anderen Strukturen haben. Petroleum ist ein komplexes Gemisch von Kohlenwasserstoffen. Die häufigsten Kohlenwasserstoffe sind Erdgas, Öl und Kohle.

See: asphalt, bitumen, crude oil, dry gas, field, gas-prone, generation, geochemistry, hydrocarbon kitchen, kerogen, maturity, natural gas, oil field, oil-prone, overmature, pay, play, post-mature, preservation, prospect, reservoir, retrograde condensation, secondary migration, sedimentary basin, source rock, stratigraphic trap, tar sand, wet gas

Schlumberger Oilfield Glossary

Es ist wichtig zu beachten, dass „organisch“ nicht unbedingt bedeutet „mit dem Leben verwandt“, obwohl es in der Regel so ist.

Die organische Chemie ist die Chemie-Disziplin, die sich mit der Untersuchung von Verbindungen mit Kohlenstoff befasst, die chemisch an Wasserstoff gebunden sind. Die organische Chemie umfasst die Synthese, Identifizierung, Modellierung und chemische Reaktionen solcher Verbindungen. Chemistry.About.com

Methan, Ethan und andere Alkane, Alkene, Alkine, Cycloalkane und Alkadiene sind einfache Kohlenwasserstoffe. Anorganisch gewonnenes Methan ist auf der Erde und anderswo in unserem Sonnensystem und wahrscheinlich in unserer Galaxis massiv reichlich vorhanden. Andere einfache Kohlenwasserstoffe sind auch oft mit anorganischem Methan, meist in Spurenmengen, assoziiert.

Der Saturnmond Titan, hat Meere von flüssigem Methan und es gibt Hinweise auf polyzyklische aromatische Kohlenwasserstoffe (PAK) in der Titan-Atmosphäre. PAK’s sind Schadstoffe, die natürlicherweise in Erdöl- und Kohlelagerstätten und als Folge der Verbrennung von kohlenstoffhaltigen Brennstoffen auftreten.

Die Tatsache, dass die methanhaltige Atmosphäre von Titan PAK und Spuren von schwereren Kohlenwasserstoffen erzeugen kann, hat keine Relevanz, wie sich Erdöl und Erdgasflüssigkeiten auf der Erde ausbilden. Selbst wenn es für die Erdölbildung von Bedeutung wäre, wäre es völlig irrelevant, wie sich Öl und Gas in der Erdkruste ansammeln.

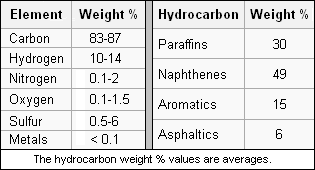

Methan und einfache Kohlenwasserstoffe sind nicht einmal entfernt mit Rohöl verwandt. Öl ist eine Mischung aus komplexen Kohlenwasserstoffen:

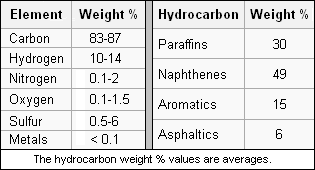

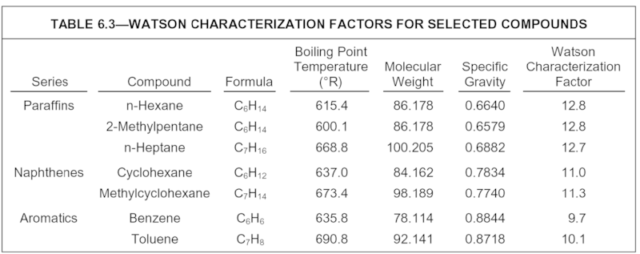

3- und 4- Petrowiki, Eigenschaften von Rohöl

Falsch zitiert als Beweis für abiogenes Öl

Es gibt eine ziemlich normale Litanei von „Beweisen“ für Abiogenischem Öl. Ich bin sicher, dass das Folgende nicht alle fehlerhaften „Beweise“ abdeckt.

Dnjepr-Donezbecken, Ukraine

Dies ist in der Regel als Beweis für Abiogenisches Öl zitiert, weil einige Russen sagen, es gab keine Quellgesteine.

Palaeozoic source rocks in the Dniepr–Donets Basin, Ukraine

http://pg.geoscienceworld.org/content/16/4/377

Reinhard F. Sachsenhofer, Viacheslav A. Shymanovskyy, Achim Bechtel, Reinhard Gratzer, Brian Horsfield, Doris Reischenbacher

DOI: 10.1144/1354-079309-032 Published on November 2010, First Published on October 20, 2010

ArticleFiguresInfo & Metrics PDF

ABSTRACT Das Dnjepr-Donezbecken (DDB) ist eine bedeutende Erdölprovinz in Osteuropa. Um die regionale und stratigraphische Verteilung der Quellsteine für das dominant gasanfällige Erdölsystem zu verstehen, wurden 676 feinkörnige Gesteine aus 30 Bohrlöchern auf Volumenparameter (Gesamtkohlenstoff (TOC), Carbonat, Schwefel, RockEval) analysiert. Für die Makro- und Biomarker-Analyse, Pyrolyse-Gaschromatographie und kinetische Untersuchungen wurde eine Teilmenge von Proben ausgewählt. Organisch reiche Sedimente treten in unterschiedlichen Intervallen innerhalb der Beckenfüllung auf. Maximale TOC-Gehalte (5,0 ± 1,9%) treten in den Rudov-Betten auf, die mehrere zehn Meter dick sind. Die ölanfälligen Gesteine (Typ III-II-Kerogen) wurden in Basineinstellungen oberhalb einer Abweichung zwischen den unteren und oberen Visean-Abschnitten abgelagert. Während die maximalen TOC-Gehalte in den Rudov-Betten auftreten, werden hohe TOC-Gehalte im gesamten Tournais- und Viseanbereich beobachtet. Allerdings sind diese Gesteine hauptsächlich gaskondensat gefährdet. In nordwestlichen Teil der DDB kommen in serpukhovischen Intervallen hoch Öl-haltige schwarze Schiefer mit bis zu 16% TOC und Wasserstoffindexwerten bis zu 550 mgHC g -1 TOC vor. Öl-haltige untere serpukhovische und Gaskondensat-haltige Mittlere Karbon-Kohle ist weit verbreitet im südlichen und südöstlichen Teil des Beckens. Obwohl keine Ursprungsfelsen mit einem devonischen Alter festgestellt wurden, kann ihre Anwesenheit nicht ausgeschlossen werden.

http://pg.geoscienceworld.org/content/16/4/377.abstract

Das Dneiper-Done-Becken hat eindeutig identifizierbare Sedimentgesteine.

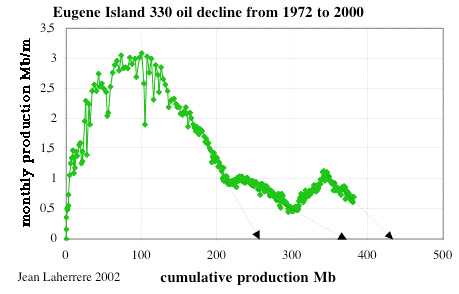

Eugene Island Feld330, Golf von Mexiko

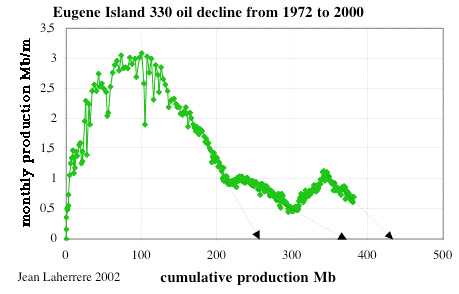

Die plötzliche, geheimnisvolle, unerklärliche Umkehr der Ergiebigkeit des Ölvorkommens für das Eugene Insel Feld 330 wurde oft als Beweis für Abiogenetisches Öl zitiert …

„Etwas Geheimnisvolles geschieht in Eugene Island 330. Die Ergiebigkeit des Ölfeldes, tief im Golf von Mexiko vor der Küste von Louisiana, sollte bereits vor Jahren zurückgegangen sein. Und für eine Weile verhielt es sich wie jedes normale Feld: Nach seiner Entdeckung in 1973 erreichte die [Ölförderung der] Eugene Insel 330 mit etwa 15.000 Barrel pro Tag (2.400 m3/d) ihren Höhepunkt. Bis 1989 verringerte sich die Produktion auf etwa 4.000 Barrel pro Tag (640 m3 / d). Dann plötzlich – einige sagen fast unerklärlich – wendete sich der Reichtum von Eugene Island. Das von PennzEnergy Co. betriebene Feld produziert mittlerweile 13.000 Barrels pro Tag (2.100 m3 / d) und die wahrscheinlichen Reserven stiegen auf über 400 Millionen Barrel von [damals] 60 Millionen.“ [5]

— Christopher Cooper, Wall Street Journal

http://interactive.wsj.com/archive/retrieve.cgi?id=SB924151147795357823.djm [hinter Bezahlschranke] Christopher Cooper, „Das merkwürdige Reservoir; Louisianas Öl-Experten suchen nach einer tieferen Bedeutung“,

Wall Street Journal, April 16, 1999

Auch in en.Wikipedia findet sich ein Bericht darüber

Zunächst, die Produktionskurve von EI 330 zeigt nichts Ungewöhnliches…

5- Monatliche vs kumulative Produktion

https://www.fromthewilderness.com/free/ww3/011205_no_free_pt2.shtml

Eugene Island 330 ist eines der größten Ölfelder im Golf von Mexiko. Allerdings, seine Produktion Kurve gibt es nichts Ungewöhnliches her. Der „Buckel“ in den späten 1990er Jahren war vor allem auf [weitere] Bohrungen zurückzuführen. Das Feld ist immer noch rückläufig. Von 1972 bis 2016 hat das Feld 452 Millionen Barrel Öl, 1,88 TCF Gas [~ 53 Billionen Kubikmeter] und 484 Millionen Barrel Salzwasser produziert. Im vergangenen Jahr betrug das Mittel etwa 11.500 BOPD, 14.400 MCFD [million cubic feet per day] und * 28.400 BSWD *[barrels of salt water per day]. Die meisten Reservoirs sind starke Wasserantriebe. Diese Arten von Reservoirs können 50% oder bessere Primärrückgewinnungen aufweisen.

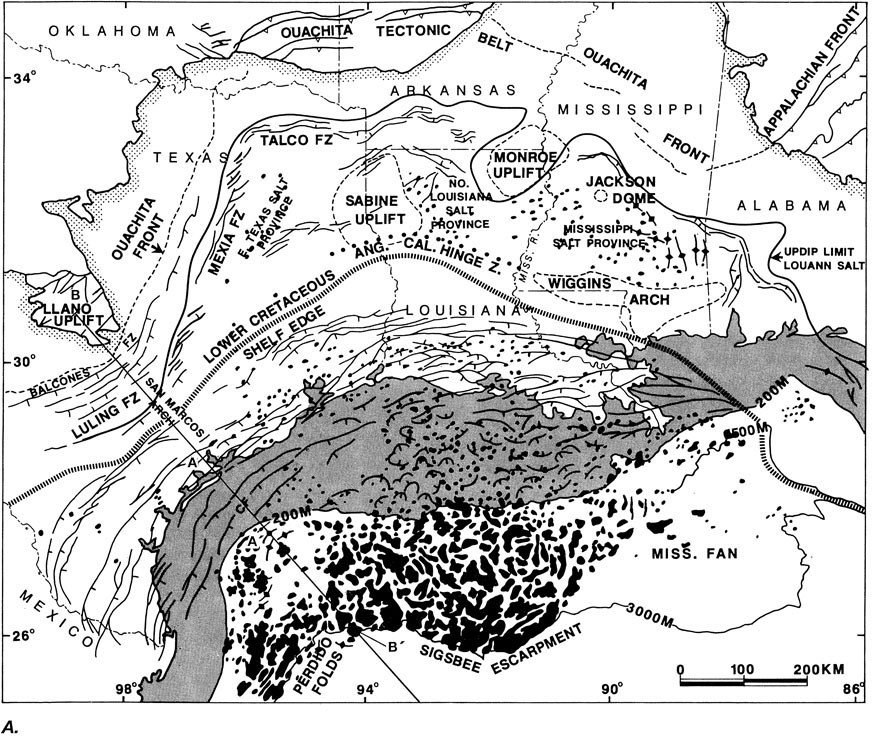

Die einzige merkwürdige Sache über EI 330 war der relativ eindeutige Beweis (4d seismisch) das Öl eine Verwerfungsebene nach oben wandert (so wie das Öl zuerst dort hinkam). Die Quellgesteine im Golf von Mexiko erzeugen noch immer Kohlenwasserstoffe, die dann noch in geologische Fallen wandern [~ in undurchlässige Schichten].

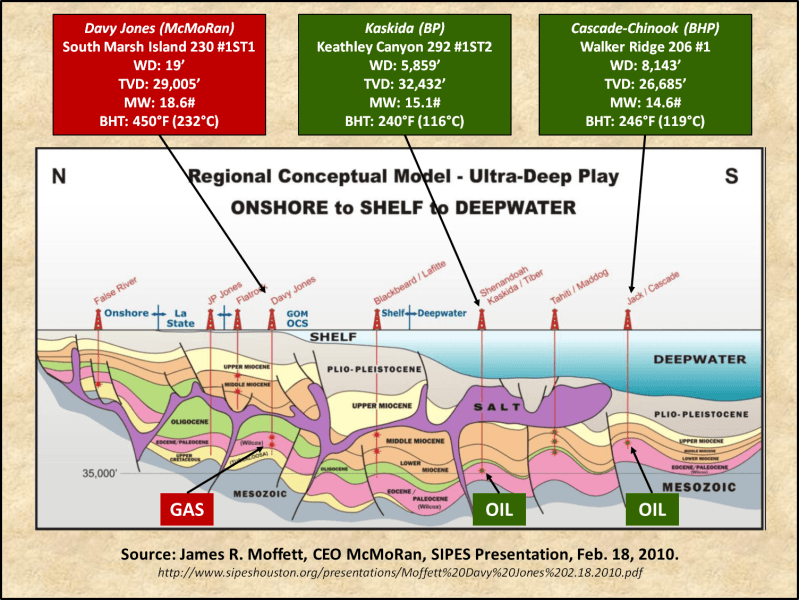

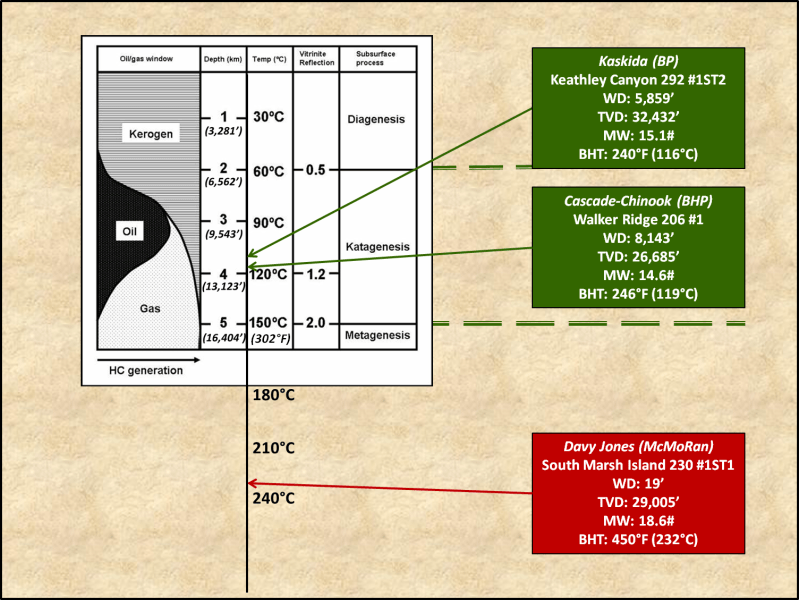

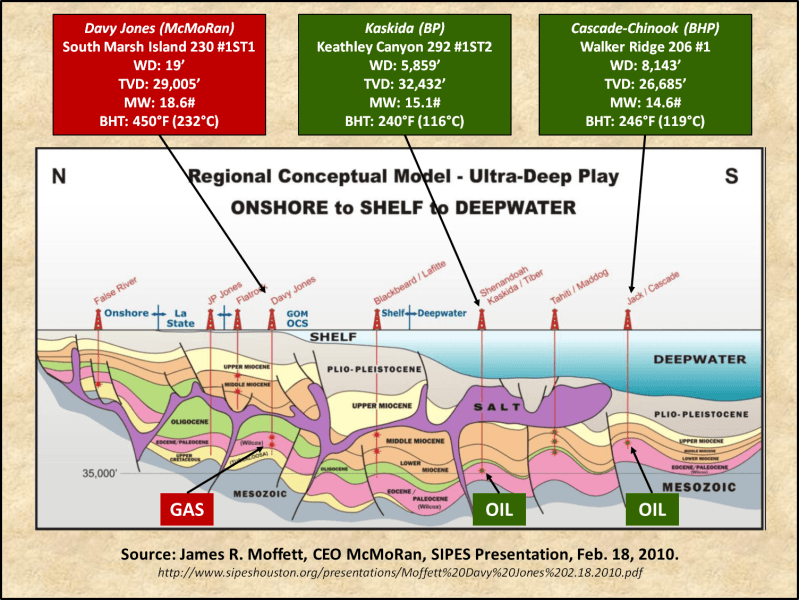

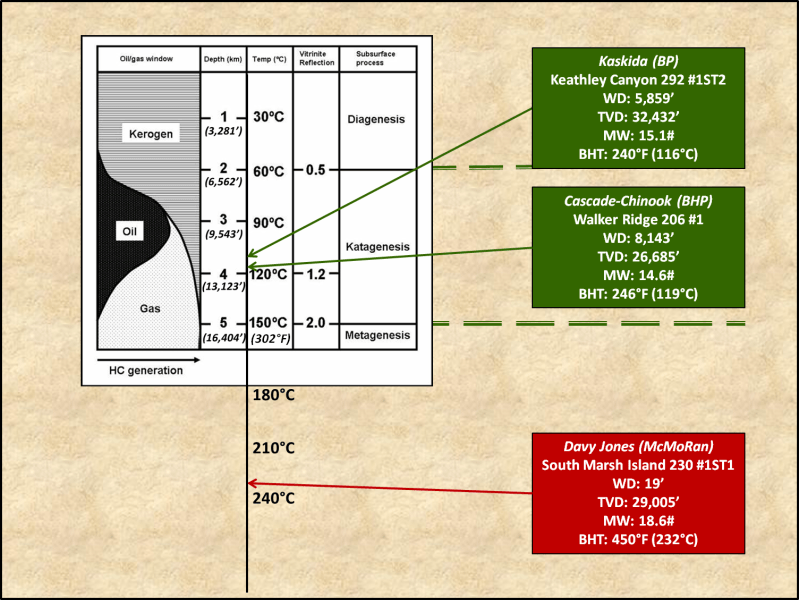

Ultratiefe Ölansammlungen sind zu tief und heiß, um im Erdöl-Fenster zu sein

[de.Wiki: Der Temperaturbereich zwischen 60 °C und 170 °C, in dem vorwiegend Erdöl entsteht, wird als Erdölfenster bezeichnet.]

Öl stammt aus organischem Material, meist Algen, die schnell im Schlamm am Boden von Ozeanen und Seen begraben wurde – So hatte es nie eine Chance zu versteinern. Druck, Wärme und Zeit verwandelten das organische Material in Kerogen, Öl und Erdgas …

6- Crain’s Petrophysical Handbook

Da die Biomasse tiefer in die Sedimentspalte eingegraben wird, wird sie durch zunehmenden Druck komprimiert, steigende Temperatur kochen es und die Kohlenwasserstoffe wandern langsam Richtung Oberfläche, weil sie weniger dicht sind als konnates Wasser [eingeschlossenes…] / Formationswasser. Das Kerogen kocht zuerst zu schwerem Öl, dann zu leichtem Öl, dann zu nassem thermogenen Gas, dann zu thermogenem leichtem Gas, dann zu Hochtemperatur-Methan …

7- Crain’s Petrophysical Handbook

Rohöl crackt bei Temperaturen oberhalb von etwa 150°C. Es kann in der Regel nicht überall in der Tiefe in der Nähe des Mantels existieren.

Das Ölfeld Jack / St Malo im Abschnitt „Walker Ridge 758 Chevron # 1“ ist die tiefste aktive Ölquelle im Golf von Mexiko; in einer Wassertiefe von ~ 2,1 km wurde bis zu einer gesamten vertikalen Tiefe (TVD) von ~8,7 km gebohrt. Es wurde in einem unteren Tertiär-Wilcox-Sandstein (8,1 km – 8,3 km) abgeschlossen. Die Bodenlochtemperatur betrug 110°C. Das Öl wanderte aus tieferen mesozoischen und unteren Tertiärquellenfelsen nach oben. Im Erdölfenster wurden sogar noch tiefere Ölreservoire entdeckt, viele davon werden in den nächsten Jahren in Erschließung gehen.

Im Golf von Mexiko gibt es keine Ölbohrungen mit Bohrungen außerhalb des Erdölfensters. Die Ultra-Tiefsee-Tertiär-Öl-Entdeckungen liegen gut im Erdölfenster. Die Flachwasser Untere Tertiärgas-Entdeckung bei Davy Jones ist weit von dem Erdölfenster entfernt, aber im Erdgasfenster …

8- WUWT

9- WUWT

Die Tiefen auf dem Diagramm sind Näherungen, die auf einem verallgemeinerten geothermischen Gradienten basieren. Der Geothermie Gradient ist stark variabel. Wasser und Halit (Salz) sind weniger dicht als die meisten Gesteine. Wenn das Deckgebäude aus ~ 2,4 km Seewasser und 600m Halit besteht, 9,1 km Überlagerungen wiegen viel weniger, als wenn es aus mehr dichten Felsen zusammengesetzt ist.

Das Ultra-Tiefwasser Untere Tertiär Treiben im Golf von Mexiko und die tiefen Subsalz-Schichten vor der Küste Brasiliens werden oft als Beispiele für abiotisches Öl genannt, weil die Reservoirs angeblich zu tief, zu heiß und / oder zu stark unter Druck gesetzt sind, um im Erdölfenster zu sein. Das ist schlicht falsch.

Tafelsalz wirkt wie ein Heizkörper. Es leitet Wärme von dem Substrat zur Oberfläche. Die Kombination von dicken Schichten von Salz und tiefen Wassertiefen ermöglicht es Öl in vorher unerwarteten Tiefen zu existieren. Salz und Wasser sind auch weniger dicht als der meiste andere Abraum. Dies ermöglicht, dass „reservoir quality rocks“ [Reservoir-Qualitätsfelsen (?)] in tieferen Tiefen existieren als zuvor erwartet.

Ich habe Brunnen gebohrt im Golf von Mexiko, tiefer als 6 km. Die Bodenlochtemperaturen lagen im Bereich von 100 ° C. Zehn Brunnen im Golf von Mexiko, gebohrt zu vertikalen Tiefen von mehr als 6 km, haben jeweils mehr als 20 Millionen Barrel Öl produziert. Die maximale Bodenlochtemperatur (100°C) wurde in der Bohrung des Mississippi Canyon (MC) 777 TF001, gebohrt von BP, angetroffen. Die durchschnittliche Bodenlochtemperatur der zehn Bohrungen betrug 92°C.

Für weitere Informationen über die Geologie und Erdölsysteme des Golfs von Mexiko empfehle ich:

The Prize Beneath the Salt by Dribus, Jackson and Kapoor

Hydrocarbon Systems Analysis of the Northern Gulf of Mexico: Delineation of Hydrocarbon Migration Pathways Using Seepsand Seismic Imaging by Hood, Wnger, Gross and Harrison

Gulf of Mexico by Galloway

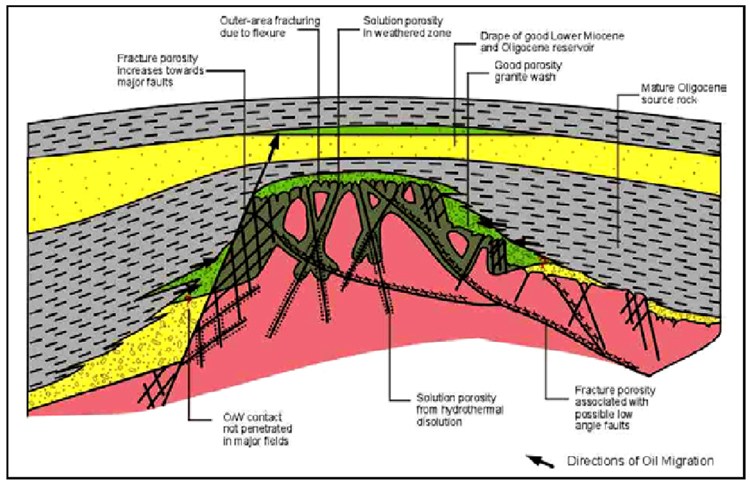

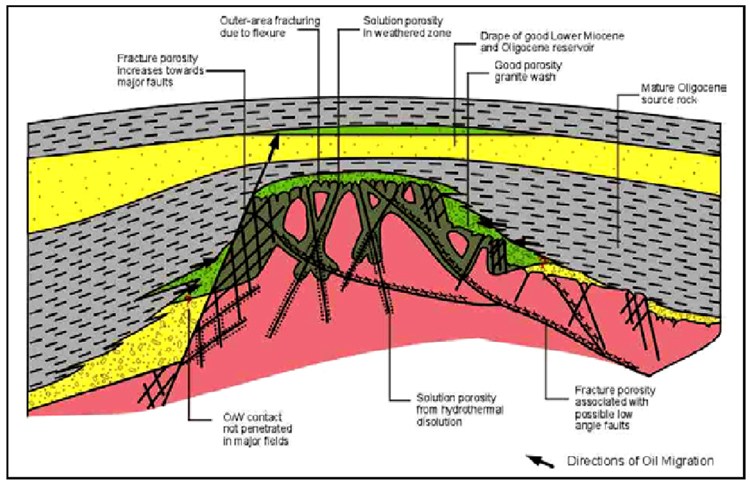

Offshore-Vietnam und andere Fractured Basement Reservoirs

Einige Ölfelder produzieren aus gebrochenen Grundfelsen, meist Granit. Das Cuu Long Becken, offshore Vietnam wird oft als Beispiel für Abiogenes Öl genannt.

10 – Petroleum Geology of Cuu Long Basin – Offshore Vietnam*

Von Nguyen Du Hung und Hung Van Le

Suchen und Entdecken: Article #10062 (2004)

* Basierend auf „extended abstract“ mit dem Titel „Hydrocarbon Geology of Cuu Long Becken – Offshore Vietnam“ für die Präsentation auf der AAPG International Conference, Barcelona, Spanien, 21-24 September 2003.

[…]

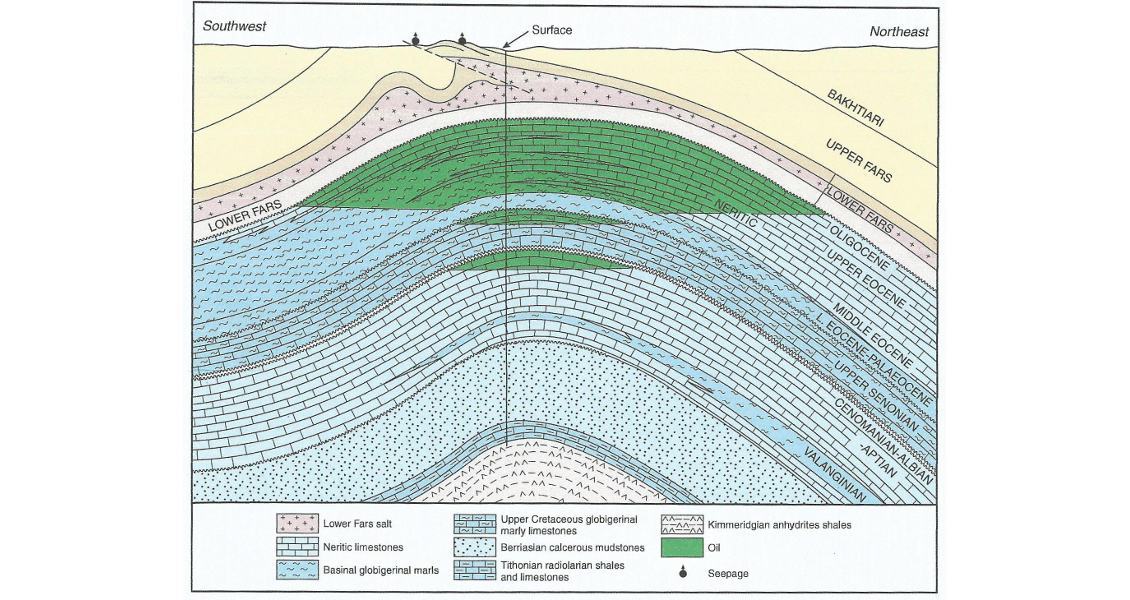

Source Rocks

[Source Rock (Quellgestein) ist die Hauptquelle, aus der Kohlenwasserstoffe erzeugt oder erzeugt werden können. Ölschiefer gilt als unreife Source Rock.]

Die effektiven Quellengesteine sind der obere Oligozänschiefer, der in dem gesamten Becken und dem unteren Oligocen eingelagerten Schiefer vorhanden ist. Sie enthalten meist Kerogen Typ I / II, die aus maritimen Sedimenten erzeugt werden. Der durchschnittliche TOC Anteil (Gesamtkohlenstoff) reicht von mehr als 1% bis zu fast 10%; Der Wasserstoffindex reicht von 300 bis mehr als 600 mg / g TOC (Abbildung 5).

Fractured Basement Reservoir

Zerklüftete Grundreservoirs sind die einzigartigen Merkmale des Cuu Long Beckens, obwohl es noch andere Ölfunde in Trümmer- und Vulkangesteinen gibt. Die ersten Erdölfunde im Boden wurden von Vietsopetro im Jahre 1988 auf dem Gebiet von Bach Ho gemacht. Das Öl wurde in Makrofrakturen, Mikrofrakturen und „vuggy pores“ gelagert [~ kleine Poren – Ein kleiner Hohlraum in einem Fels oder einer Vene, oft mit einem Mineralfutter von unterschiedlicher Komposition aus dem umliegenden Felsen.] Die Matrixporosität des magmatischen Körpers ist vernachlässigbar. Frakturen im Grund können aus einer oder einer Kombination folgender Faktoren entstehen:

1) Der Kühlung des magmatischen Körpers

2) Tektonische Aktivität

3) Hydrothermale Prozesse

4) Verwitterung und Abblättern.

AAPG Search and Discovery

[Die American Association of Petroleum Geologists (AAPG) ist eine internationale wissenschaftliche Gesellschaft mit dem Schwerpunkt Erdölgeologie]

Organische Marker im Öl entsprechen dem Kerogen im Oligozänschiefer. Für die „abiotische Theorie“ müsste das Öl aus dem Granit wandern, das organische Material aus dem Schiefer auswaschen und dann wieder in den Granit zurück wandern.

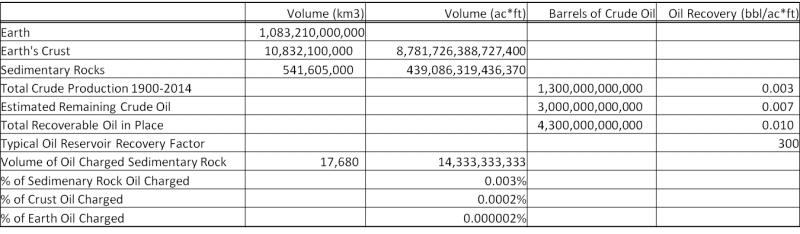

Es gibt nicht genug organische Materie, die in den Ozeanen versunken ist, um das gesamte Öl zu erklären

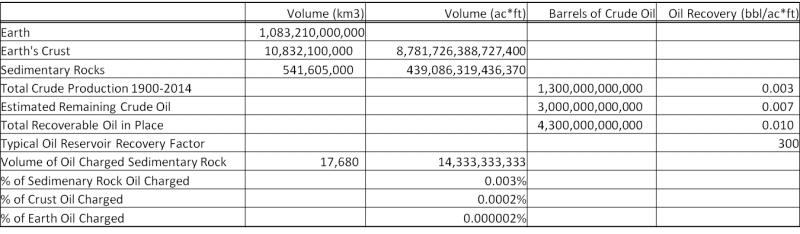

Hier ist die Berechnung:

11-Grafik WUWT

- Die Erdkruste beträgt ~ 1% des Erdvolumens.

- Sedimentgesteine umfassen ~ 5% des Volumens der Kruste.

- Die weltweite Rohöl-Produktion seit 1900 betrug 1,3 Billionen Barrel.

- Wenn es noch 3,0 Billionen Barrel gibt, die noch zu finden und zu produzieren sind, enthalten die Sedimentgesteine durchschnittlich 0,01 Barrel aufbereitbares Rohöl pro acre*ft

[0,01 Acre-feet (ac ft) = 12,33 m³

http://www.kylesconverter.com/volume/acre–feet-to-cubic-meters ].

- Ein typisches Ölreservoir hat einen Rückgewinnungsfaktor von ~ 300 Barrel pro acre*ft.

- Das bedeutet, dass nur 0,003% der Sedimentgesteine der Erde mit Erdöl geladen sein müssten, um das Erdöl zu erklären, das jemals auf der Erde produziert werden könnte.

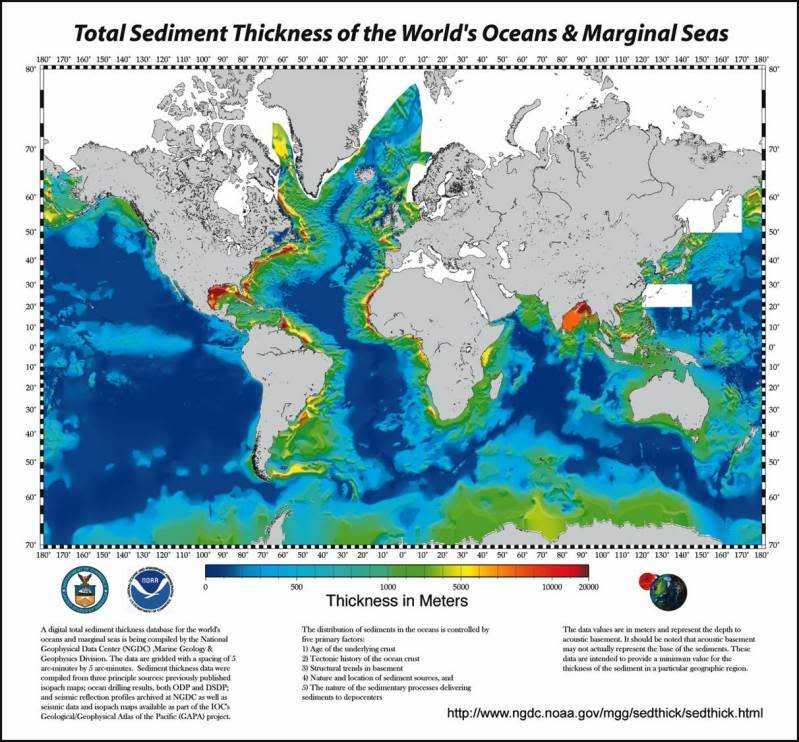

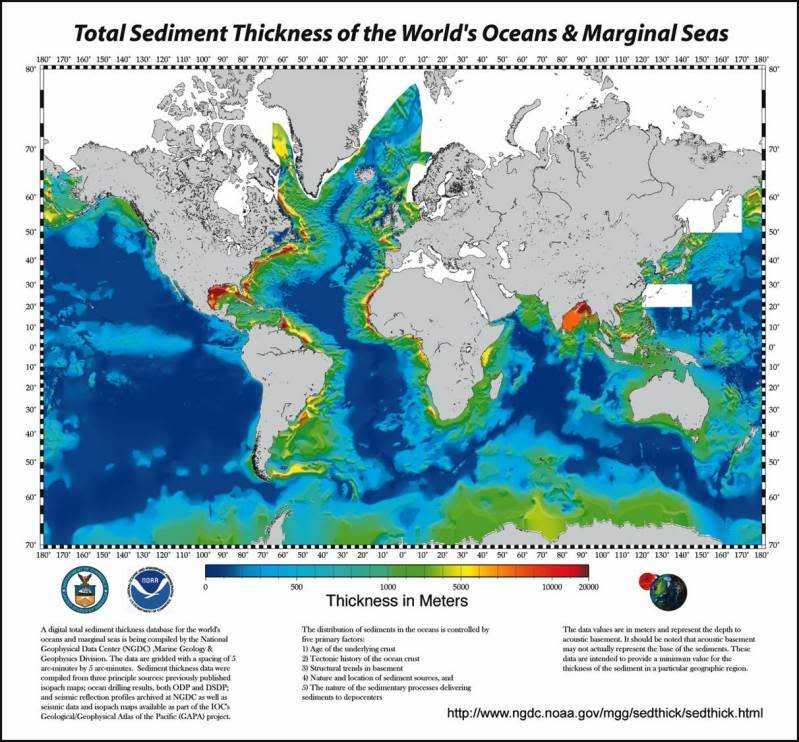

Das Volumen des organischen kohlenstoffreichen Sediments in der Erdkruste ist massiv groß. Der Golf von Mexiko hat in den letzten 200 Millionen Jahren mehr als 18,2 km Sedimentäre Säulen akkumuliert. Allein die Cenozoikum Sektion ist mehr als 12,2 km dick. Das Quartär kann an einigen Stellen mehr als 8,5 km sein. Der größte Teil der Sedimentspalte besteht aus dickem, organisch-reichem Schiefer.

Öl wird noch gebildet und wandert von der Bezugsquelle zu dem Reservoir Gestein im Golf von Mexiko. Die Pleistozän Stauseen sind weniger als 2,5 Millionen Jahre alt und viele sind nur in den letzten 275.000 Jahren gebildet worden. Die Reservoirs werden nicht so schnell geladen, wie wir sie entleeren.

12 – Rote Flächen indizieren ~20,000 Meter Sediment Dicke.

Ozeanische Sedimentäre Isopach Karte

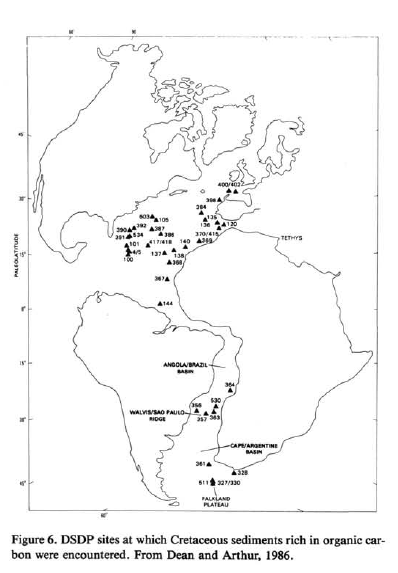

Schwarzer Meeresschiefer, die unter anoxischen Bedingungen deponiert werden, werden mit dem Material beladen, das Öl aus …

Der organische Kohlenstoff (TOC) liegt im Mittel bei 10% Gewichtsanteil

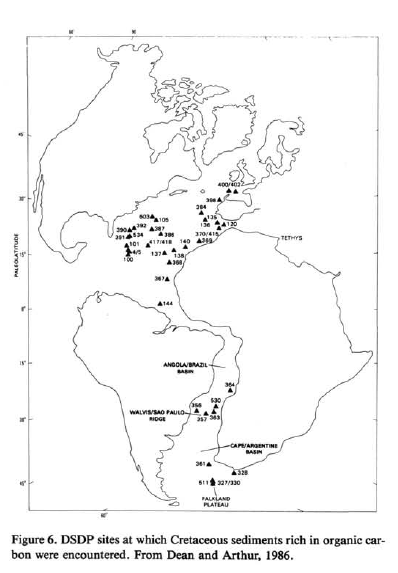

Die Kreidezeit war insbesonders eine Küche für Kohlenwasserstoff. Die Meeresbedingungen konnten für die Ablagerung von Quellgesteinen nicht günstiger sein, selbst wenn sie für einen solchen Zweck entworfen worden wären …

13- „DSDP (Deep See Drilling Projects) – Tiefsee Bohrungen, an denen kreidige Sedimente, die reich an organischer Substanz waren, angetroffen wurden. Von Dean und Arthur, 1986. “

Cretaceous Proto-Atlantic [die Kreideformationen des frühgeschichtlichen Atlantik]

Das untere Tertiäre Eozän war auch eine Kohlenwasserstoffküche (bis zu 21% TOC Anteile).

Es gibt keinen Mangel an organischer Substanz in den Sedimentbecken der Erdkruste.

Der Siljan Ring

Der Nachweis von abiogenischem Öl würde aus der Entdeckung eines bedeutenden Volumens an abiogenischem Öls bestehen.

Bisher war der nahegelegenste Nachweis eines „asphaltitischen Materials, das, was in dem Bohrstamm bei 5945 m Tiefe im Bohrloch Gravberg-1 aus dem präkambrischen Granit, Siljan, Schweden, entfernt worden war.“

„Die chemische Charakterisierung zeigte, dass dieses Material geringe Mengen an Kohlenwasserstoffen enthält, die im Dieselbereich maximieren. Es wurden keine schweren Kohlenwasserstoffe mit Ausnahme der Spuren von polycyclischen Aliphaten identifiziert. Aus den chemischen und stabilen Isotopencharakterisierungen gelangten wir zu dem Ergebnis, dass das schwarze gelatineartige Material überwiegend aus der Veränderung biologisch abbaubarer nicht toxischer Gleitmittel (BNTL – biodegradable nontoxic lubricant) durch Natronlauge, mit Dieselöl und Spuren von polycyclischen Kohlenwasserstoffen aus dem rezirkulierenden lokalen Seewasser gewonnen wird. Es konnten keine Hinweise für eine indigene [~ regionale] oder tiefe Quelle für die Kohlenwasserstoffe gefunden werden.“

https://www.onepetro.org/journal-paper/SPE-19898-PA

Leider war das „Asphalt-artige Material“ höchstwahrscheinlich aus der in dem Bohrloch verwendeten Bohrflüssigkeit abgeleitet.

Andere ungewöhnliche Argumente

Diese Argumente, angeblich aus Prof. Thomas Golds Buch, „Biosphäre in der heißen Tiefe“ zeigen eine völlige Unkenntnis der konventionellen Theorie der Kohlenwasserstoffbildung und -Akkumulation…

[Prof. Th. Gold Ϯ2004]

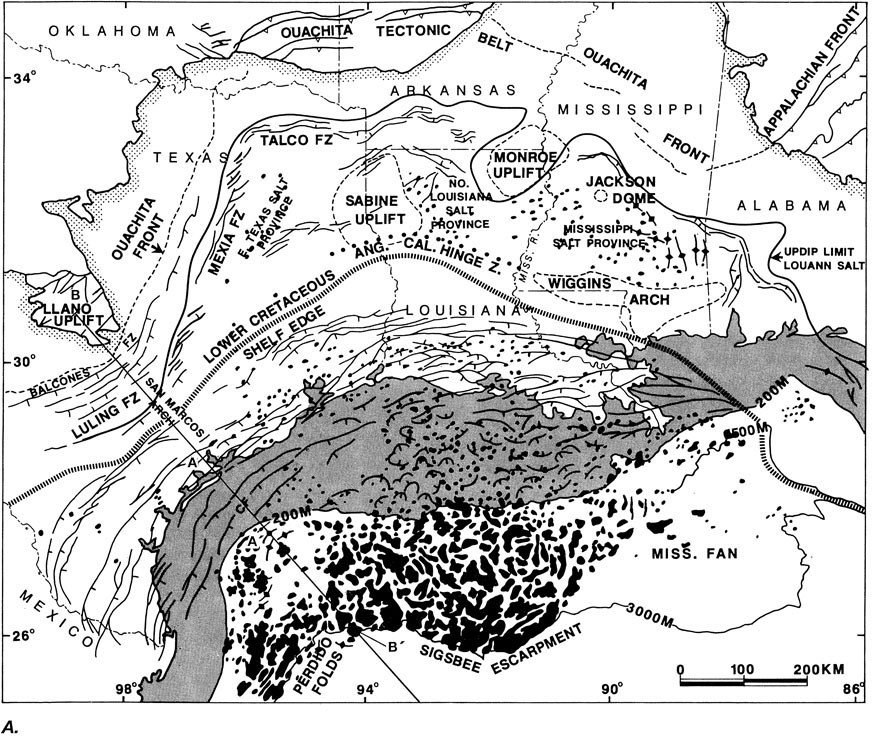

(8) Petroleum und Methan finden sich häufig in geographischen Mustern langer Linien oder Bögen, die mehr mit tiefliegenden großen strukturellen Strukturmerkmalen der Kruste zusammenhängen als mit dem kleineren Maßstab der Sedimentablagerungen.

Öl wird in der Regel durch strukturelle Merkmale eingeschlossen, häufig gewöhnliche Bruchflächen. Strukturelle Tendenzen neigen zu linearen und bogenförmigen Mustern …

14 – Die schwarzen Kleckse sind Salzkörper und die krummlinigen Liniensegmente sind Haupt Bruchlinien.

Source: U. of Idaho

(9) Kohlenwasserstoffreiche Gebiete sind auf vielen verschiedenen Ebenen kohlenwasserstoffreich, entsprechend ganz unterschiedlicher geologischer Epochen und erstrecken sich bis zu dem kristallinen Untergrund, der dem Sediment zugrunde liegt. Eine Invasion eines Bereichs durch Kohlenwasserstofffluide von unten könnte dies besser berücksichtigen als die Chance einer sukzessiven Abscheidung.

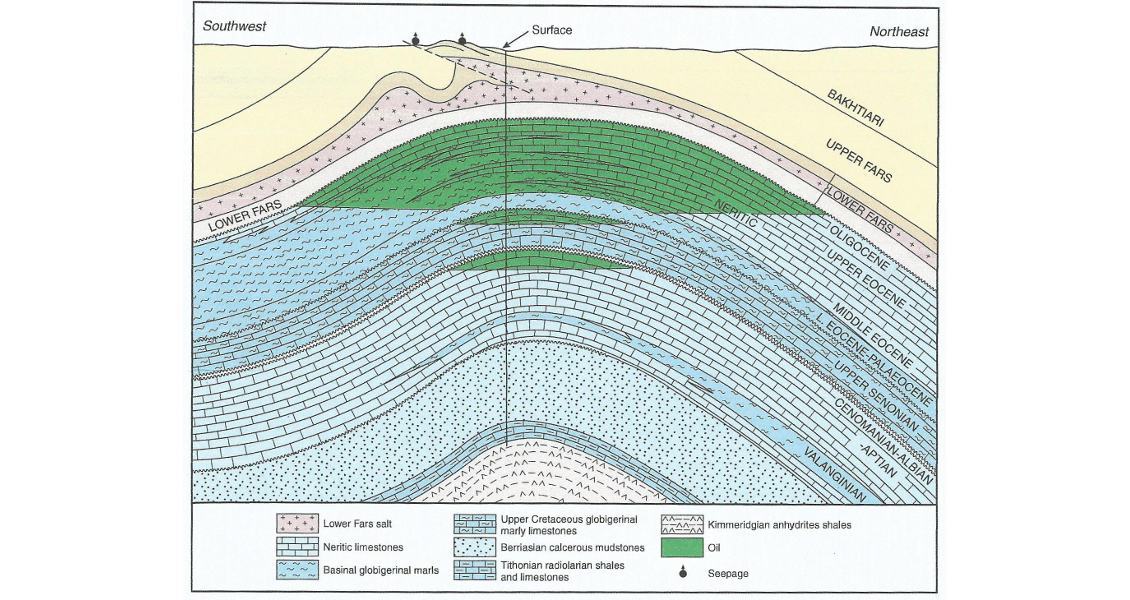

Das ist einfach nur Unwissenheit. Die konventionelle Theorie der Ölbildung und -Akkumulation besagt nicht, dass sich Öl in situ bildet. Es bildet sich in tieferen Sedimentgesteinen und wandert nach oben, um sich in strukturellen und stratigraphischen Fallen zu akkumulieren … Mit anderen Worten: „eine Invasion eines Gebietes durch Kohlenwasserstoffflüssigkeiten von unten“.

15- Petroleumsupport.com

„Kohlenwasserstoffreiche Gebiete sind in der Regel auf vielen verschiedenen Ebenen kohlenwasserstoffreich“, weil die strukturelle Verformung auf vielen Ebenen Fallen schafft und das Öl von unten in sie wandert.

16- Source assets.geoexpro.com

(10) Einigem Petroleum aus tieferen und heißeren Ebenen fehlen fast vollständig die biologischen Beweise. Die optische Aktivität und der ungerade-zahlige Kohlenstoffzahl-Effekt sind manchmal völlig fehlend und es wäre schwer zu vermuten, dass eine solche gründliche Zerstörung der biologischen Moleküle aufgetreten war, wie dies erforderlich sein würde, wobei jedoch das Schüttgut sehr ähnlich zu andere Rohölen bliebe.

Elender Unsinn.

(11) Methan findet sich an vielen Orten, wo ein biogenetischer Ursprung unwahrscheinlich ist oder wo biologische Ablagerungen unzureichend erscheinen: in großen Ozeanspalten in Abwesenheit von wesentlichen Sedimenten; In Fissuren in magmatischen und metamorphen Gesteinen, auch in großer Tiefe; In aktiven vulkanischen Gebieten, auch wenn es ein Minimum an Sedimenten gibt; Und es gibt massive Mengen an Methanhydraten (Methan-Wassereis-Kombinationen) in Permafrost- und Ozeanablagerungen, wo es zweifelhaft ist, dass eine ausreichende Menge und Verteilung von biologischem Ausgangsmaterial vorliegt.

Der Methan-Strohmann. Niemand hat gegen das anorganisch hergestellte Methan argumentiert.

(12) Die Kohlenwasserstoffablagerungen einer großen Fläche weisen häufig allgemeine chemische oder isotopische Merkmale auf, die unabhängig von der vielfältigen Zusammensetzung oder dem geologischen Alter der Formationen sind, in denen sie sich befinden. Solche chemischen Signaturen können in den Abundanzverhältnissen [dem Isotopenhäufigkeitsverhältnis] einiger kleinerer Bestandteile gesehen werden, wie Spuren von bestimmten Metallen, die Bestandteile von Petroleum ausmachen; Eine gemeinsame Tendenz kann im Verhältnis von Isotopen einiger Elemente oder im Häufigkeitsverhältnis von einigen der verschiedenen Moleküle gesehen werden, die Petroleum bilden. So konnte eine chemische Analyse einer Petroleumprobe oft die Identifizierung des allgemeinen Ursprungsgebiets ermöglichen, auch wenn in diesem Bereich ganz unterschiedliche Gebilde Erdöl erzeugen könnten. Beispielsweise kann ein Rohöl von irgendwo im Mittleren Osten von einem Öl, das aus irgendeinem Teil Südamerikas oder aus den Ölen Westafrikas stammt, unterschieden werden; Kann fast jedes der Öle aus Kalifornien von dem der anderen Regionen durch das Kohlenstoffisotopenverhältnis unterschieden werden.

Denn die Quellgesteine sind „unabhängig von der vielfältigen Zusammensetzung oder den geologischen Zeiten der Formationen, in denen“ das Öl abgegriffen worden ist.

Dieses Argument von Kenny et al. 2002 hat die konventionelle Theorie der Kohlenwasserstoffbildung, -migration und -akkumulation grundsätzlich missachtet und argumentiert dann gegen einen Strohmann ihrer eigenen Konstruktion:

„Die spontane Genese von Kohlenwasserstoffen, die natürliches Erdöl enthalten, wurde durch chemische Thermodynamik-Stabilitätstheorie analysiert. Die Einschränkungen der chemischen Entwicklung nach dem zweiten Hauptsatz der Thermodynamik werden kurz untersucht und das wirksame Verbot der Umwandlung von biologischen Molekülen in Kohlenwasserstoffmoleküle in dem für die oberflächennahe Erdkruste charakteristischen Temperatur- und Druckumwandlungsmechanismus schwerer als Methan wird berücksichtigt.“

http://www.pnas.org/content/99/17/10976.long

Die konventionelle Theorie des Kohlenwasserstoffs hat keine Ähnlichkeit mit einer „spontanen Entstehung von Kohlenwasserstoffen“, und die Energiequellen sind Wärme, Druck und chemische Reaktion, die aus Wärme und Druck resultieren.

Schlussfolgerungen

Eine mehr sinnlose Kritik an der allgemein akzeptierten Theorie der Kohlenwasserstoffbildung, ist die Vorstellung, dass unser Anhängen an einer alten Theorie uns daran hindert, abiogenes Öl zu finden. Das ist ein Quatsch. Wir suchen nicht nach Öl mit Hilfe von Theorien über die Kohlenwasserstoffbildung. Die Theorie wurde aus den Beobachtungen der Kohlenwasserstoffansammlungen entwickelt. Wenn wir ein neues Becken erforschen, suchen wir nach Gesamtölsystemen; Jedoch, wenn ich im Golf von Mexiko prospektiere, suche ich nicht nach den Quellengestein.

Geologen halten sich allgemein an Chamberlin’s Method of Multiple Working Hypotheses [… Methode der mehrfachen Arbeitshypothesen] und die meisten von uns haben einen offenen Verstand zur Abiogenetischen Ölhypothese. Die amerikanische Vereinigung der Erdöl-Geologen (AAPG) hat sogar Konferenzen zu diesem Thema veranstaltet…

Zusammenfassung

AAPG Forschungskonferenz

Herkunft von Erdöl

Juni 2005, Calgary, Alberta, Kanada

Suchen und Entdecken Artikel # 90043 (2005)

Verfasst am 26. Juli 2005

Hinweis: Punkte, denen Sternchen vorangestellt ist (*), bezeichnen erweiterte Zusammenfassungen, die meisten mit Illustrationen.

*Two Models of the Middle Devonian Petroleum System in the Volgograd Region: the Pros and Cons

by Leonid Anissimov and Stanislav Chizhov

The Complementary Roles of Kinetics and Thermodynamics in the Generation and Preservation of Oil and Gas

by Colin Barker

Origin of High Helium Concentrations in Dry Gas by Water Fractionation

by Alton A. Brown

Abiogenic Petroleum Generated by Serpentinization of Oceanic Mantellic Rocks

by J. L. Charlou, J. P. Donval, P. Jean-Baptiste, D. Levaché, Y. Fouquet, J. P. Foucher, and P. Cochonat

*The Petroleum System Paradigm and the Biogenic Origin of Oil and Gas

by Wallace G. Dow

Hydrocarbons in Deep Water: A Brief Review of Some DSDP/ODP/IODP Results

by Martin Hovland, Barry Katz, and George Claypool

*Hydrides and Anhydrides

by C. Warren Hunt

From Source to Reservoir – the Generation and Migration Process

by Barry J. Katz

*Hydrothermal Hydrocarbons

by Stanley B. Keith and Monte M. Swan

*Juvenile Petroleum Pathway: From Fluid Inclusions via Tectonic Pathways to Oil Fields

by Alexander A. Kitchka

*Petroleum: To Be Or Not To Be Abiogenic

by M. R. Mello and J. M. Moldowan

*Isotopic and Chemical Composition of Natural Gas from the Potato Hills Field, Southeastern Oklahoma: Evidence for an Abiogenic Origin?

Jeffrey Seewald and Jean Whelan

Trace Element Evidence for Major Contribution to Commercial Oils by Serpentinizing Mantle Peridotites

by Peter Szatmari, Tereza Cristina Oliveira Da Fonseca, and Norbert Fritz Miekeley

*Conceptions and Indicators of the Abiogenic Oil and Gas Origin and Its Significance

by B. M. Valyaev, S. A. Leonov, G. A. Titkov, and M. Yu. Chudetsky

http://www.searchanddiscovery.com/documents/abstracts/2005research_calgary/index.htm?q=%252Btext%253Agas

Es läuft auf zwei Dinge hinaus:

- Die konventionelle Theorie erklärt alle Beobachtungen.

- Es würde keinen Einfluss auf den Prozess der Öl-und Gas-Exploration machen.

Der Prozess der Kohlenwasserstoffbildung ist sehr organisiert, wurde in allen Stadien in der Natur beobachtet, kann in einer strengen wissenschaftlichen Theorie quantifiziert werden und kann unter Laborbedingungen weitgehend simuliert werden. Der einzige Teil des Prozesses, der nicht direkt im Laboratorium wiederholt werden kann, ist die Zeit.

Erdöl-Erzeugung durch Pyrolyse in Laborbedingungen über sechs Jahren mit simulieren Bedingungen in einem absinkenden Becken

D. SAXBY & K. W. RILEY

CSIRO Division of Fossil Fuels, PO Box 136, North Ryde, New South Wales 2113, Australia […]

Infolgedessen haben wir ein potentielles Quellenmaterial von 100 bis 400 ° C über 6 Jahre lang erhitzt und dabei die Temperatur um 1 K pro Woche erhöht. Dies erfolgte in einem Versuch, die thermische Geschichte einer Probe, die in einem kontinuierlich nachsinkenden Becken mit einem konstanten geothermischen Gradienten bedeckt wurde, zu simulieren. Nach vier Jahren wurde ein Produkt, das von einem paraffinischen Rohöl nicht unterscheidbar ist, aus einem Torbanit erzeugt [Torbanit — (Bitumenit), asphaltartige Substanz, welche zwischen verschiedenen Steinkohlenflötzen im nördlichen England in 20 u. mehr Zoll mächtigen Schichten vorkommt, ist weich, dunkelbraun; wird zur Bereitung eines vorzüglichen Leuchtgases benutzt …; universal_lexikon.deacademic.com], während eine Braunkohle eine Produktverteilung ergab, die mit einem nassen Erdgas in Zusammenhang stehen könnte. Von großer Bedeutung ist die Abwesenheit von Olefinen und Kohlenmonoxid in allen Produkten. Wir glauben, dass die gegenwärtigen Experimente, die möglicherweise so langsam wie realistisch in einer menschlichen Zeitskala geplant sind, erstmals erfolgreich die Kohlenwasserstofferzeugung in einem kontinuierlich sinkenden Sedimentbecken dupliziert haben.

http://www.nature.com/nature/journal/v308/n5955/abs/308177a0.html

Während es durch die Mantel-Serpentinisierung [ ~ Mineraliengemisch, meistens grün] oder durch das Fischer-Tropsch-Verfahren möglich ist, Öl zu bilden, gibt es einfach keinen Beweis, dass jedes Erdöl durch diese Prozesse auf der Erde jemals gebildet wurde. Wenn sich Öl in dem Mantel bildete, würde es aus den Mittelozeanrücken fließen (Methan, das aus den Mittelozean-Rippen fließt, ist kein Öl).

[der Sinn des ersten Satzteiles ist mir nicht ganz klar, daher hier auch im Original; der Übersetzer]

“There are very few crude oil accumulations that are even consistent with the abiogenic hypotheses and no significant accumulations inconsistent with the generally accepted theory of hydrocarbon formation.”

„Es gibt sehr wenige Ansammlungen von Rohöl, die sogar im Einklang mit den abiogenetischen Hypothesen stehen und keine signifikanten Ansammlungen, die mit der allgemein akzeptierten Theorie der Kohlenwasserstoffbildung nicht übereinstimmen.“

Letztendlich ist die gesamte Debatte akademisch. „Öl ist, wo Sie es finden.“ Allerdings hat es sich ursprünglich gebildet, es muss in wirtschaftlichen Ansammlungen gefunden werden. Igneous [gebildet aus Lava oder Magma] und metamorphe Gesteine sind selten porös und durchlässig … und enthalten nur selten Rohöl. Auch wenn Öl anorganisch gebräuchlich geformt wurde … Es würde nicht ändern, wie und wo Ölgesellschaften nach Öl suchen. Es muss noch in porösen und durchlässigen Reservoirs gefangen werden – Sandsteine, Kalksteine, Schiefer und andere Sedimentgesteine. Sogar das Öl, das in gebrochenen Graniten und anderen Grundgesteinen gefangen ist, musste durch Sedimentgesteine wandern und von diesen gefangen werden.

Ein Großteil des Materials in diesem Beitrag wurde übernommen von den Kommentaren von:

Peak Oil Indefinitely Postponed. (Peak-Öl endgültig verschoben)

Erschienen auf WUWT am 18.02.2017

Übersetzt durch Andreas Demmig

https://wattsupwiththat.com/2017/02/18/oil-where-did-it-come-from/

Hinweis in eigener Sache:

Geologie ist nicht mein Fachgebiet. Der eine oder andere unserer Leser mag darin bestimmt besser sein als ich. Ich habe viel recherchiert, aber gefühlte 10 Semester Fachstudium konnte ich nicht nachvollziehen, danke für ihr Verständnis.

Andreas Demmig