Rund 120 Jahren hat es gedauert, bis ein hervorragendes Stromsystem aufgebaut war. Die erste Überlandleitung für Strom wurde anläßlich der Internationalen Elektro-technischen Ausstellung 1891 in Frankfurt gelegt. Seitdem bauten Ingenieure ein Stromnetz auf, das in Sachen Zuverlässigkeit seinesgleichen suchte. So wenig Stromausfälle wie hierzulande gab es in nur wenigen anderen Ländern. Ebenso lieferte die Kraftwerksindustrie relativ preiswerte Elektroenergie. Voraussetzung für eine erfolgreiche Industrialisierung Deutschlands.

Jetzt also die Frage, wie schnell man das System wieder zerstören kann.

Einmal, indem die Preise immer stärker steigen.

In Deutschland sehen wir die »Erfolge« an ins wahnwitzige gesteigerten Strompreise. Es sind die zweithöchsten in Europa. Rund 1050 Euro kosten jene 3500 kWh, die eine dreiköpfige Familie durchschnittlich im Jahr verbraucht.

Das bedeutet: Strom wird langsam zum Luxusgut. Das merkt jeder im trauten Heim: Eine Viertelstunde Haare föhnen kostet bereits 12 Cents. Der Sonntagsbraten wird ebenso teurer.

Den größten Teil der Summe schluckt mit rund 265 Euro die sogenannte EEG-Umlage. Geld, das eine normale Familie für die sicheren Renditen von acht Prozent der Energiewenden-Gewinnler abdrückt. Die bekommen Geld sogar dann, wenn ihre Photovoltaik-oder Windanlagen keinen Strom produzieren, weil zu viel davon vorhanden ist.

Viele Ärmere können sich Strom kaum noch leisten. Zumal er im kommenden Jahr wieder teurer wird. Die EEG-Umlage steigt, wie wir gerade mitgeteilt bekamen. Nur der Bundestagswahl ist es sicherlich geschuldet, daß sie nicht in noch höhere Dimensionen steigt. Das könnte im darauffolgenden Jahr nachgeholt werden.

Insgesamt, so erregte kürzlich eine Studie des Institutes für Wettbewerbsökonomik an der Universität Düsseldorf Aufsehen, werde die »Energiewende« bis zum Jahre 2025 die unvorstellbare Summe von 520 Milliarden kosten. Das ist deutlich mehr als der Bundeshaushalt ( ca. 300 Milliarden Euro) beträgt. Eine Familie wird dann in diesem Zeitraum 25 000 Euro bezahlt haben.

Die Belastung der durchschnittlichen Haushalte ist so dramatisch gestiegen, daß die Erinnerung an die Kosten jener berühmten Kugel Eis wie Hohn klingt.

Es nützt nichts, wenn jetzt einzelne Forderungen erhoben werden, die Preise zu senken. Das bedeutet gleichzeitig: Abschied von der Energiewende. Denn die kann nur funktionieren, wenn die Betreiber der Anlagen mit Geld zugeschüttet werden. Auf einem freien Markt könnten sich diese Formen niemals behaupten.

Sonne und Wind sind nicht in der Lage, allein die Stromversorgung aufrecht zu erhalten. Dazu müssen konventionelle Großkraftwerke bereit stehen. Das bedeutet doppelte Kosten.

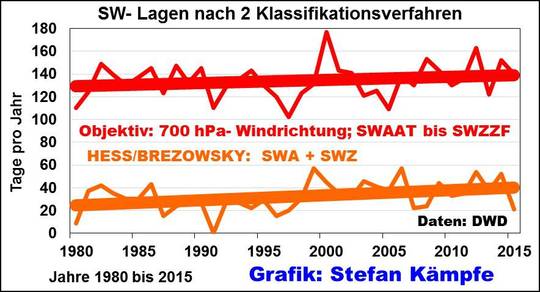

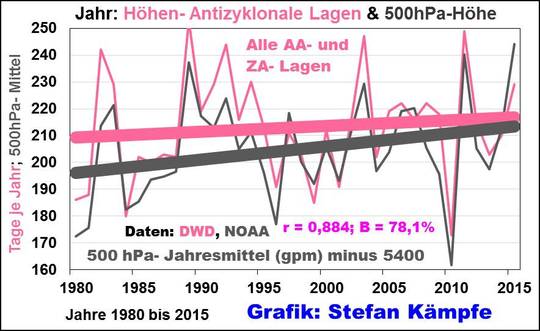

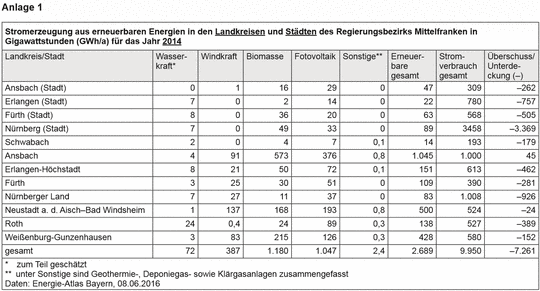

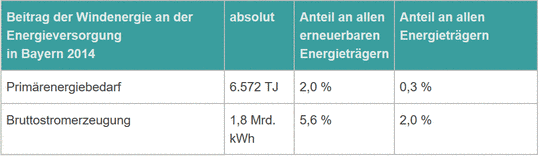

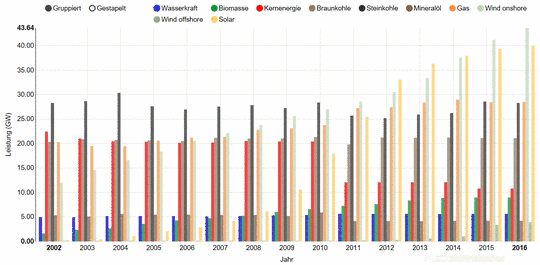

Ökostrom ist nutzlos, liefert einen lächerlich geringen Anteil, obwohl die Landschaft bereits mit Windparks zugekleistert ist. Das zeigt ein Blick auf den Stromverbrauch an einem durchschnittlichen Tag:

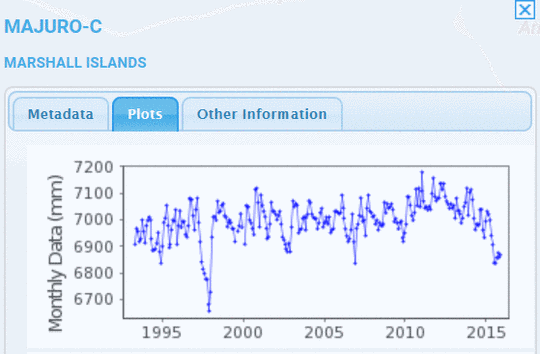

( Bild chart 8.10.)

Die großen blauen Anteile sind die Einspeisungen von Kraftwerken. Gelb ist das, was Solaranlagen zeitweise liefern. Dieser Anteil wird sich jetzt im nebligen Herbst und Winter weiter verringern. Fast mit der Lupe suchen muß man den Anteil, der von den Windanlagen kommt.

Erstaunlich, wie rund um den Erdball den Kampf gegen billige Energie geführt wird. Das scheint der neue Klassenkampf zu sein: Strom wird so verteuert, daß er zum Luxusgut mutiert.

Das gleiche Spiel sehen wir in der USA.

»Die Ärmsten tragen die Kosten der grünen Energieträume.« Das sagt in den Vereinigten Staaten William F. Shughart II. Er ist Research Director und Senior Fellow am Independent Institute im kalifornischen Oakland.

http://www.independent.org/newsroom/article.asp?id=8892

Familien mit niedrigen und mittleren Einkommen verdienen so wenig, daß sie höhere Energiepreise nicht ausgleichen können. Sie werden am meisten belastet. Die Geringverdiener tragen also die Kosten der Spielereien der grünen Spitze. Die läßt sich‘s auf dem Rücken der Armen gut gehen.

In den USA hat die berüchtigte Environmental Protection Agency EPA, die amerikanische Umweltbehörde, den Clean Power Plan erlassen, ein »historischer und wichtiger Schritt«, eine Reaktion auf den Klimawandel, wie die EPA betont.

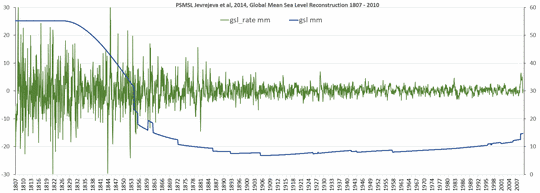

Doch Shughart und Kollegen stellen fest: Der Clean Power Plan wirke sich praktisch nicht aus. Es würde nur eine Temperaturreduktion von lediglich 0,0015 bis zum Jahr 2100 erreicht. Eine ähnliche Studie der American Coalition für Clean Coal Elektricity kommt zu dem Ergebnis, dass die Aktion gerade mal einen Effekt in der Größenordnung habe, wie »wenn sich der Meeresspiegel in der Stärke von ein bis zwei menschliche Haaren anhebe«.

Das einzige Ergebnis des Plans: Der Strom werde deutlich teurer als bisher sein, sagen die Forscher um William Shughart.

Sie werten in erstaunlicher Direktheit die Aktionen der EPA als aggressive Angriffe auf billigen Strom. Dabei werden die Eigentümer von Kohlekraftwerken gezwungen, ihre Kraftwerke zu schließen. Denn die lohnen nicht mehr.

Innerhalb eines Jahres nach der Umsetzung der Pläne würden Kraftwerkskapazitäten in der Größenordnung von 11 Gigawatt Kohleverstromung verschwinden. Das ist die Strommenge, die 2,5 Millionen Haushalte benötigen.

Dabei ist die EPA nicht die einzige staatliche Einrichtung in den USA, die preiswerte Stromquellen attackiert. Das Innenministerium will mit Hilfe einer Stream Protection Rule Kohlekraftwerken den Garaus machen.

Die merkwürdige Begründung: Die Qualität und Quantität von Oberflächenwasser solle geschützt werden. Auch das Grundwasser solle für die – na was wohl – nächsten Generationen geschützt werden. Es werden wie immer hehre Ziele ins Feld geführt; gegen die soll man schwerlich etwas sagen können.

Betroffen von diesen Regulierungen werden vor allem die Menschen in den Appalachen sein. Sie leben in den Mittelgebirgen im Osten Nordamerikas hauptsächlich vom Steinkohlebergbau und bezahlen einen dementsprechend hohen Preis, nämlich den mit Jobverlust. Das kennen wir – ähnlich wie hierzulande die Kohlearbeiter in den Braunkohlengebieten der Lausitz.

Rund 100.000 bis 300.000 Arbeitsplätze im Bergbau könnten verlorengehen. Kohle im Wert bis zu 29 Milliarden Dollar bliebe ungenutzt in der Erde, weil Bürokraten beschlossen hätten, sie dürfe nicht abgebaut werden.

Shughart und Kollegen machen die Rechnung auf: Das entspricht einem Verlust von bis zu 6,4 Milliarden Dollar an Steuereinnahmen.

»Ein sauberer und grüner Planet sind würdige Ziele«, sagen sie. Das dürfe aber nicht blind für die Kosten machen.

Umweltgesetzgebung sei Klassenkampf, da die Geringverdiener die Umweltziele der politischen Elite bezahlen müsse. »Wir müssen uns immer fragen, wen wir schaden, um unsere angeblichen »grünen« Träume zu erreichen.«

Soweit kommt uns das in Deutschland ziemlich bekannt vor.

Die EPA ist jene amerikanische Umweltbehörde, die zur Zeit auch VW zerschießt und sich auf Kosten des deutschen Autoherstellers profilieren will.

An der Spitze dieser Behörde sitzt die Regierungsbeamtin Gina McCarthy, eine studierte Anthropologin. Sie will als Hardcore Umweltkämpferin zu Ruhm und Ehre kommen. Doch geriet sie selbst unter Druck, weil sie 6000 SMS auf ihrem Diensthandy gelöscht hatte, statt sie zu archivieren, wie es eigentlich Vorschrift ist.

Die Industrie wiederum wirft der Behörde vor, Arbeitsplätze zu vernichten. Sogenannte »Umweltschützer« prügeln von der anderen Seite auf sie ein, zu weich zu sein.

Währenddessen sorgten Mitarbeiter der EPA selbst für einen deftigen Umweltskandal, als sie drei Millionen Liter kontaminiertes Wasser in einen Fluß laufen ließen. So kam ihr der VW Diesel Affäre gerade recht, um abzulenken.

Präsident Obama wollte sich einen grünen Anstrich verpassen und ließ in einer seiner letzten Amtsstreiche die USA auf den Klimawandel vorbereiten, den Kohlendioxid-Ausstoß in den USA drastisch verringern und eine Führungsrolle im Klimaschutz einnehmen. Er erklärte tatsächlich seinerzeit CO2 zum Feind.

Obama wollte im Kampf gegen diesen Feind der »Wissenschaft ihren rechtmäßigen Platz zurückgeben« und hatte dazu mit John Holdren ausgerechnet einen der führenden Panikmacher zu seinem wissenschaftlichen Chefberater berufen. Holdren ist ein bizarrer Physiker, der alles tun will, damit »Treibhausgase« reduziert werden, der auch schon mal Zwangssterilisation von Frauen, die zu viele Kinder haben, befürwortet und vor einem überbevölkerten Planeten warnt, ohne aber selbst den Anfang machen zu wollen.

Das Ganze, daran muß immer wieder erinnert werden, weil ein paar Leute die Mär in die Welt gesetzt haben, das Wohl der Menschheit hänge künftig davon ab, CO2 zu verringern. Es ist immer das gleiche Spiel: die bösen Abgase, das böse CO2 der Popanz. »Der Mensch«, der alles versaut. Wären da nicht die »Guten«, die alles retten wollen und dafür Spendengelder brauchen sowie »Staatsknete« für Umweltprojekte.

Und nein, es sind nicht nur umweltbewegte Gruppen und NGOs, die durch ihre unseligen Aktivitäten die Automobilindustrie zerstören wollen. Die Autoindustrie zerstört sich selbst.

So hatte bekanntlich VW eine Stiftung auf die Beine gestellt, mit 2,9 Milliarden an Kapital ausgestattet, um »Gutes« zu tun, zum Beispiel: »Wir stiften Wissen«.

Diese Volkswagenstiftung finanzierte jenes Apokalypsenszenario »Grenzen des Wachstums«, das der Club of Rome 1972 vorstellte. Der Fortgang der Geschichte ist bekannt.

Heute finanzieren viele Industriestiftungen Projekte, nach den am grünen Wesen die Welt genesen soll.

Die Folgen reichen mittlerweile bis in den Produktionssektor, als dort, wo noch das Geld verdient wird. Die deutsche Industrie leidet sehr unter den exorbitanten Stromkosten. Energiepreise sind ein wesentlicher Produktionsfaktor. Rainer Thiele, SPD-Abgeordneter im nordrhein-westfälischen Landtag, sieht diese Entwicklung mit erheblicher Sorge und weist auf eine Studie aus den USA (IHS) hin, die zu dem Ergebnis kommt, dass alleine von 2008 bis 2013 Deutschland bereits ca. 52 Milliarden Euro Nettoexportverluste hinnehmen musste wegen der im internationalen Vergleich stärker gestiegenen Industriestrompreise.

Thiele: »Mir bereitet die Energiewende, so wie sie gemacht wird, große Sorgen. Für unsere Metall- und Chemieindustrie ist neben bezahlbaren Strompreisen die Frage der Versorgungssicherheit mindestens genauso wichtig. Und die ist bei Wind- und Sonnenenergie noch lange nicht gegeben. Trotzdem wird ein gewaltiger Druck aufgebaut, Braunkohlekraftwerke möglichst schnell zu schließen.«

Viele Unternehmen geraten in Schwierigkeiten, weil die Energiepreise die Gewinne auffressen. Für Investitionen bleibt häufig nichts mehr übrig.

Der Vorstand der BASF in Ludwigshafen hat bereits einen Vorstandsbeschluß gefaßt, aufgrund der deutschen Energiekostenperspektive Zukunftsprojekte nicht mehr in Deutschland zu investieren.

Der Direktor der Denkschule für deutsche Energiepolitik »Agora Energiewende«, Patrick Graichen wird in »Die Zeit« vom 4.12.2014 zur Energiewende wie folgt zitiert:

»Wir haben uns geirrt bei der Energiewende. Nicht nur bei ein paar Details, sondern in einem zentralen Punkt. Die vielen neuen Windräder und Solaranlagen, die Deutschland baut, leisten nicht, was wir uns von ihnen versprochen haben. Wir hatten gehofft, dass sie die schmutzigen Kohlekraftwerke ersetzen würden, die schlimmste Quelle von Treibhausgasen. Aber das tun sie nicht.«

Ein Irrtum, den die Stromverbraucher bisher mit 20 Milliarden an Mehrkosten bezahlt haben und weiter sehr teuer bezahlen werden.

Der Vorschlag lag einmal auf dem Tisch, die Erzeuger von Sonnen- und Windstrom daraufhin zu verpflichten, daß sie nicht nur Zufallsstrom liefern können, wann es ihnen paßt – unabhängig davon, ob die Ware Strom jemand braucht oder nicht. So, wie das auf einem Markt eigentlich normal wäre.

Sie müßten – wie jeder Lieferant – auch eine Lieferverpflichtung über Menge und Lieferzeit eingehen und dafür sorgen, daß Strom dann vorhanden ist, wenn er gebraucht wird. Also nicht nur sagen: Hier habt ihr Strom, nehmt ihn, in der nächsten Minute aber haben wir keinen. Schon sähe die Bilanz ganz anders aus. Doch dieser Vorschlag wurde sehr schnell hinweggefegt.

Bleibt jetzt nur die einzige Lösung: Die zerstörerische »Energiewende« muß weg. So schnell wie möglich.

Der Haken: Es verdienen dabei mittlerweile zu viele »Kriegsgewinnler«.

Die 520 Milliarden sind erst der Anfang.