„Klimaforschung“ – eine Spielvariante der Zukunftsforschung

Was ist „Zukunftsforschung“, was kann sie leisten?

Schon zu Anfang stellte der Mensch fest, dass er in die Rhythmen der Natur eingebunden ist, sich ihnen anpassen muss! Die Stern- und Kalenderforschung standen am Anfang aller Forschung wie deren Zusammenhang mit dem jährlichen Wetterablauf und dessen Einfluss auf das Pflanzenwachstum. Die „Bauernregeln“ bis hin zum „Hundertjährigen Kalender“ seien ein Hinweis.

Wenngleich seit jeher „das Morgen“ den Menschen ob seiner Neugier interessierte, so waren seine Möglichkeiten, in die Zukunft zu schauen, eher begrenzt und beschränkten sich auf Horoskope und Wahrsagerei. Die „Zukunftsforschung“ ist neuesten Datums, konnte sich aber nicht etablieren, weil der „Zufall“ nicht berechenbar ist. Wikipedia definiert sie als die „systematische und kritische wissenschaftliche Untersuchung von Fragen möglicher zukünftiger Entwicklungen“, beschränkt auf den „technischen, wirtschaftlichen wie sozialen Bereich“. Der natürliche Bereich ist ausgeschlossen und dazu gehört zweifelsohne das Wetter. Es ist ein „Sorgenkind“, weil es sich jedweder exakten räumlichen wie zeitlichen Vorhersage entzieht und daher zu den „chaotischen Naturvorgängen“ zählt.

Die „Zukunftsforschung“ entstand im Jahr 1943 in den USA. Ihr Begründer war Ossip K. Flechtheim (1909-1998), der an Horkheimers Institut für Sozialforschung der Columbia University in New York arbeitete. Er konstruierte die „Futurologie“ als „Synthese aus Ideologie und Utopie“ und machte klar, dass kein Anspruch auf „Wissenschaftlichkeit“ erhoben wird. Dieses ehrliche Bekenntnis wurde jedoch bald Opfer politischer Hybris, die seit je „Allmachtsansprüche“ hegt und pflegt. Zum Hauptzweck wurde die Erarbeitung gesellschaftlicher wie politisch-spekulativer Trends und Zielprojektionen, um über beliebig konstruierte „Zukunftsentwürfe“ soziale Ängste wie Stimmungen erzeugen und manipulativ politisch instrumentalisieren zu können. Die Politik fand nur zu leicht willfährige Helfer in den Wissenschaften.

Von der Zukunftsforschung illegal in die „Klimaforschung“

Mit der „Futurologie“ befassten sich in Deutschland vornehmlich zwei Physiker. Wilhelm Fucks (1902-1990) beschäftigte sich unter anderem mit der zukünftigen Entwicklung der globalen Machtverhältnisse und schrieb 1965 sein berühmtes Buch „Formeln zur Macht“. Er leitete das „Institut für mathematisch-empirische Sozialforschung“ in Aachen. Karl Steinbuch (1917-2005) gilt als „Haupttheoretiker der informierten bzw. falsch programmierten Gesellschaft“. Seine Bücher waren 1966 „Die informierte Gesellschaft“, 1968 „Falsch programmiert“, 1973 „Kurskorrektur“. Von Steinbuch stammt der Satz: „Das menschliche Gehirn ist nicht geschaffen, rationale Prozesse zu veranstalten, sondern das Überleben des Organismus zu bewirken.“ Und was ist leichter, als eine heile Welt im „Klimagleichgewicht“ zu versprechen?

Die Beschäftigung mit der Zukunft erfordert eine strenge Unterscheidung zwischen tatsächlichem Wissen und Glaube, Abschätzung und Vermutung, Extrapolation und Spekulation. Schon Platon und Kant bemühten sich diesbezüglich um Differenzierung. Von Platon stammen das Liniengleichnis, das Sonnengleichnis und das Höhlengleichnis. Die Höhle versinnbildlicht die Welt. Sir Francis Bacon (1561-1626) verglich klug die Schattenbilder mit menschlichen Vorurteilen, mit irrigen Vorstellungen. Jeder Mensch habe seine eigene Höhle, die das Licht der Natur bricht und verdirbt. Das erinnert schon an die heutige „Neuropsychoanalyse“, die das „narrative Selbst“ erforscht und der Frage nachgeht, wie unbewusste neuropsychische Prozesse unser Denken, Fühlen und Handeln steuern. Man sucht nach „verborgenen Determinanten“, nach den unbewussten Prozessen, die außerhalb der willentlichen Kontrolle der Betroffenen ablaufen und unser Verhalten lenken. Wenn wir aufgrund der Hirnstruktur auch nicht selbst die unbewussten Vorgänge in uns kontrollieren können, so könnten wir mutig unseren Handlungsspielraum erweitern, indem wir uns von selbst auferlegten Denkverboten befreien. Und davon gibt es in der modernen Medienlandschaft eine Unmenge.

Jedes Verstehen setzt eine Konstruktion unseres Geistes dar und führt uns an unsere kognitive Leistungsfähigkeit bei dem Bemühen, Bedeutung und Sinn bei den ständigen Veränderungen durch äußere Einflüsse zu erfassen. Leichtfertig überlassen wir der Politik die „Konstruktion“ der Welt. Irgendwo ist jeder in Strukturen eingebunden nach dem Motto „Ich bin vernetzt, darum bin ich!“ So ein „Netz“ ist wie ein Spinnengewebe, dem nur mit ganz gewaltigen Anstrengungen zu entrinnen ist. Gelingt der Befreiungsakt, ist man sofort der Kälte sozialer Einsamkeit ausgesetzt als Strafe für nicht konformes Verhalten. „Querdenker“ droht der mediale Pranger. Der uns ständig beobachtende, uns verfolgende und über uns thronende „Zeitgeist“ ist sehr wachsam und unerbittlich. Er signalisiert uns, wenn wir im „Abseits“ stehen und pfeift uns öffentlich zurück.

Wie man eine Zukunft konstruiert und diese aus einer fiktiven Vorstellung in die reale Welt projiziert, erleben wir auf internationaler Ebene in der „Klimaforschung“, in der „Klimapolitik“ mit dem aussichtslosen Bemühen, das Klima zu schützen und damit den Klimawandel zu stoppen. Klimaexperten haben ein „mathematisches Objekt“ geschaffen, dessen Existenz erst durch seine Konstruktion begründet wird. Die „Globaltemperatur“ ist solch ein „Objekt“. Sie ist eine abgeleitete abstrakte Größe, ein Konstrukt ohne Existenz. Das Wetter ist ein realer Naturvorgang. Dagegen ist „Klima“ nicht existent und wird nur durch seine Konstruktion begründet. „Klima“ wurde vom Menschen definiert und diese Definition kann jederzeit mehrheitlich verändert werden. „Klima“ ist Menschenwerk, so gesehen „menschengemacht“. Dies lernte man in der Schule im Fach Geographie bei der Besprechung der „Klimakarten“ in den Schulatlanten. Das „Azorenhoch“ im Juli wie das „Islandtief“ sind menschengemachte statistische Scheingebilde, die keinerlei Bewegung zeigen. Sie sind ortsfest im Gegensatz zu den ständig ziehenden und vergänglichen Hoch- und Tiefdruckgebieten. Die Klimakarten sind „Dauerkarten“ im Vergleich zu den sich täglich verändernden Wetterkarten.

Neben der realen Wetterwelt mit ihren Überraschungen und Fehlprognosen ist eine „Klimawelt“ konstruiert werden, deren Existenz mit Hilfe von Computermodellen und Simulationen nur vorgetäuscht wird, die aber dennoch auf der politisch-sozialen Ebene eine starke „Wirkmacht“ auf uns ausübt, so dass viele Menschen fest daran glauben, den „Klimawandel“ spüren, sogar sehen können und sich ängstigen. Ich gehöre nicht zu den begnadeten Wesen, die den Unterschied zwischen den „Globaltemperaturen“ von 14,85°C im Jahr 2015 und der von 14,84°C im Jahr 2014 am eigenen Leib spüren.

Das „Globalklima“ ist ein abstraktes Konstrukt aus Sonnen- und Höhlengleichnis

Mit seinem „Liniengleichnis“ zeigte Platon auf, wie wir über „Abbilder“, die sinnlich wahrnehmbaren Dinge und „mathematische Konstrukte“ zu unseren Ideen gelangen. Mit dem „Sonnengleichnis“ versuchte Platon, das Gute gleichnishaft zu veranschaulichen. So wie die Sonne im Bereich des Sichtbaren als Quelle allen Lebens die alles beherrschende Macht ist, so herrscht in der geistigen Welt das „Gute“ als Quelle von Wahrheit und Wissen. Im „Höhlengleichnis“ versinnbildlicht Platon die Welt als Höhle. Schattenbilder beherrschen unsere Vorstellungen, obgleich wir längst im Weltall Raumstationen und Satelliten positioniert haben, von denen wir die Erdkugel von außerhalb der „Höhle“ direkt im Lichtkegel der Sonne sehen können.

Exemplarisch für die blinde Rückständigkeit der weltbesten Klimaexperten, die in den als Schiedsgericht fungierenden Weltklimarat IPCC der UNO entsendet wurden, sei gezeigt, wie diese die Erde sehen. Wie von Platon beschrieben, sehen sie in der finsteren Höhle die Erde auf der Projektionsfläche als dunklen kreisrunden Schatten als Scheibe mit der Fläche πr2. Sie fehlinterpretieren diese Beobachtung und sagen, dass die Erde als „Querschnittsfläche“ von der Sonne beschienen werde. Niemand erhebt Widerspruch. Dann fällt den Experten ein, dass die Erde eine Kugel ist, deren Oberfläche der 4-fachen der Kreisfläche entspricht. Nun machen sie folgende simple mathematische Berechnung. Sie nehmen die „Solarkonstante“ von S = 1368 Watt/m2 und teilen diese durch 4. Damit verteilen die Experten die auf die Erdscheibe eingestrahlte Sonnenenergie rechnerisch gleichmäßig über die Erde und erhalten eine Bestrahlung der Erdkugel von S = 342 Watt/m2. So verschwindet die frei im Weltall ihre Bahnen ziehende Erde in der kalt gerechneten „hohlen“ Sonne, die wie eine Hülle um die Erde gewickelt ist. Wer hier nicht massiv Widerspruch erhebt und den Experten glaubt, ist ihnen ausgeliefert!

Die Erde ist ein Himmelskörper, der täglich um seine eigene Achse rotiert und sich jährlich um die Sonne dreht. Im Wechsel der Tageszeiten wie der Jahreszeiten wird die Erdoberfläche unterschiedlich bestrahlt und erwärmt. Alles Leben auf der Erde richtet sich danach. Wer die Erde in eine Hohlraumsonne steckt, nimmt die Wirklichkeit nicht wahr, lebt in einer irrealen „Umwelt“. Dem Zwang ihrer Logik folgend nehmen die Klimaexperten die Stefan-Boltzmann-Gleichung S = σ T4, um die Temperatur der Erde in Kelvin (°Celsius + 273) zu berechnen. T bestimmt S und umgekehrt. Diese Gleichung wurde für einen „idealen schwarzen Körper“ entwickelt. Der „schwarze Körper“, der zugleich optimaler Empfänger wie Sender von elektromagnetischer Strahlung ist, wurde 1860 von Gustav Kirchhoff (1824-1887) als „idealisierte thermische Strahlungsquelle“ definiert. Die Idealisierung besteht darin, dass solch ein „Körper“ alle auf ihn treffenden elektromagnetischen Strahlen aller Wellenlängen vollständig absorbiert, sich optimal erwärmt. Seine eigene Wärmestrahlung emittiert er auch vollständig, wobei sie nach Intensität und spektraler Verteilung nur von seiner absoluten Temperatur abhängt. Solch ein Körper erwärmt sich schneller als alle anderen Körper, kühlt sich aber auch schneller als die anderen ab.

Da es solch einen „idealen schwarzen Körper“ in der Natur nicht gibt, ebenso wie sein Gegenteil, einen „idealen weißen Körper“, konstruierte Josef Stefan (1835-1893) eine „Kiste“, die dem Konzept des „Schwarzkörperstrahlers“ am nächsten kommt. Er baute einen geschlossenen „Hohlraum“, dessen Wände beheizt und mit Reglern auf konstante Temperaturen eingestellt werden konnten. Sodann bohrte er ein kleines Loch in eine Wand des Hohlraums und maß die austretende Strahlung. Es zeigte sich, dass die Wellenlänge der Strahlung mit der Beheizung oder Abkühlung der Wände kürzer oder länger war. Stefan entwickelte daraus eine einfache „Gesetzmäßigkeit“, die von Ludwig Boltzmann (1844-1906) theoretisch bestätigt wurde. So erhielt die Gleichung zwei „Väter“, die Stefan-Boltzmann-Gleichung. Diese Gleichung beschreibt nur den Einfluss der Strahlung auf die Temperatur eines Körpers, sonst nichts! Sie besagt, dass mit Variation der Strahlung die absolute Temperatur des Körpers mit der 4. Potenz steigt oder fällt. Das erklärt, warum die rot glühende Herdplatte bei Abschalten des Stromes so schnell schwarz wird. Ebenso schnell, wegen die Temperatur mit der 4. Potenz in die Gleichung eingeht, kühlt die rot glühende Lava eines Vulkans ab, verfestigt sich und wird schwarz. Daher sinkt zum Abend die Temperatur erst rasch und mit der Abkühlung in der Nacht immer langsamer.

Indem die Klimaexperten die Stefan-Boltzmann-Gleichung S = σ T4 zur Berechnung einer theoretischen „Strahlungsgleichgewichtstemperatur“ zwischen Sonne und Erde nehmen, zeigen sie, dass sie nicht nur selbst in der „Höhle“ Platons stecken, sondern auch die Erde in einen „Hohlraum“ einsperren, deren Temperatur man einfach regeln kann. Doch dazu bedarf es keinerlei „Treibhausgase“, keines „Treibhauseffektes“. Der Mensch wird zum „Regler“ der Natur, denn die Temperatur reagiert auf die Strahlung und bestimmt die Strahlung. Bei der Berechnung der Körpertemperatur kommt keine Atmosphäre vor. Die Berechnung gilt nur für den Fall, dass alle Strahlung auch absorbiert wird. Das geht nur im „Hohlraum“! Trotzdem bauen die Experten in die Gleichung eine „Albedo“ von 0,3 ein und reduzieren die „Solarkonstante“ um 30 Prozent.. Sie ziehen also von den 342 Watt/m2 30 Prozent ab und erhalten einen Wert S = 240 Watt/m2. Diesen Wert geben sie in die Stefan-Boltzmann-Gleichung ein und erhalten für T einen Wert von 255 Kelvin oder -18° Celsius. Wer sich auf dieses Rechenspielchen einlässt, ist dem Zwang der „Logik“ der Klimaexperten verfallen.

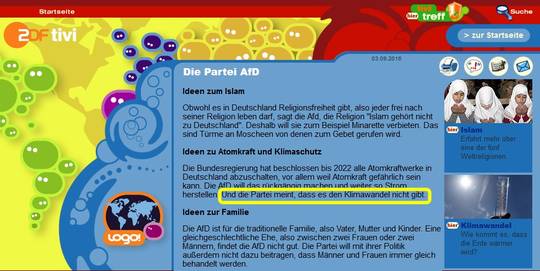

Diesen Wert von -18° Celsius deklarieren die Klimaexperten zu der „Normaltemperatur“ der Erde. Diese Temperatur sei die „Strahlungsgleichgewichtstemperatur“ einer Erde ohne „Treibhausgase“. Bei optimaler Einstrahlung der Sonne hätte die Erde nur eine Temperatur von -18°C, sie wäre eine „Eiskugel“, auf der ein Leben nicht möglich wäre. Nun wird der „natürliche Treibhauseffekt“, den es in der Natur nicht gibt und nicht geben kann, erfunden. Der theoretischen Phantasietemperatur von -18°C stellen sie eine nicht minder theoretische „Globaltemperatur“ von +15°C entgegen und erklären die Differenz von 33°C zum „natürlichen Treibhauseffekt“. Er ist der Hauptfeiler der „Klimapolitik“ und mit ihm steht und fällt das ganze Kunstgebilde. Aber die „Lüge“ wird gut kaschiert mit der Behauptung, dass es „ihm“ zu verdanken sei, dass die Erde ein „grüner Planet“ ist und eine lebenstaugliche Temperatur von +15°C hat. Dies sei dem Kohlenstoffdioxid CO2 zu verdanken. Nein! Das CO2 hat nichts mit den variierenden Lufttemperaturen zu tun. Seine lebenswichtige Bedeutung steckt in der Fotosynthesegleichung. Ohne CO2 und auch ohne H2O und ohne Sonnenstrahlung (hv) gäbe es keine grünen Pflanzen, gäbe es keine Nahrung und keinen Sauerstoff für die Tiere wie uns Menschen.

Bei einer gleichmäßigen Oberflächentemperatur von -18°C strahlt die Erde gemäß der Stefan-Boltzmann-Gleichung 240 W/m2 ab, bei +15°C sind es 390 W/m2. Wo kommen diese 150 W/m2 her? Die Erde muss nämlich mit 390 W/m2 bestrahlt werden, um eine Temperatur von 15°C zu haben. Da eine Selbsterwärmung eines Körpers nicht erklärt werden kann, erfinden die Experten eine „Gegenstrahlung“. Wer diese jedoch nachts bei klarem Himmel messen will, hat Pech. Ausgerechnet bei klarem Himmel, wenn die „Treibhausgase“ ungehindert die Erde erwärmen könnten, wird es kalt und kälter, bis am Morgen wieder die Sonne aufgeht und den Erdboden erwärmt. Auch hier wird die Natur auf den Kopf gestellt. Jeder Körper, ob warm oder kalt, strahlt ab einer Temperatur größer O Kelvin oder -273°C Wärme ab, immer. Die Intensität steigt mit der 4. Potenz der absoluten Temperatur. Kein Körper kann sich mit der ihm eigenen inneren Energie erwärmen, selbst dann nicht, wenn die von ihm abgestrahlte Energie von den „Treibhausgasen“ zu 100 Prozent an ihn zurückgestrahlt würde. Für die Erde bedeutet dies: Sie muss von außen erwärmt werden, von der Sonne. Alles Leben beginnt mit dem „Es werde Licht!“ Das Leben auf der Erde verdankt seine Existenz der Strahlkraft der Sonne, keineswegs den „Treibhausgasen“. Sie bestimmt die Temperaturen und deswegen folgen auch die Zugvögel, die Schwalben und Störche, der Sonne. Während jetzt das „Leben“ auf der Nordhemisphäre zum Winter hin langsam „erstarrt“, blüht es zum Sommer auf der Südhemisphäre auf. Woher wissen die Störche, wann es bei uns Frühling wird und sie wieder zurückkommen können?

Die Behauptung der Existenz eines „natürlichen Treibhauseffektes“ von 33°C ist eine Schutzbehauptung. Schlimmer, sie ist ein Phantasieprodukt, der größte physikalische Schwindel der Neuzeit. Der „Treibhauseffekt“ ist ein Schwindel, der aus einer intellektuellen Notlage geboren wurde, in die man sich selbst als „Höhlenbewohner“ hinein manövriert hatte und aus dem Schattenwurf der Erde irrigerweise schloss, diese sei eine „Scheibe“. Wie eine Kugel bestrahlt wird, das kann jeder an einem Fußball mit Hilfe einer Taschenlampe überprüfen oder anhand eines Satellitenfotos von der Erde aus dem Weltraum. Alle Satellitenfotos zeigen zwar auf eine Fläche projiziert einen Kreis, aber dieser überdeckt flächenmäßig 180 Grad des Erdumfangs ab, also die doppelte Kreisfläche, die Halbkugel 2πr2. Bei der 24-stündigen Rotation der Erde um sich selbst wird immer eine Erdhälfte von der Sonne beschienen. Am Äquator sind das 12 Stunden Tag und 12 Stunden Nacht. Die Erde ist nicht wie eine Tomate oder ein Apfel in der Mitte aufgeschnitten und hält ihre Querschnittsfläche der Sonne entgegen. Auf dieser primitiven Annahme beruht das ganze Konstrukt der Erde als „Treibhaus“.

Wenn man auf diesem Expertenniveau verharrt und nur mal die Korrektur macht, dass die Erde nicht als „Querschnittsfläche“ sondern als „Halbkugel“ bestrahlt wird, man also die „Solarkonstante“ durch 2 und nicht durch 4 teilt, dann erhält man 684 Watt/m2 und nach Abzug der Albedo von 0,3 einen Wert von 480 Watt/m2 statt 240 W/m2. Der Treibhauseffekt kehrt sich in einen Kühleffekt um und damit nähern wir uns dem, was Isaac Newton (1643-1727) bereits um 1666 experimentell gefunden hatte. Alle Körper kühlen sich ab. Die Geschwindigkeit hängt dabei von der Differenz zwischen der Körper- und seiner Umgebungstemperatur ab. Das „Newton’sche Abkühlungsgesetz“ wollen die Klimaexperten nicht kennen oder ignorieren es in der Hoffnung, dass es nicht auffällt. Newton formulierte sein Gesetz, lange bevor 1791 Pierre Prévost (1751-1839) zeigte, dass alle Körper Wärme ausstrahlen, egal ob warm oder kalt.

Mögen die Klimaexperten „Newton’s Abkühlungsgesetz“ unterschlagen, es leistet gute Dienste in der Gerichtsmedizin bei der Rückberechnung des Mordzeitpunktes anhand der Abkühlungsgeschwindigkeit von Leichen. Man benötigt die Umgebungstemperatur und zu zwei Zeiten die Leichentemperatur, um anhand des Abkühlungsgesetzes die Zeit zu berechnen, die vom Mord bis zur ersten Temperaturmessung verstrichen ist. Schauen Sie bei „Google“ nach unter „Alibi zur Mordzeit“!

Das Potsdam-Institut für Klimafolgenforschung und die Landwirtschaft!

Durch seine Pressemitteilungen gibt das PIK regelmäßig Einblicke in sein Innenleben wie seine Gedankenwelt. Am 24. August 2016 hieß es: „Landwirtschaft im Klimawandel: Freier Handel könnte ökonomische Verluste ausgleichen“. Die PM beginnt: „Rund um den Globus stellt der Klimawandel ein Risiko für die landwirtschaftliche Produktivität dar und könnte Nahrungsmittelpreise hochtreiben“. Dies zeige eine neue Studie, die nichts anderes sagt, was die Menschheit aus Erfahrung seit Urzeiten weiß. Doch dann wird es amüsant: „Die Landwirtschaft ist sehr anfällig für Klimaveränderungen – schon ein kleiner Anstieg der globalen Mitteltemperatur kann Konsequenzen haben für regionale Ernten“. Wie ist man bloß auf diese erleuchtende Eingebung gekommen? „Die Wissenschaftler kombinierten für ihre Studie 19 verschiedene Klimaprojektionen mit Simulationen zu landwirtschaftlichen Erträgen“.

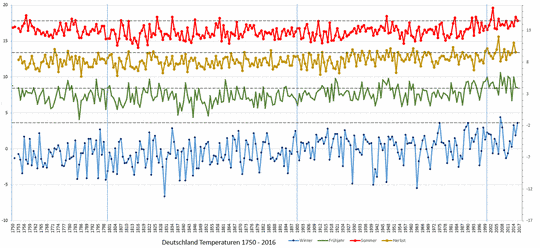

Das hört sich äußerst beeindruckend an und strapaziert die kognitive Leistungsfähigkeit der meisten Menschen. Sie reagieren wie Tiere im Scheinwerferlicht und lassen sich durch eine vermutete Intelligenz blenden. Dabei ist es nichts als numerische Routine, das Spielen und Variieren von Computermodellen, die alles simulieren, nur nicht die Realität und das zukünftige Klima. Laut der von der Weltorganisation für Meteorologie international festgelegten Definition von Klima lassen sich Klimawerte nur lokal berechnen. Zugrunde gelegt werden die Wetterdaten von 30 Jahren. 30 Jahre muss man das Wetter ertragen, bevor man die Wettervergangenheit zu „Klima“ verarbeitet. Überall auf der Welt gibt es Wetter, extrem unterschiedliches Wetter, aber weder ein einheitliches „Globalwetter“ noch ein „Gobalklima“, von dem man ohnehin nur die „Globaltemperatur“ kennt.

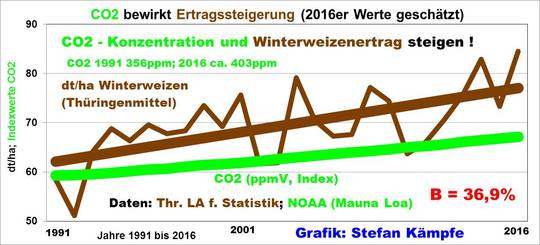

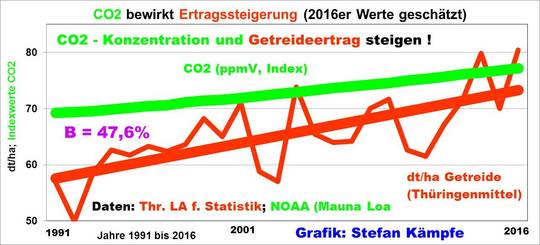

Wie kommt das PIK zur Annahme, ein „kleiner Anstieg der globalen Mitteltemperatur“ hätte gravierende Konsequenzen „für regionale Ernten“. Lebt man dort nur noch in Modellwelten und sieht die Wirklichkeit nicht mehr? Jeder Gemüsebauer oder Landwirt könnte den PIK-Experten erklären, dass der Ertrag und die Qualität einer Ernte vom Wetter abhängen, wobei die Pflanzen die unterschiedlichsten Ansprüche an das ihnen optimale Wetter stellen. Etliche Faktoren wirken auf die Kulturpflanzen, nicht nur die Temperatur. Was nützen die angenehmsten Temperaturen, wenn es an Regen mangelt, es zu viel Regen gibt oder Hagel einen Weinberg entlaubt?

Den saisonalen landwirtschaftlichen Nutzpflanzen ist die globale Mitteltemperatur wie das „Globalklima“ völlig wurscht. Haben die PIK-Klimaexperten noch nie in einen Klimaatlas geschaut und festgestellt, dass es auf der Erde eine große Vielfalt sehr unterschiedlicher Klimata gibt. Selbst in einer Weinbauregion wie Rheinhessen ist nicht überall der Anbau von Wein klug und ratsam. Da empfiehlt sich ein genaues Studium der Topographie, der Inklination und Exposition einer Lage. Eine optimale Bestrahlung ist wichtig für hohe Oechsle-Grade. Das Wachstum von Pflanzen wird vom Wetter in der Zeit zwischen Saat und Ernte, der Vegetationsperiode, bestimmt. Diese beginnt für die Pflanzen der mittleren Breiten etwa März/April und endet etwa September/Oktober. Was interessieren die Rüben die Temperaturen im Winter? Wer die Wachstumsperiode verlängern und die Pflanzen vor Spätfrösten schützen will, betreibt Unterglasgartenbau, nutzt Gewächshäuser oder breitet im Frühjahr Folien über die Gemüsefelder aus. Salat, Kohl, Spargel, Sommergerste, Winterweizen, Kartoffeln, Zuckerrüben, alle Pflanzen haben spezielle Ansprüche, was den Wetterablauf während des Sommerhalbjahres betrifft. Es ist absoluter Unsinn, „klimabezogene Schäden“ durch eine Rechengröße wie die „Globaltemperatur“ herbei zu fantasieren. Nirgendwo auf dem weiten Erdenrund berechnen Pflanzen die „Globaltemperatur“, um ihr Wachstum danach auszurichten.

Das Potsdam-Institut für Klimafolgenforschung und die „Biodiversität“

Am 29. August 2016 überraschte das Potsdam-Institut mit der sensationellen Meldung „Amazonaswald: Biodiversität kann Klimarisiken mindern“. Es heißt: „Wald mit einer großen Vielfalt kann besser auf Klimastress reagieren. Erstmals konnten Forscher dies jetzt für das Amazonas-Gebiet in umfassenden Computer-Simulationen, die den Artenreichtum von Bäumen dort mit einberechnen, zeigen. Biodiversität kann demnach ein wirksames Mittel sein, Klimarisiken abzumildern, und sollte nicht im Naturschutzkontext betrachtet werden.“

Ich zitiere weiter: „Die Vielfalt der Eigenschaften all der verschiedenen Pflanzen in den Wäldern des Amazonas könnte diesem helfen, sich auf ein gewisses Maß von Klimaveränderung einzustellen – manche der vorherrschenden Bäume würden absterben und andere Arten würden ihren Platz einnehmen, die mit den zukünftigen klimatischen Bedingungen besser zurecht kommen.“ Und dann die „Erkenntnis“: „Biodiversität erweist sich hier als ein Muss, nicht als hübsches Beiwerk. Sie kann funktional sein für das langfristige Überleben der großen Biomasse-Reservoirs unserer Erde, zu denen auch die Wälder der Amazonas-Region gehören.“ Seit 1992 gibt es das PIK! Jetzt nach 25 Jahren entdeckt man plötzlich die „Biodiversität“ und legt ungewollt die Lunte an das „Globalklima“. Es ist dieser Befehl „think global“, der den Blick nicht nur auf die Wettervielfalt sondern auch auf die Schönheit und Vielfalt der Natur versperrt.

Es heißt dann weiter: „Nie zuvor ist dieses Kräftespiel so genau und umfassend in eine biogeochemische Simulation von Vegetation und Klimawandel eingebaut worden, dies ist ein wichtiger Schritt vorwärts für die noch bessere Modellierung des Erdsystems.“ „Wir haben hieran mehrere Jahre gearbeitet. Bekannt war, dass Biodiversität bedeutsam ist für die Produktivität eines Ökosystems und für das Speichern von Biomasse. Aber bislang konnte dies im großen Maßstab nicht quantitativ gezeigt werden. Wir freuen uns, dass wir hier auf der Grundlage früherer Forschung eine Lücke schließen können.“ Zum Schluss der Satz: „Trotz der ermutigenden Ergebnisse zum funktionalen Wert der Biodiversität bleibt der Regenwald des Amazonas leider einer der Brennpunkte unseres Planeten, der nach einer raschen Verringerung des CO2-Ausstoßes verlangt.“

Exakt dies verlangt der „Regenwald“ nicht, denn er weiß, dass für ihn das CO2 zum Leben und Wachstum unverzichtbar ist. Er braucht vor allem H2O, dann CO2 und eine ganzjährige Vegetationsperiode. Mögen sich die PIK-Wissenschaftler freuen ob ihrer Simulationskünste. Was sie der Welt an „Weisheiten“ propagieren, ist für die Natur eine Selbstverständlichkeit. Die Biodiversität hat die Natur praktiziert und perfektioniert, lange bevor der neunmalkluge Mensch sich Gedanken darüber machte, wie die Natur funktioniert und sich den unterschiedlichsten Wetterbedingungen auf der Erde optimal anpasst. Im Grunde ist es eine Frechheit, was das PIK mit dieser Studie propagiert. Die Natur braucht das PIK nicht, um zu wissen, wie sie sich optimal an die variierenden erdgeschichtlichen Randbedingungen anpasst. Die Vegetation Skandinaviens während der Eem-Warmzeit vor etwa 120 000 Jahren musste der Weichsel-Eiszeit gewichen, um nach deren Ende vor etwa 12 000 Jahren sofort wieder zurückzukehren und auf dem Wege der natürlichen Sukzession eine Artenvielfalt ohnegleichen zu schaffen. Die Natur bedarf uns Menschen nicht dazu.

Die Biodiversität mit den unterschiedlichsten Ökosystemen ist eine Leistung der Natur und hängt ab von der Strahlung, den Niederschlägen und den Temperaturen, die wesentlich das Wetter bestimmen. Wer jedoch von der „einen Welt“ mit der „einen Temperatur“ und dem „einen Globalklima“ träumt, sieht diese Vielfalt und Schönheit nicht. Doch soweit ist man im PIK nicht. Wer behauptet, dass „Biodiversität Klimarisiken mindern kann“, sieht die Wahrheit nicht. Die „Biodiversität“, die Mannigfaltigkeit von Flora und Fauna ist eine aktive Anpassungsreaktion der Natur auf die Wettervielfalt, auf die wechselnden Wetterregime. Die „Biodiversität“ mindert die Wetterrisiken nicht und damit auch nicht die „Klimarisiken“!

Wann wird die so gerühmte „Qualitätsforschung“ des Potsdam-Instituts von neutraler Stelle einer Evaluation unterzogen? Der Ruf der „Wissenschaft“ insgesamt steht auf dem Spiel. Wie will das PIK die Zukunft vorhersagen, wenn es nicht einmal die Vergangenheit in ihren Abläufen begriffen hat und halbwegs logisch erklären kann?