[1] "Wir sind im Krieg. Gegen den Klimawandel"

Vor ein paar Monaten entfachte unser Feind eine Feuersbrunst in Kanada, die uns zur Evakuierung einer 90.000-Einwohner-Stadt zwang. … Eine seiner Fluten bedrohte Kunstschätze von unermesslichem Wert im Louvre. Der Feind setzt sogar Bio-Waffen ein, um psychologischen Terror zu verbreiten: Der Zika-Virus lässt auf einem ganzen Kontinent die Köpfe von Neugeborenen schrumpfen."

Diese Frontberichterstattung zum Klimakrieg stammt vom lt. WIKIPEDIA wohl berühmtesten Klimaaktivisten der Welt, Bill McKibben, im Original nachzulesen bei: [3] World War III is well and truly underway. And we are losing.

Bill McKibben ist Inhaber des alternativen Nobelpreises „Alternativer Nobelpreis für Bill McKibben“ und gehört zu den 100 Vordenkern der Welt: WIKIPEDIA: Das Magazin „Foreign Policy“ führt ihn in der Liste der 100 wichtigsten globalen Vordenker und MSN zählt ihn zu einem der einflussreichsten Menschen des Jahres 2009.

Wer so berühmt ist, dessen Aktionen werden auch in Deutschland von investigativen Klima-Alarmseiten befürwortet und hofiert.

Klimafakten.de: [1] … Die Idee selbst ist nicht neu. Schon mehrfach erklärten Klimaschützer, für den notwendigen Umbau von Wirtschaft und Gesellschaft brauche es eine "Mobilisierung wie in Kriegszeiten" – zuletzt fand die Metapher zum Beispiel Eingang ins Wahlprogramm der demokratischen Präsidentschaftskandidatin Hillary Clinton.

… In seinem Essay zieht der 55-Jährige das Gedankenspiel konsequent durch und stellt den Kampf gegen den Klimawandel als Dritten Weltkrieg dar, der eigentlich längst begonnen habe. Wie einst in den 1930er Jahren gegen Hitler-Deutschland versuche es die Menschheit bisher mit eher zögerlichen Schritten und einer Appeasement-Politik. Der Klimavertrag von Paris sei so etwas wie das Münchner Abkommen. Teilweise sehr detailliert vergleicht McKibben die rasante Aufrüstung der USA im Zweiten Weltkrieg mit dem, was heute erforderlich wäre für eine Energiewende – und neben den Hunderten von Panzerfabriken, Schiffswerften, Fallschirmnähereien etc., die einst unter Franklin D. Roosevelt aus dem Boden gestampft wurden, erscheint die notwendige Zahl von Solar- und Windrad-Fabriken plötzlich gar nicht mehr so entmutigend groß…

Und wenn es um bedingungslose, faktenresistente Unterstützung von Klimaalarm geht, ist wie eigentlich immer auch die Infoseite der Klima-Regierungsberaterin C. Kemfert zur Stelle. Ein beispielhaft wohlwollendes Interview mit McKibben anbei zum Einlesen: Klimaretter.Info 24. Oktober 2013: "Amerika steckt den Kopf in den Sand"

Rezension

Erstaunlich ist, dass reine Agitation und vollkommen unkritische Reflexion ausreichen, um zu den 100 globalen Vordenkern der Welt zu zählen und einen (alternativen) Nobelpreis zu bekommt.

Greenpeace Magazin: Die Jury begründete die Wahl mit der „erfolgreichen Mobilisierung einer wachsenden zivilgesellschaftlichen Bewegung gegen den Klimawandel“.

Anm.: Bei Al Gore mit seinem Klimakatastrophenfilm wurde bewiesen, dass das „richtige“ Nobelpreiskomitee dazu keinen Unterschied macht.

Nach diesen Kriterien fällt jeder erfolgreiche Agitator / Diktator darunter (was in der Geschichte auch geschehen ist). Weshalb jedoch ein „Vordenken“ damit verbunden sein soll, erschließt sich wohl nur dem „Entscheidungsteam“ und entspringt wahrscheinlich der Amerikanischen Pilgerväter-Tradition, wonach Erfolg ein untrügliches Merkmal für Gottes Wohlwollen sei und deshalb das wirklich wichtige Bewertungskriterium eines Menschen darstellt. Doch gilt dies nicht nur für die Amerikanische Pilgervätertradition, sondern auch für beide christlichen Hauptkirchen. Alles was ein „Zeichen der Zeit“, also Mehrheitsmeinung geworden ist, ist automatisch auch Gottes Wille, siehe dazu: Kirche und Klimawandel.

Zufügung: Nach der Editierung dieses Artikels entstand aus ähnlichem Anlass einer über die deutsche „Klimaprophetin“, Frau Umweltministerin Dr. Hendricks [15]„Frau Hendricks im Klimawahn“, der dann jedoch vorgezogen wurde. Beide Artikel ergänzen sich mit ihren Darstellungen.

Bill McKibben

Gesichtet wird hier nur, was die Öffentlichkeit und Medien aus seinen vielen Publikationen und Mitteilungen extrahieren. Danach ist sein großer Verdienst Leistungen als Organisator von Massenbewegungen:

Klimaretter.Info: Alternativer Nobelpreis für Bill McKibben

Dem Magazin The New Yorker sagte McKibben anlässlich des Ban-Ki-Moon-Gipfels in dieser Woche, dass es zwar schon lange eine "gute, strukturierte Bewegung" aus Klimaforschern und Umweltlobbyisten gebe, aber die Bevölkerung lange Zeit nicht Teil der weltweiten Klimaschutzbewegung gewesen sei. Deshalb habe er 2008 die Kampagne 350.org mitgegründet. Der Name leitet sich aus der geforderten maximalen CO2-Konzentration der Erdatmosphäre von 350 ppm her – der aktuelle Wert liegt bei 400 ppm.

Die Bewegung müsse eine Gegenmacht zur fossilen Industrie aufbauen, so McKibben gegenüber dem New Yorker. Die weltweiten People’s-March-Veranstaltungen am vergangenen Samstag und die größte Klimademo aller Zeiten am Sonntag in New York seien nur der "Warm-up" für das nächste Jahr, wenn es um das Aushandeln eines neuen Klimavertrages in Paris geht.

2007 startete McKibben mit der landesweiten Kampagne stepitup2007, um Druck auf die US-Regierung für mehr Engagement im Klimaschutz zu machen. Seine aktuelle Kampagne 350.org ist mittlerweile eine weltweite Bewegung und nach eigenen Angaben in 188 Ländern aktiv. Die Klimaaktivisten von 350.org organisieren weltweite Aktionen wie den People’s March oder Kampagnen gegen fossile Investitionen, aber auch lokalen Protest gegen Kohlekraftwerke oder Teersand-Pipelines.

2009 erlangte McKibben internationale Bekanntheit, als er 5.200 Demonstrationen am selben Tag in 181 Ländern organisierte.

Wenige, eingängige Statements reichen

Seine Argumentationen beschränkt Bill McKibbben als Klimaaktivist auf wenige, eingängige Statements. Seine einfachen Kernthesen lauten:

-Es ist bereits zu viel CO2 in der Atmosphäre

-Die Welt ist eigentlich schon nicht mehr zu retten – wenn überhaupt, dann nur noch mittels Extremmaßnahmen

-Schuld ist die Verbrennung fossiler Stoffe wie Kohle, Erdöl, Gas

-Die Förderung fossiler Stoffe muss verboten werden

-Jeder Weg zur Verhinderung der Förderung ist zulässig

Als Belege bietet er dazu fast durchgängig (für Klimaskeptiker) hanebüchene Ableitungen. Kein Wunder, eine seiner wesentlichen „Belegquellen“ ist wohl Herr James Hansen (Publizierer des Hockey-Stick).

Greenpeace Magazin (über McKibben):

Inzwischen wird der Klimawandel an immer mehr Orten zur spürbaren Wirklichkeit. In New York hat Hurrikan Sandy U-Bahnstationen mit Salzwasser gefüllt. Viele Menschen haben Fluten und Dürren erlebt und fangen an zu verstehen, was tatsächlich mit dem Klima passiert. Selbst dort, wo die Bewohner bisher nur wenig beeinträchtigt wurden, bleibt die simple Mathematik des Klimawandels: Es ist bereits jetzt zu viel Kohlendioxid in der Atmosphäre – der Name 350.org bringt das auf den Punkt.

Erklären Sie uns bitte diese Zahl.

Wissenschaftler sagen uns, dass wir den Kohlendioxidgehalt in der Atmosphäre wieder auf 350 ppm (parts per million) reduzieren müssen, damit der Planet bewohnbar bleibt. Wir sind aber schon bei 400 ppm. Um den Temperaturanstieg unter zwei Grad zu halten, hätten wir schon vor einigen Jahren aufhören sollen, CO2 in die Atmosphäre zu pumpen.

Was sind Ihre zentralen Strategien im Kampf für den Klimaschutz?

Es gibt mindestens zwei Stränge, an denen wir tätig sind. Zunächst geht es darum, sich bei jedem Bauvorhaben für neue Öl-, Kohle- oder Gas-Infrastruktur einzumischen. Das können wir an vielen Orten tun, da weiterhin neue Projekte wie Pipelines, Ölfelder oder Kraftwerke geplant sind. Wir versuchen, diese Vorhaben zu verhindern. Da spielen wir in der Defensive und es klappt gut. Der zweite Strang ist die Divest-Kampagne, sozusagen unser Offensivspiel. Seit 2012 haben sich tausende Institutionen, Kommunen und Einzelpersonen dazu verpflichtet, ihre Gelder aus der fossilen Industrie abzuziehen. Sie repräsentieren gemeinsam ein Vermögen in Höhe von rund 50 Milliarden US-Dollar. Neben hochrangigen Persönlichkeiten wie Bischof Desmond Tutu und dem Weltbankpräsident Jim Yong Kim setzen sich beispielsweise auch die Rockefeller Brothers Stiftung und der Britische Ärzteverband für dieses Ziel ein. So sorgen wir für Unruhe in der Rohstoffindustrie.

2014 war weltweit das heißeste Jahr seit Beginn der Aufzeichnungen. Können wir den Klimawandel wirklich noch stoppen?

Ihn zu stoppen ist keine Option mehr. Das Klima heizt sich auf und es wird wohl weiterhin wärmer werden. Die Frage ist, wie sehr und wie schnell das passiert. Selbst die Zwei-Grad-Grenze, die bisher als rote Linie beschrieben wurde, ist viel zu hoch angesetzt. Schon bei einem Grad schmilzt die Arktis, und es ist eine schlichtweg idiotische Idee, noch darauf zu warten, was bei zwei Grad Erwärmung passiert.

co2Online (unterstützt vom BMUB): Seine wichtigste Botschaft: Schon heute haben wir mit 387 ppm zu viel CO2 in der Erdatmosphäre. Um eine Destabiliserung des Klimas zu vermeiden, müssen wir so schnell wie möglich auf maximal 350 ppm zurück – das zeigen die neuesten Erkenntnisse der Klimawissenschaft eindeutig. Diese Tatsache wird bisher jedoch von den Entscheidungsträgern der Welt weitgehend mißachtet. Daher benötigen wir so viele Menschen wie möglich, die über den neuesten Stand der Wissenschaft informiert sind und dementsprechend handeln.

Dass es sich dabei um reine Agitation eines sich selbst ernannten Weltverbesserers handelt, sei anhand einiger seiner „Belege“ gezeigt:

McKibbens wesentliche Thesen

Der Zika-Virus lässt auf einem ganzen Kontinent die Köpfe von Neugeborenen schrumpfen

McKibben: [1]Der Feind setzt sogar Bio-Waffen ein, um psychologischen Terror zu verbreiten: Der Zika-Virus lässt auf einem ganzen Kontinent die Köpfe von Neugeborenen schrumpfen

[4] Wie stark sich die Welt verändert, zeige aktuell die Verbreitung des Zika-Virus: “Die Moskitos, die die Krankheit übertragen, mögen das warme Klima, das wir zunehmend verbreiten”. Die Krankheit ist der Grund, warum Regierungen in Lateinamerika und der Karibik ihren Bürgerinnen offiziell empfehlen, nicht schwanger zu werden. “Wir haben es so weit kommen lassen, dass Kinder bekommen – die schönste und grundlegendste Sache der Menschheit – vom Klimawandel in Frage gestellt wird. Das kann ich einfach nicht fassen”.

Googeln nach dem Virus bringt natürlich eine Unmenge an Fundstellen hervor. In fast allen wird der Klimawandel als möglich, neue Verbreitungs-Ursache genannt. Das liegt aber nicht an der angeblichen Tatsache (meistens steht ja „mögliche“ Ursache), sondern alleine am Multiplizieren der Ur-Nachrichten. Generell lautet die Argumentation: Wenn es wärmer wird, verbreitet sich die Mücke weiter – und deshalb ist der Klimawandel schuld. Dass es diese Mücke schon lange in einem großen Verbreitungsgürtel rund um die Welt gibt und alleine der Verdacht auf Schädelmissbildung bei Neugeborenen (ausschließlich in Brasilien) überhaupt Aufmerksamkeit erregt hat, wird unterschlagen. Aber mit einer Aussage: „Der Zika-Virus lässt auf einem ganzen Kontinent die Köpfe von Neugeborenen schrumpfen“, lassen sich Massen bewegen.

Wie die Aussage: „.. ein ganzer Kontinent … „ ohne Agitation in Zahlen ungefähr aussieht, lässt sich in einem (lesenswerten) Zeitungsbeitrag sehen.

ZEIT ONLINE 29. Januar 2016: [8] Zika-Virus: Das Märchen von den 4.000 geschädigten Babys

Bei den verbleibenden 270 Meldungen besteht aufgrund von Ultraschall-, Röntgen- oder Laboruntersuchungen der begründete Verdacht auf eine Verkleinerung des Schädels oder eine infektiöse Schädigung des Nervensystems. Bei sechs dieser Fälle wurde das Zika-Virus nachgewiesen.

Dass das Zika-Virus neben den anderen, von dieser Mücke übertragbaren Krankheiten das wohl kleinste Problem ist, lässt sich auch nachlesen. Aber diese tödlichen Krankheiten kennt man als „alltägliche Tropenkrankheiten“, weshalb man dagegen keine Massen mobilisieren kann. Vor allem müsste man Grundlegendes dagegen tun und das ist weit schwieriger, als Protestmärsche gegen CO2 und Kohleförderung zu organisieren.

[8] Zika war in den Lehrbüchern bislang höchstens im Kleingedruckten zu finden. In den Jahren 2013-14 aber rückte das Virus ins Visier professioneller Seuchenjäger: In Französisch-Polynesien gab es den bis dahin größten Ausbruch mit wahrscheinlich mehr als 10.000 Erkrankten. Die WHO und die Gesundheitsbehörden in Südamerika waren also gewarnt, als im Mai 2015 die ersten Zika-Infektionen in Brasilien auftraten. Doch Brasilien kämpft bereits seit Jahrzehnten erfolglos gegen die Gelbfiebermücke, Aedes aegypti. Die Mücke ist für über 1,6 Millionen Dengue-Erkrankungen jährlich verantwortlich, von denen im letzten Jahr nach offiziellen Berichten 843 zum Tode führten. Die Dunkelziffer der Todesfälle dürfte weit höher sein.

Aedes aegypti hat sich an die Großstätte Lateinamerikas perfekt angepasst. Während der Malaria-Überträger Anopheles nur auf besonders sauberen Naturgewässern brütet, liebt Aedes schmutzige Pfützen in alten Autoreifen, vergammelten Blumentöpfen und weggeworfenen Coladosen. Als echter Großstädter ist Aedes tag- und nachtaktiv und so nervenstark, dass ihn auch verzweifeltes Wedeln und Schütteln kaum vertreiben kann. Das Versprühen von Insektiziden, das vor der Karnevalszeit an den touristisch wichtigen Punkten wie ein Ritual zelebriert wird, bringt langfristig nichts, solange die Nistplätze in den Favelas unbehelligt bleiben. Gegen die Aedes-Plage in Brasiliens Metropolen gibt es nur ein wirksames Mittel: gründlich Aufräumen. Doch mit den entsprechenden Aufrufen sind bereits mehrere Regierungen gescheitert.

Jede Woche verlieren wir 22.000 Quadratmeilen arktischen Eises

McKibben: [1] jede Woche verlieren wir 22.000 Quadratmeilen arktischen Eises

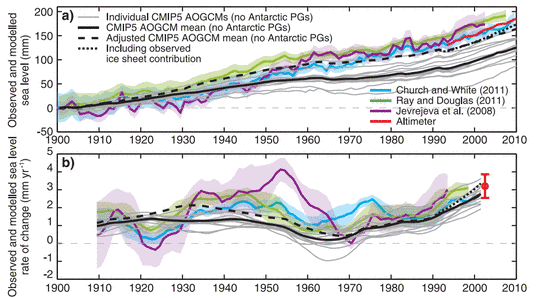

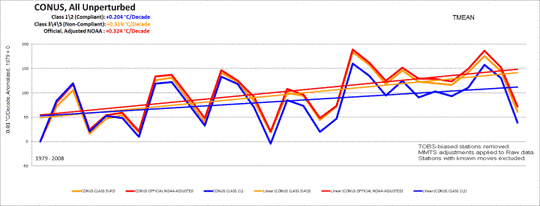

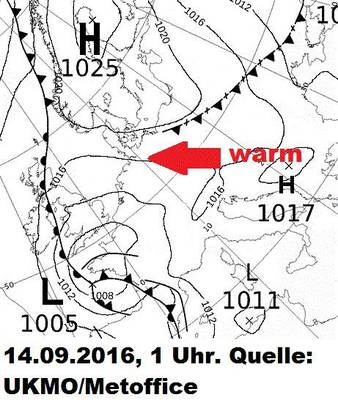

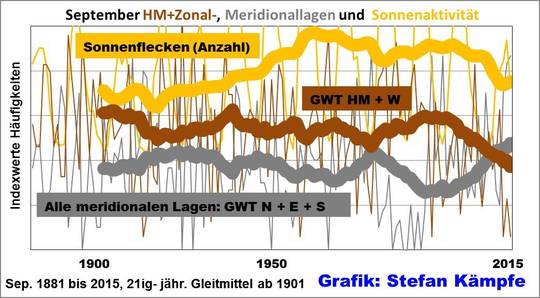

Dazu der aktuelle Bedeckungsstatus der Arktis (Bild 1). Seit dem Jahr 2007 stagniert der Eisrückgang und die Vorhersage von Al Gore ist ebenfalls nicht eingetroffen.

Bild 1 Aktuelle Eisbedeckung Arktis (in etwa mit diesjährigem Minimum, da ab Mitte Sept das Eis wieder zu nimmt, wie Bild 1.1, welches aktuellere Daten hat zeigt)

Bild 1.1 Eisbedeckung Arktis Detailsicht, Stand 14.09.2016. Quelle: meereisportal.de

Dass sich beim Meereis nicht nur Al Gore getäuscht hat, sondern auch das AWI, welches gerne seine klimapolitisch korrekte Forschung publiziert, zeigt die Meldung vom Frühjahr:

NDR.de 21.04.2016: Arktis droht Rekord-Schmelze: "Ein klares Signal"

Es sind keine guten Neuigkeiten, die Wissenschaftler des Alfred-Wegener-Institut (AWI) Bremerhaven am Donnerstag über die Arktis bekannt gegeben haben. Denn sie erwarten in diesem Sommer eine neue Rekordschmelze des Meereises in der Arktis. … "Aber die aktuelle Entwicklung bestätigt den Trend der globalen Erwärmung und ist ein klares Klimasignal."

Wie rasend sich beim AWI die Erkenntnisse ändern und wie publiziert wird, dass die Vorhersage nicht eintraf, zeigen die folgenden Meldungen:

13. September 2016: Meereis in der Arktis steuert stark auf sommerliches Minimum zu

14. September 2016: Sommerliches Meereisminimum in der Arktis durchschritten – Das Jahr 2016 zeigt die zweitniedrigste jemals gemessene Meereisausdehnung

Anm.: Die Aussage “jemals gemessen” bedeutet natürlich nur, dass man erst seit der Satellitenära, welche um 1976 begann diese Daten hat. Es bedeutet damit nr: “Seit den gerade einmal 40 Jahren Messzeitraum wurde (sofern man die Fehler der Messungen nicht berücksichtigt) das zweit-niedrigste Sommerminimum gemessen. Die von Al Gore vorher-gesagte, totale Sommerauflösung des Eises spätestens im Jahr 2013 ist bei Weitem nicht eingetroffen”.

Zurück zu McGibben

Unklar ist, woher die 22.000 Quadratmeilen / Woche abgeleitet sind, welche laut der „Schlachtmeldung“ wöchentlich an den Klimawandel verloren werden.

Die Differenz des Arktischen Sommereis-Minimums seit 1979 (davor sind keine verlässlichen Daten verfügbar) beträgt:

-1979: Sommereis-Minimum ca. 7 Mio km2

-2015: Sommereis-Minimum ca. 4,5 Mio km2

-Differenz innerhalb der 36 Jahre Messzeitraum durch Satelliten: ca. 2,5 Mio km2

Umgerechnet sind das ca. 965.250 Quadratmeilen / 1872 Wochen = 516 Quadratmeilen / Woche, seit dem Jahr 1979 also 2,35 % der von McKibben gemeldeten, wöchentlichen Abnahme. Vielleicht weiß ein Blogleser woher McKibbens mehr als hoffnungslos überzogene Angaben resultieren. Seriöse Berichterstattung sieht jedenfalls anders aus.

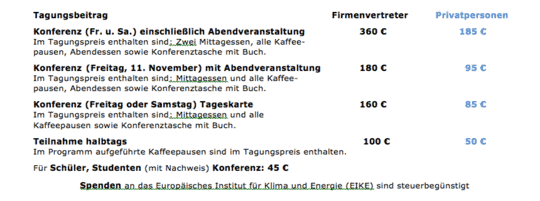

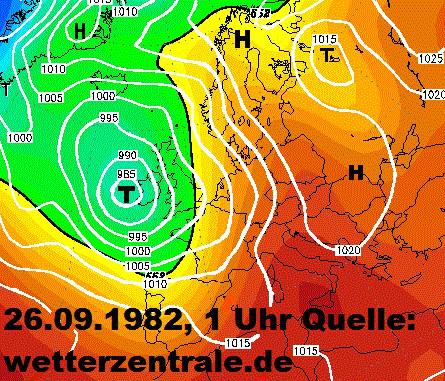

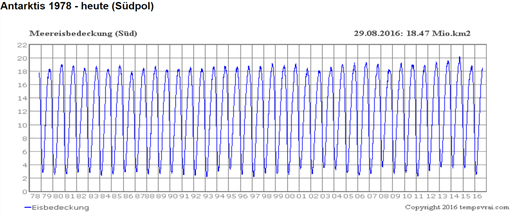

Dass auf der Südhälfte der Erde davon weiterhin rein gar nichts zu sehen ist, zeigt das folgende Bild der Antarktis. Ist es vorstellbar, dass CO2 nur auf der Nordhalbkugel einen „Klimakrieg“ entfacht hat und die Südhälfte „verschont“?

Bild 2 Aktuelle Eisbedeckung Antarktis

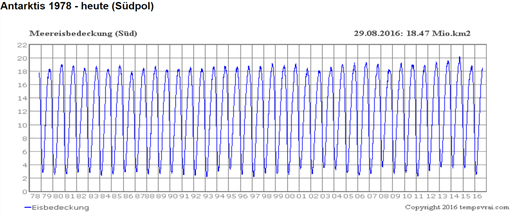

Vor ein paar Monaten entfachte unser Feind eine Feuersbrunst in Kanada

McKibben: [1] Vor ein paar Monaten entfachte unser Feind eine Feuersbrunst in Kanada

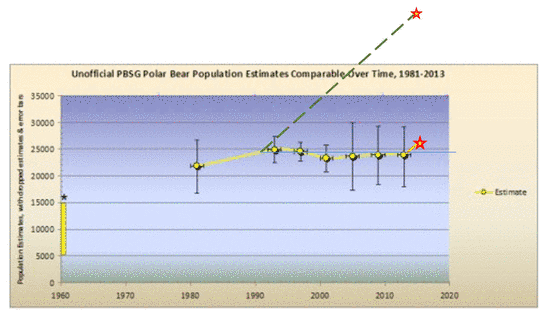

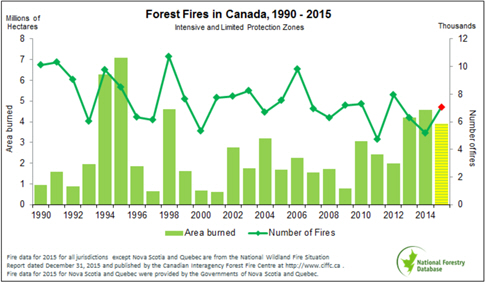

Wenn man dazu googelt, erscheinen wieder viele Seiten, welche zu wissen meinen, dass Feuer durch den Klimawandel zunehmen. Sieht man sich die wirklichen Daten an, lässt sich auch dies nicht entdecken. Ausgerechnet in Kanada nimmt die Anzahl von Großfeuer-Ereignissen in der Natur seit Beginn der Grafik um 1990 stetig ab. Davor waren sie niedriger. Das dürfte aber wohl an der damals zu geringen Beobachtungsdichte gelegen haben.

Sogar der SPIEGEL hat sich des Themas vor kurzem angenommen: [9] SPIEGEL ONLINE 11.05.2016: Katastrophe in Kanada: Die Mär von den Klimawandel-Waldbränden

Bild 3 Feuer-Ereignisse in Kanada. Quelle: Kanada National Forest Database, abgerufen am 31.08.2016

Dazu noch ein Bild für die gesamte USA. Auch dort ist keine Zunahme erkennbar.

Bild 4 [14] Feuerereignisse in den USA, abgerufen am 31.08.2016

Eine seiner Fluten bedrohte Kunstschätze von unermesslichem Wert im Louvre

McKibben: [1] Eine seiner Fluten bedrohte Kunstschätze von unermesslichem Wert im Louvre

Gerade zu den jüngsten Überschwemmungen welche auch Paris getroffen haben, gibt es genügend Analysen welche belegen, dass diese weder durch einen Klimawandel bedingt, noch dass sie einzigartig waren. Und auch die Seine ist in einer Analyse gezeigt:

EIKE 19.06.2016: Ein 106 Jahre altes Foto lässt Alarmisten über die Pariser Überschwemmung „alt aussehen“

Während die einen die globale Erwärmung als Schuldigen herausstellen, war auf WuWT ein Bericht zu lesen, dass die "Große Flut von Paris im Jahre 1910 Wasserstände auf mehr als 20 Fuß (ca. 8,6 m) über dem normalen ansteigen sah, lange bevor die globale Erwärmung ein Problem war.

"Vor mehr als 100 Jahren stieg die Seine auf einen Rekord von mehr 8,6 m (ca. 20 Fuß) über dem üblichen Niveau, und verursachte eine Katastrophe die als die große Flut von Paris 1910 bekannt wurde." Schrieb Kristine Mitchell in einem Beitrag für mymodernmet.com am Juni 6.

Es ist zudem gegen die Klimawandel-Theorie, im Sommer mehr Überschwemmungen zu erwarten, weil nach dieser die Sommerniederschläge abnehmen müssen.

Und immer neu muss man zeigen, wann die wirklich schlimmen Überschwemmungen waren – vor dem Klimawandel:

Bild 5[11] Hochwassermarken des Mains bei Würzburg seit dem Mittelalter bis 2013

Bild 6 [11] Hochwasserpegel Köln 1784 – 2013 lt. Daten der Stadtentwässerungsbetriebe Köln AöR (Grafik vom Autor erstellt). Y-Achse: Rheinpegel (m)

Im Artikel „Der Klimawandel bedroht die Wüste Namib – glaubt Deutschlandradio Kultur“ ist ein weiteres Beispiel früherer Sintfluten ausgeführt.

Und immer wieder trifft der Klimawandel die Korallen

McKibben: [1] … Im Pazifik gelang dem Feind dieses Frühjahr auf Tausenden von Meilen ein großer Durchbruch, als er einen vollen Angriff auf die Korallenriffe startete.

Im Original steht:

In the Pacific this spring, the enemy staged a daring breakout across thousands of miles of ocean, waging a full-scale assault on the region’s coral reefs. In a matter of months, long stretches of formations like the Great Barrier Reef—dating back past the start of human civilization and visible from space—were reduced to white bone-yards.

Gerade die Korallen müssen regelmäßig für den Klimawandel sterben. Doch gibt es auch dazu in der realen Natur wenig Anlass:

kaltesonne 6. Januar 2015: Unerwartete Wendung: Korallen sind viel Wärmestress-resistenter als vormals befürchtet.

So berichtete eine Forschergruppe um Peter Bell von der University of Queensland im April 2014 im Fachjournal AMBIO, dass der Hauptgrund des langfristigen Korallensterbens im Great Barrier Reef in der lokalen Wasserverschmutzung, also der Eutrophierung, zu suchen ist. Kein Wort zur hitzegetriebenen Korallenbleiche oder Ozeanversauerung.

Hier die Kurzfassung der Arbeit im Original:

Long-term monitoring data show that hard coral cover on the Great Barrier Reef (GBR) has reduced by >70 % over the past century. Although authorities and many marine scientists were in denial for many years, it is now widely accepted that this reduction is largely attributable to the chronic state of eutrophication that exists throughout most of the GBR. Some reefs in the far northern GBR where the annual mean chlorophyll a (Chl a) is in the lower range of the proposed Eutrophication Threshold Concentration for Chl a (~0.2–0.3 mg m−3) show little or no evidence of degradation over the past century. However, the available evidence suggests that coral diseases and the crown-of-thorns starfish will proliferate in such waters and hence the mandated eutrophication Trigger values for Chl a (~0.4–0.45 mg m−3) will need to be decreased to ~0.2 mg m−3 for sustaining coral reef communities.

Die Arbeit von Bell und Kollegen blieb von der deutschsprachigen Presse unberücksichtigt. Was der Frankfurter Rundschau ebenfalls entgangen ist: Walter Strack führte eine genauere Überprüfung der alarmistischen PNAS-Great Barrier Reef-Arbeit durch und förderte größere Ungereimtheiten an den Tag (siehe Details auf WUWT).

Auf Arte kam gerade eine Reportage: 07. September 2016 Grenzenloses Frankreich: Neukaledonien

Diese Inselgruppe liegt auf der gleichen Höhe wie das Barriere-Riff und ist auch nicht allzu weit davon entfernt. Wie „üblich“, kam eine Meeresbiologin zu Wort, welche das inzwischen rund um die Welt notwendige „Klimamonitoring“ durchführt, ohne das unsere Erde wohl täglich unbemerkt untergehen könnte. Und diese Beobachterin berichtete im Interview, dass die Korallen um Neukaledonien in einem erstaunlich gutem Zustand sind.

Weiter ist dem Autor eine ZDF- Reportage über die Korallenbleiche in Erinnerung geblieben.

ZDF-Film vom 30.10.2015: „Die geheime Welt der Ozeane, Rotes Meer“

(Passagen-Skizze des Autors): In der Reportage präsentiert sich Phillip Coustou mit durchgängiger Penetranz als der Korallenretter der Weltmeere. Den ganzen Film über erzählt er, dass die steigende Meerestemperatur alle Korallen der Weltmeere unwiederbringlich töten wird, er aber zur Rettung bereit steht. Zum Schluss erreicht die Expedition die Küste vor Eritrea. Dort ist das Meerwasser so heiß, dass lt. Coustou alle Korallen gestorben sein müssen. Der lokale, eritreische Meeresbiologe erzählt ihm jedoch, dass die in geringem Umfang hier zu beobachtende Korallenbleiche sich sehr schnell erholt.

Coustou sieht bei den Tauchgängen selbst, dass die Korallen überhaupt keine Notiz von seinen vorhergesagten Temperaturtod nehmen und trotz der hohen Wassertemperatur prächtig gedeihen. Er ist erkennbar entsetzt – aber (vom eritreischen Meeresbiologen) nicht von seiner falschen Theorie zu überzeugen. Leider endet der Film danach und geht nicht weiter darauf ein.

Auf JoanNova dazu ebenfalls eine erhellende Reportage: Great Barrier Reef: 5% bleached, not 93% says new report “discrepancy phenomenal”

In ihr wird beschreiben, wie Medien aus 7 % „nicht gebleichten Korallen“ 93 % beschädigte (damaged) Korallen machen. Da diese die Tourismusindustrie massiv beeinflusst, wird eine neue Untersuchung initiiert. Diese findet an den als besonders geschädigt gemeldeten Abschnitten (300 km Untersuchungslänge) nur 5 % geschädigten Korallenanteil und keine negative Veränderung zum Zustand einer Untersuchung welche vor 20 Jahren stattgefunden hat:

Cairns Post: Reef right, not white

REEF tourism operators have found less than five per cent of coral has died off — compared to the 50 to 60 per cent estimated by scientists — under “extreme” coral bleaching on the northern Great Barrier Reef.

Ganz aktuell auch auf WUWT: Inconvenient: Giant Coral Reef That ‘Died’ In 2003 Teeming With Life Again

Gerade eben dies auch auf EIKE erschienen: Lagen die Wissenschaftler falsch? Das Great Barrier Reef ist relativ unbeeinflusst durch die globale Erwärmung

Fazit: Die einfache und gängige „Korallen sterben bei mehr Wärme“ Hypothese erweist sich einfach als falsch.

Weitere Argumentationsschnipsel des „Vordenkers“ der Welt

Klimaretter.Info 03. Mai 2013:[6] Klimawandel: Es geht um Mathematik

McKibben: Die einfache Botschaft lautet: "Mehr als 350 ppm Kohlendioxid in der Luft sind nicht vereinbar mit dem Leben auf der Erde." Für die nächsten Tage oder Wochen wird aber mit einem Wert von 400 ppm (parts per million, Millionsteln) gerechnet.

Es geht einfach um Mathematik. Die Rechnung an diesem Punkt des Klimawandels ist, dass es viel mehr Reserven an fossilen Brennstoffen gibt, als verbrannt werden dürfen. So ziemlich jedes Land auf der Welt stimmt damit überein, dass wir das Zwei-Grad-Limit nicht überschreiten dürfen. Aber die Ölindustrie hat drei- oder viermal mehr Reserven, als wir je verbrennen dürfen. Wir müssen das Bewusstsein dafür verankern, dass es nicht okay ist, in diese Firmen zu investieren, dass sie nicht wie normale Unternehmen behandelt werden dürfen.

Was wir erreichen wollen, ist, dass aus diesen Unternehmen deinvestiert wird und kräftig in erneuerbare Energien investiert wird.

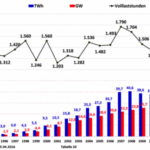

Interviewer: Dann gibt es noch ein großes Speicherproblem bei den Erneuerbaren.

Ja, das stimmt. Mehr und mehr kommt aber der Gedanke auf, dass man an unerwarteten Orten speichern kann, beispielsweise sind Autobatterien ein idealer Speicherplatz, der überall im Netz zur Verfügung stehen kann.

Sie meinen also, wir können darauf vertrauen, dass die Ingenieure eine Lösung finden werden?

Nun, ich glaube, sie sind schon dabei. Schauen Sie, als ich vor 25 Jahren das erste Buch über all dies schrieb, hatten wir keine Idee, wie wir das alles bewerkstelligen würden. Und heute zeigt ein Land wie Deutschland, dass man einen großen Teil einer modernen Wirtschaft mit erneuerbarer Energie versorgen kann.

Mit dieser festen Überzeugung ist McKibben nicht allein.

Klima-Regierungsberater Prof. Schellnhuber hat die gleiche Überzeugung. Nur fehlt ihm vollkommen die messianische Aura, neben „politischer Intelligenz“ auch Massen mobilisieren zu können.

Kaltesonne, 29. August 2016: Nun wird es ernst: Kanzlerinnenberater Schellnhuber fordert bedingungslose Zerstörung der fossilen Brennstoffindustrie

Der Direktor des Potsdam-Instituts für Klimafolgenforschung, Hans-Joachim Schellnhuber, plant eine Revolution. Als Co-Autor des Papers “The biggest gamble of the world” forderte er am 24. August 2016 im Fachblatt Earth’s Future den Zusammenbruch der Industrie, die fossile Brennstoffe verwendet. Erreichen möchte Schellnhuber dies durch eine Zerstörung der Finanzierung, der Technologie und des Konsumverhaltens. Auf Seite 11 des Artikels schreiben die Autoren:

“ Only an induced implosion of the fossil fuelled business as usual through disruptive changes in investment dynamics, technology and consumer behavior could move those scenarios closer to reality”.

Auf Seite 14:

“Eine Weltregierung soll eingesetzt werden aus Akteuren der Wissenschaft, aus dem privaten Sektor und der Zivilgesellschaft” (“This strengthened global governance should be consolidated by an alliance of multiple stakeholders, including academia, the private sector, and civil society.” S.14)

Das Ganze natürlich sofort und ohne Rücksicht auf die Kosten. 100 Mrd. $ jährlich müssen in einen Klimafonds für die Entwicklungsländer fließen, schreiben Schellnhuber und Kollegen auf Seite 5. Wahrlich das größte Spiel der Welt!

Fazit

Weiter lohnt es sich nicht, Herrn McKibbens Thesen zu analysieren (rein persönliche Meinung des Autors). Sie sind offensichtlich unseriös und zeigen nur den messianischen (und nicht brotlosen) Eifer eines Klimapropheten, der nur deshalb, weil er seine Agitation extrem skrupellos betreibt und damit Erfolg hat, von den Medien hofiert wird.

Das wirklich Erschütternde ist jedoch, welche Preise man damit einheimsen kann und dass auch ihm so viele Menschen (inclusive Deutsche Klimaberater(-innen) folgen. Beides ist aber keine neue Erscheinung in der Geschichte und wiederholt sich regelmäßig.

Das Thema wäre ganz bestimmt eine tiefenpsychologisch / massen-soziologische Betrachtung und Vergleich mit theologischen Mechanismen wert. Dem Autor als Techniker fehlen dazu aber die notwendigen, fachspezifischen Begriffe, um es soziologisch ausreichend unverständlich umschreiben zu können.

Was sagt das IPCC dazu? Dieser nimmt natürlich nicht zum „Klimakrieg“ Stellung, bietet dafür aber einen globalen Überblick.

IPCC Aussagen

Hinweis: Die Detailtexte zu diesen IPCC-Aussagen sind vollständig im EIKE Artikel: [15] „Frau Hendricks im Klimawahn“ enthalten, bei Interesse dort nachlesen.

Quellen (Anm.: Alle Aussagen sind im letzten IPCC-Klimareport, dem AR5 Langebericht hinterlegt, sie sind im Summary nicht zu in dieser Form nicht zu finden): [12][13]

-Tropische Stürme und Hurrikane: keine signifikanten Trends

-Tropische Zyklone: keine signifikanten Trends

-Außer-tropischeZyklone: keine signifikanten Trends

-Dürren: keine signifikanten Trends

-Überflutungen: keine signifikanten Trends

-Hagel und Gewitter: keine signifikanten Trends

IPCC Zusammenfassung

IPCC 2013, AR5, WGI, Kapitel 2, Seite 219: “There is limited evidence of changes in extremes associated with other climate variables since the mid-20th century.”

Übersetzung: “Es gibt [nur] begrenzte Anhaltspunkte zu Änderungen bei Extremereignissen, die mit anderen Klimavariablen seit der Mitte des 20. Jahrhunderts verbunden sind.“

Fazit

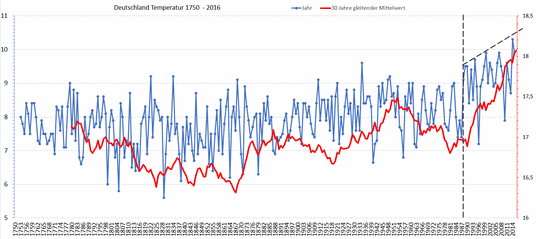

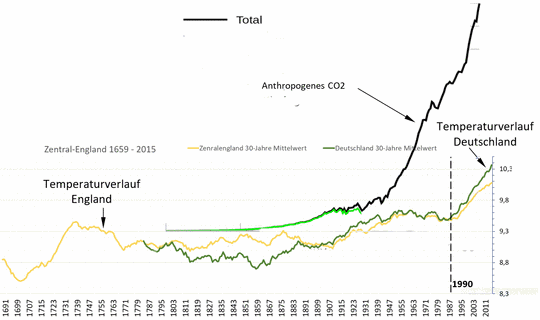

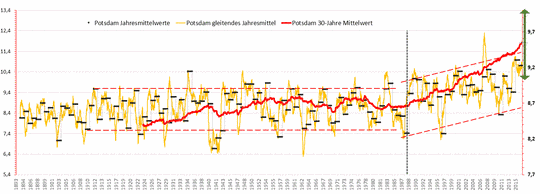

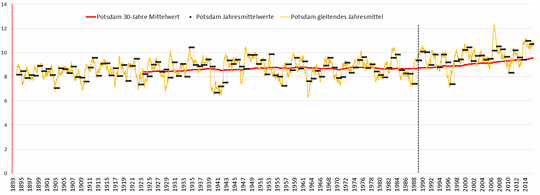

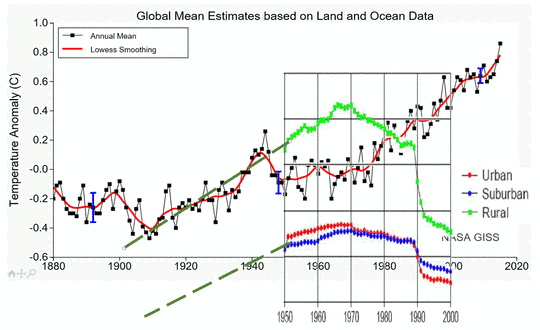

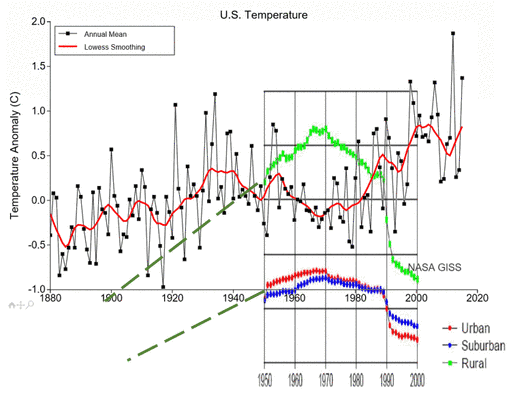

Was bleibt von den Thesen übrig? Wohl eine kleine Erwärmung der Welt-Mitteltemperatur seit der letzten Kaltzeit. Das ist normal – sonst wäre die Temperatur der Erde ja „eingefroren“, was unwahrscheinlich ist. Es geht nur darum, ob dies vom Menschen, oder von der Natur verursacht wurde. Der Beleg (für die anthropogene Ursache) seien unter anderem die „nicht mehr natürlich erklärbare Anstiegs-Geschwindigkeit“ und der angebliche Beginn mit der Industrialisierung. Beides lässt sich nach Überzeugung des Autors nicht belegen. Begründung: Die Datenlage ist viel zu ungenau: Die Problematik der Temperaturrekonstruktion Eine beispielhafte Sichtung dazu anhand des Projektes PAGES 2k

Nach den vielen erschütternden Kampfberichten zum Abschluss noch ein Bild, welches belegen könnte, dass ein Wandel des Klimas doch mit der Industrialisierung angefangen hat. Etwas weiter gesponnen, könnten weitsichtige Neubürger belegen, dass die nächste Eiszeit bald kommen wird.

Bild 7 Bildquelle: Klimanotizen.de

Quellen

[1]

Klimafakten.de 18.08.2016: "Wir sind im Krieg. Gegen den Klimawandel"

https://www.klimafakten.de/meldung/wir-sind-im-krieg-gegen-den-klimawandel

[2]

Frankfurter Rundschau: Regierung empfiehlt Notvorrat

http://www.fr-online.de/panorama/sicherheit–regierung-empfiehlt-notvorrat-,1472782,34657538.html

[3]

NEW REPUBLIC: A WORLD AT WAR

https://newrepublic.com/article/135684/declare-war-climate-change-mobilize-wwii

[4]

ze.tt: Umweltaktivist Bill McKibben im Interview: „Der Kampf gegen die Ölfirmen geht weiter“

http://ze.tt/umweltaktivist-bill-mckibben-im-interview-der-kampf-gegen-die-oelfirmen-geht-weiter/

[5]

Klimaretter.Info 24. Oktober 2013: "Amerika steckt den Kopf in den Sand"

http://www.klimaretter.info/protest/hintergrund/14875-qamerika-steckt-den-kopf-in-den-sandq

[6]

Klimaretter.Info 03. Mai 2013: Klimawandel: Es geht um Mathematik

[7]

Kaltesonne, 29. August 2016: Nun wird es ernst: Kanzlerinnenberater Schellnhuber fordert bedingungslose Zerstörung der fossilen Brennstoffindustrie

http://www.kaltesonne.de/nun-wird-es-ernst-kanzlerinnenberater-schellnhuber-fordert-bedingungslose-zerstorung-der-fossilen-brennstoffindustrie/

[8]

ZEIT ONLINE 29. Januar 2016: Zika-Virus: Das Märchen von den 4.000 geschädigten Babys

http://www.zeit.de/wissen/gesundheit/2016-01/zika-virus-who-gesundheitsnotfall-angst/komplettansicht

[9]

SPIEGEL ONLINE 11.05.2016: Katastrophe in Kanada: Die Mär von den Klimawandel-Waldbränden

http://www.spiegel.de/wissenschaft/natur/kanada-werden-waldbraende-vom-klimawandel-ausgeloest-a-1091833.html

[10]

Climate Central 2015: THE AGE OF ALASKAN WILDFIRES

[11]

EIKE 21.11.2015: Die bayerische Umweltministerin Frau Scharf: Extremwetter, Extrem-Hochwasser und die Unberechenbarkeit des Wetters nehmen zu. Doch stimmt das wirklich?

http://www.eike-klima-energie.eu/news-cache/die-bayerische-umweltministerin-frau-scharf-extremwetter-extrem-hochwasser-und-die-unberechenbarkeit-des-wetters-nehmen-zu-doch-stimmt-das-wirklich/

[12]

Quelle der Übersetzungen: EIKE 09.12.2015: Pinocchiopresse? Lügenpresse? Die deutschen Medien und ihre "Klimakatastrophen"

http://eike-klima-energie.eu/climategate-anzeige/pinocchiopresse-luegenpresse-die-deutschen-medien-und-ihre-klimakatastrophen/

[13]

IPCC AR5 Langfassung: Fifth Assessment Report CLIMATE CHANGE 2013 The Physical Science Basis

http://www.climatechange2013.org/images/report/WG1AR5_ALL_FINAL.pdf

[14]

US National Interagency Coordination Center Wildland Fire Summary and Statistics Annual Report 2015 http://www.nifc.gov/fireInfo/nfn.htm

[15]

EIKE 14.09.2016: Frau Hendricks glaubt im Klimawahn, Klimapäpstin geworden zu sein und den Irrglauben ihrer Bürger verdammen zu dürfen Zu ihrem Gastbeitrag „Weit verbreiteter Irrglaube“ im Handelsblatt[1]

http://www.eike-klima-energie.eu/news-cache/stop-es-kommt-aenderung-frau-hendricks-glaubt-im-klimawahn-klimapaepstin-geworden-zu-sein-und-den-irrglauben-ihrer-buerger-verdammen-zu-duerfen-zu-ihrem-gastbeitrag-weit-verbreiteter-irrglaube-im-handelsblatt1/#postentry