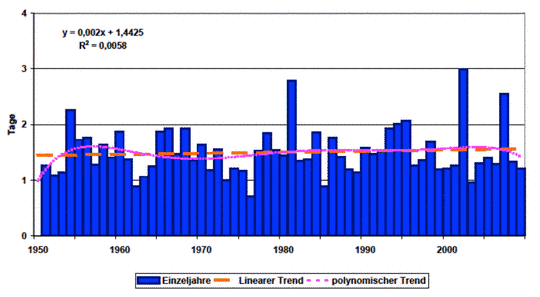

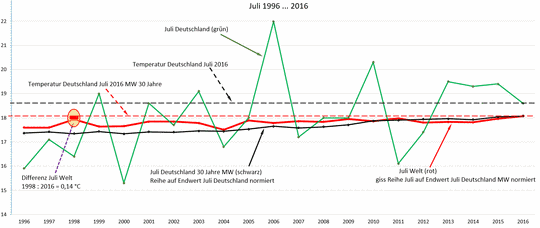

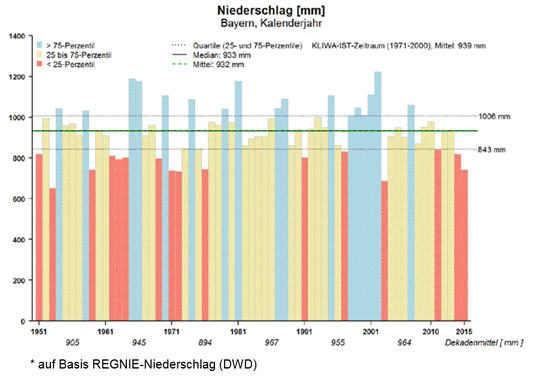

Kapitel: Anzahl der Eistage

Gezeigt wird in der Klimainformation Bild 21.

(Aus der Klimainformation) Bild 21 [1] Bildtext: An der Graphik lässt sich seit 1950 eine Tendenz zur Abnahme der Anzahl der Eistage pro Jahr ablesen. Jedoch ist die Abnahme der mittleren Anzahl der Eistage von ca. 27 Tagen pro Jahr auf aktuell etwa 21 Tage pro Jahr nicht statistisch nachweisbar.

Eine Analyse erspart sich der Autor, bis auf die Anmerkung, dass es bei der enormen Streuung praktisch nicht möglich ist, einen wahren Trend zu ermitteln, schon gar nicht über die letzten 20 Jahre. In diesen 20 Jahren war der Stand jedenfalls nicht anders als zwischen 1950 bis 1975. Entsprechend steht auch als Erklärungstext, dass keine statistisch belegbare Tendenz vorliegt.

Man muss sich das einmal klar machen. Selbst 50 Jahre reichen nicht aus, um einen Klimawandel-Einfluss belegen zu können. Aber Minister wissen, dass dieser in Deutschland „… schneller voran schreitet, als bisher angenommen“ [22].

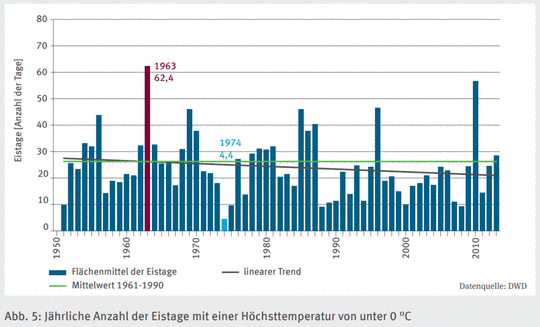

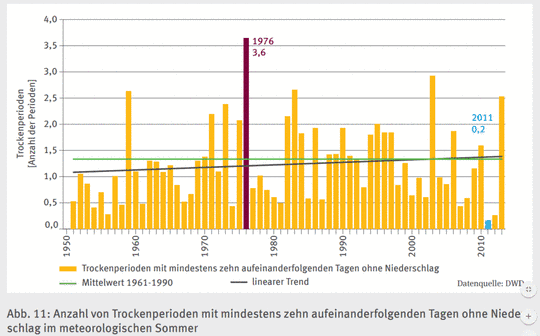

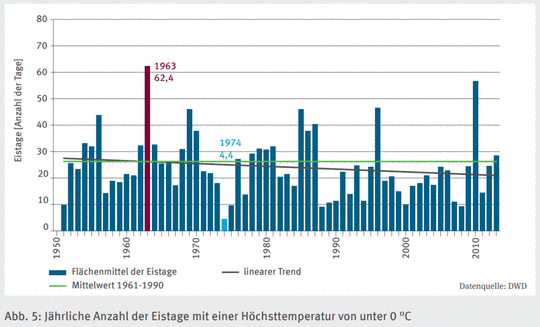

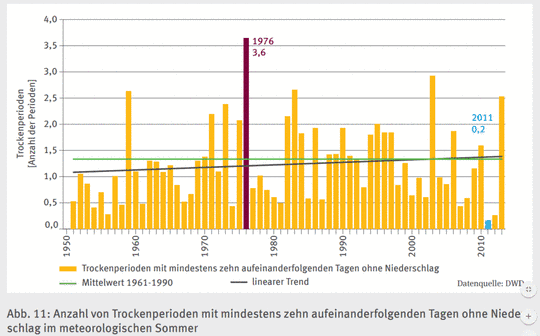

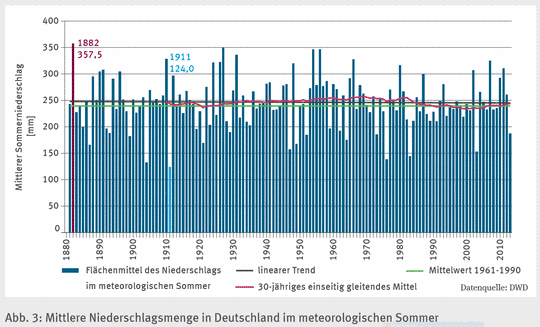

Kapitel: Veränderung von Trockenperioden im meteorologischen Sommer

Gezeigt wird in der Klimainformation Bild 19.

(Aus der Klimainformation) Bild 22 [1] Bildtext: … Aus diesem Grund und wegen der hohen Schwankungen von Jahr zu Jahr sowie ausgeprägter natürlicher Schwankungen können keine statistisch gesicherten Aussagen getroffen werden.

Sichtung: Veränderung von Trockenperioden im meteorologischen Sommer

Nicht einmal die Trockenheit lässt einen belegbaren Einfluss eines Klimawandels erkennen, wie die Grafik (Bild 22) zeigt.

Ergänzende Information zu Trockenperioden

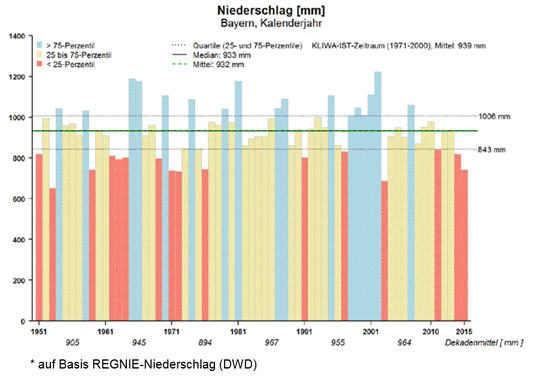

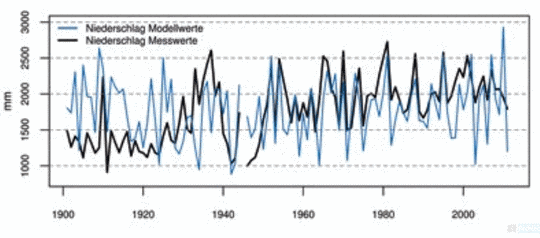

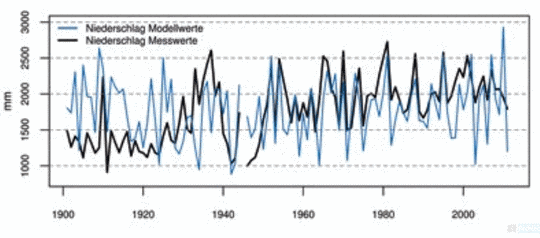

Nun kann man sagen, der Extremsommer 2015 fehlt und deshalb ist die Darstellung (Bild 22) „verzerrt“ (was aber der Wissenschaftliche Dienst zu vertreten hätte). Deshalb dazu ein aktuelles Bild aus dem Hitze- und Trockenheits-gebeuteltem Süden (Bild 23). Selbst das extrem-Trockenjahr 2015 war im Vergleich in Bayern bei weitem nicht das Schlimmste. Und vor allem lässt sich außer starken Schwankungen kein langfristiger Trend zu mehr Trockenheit ableiten.

Bild 23 [8] Niederschlag in Bayern von 1951 bis 2015

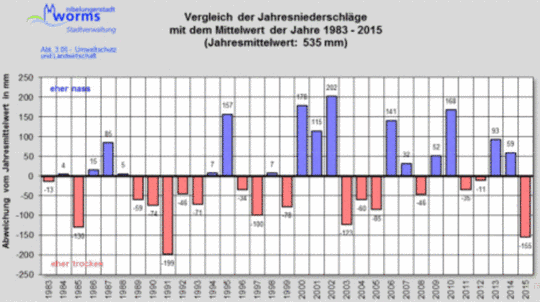

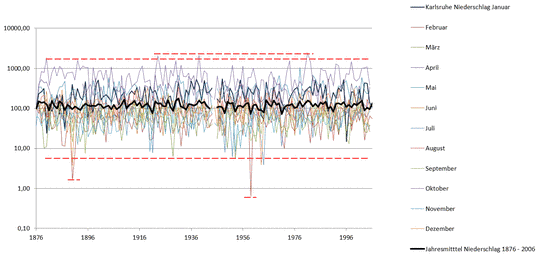

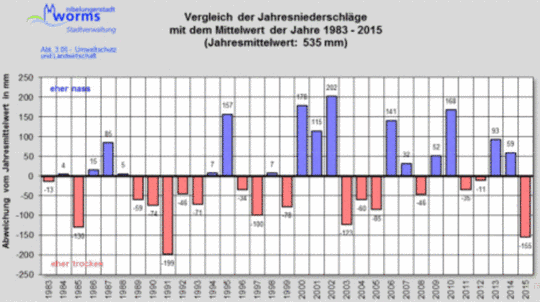

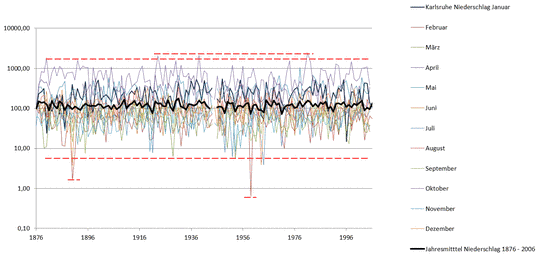

Ergänzend eine Darstellung der Niederschläge Messtelle Stadt Worms. Auch hier starke Streuungen, aber definitiv kein Trend oder Hinweis auf neue Extreme. Wie in Bayern war auch dort das Trockenjahr 2015 kein neuer Extremwert. Für Karlsruhe zeigt sich ein ähnliches Bild. Die Extreme waren alle vor dem „schlimmen“ Klimawandel.

Bild 24 Niederschlag Stadt Worms von 1983 – 2015. Quelle: Stadt Worms 2016: Konzept zur Anpassung an den Klimawandel

Bild 25 Niederschlag Stadt Karlsruhe von 1976 – 2006. Quelle: DWD

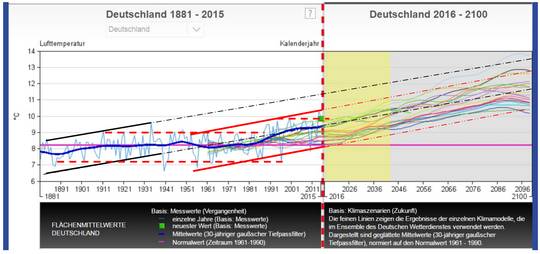

Kapitel: Hochwasser

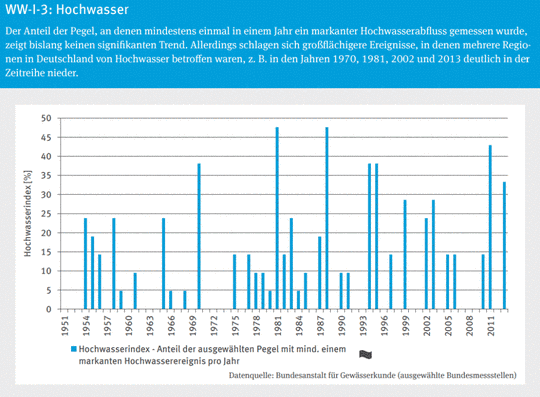

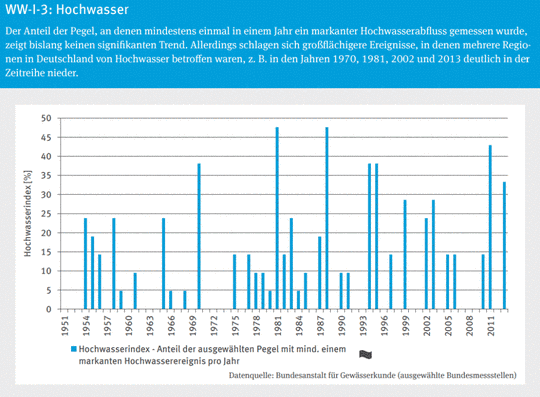

Und wieder eine Kopie aus dem UBA Monitoringbericht.

Klimainformation Bild 26 [1] Bildtext (Auszug): Obwohl es im Betrachtungszeitraum mehrfach großflächige Hochwasserereignisse gegeben hat, ist kein signifikanter Trend abzulesen.

Sichtung und ergänzende Information zum Kapitel: Hochwasser

Die in der Klimainformation gezeigte Grafik zeigt eigentlich schon alles: Keine Zunahme von Hochwasser!

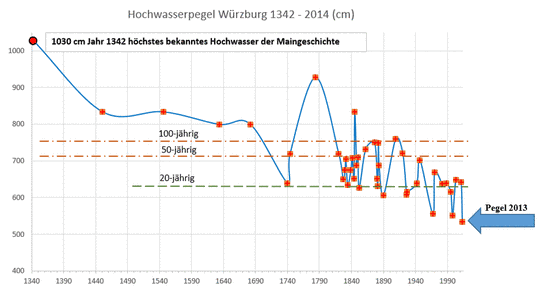

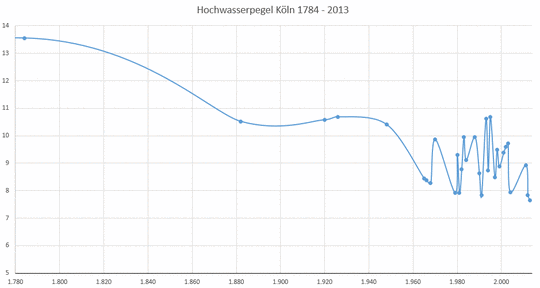

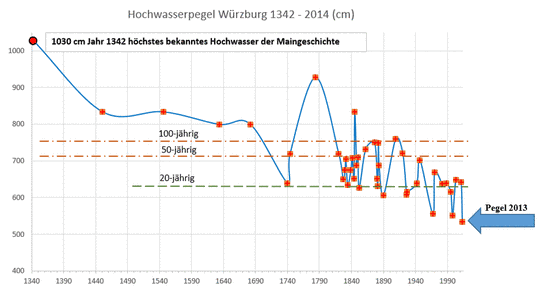

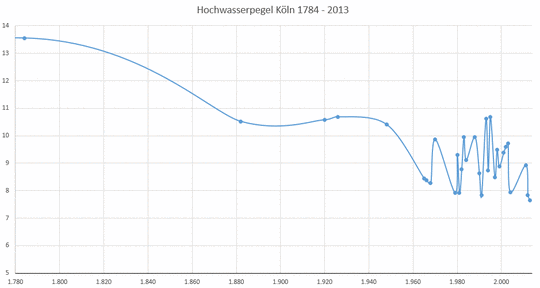

Und gerade Hochwasser sind ein ganz schlechtes Beispiel, um einen Klimawandel belegen zu wollen. Denn wie jeder Interessierte weiss, waren Hochwasserereignisse nur in der angeblich „goldenen, vor-CO2-Zeit“ wirklich extrem[11]. Was Deutschland derzeit erlebt, ist dagegen praktisch „vernachlässigbar“. Und die aktuellen Hochwasser zum letzten Mai / Juni-Übergang waren niemals dem Klimawandel geschuldet, wie einmal Bild 13 (Teil 1) anhand der niedrigen Temperaturen zeigt und vor allem die Ursachenanalysen [13][14]:

Es stimmt eben nicht so einfach: Mehr Hitze = mehr Feuchte = mehr Niederschlag. Dann müsste es in der Sahara dauernd regnen.

Bild 27[11] Hochwassermarken des Mains bei Würzburg seit dem Mittelalter bis 2013

Bild 28 [11] Hochwasserpegel Köln 1784 – 2013 lt. Daten der Stadtentwässerungsbetriebe Köln AöR (Grafik vom Autor erstellt). Y-Achse: Rheinpegel (m)

Klar, dass die Grünen auf solche Fakten keine Rücksicht nehmen [13], man braucht ja nur auf „Experten“ verweisen.

Bündnis 90 / Die Grünen: Hochwasserschutz und Ursachenbekämpfung

… Die Experten sind sich darüber einig, dass die aktuellen Wetterphänomene in großen Teilen auf die Klimaüberhitzung zurückzuführen sind. Deshalb sind Maßnahmen zur Begrenzung der Klimaüberhitzung die wichtigste politische Konsequenz.„Wir müssen die Klimaüberhitzung stoppen und den CO2-Ausstoß massiv reduzieren… „

Fazit zum Kapitel Hochwasser

Warum steht in der Klimainformation „Obwohl es im Betrachtungszeitraum mehrfach großflächige Hochwasserereignisse gegeben hat, ist kein signifikanter Trend abzulesen“ und nicht richtiger: Die letzten 20 Jahre gab es keine Erhöhung Klimawandel-zuordenbarer Hochwasser und im langfristigen Vergleich liegen die Hochwasserpegel von wenigen Ausnahmen abgesehen an den untersten, je gemessenen Werten.

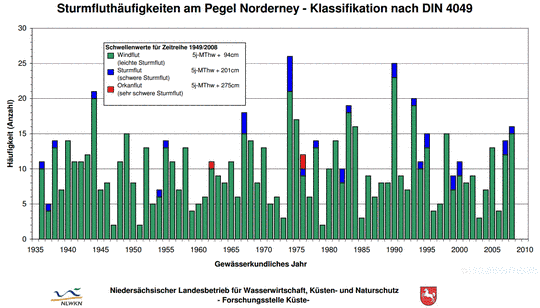

Kapitel: Sturmfluten

Wieder nur ein Bild aus dem UBA Monitoringbericht.

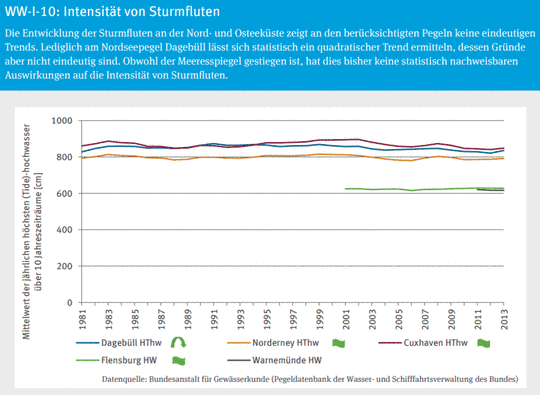

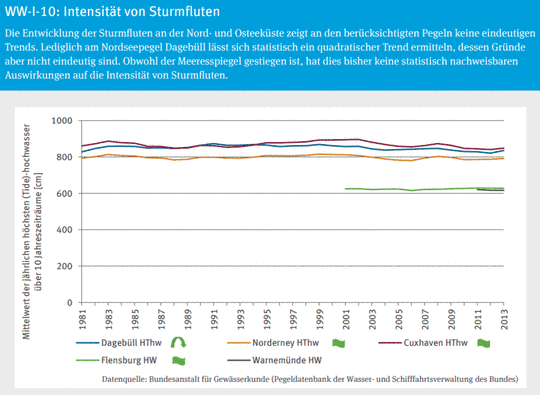

(Aus der Klimainformation) Bild 29 [1] Bildtext (Auszug): Anhand der ausgewerteten Pegel lässt sich weder für die Nordsee- noch für die Ostseeküste ein eindeutiger Trend ablesen.

Sichtung Kapitel: Sturmfluten

Der Bildtext (Bild 29) umschreibt statistisch verbrämt, was man nicht sagen will oder darf: Der Küstenpegel an Deutschlands Küsten hat sich seit 1981 nicht im Geringsten erhöht. Und selbstverständlich zeigt das Bild einen eindeutigen, signifikanten Trend: Eine horizontale Gerade.

Dass dort zur Grafik (Bild 29) weiter steht:

[25] Aus der Darstellung auf Basis gleitender 10-Jahresmittelwerte sind extreme Einzelereignisse nicht abzulesen. …

Über die gesamte Zeitreihe betrachtet lässt sich für die ausgewählten Pegel bisher kein Trend ableiten.

… wurde für die Abgeordneten als Information nicht mehr übernommen. Und dass im blauen Feld steht: „ … Obwohl der Meeresspiegel gestiegen ist, hat das bisher keine statistisch nachweisbare Auswirkung auf die Intensität von Sturmfluten“ muss jeder Abgeordnete dort selbst nachlesen.

Ergänzende Information zum Thema Sturmfluten

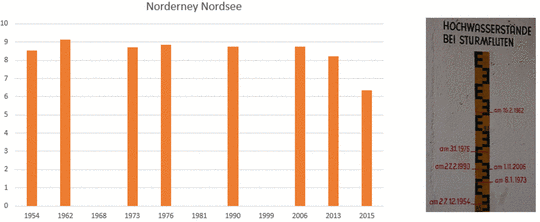

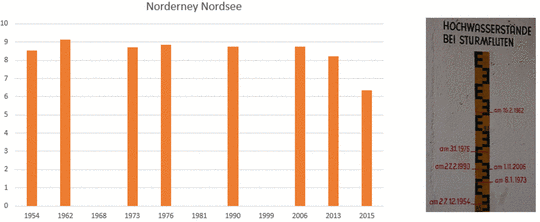

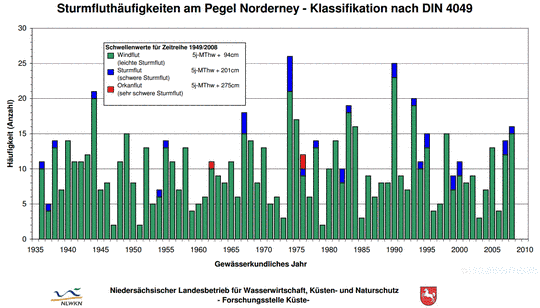

Anbei die Flutmarken von Norderney, aus einem Pegelfoto (und Zusatzangaben) umgesetzt. Es ist kein steigender Klima-Trend vorhanden. Gleiches gilt für die Sturmflut-Häufigkeit.

Bild 30 Sturmflut-Pegelmarken von Norderney 1954 – 2006 / 2015. Vom Autor anhand der Daten des Pegelfotos umgesetzt. Die Daten zum Jahr 2013 / 2015 stammen von der Pensions-Homepage, Haus Seeadler (Norderney)

Bild 31 Sturmfluthäufigkeit am Pegel Norderney

Und dazu die Information des Niedersächsischen Ministeriums für Umwelt Energie und Klimaschutz, Rubrik: Gezeiten, Strömung und Seegang

Der derzeitige Anstieg des mittleren Tidehochwassers (Mittelwert der Hochwasserstände der Tiden in einem Zeitraum) an der niedersächsischen Küste beträgt etwa 25 Zentimeter in 100 Jahren (Abb. 2). Eine Beschleunigung dieses Anstiegs, wie sie bedingt durch die Klimaänderungen (siehe Kapitel 1.1.1.2) zum Teil erwartet wird, lässt sich aus den vorliegenden Pegelbeobachtungen über die letzten 120 Jahre derzeit nicht ableiten. Ebenso wenig kann zurzeit anhand der erfassten Wasserstände an den Pegeln der Nordseeküste eine Zunahme der Sturmfluten (Abb. 3) durch Klimaänderungen belegt werden (Abb. 4).

Den Grünen ist auch das bisher noch nicht aufgefallen, bzw. sie haben noch nie nachgesehen, wie die wahre Natur und ihre Ideologie auseinander driften und es gar keine „Häufigere und intensivere Hochwasserereignisse“ gibt. Wenn es die wahre Natur nicht „hergibt“, kann man es „bei Grün“ trotzdem als Märchen erzählen:

Bundestagsfraktion von Bündnis 90 / Die Grünen 2015[15]

Aber man soll nicht immer nur auf die Grünen einschlagen. Die Umweltminister(-innen) der Regierungsparteien sind keine Spur besser [14].

Auf der Regierungshomepage steht im Kapitel: Kampf gegen Erderwärmung

Stand 26. Februar 2015: Dauerregen und Sturmfluten nehmen zu

Als Beleg wird die Information der Versicherungswirtschaft angezogen: Der Gesamtverband der Deutschen Versicherungswirtschaft warnt schon länger vor einer Häufung von Wetterkatastrophen in den nächsten Jahrzehnten.

In der ehemaligen DDR dürfte die Informationswahrheit nicht weit weg von der unserer aktuellen Regierung gelegen haben.

Und wie damals gilt, was oben verkündet wird, hat unten Wahrheit zu sein:

Kapitel: Kampf gegen Erderwärmung: „Bundeskanzlerin Angela Merkel bezeichnete das Eindämmen des Klimawandels als gesamtgesellschaftlich zentrale Herausforderung“.

Kapitel: Aktuelle Abweichungen von den Normalwerten 1961-1990 und mögliche Szenarien des zukünftigen Klimas in Deutschland im Deutschen Klimaatlas

Gezeigt werden in Folge fast nur noch Bilder aus der Vulnerabilitätsstudie. In diesem Kapitel werden wegen der vielen verschiedenen Teilthemen Listung und Sichtung nebeneinander durchgeführt.

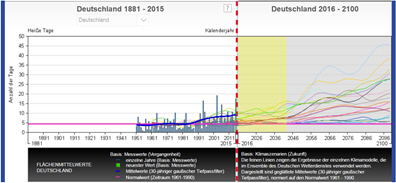

Teil: Heiße Tage und Eistage

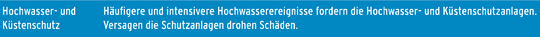

(Aus der Klimainformation) Bild 32 [1] Bildtext (Auszug): Es ist vor allem ab Beginn der 1980er Jahre eine signifikante Erhöhung der Anzahl der heißen Tage bis zum Jahr 2015 ablesbar. Die Klimasimulation im rechten Teil der Abbildung lässt für die Zukunft einen weiteren sehr starken Temperaturanstieg erwarten.

Anmerkung des Autors: Alle Temperaturkurven zeigen, dass Mittelwert und Extremwerte überhaupt nicht miteinander korrelieren (siehe dazu auch Bild 10 und 11 im Teil 1). In „Das Phänomen der „Temperaturstufen“ [12] wurde es gezeigt. Es ist deshalb einfach vermessen (und in einem vorhergehenden Kapitel bereits ausgeführt), aus dem kurzen, stark schwankenden Verlauf „der Anzahl heißer Tage“ einen „weiteren, sehr starken Temperaturanstieg“ abzuleiten.

(Aus der Klimainformation) Bild 33 [1] Bildtext: Es ist eine seit 1951 abnehmende Anzahl der Eistage bis zum Jahr 2015 ablesbar. Die Klimasimulation im rechten Teil der Abbildung lässt für die Zukunft eine weitere deutliche Abnahme der Anzahl von Eistagen erwarten.

Anscheinend hat der Wissenschaftliche Dienst es nun aufgegeben, nach einem Klimawandeleinfluss zu suchen. In dem Fall hilft immer die Simulation. Und dafür gibt es inzwischen den Vulnerabilitätsatlas Deutschland. Obwohl dieser ein Lehrbeispiel für falsch angewandte Mathematik ist „Rezension: UBA Studie 24/2015 Die Vulnerabilität Deutschlands gegenüber dem Klimawandel“[9], wird er überall angezogen, wenn man die Zukunft belegen will.

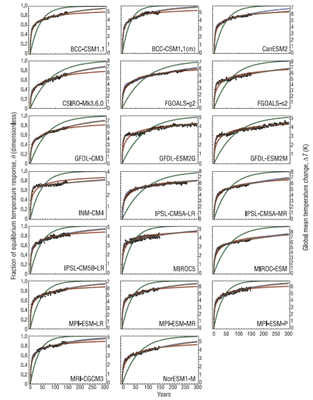

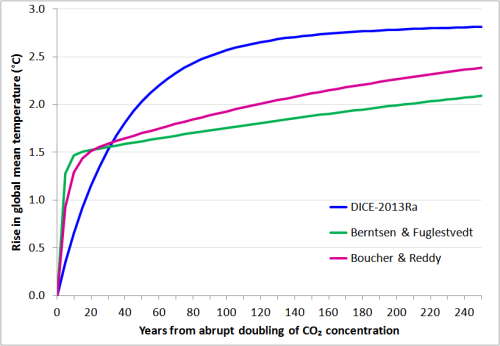

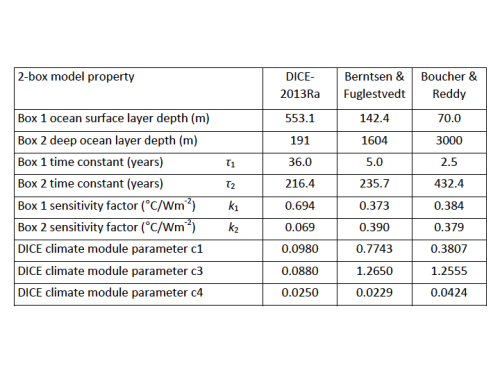

Erschreckend ist, dass es überhaupt niemanden stört (auch einen Wissenschaftlichen Dienst nicht), wenn man in den Simulationskurven deutlich sieht, dass bereits die aktuelle Wirklichkeit von den 21 Klimamodellen im Wesentlichen vollkommen falsch abgebildet wird und diese daraus in die Zukunft teils nur noch wirre Oszillationen schreiben. Auch stellt sich immer neu die entscheidende Frage: Welches der 21 Modelle liefert nun das richtige Ergebnis? Mitteln geht nicht, da die Modelle statistisch nicht ausreichend voneinander unabhängig sind. Und mit welchen Daten will man diese kalibrieren? Je genauer man hinschaut, umso deutlicher stellt man fest, dass die Vergangenheit für die Simulation der Zukunft viel zu ungenau messtechnisch erfasst ist.

Fazit: Aufgrund ungenau bekannter Vergangenheiten und grottenschlecht aktuell getroffener Werte genau die Zukunft simulieren zu wollen, kann nicht funktionieren. Den meisten Kurven sieht man das auch direkt an (und viele schlimmere wurden gar nicht erst in die Grafiken übernommen). Siehe dazu auch einen Beitrag auf kaltesonne: „Stimmungsumschwung in Sachen Klimamodelle: Das Vertrauen der Fachwelt schwindet“

Gerade beim Bild 33 hat man den Eindruck, dass die Simulationen – welche bereits aktuell drastische Fehlwerte aufweisen – einer (vielleicht unbewussten) Vorgabe folgen. Ist es wirklich wahrscheinlich, dass die künftigen Winter keinen Frost mehr kennen werden?

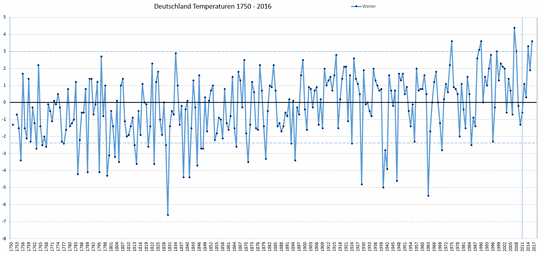

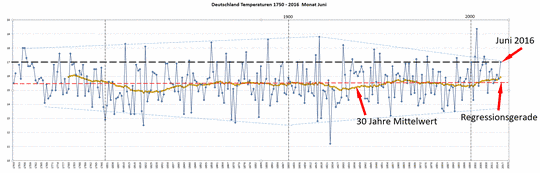

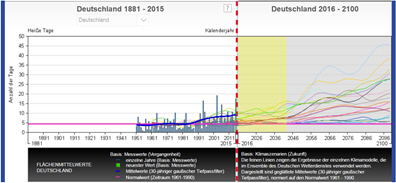

Es mag sein, dass eine Kurve welche im Jahr 1961 beginnt dies „nahelegt“, obwohl es im Jahr 1975 die wenigsten Eistage gab. Betrachtet man jedoch den langfristigen Verlauf der Wintertemperaturen (Bild 34), erscheint es eher unwahrscheinlich. Bisher fand die Temperatur auch nach wärmeren Abschnitten immer wieder zur Kälte zurück. Was man jedoch deutlich erkennt ist, dass seit in Deutschland fast jeder Zentralheizung hat und im Winter konsequent gegen die Kälte „gegenheizt“ wird (und die Urbanisation großflächig zu nimmt), die Temperatur scheinbar nicht mehr so kalt wird. Das wäre dann aber wieder eher dem Wärmeinseleffekt, als dem CO2 geschuldet.

Bild 34 [4] Wintertemperatur Deutschland von 1750 – 2016. Quelle WIKIPEDIA (Grafik vom Autor aus den Daten erstellt)

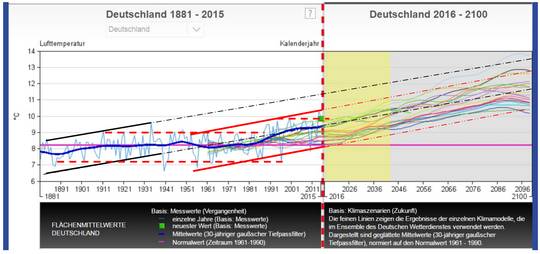

Lufttemperatur

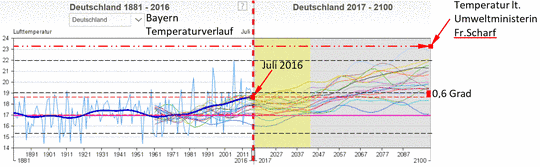

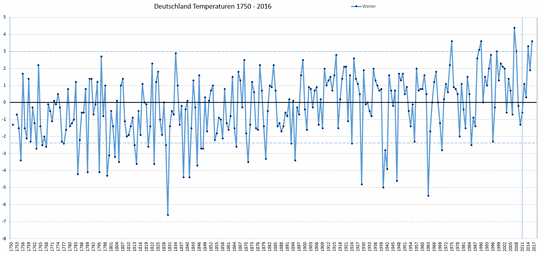

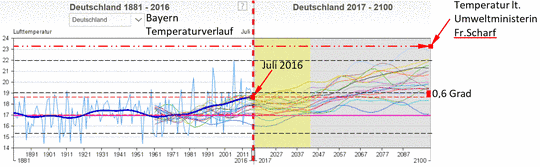

(Aus der Klimainformation) Bild 35 [1] Lufttemperaturen Deutschland.

Bildtext: Es ist seit 1881 eine deutliche Erhöhung der Lufttemperatur bis zum Jahr 2015 ablesbar. Die Mitteltemperatur ist in Deutschland seit 1881 um etwa 1,4 °C gestiegen44. Die Klimasimulation im rechten Teil der Abbildung lässt für die Zukunft einen weiteren signifikanten Temperaturanstieg erwarten.

Zeichnet man in das Bild 35 Verlaufslinien, dann sieht man, wie wenig sich die Temperatur linear verhält. Sie verläuft zwar in Trendkanälen, ändert diese aber auch schnell wieder. Bei den Simulationen hat man den Eindruck, dass sie davon nichts „wüssten“. Schon jetzt, wo noch durch „Kalibrierungen“ drastisch in die Simulationsverläufe eingegriffen wird, treffen die meisten Simulationskurven die Temperaturwerte nicht. Jedenfalls bezweifelt der Autor stark, dass die Temperatur wie simuliert nun „ewig“ im aktuell schon nicht mehr gut zutreffenden Trendkanal verbleiben würde.

Bild 36 [1] Lufttemperaturen Deutschland (Bild 35), vom Autor um schwarze und rote Verlaufslinien ergänzt.

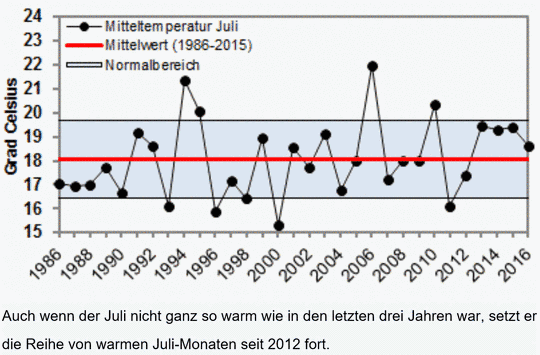

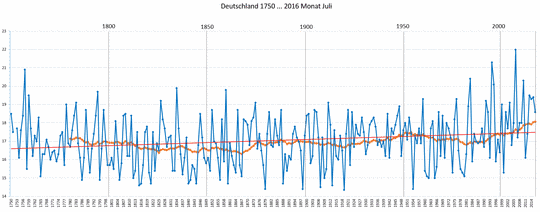

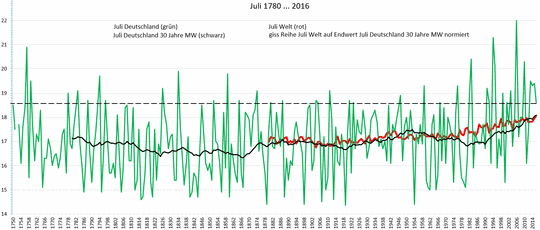

Ergänzende Informationen zu Temperatur und Hitze

Im Klimaatlas Deutschland sind aktuelle Daten auch für Bundesländer verfügbar. Deshalb die vom Monat Juli in Bayern (Bild 37). Die Temperatur in diesem angeblich besonders vom Klimawandel betroffenen Bundesland lag im heißen Monat Juli 2016 auf dem Niveau wie vor über 100 Jahren und liegt wieder am Trendkanal der letzten hundert Jahre. Die Simulationen zeigen aktuell eine Spanne von ca. 2,8 Grad und vor allem, dass fast alle Simulationen bereits aktuell schon deutlich bis extrem vom Messwert abweichen, wobei die Spanne ca. das 5-Fache der angeblich zulässigen, restlichen 0,6 Grad Temperaturerhöhung beträgt. Mit dieser extremen Start-Ungenauigkeit trotz Kalibrierung werden die nächsten 100 Jahre simuliert. Um das Problem zu zeigen, die Grafik für Bayern.

Bild 37 Lufttemperaturen Monat Juli Bayern von 1881 – 2016. Vom Autor um Linien ergänzt. Quelle: DWD Deutscher Klimaatlas

Diese Grafik (Bild 37) beruhigt: Nur wenige der vielen Simulationen weisen im Jahr 2100 einen höheren Temperaturwert aus als er bereits vorkam und damit schon belegbar überlebt wurde. Ansonsten liegen alle Simulationen im schon „erlebten“ Korridor. Die Simulationsspanne im Jahr 2100 überstreicht einen Temperaturbereich von ca. 3,6 Grad. Es kann somit wärmer, kälter, oder gleich werden. Eigentlich kann man sich problemlos jede Wunschtemperatur aussuchen. Zumindest Bayern kann den kommenden 100 Jahren damit (simuliert) vollkommen sorgenfrei entgegensehen. Es würde nicht wundern, wenn die CSU im nächsten Wahlk(r)ampf behauptet, das wäre alleine ihr Verdienst. Dem steht jedoch das mangelnde Wissen ihrer Umweltministerin im Weg[14][11].

Bayerns Umweltministerin ist überzeugt, dass Bayern bis zum Jahr 2100 um 4,5 Grad wärmer wird, sofern man nicht sofort CO2 reduziert. Zwar kommen nur wenige der ca. 20 Simulationsläufe überhaupt in diese Temperaturnähe. Doch eine Klimafachkraft mit der Ausbildung Kauffrau kann dieses simulierte Restrisiko welches ihr wohl von einer „Klima-Simulationsfachkraft“ berichtet wurde für Bayerns Bürger selbstverständlich nicht eingehen:

Bayerischer Landtag 2. Dezember 2015: Umweltministerin Ulrike Scharf zeichnete in ihrer Regierungserklärung zur bayerischen Klimapolitik ein dramatisches Bild: Danach droht laut einer neuen Prognose noch in diesem Jahrhundert im Freistaat ein Temperaturanstieg um bis zu 4,5 Grad Celsius. … Die bayerische Staatsregierung, so Scharf, unterstütze das Ziel einer kohlenstoff-freien Weltwirtschaft.

SPD, Freien Wählern und Grünen war das noch zu wenig Dramatik, womit sich mangelndes Wissen zu „die am wenigsten Unwissende“ positiviert. Es wird damit allerdings wohl weniger ein Klimaalarm aufgedeckt, als die Zurschaustellung der Oppositionsproblematik in Bayern. Wenn die CSU nichts weiß, toppt es die Opposition.

Informativ sind im Bild 37 auch die 0,6 Grad Temperaturerhöhung eingezeichnet, um die sich nach dem Klimagipfel-Beschluss von 2015 die Welttemperatur bis zum Jahr 2100 maximal erhöhen darf, damit die Erde nicht Klima-kollabiert. Jeder sollt sich selbst fragen, ob dieser Grenzwert sinnvoll sein kann und wie Simulationen, welche nicht einmal Bayern aktuell genauer als mit 2,8 Grad Fehlerspanne abbilden können, für die gesamte Erde „wissen“, dass +0,6 Grad in 100 Jahren diese unumkehrbar „zum Kippen“ bringen.

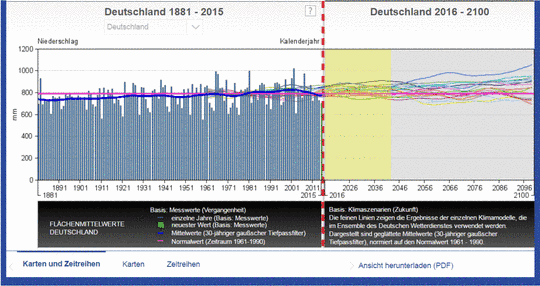

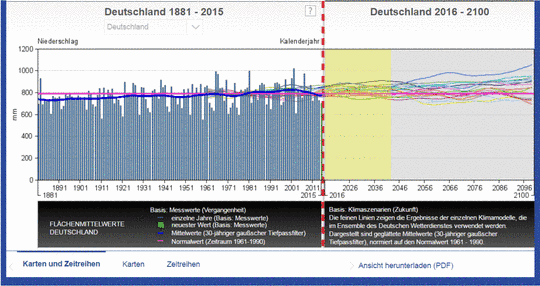

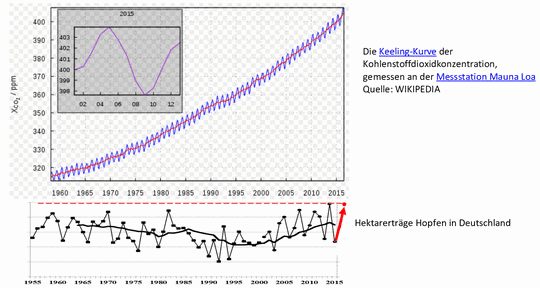

Niederschlag

(Aus der Klimainformation) Bild 38 [1] Bildtext: Im Jahr 2015 fiel weniger Niederschlag als im Vergleichszeitraum 1881-2015, insgesamt hat die Niederschlagsmenge seit 1881 jedoch um gut 10 % zugenommen. Die Klimasimulation im rechten unteren Teil der Abbildung lässt für die Zukunft einen weiteren leichten Anstieg der Niederschlagsmengen erwarten.

Sichtung Niederschlag mit Zusatzinformation

Was sagt eine ganz aktuelle Untersuchung des DWD zum Niederschlag:

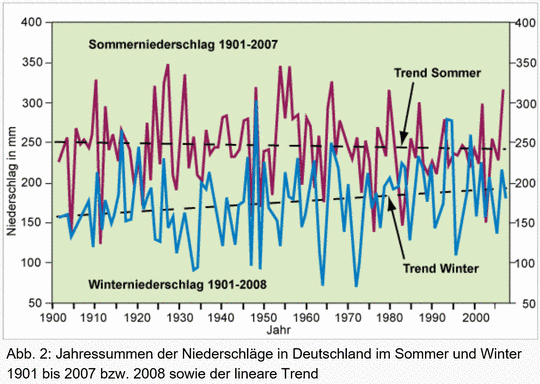

Winterhalbjahr:

[10] Sowohl für den meteorologischen als auch den hydrologischen Winter ist die Häufigkeit hoher täglicher Regenmengen demnach im Verlaufe des Untersuchungszeitraums um rund 25% angestiegen (vgl. Abb. 1). Dabei unterscheidet sich die Entwicklung in den einzelnen Regionen Deutschlands nur unwesentlich voneinander. In beiden Fällen, insbesondere aber für die meteorologischen Wintermonate, lässt sich jedoch nicht mit letzter Sicherheit sagen, inwieweit der beobachtete Anstieg auf die natürliche Klimavariabilität zurückzuführen ist. Für eine solche Differenzierung reicht selbst die Länge dieser Zeitreihen nicht aus.

Sommerhalbjahr:

[10] Für den Sommer (meteorologisch sowie hydrologisch) lassen sich dagegen praktisch keine Trends identifizieren. Hier dominieren kurz- und längerfristige zyklische Variabilitäten. Zudem verlief die Starkniederschlagsentwicklung seit 1951 in den einzelnen Regionen sehr unterschiedlich, wodurch das indifferente Gesamtbild zu dieser Jahreszeit noch weiter verstärkt wird. Lediglich für den hydrologischen Sommer3 und den höchsten ausgewerteten Schwellenwert ist für die Südhälfte Deutschlands eine leichte Zunahme erkennbar.

[10]Für kürzere Dauerstufen von weniger als 24 Stunden liegen konkret für das Gebiet von Deutschland bislang noch recht wenige Erkenntnisse zum Trendverhalten von Starkniederschlägen vor

Gemäß erster Ergebnisse einer aktuellen Untersuchung dieser Daten weisen die hohen Niederschlagsschwellen10 der Dauerstufe 60 Minuten während der Monate Mai bis September in den meisten Regionen Deutschlands im Zeitraum 1965 bis 2015 häufiger einen negativen als einen positiven Trend auf. Allerdings unterscheidet sich die Anzahl der Stationen mit einem Rückgang der Starkniederschläge zumeist nicht markant von der Anzahl der Stationen mit einer Zunahme.

[10] Fazit

Die Häufigkeit von Starkniederschlägen der Dauerstufe 24 Stunden hat in Deutschland in den vergangenen 65 Jahren im Winter bereits um rund 25% zugenommen. Gemäß den Projektionen regionaler Klimamodelle ist davon auszugehen, dass sich dieser Anstieg bis zum Jahre 2100 in etwa der gleichen Größenordnung weiter fortsetzen wird. Für die Sommermonate ist dagegen bislang kein eindeutiger Trend auszumachen. Bezüglich der Intensität der Starkniederschläge auf dieser Zeitskala gilt grundsätzlich Ähnliches.

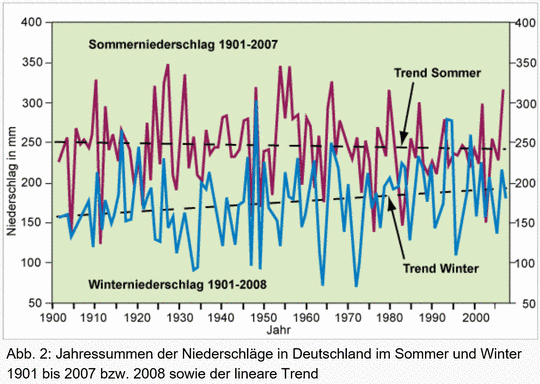

Bild 39 hilft zur Erklärung. Wenn man genauer hinsieht, könnte man sagen, dass es im Sommer sowieso nicht, aber auch im Winter keinen wirklichen Trend gibt, wie es laut dem Klimawandel überall publiziert wird. Aber Computer-Statistik ist unerbittlich. Irgend ein Trend lässt sich trotz größter Streuungen rein numerisch immer berechnen, der Rest ist dann der Glaube daran.

Bild 39[16] Sommer- und Winterniederschlag von 1901 – 2007

Wenn man bedenkt, dass sich die Niederschlagsmenge Deutschlands seit 1881 lediglich um 10 % verändert haben soll, ist der Einfluss eines Klimawandels schon fast auszuschließen, beziehungsweise nicht nachweisbar. Denn 10 % Änderung in diesem Zeitraum dürften weit unter der globalen Mess-Unsicherheit dieser langen Reihe liegen. Und ausgerechnet die kurzen, aber extremen Niederschläge (welchen angeblich zu den jüngsten Überschwemmungen geführt haben) nehmen laut dem DWD im Sommerhalbjahr eher ab.

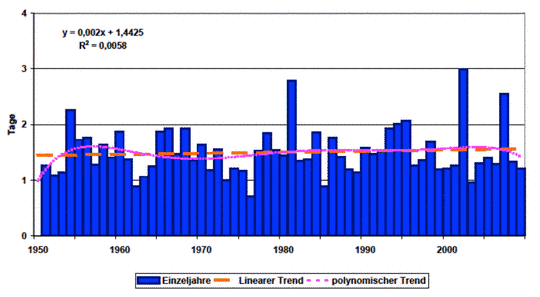

Bleibt noch ein Blick auf die angeblich steigenden Extremniederschläge (Bild 40). Seit dem Beginn der Grafik um 1950 ist keine Änderung und auf gar keinen Fall eine Klimawandel-bedingte Erhöhung sichtbar.

Bild 40[23] Anzahl der Tage mit mindestens 30 mm Niederschlag pro Jahr für Deutschland lt. CSC

Fazit zum Niederschlag

Die Beschreibung lässt konsequent wichtige Detailinformationen weg, indem sie die Jahreszeit-Abhängigkeiten nicht detailliert. Damit erfährt niemand, dass die bisherigen Vorhersagen für mehr Starkniederschlag im Sommerhalbjahr nicht eingetroffen sind. Auch über die bekannten, wichtigen Bezüge zu den jüngsten Flutereignissen (nicht Klimawandel-bedingt) wird nicht informiert.

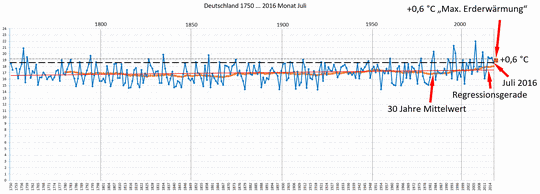

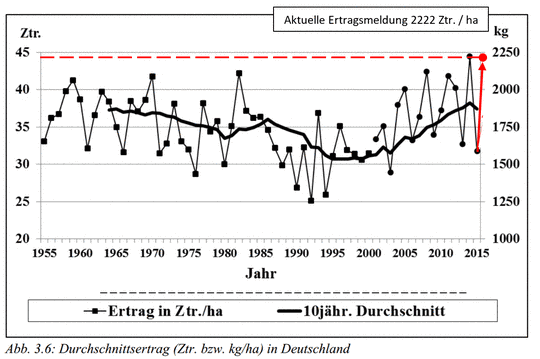

Zusatzinformation zur Niederschlagsmodellierung

Im Klimareport Bayern 2015 ist ein gutes Beispiel für die Ungenauigkeit von Niederschlagsmodellierungen gezeigt. Obwohl nicht global, sondern nur ein Ort simuliert wird, weichen Messergebnisse und Simulationswerte häufig stark voneinander ab und aktuell stimmt überhaupt nichts mehr. Zusätzlich musste eine „Biaskorrektur“ erfolgen. Es hat demnach nicht einmal der Mittelwert übereingestimmt. Wer behauptet bei solchen Fehlern wären aber die weiteren 100 Jahre „genau“ simulierbar, muss schon sehr Computergläubig sein. Aber die Vorschau kann man heute ja nicht überprüfen.

Bild 41 Vergleich Niederschlag Zugspitze, Messwerte und Modellierung. Quelle: Klimareport Bayern 2015 Abbildung 1

Dieses (beim Niederschlag besonders große) Simulationsproblem ist bekannt und wird etwas „entfernt“ von der Mainstream-Klimawissenschaft auch ganz leise diskutiert:

[29] NEUE STUDIE ZEIGT ERHEBLICHE DIFFERENZEN ZWISCHEN KLIMAARCHIVEN UND KLIMAMODELLEN – Das Klima der Erde scheint in den letzten 7000 Jahren sehr viel unbeständiger gewesen zu sein als bisher gedacht.

Über Zeiträume von Jahren und Jahrzehnten stimmten Mess- bzw. Klimaarchivdaten und Modellläufe recht gut überein. Doch je länger die Zeitskalen, desto größer wurde die Diskrepanz – am stärksten in tropischen Meeresregionen. Auf tausendjähriger Zeitskala unterschätzten gängige Klimamodelle die aus den Klimaarchiven rekonstruierten Schwankungen der Meeresoberflächentemperaturen um den Faktor 50.

„Theoretisch gibt es nun zwei denkbare Erklärungen“, so Thomas Laepple. „Entweder liefern die Klimaarchive keine verlässlichen Temperaturdaten, oder die Klimamodelle unterschätzen die Variabilität des Klimas. Vielleicht stimmt auch beides ein bisschen.“

Zusatzinformation: Klimamodelle rekonstruieren Niederschlagsentwicklungen nur mit gröbsten Fehlern

Klar, dass darüber in der Klimainformation nicht der kleinste Hinweis zu finden ist.

Kapitel: Übersichtskarte zu möglichen Handlungsfeldern eines Klimawandels in Deutschland

[1] Im Zusammenhang mit der Veröffentlichung einer Studie zur „Vulnerabilität Deutschlands gegenüber dem Klimawandel“ im November 2015 hat der Deutsche Wetterdienst auf seinen Internetseiten eine Karte veröffentlicht, die einen Überblick über die Folgen des Klimawandels in den einzelnen Regionen Deutschlands bietet und daraus resultierende Schäden, Veränderungen und Beeinträchtigungen prognostiziert.

Dieses Kapitel wird nicht rezensiert. Wer an eine „Vorhersagegenauigkeit“ von Klima-Simulationen die mit ungenauen Daten kalibriert sind glaubt, dem ist eigentlich nicht zu helfen. Leider ist diese Spezies jedoch häufig anzutreffen.

Basisparameter des anthropogenen Klimawandels

Dieses Kapitel fehlt in der Klimainformation, wirklich nirgendwo ist auch nur ein kleinster Hinweis dazu zu finden. Dabei geht es um die Frage, wie genau die angeblich sicheren Aussagen zum Klimawandel wirklich sind.

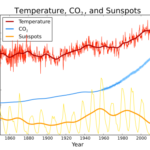

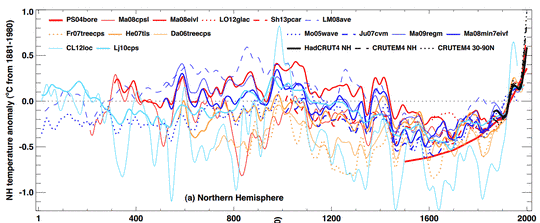

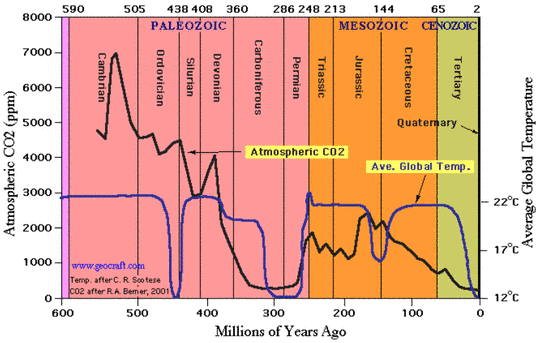

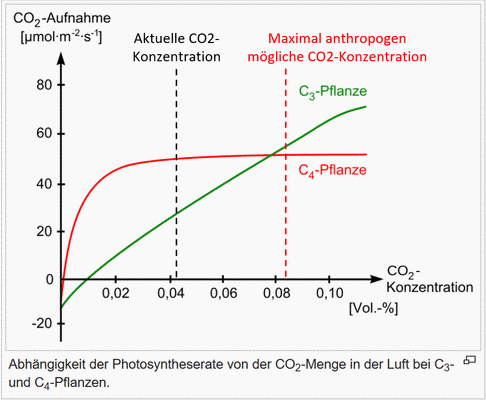

Korrelation CO2-Eintrag und Temperatur

Wie in der Rezension an einigen Stellen gezeigt wurde, verläuft der CO2-Eintrag (steigt überproportional stetig an) und der Temperaturverlauf über weite Strecken ohne Korrelation, teilweise sogar gegenläufig. Aufgrund der enormen natürlichen Temperatur- und Wetterstreuungen reichen für die meisten Einflüsse auch die 30 Jahre Meteorologischer Messzeitraum zur Belegung stabiler Trends nicht wirklich aus.

Welttemperatur ohne menschlichen Einfluss

An der „naturgegebenen Welttemperatur“ wird laufend gedreht. Mal beträgt sie 15 Grad, dann fällt sie plötzlich auf 13,9 Grad: M. Limburg „Mit 15 °C ist die Erde perfekt“, jetzt sollen nur 14,8 °C eine unerträgliche Erwärmung sein!“. Dabei darf das gar nicht sein, denn die „richtige“ Temperatur wird physikalisch genau berechnet und „driftet“ nicht. Auf die Fragestellung, ob das Klima alarmistisch wäre, oder einfach nur normal, hat dies einen gewaltigen Einfluss.

CO2-Sensitivität

Max Plank Institut für Meteorologie: Der Wert der Klimasensitivität liegt nach Einschätzung des fünften Sachstandsberichts des Intergovernmental Panel on Climate Change (IPCC) wahrscheinlich zwischen 1,5 und 4,5 °C und umfasst somit eine Unsicherheit, die sich seit den frühen Untersuchungen der Klimasensitivität in den 1970er Jahren nicht verringert hat.

Frühere Schätzungen des Effektes deuteten darauf hin, dass er alle anderen positiven Rückkopplungen aufheben könnte, was zu einer Klimasensitivität von nur 1 °C führen würde. Durch das Integrieren des Iris-Effekts in das MPI-M Erdsystemmodell zeigten Mauritsen und Stevens, dass die vom Iris-Effekt verursachte, trockenere Atmosphäre zu weniger Wolken führt und somit den verminderten Treibhauseffekt durch weniger hohe Wolken aufhebt. Diese Verringerung von hohen Wolken verstärkt zudem Änderungen des Wasserkreislaufs. Sowohl eine niedrigere Klimasensitivität von etwa 2 °C als auch eine verstärkte hydrologische Änderung könnten die Modelle näher an die besten Schätzungen aus Beobachtungen heranbringen.

Laut einer aktuellen Studie ist zu erwarten, dass man die Unsicherheit mit dieser Wartetaktik in den nächsten 15 Jahren halbieren kann. Aber auch die Theorie, die jener Studie zugrunde liegt, wird kritisiert und es ist daher wahrscheinlich, dass es mehr Zeit beansprucht, als angenommen wird.

Man nimmt also neuerdings an, dass die Klimasensitivität eher zwischen 1 … 2 °C liegt und damit am unteren, vom IPCC angegebenen Bereich (was Klimakritiker schon längst annehmen). Und man hofft, es in den nächsten 15 Jahren etwas genauer zu wissen, eher aber nicht.

Fazit

Nicht allen ist klar, dass in der angeblich „gesicherten“ Wissenschaft gerade bezüglich der wichtigen Parameter schon immer und vor allem weiterhin so eklatante Ungenauigkeiten bestehen. Trotzdem werden damit seit den 1970er Jahren fleißig und regelmäßig Weltuntergänge simuliert.

Wer sich (was die vielen Simulationsprojektions-Bilder zeigen) wundert, warum die Zukunftsprojektionen teils abhängig vom Forschungsinstitut so gewaltig unterschiedlich ausfallen, findet darin eine Lösung.

Abschließende Zusammenfassung des Autors (Teil 1 / 2)

Wenn das, was diese Fachstelle abgeliefert hat das Ergebnis wissenschaftlicher Arbeit sein soll, dann fällt fast jede Publizierung auf EIKE automatisch darunter. Geht es etwas darüber hinaus, indem zum Beispiel anstelle nur zu Zitieren und zu Kopieren eigene Gedanken zugefügt werden, wird man wohl zum ernannten Professor. Auch das würde sich dann auf EIKE oft finden.

Doch Ironie beiseite:

Was als Information für Abgeordnete abgeliefert wurde, ist eine oberflächliche Auftragsarbeit mit dem Untertitel „lustlose Propagandapublikation“. Wenn dies das Informationsniveau ist, aus dem heraus Abgeordnete entscheiden sollen, mal so nebenbei zig Milliarden EUR aus dem Bundesetat in einen mit 100 Milliarden EUR gestarteten Klimafonds zu schaufeln oder Deutschland vollkommen zu dekarbonisieren, dann „Guten Nacht“ für den ehemaligen Wissenschaftsstandort Deutschland.

Es kann natürlich auch sein, dass dieser „Wissenschaftliche Dienst“ sich bewusst dümmer gestellt hat als er ist, um nicht mit einer richtigen, aber politisch falschen Aussage, ins Fettnäpfchen zu treten und dadurch Finanzmittel oder Karrieren zu gefährden. Im vermerkelten Deutschland inzwischen eine latente, nicht zu unterschätzende Gefahr. Dummheit wird immer unterstützt wenn sie nützlich ist, falsche Gedanken nie.

Als Ergebnis lässt sich feststellen, dass es (rein persönliche Meinung des Autors) auch dem Wissenschaftlichen Dienst nicht gelungen ist, im Zeitraum der letzten 20 Jahre einen signifikanten (negativen) Klimawandeleinfluss zu finden. Der Autor hofft auch gezeigt zu haben, wie oft (nicht nur) beim Klimawandel Behauptungen aufgestellt werden die einer Nachprüfung nicht stand halten.

Etwas Erfreuliches ließ sich trotzdem entdecken

Es ist keine Information vom Potsdamer PIK gelistet. Da stellt sich die Frage: Ist die einzige Person, welche sich in Berlin noch von dieser Fließband-Klima-Hysterie-Produktionsabteilung beeinflussen lässt Frau Umweltministerin Hendricks (und die Grünen[17])? Das würde hoffen lassen.

Bild 42 [17] Screenshot eines Videos „Wie geht es weiter nach dem Abkommen von Paris?“ mit Prof. Schellnhuber (PIK) und Anton Hofreiter Bündnis 90 / Die GrüneN

Wie unsachlich diffamierend die Debatte um den Klimawandel selbst von „Wissenschaftlern“ geführt wird, zeigt immer wieder neu beispielhaft die Informationsseite der Klimaberaterin von Umweltministerin Hendricks, C. Kemfert.

Klimaretter.Info: Klimaleugner sagen Glück Auf

Darin wird auch die Aussage: "Wir befinden uns heute in einem sich verstärkenden Klimawandel, der auch vor unserer Haustür nicht mehr Halt macht" als richtig dargestellt.

Jeder Leser darf sich anhand der Rezension fragen, ob dieses Statement auf der Homepage der Klimafachfrau diskussionslos als wahr angenommen werden kann. Frau Hendricks scheint es nicht zu stören (bzw. sie wünscht nur Berater, welche ihre Klimahysterie unterstützen), von jemandem beraten zu werden der offen verkündet, an Neutralität und der Bewertung von Fakten kein Interesse zu haben[30].

Hoffen wir, dass auch ein paar Abgeordnete diese Rezension lesen und den Mut haben, sich eigene Gedanken über den angeblich für jedes Negativereignis verantwortlichen Klimawandel zu machen (und dies in Abstimmungen auch zu äußern).

Quellen (Teil 1 / 2)

[1] Wissenschaftliche Dienste Dokumentation : WD 8 – 3000 – 049/16 Extreme Wetter- und Naturereignisse in Deutschland in den vergangenen 20 Jahren

[2] Munich Re: April 2016 NatCatSERVICE Schadenereignisse in Deutschland 1980 – 2015

[3] MunichRe Juli 2012: NATCATSERVICE Naturkatastrophen in Deutschland 1970 – 2011

[4] WIKIPEDIA Zeitreihe der Lufttemperaturen in Deutschland 1750 – 2016

https://de.wikipedia.org/wiki/Zeitreihe_der_Lufttemperatur_in_Deutschland

[5] EIKE 30.07.2016: Weltweiter Temperaturrekord gemessen?

http://www.eike-klima-energie.eu/news-cache/weltweiter-temperaturrekord-gemessen/

[6] EIKE 29.07.2016: Bayerischer Klimakongress 2016 in Würzburg

http://www.eike-klima-energie.eu/news-cache/bayerischer-klimakongress-2016-in-wuerzburg/

[7] Deutscher Wetterdienst Agrarmeteorologie Weihenstephan, Dr. Harald Maier, Foliensatz: Klimawandel in Bayern Veränderungen und Perspektiven

[8] Bayerisches Landesamt für Umwelt, Referat Grundwassermonitoring, Dr. Jörg Neumann, Foliensatz: Klimawandel in Bayern – Was passiert mit unserem Grundwasser?

[9] EIKE 07.02.2016: Der Himmel fällt uns auf den Kopf und ohne die Glaskugel im Computer würden wir es nie erfahren

Rezension: UBA Studie 24/2015 Die Vulnerabilität Deutschlands gegenüber dem Klimawandel

http://www.eike-klima-energie.eu/news-cache/der-himmel-faellt-uns-auf-den-kopf-und-ohne-die-glaskugel-im-computer-wuerden-wir-es-nie-erfahren/

[10] DWD, Geschäftsbereich Klima und Umwelt, Paul Becker, Andreas Becker, Clementine Dalelane, Thomas Deutschländer, Thomas Junghänel und Andreas Walter, Stand: 19.07.2016: Die Entwicklung von Starkniederschlägen in Deutschland Plädoyer für eine differenzierte Betrachtung

[11] EIKE 21.11.2015: Die bayerische Umweltministerin Frau Scharf: Extremwetter, Extrem-Hochwasser und die Unberechenbarkeit des Wetters nehmen zu. Doch stimmt das wirklich?

http://www.eike-klima-energie.eu/news-cache/die-bayerische-umweltministerin-frau-scharf-extremwetter-extrem-hochwasser-und-die-unberechenbarkeit-des-wetters-nehmen-zu-doch-stimmt-das-wirklich/

[12] EIKE 06.11.2015: Langfrist-Temperaturverläufe Deutschlands: Das Phänomen der „Temperaturstufen“

http://www.eike-klima-energie.eu/news-cache/langfrist-temperaturverlaeufe-deutschlands-das-phaenomen-der-temperaturstufen/

[13] EIKE 06.07.2016 : Das Unwetter bei Simbach am Inn – Ein Nachtrag zur Debatte im Bayerischen Landtag

http://www.eike-klima-energie.eu/news-cache/das-unwetter-bei-simbach-am-inn-ein-nachtrag-zur-debatte-im-bayerischen-landtag/

[14] EIKE 09.06.2016: An den Unwettern ist der Mensch eher nicht schuld – aber ganz sicher an deren Folgen

Darstellung des Unwetters um Simbach Niederbayern

http://www.eike-klima-energie.eu/news-cache/an-den-unwettern-ist-der-mensch-eher-nicht-schuld-aber-ganz-sicher-an-deren-folgen/

[15] Bundestagsfraktion von Bündnis 90 / Die Grünen 2015, Dr.StefanieGroll: Brennpunkte des Klimawandels in Deutschland

[16] Bildungsserver wiki: Klimaänderungen in Deutschland

http://wiki.bildungsserver.de/klimawandel/index.php/Klima%C3%A4nderungen_in_Deutschland

[17] Bündnis 90 / Die Grünen: Die Klima-Uhr Ab jetzt wird’s kritisch

https://www.gruene-bundestag.de/themen/klimaschutz/ab-jetzt-wirds-kritisch-06-01-2016.html

[18] Munich Re Geo Risks Research/Corporate Climate Centre, Prof. Dr. Peter Höppe. Foliensatz zur FAchtagung „Klimaschutz: Kälte und Klimatechnik in der Energiewende“, Berlin 11.4.2016: Wirtschaftliche und Gesellschaftliche Gefahren des Klimawandels

[19] Swiss Re SIGMA Report No 1 /2016: Natural catastrophes and man-made disasters in 2015

[20] EIKE Stefan Kämpfe, Josef Kowatsch: Der Monat Juli wurde wärmer, in Deutschland aber nur wegen des Wärmeinseleffektes (WI), einer höheren Sonnenscheindauer und geänderter Wetterlagenhäufigkeiten

http://www.eike-klima-energie.eu/news-cache/der-monat-juli-wurde-waermer-in-deutschland-aber-nur-wegen-des-waermeinseleffektes-wi-einer-hoeheren-sonnenscheindauer-und-geaenderter-wetterlagenhaeufigkeiten/

[21] EIKE 01.06.2015: In Deutschland kein Klimawandel in Sicht – das kann die SZ nicht auf sich sitzen lassen (Teil2)

Sichtung UBA Klimamonitoringbericht Teil 2

http://www.eike-klima-energie.eu/climategate-anzeige/in-deutschland-kein-klimawandel-in-sicht-das-kann-die-sz-nicht-auf-sich-sitzen-lassen-teil2/

[22] EIKE 29.07.2016: Bayerischer Klimakongress 2016 in Würzburg

http://www.eike-klima-energie.eu/news-cache/bayerischer-klimakongress-2016-in-wuerzburg/

[23] CSC Climate Service Center, Publizierung: Ergebnisse und Auswertungen der Recherche zur Entwicklung von Extremwetterereignissen in Deutschland

[24] EIKE 14.04.2016 9. IKEK, Dipl.-Meteorologe Klaus-Eckart Puls: Extremwetter-Ereignisse : Was finden die Wetterdienste? Was schreibt der Klimarat IPCC?

http://www.eike-klima-energie.eu/klima-anzeige/9-ikek-dipl-meteorologe-klaus-eckart-pulsextremwetter-ereignisse-was-finden-die-wetterdienste-was-schreibt-der-klimarat-ipcc/

[25] UBA Studie 24/2015 Die Vulnerabilität Deutschlands gegenüber dem Klimawandel

[26] EIKE 10.08.2016: Tollhaus Berlin – Forscher sollen nachträglich die „Wissens- und Entscheidungsbasis“ für das verabschiedete 1,5 Grad Ziel suchen

http://www.eike-klima-energie.eu/news-cache/tollhaus-berlin-forscher-sollen-nachtraeglich-die-wissens-und-entscheidungsbasis-fuer-das-verabschiedete-15-grad-ziel-suchen/

[27] kaltesonne, 9. August 2016, Uli Weber: Die Dekarbonisierung der Welt: Ist der natürliche CO2-Kreislauf wirklich „settled Science“?

http://www.kaltesonne.de/die-dekarbonisierung-der-welt-ist-der-naturliche-co2-kreislauf-wirklich-%e2%80%9esettled-science/

[28] EIKE 05.08.2015: Nicht ewig leiden die Wälder- Wie der deutsche Wald innerhalb von drei Monaten genesen ist

http://www.eike-klima-energie.eu/klima-anzeige/nicht-ewig-leiden-die-waelder-wie-der-deutsche-wald-innerhalb-von-drei-monaten-genesen-ist/

[29] kaltesonne 22. November 2014: Neue AWI-Studie warnt: Klimamodelle unterschätzen natürliche Schwankungen der Meeresoberflächentemperaturen um den Faktor 50

[30] EIKE 23.07.2016: Der Unterschied in der Klimawandel-Berichterstattung: Kritik an der Berichterstattung des Portals Klimaretter.Info

http://www.eike-klima-energie.eu/news-cache/der-unterschied-in-der-klimawandel-berichterstattung/

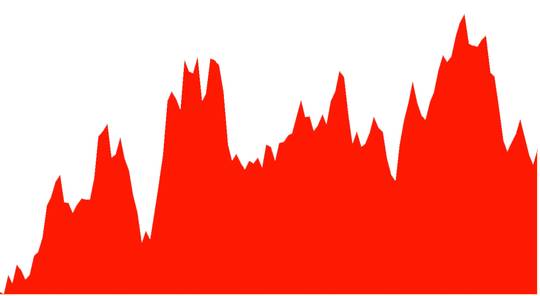

Bild 8. Die Börsenindices von Wertpapieren im Bereich der Kernenergie haben ihren Abwärtstrend überwunden. Seit Anfang 2016 steigen die Kurse langsam wieder an

Bild 8. Die Börsenindices von Wertpapieren im Bereich der Kernenergie haben ihren Abwärtstrend überwunden. Seit Anfang 2016 steigen die Kurse langsam wieder an

Video mit PP-Folien

Video mit PP-Folien