Berliner Zeitung 18.08.2016: [1] Klimawandel : Inseldorf in Alaska flieht komplett aufs Festland

Im US-Bundesstaat Alaska hat ein 600-Seelen-Dorf per Volksentscheid einen Komplettumzug von einer Insel aufs Festland beschlossen. Die Bevölkerung will damit den Folgen des Klimawandels entkommen, meldete das Umwelt-Magazin „Grist“ am Mittwoch unter Berufung auf die Gemeindeverwaltung.

Die Insel, auf der sich das Inuit-Dorf Shishmaref derzeit befindet, ist bereits schwer vom steigenden Meeresspiegel gezeichnet. Ein Großteil der Strände sind schon vom Ozean verschluckt, neues Bauland für die wachsende Bevölkerung kann nicht mehr gewonnen werden.

Es war zu erwarten, dass Klimaretter.Info die Meldung aufnehmen würde und sie kam:

Klimaretter.Info 20.08.2016: [12] Alaska: Ein Dorf flieht vor dem Klimawandel

… Zutreffend ist es trotzdem, denn Shishmaref gilt als einer der Orte auf der Welt, die am stärksten unter dem Klimawandel leiden. Den Einwohnern wird es nun buchstäblich zu heiß: Sie ziehen um, haben sie gemeinsam per Bürgerentscheid beschlossen.

In den sehr nördlichen Breitengraden macht sich die globale Erwärmung bereits etwa doppelt so stark bemerkbar wie im globalen Durchschnitt. Das hat zur Folge, dass das Meereis schmilzt und die Insel weniger vor Sturmfluten schützt. Zugleich schmilzt der Permafrost, auf den die Shishmarefer ihre Häuser gebaut haben. Das macht den Boden anfällig für Erosion. Dadurch und durch den Meeresspiegelanstieg wird die Insel jedes Jahr kleiner.

Es ist nicht das erste Mal, dass Shishmaref umziehen will. Schon 2002 stimmten die Einwohner dafür. Das Vorhaben scheiterte am Geld.

Klimaretter.Info übernahm die Aktivistenmeldung wie üblich ungeprüft, ergänzte sie jedoch zur „besseren“ Alarmierung gleich mit einem ergänzenden Hinweis über die ebenfalls bedrohten Südseeinseln:

Klimaretter.Info 20.08.2016: [12] Auch anderswo auf der Welt spielen Gemeinden, teils ganze Länder, mit dem Gedanken der Umsiedlung, weil sie von den Folgen des Klimawandels bedroht sind. Bisher geht es dabei meist um kleine Inselsstaaten im Pazifik. Unfreiwilliger Vorreiter ist Kiribati, dessen 32 Atolle zwischen Hawaii und Australien größtenteils weniger als zwei Meter über dem Meeresspiegel liegen.

Anmerkung: Dass dies (mit dem angeblich Klimawandel-bedingten Untergang der Südseeinseln) trotz dauernder Wiederholung nicht stimmt, wurde schon umfangreich berichtet[11] [20].

Das Inseldorf Shishmaref an der Küste vor Alaska

Die Meldungen zum Inseldorf in Alaska basieren auf der Info einer Klimaaktivisten-WEB-Seite grist [2] die es wieder von der Gemeindeverwaltung des Ortes erfuhr. Das Thema hat eine längere Vorgeschichte, über die der Spiegel bereits vor fas zehn Jahren schon berichtete [4] DER SPIEGEL 09.06.2008: „KLIMAWANDEL Ein Dorf verklagt die Welt“ und beginnt in dieser Form ungefähr im Jahr 2002 [5].

An solche Untergänge wird man sich in Zukunft gewöhnen. Und es wird kaum jemanden geben, der dem widerspricht. Eher werden sich die Stimmen häufen, dass „wir im reichen Westen“ für diese Menschen noch viel mehr tun – bedeutet zahlen – müssen denn: Der Klimawandel ist doch so offensichtlich und so „gesicherte“ westliche Schuld, dass unsere Politiker dafür sorgen, diese Schuld rund um die Welt einklagbar zu machen. Während man dies bei TTIP und CETA als eine bare Zumutung empfindet, wird es beim „Klimawandel“ geradezu herbei gesehnt.

Welche Belege dann ausreichen, soll diese kleine Recherche als orientierende Darstellung zeigen, indem der Einfluss des Klimawandels um das Inuit Inseldorf Shismaref festgestellt wird.

Der mögliche Einfluss des Klimawandels auf das Inseldorf Shismaref

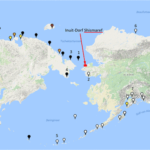

Bild 1 zeigt die ungefähre Lage der betreffenden Ansiedlung und dazu die umliegenden Tiden-Messstationen.

Bild 1 Screenshot von der PSML Homepage mit Tiden-Messstationen. Zufügungen durch den Autor: Nummern der ausgewerteten Pegelstationen und ungefähre Lage des Inseldorfes Shismaref

Der Meerespegel steigt unaufhörlich

Eine immer getätigte Aussage ist ein stetig steigender Meerespegel: [12] [1]Die Insel, auf der sich das Inuit-Dorf Shishmaref derzeit befindet, ist bereits schwer vom steigenden Meeresspiegel gezeichnet.

Wie es sich bei allen Recherchen zum Klimawandel zeigt, gibt es zwar viele Messstationen, aber obwohl es sehr wichtig wäre, sind zu den wenigsten brauchbare Daten hinterlegt. Auch hier bestätigt sich wieder eine grottenschlechte Datenlage und man (der Autor) fragt sich, wie die Institutionen damit ihren globalen „Meerespegelverlauf“ ermitteln können. Der Verdacht entsteht, dass viele Stationen nur dazu dienen, den Vertrauensbereich statistisch (Vertrauensbereich des Mittelwertes = proportional 1 / ) klein zu rechnen. Für die die folgenden Darstellungen wurden die wenigen, verfügbaren langfristigen und mit nicht zu vielen Datenlücken gekennzeichneten Pegel verwendet.

Sichtung der Tidenverläufe dieser Weltgegend anhand der PSML Datenbank

Tidenverlauf

Detailbilder sind als Anlage hinterlegt, hier die Zusammenfassung.

Was man in den Einzelbilder der Anlage erkennen kann sieht man natürlich auch hier in der Zusammenfassung: Der Tidenpegel steigt in diesem Meeresbereich nicht an.

Bild 2 Tidenpegelverlauf Station Adak(5), Anchorage (7), Prudhoe Bay (6). Vom Autor anhand der PSML-Daten erstelle Grafik.

Noch deutlicher wird es, wenn man die Pegel auf den gleichen Endwert normiert. Egal wie man es betrachtet, seit ca. 1960 fällt der Pegel. Der aktuelle Pegelstand entspricht dem zu Beginn der längsten Messreihe um 1943.

Bild 3 Tidenpegelverlauf Station Adak(5), Anchorage (7) auf den gleichen Endwert normiert. Vom Autor anhand der PSML-Daten erstelle Grafik

In einer Studie stellten die Autoren das Gleiche (wie der Autor) fest

[6] First, recall that the Chukchi Sea lacks any longterm annual tide gauge data so that direct comparisons of 19th and 20th century trends are not possible. Nonetheless, our paleo-sea level curve may indicate a slower response than the average rate of 1 to 2 mm of annual sea level rise, retrodicted from over 130 stations, mostly in the northern hemisphere (Gornitz and Lebedeff, 1987; Gornitz, 1993).

[Übersetzung von Chris Frey: Erstens sollte man nicht vergessen, dass es aus der Tschuktschen-See keinerlei langzeitliche Tidenmessungen gibt, so dass direkte Vergleiche mit Trends im 19. und 20.Jahrhundert nicht möglich sind. Nichtsdestotrotz kann unsere Kurve des Paläo-Verlaufs des Meeresspiegels eine langsamere Reaktion zeigen als die mittlere Rate von 1 bis 2 mm pro Jahr, ermittelt im Nachhinein von 130 Stationen zumeist auf der Nordhemisphäre (Gornitz and Lebedeff, 1987; Gornitz, 1993).

Ende Übersetzung]

Fazit

Dass ein Klimawandel-bedingt steigender Meerespegel die Ursache für die geschilderten Probleme sein kann, ist auszuschließen. Es bedeutet nicht, dass der Pegel dort nie gestiegen ist, aber sicher nicht in jüngerer und jüngster Zeit.

Wie bei Tidenpegel-Verlaufsangaben manipuliert wird, wenn es „der guten Sache“ dient, wurde im Artikel: EIKE 17.07.2016: Wie man den Meerespegel-Verlauf in die richtige Richtung dreht Aus dem Lehrbuch für (Klima-)Statistikbetrug, exemplarisch gezeigt.

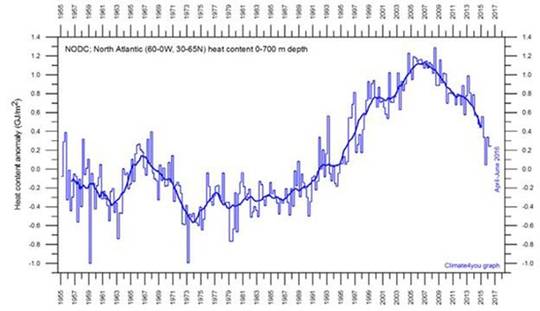

Es wird immer wärmer

DER SPIEGEL 09.06.2008: [4] KLIMAWANDEL Ein Dorf verklagt die Welt

Die globale Erwärmung ist längst im Gange, sie vollzieht sich in der Arktis schneller als im Rest der Welt: Seit Beginn der Industrialisierung hat sich die Temperatur auf der Erde um rund 0,8 Grad erhöht, in der Arktis sogar um das Doppelte.

Ähnlich wird dies auch von Klimaretter.Info angegeben.

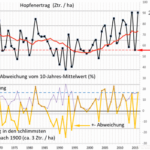

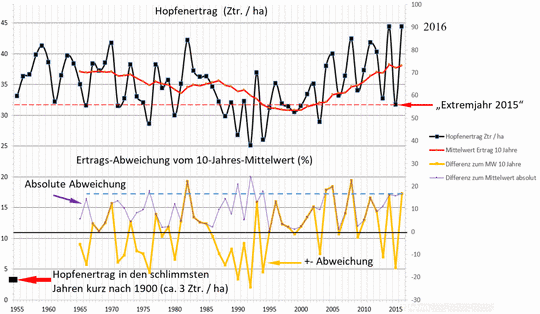

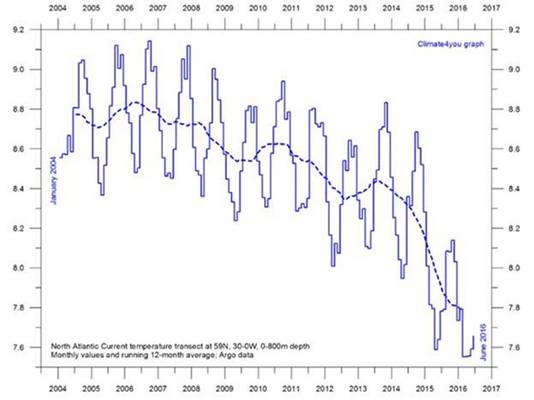

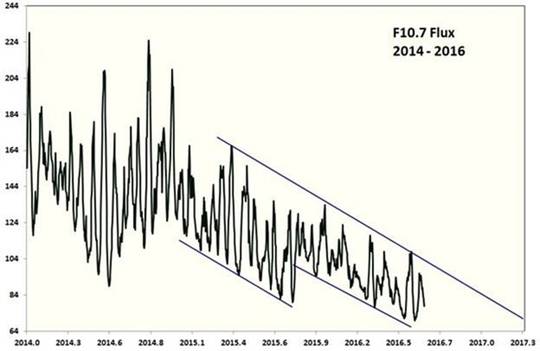

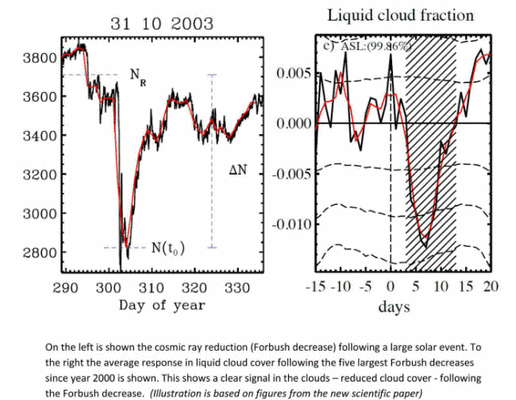

Hinweis: In der ursprünglichen Fassung dieses Artikels war nur Bild 4 als Version aus einem anderen Artikel enthalten[8]. Zwischenzeitlich gibt es auf der originalen Veröffentlichungsstelle The Alaska Climate Research Center eine neue Version, Bild 5.

Bild 4 [8] Temperaturentwicklung von Alaska während der vergangenen 60 Jahre. Quelle: The Alaska Climate Research Center. Hinweis: veraltete Darstellung aus [8] entnommen

Bild 5 Temperaturentwicklung von Alaska während der vergangenen 60 Jahre. Quelle: The Alaska Climate Research Center, abgerufen am 28.08.2016

Diese aktualisierte Darstellung zeigt die letzten zwei Jahr eine zusätzliche, starke Erwärmung. Wie schnell sich Temperaturen kurzfristig aber auch in die andere Richtung ändern, zeigt das folgende Bild 6 welches ganz aktuell ist und zudem von Satelliten stammt. Dort hat die Arktis den Stand von ca. 0,4 Grad wie er um 1980 schon war. Die kurze Spitze zeigt sich als ein seltenes, aber auch in der Vergangenheit im Nord- wie im Südpolargebiet schon vorgekommenes Ereignis.

Auf jeden Fall ist es ein gutes Beispiel, wie erheblich die verwendeten Zeitabschnitte die Interpretation beeinflussen und vor allem, dass nur sehr langfristige Verläufe ein einigermaßen stimmiges Bild ergeben.

Den von Satelliten gemessenen Verlauf um den Nordpol und Südpol zeigt das folgende Bild 6. Den für die Arktis überall gemeldeten, extrem hohen Temperaturanstieg konnten Satelliten nicht entdecken – außer für ganz wenige Monate.

[12] In den sehr nördlichen Breitengraden macht sich die globale Erwärmung bereits etwa doppelt so stark bemerkbar wie im globalen Durchschnitt

Den von Satelliten gemessenen Verlauf um den Nordpol und Südpol zeigt das folgende Bild 6. Den für die Arktis überall gemeldeten, extrem hohen Temperaturanstieg konnten Satelliten nicht entdecken – außer für ganz wenige Monate.

[12] In den sehr nördlichen Breitengraden macht sich die globale Erwärmung bereits etwa doppelt so stark bemerkbar wie im globalen Durchschnitt

Dass solche Effekte öfters vorkommen, kann man gut um das Jahr 1980 sehen. Daraus „Klimahysterie-Stories“ zu „schnitzen“, bleibt Portalen wie etwa Klimaretter-Info vorbehalten. Eines ist sicher: Wer zu Beginn dieser Temperaturaufzeichnung um 1979 gelebt hat, kann aktuell keinen Unterschied erkennen.

Aber wichtiger: Warum wirkt die Temperaturverstärkung des anthropogenen CO2 – wenn überhaupt – nur auf der Nordhalbkugel? Die südliche Hälfte weigert sich weiterhin beharrlich daran „teilzunehmen“. Das lässt die Theorie aber nicht zu. Muss sich nun die Erde ändern, oder die Theorie?

Bild 6 Global monthly average lower troposphere temperature since 1979 for the North Pole and South Pole regions, based on satellite observations (University of Alabama at Huntsville, USA). This graph uses data obtained by the National Oceanographic and Atmospheric Administration (NOAA) TIROS-N satellite, interpreted by Dr. Roy Spencer and Dr. John Christy, both at Global Hydrology and Climate Center, University of Alabama at Huntsville, USA. Thick lines are the simple running 37 month average, nearly corresponding to a running 3 yr average. Click here to read about data smoothing. Click here to download the entire series of UAH MSU global monthly lower troposphere temperatures since December 1978.

Quelle: Hide the decline The indispensable A-Z in the climate debate

[Übersetzung von Chris Frey: Bild 6: Globale mittlere Temperatur der unteren Troposphäre seit 1979 für die Gebiete um Nord- und Südpol auf der Grundlage von Satellitenmessungen (University of Alabama at Huntsville, USA). In diese Graphik gehen Daten ein des TIROS-N-Satelliten der NASA, interpretiert von Dr. Roy Spencer und Dr. John Christy,beide am Global Hydrology and Climate Center, University of Alabama at Huntsville, USA. Dicke Linien sind das einfache gleitende Mittel über 37 Monate, was nahezu korrespondiert mit einem 3-Jahre-Mittel. …

Ende Übersetzung]

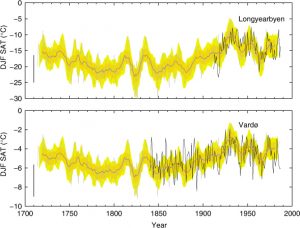

Vor der Satellitenära waren die Temperaturangaben bestimmt ungenauer. Trotzdem ist es interessant, den Verlauf davor zu betrachten. Man erkennt: Alles schon einmal da gewesen. Und: Ein CO2-steigender Einfluss ist nicht erkennbar!

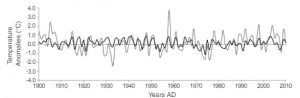

Bild 7 Diagram showing Arctic monthly surface air temperature anomaly 70-90oN since January 1900, in relation to the WMO normal period 1961-1990. The thin blue line shows the monthly temperature anomaly, while the thicker red line shows the running 13 month average. In general, the range of monthly temperature variations decreases throughout the first 30-50 years of the record, reflecting the increasing number of

[Übersetzung von Chris Frey: Bild 7: Arktische monatliche Anomalie der Lufttemperatur von 70°N bis 90°N seit Januar 1900 im Vergleich mit der WMO-Bezugsperiode 1961 bis 1990. Die dünne blaue Linie zeigt die monatliche Temperaturanomalie, während die dickere rote Linie das über 13 Monate gleitende Mittel zeigt. Allgemein nimmt die Bandbreite monatlicher Temperatur-Variationen während der ersten 30 bis 50 Jahre der Aufzeichnung ab, was die zunehmende Zahl der ?? reflektiert [Hier fehlt eindeutig ein Wort].

Quelle: Hide the decline The indispensable A-Z in the climate debate

Ende Übersetzung]

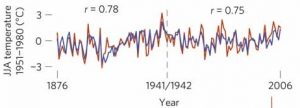

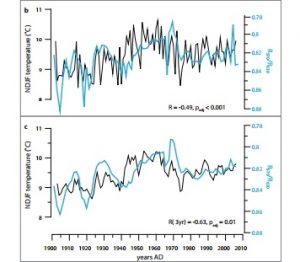

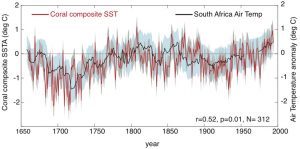

Ergänzend eine langfristige Darstellung (Bild 8). Es handelt sich nicht um genau diese Gegend, ist aber sicherlich im Ansatz repräsentativ. Erklärungstext zum Bild 6: [8] … aus dem kanadischen British Columbia sind nun interessante Erkenntnisse zur Temperaturgeschichte bekannt geworden. Auf Basis von Baumringen konstruierten Forscher jetzt die Temperaturentwicklung der letzten 800 Jahre für die Sommermonate Juni und Juli. Dabei zeigte sich, dass die 1940er Jahre wärmer als heute waren. Auch in den Jahrhunderten davor gab es immer wieder Phasen, in denen es wärmer als heute war.

Bild 8 [8] kanadisch British Columbia. Temperaturentwicklung der letzten 800 Jahre für die Sommermonate Juni und Juli auf Basis von Baumringen

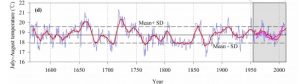

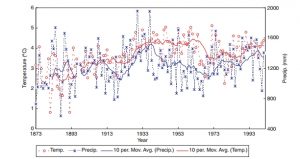

Und zum Schluss noch eine Langfristdarstellung von Temperaturproxis in Alaska um Anchorage. Danach haben die Temperaturen dort seit ca. 4.000 Jahren stetig abgenommen (was auch in Bild 13 gezeigt ist). Die Tiere und Pflanzen welche aktuell angeblich wegen der geringen Erwärmung schon „ausbleiben“ oder „verschwinden“ waren entweder dort langfristig betrachtet gar nie heimisch oder haben schon immer gewechselt wie das Klima auch.

Bild 9 [9] Sommer-Temperaturen von Temperaturproxis in Alaska

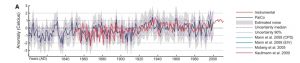

Wie „sicher“ Rekonstruktionen des Klimas (auch der Arktis) sind, zeigt das folgende Bild aus der jüngsten und umfassendsten Klimarekonstruktions-Analyse. Details dazu wurden bereits berichtet.

EIKE: [16] Die Problematik der Temperaturrekonstruktion Eine beispielhafte Sichtung dazu anhand des Projektes PAGES 2k

Bild 10 Alle Proxis Arctic des Projekt PAGES 2k Datensatzes. Quelle: Active viewer for the Pages 2K Proxis

Was die Natur nicht schafft, lässt sich trotzdem beliebig simulieren und hemmungslos publizieren. Den Begriff „Blamieren“ gibt es in dieser „Wissenschaft“ scheinbar nicht. Wie das Kalibrieren bei der wie Rauschen aussehenden Temperatur-Datenlage (Bild 10) gelingt, erschließt sich nur Simulations-„Wissenschaftlern“, ist aber eben Trend. Wenn man sich ein solches Simulationsergebnis ansieht, sollte einem jedoch weniger Angst vor der Zukunft, als vor dieser „Wissenschaft“ und deren Gläubigen werden.

Bild 11 [14] Fig. 11. Ensemble mean of surface air temperature anomalies relative to its climatology for the 1980–1999 period for each month averaged over (A) the Chukchi Sea

Fazit

Die Einwohner erlebten dort zwischenzeitlich höhere Temperaturen, doch gingen diese inzwischen auch wieder auf einen Stand wie vor ca. 60 Jahren zurück. Die Eltern der aktuellen Einwohner erlebten also bereits die gleichen Temperaturen. Eine durch einen Klimawandel stetig immer weiter ansteigende Wärme ist in der Wirklichkeit nirgends erkennbar. Aktuell scheint sich die Gegend eher in einer historisch kalten Klimaphase zu befinden. Zeiten mit weniger Eis und weniger Permafrost hat diese Gegend schon früher über lange Zeiträume erlebt und überstanden. Es ist überhaupt nicht unwahrscheinlich, dass die aktuellen Temperaturerhöhungen nur Teil eines natürlichen Zyklus und natürlicher Variabilität sind.

Lediglich vollkommen unglaubwürdige (da mangels genauer Daten nicht kalibrierbare) Simulationen berechnen beliebig alarmistische Zukunftsprojektionen.

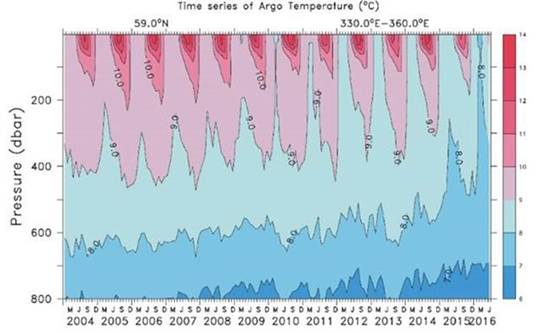

Es gibt kein Eis mehr

gris: [2] Rising seas and more ice-free months are causing erosion that is eating away at the island.

Eine Diskussion darüber ist schwierig. Denn es scheint so, als haben heutige Erdbewohner die Überzeugung, dass die Natur sich nicht mehr verändern dürfe, sobald sich der Mensch daran gewöhnt und Siedlungen errichtet hat. Gletscher waren über Jahrtausende eine ständige Todes-Bedrohung und wurden mit enormem (auch finanziellem Aufwand an eine dabei immer gerne helfende Institution) Einsatz „weggebetet“. Erst seit man sie für die Touristen benötigt, fordert man plötzlich, dass sie bleiben müssen und gibt ihnen auf einmal einen positiven Wert [22].

Leider sind Grafiken der Polareisbedeckung erst seit Beginn der Satellitenära verfügbar (Bild 12). Zwar melden unsere Medien regelmäßig dass es eigentlich kein Eis mehr gäbe, doch so schlimm sieht es damit nicht aus. Vor allem Al Gores „sichere Vorhersage“ – ab dem Jahr 2013 wäre die Arktis im Sommer völlig eisfrei, hat sich nicht im Ansatz bewahrheitet. Was sicher Tatsache ist: Das Tauen und Wiederkommen dieser Eisfläche ändert seine Zeitpunkte im Jahr. Es ist aber zu bezweifeln, ob das Eis dies früher noch nie gemacht hat.

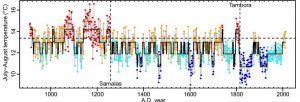

Bild 12 Aktuelle Grafik der arktischen Meereisbedeckung

Interessanter ist die langfristige Betrachtung. Das Meer-Eis in genau dieser Gegend befindet sich aktuell auf einem selbst über die letzten 2.000 Jahre gesehen historisch hohem! Bedeckungs-Niveau und die Temperaturen auf einem niedrigen! Damit waren nach der aktuellen Lesart die historischen Vergangenheiten erheblich negativer „Klimawandel“-beeinflusst als die Gegenwart.

Bild 13 [13] Vergangenheitsdaten See-Eis Bedeckung, Salzgehalt, Sommer-Temperatur der Meeresoberfläche

Die Insel „verschwindet“

Berliner Zeitung: [1] … Ein Großteil der Strände sind schon vom Ozean verschluckt

Shishmaref, Alaska: Rising temperatures have resulted in a reduction in the sea ice which serves to buffer Shishmaref from storm surges. At the same time, the permafrost that the village is built on has also begun to melt, making the shore even more vulnerable to erosion.

[Übersetzung von Chris Frey: Shishmaref, Alaska: Steigende Temperaturen führten zu einer Abnahme des Meereises, welches bisher als Schutzwall von Shishmaref vor Sturmfluten fungierte. Gleichzeitig hat der Permafrost, auf dem die Ortschaft erbaut worden ist, ebenfalls zu schmelzen begonnen, was die Küste sogar noch verwundbarer für Erosion machr.

Ende Übersetzung]

Beim Betrachten der Bilder in den Zeitungsartikeln fällt auf, dass die Insel relativ hoch ist und damit keine Probleme mit einem steigenden Pegel haben sollte. Trotzdem „verschwindet“ der Strand.

Die Sichtung der grist-Artikel zeigt das wirkliche Problem: Die Insel besteht aus reinem Sand. Laut den Beschreibungen hielt dieser, so lange er ständig gefroren war. Seit es etwas wärmer wurde, ist er jedoch anfälliger geworden. Die Deutsche Nordseeküste kennt solche bedrohten, sandigen Inseln zu Genüge, wie zum Beispiel Sylt welche ohne massive Küstenschutzmaßnahmen schon erheblich kleiner wäre. Allerdings haben die Nordseeküsten im Mittelalter die wirklich gewaltigen Mengen Land verloren. Was dort seit der Neuzeit passiert, ist dagegen fast nichts.

Und auch in dieser Gegend von Alaska ist das Problem nicht neu.

[7] The results show mean erosion rates of −0.12 to −0.08 m/yr in the region from 1950 to 2003. The northern and southern shorelines showed erosion between 1950 and 1980, but slight accretion/stabilization between 1980 and 2003. These changes possibly correlate with Aleutian low anomaly variations that affected the climate in the area of study. On the basis of the predictions of SLR in the Arctic for 2000–2049 and 2050–2100, mean erosion rates may increase to 0.6–1.65 m/yr. This would translate into an approximately 70–1000-m retreat of the shore, depending on its slope, composition, and geomorphologic type. These results help to assess coastal vulnerability and can contribute to regional planning efforts.

[Übersetzung von Chris Frey: Es ergeben sich mittlere Erosionsraten von -0,12 bis -0,08 M pro Jahr in dem Gebiet von 1950 bis 2003. Die Nord- und Südküste zeigten Erosion zwischen 1950 und 1980, jedoch leichte Zunahme/Stabilisierung zwischen 1980 und 2003. Diese Änderungen korrelieren möglicherweise mit geringen Anomalie-Variationen bei den Aleuten, die das Klima im Untersuchungsgebiet beeinflusst haben. Auf der Grundlage der SLR-Vorhersagen in der Arktis für 2000 bis 2049 und 2050 bis 2100, könnten die mittleren Erosionsraten zunehmen auf 0,6 bis 1,65 m pro Jahr. Dies wäre gleichbedeutend mit einer Rückbildung der Küsten um 70 bis 1000 m, abhängig von der Steilheit, der Zusammensetzung und des geomorphologischen Typs. Diese Ergebnisse helfen, die küstennahe Verwundbarkeit abzuschätzen und können bei regionalen Planungen helfen.

Ende Übersetzung]

Es handelt sich demnach um einen für Küstenerosion mehr als sehr anfälligen Küstenstreifen. Bereits kleinste Veränderungen an Klimafaktoren haben einen großen Einfluss. Die Erosion ist in der Studie seit 1950 untersucht, also als ein Problem bekannt. Für die Zeit von 1980 … 2003 wird eine „leichte Zunahme / Stabilisierung“ gemeldet. Als die Bewohner im Jahr 2002 bereits erstmals den Umzug beschlossen, stellte sich die Thematik somit beileibe nicht Klimawandel-bedingt dramatisch verstärkt dar, sondern war ein dort wohl immer schon vorhandener Vorgang, vergleichbar der Deutschen Nordseeküste. Im Kern wird es erst in Klimasimulationen zur wirklichen Zukunfts-Dramatik (gemacht).

Schaut man im Klimaretter.Info Artikel auf das Bild mit der neueren Küsten-Schutzverbauung, wagt man Zweifel, ob sich die simulierte Apokalypse bewahrheiten wird. Das „Alarmbild“ mit der am Strand abgerutschten Hütte stammt jedenfalls bestimmt nicht von diesem neu geschützten Küstenteil. Es ist somit anzunehmen, dass auch dort der Der Mensch mit konkreten Maßnahmen sinnvoll schützen kann. Ob dazu auch die CO2-Vermeidung gehört, bezweifelt der Autor.

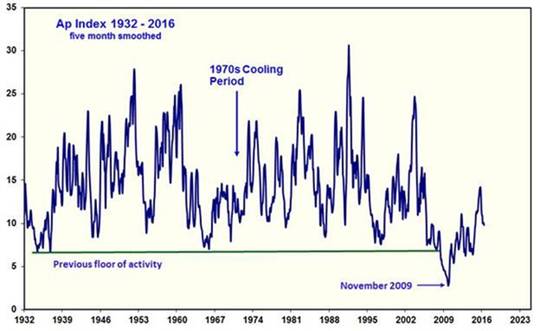

Die Stürme werden immer schlimmer

Eine zusätzlich gemeldet Ursache – ständig zunehmende Stürme – bleibt unsicher. Es sind darüber verschiedene Studien zu finden, welche sich im Ergebnis teils widersprechen. Privat ist eine fundierte Analyse aufwendig, da viele der Studien kostenpflichtig sind (man kann nur die Zusammenfassungen kostenfrei lesen), weshalb der Autor darauf verzichtet und anbei nur etwas Information aus Fundstellen listet.

Eine Studie ermittelte, dass Stürme in dieser Gegend bei Kälte zunehmen, also dank Klimawandel schwächer werden müssten:

[6] Geologic data suggest that, in the Chukchi Sea, storm frequency is correlated with colder rather than warmer climatic conditions (Mason and Jordan, 1993; Mason et al., 1996; Mason, 1999). Our data do not therefore support predictions of more frequent or intense coastal storms associated with atmospheric warming for this region.

[Übersetzung von Chris Frey: Geologische Daten zeigen, dass die Sturmhäufigkeit in der Tschuktschen-See korreliert ist mit kälteren und nicht mit wärmeren Klimabedingungen (Mason and Jordan, 1993; Mason et al., 1996; Mason, 1999). Unsere Daten stützen daher nicht Prophezeiungen häufigerer oder stärkerer küstennaher Stürme, die mit der atmosphärischen Erwärmung in diesem Gebiet assoziiert sind.

Ende Übersetzung]

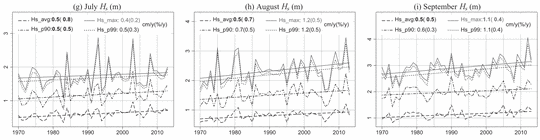

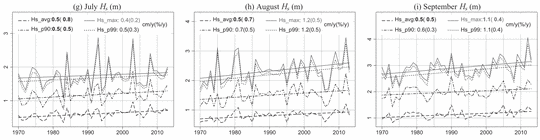

In einer anderen Studie sind die Wellenhöhen seit 1970 rekonstruiert. Beim Betrachten zeigt sich, dass im Kern lediglich im September und davon nur in einer kurzen Spitze so um das Jahr 2012 die Wellenhöhe höher war (um ca. 07 m – „normal“ scheinen ca. 3,5 m). Es erscheint unglaubwürdig, dass wegen dieser im Grund geringfügigen und sehr kurzen Veränderung (so sie wirklich messbar ist) die Insel „verschwindet“:

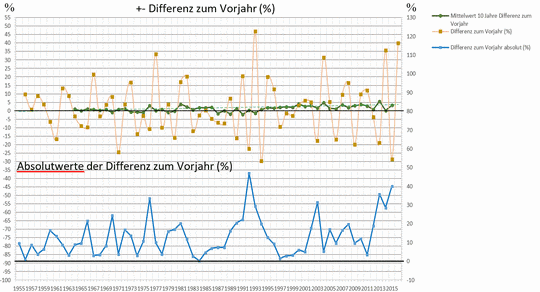

Bild 14 [15] FIG. 6 Verlauf der Wellenhöhen (H) in der Seegegend Beaufort–Chukchi–Bering (BCB) Seas

In der Studie selbst[15] ist dazu ausgeführt, dass die ermittelte Zunahme der Wellenhöhen (welche sich zwischen den drei untersuchten Gegenden im Jahresverlauf deutlich unterscheidet) nicht aufgrund zunehmender Windstärken (diese nimmt nämlich wieder Erwartung nicht signifikant zu), sondern wohl aufgrund der längeren Wellenlaufzeiten durch die größeren, eisfreien Wasserflächen entsteht. Nimmt die Eisbedeckung wieder zu, ist mit einem Rückgang der Wellenhöhen zu rechnen.

Zusammenfassung Klimawandel-Einfluss

Relativ leicht lässt sich feststellen, dass die gemeldeten Verursacher für die Probleme teils gar nicht (steigender Meerespegel, stärkere Stürme) und wenige anteilig, aber nicht als Hauptursache der berichteten Probleme, verantwortlich sein können. Zudem lässt sich feststellen, dass der aktuelle Klimazustand dort eher einem Klimawandel widerspricht und die einem Klimawandel zugeschriebenen Effekte auch in historischer Zeit viel stärker vorlagen.

Damit bestätigt sich wieder, was der Autor in seinen zwischenzeitlich umfassenden Recherchen zu gemeldeten, Klimawandel-bedingt untergehenden Inseln feststelle: Er fand bisher keine! bei der sich ein anthropogener Klimawandel-Einfluss als Ursache belegen ließe. Was er aber fand, waren durchgängig falsche Datenangaben und „Belegführungen“ durch ungeprüfte Aussagen von Klimaaktivisten.

In aller Regel gilt bei diesen Meldungen: Die typischen „Klimawandel“- Einflüsse liegen bei näherem Hinsehen einfach nicht vor. Man müsste als Beleg einen anderen Klimawandel erfinden. Und diesen gibt es hier: Rückfall in das frühere Klima! Die Inuit wüschen sich dies, nicht wissend (oder nicht wissen wollend), dass es genau das ist, was der Klimawandel – so es ihn gäbe – auch bringen müsste, nämlich Wärme. Denn die gewünschte – angeblich immer schon vorhandene Kälte – erweist sich eher als eine Ausnahme in ihrer historischen Klimageschichte.

Auch Inuit-Kinder mögen es bequem(er)

Das Leben am Ende der Welt und noch dazu am Rande des Polarmeeres gefällt nicht jedem und trotz einer vermeintlich schier endlosen Wüstenei fehlt auch Land an der richtigen Stelle. Das war schon bevor man einen Klimawandel „kannte“ so.

DER SPIEGEL: [4] Denn dass Kivalina (Anm.: Ein Dorf neben Shismaref) umzieht, war eigentlich schon klar, noch bevor der Klimawandel kam und die Sache dringlich machte. Die Landspitze, auf der Kivalina liegt, ist einfach zu klein. Es passen keine neuen Häuser mehr ins Dorf. Seit 15 Jahren reden sie vom Umsiedeln, seit 15 Jahren verhandeln sie mit dem Bundesstaat Alaska über die Kosten.

[5] In addition to erosion, the island village has problems with securing fresh water and space to build, Nayokpuk said. Shishmaref has a young population — the median age is about 20 — and there will be a need for more housing.

“The main problems are a lack of space and the danger we are facing whenever we have a storm“

The ship traffic through the Bering Strait — including fishermen, shipping, and even cruise ships — has impacted the marine wildlife and could be why there are fewer seals and fish around, Eningowuk said.

[Übersetzung von Chris Frey: Zusätzlich zur Erosion hat das Inseldorf Probleme mit Süsswasser, und es gibt kaum Raum zum Bau von Reservoiren, sagte Nayokpuk. Shishmaefs Bevölkerung ist jung – mit einem mittleren Alter von 20 Jahren – und es wird mehr Bedarf für Wohnraum geben. “Die Hauptprobleme sind fehlender Platz dafür und die Gefahr durch Stürme bei uns”.

Der Schiffsverkehr durch die Bering-Straße – einschließlich Fischerboote, Frachtschiffe und sogar Kreuzfahrtschiffe – hat die maritime Flora und Fauna beeinflusst und könnte der Grund dafür sein, dass es weniger Seehunde und Fische gibt, sagte Eningowuk.

[Ende Übersetzung]

Auch Komfort spielt eine Rolle

Vor allem die Jüngeren sehen im Fernsehen, dass es anders wo solchen gibt:

grist[2]: “Our culture is really hard, we’re up here near the Arctic circle, and we enjoy it — it’s what we’re used to,” Eningowuk said. “But our children, the younger generation are the ones who are not too excited about it,” he said, adding that all of his children have moved away from Shishmaref. “Other children are also already looking for other places to live … they’re finding other professions that will keep them in the cities,” Eningowuk said. The internet and television have shown them that there are easier ways to live,

[Übersetzung von Chris Frey: grist [2]: “Unsere Kultur ist wirklich hart. Wir leben hier am Polarkreis, und wir erfreuen uns daran – das ist es, woran wir gewöhnt sind”, sagte Eningowuk. “Aber unsere Kinder, die jüngere Generation sind diejenigen, die darüber nicht so begeistert sind”, sagte er und fügte hinzu, dass alle seine Kinder aus Shishmaref weggezogen sind. “Unsere Kinder halten ebenfalls schon Ausschau nach anderen Orten zum Wohnen … sie finden andere Berufe, die sie in den Städten halten”. Internet und Fernsehen haben ihnen gezeigt, dass es einfachere Lebensweisen gibt.

Ende Übersetujng]

Der Klimawandel wird zunehmend zur Geldquelle

Wenn man Klimaaktivist wird, erschließen sich Möglichkeiten, die sonst undenkbar wären. Es ist nicht erforderlich etwas zu wissen, sondern das „eingetrichterte“ Klima-Alarmwissen weltweit vorzutragen (Anm.: Das gilt auch für Aktivisten von Südseeinseln und in Afrika) – eine Verlockung, welche enorm motiviert:

grist: [2] Esau Sinnok, an 18-year-old climate activist from Shishmaref

Sinnok has traveled around the world to advocate for his Inupiaq Native village and others threatened by climate change in western Alaska. He became an Arctic Youth Ambassador for a program led by the U.S. Interior and State Departments, and is currently a participant in the Sierra Club’s Fresh Tracks program.

In December 2015, Sinnok attended the United Nations COP 21 in Paris, France. At the conference, a global climate treaty was signed by 195 nations in an effort to prevent the worst effects of climate change.

[Übersetzung von Chris Frey: Esau Sinnok, ein 18 Jahre alter Klimaaktivist aus Shishmaref:

Sinnok ist um die Welt gereist, um für sein Eingeborenen-Dorf Inupiaq und andere Ortschaften in Westalaska zu werben, die vom Klimawandel bedroht sind. Er wurde Arctic Youth Ambassador für ein Programm unter Führung des State Department und des Innenministeriums. Gegenwärtig nimmt er am Fresh Tracks program des Sierra-Clubs teil.

Im Dezember 2015 nahm Sinnok an der COP21 in Paris teil. …

Ende Übersetzung]

Und inzwischen helfen auch fürsorglich Individuen, welche das wirklich erforderliche Wissen haben.

DER SPIEGEL: [4] Es ist kein Zufall, dass die Klage aus Kivalina kommt. Einer der Anwälte war im vergangenen Jahr durch Alaska gezogen, auf der Suche nach möglichen Mandanten. Ein Klimaopfer-Casting.

Das Dorf Shishmaref zum Beispiel, etwas südlich von Kivalina, wäre ebenfalls ein guter Kandidat gewesen. In Shishmaref spülten die Stürme schon so viel Land davon, dass ein Haus mittlerweile halb in der Luft hängt, als hätte es jemand über die Klippe gedrückt. Aber Shishmaref wollte nicht klagen. Kivalina schon.

Ende Februar dieses Jahres haben die Stadt Kivalina und der Eskimo-Stamm Kivalina beim Gericht in San Francisco, Kalifornien, eine Klage eingereicht. Angeklagt sind 24 Öl- und Energiefirmen, Multis wie BP, Shell, ExxonMobil oder Chevron oder die American Electric Power Company, einer der größten Stromkonzerne im Land.

Sie blasen, so werfen die Eskimos ihnen vor, Millionen Tonnen CO2 und anderer Treibhausgase jährlich in die Luft, treiben die globale Erwärmung voran, und sie haben versucht, das Ausmaß und die Folgen des Klimawandels zu verharmlosen. Eine Verschwörung nennt das die Klage.

Und nun sollen sie bezahlen. Kivalina verlangt Schadensersatz für die Klimaschäden. 400 Einwohner müssen umgesiedelt, Häuser und Schule neu gebaut, Stromleitungen verlegt, Wasseranschlüsse geschaffen werden. Zwischen 100 und 400 Millionen Dollar dürfte das kosten.

Damit schreitet eine Entwicklung fort, wie sie bereits in [19] und [18]: „Staaten für mehr Klimaschutz verklagen ist cool“ beschrieben wurde.

Ergänzung

Gerade als dieses Manuskript gemailt werden sollte, warf der Autor noch einen Blick zu Klimaretter.Info, der Homepage zur bedenkenlosen Unterstützung der Klimahysterie. Und dort ist ebene eine (natürlich zustimmende) Information dazu erschienen:

Klimaretter.Info 23. August 2016: Klimaseniorinnen verklagen Schweiz

Mehr als 100 Seniorinnen aus der Schweiz wollen ihren Staat verklagen. Grund ist die verfehlte Klimapolitik, die zu einer Zunahme gesundheitsbelastender Wetterextreme führt, berichtet der Zürcher Tages-Anzeiger.

"Klimaschutz per Gericht" entwickelt sich derzeit zum wichtigen Standbein im Kampf gegen Treibhausgase. Mit dem Paris-Vertrag gibt es aller Voraussicht nach bald eine starke völkerrechtliche Grundlage dafür. Erfolgreich waren bereits Privatklagen wegen unterlassenem Klimaschutz gegen Regierungen in den Niederlanden und in Pakistan sowie in mehreren US-Bundesstaaten. Noch nicht entschieden sind die Klagen von elf prominenten Belgiern gegen Bundes- und Landesregierungen sowie die Klage eines Peruaners gegen den Kohlekonzern RWE. Auf den Philippinen geht auch eine Regierungskommission juristisch gegen 47 Weltkonzerne vor.

Und Deutschland rühmt sich, dafür einer der wesentlichen Zahlmeister zu werden

Auf dem VII. Petersberger Klimadialog im Juli hat Frau Merkel mitgeteilt, dass Deutschland eine führende Rolle zum Klimawandel einnehmen will und sie nicht im Entferntesten daran denkt, dazu eine kritische Meinung zu akzeptieren. Auch Frau Hendricks bekannte Klimahysterie wurde von ihr positiv gewürdigt.

Rede von Bundeskanzlerin Merkel zum VII. Petersberger Klimadialog am 5. Juli 2016

(Ganz kurze Auszüge):

Wir als Bundesregierung befassen uns morgen im Kabinett mit dem Gesetzentwurf zur Ratifizierung des Pariser Abkommens. Wir wollen versuchen, den gesamten Prozess noch vor der Klimakonferenz in Marrakesch abzuschließen. Die Ratifikationsurkunde wollen wir anschließend zusammen mit der Europäischen Union und den anderen Mitgliedstaaten übermitteln und damit das klare Signal senden, dass Europa die Ergebnisse von Paris umsetzt und beim Klimaschutz an einem Strang und dann auch noch in eine Richtung zieht.

Nicht nur bei uns, sondern in allen Regionen der Welt gibt es sehr viel Bewegung. Die globale Transformation hat bereits begonnen.

Neben langfristigen Strategien sind natürlich schon ziemlich bald konkrete Klimabeiträge gefragt. Das ist der zweite Punkt, auf den es ankommt, um das Pariser Abkommen mit Leben zu füllen. Es ist sehr erfreulich, dass alle Staaten freiwillige Klimabeiträge geboten haben. Wie der Außenminister schon sagte: Diese reichen aber in der Summe noch nicht aus, um die Zwei-Grad-Obergrenze einzuhalten. Deshalb haben wir sehr darauf gesetzt, dass es alle fünf Jahre eine Revision gibt. Diese Revisionen werden sicher auch schmerzlich werden, weil man sehr gut sehen wird, wie weit wir gekommen sind. Ich habe mir jüngst noch einmal den CO2-Anstieg der weltweiten Emissionen angeschaut. Die Zahlenreihe von 1900 bis in die heutige Zeit sieht wirklich bedrohlich aus.

Ziele sind fein, aber sie müssen auch mit einer vernünftigen Finanzierung unterlegt werden. Das ist der dritte Aspekt. Das Abkommen nimmt uns in die Pflicht, Finanzflüsse mit einer emissionsarmen, klimaschonenden Entwicklung in Einklang zu bringen.

Ausgangspunkt ist das, was von der Konferenz in Kopenhagen positiv übrig geblieben ist, nämlich die Zusage, aus öffentlichen und privaten Quellen ab 2020 jährlich 100 Milliarden US-Dollar für ärmere Staaten bereitzustellen.

Ich will hier noch einmal sagen: Ich halte das für einen richtigen Ansatz. Ein Kohlenstoffpreis lenkt Investitionen in kohlenstoffarme Infrastrukturen, Technologien und Produkte. Ein solcher Preis sorgt dafür, dass Emissionen dort reduziert werden, wo dies besonders kosteneffizient möglich ist. Zudem werden öffentliche Einnahmen gewonnen, die für die Klimafinanzierung sowohl im In- als auch im Ausland verwendet werden können.

Es ist nicht übertrieben zu sagen: Klimaschutz ist nicht mehr und nicht weniger als eine Frage des Überlebens. Lassen Sie uns deshalb das Klimaabkommen mit Leben erfüllen.

Wer beliebig Geld (seiner Steuerzahler) verschenkt, ist sicher rund um die Welt allseits beliebt. Ob man deshalb geachtet wird, steht auf einem anderen Blatt. Aber um einmal einen gut dotierten und mit viel Ehre verbundenen Posten in einem internationalen Gremium zu erlangen, wird es wohl reichen.

Was dies (hier für die „klimaneutralen Energien“) bedeutet, hat Fred F. Mueller auf EIKE jüngst beschrieben:

Rechts überholt und elegant geschnitten: Die Vertreter der „erneuerbaren“ als betrogene Betrüger

Fazit

So lange kritisches Denken beim Klimawandel nicht akzeptiert wird, wird die Klimahysterie so weiter gehen und sich eher noch beschleunigen. Und den Deutschen Steuerzahler wird es viel Geld kosten, welches ohne den geringsten Klimanutzen die Taschen reicher Banker (wie es Frau Merkel in der „Petersberger“ Erklärung extra begrüßt) und reicher Potentaten füllt.

Dafür, dass sich das nicht ändert (und die Fördergeld-Quellen erhalten bleiben), sorgen Klimaberater wie Prof. C. Kemfert, welche mit ihrer Homepage-Information regelmäßig belegen, dass überhaupt kein Interesse besteht, klimaalarmistische Meldung vor der Publikation zu hinterfragen und auf ihren Wahrheitsgehalt zu prüfen[17].

Nachtrag Sichtung untergehender Inseln

Anbei eine Listung bisheriger Untersuchungen über aufgrund des Klimawandels angeblich unter gehender Inseln:

Stuttgarter Nachrichten 07. Juli 2016: Eine Südseeinsel trotzt dem Untergang

EIKE 11.07.2016: Florida Keys: Ein Paradies geht unter – wegen des Klimawandels?

EIKE 28.07.2016: Löst sich das Rätsel versinkender Inseln? Dokumentarfilm Sandraub – das Ende der Strände

EIKE 14.05.2016: Schon fünf Salomonen-Inseln sind durch den Klimawandel versunken – obwohl der Pegel dort nicht gestiegen ist

EIKE 14.12.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 3 Die Marshall-Inselgruppe – (kein) Beispiel für einen Untergang

EIKE 26.11.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 2

EIKE 17.09.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 1 Die Malediven

DONNER + Doria, 12.Dez. 2012: Inseln, die einfach nicht untergehen wollen

Anlage Tidenpegel

Hinweis: Die Nummern beziehen sich auf die zugefügte Stationskennzeichnung in Bild 1

Bild Messstelle Adak Alaska (Nr. 5)

Bild Messstelle Nome Alaska (Nr. 2)

Bild Messstelle Ratmanova Russland (Nr. 1)

Bild Messstelle Netten Russland (Nr. 3)

Bild Messstelle Providenia Russland (Nr. 4)

Bild Messstelle Prudhoe Bay Alaska (Nr. 6)

Bild Messstelle Anchorage Alaska (Nr. 7)

Quellen

[1] Berliner Zeitung 18.08.2016: Klimawandel : Inseldorf in Alaska flieht komplett aufs Festland

http://www.berliner-zeitung.de/panorama/klimawandel–inseldorf-in-alaska-flieht-komplett-aufs-festland-24608070

[2] grist Aug 15, 2016: Stay or go? Alaska Native community votes on a difficult decision

http://grist.org/climate-energy/stay-or-go-alaska-native-community-faces-difficult-decision/

[3] Kronen Zeitung 18.08.2016: Wegen Klimawandel Im US- Staat Alaska hat ein 600- Seelen- Dorf per Volksentscheid einen Komplettumzug von einer Insel aufs Festland beschlossen.

http://www.krone.at/welt/alaska-ganzes-inseldorf-flieht-aufs-festland-wegen-klimawandel-story-525277

[4] DER SPIEGEL 09.06.2008: KLIMAWANDEL Ein Dorf verklagt die Welt

http://www.spiegel.de/spiegel/print/d-57359766.html

[5] peninsula CLARION July 21, 2002: Shishmaref residents vote to move village

http://peninsulaclarion.com/stories/072102/ala_072102alapm0020001.shtml#.V7XUGYVOKP5

[6] Mason, O.K., J.W. Jordan, and L. Plug, 1995. Late Holocene storm and sea level history in the southern Chukchi Sea.

[7] Yuri Gorokhovich and Anthony Leiserowiz: Historical and Future Coastal Changes in Northwest Alaska (doi: 10.2112/JCOASTRES-D-11-00031.1)

[8] kaltesonne 27. Oktober 2013: Klimaerwärmung in China, Alaska und Kanada verzweifelt gesucht

http://www.kaltesonne.de/klimaerwarmung-in-china-alaska-und-kanada-verzweifelt-gesucht/

[9] Benjamin F. Clegg at al. October 21, 2011: Nonlinear response of summer temperature to Holocene insolation forcing in Alaska

[10] Yeo, S., Kim, K., Yeh, S. et al. Clim Dyn (2014) 42: 2423. doi:10.1007/s00382-013-2042-z Recent climate variation in the Bering and Chukchi Seas and its linkages to large-scale circulation in the Pacific

http://link.springer.com/article/10.1007/s00382-013-2042-z

[11] EIKE 14.12.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 3 Die Marshall-Inselgruppe – (kein) Beispiel für einen Untergang

http://www.eike-klima-energie.eu/news-cache/gehen-die-suedseeinseln-wirklich-wegen-des-klimawandels-unter-teil-3-die-marshall-inselgruppe-kein-beispiel-fuer-einen-untergang/

[12] Klimaretter.Info 20.08.2016: Alaska: Ein Dorf flieht vor dem Klimawandel

http://www.klimaretter.info/umwelt/hintergrund/21767-alaska-ein-dorf-flieht-vor-dem-klimawandel

[13] Can. J. Earth Sci. 45: 1377–1397 (2008) J.L. McKay at al.: Holocene fluctuations in Arctic sea-ice cover: dinocyst-based recon structions for the eastern Chukchi Sea

[14] Muyin Wang, James E. Overland, Phyllis Stabeno, 2012: Future climate of the Ber ing and Chukc hi Seas projected by global climate models

[15] XIAOLAN L. WANG,YANG FENG, AND VAL R. SWAIL. Mai 2015: Historical Changes in the Beaufort–Chukchi–Bering Seas Surface Winds and Waves, 1971–2013

[16] EIKE 11.05.2016: Die Problematik der Temperaturrekonstruktion Eine beispielhafte Sichtung dazu anhand des Projektes PAGES 2k

http://www.eike-klima-energie.eu/news-cache/die-problematik-der-temperaturrekonstruktion-eine-beispielhafte-sichtung-dazu-anhand-des-projektes-pages-2k/

[17] EIKE 23.07.2016: Der Unterschied in der Klimawandel-Berichterstattung

Kritik an der Berichterstattung des Portals Klimaretter.Info

http://www.eike-klima-energie.eu/news-cache/der-unterschied-in-der-klimawandel-berichterstattung/

[18] EIKE 15.06.2016: Staaten für mehr Klimaschutz verklagen ist cool

http://www.eike-klima-energie.eu/news-cache/staaten-fuer-mehr-klimaschutz-verklagen-ist-cool/

[19] EIKE 21.08.2015: Die Ökokirche beginnt zuzuschlagen Eine Klimastiftung verklagt den Staat wegen zu wenig Klimaschutz – und gewinnt

www.eike-klima-energie.eu/news-cache/die-oekokirche-beginnt-zuzuschlagen-eine-klimastiftung-verklagt-den-staat-wegen-zu-wenig-klimaschutz-und-gewinnt/

[20] Listung EIKE 11.07.2016: Florida Keys: Ein Paradies geht unter – wegen des Klimawandels?

http://www.eike-klima-energie.eu/news-cache/florida-keys-ein-paradies-geht-unter-wegen-des-klimawandels/

EIKE 28.07.2016: Löst sich das Rätsel versinkender Inseln? Dokumentarfilm Sandraub – das Ende der Strände

http://www.eike-klima-energie.eu/news-cache/loest-sich-das-raetsel-versinkender-inseln-dokumentarfilm-sandraub-das-ende-der-straende/

EIKE 14.05.2016: Schon fünf Salomonen-Inseln sind durch den Klimawandel versunken – obwohl der Pegel dort nicht gestiegen ist

http://www.eike-klima-energie.eu/news-cache/schon-fuenf-salomonen-inseln-sind-durch-den-klimawandel-versunken-obwohl-der-pegel-dort-nicht-gestiegen-ist/

EIKE 14.12.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 3 Die Marshall-Inselgruppe – (kein) Beispiel für einen Untergang

http://www.eike-klima-energie.eu/news-cache/gehen-die-suedseeinseln-wirklich-wegen-des-klimawandels-unter-teil-3-die-marshall-inselgruppe-kein-beispiel-fuer-einen-untergang/

EIKE 26.11.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 2

http://www.eike-klima-energie.eu/climategate-anzeige/gehen-die-suedseeinseln-wirklich-wegen-des-klimawandels-unter-teil-2/

EIKE 17.09.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 1 Die Malediven

http://www.eike-klima-energie.eu/news-cache/ist-der-reiche-westen-wirklich-an-den-inselfluechtlingen-schuld-weil-er-co2-emittiert-teil1-die-malediven/

Stuttgarter Nachrichten 07. Juli 2016: Eine Südseeinsel trotzt dem Untergang

http://www.stuttgarter-nachrichten.de/inhalt.klimawandel-eine-suedseeinsel-trotzt-dem-untergang.ed9f28a3-6591-4eb1-98dd-db6218069cc0.html

[21] DONNER + Doria, 12.Dez. 2012: Inseln, die einfach nicht untergehen wollen

http://donnerunddoria.welt.de/2012/12/12/inseln-die-einfach-nicht-untergehen-wollen/

[22] EIKE 31.07.2015: Fakten zu Gletscherschwund und Co. – und wie Ideologie unsere Natur zerstört

http://www.eike-klima-energie.eu/klima-anzeige/fakten-zu-gletscherschwund-und-co-und-wie-ideologie-unsere-natur-zerstoert/

Update vom 29. 08 2016, Bilder 4 und 5 sind neu, incl. der zugehörige Text

Helmut Kuntz