Begeht die „Nachrichten“-Agentur Reuters Betrug?

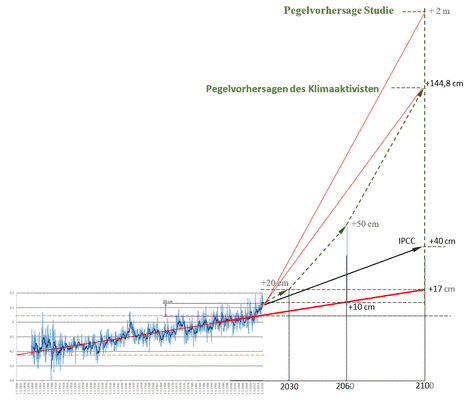

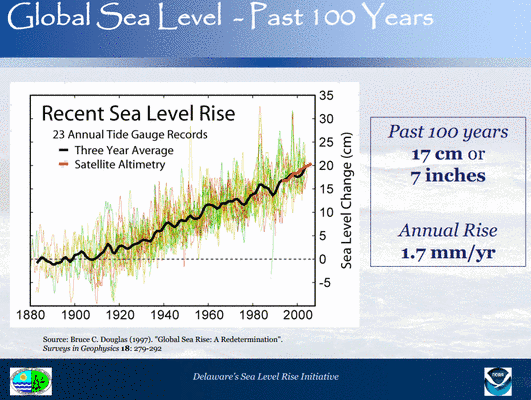

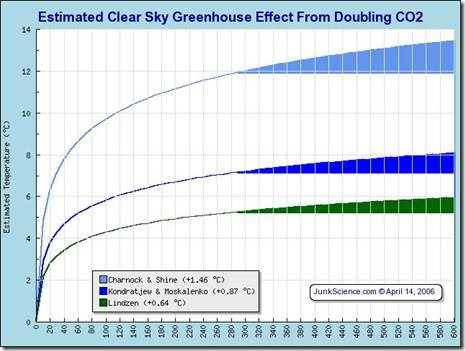

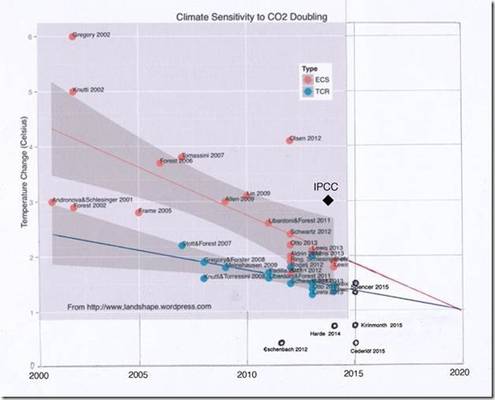

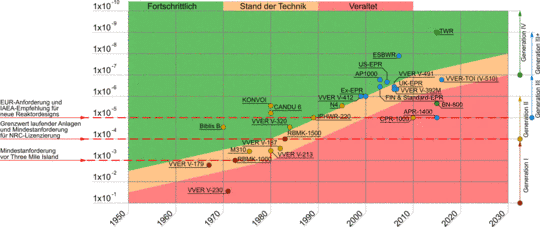

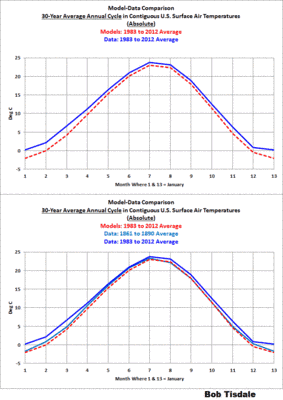

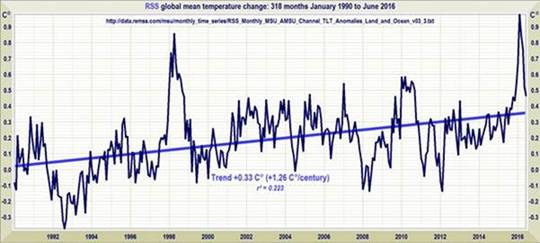

Bild rechts: Das Globale-Erwärmung-Speedometer von Januar 2001 bis Juni 2016 zeigt die gemessene Erwärmung in den Datensätzen von HadCRUT4 und NCEI, die noch unter der geringsten, vom IPCC im Jahre 1990 geschätzten Zahl lag sowie im unteren Bereich der Prophezeiungen aus den Jahren 1995 und 2001. Die Satelliten-Datensätze zeigen dagegen weniger Erwärmung als sämtliche IPCC-Prophezeiungen von 1990 bis 2001. Seit jüngeren IPCC-Schätzungen ist zu wenig Zeit vergangen, um diese zuverlässig testen zu können.

Alle Beobachtungen zeigen erhebliche Auswirkungen der jüngsten El-Niño-Spitze, welcher durchaus eine korrigierende La Niña folgen könnte. Es ist wahrscheinlich, dass sich dann wieder der Stillstand einstellt, doch würde ich darauf noch nicht wetten. Der Theorie zufolge wäre mittel- und langfristig eine gewisse Erwärmung zu erwarten, insgesamt aber keine sehr große.

War es also wirklich zu viel Arbeit für Reuters, die IPCC-Prophezeiungen mit den Beobachtungen zu vergleichen? Reuters preist das IPCC ob dessen numerischer Daten. War es also wirklich zu viel Arbeit, anstatt in abstoßender Weise eine Tischvorlage hervorzuwürgen, den jeder Kunde selbst hätte vom WMO herunterladen können?

„Der Juni“, heißt es in dem ergreifenden Stück Arbeit von Reuters, „markiert den 14. Monat hintereinander mit Rekord-Wärme“. [Das erschien natürlich augenblicklich auch in der „Süddeutschen Zeitung“! Anm. d. Übers.] Aber – als Ted Cruz die WUWT-Graphik mit dem Stillstand im November vorigen Jahres dem Senat präsentierte – gab es da nicht ein erhebliches Wehklagen, dass 19 Jahre eine zu kurze Zeit sei, um irgendwelche Schlussfolgerungen zu ziehen?

Und doch hat Reuters, die vermeintlich diskontfähige Finanz-/Statistik-Nachrichtenagentur, bedingungslos eine WMO-Propaganda verbreitet, der zufolge 14 Monate ausreichend seien, um zu bestätigen, was Private Fraser in Dad’s Army [eine amerikanische Comedy-Fernsehserie] uns schon lange gesagt hat: „Wir sind dem Untergang geweiht“ [We’re a’ doomed!]

“We’re a’ DOOMED!”

Weiter. Reuters zitiert ohne jede Nachfrage einen Sprecher der WMO mit den Worten: „Was wir während der ersten sechs Monate dieses Jahres 2016 gesehen haben, ist wirklich ziemlich alarmierend. Dieses Jahr zeigt, dass sich der Planet viel schneller in viel kürzerer Zeit erwärmen kann als erwartet … Wir haben längst nicht so viel Zeit wie gedacht“.

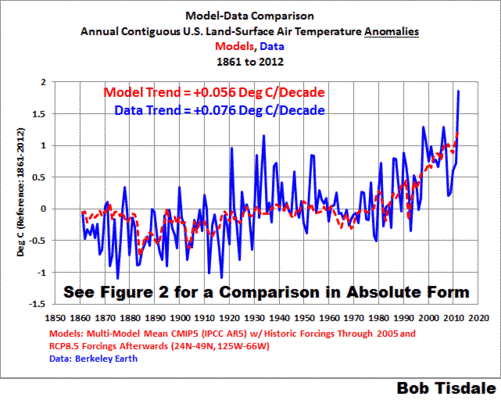

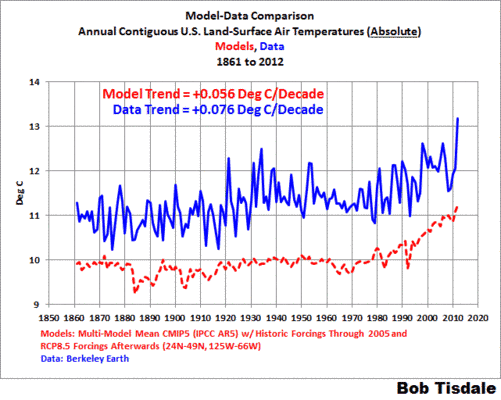

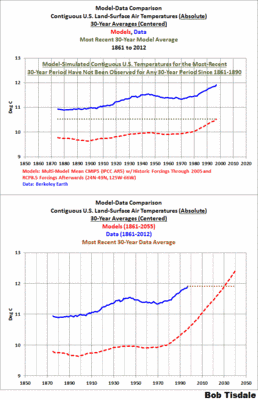

Ähem – nein! Man schaue auf die Prophezeiungen und dann auf die gemessene Realität, sogar noch nach all den Datenmanipulationen. Es sollte sogar der durchschnittlichsten journalistischen „Intelligenz“ bei Reuters klar sein, dass sich der Planet derzeit weitaus langsamer erwärmt als gedacht.

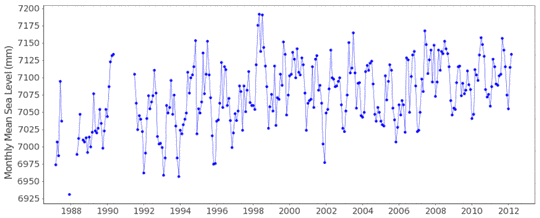

Weiter. Reuters wiederholt ungefragt, dass „die mittlere Temperatur während der ersten sechs Monate des Jahres 2016 um 1,3°C höher lag als während der präindustriellen Zeit zum Ende des 19. Jahrhunderts, jedenfalls der Weltraumagentur NASA zufolge“.

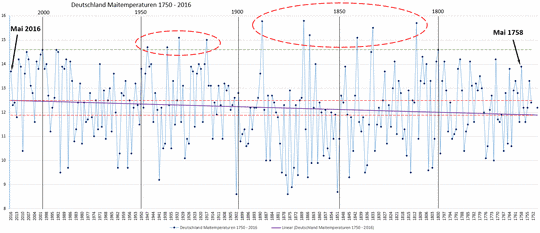

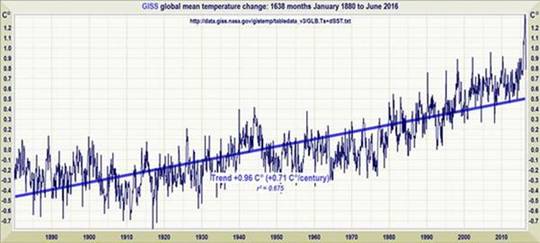

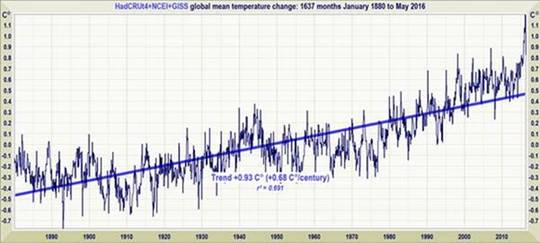

Ähem – nein! Selbst wenn man sich auf den globalen Temperatur-Datensatz verlässt, der am meisten manipuliert und am voreingenommensten ist, nämlich den Datensatz der „Weltraumagentur NASA“, beträgt die Rate der globalen Erwärmung seit Beginn des Datensatzes im Januar 1880 weniger als 1 Grad, äquivalent zu bloßen 0,7°C pro Jahrhundert. Das ist nicht wirklich Angst erzeugend. Es liegt deutlich innerhalb der natürlichen Variabilität.

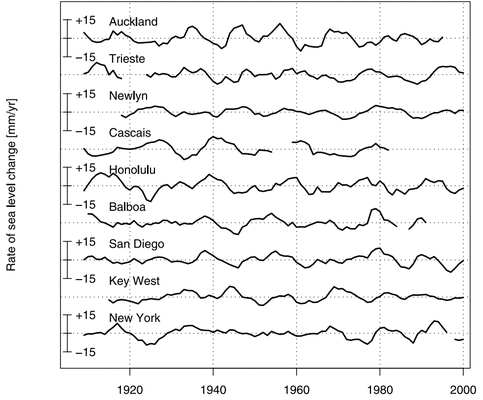

Gibt es bei Reuters niemanden mehr mit ausreichenden grundlegenden mathematischen Kenntnissen um zu wissen, dass man in der Statistik keine willkürlichen Vergleiche anstellen sollte zwischen Perioden von Monaten bzw. Jahrzehnten? Es ist besser, den Trend in den Daten zu bestimmen:

Weiter. Reuters „berichtet“ ungefragt, dass „im Zuge des Pariser Abkommens fast 200 Regierungen zugestimmt haben, die globale Erwärmung deutlich unter 2°C zu halten, verglichen mit dem vorindustriellen Niveau, während ,Bemühungen‘ verfolgt werden sollen, sie unter 1,5°C zu halten – einem unteren Limit, dass schon jetzt fast erreicht ist“. Oh Mann – nein! Zieht man das Mittel aller drei Datensätze heran, beträgt der Erwärmungstrend seit 1880 etwas mehr als 0,9°C, was noch einen Spielraum von 0,6°C übrig lässt, bevor das neue willkürliche Ziel von 1,5°C erreicht wird – und einen solchen von 1,1°C, bevor das zuvor gesetzte willkürliche Ziel von 2°C erreicht wird.

Gibt es niemanden bei Reuters, der eine grundlegende lineare Trendanalyse kleinster Quadrate durchführen kann? Das ohne jede Notwendigkeit propagierte „untere Limit“ von 1,5°C ist in keiner Weise „fast schon erreicht“.

Weiter. Als Nächstes lässt Reuters ohne jede Nachfrage einen „Experten“ zu Wort kommen: „Es gibt nahezu kein plausibles Szenario, das uns etwas anderes liefert als ein außerordentliches Jahr hinsichtlich Eis (Schmelze), CO2, Temperatur – also all der Dinge, die wir im Auge haben“.

Himmel – nein, nein und nochmals nein!

Was die Eisschmelze angeht – eine weitere totalitäre Propaganda-Expedition hat sich aufgemacht, um „die Aufmerksamkeit zu steigern“ bzgl. der Klima-„Katastrophe“. Man versucht, die Arktis im Sommer zu umsegeln. Die Tour musste kürzlich abgebrochen werden wegen – ähm – zu viel Eis. Weder die Nordwest- noch die Nordostpassage ist offen. Die Expedition wurde aufgehalten in einem der grässlichsten Orte – Murmansk. Das sollte ihnen zu denken geben!

Einmal habe ich die Eigentümer des mondänen Mega-Schiffes The World davor bewahrt, ein Vermögen zu verlieren, als der ansonsten geistig völlig gesunde Kapitän der Idee verfallen war, durch die Nordwest-Passage zu fahren, und ich ihn davon abgebracht habe.

Zu jener Zeit lag The World in Fremantle vor Anker. Meine liebe Frau und ich verbrachten ein paar Tage an Bord. Wir irrten auf dem ganzen Schiff umher, als wir irrtümlicherweise in das Büro des Kapitäns stolperten, wo er und seine Offiziere in bester Stimmung über Pläne brüteten, die Nordwest-Passage zu durchfahren.

Der Kapitän nahm uns mit auf die Brücke und erklärte uns mit jenem verträumten Blick des Abenteurers in seinen Augen alles über seine Idee. Ich rief die globalen und arktischen Meereis-Daten der University of Illinois auf dem Schiffscomputer auf und hielt dem Kapitän einen kurzen Vortrag hinsichtlich der sehr wenigen Gelegenheiten im vorigen Jahrhundert, in denen die Nordwest-Passage offen war.

Die Arktis, erklärte ich ihm, war unvorhersagbar, weshalb er nicht zu bereitwillig den Wirklich Gläubigen bei jedem erbarmungswürdigen, aber vorübergehend in Mode befindlichen Dogma der Neuen Religion folgen sollte. Er sah sofort ein, dass sein Vorhaben unmöglich war und setzte sich mit den Eigentümern des Schiffes in Verbindung, noch einmal nachzudenken.

Können wir vielleicht auch nur einen einzigen „Journalisten“ von Reuters von den verschiedenen globalen institutionellen Profiteuren des Untergangs fortführen, die ihre sinnlosen Tage in verschwenderisch ausgestatteten, den Planeten zerstörenden und ventilierten Hallen lange genug verbringen, um die Daten der realen Welt draußen zu checken?

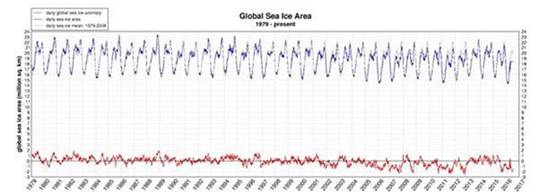

Auf der Meereis-Site von WUWT zeigen die Daten der University of Illinois Folgendes, was nicht sehr ängstigend ist:

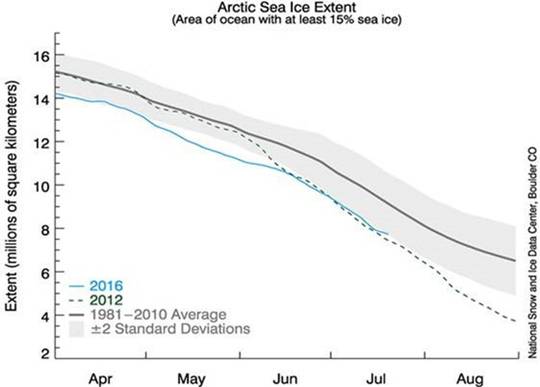

Der Graphik des National Snow and Ice Data Center zufolge ist es möglich, jedoch recht unwahrscheinlich, dass es ein oder zwei Wochen lang in diesem Sommer keine arktische Eiskappe geben wird:

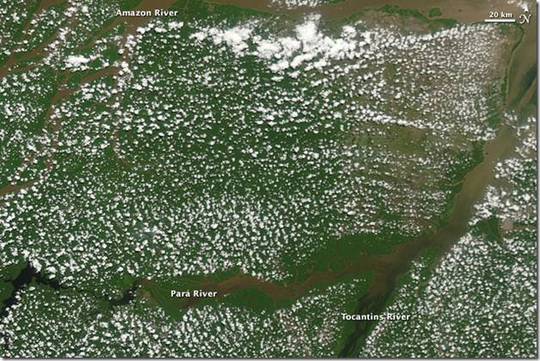

Selbst wenn das Eis ein oder zwei Wochen lang verschwinden würde – na und? Das Gleiche galt für die zwanziger und dreißiger Jahre, in denen es wärmer war als heute, jedoch gab es noch keine Satelliten, um dies zu zeigen. Würde ein totaler Eisverlust die Albedo der Erde drastisch verändern? Nein: es ist zu weit nördlich, und in jedem Falle macht den allermeisten Teil der Albedo der Erde die Reflektion durch Wolken aus. Die Erdoberfläche hat damit nur sehr wenig zu tun, außer vielleicht während der Schneedecken-Saison im nordhemisphärischen Winter, aber vier Fünftel der Schnee-Albedo stammen vom Festland, nicht vom Arktischen Ozean.

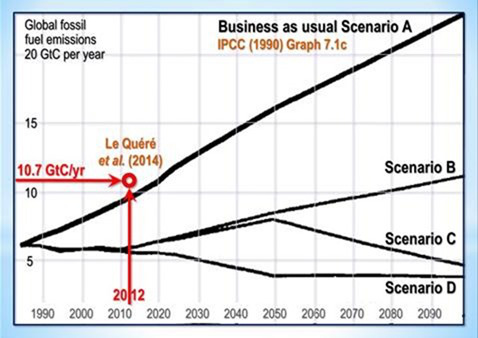

Was das CO2 angeht – trotz aller Propaganda der Totalitarians hinsichtlich der Notwendigkeit, die Welt wegen seiner Emissions-Sünden in Haftung zu nehmen (Propaganda, für die Reuters schon immer ein unermüdlicher und widerlich kriecherischer Cheerleader war), nehmen die Emissionen weiterhin mit einer Rate zu, die so ziemlich über dem Nichtstun-Szenario des IPCC aus dem Jahre 1990 liegt:

Falls es das wirkliche Ziel all jener Propaganda war, den Welt-Ausstoß von CO2 zu reduzieren, hätte jener Ausstoß bis jetzt ohne Zweifel zurückgehen müssen. Aber das wirkliche Ziel, das erreicht worden ist, ist der Krieg gegen und die Zerschlagung der US-Kohleindustrie, ehemals eine der größten Finanziers der Republikanischen Partei.

Soweit ich sehe, haben die faulen „Journalisten“ von Reuters niemals berichtet, dass die einzige IPCC-Prophezeiung, die hinter der Realität zurückgeblieben war, die globale CO2-Emissionsrate war. Der Gesamteffekt all jener internationalen Konferenzen war genau Null.

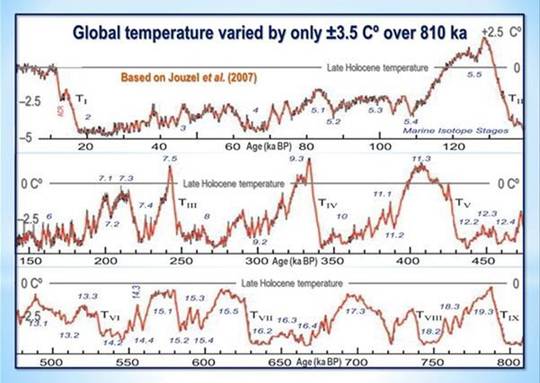

Was die Temperatur betrifft – wird dies wirklich ein „außerordentliches Jahr“? Dazu wollen wir etwas machen, wofür kein Reuters-„Journalist“ das Wissen, den Verstand oder das Interesse hat, nämlich die heutigen Temperaturen in einen Zusammenhang stellen mit Temperaturen in geologischen Zeiträumen, sprich der letzten vier großen Warmzeiten zwischen den Eiszeiten.

In allen vier dieser Warmzeiten während der letzten 450.000 Jahre war es genauso warm oder sogar wärmer als gegenwärtig. Alle jene prähistorischen SUVs, könnte man annehmen.

Soweit ich weiß, hat Reuters niemals darauf hingewiesen, dass es nicht das geringste Außerordentliche gibt hinsichtlich der derzeitigen globalen mittleren Temperatur. Auf der Welt gab es das alles schon mal zuvor – und alles hat überlebt.

Weiter. Reuters hat sich dazu durchgerungen, die Existenz der jüngsten starken El Niño-Spitze einzuräumen, obwohl natürlich der Propagandist, der den Beitrag verfasst hat, es irgendwie versäumt hat zu erwähnen, dass dies ein natürliches und regelmäßig auftretendes Ereignis ist und nicht eine plötzliche Folge der globalen Erwärmung:

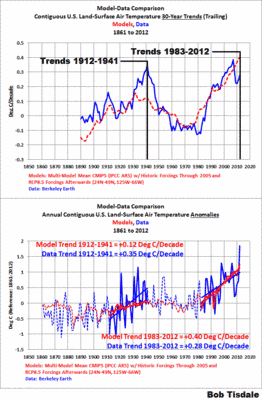

El Niño-Spitzen der Jahre 1998, 2007, 2010 und 2016. Die Rate der globalen Erwärmung seit 1990, äquivalent zu 1,26 K pro Jahrhundert, liegt weit unterhalb des vom IPCC prophezeiten Intervalls von 2,8 (1,9; 4,2) K pro Jahrhundert.

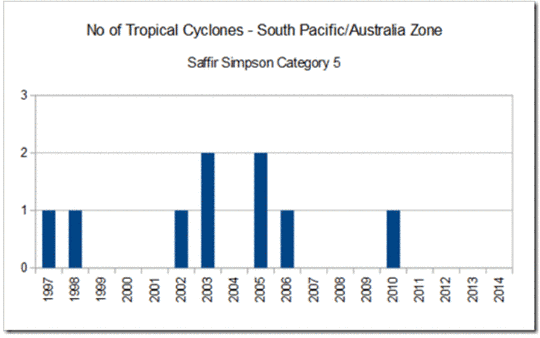

Stattdessen plappert Reuters ohne Nachfrage die Worte des WMO-Generalsekretärs nach: „Der Klimawandel, verursacht durch Wärme einfangende Treibhausgase, wird nicht verschwinden. Dies bedeutet, dass wir mehr Hitzewellen erleben werden! Mehr extreme Regenmengen!! Und potentiell noch stärkere Auswirkungen!!! Tropische Zyklone!!!!“

Nun könnte man erwarten, dass wärmeres Wetter mehr Hitzewellen mit sich bringt. Aber hat Reuters wirklich nichts Besseres zu tun als einen langweiligen, überbezahlten Sektierer der WMO zu zitieren, um uns das mitzuteilen?

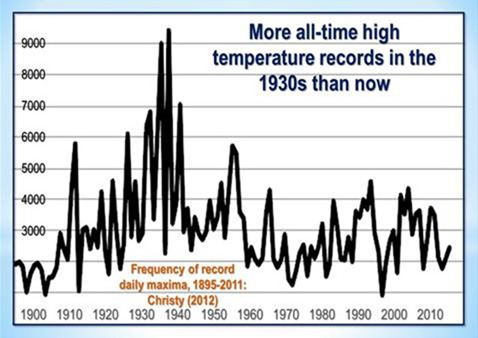

Und selbst wenn, wäre es nicht besser gewesen, wenn Reuters die besten Wetteraufzeichnungen der Welt gecheckt hätte, jene der USA, um zu erkennen, wann die Anzahl von Rekordwerten der täglichen Höchsttemperatur – die Maßzahl für Hitzewellen – am höchsten war?

Die Antwort geht aus den bloßen Fakten hervor: das war in den dreißiger Jahren der Fall, als die CO2-Konzentration noch kaum über ihren vorindustriellen Wert gestiegen war.

Was die „extremeren Regenmengen“ angeht – selbst das IPCC wurde sowohl in seinem Sonderbericht zu Extremwetter als auch im 5. Zustandsbericht davon überzeugt einzuräumen, dass es bis heute kaum Beweise für „extremere Regenmengen“ gibt und auch kaum Gründe, dies demnächst zu erwarten.

Hätte der Reuters-„Journalist“ nicht lange genug ausgenüchtert werden können, um aus den edlen Hallen der WND (mit Hauptquartier in Genf, wo vermutlich die ganze Story erdacht worden war) in die edlen Hallen des IPCC torkeln zu können (ebenfalls in Genf ansässig, wo die Herrschenden gegenüber offizieller Korruption viel nachsichtiger sind als irgendwo sonst auf diesem Planeten)?

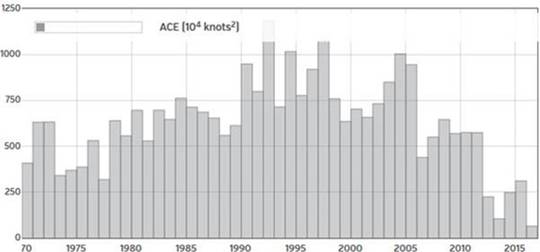

Und was die „stärkeren tropischen Zyklone“ angeht – die Graphik der akkumulierten Zyklon-Energie während der letzten Jahrzehnte entlarvt auch dies als eine Lüge:

Akkumulierter Zyklon-Energie-Index von weatherground.com.

Weiter! Reuters propagiert seine eigene Meinung, wonach „wiederholte Extreme wie Hitzewellen!, Wolkenbrüche!! oder Dürren!!! zu verstärkten Maßnahmen führen können, die Treibhausgas-Emissionen zu begrenzen“.

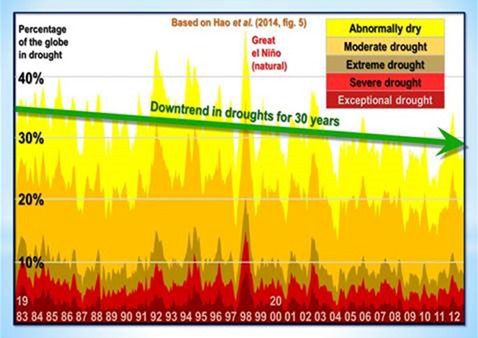

Wir hatten es schon immer mit Hitzewellen und Wolkenbrüchen zu tun. Bezüglich Dürren zeigt die jüngste umfassende Übersicht von Hao et al. 2014, dass es zu einem Rückgang der Festlandsgebiete gekommen war, die von einer Dürre heimgesucht wurden:

Und schließlich die offene Propaganda: Reuters zitiert einen „Klima-Experten“ am International Institute for Applied Taxpayers’ Money Gobbling in Wien mit den Worten: „Forschungen zeigen, dass Extreme den Klimawandel für die allgemeine Öffentlichkeit fassbarer und verständlicher machen. Es könnte helfen, die Menschen zu motivieren, sich bei Klima-Maßnahmen zu engagieren und etwas zu tun“.

Übersetzung: „Die Daten stützen unsere Klima-Profite nicht. Die Fakten stützen sie nicht. Die Graphiken stützen sie nicht. Selbst das Wetter stützt sie nicht. Es gab einfach nicht genug schlechtes Wetter, um uns mit der Entschuldigung für noch mehr Verschwendung von Steuergeldern davon kommen zu lassen. Irgendetwas muss geschehen, und zwar bald, oder wir müssen für unseren Lebensunterhalt arbeiten“.

Ist die Story von Reuters wie so viele andere, die man dort veröffentlicht hatte, nicht eine Fortsetzung des Klimaschwindels, direkt betrügerisch?

Man gebe einfach mal den Terminus „Reuters disclaimer“ in eine Suchmaschine ein. Heraus kommt in Großbuchstaben dies [übersetzt]:

„THOMSON REUTERS DEMENTIERT JEDE GEWÄHR, AUSDRÜCKLICH ODER IMPLIZIT, HINSICHTLICH DER GENAUIGKEIT IRGENDWELCHER INHALTE ODER WAS DIE ZUVERLÄSSIGKEIT DER INFORMATION BZGL. IRGENDEINES ZIELES BETRIFFT“.

Es ist also nicht so, dass man uns angemessen davor gewarnt hat, dass Reuters einfach eine weitere Müll-Website ist, die sich viel mehr totalitärer Propaganda widmet als bloßen Fakten.

Allerdings macht Reuters Kasse – und sehr große! – von verschiedenen Organisationen unter der Voraussetzung zu versuchen, Genauigkeit und Selbstlosigkeit zu erreichen, selbst wenn dies nicht immer erreicht wird. Das „Handbook of ,Journalism’“ von Reuters beginnt mit den folgenden wohlklingenden Worten:

„Alles, was wir Reuters-,Journalisten‘ tun, muss unabhängig sein (wie bitte?), frei von jedwedem Bias (was?) und mit oberster Integrität (wirklich?) ausgeführt werden. Dies sind unsere Kernwerte (Werte?), die sich aus den Vertrauens-Prinzipien (Prinzipien?) von Reuters ergeben. Als Nachrichten-Service (Nachrichten-Service?) in Echtzeit, dessen Ruf auf Zuverlässigkeit beruht (na sowas!), schätzen wir auch Genauigkeit (pull the other one, squire, it’s got bells on) …”

Unter den Zehn Geboten des Reuters-„Journalismus’“ sind Folgende: Genauigkeit immer sakrosankt halten; Fehler offen zu korrigieren, nach Ausgewogenheit und der Vermeidung von Verzerrungen zu streben, Interessenkonflikte zu benennen, keine Meinungen von „Journalisten“ in Nachrichten einfließen zu lassen und nichts zu fabrizieren (Man reiche mir die Anti-Lach-Medizin!)

Trotz des groß geschriebenen und Aufmerksamkeit heischenden Disclaimers hält sich folglich Reuters selbst für eine Organisation, deren Nachrichten-„Journalisten“ sich zumindest Mühe geben, genau, ehrlich, unparteiisch, ungekauft sowie Fakten und Wahrheit zu folgen.

Wie es scheint, mit Ausnahme des Themas Klimawandel.

Jetzt lese man diesen Beitrag noch einmal. Zeigt das Herumeiern um die goldenen Paläste der Korruptions-Hauptstädte Europas irgendwelche wahrnehmbaren Bemühungen welcher Art auch immer, genau, ehrlich, unparteiisch ungekauft zu sein? Wenn Jahr für Jahr die Plattitüden der Totalitarians über die imaginären Einflüsse des Menschen auf das Klima immer wieder und buchstäblich gegen die Fakten und die Daten stehen und von einer zunehmenden Zahl von veröffentlichten Forschungsstudien einschließlich von 250 Studien, die den „Konsens“ ad absurdum führen, herausgefordert werden?

Wenn Sie das wie ich nicht so sehen, klicken Sie bei https://reuters.zendesk.com/anonymous_requests/new, hinterlassen Sie einen Kommentar darüber, was Sie denken, und senden Sie Monckton@mail.com eine Kopie des Kommentars sowie irgendeiner Antwort, die man vielleicht bekommt.

Vor vielen Jahren kannte ich den damaligen Chairman von Reuters, Lord Barneston. Er war ein ehrlicher Mann, der einen Müll wie jüngst von Reuters nie toleriert hätte. Vielleicht hat jemand in der Organisation doch noch ein Gewissen wie er.

Versuchen Sie es! Wir sollten uns hier nicht nur untereinander unterhalten, sondern auch die Außenwelt die Wahrheit wissen lassen. Die Wahrheit wird sich schließlich durchsetzen, aber je öfter wir die Hausierer der Falschheiten herausfordern, umso schneller wird das der Fall sein und umso weniger unschuldige Menschen werden durch die auf diesen Falschheiten beruhenden politischen Maßnahmen getötet.

Link: https://wattsupwiththat.com/2016/07/22/is-the-reuters-news-agency-committing-fraud/

Übersetzt von Chris Frey EIKE

Bemerkung des Übersetzers: Warum zog sich bei der gesamten Übersetzung dieses Beitrags der Gedanke an die „Süddeutsche Zeitung“ wie ein roter Faden durch mein Gehirn?