Man hat mich aufgefordert, einen Beitrag zu schreiben, in dem das Konzept der Energie-Ausbeute im Verhältnis zur Energie-Investition begutachtet wird, und als Ersten Schritt in diese Richtung habe ich eine E-Mail an meine State-side-Freunde Charlie Hall, Nate Hagens und David Murphy geschrieben mit der Bitte, mir Literatur aus jüngerer Zeit zu übermitteln. Die erste Studie stammt von Ferruccio Ferroni und Robert J. Hopkirk und trägt den Titel [übersetzt; Originaltitel siehe unten] „Energieausbeute im Verhältnis zu Energieinvestition (ERoEI) für Photovoltaik-Solarsysteme in Gebieten mit moderater Einstrahlung (1). Die Ergebnisse sind so Atem beraubend, dass ich diesen Beitrag sofort schreiben musste.

Was also ist ERoEI? Es ist einfach das Verhältnis zwischen Energieausbeute und der Energiemenge, die verbraucht wird zur Erzeugung dieser Energieausbeute:

ERoEI = erzeugte Energie / investierte Energie

Einfach, nicht wahr? Nun, ganz so einfach, wie es auf den ersten Blick aussieht, ist es nicht. Um den Punkt herauszuarbeiten: verwendet man PV, wird die erzeugte Energie abhängig sein von Breite, der Sonnenscheindauer, der Ausrichtung der Paneele und auch von der Lebensdauer der Paneele selbst. Und wie misst man die investierte Energie bzw. zeichnet diese auf? Misst man einfach den von der PV-Fabrik verbrauchten Strom, oder fügt man noch die von den Arbeitern, den Bergbauarbeitern verbrauchte Energie hinzu, die das Silikon und die Kohle abgebaut haben, um den Strom herzustellen? Ferroni und Hopkirk beleuchten all diese Details und kommen auf ein Verhältnis ERoEI von Solarpaneelen in gemäßigten Breiten von 0,83. Solar-PV ist also keine Energiequelle, sondern eine Energiesenke. Das gilt für die Schweiz und Deutschland. In Aberdeen dürfte es noch viel schlechter sein!

Warum ist ERoEI so wichtig? Es ist ein für die meisten Individuen fremdes Konzept, einschließlich vieler Ingenieure, Beschäftigten im Energiesektor, Akademiker und Politiker. Das damit in Beziehung stehende Konzept der Gesamt-Energie [net energy] ist definiert als:

Net Energy = ERoEI – 1 (wobei 1 die investierte Energie ist).

Die Gesamtenergie ist der Überschuss an Energie, der von unserem Energie-Input übrig bleibt und den wir gebrauchen, um die Gesellschaft mit Energie zu versorgen – Krankenhäuser bauen, Schulen, Frachtflugzeuge und zum Anbau von Nahrungsmitteln. In der Vergangenheit lag das ERoEI unserer primären Energiequellen – Öl, Gas und Kohle – wahrscheinlich über 50, das heißt, dass eimerweise billige Energie übrig war, um unsere gesamte Infrastruktur einzurichten und alle Menschen zu ernähren, die heute die Erde bewohnen. Aber mit der Gesamtenergie-Gleichung für Solar-PV sieht es so aus:

0,83 – 1 = – 0,17

… Brüssel, wir haben ein Problem!

Wie in aller Welt kann es also sein, dass wir in großem Umfang Apparate zu installieren, die offensichtlich Energie verbrauchen anstatt sie zu erzeugen? Die einfache Antwort lautet, dass unser Finanzsystem, Gesetze und Subventionen in der Lage sind, die Gesetze von Physik und Thermodynamik so lange zu verbiegen, bis wir ein ausreichend hohes ERoEI erreichen, um das ganze System am Laufen zu halten und um parasitäre Erneuerbare zu subventionieren. Man versuche mal, Silikon abzubauen und zu veredeln mittels einer elektrischen Bergbau-Maschine, die von der Sonne angetrieben wird – und die Gesetze der Physik werden sich sehr rasch wieder etablieren.

Einfach ausgedrückt, die in Nordeuropa installierte PV kann man betrachten als Kohle, die in China verbrannt wird zur Stromerzeugung hierzulande. Sämtliche CO2-Emissionen, die die Motive für PV stützen, erfolgen in China. Nur im Falle eines hohen Energie-Gewinns durch die PV-Paneele würden durch Solar-PV CO2-Emissionen reduziert. Mehr dazu weiter unten.

[Hervorhebung vom Übersetzer].

Energie-Ausbeute

Die Berechnungen basieren alle auf die erzeugte Energie von 1 m² PV.

Theoretische Berechnungen der Hersteller, was PV-Module erzeugen sollten, berücksichtigen nicht die operationelle Einbuße durch Staub auf der Oberfläche. Auch schlechte Ausrichtung, Ausfall einer Einheit oder deren Bruch finden keinen Eingang in die Berechnungen, obwohl derartige Störungen sehr verbreitet sind.

Die tatsächlich erzeugte Energie, errechnet mittels Schweizer Statistiken, ergibt sich zu 106 kWe/m² pro Jahr.

Dann müssen wir noch wissen, wie lange die Paneele halten. Die Hersteller behaupten 30 Jahre, jedoch zeigen empirische Beweise, dass die mittlere Lebensdauer in Deutschland lediglich 17 Jahre beträgt. Ferroni und Hopkirk rechnen großzügig mit einer Lebensdauer von 25 Jahren.

Kombiniert man all diese Faktoren, kommt man auf eine Zahl von 2203 kWe/m² während der Lebenszeit einer Einheit.

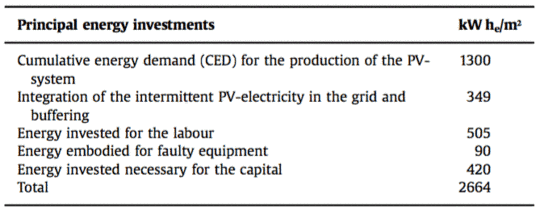

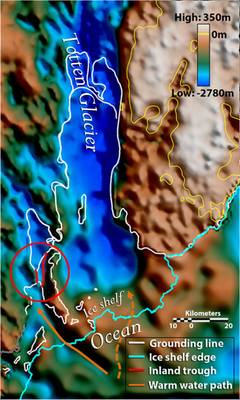

Aufgewendete Energie

Die Berechnung der aufgewendeten Energie erfolgt ebenfalls auf der Grundlage von 1 m² PV-Fläche und verwendet die Material-Masse als Proxy für die verbrauchte Energie und das BIP der Energiedichte als Proxy für den Arbeits-Term in der Gleichung.

Zwei verschiedene Verfahren zur Erfassung der aufgewendeten Energie werden beschrieben:

ERoEI (IEA)

ERoEI (Ext)

Dabei steht IEA für die Verfahren der International Energy Agency und Ext für die erweiterte Grenze wie von Murphy und Hall 2010 beschrieben (2, 3). Der Unterschied zwischen beiden Verfahren ist, dass die IEA dazu tendiert, sich auf die beim Industrieprozess verbrauchte Energie zu konzentrieren, während das erweiterte verfahren von Murphy und Hall 2010 auch Aktivitäten wie Bergbau, Veredelung und Transport des Silikon-Rohmaterials enthält.

Meiner Ansicht nach folgen Ferroni und Hopkirk korrekt dem erweiterten ERoEI-Verfahren von Murphy und Hall. In ihre Berechnungen gehen ein:

● Material zur Herstellung der Paneele, aber auch zur Aufrichtung und Installation derselben

● Arbeit in jedem Stadium des Prozesses, vom Abbau bis zur Entsorgung

● Herstellungsprozess, d. h. die in den verschiedenen Fabriken verbrauchte Energie

● Fehlerhafte Paneele, die aussortiert werden

● Kapital, welches angesehen wird als die Verwertung bereits bestehender Infrastruktur und Energieinvestitionen

● Anschluss der lückenhaften PV an das Netz

Und daraus ergibt sich das Resultat von ERoEI:

2203 : 2664 kWe/m² = 0,83

Der einzige Punkt, den ich in Frage stellen möchte, ist der Einbezug der Energiekosten des Kapitals. Alle erzeugte Energie kann unterteilt werden in Energieverbrauch zur Energiegewinnung und Energie für die Gesellschaft, und ich würde fragen, ob die Kapitalkosten nicht in die letztere Kategorie fallen.

Aber es scheint eine wesentliche Auslassung zu geben, und zwar die Energiekosten der Verteilung. In Europa entfallen etwa 50% der Stromkosten (ohne Steuern) auf Netzausbau und Wartung desselben. Würde man dies auch noch in die Rechnung eingehen lassen, ergäbe sich ein weiterer tiefer Zacken im ERoEI.

Dieser ERoEI-Wert ist niedriger als der Wert 2, wie er von Prieto und Hall (4) angegeben wird und erheblich niedriger als der Wert 5 bis 6, den die IEA nennt (5). Ein Grund hierfür ist, dass die jetzige Studie (1) speziell für Mittlere Breiten gilt. Aber Ferroni und Hopkirk führen auch detailliert Auslassungen der IEA auf, die folgendermaßen zusammengefasst werden können:

a) Der Energiefluss über die Systemgrenzen hinweg und dessen Investition für die Arbeit ist nicht enthalten.

b) Der Energiefluss über die Systemgrenzen hinweg und dessen Investition für das Kapital ist nicht enthalten.

c) Die für die Integration des PV-erzeugten Stromes in eine komplexe und flexible Stromversorgung sowie in ein Verteilungssystem aufgewendete Energie ist nicht enthalten (die Energieerzeugung folgt nicht dem Bedarf der Verbraucher).

d) Die IEA-Leitfäden spezifizieren den Gebrauch eines „primären Energie-Äquivalents“ als eine Grundlage. Da jedoch die erzeugte Energie als sekundäre elektrische Energie gemessen wird, nämlich dem Energieträger selbst, und da etwa 64% bis 67% der aufgewendeten Energie für die Herstellung der PV-Module und -Paneele ebenfalls in Form von Strom vorliegt (Weissbach et al.2013), und da außerdem die Gesetze der Konversion vom Träger oder sekundärer Energie zurück zu primärer Energie nicht wissenschaftlich perfekt sind (Giampietro und Sorman 2013), ist es sowohl einfacher als auch angemessener, die aufgewendete Energie als elektrische Energie zu bezeichnen. Der direkte Beitrag fossiler Treibstoffe, zum Beispiel um die Energie für die Prozesswärme zur Verfügung zu stellen, muss ebenfalls in sekundäre Energie konvertiert werden. Die Konversion der internen chemischen Energie in fossilen Treibstoffen zu Strom wird in modernen Kraftwerken erreicht mit einer Effizienz von 38%, jedenfalls dem statistischen Protokoll von BP zufolge (BP Statistical Review of World Energy, June 2015). In dieser Studie wollen wir zur Vermeidung von Fehlern bei der Konversion weiterhin elektrische (d. h. sekundäre) Energie verwenden mit kW he/m² als zugrunde liegende Energieeinheit.

e) Die angegebene Lebensdauer der Paneele von 30 Jahren muss aufgrund der Erfahrungen bis jetzt als unrealistisch angesehen werden.

f) Die Energieausbeute kann und sollte auf tatsächlichen experimentellen Daten beruhen, gemessen auf dem Feld. Wendet man diese Prozedur an, wird man Werte erhalten, die allgemein viel niedriger liegen als die von Investoren und Politikern erwartete Erzeugung.

Den Punkten a), c) und f) würde ich sofort zustimmen. Beim Punkt b) bin ich mir nicht sicher, und Punkt e) wird Gegenstand von Diskussionen sein. d) ist eine sehr komplexe Angelegenheit und im Grunde das, was ich in meinem jüngsten Beitrag hier beschrieben habe. Ich stimme Ferroni und Hopkirk zu, wenn sie schreiben, dass Einheiten von Strom durchweg verwendet werden müssen, aber falls die IEA die verbrauchte Energie für thermische Verluste in Kraftwerken hochgerechnet hat, würde dies ihre investierte Energie zunehmen lassen und ihre Schätzungen von ERoEI drücken und nicht aufblähen. Dieser Punkt bedarf also noch der Klärung.

Auswirkungen auf die Umwelt

Der Hauptgrund für die Hinwendung zu Solar-PV in Europa ist die Reduktion der CO2-Emissionen. Die Europäische Kommission und die meisten Regierungen in Europa haben in Wolkenkuckucksheim geweilt, als sie CO2-intensive Industrien nach China zu übersiedeln erlaubten, damit die Emissionen in Europa zurückgehen, während sie in China steigen, und weil sie uns glauben machen wollten, dass der aus China importierte Stahl irgendwie emissionsfrei ist.

Das Beispiel Solar-PV rückt dies scharf in den Mittelpunkt. Geht man davon aus, dass der Haupt-Energie-Input von Kohle stammt (und schmutziger Kohle mit geringer Effizienz obendrein) und mit einem ERoEI <1, führt die Stromerzeugung mittels PV in Wirklichkeit zu höheren Emissionen, als wenn man die Kohle gleich von Anfang an zur Stromerzeugung verbrannt hätte. Aber es ist noch viel schlimmer. Alle Emissionen, die mit 25 Jahren der Stromerzeugung assoziiert sind, befinden sich jetzt in der Atmosphäre und würden die globale Erwärmung noch viel schlimmer machen als es ohne PV der Fall wäre [so es diese globale Erwärmung wirklich gibt und so sie wirklich schlimm wäre. Anm. d. Übers.]

Und es wird sogar noch schlimmer! Zur Herstellung der PV-Paneele braucht man außerdem noch viele hässliche Chemikalien:

Viele potentiell gefährliche Chemikalien werden während der Herstellung der Solarmodule gebraucht. Erwähnt werden sollen hier Stickstoff-Trifluorid (NF3; Arnold et al.2013). Dieses Gas wird gebraucht, um verbleibende, mit Silizium kontaminierte Zusätze in den Herstellungsräumen zu reinigen. Dem IPCC zufolge hat dieses Gas ein Potential zur globalen Erwärmung 16.600 mal so hoch wie CO2. Zwei weitere, ähnlich unerwünschte „Treibhaus“-Gase sind Hexafluoräthan (C2F6) und Schwefel-Hexafluorid (SF6).

Und:

Das mittlere Gewicht eines PV-Moduls beträgt etwa 16 kg/m² und das Gewicht des stützenden Systems, der Umwandler und dem Gleichgewicht des Systems mindestens 25 kg/m² (Myrans 2009). Das Gewicht des Betons ist nicht enthalten. Auch sind die meisten verwendeten Chemikalien wie Säuren, Basen, Beizen, elementare Gase, Dotierstoffe [?], photo-lithographische Chemikalien usw. nicht enthalten, da deren Verbrauch nur gering ist. Aber wir müssen Salzsäure (HCl) hinzufügen: Die Herstellung des Solar-Siliziums für ein Quadratmeter Paneelfläche erfordert 3,5 kg konzentrierte Salzsäure.

Vergleich mit Kernkraft

Die Studie zeigt einige interessante Vergleiche mit Kernkraft. Schauen wir zunächst auf das pro Einheit erzeugten Stromes benötigte Material:

● PV verbraucht 20,2 g pro kW he (hauptsächlich Aluminiumstahl und Kupfer)

● Ein Kernkraftwerk verbraucht 0,31 g pro kW he (hauptsächlich Stahl) für einen Nutzungsgrad [load factor] von 85%.

kW he = kilowatt hours electrical

Bezüglich der Arbeitskraft stellen die Autoren fest:

Die in der Erneuerbaren-Industrie involvierten Industrien werben mit ihrer Fähigkeit, viele neue Arbeitsplätze zu schaffen.

Während natürlich die beste Energieform so wenig Arbeitskraft wie möglich erfordern sollte. An einem Punkt, wo ERoEI 1 erreicht, ist jedermann im Bereich Energieerzeugung tätig, und die Gesellschaft, so wie wir sie kennen, kollabiert!

● Solar-PV erzeugt 94,4 Arbeitsplätze pro installierter MW, adjustiert für den Kapazitätsfaktor.

● Kernkraft erzeugt 13 Arbeitsplätze pro installierter MW, darin enthalten sind Aufbau, Betrieb und Stilllegung.

Das könnte für Politiker großartig aussehen, aber es ist diese Ineffizienz, die Solar-PV teuer macht und ERoEI killt. Und schaut man auf die Kapitalkosten:

● Solar-PV kostet CHF 6000 pro installiertem KW (CHF = Schweizer Franken)

● Kernkraft kostet CHF 5500 pro installierten KW.

Aber normalisiert hinsichtlich der Kapazitätsfaktoren von 9% für Solar und 85% für Kernkraft erhalten wir als effektive Kapazität

66.667 : 6471 = 10,3

Fazit: Solar-PV ist zehn mal so kapitalintensiv wie Kernkraft.

Energieumsatz

Wenn ERoEI sich 1 nähert oder unter diesen Wert sinkt, betreten wir den Bereich Energieumsatz, der in unserem Energiesystem ziemlich verbreitet ist. Konvertieren wir beispielsweise Kohle zu Strom, verlieren wir etwa 62% der thermischen Energie. Die Konversion von Kohle und anderer Rohmaterialien in ein PV-Paneel könnte unter bestimmten Bedingungen sinnvoll sein. Zum Beispiel können PV und ein Batteriesystem afrikanische Dörfer mit etwas Strom versorgen, wenn diese keinerlei Aussicht haben, in absehbarer Zeit an ein Netz angeschlossen zu werden. Gleiches gilt für eine Berghütte. Individuen, die sich Sorgen bzgl. Blackouts machen, könnten ebenfalls ein PV-Batteriesystem als Backup in Erwägung ziehen.

Aber hinsichtlich des Zieles der Reduktion von CO2-Emissionen scheitert PV kläglich in Mittleren Breiten. Es fügt dem System einfach Kosten und Rauschen hinzu. In sonnigeren Klimaten könnte sich die Lage verbessern.

Abschließende Bemerkungen

Die Ergebnisse dieser einen Studie zeigen, dass die Installation von Solar-PV in Mittleren Breiten, also in Ländern wie Deutschland und UK, eine einzige Verschwendung von Zeit, Energie und Geld ist. Alles, was man erreicht ist, dass die Strompreise steigen und das Netz destabilisiert wird. Verteidiger von erneuerbarer Energie und Solar werden darauf verweisen, dass dies nur eine einzige Studie ist und dass die von Ferroni und Hopkirk verwendeten Eingangsparameter diskussionswürdig sind. Aber es gibt gute Gründe zu glauben, dass die Ergebnisse ziemlich genau der Realität entsprechen. Zum Beispiel fanden Prieto und Hall ein ERoEI für Solar-PV = 2. Schaut man allein auf wolkige hohe und Mittlere Breiten, wird sich diese Zahl substantiell verkleinern.

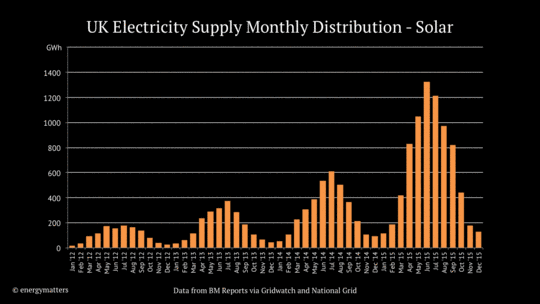

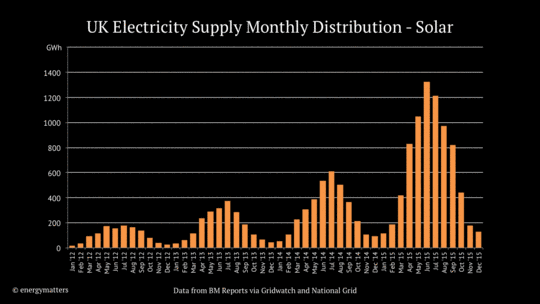

Und man muss sich nur mal die unten gezeigten Outputs ansehen. Solar-PV erzeugt ein Tröpfeln im Winter und absolut gar nichts mehr bei der Bedarfsspitze gegen 18 Uhr. Und hierfür müssen gewaltige finanzielle Kosten und Energie aufgewendet werden, um dies zu kompensieren – und was die Erneuerbaren-Enthusiasten mit einem Schulterzucken vom Tisch wischen.

Abbildung 1, Quelle: UK Grid Graphed: Die Verteilung von Solarerzeugung in UK hat sich im Verlauf von 4 Jahren versiebenfacht. Aber 7 mal Tröpfeln im Winter ist immer noch tröpfeln. Die große Menge Energie in diesen teuren Objekten bringt uns gar nichts, wenn wir es am meisten brauchen.

Energy Matters hat eine gute Sucheinrichtung oben rechts. Man gebe Solar-PV ein, und ich war überrascht zu sehen, wie viele Artikel Roger und ich geschrieben haben und sie alle mehr oder weniger zu den gleichen Ergebnissen kommen. Ich habe diese Links unten an diesen Beitrag angefügt.

Abbildung 2: Eine typische Solar-Installation in Aberdeen, wo sich die Paneele auf einem nach Osten geneigten Dach befinden, während das ideale, nach Süden zeigende Dach frei davon ist. Dies ist ein Symbol für Dummheit und Ignoranz, die inzwischen auch in der Akademiker-Zunft Einzug hält. Hat irgendjemand eine Universität gesehen, die sich keine Solarpaneele auf das Dach gepappt hat? Ich habe Akademien argumentieren hören, dass die Ausrichtung in Schottland gar keine Rolle spielt, und damit könnten sie recht haben. Ich wage zu sagen, dass es kaum einen Unterschied hinsichtlich des Outputs ausmachen würde, wenn man die Solarpaneele einfach in ihrer Verpackung belässt. Akademiker sind natürlich immer stärker darauf bedacht, die Regierungspolitik zu unterstützen. Man beachte, dass sonnige Tage in Aberdeen nur extrem selten auftreten. Und im Winter geht die Sonne gegen 10 Uhr auf und gegen 15 Uhr unter.

Vor zwei Jahren wetterte ich gegen die Zufalls-Ausrichtung von Solarpaneelen in Aberdeen, und zwar in einem Beitrag mit dem Titel Solar Scotland. Und diese Zufalls-Orientierung wird zweifellos zu ernsthaft geringeren Werten von ERoEI führen. PV-Enthusiasten werden ohne Zweifel in ihren Gesamtenergie-Analysen davon ausgehen, dass alle Solarpaneele optimal ausgerichtet sind, während sie dies in der realen Welt von Ferroni und Hopkirk nicht sind. Ein gutes Rezept hierzu wäre die Streichung der Einspeisetarife für Systeme, die nicht optimal ausgerichtet sind, während man in Zukunft die Solar-PV-Einspeisetarife vollständig streicht.

Aber wie kann man erreichen, dass diese Botschaft auf der politischen Ebene gehört wird? Das finale Interview von David McKay war sehr aufschlussreich:

Der einzige Grund dafür, dass Solar überhaupt ein Thema wurde, war Demokratie. Die Parlaments-Abgeordneten wollten einen Solar-Einspeisetarif. Daher wurde gegen den Ratschlag der Bediensteten in den Ministerien ,Nein, wir sollten solar nicht subventionieren‘ diese Politik in Kraft gesetzt. Es gab außerdem sehr erfolgreiche Lobbyarbeit durch die Solar-Lobbyisten. Und so herrscht jetzt weit verbreitet dieser Glaube, dass Solar etwas Wunderbares ist, obwohl … UK eines der dunkelsten Länder der Welt ist.

Falls die Politiker jetzt nicht auf den Ratschlag eines der berühmtesten und angesehensten Energie-Analysten der Welt hören, dann, so glaube ich, werden sie auf niemanden hören. Aber mit der Zeit wird ihnen allmählich und immer mehr dämmern, welche Konsequenzen es hat, wenn ihre Wähler über die Energie-Klippe stürzen.

References

[1] Ferruccio Ferroni and Robert J. Hopkirk 2016: Energy Return on Energy Invested (ERoEI) for photovoltaic solar systems in regions of moderate insolation: Energy Policy 94 (2016) 336–344

[2] Murphy, D.J.R., Hall, C.A.S., 2010. Year in review-EROI or energy return on (energy) invested. Ann. N. Y. Acad. Sci. Spec. Issue Ecol. Econ. Rev. 1185, 102–118.

[3] Murphy, D.J.R., Hall, C.A.S., 2011. Energy return on investment, peak oil and the end of economic growth. Ann. N.Y. Acad. Sci. Spec. Issue Ecol. Econ. 1219, 52–72.

[4] Prieto, P.A., Hall, C.A.S., 2013. Spain’s Photovoltaic Revolution – The Energy Return on Investment. By Pedro A. Prieto and Charles A.S. Hall, Springer.

[5] IEA-PVPS T12, Methodology Guidelines on the Life Cycle Assessment of Photovoltaic Electricity – Report IEA-PVPS T12-03:2011.

Link: http://euanmearns.com/the-energy-return-of-solar-pv/

Übersetzt von Chris Frey EIKE