Was für ein Vorhaben! Was für eine Hybris! Seit Bestehen der Erde ist ihre Atmosphäre von teils drastischen Klimaänderungen betroffen. Und jetzt sollen Änderungen der weltweit unterschiedlichen Lufttemperaturen, die ja wesentliche Elemente des Klimas sind, vertraglich festgelegt werden, so etwa wie die Einstellung des Thermostaten an einer Zentralheizung. Dies ist angeblich möglich durch die als „Dekarbonisierung“ bezeichnete Beendigung aller durch die heutige Lebensweise (Industrie, Verkehr, Wohnen) verursachten Emissionen des Gases Kohlendioxid ( CO2).

Eine Wettervorhersage über mehr als drei Tage ist kaum möglich. Und jetzt wird behauptet, dass sich die langfristigen Mittelwerte dieses komplexen Geschehens durch Einflussnahme auf winzige Änderungen eines einzigen Parameters, der CO2 Konzentration nachhaltig regeln lassen.

Dennoch wurde dieses absurde Vorhaben auf der Klimakonferenz von 195 Ländern plus der EU beschlossen.

Die auf Grund der Klimaänderung beschworenen angeblichen Gefahren treffen hauptsächlich unterentwickelte Länder, die kaum Beiträge zur CO2 Emission leisten und damit von der kostspieligen Dekarbonisierung ihrer Lebensumstände kaum betroffen sind, an der ja angeblich die Industrieländer „Schuld“ sind. Daraus wird ein Anspruch dieser Länder gegen die entwickelte Welt abgeleitet. Diesem Anspruch soll durch Gründung eines UN Klimaschutzfonds genüge geleistet werden, in den die Industrieländer soviel einzahlen, dass daraus jährlich 100 Mrd. $ an die ärmeren Länder verteilt werden können, um diesen zu ermöglichen sich gegen die „Gefahren“ des Klimawandels rüsten zu können. Das wird diese anregen, irgendwelche Projekte zu erfinden, für die sie dann Geld beanspruchen können. Was veranlasst die Geberländer bei dieser gigantischen Vermögensumverteilungs-Maschinerie mit zu machen?

Unerklärlicher Weise gehört das führende Industrieland Deutschland zu den aktivsten Verfechtern dieser Dekarbonisierungsstrategie. Die Angst vor einer die Menschheit bedrohenden Erderwärmung wird vor allem auch durch die links-grün dominierte deutsche Regierung Merkel geschürt. Bereits auf der ersten Weltklimakonferenz COP 1 1995 in Berlin versprach die damalige Umweltministerin Angela Merkel, sich dafür einzusetzen, dass Deutschland stets den höchsten Beitrag aller Industrieländer für den „Klimaschutz“ aufbringen soll. Dies ist eine der wenigen Konstanten in ihrer Politik. Merkel 2007: „Ein weiter so gibt es nicht. Der Klimaschutz ist die größte Herausforderung des Jahrhunderts“. Und bei der G7 Konferenz in Elmau erneut ein Bekenntnis zum Zweigrad-Ziel: „Wir wissen, dass wir dafür tiefe Einschnitte bei weltweiten Treibhausgas-Emissionen brauchen und haben uns deshalb dazu bekannt, dass wir im Laufe dieses Jahrhunderts eine Dekarbonisierung der Weltwirtschaft brauchen“.(Pressekonferenz Sender Phoenix, 8.6.2015)

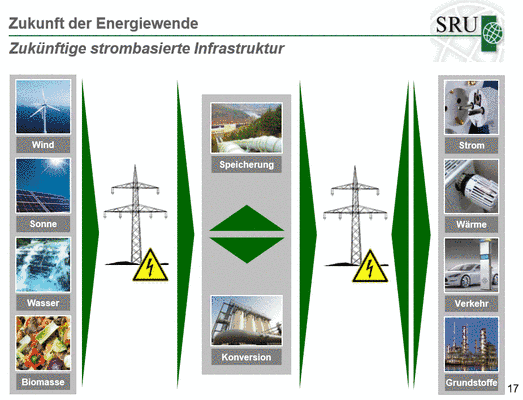

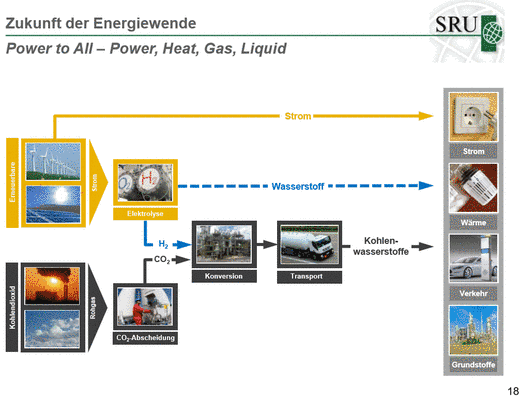

Die Umweltministerin Frau Hendricks propagiert das Auslaufen der Produktion von Verbrennungsmotoren bis Mitte des Jahrhunderts. Das Elektroauto soll dann offenbar die Basis für den Individualverkehr werden. Eine abenteuerlich Vorstellung. Ein teures Fahrzeug, mit dem man ohne Klimaanlage jeweils ca. 100 km fahren kann, bis man an einer hoffentlich freien Ladestation in einer halben Stunde Energie für die nächsten 100 km laden kann. Ein solches Vehikel, dass selbstverständlich in einer Marktwirtschaft praktisch unverkäuflich ist, soll nun durch eine von der Allgemeinheit aufzubringende Subvention von 4000 € gefördert werden. Ein Fahrzeug, das keinen steuerlichen Beitrag zu Ausbau und Erhalt der Verkehrsinfrastruktur leistet. Die technologischen Defizite sollen durch staatlich geförderte Entwicklungen überwunden werden, für die es aber derzeit überhaupt keinen erfolgversprechenden Ansatz gibt.

Als naturwissenschaftlich ausgebildeter Ingenieur steht man diesen politischen Abenteuern fassungslos gegenüber und sucht nach einer Erklärung für eine solche de facto Selbstmord-Strategie.

Das von Angela Merkel auf der Vorkonferenz in Elmau maßgeblich konzipierte Programm der COP 21 in Paris, bedeutet praktisch: 40.000 „Revolutionäre“ beschließen einen neuen Morgenthauplan!

Der Morgenthauplan war bekanntlich der nach Ende des zweiten Weltkriegs 1944 vom US Finanzminister Morgenthau entworfene Plan einer vollständigen Deindustrialisierung Deutschlands, das auf den Status eines Agrarlands zurückentwickelt werden sollte. Insbesondere sollte die Montanindustrie an Ruhr und Saar total beendet werden. Das Wort „Dekarbonisierung“ gab es damals noch nicht, aber es beschreibt genau das!

Exkurs

zu den naturwissenschaftlichen Grundlagen der Hypothese von der menschlich verursachten globalen Erwärmung kurz AGW-Hypothese (Anthropogenic Global Warming).

Zur Begründung wurde ein Gedanke herangezogen, den zuerst Jean Babtiste Fourier im Jahr 1824 beschrieben hat. Einfallendes Licht erwärmt den Erdboden, die vom Erdboden dadurch emittierte Wärmestrahlung wird aber in der Atmosphäre irgendwie absorbiert und erwärmt (Fourier kannte die Strahlungseigenschaften der Gase noch nicht).

Ausgehend von diesen Ideen beschrieb John Tyndall 1862 einen auf den Strahlungseigenschaften der Gase beruhenden Treibhauseffekt. Er erkannte, dass dafür im wesentlichen der Wasserdampf verantwortlich ist, aber auch CO2 eine Rolle spielt. Auf diesen Ideen aufbauend leitete der Physiko- Chemiker Svante Arrhenius (1859 – 1927) im Jahr 1896 ein Klimamodell ab, mit dem er versuchte, die Eiszeiten zu erklären.

Diese Thesen hatten nur ein kurzes Leben. Sie wurden bereits von den berühmten Physikern Gustav Kirchhoff (1824 – 1887) und Robert Bunsen (1811 – 1899) widerlegt. Kirchhoff und Bunsen wiesen anhand der von ihnen aufgestellten und noch heute Bestandteil des elementaren Physikunterrichts bildenden Grundlagen der Wärmeübertragung durch Strahlung nach, dass die Erdatmosphäre als offenes System nicht mit einem Treibhaus verglichen werden darf. Ein strahlender, annähernd schwarzer Körper kann von keiner nur selektiv Strahlung absorbierenden Schicht an seiner Abkühlung gegen einen kalten Hintergrund behindert werden. Insbesondere ist auch eine Wärmeübertragung aus der kalten Hochatmosphäre auf den warmen Erdboden weder durch eine „Gegenstrahlung“ noch durch sonst einen Mechanismus möglich, da dies dem 2. Hauptsatz der Thermodynamik widerspricht!

Die Erde kann nicht mit einem Treibhaus verglichen werden, da das für die Funktion eines Treibhauses entscheidende Bauelement eines Glasdachs fehlt. Der reale Treibhauseffekt beruht nicht auf Strahlungswirkung sondern auf der Behinderung des konvektiven Wärmeaustauschs mit der Umgebung. 1906 lieferte der amerikanische Physiker William R. Wood dafür auch einen experimentellen Beweis durch Vergleich zweier Treibhausmodelle mit einem für Wärmestrahlung durchlässigen und einem undurchlässigen Glasdach. Beide erwärmen sich ungefähr gleich. Die Strahlung spielt keine Rolle.

Mehr ist dazu nicht zu sagen. So funktioniert Naturwissenschaft: Neue Ideen werden geboren und müssen einer Prüfung anhand erprobter Gesetze, Messungen und Beobachtungen standhalten oder werden verworfenen. Das ist die naturwissenschaftliche Methode, wie sie von dem bedeutenden Philosophen Karl Popper[1] in „Conjectures und Refutations“ beschrieben ist. Die letzte Instanz für die Entscheidung, ob eine These Anerkennung findet oder verworfen werden muss, ist immer die Beobachtung.

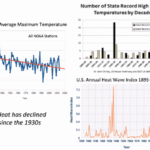

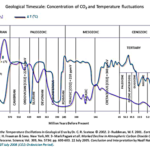

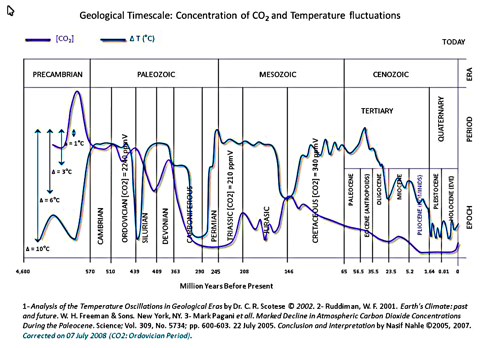

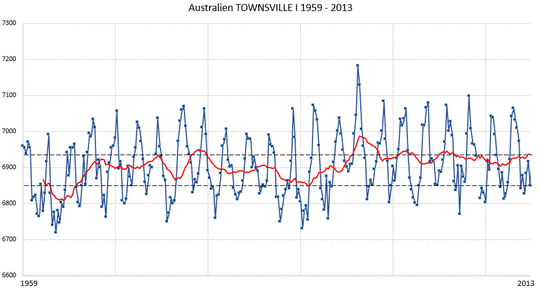

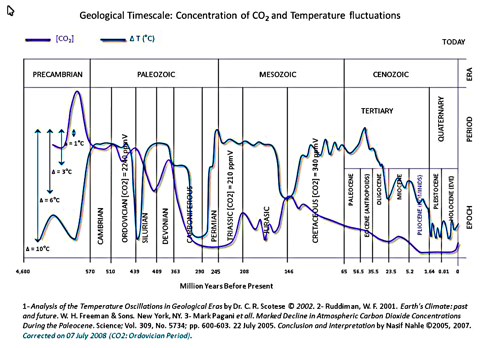

Die klarste Antwort gibt in diesem Fall die Paläoklimatologie: Selbst unter Beachtung der Tatsache, dass derartige über Jahrmillionen gehende und auf verschiedene Proxydaten zugreifende Darstellungen eine vielleicht relativ große Unsicherheit aufweisen, zeigt das Diagramm eindeutig: Es gab und gibt keine Steuerung der globalen Temperatur der Troposphäre durch ihren CO2-Gehalt!

Abbildung 1. Verlauf der CO2 Konzentration und er globalen Mitteltemperatur über geologische Zeiträume.

Beide Größen zeigen aber extreme Werte, die weit über die aktuellen, alarmistisch diskutierten Werte hinausgehen. Insbesondere mit CO2 -Gehalten die mehr als 10 fach über den heutigen Werten liegen ohne dass lebensbedrohliche Temperaturen erreicht wurden.

Siehe Bild oben

Ausgangspunkt des gegenwärtig einen großen Teil der Industrieländer gefährdenden Ökowahns war wahrscheinlich die vom Club of Rom in die Vorstellung der Massen gerückte malthusianistische[2] Vorstellung von den Grenzen des Wachstums, die insbesondere der kapitalistischen Wirtschaft ein Ende bereiten werden. Dies ist der Vorläufer, der heute von der Umweltbewegung entwickelten Hypothese des „Ökologischen Fußabdrucks“[3].

Nach dieser in Deutschland vor allem durch Ernst Ulrich von Weizsäcker vertretenen These gibt es in den Industrieländern große „Nachhaltigkeitsdefizite“ gegenüber den Entwicklungsländern. Die Daten werden vom Global Footprint Network erhoben. Dabei wird die für einem Menschen durchschnittlich verfügbare Land- und Wasserfläche (die sogenannte „Biokapazität“) der von diesem Menschen in Anspruch genommenen Fläche gegenüber gestellt. Die von den Bürgern der Industrieländer in Anspruch genommene Fläche ist dabei im Vergleich zu der in den Entwicklungsländern pro Kopf verfügbaren Fläche zu groß. Slogan: Wollten alle Menschen die von den Bewohnern der Industrieländer beansprucht Fläche nutzen, brauchte man eine zweite Erde!

In diese Berechnungen werden nicht nur die reinen Produktionsflächen, etwa für die Lebensmittelproduktion einbezogen, sondern z.B. auch Ansätze für die Müllentsorgung. Einen großen Teil nimmt die Energiewirtschaft ein, bei der etwa die Waldfläche berechnet wird, die notwendig ist, um die auf eine Person entfallende Kohlendioxidemmission zu neutralisieren. Wie man leicht erkennt, bietet das Konzept eine große Anzahl von willkürlich anwendbaren Stellschrauben, die letztlich jedes gewünschte Ergebnis einstellbar machen.

Das Konzept ist sehr gut und einprägsam zu veranschaulichen. Das Global Footprint Network berechnet z.B. jährlich den „Earth Overshoot Day“, ab dem die von der Menschheit konsumierten Ressourcen die Kapazität der Erde übersteigen. Im Jahr 2012 war dies der 22.August!

Im Jahr 2009 wurden auf Grund dieser Konzepte von einem 28 köpfigen Wissenschaftlerteam sogenannte „Planetary Bounderies“ als ökologische Grenzen der Erde definiert, die von einer künftigen Menschheit nicht überschritten werden dürfen. Zu diesem Team gehörte, man könnte fast sagen selbstverständlich, auch Hans-Joachim Schellnhuber vom Potsdam Institut für Klimafolgenforschung (PIK), der die Verbindung der malthusianistischen Ressourcenerschöpfungs-Theorie mit der Klimapolitik herstellte. Auch die Atmosphäre wird zu einem knappen Gut. Die Treibhausgas-Hypothese wird wiederbelebt und behauptet, es dürften nur noch sehr begrenzte Mengen von CO2 in der Atmosphäre „abgelagert“ werden.

Dies wurde sehr offen bereits in dem oft zitierten Statement des Geschäftsführers des PIK[4], Otmar Edenhofer ausgesprochen. Er sagte 2010 auf der Klimakonferenz in Cancun:

„ Der Klimagipfel ist keine Klimakonferenz, sondern eine der größten Wirtschaftskonferenzen seit dem zweiten Weltkrieg. Warum? Weil wir noch 11.000 Gigatonnen Kohlenstoff ..unter unseren Füßen haben..und wir dürfen nur noch 400 Gigatonnen in der Atmosphäre ablagern, wenn wir das Zweigrad-Ziel einhalten wollen.“ Und weiter: „Zunächst haben wir Industrieländer die Atmosphäre der Weltgesellschaft quasi enteignet. Aber man muss klar sagen: Wir verteilen durch die Klimapolitik de facto das Weltvermögen um“.

Er unterstellt damit, dass es den bereits widerlegten Zusammenhang zwischen Klima und CO2 Gehalt der Troposphäre gibt und dass er sogar die diesbezüglichen quantitativen Verhältnisse kennt.

Hier wird jetzt eine der Quellen sichtbar, die zu dem gegenwärtigen allumfassenden Klimawahn geführt hat.

Es kann als gesichert gelten, dass eine Gruppe von Aktivisten um den damaligen US Präsidentschaftskandidat Al Gore auf dieser Grundlage eine Geschäftsidee entwickelte.

Ein Maximalgehalt der Erdatmosphäre an CO2 wird zu einer begrenzten Ressource definiert und damit zum Gegenstand einer Mangelverwaltung mit Hilfe von Kohlenstoffsteuern. Der „Spiegel“ (Heft 33, 1986) erscheint mit dem Titelbild des im Meer versinkenden Kölner Doms und der Unterschrift: „Die Klimakatastrophe“. Durch die Rationierung der Erlaubnis Kohlendioxid zu emittieren wird ein neues knappes Gut erschaffen, das bezahlt werden muss. ( Hartmut Bachmann, Die Lüge der Klimakatastrophe, 6. Auflage 2010). Durch die sehr guten Verbindungen dieser Clique findet diese Idee den Weg in den US-Senat und in die große Politik. AGW ist bei der UN angekommen.

Hier vermählt sich die Geschäftsidee mit der in den 70iger Jahren auf der oben beschriebenen Malthusianistischen Ideen allseits um sich greifenden antikapitalistischen Ideologie.

Als Hauptakteur fungierte James Hansen, bis 2013 Head of NASA Goddard Institute for Space Studies und Freund Al Gores. Hansen war es, der das AGW-Konzept über den US-Senat zum Gegenstand der UN machte, was zur Gründung des UNFCCC[5] und des IPCC[6] führte.

Eine weitere Zentralfigur war der US Klimatologen Michael Mann[7], der aus Baumringdaten für die letzten 2000 Jahre nachzuweisen versuchte, dass allein menschliche CO2 Emissionen des letzten Viertels des 20. Jahrhunderts einen dramatischen Anstieg der Globaltemperatur verursacht haben.

In dieser Kurve zeigt er eine über die letzten 2000 Jahre gleichmäßige Temperatur in der Troposphäre mit einem plötzlichen steilen Anstieg in dem letzten Quartal des 20. Jahrhunderts, (die sogenannte Hockeystick-Kurve). Diese Kurve unterschlägt die seit langem bekannten Perioden der „Mittelalterlichen Warmzeit“ und der „Kleinen Eiszeit“ .Sie ist eine Fälschung[8] wie von Steven McIntyre und Ross McKitrick (Universtiy of Guelpf) in einer detaillierten Analyse der von Mann benutzten statistischen Verfahren bewiesen wurde. Dieser Betrug war den Akteuren durchaus bewusst, wie später aus dem gehackten Server der University of East Anglia öffentlich zugänglich gewordenen E-Mailverkehr zwischen den Beteiligten hervorgeht. Es handelt sich um den vielleicht größten Wissenschaftsskandal der Neuzeit, der inzwischen als „Climate Gate“ in die Wissenschaftsgeschichte eingegangen ist.

Die zweite, heute die Diskussion dominierende Quelle des allgemeinen Klimawahns ist vermutlich die oben geschilderte, vom Club of Rom wiederbelebte, Debatte über eine drohende Verknappung vieler Ressourcen, eine Verteilungsgerechtigkeitsdebatte entsteht mit der Tendenz zu einer neuen Art von Sozialismus.

Ziel ist die Vernichtung der kapitalistischen Marktwirtschaft zugunsten einer angeblich gerechteren Welt. Ideologische Basis ist die angebliche Bedrohung der Welt durch eine von der menschlichen Industriegesellschaft verursachte, gefährliche, weltweite Erwärmung durch zu hohe Emissionen von Kohlendioxid CO2 . Die AGW Hypothese wird nun zunehmend mit einem keine Diskussion duldenden Absolutheitsanspruch vom UNFCCC[9] vertreten. Sie hat inzwischen religionsartige Züge angenommen und den Status eines nicht mehr hinterfragbaren Dogmas erreicht.

Die derzeitige Vorsitzende des UNFCCC, Christiana Figueres,

Zitat: „Das ist das erste Mal in der Geschichte der Menschheit, dass wir es uns absichtlich zur Aufgabe gemacht haben ,innerhalb einer festgelegten Zeitspanne das seit der industriellen Revolution für mindestens 150 Jahre vorherrschende Leitbild der wirtschaftlichen Entwicklung zu ändern“. Und weiter: “Dies ist wahrscheinlich die schwierigste Aufgabe, die wir uns je gegeben haben. Absichtlich das Leitbild der wirtschaftlichen Entwicklung zu transformieren …“.

Dazu bedient sich die UNFCCC u.a. der jeweils für politische Zwecke erstellten Zusammenfassungen der Berichte des IPCC[10], dem oft als wissenschaftliche Organisation missverstandenen Weltklimarat. Dieser wurde 1988 vom Umweltprogramm der vereinten Nationen (UNEP) und der Weltorganisation für Meteorologie (WMO) als zwischenstaatliche Organisation ins Leben gerufen, um für politische Entscheidungsträger den Stand der wissenschaftlichen Forschung zusammen zu fassen. Die „Rechtmäßigkeit der wissenschaftlichen Inhalte“ von IPCC Berichten erkennen Regierungen durch die Verabschiedung der jeweiligen „Zusammenfassung für politische Entscheidungsträger“ an (Siehe z.B. Wikipedia).

Auftragsgemäß und allen anerkannten wissenschaftlichen Gepflogenheiten widersprechend wird dabei die AGW These nicht auf ihre Gültigkeit geprüft, sondern es werden nur die These eventuell stützende Argumente gesammelt und flächendeckend in die öffentliche Meinung transportiert.

Wie oben bereits erläutert ist aus paläoklimatologischen Daten über Millionen von Jahren leicht nachweisbar, dass das in der Troposphäre vorhandene Kohlendioxid nie einen steuernden Einfluss auf die Temperatur gehabt hat.

Die AGW-Hypothese ist aber gegen auf naturwissenschaftlicher Basis vorgebrachte Argumente immunisiert, da es den Vertretern dieser These erfolgreich gelungen ist, die Beweislast umzukehren.

Seit den bahnbrechende Arbeiten Sir Karl Poppers zur Theorie der Naturwissenschaften wissen wir, dass die Gültigkeit naturwissenschaftlicher Aussagen nicht beweisbar sondern nur gegebenenfalls falsifizierbar ist.

Es ist daher nicht Aufgabe der etablierten meteorologischen Wissenschaft zu beweisen, dass die Behauptungen des IPCC falsch sind, sondern es wäre Aufgabe des IPCC zu beweisen, dass die auf vielen Beobachtungsdaten beruhende Nullhypothese: „CO2 hat keinen Einfluss auf das Klima“ falsch ist. Diesen Nachweis hat das IPCC in bisher 5 umfangreichen Berichten nicht geführt und letztlich nicht einmal ernsthaft versucht.

Speziell für die Beratung der deutschen Regierung wurde ein weiteres Gremium, der WBGU[11], geschaffen. Es wird nicht überraschen, dass der Vorsitzende auch hier der Gottvater der Klimareligion Hans-Joachim Schellnhuber ist. Dieser Rat wurde 1992 vor dem sogenannten „Erdgipfel von Rio“ als „unabhängiges“ Beratergremium gegründet, das von der Bundesregierung mit der Erstellung von Sondergutachten beauftragt werden kann. Die Mitglieder werden vom Bundeskabinett berufen (wodurch garantiert ist, dass der jeweilige Rat das gewünschte Ergebnis liefert). Der Rat legt der Bundesregierung jährlich ein Hauptgutachten vor zum Thema „Welt im Wandel“.

Welche konkreten Vorstellungen Angela Merkels Berater dabei im Auge haben ist beschrieben im Hauptgutachten 2011 unter dem Titel:

„Gesellschaftsvertrag für eine Große Transformation“. In der Einführung heißt es: „Dieser Bericht begründet die dringende Notwendigkeit einer post-fossilen Wirtschaftsweise, zeigt zugleich die Machbarkeit der Wende zur Nachhaltigkeit auf und präsentiert zehn konkrete Maßnahmenbündel zur Beschleunigung des erforderlichen Umbaus. … Damit die Transformation tatsächlich gelingen kann, muss ein Gesellschaftsvertrag zur Innovation durch einen neuartigen Diskurs zwischen Regierungen und Bürgern innerhalb und außerhalb des Nationalstaats geschlossen werden.“

Und weiter:

„ …dass dies nur gelingen kann, wenn Staaten, Unternehmen und die gesamte Zivilgesellschaft gemeinsam die richtigen Weichen stellen und alle Mittel der regionalen und globalen Zusammenarbeit ausschöpfen.“

Welche Weichen richtig sind entscheidet der WBGU zusammen mit dem Sekretariat der Klimarahmenkonvention der Vereinten Nationen UNFCCC. Für den noch unter dem Nationalsozialismus aufgewachsenen Autor klingt dies in Sprache und Diktion wie ein Auszug aus einem Kompilat von „Mein Kampf“ und dem „Kommunistischen Manifest“. Dieser Stil setzt sich dann auch in den hier speziell diskutierten Ausführungen zur Klima- und Energiepolitik fort.

Das in der gesamten Öffentlichkeit gefeierte Ergebnis der COP 21 in Paris war, dass man sich geeinigt habe, den unterstellten Anstieg der Globaltemperatur bis 2050 auf deutlich unter 2° zu begrenzen und Anstrengungen zu unternehmen für eine Begrenzung auf 1,5°. Für Deutschland wird dazu ein klarer Auftrag abgeleitet, einen „konsequenten und ambitionierten Klimaschutzpfad einzuschlagen“. Dieser muss gemäß den Autoren des WBGU einen Rückgang der Treibhausgas Emissionen gegenüber 1990 um mindestens 95% bis 2050 erreichen, Schlagwort: Dekarbonisierung!

Man sollte erwarten, dass bei einem derart konkret formulierten Ziel eine klare Vorstellung zu Grunde liegt, wie viel CO2 das denn ist, was da eingespart werden muss und welchen Beitrag zur Vermeidung eines gefährlichen Temperaturanstiegs das denn bringt. Das heißt, es müsste eine Kausalfunktion der Abhängigkeit der Globaltemperatur vom CO2 Gehalt der Atmosphäre existieren in der Form: delta TGlobal = f (CO2 Gehalt).

Eine mögliche Quelle, die hier Auskunft geben müsste, ist das 2014 erschienene Sondergutachten des WBGU: „Klimaschutz als Weltbürgerbewegung“. Ein gewaltiger pseudowissenschaftlicher Schwulst im Auftrag des Bundesministeriums für Bildung und Forschung und des Bundesministeriums für Umwelt, Naturschutz, Bau- und Reaktorsicherheit. Dort heißt es auf Seite 1 (Hervorhebungen durch den Autor):

„Der 5. Sachstandsbericht des Weltklimarates (IPCC) macht unmissverständlich klar: Inakzeptable Klimafolgen, die sich jenseits der 2°C Leitplanke häufen dürften, können nur vermieden werden, wenn der weitere Anstieg der Treibhausgaskonzentration so bald wie möglich gestoppt wird. Der WBGU empfiehlt daher, die CO2 Emissionen aus fossilen Energieträgern bis spätestens 2070 auf Null zu senken“.

Und weiter:

„Der Weltgesellschaft als Ganzes steht ein eng begrenztes Kohlenstoffbudget zur Verfügung, so dass der Scheitelpunkt der Emissionen möglichst bis 2020, auf alle Fälle aber in der dritten Dekade erreicht werden sollte.“

Als Begründung für diese, den Selbstmord des Industriestandorts Deutschland bedeuten würdenden Forderungen heißt es noch auf Seite 1:

„Die Aussagen des 5. IPCC Sachstandsberichts sind eindeutig: Der Klimawandel findet statt und der Einfluss des Menschen ist unstrittig. Die Beweislage zur globalen Erwärmung ist überwältigend. Bei ungebremster Treibhausgasemission könnte bis Ende des Jahrhunderts ein globaler Temperaturanstieg von mehr 4°C erfolgen.“

Sucht man im Bericht nun nach den angeblichen Beweisen, findet man zunächst (Seite 5) ohne irgend eine über einen Hinweis auf das IPCC hinausgehende Quellenangabe die übliche bereits vielfach widerlegte Behauptung:

„Es besteht kein Zweifel mehr: das Klimasystem erwärmt sich. Beobachtungen von Atmosphäre, Ozean und Eis zeigen eine fortschreitende Erwärmung der Erde…“.

Auf Seite 6 heißt es dann aber interessanter Weise:

„Der globale Temperaturtrend unterliegt einer starken Variabilität, die auf natürliche interne Schwankungen des Klimasystems zurückzuführen ist, z.B. auf Phänomene wie El Nino / südliche Oszillation (ENSO) oder die Pazifische Dekadische Oszillation (PDO). Diese interne Variabilität des Klimasystems kann den langfristigen Klimatrend für kurze Zeit verstärken, abschwächen oder sogar umkehren. Solche Variationen sind häufig in Beobachtungen zu finden, aber auch Klimamodelle sind in der Lage, solche Fälle zu simulieren. Allerdings erlauben die Modelle keine genaue zeitliche Vorhersage von solchen Variationen auf einer Zeitskala von wenigen Jahren.“.

Nach diesen durchaus kritischen Feststellungen diskutiert der Bericht dann ausführlich viele teils sehr vage Vorstellungen, wo denn die glaubensgemäß ständig weiter zugeführte aber real nicht nachweisbare Wärme wohl geblieben sein könnte. Die Schwierigkeiten der Modellbildung werden erörtert, aber ein ständiger Fortschritt dabei festgestellt, der die neueren Modelle in die Lage versetzt zuverlässige Szenerien der Klimaentwicklung zu erstellen mit den geschilderten bedrohlichen Konsequenzen für die Erde.

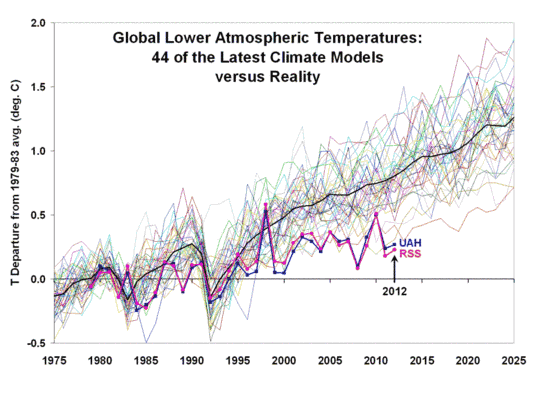

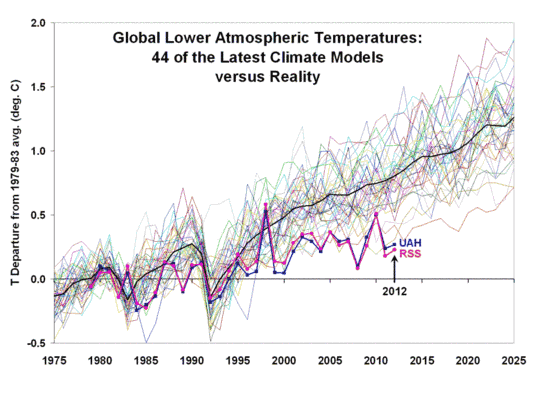

Abbildung 2: "Nicht ganz perfekte" Klimamodelle im Vergleich zur Realität. Die Abweichung zwischen den Satelliten Mitteln und der Modell Mittel liegen heute bei ca. 0,5 K. Das ist mehr als die Hälfte des gesamten Anstiegs des letzten Jahrhunderts.

Auf Seite 11 heißt es:

„Obwohl sie noch nicht perfekt sind, gehören Klimamodelle sicherlich zu den besten Werkzeugen unserer Gesellschaft, um bestimmte Aspekte der Zukunft zu projizieren. Damit stellen sie eine solide Basis für Entscheidungsprozesse dar.“

Die Basis sieht dann wie folgt aus:

Mit den laufend fortentwickelten Modellen wurden Szenarien erstellt, sogenannte „Representative Concentration Pathways (RCPs). Ausgehend von vorgegebenen von der Konzentration von Treib-hausgasen abhängigen „Strahlungsantrieben“ von 2.6, 4.5, 6.0 und 8.5 W/m² wurden Erwärmungsszenarien gerechnet. Die niedrigste (RCP 2.6) hält die 2° Leitplanke mit 66% Wahrscheinlichkeit ein. Mit den Klimamodellen wurden „die Antwortmuster des Klimasystems auf verschiedene individuelle externe Anregungen“ untersucht. „Aus dem Vergleich dieser Experimente geht eindeutig hervor, dass die beobachtete Erwärmung der letzten 50 Jahre weder durch interne Variabilität noch durch natürlich, externe Anregung zustande kommt, sondern nur durch den durch anthropogene Emission erzeugten Anstieg im CO2 – Gehalt der Atmosphäre erklärt werden kann“ .

Daraus resultiert auch die Aussage im 5. IPCC Sachstandsbericht:

„Dass es „extrem wahrscheinlich (> 95%)ist, dass mehr als die Hälfte des beobachteten Anstiegs der Oberflächentemperatur der Erde von 1951 bis 2010 durch menschliche Aktivitäten zustand gekommen ist.“

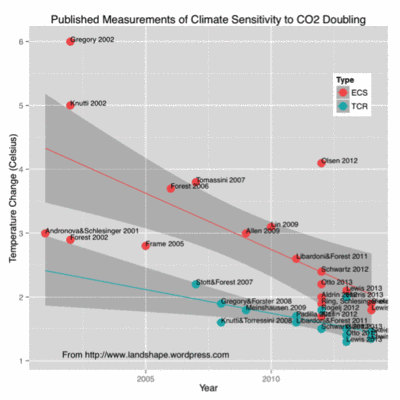

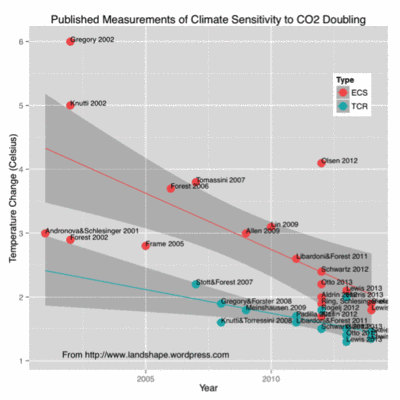

Die Klimasensitivität wird definiert als die Änderung der Oberflächentemperatur der Erde bei einer Verdoppelung des CO2 Gehalts nachdem der Gleichgewichtszustand erreicht ist.

Abbildung 3:Entwicklung des CS Wertes gem. verschiedener Studien. Trend: Je jünger desto geringer. Zuletzt Harde [1] CS = 0.45K ± 30 %, andere 0,3 bis 1 K. Das IPCC schreibt dazu in der Summary for Policymakers, SPM auf Seite 16, aber nur als Fußnote: "No best estimate for equilibrum climate sensitivity; d.h der Wert ist unbekannt, aber deutlich kleiner als 3 K

WBGU:

„Nach neuen, besser fundierten Abschätzungen durch den IPCC (Collins et. all) liegt der Wert mit > 66% Wahrscheinlichkeit zwischen 1,5° und 4,5° C“.

Es wimmelt von Konjunktiven und „Wahrscheinlichkeiten“.

Wie man sofort sieht, sind diese Aussagen widersprüchlich in sich. Die gemäß AGW-These eindeutig und unstrittig auf die menschlichen CO2 Emissionen zurückführbaren Änderungen des Klimas werden mit Wahrscheinlichkeitsaussagen präzisiert. Der dabei verwendete Wahrscheinlichkeitsbegriff ist darüber hinaus falsch!

In der mathematischen Statistik versteht man unter Wahrscheinlichkeit die Häufigkeit, mit der ein bestimmtes Ereignis eintritt, als Ergebnis von Experimenten oder Beobachtungen mit verschiedenen prinzipiell nicht vorhersagbaren Ergebnissen. Als Beispiel dient oft der Wurf von Würfeln, bei dem die Wahrscheinlichkeit des Auftretens einer bestimmten Augenzahl angegeben wird.

Ein mit dieser Definition vergleichbarer Vorgang liegt aber hier nicht vor. Es werden ja ausdrücklich „Experimente“ mit Computermodellen beschrieben. Computersimulationen sind aber grundsätzlich deterministisch und zeigen bei gleichen Eingaben immer die gleichen Ergebnisse. Den gleichen elementaren Fehler machen die Studienautoren im Zusammenhang mit der sogenannten Klimasensitivität. Auch dies ist definitionsgemäß keine stochastische Variable sondern eine deterministische Größe. Die Angabe einer Wahrscheinlichkeit, mit der diese Größe einen bestimmten Erwartungswert annimmt ist daher sinnlos. Die Temperaturzunahme, die von einer gegebenen Erhöhung des CO2-Gehalts verursacht wird, sollte definitionsgemäß ein physikalischer Prozess sein. Dass diese Größe schwer bestimmbar ist, liegt an der Komplexität des Systems und nicht an einer prinzipiellen Unbestimmbarkeit wie etwa beim Würfelspiel.

Die in Paris beschlossenen Maßnahmen zu einem vollständigen mit einer gigantischen Kapitalvernichtung einhergehenden Umbau der gesamten Weltwirtschaft auf Basis letztlich völlig irrelevanter Computerspiele müssen daher als ein Gipfel der Inkompetenz und Verantwortungslosigkeit der daran beteiligten Regierungen angesehen werden.

Welche Ziele Angela Merkel eigentlich umtreiben, soll hier nicht im einzelnen analysiert werden. Klares Kennzeichen ihrer Politik ist, dass sie an einer an ordoliberalen Prinzipien orientierten Marktwirtschaft ebenso wenig interessiert ist, wie an einem Schutz privaten Kapitals oder verantwortungsvollem Umgang mit Steuergeldern.

Ihren ersten offenbar aus einer Mischung von Macht- und Umweltpolitik motivierten Vernichtungsschlag führt sie gegen die deutsche Atomindustrie. Es gelingt ihr das entsprechende entschädigungslose Enteignungsverfahren mit offensichtlich fadenscheinigen Begründungen innerhalb weniger Tage durch den inzwischen zu einer oppositionsfreien Volkskammer entarteten Bundestag zu drücken. Sie hat die Chuzpe sich diese bis dahin größte Vernichtung privaten Kapitals von einem Ethikausschuss ohne große Fachkenntnisse absegnen zu lassen. Das ist Mittelalter, vergleichbar mit der seinerzeitigen Ablehnung der Erbauung des Panamakanals, weil es Gott nicht wollen könne, dass die amerikanischen Kontinente getrennt werden.

Dieser erste Eingriff in die Privatwirtschaft wird seither übertroffen durch die Folgen der mit dem Atomausstieg gleichzeitig eingeführten Gesetze zur Umstellung auf „erneuerbare Energie“. Die jährlich den privaten Haushalten zugunsten einiger Profiteure entzogenen Mittel überschreiten inzwischen 24 Mrd: EUR und die auf den Haushalten in diesem Zusammenhang lastenden Verbindlichkeiten überschreiten 300 Mrd. EUR.

Dies alles sind die bereits eingetretenen Auswirkungen der aktuellen, am Klimawahn ausgerichteten Politik. Die derzeitigen Akteure können nicht mehr zur Verantwortung gezogen werden, wenn das jetzt für die Zukunft entworfenen Weltbild eines dekarbonisierten Deutschland Wirklichkeit werden sollte. Eine Zeit, nachdem die letzte Dampfturbine aufgehört hat, sich zu drehen, die letzte Tankstelle abgerissen wurde, der letzte Hochofen ausgegangen ist und die Tore des letzten Stahlwerks für immer geschlossen wurden. Der letzte Ferienflieger hat abgehoben. Die Hausfrau oder der Hausmann besteigen ihr Lastenfahrrad, um den Einkauf in ihr kaltes Haus zu bringen ehe der Smartzähler im Haus den ohnehin zu warm eingestellten Kühlschrank abschaltet.

Soll das wirklich die Welt sein, die wir unseren Kindern hinterlassen wollen? Wo bleibt die von Kant beschworene Vernunft. Gibt es wirklich in Politik und Wirtschaft nur noch angepasste Mitläufer auf dem Weg in den Untergang dieses einst erfolgreichen Landes?

Wie es scheint, ist die AfD die einzige politische Kraft, die sich diesem Wahnsinnsvorhaben entgegenstellt. Wird sie stark genug sein, Deutschland von diesem Selbstmordprogramm abzubringen?

[1] Sir Karl Popper * 1902 in Wien, gest. 1994 London. Einer der bedeutendsten Philosophen des 20. Jahrhunderts. Begründer der modernen Wissenschaftstheorie. In seinem Buch „Conjectures and Refutations, The Growth of Scientific Knowledge“ erklärt er, wie naturwissenschaftlicher Fortschritt durch Versuch und Irrtum entsteht.

[2] Thomas Robert Malthus, * 1766 bei Dorking, Grafschaft Surray, gest. 1834. Britischer Ökonom. Verfasste mehrere Werke zur Bevölkerungstheorie, nach der biologischen Gesetzen folgend die Bevölkerungszahl exponentiell zunimmt, während die natürlichen Ressourcen nur in arithmetischer Progression zunehmen und schließlich überhaupt nicht mehr erweiterbar sind.

[3] Ökologischer Fußabdruck: 1994 von Mathis Wackernagel und William Rees entwickeltes Konzept der Berechnung des Flächenanteils der Erdoberfläche, die ein Mensch unter heutigen Produktionsbedingungen dauerhaft braucht, um seinen Lebensstil aufrecht zu erhalten. Die Daten werden vom 2003 gegründeten Global Footprint Network in Hektar pro Person und Jahr angegeben.

[4] Potsdam Institut für Klimafolgenforschung PIK. 1992 unter Leitung von Hans-Joachim Schellnhuber gegründetes Institut zur Untersuchung von Fragen im Bereich Nachhaltige Entwicklung und Klimawandel als Grundlage für Entscheidungen im Bereich Politik, Wirtschaft und Zivilgesellschaft. Unter A. Merkel auf 300 Mitarbeiter aufgepäppelt.

[5] United Nations Framework Conventionon Climate Change UNFCCC. Gegründet 1992 derzeitiger Sitz des Sekretariats ist Bonn. Veranstalter der jährlichen „Parteitage“, der Klimakonferenzen (Conference of the Parties (COP)). Auftraggeber für das IPCC.).

[6] IPCC Intergovernmental Panel on Climate Change, der sogenannte Weltklimarat. Keine Wissenschaftseinrichtung also sondern eine Lobby. Herausgeber sogenannter Sachstandsberichte, die die Existenz eines vom Menschen verursachten Klimawandels nachweisen sollen.

[7] Michael E. Mann, Professor of Meteorology, Director Earth System Science Center, Pensylvenia State University

[8] Ross McKitrick, University of Guelph Ontario. Member of Global Warming Policy Foundation zeigte, dass Mann’s Darstellung grundlegende Fehler in der Datenbehandlung aufwies und letztlich bei Eingabe beliebiger Daten immer das gleiche Ergebnis zeitigte.

[9] UNFCCC: UNITED Nations framework Convention on climate change.

[10] IPCC = Intergovernmentel Panel on climate change. Eine Lobby also, keine wissenschaftliche Institution.

[11] WBGU = Wissenschaftlicher Beirat der Bundesregierung Globale Umweltveränderungen. Lokalisiert beim PIK.

[12] Hermann Harde Was trägt CO2 wirklich zur globalen Erwärmung bei