Jüngst kam wieder einer dieser Beiträge, diesmal über den unaufhaltsamen und bereits – auch in Deutschland – schon schlimmen Klimawandel:

Bayerischer Rundfunk, Homepageinformation am 08.03.2016:

Extremwetter durch Klimawandel: Mehr Starkregen, Dürren, Hitzewellen und Orkane

Extreme Wetterphänomene treten weltweit immer häufiger auf, auch in Deutschland. Wissenschaftler machen auch die Klimaerwärmung dafür verantwortlich. Und sie zeichnen ein düsteres Szenario.

Auf diese „Information“ hin fragte der Autor beim BR zu Belegen nach und bekam als einen (mit einem Zweiten des IPCC) die Information zur jüngsten Pressemeldung der Munich Re genannt:

Vom BR gemeldete Belegstelle zur Zunahme von klimawandel-bedingten Extremwetterereignissen:

Munich RE „Risiken durch anhaltende Extremwetterlagen steigen – „Topics GEO“ analysiert Naturkatastrophen 2014

Was dem BR nicht auffiel: Diese Pressemeldung der Munich Re ist eines der typischen Beispiele, wie ein bewusst alarmistischer Header eine bestimmte Risikoursache suggerieren soll, und in den Ausführungen dann sorgfältig umschrieben wird, dass sich diese Risiken aber nicht (wie man aufgrund der Überschrift meinen könnte) auf den Klimawandel beziehen. Bei „Klima-Alarmmeldungen“ eine übliche Methode, um aus nicht vorhandenen oder schwammigen Belegen doch noch die „gewünschte“ Aussage „herauszukitzeln“ – und als Folge ein typischer „Reinfaller“ für unsere Klimawandel-glaubensgestählten Medien, wie es auch der EIKE-Beitrag „Als der Meeresspiegel doppelt so schnell anstieg – nur weil eine Studie nicht richtig gelesen wurde“ zeigt.

Munich Re Pressemitteilung [1] vom 3. März 2015: Risiken durch anhaltende Extremwetterlagen steigen

In den vergangenen Jahren haben lang anhaltende Extremwetterlagen schwere Naturkatastrophen ausgelöst und Schäden in Milliardenhöhe verursacht. In der Wissenschaft mehren sich Studien, die eine Zunahme von quasi ortsfesten Wetterlagen sowie einen Zusammenhang mit der durch den Klimawandel verursachten starken Erwärmung in der Arktis nahelegen.

Die Klimaapokalypse nimmt seinen vorhergesagten Verlauf und ist zu einem messbaren Risikofaktor geworden – könnte man anhand der Pressemitteilungs-Überschrift meinen.

Allerdings, etwas weiter hinten im Text kommt eine vollkommen andere Information (Hervorhebungen durch den Autor):

MuRe[1] 2014 blieben die Schäden aus Naturkatastrophen zum dritten Mal in Folge unter dem langjährigen Durchschnitt. Auch wenn immer noch 7700 Menschen bei den Naturkatastrophen ums Leben kamen, so waren es zumindest deutlich weniger als im Durchschnitt; die Zahl der Todesopfer lag in einer Größenordnung wie zuletzt 1984 (rund 7000).

So positiv konnte man das nicht stehen lassen, weshalb Erklärungen nachgeschoben kommen – die genau das Vorhergehende bestätigen: Die Schadenssummen und damit der Schadenstrend steigt (… steigenden exponierten Werte), aber nicht die klimabedingten Ereignisse.

MuRe [1]: Jeworrek betonte: „Aus dem Schadenverlauf der vergangenen Jahre auf eine Trendumkehr zu schließen, wäre verfehlt. Der Schadentrend der vergangenen Jahrzehnte zeigt eindeutig nach oben, vor allem getrieben durch die steigenden exponierten Werte.“

Bestätigt wird also genau das, was der Autor schon Anfang des Jahres in der umfangreichen Rezension [3] anhand der Schadensdaten von Munich Re und Swiss Re feststellen konnte – klimabedingte Schadensereignisse nehmen weltweit nicht zu. Damals machte der Autor jedoch einen Fehler, bzw. bei MuRe stand es so: Er gab den aktuellen Stand als vergleichbar dem vom Jahr 1991 an. Munich Re korrigierte dies nun auf 1984 (1980) und datiert es um weitere 10 Jahre vor.

Jemanden, der das Thema verfolgt, wundert dies nicht. Zum Beispiel ist der Stand Tornadoopfer in den USA fast auf dem niedrigsten Stand seit Beginn der Aufzeichnungen um 1875 [20].

Fazit

Die Munich Re stellt fest, dass die aktuelle Mortalität durch Klimaschadens-Ereignisse dem Stand von 1980, also dem vor 35 Jahren entspricht!

Personelle Risiken sind also seit 35 Jahren nicht mehr gestiegen. Allerdings steigen die Risiken für Vermögenswerte, weil immer mehr Urbanität in Risikogebiete gebaut wird.

Steht aber vielleicht im von der Pressemitteilung als Hintergrundinformation angezogenen MuRe Analysepaper doch noch etwas Anderes drin?

Munich Re, Publikation TOPICS CEO, Ausgabe 2015: Naturkatastrophen 2014 Analysen, Bewertungen, Positionen

Im MuRe TOPICS CEO steht das Positive gleich im Vorwort:

TOPICS CEO [2]: Liebe Leserinnen und Leser,

das Jahr 2014 war im Hinblick auf Naturkatastrophen für die Versicherungswirtschaft sicherlich ein Jahr zum Durchatmen. Zum dritten Mal in Folge blieben die Schäden unter dem langjährigen Durchschnitt. Nur einmal, bei den verheerenden Schneestürmen in Japan, erreichten die versicherten Schäden eine Höhe von über drei Milliarden US-Dollar.

Erfreulich war zudem, dass es 2014 vergleichsweise wenige Todesopfer durch Naturkatastrophen gab – die zweitniedrigste Anzahl seit 1980.

Und im weiteren Verlauf wird es noch deutlicher. Beim Lesen dieser Publikation merkt man unverkennbar der Einfluss des PIK. Etliches was man von dort an „vielleicht möglichen, zumindest nicht mit absoluter Sicherheit ausschließbaren Szenarien für die Zukunft kennt“ findet sich auch hier. Der Grund ist erkennbar. Wenn es aktuell keine Apokalypse gibt, muss sie eben in der Zukunft zu finden sein. Und das PIK mit seinem Supercomputer (und als Berater der Munich Re) kann diese Zukunft sicher am besten in allen parametrierbaren Variantenausführungen simulieren.

So wird das wohl liebste Kind des PIK, der Arktische Kipppunkt, lange ausgeführt, endet aber mit der Schlussbemerkung, dass es sich um eine Meinung und eben nicht um gesicherte Erkenntnisse, ja nicht einmal (sofern es überhaupt käme) um ein klimawandel-bedingtes Ereignis handeln müsste (Anm.: Siehe dazu auch [6]):

[2] Nach herrschender Meinung der Klimaforscher sind „Kippeffekte“ mit erheblichen irreversiblen Folgen

nicht auszuschließen, wenn die globale Durchschnittstemperatur gegenüber der vorindustriellen Zeit um mehr als

2 °C zunimmt

Ein – voraussichtlich über Jahrhunderte andauernder – Verlust des Westantarktischen Eisschilds würde den globalen Meeresspiegel um mehr als drei Meter ansteigen lassen. Ob der Beginn des irreversiblen Zerfallsprozesses

des Westantarktischen Eisschilds eindeutig auf die anthropogene Klimaerwärmung zurückzuführen ist, lässt sich derzeit wissenschaftlich nicht eindeutig belegen.

Viel mehr gibt die Publikation zum Thema Klimawandel nicht her, schon gar nicht einen Beleg.

Mangels Belegen werden schreckliche Bilder gezeigt und Szenarien fabuliert

Wie können aber „Risiken durch anhaltende Extremwetterlagen steigen“, wenn die weltgrößte Rückversicherung gleichzeitig „ durchatmet“ und die Anzahl Mortalität durch Naturkatastrophen die zweitniedrigste seit 1980 (niedrigste seit 1983) ist?

Die Pressemitteilung klärt im Innersten etwas auf.

Die Risiken sind nicht wirklich da, sondern Studien „legen es nahe“. Auch sind die letzten richtig großen Schadensereignisse vorwiegend Kälte-bedingt und wollen damit so gar nicht zum „überhitzten Planeten“ passen. Das bemerken die Klimawissenschaftler auch und [1]„ … diskutiert intensiv, ob der Klimawandel und insbesondere die besonders starke Erwärmung in der Arktis für diese veränderten Wettermuster verantwortlich ist.“

Um die schlimme Klima-Umwelt trotzdem zu demonstrieren ist in der Broschüre noch ein Bild der globalen Welttemperatur enthalten (Bild 1).

Vom Autor sind im Bild das Toleranzband der Messgenauigkeit einer elektronischen Station von +- 0,2 Grad und die ungefähre globale Mess-Ungenauigkeit vor 1990 mit ca. +- 1 Grad und ab 1990 von +-0,6 Grad [7] bläulich eingefärbt zugefügt.

Der Temperaturstillstand seit ca. 2000 ist deutlich erkennbar (die geringfügige Erhöhung der Balken ist so weit unterhalb der Messgenauigkeit, dass das bisschen angezeigte Erhöhung eine reine Zufallsaussage darstellt). Anhand der Toleranzbänder kann sich Jeder klar machen, wie un-glaubhaft solche Darstellungen in Wirklichkeit sind und wie wenig diese einen waren Global-Temperaturverlauf repräsentieren.

Bild 1 [2] Verlauf der Globaltemperatur seit 1950. Vom Autor um die Toleranzbänder einer Messstation (rot) und der Globalmessung (blau) ergänzt

Zu den Maximaltemperaturen erklärt MuRe:

[2] Allerdings wurden die bisherigen maximalen Jahres-Durchschnittstemperaturen von 2005 und 2010 nur sehr knapp um 0,04 °C geknackt.

Diese Aussage ist ein Affront an alle, welche noch etwas Minimal-Ahnung von Messtechnik haben. Bei den hohen Temperatur-Messtoleranzen (Bild 1) eine nicht mehr messbare Änderung von 0,04 °C als „geknackt“ anzugeben zeigt überhaupt nichts, außer deutlich das niedrige Wissenschaftsniveau dieser (Populär-)Publizierung und Versagen oder Fehlen aller fachlichen Kontrollinstanzen.

Anm.: Vergleichbares musste der Autor auch bei der Rezension der Vulnerabilitätsstudie Deutschland [8] feststellen.

Warum die Globaltemperatur (falls überhaupt) höher wurde, ist ebenfalls interessant:

[2] Für die Einstufung als global wärmstes Jahr waren ausschließlich die dauerhaft von Juni bis Dezember höchsten je gemessenen Temperaturen der Meeresoberflächen verantwortlich. Über Land erreichte die Erwärmung im globalen Jahresmittel keinen neuen Spitzenwert.

Erinnert man sich an Deutschland, dass laut seiner Umweltministerin „den Klimawandel täglich spürt“, obwohl nun gemeldet wird, dass sich die Landtemperaturen gar nicht erhöht haben. Nun gut, für Deutschland vielleicht um 0,1 Grad in den letzten 33 Jahren [11].

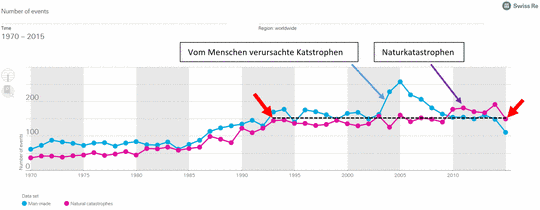

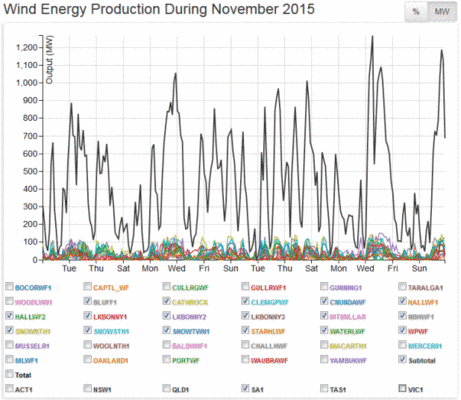

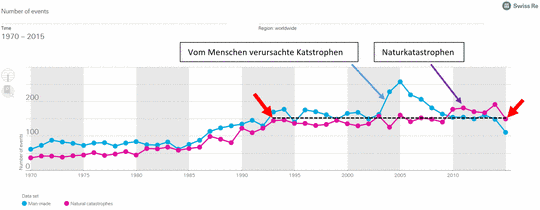

Zuletzt noch der vom Autor aus einer MuRe Darstellung extrahierte jährliche Verlauf wetterbedingter Schadensereignisse (Bild 2). Diesen extrahiert der Autor wegen des Aufwandes nicht neu sondern entnimmt sie aus [4]. Es fehlt damit nur das letzte Jahr. Auch darin ist keine Erhöhung erkennbar, was auch für eine vergleichbare Darstellung von Swiss Re (Bild 3) gilt.

Bild 2 [4] Wetterbedingte Schadenereignisse weltweit 1980 – 2014 mit vom Autor herauskopierten und auf die Grundlinie gesetzten Balken der Gesamtschäden.

Bild 3 [5] Swiss Re Anzahl Naturkatastrophen-Ereignisse (rot) und man-made-events (blau) von 1970 – 2015

Fazit

Wer die Pressemitteilung von Munich Re[1] als Beleg für die Aussage “Extreme Wetterphänomene treten weltweit immer häufiger auf“ anzieht, belegt nur dass er sich keinerlei Mühe gemacht hat hineinzusehen – vielleicht, um nicht Gefahr zu laufen, an seiner vorgefassten Ideologie zweifeln zu müssen.

Und in Deutschland?

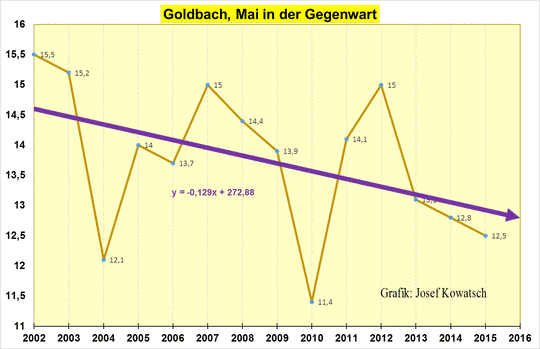

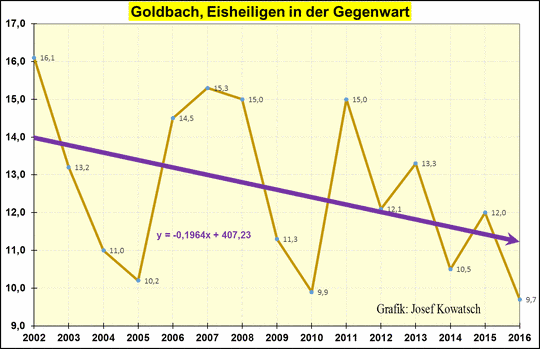

Beim Bayerischen Rundfunk heißt es ergänzend „… auch in Deutschland“. Die angegebene „Belegstelle“ sagt dazu nichts aus. Aber es gibt ja genügend Informationsmaterial. Rein zufällig kam gerade auf kaltesonne.de eine Darstellung:

kaltesonne[13]: Steigende Temperaturen in Deutschland? Ja und nein:

Die Eisheiligen werden immer kälter

Forsythien und der Klimawandel: Frühlingsbeginn in Hamburg während der letzten 30 Jahre immer mehr verspätet

Unerklärlich: Weshalb stieg 2015 der Heizbedarf in Deutschland, obwohl es angeblich das zweitwärmste Jahr seit Beginn der Messungen war?

Winter in Deutschland seit 30 Jahren unverändert

Deutschland-Temperaturen 1990-2015: 7 Monate wärmer, 5 Monate kälter

Deutschlandtemperaturen 1995-2015: 8 Monate wärmer, 4 Monate kälter

Winter in Deutschland: Immer wärmer oder immer kälter?

Deutschland-Temperaturen 2000-2015: 7 Monate wärmer, 5 Monate kälter

Meteorologe Christian Zenkl: Im Alpenraum sind die Temperaturen in den Bergen in den letzten 30 Jahren um etwa ein Grad C gesunken

Feuchtere Winter? Kann sein. Aber ist das schlimm? Bei den Extremniederschlägen sind jedenfalls keine Auffälligkeiten zu vermelden:

Klimabericht des Umweltbundesamtes (UBA) zu Deutschland: Kein statistisch gesicherter Anstieg extremer Niederschläge oder von Trockenperioden

Häufigere Wetterextreme? Wohl kaum:

Keine Belege für mehr Extremwetter in Deutschland

Neue Studien geben Entwarnung: Europäische Dürren noch vollständig im Bereich der natürlichen Schwankungsbreite

2014 erneut mit weniger Schäden durch Extremwetter. MunichRe trotzig: “Niemand sollte sich in Sicherheit wiegen”

Wie ist es mit dem Starkregen?

Die umfassendste und bestimmt seriöse Informationsquelle zu Klimaereignissen in Deutschland, der Uba Klimamonitoringbericht 2015[12] sagt zu Starkregen – nichts.

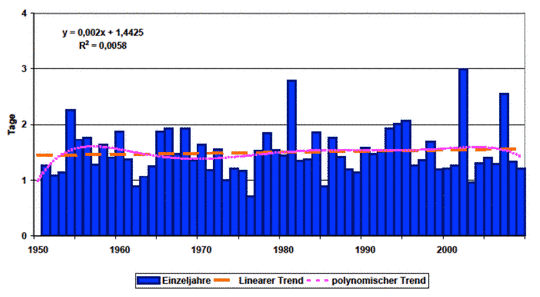

Das lässt nur den einen Schluss zu: Er hat nicht signifikant zugenommen! Das zeigt sich auch wenn man die Daten aus einem Einzelbericht des DWD ansieht (Bild 4). Es lässt sich keine Verschlimmerung feststellen. Stark geregnet hat es immer, die höchste Spitze ist vor dem Jahr 1940, die zweithöchste um 1970 und erst dann kommt ein jüngeres Datum. Auch die Darstellung zum hohen Niederschlag (Bild 5) weist seit 1950 keinen Anstieg aus. Aktuell regnet es so stark wie um 1950.

Alarme stellt man sich anders vor.

Bild 4 Starkregenereignisse Köln Wahn ab 1931. Quelle: DWD „Das Projekt Starkregen DWD/GDV“

Bild 5 Anzahl der Tage mit mindestens 30 mm Niederschlag pro Jahr für Deutschland. Quelle CSC Climate Service Center

Wie steht es mit den Dürren?

Auch dazu sagt der Uba Klimamonitoringbericht nichts, weshalb man die Angaben zu Trockenperioden zu Rate ziehen muss.

Dazu wird vermeldet:

Uba [12]: Wie Abbildung 11 zeigt, ist die Anzahl solcher Trockenperioden im Flächenmittel von Deutschland seit 1951

um ca. 0,3 Ereignisse pro Jahr geringfügig angestiegen. Bereits aufgrund der Seltenheit solcher Ereignisse mit einem Mittelwert von nur 1,3 Fällen pro Jahr im klimatologischen Referenzzeitraum 1961-1990 sowie der extrem

hohen Variabilität von Jahr zu Jahr ist aber auch diese Zunahme bislang statistisch keineswegs gesichert.

Also auch dazu Entwarnung, wie es Bild 6 auch zeigt.

Bild 6 [12] Anzahl von Trockenperioden seit 1960 in Deutschland

Hitzewellen

Uba [12]: Im Rückblick zeichnet sich seit den 1970er Jahren bereits ein Trend zur Zunahme sogenannter „Heißer Tage“ ab, an denen der Tageshöchstwert der Temperatur 30 °C oder mehr beträgt. In „Tropennächten“ sinken die Temperaturen nicht unter 20 °C, eine nächtliche Erholung ist dann insbesondere nach sehr heißen Tagen eingeschränkt. Tropennächte treten bislang in unseren Breiten im Gegensatz zu den Heißen Tagen noch selten auf.

Dies ist die einzige Veränderung, welche in Deutschland überhaupt eine Signifikanz ausweist. Allerdings hat dabei der Wärmeinseleffekt auch einen großen Einfluss und den verursacht nicht das Klima. Unter der Betrachtung, dass die Maximaltemperatur in Deutschland (vielleicht) nach 33 Jahren um 0,1 Grad gestiegen ist, obwohl der Trend ausgerechnet zur Kaltzeit des letzten Jahrhunderts beginnt, relativiert sich jedoch diese Signifikanz.

Bild 7 [12] Gebietsmittel von Heißen Tagen und Tropennächten seit 1970 in Deutschland

Aber die Orkane

Es wird ermüdend, aber der Uba Klimamonitoringbericht [12] sagt auch dazu nichts. Wieder der sichere Beleg, dass kein positiver Trend vorliegt, oder keine brauchbaren Daten (darin ist der Bericht ehrlich).

Also muss man wieder nach einem Ersatzparameter suchen und der findet sich zum Beispiel in der „ungeplanten Holznutzung“. Und siehe da, es gibt keinen gesicherten Trend. Man musste sich für die „notwendige Alarmrichtung“ mit dem „Eindruck“ begnügen.

Uba Klimamonitoringbericht [12]: Auch wenn sich in den zurückliegenden knapp zwanzig Jahren kein statistisch abgesicherter Trend zu einer Zunahme des Umfangs ungeplanter Holznutzungen abzeichnet, entsteht in der Forstwirtschaft zunehmend der Eindruck, dass die Phasen ohne relevante Einflüsse von Zwangsnutzungen immer kürzer werden.

Vielleicht eine viel sicherere, da wesentlich sorgfältiger und genauer registrierte Aussage bieten die Wetter-bedingten Schäden an Freileitungen (Bild 8). Auch diese zeigen keinerlei steigenden Trend sondern das Gegenteil.

Bild 8 [12] Wetterbedingte Unterbrechungen der Stromversorgung

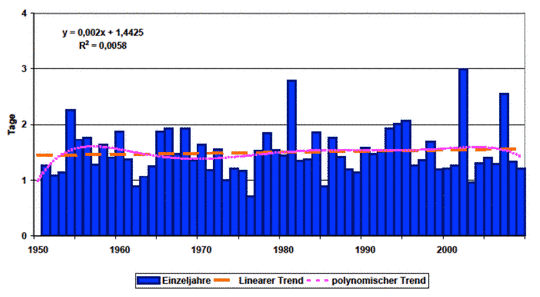

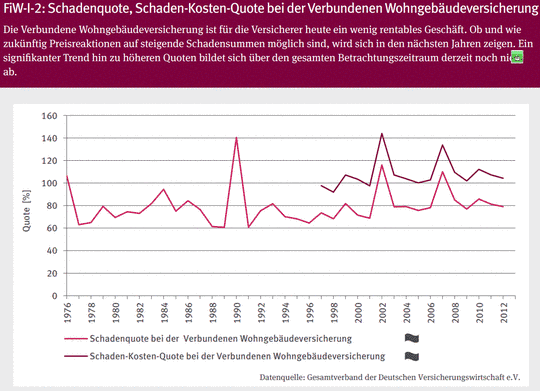

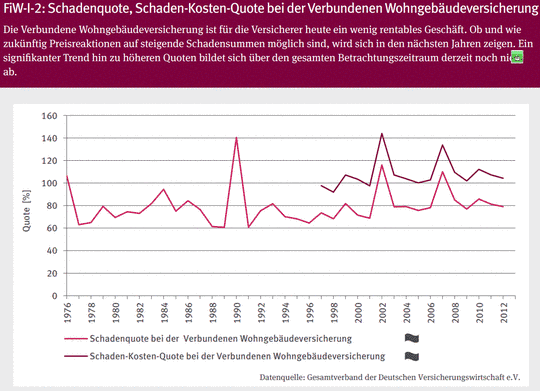

Was den Bürger direkt betrifft, ist die Schadensquote. Aber auch diese zeigt keinen steigenden Trend.

Bild 9 [12] Schäden der Wohngebäudeversicherung

Schlussbetrachtung

Gegenüber der letzten Rezension [3] hat sich nichts verändert. Die Munich Re kann einen Klimawandel-Einfluss für wetterbedingte Schadensereignisse weiterhin nicht finden, sondern nur in der Zukunft simulieren. Man könnte lediglich meinen, dass das fachliche Niveau in den MuRe Publizierungen etwas nachgelassen hat.

Weder für die Welt, noch für Deutschland lässt sich die Meldung des BR bestätigen. Die angegebene Belegstelle sagt ebenfalls das Gegenteil.

Schade ist, dass unsere gut bezahlten und mit extensivem Personalbestand ausgestatteten „Öffentlichen“ zwar auf ihrer Homepage und in Reportagen in vorbildlicher Propaganda-Pflichterfüllung den Klimateufel an die Wand malen, jedoch keinen Anlass sehen dazu zu recherchieren. Für sie reicht es, wenn öffentlich bezahlte Alarm-Publizier-Institute und Firmen welche davon profitieren entsprechende Meldungen über die dpa verteilen. Ihr Vorteil ist: Eine dpa-Agenturmeldung muss nicht geprüft werden. Sie ist über den Weg durch dieses „Wahrheitsinstitut“ (ausschließlich persönliche Meinung des Autors) juristisch gesehen automatisch „wahr“ geworden*. Konsequenzen für nachfolgende Publizierer aus der Berichts-Gehirnwäsche sind damit ausgeschlossen.

* [19] Äußerungs- / Presserecht Prüfung der Quelle

Bei der Übernahme von Informationen aus sog. "privilegierten Quellen" ist die Prüfungspflicht des Journalisten weniger streng. Er darf sich hier i.d.R. darauf verlassen, dass die Information zutreffend und ggf. unter Zugrundelegung des journalistischen Sorgfaltsmaßstabes geprüft wurden.

Beispiele für privilegierte Quellen: Agenturmeldungen, Gerichtsurteile, behördliche Mitteilungen, Mitteilungen über Parlaments- oder Gerichtsverhandlungen.

Was muss Deutschland beim Klima wirklich fürchten?

Dass dieses in sein Verhalten zur vorindustriellen Zeit zurückfällt, wie es von Deutschlands „Intelligenz“ sehnlichst gewünscht wird.

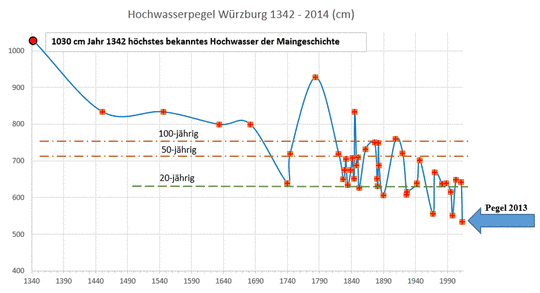

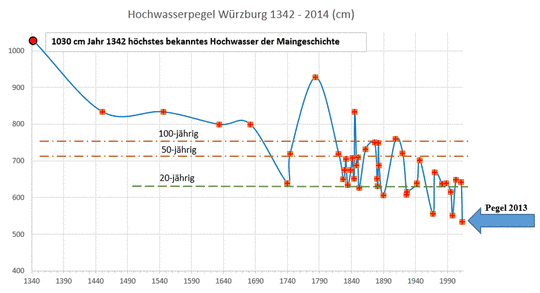

Kaum Jemand denkt beim ständigen Klimaalarmismus-Getrommel daran, dass wir aktuell in einem verblüffend ruhigen und angenehmen Klimavariabilitäts- Zeitalter leben, für das wir dankbar sein sollten. Früher, als das Klima angeblich erstrebenswert natürlich war, verhielt es sich wesentlich grausamer und extensiver. In der EIKE-Publizierung: „Extremhochwasser und Unberechenbarkeit des Wetters“[14] ist das umfassend beschrieben. Ein Bild daraus:

Bild 10 Hochwassermarken des Mains bei Würzburg seit dem Mittelalter bis 2013. Vom Autor als Grafik anhand von der Stadt Würzburg hinterlegten Daten erstellt. Y-Achse: Pegelhöhe in cm

Frage an die Leser: Wann wurde eine Freiluftveranstaltung in Würzburg vom Hochwasser überflutet und musste abgebrochen werden? – Im Jahr 2013.

Selbstverständlich galt das als ein Menetekel des immer zerstörerischeren Klimawandels. In der EIKE-Publizierug des Autors:

„Kann man den Klimawandel in Deutschland wirklich täglich spüren? Eine Suche mit überraschendem Ergebnis“ ist es detaillierter dargestellt. Anbei der Auszug daraus über das würzburger Festival von 2013:

DIE WELT am 05.12.14: Würzburg (dpa/lby) – Der Klimawandel macht dem Würzburger Africa Festival zu schaffen: 2013 wurde es von Hochwasser überrascht, musste abgebrochen werden und herbe Verluste verkraften. Um künftig im Fall von Naturkatastrophen und ähnlichen Notfällen finanziell abgesichert zu sein, hat der Veranstalter nun eine Stiftung gegründet. «Das Wetter wird leider nicht besser, sondern schlechter. Wir müssen uns auf den Klimawandel einstellen», betonte Festivalleiter Stefan Oschmann am Freitag in Würzburg.

Damaliger Kommentar des Autors dazu:

Fühlt man sich da nicht verarscht? Der niedrigste Hochwasserpegel seit Menschengedenken und darauf muss man sich nun „einstellen“ weil es immer schlechter wird! Dass man eine Veranstaltung auf einer Fläche errichten lässt, die in einem weit unter 20-jährigem Turnus (nach der Grafik alle 6,6 Jahre) regelmäßig überschwemmt wird, ist ein Armutszeugnis der Planer. Aber diesen Dilettantismus einem Klimawandel zuzuschieben ist unverfroren. Dem „DIE WELT“-Redakteur ist es nicht aufgefallen und die Verantwortlichen vom städtischen Planungsamt haben es aus gutem Grund vermieden, ihn darauf hinzuweisen.

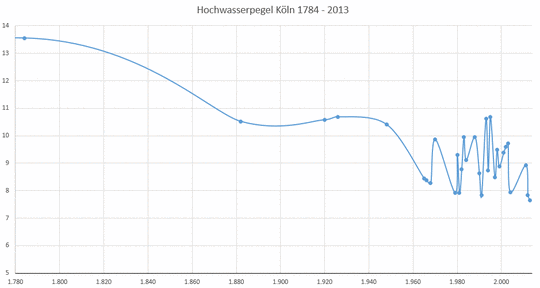

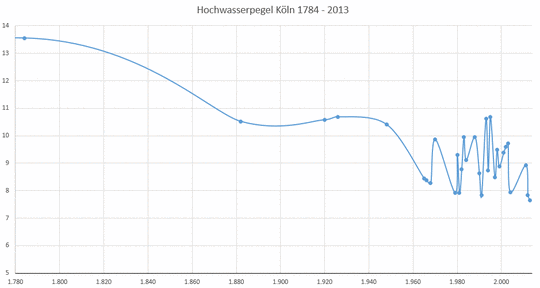

Wer sich sicher ist, dass der Main ein (vom Autor ausgesuchtes) Ausnahmebeispiel wäre, sehe sich den Hochwasserverlauf des Rheins bei Köln an.

Bild 11 Hochwasserpegel Köln 1784 – 2013 nach den Daten der Stadtentwässerungsbetriebe Köln AöR vom Autor als Grafik erstellt). Y-Achse: Rheinpegel (m)

Auf „The European“ kam jüngst ein Artikel, der dieses Thema unter verschiedenen Blickwinkeln darstellt „Der Mythos vom Gleichgewicht der Natur“[17]. Auch wenn der Autor mit einigen Aussagen nicht übereinstimmt, ist er absolut lesenswert – und er bestätigt auch viele Thesen des Autors.

Darin steht zum Beispiel

[17] In der Wissenschaftszeitschrift „Science“ wurde vor Kurzem eine Arbeit veröffentlicht, die belegt, wie der Kaltzeittrend durch die menschengemachte Erwärmung abrupt unterbrochen wurde. Hätte sich die natürliche Abkühlung des Planeten fortgesetzt, wäre es heute ein Grad kälter. Man könnte Nordeuropa nicht mehr bewohnen.

Nun behauptet der Autor dass dies insofern nicht stimmt, weil die mittelalterliche Kaltzeit spätestens um 1600, wenn nicht sogar um 1400 endete und die aktuelle (kleine) Warmzeit damit bestimmt nicht durch menschlichen Einfluss begann „Rekonstruierte Temperaturverläufe der vergangenen zwei Jahrtausende“[18]. Das ändert aber nichts an der Folgerung was passiert wäre, hätte die „gütige Natur“ mit dem vorindustriellen Klima einfach so weiter gemacht.

Nachspann

Herr Limburg hat sich eben auf EIKE beklagt, dass die Jugend so wenig (über Technik) lernt und weiß: „AfD Chefin Frauke Petry muss Oberschülern über den Unterschied zwischen Smog und CO2 belehren“.

Leider liegt dies auch daran, dass im Grün-vermerkelten Deutschland unter der Aufsicht von Herrn Kauder zu viel Wissen praktisch einem Verbot für höhere Ämter gleichkommt. Es ist viel vorteilhafter Theologie, Politik, ev. noch Philosophie studiert zu haben, obwohl ein guter Studienabbruch als Sprungbrett auch nicht schlecht ist.

Immer wieder anschaulich dafür ist die Fachausbildung der Reihe von Umweltminister –innen:

-

Umweltminister

-

Umweltbundesamt Leiterin

(seit 2014)

Waren die bisherigen allerdings einfach nur von Unkenntnis gezeichnet (zu Herrn Trittin schreibt der Autor seine Meinung nicht öffentlich), scheint die aktuelle Umweltministerin zusätzlich durch das andauernde Klimawandel-Bombardement noch klimawandel-psychisch angeknackst. Wie kann es sonst sein, dass Sie sich mit einem bekannten Klimawandel-Betrüger einlässt und das noch berichtenswert findet:

Zitat aus einem Zeitungsartikel vom 14.12.2015 (Print-Lokalausgabe der nordbayerischen Nachrichten):

„Zum wiederholten Male lobt Hendricks das politische Geschick ihres „Freundes Tony de Brum“. Der Außenminister der Marshallinseln, die bei einem weiteren Anstieg des Meeresspiegels im Meer versinken würden, hatte am Morgen Anstecker aus getrockneten Halmen verteilt. Sie sollten Glück bringen. Auch Bundesumweltministerin Frau Hendricks und EU-Klimakommissar Miguel Arias Cañete befestigten ihre Bast-Anstecker am Revers.“

Anmerkung: In der Recherche über die Marshall-Inseln[16] wurde gezeigt, dass Herr Tony de Brum eine ganz unrühmliche bis betrügerische Rolle bei der (falschen) Darstellung zur Ursache der Probleme seiner Inseln spielt um an Klimagelder zu gelangen. Aber politisches Geschick hatte ein Herr Blatter auch um an Geld zu kommen – und war zu seinen Zeiten allseits beliebt und geachtet. Und seine früheren Freunde haben zwar viel Geld an ihn gegeben, aber nicht gleich viele Milliarden und auch nicht das der Bürger (Anm.: in den Klimafonds – aktuell mit 100 Milliarden $ pa vorgesehen will Deutschland 10 % einzahlen).

Auch die Darstellungen über die „Recherchequalität“ des Bayerischen Rundfunks zeigen es – Wissen ist eher ein Grund für keine Anstellung.

Welche (auf keinen Fall fachliche, sondern eine als Aktivist) Ausbildung man bei Klimaretter.Info erwaret, ist im Artikel „Berichterstattung von klimaretterinfo ueber die am Pfingstwochenende durchgefuehrten Agitationen im Braunkohlerevier“ anhand der Ausbildungslistung der Redakteure ebenfalls am Schluss gezeigt.

Gehört nicht mehr zum Artikel

Auf ScienceSceptical hat ein Leser den folgenden Kommentarbeitrag eingestellt

Hatten wir nicht in Japan ein Erdbeben bisher unbekannter Stärke?

Und in Südamerika wurde ein neuer Supervulkan entdeckt.

Jetzt das Erdbeben vor Sumatra, auch von gewaltiger Stärke!

Der Ätna, Europas grösster Vulkan, ist aktiv geworden, schon 6 mal in diesem Jahr!!

Die Sonnenflecken verhalten sich ungewöhnlich!!!

In Japan gab es erst vor ein paar Tagen wieder ein Beben, fast gleichzeitig auch eines in Mexiko!

Doch das ist nicht alles: In der letzten Woche zeigten 13 Vulkane Änderungen in ihrer Aktivität und bei 4 Vulkanen wurden neue, ungewöhnliche Aktivitäten festgestellt!

Gewiss handelt es sich hier um GAGA (garantiert anthropogene geologische Aktivität).

Schuld ist natürlich niemand anderes als die Erdölkapitalisten, die rücksichtslos auf der Suche nach dem schnellen Dollar in Gäas Haut herumbohren — jetzt kommt noch das Fracking hinzu —, bis diese allergisch mit Schüttelfrost (Erdbeben) und Ausschlag (Eruptionen) reagiert. Mit Menschen- und Ziegenopfern ist es nicht getan: nur ein sofortiger Stopp aller Grabungs- und Bohrungstätigkeit kann helfen.

Als Übergangsmaßnahme schlage ich einstweilen einen Handel mit Erdzertifikaten vor, um die industrielle Penetration der Erdkruste künstlich zu verteuern und so einzuregeln.

Quellen

[1] Munich Re Rückversicherung 3. März 2015, Pressemitteilung: Risiken durch anhaltende Extremwetterlagen steigen – „Topics GEO“ analysiert Naturkatastrophen 2014

https://www.munichre.com/de/media-relations/publications/press-releases/2015/2015-03-03-press-release/index.html

[2] Munich Re, Publikation TOPICS CEO: Naturkatastrophen 2014 Analysen, Bewertungen, Positionen Ausgabe 2015

[3] EIKE 13.01.2016: Munich Re Presseinfo: Natur fordert mehr Opfer – Naturkatastrophen wie Erdbeben, Überschwemmungen und Hitzewellen haben 2015 deutlich mehr Menschenleben gekostet als im Vorjahr

http://www.eike-klima-energie.eu/climategate-anzeige/munich-re-presseinfo-natur-fordert-mehr-opfer-naturkatastrophen-wie-erdbeben-ueberschwemmungen-und-hitzewellen-haben-2015-deutlich-mehr-menschenleben-gekostet-als-im-vorjahr/

[4] Munich RE, NatCatSERVICE Januar 2015 Foliensatz: Wetterbedingte Schadenereignisse weltweit 1980 – 2014, Gesamtschäden und versicherte Schäden

[5] Swiss Re Zürich: Sigma explorer

http://www.sigma-explorer.com/

[6] EIKE 01.04.2016: PIK-Alarmmeldung: „Meeresspiegelanstieg: Zu groß zum Wegpumpen“, er könnte bis 2100 um 1,3 m steigen

http://www.eike-klima-energie.eu/news-cache/pik-alarmmeldung-meeresspiegelanstieg-zu-gross-zum-wegpumpen-er-koennte-bis-2100-um-13-m-steigen/

[7] EIKE, 26.04.2016: Systematischer Fehler bei Klimamessungen: Die Aufzeichnung der Lufttemperatur an der Erdoberfläche

http://www.eike-klima-energie.eu/klima-anzeige/systematischer-fehler-bei-klimamessungen-die-aufzeichnung-der-lufttemperatur-an-der-erdoberflaeche/

[8] EIKE 07.02.2016: Der Himmel fällt uns auf den Kopf und ohne die Glaskugel im Computer würden wir es nie erfahren

Rezension: UBA Studie 24/2015 Die Vulnerabilität Deutschlands gegenüber dem Klimawandel

http://www.eike-klima-energie.eu/news-cache/der-himmel-faellt-uns-auf-den-kopf-und-ohne-die-glaskugel-im-computer-wuerden-wir-es-nie-erfahren/

[9] EIKE 10.04.2016: Nachgefragt: BR Programm 14.3.2016, Sendung: „Jetzt mal ehrlich Verstrahltes Bayern: Wie viel Wahrheit ist uns zumutbar?“

http://www.eike-klima-energie.eu/news-cache/nachgefragt-br-programm-1432016-sendung-jetzt-mal-ehrlich-verstrahltes-bayern-wie-viel-wahrheit-ist-uns-zumutbar/

[10] EIKE 10.04.2016 : Nachgefragt: BR Programm 14.3.2016, Sendung: „Jetzt mal ehrlich Verstrahltes Bayern: Wie viel Wahrheit ist uns zumutbar?“

http://www.eike-klima-energie.eu/news-cache/nachgefragt-br-programm-1432016-sendung-jetzt-mal-ehrlich-verstrahltes-bayern-wie-viel-wahrheit-ist-uns-zumutbar/

[11] EIKE 28.07.2015: 5. Juli 2015, der bisher heißeste Tag Deutschlands?

http://www.eike-klima-energie.eu/klima-anzeige/5-juli-2015-der-bisher-heisseste-tag-deutschlands/

[12] Umweltbundesamt: Monitoringbericht 2015 zur Deutschen Anpassungsstrategie an den Klimawandel, Bericht der Interministeriellen Arbeitsgruppe Anpassungsstrategie der Bundesregierung

[13] kaltesonne, 21. Mai 2016 : ARD-Doku “Im Land der Lügen – Wie uns Politik und Wirtschaft mit Zahlen manipulieren”, Teil Journalistenworkshop “Klimawandel in Norddeutschland”

http://www.kaltesonne.de/ard-doku-im-land-der-lugen-wie-uns-politik-und-wirtschaft-mit-zahlen-manipulieren/

[14] EIKE, 21.11.2015: Die bayerische Umweltministerin Frau Scharf: Extremwetter, Extrem-Hochwasser und die Unberechenbarkeit des Wetters nehmen zu. Doch stimmt das wirklich?

http://www.eike-klima-energie.eu/news-cache/die-bayerische-umweltministerin-frau-scharf-extremwetter-extrem-hochwasser-und-die-unberechenbarkeit-des-wetters-nehmen-zu-doch-stimmt-das-wirklich/

[15] EIKE 29.10.2015 :Kann man den Klimawandel in Deutschland wirklich täglich spüren? Eine Suche mit überraschendem Ergebnis

http://www.eike-klima-energie.eu/news-cache/kann-man-den-klimawandel-in-deutschland-wirklich-taeglich-spueren-eine-suche-mit-ueberraschendem-ergebnis/

[16] EIKE 14.12.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 3 Die Marshall-Inselgruppe – (kein) Beispiel für einen Untergang

http://www.eike-klima-energie.eu/news-cache/gehen-die-suedseeinseln-wirklich-wegen-des-klimawandels-unter-teil-3-die-marshall-inselgruppe-kein-beispiel-fuer-einen-untergang/

[17] The European, 16.12.2015: Der Mythos vom Gleichgewicht der Natur

http://www.theeuropean.de/gerd-gantefoer/10602-klimaerwaermung-im-diskurs

[18] EIKE 26.03.2016: Rekonstruierte Temperaturverläufe der vergangenen zwei Jahrtausende. Eine Literatursichtung von 1990 bis ganz aktuell

http://www.eike-klima-energie.eu/news-cache/rekonstruierte-temperaturverlaeufe-der-vergangenen-zwei-jahrtausende-eine-literatursichtung-von-1990-bis-ganz-aktuell/

[19] böhmanwaltskanzlei: Äußerungs- / Presserecht Prüfung der Quelle

https://www.boehmanwaltskanzlei.de/kompetenzen/medienrecht/presserecht/persoenlichkeitsrechtschutz/schranken-persoenlichkeitsrechtsschutz/journalistische-sorgfaltspflichten/777-pruefung-der-quelle

[20] EIKE 27.03.2016 : Nachgesehen: Anzahl Tornadoopfer in den USA fast auf dem niedrigsten Stand seit Beginn der Zählung um 1875

http://www.eike-klima-energie.eu/news-cache/nachgesehen-anzahl-tornadoopfer-in-den-usa-fast-auf-dem-niedrigsten-stand-seit-beginn-der-zaehlung-um-1875/

144Windanlagen in 5 Meilen Entfernung

144Windanlagen in 5 Meilen Entfernung