Die ökonomischen Auswirkungen von Treibhausgas-Emissionen

Energiegleichgewichts-Klimasensitivität

Der wichtigste Parameter bei der Berechnung der ökonomischen Auswirkung des Klimawandels ist die Sensitivität des Klimas gegenüber Treibhausgas-Emissionen. Der Klimatologe Nicholas Lewis gebrauchte ein Energie-Gleichgewichts-Verfahren, um die Gleichgewichts-Klimasensitivität ECS zu schätzen. Er kam auf ein Best Estimate von 1,45°C bei einer Verdoppelung des atmosphärischen CO2-Gehaltes mit einer wahrscheinlichen Unsicherheits-Bandbreite (17% bis 83% Vertrauen) von 1,2°C bis 1,8°C.

ECS ist die globale Temperaturänderung als Folge einer CO2-Verdoppelung, nachdem man den Ozeanen Zeit gegeben hat, Temperatur-Gleichgewicht zu erreichen, was etwa 3000 Jahre dauert.

Ein für die Politik wichtigerer Parameter ist die Transiente Klima-Reaktion TCR, welche die globale Temperaturänderung zur Zeit der CO2-Verdoppelung ist. Eine derartige Verdoppelung würde bei der heutigen Rate der Zunahme von 55% etwa 126 Jahre dauern. Die Analyse ergibt ein Best Estimate bei 1,21°C mit einer wahrscheinlichen Bandbreite (17% bis 83%) zwischen 1,05°C und 1,45°C.

Die beiden analysierten Zeiträume sind 1859 bis 1882 und 1995 bis 2011. Sie wurden gewählt, weil sie sich durch die längste frühe bzw. späteste Periode ohne signifikante vulkanische Aktivität auszeichnen. Dies bietet die größte Änderung des Antriebs und folglich die geringste Unsicherheits-Bandbreite. Der lange Zeitraum zwischen den beiden Perioden hat zur Folge, dass sich kurzfristige Ozean-Oszillationen wie die AMO und die PDO heraus mitteln, berühren aber nicht Ozean-Oszillationen im Maßstab von Jahrtausenden oder indirekte solare Einflüsse.

Aerosole sind der dominante Beitrag zur Unsicherheit bei Schätzungen der Klima-Sensitivität. Nicholas Lewis schreibt: „In diesem Zusammenhang sind Schätzungen des Aerosol-Antriebs in einer überzeugenden neuen Studie von Björn Stevens mittels Verfahren, die auf der Physik basieren und mit Beobachtungen überprüft wurden, eine grundlegende Veränderung“. Stevens ist Experte bzgl. Wolken-Aerosol-Prozesse. Er leitete eine neue, längere Schätzung des Aerosol-Antriebs ab. Lewis verwendete die neue Schätzung für den Aerosol-Antrieb und verwendete Schätzungen anderer Antriebe, wie sie im 5. Zustandsbericht des IPCC beziffert worden waren.

Adjustierungen für Jahrtausend zyklische Erwärmung und Stadtwärme

Diese Analyse von Lewis berücksichtigt nicht die langfristige natürliche Erwärmung seit der Kleinen Eiszeit LIA, wahrscheinlich ausgelöst durch indirekte Sonnenaktivität. Die Temperatur-Historie zeigt eine offensichtliche Temperatur-Oszillation im Jahrtausend-Maßstab, was zeigt, dass natürliche Klimaänderung einen bedeutenden Anteil an der Erholung der Temperatur seit der LIA hat.

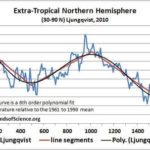

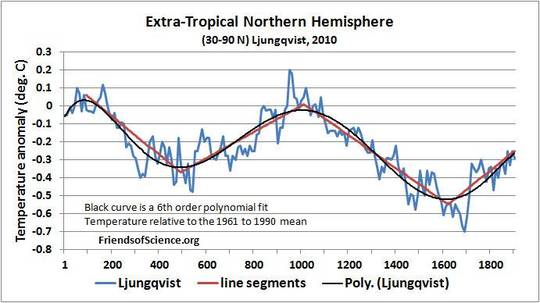

Abbildung 1: Außertropische Temperaturänderung auf der Nordhemisphäre, modifiziert übernommen von Ljungquist 2010 mit einem Polynom-Fit 6. Ordnung und Linien-Segmenten. Römische Warmzeit AD 1 bis 300; Kaltzeit der Dark Ages AD 300 bis 900; Mittelalterliche Warmzeit 800 bis 1300; Kleine Eiszeit 1300 bis 1900; moderne Warmzeit 1900 bis heute.

Frederik Ljungquist erstellte eine Temperatur-Rekonstruktion der außertropischen Nordhemisphäre (ETNH) während der letzten beiden Jahrtausende mit einer dekadischen Auflösung aufgrund von 30 Temperatur-Proxys. Anthropogene Treibhausgas-Emissionen haben bis zum Jahr 1990 keine signifikante Temperaturänderung ausgelöst, weil kumulative CO2-Emissionen bis 1900 nicht signifikant waren. Das Mittel der absoluten natürlichen Temperaturänderung über die vier Perioden in Abbildung 1 betrug 0,095°C pro Jahrhundert.

Die Ljungquist-Studie nennt zahlreiche Gründe, warum die Rekonstruktion wahrscheinlich die Temperatur-Variabilität „ernstlich unterschätzt“. Aber er nimmt an seiner Rekonstruktion keinerlei Korrekturen vor. Die Baumring-Proxys sind hin zur sommerlichen Wachstumsperiode verzerrt. Falls die Abkühlung der LIA in den Wintermonaten ausgeprägter war, wäre die Jahresschätzung zu warm verzerrt. Die großen Datierungs-Unsicherheiten in Sediment-Proxys haben den Effekt der „Verflachung“ der Temperaturen, so dass die wirkliche Größenordnung zwischen Warm- und Kaltperioden unterschätzt ist.

Die Proxy-Temperatur ist während des 20. Jahrhunderts nicht so stark gestiegen wie die mit Thermometern gemessene Temperatur. Dies zeigt, dass die instrumentelle Temperatur zum Wärmeren verzerrt ist infolge des nicht korrigierten städtischen Wärmeinsel-Effektes UHI und/oder unterschätzten rekonstruierten Temperaturvariationen aus den Proxys.

Die jährlichen Temperaturen zeigen 23% mehr Variabilität als die Temperaturvariabilität von Bäumen während der Wachstumssaison, gewichtet nach Wachstumsraten der Bäume. Dies zeigt, dass die Baumring-Proxys die Temperaturvariabilität unterschätzen. Acht der 30 Proxys haben diesen jahreszeitliche Baumring-Bias. Unter der Annahme der Datierungs-Unsicherheit der 12 Sediment-Proxys verbreitert sich die Auflösung über 100 Jahre. Damit wurde geschätzt, dass diese Proxys die Temperaturvariabilität um 12% unterschätzen. Der gewichtete mittlere Bias der 30 Proxys wurde mit 11% geschätzt.

Die Temperaturvariabilität der Tropen und der Südhemisphäre ist geringer als auf der extratropischen Nordhemisphäre, was dem größeren Ozeangebiet geschuldet ist. Betrachtet man die kühlste und wärmste Zwei-Dekaden-Periode, variieren die globalen Temperaturen nur um 80% der ETNH. Die globale natürliche Erholung aus der Kleinen Eiszeit wird mit 0,084°C pro Jahrhundert geschätzt, wobei der Proxy-Bias und die globalen Adjustierungen berücksichtigt sind.

Zahlreiche Studien haben gezeigt, dass der UHI die Temperaturmessungen mit Thermometern kontaminiert. Eine Studie von McKitrick und Michaels 2007 zeigte, dass fast die Hälfte der Erwärmung auf dem Festland seit 1980 in den Instrumenten-Datensätzen auf den UHI zurückzuführen ist. Der UHI auf dem Festland macht etwa 0,14°C pro Dekade aus oder 0,042°C pro Dekade auf globaler Basis seit 1979.

Die Jahrtausend-Erwärmung und UHI-Korrekturen reduzieren die Temperaturänderung zwischen den beiden Perioden der Analyse aufgrund von Treibhausgasen von 0,72°C auf 0,51°C. Der Best Estimate des ECS unter Einbeziehung des Jahrtausend-Erwärmungszyklus‘ und dem UHI liegt bei 1,02°C, und der Best Estimate von TCR bei 0,85°C.

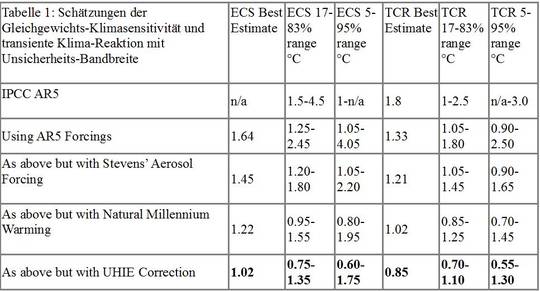

Zusammenfassung der Klimasensitivitäts-Schätzungen

Tabelle 1 listet die Best Estimates von ECS und TCR sowie die wahrscheinlichen und höchst wahrscheinlichen Vertrauensintervalle in 5 Fällen. Alle auf Antriebe basierenden Schätzungen verwenden jeweils initiale und finale Perioden von 1859 bis 1882 und 1995 bis 2011. Die Bandbreiten liegen nahe 0,05°C.

Tabelle 1: Die Best Estimate der TCR von 0,85°C impliziert, dass die globale Temperatur von 2016 bis 2100 infolge anthropogener Treibhausgas-Emissionen nur um 0,57°C steigen wird, falls der atmosphärische CO2-Gehalt weiter mit der gegenwärtigen Rate von 0,55% pro Jahr zunimmt. Tatsächliche Temperaturen werden abhängig vom natürlichen Klimawandel steigen oder sinken.

Soziale Kosten von Kohlenstoff

Die Interagency Working Group (IWG) der US-Regierung zu sozialen Kosten von Kohlenstoff (SCC) nutzt drei integrierte Assessment-Modelle (IAM), um die sozialen Kosten und Vorteile von Treibhausgas-Emissionen zu bestimmen. In zwei dieser Modelle, DICE und PAGE, sind die Vorteile der Düngung durch CO2 und andere Vorteile der Erwärmung nicht enthalten, ebensowenig wie die Berücksichtigung von Anpassung.

In das FUND-Modell gehen diese Vorteile ein, doch unterschätzt es die Vorteile der CO2-Düngung. Idso (2013) kam zu dem Ergebnis, dass die Zunahme der atmosphärischen CO2-Konzentration während des Zeitraumes 1961 bis 2011 verantwortlich war für die zunehmenden landwirtschaftlichen Erträge im Wert von 3,2 Billionen Dollar (in constant 2005 US$).

Das FUND-Modell zeigt, dass Kanada aus den Emissionen den Vorteil von 1,9% des BIP bis zum Jahr 2100 erzielen wird, äquivalent zu einem Vorteil von 109 Milliarden Dollar jährlich, wenn man eine ECS von 3°C annimmt. Anthropogener Klimawandel wird in Kanada ausschließlich positive Auswirkungen haben, die während des gesamten 21. Jahrhunderts zunehmen.

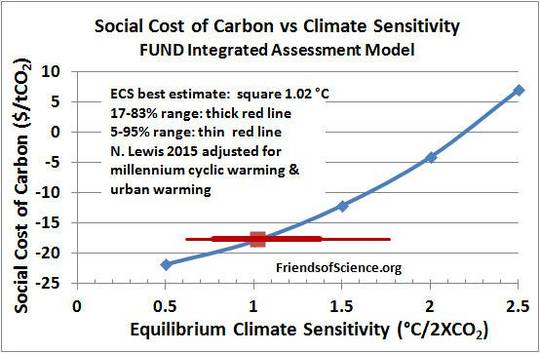

Abbildung 2: Die Gleichgewichts-Klimasensitivität ECS wie von N. Lewis berechnet mit dem Aerosol-Antrieb von Stevens, anderen Antrieben und Wärmeaufnahme laut AR 5 des IPCC sowie globale Temperaturen, die adjustiert wurden, um der natürlichen Jahrtausend-Zyklus-Erwärmung sowie der städtischen Erwärmung seit 1980 Rechnung zu tragen. Die Best Estimate von ECS wird durch das rote Quadrat repräsentiert, Unsicherheits-Bandbreiten durch die roten Linien. Die sozialen Kosten von Kohlenstoff ach dem FUND-Modell zeigt die blaue Linie.

Abbildung 2 zeigt die SCC (blaue Linie) als eine Funktion von ECS. Die Best Estimate von ECS zeigt das rote Quadrat. Die dicke rote Linie zeigt die 17% bis 83%-Bandbreite der Wahrscheinlichkeit und die dünne rote Linie zeigt die Wahrscheinlichkeits-Bandbreite der ECS-Schätzung von 5% bis 95%. Die SCC-Werte zeigen einen realen Diskontsatz von 3%.

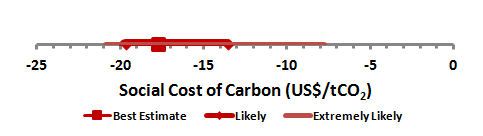

Projiziert man die ECS-Werte vertikal auf der blauen SSC vs ECS-Kurve, erhält man die Best Estimate und die Vertrauensintervalle von SCC, wie in Abbildung 3 gezeigt. Die Analyse zeigt, dass auf globaler Basis die Best Estimate von ECS mit 1,02°C ein SCC von -17,7 US-Dollar pro Tonne CO2 ergibt, was wirklich sehr vorteilhaft ist. Die Wahrscheinlichkeits-Bandbreite beträgt -19,7 bis -13,6 US-Dollar pro Tonne CO2, und es ist extrem wahrscheinlich, dass es unter -7,7 US-Dollar pro Tonne CO2 liegt. Diese Ergebnisse zeigen, dass man auf fossile Treibstoffe keine Kohlenstoff-Steuer erheben sollte, sondern man sollte jede Tonne CO2 mit etwa 18 US-Dollar subventionieren.

Die Vorteile durch CO2-Düngung, einer geringeren, von kaltem Wetter verursachten Sterblichkeit, geringere Industriekosten wie Kosten für Konstruktion, mehr urbare Landflächen und geringere Heizkosten übersteigen eventuelle schädliche Auswirkungen durch Erwärmung bei Weitem auf globaler Basis.

Abbildung 3: Soziale Kosten von Kohlenstoff in US-Dollar pro Tonne CO2 einschließlich Best Estimate, wahrscheinliche (17% bis 83%) und extrem wahrscheinliche (5% bis 95%) Unsicherheits-Bandbreiten. Die Unsicherheits-Bandbreiten enthalten nicht die Unsicherheit in Verbindung mit dem Milleniums-Erwärmungszyklus oder dem UHI.

A longer, technical version of this article, with a section on Alberta’s climate plan, and references is available in PDF format at http://www.friendsofscience.org/index.php?id=2205

The data and calculations are at http://www.friendsofscience.org/assets/files/SCC_Lewis_CS_2.xls Excel spreadsheet.

Link: https://wattsupwiththat.com/2016/05/21/the-economic-impact-of-greenhouse-gas-emissions/

Übersetzt von Chris Frey EIKE