Inhaltlich ist dies Publizierung eine Abrundung zur Darstellung der aktuellen Pegelverläufe in der Reihe:

[6] „Gehen die Südseeinseln wirklich wegen des Klimawandels unter?.

und Ergänzung zur Analyse der entsprechenden Temperaturwerte

[11]„Rekonstruierte Temperaturverläufe der letzten zwei Jahrtausende“

Wer schon immer einmal (nach-)sehen wollte, wie Daten zum historischen und vor-historischen Pegelverlauf aussehen, kann es durch diese Recherche in kompakter Form erfahren. Gesichtet wird in diesem Artikel grob der Zeitraum von 6.000, 3.000 und 2.000 Jahren vor heute (BP), also der Bereich des schon auslaufenden Pegelanstiegs.

Eiszeiten als Treiber des Meeresspiegels

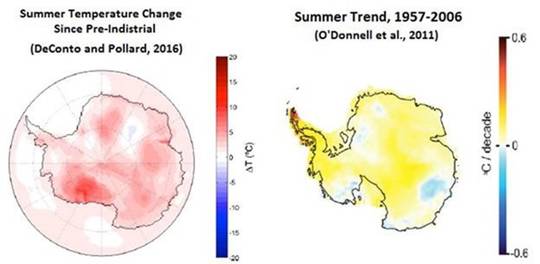

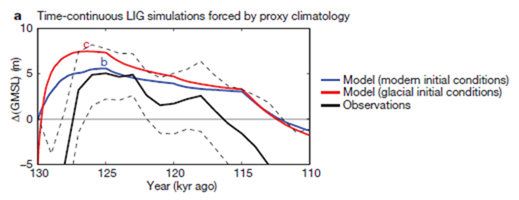

Zuerst die Darstellung was die Natur an Klimavariabilität bietet und wie konsequent sie diese durchführt. Das Bild 1 zeigt den Meerespegel, die Temperatur verläuft also gegensätzlich. Ab Age 120 … 140 (kyr) begann die letzte Eiszeit und hatte ihren Höhepunkt vor ca. 20.000 Jahren. Aktuell beginnt eine Neue! – oder die Nächste fällt ganz aus wie es Prof. Schellnhuber vom PIK vorhersagt „Fällt die nächste Eiszeit aus?“ .

Bild 1 [25] 0.1 Zyklische Wiederholung von Eiszeiten (vom Autor ergänzt)

Der gelbe Ausschnitt von Bild 1 nun im Detail. Nach dem Ende (Time 20 (kyr b2k)) der letzten Eiszeit beginnt langsam das Zeitalter des Holozän (grüner Pfeil im gelb umrandeten Bereich, WIKIPEDIA: Holozän, Beginn genau vor 11.700 +-99 Jahren vor dem Jahr 2.000) in welchem sich die Menschheit aktuell befindet.

Bild 2 [9] Verlauf des Meeresspiegels seit ca. 140.000 Jahren. Grüner Pfeil: Beginn Holozän-Zeitalter (Bild vom Autor ergänzt)

Zeitraum letzte Eiszeit und Holozän

Nach der letzten Eiszeit gab es erwartungsgemäß einen Anstieg der Pegel (Bild 3). Zum Glück fiel dieser gewaltige Anstieg in die Zeit vor dem Bau großer Städte direkt an den Küsten, obwohl die in den damaligen Küstenregionen und niedrig gelegenen Weltgegenden wohnenden Steinzeitmenschen sicher auch stark davon betroffen waren. Seit den letzten 7 … 6.000 Jahren verläuft der Pegel flach mit geringfügigen Änderungen, aber eben auch mit stetigem leichten (Rest?-)Anstieg.

Bild 3 Anstieg des Meeresspiegels nach der letzten Eiszeit. Zufügung: Grün: Beginn Holozän, Rot: betrachtete Zeiträume

Quelle: Wikipedia. Urheber: Robert A. Rohde / Lizenz: GNU-Lizenz für freie Dokumentation, Version 1.2 oder eine spätere Version

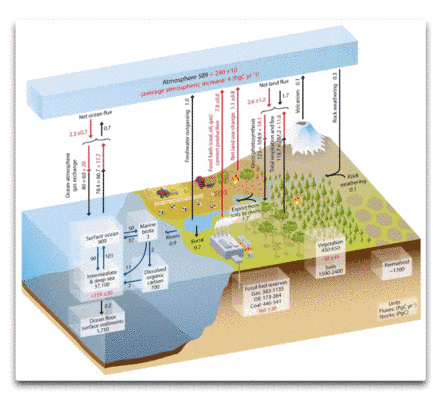

Vergessen wird oft, dass das Wasser irgendwo herkommen muss. Wie sich dies darstellt, zeigt das folgende Bild 4. Auch wenn es durch den dargestellten langen Zeitraum den aktuellen nicht mehr auflöst, kann man ahnen, dass alleine aus natürlichen Gründen eine leichte weitere Eisvolumens-Abnahme und damit rein natürlich bedingte Pegelzunahme der Weltmeere denkbar wäre. Der Eis-Volumens-Maßstab ist bereits bei 0, was zeigt, dass sich die Erde aktuell in einem Minimum an Erdeisvolumen befindet. Das Schmelzen seit 20.000 Jahren ging über 7.000 Jahre als natürlicher Klimavorgang mit unglaublicher Geschwindigkeit (ca. 14,3 mm/pa) vor sich und verläuft derzeit fast horizontal mit einem kläglichen Restvolumen. Man könnte vermuten, dass dieses kleine Restvolumen für natürliche, kurze Schwankungen immer anfälliger wird.

Auffällig ist, wie wenig die Antarktis zu dieser extremen Veränderung beigetragen hat (Bild 4). Ihr Eis ist gegenüber dem der Nordhalbkugel wesentlich stabiler, was sich aus ihrer Kälte und durch die Lage auf Festland erklärt (das wesentliche heutige Eisvolumen der Nordhemisphäre konzentriert sich auf den Landsockel von Grönland).

Auffällig in Bild 4 sind die eingetragenen Simulationen NAWI-A1 / -A2. Die Rück-Simulation des Antarktis-Eisvolumens funktioniert demnach nicht, bzw. führt abhängig vom Verfahren zu eklatanten Abweichungen.

Bild 4 [21] Verlauf der Erd-Eisvoluminas. Anm.: Das maximale Eisvolumen von 4.7841·1016m3 entspricht einer uniformen Meeresspiegelabsenkung von 117.41m [16]. Das Ende der letzten Eiszeit war vor ca. 20.000 Jahren

Bildtext: Figure 4.2: Total ice-mass change for the Pleistocene load modls NAWI-A1 and NAWIA2. The northern hemisphere contributes 120 m ESL, the southern hemisphere (i. e. the AIS) 12 m ESL to the global mean sea-level change since the LGM. The northern hemisphere glaciation starts at 120 ka BP, reaches its maximum at 20 ka BP and is identical for both load models. The last glaciation of the southern hemisphere starts at 120 ka BP (NAWI -A1) or 50 ka B P (NAWI-A2) and reaches its maximum at 15 ka BP. The previous glacial cycle (only modeled for the southern hemisphere) has the same temp oral evolution and terminates at 120 ka BP (not shown).

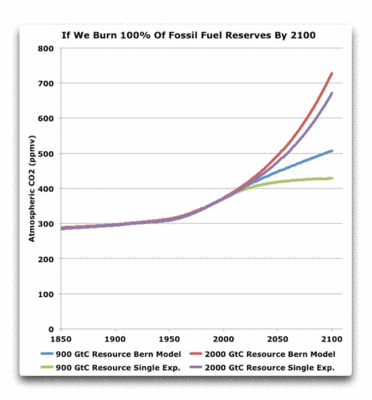

Die Zukunftsprojektion im nächsten Bild 5 betrachte man deshalb mit der nötigen Skepsis. Wenn die Klimasimulationen richtig rechnen (könnten), würde der Mensch mit seinem CO2-Beitrag die sicher kommende nächste Eiszeit etwas verzögern „Fällt die nächste Eiszeit aus?“ – Eigentlich eine grandiose Vorstellung zur Weltrettung durch anthropogenes CO2. Denn wohl nichts dürfte schlimmer sein als die nach der Zyklik mit Sicherheit kommende nächste Eiszeit.

Können wir die nächste Eiszeit überleben?

Wie schnell die Eiszeiten einsetzen, sieht man an den Spitzen von wenigen Tausend Jahren. Und einige Tausend davon können ja schon vorbei sein. Eine dann ausschließlich EEG-versorgte Energielandschaft mit verschneiten und vereisten Solar- und Windkraftanlagen sowie bis auf den Grund zugefrorenen Speicherseen dürfte die dann (er-)frierende Menschheit kaum mit der erforderlichen Wärme versorgen können. Ein Maisanbau in beheizten Gewächshäusern für Biogasanlagen dürfte auch nicht für die „Rettung“ sorgen können.

Überspitzt lässt sich daraus ableiten:

Deutschland macht das Falscheste, was man in einer solchen kritischen Klima-Situation überhaupt veranlassen kann:

– Kein CO2-emittieren (und damit den Start der mit Sicherheit kommenden Eiszeit beschleunigen)

– Auf EEG-Energie umbauen (um mit Sicherheit in dieser Eiszeit zu erfrieren)

Fazit daraus: Deutschland scheint beim „Retten“ der Welt vor irgend etwas einfach immer nur glücklos zu sein.

Der Autor könnte sich jedenfalls vorstellen, dass die ganz zukünftigen Generationen lieber in den roten als den grün- / blauen Temperaturkurven von Bild 5 leben würden. Denn darauf, dass die grüne Kurve (Verlauf ohne weitere CO2-Emission) wirklich so lange wie gezeichnet stabil bleibt und nicht wie in den letzten Millionen Jahren immer konsequent doch schnell wieder steil abfällt, sollte die Menscheit nicht vertrauen.

Gerade die Kirche welche doch in ganz anderen Zeiträumen denkt sollte sich das durch den Kopf gehen lassen.

Bild 5 [22] Verlauf der letzten Eiszeiten und Zukunftsprojektionen. Beachten: Time -100 = -100.000 Jahre, 0 = Jahr 1950

Bildtext: Abbildung 4. Auswirkungen von CO2 aus fossilen Brennstoffen auf die zukünftige Entwicklung der mittleren, globalen Temperatur. In grün der Verlauf ohne CO2 Emissionen, blau stellt den Verlauf bei Ausstoss von 300 Giga-Tonnen Kohlenstoff, orange 1000 Giga-Tonnen und rot 5000 Giga-Tonnen dar (Archer 2005) (mit Ergänzungen durch den Autor)

Nach dieser Abschweifung zur Zukunft zurück zum Thema.

Meerespegelverlauf in geschichtlicher Zeit

Dieser Zeitraum ist wichtig, weil er zur Kalibrierung und Belegung der Zukunftssimulationen dient. Wenn man – wie das PIK – „sicher ist“, dass die nächste Eiszeit in 60.000 Jahren* ausfallen wird „Fällt die nächste Eiszeit aus?“ und genaue Projektionen des weiteren Verlaufs vorlegt, muss man die entsprechenden Zukunftssimulationen anhand der Daten der Vergangenheit sehr genau kalibrieren und auch verifizieren.

*Die Eiszeit ist in dieser Zeit bereits in vollem Gange. Begonnen hat sie nach der Zyklik schon. Anm.: Wie beim Klima üblich, haben die Experten dazu jedoch vollkommen gegensätzliche Ansichten.

Was sagt der IPCC im AR5 (letzter IPCC Sachstandsbericht von 2013)

Im AR5 Hauptbericht findet sich eine Grafik (Bild 6) und dazu der folgende Erklärungstext:

IPCC AR5 [2] 13.2.1.4 The Late Holocene: Based on local sea level records spanning the last 2000 years, there is medium confience that flctuations in GMSL during this interval have not exceeded ~ ±0.25 m on time scales of a few hundred years (Section 5.6.3, Figure 13.3a).

Diese Angabe strotz nicht gerade vor Präzision und Sicherheit. Im Bild selbst ist eine Spannweite der Proxis über die letzten 3.000 und 2.000 Jahre von ca. 100 cm ausgewiesen.

Bild 6 [2] IPCC Proxibild der vergangenen 3000 Jahre (gestrichelte Linien durch den Autor ergänzt). 0 = Jahr 1950

Bildtext: Figure 13.3 (a) Paleo sea level data for the last 3000 years from Northern and Southern Hemisphere sites. The effects of glacial isostatic adjustment (GIA) have been removed from these records. Light green = Iceland (Gehrels et al., 2006), purple = Nova Scotia (Gehrels et al., 2005), bright blue = Connecticut (Donnelly et al., 2004), blue = Nova Scotia (Gehrels et al., 2005), red = United Kingdom (Gehrels et al., 2011), green = North Carolina (Kemp et al., 2011), brown = New Zealand (Gehrels et al., 2008), grey = mid-Pacific Ocean (Woodroffe et al., 2012).

Aufgrund der mangelnden Auskunftsfreudigkeit des IPCC-AR5 muss man sich die passenden Studien direkt ansehen.

Was sagen Studien über den Pegelverlauf

Übersicht

Es gibt eine von mehreren Instituten verfasste Studie [15] in welcher Pegelverläufe rund um die Welt gesammelt hinterlegt sind. Daraus zuerst die Proxybilder.

Bild 7 [15] Sammlung Pegelproxys

Bildtext (Auszug): Fig. 3 Selected relative sea-level (RSL) reconstructions from Southern

Disko Bugt, Greenland [54, 56], Northwest Georgia Strait, Canada [49], Southern Maine, USA [71], New Jersey, USA [43], Louisiana, USA [74], California, USA [49], St. Croix [99], Suriname and Guyana [100 ], Rio Grande do Norte State, Brazil [102], and South Shetland Islands, Antarctica [112, 114]. All y-axes are RSL (meters to present)

Bild 8 [15] Sammlung Pegelproxis Weiterführung

Bildtext (Auszug): Fig. 4 Selected relative sea-level reconstructions from Arisaig, Scotland [121], Baltic Coast of Sweden [122], Rotterdam, Netherlands [123], Southern France [138], Tunisia [138], Nile, Egypt [141], Langebaan Lagoon, South Africa [42], West Guongdong, China [166], Singapore [160], and North Queensland, Australia [181], and New South Wales,

Australia [182] shown as in Fig. 3

Der Autor hat sich die Mühe gemacht, die Daten der Bilder 7 und 8 in einer Tabelle zu listen und auszuwerten. Die Pegeldifferenz zum Jahr 8000 wurde vom Autor aus den Proxibildern abgeleitet, die Pegel-Änderungswerte (mm / pa) sind der Tabelle 1 der Studie [15] entnommen (dort: m / ka), die absoluten Pegeländerungen der letzen 2000 Jahre sind vom Autor aus den Werten der 2 ka Spalte (aus Tabelle 1 der Studie) zugefügt. Die Daten in der Studie vom Mittelmeer wurden nicht übernommen, da diese für die Weltmeere nicht repräsentativ sind.

Bild 9 [15] Meerespegel Verlaufsrekonstruktionen aus den Bildern 5 und 6 tabelliert (ohne Pegel Mittelmeer)

Auswertung

Diese Studie ermittelte für den Zeitraum der letzten 2.000 Jahre eine Pegel-Änderungsspannweite von absolut 4,6 m (AR5: 1 m). Anm.: Mit dem Pegelwert Antarktis (Bild J der Studie, nicht in Bild 9 übernommen) beträgt die Spannweite sogar 13,6 m.

Im Histogramm kann man die Verteilung der Pegel-Änderungswerte der letzten zwei Jahrtausende sehen. Nun sind die Pegelproxis nicht statistisch über die Welt verteilt und erfüllen somit die Anforderungen einer Stichprobe nicht. Trotzdem lässt sich gut die große Streuung erkennen und eben auch, dass solche Proxysammlungen keinen repräsentativen Globalpegel abbilden.

Bild 10 [15] Meerespegel Änderungsgeschwindigkeiten in mm / pa vom Jahr 0 bis 2000 (ohne Pegel Mittelmeer und ohne dem Pegelwert Antarktis von -5,2 mm / pa) aus Bild 7

Wären alle Pegelverläufe seit dem Jahr 0 bis heute linear, ergäbe sich rund um die Welt für die letzten 2000 Jahre daraus das folgende Bild der auf das Jahr 2000 normierten Pegeländerungen (in m).

Bild 11 [15] Meerespegel Verlaufsrekonstruktionen vom Jahr 0 bis zum Jahr 2000 aus den Werten von Bild 9, normiert auf das Jahr 2000 (ohne Pegel Mittelmeer)

Fazit

Diese Studie weist zu den Angaben des IPCC AR5 mit ca. 100 cm Pegelspanne eine erhebliche Diskrepanz bezüglich der Größe von Pegeländerungen der letzten 2000 Jahre auf.

Zudem ist es bei Weitem nicht so, dass sich rund um die Erde die Pegel gleichmäßig und in eine Richtung verändern würden. Das Ableiten globaler Trends gestaltet sich damit schwierig.

Antarktis

Wie man schon anhand der vorherigen Studie sehen konnte, macht die Südhalbkugel beim Ermitteln (weit) größere Probleme.

Im folgenden Bild dazu die Streuungen einer solchen Proxiermittlung, welche im Mittelwert dann „ganz gerade“ erscheinen.

Bild 12 [23] Pegelproxi im Raum der Antarktis

Bildtext: Figure 5. Observed sea level variations and predictions based on the ice models of ANT4 and ICE-3G. The red solid circles represent the past mean sea level determined by organic materials such as fossil shells. The green solid and open circles indicate the upper and lower bounds of the sea level evidence dated by, for example, penguin and elephant seal bone.In these calculations, we employ a viscosity model assuming that the upper and lower mantle viscosities are 5 1020 and 1022 Pa s, respectively. The lithospheric thickness (effective elastic thickness): The models used here are 100 km and 50 km.

Fazit:

Es besteht eine sehr große Diskrepanz zwischen den niedrigen Änderungswerten des Bildes im AR5 und ermittelten Werten anderer Autoren.

Sichtung anhand detaillierterer Pegelproxis

Nachdem die Studie [15] erheblich größere absolute Pegeldifferenzen als der AR5 ausweist, geht es im folgenden darum, was von der Angabe im AR5 zu halten ist, dass während der letzten 2000 Jahre mit mittlerer Sicherheit innerhalb von einigen hundert Jahren die Pegeländerungen +-0,25 m nicht überstiegen.

Verlauf eines Proxis der Malediven, indischer Ozean.

Bild 13 [3] Fig. 1. Sea level curve for the last 5000 years for the Maldives.

Verlauf eines Proxis der Nordsee.

Bild 14 [10] Meeresspiegelentwicklung an der südlichen Nordsee in den letzten 7500 Jahren. Aus Behre (2004)

Verlauf eines Proxis der Marshall-Inseln im westlichen Pazifik.

Bild 15 [14] Meeresspiegelentwicklung auf den Marschallinseln während der vergangenen 6000 Jahre. Quelle: Kench et al. 2014

Weitere Proxis aus dem pazifischen Raum

Bild 16 [19] Verschiedene Pegelproxis Süd-Pazifik. Age 0 ist das Jahr 2.000

Verlauf Island.

Bild 17 [7] Pegelproxy Island

Verlauf Brasilien

Bild 18 [20] Brasilien

In der folgenden Tabelle sind die Daten aus den vorherigen, detaillierteren Proxigrafiken zusammengefasst.

Bild 19 Zusammenfassung von Beispiel- Pegel-Änderungen in historischer Zeit (ohne die Daten aus Bild 9). Bezug Jahr 2.000 nach Chr.

Fazit

In diesen Proxis sind die Spannweiten der Pegel der letzten 2.000 Jahre deutlich niedriger als in der Studie [14], mit bis zu 3m aber immer noch wesentlich höher als im IPCC AR5 mit 1 m.

Und in diesen detaillierteren Proxis zeigt sich, dass sehr wohl davon ausgegangen werden muss, dass kurzfristige Pegeländerungen von (weit) mehr als +-25 cm während der letzten 2000 Jahre innerhalb vergleichseise kurzer Zeiträume geschehen sind.

Weiter sieht man dass die absoluten Angaben erheblich differieren und die Trendaussagen gegensätzlich sind. Kurzfristige Pegeländerungen nehmen zu, sind in den verschiedenen Studie aber unterschiedlich ausgeprägt enthalten.

Exemplarische Vergleiche verschiedener Proxiquellen mit dem AR5

Um einen direkten Vergleich durchzuführen, wurden die verfolgbaren Proxis aus dem AR5, Figure 13.3 (Bild 20) vom Autor nachgezeichnet und auf das Jahr 2.000 B.P. normiert (Bild 20).

Bild 20 [2] Verlauf einiger IPCC Proxis von Bild 6 (vom Autor nachgezeichnet und auf das Jahr 2000 B.P. normiert)

Vergleich Raum Island

Die Rekonstruktionen der gleichen Insel (Island) unterscheiden sich fundamental (Bild 21). Nimmt man als Vergleich noch aus der Studie [15] das in der Nähe liegende Schottland mit -3,2 m (Bild11) erhält man zusätzlich einen gegenteiligen Verlauf. Der AR5 zeigt die geringsten Änderungen.

Bild 21 Verlauf auf das Jahr 2000 B.P. normierte Pegel Island aus Bild 21 (AR5) (hellgrün), Bild 18 [7] (schwarz), Schottland aus Bild 17 [15] (blau)

Vergleich Raum Südpazifik

Auch der Vergleich von Proxis im südpazifischen Raum zeig erhebliche Abweichungen untereinander, wobei wieder der Verlauf aus dem AR5 der mit den geringsten Änderungen ist. In den Verläufen mit eingetragenen Proxiwerten erkennt man deutlich die in den Mittelwertkurven verschwundenen Variabilitäten. Bezogen auf die Normierung um das Jahr 0 ergeben sich in diesem Raum immerhin über 100 cm Proxiabweichungen.

Bild 22 Pegelrekonstruktionen Bereich Süd-Pazifik, vom Autor auf das Jahr 2000 B.P. (so weit möglich) normiert

Vergleich Raum Malediven

Für die Malediven wurden eine grob und eine hoch auflösende Proxy übereinander gelegt und dazu noch eine hoch auflösende aus Süd-Australien (welche natürlich nicht den Pegel Malediven abbildet). Das Bild soll zeigen, wie stark die Pegeländerungen von der Auflösung abhängen.

Hier beträgt die Pegelspannweite der letzten 2.000 Jahre ca. 3 m mit deutlichen, schnellen Änderungen.

Bild 23 Proxi Malediven aus Bild 13 grau, Proxy Malediven aus Studie [16] rot gestrichelt, Proxi Port Piri Südaustralien aus Studie [16] hellbraun. Anm.: Der rote und hellbraune Proxyverlauf wurden vom Autor anhand der Werte aus der Datentabelle gezeichnet.

Fazit

Die direkten Vergleiche durch Übereinander-Legen von Proxis aus ähnlichen Gegenden zeigt ergänzend zum vorherigen Kapitel die Unsicherheiten bei der Ermittlung bzw. Festlegung und bestätigt die Zweifel an der Aussage im AR5, dass höhere kurzfristige Pegeländerungen während der letzten 2000 Jahre noch nie vorkamen:

AR5: there is medium confience that flctuations in GMSL during this interval have not exceeded ~ ±0.25 m on time scales of a few hundred years

Vergleich im AR5

Es lässt sich einwenden dass man zu Allem eine andere Aussage finden kann, jedoch die in IPCC-Paper übernommenen so gut geprüft sind, dass daran nicht zu rütteln wäre.

Sehen wir uns deshalb dazu eine Proxy aus dem IPCC AR5 im Detail an:

— Im Bild 6, AR5 Figure 13.3 ist die Proxy: green = North Carolina (Kemp et al., 2011) enthalten.

Diese Proxi sieht in der Originalstudie wie folgt aus (Bild 24):

Bild 24 [26] Pegelverlauf NorthCarolinea im Original-Paper Kemp at al. 2011, hinterlegt im AR5 Figure 13.3 (vom Autor ergänzt)

Bildtext Fig. 2. (A) Composite EIV global land plus ocean global temperature reconstruction (1), smoothed with a 30-year LOESS low-pass filter (blue). Data since AD 1850 (red) are HADCrutv3 instrumental temperatures. Values are relative to a preindustrial average for AD 1400–1800 (B) RSL reconstructions at Sand Point and Tump Point since BC 100. Boxes represent sample-specific age and sea-level uncertainties (2σ). Inset is a comparison with nearby tide-gauge data. (C) GIA-adjusted sea level at Sand Point and Tump Point expressed relative to a preindustrial average for AD 1400–1800. Sea-level data points are represented by parallelograms because of distortion caused by GIA, which has a larger effect on the older edge of a data point than on the younger edge. Times of changes in the rate of sea-level rise (95% confidence change-point intervals) are shown. Pink envelope is a nine degree polynomial to visually summarize the North Carolina sea-level reconstruction.

Was lässt sich anhand der Originalstudie [26] ermitteln

Neben dem Umstand, dass der Pegel im Originalbild der Studie (Bild 24) vom Jahr 1000 bis ca. 1500, also immerhin über 500 Jahre gegensätzlich zur während dieser Zeit deutlich fallenden Temperatur ansteigt, findet sich genau zu dieser Studie auch ein massiver, substantieller Einwand.

Ein Forscherteam um Aslak Grinsted [27] analysierte die Studie und ist der Überzeugung, dass die Pegelableitungen aufgrund methodisch fragwürdiger Höhenkorrekturen falsch ist und die (niedrigen) Angaben zu den Toleranzen der rekonstruierten Pegelkurve in Wirklichkeit wesentlich höher angenommen müssen.

Ihre Aussage ist deutlich:

[27] Wir wissen auch nicht wie der Verlauf genau ist (das gelingt mit den unsicheren Proxidaten nicht), aber wir wissen dass die Ableitungen und Toleranzangaben von Kemp et al. nicht stimmen. Im Gegensatz zu Kemp et al. geben wird das aber offen zu.

Eine Rekonstruktion könnte damit in etwa aussehen wie im folgenden Bild 25 (Fig. 1 aus der Studie [27]) gezeigt.

Bild 25 [27] Neu rekonstruierter Pegelverlauf der Proxi [26] (mit Zufügungen durch den Autor)

Bildtext: Fig. 1. Comparison of the North Carolina sea level reconstruction corrected for two different GIA adjustments (red lines) and global sea level hind-casts from semiempirical models (thin solid lines). The choice of GIA has a large impact on the adjusted North Carolina sea level. Semiempirical hind-casts of global sea level deviate slowly from the adjusted NCRSL curve, but confidence intervals overlap for more than a millennium. Illustrative 5% to 95% confidence intervals are shown by the shaded regions colored for the appropriate curves. A 50-y smoothing has been applied to NCRSL.

Fazit

Auch in den AR5 übernommene Daten spiegeln die in den vorherigen Kapiteln aufgezeigte Problematik direkt wieder. Es ist nicht erkennbarr, dass die Datenlage darin verlässlich besser wäre. Jedoch wird dies im AR5 nicht erwähnt, sondern Aussagen mit Vertrauensbereichen abgeleitet, welche bezeifelt werden dürfen.

Fazit zum Pegelverlauf der letzten zwei Jahrtausende

Es ergibt sich das gleiche Bild wie schon bei der Recherche der Temperaturproxis [11] “Rekonstruierte Temperaturverläufe der vergangenen zwei Jahrtausende”: Eine verlässliche Datenbasis liegt nicht vor. Von einer hohen Sicherheit über die wirklichen Pegelverläufe (mit der erforderlichen Genauigkeit) kann keine Rede sein.

Und es fällt wieder auf, dass es in historischer Zeit mit ziemlicher Sicherheit erheblich größere und auch schnellere Schwankungen gegeben hat, als es die Verläufe im AR5 zeigen. Der Verdacht einer unzulässigen Glättung, vergleichbar der Hockeystick-Darstellung zur Temperatur drängt sich geradezu auf [11].

Die einzige mögliche Folgerung daraus ist:

Mit einer so widersprüchlichen bzw. ungenauen Datenbasis ist keine Zukunfts-Pegelsimulation auch nur im Ansatz glaubhaft kalibrierbar oder verifizierbar! Auch eine Aussage, ob die aktuelle Schwankung nicht doch natürlich sein kann ist nicht möglich. Was aktuell von der Klima-“Wissenschaft” an Zukunft simuliert wird, ist eher ein Würfelspiel welches nur auf immer teureren Rechnern durchgeführt wird.

Und damit ist es auch kein Wunder, dass “Jeder” beim Simulieren etwas Anderes ausgespuckt bekommt.

Bild 26 [23] Pegel-Zukunfts-Vermutungen zweier deutscher PIK Klimawissenschaftler und vom Rest der Welt

Es ist auch nicht möglich, durch Mitteln oder statistischen „Kunstgriffen“ daraus „den richtigen Verlauf“ zu erzeugen. Das Einsetzen leistungsfähigerer Computer kann an den Mängeln der Datenbasis nichts ändern, das falsche Ergebnis wird lediglich schneller ausgespuckt.

Was sagen Infoportale dazu

Wie „immer“ der Blick zu Klimaretter.Info, dem von Professoren(-innen) und Doktores betriebenem Portal für sicher AGW-klimatreue Information und Betreiber eines „Klima-Lügendetektors“. Auch dort wurde schon über die Pegelverläufe seit der letzten Eiszeit informiert. Zuletzt durch Publizierung einer Studie [16].

Klimaretter.Info, 15. Oktober 2014:

Meeresspiegel-Rekord in 6000 Jahren

6.000 Jahre lang hatte sich der Meeresspiegel kaum verändert, seit dem 20. Jahrhundert stieg er aber bis zu 20 Zentimeter an und hat damit ein historisches Hoch erreicht.

Die Forscher haben die Veränderungen des Meeresspiegels während und nach der letzten Eiszeit untersucht. Mithilfe von rund 1.000 Sedimentproben aus Australien und Asien konnten die Forscher die Entwicklung des Meeresspiegels der vergangenen 35.000 Jahre nachvollziehen und damit einen Zeitraum, der die vergangene Eiszeit miteinbezieht. Demnach ist der Meeresspiegel seit dem Schmelzen der Eisberge nach der Eiszeit konstant geblieben und erst innerhalb der vergangenen 100 bis 150 Jahre angestiegen – ein historischer Sonderfall.

Kimaretter.info hat diese Angaben bestimmt sorgfältig geprüft, wie es eben nur Professoren(-innen) können die im Rampenlicht des Klimawandels stehen und parallel noch das Wissen haben, Klimalügen sicher aufdecken und anprangern zu können.

Sehen wir zum Abschluss deshalb auch noch diese Studie [16] genauer an

Die Text-Statements der Studie [16] sind mit den darin gezeigten Bildern (Bild 27) nicht verifizierbar. So zeigt der kleine Bildausschnitt bei „A“ beim Nachsehen eine erhebliche Streuung, die bei „B“ vollkommen verschwunden ist.

Bild 27 [16] Bildauszug: Proxi mit Pegelverlauf seit Ende der letzten Eiszeit (gestrichelte rote Linien mit Kommentaren durch den Autor ergänzt)

Doch sind die verwendeten Proxis in einem Ergänzungsdokument gelistet. Im folgenden Bild 28 sind mit Normierung auf das Jahr 2.000 zwei Pegelproxis daraus und die Kurve der Malediven von Prof. Mörner übereinander gelegt:

– Malediven [16] (rot gestrichelt), Anm.: Die Spline-Funktion zwischen den roten Proxipunkten hat der Autor über Excel zugefügt und ist nicht statistisch belegt.

– Südaustralien [16] (hellbraun)

– Malediven [3] (grau), Studie Prof. A. Mörner

Man sieht deutlich:

Nimmt die Auflösung zu, zeigen sich auch in den Proxis dieser Studie[16] sowohl lang- wie auch kurzfristige, erhebliche Pegelschwankungen wie sie schon Prof Mörner (und andere Proxis) gezeigt haben.

Bild 28 Proxy Malediven aus Studie [16] rot gestrichelt, Proxi Port Piri Südaustralien aus Studie [16] hellbraun, Proxi Malediven [3] aus Bild 15 grau

Die Proxis aus der Studie [16]

In der Studie gibt es eing komplette Liste aller Proxidaten (in Summe 968 Werte).

Davon weisen z.B. die von Kiritimati (Christmas-Inseln) von 5.255 bis 0.090 trotz relativ hoher Auflösung nur eine Pegelspanne von -30 … +20 cm aus, absolut als 50 cm. Bild 15 listet für diesen pazifischen Raum dagegen eine Spanne von 1,2 m.

In der Regel stellen sich die Proxis in der Studie jedoch wie im Beispiel des folgenden Tabellenausschnitts dar (Bild 29). Die vier Zeitwerte dieses Proxis HAINAN liegen bei 912, 1119, 5059, 6835 Jahren, sind also weder fein auflösend noch gut verteilt. Doch innerhalb von 207 Jahren hat sich der Pegel plotzlich um 1,2 m!! verändert. Man beachte auch die Standardabweichung von

1 m. Zwei mal Standardabweichung (bedeutet ein Vertrauen von ca. 95 % wie es das IPCC gerne ausweist) bedeuten bei diesem Proxy eine Pegeldifferenz von +-2 m als Unsicherheit.

Bild 29 [16] Auszug der Proxitabelle S1 (data supplement) RSL: relative sea level, Sig.RSL stands for Sigma RSL, the estimated error of the observed relative Sea Level

Aufgrund dieser Datensichtung traut sich der Autor deshalb an einer (von Klimaretter.Info kritiklos übernommenen) Kernaussage der Studie erhebliche Zweifel anzumelden:

In der Studie steht:

[16] “… after which ocean volumes remained nearly constant until the renewed sea-level rise at 100–150 y ago, with no evidence of oscillations exceeding ∼15–20 cm in time intervals ≥200 y from 6 to 0.15 ka BP“

Das hat Klimaretter.Info natürlich wörtlich übernommen:

6.000 Jahre lang hatte sich der Meeresspiegel kaum verändert, seit dem 20. Jahrhundert stieg er aber bis zu 20 Zentimeter an und hat damit ein historisches Hoch erreicht.

Demnach ist der Meeresspiegel seit dem Schmelzen der Eisberge nach der Eiszeit konstant geblieben und erst innerhalb der vergangenen 100 bis 150 Jahre angestiegen – ein historischer Sonderfall.

Beim Betrachten der hinterlegten Daten sieht man jedoch, dass Proxis aus dieser Studie eher das Gegenteil aussagen. Man hat den Eindruck, das publizierte Ergebnis basierte mehr auf einem vorgegebenen Wunsch als auf den Fakten, Klimaretter.Info eingeschlossen.

Beispiel zur Problematik bei der rückwirkenden Ermittlung der wirklichen absoluten Pegel während des Holozän

In der Studie [4] steht, welche Unterschiede bereits im kleinräumigen Bereich der USA-Westküste bezüglich der Landhebungen während des Holozän bestehen. Der eine Pegel war früher bis zu 200 m höher während der andere in Noramerika 150 m tiefer lag.

[4] Sea-level history since the Last Glacial Maximum on the Pacific margin of North America is complex and heterogeneous owing to regional differences in crustal deformation (neotectonics), changes in global ocean volumes (eustasy) and the depression and rebound of the Earth’s crust in response to ice sheets on

land (isostasy). At the Last Glacial Maximum, the Cordilleran Ice Sheet depressed the crust over which it formed and created a raised forebulge along peripheral areas offshore. This, combined with different tectonic settings along the coast, resulted in divergent relative sea-level responses during the Holocene.

For example, sea level was up to 200 m higher than present in the lower Fraser Valley region of southwest British Columbia, due largely to isostatic depression. At the same time, sea level was 150 m lower than present in Haida Gwaii, on the northern coast of British Columbia, due to the combined effects of the forebulge raising the land and lower eustatic sea level.

Fazit

Die Aussagen des IPCC im AR5 zum Pegelverlauf im Holozän sind eher nicht richtig als richtig.

Es gibt oft zum gleichen Meeresgebiet vollkommen gegensätzliche Proxis. Heraus zu finden, welche die “Wahren” oder “Wahreren” sind, ist fast unmöglich (es zu versuchen, bzw auch Fehler in Studien zu zu korrigieren ist Inhalt vieler Nachfolge-Studien).

In verschiedenen Proxis finden sich im Gegensatz zur Angabe im AR5 sehr wohl auch höhere, kurzfristige Pegelschwankungen. Es ist daher eher unwahrscheinlich, dass die Aktuelle ausschließlich vom Menschen verursacht sein muss.

In den “offiziellen” Publikationen werden Proxis (und Studien) welche niedrige Schwankungen ausweisen anscheinend massiv bevorzugt. Das “muss” so sein, denn sonst ließe sich überhaupt nicht (mehr) argumentieren, dass damit Zukunftsprojektionen kalibriert werden könnten.

Es wird immer wahrscheinlicher, dass sich die AGW Klimawandel-orientierte „Wissenschaft“ verrannt hat und daraus nicht mehr herausfindet, weil das Ziel Beleg der politischen Vorgaben und weniger der Wahrheit ist. Es werden inzwischen zu Hunderten Studien produziert, die nicht Neues generieren, sondern versuchen durch „Zurechtbiegen“ ungeeigneter Daten das „Erforderliche“ zu belegen. Dass in den Studien selbst (wie auch im AR5) inzwischen immer mehr Referenzstudien gelistet werden (oft 100 St und mehr) ist kein Beweis besserer Qualität, sondern vom gegenseitigen Abschreiben der Mängel.

Dazu ist es auch so, dass die Wissenschaftler reihum neue Autorenteams zusammensetzen. Dadurch können die immer gleichen Wissenschaftler das ähnliche Ergebnis in weiteren Studien (mit-)helfen zu bestätigen, ohne dass es sehr auffällt. Denn in den Quellenhinweisen wird meistens nur der Leitautor angegeben.

Was wird vermittelt

Kaltesonne brachte es gerade auf den Punkt: “James Hansen drückt Klimaalarmpaper mit Gewalt durch. Gutachter: Hansens apokalyptische Vision ist so wahrscheinlich wie Millionen-Lotteriegewinn“ und bereits früher [8].

Doch das Portal Klimaretter.Info meldete es sofort als Bestätigung: 23. März 2016 „Bestätigt: Meeresspiegel steigt schneller“

und konnten diese Studie gar nicht genug loben.

Klimaretter.Info: Der US-Klimaforscher James Hansen und 18 Kollegen hatten schon im vergangenen Juli eine Untersuchung im Fachmagazin Atmospheric Chemistry and Physics veröffentlicht, die einen Meeresspiegelanstieg von mehreren Metern noch für dieses Jahrhundert prognostiziert – wenn die globalen Treibhausgasemissionen nicht drastisch zurückgefahren werden.

Dass diese Apokalypse des inzwischen zum Klimaaktivisten mutierten Herrn Hansen,

Klimaretter.Info: Seither hat er (Anm.: James Hansen) sich in der Klimabewegung engagiert und ist etwa Botschafter der Organisation 350.org. 2008 forderte Hansen, Manager von Öl- und Bergbaufirmen wegen "Hochverrats gegen Mensch und Natur" anzuklagen. Mehrfach wurde er bei Protestaktionen verhaftet.

wieder ausschließlich auf Simulations-Spielereien beruht und die angeneommenen Parameter – der Golfstrom schwächt sich ab und Grönland und Antarktis schmelzen noch wesentlich schneller als es sogar der IPCC annimmt – vollkommen unwahrscheinlich sind, wird nicht erwähnt.

Abschluss und Zusammenfassung

Mit dieser Publizerung ist die vom Autor über mehrere EIKE-Artikel verteilte Sichtung von Klimadaten und lang- bis kurzfristigen Pegeldaten abgeschlossen.

Alleine anhand der Sichtungen wurde gezeigt, auf welch fragwürdiger und teils gegensätzlicher Datenbasis wesentliche Aussagen der AGW-Theorie basieren und dass dies in der AGW-Wissenschaft (bisher) eher unterdrückt als kritisch beachtet wird.

Jeder Leser möge sich selbst ein Bild dazu machen. Der Autor kommt jedoch zu den folgenden Aussagen:

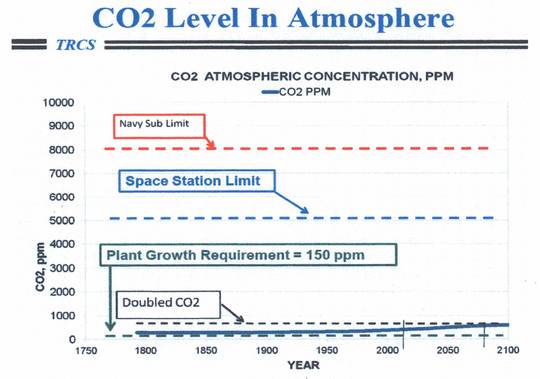

Der Meerespegel ist seit Beginn der Industrialisierung (seit ca. 1850) um ganze 25 cm gestiegen. Bei Betrachtung historischer Verläufe ist das keinesfalls „unnatürlich“. Womit die Begründung, dies könne ausschließlich vom Menschen verursacht sein stark bezweifelt werden darf.

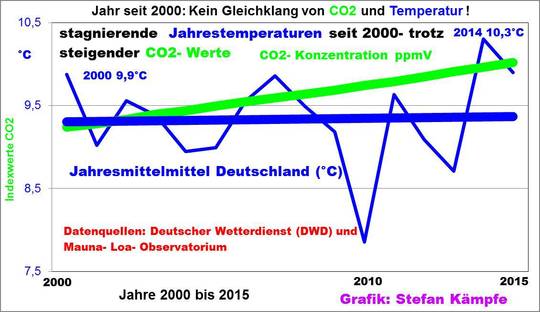

Weder im langfristigen, noch kurzfristigen historischen Verlauf lässt eine über längere Zeit bestehende Korrelation zwischen CO2 und Pegelverlauf erkennen. Damit sind alle Klimamodelle sehr fragwürdig.

Die Pegelrekonstruktionen und Varianten an Verläufen differieren so extrem, dass es nicht möglich ist mit solchen Daten Klimasimulationen zu kalibrieren oder zu verifizieren.

Wie stark der der Pegel bis 2100 wirklich steigen oder fallen wird, steht eher in den Sternen, als in Simulationsprogrammen. Der Autor weist nur darauf hin dass für Szenarien, welche einen exzessiven Anstieg vorhersagen keinerlei Begründungen – sondern nur Annahmen – vorliegen, während nach der Zyklik eher sogar eine Abschwächung möglich ist.

Quellen

[1]

PIK Pressemeldung vom 10.03.2016: Meeresspiegelanstieg: Zu groß zum Wegpumpen

https://www.pik-potsdam.de/aktuelles/pressemitteilungen/meeresspiegelanstieg-zu-gross-zum-wegpumpen

[2]

IPCC WG1 AR5 All Final 2013: Climate Change 2013 The Physical Science Basis

[3]

Nils-Axel Mörner: SETTING THE FRAMES OF EXPECTED FUTURE SEA LEVEL CHANGES BY EXPLORING PAST GEOLOGICAL SEA LEVEL RECORDS

[4]

Dan H. Shugar at al. 13. Juni 2014: Post-glacial sea-level change along the Pacifi c coast of North America

[6]

EIKE 14.12.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 3 Die Marshall-Inselgruppe – (kein) Beispiel für einen Untergang

http://www.eike-klima-energie.eu/news-cache/gehen-die-suedseeinseln-wirklich-wegen-des-klimawandels-unter-teil-3-die-marshall-inselgruppe-kein-beispiel-fuer-einen-untergang/

Teil 1 und 2 sind im Teil 3 verlinkt

[7]

RUTGERS TODAY February 22, 2016: Sea-level Rise in 20th Century Was Fastest in 3,000 Years, Rutgers-led Study Finds

Studie: Temperature-driven global sea-level variability in the Common Era

[8]

kaltesonne 30. Mai 2013: Europäisches Forschungskonsortium verwirft extreme Meeresspiegelprognosen

http://www.kaltesonne.de/?p=10644

Studie: From Ice to High Seas: Sea-level rise and European coastlines, The ice2sea Consortium, Cambridge, United Kingdom, (2013).

[9]

James Hansen et al, 22 March 2016: Ice melt, sea level rise and superstorms: evidence from paleoclimate data, climate modeling, and modern observations that 2 C global warming could be dangerous

James Hansen1,

[10]

kaltesonne, 14. März 2012: Der Meeresspiegel steigt! Seit 15.000 Jahren

Studie: Niedersächsisches Institut für historische Küstenforschung, Wilhelmshaven, 2004, Prof. Karl-Ernst Behre: Die Schwankungen des mittleren Tidehochwassers an der deutschen Nordseeküste in den letzten 3000 Jahren nach archäologischen Daten

[11]

EIKE 26.03.2016: Rekonstruierte Temperaturverläufe der vergangenen zwei Jahrtausende. Eine Literatursichtung von 1990 bis ganz aktuell

http://www.eike-klima-energie.eu/news-cache/rekonstruierte-temperaturverlaeufe-der-vergangenen-zwei-jahrtausende-eine-literatursichtung-von-1990-bis-ganz-aktuell/

[15]

Curr Clim Change Rep (12 November 2015) 1:247–262, Nicole S. Khan et al.: Holocene Relative Sea-Level Changes from Near-, Intermediate-,and Far-Field Locations

[16]

Kurt Lambeck et al., September 12, 2014: Sea level and global ice volumes from the Last Glacial Maximum to the Holocene

Ergänzungsdokument: Supporting Information

[17]

PIC 2007, Wilfried Endlicher, Friedlich-Wilhelm Gerstengrabe: Der Klimawandel

[18]

GeoForschungsZentrum Potsdam 2005, Dissertation: Glaziale Isostasie und rezente Meeresspiegeländerung

[19]

15.07.2014, Rashid, R. at al.: Constraining mid to late Holocene relative sea level change in the southern equatorial Pacific Ocean relative to the Society Islands, French Polynesia, Geochem. Geophys.

[20]

Instituto de Geociências, Universidade de São Paulo, Kenitiro Suguio at al., 16 September 2013: Indicators of Holocene sea level changes along the coast of the states of Pernambuco and Paraíba, Brazil

[21]

GeoForschungsZentrum Potsdam,Scientific, Technical Report STR 07/05, Ingo Sasgen et al.: Glacial-isostatic adju stment and sea-level change near Berkner Island, A ntarctica

[22]

ScepticalScience: Sind wir auf dem Weg zu einer neuen kleinen Eiszeit?

[23]

PIC 2007, Wilfried Endlicher, Friedlich-Wilhelm Gerstengrabe: Der Klimawandel

[25]

Universität Bremen Geowissenschaften, Diss.: Modeling oxygen isotopes in ice sheets linked to Quarternary ice-volumen variations

[26]

Kemp et al., 2011: Climate related sea-level variations over the past two millennia

http://www.pnas.org/content/108/27/11017.full

[27]

Aslak Grinsted at al.: Comment on the subsidence adjustment applied to the Kemp et al. proxy of North Carolina relative sea level