Es wird kräftig Alarm geschlagen: Klimaexperten glauben zu sehen, wie die Eismassen in der Antarktis unter den Füßen der Pinguine dahinschmelzen und Eisbären aussterben, weil sie keine Eisschollen mehr finden. Höhere Lufttemperaturen und wärmeres Wasser würden das Eis deutlich schneller abschmelzen lassen als die Klimaforscher erwartet hätten. Die Lage sei bereits jetzt so dramatisch, dass nicht einmal mehr die Beschlüsse der Pariser Klimakonferenz helfen würden. Das Meer werde immer noch gefährlich schnell ansteigen, selbst ohne weiteren Anstieg der Treibhausgase. Da lohnt ein Gespräch mit dem Physiker Prof. Dr. Horst-Joachim Lüdecke (i.R.). Er untersuchte die Rolle des CO2, sah sich alle vorhandenen Daten genau an und ist Mitautor von zahlreichen begutachteten Veröffentlichungen in wissenschaftlichen Klima-Fachzeitschriften.

Holger Douglas: Zuerst die Frage nach Knuddelbär Knuts Brüdern: Sterben sie durch unsere CO2-Emissionen aus?

Horst-Joachim Lüdecke: Nein, keine Spur davon. Eisbärpopulationen wuchsen die letzten Jahre stetig an, denn Knuts Kumpels werden nicht weniger gejagt als früher. Eisbären sind gefährliche Raubtiere und keine Knuddelbären. Sie gibt es schon viele Hunderttausende Jahre. Auch beispielsweise vor ca. 120.000 Jahren als eine globale Warmzeit und bei uns subtropische Temperaturen herrschten. Generell gilt: Alle Tiere passen sich erstaunlich schnell an neue Umweltbedingungen an, auch Eisbären.

Holger Douglas: Lassen Sie uns kurz auf den Treibhauseffekt eingehen: Kommt er dadurch zustande, dass UV-Strahlung der Sonne beim Durchgang durch das Glas eines Treibhauses in Wärmestrahlung umgewandelt wird? Wie funktioniert das in der Atmosphäre?

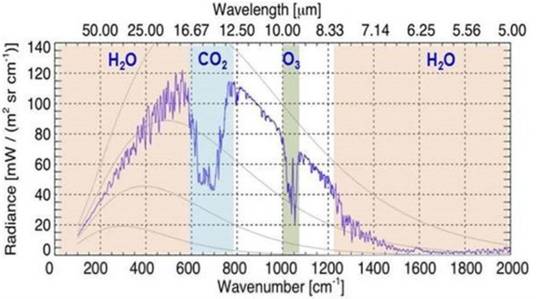

Horst-Joachim Lüdecke: Es ist recht einfach: Die kurzwellige Strahlung der Sonne durchdringt ungehindert die Luft unserer Atmosphäre. Sie wird vom Erdboden aufgenommen, der sich infolge dieser Energiezufuhr erwärmt. Durch Kontakt mit dem Erdboden erwärmt sich schließlich die Luft. Zusätzlich strahlt der Boden Infrarot ab, wie jeder warme Körper.

Diese vom Boden ausgehende infrarote Strahlung wird von den Treibhausgasen – im wesentlichen Wasserdampf, danach CO2, Methan usw. – absorbiert und als so genannte Gegenstrahlung wieder zum Boden zurückgestrahlt. Dies führt dem Boden weitere Energie zu, was seine Erwärmung erhöht. Messungen der Gegenstrahlung sind heute Standard.

In der Atmosphäre kommen noch zahlreiche weitere Effekte hinzu wie z.B. die Konvektion. Vor allem die Wolken spielen für die Temperaturentwicklung eine entscheidende Rolle. Aber das geht über den Treibhausstrahlungseffekt hinaus und ist eine andere Geschichte.

Auch beim Gärtner-Treibhaus geht die kurzwellige Sonnenstrahlung ungehindert durch das Glasdach hindurch. Völlig verschieden vom atmosphärischen Treibhauseffekt ist dagegen, dass die vom Boden erwärmte Luft durch das Glasdach des Gärtnertreibhauses nicht entweichen kann und sich dadurch weiter aufwärmt.

Holger Douglas: Ist das grundsätzlich dasselbe wie in einer kalten, klaren, wolkenlosen Nacht, in der die Erde stark auskühlt, während ansonsten eine Wolkendecke wie ein Wärmekissen wirkt?

Horst-Joachim Lüdecke: So ist es. Man erfährt dies, wenn man sein Auto bei Frost unter einem Baum mit Blättern abstellt oder 50 Meter weiter unter klarem Himmel: Bei freier Sicht zum Himmel bildet sich Eis auf den Scheiben, unter dem Baum nicht. Hier hilft die Gegenstrahlung der Blätter gegen die zu schnelle Abkühlung der Autoscheiben. Es ist eindeutig ein Strahlungseffekt, denn die Temperatur der leicht bewegten Luft ist in beiden Fällen gleich.

Holger Douglas: Jetzt gibt es die Diskussion: Wie viel Strahlung geht weg in den Weltraum? Dafür müsste man eigentlich wissen, was die Wolken machen?

Horst-Joachim Lüdecke: Den reinen Strahlungseffekt kann man theoretisch mit gewissen Unsicherheiten zuverlässig berechnen. Da ist die maßgebende Größe die sogenannte Klimasensitivität als die zusätzliche globale Erwärmung, wenn sich das CO2, das uns ja so sehr interessiert, verdoppeln würde.

Aber das ist noch nicht alles. Es kommen noch Sekundäreffekte hinzu, bei denen die Wolken eine Schlüsselrolle zu spielen scheinen. Wolken wirken zweifach. Tiefliegende Wolken kühlen, sie absorbieren die Sonnenstrahlen. Sehr hoch liegende Wolken machen das Gegenteil.

Diesen Erwärmungs– oder Abkühlungseffekt durch Wolken kann man theoretisch noch nicht berücksichtigen. Es gibt zwei Denkschienen: Die eine sagt, wenn es durch zunehmendes CO2 wärmer wird, dann wird insbesondere um den Tropengürtel herum mehr Wasser verdampft. Wasserdampf ist ein sehr starkes Treibhausgas, also verstärkt sich der Erwärmungseffekt. Man nennt so etwas Rückkopplung; die Erwärmung wird dadurch stärker als durch die reine Strahlenwirkung.

Die andere Denkschiene sagt: Das Gegenteil ist richtig! Mehr Wasserdampf in der Luft führt zu mehr Wolken. Das kühlt ab.

Also: Was ist wahr? Dazu gibt es eine Reihe von wissenschaftlichen Veröffentlichungen, die an Hand von Messungen belegen, dass der Abkühlungseffekt bei weitem überwiegt. Messungen sind immer noch maßgebend, insbesondere in der Klimaforschung wird dies leider oft übersehen.

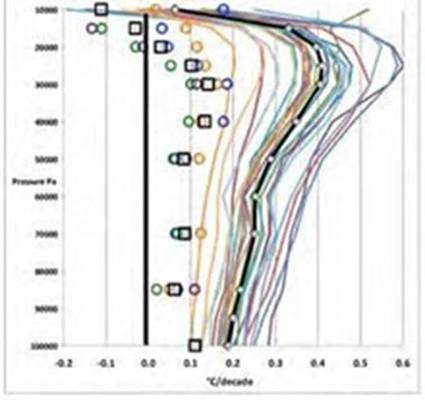

Die Theorie, die von einer Rückkopplung spricht, ist dagegen nicht durch Messungen belegt. Nach ihr müsste es nämlich über den Tropen in fünf bis sieben Kilometer Höhe eine deutlich messbare Erwärmungszone geben, der unter dem Begriff Hot Spot läuft. Den findet man aber nicht. Es spricht daher alles dafür, dass der reine Strahlungseffekt abgeschwächt und nicht etwa noch verstärkt wird.

Holger Douglas: Erstaunlich, welch kompliziertes Wechselspiel sich im Laufe der Erdgeschichte herausgebildet hat. Und jetzt plötzlich soll der Mensch alles verändern?

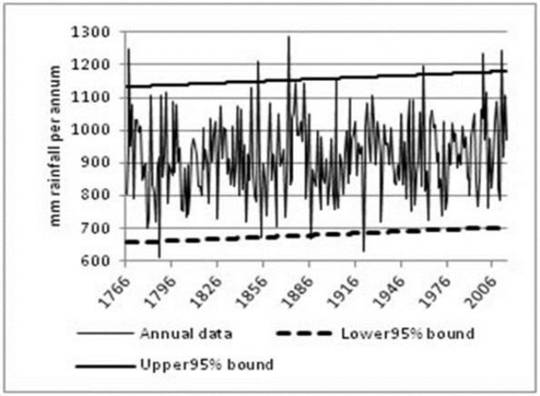

Horst-Joachim Lüdecke: Das ist tatsächlich sehr unwahrscheinlich. Den Einfluss des Menschen kann man aus dem Klimarauschen bis heute nicht heraushören. Was wir seit ungefähr 1750, also seit Beginn der Industrialisierung, an Klimaschwankungen erlebt haben, liegt meilenweitweit innerhalb des natürlichen Schwankungsbereichs des Klimas, wie wir ihn aus den Zeiten davor kennen. Vor der Industrialisierung gab es weit heftigere Klimaausschläge als danach.

Es gibt nicht die geringste wissenschaftliche Berechtigung zu behaupten: Hier sehen wir ungewöhnliche Klimaentwicklungen, die eigentlich nur vom Menschen kommen können. Nicht zuletzt belegen dies sogar der Weltklimarat (IPCC) und jedes meteorologische Lehrbuch: Es ist keine Zunahme von Extremwetterereignissen in den letzten 150 Jahren feststellbar. Ich darf kurz anmerken, dass Wetter und Klima nicht identisch sind. Klima ist der mindestens 30-jährige Durchschnittswert von Wetter.

Holger Douglas: Die Temperaturänderungen der Vergangenheit in 100 Jahreszeiträumen konnten Sie in einer wissenschaftlichen Fachveröffentlichung mit einfachen Sinuskurven wiedergeben und haben dabei erstaunlich gleichmäßige Schwankungen festgestellt?

Horst-Joachim Lüdecke: Sie sprechen jetzt Klimazyklen an. Man kennt eine ganze Reihe dieser Zyklen und vermutet, dass sie von der Sonne gesteuert werden. Stellvertretend nenne ich die Atlantische Multidekaden-Oszillation (AMO) mit einer Zykluslänge von etwa 65 Jahren, den De Vries / Suess -Zyklus von etwa 200 Jahren und den Dansgaard-Oeschger Zyklus von etwa 1500 Jahren. Solche Zyklen sieht man in fast allen guten Proxydaten.

Kurz zu Proxydaten: Es sind indirekt ermittelte Klimawerte der Vergangenheit, als es noch keine direkten Messungen gab, wie z.B. Temperaturen oder Niederschläge. Man gewinnt sie aus Analysen von Baumringen, Stalagmiten, Eisbohrkernen, Sedimenten, Pollen usw.

Man findet nun Korrelationen von Sonnenfleckenzahlen mit der Häufigkeit der Isotope Kohlenstoff 14 und Beryllium 10, aber auch mit Klimazyklen. Ein Zusammenhang dieser Daten liegt sehr nahe, aber man kennt bis heute nicht die Mechanismen, die einen solchen Zusammenhang erklären können.

Wir haben in unserem Fachaufsatz den De Vries / Suess-Zyklus näher untersucht, der für uns heute wohl am interessantesten ist. Er hat nämlich eine Periode von rund 200 Jahren, und dieser Zeitraum interessiert uns ja gerade. Es ist etwa der Zeitraum von Beginn der Industrialisierung bis heute.

Aus der guten Übereinstimmung des De Vries / Suess Zyklus mit der Temperaturentwicklung bis zurück zum Jahre 0 n.Chr. und sogar weiter in die Vergangenheit folgern wir, dass dieser Zyklus nicht plötzlich aufhört, sondern auch zukünftig fortbesteht. Wenn man ihn theoretisch weiterführt, müsste es eigentlich bald wieder kühler werden.

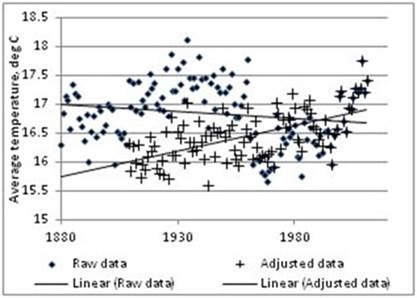

Bis jetzt sehen wir von einem deutlichen globalen Abkühlen allerdings noch nichts. Seit 18-20 Jahren herrscht aber immerhin bereits Stillstand in der globalweiten Temperaturentwicklung. Dies ist ein bemerkenswerter Widerspruch zur Erwärmungswirkung des zunehmenden menschgemachten CO2 und wird für den Klima-Alarmismus immer bedrohlicher. Es wird jetzt spannend, wie es in den nächsten 10, 20 Jahren mit den Temperaturen weitergeht.

Holger Douglas: Scheint dieser jüngste Temperaturstillstand nicht doch auf eine leichte Abkühlung hinzudeuten?

Horst-Joachim Lüdecke: Nein. Wir haben zur Zeit einfach einen Stillstand, mehr nicht. Man muss sich nur die Satellitendaten anschauen, die am zuverlässigsten sind. Man sieht dann, dass sich die Südhemisphäre abkühlt, die Nordhemisphäre in etwa gleich bleibt und sich die Arktis als einzige Erdzone wirklich erwärmt. Im globalen Durchschnitt bleibt es seit ca. 18 Jahren unverändert.

Holger Douglas: Wie genau und zuverlässig sind denn die von Ihnen genannten Proxydaten? Es bestehen sicherlich kaum Probleme, 1 bis 2000 Jahre zurückzugehen und die Temperaturentwicklung relativ präzise zu messen. Aber die Erde ist viereinhalb Milliarden Jahre alt; je weiter wir zurückgehen, desto ungenauer werden die Daten. Wie verlässlich sind diese Zyklen-Vorstellungen?

Horst-Joachim Lüdecke: Es hängt von den Zeitlängen ab: Uns interessiert im Zusammenhang der globalen Erwärmung, die gemäß Meinung der Klima-Alarmisten in den letzten 200 Jahren vom Menschen verursacht sein soll, allerhöchstens die letzten 10.000 Jahre. Vor mehr als 350 Jahren haben wir nur Proxydaten, also indirekte Messwerte. Direkt gemessen wird frühestens seit Mitte des 17. Jahrhunderts.

Alle Proxydaten haben ihre Fehler und Nachteile, je länger zurück desto stärker. Baumringe und Stalagmiten zum Beispiel sind keine reinen Proxies für Temperaturen, sondern auch für Niederschläge. Baumringe geben naturgemäß nur die Sommertemperaturen wieder. Eisbohrkerne haben zwar auch ihre Probleme, sind aber wohl am verlässlichsten, wie man es aus dem Vergleich mit Proxies aus Sedimenten weiß.

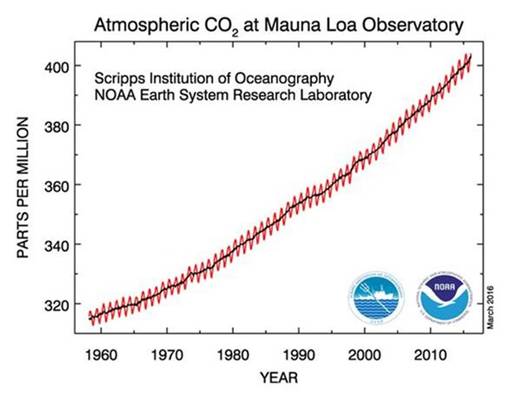

Die berühmte Eisbohrkern-Kurve der russischen Antarktis-Station Vostok über die letzten 400.000 Jahre, die Temperaturen und den CO2 Gehalt der Arktis nachbildet, ist beispielsweise sehr zuverlässig. Die CO2 Werte haben in diesem Zeitraum übrigens trotz enormer Temperaturschwankungen nur verhältnismäßig wenig geschwankt. Der CO2 Anstieg der letzten 150 Jahre ist daher ohne jeden Zweifel menschgemacht.

Wenn man natürlich noch weiter zurückgeht, dann wird es ungenauer. Aber man hat immer noch eine recht gute Vorstellung bis 500 Millionen Jahre vor unserer Zeit. Es ist heute bekannt, was damals passiert ist. Der CO2-Gehalt war früher regelmäßig höher als heute. Und die Erde erlebte Warmzeiten mit eisfreien Polkappen, aber auch Kaltzeiten, in denen sie eine Eiskugel (Snowball) war.

Vielleicht ist es in diesem Zusammenhang noch erwähnenswert, dass wir in einem Eiszeitalter leben (nicht in einer Eiszeit). Ein Eiszeitalter ist durch die gleichzeitige Vereisung beider Erdpole gekennzeichnet.

Holger Douglas: Die CO2-Konzentration der Erdatmosphäre ging teilweise bis zu 6000 ppm hoch.

Horst-Joachim Lüdecke: Ja, bis zum 15-fachen von heute – ganz grob natürlich. Es gab aber auch einmal einen Zeitpunkt vor etwa 300 Millionen Jahren als der CO2 Gehalt etwa so niedrig wie heute war. Aber wie schon gesagt sonst war er stets höher.

Was jetzt sehr wichtig ist: Es gibt keine Korrelation zwischen Temperatur und CO2-Gehalt. Es gab die Erde schon einmal total vereist mit sehr hohen CO2-Werten vor etwa 450 Millionen Jahren. Umgekehrt gab es kleine CO2-Werte bei wesentlich höheren Temperaturen als heute vor etwa 90 Millionen Jahren.

Holger Douglas: Also kein Zusammenhang zwischen CO2 und Temperaturen?

Horst-Joachim Lüdecke: Nein, der ist nicht zu sehen.

Holger Douglas: CO2 ist ein Spurengas und daher nur in sehr geringen Mengen in der Atmosphäre vorhanden. Hat es überhaupt eine wichtige Wirkung?

Horst-Joachim Lüdecke: Es stimmt, CO2 ist nur ein Spurengas, selbst das Edelgas Argon ist häufiger. Zur Zeit befinden sich 0,04 Volumenprozente CO2 in der Luft. Vor der Industrialisierung waren es etwa 0,028 Volumenprozent. Diese Differenz ist vom Menschen verursacht.

CO2 ist freilich trotz seiner geringen Konzentration als Hauptbestandteil der Photosynthese lebensnotwendig. Ohne CO2 würden wir alle nicht existieren, es gäbe keine Pflanzen oder Tiere, es gäbe nichts, was man als Leben bezeichnen könnte.

Holger Douglas: Man müsste dann doch einen Zusammenhang zwischen dem Wachstum der Pflanzen und dem CO2 Gehalt sehen oder nicht? Je mehr CO2 Gehalt – desto stärker das Wachstum der Pflanzen?

Horst-Joachim Lüdecke: Ja, so ist es. Hierzu gibt es viele wissenschaftliche Untersuchungen, zum Beispiel Messungen an Nahrungspflanzen von Reis über Weizen bis hin zu Sojabohnen. Der Zusammenhang ist eindeutig. Je mehr CO2, umso stärker der Pflanzenwuchs.

Das weiß man heute auch aus Satellitenmessungen: Die Erde ist inzwischen grüner als noch vor 50 oder 100 Jahren. Es stand sogar schon einmal im Spiegel: "die Sahara wird grüner".

Die Ernten haben weltweit auch durch das vom Menschen gemachte CO2 zugenommen. Das ist ein positiver Effekt. Negative Effekte des zunehmenden CO2 sind nicht bekannt.

Holger Douglas: Weiß das schließlich nicht auch der Gärtner, der in seinem Gewächshaus den CO2 Gehalt erhöht, teilweise bis auf 1500 ppm?

Horst-Joachim Lüdecke: Ja, die Blumen- und Tomatenzüchter machen das. Die blasen CO2 ins Gewächshaus rein. Der Effekt ist diesen Züchtern bestens bekannt.

Holger Douglas: Noch einmal kurz zurück zu der Diskussion über das menschengemachte CO2. Früher sind in der Erdgeschichte zum Beispiel große Waldgebiete abgebrannt, das tun sie auch heute noch, es gab heftige Vulkanausbrüche. Die Erde ist nicht der ruhige Planet, auf dem wir friedlich sitzen, sondern unter uns brodelt und zischt es, Vulkane speien große Mengen an giftigen Gasen und Substanzen hinaus. Woher kann man genau sagen, dass der Mensch den CO2-Gehalt erhöht hat und nicht die Natur selber? Wie zum Beispiel 1815 der gewaltige Ausbruch des Vulkans Tambora in der Südsee, der der Erde ein Jahr ohne Sommer beschert hat?

Horst-Joachim Lüdecke: Nicht nur Gase aus Vulkanen werden heute sehr gut vermessen, man hat daher ein recht genaues Bild der Verhältnisse im Allgemeinen. Das IPCC hat in seinem letzten Bericht AR5 eine schöne Abbildung zu den CO2 Senken und Quellen publiziert. Zu den Zahlenwerten gibt es zwar Unsicherheiten, aber keine der Art, dass ganz andere CO2 Quellen und Senken als die heute bekannten möglich wären.

So gibt es das vom IPCC unabhängige internationale Carbon Dioxide Information Analysis Center (CDIAC), das alle einschlägigen Daten zum CO2 Kreislauf zusammenträgt. Die Ergebnisse sind eindeutig. Wir haben beim CO2-Kreislauf einen gewaltigen Austausch zwischen Ozean und Atmosphäre und zwischen Atmosphäre und der Biosphäre. Da gehen ungefähr pro Jahr jeweils etwa 100 Gigatonnen Kohlenstoff hin und her. Der menschliche Anteil ist dagegen relativ klein: Es sind ungefähr nur zehn Gigatonnen, die der Mensch zum jetzigen Zeitpunkt jährlich in die Luft bläst.

Das, was jetzt an CO2 im Vergleich zu vor 150, 200 Jahren zusätzlich in der Atmosphäre ist, stammt vom industrialisierten Menschen. Alle Messungen sind hier stimmig. Das menschengemachte CO2 verschiebt langsam den CO2-Kreislauf in einen anderen Zustand hinein, der aber keineswegs bedenklich ist – ganz im Gegenteil.

Es passiert nämlich Folgendes: Das Meer hat einen extrem höheren CO2-Inhalt als die Atmosphäre daher bleibt seine CO2-Abgabekraft auch bei etwas CO2-Zufuhr immer noch praktisch unverändert. Technisch ausgedrückt, bleibt der CO2-Partialdruck des Meeres konstant. Wenn das CO2 der Atmosphäre zunimmt, steigt dagegen sein Partialdruck an. Die hier durch den Menschen über die Jahre eingebrachten Mengen an CO2 sind im Gegensatz zum Meer wirksam. Damit wird die Partialdruckdifferenz von der Atmosphäre zum Meer größer, und es wird immer mehr CO2 ins Meer gedrückt.

Heute geht beispielsweise schon die Hälfte des vom Menschen durch Industrie, Landwirtschaft, Rodung und Zementproduktion erzeugte CO2 ins Meer und zu gleichen Teilen in das Pflanzenwachstum.

Unmittelbar zu Beginn der Industrialisierung war dieser Anteil null. Wenn der CO2 Gehalt weiter steigt, geht immer mehr ins Meer und die Biosphäre, immer weniger verbleibt in der Atmosphäre. Der atmosphärische CO2-Gehalt kann daher ein bestimmtes Maß nicht überschreiten.

Nach unserer Fachveröffentlichung wird es sich so bei maximal 800-850 ppm einpendeln. Dieser Wert ist vermutlich sogar zu hoch, denn er besiert auf der hypotetischen Annahme, dass mehr als das Doppelte der geschätzten Weltressourcen an Kohle verbrannt wurde.

Holger Douglas: Kann man das, was Sie schildern, als Sättigungsgrenze der Atmosphäre für CO2 bezeichnen?

Horst-Joachim Lüdecke: Ja, das kann man. Es gibt eine Sättigungsgrenze. Das atmosphärische CO2 kann man anschaulich als gespannte Feder sehen: Je stärker die CO2-Konzentration der Luft, umso mehr drückt die Federkraft CO2 ins Meer hinein.

Holger Douglas: Wird das Meer durch das eingeführt CO2 nicht sauer? Und sterben durch diese Versauerung nicht die Korallen?

Horst-Joachim Lüdecke: Nein, Meeresversauerung ist ein weiterer Mythos der Alarmisten. Jeder Chemiker, dem Sie etwas von Meeresversauerung durch zunehmendes atmosphärisches CO2 erzählen, wird schmunzeln. Das Meer ist basisch, hier müsste schon mehr als der vernachlässigbare menschgemachte CO2-Eintrag passieren, bis es sauer wird. Das eingehende CO2 wird zudem nicht nur im Meerwasser gelöst, sondern geht in die Algenproduktion, die Kalkschalenbildung von Meerestieren und langfristig in die Carbonatgesteinsbildung.

Im Meer gibt noch viele unverstandene Effekte. Man weiß z.B. nicht, wieviel Biomasse von der Meeresoberfläche zum Meeresboden sinkt, wieviel karbonisiert wird usw. Theoretisch und durch Labormessungen versteht man zum Beispiel den Revelle Effekt sehr gut. Der besagt, dass bei zunehmendem CO2 Gehalt der Luft die Aufnahmefähigkeit des Meeres für CO2 abnimmt. In den globalweiten Messungen des Verhältnisses von CO2 der Luft gegenüber dem im Meer verschwindenden Anteil zeigt sich der Revelle Effekt bis heute aber gar nicht.

Auch die angebliche Empfindlichkeit von Korallen gegen mehr CO2 im Meerwasser ist ein alarmistischer Mythos. Zahlreiche wissenschaftliche Untersuchungen haben gezeigt, dass sich die Korallen schnell anpassen und ihnen höhere CO2-Konzentrationen bestens bekommen. Die Anpassungfähigkeit von Pflanzen und Tieren an veränderte Umgebungsbedingungen ist fast grenzenlos.

Holger Douglas: Schwanken nicht die Verhältnisse sehr stark, die den CO2 Kreislauf bestimmen? Und verändert sich nicht auch die CO2-Aufnahmefähigkeit des Meeres bei sich ändernden Wassertemperaturen?

Horst-Joachim Lüdecke: Kurzfristig schwankt der CO2-Fluss von Atmosphäre ins Meer und den Pflanzenwuchs tatsächlich stark, was nicht nur durch die Jahreszeiten bedingt ist. Auch die schwankende Temperatur des Meerwassers spielt eine Rolle. Wenn das Wasser kühl ist, nimmt es mehr CO2 auf, wenn es wärmer ist, weniger – ein übertriebener Vergleich wäre eine Sprudelflasche. Man konnte dies gut im Jahre 1998 erkennen, als ein besonders starker El Nino die Meerestemperaturen stark durcheinander brachte. Längerfristig sind die CO2 Flüsse aber glatt und ruhig.

Holger Douglas: Wie hoch ist denn der Einfluss der veränderten Wassertemperaturen auf den CO2 Zyklus?

Horst-Joachim Lüdecke: Wenn man sich die berühmte Vostokdaten von Temperatur und CO2-Gehalt über die letzten 400.000 Jahre anschaut, sieht man, dass beide genau übereinander liegen. Sie sind extrem gut korreliert. Dies erscheint zunächst als ein Widerspruch zu meiner vorherigen Aussage, es gäbe keine Korrelation zwischen CO2 und Temperaturen.

Wissenschaftliche Arbeiten haben die Vostok-Daten genauer untersucht und dabei festgestellt: Das CO2 hinkt grob 800 Jahre der Temperatur der Atmosphäre und damit des Meeres hinterher. Wenn es wärmer wird, dann wird mehr CO2 vom Meer ausgegast. Wenn es kälter wird, dann geht mehr CO2 ins Wasser.

Die Meere benötigen, um sich zu durchmischen, so ungefähr 1000 Jahre. Dies erklärt das CO2 Nachhinken. Anfänglich, als dieser Zusammenhang noch nicht bekannt war, wurde von den Klimaalarmisten sogar gejubelt, CO2 sei generell der Grund für jede Schwankung der mittleren Erdtemperatur. Tatsächlich ist es genau umgekehrt. Abgesehen von diesem gut bekannten Effekt der CO2 Ausgasung aus dem Meer ist keine Korrelation zwischen CO2 und Erdtemperatur bekannt.

Holger Douglas: Kommen wir noch einmal zu dem Kohlenstoff. In Deutschland geht das Wort von der Decarbonisierung um, es müsste eigentlich zum Unwort des Jahres erklärt werden. Dabei ist Kohlenstoff für uns eines der wichtigsten Elemente.

Horst-Joachim Lüdecke: Die organische Chemie ist Kohlenstoffchemie. Mit Dekarbonisierung ist nun Einsparung von CO2-Emissionen zum Schutz des Klimas gemeint. Das ist aber grober Unsinn. Man kann das Klima, das sich unablässig ändert, nicht schützen. Dazu müsste man mit dem Schutz des Wetters anfangen! Noch nie gab es konstantes Klima, so etwas wird es auch nie geben. Fortwährende Klimaänderung ist praktisch ein Naturgesetz. Die alarmistische Hypothese besagt aber, dass CO2 klimaschädlich sei und stark klimaerwärmend wirke. Dafür gibt es keine Belege.

Nur mit entsprechenden Klimamodellen kann man das hinbekommen. In die Modelle steckt man geeignete Voraussetzungen hinein wie zum Beispiel die von mir schon erwähnten Rückkopplungseffekte. Ob diese Effekte eine verlässliche Messbasis haben, interessiert die Modellierer nicht.

Dann bekommt man beliebig hohe Temperatursteigerungen heraus. Nur haben diese Modelle bisher noch nie die Klimavergangenheit wiedergeben können. Klimamodelle stimmen einfach nicht, sie sind falsch; das lässt die Klimaalarmisten erstaunlich ungerührt.

Mojib Latif, einer der bekanntesten Klimamodellierer in Deutschland, hat in einem Spiegel-Interview gefaselt, wir würden keine Winter mehr mit Schnee haben.

Auch ein solcher sachlich bodenloser Unsinn hält die Alarmisten und leider auch die deutschen Medien in ihren Aussagen nicht auf. Insbesondere die Medien geben nur den Alarmisten Gelegenheiten ihre befremdlichen Wahnvorstellungen dem Publikum in Fernsehen und Radio anzudienen. Seriöse Fachkritiker kommen nicht zu Wort.

Wenn es mit dem fehlenden Schnee nicht klappt, wird eben die nächste Sau durch Dorf getrieben, zum Beispiel die hier schon besprochene Meeresversauerung durch CO2.

Real betrachtet ist Decarbonisierung allein schon deswegen absurd, weil unser deutscher CO2 Beitrag verschwindend gering ist. Selbst wenn wir in Deutschland auf sämtliche CO2-Emissionen verzichten würden, wieder in Fellen herumlaufen würden und unser Nahrungsfleisch mit Pfeil und Bogen schießen würden, würde das an der CO2 Bilanz der Welt nichts ändern.

China, Indien, Brasilien und die USA produzieren so gut wie alles menschgemachte CO2. Wenn man die von der GroKo geplanten deutschen CO2 Emissionseinsparungen auch unter Annahme übertriebener Erwärmungsszenarien in Temperaturen umrechnet, kommt man in den nächsten 20 Jahren auf ein paar tausendstel Grad globaler Erwärmung weniger.

Es ist also sachlich völlig idiotisch, was wir da machen. Hier wird offensichtlich von politischen Schaumschlägern eine politische Vorbildfunktion angestrebt. Wir sollten uns überlegen, ob dies sinnvoll ist. Eine deutsche Vorbildfunktion gab es ja schon einmal, mit katastrophalem Erfolg.

Holger Douglas: Der Kohlenstoff ist das wesentliche Element im atmosphärischen Lebenskreislauf. Aus Kohlenstoff bestehen wir, aus dem wird alles andere in der organischen Welt zusammengestellt. CO2 benötigen die grünen Pflanzen als Baustoff. Doch das soll jetzt das schädliche Klimagas sein, das die Erde zerstören, die Meere ansteigen lassen soll?

Horst-Joachim Lüdecke: CO2 Vermeidung ist eine rein politische Agenda und hat mit sachgerechtem Handeln nichts zu tun. Es gibt sogar Aktionen wie CO2 freie Städte, die als Gipfel der Hirnrissigkeit gelten dürfen. In meiner Heimatstadt Heidelberg gab es sogar Ideenwettbewerbe zu CO2-Einsparungen für Kinder. Hier klingt bereits etwas an, das der Instrumentalisierung von unschuldigen Kindern für ideologische Ziele in der ehemaligen DDR entspricht.

Holger Douglas: Eine Gefahr scheint es aber doch zu geben, die Erhöhung der Meeresspiegel. Hat das Abschmelzen der Gletscher damit etwas zu tun?

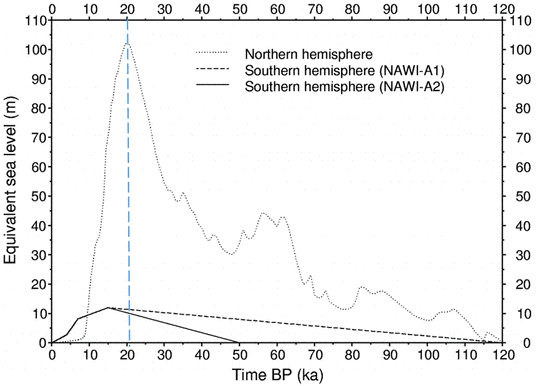

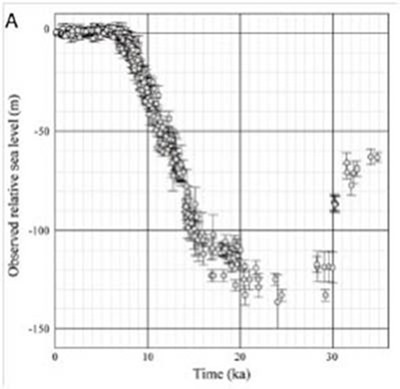

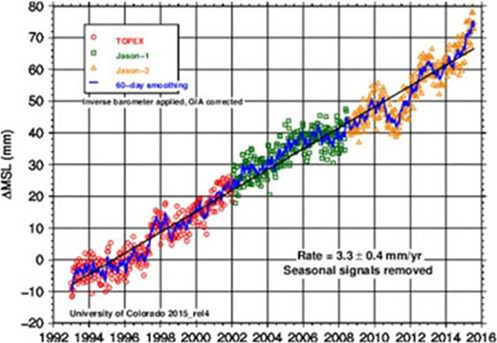

Horst-Joachim Lüdecke: Seit Ende der letzten Eiszeit etwa vor 12.000 Jahren hat sich der Meeresspiegel um etwa 130 Meter erhöht. Heute ist davon nur ein Anstieg von 1 – 3 mm pro Jahr übrig geblieben. Was die genaue Ursache für den aktuellen Anstieg ist, weiß man nicht. Immerhin scheint das Abtauen des grönländischen Festlandgletschers so um die 20% zu diesem Anstieg von 1 – 3 mm beizutragen.

Zur Gletscherschmelze: Von einer allgemeinen globalen Gletscherschmelze zu sprechen ist unzutreffend. In Teilen der Welt schmelzen die Gletscher wie zum Beispiel in den Alpen und in Grönland. In anderen Teilen nehmen sie dagegen zu wie z.B. in der Antarktis. Die Alpengletscher schmelzen bereits seit Mitte des 19. Jahrhunderts, als es praktisch noch kein menschgemachtes CO2 gab.

Ferner muss man Eisschmelzen sorgsam auseinander halten: Oft wird nur vom Meereis gesprochen. Das ist das Eis, das sich im Winter auf dem Meer bildet, und das im Sommer wieder verschwindet. Meistens ist es nur eine Bedeckung von wenigen Zentimetern bis hin zu Mini-Eisbergen von wenigen Metren Höhe.

Die Bedeckung mit Meereis wird heute mit Satelliten sehr genau gemessen. Täglich werden diese Messdaten aktualisiert und frei im Internet veröffentlicht. Und da zeigt sich der bekannte Jahreszyklus. Im Sommer haben wir ein Minimum an Eisbedeckung, im Winter ein Maximum. Die Medienmeldung ›der Nordpol schmilzt!‹ kommt regelmäßig, wenn im Spätsommer das Minimum erreicht ist. Das hat mit Klimaänderungen überhaupt nichts zu tun.

So gab es Anfang des 20. Jahrhunderts schon einmal die Wetterlage eines so weit zugefrorenen Nordmeeres, dass die Eisbären zu Fuß von Grönland direkt nach Island laufen konnten. Dann in den 1935-er Jahren war die Nordostpassage frei. Alles ist schon einmal dagewesen.

Seitdem mit Satelliten gemessen wird, sieht man kaum Veränderungen des Nordmeereises über mehrere Jahre. In der Antarktis nimmt das Meereis die letzten Jahre dagegen deutlich zu.

Maßgebend für Wettter und Klima ist aber nicht das Meereis sondern die Festlandgletscher, von denen sich übrigens etwa 98% des Weltbestandes in der Antarktis befinden. Der grönländische Eispanzer hat ungefähr 3 Millionen km³ Volumen. Selbst wenn es am Nordpol noch 5° wärmer wäre, dauerte es viele Tausend Jahre, bis er geschmolzen wäre. Bis dahin ist es leider längst wieder kalt geworden.

Holger Douglas: Grönland bezieht sich ja auf Grünland. Die Wikinger lebten dort, aber nur auf einem schmalen, damals grünen Küstenstreifen mit ein wenig Ackerbau. Der Gletscher aber war bereits vorhanden?

Horst-Joachim Lüdecke: Natürlich. Man darf aber nicht denken, dass dort Wein angebaut wurde. Man konnte dort überleben und Ackerbau betreiben. Die Wikinger sind dann wieder abgezogen, als es kälter wurde. Eine Fachveröffentlichung zeigt im Übrigen an Hand von Eisbohrkernanalysen, dass die mittlere Temperatur Grönlands seit 8000 Jahren bis heute um satte 2,5 °C gesunken ist. Das zum medialen "Der Nordpol schmilzt".

Holger Douglas: Die Herrscher von Inselreichen kommen gerne zu Klimaverhandlungen und beklagen lauthals: Wir saufen ab! Die Industrieländer sind dran Schuld! Und sie fordern mehr Milliarden für sich. Moderner Ablasshandel. Aber das ist der offenkundig kein einheitlicher Vorgang, manche Inseln scheinen zu sinken, andere scheinen sich zu heben, je nachdem, auf welchen Erdplatten sie liegen?

Horst-Joachim Lüdecke: Es hängt tatsächlich von lokaler Geologie und von der Plattentektonik ab, ob sich Inseln heben oder senken. Die Malediven brauchen keine Angst zu haben. Soweit ich mich erinnere, sinkt aber Bangladesch ein wenig ab. Hier kommt noch der Effekt der Sedimentanschwemmung durch Flüsse aus dem Himalaya hinzu. Es ist alles komplizierter, als dass man es mit ein paar Schlagworten abhandeln könnte. Holland ist nicht bedroht, hier baut man bei Bedarf höhere Deiche und steht dem Klima-Alarmismus ungewöhnlich vernünftig und reserviert gegenüber.

Holger Douglas: Was steckt Ihrer Meinung eigentlich hinter dem Klimaalarmismus?

Horst-Joachim Lüdecke: Das Ganze ist Ideologie, eine Mischung aus wohlbekanntem Marxismus, Naturromantik und den Interessen mächtiger Investoren sowie Politiker. Rousseau machte den Anfang. In der deutschen Romantik entstand das Bild vom weisen gütigen Hausvater, der sich um alles liebevoll kümmert. Die Wirklichkeit sieht anders aus. Er ist keineswegs gütig sondern ein brutaler Diktator, der uns vorschreiben will, welche Glühbirnen wir noch verwenden dürfen, dass wir kein Fleisch mehr essen dürfen – kurz, wie wir zu leben haben.

Kretschmann, der die aktuelle Wahl in Baden-Württemberg gewann, ist Musterbeispiel. Sein Ziel, den Schwarzwald und Odenwald mit völlig unnützen Windrädern zu verspargeln hat die Bevölkerung nicht abgehalten, die grünen Umweltverbrecher zu wählen. So hirnerweichend wirkt Ökoideologie.

Die Natur wird von Ökoideologen als gütig angesehen und als Mutter Gaia bezeichnet, was aber nur eine hilfsweise Verführungsmasche für Gläubige ist. Der Mensch würde die Natur schädigen. Doch die Natur ist weder gut noch böse zu uns. Wir müssen und wollen sie zweifellos schützen. Wir müssen aber gleichzeitig auch uns gegen die Natur schützen. Die moderne Medizin mit ihrem Kampf gegen tödliche Bakterien und Viren von Mutter Gaia zeigt es. Ob aber die Grünen Naturschutz wollen, ist mehr als fraglich, wie es Windräder zeigen.

Das Ziel der Ökoideologen ist in Wirklichkeit eine andere Gesellschaft – undemokratisch und diktatorisch. Ökologie ist dabei nur ein Hilfsmittel. Die kühle Billigung der Vernichtung von Hunderttausenden Fledermäusen und Greifvögeln durch Windräder belegt die Motive dieser Leute. Insbesondere die Verbindung von Klimaschutz und undemokratischen Ideologien ist unübersehbar. Echter Naturschutz zählt bei den Klimaschützern nicht mehr.

Holger Douglas: Wie konnte es Ihrer Meinung nach soweit kommen?

Horst-Joachim Lüdecke: Nachdem der Kommunismus verschwand, wurde als neue Ideologie der Klimaschutz entdeckt. Erstaunlicherweise waren die Protagonisten zahlenmäßig nicht sehr stark, setzten sich aber durch kräftige Unterstützung der Politik und mächtiger Geldgeber rasch durch. Die Möglichkeit, durch Klimaangst politische Herrschaft auszuüben und die Luft zu besteuern und für clevere Investoren in sachlich nutzlose grüne Energien neue Geschäftsfelder aufzutun war einfach zu verlockend.

Es wurde die Treibhauswirkung des CO2 entdeckt. Diese hat man dann zunehmend als fiktive Bedrohung instrumentalisiert und die neue Ideologie des Klimaschutzes darauf aufgebaut. Da stecken natürlich auch weitere handfeste geschäftliche Interessen dahinter.

Insbesondere NGOs, Greenpeace ist hier vorrangig zu nennen, reiten auf dieser Welle. Das sich am Rand der Kriminalität bewegende, aber von den deutschen Medien fast schon wie eine Regierungspartei gehandelte Greenpeace macht sein Geschäft zur Zeit mit dem Kampf gegen die Kernenergie. Ironischerweise ist Kernenergie CO2 frei.

Wenn wie jüngst zu lesen war, die Rockefeller Gruppe aus dem Ölgeschäft aussteigen und ins Geschäft der "erneuerbaren" Energie einsteigen will, weiß jeder nachdenkende Zeitgenosse, was sich hier abspielt.

Ich erlaube mir, es an dieser Stelle ganz klar zu sagen: Klimaschutz hat nichts mit Naturschutz zu tun. Klimaschutz ist eine gefährliche undemokratische Ideologie.

Nachtrag EIKE-Readaktion:

Erfahrungsgemäß führt jede News, die den Treibhauseffekt anspricht, zu oft hoch emotionalen, kontroversen Kommentaren. Auf Bitte des Interviewten (Pressesprecher Horst-Joachim Lüdecke) veröffentlichen wir daher sein folgendes Statement:

Liebe Leser: Meine im Interview gemachten Ausführungen über den Strahlungs-Treibhauseffekt, Gegenstrahlung etc. werden von allen maßgeblichen Fachleuten geteilt, sowohl den Alarmisten als auch den "Klimaskeptikern". Zu den "Klimaskeptikern" = IPCC-Gegnern zählen viele mit hohem wissenschaftlichen Ansehen, so etwa die beiden Physik-Nobelpreisträger Ivar Giaever und Robert Laughlin.

Ich habe im Interview den heutigen Kenntnisstand geschildert, eigenes habe ich nicht geäußert. Dieser allgemeine Kenntnisstand wird auch vom EIKE-Fachbeirat vertreten. Die wenigen Fach-Publikationen, die diese Auffassung nicht teilen, sollen damit nicht diskreditiert oder verschwiegen werden. Es ist aber Tatsache, dass sie in der Fachwelt so gut wie keine Resonanz erfuhren. Vielleicht ist dies der Grund, dass die Vertreter dieser Minderheit oft die notwendige Höflichkeit in der Propagierung ihrer Auffassung vermissen lassen. Mehr Sachlichkeit würde vielleicht zu gewinnbringenden Diskussionen führen.

Meine Ausführungen zu den Rückkoppelungseffekten, also IPCC-Klimamodellen, Hot Spot usw. werden selbstredend nur von den IPCC-Gegnern und nicht von den Klima-Alarmisten geteilt.

Um es daher deutlich noch einmal zu sagen: Das was im Interview zum Thema "Treibhauseffekt" zu hören ist, stammt nicht von mir. Es ist das, was die Fachleute des "Skeptikerlagers" und betreffs Strahlungsteil auch noch die IPCC-Fraktion vertreten. Ich bitte daher um Verständnis, wenn ich mich aus weiteren Diskussionen zu diesem Thema heraushalte. Dies auch deswegen, weil ich mich als Physiker zwar mit dem Thema etwas auskenne (hier, hier), aber kein Spezialist auf diesem Gebiet bin. Es gibt Einschlägigeres, stellvertretend (hier, hier). Die wohl vollständigste und umfangreichste Zusammenstellung bietet der Skeptiker-Blog "Science of Doom" (hier). Hier findet sich auch fachliche Kritik an der o. erwähnten Minderheiten-Meinung.

Wer sich also ernsthaft informieren möchte – die wichtigsten Quellen sind genannt. Wer es persönlich möchte, möge sich an einen Experten der riesigen Schar prominenter Gegner des IPCC wenden. Ich nenne stellvertretend nur Namen wie Fred Singer, Richard Lindzen, Nir Shaviv, Henrik Svensmark, Garth Paltridge, Roy Spencer usw. usw. ….. Einige von ihnen sind Mitglieder der Skeptikerorganisation "Global Warming Policy Foundation", gegründet von Benny Peiser. Ich stehe für Antworten nicht zur Verfügung.