Bild rechts: Aktivisten einer BN Kreisgruppe bei einer (Originaltext) „Eisbärenaktion“ zum letzten Klimagipfel Herbst 2015

27. Februar 2016, internationaler Eisbärentag im Münchner Tierpark Hellabrunn. Besucher erfahren alles Wissenswerte über die Tiere, ihre Gefährdung und den Klimawandel.

Hellabrunn möchte den Internationalen Eisbärentag dazu nutzen, auf die Gefährdung der wildlebenden Artgenossen der Münchner Eisbären Giovanna und Yoghi aufmerksam zu machen. Der jährlich am 27. Februar stattfindende „International Polar Bear Day“ wurde 2004 von der Organisation Polar Bears International initiiert und will weltweit auf den Klimawandel und die damit verbundene Gefährdung der Eisbären hinweisen. Laut Weltnaturschutzorganisation IUCN liegt der aktuelle Bestand der Eisbären bei etwa 20.000 Tieren in freier Wildbahn. Sie listet den Eisbären als „gefährdet“. Wissenschaftler rechnen damit, dass der Bestand innerhalb der nächsten Jahrzehnte weiter dramatisch abnimmt.

Im Hellabrunner Artenschutzzentrum informieren am Samstag, den 27. Februar die Artenschutzbotschafter des Tierparks von 10 bis 16 Uhr über den Klimawandel und geben Tipps, was jeder persönlich tun kann, um Eisbären zu schützen.

Seit 2014 unterstützt Hellabrunn die Organisation Polar Bears International.

Wieder eine der nicht enden wollenden, erschreckenden Klimawandelgeschichten. Gerade war man noch beruhigt aufgrund der Mitteilungen, die Eisbärpopulation hätte seit dem Minimum der 1950er Jahren deutlich zugenommen. Auch EIKE publizierte gerade eine erfreulich positive Darstellung dazu „Zehn düstere Prophezeiungen bzgl. des Unterganges von Eisbären sind gescheitert: jetzt wieder 20.000 bis 30.000 Exemplare“. Im Fernsehen konnte der Autor eine Reportage über Spitzbergen ansehen, bei der die Forscher teilweise nicht an Land gehen konnten, weil es von (im Film sichtbaren) Eisbären wimmelte.

Und nun sieht sich der Münchner Tierpark veranlasst auch dieses kleine Glück Kindern und Eltern zu nehmen und zu erinnern: Der schreckliche Klimawandel bleibt immer und überall.

Deshalb anbei eine kleine Darstellung was sich über die Gefährdung der Eisbären ermitteln lässt.

Ist der Tierpark Hellabrunn wissenschaftlich neutral

Ein Blick in die Veranstaltungsinformation von 2015 zeigt dass man das nicht erwarten kann. Es soll primär nicht Wissen, sondern eine Botschaft vermittelt werden – und die ist eindeutig klimapropagandistisch:

Umweltbildung am Internationalen Eisbärentag in Hellabrunn

Zoodirektor Rasem Baban ist es ein großes Anliegen, dass Hellabrunn beim Internationalen Eisbärentag dabei ist: „Wir möchten die Chance nutzen, unseren Besuchern die Tragweite ihres Handelns in Bezug auf den Klimawandel näherzubringen.

Teilnehmer des Aktionstags sollen ihr Thermostat 2°C hinunter bzw. heraufregeln (je nachdem, ob sie sich gerade im Winter oder Sommer befinden) und damit CO2 einsparen. Etwa ein Fünftel des Energiebedarfs in Deutschland wird für Heizung und Warmwasser verbraucht. Heizkosten sind damit eine wichtige Stellschraube, um Energie einzusparen und den CO2-Verbrauch zu senken.

Der globale Klimawandel, der in der Arktis am deutlichsten sichtbar ist, gilt als die größte Bedrohung für den Eisbären: Innerhalb der vergangenen 100 Jahre ist die Lufttemperatur um 5°C angestiegen. Die Ausdehnung des Packeises ist seit 1985 um sechs Prozent zurückgegangen, die Eismasse sogar um fast 40 Prozent. Das Eis schmilzt im Frühjahr früher und kehrt im Herbst später zurück.

[5] BEDROHT VOM KLIMAWANDEL AKTIV FÜR DEN KLIMASCHUTZ – AKTIV FÜR DIE EISBÄREN!

Die Angaben zur Eisbärpopulation

Hellabrunn gibt in seiner Veranstaltungsmitteilung für die Eisbärpopulation Daten der Organisation IUCN an:

Tierpark Hellabrunn Veranstaltungsinfo: Laut Weltnaturschutzorganisation IUCN liegt der aktuelle Bestand der Eisbären bei etwa 20.000 Tieren in freier Wildbahn. Sie listet den Eisbären als „gefährdet“. Wissenschaftler rechnen damit, dass der Bestand innerhalb der nächsten Jahrzehnte weiter dramatisch abnimmt.

IUCN selbst hat diese Daten genau rechtzeitig zum letzten Klimagipfel im Herbst 2015 publiziert. Anbei der Auszug vom damaligen „Spiegel“:

Mit hoher Wahrscheinlichkeit werden die Eisbärenbestände deshalb in den kommenden 35 bis 40 Jahren um mehr als 30 Prozent schrumpfen, berichtet die Weltnaturschutzorganisation IUCN.

Die Naturschützer bewerteten die Überlebenschancen der Eisbären vor allem mit Blick auf den Weltklimagipfel, der vom 30. November bis 11. Dezember in Paris stattfindet, neu. Sie glichen Daten zu allen Populationen in der Arktis mit Statistiken zur Eisschmelze in den vergangenen Jahrzehnten ab und speisten sie in eine Computersimulationen.

Die Vorhersage der dramatischen Abnahme

Wie man im Spiegel-Artikel nachlesen kann, wurde die Vorhersage, dass die Eisbärenpopulation dramatisch abnimmt anhand einer Computersimulation ermittelt – und sofort von allen Medien übernommen – wie auch vom Tierpark Hellabrunn.

Ob es jedoch in der wirklichen Natur dafür Anzeichen gibt lohnt sich nachzusehen.

Wie steht es um die Eisbärenpopulation

Die Tierschutzorganisation PeTA weiß dazu etwas zu berichten

Natürlich schlägt eine Tierschutzorganisation einer anderen in der Regel kein Auge aus. PeTA ist aber gegen Wildtierhaltung in Zoos und Zirkus. Das argumentiert sich nur, wenn sie in freier Wildbahn überleben können. Damit ist PeTA vor-eingenommen. Aber deren Recherche und Argumentation ist deshalb nicht uninformativ.

PeTA: Dramatischer Rückgang der Eisbärenpopulationen?

Wer kennt sie nicht, die Schlagzeilen „Klimaschock lässt den weißen Riesen keine Chance“ oder „Eisbären in Not“. Panikartig verbreiten sich die Meldungen, dass Knuts frei lebenden Verwandten durch Klima und Lebensraumzerstörung massiv vom Aussterben bedroht seien. Ja, die „Erderwärmung werde das majestätische Geschöpf auslöschen“.

Genau in diese Kerbe schlugen fortan auch Zoos und Politik in Bezug auf die in Deutschland inhaftierten Eisbären.

Geht der Bestand der Eisbären wirklich dramatisch zurück?

Die Rote Liste des IUCN nennt am 27.08.2009 einen Bestand von 20.000 bis 25.000 Eisbärenindividuen. Von nur noch 16.000 Eisbären kann also keine Rede sein. Auch ein Blick auf die Bestandserhebungen seit 1950 lässt erkennen, dass sich der Bestand von vormals 5.000 Eisbären bis heute erheblich erhöhte und seit 2001 recht stabil blieb. 1950 gab es bis zu 5.000 Eisbären 1965–1970 gab es 8.000-10.000 Eisbären 1984 gab es 25.000 Eisbären 1997 gab es 22.000-27.000 Eisbären 2001 gab es 21.500-25.000 Eisbären 2005 gab es 20.000-25.000 Eisbären

Zufügung des Autors: aktuell wird der Bestand auf zwischen 20 … 31.000 geschätzt

2007 sprach man von 13 einzelnen Eisbär-Populationen in Kanada, von denen elf stabil waren oder sogar zunahmen. Die IUCN beschreibt 2009 sogar 19 Eisbären-Einzelpopulationen in ihrem Lebensraum.

In sieben der 19 bislang untersuchten Eisbären-Populationen sei der Bestand stabil oder nähme sogar zu.

Von einem erheblichen Rückgang der Eisbären-Population kann also aufgrund der Zahlen nicht die Rede sein. Dennoch wird noch bis heute in den Medien von einem Problem geredet und immer weiter dramatisiert.

„Die internationale Naturschutzunion IUCN hat die Eisbären auf eine Liste von mehr als 16.000 gefährdeten Tierarten gesetzt und schätzt, dass ihre Zahl (heute 22.000-25.000 Tiere weltweit) in den kommen 45 Jahren um ein Drittel zurückgehen wird.“

In 45 Jahren soll die Population also um ca. 8.300 Tiere zurückgehen.

Wäre das aber in Anbetracht dass es auf dem heutigen Lebensraum der Eisbären einst nur ca. 5.000 Tiere lebten, wirklich dramatisch?

Die Daten zum Eisbärenbestand

Übersicht

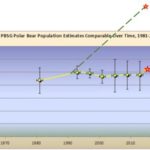

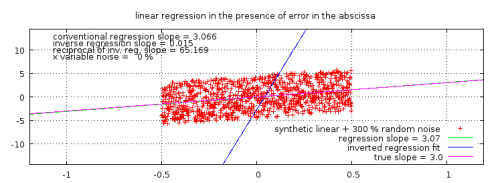

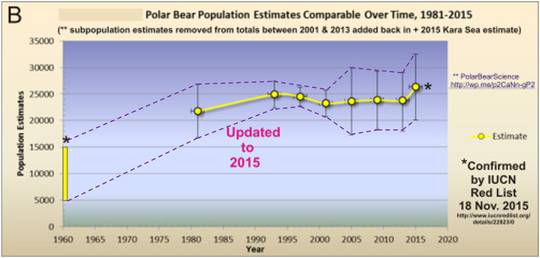

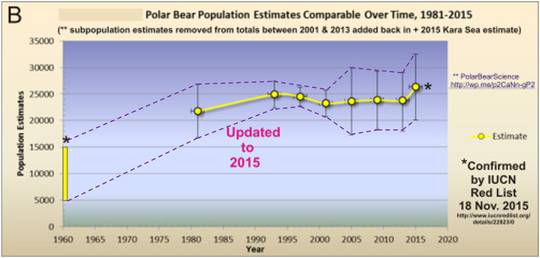

Sieht man in die aktuellen Publizierungen bei Polar Bear Science, wird für den Bestand im Jahr 2015 eine Zahl von 20.000 …. 31.000 (Mittelwert: 25.500) genannt (Polar Bear Science: „IUCN Red List says global polar bear population is 20,000 – 31,000 (25,500)“. Weiter findet sich darin das Bild 1 mit den umgesetzten Daten der Eisbärpopulationen seit 1960.

Bild 1 Verlauf der Eisbärpopulationen nach Polar Bear Science. Die Spannweite der Bestandsschätzungen wurde vom Autor durch gestrichelte Linien hervorgehoben.

Wie genau sind die Daten zur Eisbärpopulation

Der „Eisbärthriller“

Mehr durch einen Zufall kam heraus, dass die Polar Bear Specialist Group (PBSG) welche die Zahlen zum Eisbären-Bestand veröffentlicht nicht wirklich zählte, sondern die Populationsdaten einfach vermutete:

Derzeitiger Vorsitzenden der PBSG, Dr. Dag Vongraven: „qualitative Vermutung mit dem Ziel das öffentliche Interesse zu befriedigen”.

Außerdem wurden in den „Erhebungen“ gleich fünf wichtige Eisbärgebiete ausgespart. Die bisherigen Meldungen zu den Beständen waren also reine alarmistische Schätzwerte.

Auf kaltesonne wurde es gemeldet:

kaltesonne: Eisbären-Statistik-Gruppe räumt ein: Veröffentlichte Eisbärenzahlen sind lediglich eine “qualitative Vermutung"

Im Blog von Radio Utopia findet sich dazu eine informelle Zusammenfassung

Radio Utopia „Offizielle Zahlen zu weltweiten Eisbärenpopulationen ohne wissenschaftliche Grundlagen“ (Auszüge):

Um die öffentliche Nachfrage zu befriedigen, werden von der IUCN Polar Bear Specialist Group (PBSG) jahrelang einfach nur „qualifizierte“ Vermutungen zur Anzahl der vorhandenen Eisbären auf diesem Planeten abgegeben.

Was jedoch schockierend ist, ist das von einer Wissenschaftlerin am 30.Mai 2014 veröffentlichte Eingeständnis der IUCN Polar Bear Specialist Group (PBSG). …..

J. Crockford, … veröffentlichte auf ihrem Blog die am 22. Mai 2014 per E-Mail eingegangene Antwort auf ihre Nachfrage zu den Populationen vom derzeitigen Vorsitzenden der PBSG, Dr. Dag Vongraven am Norwegischen Polarinstitut.

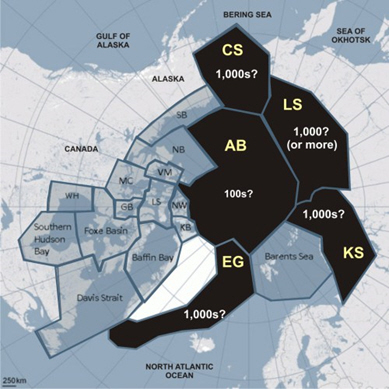

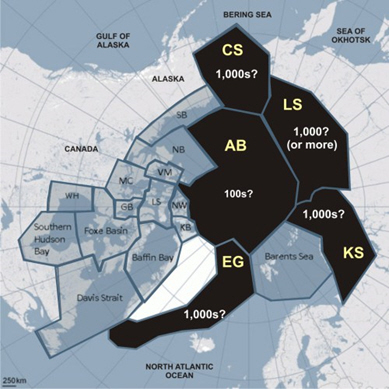

Die PBSG hat seit dem Jahr 2005 die Anzahl der Eisbären mit 20000 bis 25000 angegeben. Dabei wurden grosse Teile der polaren Gebiete nicht berücksichtigt, so das Arktische Becken, Ost-Grönland und das gesamte russische Gebiet. Ein Blick auf diese Karte genügt, um die Grösse dieses Bereiches zu erfassen. Ungefähr noch einmal die Hälfte der offiziellen Angaben müssten noch hinzugerechnet werden, auch das sind nur Schätzungen und keine tatsächlichen „wissenschaftlichen“ Werte.

Vongraven bezeichnete die Angaben als „simply a qualified guess given to satisfy public demand“ und gibt zu, dass es überhaupt kein oder allenfalls nur „rudimentäres“ Wissen dazu gibt.

Dieses Eingeständnis über die „Befriedigung des öffentlichen Interesses“ auf der Basis von Annahmen ist nicht nur der blanke Hohn, mit der jahrelang die Weltbevölkerung zum Narren vom Verschwinden der weissen Bären gehalten wurde, sondern ein grosses Verbrechen an dem betrogenen gutgläubigen Bürger, der sich ohne zu Hinterfragen auf die Wissenschaften verlässt.

Im Bild 2 sieht man welche großen Teile des Polargebietes früher nie von den Zählungen erfasst wurde (schwarz gekennzeichnete Flächen)

Bild 2 Von der PBSG nicht in den Zählungen erfasste Polargebiete (schwarz) (aus „kaltesonne“, Quelle: Polarbearscience.com)

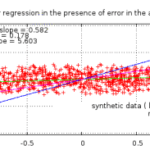

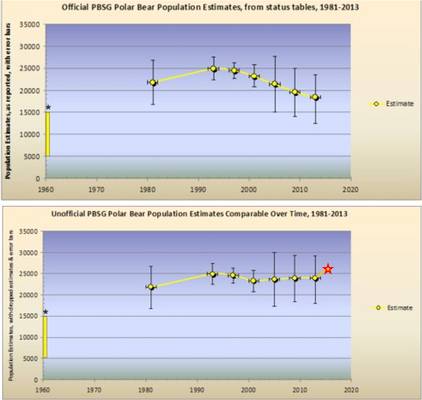

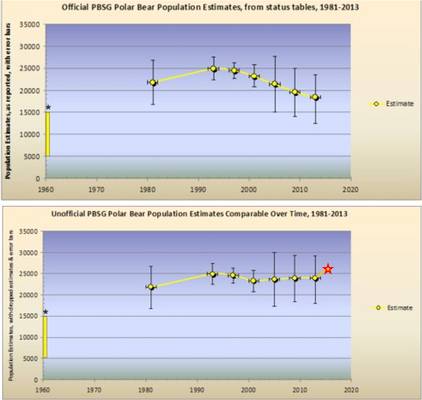

Aus der Abnahme wird auf einmal eine Zunahme der Eisbärpopulation

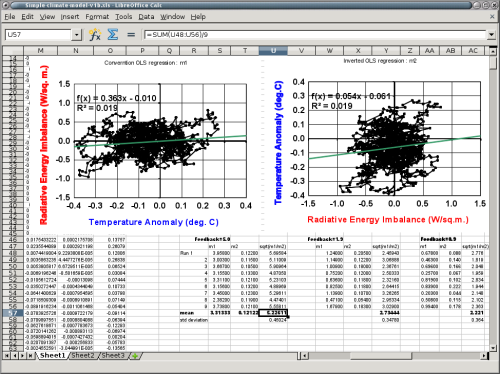

Die folgenden Grafiken (Bild 3) zeigen, wie sich nach Bekanntwerden der falschen Daten durch Ergänzen der fehlenden Populationen auf einmal eine Zunahme ergibt.

Nun zählt auch neuerdings niemand wirklich die einzelnen Bären, vor allem nicht auf russischen Gebieten. Aber eines ist sicher: Die bisherigen „Daten“ waren Fälschungen und eine Abnahme der Population ist eher unwahrscheinlich. Komischer weise wurde dies über die vielen Jahre von keinem der vielen „Experten“ und NGOs bemerkt.

Bild 3a: Eisbärenentwicklung laut PBSG (oben) und nach Berücksichtigung fehlender Daten (unten). Quelle: polarbearscience.com.

Bild 3b Eisbärenentwicklung vor / nach der Datenkorrektur (entnommen aus „kaltesonne“). Anm.: Der aktuelle Stand für 2015 im zweiten Bildteil wurde vom Autor aus Bild 1 zugefügt

Warum „müssen“ die Eisbären sterben

These: Das Frühjahrseis wird zu dünn

Tierpark Hellabrunn[5]:

In wenigen Jahrzehnten könnte die Arktis im Sommer komplett eisfrei sein. Schon heute beginnt das Packeis im Frühjahr immer früher zu schmelzen und das Meer friert im Herbst immer später zu. Dies hat schwerwiegende Folgen für den Eisbären: Die Zeit, in der Eisbären auf Robbenjagd gehen und sich ausreichend Energiereserven für die eisfreie Zeit anfressen können, wird immer kürzer.

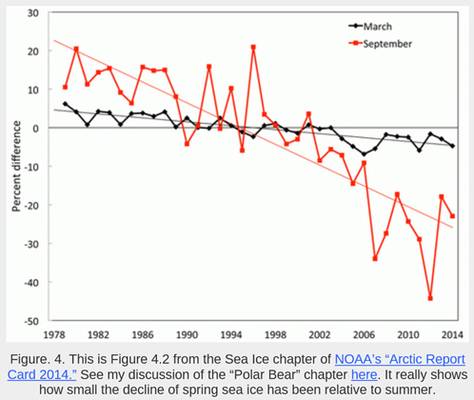

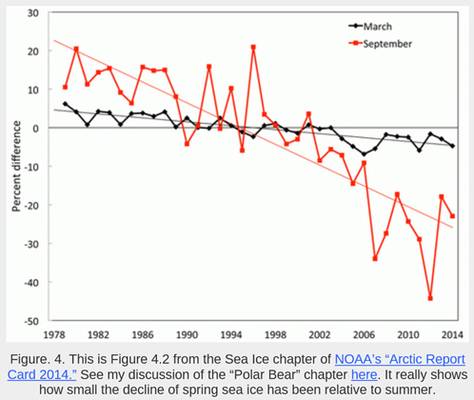

Dazu sehe man sich die Grafik aus einer Publikation von Polar Bear Science an (Bild 4). Das für die Eisbären so wichtige Eis hat ganz unwesentlich abgenommen. wohl ein Grund, warum die Population nicht abnimmt. Auch dazu stellt sich wieder die Frage: warum viel auch das wieder keinem der „Wissenschaftler“ auf?

Bild 4 Geringe Abnahme des für die Eisbären wichtigen Frühlingseises (Schwarz) im Verhältnis zum unwichtigeren Sommereis (Rot), Quelle Polar Bear Science

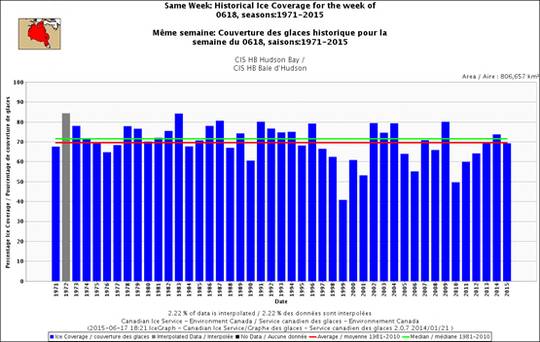

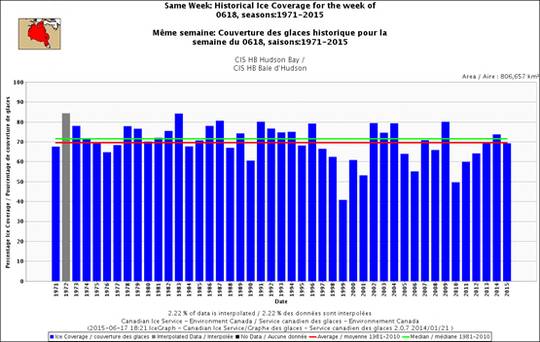

Ergänzend der Verlauf des Frühsommereises in der Hudson-Bay mit ihrer großen Eisbärdichte. So dramatisch wie überall berichtet sieht auch dieser Verlauf nicht aus. Dass Eisbären in ihrer Geschichte noch nie schlimmeres erlebt hätten kann man kaum glauben.

Bild 5 [17] Sea ice coverage over Hudson Bay for the week of 18 June, 1971-2015. CIS.

Ist das Frühlingseis allerdings zu dick ist, ist es auch nicht gut. Dann können die Bären es auf der Suche nach Robben nämlich nicht mehr durchstoßen, wie CNS News am 25. April 2014 meldete “Polar Bears Threatened…By Too Much Spring Ice”. Man stelle sich das vor – die Eisbären müssten verhungern, weil es durch Klimawandel-Schutzmaßnahmen wirklich kälter würde und das Frühjahrseis zu dick wird. Tragen die “Eisbärklamotten” in den Fußgängerzonen ihre Schilder dann anders herum?

Zudem zeigt sich, dass die Populationen zyklisch schwanken – und diese Zyklik nichts mit dem Meereis zu tun hat. Dazu aus einem EIKE Artikel.

EIKE: “Die neuste Eisbären-Ente”:

Ähnliche Einbrüche der Eisbärenpopulation wie 2004-2006 hatte es in der Beaufortsee in der Vergangenheit stets gegeben, wie die Zoologin Susan Crockford in ihrem Blog Polar Bear Science am 18. November 2014 in einer Besprechung der neuen Arbeit berichtete:

Studie: Hier kommen ein paar weitere gute Nachrichten hinsichtlich der Eisbärenpopulation, diesmal aus einer umfangreichen Studie aus der Südlichen Beaufort-See. Eine jüngst veröffentliche Studie zeigt eine Abnahme um 25% bis 50% zwischen 2004 und 2006 (stärker als ursprünglich berechnet). Allerdings hat sich die Population bis zum Jahre 2010 deutlich erholt (obwohl das vorherige Niveau noch nicht erreicht ist). Alle Schlagzeilen in den Medien (z. B. in The Guardian) sind den Pressemitteilungen gefolgt, die sich auf das Ausmaß des Rückgangs konzentriert haben. Dabei ist die Erholung des Bestandes der Teil der Studie, der wirklich eine neue Nachricht ist, basiert dies doch auf neuen Daten. Diese Erholung ist ähnlich einer solchen, die Ende der siebziger Jahre dokumentiert worden ist. Davor war es zwischen 1974 und 1976 zu einer starken Abnahme der Population gekommen, verursacht durch besonders starken Eisgang im Frühjahr (hier). … Allerdings zeigte sich in der Studie keinerlei Korrelation zwischen Rückgang der Population und Eisbedingungen. Eine solche Korrelation konnte nicht gefunden werden, weil man nicht die Dicke des Eises im Frühjahr in die Modelle eingegeben hatte – man hatte lediglich die sommerlichen Eisbedingungen betrachtet. Ich finde das ziemlich merkwürdig, da frühere Beispiele dieses Phänomens, das etwa alle 10 Jahre seit den sechziger Jahren zu beobachten ist, allesamt mit dicken Eisbedingungen im Frühjahr zusammenhingen (Die Rückgänge von 1974 bis 1976 sowie von 2004 bis 2006 waren die schlimmsten). Ein weiterer Vorgang dieser Art könnte sich im Frühjahr dieses Jahres ereignet haben (April 2014 hier), doch wurde dieser Vorgang bislang nicht bestätigt.

Allerdings zeigen unsere Ergebnisse im Kurzfristzeitraum, dass andere Faktoren als das Meereis das Überleben beeinflussen können. Ein verbessertes Verständnis der ökologischen Grundlagen als Basis für die Dynamik der Eisbärenpopulation ist notwendig, um Projektionen ihres Status‘ in der Zukunft zu verbessern und zur Entwicklung von Management-Strategien zum Schutz der Eisbären.

These: Eisbären können nur von Robben auf Packeis (über-)leben

Eisbären sind laut Lehrmeinung aus Braunbären entstanden „Welt.de Wissenschaft“, aber deren Gene als Allesfresser haben sie, wenn man den vielen „Experten“ und abschreibenden Medien glauben soll angeblich ausgerechnet nicht mit übernommen.

Allerdings doch, wie eine Information der Uni Hamburg mitteilt

[9] Eisbären sind wie alle Bären Allesfresser, legen aber ihren Schwerpunkt deutlich oder fast ausschließlich auf tierische Kost.

Es ist verständlich, dass ein Eisbär am Liebsten die für ihn leichter jagdbaren und von Kalorien strotzenden Robben frisst. Das dürfte für ihn wohl so sein, wie immer in einem 3-Sterne Lokal essen zu dürfen. Dass er ohne diese auf dem Packeis servierten Robben aber sicher verhungert, ist eine Fabel aus dem Klima-Alarmland, was sogar dem FOCUS schon einmal auffiel:

FOCUS [8]: Es wird wärmer – gut so! 6. Sterben die Eisbären aus?

Zwischen der Meereisausdehnung und der Anzahl der Eisbären konnte in der Vergangenheit kein direkter Zusammenhang nachgewiesen werden. So ist auch zukünftig nicht automatisch mit Bestandsverlusten zu rechnen, wenn die Temperaturen weiter steigen und Eisflächen verloren gehen. Denn Eisbären jagen Robben auch an eisfreien Stränden, und im Sommer tummeln sie sich seit jeher in der blühenden Tundra, wo sie sich von Lemmingen und Wühlmäusen ernähren.

Uni Bremen:

[9] Die Eisbären wandern dann entweder mit dem rückweichenden Eis in weniger produktive, küstenfernere Gewässer oder weichen auf das Festland aus, wo sie sich von Kleinsäugern, Vögeln, Eiern und Fischen sowie ganz selten auch von pflanzlicher Kost ernähren.

Neue Zürcher Zeitung:

[13] Dass die Tiere an Land fressen, ist schon länger bekannt. Fettreserven bauen sie dort allerdings nicht auf – wenn sie auf das Eis zurückkehren, sind sie leichter als vorher. Doch mittlerweile stehen den Tieren – aufgrund der Klimaänderung – auch «neue» Nahrungsmittel zur Verfügung, wie Linda Gormezano vom American Museum of Natural History und ihre Kollegen kürzlich in einigen Publikationen beschrieben.

PeTA:

[7] Doch ob gerade die Eisschmelze, also der Klimawandel, sich erheblich negativ auf die Eisbärenpopulation auswirkt, wird mittlerweile stark bezweifelt. Der sensationelle Fund eines sehr alten Eisbärenskeletts im Jahr 2008 bestärkt diese Meinung.

„Das es schon vor 130.000 Jahren Eisbären gegeben hat, ist ein Grund zum Jubel“, so Paläontologe Olafur Ingolfsson von der Uni Island. Der Fund beweise, dass „die Bären schon eine Warmzeit überlebt haben“. Eine Warmzeit, die viel wärmer gewesen sein muss, als die heutige.“

Zudem muss man wissen:

„In der letzten Zwischeneiszeit vor 10.000 bis 15.000 Jahren waren die Temperaturen in der Arktis erheblich höher als heute, auch in der mittelalterlichen Warmzeit war das Nordmeer zu einem guten Teil eisfrei. Der Eisbär hatte sich damit offenbar arrangiert, schließlich ist er nicht erst vor kurzem vom Himmel gefallen.“

Eisbären haben also schon viel wärmere Perioden überlebt, als wir sie heute haben.

Wissenschaftler fanden sogar heraus, dass in der Süd-Beautfortsee die Bärenzahl konstant blieb – trotz Schmelze. Und wussten Sie auch, dass Eisbären nicht unbedingt Eis brauchen, um zu überleben?

„Sollte es weiter wärmer werden, wäre dies für die Eisbären vermutlich auch kein großes Problem. Ursus Maritimus ist eine evolutionär sehr junge Art, die sich aus den Braunbären (Ursus arctos) entwickelt hat, mit dem sie sich bis heute kreuzen kann. In den Sommermonaten leben viele Eisbären in der schnee- und eisfreien Tundra und kommen auch dort auch gut zurecht“. (6)

„Der Fund bestärkt jene Gruppen von Biologen, die daran zweifeln, dass Eisbären tatsächlich das Eis zum Leben brauchen. Diese Forscher sind überzeugt, dass die Tiere wie Braunbären auch an Land jagen können. „Das Überleben der Eisbären hängt nicht davon ab, wie viel Eis es über dem Nordpol gibt“, sagt der Münchner Evolutionsbiologe Josef H. Reichholf.“

Allerdings muss man auch die Angaben zum genetischen Alter (wie anscheinen recht viel, was die „Experten“ angeblich über die Eisbären wissen) in Frage stellen. Laut mehreren Meldungen sind Eisbären wesentlich älter als alle Experten bisher nur zu ahnen gewagt hatten:

SPIEGEL ONLINE 20.04.2012: 600.000 Jahre: Analyse enthüllt lange Geschichte der Eisbären

Eisbären sind etwa vier- bis fünfmal so alt, wie bisher vermutet: Sie lebten bereits vor etwa 600.000 Jahren, berichtet ein internationales Forscherteam um die Frankfurter Wissenschaftler Frank Hailer und Axel Janke im Wissenschaftsmagazin "Science".

kaltesonne[11]:

… Nun hat sich die Eisbärenära sogar noch weiter nach hinten ausgedehnt. Im Juli 2012 erschien in den Proceedings of the National Academy of Sciences eine neue Arbeit eines internationalen Forscherteams um Webb Miller, das zeigen konnte, dass die Ahnenreihe der Eisbären sogar 4 bis 5 Millionen Jahre zurück reicht (siehe Berichte im Examiner, World Climate Report, New Scientist, The Resilient Earth, NIPCC und Science Daily). Eisbären gab es also sogar vor dem Beginn der pleistozänen Vereisungsphase, die erst vor knapp 2 Millionen Jahren begann.

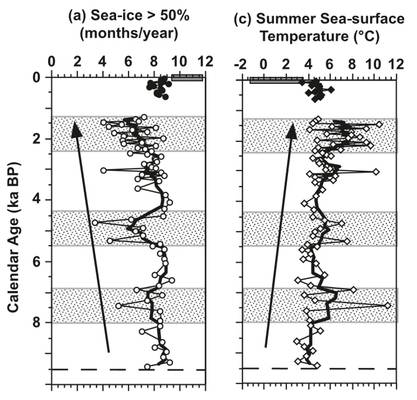

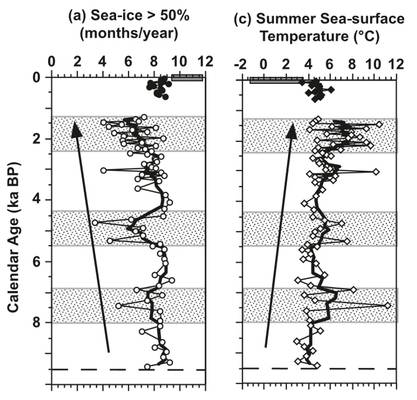

Und damit haben sie auf jeden Fall schon mehrmals viel extremere Klimaschwankungen mit mehreren Eiszeiten und Warmzeiten überstanden. Zudem auch erhebliche Schwankungen innerhalb der letzten 10.000 Jahre, wie es beispielhaft die folgenden Bilder (Bild 6) aus [21] mit dem historischen EIS- und Temperaturverlauf östlich von Alaska zeigen.

Bild 6 [21] Historischer Verlauf von Seeeisbedeckung und Sommertemperatur in de eastern Chukchi Sea

Weshalb stirbt er aber dann trotzdem wegen des Klimawandels aus?

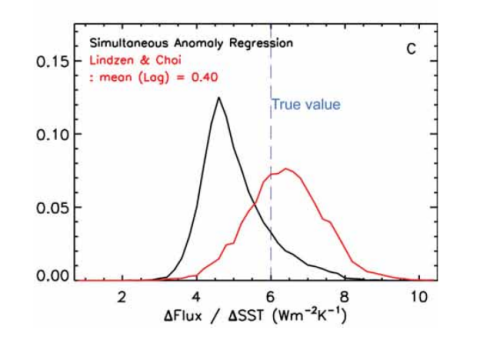

Eine Simulation „gefüttert“ – und schon muss er sterben

Wie anfangs schon erwähnt, haben die jüngsten Alarmmeldungen zum Eisbärsterben ihren Ursprung in Simulationen. Wie üblich, wurde eine Korrelation, diesmal zwischen Eisabnahme und Populationsverringerung „entdeckt“. Schreibt man diese mathematisch korrekt in die Zukunft weiter, dann sind die Eisbären irgendwann mathematisch unrettbar ausgestorben, und der unbestechliche Computer berechnet dazu sogar die Wahrscheinlichkeit.

Eine Beschreibung einer Simulation kann man bei IUCN nachlesen:

IUCN [1]:

First, we estimated generation length for Polar Bears using field data for all available ubpopulations. Second, we derived a habitat metric by summarizing spatial and temporal characteristics of remote sensing data on sea-ice concentration, in a manner that was biologically relevant to Polar Bears. Third, we used statistical models and computer simulation to project the abundance of Polar Bear subpopulations forward in time over three Polar Bear generations, based on assumed and estimated relationships between abundance and habitat.

The goals of our analysis were: (1) to provide an updated numerical reference to the ypothesis that the carrying capacity of the Arctic marine environment supporting Polar Bears is proportional to the availability of sea ice; (2) to evaluate broad relationships between available data on Polar Bear abundance and derived sea-ice metrics representing Polar Bear habitat, including the ramifications of these relationships persisting into the future;

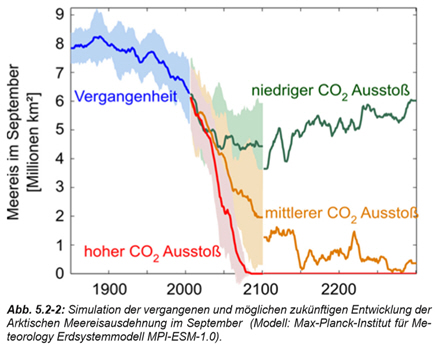

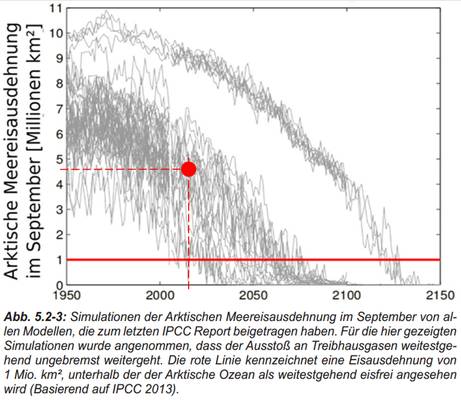

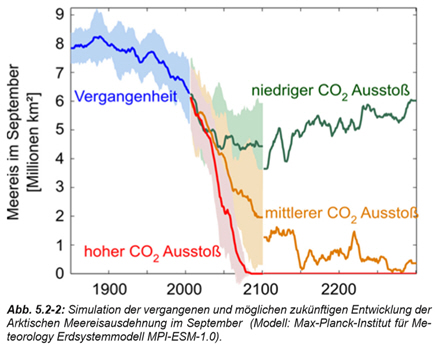

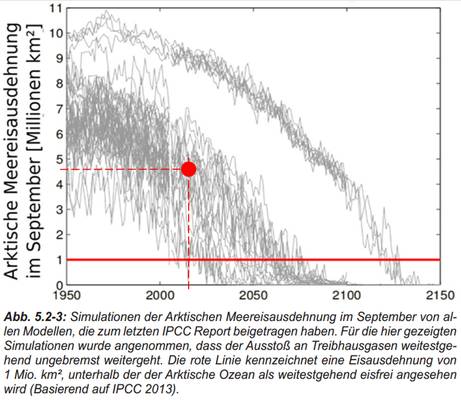

Mit diesem „gesicherten Wissen“, dass reduzierte Eisfläche eine direkt damit abnehmende Population zur Folge hat und den Temperatur- und daraus simulierten Eisverläufen aus IPCC KLimamodellen (Bild 7 und 8) lässt sich das unabwendbare Aussterben jederzeit punktgenau simulieren.

Bild 7 [16] Simulierter Verlauf der arktischen Eisbedeckung.

Dass es um 1930 in etwa so wenig Eisbedeckung wie aktuell gab, konnte die Simulation (Bild 7) nicht „rekonstruieren“. Zudem ist Der Autor dieses Papers bereits in früheren Publikationen durch Alarmismus mittels Weglassen von (ungeeigneten) Fakten aufgefallen[17]. Die in Bild 8 gezeigte Spannweite der Klimasimulations-Ergebnisse (aus der gleichen Studie) zeigt zudem überdeutlich was man von den IPCC-basierenden Simulationen halten sollte – nämlich gar nichts.

Anmerkung: Dass die klimabasierten Simulationen nach einiger Zeitspanne zu oszillieren anfangen und nur noch Unsinn liefern – aber mit auf viele Stellen berechneter Zuverlässigkeitsaussage – ist dem Autor schon bei der Analyse der UBA Vulnerabilitätsstudie aufgefallen „Der Himmel fällt uns auf den Kopf„.

Bild 8 [16] Simulationswerte der arktischen Meereisbedeckung verschiedener Klimamodelle. Die Bedeckung im Sept. 2015 (roter Punkt, ca. 4,7 Mio km2) wurde vom Autor zugefügt.

Ende von Teil 1 der Recherche zum Bestand der Eisbären

Quellen Teil 1 / 2

[1]

RUCN Red List: Polar Bear (Ursus maritimus) Supplementary material for Ursus maritimus Red List assessment

Studie mit Berechnung der Formel für die Eisbärpopulation bis zum Jahr 2050

[2]

EIKE: Zehn düstere Prophezeiungen bzgl. des Unterganges von Eisbären sind gescheitert: jetzt wieder 20.000 bis 30.000 Exemplare

http://www.eike-klima-energie.eu/news-cache/zehn-duestere-prophezeiungen-bzgl-des-unterganges-von-eisbaeren-sind-gescheitert-jetzt-wieder-20000-bis-30000-exemplare/

[3]

IUCN Redlist, Population: (Table 3 in the Supplementary Material) results in a total of approximately 26,000 Polar Bears ( 95% CI = 22,000-31,000 ).

http://www.iucnredlist.org/details/22823/0

[4]

kaltesonne 15. Dezember 2014: Eisbären-Statistik-Gruppe räumt ein: Veröffentlichte Eisbärenzahlen sind lediglich eine “qualitative Vermutung mit dem Ziel das öffentliche Interesse zu befriedigen”

http://www.kaltesonne.de/eisbar-statistik-gruppe-raumt-ein-veroffentlichte-eisbarenzahlen-sind-lediglich-eine-qualitative-vermutung-mit-dem-ziel-das-offentliche-interesse-zu-befriedigen/

[5]

Hellabrunn der Münchner Tierpark Eisbärenflyer 2014

http://www.hellabrunn.de/fileadmin/pdf/Flyer_Plaene_TP-Ordnung/Eisbaerenflyer_2014_Web.pdf

[6]

EIKE 03.12.2014: Die neueste Eisbären-Ente

http://www.eike-klima-energie.eu/climategate-anzeige/die-neueste-eisbaeren-ente/

[7]

PeTA: Klimawandel: Eine Gefahr für Eisbären?

http://www.peta.de/klimawandel-eine-gefahr-fuer-eisbaeren

[8]

FOCUS Magazin | Nr. 48 (2010): Es wird wärmer – gut so! 6. Sterben die Eisbären aus?

http://www.focus.de/wissen/klima/tid-20791/es-wird-waermer-gut-so-6-sterben-die-eisbaeren-aus_aid_582723.html

[9]

Uni Bremen, Institut für Geographie, Dr. Karin Steinecke: Können Eisbären ohne Meereis überleben?

[10]

DIE WELT 20.11.15 Die großen Verlierer des Klimawandels

http://www.welt.de/wissenschaft/umwelt/article149065091/Die-grossen-Verlierer-des-Klimawandels.html

[11]

kaltesonne 13. Dezember 2014: Studie: Eisbären können ihre Fressgewohnheiten den Umweltbedingungen anpassen

http://www.kaltesonne.de/studie-eisbaren-konnen-ihre-fressgewohnheiten-den-umweltbedingungen-anpassen/

[12]

Kerstin Langenberger arctic dreams. About me

http://www.arctic-dreams.com/en/about;3.0.0.0.html

[13]

Neue Zürcher Zeitung, 19.2.2014: Eisbären im Klimawandel Nutzung neuer Nahrungsquellen

http://www.nzz.ch/wissenschaft/nutzung-neuer-nahrungsquellen-an-land-1.18245954

[14]

EIKE 28.12.2015: Fette Eisbären: Population der Svalbard Eisbären ist in den letzten 11 Jahren um 42% gestiegen.

http://www.eike-klima-energie.eu/climategate-anzeige/fette-eisbaeren-population-der-svalbard-eisbaeren-ist-in-den-letzten-11-jahren-um-42-gestiegen/

[15]

The Global Warming Policy Foundation, GWPF Briefing 16. Susan Crockford: THE ARCTIC FALLACY Sea ice stability and the polarbear

[16]

Notz, D. (2015): Historische und zukünftige Entwicklung des Arktischen Meereises. In: Lozán, J.L., H.Grassl, D.Kasang,

D.Notz & H.EscherVetter (Hrsg.). Warnsignal Klima: Das Eis der Erde. pp. 194198

[17]

kaltesonne 12. Mai 2012: Hamburger Max-Planck-Institut mit fragwürdiger Beweisführung zum arktischen Meereis

http://www.kaltesonne.de/hamburger-max-planck-institut-mit-fragwurdiger-beweisfuhrung-zum-arktischen-meereis/

[17]

Polar Bear Science, June 16, 2015: Same amount of sea ice for Hudson Bay polar bears as 2013, bears still on the ice

Same amount of sea ice for Hudson Bay polar bears as 2013, bears still on the ice

[18]

RP.Online, 9. Januar 2016: Eisbären – Opfer des Klimawandels

http://www.rp-online.de/panorama/wissen/eisbaeren-opfer-des-klimawandels-aid-1.5676747

Gleicher Artikel in der Stuttgarter Zeitung vom 08. Januar 2016: Weiße Jäger auf der Suche nach neuer Beute

http://www.stuttgarter-zeitung.de/inhalt.eisbaeren-weisse-jaeger-auf-der-suche-nach-neuer-beute.7801fa9e-b140-4290-bca4-e09bef575cad.html

[19]

HNA (Hessische/Niedersächsische Allgemeine) 26.11.15: Experten-Interview zu Eisbären: Ist alles noch viel schlimmer?

[20]

kaltesonne 1. Mai 2012: Nicht Wärme sondern Schrotflinten sind die größten Feinde der Eisbären

http://www.kaltesonne.de/nicht-warme-sondern-schrotflinten-sind-die-grosten-feinde-der-eisbaren/

[21]

J.L. McKay at al: Holocene fluctuations in Arctic sea-ice cover: dinocyst-based reconstructions for the eastern Chukchi Sea

[22]

Norwegian Polar Institute, December 23 2015: Polar bears in Svalbard in good condition – so far

http://www.npolar.no/en/news/2015/12-23-counting-of-polar-bears-in-svalbard.html