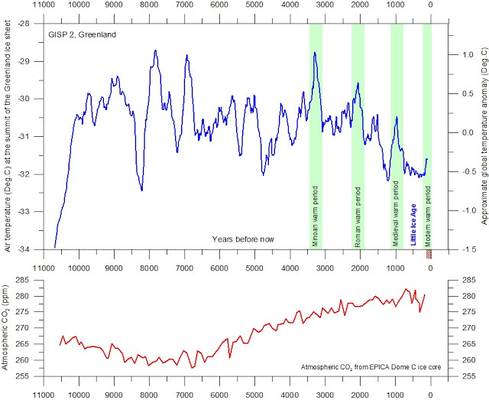

Warum ist die mittelalterliche Warmzeit (um ca. 1000 nach Chr.) so wichtig? Weil damit der Klimaalarm teilweise begründet wird. Nach der „politisch korrekten Klimalehre“ darf es damals nicht wärmer als derzeit gewesen sein. Übersteigen die heutigen Temperaturen die damaligen, sei dies ein Beleg für den anthropogen bedingten Wandel, da diese eine natürliche Variation angeblich niemals „erzeugen“ könnte. Weiter begann danach auch die aktuelle Warmzeit erst mit dem Beginn der Industrialisierung um ca. 1820 … 1850 vorwiegend durch das dadurch emittierte anthropogene CO2.

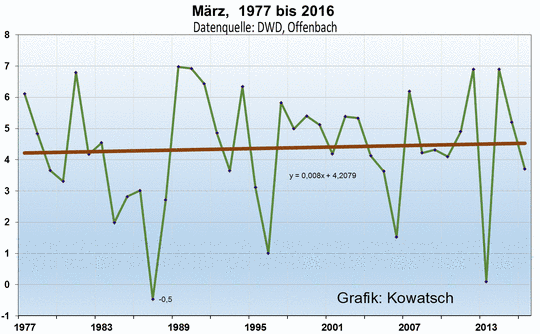

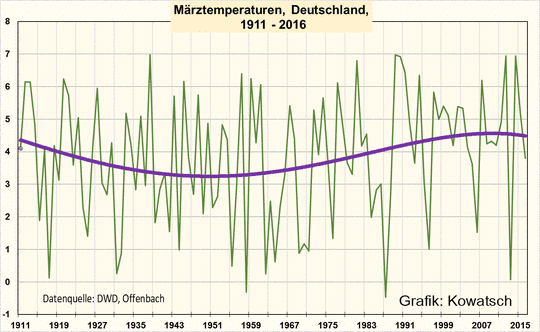

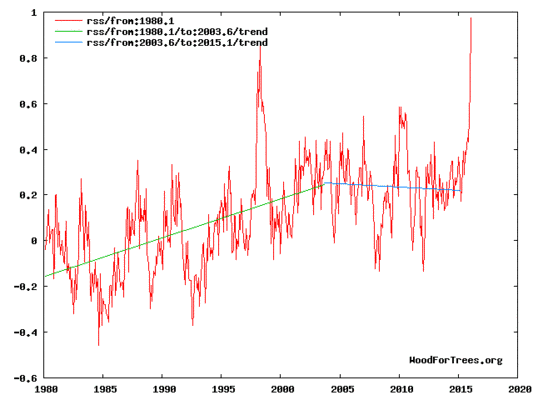

Wo befindet sich die aktuelle Erdtemperatur

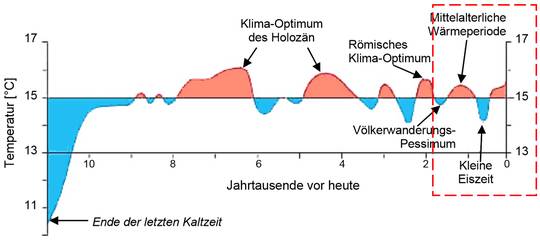

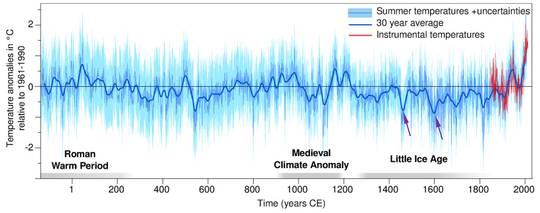

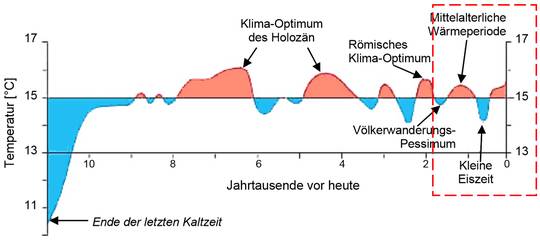

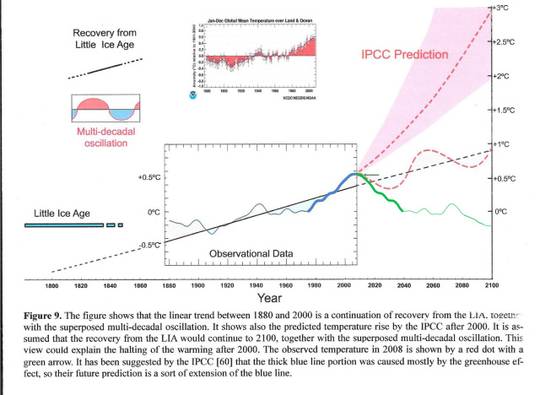

Nicht jeder Leser ist fit in der Klimahistorie. Deshalb anbei die Darstellung, wo sich das Klima aktuell befindet. Bild 1 zeigt den Verlauf seit dem Ende der letzten Eiszeit. Im Artikel selbst geht es um den rot eingegrenzten Bereich der vergangenen zwei Jahrtausende.

Bild 1 Bodennahe nordhemisphärische Mitteltemperaturen der letzten 11.000 Jahre nach Dansgaard (1969) und Schönwiese (1995), (aus KIHZ, 2000)

Welche Studie zeigt das richtige Klima der vergangenen 2000 Jahre

Wirklich weiß das wohl niemand. Die folgenden Darstellungen sollen zeigen, welche Unterschiede bestehen und dass sich das „Wissen“ und damit die Aussagen darüber regelmäßig ändern. als Konsequenz bedeutet dies allerdings auch, dass man durch Wahl der „geeigneten“ Darstellung inzwischen jede (gewünschte) Aussage problemlos mit Studien „belegen“ kann.

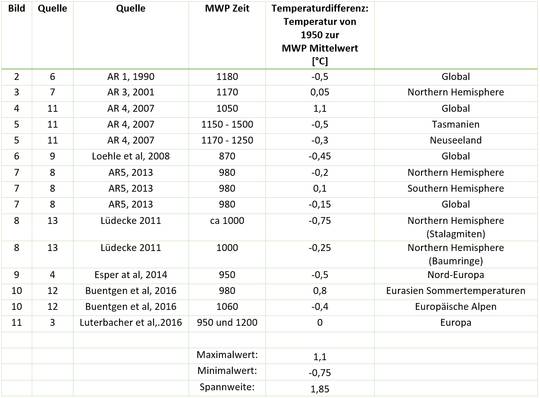

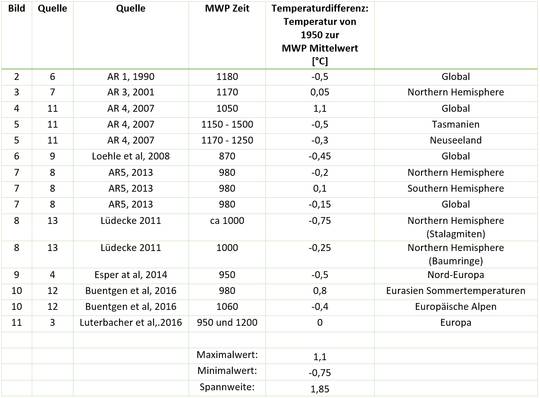

Um eine grobe Einstufung zu erhalten wurde versucht, in den im Artikel exemplarisch gezeigten Klima-Rekonstruktionsverläufen die Temperaturdifferenz vom Mittelwert der mittelalterlichen Warmzeit bis zum Jahr 1950 zu ermitteln. Die Versuche sind in den Bildern zugefügt und somit nachvollziehbar (sowie zusätzlich am Ende in einer Tabelle zusammengefasst). In vielen Kurven ist das allerdings nur recht ungenau möglich, weshalb diese Auswertung nur grobe Anhaltswerte zur Orientierung liefert. Das Schlussjahr 1950 wurde gewählt, da viele Rekonstruktionen knapp danach enden. Wer den Vergleich mit der ganz aktuellen Temperatur ergänzen möchte, muss also die Differenz seit dem Jahr 1950 dazu addieren.

Gelistet sind die Klimastudien ungefähr nach Publizierdatum, beginnend mit dem AR1 des IPCC von 1990 bis zu ganz aktuellen.

Listung von Klimarekonstruktionen der vergangenen 2000 Jahre

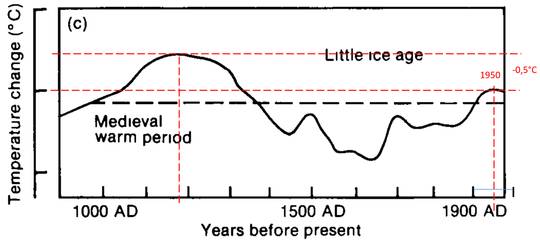

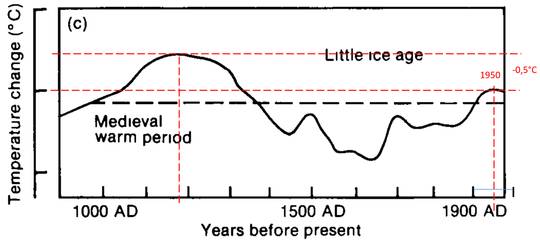

IPCC Report AR1 von 1990

Bild 2 [6] IPCC Report AR1 von 1990 Figure 7.1 (letztes von drei Bildern)

Bildtext: Schematic diagrams of global temperature variations since the Pleistocene on three time scales (a) the last million years (b) the last ten thousand years and (c) the last thousand years The dotted line nominally represents conditions near the beginning of the twentieth century

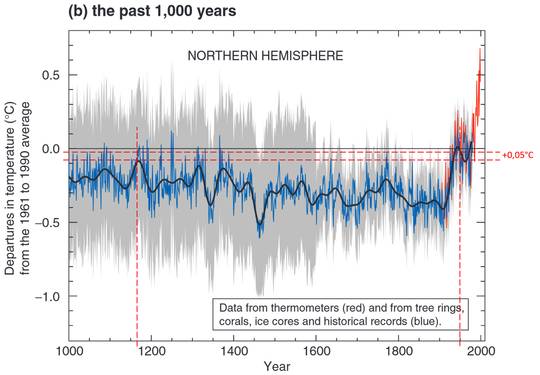

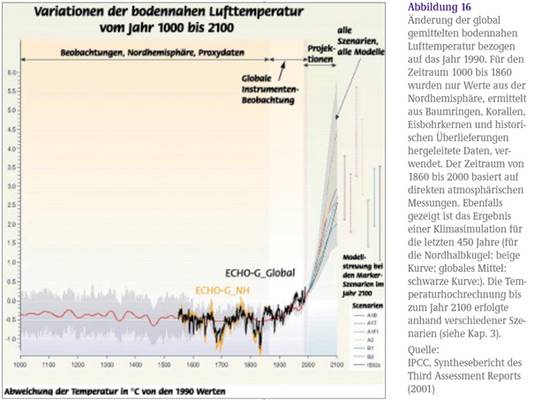

IPCC Report AR3 von 2001

Dieser Report zeigt die berühmte Hockeystick-Kurve. Die mittelalterliche Warmzeit ist fast verschwunden. Die aktuelle Warmperiode beginnt um 1900. Die Mittelwertbildung verschleiert den breiten (grauen) Unsicherheitsbereich.

Bild 3 [7] IPCC Report AR3 von 2001 Figure 1: Variations of the Earth’s surface temperature over the last millennium.

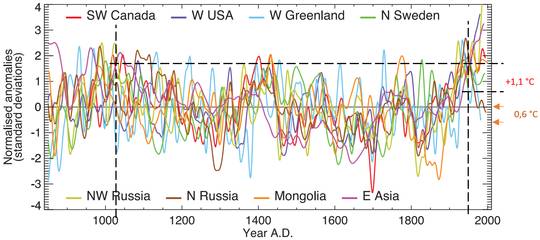

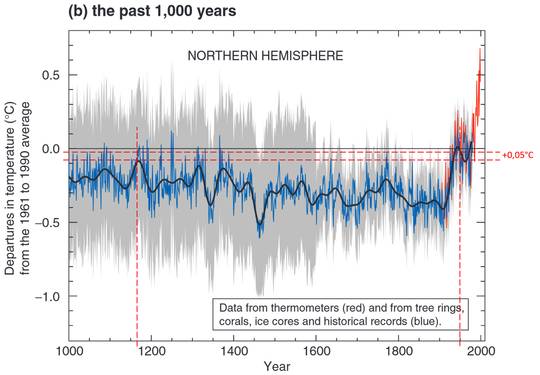

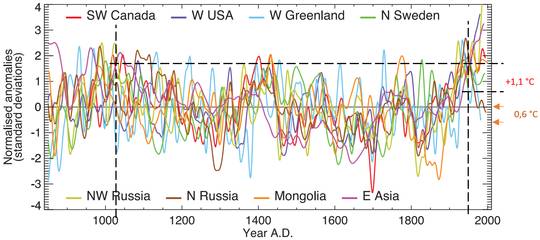

IPCC AR4 von 2007

Die Darstellung im AR4 zeigt exemplarisch die Variabilitäten verschiedener Proxyrekonstruktionen. Dieses „Spaghetti-Durcheinander“ wird durch Mittelwert-Bildung meistens „verschleiert“. Aus den verschiedenen Verläufen kann man sich jede Differenz heraussuchen, indem man die passende Gegend auswählt.

Gerade diese Grafik ist gut geeignet zur Darstellung des „Klimarettungsproblems“. Nach der IPCC-Lehre und dem letzten Klimagipfel darf sich die Erde bis 2100 maximal um 0,6 Grad erhöhen „Paris COP21 Verpflichtung“. Das kostet Deutschland Unsummen von Milliarden EUR durch die erzwungene CO2 Vermeidung. In der Grafik kann man erkennen, was 0,6 Grad (eingezeichnete) Veränderung bei der typischen Klimavariabilität bedeuten – nämlich nichts -, sowie dass es innerhalb von 100 Jahreszeiträumen regelmäßig natürlich bedingte Veränderungen größer 0,6 Grad gab.

Bild 4 [11] IPCC AR4 2007: Figure 1.

Bildtext: The heterogeneous nature of climate during the ‘Medieval Warm Period’ is illustrated by the wide spread of values exhibited by the individual records that have been used to reconstruct NH mean temperature. These consist of individual, or small regional averages of, proxy records collated from those used by Mann and Jones (2003), Esper et al. (2002) and Luckman and Wilson (2005), but exclude shorter series or those with no evidence of sensitivity to local temperature. These records have not been calibrated here, but each has been smoothed with a 20-year filter and scaled to have zero mean and unit standard deviation over the period 1001 to 1980.

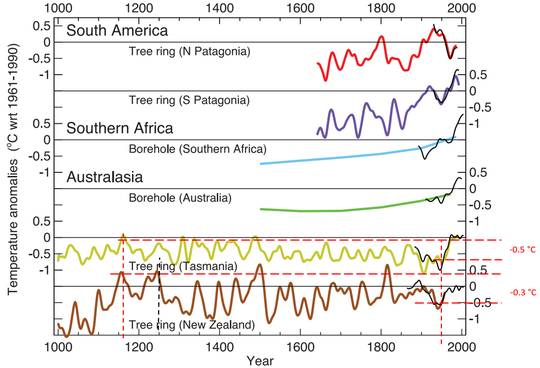

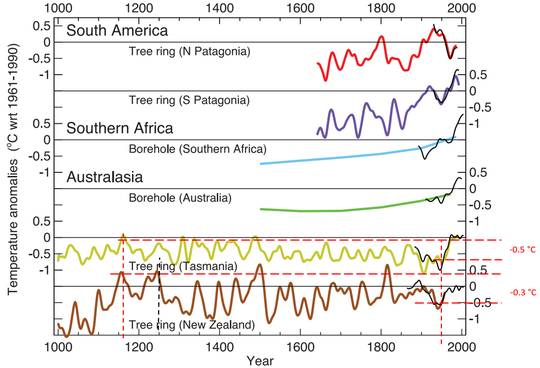

Weiter finden sich darin auch Rekonstruktionen zur Südhalbkugel (Tasmanien und Neuseeland). Diese scheint die Zyklen der Nordhalbkugel nicht durchlaufen zu haben. Anm.: „kaltesonne“ ist aktuell dabei dies anhand einer Recherche zu widerlegen.

Man beachte, dass es auf Neuseeland bereits um 1600 begann stetig wärmer zu werden.

Bild 5 [11] IPCC AR4 von 2007.Figure 6.12.

Bildtext: Temperature reconstructions for regions in the SH: two annual temperature series from South American tree ring data (Villalba et al., 2003); annual temperature estimates from borehole inversions for southern Africa and Australia (Huang et al, 2000); summer temperature series from Tasmania and New Zealand tree ring data (Cook et al., 2000, 2002a). The black curves show summer or annual instrumental temperatures for each region. All tree ring and instrumental series were smoothed with a 25-year filter and represent anomalies (°C) from the 1961 to 1990 mean (indicated by the horizontal lines).

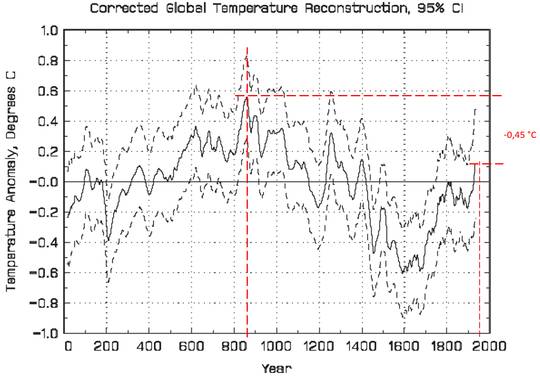

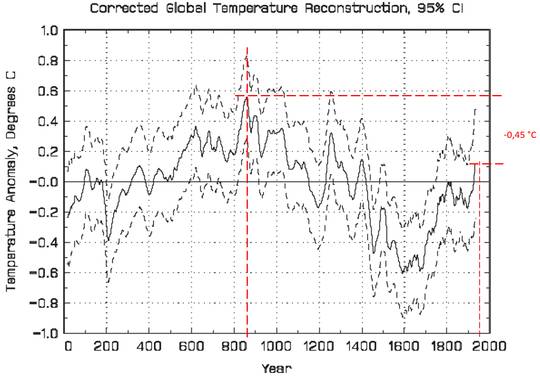

Loehle at al 2008

Nach dieser Studie war die mittelalterliche Warmzeit deutlich wärmer und die aktuelle Warmzeit beginnt eindeutig um 1600.

Bild 6 [9] Globaler historischer Klimaverlauf Jahr 0 … 1935

Bildtext: The Medieval Warming Period (MWP) was significantly warmer than the bimillennial average during most of the period 820 – 1040 AD. The Little Ice Age was significantly cooler than the average during most of 1440 – 1740 AD. The warmest tridecade of the MWP was warmer than the most recent tridecade, but not significantly so.

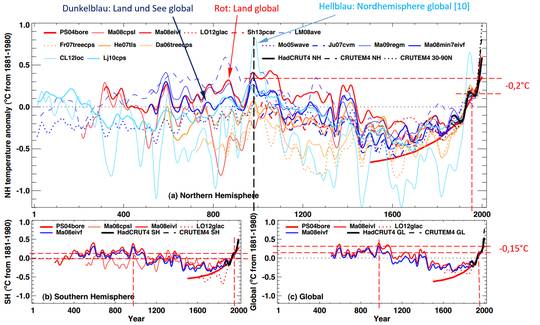

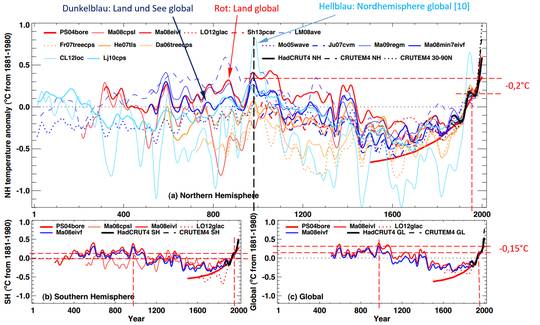

IPCC AR5 2013

Gegenüber dem AR4 zeigt die Darstellung nichts wirklich Neues, doch sind Mittelwerte enthalten. Weiterhin sieht man die vielen stark voneinander abweichenden Rekonstruktionsverläufe.

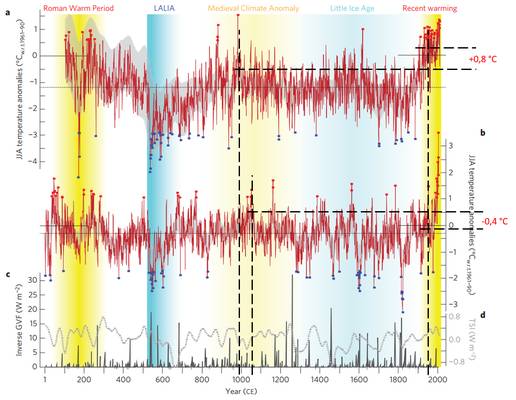

Bild 7 [8] Historischer Klimaverlauf. Quelle: AR5, Figure 5.7

Bildtext: Reconstructed (a) Northern Hemisphere and (b) Southern Hemisphere, and (c) global annual temperatures during the last 2000 years. Individual reconstructions (see Appendix 5.A.1 for further information about each one) are shown as indicated in the legends, grouped by colour according to their spatial representation (red: land-only all latitudes; orange: land-only extratropical latitudes; light blue: land and sea extra-tropical latitudes; dark blue: land and sea all latitudes) and instrumental temperatures shown in black (Hadley Centre/ Climatic Research Unit (CRU) gridded surface temperature-4 data set (HadCRUT4) land and sea, and CRU Gridded Dataset of Global Historical Near-Surface Air TEMperature Anomalies Over Land version 4 (CRUTEM4) land-only; Morice et al., 2012). All series represent anomalies (°C) from the 1881–1980 mean (horizontal dashed line) and have been smoothed with a fiter that reduces variations on time scales less than about 50 years.

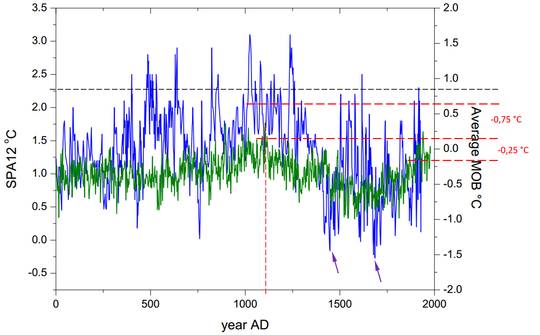

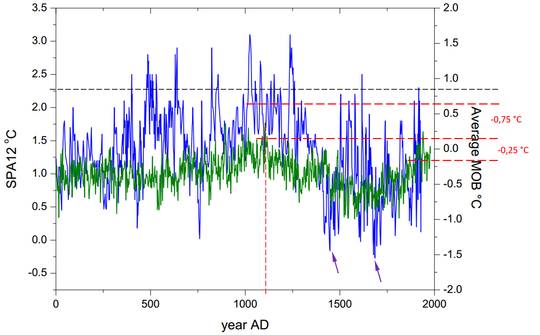

Horst-Joachim Lüdecke, Sept. 2011

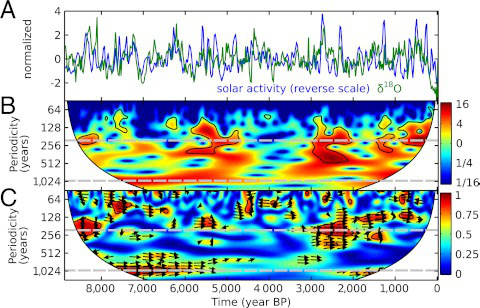

Das Besondere an dieser Publikation ist die Einbeziehung der Rekonstruktion von Tropfsteinanalysen des Professors Mangini der Uni Heidelberg (blaue Linien). Tropfsteinanalysen haben gegenüber den üblichen, auf biologischen Materialien basierenden wie Baumringanalysen (z.B. beim Hockeystick) den Vorteil, die Temperatur ganzjährig zu referenzieren und auch nicht Verzerrungen durch „Wetterstress“ oder Schädlinge abzubilden. Dieser Professor war unter den ersten, welche sich trauten öffentlich zu verkünden dass die mittelalterliche Warmzeit wärmer gewesen ist, als vom IPCC angegeben. Zusatzinformation lässt sich bei [15] nachlesen.

Auch diese Rekonstruktionen zeigen zudem den Beginn der aktuellen Warmzeit spätestens um 1600.

Bild 8 [13] Fig. 5. Temperaturrekonstruktionen aus Tropfsteinen (Blau) und biologichen Materialien (Grün)

Bildtext: (Color online) Reconstructed long-range annual records, SPA12 (blue) from a stalagmite and MOB (green) from a stack of tree rings in the northern hemisphere and further biological proxies (as an anomaly). The variance of MOB is roughly seven times smaller than for SPA12. In both records, the medieval warm period and the Maunder Minimum can be clearly identified.

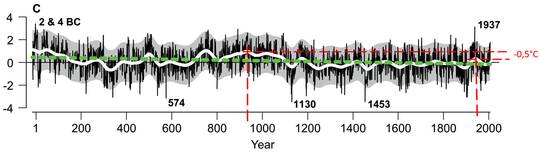

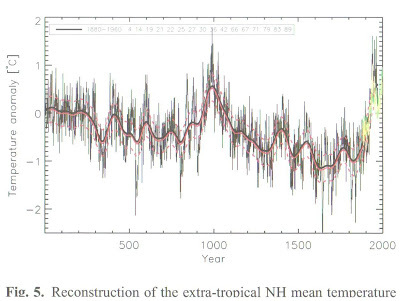

ESPER et al, 2014: Northern European summer temperature variations

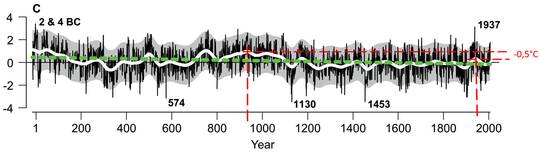

Auch diese Studie zeigt eine deutlich wärmere mittelalterliche Warmzeit. Man beachte die im Bereich von 4 °C liegende Spannweite der Temperaturen und die Extremwerte (mit Jahreszahlen gekennzeichnet). Zudem steht in der Studie:

[4] The reconstruction has centennial-scale variations superimposed on this trend, indicating conditions during Medieval and Roman times were probably warmer than in the late 20th century.

Bild 9 [4] Figure 5 (Auszug) Rekonstruierter Temperaturverlauf der letzten 2000 Jahre der nordeuropäischen Sommertemperatur

Bildtext: N-Eur temperature reconstruction at annual resolution (black) and after smoothing using a 100-year filter (white). Green curve is a linear regression fit to the annually resolved data over the 17 BC to AD 2006 period. Grey area indicates the smoothed standard error (2SE) of the calibration model, using variable chronology replicated error estimates (from B). Dates indicate the three coldest and warmest years over the past two millennia. This figure is available in colour online at wileyonlinelibrary.com.

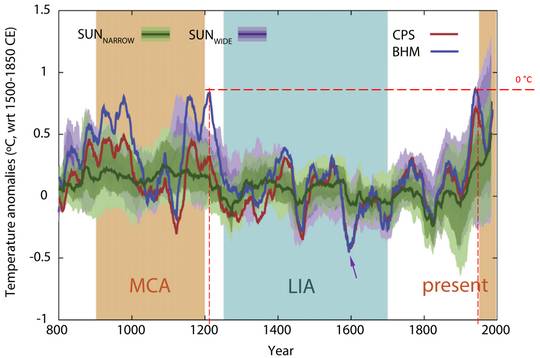

Buentgen et al. 2016

Dies ist eine ganz aktuelle Studie.

Auffallend ist die große Temperaturvariabilität der Jahreswerte um mehrere Grad. Man beachte, dass die Sommertemperatur der Alpen von 1700 bis aktuell deutlich vom „typischen“ Klimaverlauf abweicht.

Bild 10 [12] Figure 2, vom Autor ergänzt

Bildtext: Eurasian summer temperature variability. a,b, Reconstructed temperatures from the Russian Altai (a) and the European Alps5 (b), with blue and red squares indicating (51/47) positive and (53/57) negative annual extremes (>2 standard deviations), respectively. Grey background shadings denote reconstruction uncertainty after 80-year low-pass filtering (Supplementary Fig. 9). c,d, Ice-core-derived global estimates of volcanic14 (GVF; dark grey; c) and total solar irradiance17 (TSI; light dashed grey; d) forcing. Black dashed lines refer to the long-term reconstruction mean of the Common Era.

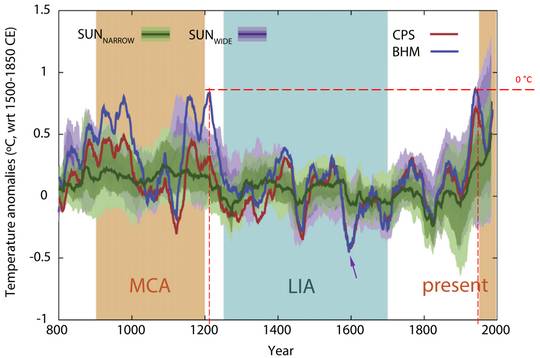

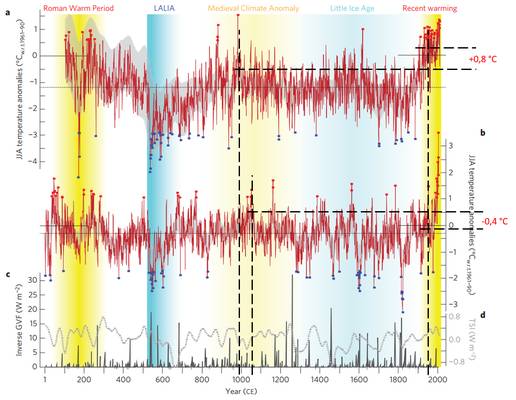

Luterbacher et al, 29.01.2016: European summer temperatures since Roman times

Diese ebenfalls ganz aktuelle Studie ist aus mehreren Gründen interessant. Es steht darin, dass selbst die aktuellen mittleren Sommertemperaturen die der historischen Warmzeiten nicht übersteigt, zumindest nicht statistisch signifikant.

[3] Our reconstructions compare well with independent instrumental and proxy-based temperature estimates, but suggest a larger amplitude in summer temperature variability than previously reported. Both CPS and BHM reconstructions indicate that the mean 20th century European summer temperature was not significantly different from some earlier centuries, including the 1st, 2nd, 8th and 10th centuries CE. The 1st century(in BHM also the 10th century) may even have been slightly warmer than the 20th century, but the difference is not statistically significant.

… The warmest century in both the CPS and BHM reconstructions is the 1st century CE (for BHM also the 10th century).

Allerdings wird dazu dann eine Einschränkung gemacht, dass die 30-Jahresmittel dagegen früher nicht wärmer waren.

[3] Comparing each 50 yr period with the 1951–2000 period reveals a similar pattern. Recent summers, however, have been unusually warm in the context of the last two millennia and there are no 30 yr periods in either reconstruction that exceed the mean average European summer temperature of the last 3 decades (1986–2015 CE).

Weiter steht in der Studie, dass die Klimamodelle die Verläufe nicht ausreichend genau simulieren können – also stark mängelbehaftet sind. Und etwas zusätzlich Interessantes: Die Sommertemperaturen waren früher weit variabler, als man bisher annahm.

[3] Our BHM-based reconstruction shows more pronounced changes in mean summer temperatures over Europe than previously reported

Bild 11 [3] Verlauf der sommerlichen Maximaltemperaturen Europa. BHM (Dunkelblau) und CPS (Rot): rekonstruierter Temperaturverlauf. Andere Farben: rückwirkende Simulationstests.

Bildtext: Simulated and reconstructed European summer land temperature anomalies (with respect to 1500–1850 CE) for the last 1200 yr, smoothed with a 31 yr moving average filter. BHM (CPS) reconstructed temperatures are shown in blue (red) over the spread of model runs. Simulations are distinguished by solar forcing: stronger (SUNWIDE, purple; TSI change from the LMM to present >0.23%) and weaker (SUNNARROW, green; TSI change from the LMM to present <0.1%). The ensemble mean (heavy line) and the two bands accounting for 50% and 80% (shading) of the spread are shown for the model ensemble (see SOM for further details).

Die zwei Darstellungen in der Studie zur historischen Temperatur (es ist heute nicht wärmer als früher, aber es war früher doch wärmer sofern man anders mittelt) führen zur Möglichkeit unterschiedlicher Interpretationen. Die Pressemitteilung der Uni hat sie voll genutzt und daraus einen Klimaalarm generiert:

Justus-Liebig-Universität Giessen. 29. Januar 2016 Pressemitteilung [2]:

Europäische Sommer so heiß wie seit über 2000 Jahren nicht

Klimaretter.Info, das Portal für ökopolitisch korrekte Darstellungen nahm dies sofort auf und informierte ebenfalls alarmistisch:

[14] Klimaretter.Info. Benjamin von Brackel (Anm.: Politikwissenschaftler), 29. Januar 2016:

Selbst die Römer hatten’s nicht so warm

Unsere Sommer sind die wärmsten seit 2.000 Jahren in Europa. Das zeigen neue Baumring-Analysen. Die Temperaturrekorde ließen sich nicht mehr mit natürlichen Schwankungen erklären, folgern Forscher, sondern nur mit dem menschengemachten Klimawandel.*

*Anmerkung des Autors: Diese letzte Aussage ist in der Studie selbst nirgends auch nur im Ansatz hinterlegt. Man hat den Eindruck, bei Klimaretter.Info hat niemand die Studie selbst eingesehen.

„kaltesonne“ hat die Studie ebenfalls rezensiert. Dort wurde sie aber wirklich durchgesehen und detailliert berichtet. Es lohnt sich, diese Rezension selbst zu lesen: „Universität Gießen findet eklatante Unterschiede zwischen realer und simulierter Temperaturentwicklung während der letzten 2000 Jahre in Europa: Klimamodelle müssen auf den Prüfstand“.

kaltesonne – Rezension (Auszug)[1]:

Zu den Autoren der Studie gehören neben Luterbacher u.a. auch Fredrik Ljungqvist, Ulf Büntgen und Jan Esper, die sich in der Vergangenheit sehr um eine seriösere Richtung in den Klimawisenschaften verdient gemacht haben. Daher verwundert der reißerische Titel der Pressemitteilung und die krampfhaft in den Text eingesprenkelten Klimaalarm-Floskeln schon. War das Buckeln vor dem IPCC und der verkrampfte Hinweis auf die angeblich (vollständig) vom Menschen herbeigeführte aktuelle Erwärmung wirklich notwendig? Waren diese Stil-Elemente quasi als wissenschaftliche Lebensversicherung notwendig, um überhaupt mit dieser Studie in die Öffentlichkeit gehen zu können, ohne von IPCC-Hardlinern abgestraft zu werden?

Wir begeben uns auf Spurensuche. Was ist dran am Hitzewellenalarm? Zunächst fällt auf, dass der Titel der Publikation im Gegensatz zur Pressemitteilung auffällig neutral gewählt wurde:

European summer temperatures since Roman times

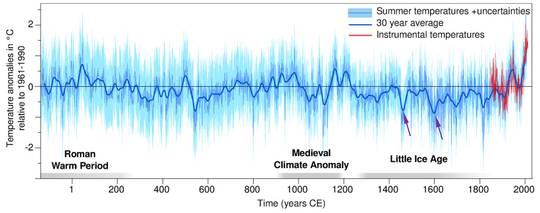

An dieser Stelle sollten wir uns die Hauptabbildung aus Pressemitteilung näher anschauen. Interessanterweise taucht die Abbildung in der Arbeit selber gar nicht auf, weder im Haupttext, noch im Datensupplement. Zu erkennen ist die in der Pressemeldung angeführte starke natürliche Variabilität der Temperaturen. Die bekannte Abfolge der Römischen Wärmeperiode, Kälteperiode der Völkerwanderungszeit, Mittelalterlichen Wärmeperiode, Kleinen Eiszeit und Modernen Wärmeperiode ist gut zu erkennen. Aus irgendeinem Grund bleiben die Begriffe jedoch in der Pressemitteilung unerwähnt.

Auffällig ist weiterhin die überlagerte knallig-rote Linie, welche die Entwicklung der letzten Jahrzehnte besonders bedrohlich erscheinen läßt. Eine fragwürdige Suggestivmethode. Das Ende der blauen 30-Jahres-Mittelwertlinie ist vom rot so stark überstrahlt, dass man es gar nicht richtig erkennt. Erst wenn man ganz genau hinschaut, wird deutlich, dass die blaue Linie lediglich das Niveau der Mittelalterlichen Wärmeperiode um 1200 n.Chr. und der Römischen Wärmephase um 50 n. Chr. erreicht.

Bild 12 [3] Grafik: CC BY-SA 4.0 J.P. Werner/EuroMed2k Members.

Und genau dies steht dann wenig überraschend auch in der Kurzfassung der Arbeit:

In der Realität fand die Gruppe um Luterbacher also das genaue Gegenteil von dem was in ihrer eigenen Pressemitteilung behauptet wird. Die Temperaturen des 20. Jahrhundert unterscheiden sich nicht von den vorangegangenen Wärmephasen. Die Römische Wärmeperiode könnte sogar noch einen Tick wärmer gewesen sein, konzedieren Luterbacher und Kollegen.

Zusammenfassung der Klimarekonstruktionen

In der folgenden Tabelle sind die Ergebnisse der gezeigten Studien / Berichte zusammengefasst:

Bild 13 Zusammenfassung der bisher dargestellten Klimarekonstruktionen

Beim Betrachten der Kurven fällt auf, dass sich bereits in der Vergangenheit in kurzen Zeiträumen gewaltige Temperaturschwankungen ereignet haben. Ob die Aktuelle daraus als „einmalig“ hervorsticht, hängt von der verwendeten Publizierung und oft auch vom Maßstab ab.

Je mehr man sich die Klimakurven ansieht, umso stärker wird allerdings der Verdacht, dass sich die Genauigkeit der Proxirekonstruktionen über die Jahrzehnte nicht wirklich verbessert hat. Zumindest reicht sie nicht aus, um die Frage, ob es zur mittelalterlichen Warmzeit wärmer oder kälter war damit sicher zu beantworten.

Dies ist auch verständlich. Eine moderne, sauber geeichte elektronische Wetterstation misst in idealer Umgebung gerade einmal auf +-0,2 °C genau. Eine Rekonstruktion über 1.000 – 2.000 Jahre zurück welche noch zusätzlich eine Proxi-Kalibrierung benötigt, soll dann großflächig Temperaturdifferenzen auf 0,2 … 0,5 Grad genau bestimmen. Das ist nicht möglich. Indem man aber Computer stur rechnen lässt, werden solche Ergebnisse präsentiert.

Auch die Zeitzuordnung scheint überaus problematisch zu sein, wie man an den vielen teils erheblichen Zeit-Verschiebungen zwischen den Kurven sehen kann. Wenn aber Temperatur und Zeitzuordnung nicht stimmen, entstehen beim Berechnen der Regressionen echte mathematische Fehler „Über die unsachgemäße Anwendung der Regression kleinster Quadrate“. Auch die Summenkurve kann dann natürlich nicht mehr stimmen.

Ein weiteres Thema bei den jüngeren Publizierungen ist die rückwirkende Simulationsprüfung. Immer öfter wird erkannt (Bsp. [3]), dass die Rückprojektionen der Klimamodelle falsche Ergebnisse liefern. Damit ist aber auch klar, dass sie die Zukunft genau so falsch projizieren (werden).

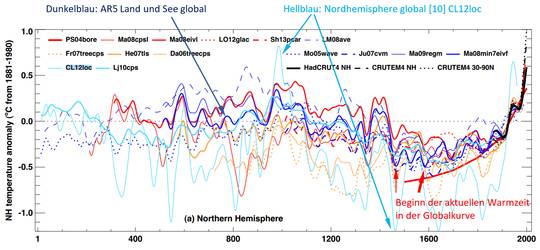

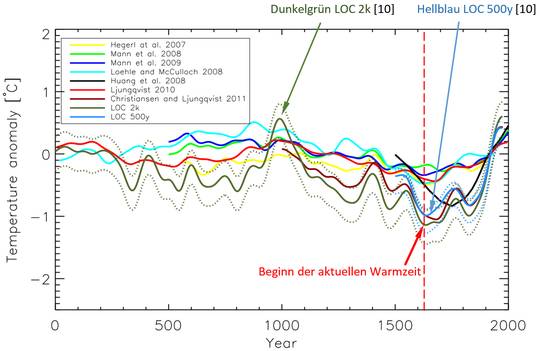

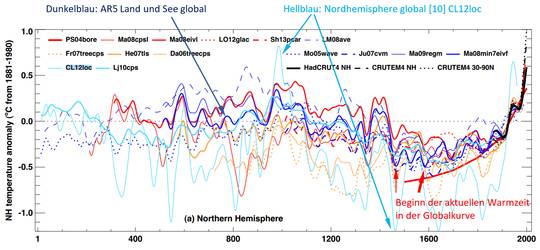

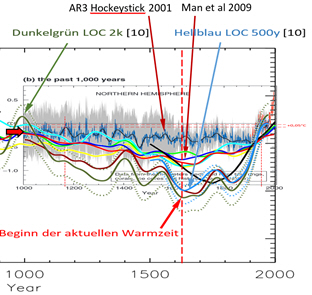

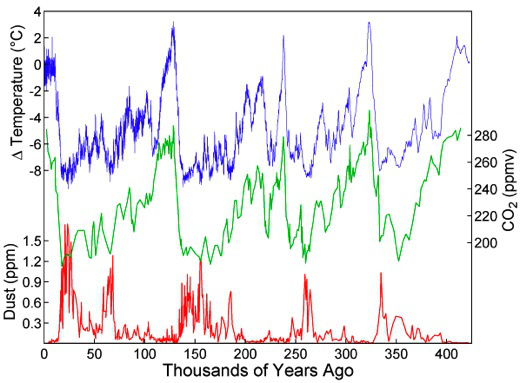

Diskussion der Klimarekonstruktion CL12loc aus dem AR5

Betrachten wir noch einmal das Bild aus dem IPCC AR5 Bericht von 2013.

Bild 14 [8] Historischer Klimaverlauf. Quelle: AR5 von 2013, Figure 5.7

In dieser beispielhaften „Spaghettisammlung“ verschiedener (möglicher) Klimaverläufe sticht die hellblaue Rekonstruktion durch ihre enorme Variabilität hervor. Diese Rekonstruktion CL12loc stammt aus der Studie*:

[10]*: Christiansen and Ljungqvist, 18.04.2012: The extra-tropical Northern Hemisphere temperature in the last two millennia: reconstructions of low-frequency variability

*Im AR5 wird über die Bildinfo CL12oc auf eine Quelle „Christiansen and Ljungqvist (2012)“ verweisen. Der Autor hat in allen (für ihn einsehbaren) Studien dieser Autoren keine Kurve mit der gleichen Temperatur im Jahr 1460 und 1630 gefunden wie sie die hellblaue Kurve ausweist. Deshalb wir in den weiteren Ausführungen auf die Darstellungen aus Studien beider Autoren von 2012 und 2010 Bezug genommen. Die Unterschiede haben keinen Einfluss auf das Interpretationsergebnis.

Eine Anfrage beim deutschen IPCC-Büro zur Quelle dieser Klimarekonstruktion läuft, ist aber noch nicht beantwortet.

In der besagten Studie wurden anhand umfangreichen Proximaterials die Klimaverläufe der letzten 2000 und der letzten 500 Jahre rekonstruiert.

Die wichtigen Ergebnisse draus sind:

Die mittelalterliche Warmzeit war um 0,6 Grad wärmer als bisher angenommen und die nach-mittelalterliche Kaltzeit um -1 Grad kälter:

[10] The two-millennia long reconstruction shows a well defined Medieval Warm Period, with a peak warming

ca. 950–1050 AD reaching 0.6 ◦C relative to the reference period 1880–1960 AD.

The 500-yr long reconstruction confirms previous results obtained with the LOC method applied to a smaller proxy compilation; in particular it shows the Little Ice Age cumulating in 1580–1720 AD with a temperature minimum of −1.0 ◦C below the reference period.

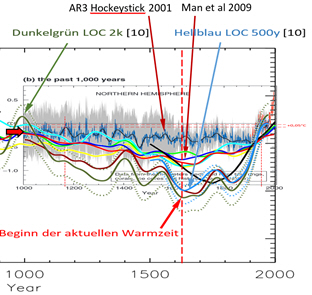

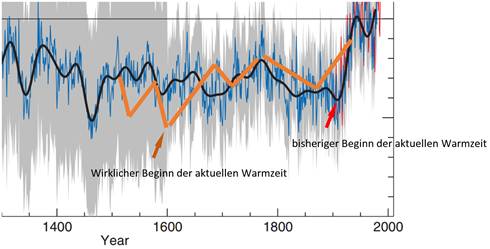

Nachdem damit ersichtlich ist, dass niemand genau weiß, wie warm die mittelalterliche Warmzeit genau war, sie aber nach den aktuellen Erkenntnissen sicher wärmer war als in der Hockeystick-Kurve angegeben, kommt ein zweiter Aspekt zum Tragen, der Beginn der aktuellen Warmzeit.

Nach der neueren Klimarekonstruktion hat die aktuelle Warmzeit spätestens um 1650 also mindestens 200 Jahre früher als die Industrialisierung begonnen

CO2 kann damit als „Starter“ der aktuellen Warmzeit ausgeschlossen werden

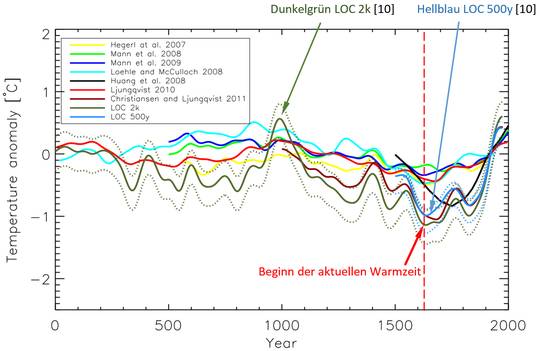

Im folgenden Bild Nr. 15 sieht man die Rekonstruktionen nochmals im Detail im Vergleich mit älteren Klimakurven. Neben dem dass die nach-mittelalterliche Kaltzeit erheblich kälter war als bisher angenommen, fällt auf dass danach die aktuelle Warmzeit bereits um 1650 beginn und nicht erst gegen 1850. Dadurch sehen die Verläufe – Beginn der mittelalterlichen Warmzeit und der aktuellen – sehr ähnlich aus und ein menschlicher Einfluss ist weder erforderlich noch ersichtlich.

Anm.: im Bild 14 (AR5) ist die Minimaltemperatur bereits um 1460, also fast 200 Jahre früher erreicht worden. Die in der Veröffentlichung [10] hinterlegten Grafiken weichen vom IPCC-Bild an einigen Stellen deutlich ab. Z.B. sind die ausgeprägten Minimas um ca. 550 und 1460 darin nicht in der Größenordnung zu finden. Nach Bild 14 würde die aktuelle Warmzeit bereits um 1460, also nochmals fast 200 Jahre früher (in Summe um 400 Jahre) beginnen.

Bild 15 [10] Vergleich der neuen Klimarekonstruktionen (LOC 2k und LOC 500y) mit anderen Rekonstruktionen aus dem AR5

Bildtext: Fig. 6. Some previous temperature reconstructions, (Hegerl et al., 2007; Loehle and McCulloch, 2008; Huang et al., 2008; Mann

et al., 2008, 2009; Ljungqvist, 2010; Christiansen and Ljungqvist, 2011) published subsequently to the IPCC Fourth Assessment Report (Solomon et al., 2007) shown together with the LOC reconstructions of the present paper. All reconstructions are centered

to zero mean in the 1880–1960 AD period and have been 50-yr smoothed with a Gaussian filter. The confidence intervals of the

LOC reconstructions of the present paper (from Figs. 5 and 8) are also shown (dashed curves).

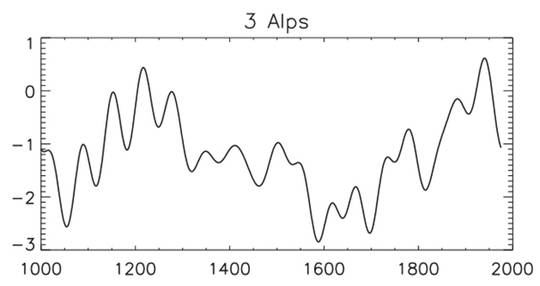

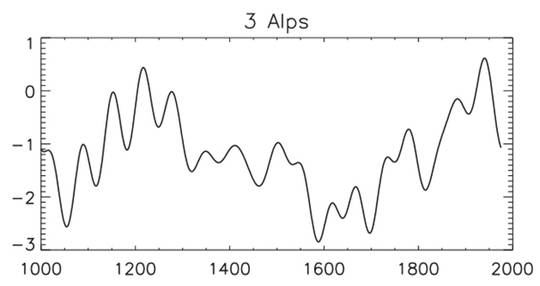

Noch deutlicher zeigt sich dies anhand eines Proxis der Alpen im folgenden Bild.

Bild 16 [15] Proxi der Alpen aus FIG. 8. Local temperature reconstructions (K) based on the proxies in Table 1 and HadCRUT2v, calibration period AD 1880–1960

Diese Aussage findet sich aber nicht nur in [10], sondern parallel in anderen Rekonstruktionen sowie auch in der Haupt-Mittelwertlinie des AR5 selbst:

Klimarekonstruktionen mit einem früheren Beginn der aktuellen Warmzeit:

· Bild 8: ca. 1550 und 1650 (violette Pfeile)

· Bild 11: 1600 (violetter Pfeil)

· Bild 12: ca. 1450 und 1600 ((violette Pfeile)

· Bild 14: 1450 und 1600 (rote Pfeile) in der Hauptlinie des AR5 für Land und See global (siehe dazu auch Bild (17)

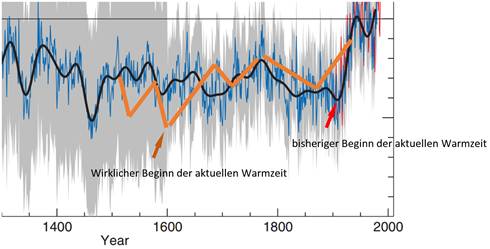

Wird die Klimageschichte umgeschrieben?

Wenn die Verfasser der Studie [10] damit recht haben dass die bisherige Methodik der Proxiauswertung falsche Ergebnisse lieferte (und der Verlauf LOC 2k der wirklich richtige ist), was sich auch anhand der Verläufe anderer Rekonstruktionen in der Listung des vorhergehenden Absatzes „Klimarekonstruktionen mit einer Verschiebung des Beginns der aktuellen Warmzeit“ bestätigt, muss die anthropogene Beeinflussung der Klimageschichte umgeschrieben werden.

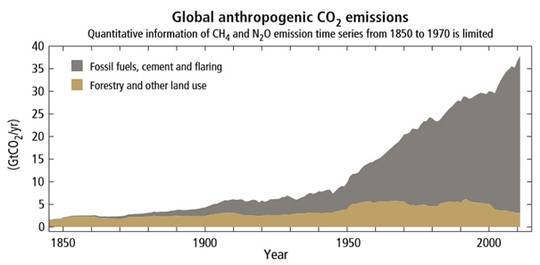

Allerdings findet sich dazu noch kaum eine Diskussion, obwohl es sogar im AR5 offensichtlich ist wie Bild 17 zeigt. Der Autor hat darin den relevanten Teil der Hockeystick-Kurve (Bild 3) mit der Mittelwert-Linie „Land und See global“ aus dem AR5 (Bild 14) überlagert. Die Begründung, dass die aktuelle Warmzeit ausschließlich durch anthropogenes CO2 nach 1800 (Bild 18) gestartet wurde ist demnach bereits im AR5 selbst widerlegt.

Bild 17 Auszug der Hockeystick-Kurve mit vom Autor zugefügtem Verlauf (hellbraune Linien) der Rekonstruktion „Land und See global“ aus dem AR5

Noch offensichtlicher wird die Diskrepanz, wenn man den Hockeystick im gleichen Maßstab zu den neueren Proxianalysen kopiert (Bild 17). Dass dieser durch neuere Proxis endgültig überholt ist, wird offensichtlich. Der Hockeystick wurde zwar 2009 vom Ersteller deutlich korrigiert (Man et al 2009) ist aber auch damit noch weit entfernt von denen der aktuellen Rekonstruktionen.

Bild 17.1 Hockeystick (Bild 3) und neuere Proxis (Bild 15) im gleichen Maßstab überlagert

Nun weiss man natürlich nicht, welches die alleine richtige Kurve ist. Aber die drastischen Unterschiede belegen, dass das Thema nicht entfernt „gesettelt“ ist, sondern dringend einer neuen Diskussion bedarf, auch wenn das PIC eine solche für absolut unnötig hält (siehe Zitierung von Prof. Rahmstorf am Ende des Artikels). Explosiv ist das Thema allemal. Die schöne, glatte Verlaufskurve des Hockeystick war (neben dem Beginn der Erwärmung ab der Industrialisierung) auch der Beleg, dass das Klima keine Sprünge gemacht hätte und die aktuelle, starke Erwärmung somit unnatürlich sein muss. Wenn von dieser schön geraden Temperaturlinie jedoch nichts mehr übrig bleibt, ist auch diese Hypothese hinfällig.

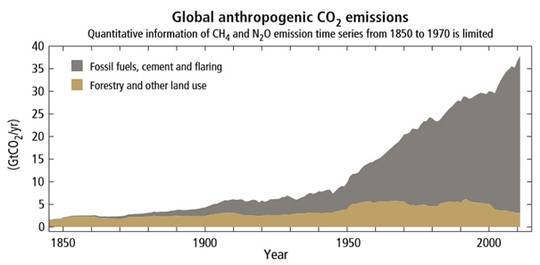

Bild 18 CO2-Emissionen (Bildauszug). Quelle: AR5 Climate Change 2014 Synthesis Report

Bildtext (Auszug): Figure 1.5 | Annual global anthropogenic carbon dioxide (CO2) emissions (gigatonne of CO2-equivalent per year, GtCO2/yr) from fossil fuel combustion, cement production and flaring, and forestry and other land use (FOLU), 1750–2011.

Dass die anthropogene CO2-Klimatheorie damit schnell in den Mülleimer der Geschichte wandert, wird allerdings kaum passieren. Zu viele Reputationen und vor allem Geld werden es noch lange Zeit verhindern. Aber aufhalten wird man es nicht mehr können.

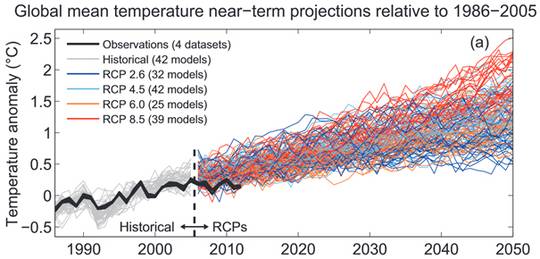

Klimazukunft

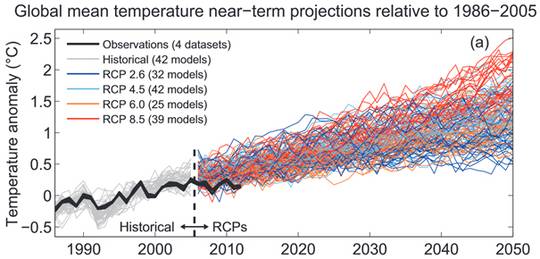

Klimamodelle werden aufgrund der Proxis parametriert. Wenn schon die Vergangenheit praktisch nicht (in der erforderlichen Genauigkeit) rekonstruierbar ist, kann auch die Zukunft daraus nicht richtig berechnet werden. Wer es sehen will, kann es im Bild 18 erkennen. Wer würde ahnen dass es sich dabei um eine Originalgrafik aus dem IPCC AR5 handelt.

Bild 19 Projektionskurven. Quelle: AR5 2013 Figure TS.14. Seite 87

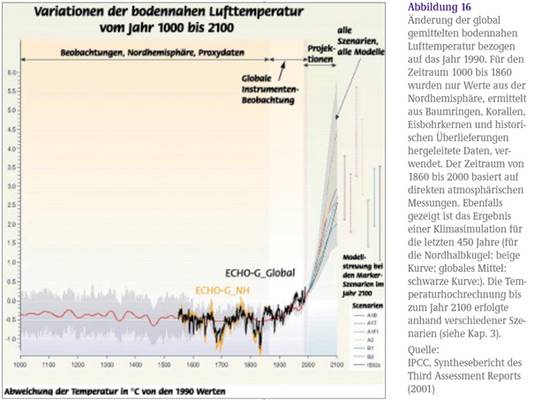

Unser Bundesministerium für Bildung und Forschung zeigt da lieber die politisch „richtige“ Darstellung (Bild 20). Aktuell kann man dort immer noch eine Broschüre „Herausforderung Klimawandel“ laden. Im Begleittext steht dazu:

„Das numerische Experiment zeigt, dass das Klimamodell die so rekonstruierte globale Klimaentwicklung (Abb. 16) und insbesondere das Phänomen der sogenannten „Kleinen Eiszeit” in Europa recht realistisch zu simulieren vermag“.

Dass inzwischen viele neue Studien aufzeigen, dass diese Aussage „realistisch zu simulieren vermag“ überhaupt nicht stimmt sowie die aktuellen Rekonstruktionen der Temperaturen im Mittelalter inzwischen deutlich anders aussehen, soll der Bürger wohl nicht über ein für Bildung und Forschung zuständiges Ministerium erfahren.

Bild 20 Bundesministerium für Bildung und Forschung, Broschüre: Herausforderung Klimawandel, Abbildung 16

Das Portal für streng klimatreue Information – Klimaretter.info – sieht auch keinerlei Handlungsbedarf und lobt zudem weiterhin die Hockeystickkurve und deren Autor „Paris ist die wahrscheinlich letzte Chance“.

Und damit liegt klimaretter.info haargenau auf der Linie des PIK.

SciLogs Klimalounge

Paläoklima: Die letzten 2000 Jahre

15. Mai 2013 von Stefan Rahmstorf in Paläoklima (Besprechung des Pages 2k Projektes)

Stefan Rahmstorf : Paläoklima: Die letzten 2000 Jahre – Im globalen Durchschnitt gleicht die neue Rekonstruktion fast aufs Haar dem bekannten „Hockeyschläger“, der vor fünfzehn Jahren erstellten ersten derartigen Rekonstruktion.

Nachspann

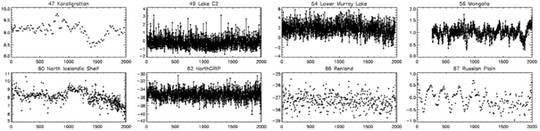

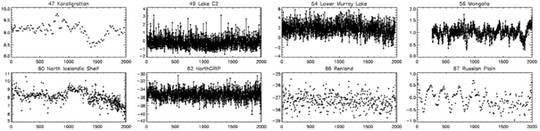

Beispiele von Klimaproxis

Um Lesern welche sich mit der Thematik weniger auskennen ein Gefühl zu geben, wie Klimaproxis aussehen, anbei ein Auszug solcher Proxis aus [10]. Nur die Mittelwertbildung macht daraus die bekannten scharfen Linien – und der Computer berechnet auch treu dazu den „Vertrauensbereich“. Und beim Klimagipfel (er-)finden daraus 40.000 „Fachleute“ durch Diskussionen und Abstimmen die wahre Temperatur. Man muss nur fest daran glauben, dass Masse (und Computerprogramme) immer die Wahrheit (er-)kennen.

Bild 21 [10] Beispiele von Proxis (Auszug aus Fig. 3 der Studie)

Quellen

[1]

kaltesonne 08.03.2016: Universität Gießen findet eklatante Unterschiede zwischen realer und simulierter Temperaturentwicklung während der letzten 2000 Jahre in Europa: Klimamodelle müssen auf den Prüfstand

[2]

Justus Liebig Universität Giessen, Pressemitteilung: Europäische Sommer so heiß wie seit über 2000 Jahren nicht

https://www.uni-giessen.de/ueber-uns/pressestelle/pm/pm19-16

[3]

Luterbacher et al, 29.01.2016: European summer temperatures since Roman times

[4]

JOURNAL OF QUATERNARY SCIENCE (2014) 29(5) 487–494, ESPER et al: Northern European summer temperature variations

over the Common Era from integrated tree-ring density records

[5]

TU Berlin. Erläuterung zur Vorlesung TWK an der TU-Berlin Inst. für Ökologie: Rekonstruktion der mittleren Temperatur auf der Nord-Halbkugel in den vergangenen 1.000 bis 2.000 Jahren.

http://lv-twk.oekosys.tu-berlin.de//project/lv-twk/002-holozaen-2000jahre.htm

[6]

IPCC Report AR 1, 1990

[7]

IPCC AR 3 WG 1, 2001. Climate Change 2001 THE SCIENTIFIC BASIS

[8]

IPCC AR5 WG1, 2013. Climate Change 2013, The Physical Science Basis

[9]

Loehle at al:Correction to: A 2000-YEAR GLOBAL TEMPERATURE RECONSTRUCTION BASED ON NON-TREE RING PROXIES ENERGY & ENVIRONMENT VOLUME 19 No. 1 2008

[10]

Clim. Past, 8, 765–786, 2012. Christiansen and Ljungqvist, 18.04.2012: The extra-tropical Northern Hemisphere temperature in the last two millennia: reconstructions of low-frequency variability

[11]

IPCC AR4 WG 1, 2007: The Physical Science Basis: Hemispheric Temperatures in the ‘Medieval Warm Period’

[12]

Buentgen et al.2016_NatureGS: Cooling and societal change during the Late Antique Little Ice Age from 536 to around 660 AD

[13]

Horst-Joachim Lüdecke Sept. 2011: Long-Term Instrumental and Reconstructed Temperature Records Contradict Anthropogenic Global Warming, Energy & Environment 22, 6, 2011, arxiv.org/PS_cache/arxiv/pdf/1110/1110.1841v1.pdf

[14]

klimaretter.info, 29. Januar 2016: Selbst die Römer hatten’s nicht so warm

http://www.klimaretter.info/forschung/hintergrund/20549-selbst-die-roemer-hattens-nicht-so-warm

[15]

CHRISTIANSEN AND LJUNGQVIST DECEMBER 2011: Reconstruction of the Extratropical NH Mean Temperature over the Last Millennium with a Method that Preserves Low-Frequency Variability

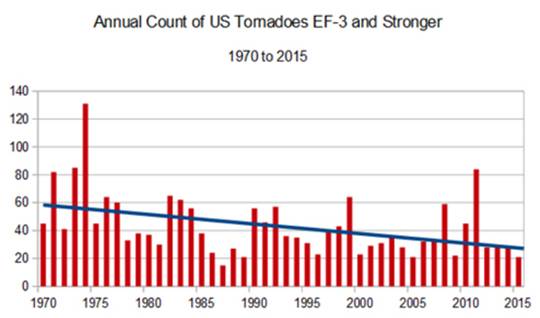

Bild 1 [2] Jährliche Anzahl schwerer Tornados seit 1970

Bild 1 [2] Jährliche Anzahl schwerer Tornados seit 1970