Grüner Staatssekretär Rainer Baake – „Mastermind“ der Energiewende, Teil II

♦ Zwischen 1974 und 1978 war er Aktivist in der Community Organizer Szene von Chicago, die versuchte, durch Infiltration von Regierungen, Verbänden und Instituten, ihre Vorstellungen zu sozialen Reformen mit möglichst vielen Agitationen zu beeinflussen, finanziert durch Stiftungen.

♦ Seit seiner 1983 bestehenden Mitgliedschaft bei den Grünen und als Unterstützer der Öko-Bewegung zeigte er sich von Anfang an als ein ideologisch geschulter Anti-Nuc- und Pro-Energiewende Aktivist.

♦ Als Beamteter Staatssekretär im hessischen Umweltministerium (1991 bis 1998) hatte er von Amtswegen auch eine Verantwortung für das hessische Oberbergamt und somit auch für das/die unter Bergrecht 1979 genehmigte Endlager/Untertage-Deponie für hoch-toxische Abfälle Herfa-Neurode. In dieser Zeit ist er schon als ideologisch gesteuerter, taktisch geschickter Zerstörer von funktionierenden technischen Betrieben bekannt geworden.

♦ Als Beamteter Staatsekretär im Bundesumweltministerium (1998 bis 2005) und als Beamteter Staatsekretär im Bundesministerium für Wirtschaft und Energie (seit 2014) hat er sich nicht nur für das Abschalten der deutschen Kernkraftwerke eingesetzt, sondern auch für das Quasi-Ende von Gorleben.

In dem Text I sind die Details zu den einzelnen Berufsabschnitten zusammengestellt:

Teil II

Thesen der Agora Energiewende (Dichtung und Wahrheit)

Die Energiewende – korrekter: Wende der Stromerzeugung – ist der Kurzbegriff für die politisch durchgesetzte Wende der Energieversorgung Deutschlands: Das früher robuste und wirtschaftliche System der Energieerzeugung, das auf einem Mix aus Kernenergie, Kohle, Öl, Gas und ‚Erneuerbareren‘ beruhte, wird abgelöst von einer neuen Energieversorgung alleine auf Basis Erneuerbarer Energie (EE) – Windkraft, Sonnenenergie, Wasserkraft, Biomasse und Erdwärme. Die wesentlichen Gründe für diese quasi-religiös fundamentalistische Wende in der Energieversorgung werden dargestellt und im Einzelnen aus naturwissenschaftlicher technischer und ökonomischer Sicht beleuchtet und bewertet:

♦ Risikovorsorge: Die Risiken der Kernenergie sind prinzipiell nicht beherrschbar. Dies haben die Reaktorkatastrophen in Tschernobyl und Fukushima gezeigt.

Diese Einschätzung entspricht nicht der weltweiten Erfahrung. Zum einen ist die Technik des Tschernobyl Reaktors nicht mit der Technik der zur Stromgewinnung genutzten Reaktoren vergleichbar, von denen heute 441 in Betrieb sind, deren Betriebszeit laufend erneuert wird und von denen weltweit 66 in Bau sind. Bei der Fukushima-Havarie widerstand der Reaktor einem extrem kräftigen Erdbeben der Stärke 9 auf der Richterskala und einer sehr hohen Tsunami-Welle. Grund der Havarie war eine fehlerhafte Standortauswahl („Fukushima und die German Angst“*). Nach Einschätzung der UNSCEAR und der WHO sind biologische Folgen durch radioaktive Strahlung nach Fukushima keine zusätzlichen Krebsrisiken festgestellt worden. Von den beiden Organisationen zeigt der statistische Vergleich zur Todesrate nach Energiequellen, bezogen auf je eine Billion erzeugter Kilowattstunden (kWh): Kernkraft 90, Wind 150, Solar auf Hausdächern 440, Wasserkraft 1.400 Erdgas 4.000, Biotreibstoffe/Biomasse 24.000, Öl 36.000 und Kohle 100.000.

♦Zudem ist der hochradioaktive Abfall aus Kernkraftwerken für Hunderttausende von Jahren äußerst giftig, ohne dass bisher eine Lösung für die Endlagerung gefunden wäre.

Diese Aussage ist grundsätzlich falsch, denn die Physik, die Chemie und die lang-zeitliche Entwicklung geologischer Prozesse (Evolution) zeigt, dass sich die Radioaktivität von abgebrannten Brennelementen in rund 100.000 Jahren auf die natürliche Radioaktivität der Natur reduziert, die Radioaktivität wieder aufgearbeiteter Abfälle in etwa auf 10.000 Jahren und die Radioaktivität der bei der Transmutation entstehenden Abfälle in etwa 300 Jahren. Zusätzlich haben ausführliche Studien nachgewiesen (Gorleben – Offizielle vorläufige Sicherheitsanalyse ergibt: Gorleben ist geeignet*), dass es bisher beim Gorleben Endlagerprojekt keine Erkenntnisse gibt, die gegen eine Eignung sprechen. Auch zeigt das Endlager/die Untertage Deponie Herfa-Neurode, dass eine Entsorgung von hoch-toxischen Abfällen, die in alle Ewigkeit hoch-toxisch bleiben, in tiefen geologischen Formationen in Deutschland genehmigungsfähig ist. Dies sollte Baake aus seiner Zeit als Beamteter Staatssekretär im Hessischen Umweltministerium doch aus seiner Vergangenheit wissen. Zur Verdeutlichung des Sachverhaltes wird zum einen auf das in Finnland gerade genehmigte Endlager für hoch-radioaktive Abfälle und zum anderen auf das natürliche Endlager von Oklo in Gabun hingewiesen, das bis ins Detail untersucht wurde und dessen Entstehung deshalb bestens bekannt ist („Offener Brief an kirchliche Würdenträger – Rückfall ins Mittelalter“*). Zusätzlich ist heute zu fragen, ob in Zukunft eine Entsorgung von radioaktiven Abfällen in tiefen geologischen Formationen überhaupt noch notwendig ist. Möglicherweise nein, denn im Juni 2014 ging der neue Reaktortyp BN-800 im russischen Kernkraftwerk Beloyarsk in Betrieb, der als Brennstoff die bei der Transmutation entstehenden Abfälle energetisch nutzt.

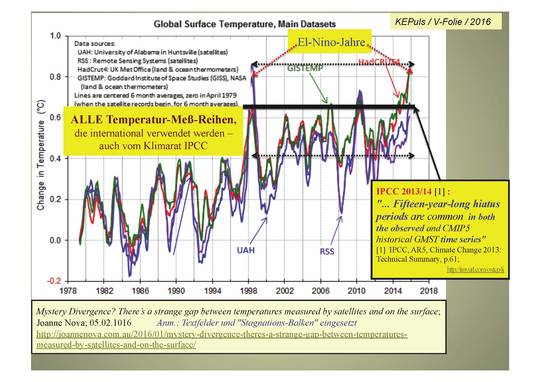

♦Klimaschutz: Bei der Verbrennung von Kohle, Öl und Gas entstehen klimaschädliche Treibhausgasemissionen, die die Hauptverursacher für den Klimawandel sind.

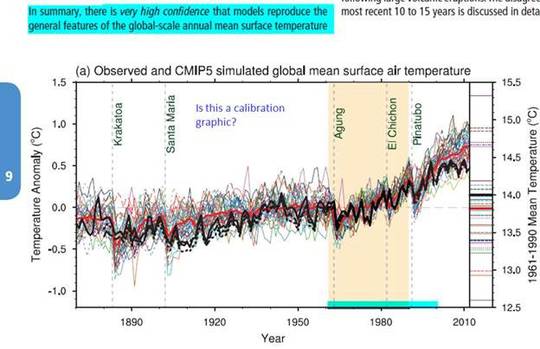

Zu diesen erheblichen Schwankungen des Klimas als Folge geologischer Prozesse, die das Klima seit Jahrmillionen ständig beeinflussen, weist ein Kommentar von Herrn Rademacher, einem nicht von der Industrie bezahlten Geologen und Journalist der F.A.Z hin („Die Erde hat kein Thermostat, Die Natur lebt, F.A.Z. vom 16. Dez.): „… Schaut man durch die Brille der Geowissenschaften auf die Prämissen und Zielsetzungen der Pariser Klimakonferenz, bleibt ein bitterer Beigeschmack. Der Grund dafür sind die ‚2 Grad‘ und ‚1,5Grad‘, die als Zielmarke der Maximalerwärmung Vertragsinhalt geworden ist. Solche Zielwerte scheinen die gesamte Diskussion über die globale Erwärmung verblüffend einfach auf einen Punkt zu bringen … Nicht nur ist diese Sicht für einen Geowissenschaftler allzu vereinfachend, sie entspricht auch nicht der Natur. Die Erde selbst hat sich nämlich im Rahmen ihrer natürlichen Variabilität im Laufe der Erdgeschichte nie an das 1,5-Grad-Ziel gehalten. Selbst in den vergangenen tausend Jahren gab es mindestens zwei, jeweils mehrere Jahrzehnte oder gar Jahrhunderte lange Episoden, in denen die mittleren Temperaturen um mehr als 1,5 Grad von den langjährigen Mittelwerten abwichen. Während des „Mittelalterlichen Klimaoptimums“ war es in Mitteleuropa und auf den Britischen Inseln erheblich wärmer als zuvor und danach. In der „Kleinen Eiszeit“ im 17. Jahrhundert war es dagegen weitaus kälter. Welche natürlichen Vorgänge hinter diesen Klimaschwankungen standen, ist wissenschaftlich noch nicht erwiesen, klar ist aber eins: Menschliche Aktivitäten, vor allem die Verbrennung fossilen Kohlenstoffs, können nicht dafür verantwortlich gewesen sein.

Eine andere natürliche Quelle substantieller Änderungen der globalen Mitteltemperatur sind Vulkanausbrüche. Sobald große Mengen Schwefeldioxid in die höheren Schichten der Atmosphäre gelangen, blockieren die daraus entstehenden Aerosole das Sonnenlicht und kühlen den Planeten. Allein der Ausbruch des Pinatubo auf den Philippinen im Jahre 1991 sorgte über einige Jahre für eine Abkühlung der Nordhalbkugel von bis zu 0,6 Grad. Dabei war diese Eruption nicht nicht einmal richtig stark.Welche Auswirkungen hätten weit heftigere Ausbrüche wie die des Novarupta (1912) oder die des Tambora (1815) oder gar Megaeruptionen wie die des Laacher Sees, der Yellowstone Caldera oder des Crater Lake im amerikanischen Bundesstaat Oregon?…“

Ein weiterer, fehlender Hinweis bei der Klimadiskussion ist, auf die seit Jahrmilliarden sehr aktiven Plattenverschiebungen und ihre Auswirkungen hinzuweisen. Alleine die mittelatlantische Spreizungszone (Mittelatlantischer Rücken), die vom Nordpol bis zum Südpol reicht, vergrößert sich jährlich im Durchschnitt um mehr als einen Zentimeter. Hinzu kommen die sonstigen unablässig stattfindenden Plattenverschiebungen und Bewegungen an den geologischen Verschluckungszonen. Wegen diesen kontinuierlich andauernden, gewaltigen Gesteins- Massenverschiebungen – die Erdkruste ist im Durchschnitt 35 km dick – muss sich kontinuierlich die Erdachse verschieben, damit der Globus nicht auseinander fliegt, ihn somit in ‚Wucht‘ hält – wie die Bleigewichte beim Reifenwechsel. Als Folge dieser endlosen Erdachseverschiebungen werden die für das Klima wichtigen Meeresströmungen kontinuierlich beeinflusst. Beispielhaft sei hier genannt: Das Erdbeben von Fukushima verschob Honshu, die Hauptinsel von Japan, 2,4 Meter nach Osten und bewegte die Erdachse um 10 bis 25 cm („Fukushima und die German Angst*).

Sogar Patrick Moor, Mitbegründer von GREENPEACE bringt es auf den Punkt (EIKE,20.01.2016): „Die einzige Konstante beim Klima ist der Wandel, im Leben, wie beim Klima. Nichts am derzeitigen Klimawandeln ist unnatürlich. Alles läuft in sattsam bekannten historisch eher mäßigen Bahnen ab. Kurz und bündig!“

♦Knappe Ressourcen: Kohle, Öl und Gas sind endlich. Je knapper sie werden, desto teurer wird ein auf fossile Energieträger basierendes Energiesystem.

Die Behauptungen des Clubs of Rome, natürliche Rohstoffressourcen seien endlich, berücksichtigen, wie schon oben näher erläutert, nicht unseren naturwissenschaftlichen Erkenntnissen. Trotzdem bleibt bei Laien der Glaube an die vom Club of Rome weltweit verkündete Behauptung, natürliche Ressourcen seien endlich, wie in Stein gemeißelt.

♦Wertschöpfung vor Ort: Während ein großer Teil der bisherigen Energieträger (insbesondere Öl, Gas, Uran und Steinkohle) importiert wird, sind die Erneuerbaren Energien heimische Energien, die somit die Wertschöpfung vor Ort erhöhen und die Importabhängigkeit reduzieren.

Diese Begründung ist reiner Unsinn! Deshalb nur folgender Kommentar: Wenn wir uns nur auf die in unserem Land vorkommenden Rohstoffe konzentrieren sollten, müssten wir in Deutschland wieder viele völlig unwirtschaftliche Bergwerke in Betrieb nehmen! Das würde wirklich teuer für Deutschland werden, noch teurer als die Energiewende – denn nicht zuletzt die politischen Gesinnungsgenossen des Beamteten Staatssekretärs Baake würden großen Spaß daran haben, diese mit lautstarken Protesten, von Medien zielgerichtet unterstützt, zu verhindern!

Zwölf Thesen zur deutschen Energiewende

Als Beamteter Staatssekretär war Baake engster Mitstreiter des grünen hessischen Umweltministers Joschka Fischer. Später (1998 bis 2005) organisierte er als Beamteter Umwelt-Staatssekretär der Regierung Schröder den Atomausstieg. Seine politische Überzeugung für eine Energiewende nahm er 2006 aus dem Bundesumweltministerium zur Deutschen Umwelthilfe und dann 2012 bis 2013 zur Denkfabrik Agora Energiewende mit. Beide Organisationen führten ihn nach Berlin. Noch als Agora-Chef hatte er seine zusammengewürfelten „Zwölf Thesen zur Energiewende“ vorgestellt, ohne auf die wesentlichsten Rahmenbedingungen für einen solch folgenschweren Technologiewechsel einzugehen. Trotzdem dienen ihm diese Thesen bis heute als Blaupause.

Der erste Hauptsatz seiner Deutschen Energiewende lautet:

„1. Im Mittelpunkt stehen Wind und Solar! Denn sie sind die preiswertesten Erneuerbare-Energien- Technologien und haben das größte Potenzial. Dies wird das Stromsystem und den Strommarkt fundamental verändern. Aus diesem Hauptsatz der Energiewende leiten sich die anderen Thesen der Publikation ab:

2. Es gibt keine „Grundlastkraftwerke“ mehr. Gas- und Kohlekraftwerke arbeiten Teilzeit

3. Flexibilität gibt es reichlich – nur lohnt sie sich bislang nicht

4. Netze sind billiger als Speicher

5. Die Sicherung der Höchstlast ist kostengünstiger

6. Die Integration des Wärmesektors ist sinnvoll

7. Der heutige Strommarkt handelt Kilowattstunden – er garantiert keine Versorgungssicherheit

8. Am Grenzkostenmarkt können sich Wind und Photovoltaik prinzipiell nicht refinanzieren

9. Ein neuer Energiewende-Markt ist erforderlich

10. Der Energiewende-Markt bindet die Nachfrageseite aktiv ein

11.Der Energiewende-Markt muss im europäischen Kontext gedacht werden

12.Effizienz: Eine gesparte Kilowattstunde ist die günstigste.“

Seit dem 09.01.2014 ist Baake Beamteter Staatssekretär im Bundesministerium für Wirtschaft und Energie.

Nach dem oben Gesagten erübrigt sich eine Bewertung dieser eher wirren, unzusammenhängenden Thesen, denn sie werden, wie jeder erkennen kann, der Komplexität der naturwissenschaftlichen, technischen, ökonomischen und auch ökologischen Herausforderungen einer effizienten Strompolitik bei weitem nicht gerecht, sondern zeigt nur, auf welch wackeligen Beinen die bombastische Baake’sche Energiewende steht. Vor allem, was die jährlich steigenden Kosten für die Stromkunden in Höhe von 28 Milliarden Euro betrifft. In der genannten Summe sind noch nicht die hohen Abschreibungskosten für die vorzeitige und deshalb unwirtschaftliche Abschaltung der deutschen Kernkraftwerke, deren Entsorgung und die Kosten für eine bei Adam und Eva wieder beginnenden Endlagersuche enthalten. Sie müssen vor allem von den weniger begüterten Bürgern und der Wirtschaft bezahlt werden, nicht dagegen von dem großen Kreis von Subvention-Gewinnlern in der Bürgerschaft, in den Kommunen und in der Industrie. Wo bleibt seine in den USA gelernte Überzeugung, die Machtlosen und Besitzlosen müssten mit allen Mittel unterstützt werden? War der Zwang zur Macht zu groß? Auch kann man in diesem Zusammenhang fragen, ob man bei den großzügigen, Wende bedingten, für jahrelang garantierten Subventionen indirekt auch an einen Kauf von Stimmen gedacht hat?. Diese Liste ist aber auch ein interessanter Hinweis auf die philanthropische Denkweise des Beamteten Staatssekretärs und auf seine ideologisch stark grüne, bar jeder naturwissenschaftlichen, technischen und ökonomischen Erfahrung. Diese Ablehnung der fundamentalen Gesetze der Geologie könnte bei ihm fast ein Hinweis auf sein im Hintergrund bestehender Glaube an den Kreationismus sein **). Nicht nur ideologische sondern auch sektiererische Glaubensrichtungen, die in den USA und zum Teil auch in Deutschland zu finden sind, könnten den sehr teuren Generationspfusch des „Masterminds“ und seine nur in Deutschland vorangetriebenen Energiewende erklären. Denn von 33 Ländern vernichtet nur das eine Land Deutschland seine weltweit führende technische und umweltfreundliche Kernenergiewirtschaft.

Was ist der Grund für diese sehr deutsche Entwicklung?

Hier stellt sich nun die interessante Frage, wie und warum sich nur in Deutschland eine derart irrationale Politik entwickeln konnte und warum die Mehrheit der deutschen Gesellschaft dieser Ideologie auf den Leim gegangen ist. Eine wesentliche von sicherlich mehreren Gründen zeigt der beruflich Werdegang des Beamteten Staatssekretärs Baake, der bis heute, trotz seiner verantwortlichen Stellung in der Gesellschaft, einen großen Zwiespalt zwischen rationaler und ideologisch geprägter Politik zu zeigen scheint. Deshalb einige Worte zur Erinnerung: Anfang der 70iger Jahre war die Bundesrepublik inmitten eines gesellschaftlichen Wandels, der zunehmend vor allem von der linken Studentenbewegung politisch aktiviert und bis heute zum Teil noch von der Politik und in den Medien gesteuert wird. Dieser Wandel war geleitet von neuen Utopien und den Möglichkeiten für alternative Lebensstile: Systeme seien veränderbar und Moral sei relativ meinten sie wohl. Die mit der linken Selbstbestimmung einhergehende Kritik an bestehenden Institutionen, die sich zunehmend mit der tiefen Angst vor realen und unrealen Umweltgefahren steuern ließ, erfasste insbesondere die deutsche Politik. Denn wie keine andere Protestbewegung ließ sich mit einer ökologistischen grünen Ideologie zusammen mit linkem Gedankengut die zukünftige Apokalypse der Menschheit definieren. Die dabei propagierten großspurigen Behauptungen entsprachen zum großen Teil – wie sich heute zeigt – nicht der Realität. Trotzdem wurden und werden sie von der Regierung bis heute als politische Leitlinien genutzt, um die deutsche Gesellschaft zu verwirren und für das eigene, ausgeprägte Machtstreben zu nutzen („’Die German Angst‘, von H. Fuchs und R. Kamradek“*). Und das bisher mit politischem Erfolg. Doch heute erkennt man, dass sich für viele Bereiche des täglichen Lebens die Behauptung wie die Endlichkeit der Ressourcen, die Gefahren der Kernkraft, die Unmöglichkeit einer sicheren Endlagerung, der Klimakatastrophe und letztendlich auch einer sehr großzügigen, offenen Multikulti-Kultur, die Deutschland bis Ende 2017 etwa 50 Milliarden Euro kosten dürftete ( F.A.Z. vom 02.02.2016), nicht erfüllt haben und nicht erfüllen werden.

Die engen, ideologischen und finanziellen Kontakte zu bekannten Nichtregierungsorganisationen und insbesondere zu Stiftungen aus den Vereinigten Staaten aber auch Deutschland sprechen bei dem Beamteten Staatssekretär Baake für sich. Denn deren Visionen – die für viele gesellschaftliche Herausforderungen zugegebener maßen Gutes tun wollen – erklären seine ideologisch geschulte Glaubensgesinnung, verbunden mit philanthropischen Gefühlen. Auch sein Glaube, die wirklichen Ursachen der größtenteils natürlich bedingten Klimaschwankungen beeinflussen zu können – nicht zuletzt durch seinen Versuch, die Erdachse festhalten zu wollen -, scheint unendlich zu sein. Seine messianische Überzeugung, Rohstoffe sind endlich, Kernkraftwerke seien des Teufels und Langzeit sichere Endlager/Untertage-Deponien seien einer Hybris von Geologen, Bergingenieuren und Kernphysikern geschuldet, stimmt mit den weltweiten Fakten nicht über ein: WHO-Bericht, 443 Kernkraftwerke weltweit, Erfahrungen vom Endlager Herfa-Neurode und dem natürlichen Endlager von Oklo in Gabun und so weiter. Hinter diesen quasi religiösen Glaubensbekenntnissen dürfte bei ihm eher ein sehr großer Wille zur Macht stehen.

Fazit: Der Beamtete Staatsekretär Baake, Mastermind der deutschen Energiewende, wird als geschickter und knallharter Zerstörer einer marktwirtschaftlichen Stromwirtschaft und als fehlgeleiteter Planer und Umsetzer einer neuen, planwirtschaftlich gesteuerten, einer hochsubventionierten und einer die Natur und die Umwelt verschandelnden Energiewirtschaft in die Geschichtsbücher eingehen.

Ein Rückblick auf ein halbes Jahrhundert

Welche Bundesregierung hat den Wohlstand gemehrt, welche verzehrt? In seiner sehr lehrreichen Abschiedsvorlesung knöpft sich Prof. Sinn (F.A.Z. 16 Dezember 2015) der bekannteste deutsche Ökonom die deutsche Wirtschaftspolitik vor: „… Auch die Energiepolitik ist ausschließlich gesinnungsethisch zu begründen, denn sie kann nun einmal keinen Beitrag zur Verringerung der Erderwärmung leisten. Bekanntlich kann das Erneuerbare-Energien-Gesetz mit seinen Einspeisetarifen den Kohlendioxid-Ausstoß in Europa nicht verändern, weil der schon durch die Menge der von der EU ausgegebenen Emissionszertifikate definiert ist. Und nicht einmal der europäische Emissionshandel selbst kann weltweit etwas bewirken, weil die Mengen an fossilen Brennstoffen, die Europa nicht verbraucht, anderswo angeliefert und verbrannt werden. Man hätte es Max Weber wirklich gegönnt, dieses Anwendungsbeispiel für seine Unterscheidung erleben zu können.

Der Unterschied zwischen der Gesinnungsethik und der Verantwortungsethik liegt darin, dass man für Erstere keinen Sachverstand braucht. Da man bereits die Stellschrauben der Wirtschaftsmaschinerie moralisch bewertet, muss man nicht wissen, wie sie funktioniert. Man kann munter drauflos moralisieren und dann zu einer politisch rationalen, wenn auch ökonomisch unvernünftigen und klimapolitisch wirkungslosen Entscheidung gelangen.

Wer indes verantwortungsethisch handeln möchte, muss ökonomischen Sachverstand haben, weil er wissen muss, wie die Maschinerie auf die Bewegung der Stellschrauben reagiert. Weil er Moral und Ethik nur auf das wirtschaftliche Endergebnis anwendet, braucht er Weitsicht und Durchhaltevermögen. Das gilt heute mehr denn je, weil der öffentliche Diskurs in der Zeit der Internet-Medien kurzatmig, oberflächlich und unkundig geworden ist.

Ökonomen sind gelernte Verantwortungsethiker, denn ihr Fach besteht gerade darin, die Wirtschaftsmaschinerie als solche zu studieren. Sie wollen mit nur schwachen Werturteilen zu möglichst harten und klaren Politikempfehlungen kommen und scheuen die Moralisierung auf der Ebene der Politikmaßnahmen wie die Pest. Dass viele das als herzlos empfinden oder den Sachverstand bezweifeln, ohne ihn selbst zu haben, ist in Kauf zu nehmen…“

***

*) genaue Erläuterungen zu den Einzelthemen sind in meinen Veröffentlichungen enthalten und bei Google unter den genannten Titeln zu finden.

**) Kreationismus (Google)

Der Kreationismus entstand im 19. Jahrhundert als Widerstand gegen das Postulat eines hohen Erdalters und die darwinsche Evolutionstheorie. Heute richtet sich der Kreationismus gegen die moderne Naturwissenschaften und Atheismus. Seine größte Bedeutung hat der Kreationismus in den christlich-fundamentalistischen und evangelikalen Richtungen in den USA. … In seinen verschiedenen Formen rangiert er zwischen Religionslehren und Pseudowissenschaft. … Heute dominiert die Theorie des Kurzzeit-Kreationismus, der die Schöpfungstage als Kalendertage auffasst. Danach kommt man auf ein Weltalter von 6000 bis maximal 12000 Jahren. Diese Annahmen sind mit nahezu allen Feldern der Naturwissenschaften unvereinbar, also ist der Kreationismus gezwungen, beispielsweise Physik und Geologie neu zu konstruieren.

Auch wenn der Kreationismus in der Öffentlichkeit kaum präsent ist, gehört er in einem Teil der evangelikalen Bewegung und in den meisten Freikirchen in Deutschland inzwischen zu ihrer Weltdeutung. Hier hält man es für selbstverständlich, dass die Bibel Recht und die Naturwissenschaften Unrecht hat. … In freikirchlichem Raum hat sich als Autorität für die Ablehnung der Evolutionstheorie etabliert. Ein Kreis von mehreren tausend Personen unterstützen die Studiengemeinschaft ‚Wort und Wissen‘. Sie ist vermutlich die personell und wissenschaftlich am besten ausgestaltete kreationistische Organisation in Europa.