Zusammenfassung

· Nach den Daten der NOAA Website war 1997 war wirklich das heißeste Jahr der Aufzeichnung mit 16,9°C (62.45°F). Die globale Durchschnittstemperatur in 2015 betrug 14,78°C (58.62°F) oder 2,12K (3.83F) unter der Temperatur von 1997.

· Nach den Daten der NOAA Website, haben die Temperaturen, wie beispielsweise die Durchschnittstemperatur des 20. Jahrhunderts und jährliche Temperaturanomalien, die festgelegt [fixed] werden mussten, unterschiedliche Werte in den jährlichen globalen Analysen.

· NOAA und NASA korrigierten historische Temperaturdaten und stellten Temperaturdaten in Gebieten ohne Temperaturaufzeichnung systematisch her, unidirektional in Richtung "kühlerer" Vergangenheit, in dem Versuch, einen steigenden Temperaturtrend zu beweisen.

· NOAA und die NASA haben Anstrengungen unternommen, ihre eigenen Satellitendaten zu diskreditieren – welche im Einklang mit dem Ballon Daten sind – weil diese eine globale Erwärmung Pause seit 1998 zeigen, was im Widerspruch mit der von NOAA und der NASA bevorzugten Erzählung steht.

· NOAA und NASA haben sich geweigert, die durch das US-Repräsentantenhaus für Wissenschaft, Weltraum und Technologie angeforderten Daten und Informationen heraus zugeben. Es gibt keinen Grund für sie die Daten und Informationen, die öffentlich zugänglich sind, zurückzuhalten, es sei denn, sie haben etwas zu verbergen.

Die Schlagzeile: „letztes Jahr war das heißeste der Aufzeichnungen, dieses Jahr ist heißer als letztes Jahr und nächstes Jahr könnte heißer als dieses Jahr werden” wird Jahr für Jahr widerholt bis die Finanzierung des Klimawechsels aufhört!

Einführung

Wie seit April 2015 [1-9] monatlich behauptet, gaben die Mainstream-Medien heute bekannt, dass: "Es ist offiziell: 2015 war das wärmste Jahr der Aufzeichnung" [10-13]. Dieses "heißen Neuigkeiten" wurde sofort veröffentlicht, nachdem das „National Centers for Environmental Information“ (NCEI) der „National Oceanic and Atmospheric Administration“ (NOAA) seine "Globale Analyse – Annual 2015" [14] geliefert hatte. Nach dieser 2015er globalen Analyse: "… die globale Durchschnittstemperatur der Oberflächenbereiche über Land und Ozean für das Jahr 2015 betrug 0,90° C (1,62 ° F) über dem Durchschnitt von 13,9° C (57,0 ° F) im 20. Jahrhunderts und schlug den bisherigen Wärmerekord von 2014 um 0,16° C (0,29° F)", um das heißeste Jahr der Aufzeichnungen zu werden. "Wir sehen wirklich einen langfristigen Trend und das ist ein Symptom für einen langfristigen Trend" und „wenn 2016 sich als so warm erweist, wie wir erwarten, wäre das beispiellos in unserem Buch der Rekorde", sagte Gavin Schmidt, Direktor des Goddard Institute for Space Studies (GISS) der National Aeronautics and Space Administration (NASA) [10,15]. Das überrascht nicht, weil ein zuvor vom britischen Met Office veröffentlichter Bericht behauptet, dass " nächste Jahr [2016] wird wahrscheinlich das wärmste dank El-Niño und fortschreitenden Klimawandel sein" [16].

Allerdings gibt es Hinweise darauf, dass die von NOAA und der NASA berechneten durchschnittlichen globalen Temperaturen ungenau, unzuverlässig und vor allem nicht mit den Satelliten-Temperaturdaten konsistent zu sein scheinen. Dieser Bericht ist ein Versuch zu verstehen, warum [bereits] seit langer Zeit, die von der NOAA und der NASA berechneten durchschnittlichen globalen Temperaturen durch "skeptische" Wissenschaftler und Meteorologen als Betrug betrachtet werden oder diplomatischer – unwissenschaftlich!

Unbestreitbare Beweise

Bedenken in Bezug auf die Genauigkeit und Zuverlässigkeit der von NOAA und der NASA berechneten durchschnittlichen globalen Temperaturen waren nicht gegeben und erfuhren keine besondere Aufmerksamkeit, bis die NASA erklärte: „dass die Temperatursteigerung des Planeten aus dem langfristigen Durchschnitt von 1,04 Celsius im Oktober [2015] die größte eines Monats überhaupt ist, die von der NASA aufgenommen wurde. Es war das erste Mal das eine monatliche Temperaturanomalie von 1 Grad Celsius in den Aufzeichnungen aus dem Jahr 1880 übertroffen wurde. Die bisherige größte Anomalie betrug 0,97 Celsius im Januar 2007 "[17] Seitdem wurden viele Beweise [, dass das falsch ist,] aufgedeckt und im Internet veröffentlicht.

Welches Jahr war das wärmste Jahr der Aufzeichnungen?

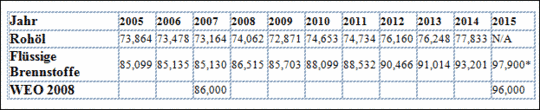

In der NOAA Globalen Analyse – Annual 2015 [14] heißt es "… die globale Durchschnittstemperatur der Oberflächenbereiche über Land und Ozean für das Jahr 2015 betrug 0,90 ° C (1,62 ° F) über dem Durchschnitt von 13,9 ° C (57.0 ° F) im 20. Jahrhundert und schlug den bisherigen Wärmerekord des Jahres 2014 um 0,16K (0.29 F)". Als Folge errechnet sich die globale Durchschnittstemperatur für das Jahr 2015 über Land und Ozean mit 14,80 °C (58.62°F). In der NOAA Global Analysis – Annual 1997 [18] heißt es: "Die globale Durchschnittstemperatur von 62.45 Grad Fahrenheit [16,9°C} im Jahr 1997 war das wärmste Jahr der Aufzeichnung und übertraf damit den bisherigen Rekord im Jahr 1995 um 0.15 Grad Fahrenheit (0,08K)."

Basierend auf diesen globalen Analysen der NOAA, war die globale Durchschnittstemperatur für das Jahr 1997, mit 16,92°C (62.45°F) höher als die für das Jahr 2015, von 14,80°C (58.62°F), mit 2,12K (3.83F). Daher war 1997 eigentlich das wärmste Jahr der Aufzeichnung und übertraf damit alle nachfolgenden Jahre einschließlich 2015!

Konstante Parameter mit unterschiedlichen Werten

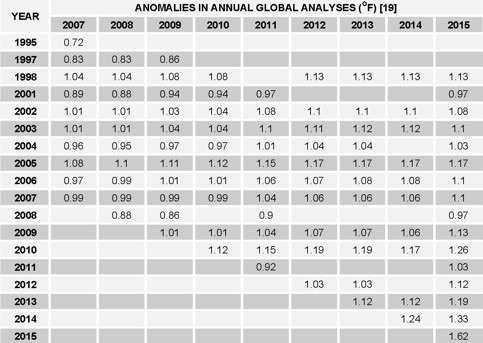

Einige Temperaturparameter, die konstant sein müssen, werden mit unterschiedlichen Werten in den NOAA globalen Analysen gezeigt. Ohne besondere Aufmerksamkeit sind sie schwer zu erkennen, da sie in Einzelanalysen versteckt sind.

Der erste Parameter, der direkte Auswirkungen auf die NOAA Einschätzung hat, ist der Durschnitt des 20. Jahrhundert. In den jährlichen globalen Analysen vor 2010, wird der Mittelwert des 20. Jahrhunderts, mit 56,9°F oder 13,9 °C ausgewiesen (eigentlich müsste es 13,83°C sein). Sein Wert wird mit 57,0°F oder 13,9 °C ab dem Jahr 2010 bis jetzt dargestellt [19].

Zusätzlich in der globalen Analyse – August 2015 [20], berichtet NOAA: "Die kombinierte Durchschnittstemperatur über globalen Land- und Ozeanoberflächen für August 2015 betrug 0,88 K (1.58 F) über dem Durchschnitt von 15,6 °C (60.1 °F) des 20. Jahrhunderts und war der höchste Augustwert in der 136-jährigen Aufzeichnung". Die Veränderung des Wertes für den Durchschnitt des 20. Jahrhunderts wird von NOAA und der NASA nicht erklärt.

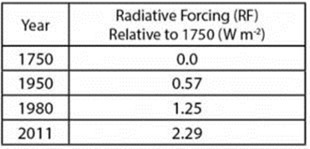

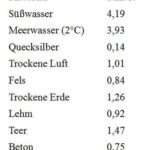

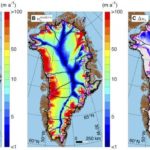

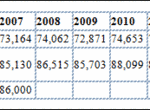

Tabelle 1 – Unterschiedliche Werte von Jahres Anomalien

Der zweite Parameter ist die jährliche Anomalie, das heißt die Differenz zwischen der jährlichen globalen Durchschnittstemperatur und der mittleren des 20. Jahrhunderts. Der Wert dieses Parameters, der eine Konstante sein muss, variiert von Analyse zu Analyse. Zum Beispiel die 2010er-Anomalie – gezeigt mit 0,62K ( 1.12F) in der globalen Analyse – Annual 2010 – steigt auf 0,83K (1.15F) in der 2011 Analyse und 0,66K (1.19F) in den 2012 und 2013 Analysen, verringert sich auf 0,94K (1.17F) in der 2014er Analyse und erhöht sich dann wieder in der 2015er Analyse, wie in Tabelle 1 gezeigt.

Korrigierte und hergestellte Temperaturdaten

Fragen in Bezug auf die Zuverlässigkeit, Genauigkeit und Angemessenheit der Temperaturdaten die von NOAA und der NASA verwendet werden, um die globale Durchschnittstemperatur zu berechnen, wurden von Joseph D’Aleo gestellt, dem ersten Direktor der Meteorologie und Mitbegründer des Kabel-TV Weather Channel und von Anthony Watts, ein 25-Jahre-Broadcast Meteorologie Veteran und derzeit ein Meteorologe für KPAY-AM-Radio und den vom Wissenschaft & Public Policy Institute (SPPI) im Jahr 2010 veröffentlichten Bericht [21].

Im Anschluss an eine integrative Beurteilung der Aufzeichnungen der Oberflächentemperaturen der Climatic Research Unit (CRU) der East Anglia University in Großbritannien und NASA‘s GISS und NOAA National Climatic Data Center (NCDC), schlossen die Autoren, dass "Instrumentale Temperaturdaten für die Vor-Satelliten-Ära (1850-1980) wurden so umfangreich, systematisch und unidirektional verfälscht, dass sie nicht glaubwürdig geltend machen können, dass es eine signifikante "globale Erwärmung" im 20. Jahrhundert gegeben hat … globale terrestrische Temperaturdaten wurden beeinträchtigt, weil mehr als drei Viertel der 6.000 Stationen, die [früher] einmal erfasst wurden, nun nicht mehr in den Trendanalysen verwendet werden … zu den Ozeanen fehlen Daten und die Unsicherheiten sind beträchtlich. Veränderungen in Datensätzen führten zu einer schrittweisen Erwärmung im Jahr 2009. "

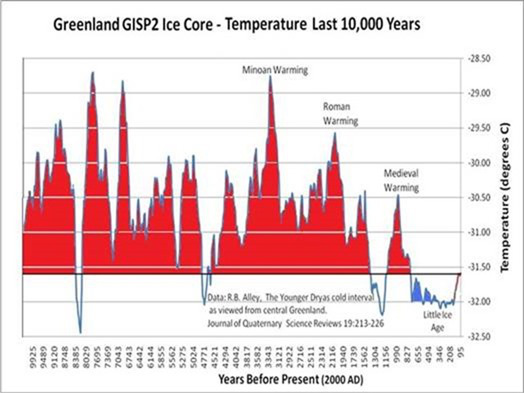

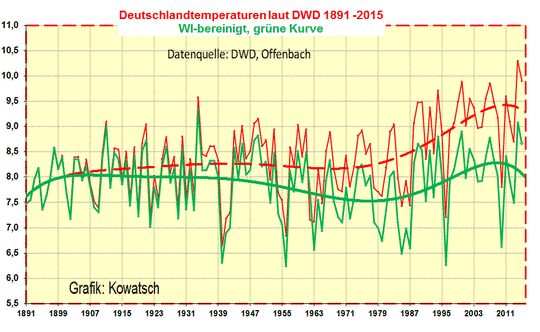

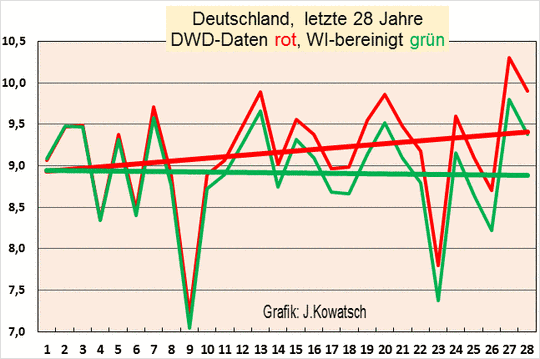

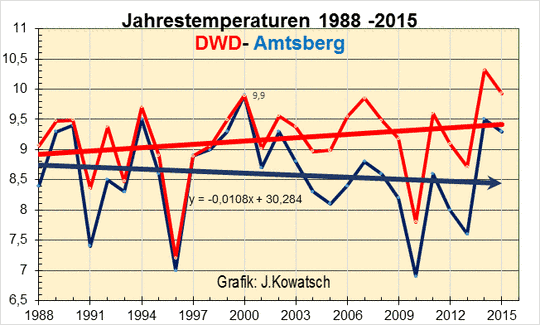

Das D’Aleo‘s und Watt‘s Bericht ermutigt zusätzliche Bewertungen durch andere Wissenschaftler, Anpassungen oder Herstellung von Temperaturdaten in den NCDC und CRU-Datenbanken genau zu prüfen. Diese zusätzlichen Bewertungen bestätigen, dass NOAA und der NASA systematisch und umfangreich, historische Daten verändert und Temperaturdaten in Bereichen ohne Messungen hergestellt haben [22-35], um "die Vergangenheit zu kühlen", damit ein zunehmender globaler Temperaturtrend gezeigt werden kann, wie von NOAA und NASA interpretiert (siehe Abbildung 1).

Abbildung 1 – NASA "kühlt" die Vergangenheit, um den globalen Erwärmungstrend zu beweisen [22]

Diskreditierung der Satellitendaten

Seit 1978 hat NOAA Wettersatelliten verwendet, um die Temperatur der Erdatmosphäre zu überwachen. Laut einer Studie, die von der NASA im Jahr 1990 [36] durchgeführt wurde, „haben mehrere Regierungs- und Universitäts Meteorologen auf der ganzen Welt festgestellt, dass die durchschnittliche Oberflächentemperatur in den letzten Jahren zugenommen hat“, der Autor dieses Berichts schrieb, dass ihre Satelliten-Analyse der oberen Atmosphäre viel genauer ist und als der normale Weg übernommen werden sollte, um globale Temperaturänderungen zu überwachen."

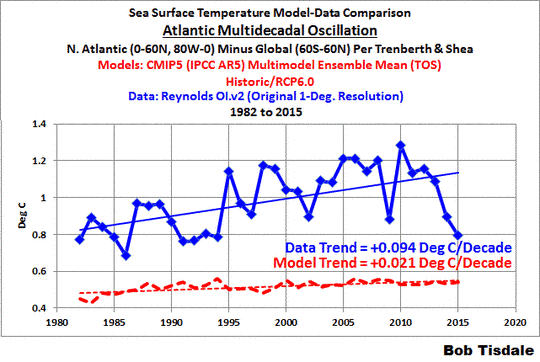

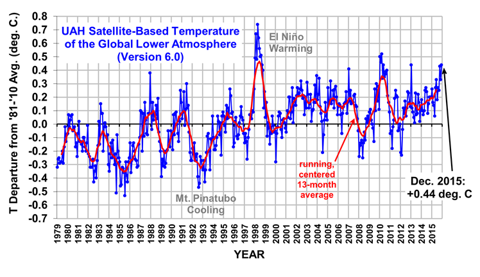

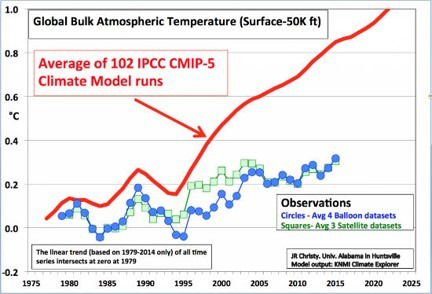

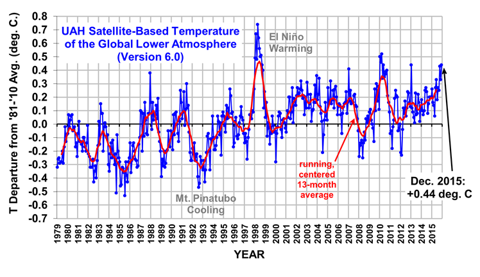

Abbildung 2 – Satelliten Temperaturanomalien der globalen unteren Atmosphäre [37]

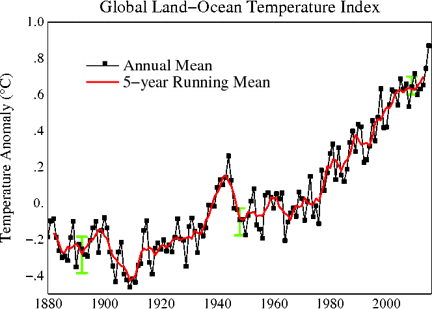

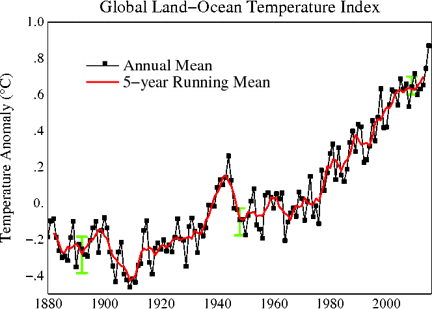

Abbildung 3 – NASA, globale Land und Meer Temperaturanomalien [38]

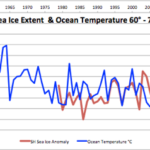

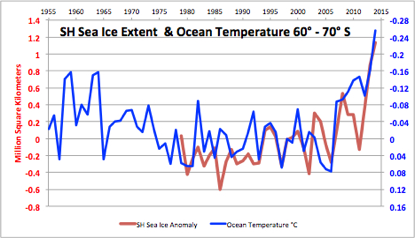

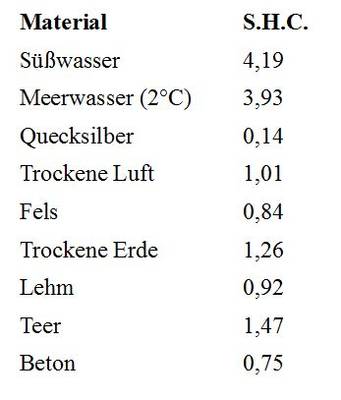

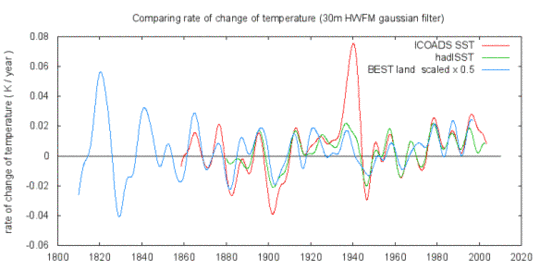

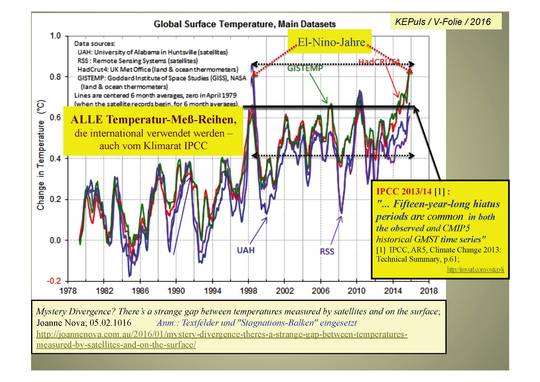

Satellitendaten von 1979 (Abbildung 2) zeigen, dass die Temperatur der globalen unteren Atmosphäre seit 1998 nicht gestiegen ist, im Widerspruch mit dem steigenden Trend der NASA, wie in Abbildung 3 zu sehen. Aus diesem Grund, haben NOAA und NASA Anstrengungen unternommen, um die durch ihre eigenen Satelliten gesammelten Temperaturdaten zu diskreditieren.

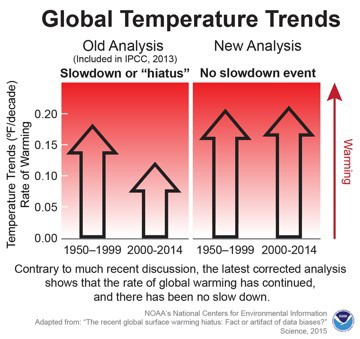

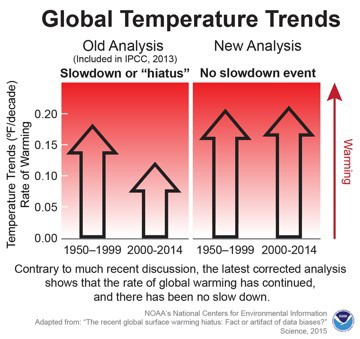

Der erste Versuch war eine Studie von Thomas R. Karl, Direktor des NOAA National Centers for Environmental Information (NCEI), und seinen NOAA Kollegen. Die Studie, online in der Zeitschrift Science [39] veröffentlicht, kommt zu dem Schluss, dass: "Viele Studien wurden den möglichen Ursachen für eine scheinbare Abnahme des Aufwärtstrend der globalen Oberflächentemperatur seit 1998 gewidmet, ein Phänomen, das die globale Erwärmungs- "Pause" überspielt hat. Hier präsentieren wir eine aktualisierte globale Oberflächentemperatur-Analyse, die zeigt, dass globale Trends höher sind als die vom IPCC gemeldeten, vor allem in den letzten Jahrzehnten, und dass die zentrale Schätzung für die Erwärmungsrate während den ersten 15 Jahre des 21. Jahrhunderts mindestens so groß ist wie in der letzten Hälfte des 20. Jahrhunderts [4]. Diese Ergebnisse stützen die Vorstellung von einem "Rückgang" in der Zunahme der globalen Oberflächentemperatur nicht."

Abbildung 4 – NOAA’s globale Temperaturtrend Analysen [Internet]

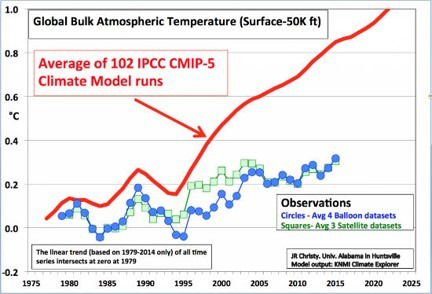

Die zweite Anstrengung war ein Propaganda-Video, an dem der "berühmte Klimaforscher" Michael Mann (der Autor von "The Hockey Stick") beteiligt war, Kevin Trenberth (zugebend, dass "es ein Hohn ist, dass wir nicht auf die im Moment fehlende Erwärmung zählen können") und Ben Santer. Das Video wurde von einer Stiftung für Klima-Aktivisten finanziert, um Zweifel an den Satellitendaten [40] zu streuen. Aber dieses Video scheint ein Schuss in den Ofen zu sein, weil (1) die Satellitendaten durch die unabhängigen Ballondaten (Abbildung 5) verifiziert werden, während die von NOAA und der NASA berechneten Temperaturdaten nicht bestätigt werden, (2) die Verwendung von Satelliten für Überwachung der globalen Temperaturänderungen war von der NASA empfohlen und (3) Jason-3 – der neueste in den Orbit gestartete Wettersatellit – ist eine internationale Mission, in der NOAA in Partnerschaft ist mit der NASA, dem Centre Nationale de’Études Spatiales (CNES), der Französischen Weltraumorganisation und der Europäischen Organisation für die Nutzung meteorologischer Satelliten (EUMETSAT)) [41].

Abbildung 5 – Satelliten- durch Ballon-Daten verifiziert [40]

Verbergen von Daten und Methoden die für wissenschaftliche Untersuchungen verwendet werden

Im Juli 2015, um die wissenschaftliche Integrität der NOAA-Studie zu "keine Pause in der globalen Erwärmung" zu beweisen, fragten der Republikaner Lamar Smith (R-Texas), der Ausschussvorsitzende im US-Repräsentantenhaus für Wissenschaft, Raumfahrt und Technologie, die NOAA um Daten und Dokumente an, die mit der Studie verbunden sind. Obwohl Rep. Smith Anfrage legitim und die angeforderten Informationen öffentlich sind, weigerte sich NOAA dem Ausschuss die angeforderten Daten und Informationen zu geben, weil "es ist eine langjährige Praxis in der wissenschaftlichen Gemeinschaft, die Vertraulichkeit der beratenden wissenschaftlichen Diskussionen zu schützen" [42]. Warum verweigert NOAA diesen Antrag? "Es gibt absolut keinen Grund für die NOAA, ihre Informationen zurückzuhalten, außer sie haben etwas zu verbergen. Und als Bundesbehörde ist es ihre Pflicht, mit dem Kongress zu kooperieren "[42].

NOAA weigerte sich weiterhin, die angeforderten Daten und Informationen zu geben, bis die Überwachung der Justiz am 2. Dezember 2015 eine Klage eingereichte, zur Vorlage der gleichen Unterlagen, die der Ausschuss anforderte. Das Department of Commerce (DOC) wurde wegen fehlender Reaktion auf die Anfrage nach dem Freedom of Information Act (FOIA) [ist in US Gesetz; der Übers.] verklagt, weil NOAA eine Komponente des DOC ist. Am 15. Dezember 2015 begann NOAA die angeforderten Dokumente an den Kongress [43] zu übermitteln.

Die Tiefe der Probleme in NOAA’s Praktiken wurde wahrscheinlich zum ersten Mal im Jahr 2007 aufgedeckt, als Klimaforscher Roger Pielke und Meteorologe Anthony Watts ernsthafte Probleme mit dem US-Oberflächentemperatur-Messnetz fanden, welches vom National Climatic Data Center (NCDC) verwaltet wurde, ein Zweig der NOAA. Sie bemühten sich, dieses Netzwerk zu validieren, aber ‚das NCDC entfernte alle Website Zugänge zu Stationsstandorten unter Berufung auf ‚Bedenken hinsichtlich der Privatsphäre.‘ Ohne diese Daten (die seit Jahren öffentlich sind), wurden Validierungsbemühungen blockiert" [44].

FAZIT

Wie so häufig von den Mainstream-Medien seit April 2015 wiederholt, erklärten NOAA und NASA offiziell, dass 2015 heißer als 2014 war, das alte wärmste Jahr der Aufzeichnungen und "versprechen", dass 2016 heißer als 2015 sein könnte! Jedoch, unleugbare Beweise zeigen, dass die von NOAA und der NASA berechneten durchschnittlichen globalen Temperaturen ungenau, unzuverlässig und nicht mit den Satellitendaten konsistent erscheinen.

Laut Daten der NOAA Website, war 1997 wirklich das heißeste Jahr der Aufzeichnung mit 16,9°C (62.45°F). Die globale Durchschnittstemperatur im Jahr 2015 betrug 14,8°C (58.62°F) oder 2,12K (3.83F) von unter der Temperatur 1997. [… und unter der „Normal“ Temperatur von 15°C gemäß PIK u.ä., der Übersetzer]

Nach den Daten der NOAA Website, haben die Parameter wie beispielsweise die Durchschnittstemperatur des 20. Jahrhunderts und der jährlichen Temperaturanomalien, die konstant sein müssten, unterschiedliche Werte in den jährlichen globalen Analysen.

NOAA und NASA korrigierten historische Temperaturdaten und stellten Temperaturdaten in Gebieten ohne Temperaturaufzeichnung systematisch her, weit verbreitet und unidirektional zum „kühlen“ der Vergangenheit, in dem Versuch, einen steigenden Temperaturtrend zu beweisen.

NOAA und der NASA haben Anstrengungen unternommen, um ihre eigenen Satellitendaten zu diskreditieren – die im Einklang mit dem Ballon Daten sind – weil eine globale Erwärmung Pause seit 1998 im Widerspruch mit der von NOAA und der NASA bevorzugten Behauptung steht.

NOAA und NASA haben sich geweigert, die durch das US-Repräsentantenhaus für Wissenschaft, Weltraum und Technologie angeforderten Daten und Informationen heraus zugeben. Es gibt keinen Grund für sie die Daten und Informationen, die öffentlich zugänglich sind, zurückzuhalten, es sei denn, sie haben etwas zu verbergen.

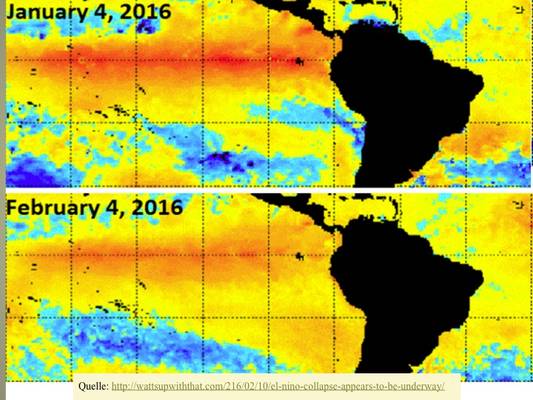

Bild WUWT

Bild WUWT

Die Schlagzeile: „letztes Jahr war das heißeste der Aufzeichnungen, dieses Jahr ist heißer als letztes Jahr und nächstes Jahr könnte heißer als dieses Jahr werden” wird Jahr für Jahr widerholt bis die Finanzierung des Klimawechsels aufhört!

Erschienen auf WUWT am 2. Februar 2016

Übersetzt durch Andreas Demmig

www.wattsupwiththat.com/2016/02/02/2014-was-the-hottest-year-on-record-but-2015-is-hotter-than-2014-and-2016-could-be-hotter-than-2015

Referenzen

[1] Andrea Thompson. April 17, 2015. “2015 Hottest Year to Date, Could Top 2014 Record.” Climate Central. http://www.climatecentral.org/news/2015-hottest-year-to-date-18895

[2] Jay Michaelson. May 16, 2015. “2015 Is the Hottest Year On Record.” The Daily Beast. http://www.thedailybeast.com/articles/2015/05/16/2015-is-the-hottest-year-on-record.html

[3] Jon Edrman. Jun 18, 2015. “2015 Still On Pace as Hottest Year On Record.” The Weather Channel. http://www.weather.com/news/climate/news/earth-warmest-january-may-2015

[4] Brian Clark Howard. July 24, 2015. “See Why 2015 May Be the Hottest Year Ever.” National Geographic. http://news.nationalgeographic.com/2015/07/071524-this-year-may-be-hottest-ever/

[5] Andrea Thompson. August 20, 2015. “2015 May Just Be Hottest Year on record.” Scientific American. http://www.scientificamerican.com/article/2015-may-just-be-hottest-year-on-record/

[6] Adam Vaughan. September 17, 2015. “US science agency says 2015 is 97% likely to be the hottest year on record.” The Guardian. http://www.theguardian.com/us-news/2015/sep/17/2015-hottest-year-on-record-noaa

[7] Justin Gillis. October 21, 2015. “2015 Likely to Be Hottest Year Ever Recorded.” The New York Times. http://www.nytimes.com/2015/10/22/science/2015-likely-to-be-hottest-year-ever-recorded.html?_r=0

[8] WMO. 25 November 2015. “WMO: 2015 likely to be Warmest on Record, 2011-2015 Warmest Five Year Period.” WMO. https://www.wmo.int/media/content/wmo-2015-likely-be-warmest-record-2011-2015-warmest-five-year-period

[9] Tom Randall. December 17, 2015. « A White-Hot Christmas Wraps Up Earth’s Hottest Year on Record.” Bloomberg Business. http://www.bloomberg.com/news/features/2015-12-17/a-white-hot-christmas-wraps-up-earth-s-hottest-year-on-record

[10] Jason Plautz. January 20, 2016. “It’s Official: 2015 Was Hottest Year on Record.” National Journal. http://www.nationaljournal.com/s/399249/its-official-2015-was-hottest-year-record?mref=scroll

[11] Brandon Miller. January 20, 2016. “2015 is warmest year on record, NOAA and NASA say.” CNN. http://www.cnn.com/2016/01/20/us/noaa-2015-warmest-year/

[12] Alyssa Newcomb. January 20, 2016. “Earth Had Its Hottest Year on Record in 2015, Says NASA, NOAA.” ABC News. http://abcnews.go.com/Technology/earth-hottest-year-record-2015-nasa-noaa/story?id=36400929

[13] Justin Gillis. January 20, 2016. “2015 Was Hottest Year in Historical Record, Scientists Say.” The New York Times. http://www.nytimes.com/2016/01/21/science/earth/2015-hottest-year-global-warming.html

[14] National Centers for Environmental Information. Retrieved January 20, 2016. “Global Analysis – Annual 2015.” NOAA. http://www.ncdc.noaa.gov/sotc/global/201513

[15] Deborah Netburn. January 20, 2016. “2015 was the hottest year on record, and the forecast for 2016 is warmer yet.” The Los Angeles Times. http://www.latimes.com/science/sciencenow/la-sci-sn-2015-hottest-year-20160119-story.html

[16] Justin Worland. December 17, 2015. “2016 Expected to Be the Warmest Year on record, Report Says.” Time. http://time.com/4154331/warmest-year-2016-climate-change-el-nino/

[17] Jason Samenow. November 17, 2015. “Record-crushing October keeps Earth on track for hottest year in 2015.” The Washington Post. https://www.washingtonpost.com/news/capital-weather-gang/wp/2015/11/17/record-crushing-october-keeps-earth-on-track-for-hottest-year-in-2015/

[18] NOAA National Climatic Data Center, State of the Climate: Global Analysis for Annual 1997, published online January 1998, retrieved on May 4, 2015 from http://www.ncdc.noaa.gov/sotc/global/199713

[19] National Centers for Environmental Information. “State of the Climate: Global Analysis.” NOAA. http://www.ncdc.noaa.gov/sotc

[20] NOAA National Centers for Environmental Information, State of the Climate: Global Analysis for August 2015, published online September 2015, retrieved on January 22, 2016. http://www.ncdc.noaa.gov/sotc/global/201508

[21] Joseph D’Aleo and Anthony Watts. August 27, 2010. Surface Temperature Records: Policy-Driven Deception? Science & Public Policy Institute.http://scienceandpublicpolicy.org/images/stories/papers/originals/surface_temp.pdf

[22] Paul Homewood. January 29, 2015. “Temperature Adjustments Around the World.” Not A Lot of People Know That. https://notalotofpeopleknowthat.wordpress.com/2015/01/29/temperature-adjustments-around-the-world/

[23] Christopher Booker. February 7, 2015. “The fiddling with temperature data is the biggest science scandal ever.” The Telegraph. http://www.telegraph.co.uk/news/earth/environment/globalwarming/11395516/The-fiddling-with-temperature-data-is-the-biggest-science-scandal-ever.html

[24] Selwyn Duke. February 9, 2015. “Global Conning: temperature Data Cooked in ‘Biggest Science Scandal Ever’.” The New American. http://www.thenewamerican.com/usnews/item/20081-global-conning-temperature-data-cooked-in-biggest-science-scandal-ever?

[25] James Delingpole. February 7, 2015. “’Breathtaking’ Adjustments to Arctic Temperature Record. Is There Any ‘Global Warming’ We Can Trust?” Breitbart. http://www.breitbart.com/london/2015/02/07/breathtaking-adjustments-to-arctic-temperature-record-is-there-any-global-warming-we-can-trust/

[26] John Hinderaker. May 5, 2015. “NOAA Caught Rewriting US Temperature History (Again).” Powerline. http://www.powerlineblog.com/archives/2015/05/noaa-caught-rewriting-us-temperature-history-again.php

[27] Paul Homewood. July 20, 2015. “NOAA Tampering Exposed.” Not A Lot of People Know That. https://notalotofpeopleknowthat.wordpress.com/2015/07/20/noaa-tampering-exposed/

[28] John Hinderaker. September 27, 2015. “Almost All US Temperature Data used in Global Warming Models Is Estimated or Altered.” Powerline. http://www.powerlineblog.com/archives/2015/09/almost-all-us-temperature-data-used-in-global-warming-models-is-estimated-or-altered.php

[29] John Goetz. September 27, 2015. “Approximately 92% (or 99%) of USHCN surface temperature data consists of estimated values.” Watts Up With That. http://wattsupwiththat.com/2015/09/27/approximately-92-or-99-of-ushcn-surface-temperature-data-consists-of-estimated-values/

[30] Larry Bell. November 17, 2015. “Data Tweaking heats up climate hype.” CFACT. http://www.cfact.org/2015/11/17/data-tweaking-heats-up-climate-hype/

[31] Tony Heller. November 19, 2015. “Record Crushing Fraud From NOAA And NASA Ahead of Paris.” The Real Climate Science. http://realclimatescience.com/2015/11/record-crushing-fraud-from-noaa-and-nasa-ahead-of-paris/

[32] Judith Curry. November 5, 2015. “Is the government tinkering with global warming data?” Fox News. http://www.foxnews.com/opinion/2015/11/05/is-government-tinkering-with-global-warming-data.html

[33] Paul Homewood. November 21, 2015. “NOAA’s Fabricated ‘Record Temperatures’.” Not A Lot People Know That. https://notalotofpeopleknowthat.wordpress.com/2015/11/21/noaas-fabricated-record-temperatures/

[34] P Gosselin. November 20, 2015. “’Massive Altered’… German Professor Examines NASA GISS Temperature Datasets.” NoTricksZone. http://notrickszone.com/2015/11/20/german-professor-examines-nasa-giss-temperature-datasets-finds-they-have-been-massively-altered/#sthash.lEDY4hkl.TeBUOeAB.dpbs

[35] Steven Goddard. November 22, 2015. “NOAA Data Tampering – Much Worse Than It Seems.” Real Science. https://stevengoddard.wordpress.com/2015/11/22/noaa-data-tampering-much-worse-than-it-seems/

[36] Steven Goddard. January 7, 2014. “NASA 1990: No Global Warming – Surface Temperature Record Should Be Replaced by More Accurate Satellites.” Real Science. https://stevengoddard.wordpress.com/2014/01/07/nasa-1990-no-global-warming-surface-temperature-record-should-be-replaced-by-more-accurate-satellites/

[37] Barbara Hollingsworth. January 21, 2016. “NASA/NOAA: 2015 ‘Warmest Year on Record’ – Except Earth’s Lower Atmosphere.” CNSNews. http://www.cnsnews.com/news/article/barbara-hollingsworth/nasanoaa-2015-warmest-year-record-except-earths-lower-atmosphere

[38] Goddard Institute for Space Studies. Retrieved on January 23, 2016. “GISS Surface temperature Analysis.” NOAA. http://data.giss.nasa.gov/gistemp/graphs_v3/

[39] Thomas R. Karl, et al. June 26, 2015. ”Possible artifacts of data biases in the recent global surface warming hiatus.” Science, Vol. 348, Issue 6242. http://science.sciencemag.org/content/sci/348/6242/1469.full.pdf

[40] Ronald Bailey. January 15, 2016. “Global Temperature Trend Propaganda Video: Who Needs Pier Review?” Reason.com. http://reason.com/blog/2016/01/15/global-temperature-trend-propaganda-vide

[41] Satellite and Information Service. January 17, 2016. “Jason-3 Officially Reaches Orbit!” NOAA. http://www.nesdis.noaa.gov/jason-3/

[42] Jeff Dunetz. October 28, 2015. “Why Is NOAA Hiding its Climate Data from Congress?” The Lid. http://lidblog.com/why-is-noaa-hiding-its-climate-data-from-congress/#

[43] Judicial Watch. December 22, 2015. “Judicial Watch Sues for Documents Withheld From Congress in New Climate Data Scandal.” Judicial Watch. http://www.judicialwatch.org/press-room/press-releases/judicial-watch-sues-for-documents-withheld-from-congress-in-new-climate-data-scandal/

[44] Michael Asher. August 7, 2007. “New Scandal Erupts over NOAA Climate Data.” Daily Tech. http://www.dailytech.com/New+Scandal+Erupts+over+NOAA+Climate+Data/article8347.htm

Bild WUWT

Bild WUWT