Auf „kaltesonne“ wird gerade um die Wahrheit zur Berichterstattung über einen in Bolivien verschwindenden See gerungen „Lago Poopo Ente nun auch im SRF“ und „Skandal in Bolivien“. Worum geht es dabei?

Es geht um ein Beispiel wie in einzelnen Medien Berichterstattungen bewusst und konsequent politisch zurechtgebogen werden

Seit Monaten bringen Medien wechselweise eine Information über Boliviens zweitgrößten See, den Lago Poopo, welcher aktuell am Austrocknen ist. In vielen Meldungen wird es dabei in den Überschriften so dargestellt, als ob die Ursache sicher der Klimawandel wäre. Doch mit wenigen Web-Klicks kann man sich darüber informieren, dass dieser extrem flache See in der Vergangenheit regelmäßig vollkommen austrocknete und es deshalb nicht mit einem (anthropogenen) Klimawandel zusammen hängt.

Bild 1 (rechts oben) Artikel auf BILD online über den Lago Poopo am 18.12.2015

Bild schreibt

[3]Anm.: als eine der wenigen Publizierungen gibt Bild die Größe mit an: von … 2792 Quadratkilometern auf 1945 Quadratkilometer sinken lassen.

Der auf knapp 3700 Metern Höhe gelegene Salzsee hatte schon in der Vergangenheit immer wieder mit akuter Wasserknappheit zu kämpfen. Er wird vom Rio Desaguadero gespeist, der vom Titicacasee zum Lago Poopó fließt.

Experten sehen verschiedene Ursachen für die Austrockung. Der fortschreitende Klimawandel sorge für immer weniger Regen im bolivianischen Hochland, mutmaßen Experten. Gewrardo Zamora von der Universität in Oruro hält aber auch den Bau von Staudämmen an Zuflüssen in Peru für eine wichtige Ursache.

El Niño wiederum ist ein Klimaphänomen im pazifischen Raum, das das Wetter insbesondere in in Südamerika, Asien und Afrika erheblich beeinflussen und auch zu Naturkatastrophen führen kann. Dieses Phänomen ist längst noch nicht vollständig enträtselt. Experten vermuten aber, dass die Erderwärmung dazu führt, dass El Niño möglicherweise in kürzeren Abständen auftritt als früher.

Das Handelsblatt weiß nicht so recht, wie es berichten soll. Vielleicht sind dem Redakteur auch Zweifel an verschiedenen Darstellungen gekommen. Jedenfalls listet es alle Statements und wenigstens kann sich der Leser daraus in etwa selbst ein Bild machen.

[5] Handelsblatt: Der See weicht der Wüste

Der zweitgrößte See Boliviens ist vollständig ausgetrocknet. Die Regierung macht den Klimawandel für den mangelnden Wassernachschub des Poopó-Sees verantwortlich. Eigene Fehler will sie nicht eingestehen.

Zwar trocknete der Salzsee auch in der Vergangenheit schon aus und erholte sich dann doch wieder. Dieses Mal rechnen Wissenschaftler aber nicht mit einer Regeneration.

„Das liefert ein Bild von der Zukunft des Klimawandels“, erklärt Dirk Hoffmann, ein deutscher Forscher am Bolivian Mountain Institute.

Eine örtliche Bürgerinitiative wirft den Behörden vor, Warnungen vor einer Austrocknung des Poopó ignoriert zu haben. „Man hätte etwas tun können, um die Katastrophe zu verhindern“, sagt deren Vorsitzender Ángel Flores. „Die Bergbauunternehmen leiten seit 1982 Wasser um.“

Präsident Evo Morales weist die Verantwortung von sich und setzt darauf, dass der See sich doch noch einmal erholt. „Mein Vater hat mir erzählt, er habe den trockenen See schon einmal auf einem Fahrrad überquert“, sagte er im vergangenen Monat.

Die EU soll helfen

Umweltschützer und Aktivisten vor Ort sehen die Regierung dennoch in der Verantwortung. Die Wasserressourcen seien schlecht gemanagt, die Verschmutzung durch den Bergbau ignoriert worden. Mehr als 100 Minen liegen flussaufwärts und viele von ihnen entließen ihre Abwässer ungeklärt in die Zuflüsse des Poopó, darunter auch Huanuni, die größte staatliche Zinnmine.

Die bolivianische Regierung hat nun die Europäische Union um 130 Millionen Euro für Wasseraufbereitungsanlagen in der Region gebeten. Außerdem sollen die Zuflüsse ausgebaggert werden, darunter der Desaguadero, der vom Titicaca-See gespeist wird.

Doch das Wahrheitsministerium dpa (deutsche Presse-Agentur) als zeitlich letzte „Informantin“ weiss es genauer und bringt es gleich in der Überschrift. Meldung der dpa vom 11. Februar 2016 in „meiner“ Lokalzeitung:

[4] dpa Riesiger See ist verschwunden von Georg Ismar

Plötzlich verschwindet ein riesiger See in Südamerika – ein Grund ist der Klimawandel

Der Logo Popo, Boliviens zweitgrößter See ist einfach verschwunden. Auf der Suche nach den Ursachen geht es zunächst den Rio Desaguadero entlang, er fließt vom berühmten Titicacasee, dem größten Südamerikas, Richtung Poopo – und ist dessen wichtigste Wasserzufuhr. … Doch was auffällt: Silber und Erzminen entlang des Flusses zweigen viel Wasser ab.

Dann kommt der „übliche“ Einheimische:

„ … wir haben nur noch etwa ein Zehntel der Regenmengen im Vergleich zu anderen Jahren“ und deshalb zweigen die Bauern vom Rio Desaguadero Bewässerungskanäle ab. „ … Wegen der Kanäle aber fließt kaum noch Wasser aus dem Rio Desaguadero in den See.“

Und Klimafachleute welche alles wissen:

„Es gibt eine eindeutige Verbindung zum Klimawandel“ meint der Landesschef des Umweltnetzwerkes Red Lationamericana Ambiental „ „ … und die Temperaturen seien …. seit 1982 um 1,8 Grad gestiegen“.

Dabei hätte die dpa wirklich etwas Zeit gehabt, sorgfältig zu recherchieren. Jedoch will man dort wohl kein Risiko in der Tendenz eingehen und beauftragte einen Redakteur, von dem man aufgrund des Werdeganges und früherer Publizierungen [12] sicher war, dass die vorgegebene politische Linien auch eingehalten wird:

dpa Pressemitteilung [12]: Georg Ismar. Studium Iberische und Lateinamerikanische Geschichte, Mittlere und Neuere Geschichte sowie Politikwissenschaft. Auf den Magister-Abschluss sowie Tätigkeiten beim WDR und am Institut für soziale Bewegungen in Bochum folgte von 2007 bis 2009 das dpa-Volontariat. Anschließend war Ismar als dpa-Politikredakteur in Berlin tätig. 2010 wurde er bundespolitischer Korrespondent mit den Schwerpunktthemen Umwelt, Energie und SPD.

Was ist dort in den Anden nun passiert

Auf kaltesonne wurden die Darstellungen bereits gelistet. Anbei diese und zusätzliche Information.

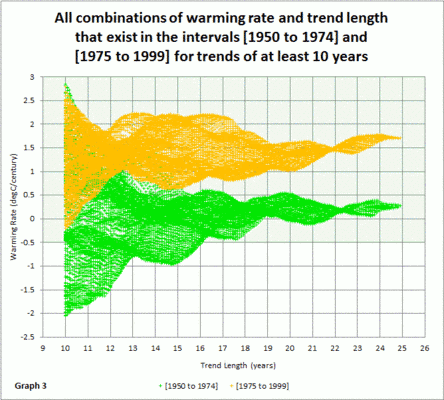

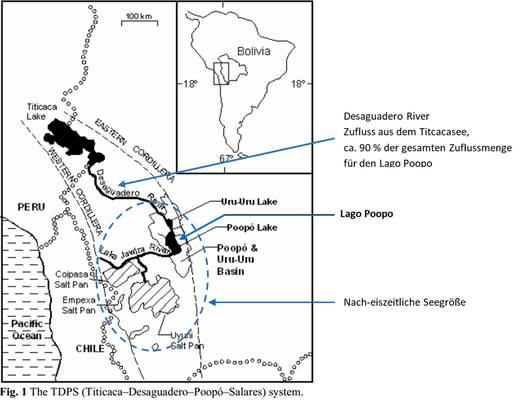

Bild 2 [9] Gebietsansicht Bolivien mit dem Lago Poopo und Zufluss vom Titicaca-See

Aussage: Der See trocknet wegen des Klimawandels aus

Zuerst einmal zum dortigen Klima. Bolivien liegt genau an einer Klimascheide. Dies führt zu laufenden Klima-Extremen in wechselnden Richtungen. In einer Studie zum Wasserhaushalt dieser Gegend (Altiplano) wird es beschrieben:

[10] (Hervorhebungen durch den Autor)

Zu den vor-historischen Temperaturschwankungen:

„….. leiten HEUSSER und STREETER (1980) für den betrachteten Zeitabschnitt des Spätglazials (Anm.: reicht bis ca. 10.000 vor Christus) Sommertemperaturen ab, die in einer Spanne zwischen -2K bis +5K relativ zum heutigen Mittelwert liegen.

Zum Wissen über die Zusammenhänge der aktuellen Klimaschwankungen:

Weiterhin wären Zusammenhänge zwischen El Nino – Southern Oscillation – Phänomenen und dem Wasserhaushalt auf dem Altiplano zu untersuchen. Die Bemühungen auf diesem Gebiet waren bisher ohne überzeugendes Ergebnis geblieben.

Ergänzung. In [14] steht dazu:

The abruptness (100–200 yr) of the shifts between high and low lake stands, however, suggests that changes in the mode of atmospheric circulation is a likely cause.

Zu den aktuellen Klimaschwankungen:

Wie in zahlreichen Arbeiten gezeigt werden konnte (VAN LOON und WILLIAMS 1976; PALTRIDGE und WOODRUFF 1981; JONES et al. 1986), hat sich um 1940 eine Veränderung des Klimas auf globaler Basis vollzogen (BARNETT 1984). Besonders auffällig dabei war der Wendepunkt von einer vorausgegangenen Erwärmung der Arktis zur nachfolgenden Abkühlung um 1940 (BORZENKOVA et al. 1976; KELLY et al. 1982).

Aus Abb. 3 und Tab. 2 ist zu ersehen, daß auch auf dem Altiplano eine Reaktion auf dieses globale Ereignis eintrat. Die wenig ergiebigen Regenzeiten zwischen 1935 und 1943 ließen den Titicacaseepegel auf den tiefsten Wert dieses Jahrhunderts sinken. Zur gleichen Zeit erhielt das Gebiet des nördlichen Mittelchile verhältnismäßig viel Niederschlag mit einer Tendenz zu niedrigen Werten von Beginn der Vierziger Jahre an (LLOYD 1973).

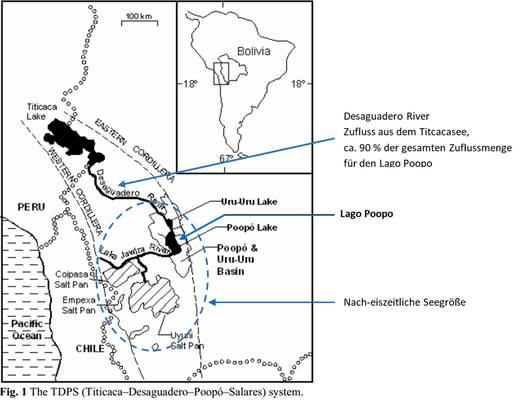

Und das Wichtigste

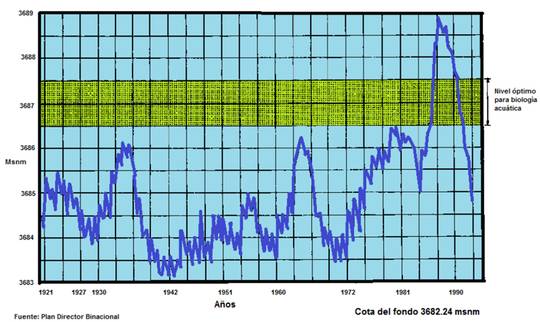

Dieser See trocknet regelmäßig aus – letztmals sogar 1997 – und tat das bereits lange vor dem Klimawandel (siehe auch die Hinweise im Bericht des Handelsblattes von dem Vater der mit dem Fahrrad über den damals ausgetrockneten See fuhr).

[9] The lake was dry between 1994 and 1997 and, according to local people, also dry or nearly dry in the early 1940s and in the early 1970s.

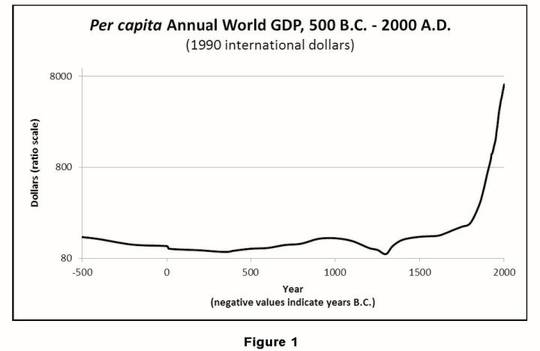

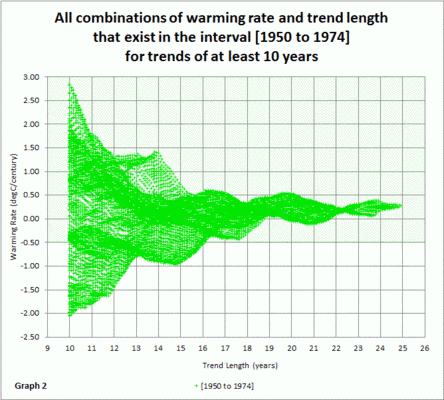

Das englischsprachige WIKIPEDIA bietet dazu sogar eine Pegelgrafik. Danach hatte der See ausgerechnet zur „Hochzeit“ des Klimawandels seinen historisch höchsten Wasserstand und verhält sich inzwischen wieder so wie in der vor-Klimawandel-Zeit:

Bild 3 [8] WIKIPEDIA historischer Pegelverlauf Lake Poopó

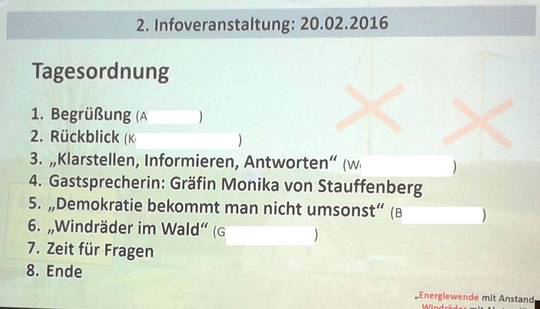

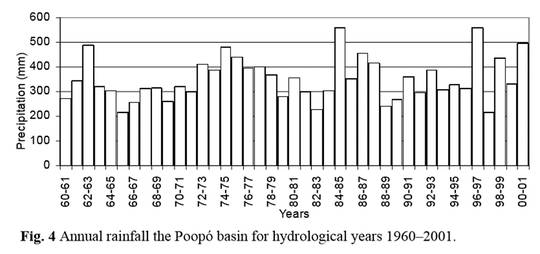

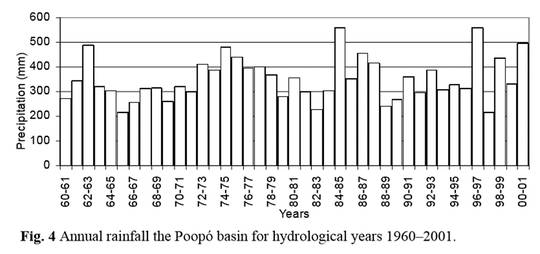

Auch die Angabe, es würde immer weniger Regnen – gar nur noch 10 % von früher wie es in der dpa-Meldung heißt – lässt sich nicht bestätigen. Dazu der rekonstruierte Niederschlagsverlauf aus einer Studie zu eben diesem Thema in den Bildern 4 und 5 [9]. Auch die Darstellung der Konrad Adenauer Stiftung sagt ganz aktuell, dass die Regenmengen nicht abgenommen haben:

[6] Da die Gesamtniederschlagsmenge ungefähr konstant geblieben ist, sind die Regenfälle heftiger und führen durch den verstärkten Abfluss zu mehr Erosion und Überschwemmungen.

Bild 4 [9] Niederschlagsverlauf am Lago de Poopo

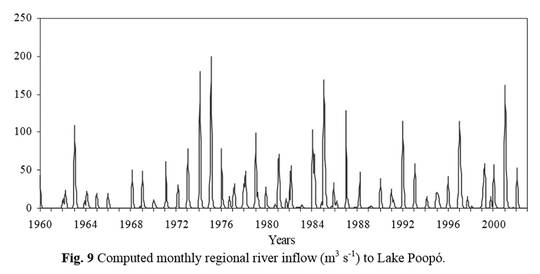

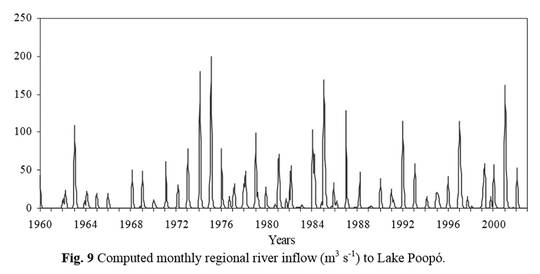

Bild 5 [9] Zuflussmenge in den Lago Poopo

Die Zuflussmenge zeigt überhaupt keine „Klimawandel“-Einflüsse. Wichtig ist auch die Aussage in der Studie, dass sich der See vom „Verschwinden“ in kürzester Zeit erholen kann, während die Klimaexperten in den Artikeln „wissen“, dass er das nicht könne:

[9] The computations also show that the lake can recover from almost dry conditions to normal or even to spill-over depth within a year. Drying of the lake to a very small surface area takes a longer time. However, it was found that, if the water depth is less than a metre in a wet season, there is a risk that the lake will be dry in a following dry season. This information, in combination with ENSO forecasts, can help in estimating lake levels with prolonged lead time and, further, in taking action so that low Lake Poopó levels fluctuations are not disastrous for the fishermen population.

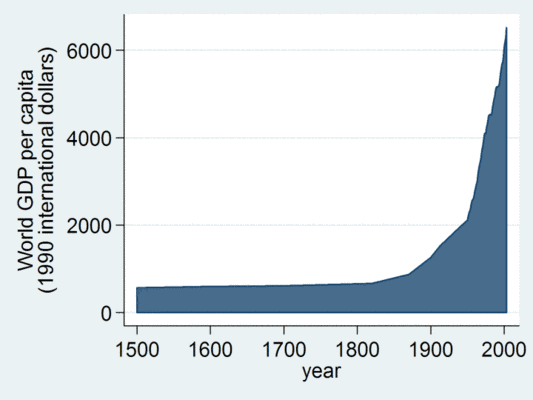

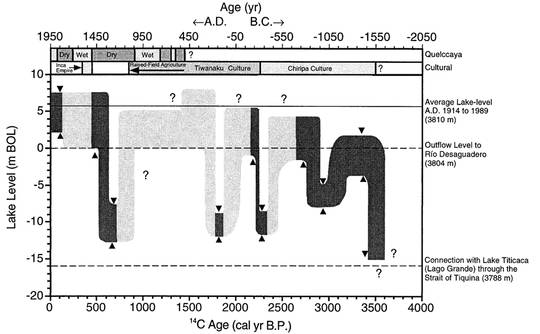

Wie wandelte sich der Zufluss in historischer Zeit

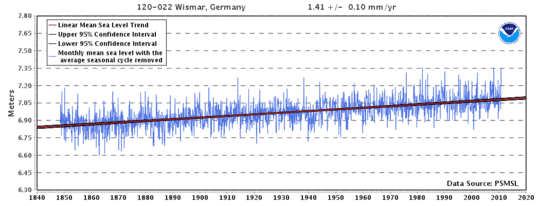

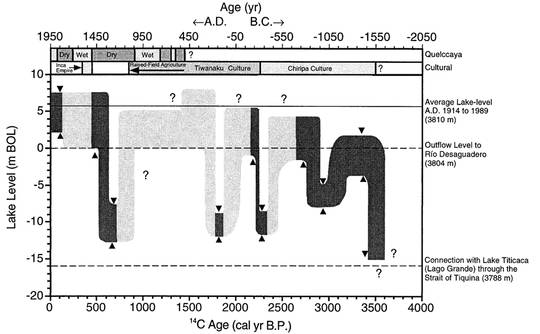

Auch das wurde schon untersucht. In der Studie „A 3500 yr High-Resolution Record of Water-Level Changes in Lake Titicaca“ [14] ist ein Bild der rekonstruierten historischen Pegel des Titicaca-Sees, welcher über den Fluss Desaguadero ca. 90 % des Wassers liefert.

Man sieht, dass der Titicacasee historisch gesehen aktuell einen hohen Pegel aufweist (1950 ist das Jahr 0 linksseitig) und die dem Klimawandel zugewiesene aktuelle Wasserarmut früher demnach über lange Zeiträume viel schlimmer war. Wichtig ist aber auch der Hinweis in der Studie, dass bereits früher gewaltig Pegelschwankungen innerhalb kurzer Zeit erfolgten.

[14] This study demonstrates that the level of Lake Titicaca has fluctuated with an amplitude ú22 m during the past 3500 cal yr and that four of the low stands were both profound and occurred abruptly over a period of 100–200 yr. The abruptness (100–200 yr) of the shifts between high and low lake stands, however, suggests that changes in the mode of atmospheric circulation is a likely cause.

FIG. 4. Water level history of Lake Titicaca based on lithostratigraphy from four cores and 60 AMS 14C measurements.

Bild 6 [14] historische Pegeldaten-Rekonstruktionen des Titicaca-Sees

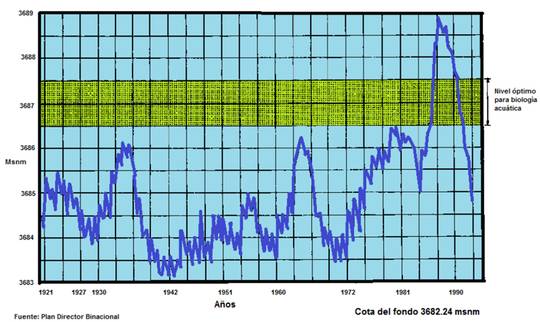

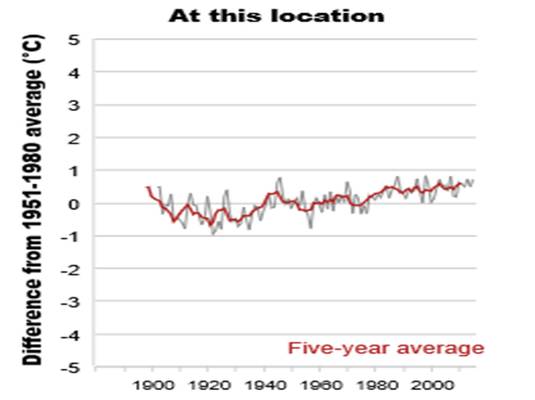

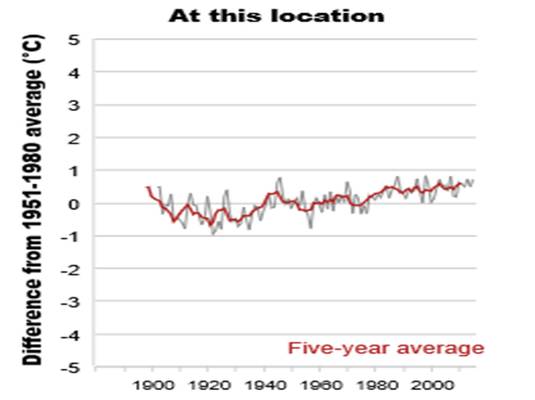

Seit 1982 ist die Temperatur um 1.8 Grad gestiegen

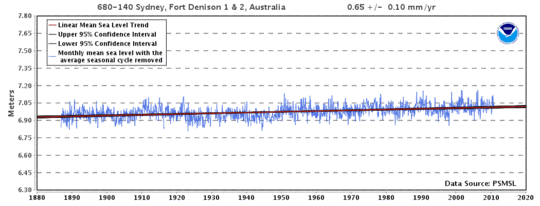

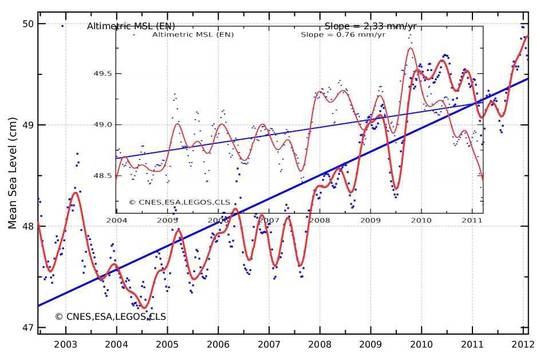

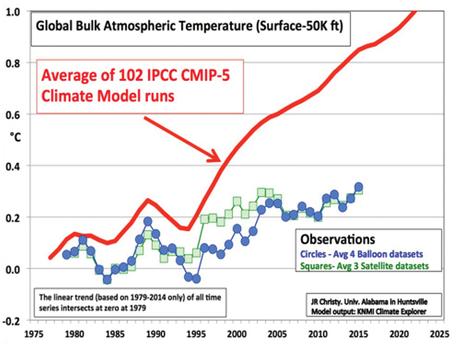

Auch dass es an der „Klimawandel-„ Temperaturerhöhung seit 1985 liegen würde, lässt sich gut widerlegen. Ca. 1940 hatte der Titicacasee als Lieferant von 90 % des Wasserzuflusses den niedrigsten (genannten) Pegel. Und laut dem dpa-Artikel soll die Temperaturerhöhung seit 1982 nun am Austrockenen schuld sein. Das ist unglaubhaft. Unabhängig davon sind jedoch die im dpa-Artikel genannten +1,8 Grad seit 1982 nicht erkennbar (Bild 7).

Anm.: Gerade für Bolivien sind die Temperaturangaben der jüngeren Zeit anscheinend mit Vorsicht zu genießen. Auf Klimaskeptiker.info steht gar, dass es seit 1990 gar keine mehr gäbe „Der Bolivien-Effekt“. Ob das wirklich stimmt, hat der Autor nicht nachgeprüft – es erscheint ihm aber etwas unwahrscheinlich.

Bild 7 [7] Temperaturverlauf am Lago Poopo

Klimafazit

Bolivien hat schon immer innerhalb kurzer Zeiträume enorme Klimaschwankungen „erlebt“. Das ist kein Zufall. Schaut man auf einen Atlanten, sieht man es in der Nähe des südlichen Wendekreises und damit auf der Breite der Wüste Namib in Afrika (auf dem nördlichen Wendekreis liegt die Sahara). Um zu „erleben“, welche Klimaextreme in diesen Breiten innerhalb kurzer Zeit stattfinden lese man die EIKE-Publizierung „Der Klimawandel bedroht die Wüste Namib“. Darin ist gezeigt, welche Sturmfluten in historischer Zeit in dieser aktuell staubtrockenen Wüste stattgefunden haben.

Zitat: „… Die Phase mit den größten Niederschlägen ereignete sich dabei zwischen 1720-1850 zu Zeiten der Kleinen Eiszeit“

Wenn nicht nur das sich stetig wandelnde Klima – was könnte es zusätzlich sein?

In den Artikeln wird es eigentlich schon deutlich. Man sehe sich die Geschichte des ausgetrockneten Aralsees (Kasachstan) an und sieht sofort Parallelen – unabhängig von der Klimazyklik des sowieso regelmäßigen Austrocknens -:

· Berbauunternehmen zweigen vom einzigen Zufluss in großen Mengen Wasser ab

· Bauern machen es ebenso und entnehmen das restliche Wasser zur künstlichen Bewässerung

Das ist auch in Bolivien bekannt. Und was Bolivien dagegen tut, steht in einer Publizierung der Adenauer-Stiftung:

[6] Konrad Adenauer Stiftung 2014: Klimareport Lateinamerika Energiesicherheit und Klimawandel weltweit BOLIVIEN

Bolivien ist Weltspitze beim Ausstoß von Kohlendioxid – zumindest wenn man die Pro-Kopf-Emissionen betrachtet. Dies beruht im Wesentlichen auf der Freisetzung von großen Mengen Kohlenstoffs durch ungebremste Entwaldung des Tieflandes sowie der allgegenwärtigen Praxis der landwirtschaftlichen Brandrodungen.

Zu den weiteren Folgen des Klimawandels gehört das häufigere Auftreten von extremen Wetterereignissen wie Dürren oder Überschwemmungen. Beides sind natürliche Erscheinungen in Bolivien, die stark vom El-Niño- bzw. La-Niña-Phänomen beeinflusst werden, sich jedoch in den letzten Jahren verstärkt bemerkbar machen.

So hat eine wissenschaftliche Studie kürzlich festgestellt, dass die Trockenzeit sich innerhalb der letzten 30 Jahre um drei Wochen verlängert und sich die Regenzeit entsprechend verkürzt hat. Da die Gesamtniederschlagsmenge ungefähr konstant geblieben ist, sind die Regenfälle heftiger und führen durch den verstärkten Abfluss zu mehr Erosion und Überschwemmungen.

Die ländliche und indigene Bevölkerung sieht sich mit der Tatsache konfrontiert, dass der jahreszeitliche Rhythmus des Klimas zunehmend durcheinander gerät. 2013 regnete es beispielsweise während der Trockenzeit jeden Monat für mehrere Tage, was absolut unüblich ist.

Und dann kommt eine wesentliche Aussage:

Die Vereinten Nationen werden von Bolivien als effektiver Mechanismus gesehen, den Belangen eines kleinen Landes weltweit Gehör zu verschaffen. So werden seit vielen Jahren von der Regierung Morales die VN-Klimaverhandlungen als Bühne genutzt, um die eigenen Positionen zu präsentieren, sich als Opfer des Klimawandels darzustellen und die industrialisierten Länder des Nordens als Hauptverantwortliche anzuklagen. So erlangte man bisher zwar weltweite Medienaufmerksamkeit, jedoch keine konkreten Ergebnisse

Germanwatch interessiert so etwas nicht. In ihrem Klimaschutz Aktionsheft 2012 steht (wie im Heft steht: gefördert durch das Bundesministerium für wirtschaftliche Zusammenarbeit und Entwicklung):

Die Bevölkerung Boliviens ist direkt von den Folgen eines Klimawandels betroffen, den sie nicht verursacht hat. Ihr möchtet, dass die Industrienationen sofort Verantwortung für ihr Handeln übernehmen und einen Anpassungsfonds finanzieren, der für die Schäden, die nicht mehr abgewendet werden können, aufkommt. Ihr fordert vehement globale Gerechtigkeit und den Schutz der Rechte von „Mutter Erde“.

Aber wie immer helfen besorgte Klimaretter-NGOs den vom Klimawandel bedrängten:

[13] Global Nature Fund Living Lakes

Der weltweite Klimawandel macht sich auch in Bolivien bemerkbar: Seit Jahren lässt sich am Titicaca-See ein Sinken des Wasserspiegels beobachten. Deshalb wurde die Stadt La Paz vom Global Nature Fund bei der Erarbeitung einer Klimastrategie unterstützt und Umweltbildungsmaßnahmen zum Klimawandel umgesetzt.

Mit dem Einsatz neuer Medien, z. B. einer Software für die Berechnung des „CO2 – und Wasserfußabdruckes“ und eines Filmfestivals wurden viele junge Leute motiviert, sich mit dem Thema zu befassen.

Darauf muss man kommen. Software „für die Berechnung des CO2-Fußabdruckes“ an Entwicklungsländer mit unfähigen Regierungen als Lösung für Probleme mit Klimaschwankungen und Natur-Raubbau zu geben.

Aber gut, Deutschlands Regierung ist nicht besser wie man anhand der CO2-Vermeidungsunterstützung für die Malediven sehen kann „Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 1“.

Fazit

Ob die Ursache des „Verschwindens“ dieses Sees in Bolivien wirklich dem CO2-Ausstoß der westlichen Länder anzulasten ist und deshalb von diesen als Selbstverständlichkeit Klimaschäden- Strafzahlungen gefordert werden können wie es Germanwatch mit „Imprimatur“ eines Bundesministeriums schreibt, möge jeder Leser selbst entscheiden.

Quellenverzeichnis

[1]

kaltesonne 13. Februar 2016: Um Antwort wird gebeten: Lago Poopó-Ente jetzt auch im SRF – Warum hat der Faktencheck versagt?

http://www.kaltesonne.de/um-antwort-wird-gebeten-lago-poopo-ente-jetzt-auch-im-srf-warum-hat-der-faktencheck-versagt/

[2]

kaltesonne 11. Februar 2016: Skandal in Bolivien: Der Klimawandel trocknet den zweitgrößten See des Landes aus, wie die Bildzeitung am 19. Dezember 2015 mit fetter Schlagzeile meldete

http://www.kaltesonne.de/die-gute-nachricht-raubtiere-helfen-bei-der-anpassung-an-den-klimawandel/

[3]

Bild 18.12.2015: Zweitgrößter See trocknet aus Klima-Drama in Bolivien!

http://www.bild.de/politik/ausland/klimawandel/bolivien-laesst-der-klimawandel-den-lago-popoo-austrocknen-43850606.bild.html

[4]

Lokalausgabe der Nordbayerischen Nachrichten vom 11. Februar 2016: Riesiger See ist verschwunden

Praktisch gleicher Artikel bei: Hessische/Niedersächsische Allgemeine (HNA): Der Poopó verschwindet Dramatisch: Boliviens zweitgrößter See ausgetrocknet

http://www.hna.de/welt/boliviens-zweitgroesster-ausgetrocknet-zr-6108102.html

[5]

Handelsblatt 23.01.2016: Der See weicht der Wüste

http://www.handelsblatt.com/technik/energie-umwelt/poop-see-in-bolivien-der-see-weicht-der-wueste/12867856.html

[6]

Konrad Adenauer Stiftung: Klimareport Lateinamerika Klimareport 2014 Energiesicherheit und Klimawandel weltweit

[7]

http://paldhous.github.io/climate-change/

[8]

WIKIPEDIA: Lake Poopó

https://en.wikipedia.org/wiki/Lake_Poop%C3%B3

[9]

Hydrological Sciences Journal 19 Jan 2010: RAMIRO PILLCO ZOLÁ & LARS BENGTSSON (2006) Long-term and extreme water level variations of the shallow Lake Poopó, Bolivia, Hydrological Sciences Journal, 51:1, 98-114

[10]

BUNDESMINISTERIUM FÜR FORSCHUNG UND TECHNOLOGIE (01 QF 072/15) SCHLUSSBERICHT, F. Künzel und A. Kessler: Untersuchungen über rezente Wasserhaushaltsschwankungen auf dem Altiplano zur Erklärung spätglazialer Klimabedingungen

[11]

ScienceScepticalBlog 12. März 2012: Polemik zum deutschen Qualitätsjournalismus: „Unentwegt quellen gereinigte Rauchgase aus den neun Kühltürmen“

[12]

dpa Pressemitteilung 11.06.2015: dpa ernennt neue Regionalbüroleiter in Rio de Janeiro und London

[13]

Global Nature Fund Living Lakes Jahresbericht 2013/2014: Kampf gegen den Klimawandel am Titicacasee

[14]

QUATERNARY RESEARCH 47, 169 – 180 (1997), MARK B. ABBOTT et al: A 3500 14C yr High-Resolution Record of Water-Level Changes in Lake Titicaca, Bolivia/Peru