Pinocchiopresse? Lügenpresse? Die deutschen Medien und ihre „Klimakatastrophen“

Der Klimarat IPCC wird von allen Medien und der Politik als verbindliches Sprachrohr der Klimaforschung angesehen. Das IPCC gibt im Abstand von 5-7 Jahren Berichte heraus, in welchen es den neueste Stand der Klimaforschung zu dokumentieren sucht (hier, hier, hier, hier) – zuletzt 2013/14 (AR5).

Darüber hinaus wird auf einer abschließenden IPCC-Konferenz ein Summary for Policymakers (SPM) zusammen geschrieben. Diese Texte werden nicht mehr von den IPCC-Wisenschaftlern der ausführlichen Einzelteile der Assessment-Reports (ca. 3000 Seiten) geschrieben, sondern im Wesentlichen von Regierungsvertretern, NGO’s und einigen auf dem poltischen Mainstream eingeschwenkten Wissenschaftlern.

Dabei bemerkenswert:

Die sachlichen und zum Teil sehr vernüchternden und einem Alarmismus gegenüber kritischen IPCC-Original-Aussagen werden im SPM bis zur Unkenntlichkeit verändert, verstümmelt oder ganz weg gelassen!

Dazu ist jüngst eine aktuelle Kurz-Gegenüberstellung publiziert worden:

IPCC 2014 : "Synthese" kontra Messungen und Fakten

(http://tinyurl.com/pjosarx + http://tinyurl.com/okd6mzu u. PDF-Anlage)

Die grundlegenden Fragestellungen zu alledem sind:

(1) Nehmen in jüngster Zeit Extremwetterereignisse (in Klimazeiträumen) zu ?

(2) Hat der Mensch einen Einfluss auf Extremwetterereignisse ?

Zu (1) Mehr Extremwetter ?

Dazu ist in den IPCC-Original-Brichten zu lesen:

Über tropische Stürme und Hurrikane

[IPCC 2013, AR5, WGI, Kapitel 2, Seite 216]: “No robust trends in annual numbers of tropical storms, hurricanes and major hurricanes counts have been identified over the past 100 years in the North Atlantic basin.”

“Keine robusten Trends bei den jährlichen Zahlen von tropischen Stürmen, Hurrikans und Stark-Hurrikans konnten in den letzten 100 Jahren im Nordatlantischen Becken ausgemacht werden.

Über tropische Zyklone

[IPCC 2013, AR5, WGI, Kapitel 2, Seite 216]: “Current datasets indicate no significant observed trends in global tropical cyclone frequency over the past century and it remains uncertain whether any reported long-term increases in tropical cyclone frequency are robust, after accounting for past changes in observing capabilities.”

“Aktuelle Datensätze zeigen keine signifikanten beobachteten Trends bei der weltweiten tropischen Wirbelsturmfrequenz während des letzten Jahrhunderts und es ist ungewiss, ob ein berichteter langfristiger Anstieg der tropischen Wirbelsturm-Frequenz robust ist, nach Berücksichtigung der letzten Änderungen in den Beobachtungs-Möglichkeiten.“

Über außer-tropischeZyklone

[IPCC 2013, AR5, WGI, Kapitel 2, Seite 220]: “In summary, confidence in large scale changes in the intensity of extreme extratropical cyclones since 1900 is low. There is also low confidence for a clear trend in storminess proxies over the last century due to inconsistencies between studies or lack of long-term data in some parts of the world (particularly in the SH). Likewise, confidence in trends in extreme winds is low, owing to quality and consistency issues with analysed data.”

“Zusammenfassend ist das Vertrauen in große Änderungen in der Intensität extremer aussertropischer Zyklone seit 1900 gering. Es gibt auch [nur] ein geringes Vertrauen für einen klaren Trend bei Sturm-Proxies wegen Inkonsistenzen zwischen den Studien oder wegen dem Fehlen von Langzeitdaten des letzten Jahrhunderts in einigen Teilen der Welt (vor allem auf der Südhemisphäre). Ebenso ist das Vertrauen in Trends in extreme Winde niedrig, wegen der Qualität und wegen Konsistenz-Problemen mit den analysierten Daten.“

Über Dürren

[IPCC 2013, AR5, WGI, Technical Summery, Seite 50]:

”There is low confidence in a global-scale observed trend in drought or dryness (lack of rainfall), owing to lack of direct observations, dependencies of inferred trends on the index choice and geographical inconsistencies in the trends.”

“Es besteht ein geringes Vertrauen im globalen Maßstab beobachteten Trend an Dürre oder Trockenheit (Mangel an Niederschlag), aus Mangel an direkten Beobachtungen, Abhängigkeiten von abgeleiteten Trends auf der Indexauswahl und wegen geographischer Unstimmigkeiten in den Trends.“

sowie

in [IPCC 2013, AR5, WGI, Kapitel 2, Seite 215]: “In summary, the current assessment concludes that there is not enough evidence at present to suggest more than low confidence in a global scale observed trend in drought ordryness (lack of rainfall) since the middle of the 20th century, owing to lack of direct observations, geographical inconsistencies in the trends, and dependencies of inferred trends on the index choice. Based on updated studies, AR4 conclusions regarding global increasing trends in drought since the 1970s were probably overstated. However, it is likely that the frequency and intensity of drought has increased in the Mediterranean and West Africa and decreased in central North America and north-west Australia since 1950.”

"Zusammenfassend kommt die aktuelle Bewertung zu dem Schluß, daß es zur Zeit nicht genug Hinweise und [nur] ein geringes Vertrauen in einen beobachteten globalen Trend an Dürre oder Trockenheit (Mangel an Niederschlägen) gibt, aus Mangel an direkten Beobachtungen in der Mitte des 20. Jahrhunderts, geographischen Inkonsistenzen in den Trends und Abhängigkeiten der abgeleiteten Trends auf der Indexauswahl. Auf Basis aktualisierter Studien waren die AR4-Schlußfolgerungen bezüglich global zunehmender Trends an Dürre seit den 1970er Jahren wahrscheinlich übertrieben. Es ist jedoch wahrscheinlich, daß die Häufigkeit und Intensität von Dürre im Mittelmeerraum und Westafrika sich erhöhen könnte und im Zentrum von Nordamerika und Nordwest-Australien seit 1950 abnehmen könnte."

Zu Überflutungen

[IPCC 2013, AR5, WGI, Technical Summery, Seite 112]: ”There continues to be a lack of evidence and thus low confidence regarding the sign of trend in the magnitude and/or frequency of floods on a global scale over the instrumental record.”

“Es besteht weiterhin ein Mangel an Beweisen und deshalb ein geringes Vertrauen in Bezug auf Trend-Anzeichen in Bezug auf Größe und / oder Häufigkeit von Überschwemmungen auf globaler Ebene der Instrumenten-Aufzeichnungen.“

Über Hagel und Gewitter

[IPCC 2013, AR5, WGI, Kapitel 2, Seite 216]: “In summary, there is low confidence in observed trends in small-scale severe weather phenomena such as hail and thunderstorms because of historical data inhomogeneities and inadequacies in monitoring systems.”

"Zusammenfassend gibt es [nur] ein geringes Vertrauen in beobachtete Trends bei den Unwetter-Erscheinungen wie Hagel und Gewitter wegen historischen Daten-Inhomogenitäten und Unzulänglichkeiten bei der Systemüberwachung."

Und schließlich fasst das IPCC zusammen

[IPCC 2013, AR5, WGI, Kapitel 2, Seite 219]: “There is limited evidence of changes in extremes associated with other climate variables since the mid-20th century.”

“Es gibt [nur] begrenzte Anhaltspunkte zu Änderungen bei Extremereignissen, die mit anderen Klimavariablen seit der Mitte des 20. Jahrhunderts verbunden sind.“

Es ist bemerkenswert, dass alle diese Zitate und Aussagen in der 28-seitigen deutschen Fassung des Summary for policymakers (hier) fehlen!

Damit ist anhand der wissenschaftlich gehaltenen und damit allein maßgebenden IPCC-Aussagen absolut klar:

Extremwetterzunahmen im jüngsten Klimazeitraum sind nicht auffindbar von den Wetterdiensten.

Zum gleichen Ergebnis kommen zwei deutsche Hochschullehrer, die dazu ein ganzes Buch geschrieben haben:

H. Krauss* u. U. Ebel: Risiko Wetter, Springer (2003); 250 S., zahlr. Abbildungen

)* Professor Helmut Kraus war weltweit anerkannter Ordinarius für Meteorologie an der Universität Bonn.

Zu (2): Anthropogenen Einfluss auf Klima-Ereignisse?

Für die in den Klima-Modellen prognostizierte Erwärmung ist die so genannte Klima-Sensitivität des CO2 entscheidend. Sie beschreibt die hypothetische Erwärmungsrate (global gemittelt) in Grad bei CO2-Verdoppelung. Ist sie groß, besteht evtl. Gefährdung, ist sie klein, dann nicht. Interessanterweise ist der Wert dieser Klimasensitivität aber bis heute der Wissenschaft unbekannt bzw. umstritten. Genau das steht sogar im jüngsten IPCC-Bericht (2013/14), Summary for Policymakers, SPM auf S.16 als Fußnote (hier): "No best estimate for equilibrum climate sensitivity can now be given because of a lack of agreement on values across assessed lines of evidence and studies".

Für die Klimasensitivität kann keine Abschätzung angegeben werden, weil keine wissenschaftliche Übereinstimmung über ihren Wert an Hand von Evidenz und Studien vorliegt.

Daraus folgt zwingend, dass alle diskutierten "Klimaschutzmaßnahmen", die aktuell in Paris für Wirbel sorgen, auf einem unbekannten Zahlenwert beruhen. Absurder geht’s nimmer. Die Welt hat wahrlich andere Probleme als sich mit einem fiktiven Problem zu beschäftigen, dessen Stärke unbekannt ist.

Dennoch fabulieren hierzulande Professoren als wissenschaftliche Clowns über ein 2-Grad-Ziel (http://tinyurl.com/nvkyft7) . Man befragt sie in den deutschen "Qualitätsmedien" fast im Wochentakt zu ihrem sachlichen Quatsch. Einer dieser Clowns steht wohl schon kurz vor der Seligsprechung durch den Papst.

Wenn uns ein Energieberater erzählen würde, dass unser Wohnhaus brennt, nur weil sich die Lufttemperatur auf Grund der anthropogenen Erwärmung um 1 Grad °C erhöht hat, dann würde man ihn unsanft vor die Tür setzen. Ein WGBU-Mitglied als Berater der Bundesregierung (Prof. Hans-Joachim Schellnhuber) darf dagegen von Selbstverbrennung faseln, nur weil seit Beginn der Industrialisierung die global gemittelte Lufttempertaur um 0,7 °C angestiegen ist.

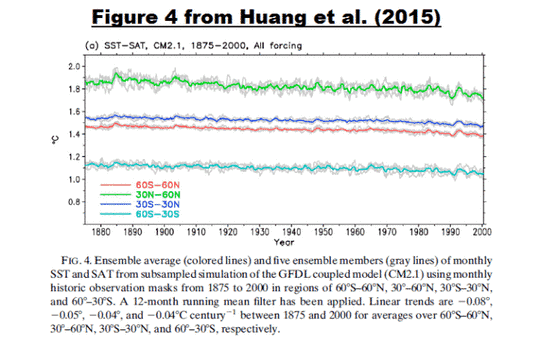

Bei alledem ist noch zu berücksichtigen, dass der Klimarat IPCC in seinem jüngsten Bericht darauf hinweist, dass es – seit mittlerweile mehr als 15 Jahren – keine Erwärmung mehr gibt [IPCC 2013/14, IPCC, AR5, Climate Change 2013: Technical Summary, p.61]:

"… Fifteen-year-long hiatus periods are common in both the observed and CMIP5 historical GMST time series".

"… 15 Jahre Hiatus in den beiden Zeitreihen CMIP5 und GMST ist allgemein bekannt" (Wir lassen "Hiatus = Pause" stehen, weil mit dieser Wortwahl das IPCC suggerieren möchte, die vorangegangene Erwärmung gehe irgendwann weiter, es handele sich also nur um eine Lücke.)

Man kann natürlich die vorstehend aufgeführten Fakten und Messungen durch "Glauben" ersetzen, indem man sich den meisten Journalisten und Politikern anschließt, deren natürlicher Feind die naturwissenschaftliche Wahrheit anhand von Messungen ist (Im deutschen Journalismus gibt es auch löbliche Ausnahmen, stellvertretend hier). Musterbeispiele für Ausblendung der Fakten sind die Bundesumweltministerin Barbara Hendricks (gem. ihrer Promotion Sachverständige für "Margarinefragen am Niederrhein") sowie auch die Bundeskanzlerin Angela Merkel, die ihre naturwissenschaftliche Vorbildung anscheinend komplett über Bord geworfen hat und mit niemandem, der anderer Klimameinung als sie ist, zu diskutieren wünscht (hier): Dieses kann man durchaus als ein zusätzliches Musterbeispiel gegen Bürgernähe und gelebte Demokratie anzusehen.

CO2-Einsparungen verursachen in Wirtschaft und Industrie Kosten von hunderten Milliarden Euro. Die Klimawirksamkeit solcher CO2-Einsparungen beträgt sogar in den ungünstigsten IPCC-Szenarien nur unmessbare Temperatur-Minderungen im Hundertstel Grad-Bereich bis zum Ende unseres Jahrhunderts. Darf eine souveräne deutsche Regierung das unter billigender Schädigung der deutschen Wirtschaft und des gesunden Menschenverstandes propagieren ? Jedenfalls – genau das tut sie.

=====================================================

Eine zusammenfassende Übersicht zu "Extremwetter-Trends – JA oder NEIN ?" mit zahlreichen Graphiken findet sich in der PDF-Anlage 1; eine Gegenüberstellung SPM vs. gemessene Realität in Anlage 2.

======================================================